Cell Outage Compensation in LTE Networks

Cell Outage Compensation in LTE Networks: Algorithms and Performance Assessment

M. Amirijoo1, L. Jorguseski2, R. Litjens2 and L. C. Schmelz3

1 Ericsson, Link?ping, Sweden,

2 TNO ICT, Delft, The Netherlands,

3 Nokia Siemens Networks, Munich, Germany

mehdi.amirijoo@https://www.360docs.net/doc/021989415.html,, {ljupco.jorguseski,remco.litjens}@tno.nl,

christoph.schmelz@https://www.360docs.net/doc/021989415.html,

Abstract — Cell outage compensation is a self-healing function and as such part of the Self-Organising Networks concept for mobile wireless networks. It aims at mitigating the degradation of coverage, capacity and service quality caused by a cell or site level outage. Upon detection of such an outage, cell outage compensation tunes a variety of control parameters, e.g., electrical antenna tilt and uplink target received power level, in cells surrounding the affected site, in order to minimise the outage-induced performance effects in accordance with the operator policy. In this paper we outline the cell outage management framework, propose concrete compensation algorithms and assess the achieved performance effects in various scenarios. The reported simulation results show that the proposed compensation algorithm is able to recover a significant percentage of the users that would otherwise be dropped, while still providing sufficient service quality in the compensating cells.

I.I NTRODUCTION

Outages in mobile cellular networks come in different degrees of significance and may have different reasons. The failure of a site, a sector, or a physical channel or signal can be caused by, e.g., hard- or software failures (radio board failure, channel processing implementation error, etc.), external failures of power supply or network connectivity, or erroneous configuration. The largely manual analysis to detect outages in today’s networks is rather suboptimal in terms of the involved response time, the incurred performance degradation and, potentially, revenue loss.

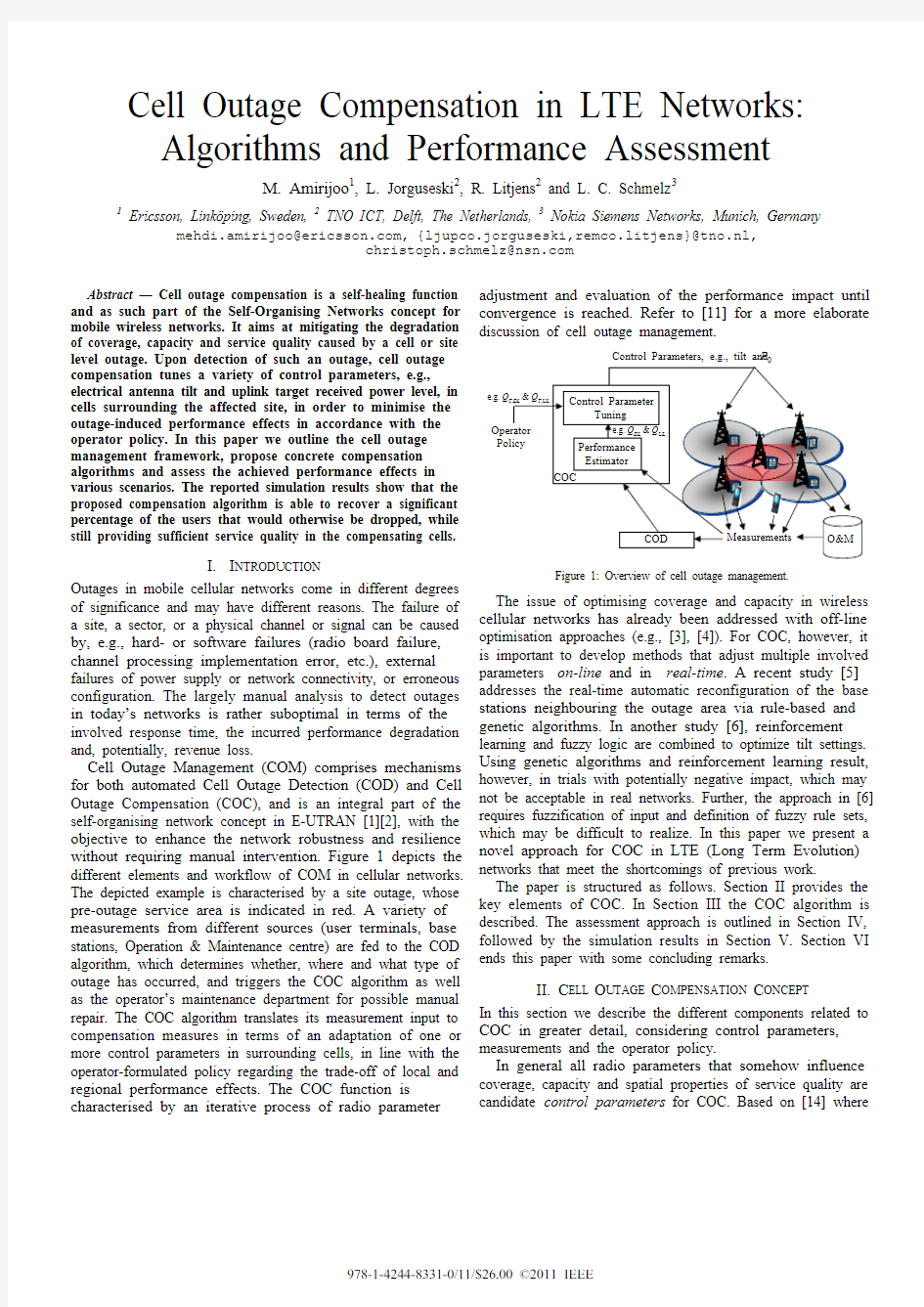

Cell Outage Management (COM) comprises mechanisms for both automated Cell Outage Detection (COD) and Cell Outage Compensation (COC), and is an integral part of the self-organising network concept in E-UTRAN [1][2], with the objective to enhance the network robustness and resilience without requiring manual intervention. Figure 1 depicts the different elements and workflow of COM in cellular networks. The depicted example is characterised by a site outage, whose pre-outage service area is indicated in red. A variety of measurements from different sources (user terminals, base stations, Operation & Maintenance centre) are fed to the COD algorithm, which determines whether, where and what type of outage has occurred, and triggers the COC algorithm as well as the operator’s maintenance department for possible manual repair. The COC algorithm translates its measurement input to compensation measures in terms of an adaptation of one or more control parameters in surrounding cells, in line with the operator-formulated policy regarding the trade-off of local and regional performance effects. The COC function is characterised by an iterative process of radio parameter adjustment and evaluation of the performance impact until convergence is reached. Refer to [11] for a more elaborate discussion of cell outage management.

Figure 1: Overview of cell outage management.

The issue of optimising coverage and capacity in wireless cellular networks has already been addressed with off-line optimisation approaches (e.g., [3], [4]). For COC, however, it is important to develop methods that adjust multiple involved parameters on-line and in real-time. A recent study [5] addresses the real-time automatic reconfiguration of the base stations neighbouring the outage area via rule-based and genetic algorithms. In another study [6], reinforcement learning and fuzzy logic are combined to optimize tilt settings. Using genetic algorithms and reinforcement learning result, however, in trials with potentially negative impact, which may not be acceptable in real networks. Further, the approach in [6] requires fuzzification of input and definition of fuzzy rule sets, which may be difficult to realize. In this paper we present a novel approach for COC in LTE (Long Term Evolution) networks that meet the shortcomings of previous work.

The paper is structured as follows. Section II provides the key elements of COC. In Section III the COC algorithm is described. The assessment approach is outlined in Section IV, followed by the simulation results in Section V. Section VI ends this paper with some concluding remarks.

II.C ELL O UTAGE C OMPENSATION C ONCEPT

In this section we describe the different components related to COC in greater detail, considering control parameters, measurements and the operator policy.

In general all radio parameters that somehow influence coverage, capacity and spatial properties of service quality are candidate control parameters for COC. Based on [14] where

Measurements

Control Parameters, e.g., tilt and P

e.g. Q

978-1-4244-8331-0/11/$26.00 ?2011 IEEE

the COC potential of several control parameters was assessed in different scenarios, the target received power density P0 of the Physical Uplink Shared Channel (PUSCH) and the antenna tilt are selected as most effective COC parameters. The uplink power level for PUSCH transmission is controlled by the uplink power control. The open loop part of the power control derives the uplink power level from, among others, a target received power density P0 (per Physical Resource Block, PRB). Decreasing P0 generally results in lower power levels for PUSCH transmissions, and consequently lower UL inter-cell interference levels. Hence we have on one hand extended UL coverage due to reduced inter-cell interference per PRB, while on the other hand the per-user throughputs are decreased due to reduced per-PRB channel rates, i.e., lower Modulation and Coding Scheme (MCS) and, consequently, a higher PRB utilisation.

Modern antennas are capable of electrical adaptation of both the orientation of the main antenna lobe and the antenna pattern, e.g. via remote electrical tilt or beam forming techniques. Adjusting the antenna tilt shapes the cell footprint. For example, decreasing the antenna downtilt (up tilting) extends the footprint further away from the base station location, which can be used for providing coverage in the area affected by a neighbour cell outage.

The measurements used for COC may be obtained from the eNodeBs (e.g., cell loads, radio link/handover failure statistics, interference levels, etc.), UEs (e.g., reference signal received power, link failure reports, etc.) and O&M system providing quality-based KPIs, e.g. the 10th UL (DL) throughput percentile Q UL(Q DL). Note that if UE measurements can be combined with positioning information different types of coverage maps can be generated and used for more advanced COC algorithms. This is left for further study and not addressed in the remaining sections.

The operator policy is the key differentiation factor among the network operators. These policies define the trade-off an operator is making between e.g. investment and operational costs versus network performance, as well as between the different network performance aspects (coverage, capacity, quality). An example of an operator policy that is used in this study for COC is to maximise coverage given minimum constraints Q T,UL and Q T,DL on the 10th UL and DL throughput percentiles, respectively (i.e. Q UL≥ Q T,UL and Q DL≥ Q T,DL). An operator policy may depend on location, time as well as on the operational state of a cell, e.g. whether it is in ‘normal’ state or involved in the compensation of an outage in its vicinity.

III.A LGORITHMS

The extensive controllability study presented in [14] revealed that by altering P0 and tilt we can effectively trade service quality for enhanced coverage. This potential is utilised in the following compensation algorithms, which are executed in a stand-alone manner in each compensating cell.

Considering a P0-based COC algorithm, the UL and DL quality in each cell are continuously measured, whereby P0 is decreased under the constraints that

min

,0

,

,

,

,P

P

Q

Q

Q

Q

UL

T

UL

DL

T

DL

≥

≥

≥

where P0,min is the minimum tolerable P0 (see below). Clearly, there are several ways of setting P0 such that the above-specified constraint is satisfied. Key considerations for computing appropriate P0 include (i) the observed UL and DL quality over a time windo w, i.e., Q DL and Q UL respectively, (ii) outage quality targets Q T,DL and Q T,UL, and (iii) current and historical P0 values.

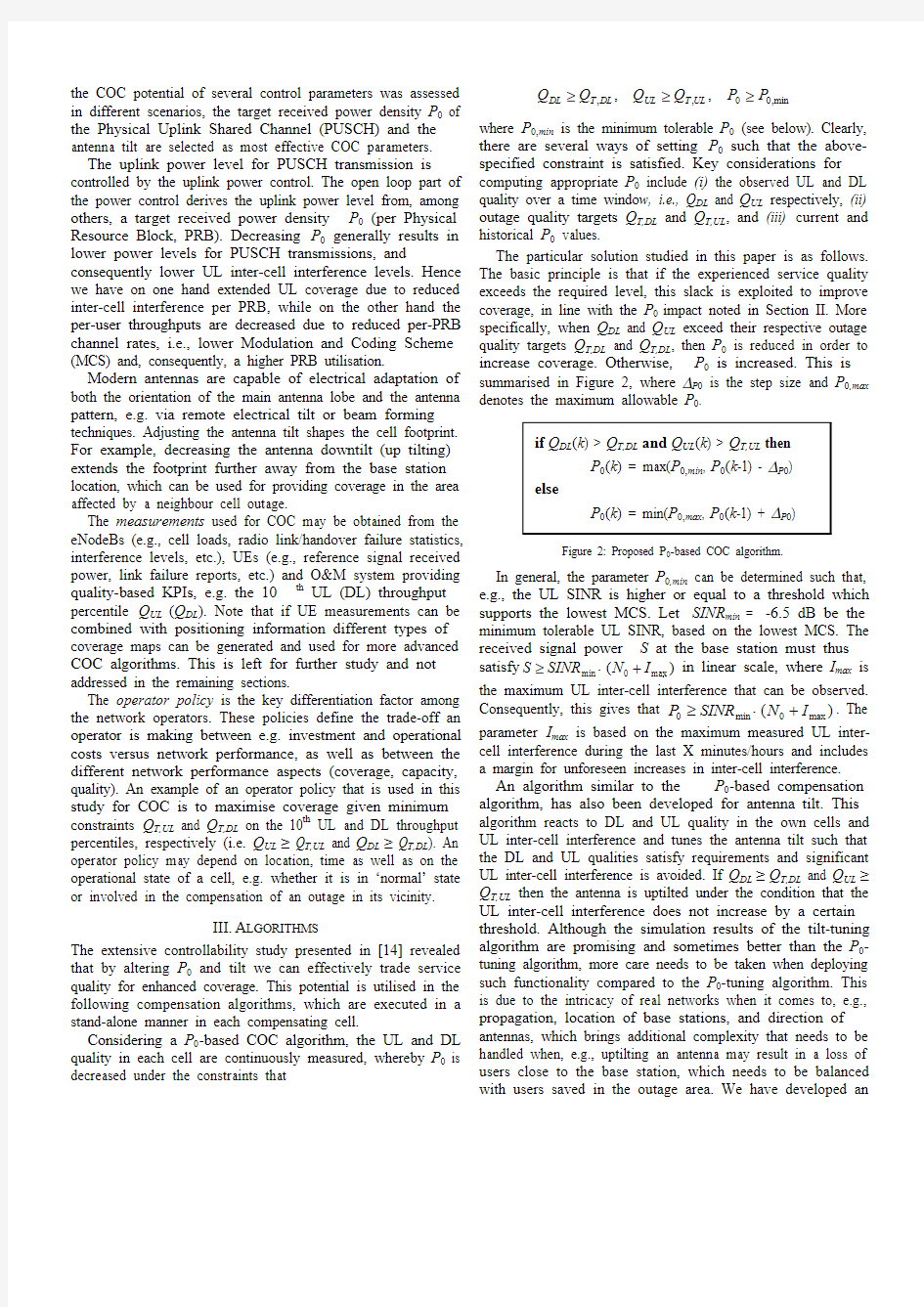

The particular solution studied in this paper is as follows. The basic principle is that if the experienced service quality exceeds the required level, this slack is exploited to improve coverage, in line with the P0impact noted in Section II. More specifically, when Q DL and Q UL exceed their respective outage quality targets Q T,DL and Q T,DL, then P0 is reduced in order to increase coverage. Otherwise, P0 is increased. This is summarised in Figure 2, where ΔP0 is the step size and P0,max denotes the maximum allowable P0.

Figure 2: Proposed P0-based COC algorithm.

In general, the parameter P0,min can be determined such that, e.g., the UL SINR is higher or equal to a threshold which supports the lowest MCS. Let SINR min = -6.5 dB be the minimum tolerable UL SINR, based on the lowest MCS. The received signal power S at the base station must thus satisfy)

(

max

min

I

N

SINR

S+

×

≥in linear scale, where I max is the maximum UL inter-cell interference that can be observed. Consequently, this gives that )

(

max

min

I

N

SINR

P+

×

≥. The parameter I max is based on the maximum measured UL inter-cell interference during the last X minutes/hours and includes a margin for unforeseen increases in inter-cell interference.

An algorithm similar to the P0-based compensation algorithm, has also been developed for antenna tilt. This algorithm reacts to DL and UL quality in the own cells and UL inter-cell interference and tunes the antenna tilt such that the DL and UL qualities satisfy requirements and significant UL inter-cell interference is avoided. If Q DL≥Q T,DL and Q UL≥Q T,UL then the antenna is uptilted under the condition that the UL inter-cell interference does not increase by a certain threshold. Although the simulation results of the tilt-tuning algorithm are promising and sometimes better than the P0-tuning algorithm, more care needs to be taken when deploying such functionality compared to the P0-tuning algorithm. This is due to the intricacy of real networks when it comes to, e.g., propagation, location of base stations, and direction of antennas, which brings additional complexity that needs to be handled when, e.g., uptilting an antenna may result in a loss of users close to the base station, which needs to be balanced

with users saved in the outage area. We have developed an

initial solution for automatic tilt tuning and present the preliminary results in Section V.

IV. A SSESSMENT A PPROACH The performance enhancement achieved by the proposed COC algorithms is assessed for a few data-only scenarios, which are characterised by distinct inter-site distance and load settings. The choice is based on the following arguments. In a sparse, coverage-driven network layout, little potential is likely to exist for compensating outage-induced performance

loss, while in a dense, capacity-driven network layout, this potential is much higher. The latter is particularly true when traffic loads are relatively low. Detailed specifications of the considered coverage- and capacity-driven layouts and the associated traffic loads, are given in Section V.

Although the COC algorithms operate independently in

each compensating cell, in the assessment approach a

distinction is made between two distinct compensation cell groups (see Figure 3). Cell group 1 (green arrows) comprises the three adjacent cells directed towards the outage area, while cell group 2 (blue arrows) comprises the six cells directed sideways. Separate assessments address the case where only group 1 contributes to the compensation, or both groups 1 & 2.

In practice, the set of compensating cells can be determined

either on- or off-line, based on e.g. predictions, simulations or measurements (handover rates, RSRP/RSRQ 1 reports, etc).

N loss

# served users

Figure 3: Compensating cells (l) and coverage metrics (r).

The objective of the assessment is to determine the degree of compensation that is attainable by control parameter (P 0 and tilt) adaptation in different scenarios, as well as its sensitivity w.r.t. the number of compensating cells. We hereby concentrate on the coverage gains and the quality sacrifice made in the compensating cells to achieve these gains.

The achieved coverage is expressed by either the relative (RCF ) or absolute compensation factor (ACF ):

,,nom

save loss save L N

ACF N N RCF ≡≡

where N loss is the total number of users that loose coverage due to the outage, N save is the total number of users that are recovered due to the COC actions, and L nom is the nominal (or average) number of users served by a cell (see also Figure 32).

1

Reference Signal Received Power/Quality.

2 Since the vertical axis (‘# served users’) in Figure

3 covers the entire affected area, while L nom is a cell-level metric, L nom is not illustrated in the figure.

As such, ACF gives the number of saved users relative to the

average number of served users in each cell. RFC and AFC are computed for the whole simulation area and are formed

during the steady-state (SS), where the results have converged

(during the final iterations). Herein, a user is ‘covered’ if three conditions are satisfied: (i) the Reference Signal (RS) SINR exceeds -6 dB; (ii) the RSRP exceeds -127 dBm; and (iii) the experienced SINR on the DL and UL is high enough to support the lowest MCS, i.e. SINR ≥ -6.5 dB.

The service quality is expressed by the 10th user throughput percentile in up- and downlink, i.e., Q UL and Q DL . A distinction is made between the post-outage/pre-compensation quality Q pre-comp and the post-compensation service quality Q comp . Service qualities Q pre-comp and Q comp are always

computed over the first tier of neighbours (group 1 and 2). V. S IMULATION R ESULTS The sensitivity analysis is performed using a Monte Carlo-based LTE network simulator. We consider a hexagonal layout of 19×3 cells. Key system parameters are listed in Table 1 (largely based on [12]). Table 1: Key system parameters. Capacity-driven layout Coverage-driven layout Inter-site distance 500 m 2200 m

Antenna downtilt 15o

5o

System bandwidth

10 MHz Maximum base station output power 46 dBm Average RS power 33 dBm Maximum UE output power 25 dBm

Path loss 128.1 + 37.6 log 10 r , with r in km Shadowing σ = 8 dB, inter-site correlation of ?, decorrel.

distance = inter-site distance / 15

Antenna model 3GPP 3D model

Noise level

-199 dBW/Hz in DL, -195 dBW/Hz in UL Service

Generic elastic data service with a requested throughput of 1 Mb/s (DL) & 250 kb/s (UL)

The considered scenarios are specified by the inter-site distance and the traffic load. The coverage-driven network layout is characterised by an inter-site distance of 2200m and a default (pre-outage) antenna downtilt of 5o . For this layout we consider only a low traffic load of (on average) 1 UE per cell (with a traffic model as given in Table 1). The coverage-driven layout represents a noise-limited scenario. The capacity-driven network layout is characterised by an inter-site distance of 500m, a default antenna downtilt of 15o , and low, medium or high traffic loads of (on average) 1, 23 and 47 UEs per cell. We assume outage-based performance targets of Q T,DL = 128 kbps and Q T,UL = 64 kbps.

A. Performance Summary

In this section we present performance results for the P 0-tuning algorithm. Specifically, we assess the compensation gains under different traffic loads, and for cases whether the compensation group comprises either only cell group 1 or both cell groups 1 and 2.

Figure 4 shows RCF and ACF for different traffic loads and compensation groups. We see that the compensation potential in terms of coverage improves as the load decreases. One interesting observation is that RCF > 1 during medium and low load when both group 1 and 2 are included in the compensation, i.e. we have that N save > N loss, which may seem contradictory at first sight. This is due to the dimensioning and parameter tuning of the network in a pre-outage setting, where coverage and quality are balanced. Since the compensation algorithms are not aware of changes to coverage (the standards lack appropriate measurements enabling accurate coverage observation), they simply reduce quality in exchange for improvements in coverage. This can as such imply that coverage targets used in the network planning are even exceeded during an outage. Further, we see that RCF and ACF are higher when including cell groups 1 and 2 in the compensation procedure, compared to the case where only cell group 1 performs compensation. Including both groups 1 and 2 results in an even less inter-cell interference compared to when compensation is done only by cell group 1, which enables the cells in group 1 to ‘penetrate’ even more into the outage area.

Figure 4: RCF (a) and ACF (b) for capacity-driven layout for different loads and compensation groups.

Figure 5 shows the quality degradation when outage compensation is applied. In general, both UL and DL quality is reduced due to more users being served, which share a given amount of resources. In addition, the UL quality is reduced more than the DL quality, since reducing P0 results in lower SINRs and hence a lower spectral efficiency. Further, the quality degradation is most visible for high and medium load and can be as low as 50% of the quality without any compensation (Q pre-comp). The quality reduction does, however, not decrease during low load, since there are enough resources to meet the UEs’ bit rate requirements (see Table 1).

Figure 5: DL quality (a) and UL quality (b) for capacity-driven layout for different loads and compensation groups.

As can be seen in Figure 5, the quality degradation is mostly visible when including both group 1 and 2 in the compensation (recall that Q pre-comp and Q comp are computed over group 1 and 2). When including both group 1 and 2 in the compensation, more cells suffer from quality degradation and, as such, we observe a greater quality reduction. This is an additional trade-off that needs to be considered, i.e., how many neighbouring cells that suffer from quality degradation and on the other hand contribute to increasing the coverage. We have also analysed the results of the coverage-driven layout, which show that the compensation potential is less for a coverage-driven layout, i.e., the ACF is lower compared to the capacity-driven layout. Further, we have no quality degradation in DL and a very small degradation in the UL. This is due to the low load and the fact that the network is underutilised, which is typically the case for networks dimensioned for coverage.

The results from tilt tuning show that similar or better performance can be expected, depending on the load situation.

In particular, higher compensation potential exists during

medium and low load when employing tilt-tuning. B. Temporal Behaviour

In this section we study the temporal behaviour of the P 0-tuning algorithm in a capacity-driven layout during high load.

Figure 6: (a) P

0 of the compensating cells, where max, mean and min is computed over the compensating cells (b) Mean of the DL and UL quality metrics computed over the compensating cells.

Figure 7: Snapshot of outage situation with largely converged compensation (iteration > 200).

An outage occurs at iteration 50, resulting in a reduction of number of served UEs and the creation of coverage holes, as shown in Figure 7. Compensation starts at iteration 100, whereby P 0 is gradually decreased, resulting in a reduction of mainly UL quality and in an increase in coverage and number of served users.

VI. C ONCLUDING R EMARKS In conclusion, an overview of cell outage management has been presented as a self-organising functionality in LTE

networks, followed by specific algorithmic solutions and evaluations to cell outage compensation. In the presented

algorithm, the parameters of cells neighbouring a failed cell/site can be automatically adjusted such that the coverage is maximised given constraints on quality defined in terms of

cell-edge user throughout. Depending on the considered scenario in terms of e.g., traffic loading, simulation results show the majority of the users can be recovered at the cost of an acceptably reduced quality in the compensating cells.

Key challenges that remain are, for example, accurate real-time coverage estimations, which enable a richer and more powerful operator policy where requirements on coverage can

be explicitly expressed and monitored. More specifically, if

appropriate measurements that enable accurate observation of coverage can be developed then this would facilitate the

inclusion of a coverage component in the operator policy and

in the algorithms. This would then result in a better match between coverage and quality balancing in network

dimensioning and planning, and during compensation.

A CKNOWLEDGMENT

The presented work was carried out within the EU-sponsored FP7 SOCRATES project [13].

R EFERENCES

[1] NGMN, ‘Use cases related to self organising networks. Overall

Description’, 2007.

[2] 3GPP TS 32.541, ‘Self-Healing OAM; Concepts and Requirements’,

v1.2.0, 2010.

[3] I. Siomina, P. Varbrand and D. Yuan, ‘Automated optimisation of

service coverage and base station antenna configuration in UMTS networks ’, Wireless Communications Magazine , vol. 13, no. 6, 2006. [4] D. Fagen, P. Vicharelli and J. Weitzen, ‘Automated coverage

optimisation in wireless networks ’, VTC ‘06, Montreal, Canada, 2006. [5] E3, ‘Simulation based recommendations for DSA and self-management’, FP7 E3 project ICT-2007-216248, 2009.

[6] R. Razavi, S. Klein, H. Claussen, ‘Self-Optimization of Capacity and

Coverage in LTE Networks Using a Fuzzy Reinforcement Learning Approach ’, PIMRC ’10, Istanbul, Turkey, 2010

[7] 3GPP TS 36.211, ‘Physical Channels and Modulation’, v8.9.0, 2009. [8] A. Simonsson and A. Furuskar, ‘Uplink power control in LTE –

Overview and performance ’, VTC ’08, Calgary, Canada, 2008. [9] 3GPP TS 36.213, ‘Physical layer procedures’, v8.8.0, 2009.

[10] J. Niemel? and J. Lempi?inen, ‘Impact of mechanical antenna downtilt

on performance of W-CDMA cellular networks ’, VTC ‘04, Milan, Italy, 2004.

[11] M. Amirijoo, L. Jorguseski, T. Kürner, R. Litjens, M. Neuland, L.C.

Schmelz and U. Türke, ‘Cell Outage Management in LTE Networks ’, ISWCS ’09, Siena, Italy, 2009.

[12] 3GPP TR 36.814, ‘Further advancements for E-UTRA – Physical layer

aspects’, v1.0.1, 2009.

[13] SOCRATES project, www.fp7-socrates.eu , 2010.

[14] M. Amirijoo, L. Jorguseski, R. Litjens and R. Nascimento,

‘Effectiveness of Cell Outage Compensation in LTE Networks ’, CCNC ’11, Las Vegas, USA, 2011.

Failed Cell Compensating Cell Operational Cell Covered Area Coverage Hole

Compensated Coverage Hole

触摸屏的种类及工作原理

触摸屏种类及原理 随着多媒体信息查询的与日俱增,人们越来越多地谈到触摸屏,因为触摸屏不仅适用于中国多媒体信息查询的国情,而且触摸屏具有坚固耐用、反应速度快、节省空间、易于交流等许多优点。利用这种技术,我们用户只要用手指轻轻地碰计算机显示屏上的图符或文字就能实现对主机操作,从而使人机交互更为直截了当,这种技术大大方便了那些不懂电脑操作的用户。 触摸屏作为一种最新的电脑输入设备,它是目前最简单、方便、自然的一种人机交互方式。它赋予了多媒体以崭新的面貌,是极富吸引力的全新多媒体交互设备。触摸屏在我国的应用范围非常广阔,主要是公共信息的查询;如电信局、税务局、银行、电力等部门的业务查询;城市街头的信息查询;此外应用于领导办公、工业控制、军事指挥、电子游戏、点歌点菜、多媒体教学、房地产预售等。将来,触摸屏还要走入家庭。 随着使用电脑作为信息来源的与日俱增,触摸屏以其易于使用、坚固耐用、反应速度快、节省空间等优点,使得系统设计师们越来越多的感到使用触摸屏的确具有具有相当大的优越性。触摸屏出现在中国市场上至今只有短短的几年时间,这个新的多媒体设备还没有为许多人接触和了解,包括一些正打算使用触摸屏的系统设计师,还都把触摸屏当作可有可无的设备,从发达国家触摸屏的普及历程和我国多媒体信息业正处在的阶段来看,这种观念还具有一定的普遍性。事实上,触摸屏是一个使多媒体信息或控制改头换面的设备,它赋予多媒体系统以崭新的面貌,是极富吸引力的全新多媒体交互设备。发达国家的系统设计师们和我国率先使用触摸屏的系统设计师们已经清楚的知道,触摸屏对于各种应用领域的电脑已经不再是可有可无的东西,而是必不可少的设备。它极大的简化了计算机的使用,即使是对计算机一无所知的人,也照样能够信手拈来,使计算机展现出更大的魅力。解决了公共信息市场上计算机所无法解决的问题。 随着城市向信息化方向发展和电脑网络在国民生活中的渗透,信息查询都已用触摸屏实现--显示内容可触摸的形式出现。为了帮助大家对触摸屏有一个大概的了解,笔者就在这里提供一些有关触摸屏的相关知识,希望这些内容能对大家有所用处。 一、触摸屏的工作原理 为了操作上的方便,人们用触摸屏来代替鼠标或键盘。工作时,我们必须首先用手指或其它物体触摸安装在显示器前端的触摸屏,然后系统根据手指触摸的图标或菜单位置来定位选择信息输入。触摸屏由触摸检测部件和触摸屏控制器组成;触摸检测部件安装在显示器屏幕前面,用于检测用户触摸位置,接受后送触摸屏控制器;而触摸屏控制器的主要作用是从触摸点检测装置上接收触摸信息,并将它转换成触点坐标,再送给CPU,它同时能接收CPU发来的命令并加以执行。 二、触摸屏的主要类型

计算机原理试题与答案

全国2004年4月高等教育自学考试 计算机原理试题 课程代码:02384 第一部分选择题(共25分) 一、单项选择题(本大题共25小题,每小题1分,共25分) 在每小题列出的四个选项中只有一个选项是符合题目要求的,请将其代码填写在题后的括号内。错选、多选或未选均无分。 1.计算机中一次处理的最大二进制位数即为() A.位B.字节 C.字长D.代码 2.下列算式中属于逻辑运算的是() A.1+1=2 B.1-1=0 C.1+1=10 D.1+1=1 3.下图所示的门电路,它的逻辑表达式是() A.F=CD AB B.F=ABCD C.F=AB+CD D.F=ABCD 4.八进制数中的1位对应于二进制数的() A.2位B.3位 C.4位D.5位 5.下列叙述正确的是() A.原码是表示无符号数的编码方法 B.对一个数据的原码的各位取反而且在末位再加1就可以得到这个数据的补码

C.定点数表示的是整数 D.二进制数据表示在计算机中容易实现 6.浮点数0.00100011B×2-1的规格化表示是() A.0.1000110B×2-11B B.0.0100011B×2-10B C.0.0100011B×20B D.0.1000110B×21B 7.两个定点数作补码加法运算,对相加后最高位出现进位1的处理是() A.判为溢出B.AC中不保留 C.寄存在AC中D.循环加到末位 8.运算器中通用寄存器的长度一般取() A.8位B.16位 C.32位D.等于计算机字长 9.目前在大多数微型机上广泛使用宽度为32/64位的高速总线是() A.ISA B.EISA C.PCI D.VESA 10.某计算机指令的操作码有8个二进位,这种计算机的指令系统中的指令条数至多为 ()A.8 B.64 C.128 D.256 11.间接访内指令LDA @Ad的指令周期包含CPU周期至少有() A.一个B.二个 C.三个D.四个 12.在程序中,可用转移指令实现跳过后续的3条指令继续执行。这种指令的寻址方式是() A.变址寻址方式B.相对寻址方式

天线分集技术的原理

天线分集技术的原理 最初,许多设计者可能会担心区域规范的复杂性问题,因为在全世界范围内,不同区域规范也各异。然而,只要多加研究便能了解并符合不同区域的法规,因为在每一个地区,通常都会有一个政府单位负责颁布相关文件,以说明“符合特定目的的发射端相关的规则。 无线电通信中更难于理解的部分在于无线电通信链路质量与多种外部因素相关,多种可变因素交织在一起产生了复杂的传输环境,而这种传输环境通常很难解释清楚。然而,掌握基本概念往往有助于理解多变的无线电通信链接品质,一旦理解了这些基本概念,其中许多问题可以通过一种低成本、易实现的被称作天线分集(antenna diversity)的技术来实现。 环境因素的考虑 影响无线电通信链路持续稳定的首要环境因素是被称为多径/衰落和天线极化/分集的现象。这些现象对于链路质量的影响要么是建设性的要么是破坏性的,这取决于不同的特定环境。可能发生的情况太多了,于是,当我们试着要了解特定的环境条件在某个时间点对无线电通信链接的作用,以及会造成何种链接质量时,这无疑是非常困难的。 天线极化/分集 这种被称为天线极化的现象是由给定天线的方向属性引起的,虽然有时候把天线极化解释为在某些无线电通信链路质量上的衰减,但是一些无线电通信设计者经常利用这一特性来调整天线,通过限制收发信号在限定的方向范围之内达其所需。这是可行的,因为天线在各个方向上的辐射不均衡,并且利用这一特性能够屏蔽其他(方向)来源的射频噪声。 简单的说,天线分为全向和定向两种。全向天线收发信号时,在各个方向的强度相同,而定向天线的收发信号被限定在一个方向范围之内。若要打造高度稳固的链接,首先就要从了解此应用开始。例如:如果一个链路上的信号仅来自于特定的方向,那么选择定向天线获

触摸屏系统系统架构和原理教学内容

触摸屏系统 架 构 和 原 理

目录 一、系统开发理念 0 二、系统开发功能描述 0 2.1 触控查询 0 2.2用户角色管理 0 2.3局域网共享 (1) 2.4 管理控制台的页面内容本地更新 (1) 三、系统功能特点列表 (1) 四、系统开发原理 (2) 五、系统运行环境需求 (3)

一、系统开发理念 系统采用B/S结构实现,通过专用浏览器进行信息的浏览查询与交互。系统将采用先进的多媒体技术,采用直观生动图文并茂的方式,给用户提供最优质最便捷的服务。 本系统是一个用于公共信息、公告等内容的发布和触摸查询显示的系统,系统具有声音、图像、文字等表现方式。后台管理主程序、数据库查询部分部分采用C#语言进行开发,前台动画的实现采用PhotoShop、Dreamweaver等多媒体处理技术。 多媒体查询服务终端采用自助服务(Self-service)方式。可透过Ethernet 网络与后端各式内容服务器连结,支持多种通信协议,透过模块化的应用程序开发,可使自助服务的应用程序可以达成高度的便利性。 二、系统开发功能描述 2.1 触控查询 通过触摸屏对公开信息进行查询阅读。 2.2用户角色管理 系统设置高级管理员,拥有系统最高权限,包括:用户管理、角色管理、权限管理。高级管理员可分配管理用户,新用户由高级管理员授权后方可登录系统,并可以在登录系统后更改用户密码,用户可以根据需要增加多个高级管理员;高级管理员可以增加下级管理员,并可根据管理需要设置多级管理员;可以新增、删除各级管理员,修改管理权限密码等,并可以进行角色的授权设置。 各用户根据高级管理员分配的权限,可进行后台查看、发布、编辑信息等操作。可任意编辑图文内容,插入多幅图片、FLASH、媒体,图文混排,还具上传内容源码查看功能,对于少量修改,可使用在线网页编辑器修改。修改制作版面,使用网页制作软件进行编辑。

计算机组成原理试题及答案

二、填空题 1 字符信息是符号数据,属于处理(非数值)领域的问题,国际上采用的字符系统是七单位的(ASCII)码。P23 2 按IEEE754标准,一个32位浮点数由符号位S(1位)、阶码E(8位)、尾数M(23位)三个域组成。其中阶码E的值等于指数的真值(e)加上一个固定的偏移值(127)。P17 3 双端口存储器和多模块交叉存储器属于并行存储器结构,其中前者采用(空间)并行技术,后者采用(时间)并行技术。P86 4 衡量总线性能的重要指标是(总线带宽),它定义为总线本身所能达到的最高传输速率,单位是(MB/s)。P185 5 在计算机术语中,将ALU控制器和()存储器合在一起称为()。 6 数的真值变成机器码可采用原码表示法,反码表示法,(补码)表示法,(移码)表示法。P19-P21 7 广泛使用的(SRAM)和(DRAM)都是半导体随机读写存储器。前者的速度比后者快,但集成度不如后者高。P67 8 反映主存速度指标的三个术语是存取时间、(存储周期)和(存储器带宽)。P67 9 形成指令地址的方法称为指令寻址,通常是(顺序)寻址,遇到转移指令时(跳跃)寻址。P112 10 CPU从(主存中)取出一条指令并执行这条指令的时间和称为(指令周期)。 11 定点32位字长的字,采用2的补码形式表示时,一个字所能表示

的整数范围是(-2的31次方到2的31次方减1 )。P20 12 IEEE754标准规定的64位浮点数格式中,符号位为1位,阶码为11位,尾数为52位,则它能表示的最大规格化正数为(+[1+(1-2 )]×2 )。 13 浮点加、减法运算的步骤是(0操作处理)、(比较阶码大小并完成对阶)、(尾数进行加或减运算)、(结果规格化并进行舍入处理)、(溢出处理)。P54 14 某计算机字长32位,其存储容量为64MB,若按字编址,它的存储系统的地址线至少需要(14)条。64×1024KB=2048KB(寻址范32围)=2048×8(化为字的形式)=214 15一个组相联映射的Cache,有128块,每组4块,主存共有16384块,每块64个字,则主存地址共(20)位,其中主存字块标记应为(9)位,组地址应为(5)位,Cache地址共(13)位。 16 CPU存取出一条指令并执行该指令的时间叫(指令周期),它通常包含若干个(CPU周期),而后者又包含若干个(时钟周期)。P131 17 计算机系统的层次结构从下至上可分为五级,即微程序设计级(或逻辑电路级)、一般机器级、操作系统级、(汇编语言)级、(高级语言)级。P13 18十进制数在计算机内有两种表示形式:(字符串)形式和(压缩的十进制数串)形式。前者主要用在非数值计算的应用领域,后者用于直接完成十进制数的算术运算。P19 19一个定点数由符号位和数值域两部分组成。按小数点位置不同,

触摸屏原理及应用实例

触摸屏原理及应用实例 一、触摸屏的结构及工作原理 触摸屏从工作原理上可以分为电阻式、电容式、红外线式、矢量压力传感器式等,以四线电阻式触摸屏为例。 1、触摸屏的结构 典型触摸屏的工作部分一般由三部分组成,如下图所示:两层透明的阻性导体层、两层导体之间的隔离层、电极。阻性导体层选用阻性材料,如铟锡氧化物(ITO)涂在衬底上构成,上层衬底用塑料,下层衬底用玻璃。隔离层为粘性绝缘液体材料,如聚脂薄膜。电极选用导电性能极好的材料(如银粉墨)构成,其导电性能大约为ITO(一种N型氧化物半导体氧化铟锡,ITO薄膜即铟锡氧化物半导体透明导电膜,通常有两个重要的性能指标:电阻率和光透过率)的1000倍。 触摸屏结构触摸屏工作时,上下导体层相当于电阻网络,如下图所示。 2、触摸屏的测量过程工作原理

电阻式触摸屏有四线和五线两种,四线最具有代表性。 在外ITO 层的上、下两边各渡一个狭长电极,引出端为Y +、Y -,在内IT0层的左、右两边分别渡上狭长电极,引出端为X +、X -。为了获得触摸点在X 方向的位置信号,在内IT0层的两电极X +,X -上别加REF V ,0 V 电压,使内IT0层上形成了从了从0-REF V 的电压梯度,触摸点至X -端的电压为该两端电阻对REF V 的分压,分压值代表了触摸点在X 方向的位置,然后将外lT0层的一个电极(如Y -)端悬空,可从另一电极(Y +)取出这一分压,将该分压进行A/D 转换,并与REF V 进行比较,便可得到触摸点的X 坐标。 为了获得触摸点在y 方向的位置信号,需要在外ITO 层的两电极Y +,Y -上分别加REF V ,0 V 电压,将内lT0层的一个电极(X -)悬空,从另一电极上取出触摸点在y 方向的分压。 四线电阻触摸屏测量原理 测量电压与测量点关系等效电路 测量触摸点P处测量结果计算如下:212CC y V V R R R = ?+4 34 CC x V V R R R =?+

计算机组成原理参考答案汇总

红色标记为找到了的参考答案,问答题比较全,绿色标记为个人做的,仅供参考!第一章计算机系统概述 1. 目前的计算机中,代码形式是______。 A.指令以二进制形式存放,数据以十进制形式存放 B.指令以十进制形式存放,数据以二进制形式存放 C.指令和数据都以二进制形式存放 D.指令和数据都以十进制形式存放 2. 完整的计算机系统应包括______。 A. 运算器、存储器、控制器 B. 外部设备和主机 C. 主机和实用程序 D. 配套的硬件设备和软件系统 3. 目前我们所说的个人台式商用机属于______。 A.巨型机 B.中型机 C.小型机 D.微型机 4. Intel80486是32位微处理器,Pentium是______位微处理器。 A.16B.32C.48D.64 5. 下列______属于应用软件。 A. 操作系统 B. 编译系统 C. 连接程序 D.文本处理 6. 目前的计算机,从原理上讲______。 A.指令以二进制形式存放,数据以十进制形式存放 B.指令以十进制形式存放,数据以二进制形式存放 C.指令和数据都以二进制形式存放 D.指令和数据都以十进制形式存放 7. 计算机问世至今,新型机器不断推陈出新,不管怎样更新,依然保有“存储程序”的概念,最早提出这种概念的是______。 A.巴贝奇 B.冯. 诺依曼 C.帕斯卡 D.贝尔 8.通常划分计算机发展时代是以()为标准 A.所用的电子器件 B.运算速度 C.计算机结构 D.所有语言 9.到目前为止,计算机中所有的信息任以二进制方式表示的理由是() A.节约原件 B.运算速度快 C.由物理器件的性能决定 D.信息处理方便 10.冯.诺依曼计算机中指令和数据均以二进制形式存放在存储器中,CPU区分它们的依据是() A.指令操作码的译码结果 B.指令和数据的寻址方式 C.指令周期的不同阶段 D.指令和数据所在的存储单元 11.计算机系统层次结构通常分为微程序机器层、机器语言层、操作系统层、汇编语言机器层和高级语言机器层。层次之间的依存关系为() A.上下层都无关 B.上一层实现对下一层的功能扩展,而下一层与上一层无关 C.上一层实现对下一层的功能扩展,而下一层是实现上一层的基础

浅析发射分集与接收分集技术

浅析发射分集与接收分集技术 1 概述 1.1 多天线信息论简介 近年来,多天线系统(也称为MIMO系统)引起了人们很大的研究兴趣,多天线系统原理如图1所示,它可以增加系统的容量,改进误比特率(BER).然而,获得这些增益的代价是硬件的复杂度提高,无线系统前端复杂度、体积和价格随着天线数目的增加而增加。使用天线选择技术,就可以在获得MIMO系统优势的同时降低成本。 图1 MIMO系统原理 有两种改进无线通信的方法:分集方法、复用方法。分集方法可以提高通信系统的鲁棒性,利用发送和接收天线之间的多条路径,改善系统的BER。在接收端,这种分集与RAKE接收提供的类似。分集也可以通过使用多根发射天线来得到,但是必须面对发送时带来的相互干扰。这一类主要是空时编码技术。 另外一类MIMO技术是空间复用,来自于这样一个事实:在一个具有丰富散射的环境中,接收机可以解析同时从多根天线发送的信号,因此,可以发送并行独立的数据流,使得总的系统容量随着min( , )线性增长,其中

和 是接收和发送天线的数目。 1.2 空时处理技术 空时处理始终是通信理论界的一个活跃领域。在早期研究中,学者们主要注重空间信号传播特性和信号处理,对空间处理的信息论本质探讨不多。上世纪九十年代中期,由于移动通信爆炸式发展,对于无线链路传输速率提出了越来越高的要求,传统的时频域信号设计很难满足这些需求。工业界的实际需求推动了理论界的深入探索。 在MIMO技术的发展,可以将空时编码的研究分为三大方向:空间复用、空间分集与空时预编码技术,如图2所示。 图2 MIMO技术的发展

1.3 空间分集研究 多天线分集接收是抗衰落的传统技术手段,但对于多天线发送分集,长久以来学术界并没有统一认识。1995年Telatarp[3]首先得到了高斯信道下多天线发送系统的信道容量和差错指数函数。他假定各个通道之间的衰落是相互独立的。几乎同时, Foschini和Gans在[4]得到了在准静态衰落信道条件下的截止信道容量(Outage Capacity)。此处的准静态是指信道衰落在一个长周期内保持不变,而周期之间的衰落相互独立,也称这种信道为块衰落信道(Block Fading)。 Foschini和Gans的工作,以及Telatar的工作是多天线信息论研究的开创 性文献。在这些著作中,他们指出,在一定条件下,采用多个天线发送、多个天线接收(MIMO)系统可以成倍提高系统容量,信道容量的增长与天线数目成线性关系 1.4 空时块编码 (STBC) 本文我们主要介绍一类高性能的空时编码方法——空时块编码( STBC: Space Time Block Code)。 STBC编码最先是由Alamouti[1]在1998年引入的,采用了简单的两天线发分集编码的方式。这种STBC编码最大的优势在于,采用简单的最大似然译码准则,可以获得完全的天线增益。 Tarokh[5]进一步将2天线STBC编码推广到多天线形式,提出了通用的正交设计准则。 2 MIMO原理及方案

四大触摸屏技术工作原理及特点分析

四大触摸屏技术工作原理及特点分析 为了操作上的方便,人们用触摸屏来代替鼠标或键盘。工作时,我们必须首先用手指或其它物体触摸安装在显示器前端的触摸屏,然后系统根据手指触摸的图标或菜单位置来定位选择信息输入。触摸屏由触摸检测部件和触摸屏控制器组成;触摸检测部件安装在显示器屏幕前面,用于检测用户触摸位置,接受后送触摸屏控制器;而触摸屏控制器的主要作用是从触摸点检测装置上接收触摸信息,并将它转换成触点坐标,再送给CPU,它同时能接收CPU发来的命令并加以执行。 触摸屏的主要类型 按照触摸屏的工作原理和传输信息的介质,我们把触摸屏分为四种,它们分别为电阻式、电容感应式、红外线式以及表面声波式。每一类触摸屏都有其各自的优缺点,要了解那种触摸屏适用于那种场合,关键就在于要懂得每一类触摸屏技术的工作原理和特点。下面对上述的各种类型的触摸屏进行简要介绍一下: 1.电阻式触摸屏 电阻式触摸屏的工作原理 这种触摸屏利用压力感应进行控制。电阻触摸屏的主要部分是一块与显示器表面非常配合的电阻薄膜屏,这是一种多层的复合薄膜,它以一层玻璃或硬塑料平板作为基层,表面涂有一层透明氧化金属(透明的导电电阻)导电层,上面再盖有一层外表面硬化处理、光滑防擦的塑料层、它的内表面也涂有一层涂层、在他们之间有许多细小的(小于1/1000英寸)的透明隔离点把两层导电层隔开绝缘。当手指触摸屏幕时,两层导电层在触摸点位置就有了接触,电阻发生变化,在X 和Y两个方向上产生信号,然后送触摸屏控制器。控制器侦测到这一接触并计算出(X,Y)的位置,再根据模拟鼠标的方式运作。这就是电阻技术触摸屏的最基本的原理。电阻类触摸屏的关键在于材料科技,常用的透明导电涂层材料有:(1)ITO,氧化铟,弱导电体,特性是当厚度降到1800个埃(埃=10-10米)以下时会突然变得透明,透光率为80%,再薄下去透光率反而下降,到300埃厚度时又上升到80%。ITO是所有电阻技术触摸屏及电容技术触摸屏都用到的主要材料,实际上电阻和电容技术触摸屏的工作面就是ITO涂层。

计算机组成原理试题及答案

《计算机组成原理》试题 一、(共30分) 1.(10分) (1)将十进制数+107/128化成二进制数、八进制数和十六进制数(3分) (2)请回答什么是二--十进制编码?什么是有权码、什么是无权码、各举一个你熟悉的有权码和无权码的例子?(7分) 2.已知X=0.1101,Y=-0.0101,用原码一位乘法计算X*Y=?要求写出计算过程。(10分) 3.说明海明码能实现检错纠错的基本原理?为什么能发现并改正一位错、也能发现二位错,校验位和数据位在位数上应满足什么条件?(5分) 4.举例说明运算器中的ALU通常可以提供的至少5种运算功能?运算器中使用多累加器的好处是什么?乘商寄存器的基本功能是什么?(5分) 二、(共30分) 1.在设计指令系统时,通常应从哪4个方面考虑?(每个2分,共8分) 2.简要说明减法指令SUB R3,R2和子程序调用指令的执行步骤(每个4分,共8分) 3.在微程序的控制器中,通常有哪5种得到下一条指令地址的方式。(第个2分,共10分) 4.简要地说明组合逻辑控制器应由哪几个功能部件组成?(4分) 三、(共22分) 1.静态存储器和动态存储器器件的特性有哪些主要区别?各自主要应用在什么地方?(7分) 2.CACHE有哪3种基本映象方式,各自的主要特点是什么?衡量高速缓冲存储器(CACHE)性能的最重要的指标是什么?(10分) 3.使用阵列磁盘的目的是什么?阵列磁盘中的RAID0、RAID1、RAID4、RAID5各有什么样的容错能力?(5分) 四、(共18分) 1.比较程序控制方式、程序中断方式、直接存储器访问方式,在完成输入/输出操作时的优缺点。(9分) 2.比较针式、喷墨式、激光3类打印机各自的优缺点和主要应用场所。(9分) 答案 一、(共30分) 1.(10分) (1) (+107/128)10 = (+1101011/10000000)2 = (+0.1101011)2 = (+0.153)8 = (+6B)16 (2) 二-十进制码即8421码,即4个基2码位的权从高到低分别为8、4、2、1,使用基码的0000,0001,0010,……,1001这十种组合分别表示0至9这十个值。4位基二码之间满足二进制的规则,而十进制数位之间则满足十进制规则。 1

喷码机触摸屏的工作原理与应用

喷码机触摸屏的工作原理与应用 一、触摸屏的工作原理为了操作上的方便,人们用触摸屏来代替鼠标或键盘。工作时,我们必须首先用手指或其它物体触摸安装在显示器前端的触摸屏,然后系统根据手指触摸的图标或菜单位置来定位选择信息输入。触摸屏由触摸检测部件和触摸屏控制器组成;触摸检测部件安装在显示器屏幕前面,用于检测用户触摸位置,接受后送触摸屏控制器;而触摸屏控制器的主要作用是从触摸点检测装置上接收触摸信息,并将它转换成触点坐标,再送给CPU,它同时能接收CPU 发来的命令并加以执行。二、触摸屏的主要类型从技术原理来区别触摸屏,可分为五个基本种类:矢量压力传感技术触摸屏、电阻技术触摸屏、电容技术触摸屏、红外线技术触摸屏、表面声波技术触摸屏。其中矢量压力传感技术触摸屏已退出历史舞台。触摸屏红外屏价格低廉,但其外框易碎,容易产生光干扰,曲面情况下失真;电容屏设计理论好,但其图象失真问题很难得到根本解决;电阻屏的定位准确,但其价格颇高,且怕刮易损。表面声波触摸屏解决了以往触摸屏的各种缺陷,清晰抗暴,适于各种场合,缺憾是屏表面的水滴、尘土会使触摸屏变的迟钝,甚至不工作。按照触摸屏的工作原理和传输信息的介质,我们把触摸屏分为四种,它们分别为电阻式、红外线式、电容感应式以及表面声波式,下面笔者就对上述的各种类型的触摸屏进行简要介绍: 1、电阻式触摸屏电阻触摸屏的屏体部分是一块与显示器表面非常配合的多层复合薄膜,由一层玻璃或有机玻璃作为基层,表面涂有一层透明的导电层(OTI,氧化铟),上面再盖有一层外表面硬化处理、光滑防刮的塑料层,它的内表面也涂有一层OTI,在两层导电层之间有许多细小(小于千分之一英寸)的透明隔离点把它们隔开绝缘。当手指接触屏幕,两层OTI 导电层出现一个接触点,因其中一面导电层接通Y轴方向的5V 均匀电压场,使得侦测层的电压由零变为非零,控制器侦测到这个接通后,进行A/D 转换,并将得到的电压值与5V 相比,即可得触摸点的Y 轴坐标,同理得出X 轴的坐标,这就是电阻技术触摸屏共同的最基本原理。电阻屏根据引出线数多少,分为四线、五线等多线电阻触摸屏。五线电阻触摸屏的A面是导电玻璃而不是导电涂覆层,导电玻璃的工艺使其的寿命得到极大的提高,并且可以提高透光率。 电阻式触摸屏的OTI 涂层比较薄且容易脆断,涂得太厚又会降低透光且形成内反射降低清晰度,OTI 外虽多加了一层薄塑料保护层,但依然容易被锐利物件所破坏;且由于经常被触动,表层OTI 使用一定时间后会出现细小裂纹,甚至变型,如其中一点的外层OTI 受破坏而断裂,便失去作为导电体的作用,触摸屏的寿命并不长久。但电阻式触摸屏不受尘埃、水、污物影响。这种触摸屏利用压力感应进行控制。它用两层高透明的导电层组成触摸屏,两层之间距离仅为2.5 微米。当手指按在触摸屏上时,该处两层导电层接触,电阻发生变化,在X 和Y 两个方向上产生信号,然后送触摸屏控制器。这种触摸屏能在恶劣环境下工作,但手感和透光性较差,适合配带手套和不能用手直接触控的场合。电阻类触摸屏的关键在于材料科技,常用的透明导电涂层材料有:A、ITO,氧化铟,弱导电体,特性是当厚度降到1800 个(埃=10-10 米)以下时会突然变得透明,透光率为80%,再薄下去透光率反而下降,到300 埃厚度时又上升到80%。ITO 是所有电阻技术触摸屏及电容技术触摸屏都用到的主要材料,实际上电阻和电容技术触摸屏的工作面就是ITO 涂层。B、镍金涂层,五线电阻触摸屏的外层导电层使用的是延展性好的镍金涂层材料,外导电层由于频繁触摸,使用延展性好的镍金材料目的是为了延长使用寿命,但是工艺成本较为高昂。镍金导电层虽然延展性好,但是只能作透明导体,不适合作为电阻触摸屏的工作面,因为它导电率高,而且金属不易做到厚度非常均匀,不宜作电压分布层,只能作为探层。 2、电容式触摸屏电容式触摸屏的构造主要是在玻璃屏幕上镀一层透明的薄膜体层,再在导体层外加上一块保护玻璃,双玻璃设计能彻底保护导体层及感应器。电容式触摸屏在

计算机原理 试题及答案

计算机组成原理试卷A 一、选择题(每小题2分,共30分) 1.下列数中最小的数是______。 A.(100100)2 B.(43)8 C.(110010)BCD D.(25)16 2.计算机经历了从器件角度划分的四代发展历程,但从系统结构上来看,至今绝大多数计算机仍属于______型计算机。 A.实时处理 B.智能化 C.并行 D.冯.诺依曼 3.存储器是计算机系统中的记忆设备,它主要用来______。 A.存放数据 B.存放程序 C.存放微程序 D.存放数据和程序 4.以下四种类型指令中,执行时间最长的是______。 A.RR型指令 B.RS型指令 C.SS型指令 D.程序控制指令 5. 计算机的外围设备是指______。 A.输入/输出设备 B.外存储器 C.远程通信设备 D.除了CPU和内存以外的其它设备 6.堆栈寻址方式中,设A为通用寄存器,SP为堆栈指示器,M SP为SP指示器的栈顶单元,如果操作动作是:(A)→M SP,(SP)-1→SP,那么出栈操作的动作应为______。 A.(M SP)→A,(SP)+1→SP B.(SP)+1→SP,(M SP)→A C.(SP)-1→SP,(M SP)→A D.(M SP)→A,(SP)-1→SP 7.某寄存器中的值有时是地址,因此只有计算机的______才能识别它。 A.译码器 B.判别程序 C.指令 D.时序信号 8. 寄存器间接寻址方式中,操作数处在______。 A.通用寄存器 B.主存单元 C.程序计数器 D.堆栈 9. 假定下列字符码中有奇偶校验位,但没有数据错误,采用偶校验的字符码是______。 A.11001011 B.11010110 C.11000001 D.1100101 10.不是发生中断请求的条件是______。 A.一条指令执行结束 B.一次I/O操作结束 C.机器内部发生故障 D.一次DMA操作结束 11.指令系统中采用不同寻址方式的目的主要是______。 A实现存贮程序和程序控制B缩短指令长度,扩大寻址空间,提高编程灵活性C可以直接访问外存D提供扩展操作码的可能并降低指令译码难度 12.某SRAM芯片,其容量为512×8位,除电源和接地端外,该芯片引出线的最小数目应 是______。 A 23 B 25 C 50 D 19 13.算术右移指令执行的操作是______。 A 符号位填0,并顺次右移1位,最低位移至进位标志位;

表面声波式触摸屏原理

表面声波式触摸屏原理--- 表面声波触摸屏的触摸屏部分可以是一块平面、球面或是柱面的玻璃平板,安装在CRT、LED、LCD或是等离子显示器屏幕的前面。这块玻璃平板只是一块纯粹的强化玻璃,区别于别类触摸屏技术是没有任何贴膜和覆盖层。玻璃屏的左上角和右下角各固定了竖直和水平方向的超声波发射换能器,右上角则固定了两个相应的超声波接收换能器。玻璃屏的四个周边则刻有45°角由疏到密间隔非常精密的反射条纹。 工作原理以右下角的X-轴发射换能器为例: 发射换能器把控制器通过触摸屏电缆送来的电信号转化为声波能量向左方表面传递,然后由玻璃板下边的一组精密反射条纹把声波能量反射成向上的均匀面传递,声波能量经过屏体表面,再由上边的反射条纹聚成向右的线传播给X-轴的接收换能器,接收换能器将返回的表面声波能量变为电信号。 当发射换能器发射一个窄脉冲后,声波能量历经不同途径到达接收换能器,走最右边的最早到达,走最左边的最晚到达,早到达的和晚到达的这些声波能量叠加成一个较宽的波形信号,不难看出,接收信号集合了所有在X轴方向历经长短不同路径回归的声波能量,它们在Y轴走过的路程是相同的,但在X轴上,最远的比最近的多走了两倍X轴最大距离。因此这个波形信号的时间轴反映各原始波形叠加前的位置,也就是X轴坐标。 发射信号与接收信号波形在没有触摸的时候,接收信号的波形与参照波形完全一样。当手指或其它能够吸收或阻挡声波能量的物体触摸屏幕时,X轴途经手指部位向上走的声波能量被部分吸收,反应在接收波形上即某一时刻位置上波形有一个衰减缺口。 接收波形对应手指挡住部位信号衰减了一个缺口,计算缺口位置即得触摸坐标控制器分析到接收信号的衰减并由缺口的位置判定X坐标。之后Y轴同样的过程判定出触摸点的Y坐标。除了一般触摸屏都能响应的X、Y坐标外,表面声波触摸屏还响应第三轴Z轴坐标,也就是能感知用户触摸压力大小值。其原理是由接收信号衰减处的衰减量计算得到。三轴一旦确定,控制器就把它们传给主机。 ---表面声波触摸屏特点--- 表面声波触摸屏第一大特点就是抗暴,因为表面声波触摸屏的工作面是一层看不见、打不坏的声波能量,触摸屏的基层玻璃没有任何夹层和结构应力(表面声波触摸屏可以发展到直接做在CRT表面从而没有任何“屏幕”),因此非常抗暴力使用,适合公共场所。 表面声波第二大特点就是清晰美观,因为结构少,只有一层普通玻璃,透光率和清晰度都比电容电阻触摸屏好得多。反应速度快,是所有触摸屏中反应速度最快的,使用时感觉很顺畅。 表面声波第四大特点是性能稳定,因为表面声波技术原理稳定,而表面声波触摸屏的控制器靠测量衰减时刻在时间轴上的位置来计算触摸位置,所以表面声波触摸屏非常稳定,精度也非常高,目前表面声波技术触摸屏的精度通常是4096×4096×256级力度。 表面声波触摸屏的缺点是触摸屏表面的灰尘和水滴也阻挡表面声波的传递,虽然聪明的控制卡能分辨出来,但尘土积累到一定程度,信号也就衰减得非常厉害,此时表面声波触摸屏变得迟钝甚至不工作,因此,表面声波触摸屏一方面推出防尘型触摸屏,一方面建议别忘了每年定期清洁触摸屏。 表面声波触摸屏能聪明的知道什么是尘土和水滴,什么是手指,有多少在触摸。因为:我们的手指触摸在4096×4096×256级力度的精度下,每秒48次的触摸数据不可能是纹丝不变的,而尘土或水滴就一点都不变,控制器发现一个“触摸”出现后纹丝不变超过三秒钟即自动识别为干扰物。 表面声波触摸屏还具有第三轴Z轴,也就是压力轴响应,这是因为用户触摸屏幕的力量越大,接收信号波形上的衰减缺口也就越宽越深。目在所有触摸屏中只有声波触摸屏具有能感知触摸压力这个性能,有了这个功能,每个触摸点就不仅仅是有触摸和无触摸的两个

触摸屏种类及说明

触摸屏种类及说明 触摸屏是一种可以根据显示屏表面接触(手指、笔)、依靠电脑识别其触摸的位置,做出相应的反映的一种电子设备.目前市面上的触摸屏大致可以分为电容式触摸屏,四线电阻式触摸屏,五线电阻式触摸屏,表面声波触摸屏、红外线式触摸屏及光学触摸屏五种类型。 电容屏 电容技术的触摸屏是一块四层复合玻璃屏,如下图所示。玻璃屏的内表面和夹层各涂有一层ITO导电层,最外层是只有0.0015毫米厚的矽土玻璃保护层。内层ITO作为屏蔽层,以保证良好的工作环境,夹层ITO涂层作为检测定位的工作层,在四个角或四条边上引出四个电极。 容屏基本工作原理的最初想法是:人是假象的接地物(零电势体),给工作面通上一个很低的电压,当用户触摸屏幕时,手指头吸收走一个很小的电流,这个电流分从触摸屏四个角或四条边上的电极中流出,并且理论上流经这四个电极的电流与手指到四角的距离成比例,控制器通过对这四个电流比例的精密计算,得出触摸点的位置。 这个想法本来是很好的。但是,按照这种思路进行下去,却碰到了难以逾越的障碍:目前的透明导电材料

ITO——氧化金属非常脆弱,触摸几下就会损坏,还不能直接用来作工作层。材料的问题一时还难以解决,只好委曲求全:在外部增加一层非常薄的坚硬玻璃。 这层玻璃显然是不导电的,直流导电是不行了,改用高频交流信号,靠人的手指头(隔着薄玻璃)与工作面形成的耦合电容来吸走一个交流电流,这就是电容屏“电容”名字的由来:靠耦合电容来工作。 问题解决了,但代价是很大的:首先是“漂移”,因为耦合电容的方式是不稳定的,它直接受温度、湿度、手指湿润程度、人体体重、地面干燥程度影响,受外界大面积物体的干扰也非常大,带来了不稳定的结果,这些都直接违背了作为触摸屏这种绝对坐标系统的基本要求,不可避免的要产生漂移,有的电容触摸屏欲求通过25点校准法甚至96点校准法来解决漂移问题,其实是不可能的,漂移是电容工作的这种方式决定的,即使是在控制器的单片机程序上利用动态计算和经验值查表,也只能是治标不治本。多点校准法最早是大屏幕投影触摸板使用的方法,目的是消除坐标对应的线性失真,电容触摸屏的线性失真也非常厉害,主要是因为电容屏的计算建立在四个电流量与触摸点到四电极的距离成比例的理想状态上,实际由于受环境电容、线路寄生电容和不同人使用的影响,这种比例关系不可能是完全线性的,多点校准法只能解决局域分配的线性问题,解决不了整体的漂移。 电容方式的另一个代价是:最外这层极薄的玻璃,正常情况下防刮擦性能非常好,但工艺上要求在真空下制造,因为它害怕氢,哪怕有一点氢也会结合成易脆碎的玻璃,使用中轻轻一敲就成个小破洞,这对电容触摸屏来说是要命的:破洞周围直径5cm大小的区域不能使用。实际的真空是不可能有的,这层极薄的玻璃有5%的概率碰上有破洞的产品。 电容触摸屏的透光率和清晰度优于四线电阻屏,尤其是一些新的产品。 四线电阻触摸屏 电阻触摸屏的屏体部分是一块与显示器表面非常配合的多层复合薄膜,由一层玻璃或有机玻璃作为基层,表面涂有一层透明的导电层,上面再盖有一层外表面硬化处理、光滑防刮的塑料层,它的内表面也涂有一层透明导电层,在两层导电层之间有许多细小(小于千分之一英寸)的透明隔离点把它们隔开绝缘。 当手指触摸屏幕时,平常相互绝缘的两层导电层就在触摸点位置有了一个接触,因其中一面导电层接通Y 轴方向的5V均匀电压场,使得侦测层的电压由零变为非零,控制器侦测到这个接通后,进行A/D转换,并将得到的电压值与5V相比即可得触摸点的Y轴坐标,同理得出X轴的坐标,这就是所有电阻技术触摸屏共同的最基本原理。 电阻类触摸屏的关键在于材料科技。常用的透明导电涂层材料有: ①ITO,氧化铟,弱导电体,特性是当厚度降到1800个埃(埃=10-10米)以下时会突然变得透明,透光率为80%,再薄下去透光率反而下降,到300埃厚度时又上升到80%。ITO是所有电阻技术触摸屏及电容技术触摸屏都用到的主要材料,实际上电阻和电容技术触摸屏的工作面就是ITO涂层。

计算机原理-答案

《计算机原理》答案 一、填空题 1、1024 1024 1024 2、运算器、控制器、存储器、输入设备、输出设备 1、内存储器外存储器 2、打字键区_、功能键区、游标/控制键区__、数字键区_ 3、处理器、文件、存储器、作业、 4、多任务、图形界面 5、您的计算机进入睡眠状态、关闭计算机、重新启动计算机和重新启动计算机并切换到 MS___DOS方式(M)。 6、两 7、三 8、用户的帐号 9、不同性质的概念 二、简答题 1、简述计算机的工作原理。 计算机仅有硬件,计算机只有运算的可能性,如果计算机进行计算、控制等功能的话,计算机还必须配有必要的软件。所谓软件就是指使用计算机的各种程序。(1)指令和程序的概念指令就是让计算机完成某个操作所发出的指令或命令,即计算机完成某个操作的依据。 一条指令通常有两个部分组成,前面是操作码部分,后面是操作数部分。操作码是指该指令要完成的操作,操作数是指参加运算的数或者数所在的单元地址。一台计算机的所有指令的集合,称为该计算机的指令系统。 使用者根据解决某一问题的步骤,选用一条条指令进行有许的排列。计算机执行了这一指令序列,便可完成预定的任务。这一指令序列就称为程序。显然,程序中的每一条指令必须是所用计算机的指令系统中的指令,因此指令系统是系统提供给使用者编制程序的基本依据。指令系统反映了计算机的基本功能,不同的计算机其指令系统也不相同。 (2)计算机执行指令的过程 计算机执行指令一般分为两个阶段:第一阶段,将要执行的指令从内存取到CPU内;第二阶段,CPU对屈辱的该指令进行分析译码,判断该条指令要完成的操作,然后向各部件发出完成该操作的控制信号,完成该指令的功能。当一条指令执行完后就进入下一条指令的取指操作。一般将第一阶段取指令的操作称为取指周期,将第二阶段称为执行周期。 (3)程序的执行过程 程序是一系列指令的有序集合构成,计算机执行程序就是、执行这系列指令。CPU从内存读出一条指令到CPU执行,该指令执行完,再从内存读出下一条指令到CPU内执行。CPU 不断取指令,执行指令,这就是程序的执行过程。 2、计算机有哪些应用领域? 目前,电子计算机已经在工业、农业、财贸、经济、国防、科技及社会生活的各个领域中得到极其广泛的应用。归纳起来分以下几个方面。科学计算数据处理自动控制计算机辅助工程人工智能 3、什么是操作系统? 操作系统是计算机软件系统的核心和基础,它提供了软件开发和运行的环境。有了操作系统,计算机的各个部件才得以协调工作,得到有效管理。 4、文档是如何创建、关闭和打开的?其内容是如何进行复制、删除和移动的? 创建;在WORD窗口中选择文件菜单中的新建,即可新建一个文档 关闭:所谓关闭文档,即对当前文档存盘并退出对该文档的处理,只需要在文件菜单中选择关闭命令,或者用鼠标单击文档窗口右上角的关闭按钮。如果关闭文档之前尚未保存文档,则系统会给出提示,询问是否保存对该文档的修改。 打开;(1)在WINDOWS的资源管理器中或我的电脑窗口中找到需要打开的WORD文档,然后

触摸屏的原理与应用

触摸屏的原理与应用触摸屏又称为“触控屏”、“触控面板”,是一种可接收触头等输入讯号的感应式液晶显示装置,当接触了屏幕上的图形按钮时,屏幕上的触觉反馈系统可根据预先编程的程式驱动各种连结装置,可用以取代机械式的按钮面板,并借由液晶显示画面制造出生动的影音效果。 触摸屏原理:主要由其二大特性决定。第一:绝对坐标系统,第二:传感器。 首先先来区别下,鼠标与触摸屏的工作原理有何区别?借此来认识绝对坐标系统和相对坐标系统的区别。 鼠标的工作原理是通过检测鼠标器的位移,将位移信号转换为电脉冲信号,再通过程序的处理和转换来控制屏幕上的鼠标箭头的移动,属于相对坐标定位系统。而绝对坐标系统要选哪就直接点那,与鼠标这类相对定位系统的本质区别是一次到位的直观性。绝对坐标系的特点是每一次定位坐标与上一次定位坐标没有关系,触摸屏在物理上是一套独立的坐标定位系统,每次触摸的数据通过校准数据转为屏幕上的坐标。 第二:定位传感器 检测触摸并定位,各种触摸屏技术都是依靠各自的传感器来工作的,甚至有的触摸屏本身就是一套传感器。各自的定位原理和各自所用的传感器决定了触摸屏的反应速度、可靠 性、稳定性和寿命。 通过以上两个特性,触摸屏工作时,首先用手指或其它物体触摸安装

在显示器前端的触摸屏,然后系统根据手指触摸的图标或菜单位置(即绝对坐标系统)来定位选择信息输入。触摸屏由触摸检测部件和触摸屏控制器组成;触摸检测部件安装在显示器屏幕前面,用于检测用户触摸位置,接受后送触摸屏控制器(即传感器);而触摸屏控制器的主要作用是从触摸点检测装置上接收触摸信息,并将它转换成触点坐标,再送给CPU它同时能接收CPU发来的命令并加以执行。触摸屏传感器技术从触摸屏传感器技术原理来划分:有可分为五个基本种类:矢量压力传感技术触摸屏、电阻技术触摸屏、电容技术触摸屏、红外线技术触摸屏、表面声波技术触摸屏。 其中矢量压力传感技术触摸屏已退出历史舞台;红外线技术触摸屏价格低廉,但其外框易碎,容易产生光干扰,曲面情况下失真;电容技术触摸屏设计构思合理,但其图像失真问题很难得到根本解决;电阻技术触摸屏的定位准确,但其价格颇高,且怕刮易损;表面声波触摸屏解决了以往触摸屏的各种缺陷,清晰不容易被损坏,适于各种场合,缺点是屏幕表面如果有水滴和尘土会使触摸屏变的迟钝,甚至不工作。按照触摸屏的工作原理和传输信息的介质,把触摸屏分为四种,它们分别为电阻式、电容感应式、红外线式以及表面声波式。每一类触摸屏都有其各自的优缺点,要了解哪种触摸屏适用于哪种场合,关键就在于要懂得每一类触摸屏技术的工作原理和特点。 下面对上述的各种类型的触摸屏进行简要介绍一下: 1、表面声波屏 声波屏的三个角分别粘贴着X,Y 方向的发射和接收声波的换能器(换

触摸屏的原理与应用

触摸屏的原理与应用 触摸屏又称为“触控屏”、“触控面板”,是一种可接收触头等输入讯号的感应式液晶显示装置,当接触了屏幕上的图形按钮时,屏幕上的触觉反馈系统可根据预先编程的程式驱动各种连结装置,可用以取代机械式的按钮面板,并借由液晶显示画面制造出生动的影音效果。 触摸屏原理:主要由其二大特性决定。第一:绝对坐标系统,第二:传感器。 首先先来区别下,鼠标与触摸屏的工作原理有何区别?借此来认识绝对坐标系统和相对坐标系统的区别。 鼠标的工作原理是通过检测鼠标器的位移,将位移信号转换为电脉冲信号,再通过程序的处理和转换来控制屏幕上的鼠标箭头的移动,属于相对坐标定位系统。而绝对坐标系统要选哪就直接点那,与鼠标这类相对定位系统的本质区别是一次到位的直观性。绝对坐标系的特点是每一次定位坐标与上一次定位坐标没有关系,触摸屏在物理上是一套独立的坐标定位系统,每次触摸的数据通过校准数据转为屏幕上的坐标。 第二:定位传感器 检测触摸并定位,各种触摸屏技术都是依靠各自的传感器来工作的,甚至有的触摸屏本身就是一套传感器。各自的定位原理和各自所用的传感器决定了触摸屏的反应速度、可靠

性、稳定性和寿命。 通过以上两个特性,触摸屏工作时,首先用手指或其它物体触摸安装在显示器前端的触摸屏,然后系统根据手指触摸的图标或菜单位置(即绝对坐标系统)来定位选择信息输入。触摸屏由触摸检测部件和触摸屏控制器组成;触摸检测部件安装在显示器屏幕前面,用于检测用户触摸位置,接受后送触摸屏控制器(即传感器);而触摸屏控制器的主要作用是从触摸点检测装置上接收触摸信息,并将它转换成触点坐标,再送给CPU,它同时能接收CPU发来的命令并加以执行。触摸屏传感器技术 从触摸屏传感器技术原理来划分:有可分为五个基本种类:矢量压力传感技术触摸屏、电阻技术触摸屏、电容技术触摸屏、红外线技术触摸屏、表面声波技术触摸屏。 其中矢量压力传感技术触摸屏已退出历史舞台;红外线技术触摸屏价格低廉,但其外框易碎,容易产生光干扰,曲面情况下失真;电容技术触摸屏设计构思合理,但其图像失真问题很难得到根本解决;电阻技术触摸屏的定位准确,但其价格颇高,且怕刮易损;表面声波触摸屏解决了以往触摸屏的各种缺陷,清晰不容易被损坏,适于各种场合,缺点是屏幕表面如果有水滴和尘土会使触摸屏变的迟钝,甚至不工作。按照触摸屏的工作原理和传输信息的介质,把触摸屏分为四种,它们分别为电阻式、电容感应式、红外线式以及表面声