Hadoop倒排索引例子

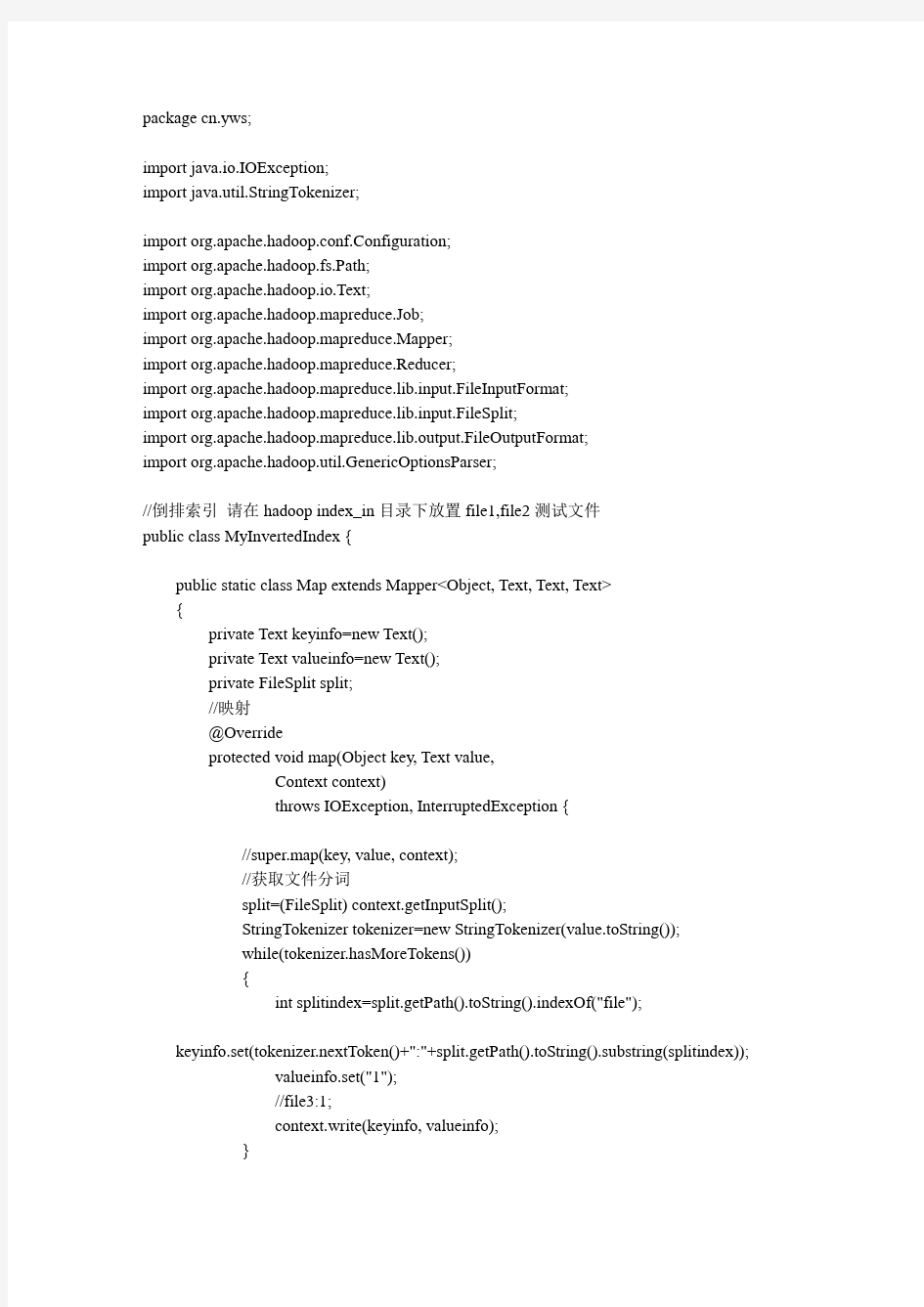

package cn.yws;

import java.io.IOException;

import java.util.StringTokenizer;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.input.FileSplit;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.util.GenericOptionsParser;

//倒排索引请在hadoop index_in目录下放置file1,file2测试文件

public class MyInvertedIndex {

public static class Map extends Mapper

{

private Text keyinfo=new Text();

private Text valueinfo=new Text();

private FileSplit split;

//映射

@Override

protected void map(Object key, Text value,

Context context)

throws IOException, InterruptedException {

//super.map(key, value, context);

//获取文件分词

split=(FileSplit) context.getInputSplit();

StringTokenizer tokenizer=new StringTokenizer(value.toString());

while(tokenizer.hasMoreTokens())

{

int splitindex=split.getPath().toString().indexOf("file");

keyinfo.set(tokenizer.nextToken()+":"+split.getPath().toString().substring(splitindex));

valueinfo.set("1");

//file3:1;

context.write(keyinfo, valueinfo);

}

}

}

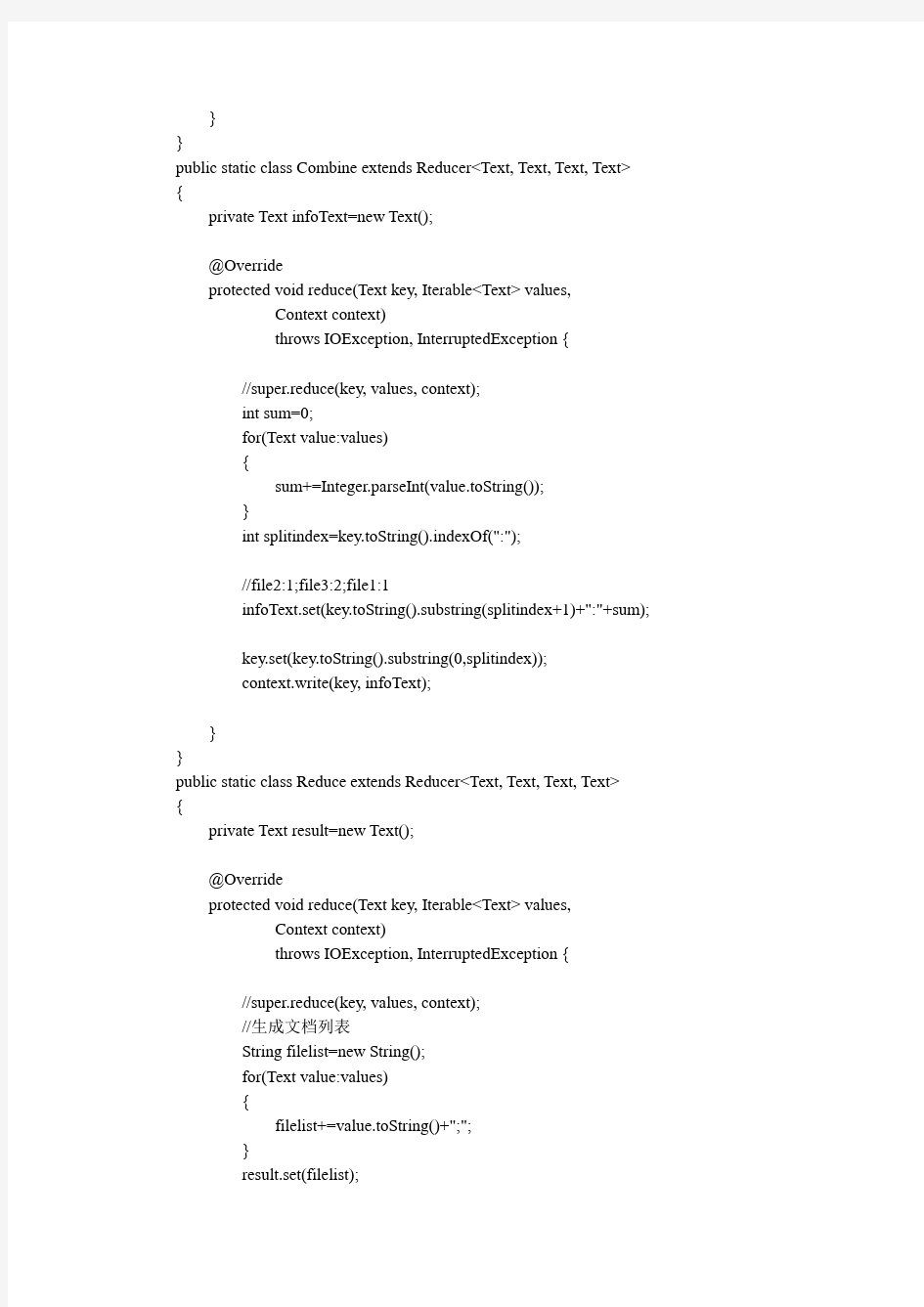

public static class Combine extends Reducer

private Text infoText=new Text();

@Override

protected void reduce(Text key, Iterable

Context context)

throws IOException, InterruptedException {

//super.reduce(key, values, context);

int sum=0;

for(Text value:values)

{

sum+=Integer.parseInt(value.toString());

}

int splitindex=key.toString().indexOf(":");

//file2:1;file3:2;file1:1

infoText.set(key.toString().substring(splitindex+1)+":"+sum);

key.set(key.toString().substring(0,splitindex));

context.write(key, infoText);

}

}

public static class Reduce extends Reducer

private Text result=new Text();

@Override

protected void reduce(Text key, Iterable

Context context)

throws IOException, InterruptedException {

//super.reduce(key, values, context);

//生成文档列表

String filelist=new String();

for(Text value:values)

{

filelist+=value.toString()+";";

}

result.set(filelist);

context.write(key, result);

}

}

public static void main(String[] args) {

try {

Configuration configuration=new Configuration();

//这句话很关键

configuration.set("mapred.job.tracker", "192.168.1.15:9001");

String[] ioargs=new String[]{"index_in","index_out3"};

if(args.length==2)

{

ioargs=args;

}

String[] otherArgs=new GenericOptionsParser(configuration,ioargs).getRemainingArgs();

if(otherArgs.length!=2)

{

System.err.println("Usage:inverted

"+MyInvertedIndex.class.getSimpleName()+"

System.exit(2);

}

//启动计算任务

Job job=new Job(configuration, MyInvertedIndex.class.getSimpleName());

job.setJarByClass(MyInvertedIndex.class);

//映射

job.setMapperClass(Map.class);

//合成

job.setCombinerClass(Combine.class);

//规约

job.setReducerClass(Reduce.class);

//设置映射Map输出类型

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(Text.class);

//设置reduce规约输出类型

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(Text.class);

//设置输入和输出目录

FileInputFormat.addInputPath(job, new Path(otherArgs[0]));

FileOutputFormat.setOutputPath(job, new Path(otherArgs[1]));

System.exit(job.waitForCompletion(true)?0:1);

} catch (Exception e) {

e.printStackTrace();

}

}

}

基于Hadoop的研究及性能分析

基于Hadoop的研究及性能分析 摘要 在大数据到来的今天,本文首先介绍了Hadoop及其核心技术MapReduce的工作原理。详细讨论了Hadoop推测执行算法和SALS 推测执行算法并对它们的性能进行分析。最后,分析了MapReduce 框架的通用二路连接算法 RSJ。为了提高性能,提出了一种基于DistributedCache 的改进算法,通过减少 mapper 输出的数据来达到优化的目的。 关键字:Hadoop MapReduce 性能算法

Abstract:In the era of big data, this paper introduces Hadoop, MapReduce and its core technology works.I have discussed the Hadoop speculative execution algorithms and SALS speculative execution algorithm and analyzed their performance.Finally, I analyzed the Common Road Join Algorithm in MapReduce framework.To improve performance, I propose an improved algorithm based DistributedCache by reducing the mapper output data to achieve optimization purposes. Key words:Hadoop; MapReduce; Performance;Algorithm

(完整版)hadoop常见笔试题答案

Hadoop测试题 一.填空题,1分(41空),2分(42空)共125分 1.(每空1分) datanode 负责HDFS数据存储。 2.(每空1分)HDFS中的block默认保存 3 份。 3.(每空1分)ResourceManager 程序通常与NameNode 在一个节点启动。 4.(每空1分)hadoop运行的模式有:单机模式、伪分布模式、完全分布式。 5.(每空1分)Hadoop集群搭建中常用的4个配置文件为:core-site.xml 、hdfs-site.xml 、mapred-site.xml 、yarn-site.xml 。 6.(每空2分)HDFS将要存储的大文件进行分割,分割后存放在既定的存储块 中,并通过预先设定的优化处理,模式对存储的数据进行预处理,从而解决了大文件储存与计算的需求。 7.(每空2分)一个HDFS集群包括两大部分,即namenode 与datanode 。一般来说,一 个集群中会有一个namenode 和多个datanode 共同工作。 8.(每空2分) namenode 是集群的主服务器,主要是用于对HDFS中所有的文件及内容 数据进行维护,并不断读取记录集群中datanode 主机情况与工作状态,并通过读取与写入镜像日志文件的方式进行存储。 9.(每空2分) datanode 在HDFS集群中担任任务具体执行角色,是集群的工作节点。文 件被分成若干个相同大小的数据块,分别存储在若干个datanode 上,datanode 会定期向集群内namenode 发送自己的运行状态与存储内容,并根据namnode 发送的指令进行工作。 10.(每空2分) namenode 负责接受客户端发送过来的信息,然后将文件存储位置信息发 送给client ,由client 直接与datanode 进行联系,从而进行部分文件的运算与操作。 11.(每空1分) block 是HDFS的基本存储单元,默认大小是128M 。 12.(每空1分)HDFS还可以对已经存储的Block进行多副本备份,将每个Block至少复制到 3 个相互独立的硬件上,这样可以快速恢复损坏的数据。 13.(每空2分)当客户端的读取操作发生错误的时候,客户端会向namenode 报告错误,并 请求namenode 排除错误的datanode 后,重新根据距离排序,从而获得一个新的的读取路径。如果所有的datanode 都报告读取失败,那么整个任务就读取失败。14.(每空2分)对于写出操作过程中出现的问题,FSDataOutputStream 并不会立即关闭。 客户端向Namenode报告错误信息,并直接向提供备份的datanode 中写入数据。备份datanode 被升级为首选datanode ,并在其余2个datanode 中备份复制数据。 NameNode对错误的DataNode进行标记以便后续对其进行处理。 15.(每空1分)格式化HDFS系统的命令为:hdfs namenode –format 。 16.(每空1分)启动hdfs的shell脚本为:start-dfs.sh 。 17.(每空1分)启动yarn的shell脚本为:start-yarn.sh 。 18.(每空1分)停止hdfs的shell脚本为:stop-dfs.sh 。 19.(每空1分)hadoop创建多级目录(如:/a/b/c)的命令为:hadoop fs –mkdir –p /a/b/c 。 20.(每空1分)hadoop显示根目录命令为:hadoop fs –lsr 。 21.(每空1分)hadoop包含的四大模块分别是:Hadoop common 、HDFS 、

hadoop练习题--带答案

Hadoop 练习题姓名:分数: 单项选择题 1.下面哪个程序负责HDFS数据存储。 a)NameNode b)Jobtracker c)Datanode √ d)secondaryNameNode e)tasktracker 2.HDfS中的block默认保存几份? a)3份√ b)2份 c)1份 d)不确定 3.下列哪个程序通常与NameNode在一个节点启动? a)SecondaryNameNode b)DataNode c)TaskTracker d)Jobtracker√ 4.Hadoop作者 a)Martin Fowler b)Kent Beck c)Doug cutting√ 5.HDFS默认Block Size a)32MB b)64MB√ c)128MB 6.下列哪项通常是集群的最主要的性能瓶颈 a)CPU b)网络 c)磁盘√ d)内存

7.关于SecondaryNameNode哪项是正确的? a)它是NameNode的热备 b)它对内存没有要求 c)它的目的是帮助NameNode合并编辑日志,减少NameNode启动时间√ d)SecondaryNameNode应与NameNode部署到一个节点 8.一个gzip文件大小75MB,客户端设置Block大小为64MB,请我其占用几个Block? a) 1 b)2√ c) 3 d) 4 9.HDFS有一个gzip文件大小75MB,客户端设置Block大小为64MB。当运行mapreduce 任务读取该文件时input split大小为? a)64MB b)75MB√ c)一个map读取64MB,另外一个map读取11MB 10.HDFS有一个LZO(with index)文件大小75MB,客户端设置Block大小为64MB。当运 行mapreduce任务读取该文件时input split大小为? a)64MB b)75MB c)一个map读取64MB,另外一个map读取11MB√ 多选题: 11.下列哪项可以作为集群的管理工具 a)Puppet√ b)Pdsh√ c)Cloudera Manager√ d)Rsync + ssh + scp√ 12.配置机架感知的下面哪项正确 a)如果一个机架出问题,不会影响数据读写√ b)写入数据的时候会写到不同机架的DataNode中√ c)MapReduce会根据机架获取离自己比较近的网络数据√ 13.Client端上传文件的时候下列哪项正确 a)数据经过NameNode传递给DataNode b)Client端将文件以Block为单位,管道方式依次传到DataNode√ c)Client只上传数据到一台DataNode,然后由NameNode负责Block复制工作 d)当某个DataNode失败,客户端会继续传给其它DataNode √

基于java的倒排索引

倒排索引 一、倒排索引 倒排索引源于实际应用中需要根据属性的值来查找记录。这种索引表中的每一项都包括一个属性值和具有该属性值的各记录的地址。由于不是由记录来确定属性值,而是由属性值来确定记录的位置,因而称为倒排索引(inverted index)。带有倒排索引的文件我们称为倒排索引文件,简称倒排文件(inverted file)。 建立索引是聊天机器人的语料库搜索核心技术之一,目的是加快响应用户的输入。使用了搜索引擎技术中最常用的倒排索引技术,它是“单词”到“文档”的一个映射。由于问答系统中的查询都是输入一段自然语言文本进行搜索,经过中文分词都转化为一系列关键词。利用倒排索引,可以通过关键词找到包含它们的文档集合,然后将其中的每一个文档与查询进行相似度匹配,从而返回与用户查询最相关的答案。 现在我们先了解下倒排索引建立的大概流程图: 倒序索引流程示意图 由流程图可知道建立索引大概分为5大步: 1)文档的分析。首先为每一篇文档分配唯一的ID ,然后对文档进行分词(主要是去除停用词和抽取词干),接着把得到的每个新词存放到词典当中,如果词典中已经存在该词语,则更新相对应的数据信息。当一篇文档被分析完之后会产生一个临时文件,该临时文件时用来存放词语ID 、文档ID 和相对出现的位置等信息。 2)排序。将得到的临时文件按词语ID 进行排序,得到一个初步有序列表。 3)词语合并。一篇文档是有很多词语所组成的,而每一个汉字或词语都有许多 文档源 临时文件 词语 分配ID 、分词 加入 包括 词典 得到各子有序文档 合并各个文档 的词语集 按各文档 ID 排序 倒序索引列表 具有相同语义的词语集表 词语集合表 词语 语义 分类 排序 词语有序列表 词语ID 、文档ID 等 生成 排序

Hadoop 100道面试题及答案解析

3.6 误) 3.7Hadoop支持数据的随机读写。(错) (8) NameNode负责管理metadata,client端每次读写请求,它都会从磁盘中3.8 读取或则会写入metadata信息并反馈client端。(错误) (8) NameNode本地磁盘保存了Block的位置信息。(个人认为正确,欢迎提出其它意见) (9) 3.9 3.10 3.11DataNode通过长连接与NameNode保持通信。(有分歧) (9) Hadoop自身具有严格的权限管理和安全措施保障集群正常运行。(错误)9 3.12 3.13 3.14Slave节点要存储数据,所以它的磁盘越大越好。(错误) (9) hadoop dfsadmin–report命令用于检测HDFS损坏块。(错误) (9) Hadoop默认调度器策略为FIFO(正确) (9) 100道常见Hadoop面试题及答案解析 目录 1单选题 (5) 1.1 1.2 1.3 1.4 1.5 1.6 1.7下面哪个程序负责HDFS数据存储。 (5) HDfS中的block默认保存几份? (5) 下列哪个程序通常与NameNode在一个节点启动? (5) Hadoop作者 (6) HDFS默认Block Size (6) 下列哪项通常是集群的最主要瓶颈: (6) 关于SecondaryNameNode哪项是正确的? (6) 2 3多选题 (7) 2.1 2.2 2.3 2.4 2.5 下列哪项可以作为集群的管理? (7) 配置机架感知的下面哪项正确: (7) Client端上传文件的时候下列哪项正确? (7) 下列哪个是Hadoop运行的模式: (7) Cloudera提供哪几种安装CDH的方法? (7) 判断题 (8) 3.1 3.2 3.3 Ganglia不仅可以进行监控,也可以进行告警。(正确) (8) Block Size是不可以修改的。(错误) (8) Nagios不可以监控Hadoop集群,因为它不提供Hadoop支持。(错误) 8 3.4如果NameNode意外终止,SecondaryNameNode会接替它使集群继续工作。(错误) (8) 3.5Cloudera CDH是需要付费使用的。(错误) (8) Hadoop是Java开发的,所以MapReduce只支持Java语言编写。(错 8

hadoop倒排索引实验报告

大数据技术概论实验报告 作 业 三 姓名:郭利强 专业:工程管理专业 学号: 2015E8009064028

目录 1.实验要求 (3) 2.环境说明 (4) 2.1系统硬件 (4) 2.2系统软件 (4) 2.3集群配置 (4) 3.实验设计 (4) 3.1第一部分设计 (4) 3.2第二部分设计 (6) 4.程序代码 (11) 4.1第一部分代码 (11) 4.2第二部分代码 (17) 5.实验输入和结果 (21) 实验输入输出结果见压缩包中对应目录 (21)

1.实验要求 第一部分:采用辅助排序的设计方法,对于输入的N个IP网络流量文件,计算得到文件中的各个源IP地址连接的不同目的IP地址个数,即对各个源IP地址连接的目的IP地址去重并计数 举例如下: 第二部分:输入N个文件,生成带详细信息的倒排索引 举例如下,有4个输入文件: – d1.txt: cat dog cat fox – d2.txt: cat bear cat cat fox – d3.txt: fox wolf dog – d4.txt: wolf hen rabbit cat sheep 要求建立如下格式的倒排索引: – cat —>3: 4: {(d1.txt,2,4),(d2.txt,3,5),(d4.txt,1,5)}–单词—>出现该单词的文件个数:总文件个数: {(出现该单词的文件名,单词在该文件中的出现次数,该文件的总单词数),……}

2.环境说明 2.1系统硬件 处理器:Intel Core i3-2350M CPU@2.3GHz×4 内存:2GB 磁盘:60GB 2.2系统软件 操作系统:Ubuntu 14.04 LTS 操作系统类型:32位 Java版本:1.7.0_85 Eclipse版本:3.8 Hadoop插件:hadoop-eclipse-plugin-2.6.0.jar Hadoop:2.6.1 2.3集群配置 集群配置为伪分布模式,节点数量一个 3.实验设计 3.1第一部分设计

hadoop常用算法例子解读

基本MapReduce模式计数与求和基本MapReduce模式计数与求和 问题陈述: 有许多文档,每个文档都有一些字段组成。需要计算出每个字段在所有文档中的出现次数或者这些字段的其他什么统计值。例如,给定一个log文件,其中的每条记录都包含一个响应时间,需要计算出平均响应时间。 解决方案: 让我们先从简单的例子入手。在下面的代码片段里,Mapper每遇到指定词就把频次记1,Reducer一个个遍历这些词的集合然后把他们的频次加和。 1.class Mapper 2. method Map(docid id, doc d) 3. for all term t in doc d do 4. Emit(term t, count 1) 5. 6.class Reducer 7. method Reduce(term t, counts [c1, c2,...]) 8. sum = 0 9. for all count c in [c1, c2,...] do 10. sum = sum + c 11. Emit(term t, count sum) 复制代码 这种方法的缺点显而易见,Mapper提交了太多无意义的计数。它完全可以通过先对每个文档中的词进行计数从而减少传递给Reducer的数据量: [size=14.166666030883789px] 1. 1 class Mapper 2. 2 method Map(docid id, doc d) 3. 3 H = new AssociativeArray 4. 4 for all term t in doc d do 5. 5 H{t} = H{t} + 1

面试必过——50个最受欢迎的Hadoop面试问题

50个最受欢迎的Hadoop面试问题 您是否打算在大数据和数据分析领域找到工作?您是否担心破解Hadoop面试? 我们整理了一份方便的Hadoop面试问题清单。您可能具有关于软件框架的丰富知识,但是在短短的15分钟面试环节中无法测试所有这些知识。因此,面试官会问您一些特定的大数据面试问题,他们认为这些问题易于判断您对主题的了解。 立即注册:Hadoop基础在线培训课程 Hadoop面试的前50名问答 当前,与大数据相关的工作正在增加。五分之一的大公司正在迁移到大数据分析,因此现在是时候开始申请该领域的工作了。因此,我们不需再拖延地介绍Hadoop面试的前50名问答,这将帮助您完成面试。 Hadoop基本面试问题 这些是您在大数据采访中必将面对的最常见和最受欢迎的大数据Hadoop采访问题。通过准备这些Hadoop面试问题,无疑会给您带来竞争优势。 首先,我们将重点关注人们在申请Hadoop相关工作时遇到的常见和基本的Hadoop 面试问题,无论其职位如何。

1. Hadoop框架中使用了哪些概念? 答:Hadoop框架在两个核心概念上起作用: ?HDFS:Hadoop分布式文件系统的缩写,它是一个基于Java的文件系统,用于可扩展和可靠地存储大型数据集。HDFS本身在主从架构上工作,并以块 形式存储其所有数据。 ?MapReduce:这是用于处理和生成大型数据集的编程模型以及相关的实现。 Hadoop作业基本上分为两个不同的任务作业。映射作业将数据集分解为键 值对或元组。然后,reduce作业获取map作业的输出,并将数据元组合并 为较小的元组集。 2.什么是Hadoop?命名Hadoop应用程序的主要组件。 答:Hadoop是“大数据”问题的解决方案。Hadoop被描述为提供许多用于存储和处理大数据的工具和服务的框架。当难以使用传统方法进行决策时,它在大数据分析和制定有效的业务决策中也起着重要作用。 Hadoop提供了广泛的工具集,可以非常轻松地存储和处理数据。以下是Hadoop的所有主要组件:

信息检索与搜索引擎技术_实验3 倒排索引、正排索引

XXXX大学信息工程与自动化学院学生实验报告 课程名称:信息检索与搜索引擎技术 一、上机目的及内容 1.上机目的 熟悉索引的作用和重要性; 熟悉正排索引和倒排索引及其建立; 2.上机内容 对 Doc1:清华/大学/清华/主页 Doc2:世纪/清华 Doc3:北京/大学 建立正排索引和倒排索引 二、实验环境 Windows操作系统 PC机一台,MyEclipse 三、实验原理 将词项集合建立成为倒排索引的过程分为两个步骤:首先要将文本词项集合处理成正排索引,在建立正排索引的时候把词项列表的结构建立起来;然后再有正排索引建立成倒排索引. 正排索引的建立方法: 1.顺序扫描集合中的词项.

2.当遇到在文档中第一次出现的词项时,要更新词项表,如果词项列表中已近含有这个 词,则把改词的DF加1,否则添加这个词项,置DF为1. 3.然后处理词项,生成词项的出现记录信息,插入到对应词项的Hit List中。 正排索引建立完成之后,依照索引中的WordID 为单位,将DocID进行填充,然后按照WordID对所有单位进行从小到大的排序,就可以得到基本的倒排索引。要得到由WordID为键值的索引项,只需要再将WordID和DocID的存贮位置互换,并按照WordID进行归并即可。最后再将词项列表中的Pointer指针置为指向对应词项的索引项存储地址。这样得到的索引就可以用来进行检索了。 四、实验记录 package com.liu.suoyin; import java.util.*; public class Suoyin { public static void main(String[] args) { Zhengpai zp=suoyin(); daopai(zp); } public static Zhengpai suoyin(){ String[][] doc ={{"清华","大学","清华","主页"},{"世纪","清华"},{"北京","大学"}}; List 计算机新技术论文 论文题目:搜索引擎索引技术 课程名称:计算机新技术 专业: 班级: 学号: 姓名: 搜索引擎索引技术 摘要:近期两类国内搜索引擎技术的研究状况:爬虫系统性能优化技术研究及高级文件搜索引擎核心技术研究。爬虫系统性能优化侧重于:对爬行方式的优化实现海量信息源的高效索引;对URL 数据库存取算法的优化提高用户检索的响应速度。高级文件搜索引擎研究是通过对字符串匹配的扩展、属性过滤的扩展、查询结果优化排序、输出结果的优化选择等7 种核心技术的有效结合,丰富了文件搜引擎的功能。 关键词:互联网搜索引擎爬虫技术检索技术 搜索引擎作为网络信息搜寻的工具,它以一定的策略在互联网中搜集、发现信息,对信息进行理解、提取、组织和处理,并为用户提供检索服务。早期的搜索引擎将互联网中的资源服务器做为搜索的目标,并将收集的数据按概念进行分类,用户从分类引导中索取所需的信息资源。随着网络资源成几何量级增长, 这种方式很快就被淘汰。1994年,Spider 程序被应用到索引程序中,Yahoo 、Google等相继出现,搜索引擎技术在应用和性能方面得到长足进步。但至今,功能再强大的搜索引擎都仍然存在信息丢失、招回率不高、精确率不高等问题。用户需要更快、更准、更方便、更有效的查询服务成为搜索引擎技术发展研究追求的目标。2003 年3 月“全国首届搜索引擎和网上信息挖掘学术研讨会”在北京大学举行,该会收录论文30篇,基本反映了当前国内研究状况及进展,本文将其中最具代表性的Igloo1. 2 版网络搜索引擎和天网FTP 搜索引擎关键技术的研究状况做一介绍。 现在的数据库通常只是将信息简单地数字化和有序化,无法根据各类读者的需要组合成特定的知识体系。怎样让读者在众多信息源中迅速、直接选中自己所要检索的相关信息,能不能将信息整理、筛选,划分成许多类别分明、有特色的“知识块”,以利于读者使用呢? 知识仓库的出现,为我们解决相关问题提供了有效的技术手段。20 世纪90 年代,西方管理学家提出了知识管理的概念,认为采用现代信息技术和手段将信息加工整理成为知识,并对这些知识按照某种知识结构进行有效的管理,形成具有规定使用功能的数据仓库,也就是知识仓库。数字图书馆应用系统是进行数字化建设及整合各类数字资源的基础平台,它支持对知识和数字资源的采集、加工、处理、存储、归档、组织、发布和利用等全过程。知识仓库是数字图书馆资源建设的核心内容之一。随着信息数字化进程的加快,图书馆的工作重心开始向数字信息的描述、管理和服务转移。利用现代信息技术将更多的特色资源和常用资源数字化,通过DC 元数据的应用,可以对知识资源实现横向和纵向整合,通过建立DC、MARC 等多种元数据的关联,并以XML 结构的RDF 资源描述体系封装整合多种元数据,实现对数字资源的综合整合,最终实现文本、图像、音频、视频等不同媒体,图书、期刊、会议录、学位论文等不同类型,书目、文摘、索引、引文、综述、评论、全文等不同级次资源的链接,建立起文献、机构、人 基于Hadoop 的云计算算法研究 辛大欣,屈伟 (西安工业大学陕西西安710021) 摘要:随着科技技术的发展,数据呈现几何级的增长,面对这个情况传统存储服务无法满足复杂数据慢慢地暴露出来,传统的存储计算服务不仅浪费着极大的资源,还对于环境有着极大的不利影响。在这个大环境下云计算应势而生。本论文将针对目前的存储服务无法满足复杂数据的问题,研究云存储中的任务调度技术。通过与Hadoop 平台结合的试验对于现有的三种算法进行算法的实现过程的研究以及结果的对比。关键词:云计算;数据存储;任务调度技术;低碳节能中图分类号:TP302 文献标识码:A 文章编号:1674-6236(2013)03-0033-03 Cloud computing algorithm research based on Hadoop XIN Da -xin ,QU Wei (Xi ’an Technological University ,Xi ’an 710021,China ) Abstract:With the development of technologies ,data exponentially growth ,face the situation of traditional storage service can not satisfy the complicated data slowly emerged ,the traditional storage calculation service is not only a waste of a great resource ,but also for the environment has a great adverse effects.In the environment of cloud computing should situation and unripe.This paper will analyze the current storage service can not satisfy the complicated data ,study the cloud task scheduling technology.With the Hadoop platform with experiment for three kinds of existing algorithm algorithm implementation process and research results. Key words:cloudcomputing ;virtualization ;taskscheduling algorithms ;low -carbon energy 收稿日期:2012-09-24 稿件编号:201209170 作者简介:辛大欣(1966—),男,陕西西安人,硕士,副教授。研究方向:计算机网络,人工智能,云计算。 随着信息技术的不断提高,信息和数据呈现几何级的增长,大量的数据需要处理。在这种环境下,单点存储的问题已逐步暴露。 区域问题:单点存储,使用户在外出需要克服相当大的网络延迟访问服务。同时,为了方便维修,升级等问题使得存储数据选择的位置变得相对困难。 灾难恢复问题:当系统崩溃后必须被恢复时,如果数据存储备份被破坏将导致灾难性的后果。假如盲目地支持多个备份,不仅本身就是一种资源浪费,而且多个数据备份之间的一致性和可用性也是一个棘手的问题。 可扩展性问题:单点存储在可扩展性方面有很多问题。每个额外需要增加的功能或者服务都需要重新对硬件软件的结构进行重新设计和配置。同时对于硬件的更新也会带来巨大的麻烦。 管理费用:单点存储需要很多额外的管理开销,如机房,服务集群功率消耗,以及专门的数据管理开销和人员的培训费用。据统计仅数据中心的碳排放量占碳的总排放量百分之二,排放量达到约35000000吨每年。 有些公司电力成本每年超过硬件投资。在电力分配中,服务器设备占52%的总能源消耗,冷却系统和电力系统各38%和9%,只有1%的照明系统。面对这种严峻的形势下,构 建节能绿色数据中心已成为焦点。 云计算在节约能源方面的特点正好符合了”低碳节能”的思想。 1)通过使用云计算,提高了设备的利用资源,减少数据 中心能耗,同时避免经济损失造成的闲置设备。云“自我服务”的计算架构将大大降低成本和管理,可以节省资源。 2)使用公共云服务,企业只需购买云计算服务,根据自 己的需要,不需要购买电脑设备,尤其是不需要购置管理服务和数据中心的服务器,从而达到节约能耗的目的。 3)使用云桌面终端接入,没有笨重的机箱和风扇声。减 少功率消耗,减少热量,每个用户平均耗电量小于25瓦,大大降低了能源消耗,每年可节省近70%的电力供应。 从上面可以看出云计算可以解决目前单点存储的局限性以,而且对于资源的节约有很好的效果。下面对于云计算中的3种方法进行研究。 1 在Hadoop 云计算框架中的调度算法 1.1 FIFO 算法 FIFO 调度算法中所有的用户任务都被提交到一个队列 中,然后由TaskTracker 按照任务的优先级(比如提交时间的 电子设计工程 Electronic Design Engineering 第21卷 Vol.21 第3期No.32013年2月Feb.2013 -33- 搜索引擎核心技术解密 经过十几年的发展,搜索引擎已经成为互联网的重要入口之一,全球互联网上访问量最大的十个网站之一Twitter联合创始人埃文.威廉姆斯提出了“域名已死轮”:好记的域名不再重要,因为人们会通过搜索进入网站。搜索引擎的排名对于中小网站流量来说至关重要了,了解搜索引擎简单界面背后的技术原理其实对很多人都很重要 授课对象: 一、对搜索引擎核心算法有兴趣的技术人员 1、搜索引擎的整体框架是怎样的?包含哪些核心技术? 2、网络爬虫的基本架构师什么?常见的爬取策略是什么?什么是暗网爬取?如何构建分布式爬虫?百度的阿拉丁计划是 3、什么是倒排索引?如何对倒排索引进行数据压缩? 4、搜索引擎如何对搜索结果排序? 5、什么是向量空间模型?什么是概率模型?什么是BM25模型?什么是机器学习排序?它们之间有何异同? 6、PageRank和HITS算法是什么关系?有何异同?SALSA算法是什么?Hilltop算法又是什么?各种链接分析算法之间是什么关系? 7、如何识别搜索用户的真实搜索意图?用户搜索目的可以分为几类?什么是点击图?什么是查询会话?相关搜索是如何做到的? 8、为什么要对网页进行去重处理?如何对网页进行去重?哪种算法效果较好? 9、搜索引擎缓存有几级结构?核心策略是什么? 10、什么是情境搜索?什么是社会化搜索?什么是实时搜索? 二、对云计算与云存储有兴趣的技术人员 1、什么是CAP原理?什么是ACID原理?它们之间有什么异同? 2、Google的整套云计算框架包含哪些技术?Hadoop系列和Google的云计算框架是什么关系? 3、Google的三驾马车GFS、BigTable、MapReduce各自代表什么含义?是什么关系? 4、Google的咖啡因系统的基本原理是什么? 5、Google的Pregel计算模型和MapReduce计算模型有什么区别? 6、Google的Megastore云存储系统和BigTable是什么关系? 7、亚马逊公司的Dynamo系统是什么? Hadoop练习题 姓名:分数: 单项选择题 1.下面哪个程序负责HDFS数据存储。 a)NameNode b)Jobtracker c)Datanode√ d)secondaryNameNode e)tasktracker 2.HDfS中的block默认保存几份? a)3份√ b)2份 c)1份 d)不确定 3.下列哪个程序通常与NameNode在一个节点启动? a)SecondaryNameNode b)DataNode c)TaskTracker d)Jobtracker√ 4.Hadoop作者 a)Martin Fowler b)Kent Beck c)Doug cutting√ 5.HDFS默认Block Size a)32MB b)64MB√ c)128MB 6.下列哪项通常是集群的最主要的性能瓶颈 a)CPU b)网络 c)磁盘√ d)内存 7.关于SecondaryNameNode哪项是正确的? a)它是NameNode的热备 b)它对内存没有要求 c)它的目的是帮助NameNode合并编辑日志,减少NameNode启动时间√d)SecondaryNameNode应与NameNode部署到一个节点 8.一个gzip文件大小75MB,客户端设置Block大小为64MB,请我其占用几个Block?a)1 b)2√ c)3 d)4 9.HDFS有一个gzip文件大小75MB,客户端设置Block大小为64MB。当运行mapreduce任务读取该文件时input split大小为? a)64MB b)75MB√ c)一个map读取64MB,另外一个map读取11MB 10.HDFS有一个LZO(withindex)文件大小75MB,客户端设置Block大小为64MB。当运行mapreduce任务读取该文件时input split大小为? a)64MB b)75MB c)一个map读取64MB,另外一个map读取11MB√ 多选题: 11.下列哪项可以作为集群的管理工具 a)Puppet√ b)Pdsh√ c)Cloudera Manager√ d)Rsync + ssh + scp√ 12.配置机架感知的下面哪项正确 a)如果一个机架出问题,不会影响数据读写√ b)写入数据的时候会写到不同机架的DataNode中√ c)MapReduce会根据机架获取离自己比较近的网络数据√ 13.Client端上传文件的时候下列哪项正确 a)数据经过NameNode传递给DataNode 第39卷 第10期 2016年10月计 算 机 学 报CHINESEJOURNALOFCOMPUTERSVol.39No.10Oct.2016 收稿日期:2015-04-07;在线出版日期:2015-10-13.本课题得到国家自然科学基金(61100022,61472069) 、国家“八六三”高技术研究发展计划项目基金(2012AA011004)、中央高校基本科研业务费专项资金资助项目(N130404014)资助.白 梅,女,1986年生, 博士研究生,主要研究方向为流数据管理和不确定数据管理.E-mail:baimei861221@163.com.信俊昌,男,1977年生, 博士,副教授,主要研究方向为分布式数据管理与传感数据集成.王国仁,男,1966年生,博士,教授,博士生导师,主要研究领域为数据库、大数据管理.王习特,男,1987年生,博士研究生,中国计算机学会(CCF)会员,主要研究方向为大数据管理.数据流上动态轮廓查询处理技术的研究 白梅 信俊昌 王国仁 王习特 (东北大学信息科学与工程学院 沈阳 110004) 摘 要 轮廓查询(Skyline)是一种典型的多目标优化问题.动态轮廓查询(DynamicSkyline) 是轮廓查询的一个重要变种,其目标是对于一个给定的查询点q ,返回在各维度上最接近q 的所有点.对比轮廓查询,动态轮廓查询根据 查询点q 的位置变动, 可以更加灵活地返回查询结果.文中关注数据流上动态轮廓查询处理,此问题在多目标决策方面具有非常重要的应用.为有效地解决该问题,首先提出了一种组合式索引结构来管理数据流上的点,该索引结 构包括两个部分: 对整体数据使用分层次划分结构进行维护;对子划分内部数据采用倒排索引结构进行维护.该组合式索引结构具有更新快、过滤性能高、适合任意数据分布等优点,可以提高动态轮廓的查询处理效率.然后,基于 该组合式索引结构,提出了基础的数据流上动态轮廓查询算法(BasicDynamicSkylineQueryoverDataStream, BDS2).通过维护少量的数据,BDS2可以快速地计算出数据流上的动态轮廓集合. 然而BDS2在处理个别更新时,会有较大的时间延迟,为了更稳定地计算数据流上的动态轮廓,避免更新某些点时计算量急剧增加,进一步提出了改进的数据流上动态轮廓查询算法(ImprovedDynamicSkylineQueryoverDataStream,IDS2). 最后,通过一系列的实验验证了文中所提出算法的有效性. 关键词 数据流;动态轮廓;组合式索引;分层次划分;倒排索引 中图法分类号TP391 DOI 号10.11897/SP.J.1016.2016.02007 Research on D y namic Sk y line Q uer y Processin g over Data Streams BAIMei XINJun-Chang WANGGuo-Ren WANGXi-Te (Colle g e o f In f ormation Science &En g ineerin g ,Northeastern Universit y ,Shen y an g 110004) Abstract Skylinequeryisatypicalmulit-objectiveoptimizationproblem.DynamicSkylineisanimportantvariantofskylineoperator.Givenaquerypointq ,dynamicskylinequerycanreturnthetupleswhichareclosetoq inallthedimensions.Comparingwiththeskylinequery,dynamicskylinecanreturntheresultflexiblybychanginglocationsofthequerypointq .Inthispaper,wefocusonthedynamicskylinequeryproblemoverthedatastream,whichplaysaveryimportantroleinthemulti-criteriadecisionmaking.Tosolvethisproblemefficiently,firstly,weproposeacombinedindexstructuretomanagethedatainthedatastream.Thecombinedindexstructurecontainstwoparts:thewholedataaremanagedbyahierarchicaldivisionstructure;thedataintheleafdivisionaremanagedbyaninvertedindexstructure.Thiscombinedindexstructurehassomeadvantages,suchasbeupdatedfast,havehighfilteringcapacityandbesuitableforarbitrarydatadistributions.Itcanacceleratethespeedofupdateoperationoverthedatastreamandimprovetheperformanceofdynamicskylinecalculation.Secondly,basedonthiscombinedindex,wepropose thebasicdynamicskylinequeryalgorithmoverdatastreams(BDS2forshort) ,whichcanquickly万方数据 课程考试(论文) 作业(论文)题目: 全文检索中的索引策略 所修课程名称: Ajax 技术 修课程时间: 2011 年 03 月至 2011 年 05 月 完成作业(论文)日期: 2011 年 06 月 评阅成绩: 评阅意见: 评阅教师签名: 年 月 日 __ _ _ 计算机科学__ __ 系__ __ 08__ __级____ 软件工程___ _专业 姓名_ ___** ____ 学号__ __20 08090112_ _ _ _ … … … … … …… … … ……… (密 ) … … … … … … …… … … … …( 封 ) … …… … … … …… … … …… ( 线 ) …… … …… …… … … … … … 基于HibernateSearch+Ajax全文检索中的索引策略 ** (四川文理学院计算机科学系,四川 ** 123456) 摘要:本文主要讲解全文检索中的索引的种类、发展、实现原理。索引文件有多种组织形式,其中以正排表、倒排表、后继数组模型以及互关联后继数组模型比较常用。下面主要详细列举介绍Lucene倒排索引的组织形式以及实现原理。 关键词:索引;搜索引擎;全文检索;Lucene倒排索引;实现原理; Based on HibernateSearch + Ajax full text search the index of the strategy ** (Department of Computer Science, Sichuan University of Arts and Science, **123456,China)Abstract: this paper explained the index of the full text search the kinds, development and realize the principle. The index DuoZhong organization form, among them with are row watch, inverted table, subsequent array model and mutual association subsequent array model is commonly used. Below are the main detailed introduced Lucene inverted index the form of organization as well as the realization principle. Key words:index; Search engine; Full text search; Lucene inverted index; 1引言 使用索引可快速访问数据库表中的特定信息。索引是对数据库表中一列或多列的值进行排序的一种结构,例如 employee 表的姓(name)列。如果要按姓查找特定职员,与必须搜索表中的所有行相比,索引会帮助您更快地获得该信息。 索引是一个单独的、物理的数据库结构,它是某个表中一列或若干列值的集合和相应的指向表中物理标识这些值的数据页的逻辑指针清单。 在搜索引擎实际的应用之中,有时需要按照关键字的某些值查找记录,所以我们是按照关键字建立索引,这个索引我们就称之为——倒排索引,而带有倒排索引的文件我们又称作——倒排索引文件,也可以叫它为——倒排文件,来实现快速的检索与高速的效率。 基金项目:四川**学院2011年科研项目(2011B02Z);2011年四川省教育厅重点项目(11ZA172) 作者简介:**(1989-11-15),男,汉族,四川巴**市人,本科在读,研究方向为软件工程。搜索引擎索引技术

基于Hadoop的云计算算法研究

搜索引擎核心技术解密

hadoop练习题--带答案

数据流上动态轮廓查询处理技术的研究

全文检索中的索引策略-倒排索引