Windows系统下实现cfx与fluent的分布式并行计算

Windows系统下实现cfx与fluent的分布式并行计算

1、用户设置

用户账户设置:用户账户,是指登陆界面的Windows系统用户。在需要并行的多台计算机上分别设置具有相同名称的管理员账户和相同的密码,本例每台计算机上都新建一个管理员用户:cfx,密码:123456。

计算机名设置:计算机名,是“我的电脑”-“属性”-“计算机名”。这一步不是必要的,主要是便于安装ANSYS软件和编辑计算文件方便。本例给每台计算机依次设置了“winpc1”,“winpc2”,……,“winpcn”。

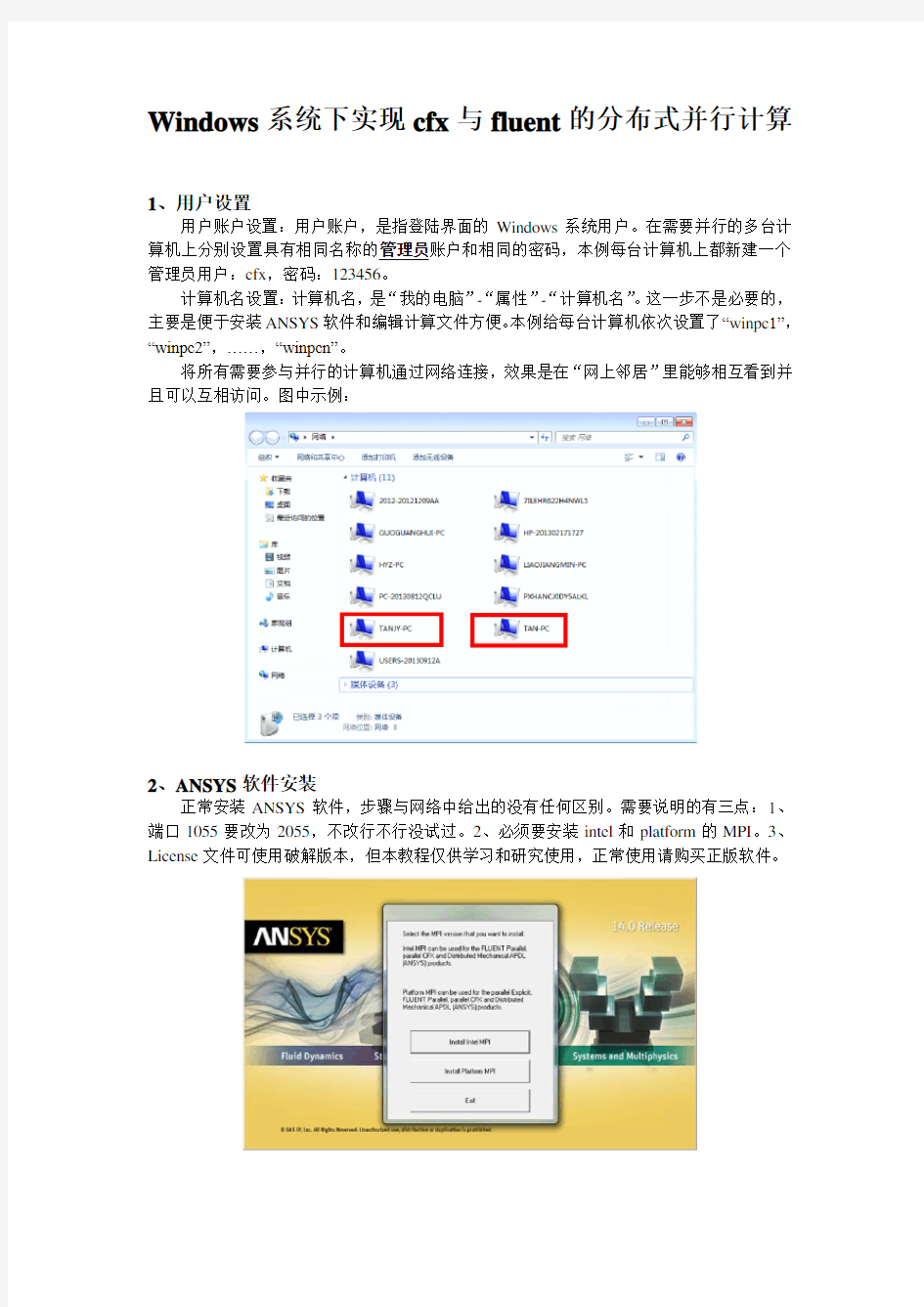

将所有需要参与并行的计算机通过网络连接,效果是在“网上邻居”里能够相互看到并且可以互相访问。图中示例:

2、ANSYS软件安装

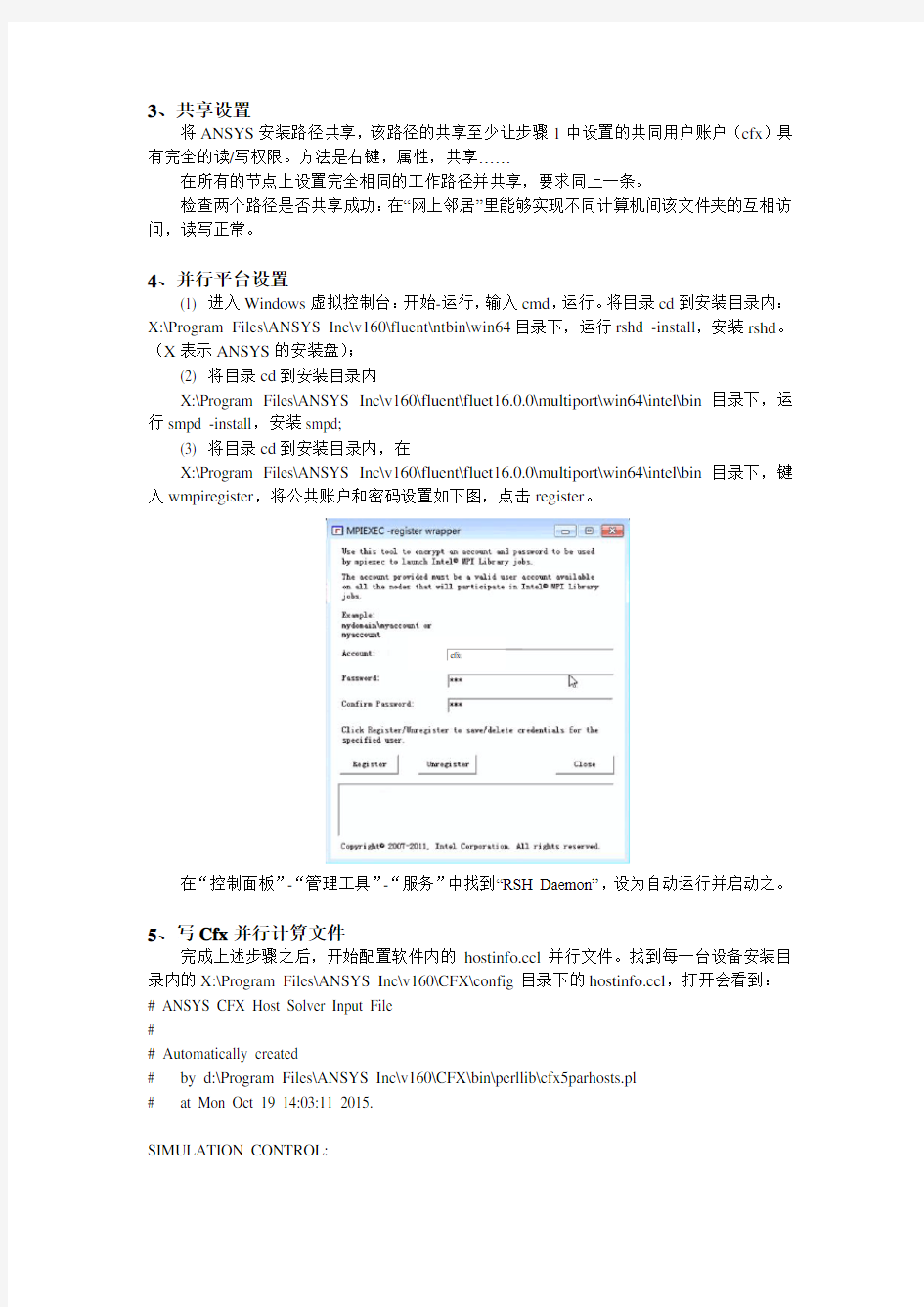

正常安装ANSYS软件,步骤与网络中给出的没有任何区别。需要说明的有三点:1、端口1055要改为2055,不改行不行没试过。2、必须要安装intel和platform的MPI。3、License文件可使用破解版本,但本教程仅供学习和研究使用,正常使用请购买正版软件。

3、共享设置

将ANSYS安装路径共享,该路径的共享至少让步骤1中设置的共同用户账户(cfx)具有完全的读/写权限。方法是右键,属性,共享……

在所有的节点上设置完全相同的工作路径并共享,要求同上一条。

检查两个路径是否共享成功:在“网上邻居”里能够实现不同计算机间该文件夹的互相访问,读写正常。

4、并行平台设置

(1) 进入Windows虚拟控制台:开始-运行,输入cmd,运行。将目录cd到安装目录内:X:\Program Files\ANSYS Inc\v160\fluent\ntbin\win64目录下,运行rshd -install,安装rshd。(X表示ANSYS的安装盘);

(2) 将目录cd到安装目录内

X:\Program Files\ANSYS Inc\v160\fluent\fluet16.0.0\multiport\win64\intel\bin目录下,运行smpd -install,安装smpd;

(3) 将目录cd到安装目录内,在

X:\Program Files\ANSYS Inc\v160\fluent\fluet16.0.0\multiport\win64\intel\bin目录下,键入wmpiregister,将公共账户和密码设置如下图,点击register。

cfx

在“控制面板”-“管理工具”-“服务”中找到“RSH Daemon”,设为自动运行并启动之。

5、写Cfx并行计算文件

完成上述步骤之后,开始配置软件内的https://www.360docs.net/doc/5e10530059.html,l并行文件。找到每一台设备安装目录内的X:\Program Files\ANSYS Inc\v160\CFX\config目录下的https://www.360docs.net/doc/5e10530059.html,l,打开会看到:# ANSYS CFX Host Solver Input File

#

# Automatically created

# by d:\Program Files\ANSYS Inc\v160\CFX\bin\perllib\cfx5parhosts.pl

# at Mon Oct 19 14:03:11 2015.

SIMULATION CONTROL:

EXECUTION CONTROL:

PARALLEL HOST LIBRARY:

HOST DEFINITION: winpc1

Remote Host Name = winpc1

Installation Root = d:\Program Files\ANSYS Inc\v%v\CFX

Host Architecture String = winnt-amd64

END # HOST DEFINITION winpc1

END # PARALLEL HOST LIBRARY

END # EXECUTION CONTROL

END # SIMULATION CONTROL

将红色部分复制多份(对应参与并行的节点个数),然后分别修改计算机名为winpc1、winpc2、……、winpcn。完成后https://www.360docs.net/doc/5e10530059.html,l文件内的效果为:

# ANSYS CFX Host Solver Input File

#

# Automatically created

# by d:\Program Files\ANSYS Inc\v160\CFX\bin\perllib\cfx5parhosts.pl

# at Mon Oct 19 14:03:11 2015.

SIMULATION CONTROL:

EXECUTION CONTROL:

PARALLEL HOST LIBRARY:

HOST DEFINITION: winpc1

Remote Host Name = winpc1

Installation Root = X:\Program Files\ANSYS Inc\v%v\CFX

Host Architecture String = winnt-amd64

END # HOST DEFINITION winpc1

HOST DEFINITION: winpc2

Remote Host Name = winpc2

Installation Root = X:\Program Files\ANSYS Inc\v%v\CFX

Host Architecture String = winnt-amd64

END # HOST DEFINITION winpc2

……

……

……

HOST DEFINITION: winpcn

Remote Host Name = winpcn

Installation Root = X:\Program Files\ANSYS Inc\v%v\CFX

Host Architecture String = winnt-amd64

END # HOST DEFINITION winpcn

END # PARALLEL HOST LIBRARY

END # EXECUTION CONTROL

END # SIMULATION CONTROL

将写好的https://www.360docs.net/doc/5e10530059.html,l文件分别覆盖原位置的https://www.360docs.net/doc/5e10530059.html,l文件,每台节点都必须更新该文件。

在Cfx计算设置界面,选择如下图,完成对应的设置,cfx分布式并行启成功。

6、Fluent并行设置

以fluent14.0为例,完成步骤4之后,直接通过此步设置fluent的分布式并行。

(1) 打开Fluent14.0如下图:

工作目录设置为之前建立的共享工作目录,如\\TAN-PC\fluent-work;

FLUENT启动目录为D:\Program Files\ANSYS Inc\v140\fluent\; (无需设置,自动显示) Processing Options处,Parallel per Machine File machine, Number of Process处设置启动核数;

(2) Parallel Settings设置如下图:

MPI类型处,选择intel;

Run Types处,选择Distributed Memory on Local Machine。选择Machine Names,分别写入上文提到的:winpc1,winpc2,……,winpcn (直接填入计算机名,以英文的逗号隔开)。也可写File Containing Machine Names,然后填入对于的文件。

3) 点击OK和Yes,忽略两个警告信息后成功启动多机并行Fluent。

ANSYS14.0和ANSYS16.0亲测有效,测试系统为Windows server 2008,4机并行。

仰望天空blog

2016.8.31

MATLAB分布式并行计算服务器配置和使用方法Word版

Windows下MATLAB分布式并行计算服务器配置和使用方 法 1MATLAB分布式并行计算服务器介绍 MATLAB Distributed Computing Server可以使并行计算工具箱应用程序得到扩展,从而可以使用运行在任意数量计算机上的任意数量的worker。MATLAB Distributed Computing Server还支持交互式和批处理工作流。此外,使用Parallel Computing Toolbox 函数的MATLAB 应用程序还可利用MATLAB Compiler (MATLAB 编译器)编入独立的可执行程序和共享软件组件,以进行免费特许分发。这些可执行应用程序和共享库可以连接至MATLAB Distributed Computing Server的worker,并在计算机集群上执行MATLAB同时计算,加快大型作业执行速度,节省运行时间。 MATLAB Distributed Computing Server 支持多个调度程序:MathWorks 作业管理器(随产品提供)或任何其他第三方调度程序,例如Platform LSF、Microsoft Windows Compute Cluster Server(CCS)、Altair PBS Pro,以及TORQUE。 使用工具箱中的Configurations Manager(配置管理器),可以维护指定的设置,例如调度程序类型、路径设置,以及集群使用政策。通常,仅需更改配置名称即可在集群间或调度程序间切换。 MATLAB Distributed Computing Server 会在应用程序运行时在基于用户配置文件的集群上动态启用所需的许可证。这样,管理员便只需在集群上管理一个服务器许可证,而无需针对每位集群用户在集群上管理单独的工具箱和模块集许可证。 作业(Job)是在MATLAB中大量的操作运算。一个作业可以分解不同的部分称为任务(Task),客户可以决定如何更好的划分任务,各任务可以相同也可以不同。MALAB中定义并建立作业及其任务的会话(Session)被称为客户端会话,通常这是在你用来编写程序那台机器上进行的。客户端用并行计算工具箱来定义和建立作业及其任务,MDCE通过计算各个任务来执行作业并负责把结果返

LBGK模型的分布式并行计算

万方数据

2LBGKD2Q9模型的并行计算 2.1数据分布 将流场划分成N。xN,的网格。设有P=只×Pv个进程参与并行计算,进程号P。=H以(0≤i<只,0≤J<尸v)。将数据按照重叠一条边的分块分布到各进程中。其中,进程P。存储并处理的数据网格点集,如图l所示。 图1进程珊存储并处理的区域(斜线处为重叠部分) 2.2交替方向的Jacobi迭代通信 Jacobi迭代是一类典型的通信迭代操作。文献[4】主要讨论了一个方向的Jacobi迭代。根据数据分布及计算要求,需要采用2个方向交替的Jacobi迭代通信操作。本文认为,“即发即收”的通信策略能有效避免完全的“先发后收”可能造成的通信数据“堆积”过多,从而避免数据的丢失。进程Pli的通信操作如下(见图2): (1)Ifi≠只一1then发送数据到进程P¨,; (2)Ifi≠0then从进程Pf_J,接收数据; (3)If,≠只-1then发送数据到进程Pml; (4)IfJ≠0then从进程P—l接收数据。 各进程并行执行上述操作。 图2交普方向的Jacobi迭代 2.3通信时间理论 由一般的通信模型可知,若发送、接收信息长度为n字节的数据所需时间为:丁(n)=口+n∥,其中,常数口为通信启动时间;∥为常系数,则上述一次交替方向的Jacobi迭代通信操作的时间约为 20e+2fl'N、.P,=1 P。=1 其他 其中,∥7=∥sizeof(double)。 一般情况下,当等3鲁,即等=鲁时,通信的数据量(字节数)是最少的,为4口+4∥,./丝堡。可见,通信的信息 V只×0 总量和通信时间随进程总数只×尸v的增加而减少。 由于c语言中数组是按“行”存放的(Fortran是按“列”存放的),当存放、发送列数据时,需要一定的辅助操作,这就增加了并行计算的计算时间,因此在只:Pv无法恰好等于Nx:N。时,需要综合考虑流场形状及大小、数据在内存中的按“行”(或按“列”)的存放方式,以确定数据的最佳分布方案。 3数值实验 数值实验是在“自强3000”计算机上进行的ou自强3000”计算机拥有174个计算结点,每个计算结点上有2个3.06CPU,2GB内存。本文的实验使用了其中的32个计算结点共64个CPU。程序采用MPI及C语言编写,程序执行时,每个计算结点中启动2个进程。数值实验针对不同规模的网格划分、不同进程数以及不同的数据分布方案进行了大量实验,测得如下结果:不同的流场规模对应着各自的最佳网格划分方式;计算次数越多,加速比越大,越能体现并行计算的优越性。 由表1数据可以得知,对于规模为Nx×N、,=400x400,数据划分成6×6块时的加速比最高,而对于MXNy=600x200,数据划分为12×3块则更具优越性。合适的划分方式可以使总体通信量减至最少,从而提高加速比和并行效率。另外,计算规模越大,加速比越大。 表1并行计算D2Q9模型的加速比(进程数为36) 在固定计算规模,增加处理器的情况下,并行系统的加速比会上升,并行效率会下降;在固定处理器数目,增加计算规模的情况下,并行系统的加速比和效率都会随之增加。 从表2可见,流场规模越大,并行计算的优越性越显著。因为此时计算规模(粒度)较大,相对于通信量占有一定的优势。由图3可见,加速比随进程数呈线性增长,这表明LBGKD2Q9模型的并行计算具有良好的可扩展性。 表2漉场规模固定时并行计算D2Q9模型的加速比 0816243240485664 numofprocess 图3藐场规模固定时D2Q9模型并行计算的加速比 4结束语 本文讨论了LBGKD2Q9模型的分布式并行计算,通过大量的数值实验重点研究了数据分布方案如何与问题规模匹配,以获得更高的并行效率的问题。展示了LBGK模型方法良好的并行性和可扩展性。得到了二维LBGK模型并行计算数据分布的一般原则、交替方向Jacobi迭代的通信策略。这些结论对进一步开展三维LBGK模型的并行计算及其他类似问题的并行计算有一定的指导意义。(下转第104页) 一101—万方数据

分布式与并行计算报告

并行计算技术及其应用简介 XX (XXX,XX,XXX) 摘要:并行计算是实现高性能计算的主要技术手段。在本文中从并行计算的发展历程开始介绍,总结了并行计算在发展过程中所面临的问题以及其发展历程中出现的重要技术。通过分析在当前比较常用的实现并行计算的框架和技术,来对并行计算的现状进行阐述。常用的并行架构分为SMP(多处理系统)、NUMA (非统一内存存储)、MPP(巨型并行处理)以及集群。涉及并行计算的编程模型有MPI、PVM、OpenMP、TBB及Cilk++等。并结合当前研究比较多的云计算和大数据来探讨并行计算的应用。最后通过MPI编程模型,进行了并行编程的简单实验。 关键词:并行计算;框架;编写模型;应用;实验 A Succinct Survey about Parallel Computing Technology and It’s Application Abstract:Parallel computing is the main technology to implement high performance computing. This paper starts from the history of the development of Parallel Computing. It summarizes the problems faced in the development of parallel computing and the important technologies in the course of its development. Through the analysis of framework and technology commonly used in parallel computing currently,to explain the current situation of parallel computing.Framework commonly used in parallel are SMP(multi processing system),NUMA(non uniform memory storage),MPP(massively parallel processing) and cluster.The programming models of parallel computing are MPI, PVM, OpenMP, TBB and Cilk++, etc.Explored the application of parallel computing combined with cloud computing and big data which are very popular in current research.Finally ,through the MPI programming model,a simple experiment of parallel programming is carried out. Key words:parallel computing; framework; programming model; application; experiment 1引言 近年来多核处理器的快速发展,使得当前软件技术面临巨大的挑战。单纯的提高单机性能,已经不能满足软件发展的需求,特别是在处理一些大的计算问题上,单机性能越发显得不足。在最近AlphaGo与李世石的围棋大战中,AlphaGo就使用了分布式并行计算技术,才能获得强大的搜索计算能力。并行计算正是在这种背景下,应运而生。并行计算或称平行计算时相对于串行计算来说的。它是一种一次可执行多个指令的算法,目的是提高计算速度,及通过扩大问题求解规模,解决大型而复杂的计算问题。可分为时间上的并行和空间上的并行。时间上的并行就是指流水线技术,而空间上的并行则是指用多个处理器并发的执行计算。其中空间上的并行,也是本文主要的关注点。 并行计算(Parallel Computing)是指同时使用多种计算资源解决计算问题的过程,是提高计算机系统计算速度和处理能力的一种有效手段。它的基本思想是用多个处理器来协同求解同一问题,即将被求解的问题分解成若干个部分,各部分均由一个独立的处理机来并行计算。并行计算系统既可以是专门设计的,含有多个处理器的超级计算机,也可以是以某种方式互联的若干台的独立计算机构成的集群。通过并行计算集群完成数据的处理,再将处理的结果返回给用户。 目前常用的并行计算技术中,有调用系统函数启动多线程以及利用多种并行编程语言开发并行程序,常用的并行模型有MPI、PVM、OpenMP、TBB、Cilk++等。利用这些并行技术可以充分利用多核资源适应目前快速发展的社会需求。并行技术不仅要提高并行效率,也要在一定程度上减轻软件开发人员负担,如近年来的TBB、Cilk++并行模型就在一定程度上减少了开发难度,提高了开发效率,使得并行软件开发人员把更多精力专注于如何提高算法本身效率,而非把时间和精力放在如何去并行一个算法。

华南理工大学分布式计算期末考试卷题整理

华南理工大学分布式计算期末考试卷题整 理 第一章:分布式 1)并行计算与分布式计算区别? (1)所谓分布式计算是一门计算机科学,它研究如何把一个需要非常巨大的计算能力才能 解决的问题分成许多小的部分,然后把这些部分分配给许多计算机进行处理,最后把这些 计算结果综合起来得到最终的结果。 与并行计算不同的是,并行计算是使用多个处理器并行执行单个计算。 2)分布式计算的核心技术是? 进程间通信IPC!!! 3)解决进程间通信死锁的两种方法? 超时和多线程 4)分布式系统的CAP理论是什么? 一致性,可用性,分区容忍性 第二章:范型 1)网络应用中使用的最多的分布式计算范型是? 客户-服务器范型(简称CS范型) 2)消息传递范型与消息中间件范型异同? 消息传递:一个进程发送代表请求的消息,该消息被传送到接受者;接受者处理该请求,并发送一条应答消息。随后,该应答可能触发下一个请求,并导致下一个应答消息。如 此不断反复传递消息,实现两个进程间的数据交换. 基于该范型的开发工具有Socket应用程序接口(Socket API)和信息传递接口(Message Passing Interface,MPI)等 消息系统模型可以进一步划分为两种子类型:点对点消息模型(Point- to-point message model)和发布订阅消息模型(Public/Subscribe message model)。 在这种模型中,消息系统将来自发送者的一条消息转发到接收者的消息 队列中。与基本的消息传递模型不同的是,这种中间件模型提供了消息 暂存的功能,从而可以将消息的发送和接受分离。与基本的消息传递模 型相比,点对点消息模型为实现异步消息操作提供了额外的一层抽象。 如果要在基本的消息传递模型中达到同样的结果,就必须借助于线程或 者子进程技术。 3)一个分布式应用能否使用多个分布式计算范型? 可以,部分。

分布式与并行计算报告

分布式与并行计算报告

————————————————————————————————作者:————————————————————————————————日期: ?

并行计算技术及其应用简介 XX (XXX,XX,XXX) 摘要:并行计算是实现高性能计算的主要技术手段。在本文中从并行计算的发展历程开始介绍,总结了并行计算在发展过程中所面临的问题以及其发展历程中出现的重要技术。通过分析在当前比较常用的实现并行计算的框架和技术,来对并行计算的现状进行阐述。常用的并行架构分为SMP(多处理系统)、NUMA(非统一内存存储)、MPP(巨型并行处理)以及集群。涉及并行计算的编程模型有MPI、PVM、Ope nMP、TBB及Cilk++等。并结合当前研究比较多的云计算和大数据来探讨并行计算的应用。最后通过MPI编程模型,进行了并行编程的简单实验。 关键词:并行计算;框架;编写模型;应用;实验 A Succinct SurveyaboutParallelComputing Technology and It’sApplication Abstract:Parallel computing is the main technology to implement high performance computing. Thispaper starts fromthe historyofthe development of Parallel Computing. It summarizes the problems faced in the development of parallel computingand the i mportant technologies in the course of itsdevelopment. Through theanalysis of framework andtechnologycommonly used inparallel computing currently,to explain the current situationofparallelcomputing.Framework commonlyused in parallel areSMP(multi processing system),NUMA(non uniform memory storage),MPP(massivel yparallel processing)and cluster.The programming models of parallelcomputing areMPI, PVM,OpenMP, TBB and Cilk++,etc.Explored the application ofparallel computing combinedwithcloudcomputingand big data whichare very popular incu rrentresearch.Finally ,through the MPI programming model,asimple experiment ofparallel programming iscarried out. Keywords:parallel computing; framework;programming model;application; experiment 1引言 近年来多核处理器的快速发展,使得当前软件技术面临巨大的挑战。单纯的提高单机性能,已经不能满足软件发展的需求,特别是在处理一些大的计算问题上,单机性能越发显得不足。在最近AlphaGo与李世石的围棋大战中,AlphaGo就使用了分布式并行计算技术,才能获得强大的搜索计算能力。并行计算正是在这种背景下,应运而生。并行计算或称平行计算时相对于串行计算来说的。它是一种一次可执行多个指令的算法,目的是提高计算速度,及通过扩大问题求解规模,解决大型而复杂的计算问题。可分为时间上的并行和空间上的并行。时间上的并行就是指流水线技术,而空间上的并行则是指用多个处理器并发的执行计算。其中空间上的并行,也是本文主要的关注点。 并行计算(Parallel Computing)是指同时使用多种计算资源解决计算问题的过程,是提高计算机系统计算速度和处理能力的一种有效手段。它的基本思想是用多个处理器来协同求解同一问题,即将被求解的问题分解成若干个部分,各部分均由一个独立的处理机来并行计算。并行计算系统既可以是专门设计的,含有多个处理器的超级计算机,也可以是以某种方式互联的若干台的独立计算机构成的集群。通过并行计算集群完成数据的处理,再将处理的结果返回给用户。 目前常用的并行计算技术中,有调用系统函数启动多线程以及利用多种并行编程语言开发并行程序,常用

ANSYS分布式并行计算步骤

ANSYS11.0分布式并行计算步骤 Example: Running Distributed ANSYS on Windows 一、准备工作 (1)在主从机上分别安装ansys11.0到相同的目录下。 (2)在主从机上分别注册相同的用户名(管理员身份)和密码。 (3)在主从机上分别安装dotnetfx.exe。 (4)在主从机上分别为ansys创建相同的工作目录。 (5)把测试例题命令流tutor1_carrier_win.inp复制到主机的工作目录下。 命令流位于C:\Program Files\ANSYS Inc\v110\ANSYS\data\models的目录下。 二、安装mpich2并进行测试 (1)在主从机上分别安装mpich2-1.0.3-1-win32-ia32.msi,此文件在C:\Program Files\ANSYS Inc\v110\ANSYS\MPICH2中,采用默认安装目录见下图。 (2)在运行开始>程序>MPICH2>wmpiregister,输入用户名和密码,单击register,单击OK,如图所示。 (3)单机测试:在主从机上分别在DOS模式下进入C:\Program Files\Ansys Inc\v110\ANSYS\bin\intel,运行ansys110 -np 2 -mpitest命令,见下图所示。 (3)打开C:\Program Files\Ansys Inc\v110\ANSYS\bin\intel,用记事本打开machines,进行编辑,见下图,其中A13A7DA13157493为主机计算机名,PC-200907230929为从机计算机名。必须为偶数个结点,每两个核构成一个结点,所以为核数为奇数。例如A13A7DA13157493电脑为4核,设置了2核,PC-200907230929为2核,设置了1核,3核构成2个结点。

分布式并行计算应用

分布式并行计算应用(一) 迎接P2P分布式并行计算今年是处理器的“双核年”。多年以来,Intel和AMD都在持续努力提升CPU计算能力,在单芯片频率达到近乎极限后,终于将CPU推入多内核时代。 现今的个人计算机,运算能力是早期大型计算机的百倍以上,这是拜软件业与硬件业互相促进之赐。众所周知的例子,是所谓“微软-英特尔”联盟,即操作系统和处理器相互刺激市场需求。市场竞合的结果,导致寡头垄断局面形成;在个人电脑市场上,两硬(Intel、AMD)一软(微软)分蛋糕分得不亦乐乎。 我们需要越来越快的计算机。人类追求极限的永恒需要,会让我们在追求更高计算能力的路上继续走下去。然而,“更高计算能力”并不一定意味着“更快的CPU”,所有CPU计算能力的总和,总是大于单个CPU,分布式并行计算,提供了让许多CPU 协同工作的可能性。 多CPU(多台计算机)协同,基本上是软件层面的问题,软件层面的问题,最终还是操作系统平台的问题。互联网给了Goo gle一个机会,把运算放到客户端去执行,这是一种聪明的做法——它意味着更少的中央服务器投入和更好的用户体验。Googl e持续推出基于Web的新服务,几乎让人觉得Web OS时代已经

到来。这判断为时过早,可以说,目前Web客户端平台运算能力相对于纯本地程序,是相当低下的;再者,浏览器本身,仍然需要在操作系统之上运行;其三,这种架构仍然没有将客户计算机有机地整合起来。 IBM等大公司,推网格计算概念已有多时,实质成果还不如小小一个BT/eMule来得大。P2P技术用在文件共享上,已经改变了整个娱乐业格局,如果它被应用于运算能力协同上,前途无可限量。 互联网会更加普及,未来所有个人设备都会随时在线,设备(客户端)是人类个体的智能代理。如果把每个设备看作CPU的一个内核,将能组成一个运算能力强大的多核CPU。过去几十年,计算机CPU和操作系统,一直在朝着高度集成化方向发展,导致软、硬件体系结构趋向于高度复杂,单机运算能力也在逼近极限。基于P2P的分布式并行计算,另辟蹊径,化解了单机高度集成带来的复杂度。 基于P2P的广域网分布式并行计算,有两个问题需要解决:第一,协同机制。客户端之间如何互相协作、如何分解问题、如何解决通讯导致的延迟、如何实现“热插拔”…… 第二,信用机制。WebService租用和ASP(Application S ervice Provider)未能变成主流市场,很大程度上是因为信用机制不够健全。信用有两个层面,一个是信用观念,一个是信用技术,前者取决于后者。

分布式并行计算论文

基于Hadoop分布式爬虫设计综述 摘要:由于Internet规模不断扩大,包罗万象的信息资源被连接在一起,形成了一个广阔宏大的信息空间"在这个空间中,存在着海量的信息,如何快速高效和安全地让网络用户在如此浩瀚的信息海洋之中找到并获取自己所需的资源,是当前互联网发展的最大挑战之一。如今,云计算已成为当前的重要趋势之一。本文主要阐述在Hadoop分布式文件系统HDFS以及分布式计算框架MapReduce的基础上开发的分布式搜索引擎的爬虫设计相关技术、原理、流程图。 关键词:云计算分布式爬虫Hadoop 搜索引擎 1 引言 随着搜索引擎的发展,搜索引擎所采用的技术也随之变得丰富和多样化,能够适应不同搜索用户以及不同搜索目的的需要。目前,搜索引擎的性能指标主要有三个:首先考虑的是规模的大小,只有规模达到一定的数量级,用户搜索结果的符合度才能够达到满足不同用户的需求程度;其次是性能,搜索引擎的网络蜘蛛必须在一个较短的时间内完成对目标网络的信息搜索,同时,能够在用户可容忍的时间段内,完成搜索结果的反馈;最后是搜索的质量,能够去掉信息重复的网页,对一些无用信息进行过滤,能够准确返回用户想要的结果。 如何从庞大的资料库中找到正确的资料,被公认为是下一代搜索技术的竞争要点"要对海量的信息进行检索,单单依靠单台计算机的处理能力远远不够,即使硬件的发展速度很快,但是根本赶不上信息的增长速度。而若采用集群计算机实现,虽然可以解决处理速度问题,但由于从网络的整体上看,该集群仍是一个结点,会严重受制于网络带宽,因此,需要采用多台计算机进行分布式协同处理"。 分布式搜索引擎是通过网络把大范围的分布、异构数据集联合起来,形成一个逻辑整体,为用户提供分布式的信息检索服务。同传统搜索引擎相比,分布式搜索引擎有以下优点: 1)各检索服务器之间协同工作,每个服务器只搜索自身自治区域内的信息资源,彼此之间只传递搜索结果信息,加快了检索速度,减轻网络及各站点的负担; 2)与网络资源本身的分布式特性相适应,增加搜索服务器方便,有良好的可扩展性; 3)索引信息化分到各个数据库中,使得各索引数据库规模小,易于管理,缩短查询响应时间。 当今,大型网站的用户多,参与度广。因此,如何有效地为如此巨大的用户群

分布式与并行计算报告

分布式与并行计算 报告

并行计算技术及其应用简介 XX (XXX, XX,XXX) 摘要:并行计算是实现高性能计算的主要技术手段。在本文中从并行计算的发展历程开始介绍,总结了并行计算在发展过程中所面临的问题以及其发展历程中出现的重要技术。经过分析在当前比较常见的实现并行计算的框架和技术,来对并行计算的现状进行阐述。常见的并行架构分为SMP(多处理系统)、NUMA(非统一内存存储)、MPP(巨型并行处理)以及集群。涉及并行计算的编程模型有MPI、PVM、OpenMP、TBB及Cilk++等。并结合当前研究比较多的云计算和大数据来探讨并行计算的应用。最后经过MPI编程模型,进行了并行编程的简单实验。 关键词:并行计算;框架;编写模型;应用;实验 A Succinct Survey about Parallel Computing Technology and It’s Application Abstract:Parallel computing is the main technology to implement high performance computing. This paper starts from the history of the development of Parallel Computing. It summarizes the problems faced in the development of parallel computing and the important technologies in the course of its development. Through the analysis of framework and technology commonly used in parallel computing