实验报告:牛顿环与劈尖干涉

实验八牛顿环与劈尖干涉

实验时间:2011.04.28 实验人:陈燕纯

劈尖干涉牛顿环教案

12.5 劈尖干涉牛顿环 科目:大学物理学下 课型:新授课 课时:1课时 主要内容:等厚干涉原理劈尖干涉牛顿环 教学重点:劈尖干涉相邻条纹的间距;牛顿环的半径公式。 教学难点:根据等厚干涉图样的形成原理,理解不同的等厚干涉的条纹分布。教学要求:理解等厚干涉的原理,理解掌劈尖干涉图样条纹的分布特点,掌握劈尖干涉中相邻条纹间距与薄膜厚度的关系;理解牛顿环干涉图样的分 布特点,掌握牛顿环半径公式;了解等厚干涉的实际应用。 教学方法:讲授法讨论法 教学手段:多媒体 教学过程:(具体如下) 复习提问: 1.两同位相的相干光源,其干涉条纹的明暗条件与光程差的关系? 2.反射现象中半波损失的条件? 3.薄膜干涉中干涉光的来源?条纹的级数由什么决定? 新课导入: 我们已经学习过,光线入射在厚度均匀的薄膜上时,干涉条纹的级数由入射光的入射角决定,相同的入射角产生的干涉条纹的级数相同,因此称之为等倾干涉。 提问:当光线入射在厚度不均匀的薄膜上,产生的干涉条纹级数与哪些因素有关?明暗条纹如何分布?这种干涉现象有什么实际意义? 讲授新课: 一、劈尖干涉(只讨论单色平行光垂直入射情况) 1.装置:夹角很小的两个平面构成一个劈尖,厚度为零的地方称作“棱”。 单色平行光垂直照射在劈尖上,得到间距均匀的干涉条纹。

在劈尖表面看到的干涉条纹 劈尖内是空气薄膜或折射 率为n 的透明介质薄膜 2.光程差:先分析两束光在薄膜中的路程差,再分析半波损失。 结论:a.劈尖上与棱平行的点薄膜厚度相同,其反射光的光程差相同。 b.对空气薄膜: 3.干涉明暗条纹的条件(以空气薄膜为例): 结论:厚度相同的地方,光程差相等,条纹级数k 相同,所以称为等厚干涉。 4.各级明暗条纹的位置(即各级明暗条纹对应的薄膜厚度): 22λ+ =?ne 2 21λ+=?=e n ,???????=+=+=?==+=?暗条纹 明条纹,...2,1,02)12(22,...2,122k k e k k e λλλλ???????==-=暗纹 明纹),...2,1,02,......2,1221(k k k k k e λλ

数据挖掘实验报告

《数据挖掘》Weka实验报告 姓名_学号_ 指导教师 开课学期2015 至2016 学年 2 学期完成日期2015年6月12日

1.实验目的 基于https://www.360docs.net/doc/6e1776285.html,/ml/datasets/Breast+Cancer+WiscOnsin+%28Ori- ginal%29的数据,使用数据挖掘中的分类算法,运用Weka平台的基本功能对数据集进行分类,对算法结果进行性能比较,画出性能比较图,另外针对不同数量的训练集进行对比实验,并画出性能比较图训练并测试。 2.实验环境 实验采用Weka平台,数据使用来自https://www.360docs.net/doc/6e1776285.html,/ml/Datasets/Br- east+Cancer+WiscOnsin+%28Original%29,主要使用其中的Breast Cancer Wisc- onsin (Original) Data Set数据。Weka是怀卡托智能分析系统的缩写,该系统由新西兰怀卡托大学开发。Weka使用Java写成的,并且限制在GNU通用公共证书的条件下发布。它可以运行于几乎所有操作平台,是一款免费的,非商业化的机器学习以及数据挖掘软件。Weka提供了一个统一界面,可结合预处理以及后处理方法,将许多不同的学习算法应用于任何所给的数据集,并评估由不同的学习方案所得出的结果。 3.实验步骤 3.1数据预处理 本实验是针对威斯康辛州(原始)的乳腺癌数据集进行分类,该表含有Sample code number(样本代码),Clump Thickness(丛厚度),Uniformity of Cell Size (均匀的细胞大小),Uniformity of Cell Shape (均匀的细胞形状),Marginal Adhesion(边际粘连),Single Epithelial Cell Size(单一的上皮细胞大小),Bare Nuclei(裸核),Bland Chromatin(平淡的染色质),Normal Nucleoli(正常的核仁),Mitoses(有丝分裂),Class(分类),其中第二项到第十项取值均为1-10,分类中2代表良性,4代表恶性。通过实验,希望能找出患乳腺癌客户各指标的分布情况。 该数据的数据属性如下: 1. Sample code number(numeric),样本代码; 2. Clump Thickness(numeric),丛厚度;

数据分析实验报告

数据分析实验报告 文稿归稿存档编号:[KKUY-KKIO69-OTM243-OLUI129-G00I-FDQS58-

第一次试验报告 习题1.3 1建立数据集,定义变量并输入数据并保存。 2数据的描述,包括求均值、方差、中位数等统计量。 分析—描述统计—频率,选择如下: 输出: 统计量 全国居民 农村居民 城镇居民 N 有效 22 22 22 缺失 均值 1116.82 747.86 2336.41 中值 727.50 530.50 1499.50 方差 1031026.918 399673.838 4536136.444 百分位数 25 304.25 239.75 596.25 50 727.50 530.50 1499.50 75 1893.50 1197.00 4136.75 3画直方图,茎叶图,QQ 图。(全国居民) 分析—描述统计—探索,选择如下: 输出: 全国居民 Stem-and-Leaf Plot Frequency Stem & Leaf 5.00 0 . 56788 数据分析实验报告 【最新资料,WORD 文档,可编辑修改】

2.00 1 . 03 1.00 1 . 7 1.00 2 . 3 3.00 2 . 689 1.00 3 . 1 Stem width: 1000 Each leaf: 1 case(s) 分析—描述统计—QQ图,选择如下: 输出: 习题1.1 4数据正态性的检验:K—S检验,W检验数据: 取显着性水平为0.05 分析—描述统计—探索,选择如下:(1)K—S检验

结果:p=0.735 大于0.05 接受原假设,即数据来自正太总体。 (2 )W 检验 结果:在Shapiro-Wilk 检验结果972.00 w ,p=0.174大于0.05 接受原假设,即数据来自正太总体。 习题1.5 5 多维正态数据的统计量 数据:

数据挖掘实验报告(一)

数据挖掘实验报告(一) 数据预处理 姓名:李圣杰 班级:计算机1304 学号:1311610602

一、实验目的 1.学习均值平滑,中值平滑,边界值平滑的基本原理 2.掌握链表的使用方法 3.掌握文件读取的方法 二、实验设备 PC一台,dev-c++5.11 三、实验内容 数据平滑 假定用于分析的数据包含属性age。数据元组中age的值如下(按递增序):13, 15, 16, 16, 19, 20, 20, 21, 22, 22, 25, 25, 25, 25, 30, 33, 33, 35, 35, 35, 35, 36, 40, 45, 46, 52, 70。使用你所熟悉的程序设计语言进行编程,实现如下功能(要求程序具有通用性): (a) 使用按箱平均值平滑法对以上数据进行平滑,箱的深度为3。 (b) 使用按箱中值平滑法对以上数据进行平滑,箱的深度为3。 (c) 使用按箱边界值平滑法对以上数据进行平滑,箱的深度为3。 四、实验原理 使用c语言,对数据文件进行读取,存入带头节点的指针链表中,同时计数,均值求三个数的平均值,中值求中间的一个数的值,边界值将中间的数转换为离边界较近的边界值 五、实验步骤 代码 #include

数据挖掘实验报告资料

大数据理论与技术读书报告 -----K最近邻分类算法 指导老师: 陈莉 学生姓名: 李阳帆 学号: 201531467 专业: 计算机技术 日期 :2016年8月31日

摘要 数据挖掘是机器学习领域内广泛研究的知识领域,是将人工智能技术和数据库技术紧密结合,让计算机帮助人们从庞大的数据中智能地、自动地提取出有价值的知识模式,以满足人们不同应用的需要。K 近邻算法(KNN)是基于统计的分类方法,是大数据理论与分析的分类算法中比较常用的一种方法。该算法具有直观、无需先验统计知识、无师学习等特点,目前已经成为数据挖掘技术的理论和应用研究方法之一。本文主要研究了K 近邻分类算法,首先简要地介绍了数据挖掘中的各种分类算法,详细地阐述了K 近邻算法的基本原理和应用领域,最后在matlab环境里仿真实现,并对实验结果进行分析,提出了改进的方法。 关键词:K 近邻,聚类算法,权重,复杂度,准确度

1.引言 (1) 2.研究目的与意义 (1) 3.算法思想 (2) 4.算法实现 (2) 4.1 参数设置 (2) 4.2数据集 (2) 4.3实验步骤 (3) 4.4实验结果与分析 (3) 5.总结与反思 (4) 附件1 (6)

1.引言 随着数据库技术的飞速发展,人工智能领域的一个分支—— 机器学习的研究自 20 世纪 50 年代开始以来也取得了很大进展。用数据库管理系统来存储数据,用机器学习的方法来分析数据,挖掘大量数据背后的知识,这两者的结合促成了数据库中的知识发现(Knowledge Discovery in Databases,简记 KDD)的产生,也称作数据挖掘(Data Ming,简记 DM)。 数据挖掘是信息技术自然演化的结果。信息技术的发展大致可以描述为如下的过程:初期的是简单的数据收集和数据库的构造;后来发展到对数据的管理,包括:数据存储、检索以及数据库事务处理;再后来发展到对数据的分析和理解, 这时候出现了数据仓库技术和数据挖掘技术。数据挖掘是涉及数据库和人工智能等学科的一门当前相当活跃的研究领域。 数据挖掘是机器学习领域内广泛研究的知识领域,是将人工智能技术和数据库技术紧密结合,让计算机帮助人们从庞大的数据中智能地、自动地抽取出有价值的知识模式,以满足人们不同应用的需要[1]。目前,数据挖掘已经成为一个具有迫切实现需要的很有前途的热点研究课题。 2.研究目的与意义 近邻方法是在一组历史数据记录中寻找一个或者若干个与当前记录最相似的历史纪录的已知特征值来预测当前记录的未知或遗失特征值[14]。近邻方法是数据挖掘分类算法中比较常用的一种方法。K 近邻算法(简称 KNN)是基于统计的分类方法[15]。KNN 分类算法根据待识样本在特征空间中 K 个最近邻样本中的多数样本的类别来进行分类,因此具有直观、无需先验统计知识、无师学习等特点,从而成为非参数分类的一种重要方法。 大多数分类方法是基于向量空间模型的。当前在分类方法中,对任意两个向量: x= ) ,..., , ( 2 1x x x n和) ,..., , (' ' 2 ' 1 'x x x x n 存在 3 种最通用的距离度量:欧氏距离、余弦距 离[16]和内积[17]。有两种常用的分类策略:一种是计算待分类向量到所有训练集中的向量间的距离:如 K 近邻选择K个距离最小的向量然后进行综合,以决定其类别。另一种是用训练集中的向量构成类别向量,仅计算待分类向量到所有类别向量的距离,选择一个距离最小的类别向量决定类别的归属。很明显,距离计算在分类中起关键作用。由于以上 3 种距离度量不涉及向量的特征之间的关系,这使得距离的计算不精确,从而影响分类的效果。

牛顿环和劈尖

实验名称:等厚干涉—牛顿环和劈尖 姓名学号班级 日期20 年月日时段 一、实验目的 1. 观察等厚干涉现象,了解其特点。 2. 学习用等厚干涉测量物理量的两种方法。 3. 学习使用显微镜测量微小长度。 二、实验仪器及器件 牛顿环装置,平板光学玻璃片,读数显微镜,钠光灯,待测细丝(请自带计算器)。 三、实验原理 1.等厚干涉(简述原理、特点和应用) 2. 牛顿环产生原理

3. 曲率半径测量 (1) 推导曲率半径计算公式 (2) 实际测量公式(P129,6-3-5式)的考虑和导出 4. 劈尖干涉: 如图,当用单色光垂直入射时,空气劈尖上下表面反射的两束光将发生干涉,从而形成干涉条纹,条纹为平行于两玻片交界棱边的等间距直线。 根据光的干涉原理,得细丝的直径(或薄片的厚度)D D 22 L k n l λ λ == 牛顿环装置

四、实验内容 1. 用牛顿环测凸透镜的曲率半径。 实验装置如图所示,其中,M为读数显微镜镜 头,P为显微镜上的小反射镜,L为牛顿环装置。 (1)借助室内灯光,用肉眼直接观察牛顿环, 调节牛顿环装置上的三个螺丝钮,使牛顿环圆心 位于透镜中心。调节时,螺丝旋钮松紧要适合, 即要保持稳定,又勿过紧使透镜变形。 (2)将显微镜镜筒调到读数标尺中央,并使入射光方向与显微镜移动方向垂直。放入牛顿环装置,移动显微镜整体方位和P的角度,使视场尽可能明亮。 (3)调节显微镜目镜,使十字叉丝清晰。显微镜物镜调焦,直到看清楚牛顿环并使叉丝与环纹间无视差(注意:物镜调焦时,镜筒应由下向上调以免碰伤物镜或被测物)。移动牛顿环装置使叉丝对准牛顿环中心。 能在显微镜中看到清晰的牛顿环关键有三点:a.确保目测到的牛顿环在物镜的正下方;b.P反射镜角度合适,使S发出的钠黄光尽可能多地反射入物镜;c.物镜调焦合适。 (4)定性观察待测圆环是否均在显微镜读数范围之内并且清晰。 (5)定量测量:由于环中心有变形,应选择10级以上的条纹进行测量。如取m-n=8,则分别测出第25级到第10级各级的直径,然后用逐差法处理数据,求出曲率半径R。并给出完整的实验结果。数据处理可以用EXCEL处理。 测量时应注意避免螺旋空程引入的误差,这要求在整个测量过程中,显微镜筒只能朝一个方向移动,不许来回移动。特别在测量第25级条纹时,应使叉丝先越过25级条纹(比如第30级条纹)然后返回第25级条纹,并对第25级条纹的暗环中心位置开始读数并依次沿同一方向测完全部数据。 2. 用劈尖测细丝直径 (1)用两块平行板夹细铜丝或头发丝等被测物制成劈尖,劈尖放在载物台上,调焦得到清晰的条纹且无视差。调整劈尖位置,使干涉条纹与棱边平行。转动劈尖使条纹与显微镜移动方向垂直。 (2)测量n=20个条纹的间距l和L,计算出D值。并给出完整的实验结果。

数据分析实验报告

《数据分析》实验报告 班级:07信计0班学号:姓名:实验日期2010-3-11 实验地点:实验楼505 实验名称:样本数据的特征分析使用软件名称:MATLAB 实验目的1.熟练掌握利用Matlab软件计算均值、方差、协方差、相关系数、标准差与变异系数、偏度与峰度,中位数、分位数、三均值、四分位极差与极差; 2.熟练掌握jbtest与lillietest关于一元数据的正态性检验; 3.掌握统计作图方法; 4.掌握多元数据的数字特征与相关矩阵的处理方法; 实验内容安徽省1990-2004年万元工业GDP废气排放量、废水排放量、固体废物排放量以及用于污染治理的投入经费比重见表6.1.1,解决以下问题:表6.1.1废气、废水、固体废物排放量及污染治理的投入经费占GDP比重 年份 万元工业GDP 废气排放量 万元工业GDP 固体物排放量 万元工业GDP废 水排放量 环境污染治理投 资占GDP比重 (立方米)(千克)(吨)(%)1990 104254.40 519.48 441.65 0.18 1991 94415.00 476.97 398.19 0.26 1992 89317.41 119.45 332.14 0.23 1993 63012.42 67.93 203.91 0.20 1994 45435.04 7.86 128.20 0.17 1995 46383.42 12.45 113.39 0.22 1996 39874.19 13.24 87.12 0.15 1997 38412.85 37.97 76.98 0.21 1998 35270.79 45.36 59.68 0.11 1999 35200.76 34.93 60.82 0.15 2000 35848.97 1.82 57.35 0.19 2001 40348.43 1.17 53.06 0.11 2002 40392.96 0.16 50.96 0.12 2003 37237.13 0.05 43.94 0.15 2004 34176.27 0.06 36.90 0.13 1.计算各指标的均值、方差、标准差、变异系数以及相关系数矩阵; 2.计算各指标的偏度、峰度、三均值以及极差; 3.做出各指标数据直方图并检验该数据是否服从正态分布?若不服从正态分布,利用boxcox变换以后给出该数据的密度函数; 4.上网查找1990-2004江苏省万元工业GDP废气排放量,安徽省与江苏省是 否服从同样的分布?

数据挖掘实验报告-关联规则挖掘

数据挖掘实验报告(二)关联规则挖掘 姓名:李圣杰 班级:计算机1304 学号:1311610602

一、实验目的 1. 1.掌握关联规则挖掘的Apriori算法; 2.将Apriori算法用具体的编程语言实现。 二、实验设备 PC一台,dev-c++5.11 三、实验内容 根据下列的Apriori算法进行编程:

四、实验步骤 1.编制程序。 2.调试程序。可采用下面的数据库D作为原始数据调试程序,得到的候选1项集、2项集、3项集分别为C1、C2、C3,得到的频繁1项集、2项集、3项集分别为L1、L2、L3。

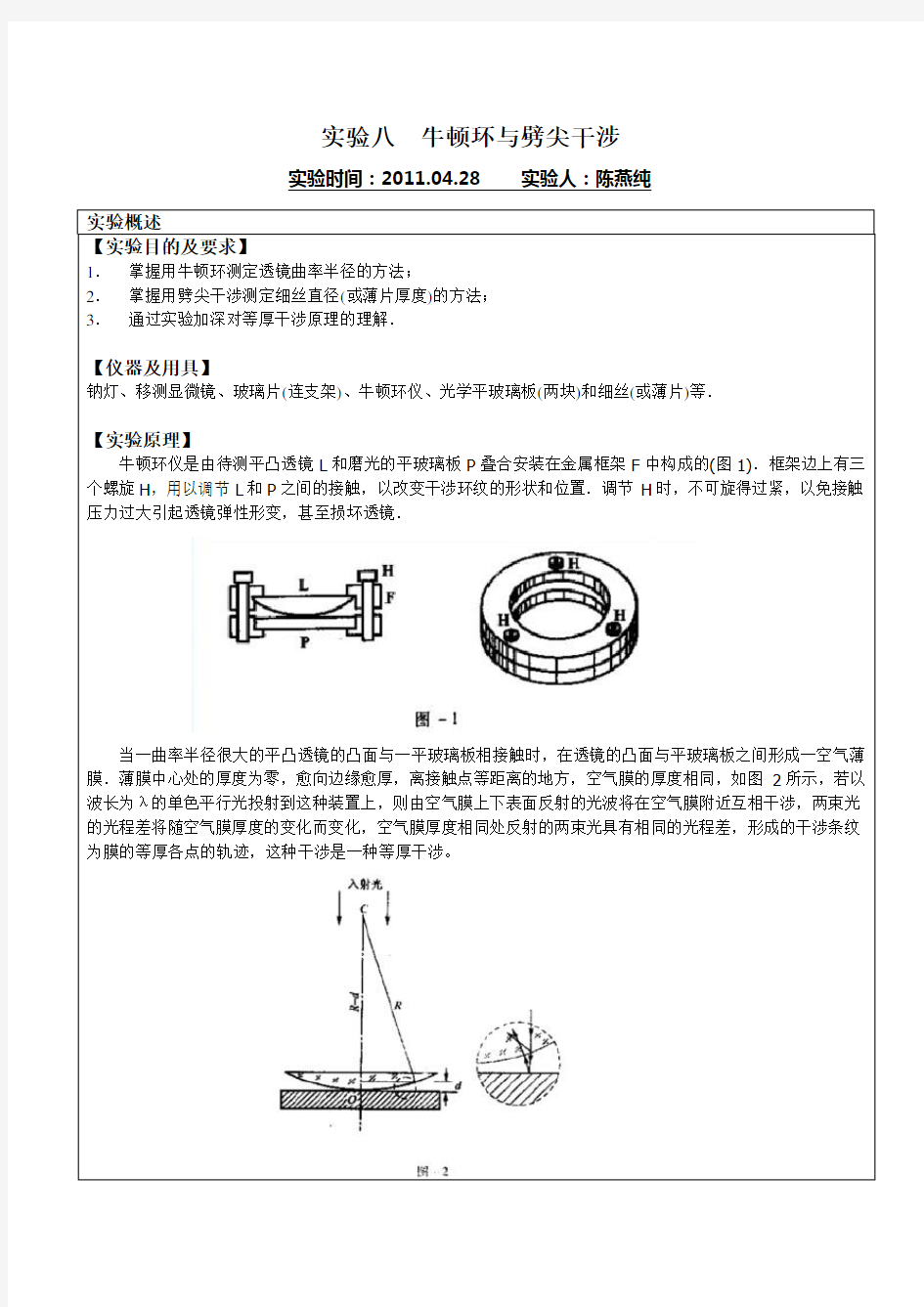

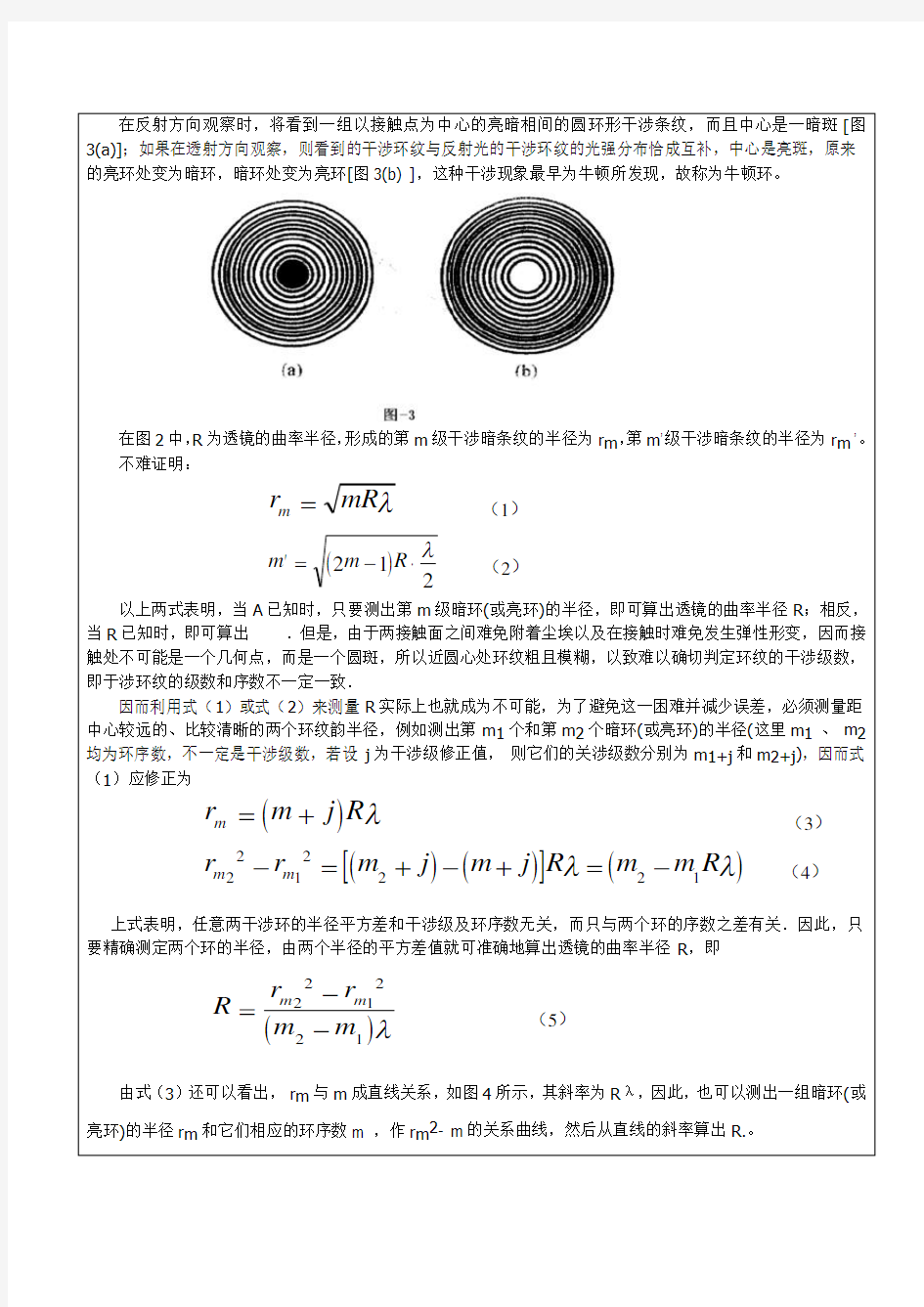

代码 #include 一、实验目的 使用数据挖掘中的分类算法,对数据集进行分类训练并测试。应用不同的分类算法,比较他们之间的不同。与此同时了解Weka平台的基本功能与使用方法。 二、实验环境 实验采用Weka 平台,数据使用Weka安装目录下data文件夹下的默认数据集iris.arff。 Weka是怀卡托智能分析系统的缩写,该系统由新西兰怀卡托大学开发。Weka使用Java 写成的,并且限制在GNU通用公共证书的条件下发布。它可以运行于几乎所有操作平台,是一款免费的,非商业化的机器学习以及数据挖掘软件。Weka提供了一个统一界面,可结合预处理以及后处理方法,将许多不同的学习算法应用于任何所给的数据集,并评估由不同的学习方案所得出的结果。 三、数据预处理 Weka平台支持ARFF格式和CSV格式的数据。由于本次使用平台自带的ARFF格式数据,所以不存在格式转换的过程。实验所用的ARFF格式数据集如图1所示 图1 ARFF格式数据集(iris.arff) 对于iris数据集,它包含了150个实例(每个分类包含50个实例),共有sepal length、sepal width、petal length、petal width和class五种属性。期中前四种属性为数值类型,class属性为分类属性,表示实例所对应的的类别。该数据集中的全部实例共可分为三类:Iris Setosa、Iris Versicolour和Iris Virginica。 实验数据集中所有的数据都是实验所需的,因此不存在属性筛选的问题。若所采用的数据集中存在大量的与实验无关的属性,则需要使用weka平台的Filter(过滤器)实现属性的筛选。 实验所需的训练集和测试集均为iris.arff。 四、实验过程及结果 应用iris数据集,分别采用LibSVM、C4.5决策树分类器和朴素贝叶斯分类器进行测试和评价,分别在训练数据上训练出分类模型,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。最后使用这些参数以及训练集和校验集数据一起构造出一个最优分类器,并利用该分类器对测试数据进行预测。 1、LibSVM分类 Weka 平台内部没有集成libSVM分类器,要使用该分类器,需要下载libsvm.jar并导入到Weka中。 用“Explorer”打开数据集“iris.arff”,并在Explorer中将功能面板切换到“Classify”。点“Choose”按钮选择“functions(weka.classifiers.functions.LibSVM)”,选择LibSVM分类算法。 在Test Options 面板中选择Cross-Validatioin folds=10,即十折交叉验证。然后点击“start”按钮: 实验八牛顿环与劈尖干涉 实验时间:实验人: 实验概述 【实验目的及要求】 1.掌握用牛顿环测定透镜曲率半径的方法; 2.掌握用劈尖干涉测定细丝直径(或薄片厚度)的方法; 3.通过实验加深对等厚干涉原理的理解. 【仪器及用具】 钠灯、移测显微镜、玻璃片(连支架)、牛顿环仪、光学平玻璃板(两块)和细丝(或薄片)等. 【实验原理】 牛顿环仪是由待测平凸透镜L和磨光的平玻璃板P叠合安装在金属框架F中构成的(图1).框架边上有三个螺旋H,用以调节L和P之间的接触,以改变干涉环纹的形状和位置.调节H时,不可旋得过紧,以免接触压力过大引起透镜弹性形变,甚至损坏透镜. 当一曲率半径很大的平凸透镜的凸面与一平玻璃板相接触时,在透镜的凸面与平玻璃板之间形成一空气薄膜.薄膜中心处的厚度为零,愈向边缘愈厚,离接触点等距离的地方,空气膜的厚度相同,如图2所示,若以波长为λ的单色平行光投射到这种装置上,则由空气膜上下表面反射的光波将在空气膜附近互相干涉,两束光的光程差将随空气膜厚度的变化而变化,空气膜厚度相同处反射的两束光具有相同的光程差,形成的干涉条纹为膜的等厚各点的轨迹,这种干涉是一种等厚干涉。 在反射方向观察时,将看到一组以接触点为中心的亮暗相间的圆环形干涉条纹,而且中心是一暗斑[图3(a)];如果在透射方向观察,则看到的干涉环纹与反射光的干涉环纹的光强分布恰成互补,中心是亮斑,原来的亮环处变为暗环,暗环处变为亮环[图3(b) ],这种干涉现象最早为牛顿所发现,故称为牛顿环。 在图2中,R 为透镜的曲率半径,形成的第m 级干涉暗条纹的半径为r m ,第m ’级干涉暗条纹的半径为r m ’。 不难证明: λmR r m = (1) ()2 12λ ?-= 'R m m (2) 以上两式表明,当A 已知时,只要测出第m 级暗环(或亮环)的半径,即可算出透镜的曲率半径R ;相反,当R 已知时,即可算出 .但是,由于两接触面之间难免附着尘埃以及在接触时难免发生弹性形变,因而接触处不可能是一个几何点,而是一个圆斑,所以近圆心处环纹粗且模糊,以致难以确切判定环纹的干涉级数,即于涉环纹的级数和序数不一定一致. 因而利用式(1)或式(2)来测量R 实际上也就成为不可能,为了避免这一困难并减少误差,必须测量距中心较远的、比较清晰的两个环纹韵半径,例如测出第m 1个和第m 2个暗环(或亮环)的半径(这里m 1 、 m 2 数据分析实验报告 【最新资料,WORD文档,可编辑修改】 第一次试验报告 习题1.3 1建立数据集,定义变量并输入数据并保存。 2数据的描述,包括求均值、方差、中位数等统计量。 分析—描述统计—频率,选择如下: 输出: 方差1031026.918399673.8384536136.444百分位数25304.25239.75596.25 50727.50530.501499.50 751893.501197.004136.75 3画直方图,茎叶图,QQ图。(全国居民) 分析—描述统计—探索,选择如下: 输出: 全国居民Stem-and-Leaf Plot Frequency Stem & Leaf 9.00 0 . 122223344 5.00 0 . 56788 2.00 1 . 03 1.00 1 . 7 1.00 2 . 3 3.00 2 . 689 1.00 3 . 1 Stem width: 1000 Each leaf: 1 case(s) 分析—描述统计—QQ图,选择如下: 输出: 习题1.1 4数据正态性的检验:K—S检验,W检验数据: 取显着性水平为0.05 分析—描述统计—探索,选择如下:(1)K—S检验 单样本Kolmogorov-Smirnov 检验 身高N60正态参数a,,b均值139.00 标准差7.064 最极端差别绝对值.089 正.045 负-.089 Kolmogorov-Smirnov Z.686 渐近显着性(双侧).735 a. 检验分布为正态分布。 b. 根据数据计算得到。 结果:p=0.735 大于0.05 接受原假设,即数据来自正太总体。(2)W检验 实验一 ID3算法实现 一、实验目的 通过编程实现决策树算法,信息增益的计算、数据子集划分、决策树的构建过程。加深对相关算法的理解过程。 实验类型:验证 计划课间:4学时 二、实验内容 1、分析决策树算法的实现流程; 2、分析信息增益的计算、数据子集划分、决策树的构建过程; 3、根据算法描述编程实现算法,调试运行; 4、对所给数据集进行验算,得到分析结果。 三、实验方法 算法描述: 以代表训练样本的单个结点开始建树; 若样本都在同一个类,则该结点成为树叶,并用该类标记; 否则,算法使用信息增益作为启发信息,选择能够最好地将样本分类的属性; 对测试属性的每个已知值,创建一个分支,并据此划分样本; 算法使用同样的过程,递归形成每个划分上的样本决策树 递归划分步骤,当下列条件之一成立时停止: 给定结点的所有样本属于同一类; 没有剩余属性可以进一步划分样本,在此情况下,采用多数表决进行 四、实验步骤 1、算法实现过程中需要使用的数据结构描述: Struct {int Attrib_Col; // 当前节点对应属性 int Value; // 对应边值 Tree_Node* Left_Node; // 子树 Tree_Node* Right_Node // 同层其他节点 Boolean IsLeaf; // 是否叶子节点 int ClassNo; // 对应分类标号 }Tree_Node; 2、整体算法流程 主程序: InputData(); T=Build_ID3(Data,Record_No, Num_Attrib); OutputRule(T); 释放内存; 3、相关子函数: 3.1、 InputData() { 输入属性集大小Num_Attrib; 输入样本数Num_Record; 分配内存Data[Num_Record][Num_Attrib]; 输入样本数据Data[Num_Record][Num_Attrib]; 获取类别数C(从最后一列中得到); } 3.2、Build_ID3(Data,Record_No, Num_Attrib) { Int Class_Distribute[C]; If (Record_No==0) { return Null } N=new tree_node(); 计算Data中各类的分布情况存入Class_Distribute Temp_Num_Attrib=0; For (i=0;i 实验三 一、实验原理 K-Means算法是一种 cluster analysis 的算法,其主要是来计算数据聚集的算法,主要通过不断地取离种子点最近均值的算法。 在数据挖掘中,K-Means算法是一种cluster analysis的算法,其主要是来计算数据聚集的算法,主要通过不断地取离种子点最近均值的算法。 算法原理: (1) 随机选取k个中心点; (2) 在第j次迭代中,对于每个样本点,选取最近的中心点,归为该类; (3) 更新中心点为每类的均值; (4) j<-j+1 ,重复(2)(3)迭代更新,直至误差小到某个值或者到达一定的迭代步 数,误差不变. 空间复杂度o(N) 时间复杂度o(I*K*N) 其中N为样本点个数,K为中心点个数,I为迭代次数 二、实验目的: 1、利用R实现数据标准化。 2、利用R实现K-Meams聚类过程。 3、了解K-Means聚类算法在客户价值分析实例中的应用。 三、实验内容 依据航空公司客户价值分析的LRFMC模型提取客户信息的LRFMC指标。对其进行标准差标准化并保存后,采用k-means算法完成客户的聚类,分析每类的客户特征,从而获得每类客户的价值。编写R程序,完成客户的k-means聚类,获得聚类中心与类标号,并统计每个类别的客户数 四、实验步骤 1、依据航空公司客户价值分析的LRFMC模型提取客户信息的LRFMC指标。 2、确定要探索分析的变量 3、利用R实现数据标准化。 4、采用k-means算法完成客户的聚类,分析每类的客户特征,从而获得每类客户的价值。 客户的k-means聚类,获得聚类中心与类标号,并统计每个类别的客户数 六、思考与分析 使用不同的预处理对数据进行变化,在使用k-means算法进行聚类,对比聚类的结果。 kmenas算法首先选择K个初始质心,其中K是用户指定的参数,即所期望的簇的个数。 这样做的前提是我们已经知道数据集中包含多少个簇. 1.与层次聚类结合 经常会产生较好的聚类结果的一个有趣策略是,首先采用层次凝聚算法决定结果 数据分析与挖掘实验报告 《数据挖掘》实验报告 目录 1.关联规则的基本概念和方法 (1) 1.1数据挖掘 (1) 1.1.1数据挖掘的概念 (1) 1.1.2数据挖掘的方法与技术 (2) 1.2关联规则 (5) 1.2.1关联规则的概念 (5) 1.2.2关联规则的实现——Apriori算法 (7) 2.用Matlab实现关联规则 (12) 2.1Matlab概述 (12) 2.2基于Matlab的Apriori算法 (13) 3.用java实现关联规则 (19) 3.1java界面描述 (19) 3.2java关键代码描述 (23) 4、实验总结 (29) 4.1实验的不足和改进 (29) 4.2实验心得 (30) 1.关联规则的基本概念和方法 1.1数据挖掘 1.1.1数据挖掘的概念 计算机技术和通信技术的迅猛发展将人类社会带入到了信息时代。在最近十几年里,数据库中存储的数据急剧增大。数据挖掘就是信息技术自然进化的结果。数据挖掘可以从大量的、不完全的、有噪声的、模糊的、随机的实际应用数据中,提取隐含在其中的,人们事先不知道的但又是潜在有用的信息和知识的过程。 许多人将数据挖掘视为另一个流行词汇数据中的知识发现(KDD)的同义词,而另一些人只是把数据挖掘视为知识发现过程的一个基本步骤。知识发现过程如下: ·数据清理(消除噪声和删除不一致的数据)·数据集成(多种数据源可以组合在一起)·数据转换(从数据库中提取和分析任务相关的数据) ·数据变换(从汇总或聚集操作,把数据变换和统一成适合挖掘的形式) ·数据挖掘(基本步骤,使用智能方法提取数 据模式) ·模式评估(根据某种兴趣度度量,识别代表知识的真正有趣的模式) ·知识表示(使用可视化和知识表示技术,向用户提供挖掘的知识)。 1.1.2数据挖掘的方法与技术 数据挖掘吸纳了诸如数据库和数据仓库技术、统计学、机器学习、高性能计算、模式识别、神经网络、数据可视化、信息检索、图像和信号处理以及空间数据分析技术的集成等许多应用领域的大量技术。数据挖掘主要包括以下方法。神经网络方法:神经网络由于本身良好的鲁棒性、自组织自适应性、并行处理、分布存储和高度容错等特性非常适合解决数据挖掘的问题,因此近年来越来越受到人们的关注。典型的神经网络模型主要分3大类:以感知机、bp反向传播模型、函数型网络为代表的,用于分类、预测和模式识别的前馈式神经网络模型;以hopfield 的离散模型和连续模型为代表的,分别用于联想记忆和优化计算的反馈式神经网络模型;以art 模型、koholon模型为代表的,用于聚类的自组 数据预处理 一、实验原理 预处理方法基本方法 1、数据清洗 去掉噪声和无关数据 2、数据集成 将多个数据源中的数据结合起来存放在一个一致的数据存储中 3、数据变换 把原始数据转换成为适合数据挖掘的形式 4、数据归约 主要方法包括:数据立方体聚集,维归约,数据压缩,数值归约,离散化和概念分层等二、实验目的 掌握数据预处理的基本方法。 三、实验内容 1、R语言初步认识(掌握R程序运行环境) 2、实验数据预处理。(掌握R语言中数据预处理的使用) 对给定的测试用例数据集,进行以下操作。 1)、加载程序,熟悉各按钮的功能。 2)、熟悉各函数的功能,运行程序,并对程序进行分析。 对餐饮销量数据进统计量分析,求销量数据均值、中位数、极差、标准差,变异系数和四分位数间距。 对餐饮企业菜品的盈利贡献度(即菜品盈利帕累托分析),画出帕累托图。 3)数据预处理 缺省值的处理:用均值替换、回归查补和多重查补对缺省值进行处理 对连续属性离散化:用等频、等宽等方法对数据进行离散化处理 四、实验步骤 1、R语言运行环境的安装配置和简单使用 (1)安装R语言 R语言下载安装包,然后进行默认安装,然后安装RStudio 工具(2)R语言控制台的使用 1.2.1查看帮助文档 1.2.2 安装软件包 1.2.3 进行简单的数据操作 (3)RStudio 简单使用 1.3.1 RStudio 中进行简单的数据处理 1.3.2 RStudio 中进行简单的数据处理 2、R语言中数据预处理 (1)加载程序,熟悉各按钮的功能。 (2)熟悉各函数的功能,运行程序,并对程序进行分析 2.2.1 销量中位数、极差、标准差,变异系数和四分位数间距。 , 2.2.2对餐饮企业菜品的盈利贡献度(即菜品盈利帕累托分析),画出帕累托图。 表1-1:不同频率下的遏止电压表 λ(nm)365 404.7 435.8 546.1 577 v(10^14)8.219 7.413 6.884 5.493 5.199 |Ua|(v) 1.727 1.357 1.129 0.544 0.418 表1-2:λ=365(nm)时不同电压下对应的电流值 U/(v)-1.927 -1.827 -1.727 -1.627 -1.527 -1.427 -1.327 I/(10^-11)A-0.4 -0.2 0 0.9 3.9 8.2 14 -1.227 -1.127 -1.027 -0.927 -0.827 -0.727 -0.718 24.2 38.1 52 66 80 97.2 100 表1-3:λ=404.7(nm)时不同电压下对应的电流值 U/(v) -1.477 -1.417 -1.357 -1.297 -1.237 -1.177 -1.117 I/(10^-11)A -1 -0.4 0 1.8 4.1 10 16.2 -1.057 -0.997 -0.937 -0.877 -0.817 -0.757 -0.737 24.2 36.2 49.8 63.9 80 93.9 100 表1-4:λ=435.8(nm)时不同电压下对应的电流值 U/(v)-1.229 -1.179 -1.129 -1.079 -1.029 -0.979 -0.929 I/(10^-11)A-1.8 -0.4 0 2 4.2 10.2 17.9 -0.879 -0.829 -0.779 -0.729 -0.679 -0.629 -0.579 -0.575 24.8 36 47 59 71.6 83.8 98 100 表1-5:λ=546.1(nm)时不同电压下对应的电流值 U/(v)-0.604 -0.574 -0.544 -0.514 -0.484 -0.454 -0.424 I/(10^-11)A-4 -2 0 3.8 10 16.2 24 -0.394 -0.364 -0.334 -0.304 -0.274 -0.244 -0.242 34 46 56.2 72 84.2 98.2 100 表1-6:λ=577(nm)时不同电压下对应的电流值 U/(v)-0.478 -0.448 -0.418 -0.388 -0.358 -0.328 -0.298 I/(10^-11)A-3.1 -1.8 0 2 6 10.2 16.1 -0.268 -0.238 -0.208 -0.178 -0.148 -0.118 -0.088 -0.058 22.1 31.8 39.8 49 58 68.2 79.8 90.1 -0.04 100 时间序列的模型法和数据挖掘两种方法比较分析研究 实验目的:通过实验能对时间序列的模型法和数据挖掘两种方法的原理和优缺点有更清楚的认识和比较. 实验内容:选用1952-2006年的中国GDP,分别对之用自回归移动平均模型(ARIMA) 和时序模型的数据挖掘方法进行分析和预测,并对两种方法的趋势和预测结果进行比较并 给出解释. 实验数据:本文研究选用1952-2006年的中国GDP,其资料如下 日期国内生产总值(亿元)日期国内生产总值(亿元) 2006-12-312094071997-12-3174772 2005-12-311830851996-12-31 2004-12-311365151995-12-31 2003-12-311994-12-31 2002-12-311993-12-31 2001-12-311992-12-31 2000-12-31894041991-12-31 1999-12-31820541990-12-31 1998-12-31795531989-12-31 1988-12-311969-12-31 1987-12-311968-12-31 1986-12-311967-12-31 1985-12-311966-12-311868 1984-12-3171711965-12-31 1983-12-311964-12-311454 1982-12-311963-12-31 1981-12-311962-12-31 1980-12-311961-12-311220 1979-12-311960-12-311457 1978-12-311959-12-311439 1977-12-311958-12-311307 1976-12-311957-12-311068 1975-12-311956-12-311028 1974-12-311955-12-31910 1973-12-311954-12-31859 1972-12-311953-12-31824 1971-12-311952-12-31679 1970-12-31 表一 国内生产总值(GDP)是指一个国家或地区所有常住单位在一定时期内生产活动的最终成果。这个指标把国民经济全部活动的产出成果概括在一个极为简明的统计数字之中为评价和衡量国家经济状况、经济增长趋势及社会财富的经济表现提供了一个最为综合的尺度,可以说, XX环和劈尖干涉 【实验目的】 1?学习用牛顿环测量透镜的曲率半径和劈尖的厚度。 2?熟练使用读数XX。 【实验仪器】 移测显微镜,钠光灯,牛顿环仪和劈尖装置。 【实验原理】 22dm dn测量透镜曲率半径的公式为: R 4(m n) 【实验内容】 一、用xx环测量透镜的曲率半径 1.调节牛顿环仪,使牛顿环的中心处于牛顿环仪的中心。(为什么?) 2?将牛顿环仪置于显微镜平台上,调节半反射镜使钠黄光充满整个视场。此时显微镜中的视场由暗变亮。(一定能调出条纹吗?) 3?调节显微镜,直至看清十字叉丝和清晰的干涉条纹。(注意: 调节显微镜物镜镜筒时,只能由下向上调节。为什么?) 4?观察条纹的分布特征。察看各级条纹的粗细是否一致,条纹间隔是否一样,并做出解释。观察牛顿环中心是亮斑还是暗斑,若为亮斑,如何解释? 5?测量暗环的直径。转动移测显微镜读数鼓轮,同时在目镜中观察,使十字刻线由牛顿环中央缓慢向一侧移动然后退回第30环,自30环开始单方向移动十字刻线,每移动一环即记下相应的读数直到第25环,然后再从同侧第15环开始记数直 到第10环;穿过中心暗斑,从另一侧第10环开始依次记数到第15 环,然后从第25环记数直至第30环。并将所测数据记入数据表格中。(为什么测量暗环的直径,而不是测量亮环的直径?) 6?观察透射光束形成的xx环。 7.观察xx产生的xx环(选做) 二、利用劈尖测量薄片厚度(表格自拟) 利用xx环测透镜的曲率半径 环的级数 环的位置 环的直径 环的级数 环的位置m3029 1428 1327 10左右dm15n左右环的直径 直径平方差 透镜曲率半径dn22dm dnR 【思考与讨论】 1、用移测显微镜测量牛顿环直径时,若测量的不是干涉环直径,而是干涉环的同一直线上的弦长,对实验是否有影响?为什么? 2、透射光能否形成牛顿环?它和反射光形成的牛顿环有什么区别?大数据挖掘weka大数据分类实验报告材料

实验报告:牛顿环与劈尖干涉

数据分析实验报告

数据挖掘实验报告1

数据挖掘实验报告三

数据分析与挖掘实验报告

数据挖掘实验报告一

光电效应实验报告数据处理 误差分析

数据挖掘实验报告(参考)

牛顿环和劈尖干――实验报告