2006年12月重庆师范大学学报(自然科学版)Dec.2006第23卷第4期JournalofChongqingNormalUniversity(NaturalScienceEdition)Vol.23No.4

Web日志挖掘技术应用研究倡

吕 佳

(重庆师范大学数学与计算机科学学院,重庆400047)

摘 要:随着Internet的迅速发展,Web在人们的日常生活和工作中的地位日益显著。Web日志挖掘就是通过对Web日志记录的挖掘,发现用户访问的Web页面的浏览模式,从而进一步分析和研究Web日志记录中的规律,改进Web站点的性能和组织结构,提供个性化服务。本文首先分析了Web日志的分布和特点,再对Web日志挖掘中的两个阶段即数据预处理和日志挖掘算法做了详细介绍,最后对Web日志挖掘技术做了展望。

关键词:Web日志挖掘;Web日志;数据预处理;日志挖掘算法

中图分类号:TP393文献标识码:A 文章编号:1672唱6693(2006)04唱0039唱06Research on Application of Web Log Mining Technology

LV Jia

(CollegeofMathematicsandComputerScience,ChongqingNormalUniversity,Chongqing400047,China)Abstract:WiththerapiddevelopmentofInternet,Webplaysanincreasinglyimportantroleinpeople'sdailylifeandwork.WeblogminingistofindbrowsingpatternofuseraccessingWebpagesbyminingWeblogrecords,accordinglytoanalyzeandresearchruleshiddeninWeblogandimprovetheperformanceandstructureofwebstation,thuscanprovidepersonaliza唱tionservices.ThispaperfirstlyanalyzedWeblogdistributionandfeature,thenintroducedtwostagesofWeblogminingindetail,i.e.datapreprocessingandlogminingalgorithms,finallyexpectedWeblogminingtechnology.

Key words:Weblogmining;Weblog;datapreprocessing;logminingalgorithms

Web作为目前Internet上信息发布的主要渠道,已经显示出巨大的商业价值和应用潜力。Web中包含了Web页面的内容信息、超链接信息,以及Web页面的访问和使用信息,为数据挖掘提供了丰富的资源。Web挖掘[1,2]旨在应用数据挖掘技术从与WWW相关的资源和用户浏览行为中提取隐含的、未知的、对决策有潜在价值的知识和模式的过程。

Web是一个无统一结构、无标准查询语言和数据模型的分布式信息系统,对其挖掘是困难的。但每一个提供信息资源的服务器都保留了一个结构化较好的日志文件,记录了用户访问该网站的交互信息,用户每访问一个页面,日志文件就会相应地增加一条记录。Web日志挖掘就是通过对Web日志记录的挖掘,发现用户访问的Web页面的浏览模式,从而进一步分析和研究Web日志记录中的规律,以期改进Web站点的性能和组织结构,提高用户查找信息的质量和效率,并通过统计和关联分析找出特定用户与特定地域、特定时间、特定页面等要素之间的内在联系。

作为Web挖掘的一个重要组成部分,通过对Web日志的挖掘,可以帮助作者更好地分析和理解用户使用Web的行为特点,发现隐藏在用户行为背后的更深层次的动因和规律,从而开发Web的最大经济潜力[3,4]。本文分析了Web日志的分布和特点,对Web日志数据预处理及挖掘算法做了详细分析,最后指出该领域当前存在的问题以及下一步研究方向。

1 Web用户访问日志分布及特点Web用户访问日志主要来源于Web服务器(Webserver)、Web代理服务器(proxy)和客户端

倡收稿日期:2006唱04唱25

资助项目:重庆师范大学科研基金(No.05XLY003)

作者简介:吕佳(1978唱),女,四川达州人,讲师,硕士,研究方向为数据挖掘。

(client)[5,6]。这3处日志数据集记录了用户使用网络资源的不同模式。Web服务器端日志数据记录了多个Web用户对单个站点的访问行为;Web代理服务器日志数据记录了多个Web用户向多个Web服务器的请求;客户端日志数据记录了单个用户访问多个Web服务器的模式。其中前两者数据的收集是由服务器自动记录的,而客户端日志数据则需要专门的程序收集,如客户端的代理软件或者使用修改过的浏览器。相对而言,服务器端日志格式标准化程度最高。

W3C组织规定了服务器日志的两种格式[7]:通用日志格式(CommonLogFormat)和扩展型日志格式(ExtendedLogFormat)。以下为重庆大学Web服务器上记录的一条完整的日志项。

202.202.3.4———[06/12/2004:17:51:33+0800]“GET/images/index_bg_15.gifHTTP/1.1”3040“http://www.cqu.edu.cn/”“Mozilla/4.0(compatible;MSIE6.0;WindowsNT5.0)”。

下面对服务器日志文件的具体格式稍作解释。

第一部分包含有关访问服务器主机的信息,从第1条记录可知,发出请求的主机的IP地址为202.202.3.4。

第2部分指明了访问的日期和时间。这次访问发生在2004年12月6日17:51:33,+0800说明重大的Web服务器位于第8时区。

第3部分是该主机发出的请求浏览网页的指令内容,包括请求方式、请求的页面(URL)和采用的协议。请求方式一般有3种,即GET、POST和HEAD。GET指从Web服务器请求了一个对象;POST表示向服务器发送信息;HEAD指只取一个对象的头。这条记录显示访问的类型是“GET”行为,被访问的内容是位于/images/目录下的一个图片文件index_bg_15.gif,所用的协议是HTTP/1.1。

第4部分为服务器执行该请求的结果状态信息和请求网页的字节数。200表示请求成功,304表示网页内容没有改变,404是最常见的错误信息,它表示请求的文件没有找到。

第5部分为用户访问网站的主页URL地址。记录显示的都是http://www.cqu.edu.cn/。

第6部分为用户使用的浏览器以及操作系统的版本。该记录显示,使用的浏览器是Mozilla/4.0,操作系统版本为WindowsNT5.0。

2 Web日志挖掘的一般流程

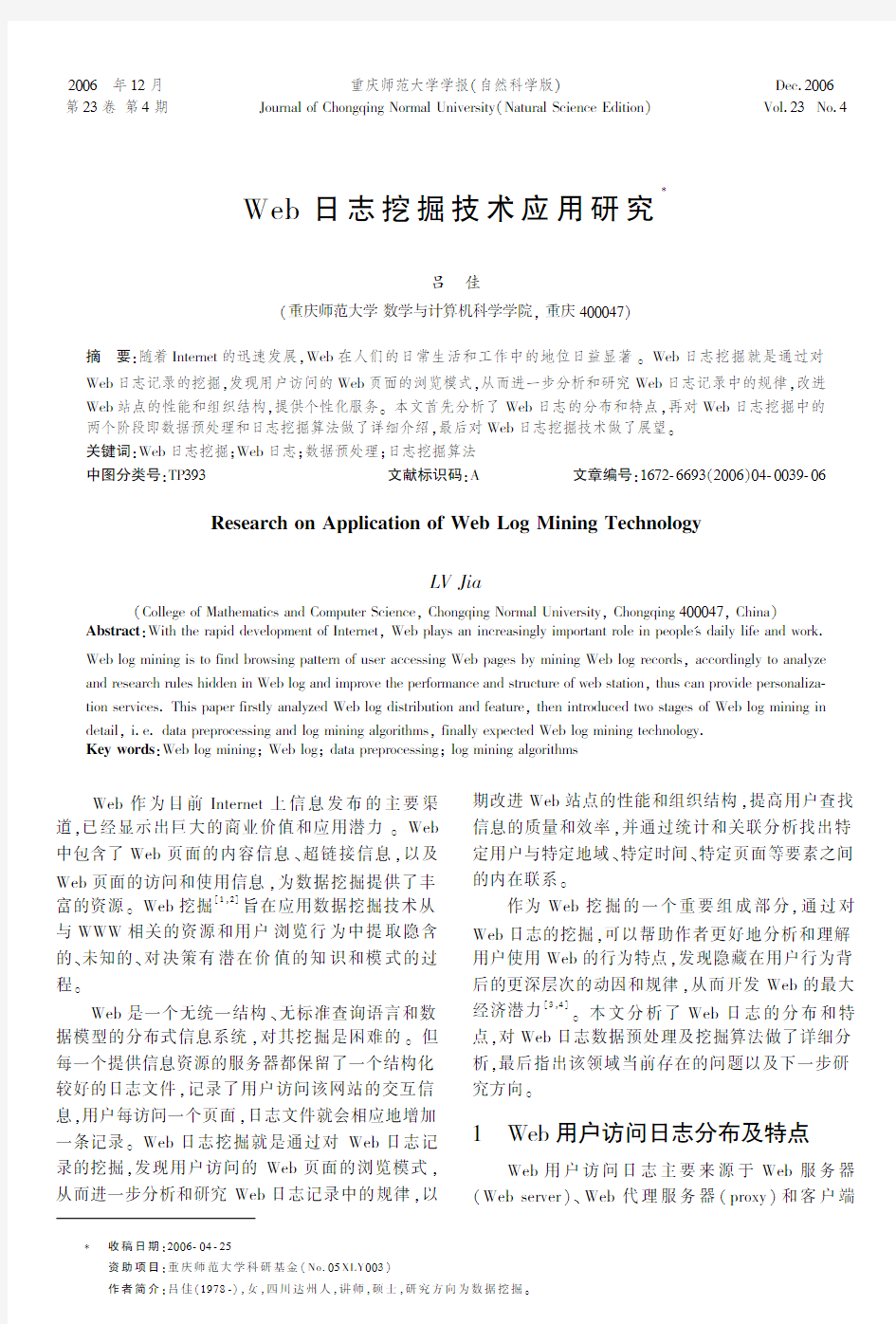

Web日志挖掘的研究依然遵循数据挖掘的研究思路,挖掘过程一般分为4个阶段,即数据预处理阶段、日志挖掘算法实施阶段、模式分析阶段和可视化阶段[8],其流程如图1

所示。

图1 Web日志挖掘的一般流程

数据预处理阶段是将原始的Web日志文件转化为适合进行数据挖掘的可靠的规范的数据格式。日志挖掘算法实施阶段是对数据预处理的结果施用挖掘算法产生规则与模式。数据预处理和日志挖掘算法是Web日志挖掘中的关键技术,数据预处理的结果作为挖掘算法的输入直接影响日志挖掘算法产生的规则与模式。模式分析阶段分析挖掘得到的规则和模式,提取有意义的、感兴趣的规则与模式作为挖掘结果。可视化则是用图形化界面将挖掘的结果显示出来。

3 Web日志挖掘的数据预处理分析

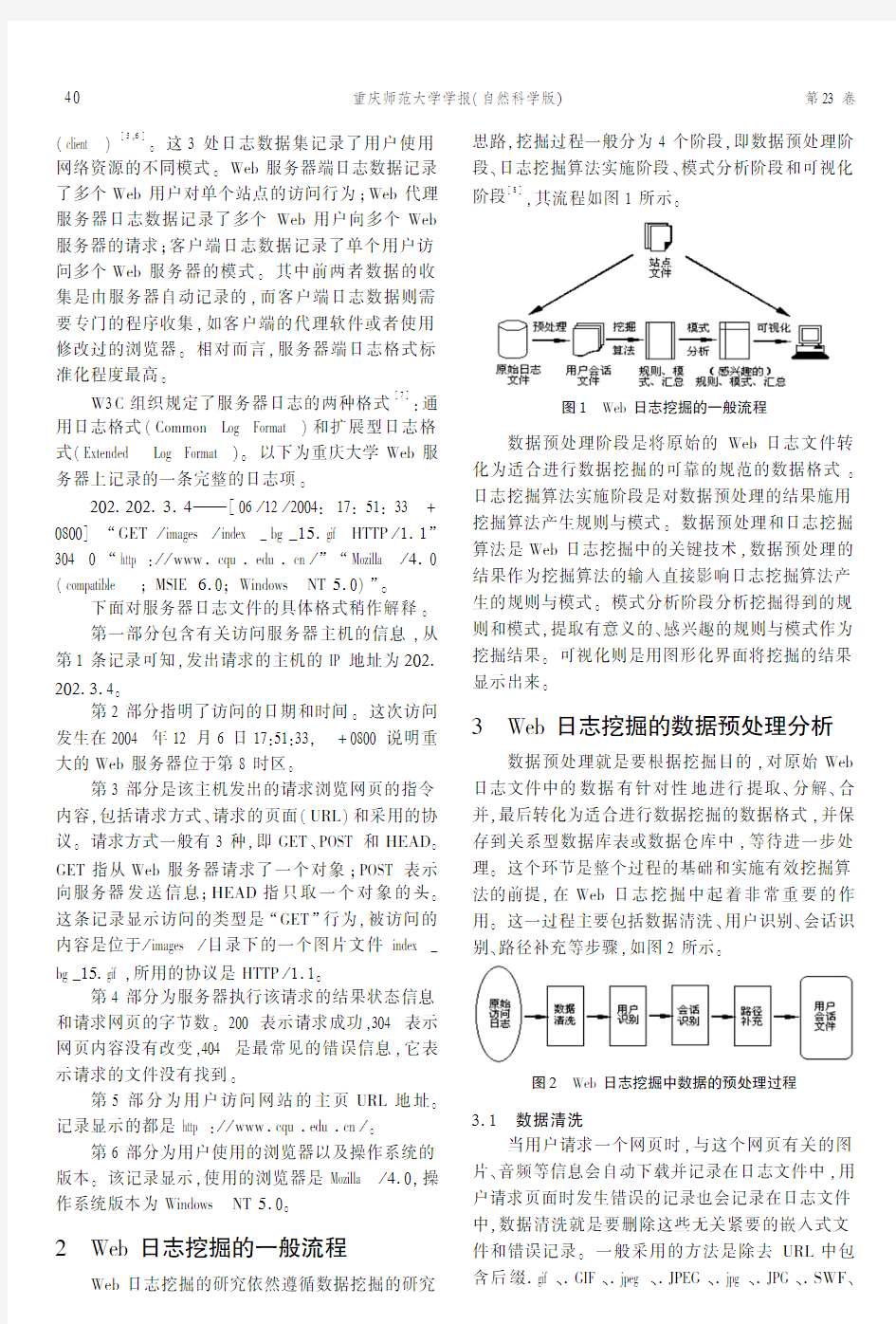

数据预处理就是要根据挖掘目的,对原始Web日志文件中的数据有针对性地进行提取、分解、合并,最后转化为适合进行数据挖掘的数据格式,并保存到关系型数据库表或数据仓库中,等待进一步处理。这个环节是整个过程的基础和实施有效挖掘算法的前提,在Web日志挖掘中起着非常重要的作用。这一过程主要包括数据清洗、用户识别、会话识别、路径补充等步骤,如图2

所示。

图2 Web日志挖掘中数据的预处理过程3.1 数据清洗

当用户请求一个网页时,与这个网页有关的图片、音频等信息会自动下载并记录在日志文件中,用户请求页面时发生错误的记录也会记录在日志文件中,数据清洗就是要删除这些无关紧要的嵌入式文件和错误记录。一般采用的方法是除去URL中包含后缀.gif、.GIF、.jpeg、.JPEG、.jpg、.JPG、.SWF、

04重庆师范大学学报(自然科学版) 第23卷

.MID、.MP3、.AVI等的日志项,删除由Javaapplet文件、js脚本文件、CSS层叠式样式表文件等产生的日志项以及删除那些错误的访问记录。当然,如果这些文件都是由用户主动点击浏览的,则这些访问记录不能删除。

3.2 用户识别由于本地缓存、代理服务器(包括网吧、局域网

等环境)以及防火墙的使用,使得在日志中辨识每一个用户变得较为复杂。可以通过Cookie和用户注册来辨识用户,但因涉及隐私问题需依赖用户的合作,故不易实现。一些启发式信息可以用来帮助辨识用户

[4]

。目前辨识用户的通用方法是:只有IP

地址、操作系统、浏览器、浏览器版本以及Http协议版本都完全相同才视为同一用户。

3.3 会话识别

会话识别的目的就是把用户的访问日志分割成

一个个的会话。一般常以时间长度来确定用户会话,即设置一个时间阈值Timeout 来划分不同的用户会话。日志中第i 条记录和第j 条记录的访问时间只要满足Time i -Time j ≤Timeout 就认为是同一会话,Timeout 取值常为30min。另外,通常用户会在

其感兴趣的页面上停留较长时间,这类页面视为目标网页。目前普遍采用的确定目标网页的方法是基于时间

[9]

。同一个用户按照时间顺序先后访问的两

个网页的时间差值,表示前一个网页的停留时间,若

超过某一给定阈值η,则认为这个网页为该用户感兴趣的目标网页。另外,可假设用户访问的最后一个网页为该用户感兴趣的目标网页。图3为标识3的会话片断。η为30s,最后一个页面停留时间设为500s。以请求编号为“151”的网页这条日志记录为例,它的停留时间是49s,超过η,所以网页“151”

是该用户的一个目标网页。

图3 用户会话部分片断

3.4 路径补充

由于存在客户端缓存等原因,使得Web服务器

日志中并没有完整地记录下用户的访问行为,路径补充就可以将遗漏的信息补充进来。例如,如果一个用户一次请求的页面不是从上一次请求的页面中链接而来的,并且这一次请求的页面是用户最近曾经请求过的页面,那么可以假设用户的请求是通过本地(如在IE中按“后退键”)或Proxy端的缓冲区得到满足的,因此服务器端无法记录此次请求,这样就需要进行路径补充,同时还可以结合站点的拓扑结构来补充路径。

在数据集经历以上步骤之后,用户会话数据必须被格式化成符合相应数据挖掘算法的数据模型,这一步工作称之为数据转化。例如,进行关联规则挖掘的数据格式和进行序列挖掘的数据格式就可能不同。显然,对于不同的数据集,应如何进行预处理,应处理成什么种类的数据源,这不仅依赖于数据挖掘要求本身和一些通用的知识,而且更依赖于挖掘算法所应用的具体领域的专家经验和知识。

4 Web日志挖掘算法

目前国内外已陆续开发出一些商业化Web日

志分析工具,这些工具主要注重统计页面的点击次数、用户在站点的停留时间和用户访问的URL等。对分析网络个体行为和群体行为特征分析,还存在着一定的局限性。在学术界,对于日志挖掘的研究,试图从社会学和心理学的角度,解释数据统计规律和分布特征,以发现日志中隐含的关系,并进行相关的行为分析。常用的Web日志挖掘技术有统计分析、序列模式分析、关联规则、分类和聚类等。

4.1 统计分析

统计分析是最常用的从Web用户行为中抽取

知识的方法。对Web日志进行统计分析可以获得有关站点使用的基本信息,如页面访问次数、页面的平均访问人数、最频繁访问的页面、浏览站点的路径平均长度等;还可以进行有限的错误分析,如非法用户登录等。这些统计数据都是基于用户浏览页面的时间、用户的浏览路径和路径长度以及用户的访问行为和习惯等信息。这种分析虽然看起来不能进行深层次的数据分析,但是分析结果往往对提高系统性能、加强系统安全性,优化站点结构,提供市场决策等方面大有帮助。目前已有许多Web跟踪与流

量分析工具实现了这些最基本的统计功能。Han等人

[10]

依据Web日志建立数据立方体

(Datacube),然后对数据立方体进行数据挖掘和联

1

4第4期 吕 佳:Web日志挖掘技术应用研究

机分析处理(OLAP)。基于数据立方体的挖掘侧重于将Web日志转变为结构化的数据立方体,能从多角度全面地进行挖掘和分析,并能引进各种成熟的数据挖掘技术,有利于Web挖掘与数据挖掘技术的迅速融合与发展。郭岩等人[11]围绕网络日志中是否蕴含用户访问Web的规律性以及如何利用这些特性,用统计的方法研究了日志规模与用户数、Web文档数以及单位用户访问Web文档数的关系,最后得出了一定时间段的Web访问日志中蕴含了用户的稳定兴趣的结论。

4.2 序列模式

序列模式指在时序数据集中发现在时间上具有先后顺序的数据项。在Web日志挖掘中,序列模式识别指寻找用户会话中在时间上有先后关系的页面请求。在Web服务器日志里,用户的访问是以一段时间为单位记载的。经数据预处理后,成为一个间断的时间序列,这些序列模式可以预测用户即将可能请求的页面,这样就可以针对特定的用户组在页面中放置不同的广告条来增加广告的点击率,还可以进行商业和市场的决策,站点结构的优化。

Markov模型常用来发掘序列模式。通常,一个Markov模型由一个状态集合和一个状态转移概率矩阵组成。用Markov模型对页面访问序列进行建模,把从一个页面的访问到另一个页面的访问看成是状态的转移,用Markov链描述页面访问之间的概率转移。文献[12,13]使用Markov模型生成序列模式,用于Web预取和系统优化。

4.3 关联规则

关联规则技术主要用于发现用户会话中经常被用户一起访问的页面集合,这些页面之间没有顺序关系。挖掘关联规则通常使用Apriori算法或其变形算法,从事务数据库中挖掘出最大频繁访问项集,这个项集就是关联规则挖掘出的用户访问模式。例如,IBM对Official1996OlympicsWeb站点服务器的日志进行关联规则的挖掘,结果发现:(1)访问室内排球页面的用户,其中的45%也访问手球页面;(2)访问羽毛球和跳水页面的用户,其中的59.7%也访问桌球页面。

关联规则可以作为站点设计者优化站点的参照,也是在Web上进行商业和市场决策的依据,而且还可以作为启发式规则为远程客户预取可能请求的页面。

文献[14]提出使用多种最小支持度阈值的策略,用户可以对不同的页面指定不同的支持度,从而保证频繁集中能够包含那些较少出现但很重要的页面。Chen等人[15]最早提出基于Web事务的Web日志挖掘技术。将数据挖掘技术应用于Web服务器日志文件,提出最大前向引用(MaximalForward

Reference,简称MFR)系列的概念,用于在日志预处理阶段辨识用户访问事务,然后采用与关联规则相似的方法挖掘频繁访问路径,以发现用户浏览模式。4.4 分类和聚类

分类是将一个对象分到事先已定义好的类中。在Web日志挖掘中,分类可以用来为一组特定的用户建立简档,这就要求抽取关键属性描述已知的用户类别。可以使用监督学习算法来分类,如决策树分类法、贝叶斯分类法、最近邻分类法、支持向量机等。例如对服务器日志做分类,可能会发现类似这样的有趣规则:通过/Product/Music提交订单的用户中,有30%是居住在西海岸并且年龄在18~25岁之间。

聚类分析是多元统计分析的一种,也是非监督模式识别的一个重要分支,在模式识别、图像分割、特征提取等领域中得到了广泛应用。对于一个特定的Web站点,其拓扑结构、页面个数都是已知的,虽然同一个用户在不同时期可能有不同的浏览模式,但其长期趋势应该是稳定的。因此,分析一定时期内用户的访问信息便可以了解用户的访问模式,实现用户聚类和页面聚类。用户聚类主要是把用户划分成若干组,具有相似浏览模式的用户分在一组,这类知识在电子商务和为用户提供个性化服务等应用中特别有用;页面聚类则可以找出具有相关内容的页面集,这对网上搜索引擎和调整页面结构等应用很有用。

文献[16]提出了一种基于低复杂性模糊关联聚类算法用于Web日志挖掘,该算法采用模糊C唱medoids思想对关系数据进行聚类,在Web文档及Web日志分析中都取得了很好的效果。文献[17]提出了K唱paths路径聚类方法,他们认为用户对Web站点的访问代表了用户对Web站点上页面的访问兴趣,这种兴趣程度可以通过用户对Web站点上页面的浏览顺序表现出来。故根据群体用户对Web站点的访问顺序进行聚类。文献[18,19]分别采用了相似性分析和Max唱Min模糊相似性度量规则对所构建URL唱UserID关联矩阵进行了相关页面分析,并提出了Web页面和客户群体的模糊聚类算法,以此

24重庆师范大学学报(自然科学版) 第23卷

发现用户频繁访问路径,实现网站优化,提供个性化服务。文献[20]提出了一种基于竞争的自激励神经网络学习算法SIN,该算法综合了自适应谐振理论和竞争型神经网络的特点,在隐层采用了Hebb学习规则,既能保证原有信息不受影响,又能对新的信息加以记忆,具有较好的学习速度和分类效果,并能有效剔除噪声,得到较为理想的用户聚类和页面聚类的结果。文献[21,22]采用PageGather算法在

Web站点上寻找相关页面集合。对聚类结果中的每一个聚类,系统自动生成一个包含该聚类中所有页面链接的Web页面,即索引页面。每一个索引页面反映了一组用户可能具有的共同兴趣。利用索引页面,可以提高用户的浏览效率。由于索引页面是系统自动生成的,因此该算法可以使Web站点的结构自动改变,具有自适应性。

5 Web日志挖掘技术展望

Web是信息发布、交互及获取的主要工具,Web上的信息量正以惊人的速度不断增长。面对日益增长的Web信息,Web日志挖掘研究的需求量也日益增加,具有广阔的发展和应用前景。而Web日志挖掘技术还有许多问题需要解决,有待研究者们进一步开展深入的研究工作。目前Web日志挖掘研究主要面临以下问题。

(1)Web是一个异质、分布、动态的信息源。Web页面支持多种媒体的表达,半结构化或无结构的数据的复杂程度要高于任何传统的文本文件结构。数据更新快,增长快,且无固定的模式。页面本身的内容和相关链接经常更新。这些都造成Web数据非常复杂。

(2)本地和各级浏览器缓存、防火墙和代理服务器的存在,以及Cookie使用条件的约束和相同IP不同用户的集中请求行为,难以有效地进行用户识别和会话识别,这成为Web日志预处理过程的重点和难点。

(3)Web上的数据海量增长,真正有用的信息可能只占其中的较小的一个部分,而这部分数据往往“淹没”在庞大的数据之中了,因此针对不同的目的,需要考虑的是如何设计出行之有效的算法[23]挖掘出有用的信息,如何评价挖掘算法在海量数据挖掘时的适应性和时效性问题。

(4)Web日志挖掘中内在机理及新的挖掘体系和结构的研究。

因此,下一步要解决的问题就主要集中在Web日志挖掘中的数据预处理和日志挖掘算法以及Web日志挖掘中新的挖掘体系的研究上,这需要寻找新的途径来解决上述问题,同时综合利用现有的成熟技术,取长补短,必然也会产生新的思想和方法,也将推动Web日志挖掘的研究。

参考文献:

[1]COOLEYR,MOBASHERR,SRIVASTAVAJ.WebMin唱ing:InformationandPatternDiscoveryontheWorldWideWeb[A].In:Procofthe9thIEEEInternationalConfonToolswithArtificialIntelligence[C].NewportBeach,CA,USA:IEEE,1997.558唱567.

[2]WANGJicheng,HUANGYuan,WUGangshan,etal.WebMining:KnowledgeDiscoveryontheWeb[A].Sys唱tems,Man,andCybernetics,IEEESMC'99ConferenceProceedings[C].Japan:IEEE,1999,2:137唱141.[3]陈新中,李岩,杨炳儒,等.Web日志挖掘技术进展[J].系统工程与电子技术,2003,25(4):492唱495.[4]郭岩,白硕,于满泉.Web使用信息挖掘综述[J].计算机科学,2005,32(1):1唱7.

[5]张娥,冯耕中,郑斐峰.Web用户访问日志数据挖掘研究[J].情报技术,2003,22(9):48唱50.

[6]张娥,冯耕中,郑斐峰.Web日志数据挖掘的数据预处理方法研究[J].计算机应用研究,2004,21(2):58唱60.[7]PHILLIPMHB,BRIANB.ExtendedLogFileFormat[EB/OL].http://www.w3.org/pub/WWW/TR/WD唱logfile.html,1996唱03唱23/2006唱04唱02.

[8]费爱国,王新辉.一种基于Web日志文件的信息挖掘方法[J].计算机应用,2004,24(6):57唱59.[9]MOBASHERB,DAIH,LUOT,etal.EffectivePersonaliza唱tionBasedonAssociationRuleDiscoveryfromWebUsageData[A].In:Proceedingsofthe3rdACMWorkshoponWebInformationandDataManagement(WIDM01)[C].NewYork:ACMPress,2001.9唱15.

[10]ZAIANEOR,XINM,HANJ.DiscoveringWebAccessPatternandTrendsbyAapplyingOLAPandDataMining

TechnologyonWebLogs[A].In:ProcofAdvancesin

DigitalLibraries[C].CA:IEEE,1998.19唱29.[11]郭岩,白硕,杨志峰,等.网络日志规模分析和用户兴趣挖掘[J].计算机学报,2005,28(9):1483唱1496.[12]DESHPANDEM,KARYPISG.SelectiveMarkovModelsforPredictingWebPageAccesses[A].In:Procofthe

FirstSIAMInternationalConfonDataMining[C].USA:

Chicago,IL,2001.7唱14.

[13]SARUKKAIRR.LinkPredictionandPathAnalysisUsingMarkovChains[A].In:Procofthe9thInternational

34

第4期 吕 佳:Web日志挖掘技术应用研究

WorldWideWebConference[C].Netherlands:Amster唱

dam,2000,33(1唱6):377唱386.

[14]LIUB,HSUW,MAY.MiningAssociationRuleswith

MultipleMinimumSupports[A].In:ProcoftheACM

SIGKDDIntlConfonKnowledgeDiscoveryandDataMin唱

ing(KDD'99,Poster)[C].USA:ACMPress,1999,337唱

341.

[15]CHENMS,PARKJS,YUPS.DataMiningforPath

TraversalPatternsinaWebEnvironment[A].InProcof

the16thInternationalConfonDistributedComputingSys唱tems[C].HongKong:IEEE,1996,27唱30:385唱392.[16]KRISHNAPURAMR,JOSHIA,NASRAOUIO,etal.

Low唱ComplexityFuzzyRelationalClusteringAlgorithmsforWebMining[J].IEEETransonFuzzySystems,2001,9(4):595唱607.

[17]王实,高文,李锦涛,等.路径聚类:在Web站点中的知

识发现[J].计算机研究与发展,2001,38(4):482唱486.

[18]宋擒豹,沈钧毅.Web日志的高效多能挖掘算法[J].计

算机研究与发展,2001,38(3):328唱333.

[19]刑东山,沈钧毅,宋擒豹.从Web日志中挖掘用户浏览偏爱路径[J].计算机学报,2003,26(11):1518唱1523.[20]董一鸿,庄越挺.基于新型的竞争型神经网络的Web日志挖掘[J].计算机研究与发展,2003,40(5):661唱

667.

[21]PERKOWITZM,ETZIONIO.TowardsAdaptiveWeb

Sites:ConceptualFrameworkandCaseStudy[J].Artifi唱

cialIntelligence,2000,118(1唱2):245唱275.[22]PERKOWITZM,ETZIONIO.AdaptiveWebSites:Auto唱

maticallySynthesizingWebPages[A].In:Procofthe15thNationalConfonArtificialIntelligence(AAAI98)[C].MenloPark,CA:AAAIPress/MITPress,1998.

727唱732.

[23]吕佳.基于人工免疫网络的多峰值函数优化[J].重庆

师范大学学报(自然科学版),2006,23(3):45唱48.

(责任编辑 游中胜)

(上接33页)

(3)认证域遵循X.509公开密钥认证,用标识类型和长度域标识。该认证域包含有IPv4或IPv6

地址的值。

图7 ANEP报文的可选项结构

5 结束语

主动网络管理[7]

体现了主动网络的思想,将一

部分网络管理功能动态地分布在主动节点上,充分利用了主动节点的计算能力,使节点能够自动发现、解决问题,从而极大地优化了网络管理。本文讨论了一种主动网络的管理模型,该模型中各个模块相互独立、任务明确,而且在每个层都可以动态更新以适应主动网络中主动节点的易变性和主动应用的扩展性,因此网络管理的稳定性和扩展性都大为提高,适应了现代网络管理的需要。

参考文献:

[1]KIWIORD,ZABELES.ActiveResourceAllocationinAc唱tiveNetworks[J].IEEEJSAC,2000,19(3):452唱459.[2]FATTADG,RELG.ActiveNetworks[A].AnEvolutionof

theInternet.ProcofAICA2001唱39thAnnualConference

[C].Italy:Cernobbio,2001.19唱22.

[3]MARSHALLIW.ActiveManagementofMultiserviceNet唱works[C].Italy:ProcIEEENOMS,2000.

[4]SHAEREA.ActiveManagementFrameworkforDistributed

MultimediaSystems[J].JournalofNetworksandSystems

Management,2000,8:49唱72.

[5]BRUNNERM,STADLERR.ServiceManagementinMulti唱

PartyActiveNetworks[J].IEEECommunicationsMaga唱

zine,2000,38(3):281唱286.

[6]KAWAMURAR,STADLERR.ActiveDistributedManage唱mentforIPNetworks[J].IEEECommunicationsMaga唱

zine,2000,38(4):114唱121.

[7]马燕,周润珍,段文书,等.一种基于MobileAgent的主动

网络管理模型研究[J].重庆师范大学学报(自然科学版),2006,23(2):26唱29.

(责任编辑 游中胜)

4

4重庆师范大学学报(自然科学版) 第23卷

网站日志分析的具体方法和步骤【基础】

网站日志挖掘分析的方法 日志文件的格式及其包含的信息 ①2006-10-17 00:00:00②202、200、44、43 ③218、77、130、24 80 ④GET ⑤/favicon、ico ⑥Mozilla/5、0+(Windows;+U;+Windows+NT+5、1;+zh-CN;+rv:1、8、0、 3)+Gecko/20060426 +Firefox/1、5、0、3。 ①访问时间;②用户IP地址;③访问的URL,端口;④请求方法(“GET”、“POST”等); ⑤访问模式;⑥agent,即用户使用的操作系统类型与浏览器软件。 一、日志的简单分析 1、注意那些被频繁访问的资源 2、注意那些您网站上不存在资源的请求。常见的扫描式攻击还包括传递恶意参数等: 3、观察搜索引擎蜘蛛的来访情况 4、观察访客行为 应敌之策: 1、封杀某个IP 2、封杀某个浏览器类型(Agent) 3、封杀某个来源(Referer) 4、防盗链 5、文件重命名 作用: 1、对访问时间进行统计,可以得到服务器在某些时间段的访问情况。 2、对IP进行统计,可以得到用户的分布情况。 3、对请求URL的统计,可以得到网站页面关注情况。 4、对错误请求的统计,可以更正有问题的页面。 二、网站挖掘 根据所挖掘的网站数据的类型,可以将网站数据挖掘分为以下三类:网站内容挖掘(网站Content Mining)、网站结构挖掘(网站Structure Mining)、网站使

用挖掘(网站Usage Mining)(也称为网站日志挖掘)。 ①网站内容挖掘。网站内容挖掘就是指从文档的内容中提取知识。网站内容挖掘又分为文本挖掘与多媒体挖掘。目前多媒体数据的挖掘研究还处于探索阶段,网站文本挖掘已经有了比较实用的功能。网站文本挖掘可以对网站上大量文档集合的内容进行总结、分类、聚类、关联分析,以及利用网站文档进行趋势预测等。网站文档中的标记,例如

与<Heading>等蕴含了额外的信息,可以利用这些信息来加强网站文本挖掘的作用。 ②网站结构挖掘。网站结构挖掘就是从网站的组织结构与链接关系中推导知识。它不仅仅局限于文档之间的超链接结构,还包括文档内部的结构。文档中的URL目录路径的结构等。网站结构挖掘能够利用网页间的超链接信息对搜索引擎的检索结果进行相关度排序,寻找个人主页与相似网页,提高网站搜索蜘蛛在网上的爬行效率,沿着超链接优先爬行。网站结构挖掘还可以用于对网站页进行分类、预测用户的网站链接使用及网站链接属性的可视化。对各个商业搜索引擎索引用的页数量进行统计分析等。 ③网站使用记录挖掘。网站使用记录挖掘就是指从网站的使用记录中提取感兴趣的模式,目前网站使用记录挖掘方面的研究较多,WWW中的每个服务器都保留了访问日志,记录了关于用户访问与交互的信息,可以通过分析与研究网站日志记录中的规律,来识别网站的潜在用户;可以用基于扩展有向树模型来识别用户浏览序列模式,从而进行网站日志挖掘;可以根据用户访问的网站记录挖掘用户的兴趣关联规则,存放在兴趣关联知识库中,作为对用户行为进行预测的依据,从而为用户预取一些网站页面,加快用户获取页面的速度,分析这些数据还可以帮助理解用户的行为,从而改进站点的结构,或为用户提供个性化的服务。 通过对网站服务器日志中大量的用户访问记录深入分析,发现用户的访问模式与兴趣爱好等有趣、新颖、潜在有用的以及可理解的未知信息与知识,用于分析站点的使用情况,从而辅助管理与支持决策。当前,网站日志挖掘主要被用于个性化服务与定制、改进系统性能与结构、站点修改、商业智能以及网站特征描述等诸多领域。 三、网站日志挖掘的方法 (一)首先,进行数据的预处理。</p><h2>web数据挖掘考试重点</h2><p>填空或简答: 1. 数据、信息和知识是广义数据表现的不同形式。 2. 主要知识模式类型有:广义知识,关联知识,类知识,预测型知识,特异型知识 3. web挖掘研究的主要流派有:Web结构挖掘、Web使用挖掘、Web内容挖掘 4. 一般地说,KDD是一个多步骤的处理过程,一般分为问题定义、数据抽取、数据预处理、.数据挖掘以及模式评估等基本阶段。 5. 数据库中的知识发现处理过程模型有:阶梯处理过程模型,螺旋处理过程模型,以用户为中心的处理结构模型,联机KDD模型,支持多数据源多知识模式的KDD处理模型 6. 粗略地说,知识发现软件或工具的发展经历了独立的知识发现软件、横向的知识发现工具集和纵向的知识发现解决方案三个主要阶段,其中后面两种反映了目前知识发现软件的两个主要发展方向。 7. 决策树分类模型的建立通常分为两个步骤:决策树生成,决策树修剪。 8. 从使用的主要技术上看,可以把分类方法归结为四种类型: a) 基于距离的分类方法 b) 决策树分类方法 c) 贝叶斯分类方法 d) 规则归纳方法 9. 关联规则挖掘问题可以划分成两个子问题: a) 发现频繁项目集:通过用户给定Minsupport ,寻找所有频繁项目集或者最大频繁项目集。 b) 生成关联规则:通过用户给定Minconfidence ,在频繁项目集中,寻找关联规则。 10. 数据挖掘是相关学科充分发展的基础上被提出和发展的。 主要的相关技术: 数据库等信息技术的发展 统计学深入应用 人工智能技术的研究和应用 11. 衡量关联规则挖掘结果的有效性: 应该从多种综合角度来考虑: a准确性:挖掘出的规则必须反映数据的实际情况。 b实用性:挖掘出的规则必须是简洁可用的。 c新颖性:挖掘出的关联规则可以为用户提供新的有价值信息。 12. 约束的常见类型有: 单调性约束; 反单调性约束; 可转变的约束; 简洁性约束. 13. 根据规则中涉及到的层次,多层次关联规则可以分为: 同层关联规则:如果一个关联规则对应的项目是同一个粒度层次,那么它是同层关联规则。层间关联规则:如果在不同的粒度层次上考虑问题,那么可能得到的是层间关联规 14. 按照聚类分析算法的主要思路,聚类方法可以被归纳为如下几种。 划分法:基于一定标准构建数据的划分。 属于该类的聚类方法有:k-means、k-modes、k-prototypes、k-medoids、PAM、CLARA、CLARANS等。 层次法:对给定数据对象集合进行层次的分解。 密度法:基于数据对象的相连密度评价。 网格法:将数据空间划分成为有限个单元(Cell)的网格结构,基于网格结构进行聚类。 模型法:给每一个簇假定一个模型,然后去寻找能够很好的满足这个模型的数据集。 15. 类间距离的度量主要有: 最短距离法:定义两个类中最靠近的两个元素间的距离为类间距离。 最长距离法:定义两个类中最远的两个元素间的距离为类间距离。 中心法:定义两类的两个中心间的距离为类间距离。</p><h2>谢运洁-浅论Web使用挖掘</h2><p>浅Web使用挖掘 谢运洁 (武汉大学信息管理学院,重庆教育学院图书馆重庆 400067) 摘要:系统介绍了Web使用挖掘的相关概念、基本流程以及各种方法在Web使用挖掘中的应用。 关键词:信息分析数据挖掘 Web使用挖掘 正文: 0引言 随着Internet和网络技术的进一步发展,许多企业机构都拥有了自己的Web站点,向用户提供各种基于Web的信息服务,如电子商务、网上银行、用户反馈、技术支持等等,对他们来讲,如何更好地向用户提供更具有针对性的服务,根据用户的网络行为来推测企业未来的发展策略变得十分重要。同时,Web网页在以惊人的速度增长,新闻、广告、教育、经济等各种信息充斥在用户面前,加上其更新速度也越来越快,使得用户在信息的海洋中无所适从,如何把信息在恰当的时间、恰当的地点以恰当的方式提供给用户更是我们必须解决的问题。Web使用挖掘,其任务是挖掘Web用户的行为模式,根据挖掘结果改进站点结构,减少用户在获取所需信息或产品之前的寻找时间,向特定用户主动提供个性化服务。 1基本概念 1.1Web数据挖掘 Web数据挖掘是指利用数据挖掘技术对Web存取模式、Web结构和规则,以及动态Web内容的查找。一般地,根据挖掘对象的不同,可以将Web数据挖掘分为三大类:Web内容挖掘(Web Content Mining)、Web结构挖掘(Web Structure Mining)和Web使用挖掘(Web Usage Mining),另外web结构挖掘可以被认为是Web内容挖掘的一部分,这样可以简单的把Web挖掘分为Web 内容挖掘和Web使用挖掘。 1.2Web使用挖掘 Web使用挖掘是指利用数据挖掘技术对Web服务器中的日志记录进行分析,发现各种用户使用模式的过程,其目的在于更好的为用户提供各种服务。Web使用挖掘可以挖掘出用户的隐藏信息,根据用户行为趋势确定企业未来的战略方向。Web使用挖掘的基本流程主要包括数据准备、数据预处理、模式发现和模式分析几个步骤。 2数据准备 Web使用挖掘的数据来源大致可分为三大块:服务器端(Server Log File)、中介代理端(Intermediary Data)以及客户端(Client Side Data)。 2.1服务器端数据 2.1.1服务器日志文件(Server Log File) Web服务器日志文件是一个存储用户基本信息、描述用户浏览行为信息的文件。特别是,它可以存储用户浏览网页时沿着网页链接所产生的点击流序列信息,是Web使用挖掘的主要数据来源。Web服务器日志通常以两种格式存储文件:普通日志文件格式(Common Log File Format),它可以存储用户IP、用户名、请求文件名、文件大小及服务器名等最基本的信息;扩展日志格式(Extended Log Format),存储了一些额外的信息,比如主机地址、请求日期和时间、用户名、传输字节数、事务完成时间等。Web使用挖掘把Web服务器日志作为主要</p><h2>WEB日志格式.doc</h2><p>WEB日志格式 轻松看懂WEB日志格式 WEB日志是网站分析和网站数据仓库的数据最基础来源,了解其格式和组成将有利于更好地进行数据的收集、处理和分析。 1、日志格式类型 目前常见的WEB日志格式主要由两类,一类是Apache的NCSA日志格式,另一类是IIS的W3C日志格式。NCSA格式又分为NCSA普通日志格式(CLF)和NCSA扩展日志格式(ECLF)两类,目前最常用的是NCSA扩展日志格式(ECLF)及基于自定义类型的Apache日志格式;而W3C扩展日志格式(ExLF)具备了更为丰富的输出信息,但目前的应用并不广泛,所以这里主要介绍的是NCSA 扩展日志格式(ECLF)。 2、常见日志格式的组成 这是一个最常见的基于NCSA扩展日志格式(ECLF)的Apache日志样例: 58.61.164.141 – – [22/Feb/20xx:09:51:46 +0800] "GET /reference-and-source/weblog-format/ HTTP/1.1″ 206 6326 " ; "Mozilla/4.0 (compatible; MSIE 6.0; Windows NT 5.1)"</p><p>可以看到这个日志主要由以下几个部分组成: 访问主机(remotehost) 显示主机的IP地址或者已解析的域名。 标识符(Ident) 由identd或直接由浏览器返回浏览者的EMAIL或其他唯一标示,因为涉及用户邮箱等隐私信息,目前几乎所有的浏览器就取消了这项功能。 授权用户(authuser) 用于记录浏览者进行身份验证时提供的名字,如果需要身份验证或者访问密码保护的信息则这项不为空,但目前大多数网站的日志这项也都是为空的。 日期时间(date) 一般的格式形如[22/Feb/20xx:09:51:46 +0800],即[日期/月份/年份:小时:分钟:秒钟时区],占用的的字符位数也基本固定。 请求(request) 即在网站上通过何种方式获取了哪些信息,也是日志中较为重要的一项,主要包括以下三个部分: 请求类型(METHOD) 常见的请求类型主要包括GET/POST/HEAD这三种; 请求资源(RESOURCE) 显示的是相应资源的URL,可以是某个网页的地址,也可</p><h2>web日志分析常用方法及应用</h2><p>Web日志挖掘分析的方法 日志文件的格式及其包含的信息 ①2006-10-17 00:00:00②202.200.44.43 ③218.77.130.24 80 ④GET ⑤/favicon.ico ⑥Mozilla/5.0+(Windows;+U;+Windows+NT+5.1;+zh-CN;+rv: 1.8.0.3)+Gecko/20060426 +Firefox/1.5.0.3。 ①访问时间;②用户IP地址;③访问的URL,端口;④请求方法(“GET”、“POST”等); ⑤访问模式;⑥agent,即用户使用的操作系统类型和浏览器软件。 一、日志的简单分析 1、注意那些被频繁访问的资源 2、注意那些你网站上不存在资源的请求。常见的扫描式攻击还包括传递恶意参数等: 3、观察搜索引擎蜘蛛的来访情况 4、观察访客行为 应敌之策: 1、封杀某个IP 2、封杀某个浏览器类型(Agent) 3、封杀某个来源(Referer) 4、防盗链 5、文件重命名 作用: 1.对访问时间进行统计,可以得到服务器在某些时间段的访问情况。 2.对IP进行统计,可以得到用户的分布情况。 3.对请求URL的统计,可以得到网站页面关注情况。 4.对错误请求的统计,可以更正有问题的页面。 二、Web挖掘 根据所挖掘的Web 数据的类型,可以将Web 数据挖掘分为以下三类:Web 内容挖掘(Web Content Mining)、Web 结构挖掘(Web Structure Mining)、Web 使用挖掘(Web Usage Mining)(也称为Web日志挖掘)。 ①Web内容挖掘。Web内容挖掘是指从文档的内容中提取知识。Web</p><h2>Linux1 WEB服务器 日志管理工具</h2><p>Linux1 WEB服务器日志管理工具 Red Hat Enterprise 5.4操作系统提供了两种实用的日志管理工具rotatelogs和logrotate,熟练地使用它们能够帮助用户轻松的维护日志。 1.rotatelogs Rotatelogs工具是一个配合Apache管理日志功能的简单程序,它包括两个选项:Logersolve和Rotatelogs。其中Logresolve选项可以将日志文件中的IP地址解析为主机名,而Rotatelogs选项可以在不停止服务器的情况下循环处理日志文件,用户也可以设置循环时间。如这条配置语句所示:CustomLog “|bin /rotatelogs /var/logs/logfile.nnnn 86400”common。 上述配置语句会建立文件/var/logs/logfile.nnnn,其中nnnn是日志文件启动时的系统时间(此时间总是滚动时间的倍数,可以用于cron脚本的同步)。语句中86400表示滚动时间,在到达该时间时会产生一个新的日志文件,时间的单位为秒,上面标示24小时。 除了指定日志文件滚动的时间外,还可以指定日志文件的大小,当达到指定大小时会创建新的日志文件,如该的配置语句所示:CustomLog “|bin /rotatelogs /var/logs/logfile 5M”common,该配置语句表示,当日志文件大小增加到5MB时自动创建新的日志文件。 2.logrotate Logrotate工具用于删除旧日志文件,并创建新的日志文件,将这一过程称为滚动。该设置可以根据日志文件的大小,也可以根据其天数来设置,这个过程一般通过cron程序来执行。Logrotate程序还可以压缩日志文件,以及发送日志到指定的E-mail。 Logrotate工具的配置文件时/etc/logrotate.conf,找到并打开该文件,可以看到如图68所示的内容。 图68 logrotate工具的配置文件内容</p><h2>数据挖掘在Web中的应用案例分析</h2><p>[数据挖掘在Web中的应用] 在竞争日益激烈的网络经济中,只有赢得用户才能最终赢得竞争的优势。作为一个网站,你知道用户都在你的网站上干什么吗?你知道你的网站哪些部分最为用户喜爱、哪些让用户感到厌烦?什么地方出了安全漏洞?什么样的改动带来了显著的用户满意度提高、什么样的改动反而丢失了用户?你怎样评价你的网站广告条的效率、你知道什么样的广告条点击率最高吗?“知己知彼,才能百战不殆”,你真的了解自己吗?挑战的背后机会仍存,所有客户行为的电子化(Click Stream),使得大量收集每个用户的每一个行为数据、深入研究客户行为成为可能。如何利用这个机会,从这些“无意义”的繁琐数据中得到大家都看得懂的、有价值的信息和知识是我们面临的问题。 [问题]: 1.根据你所学的知识,思考从网站中所获取的大量数据中,我们能做哪些有意义的数据分 析? 基于WEB 使用的挖掘,也称为WEB 日志挖掘(Web Log Mining)。与前两种挖掘方式以网上的原始数据为挖掘对象不同,基于WEB 使用的挖掘面对的是在用户和网络交互的过程中抽取出来的第二手数据。这些数据包括:网络服务器访问记录、代理服务器日志记录、用户注册信息以及用户访问网站时的行为动作等等。WEB 使用挖掘将这些数据一一纪录到日志文件中,然后对积累起来的日志文件进行挖掘,从而了解用户的网络行为数据所具有的意义。我们前面所举的例子正属于这一种类型。 基于WEB 内容的挖掘:非结构化半结构化\文本文档超文本文档\Bag of words n-grams 词短语概念或实体关系型数据\TFIDF 和变体机器学习统计学(包括自然语言处理)\归类聚类发掘抽取规则发掘文本模式建立模式. 基于WEB 结构的挖掘:半结构化数据库形式的网站链接结构\超文本文档链接\边界标志图OEM 关系型数据图形\Proprietary 算法ILP (修改后)的关联规则\发掘高频的子结构发掘网站体系结构归类聚类. 基于WEB 使用的挖掘:交互形式\服务器日志记录浏览器日志记录\关系型表图形\Proprietary 算法机器学习统计学(修改后的)关联规则\站点建设改进与管理销建立用户模式. 2.根据你所学的数据挖掘知识,谈谈哪些数据挖掘技术可以应用于Web中,以这些数据挖 掘技术可以完成哪些功能? Web Mining 技术已经应用于解决多方面的问题,比如基于WEB 内容和结构的挖掘极大的帮助了我们从浩瀚的网络资源中更加快速而准确的获取所需要的资料,而基于使用的数据挖掘之威力,更是在商业运作上发挥的淋漓尽致,具体表现在: (1)对网站的修改能有目的有依据稳步的提高用户满意度 发现系统性能瓶颈,找到安全漏洞,查看网站流量模式,找到网站最重要的部分,发现用户的需要和兴趣,对需求强烈的地方提供优化,根据用户访问模式修改网页之间的连接,把用户想要的东西以更快且有效的方式提供给用户,在正确的地方正确的时间把正确的信息提供给正确的人。 (2)测定投资回报率 测定广告和促销计划的成功度 找到最有价值的ISP 和搜索引擎 测定合作和结盟网站对自身的价值</p><h2>Web日志挖掘技术的研究与应用</h2><p>面对巨大而复杂的网络系统以及浩如烟海的信息资 源,研究人员将传统的数据挖掘技术和相结合,进行Web 挖掘,从半结构或无结构的页面中,以及使用者的Web Web 活动中,抽取感兴趣的、潜在的模式,分析、研究,并加以利用。 挖掘可分为类:内容挖掘、结构挖掘和 Web 3Web Web 日志挖掘。而日志挖掘作为挖掘的一个重要组 Web Web Web 成部分,有其独特的理论和实践意义。 所谓日志,是指在服务器上有关访问的各种日Web Web 志文件,包括访问日志、引用日志、代理日志、错误日志等文件。这些文件里包含了大量的用户访问信息,如用户的IP 地址、所访问的、访问日期和时间、访问方法或URL (GET 、访问结果功、失败、错误、访问的信息大小等。 POST)()而日志挖掘,就是通过对日志记录的挖掘,发Web Web 现用户访问页面的模式,从而进一步分析和研究日Web Web 志记录中的规律,以期改进站点的性能和组织结构,提Web 高用户查找信息的质量和效率,并通过统计和关联的分析找出特定用户与特定地域、特定时间、特定页面等要素之间的内在联系,这在电子商务等领域是大有作为的。 日志挖掘技术 1 Web 目前,日志挖掘技术主要分为两大类:基于事Web Web 务的方法和基于数据立方体的方法。基于事务的日志挖掘技术 1.1 Web Web 基于事务的日志挖掘技术最早是由 等人Web Web ,Chen [1]提出的图。他将数据挖掘技术应用于服务器日志文 (1)Web 件,提出最大向前引用算法的概念。他将用户会话分割 MF 成一系列的事务,然后采用与关联规则相类似的方法挖掘频繁访问序列,从而取得用户访问模式。 基于事务的日志挖掘技术的基本流程是:Web 预处理过程服务器日志中的内容非常丰富,(1) Web 但是由于本地缓存、代理服务器、防火墙的存在,使得直接在数据上进行挖掘变得十分困难和不准确。因此, Web log 在实施数据挖掘之前,首先必须对 文件进行数据净Web Log 化、用户识别、会话识别、页面过滤、路径补充等一系列的 工作[9] 。数据净化是指删除日志中与挖掘(Data Cleaning)Web 算法无关的数据,同时将有用的日志记录信息转换为适Web 当的数据格式。用户识别和会话识别是从日志中的每一条记录中识别出相应的用户,并将日志中的多条记录分割为不同的事务。页面过滤是针对页面的帧结构,对Web Web (Frame)日志记录进一步过滤,而路径补充则是考虑到用户可能在浏览器中使用方式而使日志中遗漏了访问信息。 Back Web 序列模式识别事务分割完成以后,接下来就(2) Web 是实施序列模式识别的工作。第一步,通过算法""MF 将日志数据中原始序列,转换为(Maximal Forward Refences)最大向前引用集,其中的每一个访问子序列都代表一个从用户访问点出发的最大向前引用,其目的是过滤掉为了取消访问而产生的回退引用的影响,从而使我们能专注于挖掘有意义的用户访问序列。第二步,从最大向前引用集中找出大"引用序列,也就是频繁出现的 "(Large Reference Sequences)引用序列。其方法和挖掘关联规则[3] 的方法相类似,但不同的是,在挖掘访问模式时,一个引用序列必须是包含在最大向前引用中的连续引用,而在挖掘关联规则时,一个 大项目集仅仅是一个事务中的项目的集合。为了找出大""引用序列,等人提出了和Chen FS(Full Scan)SS(Selective 两种算法。算法从本质上说,是利用了一些和 Scan)FS Hash 日志挖掘技术的研究与应用 Web 肖立英,李建华,谭立球 (中南大学铁道校区信息技术研究中心长沙) , 410075摘要: 介绍了目前世界上两种主要的日志挖掘技术基于事务和基于数据立方体。同时,提出了一个基于日志挖掘技术的应Web (Web )Web 用,即用户自适应的站点,介绍了这一系统的实现方法和主要特色。Web 关键词:数据挖掘;挖掘;日志挖掘;用户自适应的站点 Web Web Web Research and Application of Web Log Mining XIAO Liying, LI Jianhua, TAN Liqiu (Information Technology Research Center, Tiedao Campus,South-Central University, Changsha,410075) 【】 Abstract In this paper, the two methods of Web Log Mining (Web Session and Data Cube) are introduced. And then this paper presents the design of the adaptive site which is an application of the Web Log Mining. 【】;;;Key words Data mining Web mining Web log mining Adaptive Web site 第卷 第期287№ Vol.28 7计 算 机 工 程Computer Engineering 年月 20027 July 2002 ?开发研究与设计技术? 中图分类号: TP182 文章编号:———10003428(2002)07 027602 文献标识码:A —— 276 Web 日志 预处理过程序列模式识别图一 Chen 为代表的基于Web 事务的方法 序列模式分析 图为代表的基于 事务的方法1 Chen Web 日志 Web 预处理过程序列模式识别 序列模式分析</p><h2>WebTracker日志配置的几种常见方法</h2><p>常见Web日志切割方法 本文档就IIS、Apache、Tomcat常见Web服务下的日志切割及发布进行说明。 配置前说明 --------------------------------------------------------- 2 IIS服务器---------------------------------------------------------- 3 1、日志文件切割--------------------------------------------- 3 2、配置网站日志--------------------------------------------- 3 3、日志文件获取方法----------------------------------------- 6 4、Win2003 Server log文件可下载配置------------------------ 8 5、设置虚拟目录IP访问限制--------------------------------- 10 Apache服务器------------------------------------------------------ 11 1、日志分割设置-------------------------------------------- 11 2、设置虚拟目录来发布日志---------------------------------- 12 Tomcat服务器------------------------------------------------------ 14 1、日志分割设置-------------------------------------------- 14 2、设置虚拟目录来发布日志---------------------------------- 15</p><h2>spring aop记录Web系统操作日志</h2><p>spring aop记录Web系统操作日志配置文件: Xl代码 <d="lgA"l="q365vylgSyLgA"> <fg> <f="lgA"> <> <fg> 实现代码: Jv代码 ** *系统操作日志切面 * *@1 *11-3-1下午443 * @A llSyLgA{ 与lg之Cl会动为其封装类型之Cl vflSggClzz="ljvlgIg"; vflSglgClzz="ljvlgLg"; @R vSyLgSvyLgSv; vLgglgg=LgggLgg(gCl()gN()); @P("(*q365v**())") lvdyA(){ }; @AfTg(="yA()",g="") lvddAfTg(JPj,Tl){ Syl("出现异常"+gMg()); Syl(gCl()gN()); Syl("异常所在类"+jgTg()gCl()gN()); Syl(""+jgSg()gN() +"方法"); lgg("错误!级别的!!!"+gMg());</p><p>lgg("O==="+jgTg()gCl()gN()+"中的" +jgSg()gN()+"方法抛出"+gCl()gN() +"异常"); Syl("参数"); ; f(jgAg()!=ll&&jgAg()lg>){ f(=;<jgAg()lg;++){ Syl(jgAg()[]Sg()); lgg("参数:--"+jgAg()[]Sg()); } } } @SWg("kd") @Af("@(q365ySyLgA)") lvddAf(JPj){ Syl("----------后置通知"); Syl("方法所在类"+jgTg()gCl()gN()); Syl(""+jgSg()gN()+"方法"); SgdN=jgSg()gN(); 操作日志对象----------------- SyLgyLg=SyLg(); 操作参数----------------- SgdAg="参数"; f(jgAg()!=ll&&jgAg()lg>){ f(=;<jgAg()lg;++){ f(jgAg()[]!=ll){ Syl(jgAg()[]Sg()); dAg+=jgAg()[]Sg()+","; }l{ dAg+="ll"+","; } } Syl("------参数"+dAg); } yLgOAg(dAg); Sgd=ll;方法描述 f(!(dNW("")||dNW("g"))){ ClgCl=jgTg()gCl();</p><h2>WEB日志格式及分析.doc</h2><p>WEB日志格式及分析 网站日志挖掘分析-WEB日志格式及分析工具 WEB日志是网站分析和网站数据数据整理最基础的数据,了解其格式和组成将有利于更好地进行数据的收集、处理和分析。 一、日志格式类型 目前常见的WEB日志格式主要由两类,一类是Apache的NCSA 日志格式,另一类是IIS的W3C日志格式。NCSA格式又分为NCSA普通日志格式(CLF)和NCSA扩展日志格式(ECLF)两类,目前最常用的是NCSA扩展日志格式(ECLF)及基于自定义类型的Apache日志格式;而W3C扩展日志格式(ExLF)具备了更为丰富的输出信息,但目前的应用并不广泛,所以这里主要介绍的是NCSA扩展日志格式(ECLF)。 二、常见日志格式的组成 这是一个最常见的基于NCSA扩展日志格式(ECLF)的Apache日志样例: 可以看到这个日志主要由以下几个部分组成: 访问主机(remotehost)显示主机的IP地址或者已解析的域名。 标识符(Ident)由identd或直接由浏览器返回浏览者的EMAIL 或其他唯一标示,因为涉及用户邮箱等隐私信息,目前几乎所有的浏览器就取消了这项功能。 授权用户(authuser)用于记录浏览者进行身份验证时提供的</p><p>名字,如果需要身份验证或者访问密码保护的信息则这项不为空,但目前大多数网站的日志这项也都是为空的。 日期时间(date)一般的格式形如[22/Feb/20xx:09:51:46 +0800],即[日期/月份/年份:小时:分钟:秒钟时区],占用的的字符位数也基本固定。 请求(request)即在网站上通过何种方式获取了哪些信息,也是日志中较为重要的一项,主要包括以下三个部分: 请求类型(METHOD)常见的请求类型主要包括GET/POST/HEAD 这三种; 请求资源(RESOURCE)显示的是相应资源的URL,可以是某个网页的地址,也可以是网页上调用的图片、动画、CSS等资源; 协议版本号(PROTOCOL)显示协议及版本信息,通常是HTTP/1.1或HTTP/1.0。 状态码(status)用于表示服务器的响应状态,通常1xx的状态码表示继续消息;2xx表示请求成功;3xx表示请求的重定向;4xx表示客户端错误;5xx表示服务器错误。 传输字节数(bytes)即该次请求中一共传输的字节数。 来源页面(referrer)用于表示浏览者在访问该页面之前所浏览的页面,只有从上一页面链接过来的请求才会有该项输出,如果是新开的页面则该项为空。上例中来源页面是google,即用户从google 搜索的结果中点击进入。 用户代理(agent)用于显示用户的详细信息,包括IP、OS、</p></div>

<div class="rtopicdocs">

<div class="coltitle">相关主题</div>

<div class="relatedtopic">

<div id="tabs-section" class="tabs">

<ul class="tab-head">

<li id="1132715"><a href="/topic/1132715/" target="_blank">web日志挖掘</a></li>

<li id="23446890"><a href="/topic/23446890/" target="_blank">web日志</a></li>

<li id="11302513"><a href="/topic/11302513/" target="_blank">web使用挖掘</a></li>

<li id="14823801"><a href="/topic/14823801/" target="_blank">web访问日志</a></li>

</ul>

</div>

</div>

</div>

</div>

<div id="rightcol" class="viewcol">

<div class="coltitle">相关文档</div>

<ul class="lista">

<li><a href="/doc/4713075619.html" target="_blank">web日志分析常用方法及应用</a></li>

<li><a href="/doc/6416878793.html" target="_blank">Web日志挖掘最新</a></li>

<li><a href="/doc/406128914.html" target="_blank">Web日志挖掘中的会话识别方法</a></li>

<li><a href="/doc/6111046861.html" target="_blank">浅谈Web日志挖掘技术</a></li>

<li><a href="/doc/0b12849761.html" target="_blank">网站日志分析的具体方法和步骤【基础】</a></li>

<li><a href="/doc/8414979212.html" target="_blank">WEB日志挖掘技术的研究</a></li>

<li><a href="/doc/4118753327.html" target="_blank">基于Hadoop的Web日志挖掘</a></li>

<li><a href="/doc/8f4713924.html" target="_blank">Web日志挖掘技术的研究与应用</a></li>

</ul>

<div class="coltitle">最新文档</div>

<ul class="lista">

<li><a href="/doc/0f19509601.html" target="_blank">幼儿园小班科学《小动物过冬》PPT课件教案</a></li>

<li><a href="/doc/0119509602.html" target="_blank">2021年春新青岛版(五四制)科学四年级下册 20.《露和霜》教学课件</a></li>

<li><a href="/doc/9b19184372.html" target="_blank">自然教育课件</a></li>

<li><a href="/doc/3019258759.html" target="_blank">小学语文优质课火烧云教材分析及课件</a></li>

<li><a href="/doc/d819211938.html" target="_blank">(超详)高中语文知识点归纳汇总</a></li>

<li><a href="/doc/a419240639.html" target="_blank">高中语文基础知识点总结(5篇)</a></li>

<li><a href="/doc/9d19184371.html" target="_blank">高中语文基础知识点总结(最新)</a></li>

<li><a href="/doc/8a19195909.html" target="_blank">高中语文知识点整理总结</a></li>

<li><a href="/doc/8519195910.html" target="_blank">高中语文知识点归纳</a></li>

<li><a href="/doc/7f19336998.html" target="_blank">高中语文基础知识点总结大全</a></li>

<li><a href="/doc/7119336999.html" target="_blank">超详细的高中语文知识点归纳</a></li>

<li><a href="/doc/6619035160.html" target="_blank">高考语文知识点总结高中</a></li>

<li><a href="/doc/6719035161.html" target="_blank">高中语文知识点总结归纳</a></li>

<li><a href="/doc/4a19232289.html" target="_blank">高中语文知识点整理总结</a></li>

<li><a href="/doc/3b19258758.html" target="_blank">高中语文知识点归纳</a></li>

<li><a href="/doc/2619396978.html" target="_blank">高中语文知识点归纳(大全)</a></li>

<li><a href="/doc/2b19396979.html" target="_blank">高中语文知识点总结归纳(汇总8篇)</a></li>

<li><a href="/doc/1419338136.html" target="_blank">高中语文基础知识点整理</a></li>

<li><a href="/doc/ed19066069.html" target="_blank">化工厂应急预案</a></li>

<li><a href="/doc/bd19159069.html" target="_blank">化工消防应急预案(精选8篇)</a></li>

</ul>

</div>

</div>

<script>

var sdocid = "84b579aad1f34693daef3e59";

</script>

<div class="clearfloat"></div>

<div id="footer">

<div class="ft_info">

<a href="https://beian.miit.gov.cn">闽ICP备16038512号-3</a> <a href="/tousu.html" target="_blank">侵权投诉</a> ©2013-2023 360文档中心,www.360docs.net | <a target="_blank" href="/sitemap.html">站点地图</a><br />

本站资源均为网友上传分享,本站仅负责收集和整理,有任何问题请在对应网页下方投诉通道反馈

</div>

<script type="text/javascript">foot()</script>

</div>

</body>

</html>