面向云计算的键值型分布式存储系统研究

面向云计算的键值型分布式存储系统研究

孙 勇1

,林 菲2

,王宝军

1

(1.浙江交通职业技术学院信息学院,浙江杭州311112;2.杭州电子科技大学软件工程学院,浙江杭州310018)

摘 要: 对于数据密集型的云计算应用,基于磁盘的存储系统很难同时满足它们对性能与可用性的需求.本文

提出了一种以内存为主设备、以磁盘为辅助设备的键值型分布式存储系统M -Cloud ,能提供大数据读写、备份及恢复等存储服务功能.M -Cloud 通过将数据全部装入服务器集群内存中的方式提高系统整体性能,并设计了分区线性哈希算法以实现负载均衡和高扩展性,设计了相应的数据备份与故障快速恢复策略以保证系统可靠性.仿真实验结果表明,M -Cloud 具有较高的性能与可用性,对系统进一步改进和优化后具有应用于实际生产环境中的潜力,可为用户提供高质量的存储服务.

关键词: 云计算;键值;分布式存储系统;线性哈希;故障恢复中图分类号: TP302 文献标识码: A 文章编号: 0372-2112(2013)07-1406-06电子学报URL :http ://www .ejournal .org .cn

DOI :10.3969/j .issn .0372-2112.2013.07.025

Stu dy on the Key -Value Distribu ted Stora ge System for Cloud Computin g

SUN Yong 1,LI N Fei 2,W ANG Bao -jun 1

(1.Depar tment of Inf or mation Te chnol ogy ,Zhej iang Institute of C ommunications ,Hangzhou ,Zhej iang 311112,C hina ;

2.School of Soft war e Enginee ring ,Hangzhou Dianzi Uni vers ity ,Hangzhou ,Zhe jiang 310018,C hina )

Abstract : In view of data intensive cloud co mputi ng applications ,disk -based storage systems are difficult to meet their de -mand for performance and availability simultaneou sly .T his paper puts forward a key -value distributed sto rage system named M -Cloud ,which uses memory as main device and disk as auxiliary w hen providing storage services (read ,write ,backup and recovery )for big data .M -Cloud improves ov erall system performance by loading entire data in the memory of the cluster ,and designs PBL H (partition -based linear hashing )algorithm to achieve load balancing and high scalability .M -Cloud also designs relative backu p and fast crash recovery strategy in order to ensure high system reliability .The simulation results show that M -Cloud has high perfor -mance and availability ,with further optimization ,the system has the potential in real production environment usage ,can provide u sers with hig h -quality storage services .

Key words : cloud computing ;key -value ;di stributed storage system ;linear hashing ;crash recover y

1 引言

云计算[1]将各类软硬件设施封装为资源,以服务形

式通过互联网提供给各类用户进行按需使用.云服务提供商必须以相关软硬件的统计复用和批量采购为基础,构建并运营超大型数据中心,同时为整个系统提供高效的管理框架[2].作为云计算的重要基础部件,存储系统的应用场合及需求均不断增加,推动了许多云存储技术[3,4]的出现和发展.基于磁盘的存储系统已经很难满足云计算需求,而内存具有低延时、高吞吐的特点,只是由于容量价格等因素限制,尚未被作为首要的存储设备.

利用内存计算技术提高分布式存储系统的整体性能已是当前学术界的一个研究热点.谷歌和雅虎公司的搜索引擎将全部的搜索项索引保存在内存中,谷歌的Bigtable [5]技术允许把全部“列族”数据载入内存,但它们仅将内存作为缓存使用.传统关系型数据库处理大数据能力的不足已日益凸显,NoSQL [6]在此背景下以其强可扩展性应运而生,但它们还是以磁盘作为首要存储设备,系统性能并未提升.Memcached [7]是一种基于缓存技术的键值型存储系统,具有处理速度快的特点,但不保证数据持久性,2010年发生的一次故障导致基于Mem -cached 技术的Facebook 网站丢失了28TB 数据,服务终止了2.5小时.

收稿日期:2012-07-26;修回日期:2013-01-20;责任编辑:李勇锋

基金项目:浙江省自然科学基金(No .LY12F02017);浙江省教育厅科研项目(No .Y201223461)

第7期2013年7月电 子 学 报ACTA ELECTRONICA SINICA Vol .41 No .7

Jul . 2013

本文提出一种以内存为首要存储设备,以磁盘为备份存储设备的键值型分布式存储系统(M -Cloud ),做

出研究贡献如下:(1)通过将全部数据保存在内存中和磁盘备份的方式在提高系统性能的同时实现了数据持久性;(2)通过多备份磁盘加多目标内存的并行快速故障恢复策略保证了存储系统的高可用性与可靠性.

2 M -Cloud 系统架构及相关定义

与其它分布式存储系统相比,M -Cloud 主要有2个特点:第一是将所有数据保存在服务器(存储节点)的

内存中,磁盘仅作为备份设备使用;第二是支持动态伸缩的大规模服务器集群,并将所有机器的内存作为一个统一存储系统对外提供服务.

2.1 数据模型

M -Cloud 本质上是一种改进的键值型存储系统,将数据以键值对的形式存储在内存中,利用备份设备(磁盘)并行地实现数据持久性与故障恢复.

定义1 在M -Cloud 中,所有数据均被封装成由

M -Cloud 不解析数据内容,不识别任何数据结构,这使其可处理所有数据类型.因为数据是无结构的,所以M -Cloud 不支持条件查询等操作,将此类任务交由上层应用完成,以牺牲传统数据库丰富功能(例如条件查询、事务)为代价来获取高可扩展性.

M -Cloud 不直接写入Obj 数据,而是将其压缩后(默认使用可变字节编码[8])存储以节省空间.此外,由于许多操作可直接针对压缩数据进行,所以读取性能也会有相应的提高,因为解压缩的CPU 开销不会超过逻辑上更高内存带宽所带来的增益.

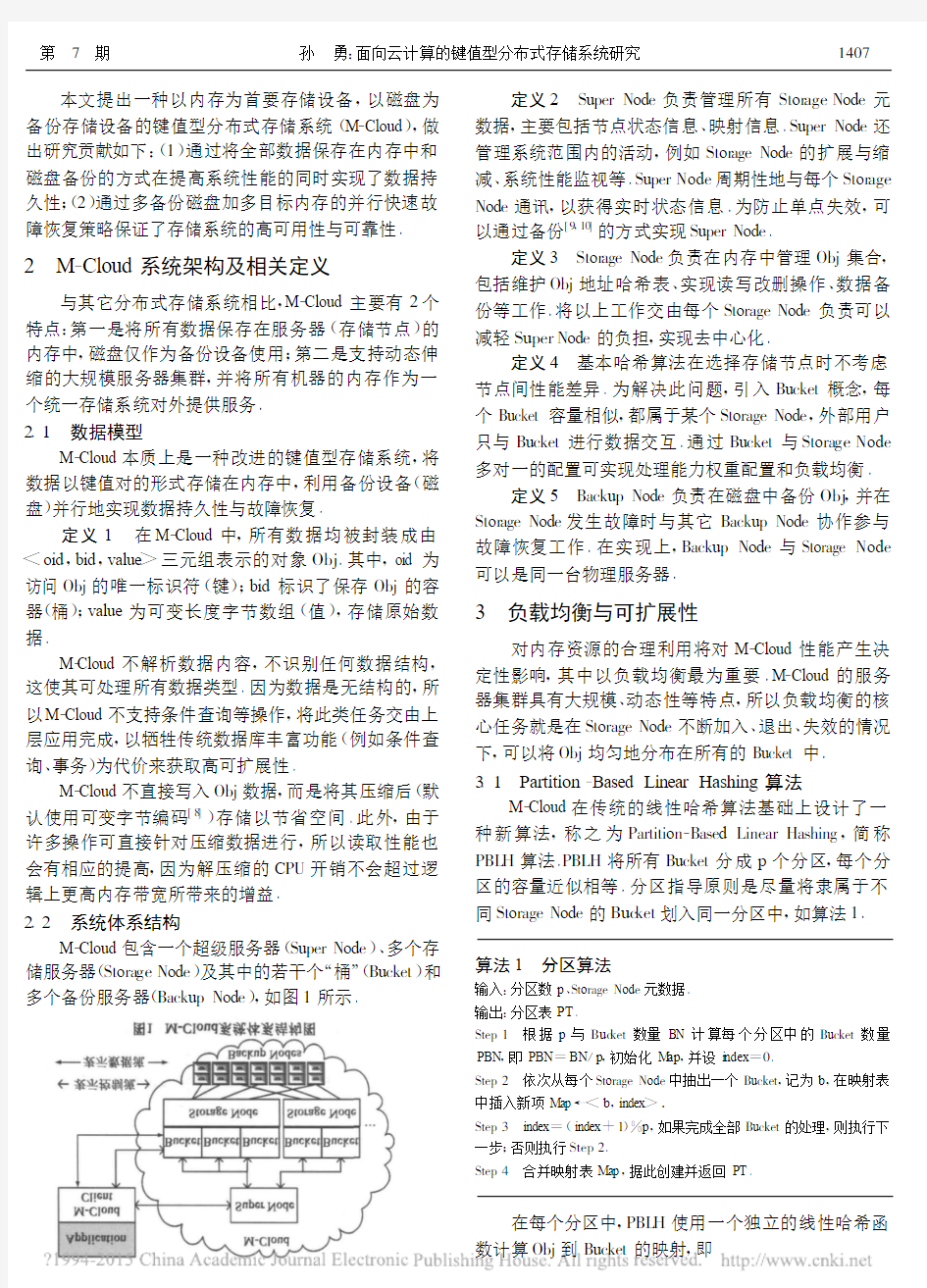

2.2 系统体系结构

M -Cloud 包含一个超级服务器(Super Node )、多个存储服务器(Stora ge Node )及其中的若干个“桶”(Bucket )和多个备份服务器(Backup Node ),如图1所示

.

定义2 Super Node 负责管理所有Stor age Node 元数据,主要包括节点状态信息、映射信息.Super Node 还管理系统范围内的活动,例如Stor age Node 的扩展与缩减、系统性能监视等.Super Node 周期性地与每个Stor age Node 通讯,以获得实时状态信息.为防止单点失效,可

以通过备份[9,10]

的方式实现Super Node . 定义3 Stor age Node 负责在内存中管理Obj 集合,包括维护Obj 地址哈希表、实现读写改删操作、数据备份等工作.将以上工作交由每个Storage Node 负责可以减轻Super Node 的负担,实现去中心化.

定义4 基本哈希算法在选择存储节点时不考虑节点间性能差异.为解决此问题,引入Bucket 概念,每个Bucket 容量相似,都属于某个Storage Node ,外部用户只与Bucket 进行数据交互.通过Bucket 与Stora ge Node 多对一的配置可实现处理能力权重配置和负载均衡. 定义5 Backup Node 负责在磁盘中备份Obj ,并在Stor age Node 发生故障时与其它Backup Node 协作参与故障恢复工作.在实现上,Backup Node 与Storage Node 可以是同一台物理服务器.

3 负载均衡与可扩展性

对内存资源的合理利用将对M -Cloud 性能产生决定性影响,其中以负载均衡最为重要.M -Cloud 的服务

器集群具有大规模、动态性等特点,所以负载均衡的核心任务就是在Storage Node 不断加入、退出、失效的情况下,可以将Obj 均匀地分布在所有的Bucket 中.

3.1 Partition -Based Linear Hashing 算法

M -Cloud 在传统的线性哈希算法基础上设计了一种新算法,称之为Partition -Based Linear Hashing ,简称PBL H 算法.PBLH 将所有Bucket 分成p 个分区,每个分区的容量近似相等.分区指导原则是尽量将隶属于不同Storage Node 的Buc ket 划入同一分区中,如算法1.

算法1 分区算法

输入:分区数p 、Storage Node 元数据.输出:分区表PT .

Step 1 根据p 与Buc ket 数量BN 计算每个分区中的Bucket 数量PBN ,即PBN =BN /p ,初始化M ap ,并设i ndex =0.

Step 2 依次从每个Storage Node 中抽出一个Bucket ,记为b ,在映射表中插入新项Map →.

Step 3 index =(index +1)%p ,如果完成全部Bucket 的处理,则执行下一步;否则执行Step 2.

Step 4 合并映射表Map ,据此创建并返回PT .

在每个分区中,PBL H 使用一个独立的线性哈希函数计算Obj 到Bucket 的映射,即

1407

第 7 期孙 勇:面向云计算的键值型分布式存储系统研究

H(oid)=M(oid)%2i+1,if M(oid)%2i+1 M(oid)%2i,else (1) 其中:N为分区内Buc ket总数,i=log 2 (N)」 函数M的作用是为Obj生成一个b(2b>N)位长度的键(默认采用SHA-1[11]).对于一个Obj,PBL H从p 个分区中选择负载最小的Bucket作为它的容器,具体步骤如算法2. 算法2 分区线性哈希算法 输入:分区数p、obj(待处理的Obj). 输出:存放obj的Bucket. Step1 在每个分区中,将obj的oid代入式(1),计算出H(oid),并生成长度为p的候选Bucket集合. Step2 向p个候选Bucket所在的s(s≤p)个Storage Node发送负载查询请求. Step 3从Step2的计算结果中选取负载最小的Bucket作为obj的容器,并根据该Bucket更新obj的bid属性. Step4 返回obj.bi d. 3.2 PBLH算法的可扩展性 为提高可扩展性,哈希函数应能动态调整,并使重定位工作最小化.目前具备此种能力的哈希算法包括一致性哈希[12]、可扩展性哈希[13]和线性哈希3种,多数的P2P系统均使用一致性哈希,文献[13]则应用可扩展性哈希实现了一种目录数据结构. 与另外两种算法相比,线性哈希更适合于在局域网环境下使用.同时线性哈希比一致性哈希有更高的均衡性.PBLH又引入了分区的概念,从而进一步提高了系统负载的均衡性,扩展方法如算法3. 算法3 扩展算法 输入:原分区表OPT、nsn(新增加的Storage Node). 输出:新分区表PT. Step1 初始化M ap,并设index=0. Step2 从nsn中抽出一个Bucket,记为b,在映射表中插入新项M ap → Step3 重定位分区index中b所占用的键值空间. Step4 index=(index+1)%OPT.p,如果完成nsn中全部Bucket的处理,则执行下一步;否则执行Step2. Step5 合并映射表Map,据此创建并返回PT. 可以看出,算法3以一种“轮询”的方式将新加入的Bucket依次指派到各个分区中,好处是可以动态地保持各分区的容量平衡.对于每个新的Bucket,PBL H根据式(1)自动将某个已存在的Bucket一半的键值空间移交给它,而其它Bucket均不受影响. 3.3 PBLH算法分析 PBLH主要作用是实现数据分布的动态平衡性,以保证系统可用性与可扩展性.为分析算法,定义如下: LI=W(Buc ket ma x)-∑n i=1 W(Buc ket i)/n(2)其中LI(Load I mbalance)用于衡量系统负载的不均衡性,W为计算Bucket中Obj总容量的函数,Buc ket ma x表 示系统当前负载最大的桶,n为桶的数量. 假设所有Obj大小相似,每次将一个Obj随机放到一个Bucket中,假设共有m个Obj且m>>n,则 LI≤m ln n/n(3)而如果将每个Obj随机放到k(k≥2,即分区数)个Buc ket中负载最小的桶中(PBLH),则 LI≤ln n/ln k+O(1)(4)以上推导过程可参见文献[14].因为在实际境下m>>n基本成立,从式(3)看出传统单路选择型算法的LI将随着数据量(即m)的增长而增长.但从式(4)可看出作为多路选择型的PBL H,LI与m无关,决定LI的因素只有n和k,这是PBL H算法的优点之一.PBL H的另一个优点是可以自动消除系统扩展造成的不均衡性. 定理1 当Bucket数量扩展时,PBLH会在创建新Obj的过程中逐渐地自动降低LI. 证明 假设处于均衡状态下的M-Cloud共有p个分区,每个分区平均有n个桶,每个桶装有大小相等的m个Obj,且具有大小相等的键值空间(即从PBLH映射到所有桶的概率均等).设系统扩展速率为,即每个分区在每次扩展中增加n(0< ≤1)个Bucket,每个新Buc ket根据算法3接管了某个旧Bucket一半的键值空间. 设CS为所有新加入和被分裂的Bucket集合,则C S=2p n,设R S为所有余下的Bucket集合,则RS =p(1-)n,根据上述定义,如下两个条件将满足:(1) CS中的每个Bucket中装载了m/2个Obj,RS中的每个Buc ket有m个Obj;(2)由于CS中每个Buc ket负责的键值空间是RS中的一半,所以CS中每个Buc ket被哈希映射的概率是1/2n,RS的相应概率则是1/n. 设D为Super Node可并行处理的Obj的总数量(CPU核数),设DA LL CS、DPB C S分别表示CS接收的Obj 数量与CS中每个Bucket接收的Obj的平均值,则DAL L c s:=∑D i=1 iP{X=i},DPB c s=DAL L cs/ CS (5)其中,X为服从二项分布B(p,)的随机值,概率函数P{X=i}=C i p i(1-)p-i.设DPB表示系统全部Buc ket 接收的Obj的平均值,可知 DPB=D/(pn(1+))(6) 设R为DPB C S 与DPB之间的比值,由上述推导可知 R=DPB c s/DPB=DAL L c s(1+)/2D(7) 1408 电 子 学 报2013年 从式(7)可知,当R =1时,所有Bucket 将接收相同数量的Obj ;当R <1时,CS 中Bucket 接收的Obj 数量小 于RS ,即系统将向不均衡方向发展;当R >1时,CS 将接收更多的Obj ,系统将向均衡方向发展,LI 值将逐渐降低. 定理1说明,只要p ≥2D (R >1),键值空间被分裂的Bucket 的负载最终将与未被分裂的Bucket 趋向于平衡,通过大量模拟测试表明,p =2D +1是一个最优取值. 4 数据的存储与备份 数据的存储与备份是M -Cloud 最基本的功能,通过“分段”+“追加”+“缓冲”三种方法相结合的方式实现了高效的存储管理,如图2所示 . 4.1 分段机制 M -Cloud 将每个Bucket 的内存空间划分成固定大小的Segment 并组成链表,Buc ket 负责维护一张哈希表(记为BHT ),用于记录Obj 与Segment 的映射关系,以支持内存中的数据随机访问.Segment 同时也是进行数据备份与故障恢复的基本单位,每个Backup Node 会在内存中维护一个用于缓冲数据的Segment (记为Buffer ).4.2 数据的写入与备份 当Bucket 接收到数据(记为wo )写请求时,将执行下列操作(见图2):(1)以追加方式将w o 写入到Seg -ment 链表的尾部;(2)在BHT 中写入(或更新)wo .oid 和相应的Segment 地址信息;(3)将w o 写入到与其对应的β(备份数,默认值为2)个Buffer 中;(4)写请求成功并直接返回;(5)当某个Buffer 写满时,Backup Node 会将其中的数据一次性地写入磁盘中,并释放该Buffer 以等待下次写入. 为防止数据丢失,Backup Node 必须保证Buffer 中数据的持久性,可以通过备用电源(为Buffer 写入磁盘提供足够的电量)等方式实现.使用上述基于缓冲的备份方式使得数据写入无须等待磁盘操作即可完成.但由于Buffer 的容量有限,其中的数据最终还是要存入到磁 盘中,所以系统总吞吐量会受到磁盘写带宽的限制,解 决方法是为Backup Node 加入更多的磁盘通过并行访问的方式提高吞吐量. 4.3 数据的读取 Super Node 的逻辑单一性极大简化了系统设计,可以在全局信息协助下精确定位每个Obj ,但为避免其成为系统瓶颈,客户端并不通过Super Node 直接读写数据,而只是向其查询Bucket 的位置信息,最小化所有同Super Node 的交互是M -Cloud 的一项重要设计原则.以下是一次数据(记为ro )读取流程示例:(1)如果客户端缓存中已存在ro 的key ,则执行第(3)步;(2)将ro .oid 发送至Super Node 执行算法2,获得ro .bid ,并把oid 和bid 属性作为key 缓存在客户端中;(3)客户端发送读请求至由bid 标识的Buc ket ,获得相应value ,此后不必再和Super Node 通讯. 5 故障恢复 M -Cloud 是服务于云计算应用的,当某个Stor age Node 产生故障时,由于内存易失性,其中保存的数据都将丢失.这时需要启动故障恢复机制,以快速重建内存数据. 5.1 Fast Parallel Recovery 算法 某个Storage Node 的故障恢复时间是由数据传输时间(记为DTT )来衡量的:将故障节点所有备份数据从其Backup Node 传输到Bucket 所花费的总时间.DTT 又由数据读取时间(备份数据从Backup Node 的磁盘读取到内存的时间,记为DRT )和网络传输时间(备份数据从Backup Node 传输至目标Bucket 的时间,记为NTT )组成.设Cap 为故障节点的内存容量,DRate 为磁盘读取速率,NRate 为网络传输速率,SN 和DN 分别为备份磁盘数量和目标Bucket 数量,可知 DT T =DRT +NTT =Cap DRate ×SN +Cap NRate ×DN (8) 进行快速故障恢复的关键是最大可能地利用集群中的海量资源来降低DT T ,图3列出了3种可选方案. 假设Cap 为16GB ,DRate 为100MB /s ,NRate 为1Gbps ,在方案(1)中SN =3,DN =1,根据式(8)可得出DTT ≈3min ;方案(2)中,SN =1000,DN =1,DTT ≈2min ,但通过大幅提高备份磁盘数量已使DRT 在1s 之内;方案(3)中,SN =1000,DN =100,DT T ≈1.44s ,在方案(2) 1409 第 7 期孙 勇:面向云计算的键值型分布式存储系统研究 基础上通过进一步提升并行率,将总恢复时间控制在2s内. 通过上述分析可知,在其它参数一定情况下,尽可能地提高SN与DN的值即可实现快速故障恢复,由算法2及其证明可知,被恢复数据会均匀地分散到各个Bucket中,即DN值优化,同时在数据备份的过程中已经保证了SN值的最大化(4.2节),以下为故障恢复算法的流程. 算法4 Fast Parallel Recovery算法 输入:故障Storage Node(记为cras h). Step1 Super Node查找c ras h中所有Obj的主备份(从Obj的β个备份中指定)数据,并向相应的Backup Node发出数据恢复指令. Step2 每个Backup Node为其中的所有主备份数据根据算法2计算目标Buc ket,并向其转发数据恢复指令. Step3 各个目标Bucket并行地执行数据恢复工作. Step4 各个目标Bucket代替c rash开始提供存储服务. 5.2 故障检测 M-Cloud主要通过两种方式检测Stora ge Node的故障,第一种方式是在客户端访问某个节点失败后向Su-per Node发出故障报告,故障恢复模块被触发执行;第二种方式是由M-Cloud主动、周期性地探测各个Storage Node的“心跳”信息,在发现故障后及时进行恢复,以避免由多点失效造成的永久性数据丢失,为防止Super Node负载过重,将“故障检测工作执行者”的角色从Su-per Node开始以“接力”方式依次向状态正常的Storage Node传递.Super Node只负责在收到故障报告后进行相应的处理工作,并迅速地发起故障恢复. 6 模拟实验与结果分析 实验主要目的是为了验证M-Cloud能适用于云计算环境并具备较好的性能及可用性,课题组实现了M-Cloud原型及其各个重要算法并利用澳大利亚墨尔本大学开发的开源系统CloudSim[15]进行了模拟实验.实验平台软硬件配置为Windows7+Intel i52.53GHz(4核)+内存2GB.实验中使用的各项参数及说明如表1. 表1 实验参数说明 参数说明 SNN Storage Node总数(CloudSim节点数) Cap Storage Node的平均内存容量,单位为GB ObjN待处理的Obj总数 Si ze Obj的平均尺寸,单位为M B p M-Cl oud分区数 β每个Obj的备份个数 实验1 数据存储性能实验 本次实验中,我们使用Memcached和分布式MySQL Cluster作为比较对象,对于Memcached及M-Cloud,将以 ;对于MySQL,创建一张包含oid和value字段的临时表,以记录形式访问.取SNN=100,Cap=16,Size=1,p=9,β= 2,在对20000个Obj存取过程中进行4次记录,并将上述过程重复10次取平均值,得到的实验结果分别如图4所示. 实验1表明,在一定集群规模情况下,Me mcac hed 和M-Cloud均表现出较快的数据存取速度,但由于受外部程序库及副本备份的影响,Memcached在数据处理量加大的情况下逐步落后于M-Cloud.同时Me mcac hed由于不支持数据持久化,影响了系统可靠性,而M-Cloud 通过异步备份保证了数据持久性和系统对性能的要求. 实验2 故障恢复实验 本次实验包含3组测试,Size值分别为1、0.5和0.25,SNN=1000, C apac ity=16,p=9,β=2.首先建立写满16GB内存数据的Stor age Node(包含1个Bucket,记为c rash),然后通过命令关闭掉c rash,最后执行故障恢复程序,在多个Storage Node中重建c rash,得到的实验结果如图5所示. 实验2表明,在总数据量一定的情况下,大尺寸Obj具有更快的恢复时间,这是由于小尺寸Obj需要更多的BHT重建时间.但同时也不宜将Obj的尺寸设置得过大,因为某些应用程序存在着对大量小规模数据随机读取的操作需求,对于这些应用程序,过大的Obj 会造成带宽、存储等资源浪费.M-Cloud中Obj尺寸上限默认值为1MB,上层应用程序应在此基础上,通过对性能、故障恢复时间、资源利用率、可用性等各项系统指 1410 电 子 学 报2013年 标的综合权衡,进行相应的参数设置. 7 总结 本文提出了一种键值型分布式存储系统M-Cloud,将数据全部保存在服务器集群的内存中以进行快速的存取处理,同时在磁盘上备份数据以保证持久性并为故障恢复提供支持.由于受实验条件和环境的限制,研发工作尚不完善,未来将在M-Cloud编程模型及其自治性等方面继续展开更深入的探索与研究. 参考文献 [1]Armbrust M,Fox A,Griffith R.Above the clouds:A Berkeley view of cloud co mputi ng[OL].http://www.eecs.berkeley. edu/Pu bs/T echRpts/2009/EECS-2009-28.pdf,2009-02 -10. [2]Schaffner J,et al.Predicting in-memory database performance for automating cluster management tasks[A].Proceeding s of the2011IEEE27th International Conference o n Data Engineer-ing[C].Hannover:IEEE,2011.1264-1275. [3]吴吉义,傅建庆,平玲娣,谢琪.一种对等结构的云存储系 统研究[J].电子学报,2011,39(5):1100-1107. WU Ji-yi,FU Jian-qing,PING Ling-di,XIE Qi.Stu dy on the P2P cloud storage system[J].Acta Electronica Sinica,2011,39 (5):1100-1107.(i n Chi nese) [4]王丽娜,等.云存储中一种基于布局的虚拟磁盘节能调度 方法[J].电子学报,2012,40(2):266-272. WANG Li-na,et al.A data assured deletion approach adapted for cloud storage[J].Acta Electronica Sinica,2012,40(2):266 -272.(in Chinese) [5]Fay Chang,et a1.Bigtable:a di stributed storage system for structu red data[J].ACM Transactions on Computer Systems, 2008,26(2):1-26. [6]Wikipedia.No SQL[OL].http://en.wikipedia.o rg/wiki/ NoSQL,2012. [7]Dormando.Memcached:a distributed memory Obj caching sys- tem[OL].https://www.360docs.net/doc/9b16507618.html,/,2012. [8]T ransier F.Algorithms and Data Structures fo r In-memory Text Search Engines[D].Karlsruhe Germany:a PhD thesis of Uni-versity of Karlsruhe,2010. [9]百度百科.双机热备[OL].https://www.360docs.net/doc/9b16507618.html,/view/ 132705.htm,2012. [10]张民贵,刘斌.IP网络的快速故障恢复[J].电子学报, 2008,36(8):1595-1602. ZHANG Min-gui,LIU Bin.Fast failure recovery of IP net- works[J].Acta Electronica Sinica,2008,36(8):1595-1602. (in Chinese) [11]Wikipedia.SHA-1[OL].https://www.360docs.net/doc/9b16507618.html,/wiki/ SHA1,2012. [12]Witold Litwin.Linear hashi ng:a new tool for file and table addressing[A].Proceeding s of the sixth international confer- ence on very large data bases[C].Montreal:VLDB,1980. 212-223. [13]Mi nwen Ji,et al.Archipelago:an island-based file system for hig hly available and scalable internet services[A].Proceeding s of the4th Conference on USEN IX Window s Systems Sy mpo- sium[C].Berkeley:USENIX Association,2000.1-1. [14]Petra Berenbrink,et al.Balanced allocations:the heavily load- ed case[J].SIA M Journal on Computing,2006,35(6):1350 -1385. [15]R N Calheiros.CloudSim:A Toolkit for Modeling and Si mu- lation of Cloud Computing Environments and Evaluation of Resou rce Provisioning Algo rithms[R].N Y,U SA:Software: Practice and Experience,Wiley Press,2010. 作者简介 孙 勇 男,1977年4月出生,辽宁盘锦 人,副教授.研究方向为分布式计算系统、无线传 感器网络等. E-mail:s y@zj https://www.360docs.net/doc/9b16507618.html, 林 菲 女,1977年11月出生,浙江永康 人,副教授.研究方向为并行分布式计算、软件工 程等. E-mail:linfei@https://www.360docs.net/doc/9b16507618.html, 1411 第 7 期孙 勇:面向云计算的键值型分布式存储系统研究 分布式控制系统 题,才能使计算机自动化真正起到其应有的作用。 1975-1980年,在这个时期集散控制系统的技术特点表现为: 从结构上划分,DCS包括过程级、操作级和管理级。过程级主要由过程控制站、I/O 单元和现场仪表组成,是系统控制功能的主要实施部分。操作级包括:操作员站和工程师站,完成系统的操作和组态。管理级主要是指工厂管理信息系统(MIS系统),作为DCS更高层次的应用,目前国内纸行业应用到这一层的系统较少。 DCS的控制程序:DCS的控制决策是由过程控制站完成的,所以控制程序是由过程控制站执行的。 过程控制站的组成: DCS的过程控制站是一个完整的计算机系统,主要由电源、CPU(中央处理器)、网络接口和I/O组成 I/O:控制系统需要建立信号的输入和输出通道,这就是I/O。DCS中的I/O一般是模块化的,一个I/O模块上有一个或多个I/O通道,用来连接传感器和执行器(调节阀)。 I/O单元:通常,一个过程控制站是有几个机架组成,每个机架可以摆放一定数量的模块。CPU所在的机架被称为CPU单元,同一个过程站中只能有一个CPU单元,其他只用来摆放I/O模块的机架就是I/O单元。 国内外应用 分散控制系统 1975 年美国最大的仪表控制公司Honeyw ell 首次向世界推出了它的综合分散控制系统TDC—2000 ( Toal Distributed Control-2000),这一系统的发表,立即引起美国工业控制界高度评价,称之为“最鼓舞人心的事件”。世界各国的各大公司也纷纷仿效,推出了一个又一个集散系统,从此过程控制进入了集散系统的新时期。 在此期间有日本横河公司推出的CEN TUM,美国泰勒仪表公司的MO SË,费雪尔公司的DCÉ —400,贝利公司的N —90,福克斯波罗公司的Cpect rum 和德国西门子公司的Telepermm。 随着计算机特别是微型计算机与网络技术的飞速发展,加上各制造商的激烈竞争,使DCS 很快从70 年代的第一代发展到90 年代初的第三代DCS。尽管在这之前的集散系统的技术水平已经很高,但其中存在着一个最主要的弊病是:各大公司推出的几十种型号的系统,几乎都是该公司的专利产品,每个公司为了保护自身的利益,采用的都是专利网络,这就为全厂、全企业的管理带来问题。 随着计算机的发展与网络开发使各控制厂商更多地采用商业计算机的技术,80年代末许多公司推出新一代的集散系统,其主要特征是新系统的局部网络采用MA P 协议;引用智能变送器与现场总线结构;在控制软件上引入PLC 的顺序控制与批量控制,使DCS 也具有PLC 的功能。 至90 年代初各国知名的DCS 有:3000,Bailey 的IN F I—90,Ro semoun t 的RS—3,W est Hoo se 的WDPF,L eeds &Non th rup 的MAX—1000,Foxbo ro 的IöA S,日本横河的CEN TUM。这里所提到的均为大型的DCS,为了适应市场的需要各厂商也开发了不少中小型的DCS 系统如S—9000,MAX—2,LXL,A 2 PACS 等等。 第1章分布式计算概述 一、选择题 1,CD 2,ABC 3,ABCD 4,ACD 二、简答题 1,参考1.1.1和节 2,参考1.1.2节 3,分布式计算的核心技术是进程间通信,参考1.3.2节 4,单播和组播 5,超时和多线程 三、实验题 1.进程A在进程B发送receive前发起send操作 进程A进程B 发出非阻塞send操 作,进程A继续运行 发出阻塞receive操 作,进程B被阻塞进程B在进程A发起send前发出receive操作 发出非阻塞send 操作,进程A 继续运行 发出阻塞receive 操作,进程B 被阻塞 收到进程A 发送的数据,进程B 被唤醒 2. 进程A 在进程B 发送receive 前发起send 操作 进程A 进程B 发出阻塞send 操作, 进程A 被阻塞 发出阻塞receive 操作,进程B 被阻塞 进程B 在进程A 发起send 前发出receive 操作 发出阻塞send操作,进程A被阻塞 发出阻塞receive操作,进程B 被阻塞 收到进程A发送的数据,进程B 被唤醒 收到进程B返回的数 据,进程A被唤醒 3.1).在提供阻塞send操作和阻塞receive操作的通信系统中在提供非阻塞send操作和阻塞receive操作的通信系统中2).P1,P2,P3进程间通信的顺序状态图 m1 m1 m2 m2 第2章分布式计算范型概述 1.消息传递,客户-服务器,P2P,分布式对象,网络服务,移动代理等 2.分布式应用最广泛最流行的范型是客户-服务器范型,参考节 3.分布式应用最基本的范型是消息传递模型,参考节 4.参考节,P2P应用有很多,例如Napster,迅雷,PPS网络电视等 5.参考节 6.参考节 7.略 8.消息传递模式是最基本的分布式计算范型,适用于大多数应用;客户-服务器范型是最 流行的分布式计算范型,应用最为广泛;P2P范型又称为对等结构范型,使得网络以最有效率的方式运行,适用于各参与者地位平等的网络;分布式对象范型,是抽象化的远程调用,适用于复杂的分布式计算应用等。 9.略 10.中间件又称为代理,中间件为参与对象提供内容抽象,隐藏对象引用,起到中介作用。 11.略 第3章 Socket编程与客户服务器应用开发 一、填空题 1.数据包socket,流式socket 2.无连接方式,面向连接方式 3.数据层,业务层,应用层 4.迭代服务器和并发服务器 5.有状态服务器和无状态服务器 二、简答题 1.API:Application Programming Interface,应用程序编程接口,是一些预先定义 的函数,目的是提供应用程序与开发人员基于某软件或硬件得以访问一组例程的能 力,而又无需访问源码,或理解内部工作机制的细节 Socket API:套接字应用程序编程接口,适用于进程间通信的套接字应用程序编程 接口 分布式存储系统节能技术研究综述 发表时间:2016-04-18T11:33:29.663Z 来源:《电力设备》2016年1期供稿作者:于辉 [导读] 广东电网有限责任公司东莞供电局信息中心)企业的信息系统产生小规模的数据,小的数据存储中心即可对数据进行存储,这个时期企业所观注的是数据中心的性能和可靠性。 于辉 (广东电网有限责任公司东莞供电局信息中心) 摘要:随着大数据时代的到来,企业所需要存储的数据越来越多,不得不对现有的数据存储中心进行扩容,以实现更大级别数据量的存储。分布式存储系统为构建数据中心的重要方式之一,存储系统的能耗情况是衡量一个存储系统性能的重要指标,因此,研究分布式存储系统的节能技术具有一定的必要性。本文的主要工作是对分布式存储技术的节能技术进行综述,以使读者了解现有的分布式存储系统节能研究现状。 关键字:大数据、分布式、节能、能耗 一、前言 大数据时间,数据存储中心的能耗越来越受到人们的重视,它也逐渐变成继性能和可靠性之后,衡量数据存储中心的第三个指标。在信息系统应用初期,企业引进信息系统来改善管理,提高企业的经营和管理效率。这个时期,企业的信息系统产生小规模的数据,小的数据存储中心即可对数据进行存储,这个时期企业所观注的是数据中心的性能和可靠性。 而随这互联网、大数据时代的到来,企业生产运营所积累的数据成几何级的增加,小的数据中心已不能支持新的数据存储需求,企业不得不对原有的数据中心进行扩容,大量的新增设备新加入到数据中心中,此时,数据中心的能耗已经成为企业所考虑的一个企业经营成本问题,如何降低数据中心的能耗已经成为企业管理者所思考的一个问题。图1给出了数据中心管理者眼中的最大挑战,可见能耗问题排在第一位[8]。 图1 数据中心管理者眼中的最大挑战 对于大规模的数据存储中心。为了保证低成本和高扩展性,通常会选择分布式存储技术。数据存储是分布式存储服务的基础,分布式存储系统中能耗最高的部分主要在设备耗能方面。因此,在分布式环境下,如果能有效降低存储系统的能耗,对降低数据中心的整体能耗有显著效果。 二、分布式存储系统 传统分布式存储系统重点考虑在分布式环境中如何解决诸如数据复制、负载均衡、集群关系管理、可靠性保证、高性能等技术问题。目前,基于OpenPower、X86等架构的国产服务器逐步采用低功耗多核处理器、高带宽内存以及异构存储等硬件资源,传统分布式存储系统在系统设计、技术优化等方面没有充分发挥上述硬件的特点。具体来说,包括以下三方面: 1 分布式存储在面向低功耗多核处理器时的不足 传统的分布式存储没有充分利用存储节点的处理能力,而存储节点的处理能力完全有能力承担除存储服务之外的任务,例如将部分计算任务迁移到存储节点上,从而提高整个集群的计算能力。另一方面,国产服务器采用的低功耗处理器提供不同功耗模式以适应不同的工作负载,可以动态变化。现有的分布式存储没有针对上述处理器特点进行设计和技术优化考虑。 2 分布式存储在面向高带宽内存时的不足 随着国产服务器逐步采用高带宽内存技术,处理器与内存间的数据移动效率越来越高,以适应大数据应用场景。如何将更有价值的数据保留在处理器缓存中,如何利用每个服务器节点上的高带宽内存形成高效的分布式缓存层,以减少对存储层的访问压力,这些问题都是现有分布式存储没有给予充分考虑,并作相应设计优化的。 3、分布式存储在面向机械硬盘与SSD组成的异构存储时的不足 大数据环境下,对存储的容量和性能等提出了更高的要求。从性能、成本的角度考虑,不允许将所有数据都统一存储于集中式的存储设备上,因此异构存储越来越受到重视。现有分布式存储系统虽然有考虑异构存储架构,但是仅以数据冷热、I/O特征作为异构存储资源分配因素。此外,现有分布式存储系统仅考虑存储层,没有将异构存储对存储以及计算与存储结合等应用场景产生的影响进行考虑分析。 三节能技术综述 由磁盘的能耗工式可知,磁盘的主要能耗取决于磁盘的转速,磁盘处于Standby状大下时,其能耗远小于在Idle和Active状态下的能耗。S.Gurumurthi 等人在TPM(Traditional Power Management)的基础上,提出了 DRPM(Dynamical RPM)技术[2]。该技术通过细分 高性能计算、分布式计算、网格计算、云计算--概念和区别 《程序员》2009-02 P34 “见证高性能计算21年” 高性能计算(High Performance Computing)HPC是计算机科学的一个分支,研究并行算法和开发相关软件,致力于开发高性能计算机(High Performance Computer)。 分布式计算是利用互联网上的计算机的中央处理器的闲置处理能力来解决大型计算问题的一种计算科学。 网格计算也是一种分布式计算。网格计算的思路是聚合分布资源,支持虚拟组织,提供高层次的服务,例如分布协同科学研究等。网格计算更多地面向科研应用,商业模型不清晰。网格计算则是聚合分散的资源,支持大型集中式应用(一个大的应用分到多处执行)。 云计算(Cloud Computing)是分布式处理(Distributed Computing)、并行处理(Parallel Computing)和网格计算(Grid Computing)的发展,或者说是这些计算机科学概念的商业实现。云计算的资源相对集中,主要以数据中心的形式提供底层资源的使用,并不强调虚拟组织(VO)的概念。云计算从诞生开始就是针对企业商业应用,商业模型比较清晰。云计算是以相对集中的资源,运行分散的应用(大量分散的应用在若干大的中心执行); 目录 高性能计算、分布式计算、网格计算、云计算--概念和区别 (1) 高性能计算 (3) 百科名片 (3) 概念 (3) 服务领域 (3) 网格 (5) 百科名片 (5) 网格的产生 (5) 网格技术的特征及其体系结构 (5) 高性能计算机的发展与应用 (17) 我国高性能计算机应用前景及发展中的问题 (17) 高性能计算机与大众生活息息相关 (17) 高性能计算机发展任重道远 (18) 分布式计算、网格计算和云计算 (21) 分布式计算 (21) 网格计算 (21) 云计算 (22) 网格计算和云计算的概念和区别 (24) 目标不同 (24) 分配资源方式的不同 (25) 殊途同归 (26) 钱德沛教授:云计算和网格计算差别何在? (27) 云计算与网格计算的概念 (27) 网格计算的特点是什么呢? (27) 云计算与网格计算区别何在 (28) 信息技术的发展带来数据的爆炸性增长,毋庸置疑,我们已经全面跨入大数据时代,PB 规模的非结构化数据越来越常见,如何有效地管理这些数据,并进一步发掘数据价值,已成为IT 管理者所必须重视的问题。同时大数据4V 特性也对存储系统的大容量、高性能、易扩展、易用性等提出了更高要求。传统的SAN 和NAS 存储架构已经难以满足海量数据的密集型I/O 并发访问需求。 ParaStor300S 并行分布式云存储系统,是在曙光公司近10年来海量数据存储与处理的基础之上,针对大数据时代的特点,全新设计并全面优化的高端存储系统。 产品定位 集群文件/对象统一存储 基于曙光完全自主研发的并行分布式软件ParaStor 构建的集群存储系统,对外统一提供多种存储协议: 提供文件存储服务,包括Linux POSIX 、NFS 、SMB 、FTP 等,满足Windows 、Linux 、Unix 等异构平台的不同访问需求; 提供对象存储服务,兼容Amazon S3接口,满足云生态的应用需求。 特别地,同一集群可以同时提供文件/对象接口,访问方式更为灵活。 Scale-Out 横向扩展的并行架构 基于服务器构建的并行分布式存储系统,对外提供单一的命名空间。支持3~4096节点的弹性无缝扩展,单一存储空间容量可扩展至EB 级。 具备超强的横向扩展能力,只需简单地增加存储节点,即可获得更大的存储容量和更多的数据通道,从而获得更高的系统聚合带宽和I/O 性能。 面向海量非结构化数据存储场景 ParaStor300S 并行分布式云存储系统适用于存在数据共享需求的多种应用领域,如高性能计算、生物信息、气象预报、环境监测分析、地震监测、能源勘探、卫星遥感、视频监控、媒资管理、视频编辑处理等,可以广泛应用于政府、教育、科研、医疗、石油、广电、企业等行业。 ParaStor300S 并行分布式云存储系统 新一代自主研发的海量非结构化数据存储 EB 级共享空间 ? 3~4096节点 ? 单一命名空间 ? 按需分配,在线扩容 多种访问协议 ? Linux POSIX ? NFS/CIFS/FTP ? S3 多款硬件平台 ? 2U12、4U24、4U36 ? SATA/SAS/SSD 混插 智能存储策略 ? SSD 读缓存加速 ? 细粒度配额管理 多重数据保护 ? 2~4副本 ? N+M:b 纠删码 ? 快照 ? 全冗余设计,无单点故障 简易运维管理 ? 多套集群统一管理 ? 资源、状态实时监控 ? 邮件、短信、SNMP 告警 分布式系统与云计算课程教学大纲 课程名称:分布式系统与云计算 英文名称:Distributed Systems and Cloud Computing 总学时:56 总学分:2 适用对象: 物联网工程专业 先修课程:程序设计语言、计算机网络 一、课程性质、目的和任务 本课程是物联网工程专业学生的专业选修课,分布式计算提供了跨越网络透明访问各种信息资源并协同处理的能力,是大规模网络应用的基础, 云计算是海量数据处理的支撑技术。本课程旨在通过介绍分布式计算与云计算相关的理论与技术,使学生能够掌握分布式系统与云计算的概念,理解并掌握当前分布计算领域的主流技术,了解分布计算与云计算研究的方向,开阔视野,为从事分布式应用开发或云计算研究打下一定的基础。 二、教学的基本要求 了解分布式计算与云计算的基本概念。 掌握常见的几种计算模式,并明确优缺点,可以根据需要选用适当的计算模式进行开发。 了解三种典型的分布式对象技术,并能掌握其中一种进行程序开发。 掌握基于Web的应用程序开发技术。 了解当今各大公司主流的云计算技术。 了解分布式计算与云计算研究的发展趋向。 三、教学的基本内容 分布计算技术和云计算的基本概念,分布式系统的目标,云计算的优点和缺点,分布式系统层次结构,分布系统中的主要特征,客户-服务器模式的基本概念,客户-服务器端架构和体系结构。 分布式对象计算:介绍三种典型的分布式对象技术CORBA、DCOM和EJB,以CORBA 为主介绍分布式对象计算技术,包括CORBA的基本结构、ORB之间的互操作,CORBA服务和公共设施以及CORBA编程。 当今各大公司主流的云计算技术介绍:Google文件系统,Bigtable技术,MapReduce 技术,Yahoo!公司的云平台技术,Aneka云平台技术,Amazon公司的Dynamo技术,IBM 公司的云计算技术。 云计算的程序开发:基于Hadoop系统的开发,基于HBase系统的开发,基于Google App Engine系统的开发,基于Windows Azure系统的开发。 内容目录 1核心观点 (3) 1.1核心推荐逻辑 (3) 1.2我们区别于市场的观点 (3) 2分布式存储将成为下一代互联网基础设施 (3) 2.1以IPFS 协议为代表的分布式存储带来新思路 (3) 2.2分布式存储将带来互联网基础架构变革 (7) 3分布式存储开辟互联网基础设施产业新格局 (9) 3.1分布式存储开发新的存储市场 (9) 3.2分布式存储已和传统存储不断融合应用 (10) 4分布式存储面临的技术瓶颈与发展机遇 (12) 4.1数据价值分层是分布式存储经济激励的关键 (12) 4.2I/O 性能瓶颈需要底层和应用层联合优化解决 (13) 4.3服务质量保障 (15) 4.4在应用、运营层面中心化组织与分布式存储将进一步融合 (15) 图表目录 图表1:IPFS 协议的分布式系统 (4) 图表2:IPFS 协议构架 (4) 图表3:集中化的版本控制系统 (5) 图表4:分布式版本控制系统 (5) 图表5:Merkle DAG 数据结构及功能特点 (6) 图表6:DHT 网络工作原理 (6) 图表7:全球数据圈每年规模 (7) 图表8:IPFS 协议关注的基础问题 (7) 图表9:IPFS 与HTTP 协议的对比 (8) 图表10:IPFS 与HTTP 寻址方式对比 (8) 图表11:全球数据量增长状况 (9) 图表12:中国云存储市场规模及增速 (9) 图表13:中国公有云市场规模及增速 (9) 图表14:个人云盘行业用户渗透率及MAU (10) 图表15:储迅部分合作伙伴 (11) 图表16:高性能分布式文件系统 (11) 图表17:CRUST 技术架构:工作量证明层MPoW、区块链共识层GPoW 及分布式云存储/计算层 (12) 图表18:CRUST 部分合作伙伴 (12) 图表19:数据价值分层是分布式存储经济激励的关键 (13) 图表20:IPFS 与HTTP 性能对比:远程读取操作的平均延迟 (14) 图表21:IPFS 与HTTP 性能对比:远程读取操作的延迟范围 (14) 图表22:IPFS 与HTTP 性能对比:远程读取操作的吞吐量 (14) 图表23:分布式存储面临的技术瓶颈与发展机遇 (15) DCS是分布式控制系统的英文缩写(Distributed Control System),在国内自控行业又称之为集散控制系统。 即所谓的分布式控制系统,或在有些资料中称之为集散系统,是相对于集中式控制系统而言的一种新型计算机控制系统,它是在集中式控制系统的基础上发展、演变而来的。在系统功能方面,DCS和集中式控制系统的区别不大,但在系统功能的实 现方法上却完全不同。 首先,DCS的骨架—系统网络,它是DCS的基础和核心。由于网络对于DCS 整个系统的实时性、可靠性和扩充性,起着决定性的作用,因此各厂家都在这方面进行了精心的设计。对于DCS的系统网络来说,它必须满足实时性的要求,即在确定 的时间限度内完成信息的传送。这里所说的“确定”的时间限度,是指在无论何种情况下,信息传送都能在这个时间限度内完成,而这个时间限度则是根据被控制过程的实时性要求确定的。因此,衡量系统网络性能的指标并不是网络的速率,即通常所说的每秒比特数(bps),而是系统网络的实时性,即能在多长的时间内确保所需信息的 传输完成。系统网络还必须非常可靠,无论在任何情况下,网络通信都不能中断,因此多数厂家的DCS均采用双总线、环形或双重星形的网络拓扑结构。为了满足系统 扩充性的要求,系统网络上可接入的最大节点数量应比实际使用的节点数量大若干倍。这样,一方面可以随时增加新的节点,另一方面也可以使系统网络运行于较轻的通信负荷状态,以确保系统的实时性和可靠性。在系统实际运行过程中,各个节点的上网和下网是随时可能发生的,特别是操作员站,这样,网络重构会经常进行,而这种操作绝对不能影响系统的正常运行,因此,系统网络应该具有很强在线网络重构功能。 其次,这是一种完全对现场I/O处理并实现直接数字控制(DOS)功能的网络节点。一般一套DCS中要设置现场I/O控制站,用以分担整个系统的I/O和控制功能。这样既可以避免由于一个站点失效造成整个系统的失效,提高系统可靠性,也可以使各站点分担数据采集和控制功能,有利于提高整个系统的性能。DCS的操作员站是 处理一切与运行操作有关的人机界面(HMI-Human Machine Interface或operator interface)功能的网络节点。 系统网络是DCS的工程师站,它是对DCS进行离线的配置、组态工作和在线的系统监督、控制、维护的网络节点,其主要功能是提供对DCS进行组态,配置工作 的工具软件(即组态软件),并在DCS在线运行时实时地监视DCS网络上各个节点的运行情况,使系统工程师可以通过工程师站及时调整系统配置及一些系统参数的设定,使DCS随时处在最佳的工作状态之下。与集中式控制系统不同,所有的DCS都要求有系统组态功能,可以说,没有系统组态功能的系统就不能称其为DCS。 DCS自1975年问世以来,已经经历了二十多年的发展历程。在这二十多年中,DCS虽然在系统的体系结构上没有发生重大改变,但是经过不断的发展和完善,其 功能和性能都得到了巨大的提高。总的来说,DCS正在向着更加开放,更加标准化,更加产品化的方向发展。 作为生产过程自动化领域的计算机控制系统,传统的DCS仅仅是一个狭义的概念。如果以为DCS只是生产过程的自动化系统,那就会引出错误的结论,因为现在 基于DHT的分布式云存储系统综述 题目:基于云计算的知识管理综述 专业:计算机应用技术 年级: 2014级 学号: 2014303100×× 姓名:静水流云 上海××大学信息工程学院 2014 年 12 月28 日 基于DHT的分布式云存储系统的综述 摘要:随着信息爆炸式的增长,集中式的存储方式的瓶颈效应愈发明显的遏制了数据存储的扩展性和并 发访问的效率等,SAN 和NAS 等传统集中式存储系统越来越难以满足海量数据存储的需要。为了解决诸 如此类的传统存储的瓶颈问题,分布式存储系统和云存储系统相继被提出,并成为学术研究和商用的热点 内容。分布式存储系统实现涉及并使用的技术有很多,本文主要介绍基于DHT的分布式存储系统,重点在 搜索技术方面。 1 引言 把用户的文件分片后均衡存储在不同的分布式存储节点上,并利用虚拟目录服务器和基于P2P—DHT 的目录服务器把文件元数据与文件数据片高效地对应起来,以提供高效目录服务,分布式存储节点以P2P 方式工作以快速完成用户对文件数据的请求任务。分布式网络存储系统DNSS充分利用了DHT原理和P2P 的搜索技术优势[3],有较高的可用性、可靠性和可扩展性。P2P技术突破了传统的C/S架构的模式,具 有非常好的扩展性,但存在安全性、可控性问题[2]。利用DHT的资源管理优势和P2P的高扩展性,可以 构建一个在全互联网范围内使用的可靠高效的海量分布式存储系统。而对于海量数据的分布式存储,主要 涉及的技术问题是如何处理好数据的添加、删除以及最为重要的查找效率,本文结合分布式hash表的一 致特性,重点讲述一下如何构造一个基于DHT的分布式存储系统,当然主要内容是DHT原理部分[1]。 2 p2p网络和hash函数概述 2.1 p2p网络简介 p2p网络又称工作组,网上各台计算机有相同的功能,无主从之分,一台计算机都是既可作为服务器,设定共享资源供网络中其他计算机所使用,又可以作为工作站,没有专用的服务器,也没有专用的工作站。在P2P网络环境中,成千上万台彼此连接的计算机都处于对等的地位,整个网络一般来说不依赖专用的集 中服务器。网络中的每一台计算机既能充当网络服务的请求者,又对其它计算机的请求作出响应,提供资 源和服务。其主要分为两种:非结构化p2p网络和结构化p2p网络[4]。前者有网络拓扑是任意的、内容 的存储位置与网络拓扑无关的特点;后者网络拓扑结构是有规律的,每个节点都随机生成一个标识(ID), 内容的存储位置与网络拓扑相关,内容的存储位置与节点标识之间存在着映射关系。 2.2 hash函数简介 Hash函数可以根据给定的一段任意长的消息计算出一个固定长度的比特串,通常称为消息摘要(MD:Message Digest),一般用于消息的完整性检验。Hash函数有以下特性:给定 P,易于计算出 MD(P) 只给出 MD(P),几乎无法找出 P无法找到两条具有同样消息摘要的不同消息Hash函数MD5:消息摘要 长度固定为128比特;SHA-1:消息摘要长度固定为160比特。Hash函数应用于P2P的特性唯一性:不同 的输入明文,对应着不同的输出摘要将节点IP地址的摘要作为节点ID,保证了节点ID在P2P环境下的 唯一性SHA-1(“202.38.64.1”) =24b92cb1d2b81a47472a93d06af3d85a42e463ea。 3 DHT原理 3.1 DHT简述 DHT(Distributed Hash Table,分布式哈希表)算法就是使用分布式哈希函数来解决结构化的分布式 存储问题[1]。分布式哈希表实际上是一张散列表,每个节点被分配给一个属于自己的散列块,并成为这 个散列块的管理者。目前,典型的DHT协议包括美国MIT的Chord、UC Berkeley的pastry和CAN、纽约 大学的Kademlia [2]。本文主要介绍chord和pastry。将内容索引抽象为 并行计算:并行计算是相对于串行计算来说的。可分为时间上的并行和空间上的 并行。时间上的并行就是指流水线技术,而空间上的并行则是指用多个处理器并 发的执行计算。并行计算的目的就是提供单处理器无法提供的性能(处理器能力 或存储器),使用多处理器求解单个问题。 分布式计算:分布式计算研究如何把一个需要非常巨大的计算能力才能解决的问 题分成许多小的部分,然后把这些部分分配给许多计算机进行处理,最后把这些 计算结果综合起来得到最终的结果。最近的分布式计算项目已经被用于使用世界 各地成千上万位志愿者的计算机的闲置计算能力,通过因特网,可以分析来自外 太空的电讯号,寻找隐蔽的黑洞,并探索可能存在的外星智慧生命等。 并行计算与分布式计算的区别:(1)简单的理解,并行计算借助并行算法和 并行编程语言能够实现进程级并行(如MPI)和线程级并行(如openMP)。而 分布式计算只是将任务分成小块到各个计算机分别计算各自执行。(2)粒度方面,并行计算中,处理器间的交互一般很频繁,往往具有细粒度和低开销的特征,并 且被认为是可靠的。而在分布式计算中,处理器间的交互不频繁,交互特征是粗 粒度,并且被认为是不可靠的。并行计算注重短的执行时间,分布式计算则注重 长的正常运行时间。(3)联系,并行计算和分布式计算两者是密切相关的。某些 特征与程度(处理器间交互频率)有关,而我们还未对这种交叉点(crossover point)进行解释。另一些特征则与侧重点有关(速度与可靠性),而且我们知道 这两个特性对并行和分布两类系统都很重要。(4)总之,这两种不同类型的计算 在一个多维空间中代表不同但又相邻的点。 集群计算:计算机集群使将一组松散集成的计算机软件和/或硬件连接起来高度 紧密地协作完成计算工作。在某种意义上,他们可以被看作是一台计算机。集群 系统中的单个计算机通常称为节点,通常通过局域网连接,但也有其它的可能连 接方式。集群计算机通常用来改进单个计算机的计算速度和/或可靠性。一般情况 下集群计算机比单个计算机,比如工作站或超级计算机性价比要高得多。根据组 成集群系统的计算机之间体系结构是否相同,集群可分为同构与异构两种。集群 计算机按功能和结构可以分为,高可用性集群(High-availability (HA) clusters)、负载均衡集群(Loadbalancing clusters)、高性能计算集群 (High-performance (HPC)clusters)、网格计算(Grid computing)。 高可用性集群,一般是指当集群中有某个节点失效的情况下,其上的任务会自动 转移到其他正常的节点上。还指可以将集群中的某节点进行离线维护再上线,该 过程并不影响整个集群的运行。 1一级视频云存储系统设计 1.1一级网络视频云存储概述 本项目采用华为网络视频云存储VCN3000设计一级视频云存储子系统.采取分布式直接存储,集中管理的方式,针对摄像头视频存储硬件采用针对视频存储优化的网络视频存储和磁盘阵列,所有的存储设备部署在各辖区运营商机房(六个),前端摄像头采用标准的H.264编码RTP流,直写到网络视频存储中。 华为网络视频云存储VCN3000采用由管理平台、IP网络,通过虚拟化、云结构化和高精确视频直接存储模式。运用负载均衡、对象存储等技术,结合视频、图片数据特点,面向应用,满足视频监控业务高可靠性、不间断的海量存储需求。采用分散存储技术加速大数据智能分析快速提取和分析效率。 华为网络视频云存储VCN3000系统使用存储虚拟化技术针对海量存储应用需求,为用户提供透明存储构架、高可扩展性的云管理存储服务。在云管理存储系统中将信令与业务承载码流相分离,云管理服务器只处理控制信令而不处理视频数据,实时视频数据直接写入到云管理存储物理存储节点,无需中间环节。 视频云管理存储管理软件在市局监控中心以集群方式进行部署,实现全市所有监控点和所有云管理存储物理设备的统一管理。 视频云管理存储系统中,IPC直写存储设备,采用云管理方案解决云管理存储管理单节点失效问题,利用负载均衡技术充分利用各存储节点的性能。云管理存储系统采用统一接口与视频管理平台对接,降低平台维护和用户管理复杂度。 华为网络视频云存储VCN3000支持基于GB/T28181标准实现与各级标准平台(符合GB/T28181规范的标准平台)间的互联互通,平台之间通过信令安全路由网关进行信令对接,在信令的控制下媒体通过媒体服务器互联。该体系构架可以支持上下级级联、平级级联以及监控报警专网与公安网的互联。 天网云存储系统建设方案 1.1存储需求概述 XX天网二期需要建设XX个高清监控点位,随着城市防控体系系统规模越来越大,以及高清视频的大规模应用,对系统中需要存储的数据和应用的复杂程度在不断提高,且视频数据需要长时间持续地保存到存储系统中,并要求随时可以调用,对存储系统的可靠性和性能等方面都提出了新的要求。 面对数百TB甚至上PB级的海量视频存储需求,传统的SAN或NAS在容量和性能的扩展上会存在瓶颈。而云存储可以突破这些性能瓶颈,而且可以实现性能与容量的线性扩展,这对于本项目存储系统来说是一个新选择。 视频云存储通过软件运用集群技术、虚拟化技术、分布式存储技术将网络中的存储设备集合起来协同工作,共同对外提供数据存储和业务访问功能。为满足本次高清点位视频存储的需求,同时符合行业发展趋势,满足业务使用需求,本次XX天网二期拟建设云存储系统进行录像存储和业务访问接口。 大容量存储需求 随着各地城市视频监控系统建设的深入,摄像头数量日益增多。前端建设普遍采用1080P高清摄像机。依据平安城市的建设要求,高清图像存储30天,那么一万路视频的总存储容量需要大致为十几个PB。 集中存储需求 对于城市级系统数十PB的存储需求,若采用通用IPSAN存储方案,则需上千台IPSAN,难以实现高效、统一的存储与设备管理,无法高效支撑公安视频实战应用。 高IO性能需求 基于视频大数据的智能实战应用对大量视频的快速收集与分析有非常高的要求,而传统IPSAN存储方式由于IO性能低,无法满足视频大数据应用的存储与应用要求。 1.2存储系统基本要求 在设计XX天网视频监控系统存储系统时,依据以下设计要求: (1)监控点的录像过程将对网络交换设备产生很大的压力,核心交换机应能负担如此大的交换压力,需考虑网络故障以后录像数据的缓存功能以及网络恢复以后的补录功能。 (2)能集中管理所有存储资源并统一调度,统一部署存储策略。与存储资源物理位置无关,只要IP网可达,便可实现对存储资源随时随地检索和回放。 (3)保障存储系统数据的安全性,对访问权限进行集中管理与分配。 (4)存储空间统一管理、统一分配,可实现无缝在线扩容。 (5)存储系统具有冗余备份的能力,提供持续稳定的性能。 (6)存储系统提供标准的运维接口,维护简单方便。 (8)存储系统具备高可靠性,出现设备故障后,存储业务不中断。 本项目在XX分局建设分布式视频云存储中心,每个存储中心依据接入到该区的视频前端的数量实际情况,规划建设分布式云存储系统。 1.3云存储拓扑示意图 UCS的存储节点通过Uni-FS分布式文件系统,将多台存储节点上的物理资 1.前言 1.1.简介 1)MinIO 是在Apache License v2.0 下发布的对象存储服务器。它 与Amazon S3 云存储服务兼容。它最适合存储非结构化数据,如照片,视频,日志文件,备份和容器/ VM 映像。对象的大小可以从几KB 到最大5TB。 2)MinIO 服务器足够轻,可以与应用程序堆栈捆绑在一起,类似于 NodeJS,Redis 和MySQL。 3)一种高性能的分布式对象存储服务器,用于大型数据基础设施。 它是机器学习和其他大数据工作负载下Hadoop HDFS 的理想s3 兼容替代品 1.2.特点 Minio使用纠删码erasure code和校验和checksum来保护数据免受硬件故障和无声数据损坏。即便丢失一半数量(N/2)的硬盘,仍然可以恢复数据。 2.预研目的 检验在分布式部署条件下,minio在多种实验环境下的数据的安全性。 3.预研环境 4.环境部署 4.1.系统初始化 1)关闭防火墙 2)关闭selinux 3)关闭NetworkManager 4.2.下载minio二进制包 curl -O https://dl.min.io/server/minio/release/linux-amd64/minio 4.3.安装minio chmod +x minio mv minio /usr/bin/ 4.4.创建节点export 在minio的4个节点上各创建1个export,为了方便理解给每个export取名为/data_{+ip地址的最后一位数},最后生成的export如下表所示: 4.5.编写运行脚本 cat minio_startup.sh #!/bin/bash export MINIO_ACCESS_KEY=Admin#Geostar,5 export MINIO_SECRET_KEY=Super#Geostar,5 /usr/bin/minio server http://172.16.150.5/data_05 http://172.16.150.14/data_14 http://172.16.150.21/data_21 http://172.16.150.24/data_24 & chmod +x minio_startup.sh 2014/10/17 云计算环境下的分布式存储技术的研究与分析 李世敏 (四川大学计算机学院,四川成都610225) Cloud Computing Environment of Distributed Storage Technology Research and Analysis LI Shi-Min (Department of SiChuan, University, City ChengDu, China) Corresponding author: E-mail: 2586975148@https://www.360docs.net/doc/9b16507618.html, Abstract: cloud computing describes a new IT service value based on the Internet, use and delivery mode, is a combination of data sharing and Shared services computing mode.As the cloud of promotion and popular, how high rate, low cost of storage and management of large amounts of data generated in the clouds, has become a focus in the study of major enterprises and organizations, which requires good cloud structure design, data storage and processing pattern and cloud storage platform.From the combination of cloud computing and cloud storage technology, aiming at how to improve the scalability of the storage, fault tolerance and lower the energy consumption of the storage, such as target, from the design of the data center network, data storage, etc were summarized, the key technology in the current distribution of storage, and on this basis, to the cloud environment of distributed storage system under the challenges faced by summarized and expounded. Key words: cloud computing;The data center;Data storage way;Storage challenges 摘要: 云计算描述了一种新的基于互联网的IT服务增值、使用和交付模式,是数据共享与服务共享计算模式的结合体。随着云计的推广和流行,如何高速率、低成本储存和管理生成于云端的大量数据,也成为各大企业和组织研究的重点,这就需要有良好的云结构设计、数据存储及处理模式和云存储平台。从云计算与云存储技术的结合入手,针对如何提高存储的可扩展性、容错性以及降低存储的能耗等目标,从数据中心网络的设计、数据的存储方式等方面对当前分布存储的关键技术进行了综述,并在此基础上,对云环境下的分布式存储系统所面临的挑战进行总结和阐述。 关键词: 云计算;数据中心;数据存储方式;存储挑战 1 引言 云计算是随着计算、存储以及通信技术的快速发展而出现的一种崭新的共享基础资源的商业计算模型,被誉为“革命性的计算模型”。云计算不同于传统的以个人计算机为中心的本地计算,它以互联网为中心,通过构建一个或多个由大量(百万级以上)普通机器和网络设备连接构成的数据中心,把海量的数据存储到数 1 1.分布式计算是一种把需要进行大量计算的工程数据分割成小块,由多台计算机分别计算,在上传运算结果够,将结果统一合并得出数据结论的科学。 2.分布式系统的关键目标:用户可以方便的访问资源;对用户隐藏资源再多台计算机上分布的情况;分布式系统是开放的;分布式系统是可扩展的3.资源可访问性:是用户可以方便的访问远程资源,并且以一种受控的方式与其他用户共享这些资源。 4.透明性;指分布系统是一个整体,而不是独立的组件的组合,系统对用户和应用程序屏蔽其组件的分离性。 5.云计算:由一系列可以动态升级和被虚拟化的资源组成,这些资源被所有云计算的用户所共享并且可以方便的通过网络访问,用户无需掌握与计算技术,只需要按照个人或者团体的需要租赁与计算的资源。 6.云计算的优缺点;优点(1.数据的可移性2.轻松维护个人应用程序和个人文件 3.对计算机的要求低4.给多人协作带来了机会5.资源整合使用率高6.节电省能,降低成本)缺点(1.对网络的高依赖性2.数据的安全问题3.数据的存活能力 7.集群运算与网格运算的区别:1在集群中,资源位于单个的管理区中由单个实体进行管理;而在网格系统中,资源分布在不同的管理区。每个管理区都有其策略和目标2应用程序的调度安排,集群系统中的调度器着眼于提高整个系统性能;而在网格系统中调度器被称为资源代理着眼于提升特定应用的表现来满足终端用户的服务质量需求。 8.分布式系统:是一组自治的计算机集合,通过通信网络和相互链接,实现资源共享和协同工作,而呈现给用户的是单个完整的计算机系统。 9.分布式与集中式区别:1.分布式各组件和进程行为是物理并发的,没有统一时钟,而集中式系统的时间是明确的,同步机制实行起来相对容易 2.分布式系统各组件必须实现可靠安全的相互作用,当一部分出现故障时,系统大部分工作仍可进行。而集中式系统出现鼓掌则不能继续工作 3.分布式系统的异构性。4与集中式系统相比,分布式系统响应时间较短。5.分布式系统具有可扩展性。 10.分布式与计算机网络区别:1.分布式系统各个计算机之间相互通信,无主从关系,网络有主从关系 2.分布式系统资源为所有用户共享,网络有限制的共享3.分布式系统中若干个计算机可相互协作共同完成一项任务,网络不行。 11.对等体系结构:在对等体系机构中,一项任务或活动涉及的所有进程扮演相同的角色,作为对等方进行协作交互,不区分客户和服务器或运行它们的计算机。 12.中间件:是一种独立的系统软件或服务程序,分布式应用软件借助这种软件在不同的技术之间共享资源,中间件位于客户机服务器的操作系统之上,管理计算资源和网络通信。 13.分布式系统分类:1布式计算系统2分布式信息系统3分布式普适系统 14.分布式系统中的硬件:1基于总线的多处理机2基于交换的多处理机3基于总线的多计算机4.基于交换的多计算机 15.分布式系统中的软件:1分布式操作系统,2.网络操作系统3中间件系统 16.分布式操作系统:是分布式软件系统的重要组成部分。负责管理分布式系统资源,控制分布式程序运行等,其主要目的是为了隐藏细节,管理硬件资源,提供系统接口,使得并进程能够共享系统资源。 17.网络操作系统:是传统操作系统的扩充,为用户提供各种交换信息和资源共享的服务,这是一种典型的松耦合的软件与松耦合的硬件结合形成的系统。 18.中间件系统:满足大量用户的需求;运行于多种硬件和OS平台;支持分布式计算,提供跨网络、硬件和OS平台的透明性应用或服务的交互功能;支持标准的协议;支持标准的接口。 19.分布系统中的主要特征:1.容错性是允许系统出错的,但它可以在故障后恢复,而不丢失数据分布式系统区别与单机系统的一个特征是可以容许部分失效。2.安全性指系统中的数据被有意或者无意地泄露以及数据和其他系统资源被破坏的问题。 20.客户—服务器体系结构:是一个物理上分布的逻辑整体,它是由客户机、服务器和连接支持部分组成。客户机:是一个面向最终用户的接口设备或应用程序,它是一项服务的消费者,它包含并管理数据库和通信设备,为客户请求过程提供服务;连接支持部分是用来连接客户机与服务器的部分,如网络连接、网络协议、应用接口等。 21.客户-服务器结构的优点:1.有利于实现资源共享2.有利于进程通信的同步,3.可实现管理科学化和专业化4.可快速进行信息处理5.具有更好的扩展性 22.面向连接服务与面向无连接的服务: 23.1面向连接的服务是指通信双方在通信过程中必须建立一个虚拟的通信线路 24.数据传输过程必须经过连接建立、连接维护与释放连接三个阶段; 25.在数据传输过程中,各个分组不需要携带目的节点的地址; 26.传输连接类似一个通信管道,发送者在一端放入数据,接收者在另一端取出数据,传输的分组顺序不变,因此传输的可靠性好,但是协议复杂,通信 效率不高。 27.2无连接服务的主要特点是: 28.每个分组都携带源节点与目的节点地址,各 个分组的转发过程是独立的; 29.传输过程不需要经过连接建立、连接维护与 释放连接三个阶段; 30.目的主机接收的分组可能出现乱序、重复与 丢失现象。 31.无连接服务的可靠性不是很好,但是由于省 去了很多协议处理过程,因此它的通信协议相对简 单,通信效率比较高。 32.应用程序的层次结构:1用户界面层:是用 户通过界面中的一些友好提示信息与服务器进行交 互的一个层次。2逻辑事务处理层:在客户端用户提 出请求之后,服务器对客户端提交的请求服务进行处 理,也是整个系统的核心。3数据层:是整个客户- 服务器模型的基础,一般是由服务器提供,它为逻辑 事务处理层提供处理过程所需要的数据。 33.多层体系结构的特点:安全性;稳定性;易 维护性;快速响应性;系统灵活扩展性 34.双层体系结构特点:1.缺乏有效的安全性 2.客户端负荷过重 3.服务器端工作效率低 4.容易造 成网络阻塞 35.计算机网络通信过程实质是分布在不同地 理位置的主机进程之间进行通信的过程,进程间的通 信实际就是进程之间的相互作用,客户-服务器模式 实际上就是提供呢进程间相互作用的一种方式。 36.进程通信中客户——服务器你模型的实现 方法:1并发服务器:核心是使用一个守护程序;处 于后台工作,当条件满足时被激活进行处理。2迭代 服务器:通过设置一个请求队列存储多个客户的服务 请求,服务器采用先到先服务的原则影响客户端的请 求。 37.并发与代理服务器的比较:1并发服务器: 系统资源要求高;可以处理多个用户的服务请求;从 服务器不以来主服务器而独立处理服务请求;不同的 从服务器可以分别处理不同客户的服务请求;系统的 实时性好;适应于面向连接服务类型 .2迭代服务 器:系统资源要求不高;处理客户的服务请求的数量 受到请求队列长度的限制;可以有效的控制请求处理 时间;适应于无连接的服务类型。 38.OSI七层:1物理层是OSI参考模型的最低 层,主要功能是为数据链路层屏蔽网络的底层物理传 输介质的差异。2数据链路层:OSI模型的第二层, 它控制网络层与物理层之间的通信。它的主要功能是 如何在不可靠的物理线路上进行数据的可靠传递。3. 网络层:O S I 模型的第三层,主要任务是通过路由 选择算法,为分组通过互联网选择适当的路径4.传输 层:向用户提供可靠的端到端的服务,其主要任务就 是实现分布式进程的通信,是整个协议结构的核心5. 会话层:负责在网络中的两节点之间建立、维持和终 止通信。6.表示层:主要是处理两个通信系统中交换 信息的表示方式,包括数据格式变换,数据加密和解 密,数据压缩与恢复功能7.应用层:应用层是最高层, 主要功能是为应用程序提供网络服务。 39.客户-服务器端模型的变种:1移动代码: 是指能从一台计算机下载到另一台计算机运行的代 码。2移动代理:可以从一台计算机移动到网络上的 另一台计算机,访问本地计算机得资源,完成存储信 息收集之类的任务,最后返回结果的一种应用程序。 3网络计算机:是一种专门用于网络计算机环境下的 终端设备4瘦客户:指一个软件层,它支持用户端得 计算机枪基于窗口的用户界面,而在远程的计算机上 执行的应用程序5移动设备和自主网络 40.分布式对象:将接口放在一台计算机上,对 象本身却驻留在另一台计算机上。 41.远程对象特征:它们的状态并不是分布的; 它驻留在单个计算机上,只有由该对象实现的接口可 以在其他计算机上使用。 42.分布式对象的基本模型:1.远程对象 2.分 布式共享对象。 43.远程过程调用的基本思想:是调用方通过使 用参数来把信息发送给被调用方,然后被调用方就传 回调用方想要得到的信息。 44.隐式绑定和显示绑定:隐式绑定是一种简单 机制,该机制允许客户在只使用对象引用的情况下可 以直接进行方法调用。显示绑定一般返回指向代理的 指针,该代理可以在本地使用。 45.RMI和RPC本质上的不同:RMI一般支持系 统级对象引用;RPC不需要使用通用的客户端和服务 器存根,却可以更加方便的使用针对特定对象的存 根。 46.分布式计算环境:是用来作为现有的操作系 统和分布式式应用程序之间的中抽象层 47.最常见的两种分布式对象:1分布式动态对 象,它是由服务器以客户的名义在本地创建,只能由 所代表的客户访问。2 分布式命名对象,它由服务器 创建后可以供多个客户共用 48.java远程方法调用的优点:1.安全2.可移 动属性3.设计方式4.安全5.便于编写和使用6.编写 一次7.分布式垃圾收集8.并行计算。 编程部分: 1.IDL模块 module china{ Module ruc{//no definition here} }; 映射结果 package china.ruc; 2.Idl常量 Module ConstIDL{const long myconstant=123}; 映射结果 packageConstIDL Public interface myconstant{public static final int value=(int)(123;)} 3.IDL结构体类型 Module structmodule{ Struct person{string name;short age;}; }; 生成结果 Package structmodule; Public final class persion implements org.omg.CORBA.portable.IDLEntity{ Public string name=null; Public short age=short(0); Public person(){} Public person(srting_name,short_age){name=_name;age= _age;} } 4.IDL序列和数组 Module arraymodule{ Struct somestructure{ Long longarray[15]; Sequence分布式控制系统

《分布式计算、云计算与大数据》习题参考解答

分布式存储系统节能技术研究综述

高性能计算、分布式计算、网格计算、云计算概念与区别

曙光ParaStor300S并行分布式云存储系统产品技术白皮书V1.6

分布式系统与云计算课程教学大纲

分布式存储发展趋势及技术瓶颈分析

DCS是分布式控制系统的英文缩写

基于DHT分布式云存储系统综述

分布式计算、并行计算及集群、网格、云计算的区别

一级视频云存储技术方案

天网云存储系统建设方案

MinIO分布式存储技术预研报告

云计算环境下的分布式存储技术的研究与分析——李世敏——1143041362

分布式系统及云计算复习资料