VMware vSphere 5.1 群集深入解析(第四部分 群集架构的扩展)

第四部分群集架构的扩展

第一章群集架构的扩展

第二章 vSphere配置

第三章故障排错

第四章总结汇总

第五章附录

第一章群集架构的扩展

在这部分我们将继续讨论特定的基础架构、怎样利用HA,DRS和存储DRS以及怎样部署增加可用性。无论是你的工作量还是资源提供给你的工作量,我们将通过一些设计建议和决策方法来进行指导。当然,为了在实施的细节上做出合适的决定,完全了解你的环境是必要的。无论如何,我们希望这个部分能提供一个恰当的方式理解如何将某些功能放到一起,如何在你的环境接收到需求的时候,建立理想的架构。

场景

我们选择是场景是扩展群集,也会提到Vmware vSphere Metro Storage Cluster 解决方案。我们选择指导的场景来允许我们解释多个设计和架构考虑。尽管场景已经测试过,在我们的实验环境中也有效,每个环境是独一无二的,我们的建议基于我们的经验和你的情况可能不同。

一个VMware vSphere Metro Storage Cluster (vMSC)配置是Vmware vSphere 5认证的解决方案,基于群集结合存储阵列同步复制。这个解决方案通常部署在数据中心距离上有限制的环境,往往大都市或者校园环境。

扩展群集模式主要的优势是使数据中心充分活跃和工作负载平衡,因为站点之间虚拟机的迁移和存储vMotion的能力,许多客户发现了其吸引力,开启 on- demand和non-intrusive来跨站点移动工作负载,群集的扩展能力提供主动负载平衡自由,这应该是主要的设计和实施目标。

扩展群集解决方案提供的好处:

?工作负载移动性

?跨站点自动负载平衡

?增强避免停机时间

?避免灾难

技术需求和约束

因为虚拟机在线迁移的技术约束,有一些指定的需求必须在扩展群集实施时需要考虑,这些需求在Vmware 硬件兼容向导中存储部分的清单中,包括如下:

?存储连接使用光纤通道,ISCSI,SVD(存储虚拟化设备)和支持FCOE ?存储连接使用NAS(NFS协议)在写入的时候不支持vMSC配置(2012年8月)

?在站点和ESXi管理网络之间支持的最大网络延迟为10ms往返时间(Round Trip Time (RTT))

?注意vMotion仅仅在企业加强版的license下才支持的10ms延迟(Metro vMotion)

?为了同步存储重复链接支持最大的延迟是5ms(Round Trip Time (RTT)),通常你的存储厂商会提供它们允许的最大的RTT

?ESXi的vMotion网络至少需要622Mbps的冗余网络链路

存储的需求比存储同步复制解决方案要复杂一些,一个

vSphere Metro Storage Cluster请求会由单个存储子系统扩展到站点,在这个设计中,提供的数据存储必须可以访问(能读能写),并同时来自于两个站点。更进一步,当问题出现,ESXi主机必须能继续从任一站点访问数据存储,不影响正在进行的存储操作。

这排除了传统的同步复制解决方案,当他们在活动的(主)LUN之间创建主/备关系,数据被访问,备LUN正在收到复制操作,在这些解决方案中,为了访问备LUN,重复必须停止(或者撤销),LUN可见主机,现在升级了的备LUN有了完全不同的LUN ID,本质上是一个新的可用副本,这种类型的解决方案适用于适用于传统的灾难恢复。预计虚拟机需要在第二站点上启动,vMSC需要同时配置第二站点,vMSC需要同时配置不影响访问,所以站点之间还是允许运行着的虚拟机进行迁移;正常的vMotion不会迁移虚拟机的磁盘文件。

vMSC的存储子系统必须在两个站点上同时读写,所有磁盘写入站点同步来确保数据一致性。写无论本地从哪个位置读取,存储架构在群集站点间调用需要大量的带宽和非常低的延迟,增加距离和延迟将引起磁盘写入延迟,使得性能大打折扣,将不允许在群集站点的不同地点之间成功执行vMotion。

统一和非统一

vMSC解决方案在不同区域目录中分类,这些分类基于不同基础的主机访问存储。理解不同类型的扩展存储解决方法非常重要,它会影响到你的设计,有个主要的目录在VMware 硬件兼容性列表中有描述:

?统一主机访问配置–两个站点的ESXi主机要连接全部站点存储群集上的存储节点来访问,提交ESXi主机的路径是扩展访问距离

?不统一的主机访问配置–每个站点的ESXi主机只连接同一站点的存储节点,提交ESXi主机的路径的存储节点限制在本地站点。

让我们从架构和实施角度描述更深一些来确保它们足够清晰。

统一,数据中心-A和数据中心-B的主机既能访问数据中心A存储系统又能访问数据中心B存储系统。实际上,存储区域网络在站点和所有主机之间被扩展从

而能访问所有的LUN,在这些配置中,读写访问LUN发生在两个阵列之一上,同步镜像被维护隐藏,在第二阵列处于只读状态。例如,如果LUN包含的数据存储在数据中心-A的阵列上可读写,所有的ESXi主机将通过数据中心A的阵

列进入数据存储,为了数据中心A的ESXi主机,会有一个本地访问,数据中心B ESXi主机上的运行着虚拟机的位于数据存储上,为了防止停机或者LUN的

操作控制转换到数据中心-B上,所有的ESXi主机将继续查看在场的相同的LUN,除了已经访问了数据中心-B的ESXi主机。

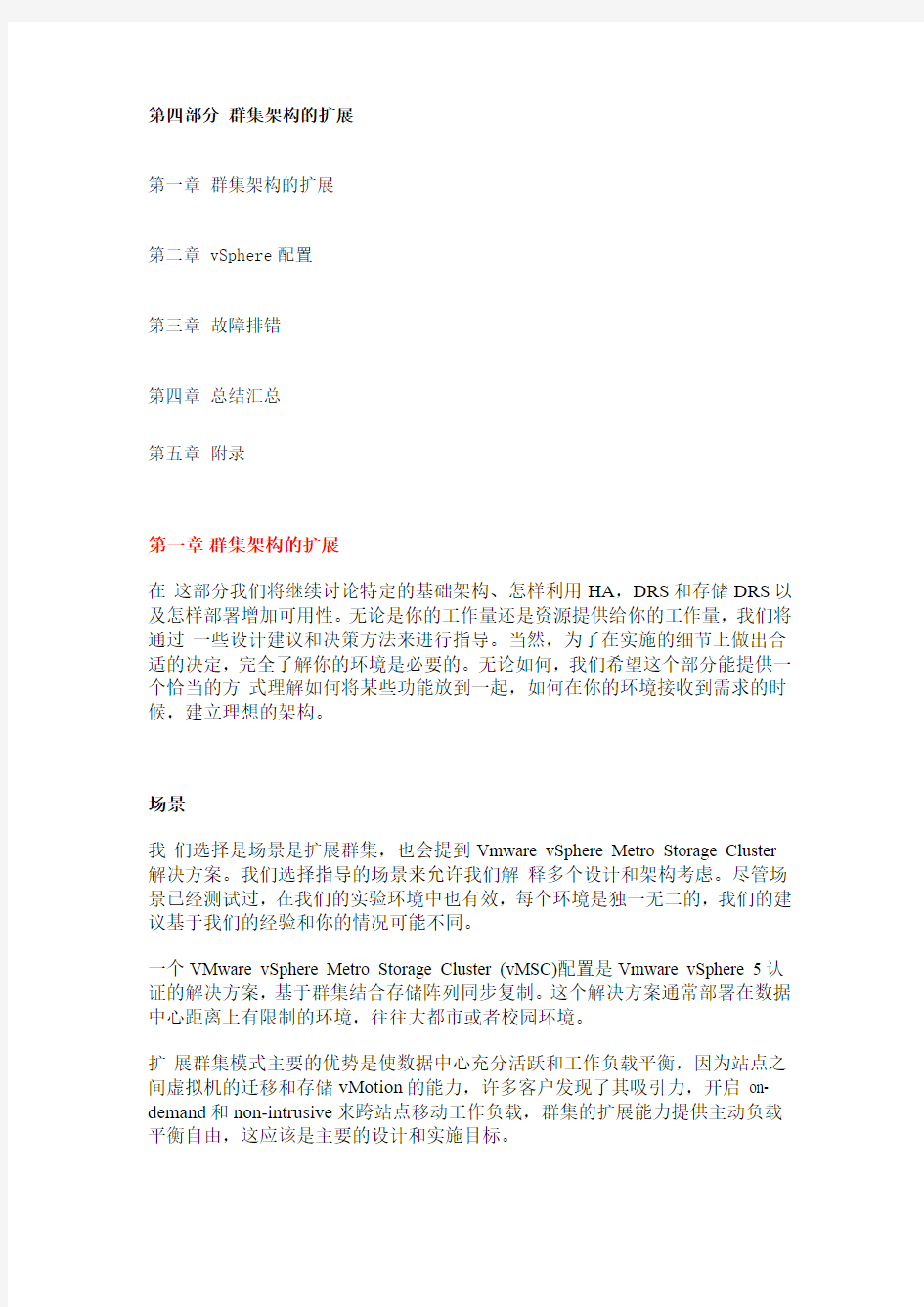

图160:统一存储架构

正如你所看到的,理想的情况是一个虚拟机同一个数据中心通过阵列控制(读写)访问的数据存储,这最大限度的减少了数据中心之间的流量,避免了读取整个互连性能的影响。

虚拟机的站点关联的概念是由数据存储的读写副本支配,―站点关联‖一些时候也称之为―site bi as‖或者―LUN locality‖,意味着当数据中心A上的虚拟机有站点关联,它读写数据中心A位于数据存储上的副本,这已经在DRS章节中解释得较详细。

不统一:数据中心A上的主机只能访问数据中心本地的阵列,阵列(相反的数

据中心的同级阵列)负责提供全部的数据存储大家访问,在大多数场景中虚拟机用到了这个概念,它允许每个数据中心上的ESXi主机读写同一个数据存储/LUN。

很好理解,即使两个虚拟机在同一个数据存储,但位于不同的数据中心,它们

会写到本地,在此配置的一个关键点是,定义每个LUN/数据存储的站点关联(Site Affinity),还有时候需要涉及到―Site bias‖或者―LUN locality‖。换句话说,如果在站点和站点上的存储系统之间的链路上发生一些事情,站点为了个给数

据存储将只有读写方式的能够访问,这当然是为了在失败的场景下阻止数据损坏。

图161:不统一的存储架构

作为统一的解决方案是当今最常用的部署,我们的测试情况下将使用统一存储,应当指出,许多的设计考虑也适用于非统一配置,若不是这种场景的情况,我们会进行收集。

场景架构

在这部分我们将为场景描述架构配置,我们还将讨论一些基本的配置和多样的vSphere功能,为了更深的解释各自的功能,涉及到此书HA和DRS部分,我们将基于VMware最佳实践和提供的操作手册来提出针对建议,在我们失败的场景中将解释怎样在实践中阻止和限制停机时间。

架构

一个由单个vSphere 5.1群集和4个ESXi主机组成的架构场景,vSphere vCenter 服务器管理这些主机,它决定使用vSphere 5.1来测试提高改进vSphere 5.0 U1

中介绍的―永久设备丢失‖(PDL)场景。介绍的这些加强的功能主要用于扩展群集环境。我们将在此章节讨论vSphere HA部分更详细的内容。值得注意的是在vSphere 5.1中PDL行为方面没有任何改变。

为了我们测试目的,我们模拟有两个站点的用户环境,第一个站点叫Frimley,第二个站点叫Bluefin。Frimley数据中心和Bluefin数据中心之间是扩展2层网络,学校群集之间的距离是最小的距离,vCenter Server和虚拟机运行在同一个

群集上。

每个站点有两个ESXi主机,Bluefin数据中心的vCenter Server配置了

vSphere DRS管理主机,在扩展群集环境中只有一个vCenter Server实例是使用的,不同于传统的VMware Site Recovery Manager配置需要两个vCenter Server。在第15章讨论了配置VM-Host关联规则,在我们的场景中使用ISCSI为主要协议。

在vSphere 5.1群集通过统一设备接入模式的光纤配置连接上

NetApp MetroCluster。此配置在NetApp的技术白皮书―TR- 3548‖中有深入描述。这意味着群集里每个主机连接了两个存储节点。每个节点连接到两个光纤交换机,第二区域的节点还连接到两个类似的交换机,对于任何给定的LUN,两个存储节点中的任何一个呈现的LUN是通过ISCSI读写。

与此相反的存储节点保持着复制,只读副本有效的隐藏起来,直到ESXi主机需要。

当使用NetApp MetroCluster,一个ISCSI连接绑定一个指定的虚拟IP地址,ESXi 主机上的这个虚拟IP地址用来连接存储控制器。在失败的场景中,IP-Address

转换到相反的存储控制器,允许无缝访问目标存储的IP地址,而不需要重新配置。

总计创建了8个LUN:4个通过虚拟ISCSI IP地址访问Frimley数据中心,另外4个通过虚拟ISCSI IP地址访问Bluefin数据中心。

图162:基础结构

表27:基础架构

第二章 vSphere配置

这种情况下,我们的重点是扩展群集环境中vSphere HA,vSphere DRS和存储DRS之间的关系,以及围绕这些vSphere组件在设计和运作方面经常被忽视和低估的考虑。历来很多重点放在存储层,而很少考虑工作负载如何配置和管理。

如我们之前提到的,扩展群集关键的驱动力是工作负载平衡和灾难避免。怎样

确认我们的环境是处在合理的平衡中而没有影响可用性或者大幅减少操作开销?

我们怎样建立配置需求和持续管理过程,我们怎样定期验证我们仍然满足我们的需求?定义和遵从需求失败会使环境混乱难以管理、各种故障场景难以预测,也会希望它来帮助你。事实上,忽略过程会导致故障事件中产生额外的停机时间。

这三个VMware vSphere功能每一个都有特别的配置需求,能加强你环境的弹性和工作负载的可用性,通过这一部分,架构建议将产生,这些建议将基于测试期间的各种场景发现的问题。每一个故障场景测试在接下来的章节中都被记录,请记住,这些故障场景直接应用这些实例的配置,基于你的实施和配置选项你的环境可能会受到额外故障。

vSphere HA 特性

我们的实例环境中有4台主机和一个统一扩展存储解决方案。当全部站点发生故障是需要考虑弹性架构的一个场景,我们建议开启接入控制

(Admission Control),工作负载的可用性是许多扩展群集环境的主要驱动力,它建议有足够的容量允许全站点故障,尽管如此,两个站点将平等的分配主机,来确保所有的工作负载能通过HA重新开始,建议配置接入控制策略为50%。

我们建议使用基于百分比的策略来提供架构的灵活性和减少操作开销,尽管新主机加入环境中没有必要改变百分比,而且没有整合率偏差,导致使用虚拟机级别预留资源的风险,更多详情请见第6章。

HA使用心跳检测机制来验证主机的状态,如第3章解释的有两个心跳检测机制;称为网络和数据存储心跳检测,网络心跳检测时HA验证主机的主要机制,数据存储心跳检测是一旦网络心跳检测失败通过HA来确定主机状态的另一种机制。

如果主机没有收到任何的心跳检测,它检测是否仅仅是从其它主机隔离或者网络中完全隔离。这个过程包括了Ping主机的默认网关,或者一个或者多个手工设置的隔离地址来代替主机网关,从而加强隔离检测的可靠性。我们建议指定最少两个额外的隔离地址并且每个地址能到本地网络,即使在站点之间连接失败的情况下,开启HA能够验证完整的网络隔离,并提供冗余允许一个IP故障。

但是,如果主机被隔离,vSphere HA触发响应,这在之前有解释过,叫做隔离响应,当主机同管理网络之间的连接断开,触发隔离响应来保证妥善管理虚拟机。隔离响应在第三章有深入讨论,根据使用不同的存储和物理网络完成,隔离响应用来在需要时做出决定,我们提到在第四章,表3中支持的决定。

在我们的测试环境中,一部分这些地址将属于Frimley 数据中心,另一部分属于Bluefine数据中心,屏幕截图显示了怎样配置多个隔离地址的实例,vSphereHA 高级设置使用das.isolationaddress,更详细的如何配置可以在KB 文章 1002117中找到。

为了vSphere HA数据存储心跳在任何故障场景中都运行正常,我们建议增加数据存储心跳的数量为2-4,最少的数据存储心跳为2,最大为5,扩展群集环境中

建议4,这样将提供本地的全冗余。还建议定义4个指定数据存储为优先数据存储心跳,选择一个站点的2个然后选择另一个站点的2个。这样做即使站点之间发生连接故障也允许vSphere HA的数据存储心跳。如果站点之间发生连接故障后站点还存在部分网络,这些数据存储将非常有用。

数据存储心跳的数量能通过HA高级设置das.heartbeatDsPerHost.进行增加。

我们建议使用―选择考虑加入我的首选项的任何群集数据存储‖,它将允许vSphere HA选择任意4个设计的数据存储,我们手工选择变得不可用,原因是如果我们建议的站点间4个心跳连接失败,vCenter将最终在一个站点上,这样另一个站点的主机就没有机会HA来改变数据存储心跳。这个设置的截屏如下。

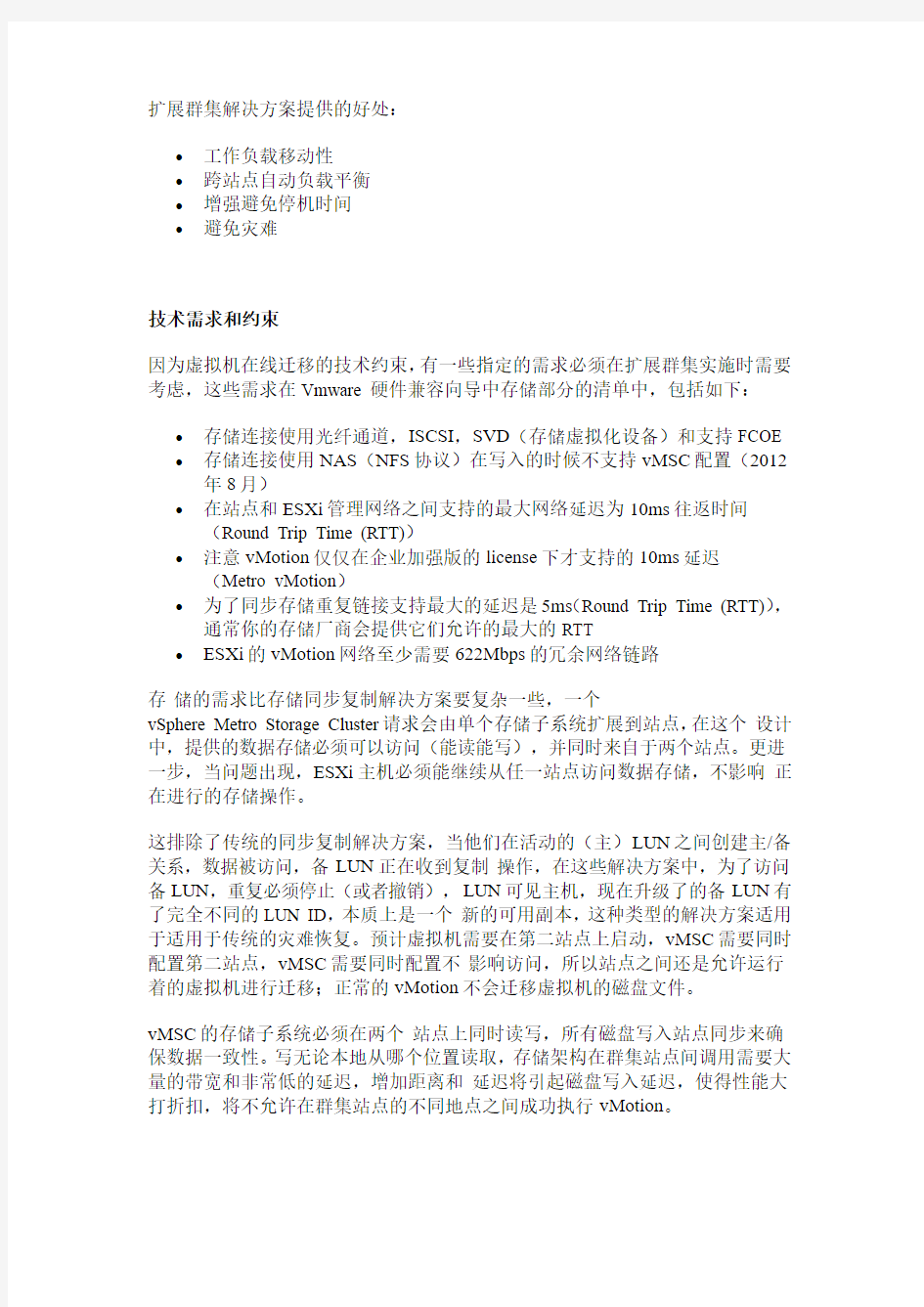

图163:数据存储心跳

vSphere 5.0 U1永久设备丢失(PDL)增强

vSphere 5.0 U1 版本中,介绍了永久设备丢失(PDL)的条件—允许数据存储上的虚拟机自动故障转移,我们将在其中一个故障场景中展示一个PDL环境,沟通的环境是通过阵列控制器经过一个指定的SCSI代码到ESXi,这些条件声明一个设备(LUN)将不可用,并且可能是永久不可用。当存储管理员设置这个LUN脱机,这个实例场景通过阵列通信,当撤回访问LUN,不统一的环境发生故障期间用来确定ESXi进行合适的行动,应该注意的是当全部存储发生故障,可能生成永久磁盘丢失的情况,在阵列和ESXi主机之间没有通信的可能,这个状态通过ESXi主机来识别当做所有路径断开(APD)。

重要的是认识到接下来的设置只应用PDL环境,而不是APD环境,在我们的故障环境中,我们将论证两种环境的不同行为。

为了允许vSphere HA响应PDL环境,vSphere U1里介绍了两个高级设置,第

一个主机设置是disk.terminateVMOnPDL Default。这个设置在

/etc/vmware/settings里配置,由默认设置为―True‖,注意这是每主机的设置,主机需要重新启动这个设置才生效,当数据存储进入了PDL状态,这个设置确保

杀掉虚拟机。PDL环境中一旦杀掉虚拟机,数据存储就磁盘I/O初始化。如果

虚拟机的文件没有在同一个数据存储上,并且PDL存在其中一个数据存储上,

通过HA虚拟机可能不会重新启动,vSphere 5.1里修正了这个问题,为了确保PDL环境中能通过HA进行迁移,我们建议设置

disk.terminateVMonPDL Default 为―True‖,并将虚拟机文件放置单个数据存储上,请注意当数据存储没有产生I/O,虚拟机只是被杀掉,虚拟机可以恢复活动的。正在运行密集内存负载而数据存储没有产生I/O的虚拟机可能恢复活动状态。

第二个设置是vSphere HA的高级设置,称之为das.maskCleanShutdown Enabled。vSphere 5.0 U1中介绍了这个设置,默认是禁用的,需要设置你的HA群集为

―True‖,这个设置允许HA触发PDL环境中自动杀掉的虚拟机重启,HA不能区分虚拟机是被PDL杀掉还是被管理员关闭,设置标记―True‖假定是前者。注意在APD期间用户关机将被行为标记

我们建议设置das.maskCleanShutdown Enabled 为―True‖,为了限制PDL环境数

据存储上虚拟机的停机时间,当das.maskCleanShutdown Enabled没有设置―True‖,PDL环境也存在,disk.terminateVMonPDL Default被设置为―True‖,杀掉虚拟机后,虚拟机重新启动不会发生,HA将假定虚拟机是管理员断电(或者关闭)。

vSphere DRS

vSphere DRS在很多环境中用来分配群集负载。vSphere DRS提供很多其它功能来帮助扩展环境,我们建议开启vSphere DRS允许群集的主机之间的负载平衡,vSphere DRS 负载平衡计算是基于CPU和内存的使用情况,同样,关于存储和

网络资源利用率和流量也必须小心照顾,为了避免扩展群集环境中非预期的存

储和网络流量开销,我们建议执行vSphere DRS关联规则来允许合乎逻辑和可预测的分开虚拟机,这将帮我们提高可用性,负责架构服务的AD,DNS虚拟机,这将有助于确保这些服务跨站点分离。

vSphere DRS关联规则还帮助阻止存储不要的停机时间和网络流量过载,我们建议调整vSphere VM-Host的存储配置关联规则,我们的意思设置VM-Host关联规则,这样虚拟机偏向于运行在同一站点的主机上,同时数据存储阵列的主要读/写节点进行配置。例如,我们的测试配置中,虚拟机存储在Frimley-01数据存储设置了VM-Host关联规则是偏向于Frimley数据中心的主机。这样确保了站点间网络连接发生故障时,虚拟机不会断开与存储系统的连接。VM-Host关联规则配置取决于这些建议,从而确保虚拟机呆在主数据存储本地。巧合的是所有的读

I/O来自于它们站点的本地虚拟机,注意:不同存储厂商使用不同的技术来描述LUN到阵列或者控制器的关系,在这个章节我们将使用通用术语

―Storage Site Affinity‖,―Storage Site Affinity‖意味着偏向于LUN 的本地读写访问。

我们建议执行―should rules‖,这些在HA发生故障时都能够被冲突,服务的可用性应该一直胜过性能。在―Must rule‖情况下,HA将不会同设置的规则冲突,在站点或主机发生故障时它可能导致服务中断。一个数据中心发生故障的场景,―Must rules‖将使它不可能为vSphere HA重启虚拟机,同时他们没有关联规则请求来允许虚拟机在其它数据中心的主机上开启。vSphere DRS同HA的沟通这些规则,把他们存储在允许启动的兼容性列表。vSphere DRS还有一个注意的地方,在某些情况下,如果大量的主机不平衡和激进建议设置,会与―Should rule‖冲突。尽管非常罕见,我们建议监控对你的工作负载产生可用性和性能有冲突的规则。

我们建议手工定义创建站点的一组主机,基于数据存储关联规则添加虚拟机到这个站点上,在我们的场景中只有限制数量的虚拟机被发布,我们建议使用vCenter Orchestrator或者Power CLI自动定义站点关联规则,如果没有选择自动,我们推荐使用一个通用的命名惯例,简化创建这些组,我们建议这些组定期验证,来确保属于组的虚拟机有正确的站点关联规则。

接下来的截屏描述了用于该场景的配置,在第一张截图中,所有的虚拟机应保持在Bluefin本地的虚拟机组内。

图164:DRS组-虚拟机

接下来,创建一个本地包括所有主机的Bluefin 主机组。

图165:DRS组-主机

最终,Bluefin本地创建好了一个新的规则,定义了连接到主机组虚拟机组―should run on‖规则

图166:VM-Host规则

两边本地都应该完成,直接导致了4个组合2个规则。

图167:结果-管理规则

调整关联性规则冲突

DRS分配了高优先级来调整关联性规则冲突,在调用期间,DRS的主要目标是调整任何冲突和为群集主机组主机清单上虚拟机生成迁移建议,这些移动的优先级比负载平衡高,所以将在负载平衡之前开始虚拟机迁移。

DRS 默认每5分钟调用一次,但是如果群集检测到更改DRS还是会触发,当主机重新连接上群集,DRS被调用,并生成建议来调整任何识别的冲突。我们的测试展示了在主机重新连接群集后的30秒内DRS生成建议来调整关联规则冲突。注意DRS限制了vMotion网络的总吞吐量,这意味着在所有的管理规则冲突被调整之前,可能需要多次调用。

vSphere Storage DRS

当定义的性能或者容量阈值超出,Storage DRS从管理员角度和虚拟机、磁盘平衡来考虑启用激进的单一数据存储,存储DRS确保你的工作负载中足够的磁盘资源可用,我们建议开启存储DRS。

存储DRS使用存储vMotion在数据存储群集内的数据存储上来迁移虚拟机,由于底层扩展存储系统使用同步复制,一个迁移或者一系列迁移将对重复流量有影响,导致在移动磁盘的时候出现网络资源争用,可能引起虚拟机临时不可用。从站点的角度,如果虚拟机不一起迁移它们的磁盘,在同一访问配置中迁移漫游数据存储还可能导致额外的I/O延迟。例如,如果Frimley主机上的虚拟机有磁盘迁移到Bluefin的数据存储上,它将继续操作,但可能降低性能。虚拟机读取磁盘受制于站点B读取虚拟iSCSI IP延迟的增加和受制于站点间的延迟。

当迁移发生时能够控制,我们建议配置存储DRS手工模式,这允许人工验证每个建议,并允许在非峰值时间应用建议,同时获得操作的益处和初始化位置的效率。

我们建议基于存储配置遵从存储站点关联来创建数据存储群集,站点A关联的数据存储不能同站点B的数据存储相互混合。这将允许操作的一致性和缓和DRS VM-Host关联规则的创建和持续。因此当数据存储群集和定义存储站点关

联边界之间的虚拟机被迁移,建议来保证所有的vSphere DRS VM-Host关联规

则被更新。我们建议调整数据存储群集和VM-Host关联规则的命名约定,以简

化配置和管理流程。

命名约定在我们的测试中用来给数据存储和数据存储群集一个特别的站点名称,从而简化站点上发布虚拟机的DRS主机关联性。在我们的站点―Bluefin‖和

―Frimley‖里的站点特指存储见下图。请注意vCenter映射功能不能用来查看存储当前的站点关联,同时也不能显示数据存储群集的对象。

图168:数据存储群集架构

第三章故障排错

这里有许多在群集系统故障场景没有介绍,但在一个合理的架构环境中,HA,DRS和存储子系统不会发生这些情况,我们将不解决没有影响力的故障,例如

单根网线的故障。它们在你选择存储厂商提供的解决方案文档中已经有深入解释。我们将讨论接下来的一些―常见‖的故障场景:

?Frimley数据中心的单台主机故障

?Frimley数据中心的单台主机隔离

?存储分割

?数据中心分割

?Frimley数据中心磁盘柜故障

?Frimley数据中心全存储故障

?Frimley数据中心全计算故障

?Frimley数据中心全计算故障和Bluefine数据中心全存储故障

?Frimley数据中心完全损失

我们还将在测试场景中指定设置错误的配置。这些设置会导致虚拟机的可用性和可恢复性发生故障,因此理解错误配置后的影响非常重要。

?VM-Host管理规则配置错误

?心跳数据存储配置错误

?隔离地址配置错误

?永久设备丢失配置错误

?vCenter Server脑裂场景

所有这些厂家都被测试,下面是我们每个方案的结果和可能的建议(如适用)。Frimley 数据中心单台主机故障

在这个场景中,我们通过在Frimley数据中心拔掉运行主机电源线缆来模拟完成了主机故障。这个场景描述如下图。

图169:单个主机故障

结果

通过vSphere HA所有的虚拟机成功启动,但是没有根据VM-Host关联性规则启动。

解释

如果一台主机发生故障,群集的HA主节点检测到故障,从此该主机不再收到

网络心跳。在主节点检测到网络心跳丢失,它将开始监控数据存储的心跳,自从主机完全发生故障,它不能产生数据存储心跳,这些通过HA 主节点检测。在

这段时间,ping故障主机的管理地址,再一次检测完成。如果所有的检测返回都是不成功的,主节点将申明丢失的主机死亡,再主节点与主机失去联系之前,

将尝试重新启动故障主机上所有受保护的虚拟机。

vSphere DRS VM- Host管理规则定义群集级别时―shoud rules‖(的成员虚拟机应

在组),意味着虚拟机可能在其它数据中心的主机上重启。在我们的测试中,我们见证这一行为多次,虚拟机在Bluefin数据中心群集中任一可用的主机上启动。vSphere DRS在首次调用时将尝试调整任何冲突的关联规则,同时按照他们的关联规则排队自动迁移置入虚拟机。我们建议手工调用vSphere DRS来确保所有的虚拟机在正确的主机上,尽可能避免性能降低和减少可用性以及可能的二次故障。在我们的场景中,虚拟机置入位置丢失将导致增加延迟,虚拟机将访问其它地方的存储。下面的截图描述了怎样在vCenter群集对象的DRS项中手工运行DRS。

图170:手工触发DRS

Frimley 数据中心主机隔离故障

在这个场景中,我们通过断开单个主机的所有的网络连接将其从Frimley数据中心隔离,存储网络不受影响。

图171:单个主机隔离

结果

虚拟机保持运行,隔离响应设置的是―保持电源开启‖

解释

当主机被隔离,通过HA 主节点隔离被检测到,同时该主机不再接受网络心跳。当主节点检测到网络心跳丢失,它将开始监控数据存储心跳,自此主机被隔离,它将在第二次HA检测机制时产生数据存储心跳,检测到有效的主机心跳将允许HA主节点来决定主机在运行中但网络隔离。依靠隔离响应配置,受影响的主机可能选择断电或者关闭虚拟机,或者依次让虚拟机通电。主机被隔离后30秒触发隔离响应。

我们建议调整隔离来响应商业需求和物理约束。从最佳实践观点来说,―保持电源开启‖是主流环境的推荐隔离响应。在合理的架构环境中隔离主机是非常罕见的事件,冗余是非常主流的设计,在使用基于网络存储协议的环境中,例如iSCSI 和NFS,建议隔离响应是―关闭电源‖,在这些环境中,它更可能是网络中断引起的主机隔离还将影响主机与数据存储的通信。

如果隔离响应推荐选择―保持开启电源―,当隔离响应被触发,将通过群集上的HA节点重新启动虚拟机。vSphere DRS VM-host管理规则定义了群集级别时

―should rules‖,意味着虚拟机可能在其它的数据中心的主机上重启,在我们的测试中,我们见证过这一行为多次,接下来的主机隔离和群集响应关联,我们建议手工调用vSphere DRS确保所有的虚拟机在合适的主机上,尽可能避免性能降低和无法置入虚拟机。在我们的场景中,无法置入虚拟机将导致增加延迟,同时虚拟机将访问其它地方的存储。

存储分割

在这个场景中,模拟数据中心之间的存储网络发生故障,描述如下图。

图172:存储分割

结果

虚拟机没有受到影响继续运行

解释

每个LUN有定义关联存储站点,vSphere DRS规则与这些关联一致。由于这些配置,没有虚拟机受到影响,同时它们的站点运行的存储保持可用。

如果任何原因虚拟机的关联规则发生冲突,Frimley数据中心内主机上运行的虚拟机,它们的磁盘属于Bluefin数据中心的数据存储,在站点间的存储分割,数据存储在所有路径断开(APC)的条件下,它不能成功的产生I/O。当HA主仍收到来自于群集其它主机的心跳,它将不会有任何行动:它们站点有冲突的任何虚拟机将不同通过HA重新启动,除非手动关闭虚拟机。

我们建议监控vSphere DRS规则的兼容性来避免APD场景中不必要的停机时间,尽管vSphere DRS每分钟调用一次,它不会保证每次调用期间所有的冲突都被解决。因此,建议严格的监控来允许快速识别异常同时阻止不必要的当机时间。

数据中心分割

在这个场景中,我们完全将Frimley数据中心和Bluefin数据中心隔离,描述如下图。

图173:数据中心分割

结果

虚拟机保持运行无影响

解释

在这个场景中,两个数据中心彼此完全隔离,这个场景类似于存储部分和主机部分隔离。发生这样的故障虚拟机不受影响。当vSphere DRS规则正确的执行,没有规则冲突。在群集分割期间HA按照逻辑的过程来决定哪些虚拟机需要重新启动:Frimley数据中心上运行的HA主节点检测到Bluefin数据中心的全部主机不可达,HA主节点首先检测没有接受到网络心跳。在此之后,它将证实是否有任何存储心跳生成;这个检查将检测存储心跳,同时站点之间存储连接发生故障,每个站点的数据存储心跳只更新本地的。虚拟机将关联剩下的正在运行的主机。接下来,HA将证实是否接受重启,因为数据存储的读写版本处于Bluefin 无法访问Frimley的主机,所以不要尝试开启其它站点丢失的虚拟机。

同样的,Bluefin 数据中心的ESXi主机将检测有没有主节点可用,并初始化选举主节点的过程,在新的主节点选出后,它将试图发现发生故障之前运行着的虚拟机,尝试重新启动它们。当所有关联到Bluefin的虚拟机仍运行在Bluefine数据中心,就不需要重启。只有关联到Frimley的虚拟机不可用,vSphere HA不会重启这些虚拟机,因为虚拟机所在的数据存储关联到Frimley,而在Bluefin数据中心不可用。

如果主机关联规则冲突,例如,默认,行为发生改变,虚拟机运行的存储没有定义的读写。我们故意配置冲突关联规则来记录这个行为:我们手工从Frimley 迁移虚拟机到Bluefin,这样做之后,我们创建了一个情况,虚拟机运行在Bluefin 的主机上运行,但是可以访问Frimley 数据中心的数据存储,当数据中心被隔离,接下来的顺序是我们见证的:

1. 虚拟机关联到Frimley但在Bluefin上不能到达数据存储。这导致了虚拟机不能磁盘读写

2. 在Frimley数据中心,虚拟机通过vSphere HA重新启动,同时Frimley数据中心的主节点不知道Bluefin数据中心运行的实例

3. 由于数据存储只有Frimley数据中心的主机能使用,Frimley数据中心的主机能获取锁定的虚拟机文件,并能够开启虚拟机

4. 创建的这个场景,同一个虚拟机在两个数据中心上运行。

图174:上电顺序

这是为什么?

?运行的虚拟机主机网络心跳丢失,因为两个站点之间没有管理网络连接?数据存储心跳丢失,因为两个站点之间没有存储网络连接

?ping运行了虚拟机的主机的管理地址失败,因为两个站点之间没有管理网络连接

?Frimley数据中心本地的主节点知道发生故障之前虚拟机已经开启,因为它不能再发生故障之后同Bluefin数据中心内的主机上的虚拟机通信?通过Bluefin数据中心的主机判断数据存储全部路径断开,同样的,没有采取任何行动。正如之前解释的,只有PDL条件下虚拟机被自动杀掉。

当两个站点之间的连接被修复,经典的―脑裂‖场景就存在了,在短时间内,两个同样MAC地址的虚拟机副本在网络上被激活。但是,它将访问虚拟机文件,HA 也认识到这一点,只要被检测到,所有属于虚拟机的副本不会访问被杀掉的虚拟机,如下图所示。

图175:锁定文件日志信息

在这个例子中,如果站点关联规则维护得比较合理,不必要的停机时间应该等于虚拟机的重启时间,而这个例子不是。所以我们建议更进一步监控vSphere DRS 规则与数据存储站点的关联来阻止不必要的停机时间。

Frimley数据中心磁盘柜故障

在这个场景中,Frimley数据中心的一个磁盘柜发生故障。在存储A 上的Frimley01和Frimley02受到影响。

图176:磁盘柜故障

VMware-vSphere日常操作手册

# 虚拟化操作手册 (

目录 一、vsphere虚拟化管理 (3) 1) 虚拟化组成及介绍 (3) > 2) ESXi (3) 3) 登录vcenter (8) 4) 新建虚拟机 (9) 5) 虚拟机的开启、安装操作系统和关闭 (22) 6) 安装VMTOOLS (26) 7) 更改虚拟机CPU和内存配置 (27) 8) 增加虚拟机硬盘 (31) 9) 虚拟机增加网卡 (37) > 10) 新建portgroup (41) 11) 虚拟机在ESXI主机间迁移 (44) 12) 虚拟机在存储LUN间迁移 (47) 13) 克隆虚拟机 (49) 14) 倒换成模板 (52) 15) 模板倒换成虚拟机 (55) 16) 删除虚拟机 (58) 17) 对ESXi的物理主机关机维护操作 (59) ~ 三、P2V转换 (61) 1) 安装Converter Server (61) 2) 登录Converter Server client (63) 3) Linux P2V (63) 4) Windows P2V (69) & ?

一、vsphere虚拟化管理 1)* 2)虚拟化组成及介绍 Vsphere 包括vcenter和ESXI主机组成. 虚拟机运行在ESXI主机上。 ESXI系统安装在物理服务器上。 Venter是虚拟化的管理平台,它安装在一台虚拟机上。 3)ESXi 连接服务器,或者从HP服务器的iLo管理界面中,登录ESXi界面。¥

" 按F2,登录。

常用的操作就两块,网络和troubleshooting。 其中troubleshooting中的restart management agents选项,用在vcenter无法管理ESXi

IT运维部年度工作总结

IT运维部年度工作总结 一、年度部门工作回顾 即将到来的XX年对于IT运维部是崭新的一年。IT运维部是A中心新增的技术部门,成员来自原技术中心和A中心各个部门,经过近一年的磨合和成长,IT 运维部取得了良好的成绩。以下是IT运维部年度主要完成工作任务: 1.软件维护和开发 1)每日报表自动生成系统:4月初,IT运维部完成开发了每日报表自动生成系统, 以提高生产率,减少数据处理人员的人力投入。 2)人员管理系统:10月初,开发完成了人员管理系统第一期,为业务部门提供质 量控制的工具。 3)运营支撑系统:为了规范A中心技术工作内部管理,提高响应速度,进行精确 化管理,IT运维部开发了以下四套系统:

4)协助业务部门进行各种软件维护工作,包括…项目,报表的维护,等等。

2.平台系统维护 1)年度一级故障数据分析: 2)完善A中心平台系统维护规范: 3)加强系统平台主动维护工作,以防患于未然: 4)快速响应,及时处理一系列重大故障。 5)进行A中心平台产品调研工作。 6)知难而上,接手数据库维护工作: 7)维护人员培养工作: 3.终端维护 1)整理终端维护资料:。 2)搭建上网代理服务器: 3)优化域服务器:。 4)C网日常技术支持:为CDMA客服区域、马场区域的座席提供技术支持工作。4.数据处理和分析 1)配合s项目:。 2)配合业务部门进行多项数据分析工作:。 二、经验教训和相关建议 在这一年中,虽然取得了不错的工作成绩,但是也存在着一些问题和不足。 1)需加强与A中心其他部门互动,以更顺利开展相关工作。

2)需加强大项目的开发进度的管理能力。 在年度公司的转型和发展过程中,我们很欣喜地看到公司蓬勃发展的良好局势。在展望持续发展的远景的同时,也提出我们对公司的相关建议: 1)增加员工职业发展、培训和继续教育的机会。员工的发展是公司保持持续创新 和进步的重要因素。 三、2009年工作思路和工作计划 1、继续做好A中心各种技术支撑工作,各项工作都要比08年做的更好。 2、开发人员管理系统第二期:包括薪酬计算模块,话务统计系统模块等等。 3、加强团队的团结性、高效性的培养,提高员工的积极性。同时,加强团队内部 沟通工作,提高团队开发水平。完善管理制度与工作规范,锻炼培养管理团队,提高部门整体管理水平。 4、加强部门内部的培训力度,活跃IT运维部内部的学术氛围。 IT运维部

vmwarevsphere日常操作手册

虚拟化操作手册2018年1月23日

目录 一、vsphere虚拟化管理 (3) 1) 虚拟化组成及介绍 (3) 2) ESXi (3) 3) 登录vcenter (8) 4) 新建虚拟机 (9) 5) 虚拟机的开启、安装操作系统和关闭 (22) 6) 安装VMTOOLS (26) 7) 更改虚拟机CPU和内存配置 (27) 8) 增加虚拟机硬盘 (31) 9) 虚拟机增加网卡 (37) 10) 新建portgroup (41) 11) 虚拟机在ESXI主机间迁移 (44) 12) 虚拟机在存储LUN间迁移 (47) 13) 克隆虚拟机 (49) 14) 倒换成模板 (52) 15) 模板倒换成虚拟机 (55) 16) 删除虚拟机 (58) 17) 对ESXi的物理主机关机维护操作 (59) 三、P2V转换 (61) 1) 安装Converter Server (61) 2) 登录Converter Server client (63) 3) Linux P2V (63) 4) Windows P2V (69)

一、vsphere虚拟化管理 1)虚拟化组成及介绍 Vsphere 包括vcenter和ESXI主机组成. 虚拟机运行在ESXI主机上。 ESXI系统安装在物理服务器上。 Venter是虚拟化的管理平台,它安装在一台虚拟机上。 2)ESXi 连接服务器,或者从HP服务器的iLo管理界面中,登录ESXi界面。 如果不是hp服务器可以用管理界面进行管理。或者直接到机房的物理服务器前进行如下操作

按F2,登录。

常用的操作就两块,网络和troubleshooting。 其中troubleshooting中的restart management agents选项,用在vcenter无法管理ESXi主机时。

运维部年度工作总结

运维部年度工作总结 篇一:运维部年度工作总结 XX年运维部工作总结XX年业已尾声,我部门在公司的正确领导下,认真执行公司制定的各项制度及部门制度,努力改进工作中存在的不足,并取得了一定进步,XX年我部门总体工作特点是:运维 任务基本饱和且多个项目同时进行,工作分散、繁琐,现就部门的各项工作进行一下简要总 结。 ⅰ.一年工作概况 1、上半年运维任务相对轻松,根据公司和部门要求集中进行内部优化,以及对以前工作 进行总结,各负责人在现有条件基础上,统筹安排,有条不紊的完成公司规定的任务指标, 没有因运维任务繁多而出现混乱。 2、下半年各主要项目陆续接手,同时部门内部各人员职责基本清晰,各负其责,整个部 门运行基本踏入正轨,方案、合同、资料、服务流程运行良好,同时现场服务人员能认真负 责的执行公司及部门的各项规定,掌握、收集、记录现场第一手资料,完成公司交办的各项 任务。

3、本年度中部门与部门间、员工与员工间,都在工作中不断的磨合,发现问题、解决问 题,各项工作并没有因此而停滞不前,经过一年时间的不断改进,对内公司各项工作渐渐运 转自如,对外也赢得了相关客户的认可,一切正朝着令人欣喜的方向前进。 4、本年度人员安排如下: 5、本年度服务数据如下: 6、本年度部门收费回款如下: 7、运维和参与项目实施情况㈠.全年部门完成运维任务: ①.解决招行成都分行监控中心大屏和两河公园停车场故障 与项目尾款回款两个难题;②.完成招行密押系统升级更新和其他系统运维任务;③.完成安 县交通卡口及金牛公安分局等其他客户监控系统运维任务;㈡.全年部门完成参与项目实施任务:金牛公安分局视频资源管理系统ⅱ.但是总结本年度的工作,还有一些问题存在,有些工作亟待改进: 一、备件管理 1、备件管理在XX年做得并不好,由于项目运维还处于成熟过程中,对运维备件要求 未按照实际使用作计划,导致在运维过程中,无法对备件进行有效控制,在今后工作中要着

VMware vSphere 服务器虚拟化建设方案

某航空公司虚拟化解决方案 行业航空业 用户名称某航空公司 项目需求服务器虚拟化 建设需求服务器虚拟化建设 项目目的IT系统必须要能满足随需应变的业务需求,随需应用的IT架构具有良好的扩展能力和柔性化,能快速地适应企业需求变化,并根据业务需要动态分配资源,从而提高业务 响应能力;能降低维护成本,提高运行效率;能够降低企业应用集成的复杂性,节省系统 整体成本。 解决方案为用户提供强大的虚拟化支持,VMware vSphere 是业界第一款云操作系统,通过将IT 基础架构转变为私有云(根据需要与外部云建立联邦的内部云集合)从而将IT 基 础架构作为可轻松访问的服务来交付。利用成本效益更高的云计算功能,打造灵活、 可靠的下一代IT 服务,对服务级别获得超强的控制力。 背景: 某航空有限责任公司(以下简称“某航”)成立于1992年11月,1993年9月17日正式开航,主要经 营航空客、货、邮运输业务。自开航以来,某航保持了16年安全飞行和15年持续盈利,成为中国民航界 赫赫有名的资产最为优良、主业最为突出、人机比例最低、最具活力和生机的航空公司之一,曾先后荣获“**市市长质量奖”、“中国最具价值品牌”、“中国十大雇主品牌”等荣誉。 用户需求及目标 IT架构需要优化 作为目前国内五大航空集团之一,某航深知,航空企业的发展离不开信息化建设,只有信息化能够帮 助某航在国内激烈的民航竞争中立于不败之地。自成立以来,某航在信息化建设上持续投入,不仅实现了 主要业务如订票系统、离港系统、货运系统、飞行运行管理系统、行李查询系统、财务系统、结算系统、 飞行部门编排航班、机组排班等业务的全部计算机化,而且还在移动办公、生产控制和服务营销等方面实 现了全方位的移动信息化。如今,某航信息化水平在国内航空公司中处于领先地位,为某航的成功发挥着 保驾护航的作用。 在成绩面前,某航没有骄傲,他们清醒地认识到,要让某航在这个充满变化的时代保持企业高速稳定 的发展,IT系统必须要能满足随需应变的业务需求,随需应用的IT架构具有良好的扩展能力和柔性化,能 快速地适应企业需求变化,并根据业务需要动态分配资源,从而提高业务响应能力;能降低维护成本,提高

VMwareESXi5.5安装及设置详细步骤

VMware ESXi是主机服务器虚拟化过程后最重要的虚拟化主机,是最灵活的虚拟主机平台。 VMware ESXi的安装方法有很多种,有交互式ESXi安装,脚本式ESXi安装,Auto Deploy ESXi 安装和使用ESXi Image Builder CLI 自定义安装,此处使用交互式ESXi安装方法。 一、VMware ESXi 5.5安装 1、将ESXi安装程序CD/DVD 插入CD/DVD-ROM 驱动器,或连接安装程序USB闪存驱动器并重新启动计算机。将BIOS设置为从CD-ROM设备或USB闪存驱动器引导。 2、在引导过程中,可以看到主机的cpu和内存的基本信息。 3、在出现的第一个安装引导界面中,点击Enter,确定继续安装。

注意:在“选择磁盘”页面中,选择要在其上安装ESXi的驱动器,然后按Enter。按F1 可获取所选磁盘的相关信息。选择磁盘时,请勿依赖于列表中的磁盘顺序。磁盘顺序由BIOS 确定,并可能顺序不当,连续添加、移除驱动器的系统可能会出现这种问题,如果选择的磁盘中包含数据,则将显示“确认磁盘选择”页面,如果在具有之前的ESXi 或ESX 安装或VMFS 数据存储的光盘上安装,该安装程序可提供多个选择。 如果选择的磁盘位于虚拟SAN 磁盘组中,则生成的安装将取决于磁盘类型和组大小。 如果选择的是SSD,则同一磁盘组中的SSD 和所有基础HDD 将被清除。 如果选择的是HDD,并且磁盘组有两个以上磁盘,则只有选定的HDD 才会被清除。 如果选择的是HDD 磁盘,并且磁盘组的磁盘不超过两个,则SSD 和选定的HDD 将被清除。

XXXX年运维工作总结

XXXX有限公司 XXXX年度运维工作总结 工作总结 XXXX XXXX/X/X 对过去的XXXX年的运维工作进行总结,主要总结工作内容、运维工作流程、经验总结。

目录 1工作内容 (3) 1.1例行工作 (3) 1.1.1 设备巡检 (3) 1.1.2 日常数据配置 (3) 1.2 网络割接、工程配合与配置优化 (4) 1.2.1网络割接 (4) 1.2.2 工程配合 (4) 1.2.3 系统配置优化 (4) 1.3 故障处理 (4) 2运维工作 (4) 2.1 服务精神 (4) 2.2 自我要求 (4) 2.3 运维水平 (5) 3经验总结 (5) 3.1 运维工具 (5) 3.2 智能巡检 (5) 3.3 经验总结 (5) 3.4 项目实施 (5) 3.5 轮岗 (5) 3.6 机房割接 (6) 3.7 部门协助 (6)

XXXX年度运维工作总结 1工作内容 工作内容主要分为:例行工作、网络割接、工程配合、配置优化、以及故障处理几项。 1.1例行工作 例行工作占全部工作的X%,主要包括:设备巡检、日常数据变更。具体百分比如下: 设备巡检:X%、日常数据变更:X% 1.1.1 设备巡检 设备巡检分为定期巡检和不定期巡检,定期巡检分为周巡检和月末巡检两种。定期巡检X次:周巡检X次,月末巡检X次 不定期巡检,主要是在每个工作日开始,根据具体工作安排情况对核心设备的log进行简单分析,以及时发现前一工作日设备的运行变化是否有异常,此项工作是周一早晨的重点工作。 1.1.2 日常数据配置 日常数据配置变更主要根据各部门提交的工单来处理,以及移动内部的协作配合工单需求,主要分为以下几类: 常规操作工单; 终端应用故障排除; 无线用户接入; 新增设备的网络规划; 配合新增设备网络布线; 涉及核心设备的接口地址变更操作; 大量需要集中处理的工作,如服务器批量接入等; 涉及网络拓扑变化的操作; 应其他部门要求的网络保障。

vmwarevsphere常见问题汇总

VMware vSphere常见问题汇总(十七) 170. Vmdk 的重做日志已损坏解题思路 [vmware-]环境:, 故障问题:执行storage vmotion之后,虚拟机出现了报错。 报错信息: is off the virtual machine. If the problem still persists, discard the redo log. 解提思路: 【故障原因】 由于快照之间的关系出现异常,导致vm启动失败: :2013-01-14t08:36:| vmx| disklib-chain : "/vmfs/volumes/50f13506-075ed29b-86b5-5ef3fd359eab/è3 184/" : failed to open (the parent virtual disk has been modified :2013-01-14t08:36:| vmx| disklib-lib : failed to open '/vmfs/volumes/50f13506-075ed29b-86b5-5ef3fd359eab/è3 184/' with flags 0xa the parent virtual disk has been modified since the child was created. The content id of the parent virtual disk does not match the corresponding parent content id in the child (18). :2013-01-14t08:36:| vmx| disk: cannot open disk "/vmfs/volumes/50f13506-075ed29b-86b5-5ef3fd359eab/è3 184/": the parent virtual disk has been modified since the child was created. The content id of the parent virtual disk does not match the corresponding parent content id in the child (18). :2013-01-14t08:36:| vmx| msg_post: error :2013-01-14t08:36:| vmx| [ cannot open the disk '/vmfs/volumes/50f13506-075ed29b-86b5-5ef3fd359eab/è3 184/' or one of the snapshot disks it depends on. :2013-01-14t08:36:| vmx| [ reason: the parent virtual disk has been modified since the child was created. The content id of the parent virtual disk does not match the corresponding parent content id in the child. :2013-01-14t08:36:| vmx| module diskearly power on failed. 【快照之间的联系】

vmwarevsphere虚拟化平台运维手册

VMware虚拟化平台 运维手册

文档编辑记录 版本记录 术语和缩写 为了方便阅读,特将文中提及的术语及缩写列示如下: 本文中所有内容均属XX公司和xx公司的商业秘密。未经允许,不得作任何形式的复制和传播。

目录 1.概述错误!未指定书签。 1.1目的错误!未指定书签。 1.2现状描述错误!未指定书签。 1.2.1软件版本错误!未指定书签。 1.2.2用户名及密码错误!未指定书签。 2.管理虚拟机错误!未指定书签。 2.1登录vCenterserver错误!未指定书签。 2.2新建虚拟机错误!未指定书签。 2.3编辑虚拟机错误!未指定书签。 2.4挂载镜像错误!未指定书签。 2.5安装VMwareTools错误!未指定书签。 2.6删除虚拟机错误!未指定书签。 2.7模板部署虚拟机错误!未指定书签。 2.8克隆虚拟机错误!未指定书签。 2.9虚拟机快照错误!未指定书签。 2.10删除虚拟机快照错误!未指定书签。 3.监控虚拟化平台错误!未指定书签。 3.1性能监控错误!未指定书签。 3.2任务和事件错误!未指定书签。 3.2.1任务错误!未指定书签。 3.2.2事件错误!未指定书签。 3.3警报错误!未指定书签。 3.4日志错误!未指定书签。 概述 1.1目的 本手册针对VMware虚拟化平台提供日常维护操作的指导。 1.2现状描述 本项目由28台物理主机和一台VC组成,另部署一套VCOPS和VDPA。 1.2.1软件版本 物理主机:VMware-ESXi-5.5.0 Vcenter:VMware-vCenter-Server-Appliance-5.5.0 Vcops: Vdpa: 1.2.2用户名及密码 管理虚拟机 1.3登录vCenterserver

2019运维部年终工作总结5篇

2019运维部年终工作总结5篇 精选运维部年终工作总结(一) 去年的年末,我来到了运维部。这是一个技术岗位,刚来的我,对于我的工作可以说是相当的陌生。大多数仪器、设备都不认识,不像书本上讲的那些。它们对于我来说都是新的,需要学习来完成工作。我对我的工作充满了热情,如饥似渴的去学习书籍,请教同事,慢慢的汲取知识和经验。刚开始,每一次出去解决故障,我都有点担心,怕工作做不好,所以每一次,我都认真向前辈们学习,看他们如何去操作仪器,如何去分析故障点,不懂的我就问为什么。 还有不懂的,我就回来查电脑,自己消化,直到理解。正是自己对知识渴求的欲望和缺乏专业知识带来的恐慌,一直鞭策着我,风风雨雨走过了这一年。值得欣慰的是,这一年,我通过向别人学习和自己的努力,学到了不少东西,积累了一些经验,有时候也可以独立完成一些工作。下面我就自己这一年来的工作做个总结: 1、学会了做标准的568B网线,学会了做2M线。知道了网线的线序,知道了2M线的用途。 2、认识了光纤和ODF架,知道了法兰盘子,知道了如何用光纤连接法兰盘子。 3、学会了如何使用光源和光功。知道了它们各自的功能和所显示的数值所代表意义。 4、知道了如何使用OTDR去打光纤的全程长度,熟悉了如何用OTDR测试新融光纤的质量,如何查故障点、测衰耗。

5、学会使用了熔接机。了解了熔接机的结构,知道了如何区分单模熔接机和多模熔接机。 6、学会了如何在几个基站之间进行跳纤。并在同事的协助下为广电跳通了2条有线电视专线。 7、对SDH有了一定的了解,并且知道了常用的OI2D和OI4D光口板和一些以太网板。知道了如何从型号上来辨别板子的类型。 8、学会了如何去基站更换板块以及该注意的一些事项。 9、协助资产盘查。对基站的各个设备有了进一步的了解,并且熟悉了好多基站的地理位置,为以后的维护打号了基础。 10、参与并协助完成相关割接。 11、管理应急库房。为日常的维护工作和割接等提供保障。这些或许对于别人,不算什么。但是对于我来说,这就是成绩,是对自己的鼓励。随着我对工作的深入了解,我越来越发现我有很多的知识点没有弄懂,正应了这句话:知道的越多,不知道的就越多。对于处于学习阶段的我来说,不断的积累工作经验、提高自身工作能力是首要任务。所以,我在以后的工作中会更加认真仔细的对待工作中的每个环节,争取把工作做的更好、更熟练。同时,我也会更加的努力去学习新的知识点,巩固以前的知识,争取让自己的技术达标,能够独立承担工作,为公司的发展奉献自己的力量。 参考运维部年终工作总结 (二) 时间飞逝,20xx年即刻岁末。这一年对我来讲可谓是人生中的又一个起点和转折。它发生了太多太多的事,有些事将会影响我的一生。那些工作中的点点滴滴仍历历在目,有过欢笑也有过惆怅、有过激情满怀也有过意志消沉。但总的来说,这一年是我人生中不平凡、

vmware vsphere 6.7虚拟化配置手册

Vmware虚拟化完整配置VSPHERE 6.7虚拟化搭建及配置 kenny

目录 一、安装环境介绍 (3) 二、安装与配置vmware vsphere 6.7 (4) 1、安装vsphere 6.7 (4) 2、配置密码 (4) 3、配置DNS、主机名和IP地址 (5) 三、配置Starwind V8 (7) 四、安装vcenter server 6.7 (10) 1、安装vcenter server(自带嵌入式数据库) (10) 2、配置外部数据库SQL SERVER 2008 (15) 3、使用外部数据库安装Vcenter server (19) 五、创建数据中心和群集HA (24) 1、新建数据中心 (24) 2、创建群集HA (24) 六、添加ESXI主机和配置存储、网络 (26) 1、添加ESXI主机到群集中 (26) 2、配置存储 (28) 3、添加网络 (30) 七、创建虚拟机 (32) 1、上传镜像至共享存储 (32) 2、新建虚拟机 (33) 3、将虚拟机克隆为模板 (37) 4、通过模板部署新虚拟机 (39) 八、物理机迁移至ESXI(P2V) (44) 1、迁移windows物理机 (44) 2、迁移Linux物理机 (49) 九、vmotion迁移测试 (51) 十、HA高可用测试 (53) 十一、VMware vSphere FT双机热备 (54) 十二、vSphere Data Protection配置部署 (57)

1、部署VDP模板 (57) 2、配置VDP (62) 3、创建备份作业 (68) 十三、附录 (72)

vmwareESXI安装教程虚拟化部署

vmware-ESXI.安装教程虚拟化部署

————————————————————————————————作者:————————————————————————————————日期:

vmware ESXI6.5安装教程 (1)ESXi 6.0和6.5至少需要4GB的内存才能安装启动vmware workstation上也是。从安装来说,VMware ESXi 6与5.x相差不大,分配2个CPU、4GB内存即可。但ESXi 5.x的版本在安装之后,可以在只有2GB内存的情况下启动并进入ESXi系统,而ESXi 6.x如果只有2GB则不能进入ESXi的控制台界面。 (2)传统的vSphere Client 6可以修改硬件版本为9、10、11的虚拟机的配置。而在以前的VMware ESXi 5.5的时候,vSphere Client 5.5的客户端,只能修改硬件版本为8及其以下的虚拟机的配置,如果你“一不小心”将虚拟机硬件版本升级到9或10,那么vSphere Client只能启动、关闭高版本的虚拟机,不能修改虚拟机的配置(例如内存、CPU、硬盘等),只能用vSphere Web Client修改,但vSphere Web Client是需要vCenter Server的。从技术来看,用vSphere Client修改虚拟机的配置应该没有什么“复杂之处”,估计是VMware为了推行vSphere Web Client吧。 (3)vSphere Client 6能直接修改高硬件版本的虚拟机的配置。 (4)虚拟机容错支持最多4个CPU,这足以满足大多数的需求。 开始安装 下载esxi.6.5 可以在5分享镜像—》虚拟机下载,然后刻盘或是写入U盘,写入操作可以搜索文档--iso写入U盘,然后启动安装。 第一个

VMwarevSphere管理员手册指南

VMwarevSphere 管理员手册 VMware

目录 1.概述 (4) 1.1目标读者 (4) 1.2VMware vSphere 组件 (4) 2.vSphere 平台管理环境配置 .............................. 错误!未定义书签。 2.1vSphere 平台配置信息.............................................................................. 错误!未定义书签。 2.2VMFS配置信息 ........................................................................................ 错误!未定义书签。 3.ESX配置管理 (6) 3.1ESXI主机配置管理 (6) 3.1.1用vSphere Client 登录到ESXI主机 (6) 3.1.2查看处理器信息 (8) 3.1.3添加存储 (9) 3.1.4配置网络 (9) 3.2许可证管理 (9) 3.2.1添加许可证/更换到VMware Center (9) 3.2.2为 ESXI主机分配许可证密钥 (11) 3.3配置/更改ESXI主机为NTP客户端 (12) 3.3.1DNS和路由配置 (14) 3.3.2配置管理验证服务 (16) 3.4集群配置管理 (17) 3.5网络配置管理 (23) 3.5.1网络配置 (23) 3.5.2添加虚拟交换机 (23) 3.5.3添加端口组 (25) 3.5.4添加上行链路适配器 (27) 3.5.5更改 vSwitch 的端口数 (28) 3.5.6编辑虚拟交换机的安全策略 (30) 3.5.7编辑虚拟交换机的故障切换和负载平衡策略 (32)

软件运维XX年工作总结和XX年工作计划

软件运维XX年工作总结和XX年工作计 划 篇一:运维部XX年终工作总结及XX年工作计划[1] 古交分公司运维部 XX年工作总结及XX年工作计划 XX年运维部在分公司直接领导下及全体部门员工的勤奋努力下,顺利完成网络维护、网络建设、网络安全等任务,有力的保证了古交数字电视及互动业务发展,全年来的工作总结和XX年计划如下: 一、网络维护及建设 1,城农网维护建设 1)、在分公司的正确领导及相关部门的大力支持下,运维部全体人员的勤奋工作。城农网维护截止12月份,运维部共处理用户故障电话报修次,安装普通用户户,搬迁用户户,开通副机用户户,安装互动用户户,以旧换新户,互动副机户,提高了网络覆盖量,更有力的提升了市场竞争力。 2),完成网络新建工程立项项,实施项等几个光节点网络覆盖面积,促进了业务发展和业务收入的增加。

2,网络优化建设 在分公司领导亲自带领下,全年对全市所辖网络进行了数字互动电视整体转换前的规划与设计。为XX年全面开展互动业务打下一个坚实的基础。对已开通互动业务的小区,加大了维修力度,并对局部不符合条件的小区进行了小范围的局部改造,使其具备开通互动业务的技术条件。通过走访互动用户,普遍反映收视效果良好。 二、机房维护及消防安全工作 1、在分公司分管领导的指导下制定了《机房值班制度》及《机房维护及消防制度》,根据制度明确了机房值班人员,建立和完善各项维护制度和加强机房资料及文档的管理,机房设备检修清扫,做好“三防”工作,确保设备正常运行,保证信号安全传输。 2、积极配合总公司和机房对纤、跳线等工作。对机房进行不定期检查,遇到安全隐患及时排除并上报,遇到节假日和重要传输时期,都做好了安全上报等工作。 3、不定期对机房的消防工作进行安全检查,就一些存在的问题进行了及时整改,消除了存在的安全隐患。 三、加强技术培训,提高队伍素质 运维部承担分公司运维和工程建设的主要队伍,面对

vmwarevsphere6.7虚拟化配置手册

Vmware 虚拟化完整配置VSPHERE 6.7虚拟化搭建及配置 kenny

目录 一、安装环境介绍 (3) 二、安装与配置vmware vsphere 6.7 (4) 1、安装 vsphere 6.7 (4) 2、配置密码 (4) 3、配置 DNS、主机名和 IP 地址 (5) 三、配置 Starwind V8 (6) 四、安装 vcenter server 6.7 (9) 1、安装 vcenter server( 自带嵌入式数据库) (9) 2、配置外部数据库SQL SERVER 2008 (14) 3、使用外部数据库安装Vcenter server (17) 五、创建数据中心和群集HA (21) 1、新建数据中心 (21) 2、创建群集 HA (21) 六、添加 ESXI主机和配置存储、网络 (23) 1、添加 ESXI主机到群集中 (23) 2、配置存储 (24) 3、添加网络 (26) 七、创建虚拟机 (28) 1、上传镜像至共享存储 (28) 2、新建虚拟机 (29) 3、将虚拟机克隆为模板 (33) 4、通过模板部署新虚拟机 (35) 八、物理机迁移至ESXI( P2V) (40) 1、迁移 windows 物理机 (40) 2、迁移 Linux 物理机 (45) 九、 vmotion 迁移测试 (47) 十、 HA 高可用测试 (49) 十一、 VMware vSphere FT 双机热备 (50) 十二、 vSphere Data Protection 配置部署 (52) 1、部署 VDP模板 (52)

2、配置 VDP (57) 3、创建备份作业 (63) 十三、附录 (68)

VMwarevSphere日常操作手册

VMware-vSphere日常操作手册

————————————————————————————————作者:————————————————————————————————日期:

虚拟化操作手册2018年1月23日

目录 一、vsphere虚拟化管理 (5) 1)虚拟化组成及介绍 5 2) ................................................................................................................................... ESXi 5 3)登录vcenter 11 4)新建虚拟机 12 5)虚拟机的开启、安装操作系统和关闭 25 6)安装VMTOOLS 29 7)更改虚拟机CPU和内存配置 30 8)增加虚拟机硬盘 34 9)虚拟机增加网卡 40 10)新建portgroup 44 11)虚拟机在ESXI主机间迁移 47 12)虚拟机在存储LUN间迁移 50 13)克隆虚拟机 52 14)倒换成模板 55 15)模板倒换成虚拟机 58 16)删除虚拟机 61 17)对ESXi的物理主机关机维护操作 62 三、P2V转换 (64) 1)安装Converter Server 64 2)登录Converter Server client 66 3)Linux P2V

66 4)Windows P2V 72 一、vsphere虚拟化管理 1)虚拟化组成及介绍 Vsphere 包括vcenter和ESXI主机组成. 虚拟机运行在ESXI主机上。 ESXI系统安装在物理服务器上。 Venter是虚拟化的管理平台,它安装在一台虚拟机上。 2)ESXi 连接服务器,或者从HP服务器的iLo管理界面中,登录ESXi界面。 如果不是hp服务器可以用管理界面进行管理。或者直接到机房的物理服务器前进行如下操作

运维部年终工作总结报告

运维部年终工作总结 想要写好一份年终工作总结并不简单,运维部员工的年终工作总结要如何写好?下面是由小编为你精心编辑的运维部年终工作总结,欢迎阅读! 运维部年终工作总结篇一: 去年的年末,我来到了运维部。这是一个技术岗位,刚来的我,对于我的工作可以说是相当的陌生。大多数仪器、设备都不认识,不像书本上讲的那些。它们对于我来说都是新的,需要学习来完成工作。我对我的工作充满了热情,如饥似渴的去学习书籍,请教同事,慢慢的汲取知识和经验。刚开始,每一次出去解决故障,我都有点担心,怕工作做不好,所以每一次,我都认真向前辈们学习,看他们如何去操作仪器,如何去分析故障点,不懂的我就问为什么。 还有不懂的,我就回来查电脑,自己消化,直到理解。正是自己对知识渴求的欲望和缺乏专业知识带来的恐慌,一直鞭策着我,风风雨雨走过了这一年。值得欣慰的是,这一年,我通过向别人学习和自己的努力,学到了不少东西,积累了一些经验,有时候也可以独立完成一些工作。下面我就自己这一年来的工作做个总结: 1、学会了做标准的568B网线,学会了做2M线。知道了网线的线序,知道了2M线的用途。 2、认识了光纤和ODF架,知道了法兰盘子,知道了如何用光纤连接法兰盘子。 3、学会了如何使用光源和光功。知道了它们各自的功能和所显示的数值所代表意义。 4、知道了如何使用OTDR去打光纤的全程长度,熟悉了如何用OTDR测试新融光纤的质量,如何查故障点、测衰耗。

5、学会使用了熔接机。了解了熔接机的结构,知道了如何区分单模熔接机和多模熔接机。 6、学会了如何在几个基站之间进行跳纤。并在同事的协助下为广电跳通了2条有线电视专线。 7、对SDH有了一定的了解,并且知道了常用的OI2D和OI4D光口板和一些以太网板。知道了如何从型号上来辨别板子的类型。 8、学会了如何去基站更换板块以及该注意的一些事项。 9、协助资产盘查。对基站的各个设备有了进一步的了解,并且熟悉了好多基站的地理位置,为以后的维护打号了基础。 10、参与并协助完成相关割接。 11、管理应急库房。为日常的维护工作和割接等提供保障。这些或许对于别人,不算什么。但是对于我来说,这就是成绩,是对自己的鼓励。随着我对工作的深入了解,我越来越发现我有很多的知识点没有弄懂,正应了这句话:知道的越多,不知道的就越多。对于处于学习阶段的我来说,不断的积累工作经验、提高自身工作能力是首要任务。所以,我在以后的工作中会更加认真仔细的对待工作中的每个环节,争取把工作做的更好、更熟练。同时,我也会更加的努力去学习新的知识点,巩固以前的知识,争取让自己的技术达标,能够独立承担工作,为公司的发展奉献自己的力量。 运维部年终工作总结篇二: 时间飞逝,20xx年即刻岁末。这一年对我来讲可谓是人生中的又一个起点和转折。它发生了太多太多的事,有些事将会影响我的一生。那些工作中的点点滴滴仍历历在目,有过欢笑也有过惆怅、有过激情满怀也有过意志消沉。但总的来说,这一年是我人生中不平凡、平庸的一年;我努力过、失落过、成功过,期盼过,当然也挫折过;每一个成功的喜悦,每一个困难面前的艰辛,在我

Vmware vSphere常见问题汇总

VmwarevSphere常见问题汇总 1、启用客户机操作系统和远程控制台之间的复制和粘贴操作 解决方法:要在客户机操作系统和远程控制台之间进行复制和粘贴,必须使 用 vSphere Client 启用复制和粘贴操作。 步骤 a、使用 vSphere Client 登录到 vCenter Server 系统并选择虚拟机。 b、在摘要选项卡中,单击编辑设置。 c、选择选项 > 高级 > 常规,然后单击配置参数。 d、单击添加行,并在“名称”和“值”列中键入以下值。 名称值 isolation.tools.copy.disable false isolation.tools.paste.disable false 注意这些选项将替代在客户机操作系统的 VMware Tools 控制面板中做出的任何设置。 e、单击确定以关闭“配置参数”对话框,然后再次单击确定以关闭“虚拟机属性”对话框。 f、重新启动虚拟机。 2、sco系统迁移过去之后找不到启动列表 解决方法:目前解决方法:使用软驱制作应急盘,通过应急盘来找到启动列表,如果不行的话,只能使用,现成的虚拟镜像导入vmware中,但是这种方法,要自己设置与自己相关的应用。 3、linux做迁移时手动添加的逻辑分区(LVM卷),迁移过去之后找不到这些分区 解决方法::给虚拟机额外添加硬盘后融合,然后将数据重新拷入加入的硬盘中。 4、安装esxi的时候找不到万兆网卡 解决方法:解决方法:安装各个厂商OEM的esxi版本。 5、迁移时提示vss原卷不能克隆

解决方法:解决方法:查看是否有额外的设备插在服务器上,如usb设备。 6、Windows迁移之后,配置网卡的时候,会提示“IP已经被分配给其他的适配器” 解决方法:打开命令行窗口(运行cmd),输入: (1)、set DEVMGR_SHOW_NONPRESENT_DEVICES=1 (2)、devmgmt.msc 在弹出的“设备管理器”窗口。选择“查看(V)”---“显示隐藏的设备(W)”,然后展开“网络适配器”子项,可以看到一些透明图标显示的网卡信息,这些信息是源服务器的物理网卡信息。然后选择透明的设备卸载,RAS同步适配器为系统正常设备,不需要将其卸载。 7、Asianux3.0迁移之后不能显示图形化界面 解决方法:解决方法:cp /etc/X11/xorg.conf /etc/X11/xorg.conf.bak vi /etc/X11/xorg.conf 将xorg.conf文件中的selection “Devices”字段中Driver对应的值修改为“vmware”即可,修改完成后通过startx启动图形化界面。 8、迁移域控主机后发生当虚拟机开启后,物理机就断网 解决方法:单播和多播的问题 9、在VC中虚拟机的鼠标全屏之后,不能控制整个屏幕 解决方法:当时安装的是esxi 4.1,将esxi4.1升级到esxi4.1upd01 ,同时要将VC client也升级到对应的版本。 10、迁移过去的win2003的系统,隔段时间之后会蓝屏或重启 解决方法:查看系统日志,有可能是杀毒软件的原因,将杀毒软件卸载重装。 11、使用FT功能需同时具备以下条件 解决方法:1 所有ESX必须为4.0以上,Build版本相同,以及在同一个HA Cluster中 2 服务器的CPU要求是同一系列(并且要求是AMD Barcelona+, Intel Penryn+的CPU) 3 BIOS中要启用VT及禁用Hyperthreading(超线程),最好同时禁用电源管理 4 每个VM只能分配1颗vCPU 5 要有专门的千兆网络负责FT

vmware vsphere 6.7虚拟化完整祥细配置手册

Vmware服务器虚拟化完整配置 VSPHERE 6.7虚拟化搭建及配置 Simon

目录 一、安装环境介绍 (3) 二、安装与配置vmware vsphere 6.7 (4) 1、安装vsphere 6.7 (4) 2、配置密码 (4) 3、配置DNS、主机名和IP地址 (5) 三、配置Starwind V8虚拟存储 (6) 四、使用windows 2012R2创建ISCSI存储 (9) 1、添加角色和功能 (9) 2、配置ISCSI链接 (10) 五、安装vcenter server 6.7 for windows (17) 1、安装vcenter server(自带嵌入式数据库) (17) 2、配置外部数据库SQL SERVER 2008 (22) 3、使用外部数据库安装Vcenter server (25) 六、安装Vcenter Server 6.7 for linux (29) 1、安装Linux版本的Vcenter (29) 七、创建数据中心和群集HA (42) 1、新建数据中心 (42) 2、创建群集HA (42) 八、添加ESXI主机和配置存储、网络 (44) 1、添加ESXI主机到群集中 (44) 2、配置存储 (45) 3、添加网络 (47) 九、创建虚拟机 (49) 1、上传镜像至共享存储 (49) 2、新建虚拟机 (49) 3、将虚拟机克隆为模板 (53) 4、通过模板部署新虚拟机 (55) 十、物理机迁移至ESXI(P2V) (60) 1、迁移windows物理机 (60) 2、迁移Linux物理机 (65)

3、使用Acronis BR迁移linux物理机 (66) 十一、vmotion迁移测试 (81) 十二、HA高可用测试 (83) 十三、VMware vSphere FT双机热备 (84) 十四、vSphere Data Protection配置部署 (86) 1、部署VDP模板 (86) 2、配置VDP (90) 3、创建备份作业 (96) 十五、部署vRealize Operations Manager (101) 1、部署ova模版 (101) 2、配置vRealize Operations Manager (104) 十六、部署VMware-vRealize-Log-Insight (110) 1、部署OVF模版 (110) 十七、附录 (117)

工程运维部 2017年度工作总结及2018年度工作计划

2017年度工作总结及2018年度工作计划 时光荏苒,2017年工程运维部的工作已接近尾声,并取得了明显的进步和突破,最大限度保证了各科室基础设施设计、整改、维护等方面的进度和质量,对于医院现投入使用的基础设施保证了其在“良好、稳定、安全”的状态下运行,锅炉房、食堂拆迁重建工作在规定时间内保质保量完成。纵观全年工作,工程运维部一方面表现在认真落实了工作部署中的各项工作,努力实现了最大限度的满足各个科室的需要,也组建成了一只高效维修团队的年度目标;另一方面表现在工作思维上的巨大转变,2017年北京双优装饰工程有限公司各工程、设备设施基本竣工且验证完毕,在此过程中,我们遇到了许多困难,在后勤保障科王旭科长的领导下,医院感染科、内科、保障保健科及各部门大力支持和配合下,最终圆满完成了工作任务。现将2017年年度工作总结如下: 一、全年工作回顾: 1、结构性维修工程——食堂、锅炉房拆除及重建 随着中关村医院三期工程规划与发展进程的不断加快,原本老旧的食堂及锅炉房一定程度上阻碍了医院的发展,经院领导协商决定,食堂及锅炉房的拆除重建工作交于工程运维部门负责。首期拆除内科楼门斗,防止在拆除锅炉房和食堂时,造成信息科的电缆出现问题,从而防止全院信息系统瘫痪,完成信息科电缆铺设;其次拆除食堂、锅炉房顶部太阳能,为后期的工作打好

基础;考虑到要保护医患人员安全,防止灰尘及建筑零件影响内科楼病人就诊,相继完成内科楼门厅改造;经仔细勘察现场,运用图纸和技术人员制定详细完善的施工方案,在固定时间内完成拆除锅炉房及食堂的重大工程。拆除后为了尽早恢复投入使用,我部门加班加点及时恢复路面,努力做好保健科的顺畅就诊,锅炉房、食堂、内科楼通道地面及时恢复,保障保健科就医通道的顺畅及安全。此次工程实施中我们不断强化技术管理,不断推进技术革新,我们建立了相应的规章制度,狠抓图纸会审、施工方案和施工技术交底等前期准备工作,严格按照“三工序”组织施工,施工中不断优化施工方案,积极开展合理化建议活动,充分考虑新技术、新工艺的推广应用。今年我部结合往年的工作经验和工作难点,将安全事故预防放在工作的首位,提高员工安全意识,创新安全文化,不断提升安全生产管理水平,全程安全无事故,保质保量完成任务,为我院后继三期工程顺利开展做好充足准备。 施工图施工图施工图 2、各科室改造工程