分布式存储参数

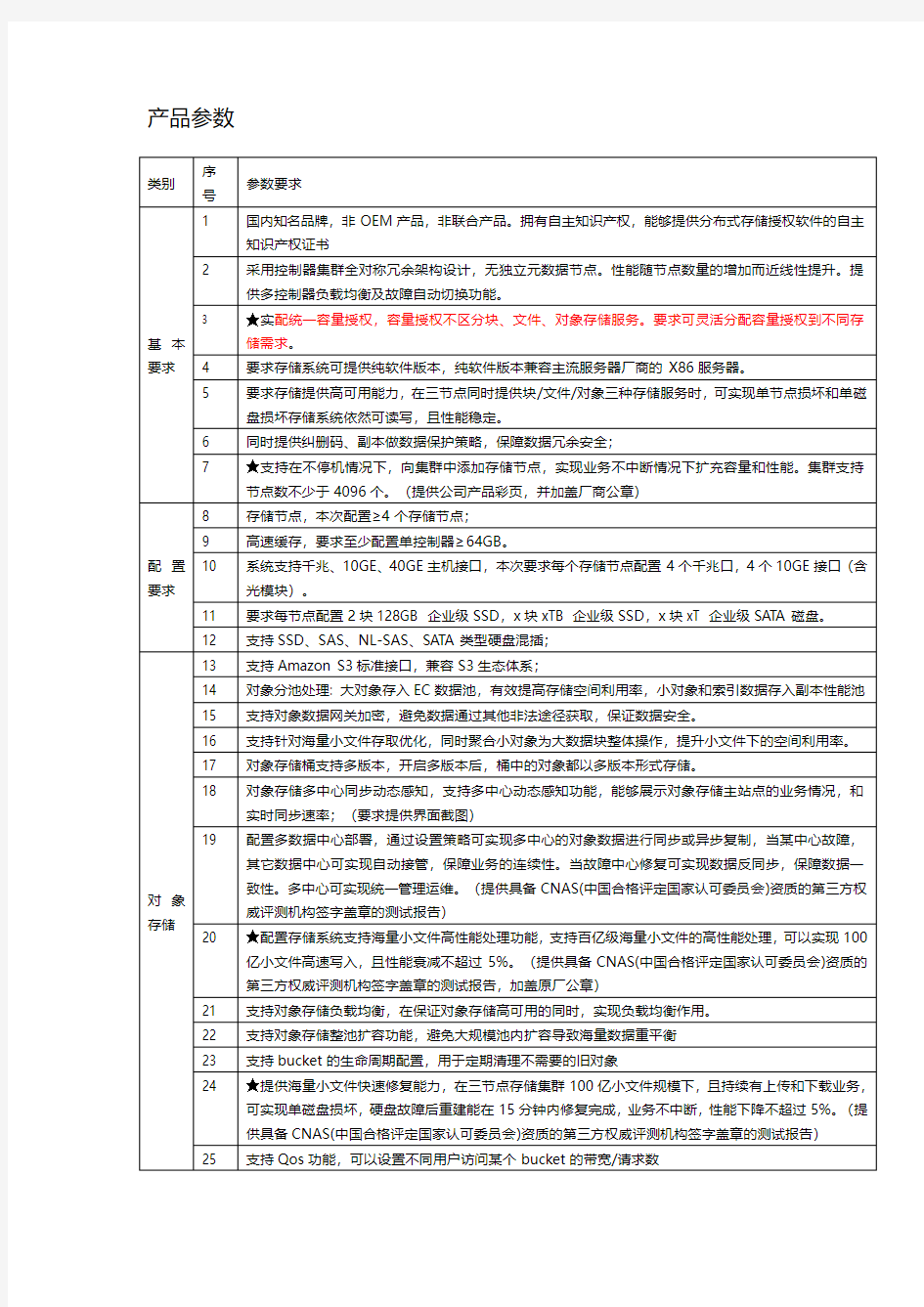

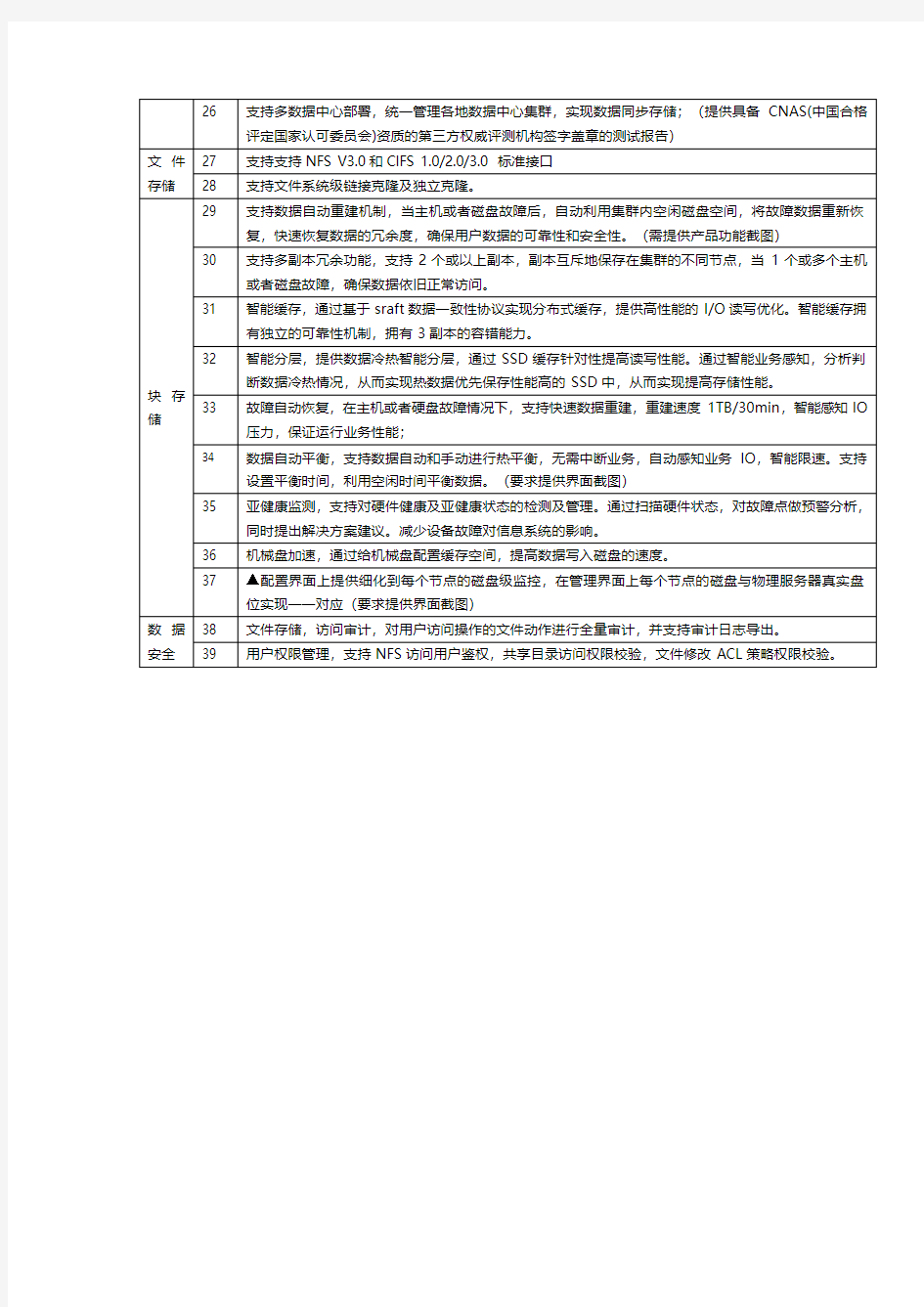

产品参数

中电55寸LED电视一体机控标参数

55寸LED电视一体机控标参数 中电L55 A、显示器参数 1.55寸LED电视一体机(含电子白板,原厂一体成型非外挂框); 2.显示尺寸:≥55英寸; 3.显示技术: LED背光源; 4.显示比例:16:9 ; 5.可视角度:≥178° 6.最佳分辨率:1920×1080 RGB; 7.亮度:≥450nits; 8.对比度:6000:1; 9.视频制式: PAL/NTSC; 10.★输入端口:TV 1路;★VGA带音频 3路(可同时接驳计算机、视频展台、携带的笔 记本电脑等); CVBS 2路; S-VIDEO 1路; YPbPr/YcbCr 1路; HDMI 2路; USB2路(支持USB无电脑播放图片及音视频文件,支持文件格式:JPG,BMP,MPEG1、2、3、4,RMVB,MP3等);RS232 1路; 11.输出端口:VGA 1路;CVBS 1路;耳机 1路; 12.通讯端口:USB 1路; 13.内置音箱2×15W扬声器; 14.电源:AC90-264V 50/60 Hz; 15.整机功耗≤150 W,待机功耗≤1 W; 16.显示屏寿命不低于50000小时 17.书写屏采用4mm厚防爆全钢化玻璃屏,防划防撞; 18.开机画面可用户自定义,具备童锁功能; 19.★通道模式自动记忆功能; 20.RS232远程通信连接数据终端,为远程控制带来了极大的便利。支持红外线遥控,支持 电视信号接收功能;

21.★外观结构:全金属外框结构,表面无尖锐或突起,美观安全;后壳为百叶窗设计,有 效防尘及通风散热,延长机器使用寿命; B、触摸屏参数 1.采用非接触式红外(两点或单点)触控技术 2.安装方式:内置一体式,非外挂框; 3.书写方式:手指或笔触摸 4.连续响应时间≤5毫秒 5.触摸有效识别≥5毫米 6.定位精度:±0.5mm 7.全屏坐标定位非线性误差:≤1% 8.红外触摸屏系统通讯端口:USB或RS232 9.支持Windows XP、Windows VISTA、Win7 10.触摸次数:同一位置6000万次以上 C、电子白板交互软件 1.★专业电子白板教学软件,可同时用两支笔在屏幕上书写,且互不干扰影响; 2.具有多种白板书写模式选择,可自定义各种书写背景颜色及选择背景图案; 3.具有彩虹笔、硬笔、毛笔等、荧光笔、艺术笔等多种书写输入功能,输入时能够控制笔 划粗细和颜色,输入内容能任意放大、缩小及移动; 4.可全屏书写和标注,书写内容局部或全屏放大、缩小、旋转、组合效果等,并可实现任 意擦除、区域擦除、对象擦除及全部擦除;实现各种图文资源的导入、打开、截取、放大、缩小,旋转、组合等;取代鼠标、屏幕书写标注; 5.具有强大的教学辅助工具,比如聚光灯、拉幕工具、黑屏工具、截屏工具、放大镜、视 频录播、量角器、直尺、三角尺、页面播放等等,并可在幕布上批注,支持板中板功能; 6.强大的几何图形工具:可绘制各种线体(直线、虚线等),并可插入圆形、矩形、椭圆 形、三角形、多边形、立体图形等实用图形;可按规定半径的画圆,弧线和扇形,按定义设计饼状和柱状分析图,插入曲线图、随机定义函数图等;智能识别所画的三角形、矩形、圆、箭头、多边形等为规则的图形;

分布式存储系统的一些理解和实践

分布式存储系统的一些理解和实践 张建伟 一、分布式存储系统介绍 1.简介 互联网数据规模越来越大,并发请求越来越高,传统的关系数据库,在很多使用场景下并不能很好的满足需求。分布式存储系统应运而生。它有良好的扩展性,弱化关系数据模型,甚至弱化一致性要求,以得到高并发和高性能。按功能分类,主要有以下几种: ?分布式文件系统 hdfs ceph glusterfs tfs ?分布式对象存储 s3(dynamo) ceph bcs(mola) ?分布式表格存储 hbase cassandra oceanbase ?块存储 ceph ebs(amazon) 分布式存储系统,包括分布式系统和单机存储两部分;不同的系统,虽在功能支持、实现机制、实现语言等方面是有差异的,但其设计时,关注的关键问题是基本相同的。单机存储的主流实现方式,有hash引擎、B+树引擎和LSM树(Log Structured Merge Tree)三种,不展开介绍。本文第二章节,主要结合hbase、cassandra和ceph,讲下分布式系统设计部分,需要关注的关键问题。 2.适用场景 各分布式存储系统功能定位不尽相同,但其适用和不适用的场景,在一定程度上是相同的,如下。

1)适用 大数据量(大于100T,乃至几十PB) key/value或者半结构化数据 高吞吐 高性能 高扩展 2)不适用 Sql查询 复杂查询,如联表查询 复杂事务 二、分布式存储系统设计要点 1.数据分布 分布式存储,可以由成千甚至上万台机器组成,以实现海量数据存储和高并发。那它最先要解决的就是数据分布问题,即哪些数据存储在哪些机器(节点)上。常用的有hash类算法和用meta表映射两种方式。一般完全分布式的设计(无master节点),会用hash类算法;而集中式的设计(有master节点)用meta表映射的方式。两者各有优缺点,后面讲到具体问题时再做比较。 1)一致性hash 将存储节点和操作的key(key唯一标识存储的object,有时也叫object name)都hash到0~2的32次方区间。映射到如下环中的某个位置。沿操作key的位置顺时针找到的第一个节点即为此key的primary存储节点。如下图所示:

ceph分布式存储介绍

Ceph分布式存储 1Ceph存储概述 Ceph 最初是一项关于存储系统的PhD 研究项目,由Sage Weil 在University of California, Santa Cruz(UCSC)实施。 Ceph 是开源分布式存储,也是主线Linux 内核(2.6.34)的一部分。1.1Ceph 架构 Ceph 生态系统可以大致划分为四部分(见图1):客户端(数据用户),元数据服务器(缓存和同步分布式元数据),一个对象存储集群(将数据和元数据作为对象存储,执行其他关键职能),以及最后的集群监视器(执行监视功能)。 图1 Ceph 生态系统 如图1 所示,客户使用元数据服务器,执行元数据操作(来确定数据位置)。元数据服务器管理数据位置,以及在何处存储新数据。值得注意的是,元数据存储在一个存储集群(标为―元数据I/O‖)。实际的文件I/O 发生在客户和对象存储集群之间。这样一来,更高层次的POSIX 功能(例如,打开、关闭、重命名)就由元数据服务器管理,不过POSIX 功能(例如读和

写)则直接由对象存储集群管理。 另一个架构视图由图2 提供。一系列服务器通过一个客户界面访问Ceph 生态系统,这就明白了元数据服务器和对象级存储器之间的关系。分布式存储系统可以在一些层中查看,包括一个存储设备的格式(Extent and B-tree-based Object File System [EBOFS] 或者一个备选),还有一个设计用于管理数据复制,故障检测,恢复,以及随后的数据迁移的覆盖管理层,叫做Reliable Autonomic Distributed Object Storage(RADOS)。最后,监视器用于识别组件故障,包括随后的通知。 图2 ceph架构视图 1.2Ceph 组件 了解了Ceph 的概念架构之后,您可以挖掘到另一个层次,了解在Ceph 中实现的主要组件。Ceph 和传统的文件系统之间的重要差异之一就是,它将智能都用在了生态环境而不是文件系统本身。 图3 显示了一个简单的Ceph 生态系统。Ceph Client 是Ceph 文件系统的用户。Ceph Metadata Daemon 提供了元数据服务器,而Ceph Object Storage Daemon 提供了实际存储(对数据和元数据两者)。最后,Ceph Monitor 提供了集群管理。要注意的是,Ceph 客户,对象存储端点,元数据服务器(根据文件系统的容量)可以有许多,而且至少有一对冗余的监视器。那么,这个文件系统是如何分布的呢?

项目服务投标文件方案(分布式存储平台建设方案)

分布式存储平台建设方案 1.分布式存储平台简介 Hadoop的目的是基于一种新的方法来存储和处理复杂的数据。通过把数据均衡分布 到集群上,通过复制副本以确保数据的可靠性和容错。存储和计算都分布到多个机器, 充分体现数据的本地性,现在的很多数据库也都支持数据分片技术, Hadoop可以运行在低配置的Pc Server服务器上面的分布式集群技术,通过把海量数据分布式存储后,通过分布式计算模型来进行海量数据分析。 优势明显: - 效率提高 - 弹性扩容 - 弹性计算 2.分布式存储的趋势 ?Data Scalability: 单台机器的容量不足以(经济的) 承载所有资料,所以需要分散。如:NoSQL ?Computing Scalability: 单台机器的运算能力不足以(经济的) 及时完成运算所以需要分散。 3.分布式存储平台搭建 分布式数据处理框架为用户提供容易使用的并行编程模式、处理海量数据的处理框架,用于对大规模数据集的并行处理。处理能力可以通过增加或减少机器达到动态调整。分布式数据处理框架采用先进的容错技术,确保处理任务的可靠性,即使在异常情况下,如机器宕机、断网的情况下,确保处理任务的实时性和准确性。

分布式数据处理框架是建立在分布式存储和分布式数据库的基础之上。 分布式数据处理框架具有如下特点: ●在高效率并行分布式软件的支撑下,可以实时完成数据处理和分析工作, 如数据处理、数据查询、和统计分析等。数据处理不会出现数据堆积现 象,各类分析和查询工作基本都在秒级完成,具有前所未有的高效性。 ●响应速度快速:采用分布式处理的方式,性能与节点数成正比,通过增 加节点的方式,可将性能提升,以达到满足需求的处理要求。 ●高可靠性:任何一个节点出现故障,系统将自动屏蔽,而且不会出现丢 失数据的现象。 ●可伸缩性:在不停机的情况下,增加节点,平台的处理能力自动增加; 减少节点,平台的处理能力自动缩减。这样,可以做到与资源池的无缝 对接,根据处理和存储任务动态地申请或释放资源,最大限度地提高资 源利用率。 ●高性价比:采用X86架构廉价处理机构建云处理平台,用软件容错替代 硬件容错,大大节省成本。在目标性能和可靠性条件下,可比传统的小 型机加商用数据库方案节省10倍左右的成本。 4.分布式存储平台同步 大数据基础平台的数据库服务包括传统的关系型数据库服务和分布式数据库。 分布式数据库系统使用计算机网络将物理位置分散而管理和控制又需要不同程度集中的多个逻辑单位(通常是集中式数据库系统)连接起来,共同组成一个统一的数据库系统,因此,分布式数据库系统可以看成是计算机网络与数据库系统的有机结合。 分布式数据库具有如下特点: 1、物理分布性:分布式数据库系统中的数据不是存储在一个站点上,而是分散存储在由计算机网络联结起来的多个站点上。 2、逻辑整体性:分布式数据库系统中的数据物理上是分散在各个站点中的,

分布式文件存储方案

1DFS系统 (DFS) 是AFS的一个版本,作为开放软件基金会(OSF)的分布 分布式文件系统 式计算环境(DCE)中的文件系统部分。 如果文件的访问仅限于一个用户,那么分布式文件系统就很容易实现。可惜的是,在许多网络环境中这种限制是不现实的,必须采取并发控制来实现文件的多用户访问,表现为如下几个形式: 只读共享任何客户机只能访问文件,而不能修改它,这实现起来很简单。 受控写操作采用这种方法,可有多个用户打开一个文件,但只有一个用户进行写修改。而该用户所作的修改并不一定出现在其它已打开此文件的用户的屏幕上。 并发写操作这种方法允许多个用户同时读写一个文件。但这需要操作系统作大量的监控工作以防止文件重写,并保证用户能够看到最新信息。这种方法即使实现得很好,许多环境中的处理要求和网络通信量也可能使它变得不可接受。 NFS和AFS的区别 NFS和AFS的区别在于对并发写操作的处理方法上。当一个客户机向服务器请求一个文件(或数据库记录),文件被放在客户工作站的高速缓存中,若另一个用户也请求同一文件,则它也会被放入那个客户工作站的高速缓存中。当两个客户都对文件进行修改时,从技术上而言就存在着该文件的三个版本(每个客户机一个,再加上服务器上的一个)。有两种方法可以在这些版本之间保持同步: 无状态系统在这个系统中,服务器并不保存其客户机正在缓存的文件的信息。因此,客户机必须协同服务器定期检查是否有其他客户改变了自己正在缓存的文件。这种方法在大的环境中会产生额外的LAN通信开销,但对小型LAN来说,这是一种令人满意的方法。NFS 就是个无状态系统。 回呼(Callback)系统在这种方法中,服务器记录它的那些客户机的所作所为,并保留它们正在缓存的文件信息。服务器在一个客户机改变了一个文件时使用一种叫回叫应答(callbackpromise)的技术通知其它客户机。这种方法减少了大量网络通信。AFS(及OSFDCE的DFS)就是回叫系统。客户机改变文件时,持有这些文件拷贝的其它客户机就被回叫并通知这些改变。 无状态操作在运行性能上有其长处,但AFS通过保证不会被回叫应答充斥也达到了这一点。方法是在一定时间后取消回叫。客户机检查回叫应答中的时间期限以保证回叫应答是当前有效的。回叫应答的另一个有趣的特征是向用户保证了文件的当前有效性。换句话说,若

分布式存储系统设计方案——备份容灾

分布式存储系统设计方案——备份容灾 在分布式存储系统中,系统可用性是最重要的指标之一,需要保证在机器发生故障时,系统可用性不受影响,为了做到这点,数据就需要保存多个副本,并且多个副本要分布在不同的机器上,只要多个副本的数据是一致的,在机器故障引起某些副本失效时,其它副本仍然能提供服务。本文主要介绍数据备份的方式,以及如何保证多个数据副本的一致性,在系统出现机器或网络故障时,如何保持系统的高可用性。 数据备份 数据备份是指存储数据的多个副本,备份方式可以分为热备和冷备,热备是指直接提供服务的备副本,或者在主副本失效时能立即提供服务的备副本,冷备是用于恢复数据的副本,一般通过Dump的方式生成。 数据热备按副本的分布方式可分为同构系统和异步系统。同构系统是把存储节点分成若干组,每组节点存储相同的数据,其中一个主节点,其他为备节点;异构系统是把数据划分成很多分片,每个分片的多个副本分布在不同的存储节点,存储节点之间是异构的,即每个节点存储的数据分片集合都不相同。在同构系统中,只有主节点提供写服务,备节点只提供读服务,每个主节点的备节点数可以不一样,这样在部署上会有更大的灵活性。在异构系统中,所有节点都是可以提供写服务的,并且在某个节点发生故障时,会有多个节点参与故障节点的数据恢复,但这种方式需要比较多的元数据来确定各个分片的主副本所在的节点,数据同步机制也会比较复杂。相比较而言,异构系统能提供更好的写性能,但实现比较复杂,而同构系统架构更简单,部署上也更灵活。鉴于互联网大部分业务场景具有写少读多的特性,我们选择了更易于实现的同构系统的设计。 系统数据备份的架构如下图所示,每个节点代表一台物理机器,所有节点按数据分布划分为多个组,每一组的主备节点存储相同的数据,只有主节点能提供写服务,主节点负责把数据变更同步到所有的备节点,所有节点都能提供读服务。主节点上会分布全量的数据,所以主节点的数量决定了系统能存储的数据量,在系统容量不足时,就需要扩容主节点数量。在系统的处理能力上,如果是写能力不足,只能通过扩容主节点数来解决;而在写能力不足时,则可以通过增加备节点来提升。每个主节点拥有的备节点数量可以不一样,这在各个节点的数据热度不一样时特别有用,可以通过给比较热的节点增加更多的备节点实现用更少的资源来提升系统的处理能力。

ONEStor分布式存储系统介绍

ONEStor分布式存储系统介绍 关于ONEStor分布式存储系统介绍,小编已在金信润天Get到了部分资料,整理出以下内容: 技术特点 H3C ONEStor存储系统采用分布式设计,可以运行在通用x86服务器上,在部署该软件时,会把所有服务器的本地硬盘组织成一个虚拟存储资源池,对上层应用提供块存储功能。H3C ONEStor分布式存储软件系统具有如下特点: 领先的分布式架构 H3C ONEStor存储软件的采用全分布式的架构:分布式管理集群,分布式哈希数据分布算法,分布式无状态客户端、分布式Cache等,这种架构为存储系统的可靠性、可用性、自动运维、高性能等方面提供了有力保证。其系统架构组成如下图所示: 上图中,ONEStor逻辑上可分为三部分:OSD、Monitor、Client。在实际部署中,这些逻辑组件可灵活部署,也就是说既可以部署在相同的物理服务器上,也可以根据性能和可靠性等方面的考虑,部署在不同的硬件设备上。下面对每一部分作一简要说明。 OSD:Object-based Storage Device

OSD由系统部分和守护进程(OSD deamon)两部分组成。OSD系统部分可看作安装了操作系统和文件系统的计算机,其硬件部分包括处理器、内存、硬盘以及网卡等。守护进程即运行在内存中的程序。在实际应用中,通常将每块硬盘(SSD或HDD)对应一个OSD,并将其视为OSD的硬盘部分,其余处理器、内存、网卡等在多个OSD之间进行复用。ONEStor存储集群中的用户都保存在这些OSD中。OSD deamon负责完成OSD的所有逻辑功能,包括与monitor 和其他OSD(事实上是其他OSD的deamon)通信以维护更新系统状态,与其他OSD共同完成数据的存储和维护,与client通信完成各种数据对象操作等等。 Monitor: Monitor是集群监控节点。Monitor持有cluster map信息。所谓Cluster Map,粗略的说就是关于集群本身的逻辑状态和存储策略的数据表示。 ONEStor Cluster Map包括Monitor map、osd map、pg map、crush map等,这些map构成了集群的元数据。总之,可以认为Monitor 持有存储集群的一些控制信息,并且这些map信息是轻量级的,只有在集群的物理设备(如主机、硬盘)和存储策略发生变化时map信息才发生改变。 Client: 这里的Client可以看出外部系统获取存储服务的网关设备。client通过与OSD或者Monitor 的交互获取cluster map,然后直接在本地进行计算,得出数据的存储位置后,便直接与对应的OSD通信,完成数据的各种操作。在此过程中,客户端可以不依赖于任何元数据服务器,不进行任何查表操作,便完成数据访问流程。这一点正是ONEStor分布式存储系统可以实现扩展性的重要保证。 客户的数据到达Client后,如何存储到OSD上,其过程大致如下图所示:

Delta控制系统参数

控标参数 1 管理软件 ?系统软件应支持所有BACnet BTL认证之设备,进行免费用无缝集成;接入BMS管理 系统;同时应提供系统软件的BTL认证文件; (1)系统软件可根据后期需要,只需购买API功能,即可实现对外通讯接口的需求,实现OA、手机APP等第三方软件研发所需的信息通讯界面;其技术形式须为REST(或SOAP) web service;(需提供软件选型表或商品说明单页) (2)系统软件可根据后期需要,只需购买能源管理功能,即可实现满足ISO 50001认证的能源管理功能;(需提供软件选型表或商品说明单页); (3)作业记录,跟踪BAS系统的所有变动,并记录操作者; ?作业系统应为B/S(浏览器/服务器)架构,其中进行WEB发布的服务器应全面支持 HTML5,以满足在应急时,可由平板电脑进行操控(平板电脑可以是IOS系统的IPAD 或ANDROID系统的平板电脑) ?系统软件操作界面应全面支持简体汉化,而不应仅是图形界面支持中文; (4)软件为进口品牌;(需提海关报关单) (5)须提供原厂对投标单位开具的【项目投标授权函】; 2 系统级控制器 (1)MAC地址和软件地址、网络编号;可通过跳线形式或软件形式进行调整;不可全面支持更改的设备将不被接受; (2)应至少提供:一个支持BACnet IP通讯的RJ45端口,一个支持BACnet MSTP的RS485端口。 ?控制器不应使用电池数据保持,而应使用FLASH内存进行控制器的失电数据保持,不

支持FLASH内存的控制器将不被接收; (3)须提供原厂对投标单位开具的【项目投标授权函】; 3应用控制器 (1)MAC地址和软件地址、网络编号;可通过跳线形式或软件形式进行调整;不可全面支持更改的设备将不被接受; (2)应至少提供:一个支持BACnet MSTP通讯的RS485端口,一个支持IO扩展通讯的RS485端口。 (3)控制空调设备(含空调机组、新风机组)所使用的控制器输入点位应为通用输入,不接受数字输入点位的DDC。方便现场调试与提高系统灵活性,并且全部支持0-5v, 0-10v,10kΩ, 4-20mA信号;数字输出支持控制器24V内部供电与外部供电两种方式; ?控制器不应使用电池数据保持,而应使用FLASH内存进行控制器的失电数据保持,不 支持FLASH内存的控制器将不被接收; ?控制器应支持系统时间自动同步功能,控制器应能自动同步相同MSTP网络系统控制 器时间,失电再上电后,系统时间不丢失; (4)控制器应提供服务端口,可实现蓝牙通讯扩展,实现与计算机的通讯; (5)须提供原厂对投标单位开具的【项目投标授权函】; 5 扩展模块 (1)总线电源及其他模块电气隔离,提高系统安全性; (2)电源由以太网控制器总线提供; (3)须提供原厂对投标单位开具的【项目投标授权函】; (4)须通过CE认证。 6 RS485 网络保护器

UPS控标参数

大队机房UPS采购 一、UPS主机参数 额定输出:30KVA 技术类型:在线供电静态旁路开关(无间断切换),双重转换技术,输出电源完全隔离。 市电参数: 输入相数:三相+N+G 输入额定电压:380V±20% 频率:50Hz±10% 电池节数:32节 输入电流谐波:50%负载<5%,100%负载<4% 功率因数:大于0.99 软启动:0-100% 5sec 旁路输入: 相数:L+N+G 电压:220V±15% 频率:50Hz±5% 切换时间:0ms 输出参数: 输出项数:L+N+G 输出方式:端子排 稳压度:220V±1% 频率:50Hz±5%(市电)、50Hz±0.05%(电池供电) 输出波形:标准正弦波 总谐波失真:线性负载<3%,非线性负载<5% 动态负载电压瞬变:±5%

瞬间恢复时间:<10ms 过载能力:125%额定负载10min,150%额定负载1min ,>150% 200ms 效率:≥96% 系统参数: 支持机柜式安装,需配套电池柜3套,含电池连接线缆及开关。 电脑通讯接口:RS 232/RS485 噪声:<55db(正前方1m) 显示:采用中/英文触摸式大屏幕LCD显示器 浪涌保护:IEC/EN 62040-2 防护等级:IP20 符合标准:安全EN50091-1,电磁兼容特性 EMC EN 50091-2 Liv.A 使用环境:环境温度,-0℃—+40℃;环境湿度,0%—90%无凝露; 产品要求: 采用触摸屏技术,大屏中文显示,无开关按键,UPS模拟流程显示,操作简单方便快捷。 可提供实时的电池运行状态及电池放电的后备时间; 在放电过程中UPS的放电时间随负载变化自动测量显示; 在电池检测时,对每只电池进行扫描,准确实时动态循环检测单体电池;测量电池的容量及活性指标,准确定位失效电池发出告警信号,保证系统的供电可靠性。 可实现输出制式的转换,通过拔码开并实现三进三处和三进单出的转换;

OBOO鸥柏触摸查询一体机技术核心控标参数

32寸触控查询一体机详细参数要求配置参数 屏幕参数 液晶屏品牌全新原厂原包LED商用液晶面板 面板色彩彩色/高清 32寸显示尺寸697.685(横)×392.256(竖) mm 显示模式Super MVA,常黑显示,透射式 显示颜色 1.07B (8-bit+Hi-FRC) 显示时间 5.5ms 扫描频率60HZ 亮度300cd/㎡ 对比度1500:1 分辨率1920*1080 屏幕比例16:9 可视角度89/89/89/89 (Typ.)(CR≥10)(左/右/上/下)面板电压12.0V(Typ.) 安卓配置参数CPU处理器安卓ARM Cortex-A17构架,八核处理器,主频1.8GHz GPU ARM Mali-T764 GPU, 支持TE, ASTC, AFBC内存压缩技术 运行内存2GB 机身存储16GB 主板芯片组瑞芯微RK3288 接口eDP接口,LVDS接口(单路,6位双路,8位,10位双路)。支持最大分辨率3840*2160,

支持HDMI 7"-108" 4K*2K显示屏,支持双屏异显功能 网络支持具备RJ45百兆网口,支持Ethernet。 具备wifi模块,支持2.4G WiFi,支持Wi-Fi 802.11b/g/n协议。3G,4G模块支持(可选) 操作系统Android 6.0 触摸性能识别原理红外识别 输入方式手指or普通笔 触摸点数10点触摸,5点书写 响应时间<20毫秒 书写精度90%区域±2mm 最小触摸物单点触摸6mm,多点触摸8mm 书写高度 3.5mm(两侧为5.5mm) 抗光强度100K LUX 通信方式全速USB 机身工艺 设计新颖美观、布局合理、布线规范。符合人体工程学设计,自带喇叭音频;特性落地式竖屏显示,竖屏设计,折弯喷涂等 材质铝型材金属喷漆,冷轧钢板、不易变形、机柜与固定背板部件结合紧密表面防护工业级透明钢化玻璃 外观工艺铝型材拉丝氧化处理 表面处理铝材漆袖可选高亮漆/采用工业漆、无须担心脱落或生锈 颜色可选黑色/银色/金色(可定制) 安装方式落地式 电源内置安全可靠的电源外引线及专用插座(有设计防静电接地)

分布式存储系统的要点

汉柏科技 分布式存储系统要点 王智民 汉柏科技有限公司

分布式存储系统 分布式存储系统,有块存储、对象存储、文件存储,有不同的开源项目如Ceph、GlusterFS、Sheepdog、Swift,还有不同的商业实现如Google、AWS、微软、金山、七牛、又拍、阿里云还有Qingcloud 首先对象存储和文件存储的区别是不大的,存储的都是一样的东西,只是抛弃了统一 的命名空间和目录树的结构,使得扩展起来桎梏少一些。 独立的互联网存储服务一般都是做对象存储的,因为块存储是给计算机用的,对象存 储是给浏览器等HTTP客户端用的。

分布式存储系统的三个问题 ?对于一套分布式存储的方案,怎样评估它是好还是不好? ?如何对分布式存储的不同实现进行分类? ?分布式存储中的“数据可靠性”是如何计算的? 1.运行或在线系统需要高性能 2.离线或备份数据需要高容量,低价格 3.所有的数据都必须是可靠的,绝对不能丢 ?对于块存储,要求的访问时延是 10ms 级的,因为给虚拟机用的,传统硬盘也是 10ms 级的时延,请求尺寸都很小,但qps(iops)可能会很高,那么在这种情况下: ?异地多中心是不现实的,存储要和主机尽量接近,相应地可靠性必然会有所打折 ?强一致副本不会过多,强一致要求对时延有影响 ?对于对象存储,要求的访问时延是 100ms - 1s 级的,请求一般是中到大尺寸,低 qps 的,在这种情况下 ?可以用更多的分散副本数来换取更高的可靠性,但过多副本增加维持一致性的难度,需要折衷

分布式存储系统的三个问题 ?对于一套分布式存储的方案,怎样评估它是好还是不好? ?如何对分布式存储的不同实现进行分类? ?分布式存储中的“数据可靠性”是如何计算的? 按照存储接口来划分 1.对象存储: 也就是通常意义的键值存储,其接口就是简单的GET、PUT、DEL和其他扩展,如七牛、又拍、Swift、S3 2.块存储: 这种接口通常以QEMU Driver或者Kernel Module的方式存在,这种接口 需要实现Linux的Block Device的接口或者QEMU提供的Block Driver接口,如Sheepdog,AWS的EBS,青云的云硬盘和阿里云的盘古系统,还有Ceph的RBD(RBD是Ceph面向块存储的接口) 3.文件存储: 通常意义是支持POSIX接口,它跟传统的文件系统如Ext4是一个类型的,但区别在于分布式存储提供了并行化的能力,如Ceph的CephFS(CephFS是Ceph面向文件存储的接口),但是有时候又会把GFS,HDFS这种非POSIX接口的类文件存储接口归入此类。

3种分布式文件系统

第一部分CEPH 1.1 特点 Ceph最大的特点是分布式的元数据服务器通过CRUSH,一种拟算法来分配文件的locaiton,其核心是 RADOS(resilient automatic distributed object storage),一个对象集群存储,本身提供对象的高可用,错误检测和修复功能。 1.2 组成 CEPH文件系统有三个主要模块: a)Client:每个Client实例向主机或进程提供一组类似于POSIX的接口。 b)OSD簇:用于存储所有的数据和元数据。 c)元数据服务簇:协调安全性、一致性与耦合性时,管理命名空间(文件名和 目录名) 1.3 架构原理 Client:用户 I/O:输入/输出 MDS:Metadata Cluster Server 元数据簇服务器 OSD:Object Storage Device 对象存储设备

Client通过与OSD的直接通讯实现I/O操作。这一过程有两种操作方式: 1. 直接通过Client实例连接到Client; 2. 通过一个文件系统连接到Client。 当一个进行打开一个文件时,Client向MDS簇发送一个请求。MDS通过文件系统层级结构把文件名翻译成文件节点(inode),并获得节点号、模式(mode)、大小与其他文件元数据。注意文件节点号与文件意义对应。如果文件存在并可以获得操作权,则MDS通过结构体返回节点号、文件长度与其他文件信息。MDS同时赋予Client操作权(如果该Client还没有的话)。目前操作权有四种,分别通过一个bit表示:读(read)、缓冲读(cache read)、写(write)、缓冲写(buffer write)。在未来,操作权会增加安全关键字,用于client向OSD证明它们可以对数据进行读写(目前的策略是全部client 都允许)。之后,包含在文件I/O中的MDS被用于限制管理能力,以保证文件的一致性与语义的合理性。 CEPH产生一组条目来进行文件数据到一系列对象的映射。为了避免任何为文件分配元数据的需要。对象名简单的把文件节点需要与条目号对应起来。对象复制品通过CRUSH(著名的映射函数)分配给OSD。例如,如果一个或多个Client打开同一个文件进行读操作,一个MDS会赋予他们读与缓存文件内容的能力。通过文件节点号、层级与文件大小,Client可以命名或分配所有包含该文件数据的对象,并直接从OSD簇中读取。任何不存在的对象或字节序列被定义为文件洞或0。同样的,如果Client打开文件进行写操作。它获得使用缓冲写的能力。任何位置上的数据都被写到合适的OSD上的合适的对象中。Client 关闭文件时,会自动放弃这种能力,并向MDS提供新的文件大小(写入时的最大偏移)。它重新定义了那些存在的并包含文件数据的对象的集合。 CEPH的设计思想有一些创新点主要有以下两个方面: 第一,数据的定位是通过CRUSH算法来实现的。

ceph源码分析之读写操作流程(2)

ceph源码分析之读写操作流程(2) 上一篇介绍了ceph存储在上两层的消息逻辑,这一篇主要介绍一下读写操作在底两层的流程。下图是上一篇消息流程的一个总结。上在ceph中,读写操作由于分布式存储的原因,故走了不同流程。 对于读操作而言: 1.客户端直接计算出存储数据所属于的主osd,直接给主osd 上发送消息。 2.主osd收到消息后,可以调用Filestore直接读取处在底层文件系统中的主pg里面的内容然后返回给客户端。具体调用函数在ReplicatedPG::do_osd_ops中实现。读操作代码流程如图:如我们之前说的,当确定读操作为主osd的消息时(CEPH_MSG_OSD_OP类型),会调用到ReplicatePG::do_osd_op函数,该函数对类型做进一步判断,当发现为读类型(CEPH_OSD_OP_READ)时,会调用FileStore中的函数对磁盘上数据进行读。 [cpp] view plain copy int ReplicatedPG::do_osd_ops(OpContext *ctx, vector<OSDOp>& ops) { …… switch (op.op) { …… case CEPH_OSD_OP_READ: ++ctx->num_read; { // read into a buffer bufferlist

bl; int r = osd->store->read(coll, soid, op.extent.offset, op.extent.length, bl); // 调用FileStore::read从底层文件系统读 取……} case CEPH_OSD_OP_WRITE: ++ctx->num_write; { ……//写操作只是做准备工作,并不实际的 写} ……} } FileStore::read 函数是底层具体的实现,会通过调用系统函数 如::open,::pread,::close等函数来完成具体的操作。[cpp] view plain copy int FileStore::read( coll_t cid, const ghobject_t& oid, uint64_t offset, size_t len, bufferlist& bl, bool allow_eio) { …… int r = lfn_open(cid, oid, false, &fd); …… got = safe_pread(**fd, bptr.c_str(), len, offset); //FileStore::safe_pread中调用了::pread …… lfn_close(fd); ……} 而对于写操作而言,由于要保证数据写入的同步性就会复杂很多: 1.首先客户端会将数据发送给主osd, 2.主osd同样要先进行写操作预处理,完成后它要发送写消息给其他的从osd,让他们对副本pg进行更改, 3.从osd通过FileJournal完成写操作到Journal中后发送消息

IP控标参数

公共机可以媲美几百台电脑的功能当做服务器 1. 定时广播管理:根据广播内容需要,可按星期、日、小时以及按终端、节目、时间的排序建立一个或多个定时广播任务,系统将自动执行所有指定的任务,无需人工操作,真正实现人性化的无人值守,省力省心。 2. 语音实时采播:IP广播节目实时采播功能,能够将来自其他音源的节目实时采集压缩存储到服务器,并可同时转播到指定的网络广播适配器终端。采播源可以是其他商用或自用电台、录音机、卡座、CD播放器、MP3播放器、麦克风等,可用于广播通知、网上讲话,电台转播等。采播的音源可实时录音,实时存储到系统服务器上,方便以后调用。 3. 本地音频输入:IP广播音频适配器可接入本地音源,通过麦克风进行本地优先广播。(优先级可调) 4. 个性点播:可通过终端可视化的界面操作点播服务器上成千上万的音频文件,高保真音效,且兼容所有MP3格式音乐,节目源不受限制。 5. 远程控制功能:系统可以实现广域网或者跨网关的传输和控制,并实时反馈现场操作信息,可视化图形信息显示当前设备的工作状态。 6. 分组控制:将在不同物理位置的终端即时方便的分成一个组,进行统一集中控制。对任意划分的区域进行不同内容的手动或自动播放 7. 多个分控设置:系统可分配不同管理权限,设立超级管理员、主管领导、查询管理员、控制管理员,不同权限的管理员可以进行不同的授权操作;分控数量无限制。 8. 系统升级扩展容易:系统升级简单容易,不需更换任何硬件设施,只需软件升级就能够达到目的,无需从控制室重新铺设线路和增加设备,只要在同一个局域网内的线路上往下增加广播网络适配器即可完成。 9. 自动休眠功能:系统不进行任何广播时,终端服务器处于关闭状态,喇叭听不到任何噪音(传统广播时刻处于待机状态,噪音无法避免),既保证了你的工作环境的清净,又大大提高了设备及喇叭的使用寿命。当有广播信号进入终端服务器时,自动解除休眠进行广播。 10. 紧急广播:系统可与消防联动,平时控制中心处于热备状态,一旦发生紧急情况,即可受控于消防联动信号,不论系统处于任何状态,根据预选设定都可马上进入全区报警或N+1~N+4邻层报警。 11. 简便的操作:IP网络广播系统结合鼠标键盘操作,不仅显示直观,操作更为方便人性化,超大触摸屏 可实时显示当前系统工作状态,良好的人机对话功能,初学者无需专业培训亦可轻松掌握,易学易懂易操作。 12. 系统零维护:IP网络广播在物理上与网络共用,所以并不在网络维护之外增加额外的维护工作;在应用上,系统可设置独立网段与计算机分隔,各网络广播适配器嵌入式系统程序固化,不会受到病毒感染,系统整体高稳定可靠零维护。 13. 多级服务器管理:系统可设定多个服务器,每个服务器都可以控制各自所属终端,通过系统软件建立连接,当某个服务器出现问题时不影响其他服务器的正常运行。 14. 灵活的安装方式,适用于大范围应用:可以横跨多个地方,实现跨局域网、跨网段、跨广域网的控制。只要有网络的地方就可以接入广播系统。 15. 终端无线遥控控制播放功能:可在网络适配器前端通过设置自带的红外无线遥控器控制系统的播放、音量调节、选曲、停止等功能 16. 终端无线遥控控制优先功能:可根据用户级别设定优先级顺序,可预设1000个级别的操作任务优先级。 17. 终端无线遥控定时功能:终端可通过遥控器进行定时选曲播放,无需到主软件上进行定

7种分布式文件系统介绍

FastDFS (7) Fastdfs简介 (7) Fastdfs系统结构图 (7) FastDFS和mogileFS的对比 (8) MogileFS (10) Mogilefs简介 (10) Mogilefs组成部分 (10) 0)数据库(MySQL)部分 (10) 1)存储节点 (11) 2)trackers(跟踪器) (11) 3)工具 (11) 4)Client (11) Mogilefs的特点 (12) 1. 应用层——没有特殊的组件要求 (12) 2. 无单点失败 (12) 3. 自动的文件复制 (12) 4. “比RAID好多了” (12) 5. 传输中立,无特殊协议 (13) 6.简单的命名空间 (13) 7.不用共享任何东西 (13) 8.不需要RAID (13)

9.不会碰到文件系统本身的不可知情况 (13) HDFS (14) HDFS简介 (14) 特点和目标 (14) 1. 硬件故障 (14) 2. 流式的数据访问 (14) 3. 简单一致性模型 (15) 4. 通信协议 (15) 基本概念 (15) 1. 数据块(block) (15) 2. 元数据节点(Namenode)和数据节点(datanode) . 16 2.1这些结点的用途 (16) 2.2元数据节点文件夹结构 (17) 2.3文件系统命名空间映像文件及修改日志 (18) 2.4从元数据节点的目录结构 (21) 2.5数据节点的目录结构 (21) 文件读写 (22) 1.读取文件 (22) 1.1 读取文件示意图 (22) 1.2 文件读取的过程 (23) 2.写入文件 (24) 2.1 写入文件示意图 (24)

控标技术参数

200万像素高清网络摄像机 1/3 逐行扫描CMOS,捕捉运动图像无锯齿 视频压缩标准支持H.264/SVAC 最低照度,彩色:0.02Lux @(F1.2,AGC ON);黑白:0.001Lux @(F1.2,AGC ON) 日夜转换模式:ICR滤光片切换 镜头接口:C/CS,支持自动光圈 支持3D数字降噪功能 支持宽动态功能,宽动态范围160dB 支持SD/SDHC卡本地存储 支持向NVR存储推送视频流,支持视频流传输协议 ICR红外滤片式自动切换,实现真正的日夜监控 支持1路BNC模拟视频输出 支持双向音频对讲或单向语音广播功能,音频输入端口支持无源麦克风 1个RS485接口,可扩展并操控云台 1路报警输入输出端口,支持报警联动功能 支持PoE网络供电功能 支持双码流,支持手机监控 支持心跳协议 支持一键复位、数字水印 130万网络红外高清高速球

红外功能: 最低照度0Lux 采用高效红外阵列,低功耗,照射距离达100m 红外灯与倍率距离匹配算法,根据倍率及距离调节红外灯亮度,使图像达到理想的状态 内置热处理装置,降低球机内腔温度,防止球机内罩起雾恒流电路设计,红外灯寿命达3万小时 系统功能: 采用索尼高性能传感器, 图像清晰, 最大分辨率可到1280x960 支持128倍超宽动态功能 精密电机驱动, 反应灵敏, 运转平稳, 精度偏差少于0.1度, 在任何速度下图像无抖动 支持RS-485控制下对HIKVISION、Pelco-P/D协议的自动识别 支持三维智能定位功能, 配合DVR和客户端软件可实现点击跟踪和放大 支持多语言菜单及操作提示功能, 用户界面友好 支持数据断电不丢失 支持断电状态记忆功能, 上电后自动回到断电前的云台和镜头状态 支持光纤模块接入

典型分布式文件系统概述

分布式文件系统概述(一) 杨栋 yangdonglee@https://www.360docs.net/doc/2d3168789.html, 2006-12 摘要 文件系统是操作系统用来组织磁盘文件的方法和数据结构。传统的文件系统指各种UNIX平台的文件系统,包括UFS、FFS、EXT2、XFS等,这些文件系统都是单机文件系统,也称本地文件系统。随着网络的兴起,为了解决资源共享问题,出现了分布式文件系统。分布式文件系统是指文件系统管理的物理存储资源不一定直接连接在本地节点上,而是通过计算机网络与节点相连。本文1简要回顾了本地文件系统,然后按照发展例程大致介绍了2006年之前各时期主要的分布式文件系统,最后从设计目标、体系结构及关键技术等方面比较了各个分布式文件系统的异同。目前很火的Hadoop文件系统、S3文件系统都是从NFS等早期文件系统一步步演化而来的,了解分布式文件系统的历史,有助于大家更加深刻地领会分布式文件系统的精髓。 1本文写于2006年底,借鉴了别人的大量资料,目的是为了与同学们分享分布式文件系统的发展史。笔者在硕士期间跟随中科院计算所的孟老师、熊老师和唐荣锋进行分布式文件系统的研究和开发。分布式文件系统源远流长,本文只是选择了其发展史上的部分实例进行简单描述,由于笔者水平十分有限,错误之处难免很多,各位同学发现问题之后麻烦回复邮件到yangdonglee@https://www.360docs.net/doc/2d3168789.html,,我会尽全力完善,或者请各位同学自行修正。笔者目前在百度进行云计算方面的研究和开发,希望有兴趣的同学一起进行探讨。

目录 1.引言 (5) 2.本地文件系统 (5) 2.1FFS (6) 2.2LFS (6) 2.3Ext3 (7) 3.分布式文件系统 (7) 3.1 发展历程 (7) 3.2分布式文件系统分类 (8) 3.2.1 实现方法 (8) 3.2.2研究状况 (8) 3.3 NFS (9) 3.3.1概述 (9) 3.3.2 体系结构 (9) 3.3.3 通信机制 (10) 3.3.4进程 (10) 3.3.5 命名 (10) 3.3.6 同步机制 (11) 3.3.7 缓存和复制 (11) 3.3.8 容错性 (12) 3.3.9 安全性 (13) 3.4 AFS、DFS、Coda和InterMezzo (13) 3.5 SpriteFS和Zebra (14) 3.6xFS (16) 3.6.1 概述 (16) 3.6.2 体系结构 (16) 3.6.3 通信 (16) 3.6.4 进程 (17) 3.6.5 命名 (18) 3.6.6 缓存 (19)