深度神经网络2

2023年秋江苏开放大学神经网络与深度学习形考二作业

2023年秋江苏开放大学神经网络与深度学习形考二作业试题列表单选题题型:单选题客观题分值5分难度:简单得分:51以下卷积运算的输出结果为A11 12<br>10 1115 16<br> 6 15C10 11<br>11 12D11 12<br>10 11学生答案:B老师点评:题型:单选题客观题分值5分难度:中等得分:52以下关于神经⽹络的训练过程,描述错误的是?A【mini-batch】从训练数据中随机选出⼀部分数据,这部分数据称为mini-batch,我们的⽬标是减少mini-batch损失函数的值。

【随机梯度下降】stochastic gradient descent:“随机”代表在梯度下降中随机初始⼀个学习率,并不断尝试多个值,寻求最好的结果C【计算梯度】为了减⼩mini-batch的损失函数,需要求出各个权重参数的梯度D【更新参数】梯度反⽅向表示损失函数的值减⼩最多的⽅向,将权重参数沿梯度反⽅向进⾏微⼩更新学生答案:B老师点评:题型:单选题客观题分值5分难度:一般得分:53多义现象可以被定义为在⽂本对象中⼀个单词或短语的多种含义共存。

下列哪⼀种⽅法可能是解决此问题的最好选择?A随机森林B以上所有⽅法卷积神经⽹络D强化学习学生答案:C老师点评:题型:单选题客观题分值5分难度:中等得分:54在⼀个神经⽹络⾥,知道每⼀个神经元的权重和偏差是最重要的⼀步。

如果以某种⽅法知道了神经元准确的权重和偏差,你就可以近似任何函数。

实现这个最佳的办法是什么?A以上都不正确B搜索所有权重和偏差的组合,直到得到最优值C随机赋值,祈祷它们是正确的赋予⼀个初始值,检查与最优值的差值,然后迭代更新权重学生答案:D题型:单选题客观题分值5分难度:一般得分:55以下场景中适合采⽤⼀对多结构RNN的是?A基于帧粒度的视频分类B⽣成图⽚说明C情感分析D机器翻译学生答案:B题型:单选题客观题分值5分难度:一般得分:56在典型CNN⽹络AlexNet中,原始图⽚是⼤⼩为227*227的三通道数据,经过96个⼤⼩为11*11的卷积核卷积后得到96个⼤⼩为55*55的特征图,若padding = 0 ,则卷积核的步⻓为多少?4B1C2D3学生答案:A老师点评:题型:单选题客观题分值5分难度:一般得分:57】在神经⽹络的学习中,权重的初始值特别重要,设定什么样的权重初始值,经常关系到神经⽹络的学习能否成功。

深度卷积神经网络

LeNet提供了利用卷积 层堆叠进行特征提取的 框架,开启了深度卷积 神经网络的发展。

图4:LeNet网络结构,来源于文献 [1]。 [1] Y. Lecun, L. Bottou, Y. Bengio and P. Haffner. Gradient-Based Learning Applied to Document Recognition. Proceedings of the IEEE, vol. 86, no. 11, 1998.

y

前向传播过程

……

.... ..

m1 i

w

m ij

loss

ym j

....

jm

1

前向传播

m 1

m m m m 1 y h ( s ) h ( w 1、计算每层中每个节点的输出 j ij yi ) h() 为激活函数 j

2、在输出层计算损失

h (s )(Tj ym j )

两个重要的信息: 1. 具有多个隐层的人工神经网络具有优异的特征学习能力, 学习得到的特征对数据有更本质的刻画,从而有利于可 视化或分类; 2. 深度神经网络在训练上的难度,可以通过“逐层初始化” (Layer-wise Pre-training)来有效克服。 Neural networks are coming back!

神经元

树突

神经元 接收信号 神经元激活 轴突发出信号

ANN

输入

隐含层输入

隐含层输出

ANN是对大脑神经元信号传输的模拟

神经网络简要介绍

感知机(Perceptron)

通过查找超平面解决二类分类问题(通过二值函数解决二类分类问题)

公式表达:

f (x) sign(w x)

深度神经网络原理

深度神经网络原理深度神经网络是一种由多层神经元组成的人工神经网络,它是一种模仿人脑神经元网络结构和工作原理而设计的计算模型。

深度神经网络的原理是基于神经元之间的连接和信息传递,通过多层次的非线性变换来学习数据的特征表示,从而实现对复杂数据的高效处理和分析。

深度神经网络的核心原理是通过多层次的神经元连接来构建复杂的特征表示。

每一层的神经元接收上一层的输出,并进行加权求和和非线性变换,然后将结果传递给下一层。

通过这种逐层的信息传递和变换,深度神经网络可以逐渐学习到数据的高级特征表示,从而实现对复杂数据的有效建模和分析。

在深度神经网络中,每一层的神经元都包含权重和偏置,通过学习算法来不断调整这些参数,使得网络可以更好地拟合数据。

常见的深度神经网络结构包括卷积神经网络(CNN)、循环神经网络(RNN)和深度信念网络(DBN)等,它们在不同领域都取得了显著的成就。

深度神经网络的训练过程通常采用反向传播算法,通过计算损失函数对网络参数进行调整,使得网络的预测结果与真实标签尽可能接近。

在训练过程中,需要大量的标记数据和计算资源来不断优化网络参数,以提高网络的泛化能力和性能。

深度神经网络在计算机视觉、自然语言处理、语音识别等领域都取得了重大突破,例如在图像分类、目标检测、机器翻译等任务上都取得了优于传统方法的效果。

随着硬件计算能力的提升和深度学习算法的不断发展,深度神经网络在各个领域的应用前景也越来越广阔。

总之,深度神经网络是一种强大的机器学习模型,它通过多层次的非线性变换来学习数据的特征表示,从而实现对复杂数据的高效建模和分析。

随着深度学习技术的不断发展,深度神经网络将在各个领域发挥越来越重要的作用,推动人工智能技术的进步和应用。

深度神经网络模型的二分类问题优化研究

深度神经网络模型的二分类问题优化研究深度神经网络(Dense Neural Network, DNN)的广泛应用已经使得分类问题变得更加有效和准确。

二分类问题是指分类目标中只有两种可能的结果,比如判断一张图片是否为猫或狗。

在处理这种问题时,有许多方法可以考虑以优化DNN模型的表现。

在本文中,我们将会探讨几个优化DNN模型处理二分类问题的方法。

一、选择合适的激活函数激活函数是神经网络中一个非常重要的组成部分,它提供了对输入数据的非线性映射。

在DNN中,常用的激活函数包括sigmoid、ReLU、tanh等等。

在处理二分类问题时,sigmoid函数是最常用的激活函数之一。

它的输出值在0到1之间,可以被看作是对于输入值的概率估计。

同时,sigmoid函数具有导数可以用于反向传播。

另外,ReLU是更为复杂的函数,它在输入为负数时会返回0,而输入为正数时会直接返回本身。

因此,它只是在正半轴上具有非零梯度。

这样的优点在于,它允许反向传播时更快速的收敛。

因此,在处理较大的数据集时,使用ReLU可能会比sigmoid更高效。

二、正则化对于DNN模型来说,过拟合(Overfitting)是非常常见的问题。

过拟合指的是当模型在训练集上表现出色,而在测试集上表现不如预期。

正则化(Regularization)是避免过拟合的一种常用方法。

常见的正则化技术有dropout和L2正则化。

对于dropout正则化,我们将网络中的一些节点设为随机失活,强制让它们的输出为0。

这样可以迫使网络学习到更加鲁棒的特征,并降低节点之间的强耦合程度。

有了L2正则化,损失函数会添加对参数平方和的惩罚项。

这样一来,模型对于某些特殊的数据输入就不会过于敏感,从而避免过拟合的情况发生。

三、优化器的选择在训练DNN模型时,需要对参数进行不断的优化调整。

优化器是一种选择合适的步长和更新方向的算法,从而使损失函数逐渐减少。

目前,Adagrad、Adam、SGD等都是较为常见的优化器。

人工神经网络基础_ANN课程笔记 2、深度神经网络

第二章深度神经网络一、概述1、基本概念深度学习(Deep Learning)是一种没有人为参与的特征选取方法,又被称为是无监督的特征学习(Unsupervised Feature Learning)。

深度学习思想的神经网络利用隐含层从低到高依次学习数据的从底层到高层、从简单到复杂、从具体到抽象的特征,而这一特性决定了深度学习模型可以学习到目标的自适应特征,具有很强的鲁棒性。

深度学习的另外一个思想是贪婪算法(greedy algorithm)的思想,其在训练的时候打破了几十年传统神经网络训练方法的“桎梏”,采用逐层训练(greedy layer-wise)的贪婪思想,并经过最后的微调(fine-tuning),这一训练算法的成功也使得深度学习获得了巨大成功。

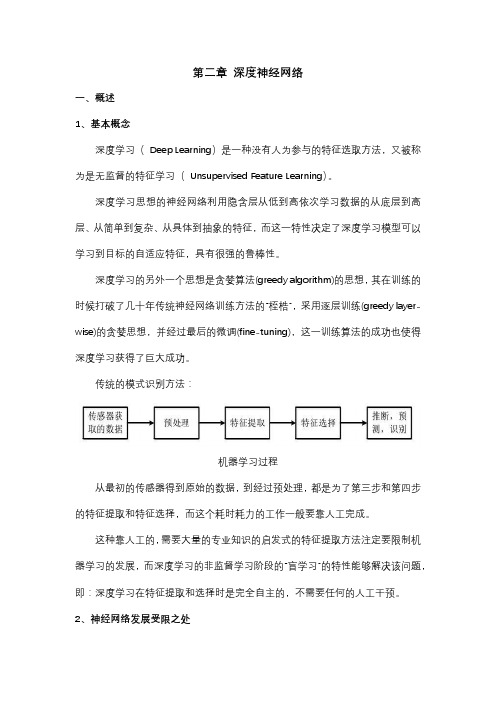

传统的模式识别方法:机器学习过程从最初的传感器得到原始的数据,到经过预处理,都是为了第三步和第四步的特征提取和特征选择,而这个耗时耗力的工作一般要靠人工完成。

这种靠人工的,需要大量的专业知识的启发式的特征提取方法注定要限制机器学习的发展,而深度学习的非监督学习阶段的“盲学习”的特性能够解决该问题,即:深度学习在特征提取和选择时是完全自主的,不需要任何的人工干预。

2、神经网络发展受限之处多隐含层的网络容易收敛到参数空间的局部最优解,即偏导数为0 的点,尤其在目标识别中,由于图像的信噪比很低,神经网络很容易陷入局部极小点; 训练算法与网络的初始参数有很大关系,比较容易过拟合;训练速度慢;在误差反向传播的训练算法中,层数越深,误差越小,甚至接近于0,造成训练失败。

误差反向传播算法必须要用到带标签的数据(有导师学习、监督学习),获取带标签的数据十分困难。

3、深度学习的学习算法深度学习的基本模型从形式上来看和神经网络一致,基本的结构单元都是神经元,由神经元组成网络层,整个网络由输入层,隐含层和输出层组成。

在深度学习理论中,一个网络的学习算法每运行一次,只调整一层网络的参数。

DBNN深度二值神经网络原理与应用

DBNN深度二值神经网络原理与应用深度学习已经成为了现代机器学习领域的热门话题之一,其中神经网络因其能够在诸如图像识别、自然语言处理、语音识别等许多领域中取得良好效果而备受瞩目。

但是,传统神经网络有着权值数量过多和运算量过大的问题,而深度二值神经网络(DBNN)则是一种改进的二值化神经网络,可以在减少计算量的同时保持良好的精度,因此备受关注。

本文将详细介绍DBNN 的原理和应用。

一、DBNN的原理DBNN是将传统的神经网络(NN)中的参数替换为二值(+1或-1)的神经网络。

在训练过程中,模型通过正向传播计算并输出网络对输入的预测结果,然后通过误差反向传播算法(BP)调整权重值来逐渐逼近真实结果。

与传统的NN不同的是,DBNN 的权重在每次更新时都会被变为+1或-1,从而严格控制了权重的数量,降低了计算复杂度。

尽管权值的数量减少了,DBNN仍然能够保持较好的精度。

这是因为,通过使用BIN function(二值化函数),DBNN不仅可以达到性能不降的目标,而且还能够在噪声环境中有更好的表现。

BIN function可以表示为:f(x) = sign (x) = +1 or -1其中,sign(x)代表在x>=0时返回+1,在x<0时返回-1的符号函数。

在二值化之后,神经元的输出可以相当于一个二进制的on/off开关,减少了参数个数的同时,保持了精度和速度,因此DBNN被广泛运用到很多领域。

二、DBNN的应用1. 图像识别在图像识别领域中,DBNN常常被用于处理灰度图像和二值图像。

其快速和简单的网络架构赋予它该任务的可行性,它可以在较短的时间内计算出较高的准确率。

在数据集的训练过程中,采用BIN function将输入二值化,同时使用随机算法对网络结构进行优化。

在测试过程中, DBNN 能够在极短的时间内对未知图像进行分类,并保持高的准确度。

2. 自然语言处理在自然语言处理领域,DBNN被用于处理情绪识别和语言情感分析。

深度神经网络及其在各领域中的应用

深度神经网络及其在各领域中的应用深度神经网络(Deep Neural Networks,DNN),指的是多层神经网络模型。

此类模型采用了多个隐层来提取高阶特征,达到了比浅层神经网络更好的效果。

深度神经网络具有非线性、并行计算能力等优势,在最近几年逐渐流行起来并被广泛用于语音识别、图像识别、自然语言处理等领域。

本文将介绍深度神经网络的原理及其在各领域的应用。

一、深度神经网络的原理深度神经网络的基本结构由分层的神经元组成,其中每一层都对前一层的输出进行转换,最后输出结果。

下面我们以手写数字识别任务为例来解释深度神经网络的工作原理。

对于手写数字的识别任务,我们需要将一张图片输入到神经网络中,并通过网络输出该图片代表的数字。

深度神经网络的每一层都被视为一个特征提取器,每一个神经元都对前一层的输出进行加权和运算。

在最深的层中,神经元将由之前层次中的特征创造复杂的模板,这些模板可表示数字中各个模块的几何形状。

最后,模型的输出用于标识图像中的数字。

这个过程可使用反向传播算法进行优化,以确保模型在训练期间学会准确地识别手写数字。

二、深度神经网络的应用1. 语音识别深度神经网络在语音识别领域的应用非常广泛。

现代的语音识别系统通常使用简化的前端特征提取流水线,生成频谱表示,并将其转换为概率分布。

这种表示可以输入到深度神经网络中,并使用反向传播算法进行优化以改善模型的性能。

最新的语音识别系统使用短时傅里叶变换等技术进行前处理,将声音转换为梅尔频率频谱,然后将其输入到深度神经网络中,以便构建语音识别模型。

识别模型可由一些基础的深度神经网络模型组成,例如循环神经网络(RNN)和卷积神经网络(CNN)等。

2. 图像识别深度神经网络已成为图像识别领域显著的研究主题。

CNN是一种特殊的深度神经网络,已成为图像分类的标准方法。

神经网络模型在学习时使用许多卷积核,以在不同的像素位置捕获同一模式,并将这些卷积核与其他神经元组合起来,以获得潜在的许多层特征。

深度学习 神经网络

我们希望所建立的网络可以尽可能的满足这些不变性特点。 为了理解卷积神经网络对这些不变性特点的贡献,我们将用不具 备这些不变性特点的前馈神经网络来进行比较。

图片识别--前馈神经网络

方便起见,我们用depth只有1的灰度图来举例。 想要完成的任务是:在宽长为4x4 的图片中识别是否有下图所示的“横折”。 图中,黄色圆点表示值为0的像素,深色圆 点表示值为1的像素。 我们知道不管这个横折在图片中的什么位置,都会被认为是相同 的横折。

例子:人脸识别

物质组成视角:神经网络的学习过程就是学习物质组成方式的过程。

增加节点数:增加同一层物质的种类,比如118个元素的原子层就有118个节点。

增加层数:增加更多层级,比如分子层,原子层,器官层,并通过判断更抽象的概念来 识别物体。

2.3、神经网络的训练

神经网络的学习过程就是学习控制着空间变换方式(物质组成方式)的权重矩阵 W , 那如何学习每一层的权重矩阵 W 呢?

因为环境的变化是随机的,所以进化并没有方向,但是却有增加差异性的趋势。 通过自我复制的方式,能够产生的差异性还是较弱。所以自然界慢慢的开始形成了有性 繁殖,两个不同的个体进行交配,增加子代的差异性。但是有性繁殖使得大范围移动成 为了必然需求。环境会随着移动而变化,个体在上一环境中通过自然学习所学习到的关 联,在下一个环境并不适用。

▪

▪

▪

运用BP算法的多层前馈神经网络神经网络实例:

▪

1

0

1

0.2

0.4

-0.5

-0.3

0.1

0.2

-0.3

-0.2

-0.4

0.2

0.1

▪

▪

省去中间计算过程,最后得到第一轮训练之后的新的权重与阈值:

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Deep Neural Networks

中国科学院自动化研究所 吴高巍 gaowei.wu@ 2015-10-27

内容

深度学习常用模型

Deep Boltzmann Machines, DBM Convolutional Neural Network, CNN Recurrent Neural Networks, RNN

RBM

学习目标:极大似然

max log( p (vi ))

i 1 N

能量函数 E(v,h) = −vTWh − bTv − aTh 波尔兹曼分布

RBM

CD-K算法

RBM

CD-1算法

AutoEncoder vs. RBM

Deep Boltzmann Machines

T

c:

x:

二维卷积

卷积

稀疏连接 参数共享

多卷积核

每个卷积核都会将图像生成为另一幅图像。

两个卷积核就可以将生成两幅图像,这两幅图像可以看做是一张图 像的不同的通道。

由4个通道卷积得到2个通道的过程

Pooling池化

通过卷积获得了特征 之后,下一步利用这些特征去做分类。

使用卷积时是利用了图像的“静态”特征 Pooling, 对不同位置的特征进行聚合统计

局部连接

局部感知野

图像的空间联系也是局部的像素联系较为紧密,而距离较远的像素 相关性则较弱。 减少了需要训练的权值数目

局部连接

参数共享

图像的一部分的统计特性与其 他部分是一样的。

在输入的不同位置检测同一种 特征 平移不变性

Convolution卷积

一维卷积

c j m x j |m|1: j

Deep Learning的常用模型

——Convolutional Neural Networks, CNN

Convolutional Neural Networks卷积神经网络

20世纪60年代,Hubel和Wiesel研究猫脑皮层

用于局部敏感和方向选择的神经元,其独特的网络结构可以有效地 降低反馈神经网络的复杂性

RNN

一般来说,RNN每一时间的输入和输出是不一样的 例,序列学习

对于序列数据是将序列项依次传入,每个序列项再对应不同的输出

RNN

时序展开

在RNN中每一个时间步骤用到的参数都是一样的

unfold

Training RNNs with backpropagation

权值一致的BP算法

深度学习的使用

Deep Learning的常用模型

——Deep Boltzmann Machines, DBM

回顾:Deep Belief Network, DBN

概率生成模型 深层结构——多层

二值随机神经元

非监督的预学习 监督微调(fine-tuning)

DBN Greedy training

Deep Boltzmann Machine

例:两层BM

MNIST: 2-layer BM

60,000 training and 10,000 testing examples 0.9 million parameters Gibbs sampler for 100,000 steps

After discriminative fine-tuning: 0.95% error rate Compare with DBN 1.2%, SVM 1.4%

RNN功能强大

Distributed hidden state that allows them to store a lot of information about the past efficiently. Non-linear dynamics that allows them to update their hidden state in complicated ways.

BP算法容易实现权值间的线性 约束

To constrain: w1 w2 we need : w1 w2 E com pute : w1 E E use w1 w2 E and w2 for w1 and w2

同样计算梯度,然后改变梯度 以满足约束

如果权值开始时满足约束,那 就会一直满足约束

子采样

Average pool Max pool

1 s2

x

i

max{xi }

1 2 s

2 x i

L2 pool

Convolved Feature

Pooled Feature

CNN基本结构

卷积层 子采样层

CNN结构

卷积神经网络是一个多层的神经网络

每层由多个二维平面组成 每个平面由多个独立神经元组成

Input Layer S2: 6 feature maps C2: 6 feature maps S1: 4 feature maps C1: 4 feature maps

CNN训练过程

监督训练 Bp算法

向前传播 从样本集中取一个样本(X,Yp),将X输入网络 计算相应的实际输出Op Op=Fn(…( F2( F1( XpW(1) )W(2) )…)W(n) ) 向后传播 计算实际输出Op与相应的理想输出Yp的差 按极小化误差的方法反向传播调整),最小化相对熵(Relative Entropy)

反向传播主要考虑三个方面:

输出层,代价函数的确定及求导 Pooling,数据的下采样及残差的上采样 卷积层,数据的卷积运算及残差的反卷积运算

例:文字识别系统LeNet-5

当年美国大多数银行就是用它来识别支票上面的手写数字的。

Subtracting a low-pass smoothed version of the layer Just another convolution in fact (with fixed coefficients) Lots of variants (per feature map, across feature maps, …)

序列数据建模(modeling sequences)

学习序列数据,常需要转换输入序列到不同领域的输出序列

eg. turn a sequence of sound pressures into a sequence of word identities.

如果没有分离的目标序列,可以通过预测输入序列中的下一 项来得到“教师信号”。

DBM

训练

训练时采用双方向(上下两层) 在训练单层时需同时考虑两个或者 多个隐含层 能量模型与RBM不一样

两层DBM

DBM

Pre-training:

Can (must) initialize from stacked RBMs

Generative fine-tuning:

卷积神经网络是一种特殊的深层神经网络模型

它的神经元间的连接是非全连接的 同一层中某些神经元之间的连接的权重是共享的(即相同的)。

Hubel-Wiesel结构

基于猫的初级视皮层(VI区)的研究。

简单细胞 复杂细胞

两层神经网络模拟初级视皮层中的简单细胞和复杂细胞

每层的神经元被组织成二维平面 “简单细胞”层提取其输入中的局部特征 “复杂细胞”层组合“简单细胞”层中相应的子区域,使得整个网络对局 部变换具有一定的不变性。

It uses methods designed for supervised learning, but it doesn’t require a separate teaching signal.

Recurrent Neural Networks, RNN

Hidden Layer会有连向下一时间 Hidden Layer的边

Empirically, seems to help a bit (1-2%) on ImageNet

CNN改进

非线性变换、池化

(Jarret et al., 2009)

CNNs in the 2010s

Deep Learning的常用模型

—— Recurrent Neural Networks, RNN —— Long Short Term Memory, LSTM

例:NORB dataset

NORB dataset

例:NORB dataset

R. Salskhutdinov

Why Greedy Layer Wise Training Works

Regularization Hypothesis

Pre-training is “constraining” parameters in a region relevant to unsupervised dataset Better generalization

The target output sequence is the input sequence with an advance of 1 step. For temporal sequences there is a natural order for the predictions.

预测序列的下一项,模糊了监督学习与非监督学习的差别

文字识别系统LeNet-5

卷积网络的核心思想:

将局部感受野、权值共享以及时间或空间亚采样这三种结构思想结 合起来获得了某种程度的位移、尺度、形变不变性。

层间联系和空域信息的紧密关系,使其适于图像处理和理解。

图像和网络的拓扑结构能很好的吻合

避免了显式的特征抽取,而隐式地从训练数据中进行学习

所有层间无向连接