Moravec算子特征提取

点特征提取编程实习报告

一.实习简介

本次实习利用VC++6.0编程实现了对8位BMP灰度图像的读取、显示,并用Moravec算子对图像进行点特征的提取。

二.程序设计

1.用MFC创建一个多文档程序框架,用来显示BMP图像:

2.为该程序框架添加菜单:

3.创建一个对话框输入参数:

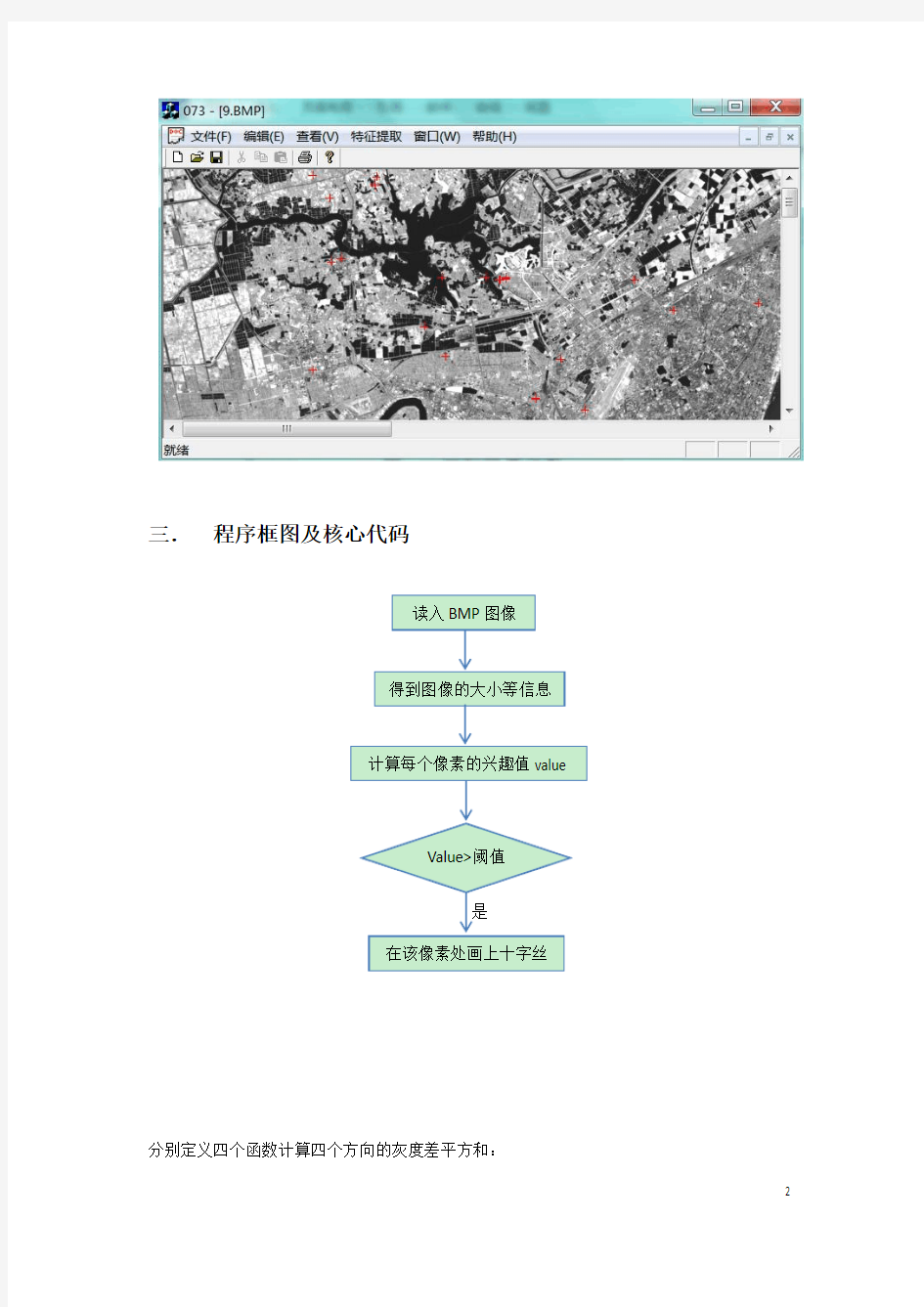

4.最后提取结果可以显示在视图中:

三.程序框图及核心代码Array

分别定义四个函数计算四个方向的灰度差平方和:

提取特征点:

实验结果分析

1、下图中阈值为8000,窗口大小从上到下从左到右分别为9*9、7*7、5*5、3*3。可

以看出随着窗口的增大,提取到的特征点个数越来越少,但是精度提高,可以防止将噪声提取出来。

2、下图中窗口大小为9,阈值从左到右从上到下分别为20000、15000、10000、5000。

可以看出,随着阈值的增大,能投提取到的特征点越来越少,只有灰度变化十分剧烈的点才能被提取出来,如下图中左上角是阈值为20000时的提取结果,可以发现没有提取出任何特征点。。

实习总结

Moravec 算子是点特征提取算子中的经典算子之一,它具有计算量小, 不丢失灰度信息等优点。用该算子提取特征点时阈值的选取直接影响着提取结果。如本次实习过程中所用的图像是武汉地区的TM影像,这幅影像的灰度范围很小,所以阈值不宜取得过大,否则会丢失很多特征点,如:当阈值选为20000时,没有提取出任何特征点。为了验证对比度对特征点提取的影响,我用Photoshop对图像做了一个对比度的增强,之后用5*5的窗口和10000的阈值对其进行特征点的提取并与原图像的提取结果做了对比,发现增强了对比度的图像中提取出的特

征点确实比原图像中的特征点多,如下图:

所以,虽然Moravec算子是点特征提取的经典算子,但是提取效果还是很大程度上受参数设置的影响,不同灰度范围的图像需要不同的阈值以及不同的窗口大小,这需要长久的实验来积累经验确定参数。或者可以通过计算整幅图像的

灰度均值的方法是程序自动确定阈值,但没有再本次实习中进行实验。

文本分类综述

山西大学研究生学位课程论文(2014 ---- 2015 学年第 2 学期) 学院(中心、所):计算机与信息技术学院 专业名称:计算机应用技术 课程名称:自然语言处理技术 论文题目:文本分类综述 授课教师(职称):王素格(教授) 研究生姓名:刘杰飞 年级:2014级 学号:201422403003 成绩: 评阅日期: 山西大学研究生学院 2015年 6 月2日

文本分类综述 摘要文本分类就是在给定的分类体系下,让计算机根据给定文本的内容,将其判别为事先确定的若干个文本类别中的某一类或某几类的过程。文本分类在冗余过滤、组织管理、智能检索、信息过滤、元数据提取、构建索引、歧义消解、文本过滤等方面有很重要的应用。本文主要介绍文本分类的研究背景,跟踪国内外文本分类技术研究动态。介绍目前文本分类过程中的一些关键技术,以及流形学习在文本分类中降维的一些应用。并且讨论目前文本分类研究面临的一些问题,及对未来发展方向的一些展望。 关键词文本分类;特征选择;分类器;中文信息处理 1.引言 上世纪九十年代以来,因特网以惊人的速度发展起来,到现在我们进入大数据时代互联网容纳了海量的各种类型的数据和信息,包括文本、声音、图像等。这里所指的文本可以是媒体新闻、科技、报告、电子邮件、技术专利、网页、书籍或其中的一部分。文本数据与声音和图像数据相比,占用网络资源少,更容易上传和下载,这使得网络资源中的大部分是以文本(超文本)形式出现的。如何有效地组织和管理这些信息,并快速、准确、全面地从中找到用户所需要的信息是当前信息科学和技术领域面临的一大挑战。基于机器学习的文本分类系统作为处理和组织大量文本数据的关键技术,能够在给定的分类模型下,根据文本的内容自动对文本分门别类,从而更好地帮助人们组织文本、挖掘文本信息,方便用户准确地定位所需的信息和分流信息。 利用文本分类技术可以把数量巨大但缺乏结构的文本数据组织成规范的文本数据,帮助人们提高信息检索的效率。通过对文本信息进行基于内容的分类,自动生成便于用户使用的文本分类系统,从而可以大大降低组织整理文档耗费的人力资源,帮助用户快速找到所需信息。因此文本分类技术得到日益广泛的关注,成为信息处理领域最重要的研究方向之一。 2.文本分类技术的发展历史及现状 2.1文本分类技术发展历史 国外自动分类研究始于1950年代末,早期文本分类主要是基于知识工程,通过手工定义一些规则来对文本进行分类,这种方法费时费力,还需要对某一领域有足够的了解,才能提炼出合适的规则。H.P.Luhn在这一领域进行了开创性的研究,他将词频统计的思想用于文本分类中。这一时期,主要是分类理论的研究,并将文本分类应用用于信息检索。在这一段时期,提出了很多经典文本分类的数学模型。比如1960年Maron在Journal of ASM上发表了有关自动分类的第一篇论文“On relevance Probabilitic indexing and informarion retriral”,这是Maron和Kuhns提出概的率标引(Probabilitic indexing )模型在信息检

特征选择与特征提取

模式类别的可分性判据 在讨论特征选择和特征压缩之前,我们先要确定一个选择和提取的原则。对一个原始特征来说,特征选择的方案很多,从N 维特征种 选择出M 个特征共有()!!! M N N C M N M = -中选法,其中哪一种方案最佳, 则需要有一个原则来进行指导。同样,特征的压缩实际上是要找到M 个N 元函数,N 元函数的数量是不可数的,这也要有一个原则来指导找出M 个最佳的N 元函数。 我们进行特征选择和特征提取的最终目的还是要进行识别,因此应该是以对识别最有利原则,这样的原则我们称为是类别的可分性判据。用这样的可分性判据可以度量当前特征维数下类别样本的可分性。可分性越大,对识别越有利,可分性越小,对识别越不利。 人们对的特征的可分性判据研究很多,然而到目前为止还没有取得一个完全满意的结果,没有哪一个判据能够完全度量出类别的可分性。下面介绍几种常用的判据,我们需要根据实际问题,从中选择出一种。 一般来说,我们希望可分性判据满足以下几个条件: 1. 与识别的错误率由直接的联系,当判据取最大值时,识别的错误率最小; 2. 当特征独立时有可加性,即: ()()121 ,,,N ij N ij k k J x x x J x ==∑

ij J 是第i 类和第j 类的可分性判据,ij J 越大,两类的可分程度 越大,()12,,,N x x x 为N 维特征; 3. 应具有某种距离的特点: 0ij J >,当i j ≠时; 0 ij J =,当i j =时; ij ji J J =; 4. 单调性,加入新的特征后,判据不减小: ()()12121,,,,,,,ij N ij N N J x x x J x x x x +≤ 。 但是遗憾的是现在所经常使用的各种判据很难满足上述全部条件,只能满足一个或几个条件。 基于矩阵形式的可分性判据 1. 类内散度矩阵 设有M 个类别,1,,M ΩΩ ,i Ω类样本集()()(){}12,,,i i i i N X X X ,i Ω类 的散度矩阵定义为: () ()() ( )()() ( ) 1 1i N T i i i i i w k k k i S N == --∑X m X m 总的类内散度矩阵为: ()() ()() () ()() () () 1 1 1 1 i N M M T i i i i i w i w i k k i i k i S P S P N ==== Ω= Ω--∑∑∑X m X m 2. 类间散度矩阵 第i 个类别和第j 个类别之间的散度矩阵定义为: () () () ( )() () ( ) T ij i j i j B S =--m m m m 总的类间散度矩阵可以定义为:

微机故障常见的检测方法与处理方法

平时常见的微机故障现象中,有很多并不是真正的硬件故障,而是由于某些设置或系统特性不为人知而造成的假故障现象。认识下面的微机假故障现象有利于快速地确认故障原因,避免不必要的故障检索工作。 1、电源插座、开关很多外围设备都是独立供电的,运行微机时只打开计算机主机电源是不够的。例如:显示器电源开关未打开,会造成“黑屏”和“死机”的假象;外置式MODEM电源开关未打开或电源插头未插好则不能拨号、上网、传送文件,甚至连MODEM都不能被识别。打印机、扫描仪等都是独立供电设备,碰到独立供电的外设故障现象时,首先应检查设备电源是否正常、电源插头/插座是否接触良好、电源开关是否打开。 2、连线问题外设跟计算机之间是通过数据线连接的,数据线脱落、接触不良均会导致该外设工作异常。如:显示器接头松动会导致屏幕偏色、无显示等故障;又如:打印机放在计算机旁并不意味着打印机连接到了计算机上,应亲自检查各设备间的线缆连接是否正确。 3、设置问题例如:显示器无显示很可能是行频调乱、宽度被压缩,甚至只是亮度被调至最暗;音箱放不出声音也许只是音量开关被关掉;硬盘不被识别也许只是主、从盘跳线位置不对……。详细了解该外设的设置情况,并动手试一下,有助于发现一些原本以为非更换零件才能解决的问题。 4、系统新特性很多“故障”现象其实是硬件设备或操作系统的新特性。如:带节能功能的主机,在间隔一段时间无人使用计算机或无程序运行后会自动关闭显示器、硬盘的电源,在你敲一下键盘后就能恢复正常。如果你不知道这一特征,就可能会认为显示器、硬盘出了毛病。再如Windows、NC的屏幕保护程序常让人误以为病毒发作……多了解微机、外设、应用软件的新特性、多向专家请教,有助于增加知识、减少无谓的恐慌。 \[] 5、其它易疏忽的地方 CD-ROM的读盘错误也许只是你无意中将光盘正、反面放倒了;软盘不能写入也许只是写保护滑到了“只读”的位置。发生了故障,首先应先判断自身操作是否有疏忽之处,而不要盲目断言某设备出了问题。 微机故障常见的检测方法

基于机器学习的文本分类方法

基于机器学习算法的文本分类方法综述 摘要:文本分类是机器学习领域新的研究热点。基于机器学习算法的文本分类方法比传统的文本分类方法优势明显。本文综述了现有的基于机器学习的文本分类方法,讨论了各种方法的优缺点,并指出了文本分类方法未来可能的发展趋势。 1.引言 随着计算机技术、数据库技术,网络技术的飞速发展,Internet的广泛应用,信息交换越来越方便,各个领域都不断产生海量数据,使得互联网数据及资源呈现海量特征,尤其是海量的文本数据。如何利用海量数据挖掘出有用的信息和知识,方便人们的查阅和应用,已经成为一个日趋重要的问题。因此,基于文本内容的信息检索和数据挖掘逐渐成为备受关注的领域。文本分类(text categorization,TC)技术是信息检索和文本挖掘的重要基础技术,其作用是根据文本的某些特征,在预先给定的类别标记(label)集合下,根据文本内容判定它的类别。传统的文本分类模式是基于知识工程和专家系统的,在灵活性和分类效果上都有很大的缺陷。例如卡内基集团为路透社开发的Construe专家系统就是采用知识工程方法构造的一个著名的文本分类系统,但该系统的开发工作量达到了10个人年,当需要进行信息更新时,维护非常困难。因此,知识工程方法已不适用于日益复杂的海量数据文本分类系统需求[1]。20世纪90年代以来,机器学习的分类算法有了日新月异的发展,很多分类器模型逐步被应用到文本分类之中,比如支持向量机(SVM,Support Vector Machine)[2-4]、最近邻法(Nearest Neighbor)[5]、决策树(Decision tree)[6]、朴素贝叶斯(Naive Bayes)[7]等。逐渐成熟的基于机器学习的文本分类方法,更注重分类器的模型自动挖掘和生成及动态优化能力,在分类效果和灵活性上都比之前基于知识工程和专家系统的文本分类模式有所突破,取得了很好的分类效果。 本文主要综述基于机器学习算法的文本分类方法。首先对文本分类问题进行概述,阐述文本分类的一般流程以及文本表述、特征选择方面的方法,然后具体研究基于及其学习的文本分类的典型方法,最后指出该领域的研究发展趋势。 2.文本自动分类概述 文本自动分类可简单定义为:给定分类体系后,根据文本内容自动确定文本关联的类别。从数学角度来看,文本分类是一个映射过程,该映射可以是一一映射,也可以是一对多映射过程。文本分类的映射规则是,系统根据已知类别中若干样本的数据信息总结出分类的规律性,建立类别判别公式或判别规则。当遇到新文本时,根据总结出的类别判别规则确定文本所属的类别。也就是说自动文本分类通过监督学习自动构建出分类器,从而实现对新的给定文本的自动归类。文本自动分类一般包括文本表达、特征选取、分类器的选择与训练、分类等几个步骤,其中文本表达和特征选取是文本分类的基础技术,而分类器的选择与训练则是文本自动分类技术的重点,基于机器学习的文本分来就是通过将机器学习领域的分类算法用于文本分类中来[8]。图1是文本自动分类的一般流程。

文本分类中的特征提取和分类算法综述

文本分类中的特征提取和分类算法综述 摘要:文本分类是信息检索和过滤过程中的一项关键技术,其任务是对未知类别的文档进行自动处理,判别它们所属于的预定义类别集合中的类别。本文主要对文本分类中所涉及的特征选择和分类算法进行了论述,并通过实验的方法进行了深入的研究。 采用kNN和Naive Bayes分类算法对已有的经典征选择方法的性能作了测试,并将分类结果进行对比,使用查全率、查准率、F1值等多项评估指标对实验结果进行综合性评价分析.最终,揭示特征选择方法的选择对分类速度及分类精度的影响。 关键字:文本分类特征选择分类算法 A Review For Feature Selection And Classification Algorithm In Text Categorization Abstract:Text categorization is a key technology in the process of information retrieval and filtering,whose task is to process automatically the unknown categories of documents and distinguish the labels they belong to in the set of predefined categories. This paper mainly discuss the feature selection and classification algorithm in text categorization, and make deep research via experiment. kNN and Native Bayes classification algorithm have been applied to test the performance of classical feature detection methods, and the classification results based on classical feature detection methods have been made a comparison. The results have been made a comprehensive evaluation analysis by assessment indicators, such as precision, recall, F1. In the end, the influence feature selection methods have made on classification speed and accuracy have been revealed. Keywords:Text categorization Feature selection Classification algorithm

基于特征值提取文本分类方案

目录 一、综述 (2) (一)实现目标 (2) (二)主要功能 (2) 二、总体架构 (3) 三、各模块建模挖掘层详解 (4) (一)无监督学习模块.............................................. 错误!未定义书签。 (二)有监督学习模块.............................................. 错误!未定义书签。 四、输入层和输出层详解 (6) (一)输入层 (6) (二)输出层 (6)

基于特征值提取文本分类设计方案 一、综述 (一)实现目标 本模块实现了对文本文档集合的分类特征值提取。对输入的分类文档,基于词频、互信息、类别信息的综合特征,从每个分类中挖掘出对应的有效特征值。 该模块还实现了对特征值的权重计算,按照特征词的权重值,构造了分类器。新增文本可以通过文本分类器进行分类,无法分类的文本可以人工分类后重新执行特征值抽取功能,重新调整特征值,从而达到优化分类器的目的。 该模块由Java编写,可用于任何需要挖掘文本主题的项目中,也可以单独使用。 (二)主要功能 该模块的主要功能包括以下几个方面: ●对原始语料库进行中文分词、去除停用词 ●词性过滤,只提取名词,动词 ●按类别进行特征词提取 ●特征词权重计算 ●文本分类

二、总体架构

三、挖掘层详解 1.文本分词 中文分词采用开源的Ansj分词工具,基于中科院的ictclas 中文分词算法,采用隐马尔科夫模型(HMM),比其他常用的开源分词工具(如mmseg4j)的分词准确率更高。Ansj是一款纯Java的、主要应用于自然语言处理的、高精度的分词工具,目标是“准确、高效、自由地进行中文分词”,可用于人名识别、地名识别、组织机构名识别、多级词性标注、关键词提取、指纹提取等领域,支持行业词典、用户自定义词典。 Ansj实现了用户自定义词典的动态添加删除,当然,也支持从文件加载词典。用户自定义词典默认路径:项目目录/library/userLibrary/userLibrary.dic。格式为:[自定义词] [词性] [词频],其中[词性]和[词频]两项可以空缺不写。本项目在Ansj原本自带的词典(367425条)基础上,扩展了以下词典: 1)从数据库中抽取的电信业务词库(5767条) 2)广深东佛城市信息精选词库(来源:搜狗细胞词库)(62617条) 3)搜狗标准词库(392778条) 4)搜狗精选词库(392507条) 5)搜狗万能词库(362333条) 本模块还提供了从数据库加载词库的功能。目前整理了以下的数据库版本的词库: 1)公积金领域词(1332条) 2)医保领域词(2503条) 2.词性过滤 代词、连词、介词等的表征能力比较弱,因为一篇文本中的代词、连词或介词对于区分这个文本所属哪个领域几乎没什么参考价值。为此可以将表征能力很差的词性的词过滤掉。而名词和动词的表征能力最强,它们是文本中具有代表性的关键词项,因为大量的汉语知识表明,名词和动词是一个汉语句子中的核心部分,它们的简单组合,往往就可以表达出一种中心思想,一种主题。因此,我们只保留名词和动词,将其他词性的词作为弱词性词过滤掉。

主要电力设备故障图像特征及识别方法研究改

摘要 摘要内容 伴随着我国电网规模的日益加大,各类变电设备的运作状态是促使其安全高效运行的最为主要的因素之一。对于各类变电设备的在线状态监测系统的推广越来越发普及。研究基于图像特征的电力设备自动故障识别具有重要意义。 本文对各类主要电力设备,研究各类变电设备故障识别分类及相应故障的图像特征,以及基于红外与紫外图像特征的故障识别方法。对于紫外放电成像技术图像的处理与特征提取,本文从紫外成像技术的基本原理出发,在讲解紫外放电图片特性的基础上,对紫外放电图像使用灰度化预处理,以及应用中值滤波等方法对图像进行降噪。并通过canny算子边缘检测计算紫外光斑面积判断是否发生放电故障。针对红外故障图像,本文在红外成像原理的基础上,对红外图像进行超像素分割及HSV空间颜色提取,对应用卷积神经网络对红外故障图像故障区域检测进行理论上的研究。 关键词:红外成像紫外成像图像处理

ABSTRACT With the increasing scale of China's power grid, the operation of various types of substation equipment is one of the most important factors to promote the safe and efficient operation. The popularization of the on-line condition monitoring system for all kinds of transformer equipment is becoming more and more popular. Research on image feature based automatic fault recognition of power equipment is of great significance. In this paper, various types of main power equipment, the study of various types of substation equipment fault identification and classification of image features, as well as infrared and ultraviolet image features based on fault identification method. For ultraviolet discharge imaging technique to image processing and feature extraction, this paper from the basic principle of UV imaging technology of on the explanation of the ultraviolet discharge picture characteristics based and discharge on the UV image using grayscale preprocessing and application of median filtering method of image in noise reduction. And through the Canny operator edge detection to determine whether the area of the UV spot to determine whether the discharge fault. Aiming at the

利用sklearn做文本分类(特征提取、knnsvm聚类)

利用sklearn做文本分类(特征提取、knnsvm聚类) 数据挖掘入门与实战公众号:datadw 分为以下几个过程: 加载数据集 提feature 分类 Naive Bayes KNN SVM聚类 20newsgroups官网 https://www.360docs.net/doc/743659015.html,/~jason/20Newsgroups/ 上给出了3个数据集,这里我们用最原始的 20news-19997.tar.gz https://www.360docs.net/doc/743659015.html,/~jason/20Newsgroups/20news-19997.ta r.gz 1.加载数据集 从20news-19997.tar.gz下载数据集,解压到 scikit_learn_data文件夹下,加载数据,详见code注释。

[python]view plaincopy #first extract the 20 news_group dataset to /scikit_learn_data fromsklearn.datasets importfetch_20newsgroups #all categories #newsgroup_train = fetch_20newsgroups(subset='train') #part categories categories = ['comp.graphics', 'comp.os.ms-windows.misc', 'comp.sys.ibm.pc.hardware', 'comp.sys.mac.hardware', 'comp.windows.x']; newsgroup_train = fetch_20newsgroups(subset = 'train',categories = categories); 可以检验是否load好了: [python]view plaincopy #print category names frompprint importpprint pprint(list(newsgroup_train.target_names))

故障特征提取的方法研究(1)解析

故障特征提取的方法研究(1) 摘要:针对常规特征提取方法存在 着问题不足,提出了基于BP神经网络和基于互信息熵的特征提取方法,并通过特征提取实例加以说明。结果表明这两种方法是可行和有效的。 关键词:特征提取故障诊断神经网络互信息熵 随着科学技术的发展,现代设备的结构日趋复杂,其故障类型越来越多,反映故障的状态、特征也相应增加。在实际故障诊断过程中,为了使诊断准确可靠,总要采集尽可能多的样本,以获得足够的故障信息。但样本太多,会占用大量的存储空间和计算时间,太多的特征输入也会引起训练过程耗时费工,甚至妨碍训练网络的收敛,最终影响分类精度。因此要从样本中提取对诊断故障贡献大的有用信息。这一工作就是特征提取。 特征提取就是利用已有特征参数构造一个较低维数的特征空间,将原始特征中蕴含的有用信息映射到少数几个特征上,忽略多余的不相干信息。从数学意义上讲,就是对一个n维向量X=[x1,x2,…,xn]T进行降维,变换为低维向量Y=[y1,y2,…,ym]T,m 文本特征提取方法研究 ______________________________________________________ 一、课题背景概述 文本挖掘是一门交叉性学科,涉及数据挖掘、机器学习、模式识别、人工智能、统计学、计算机语言学、计算机网络技术、信息学等多个领域。文本挖掘就是从大量的文档中发现隐含知识和模式的一种方法和工具,它从数据挖掘发展而来,但与传统的数据挖掘又有许多不同。文本挖掘的对象是海量、异构、分布的文档(web);文档内容是人类所使用的自然语言,缺乏计算机可理解的语义。传统数据挖掘所处理的数据是结构化的,而文档(web)都是半结构或无结构的。所以,文本挖掘面临的首要问题是如何在计算机中合理地表示文本,使之既要包含足够的信息以反映文本的特征,又不至于过于复杂使学习算法无法处理。在浩如烟海的网络信息中,80%的信息是以文本的形式存放的,WEB文本挖掘是WEB内容挖掘的一种重要形式。 文本的表示及其特征项的选取是文本挖掘、信息检索的一个基本问题,它把从文本中抽取出的特征词进行量化来表示文本信息。将它们从一个无结构的原始文本转化为结构化的计算机可以识别处理的信息,即对文本进行科学的抽象,建立它的数学模型,用以描述和代替文本。使计算机能够通过对这种模型的计算和操作来实现对文本的识别。由于文本是非结构化的数据,要想从大量的文本中挖掘有用的信息就必须首先将文本转化为可处理的结构化形式。目前人们通常采用向量空间模型来描述文本向量,但是如果直接用分词算法和词频统计方法得到的特征项来表示文本向量中的各个维,那么这个向量的维度将是非常的大。这种未经处理的文本矢量不仅给后续工作带来巨大的计算开销,使整个处理过程的效率非常低下,而且会损害分类、聚类算法的精确性,从而使所得到的结果很难令人满意。因此,必须对文本向量做进一步净化处理,在保证原文含义的基础上,找出对文本特征类别最具代表性的文本特征。为了解决这个问题,最有效的办法就是通过特征选择来降维。 目前有关文本表示的研究主要集中于文本表示模型的选择和特征词选择算法的选取上。用于表示文本的基本单位通常称为文本的特征或特征项。特征项必须具备一定的特性:1)特征项要能够确实标识文本内容;2)特征项具有将目标文本与其他文本相区分的能力;3)特征项的个数不能太多;4)特征项分离要比较容易实现。 在中文文本中可以采用字、词或短语作为表示文本的特征项。相比较而言,词比字具有更强的表达能力,而词和短语相比,词的切分难度比短语的切分难度小得多。因此,目前大多数中文文本分类系统都采用词作为特征项,称作特征词。这些特征词作为文档的中间表示形式,用来实现文档与文档、文档与用户目标之间的相似度计算。如果把所有的词都作为特征项,那么特征向量的维数将过于巨大,从而导致计算量太大,在这样的情况下,要完成文本分类几乎是不可能的。特征抽取的主要功能是在不损伤文本核心信息的情况下尽量减少要处理的单词数,以此来降低向量空间维数,从而简化计算,提高文本处理的速度和效率。文本特征选择对文本内容的过滤和分类、聚类处理、自动摘要以及用户兴趣模式发现、知识发现等有关方面的研究都有非常重要的影响。通常根据某个特征评估函数计算各个特征的评分值,然后按评分值对这些特征进行排序,选取若干个评分 故障特征提取的方法研究 2008-01-20 摘要:针对常规特征提取方法存在着问题不足,提出了基于BP神经网络和基于互信息熵的特征提取方法,并通过特征提取实例加以说明。结果表明这两种方法是可行和有效的。 关键词:特征提取故障诊断神经网络互信息熵 随着科学技术的发展,现代设备的结构日趋复杂,其故障类型越来越多,反映故障的状态、特征也相应增加。在实际故障诊断过程中,为了使诊断准确可靠,总要采集尽可能多的样本,以获得足够的故障信息。但样本太多,会占用大量的存储空间和计算时间,太多的特征输入也会引起训练过程耗时费工,甚至妨碍训练网络的收敛,最终影响分类精度。因此要从样本中提取对诊断故障贡献大的有用信息。这一工作就是特征提取。 特征提取就是利用已有特征参数构造一个较低维数的特征空间,将原始特征中蕴含的有用信息映射到少数几个特征上,忽略多余的不相干信息。从数学意义上讲,就是对一个n维向量X=[x1,x2,…,xn]T进行降维,变换为低维向量Y=[y1,y2,…,ym]T,m 文本特征提取以及分类结果分析 一、目标: 提取文本中的关键信息,用于文本的自动分类。 二、要求: a)编写特征提取程序,从训练语料中根据IG,MI,CHI或CE等指标,分别提取文 本特征词集。 b)编写文本特征向量生成程序,根据得到的文本特征词集,生成任意文档的权值特征 向量。为其它设计分类器的同学提供训练文档和测试文档的特征向量集。 c)编写统计程序,对其它同学的分类结果进行统计和分析,包括准确率(Precision)和 找回率(Recall),以及综合指标(F-Measure=…)。 三、文本特征提取原理 文本特征提取是进行文本分类训练和识别的基础。其基本思路是基于向量空间面向(VSM――Vector Space Modal),即把一篇文本视为N为空间中的一个点。点的各维数据表示该文档的一个特征(数字化的特征)。而文档的特征一般采用关键词集,即根据一组预定义的关键词,以某种方法计算这些关键词在当前文档中的权重,然后用这些权重形成一个数字向量,这就是该文档的特征向量。 由上面的简介可知,这里有两个方面的问题:(1)如何定义“关键词集”(或称为“特征词集”);(2)如何就是某个关键词在一篇文本中的权重。 1.提取关键词集 首先,我们提取关键词的最终目的是为了对文本进行分类。一些词,如“的”,对应文本分类不可能有任何帮助;或者,“计算机”一词对进行“台独类”和“成人类”文章的分类也没有任何帮助。因此,关键词集是与分类目标相关的。从上面的例子可以想象,在提取关键词集中有两个步骤: d)筛选关键词的各种方法 根据词汇与预定义分类文本的相关程度来筛选关键词。使用一个训练文档集(其中各文档的分类已经由人工指定),通过计算其中词汇与文档分类的相关程度,选择相关程度高的词汇作为表达文档特征的关键词。 词汇与文档分类相关度的计算有多种方式。 1)词频(TF-Term Frequency): 该思路很简单:如果词汇w在Ci类文本中出现的频率很高,就用它作为一个关键词: 文本分类的过程: (1) 选择训练文本。好的训练文本对分类器的最终结果起到至关重要的作用。 (2) 选择文本特征。 对训练样本和测试样本进行数据预处理,包括分词、去停用词、 消除噪音等。目前的文本分类研究,主要选取一些具有代表性的词、词组、短语来表示文本。 (3) 建立文本表示模型。 为了便于计算机理解和计算相关的文本属性,需要对文本 进行表示,其中向量空间模型(Vector Space Model VSM)运用最为广泛。 (4) 选择分类方法。 文本分类的核心部分,不同的分类方法原理不同需要处理的数 据也不同。经典分类算法有朴素贝叶斯(Naive Bayes NB)、K-近邻(K-Nearest Neighbor KNN)、决策树(Decision Tree DTree)、算数平均质心(Arithmetical Average Centroid AAC)、支持向量机(Support Vector Machine SVM)。 (5) 分类结果的评估。 目前主流的评估标准准确率、召回率和F1值。 选择文本特征 我们需要将文档转换为计算机可以衡量、运算的形式。现在运用最广泛的形式:将文档映射入向量空间。具体流程如图1。 这样就将一篇文章映射成了为了向量空间中的一个向量。在把文章都映射完成后,我们可以根据自己不同的需求,在向量空间中进行运算。比如计算两篇文章的相似度:我们把向量的起点都映射到原点,则我们可以比较向量的长度、向量的夹角、向量两个终点的距离等等;我们还可以宏观的观察大量的向量在向量空间中的分布情况,对大量聚集在一起的向量抽取它们的共性:计算他们的中心、他们整体的方向等。其实数学模型很好,只不过限于计算机的存储、运算水平,向量空间的维度过高、文档数量过大、计算复杂度过高会使得模型的计算机实现变得困难,我们不得不进行简化:向量空间维度降低、较低复杂度的计算分析方法等等。而根据简化的合理程度,影响我们得到的结果质量。 文本分类论文:中文文本情感分类的研究 【中文摘要】文本情感分类是指通过挖掘和分析文本中的立场、观点、情绪等主观信息,对文本的情感倾向做出类别判断。随着人们在Web中表达自己观点这一现象越来越普遍,针对文本情感分类的研究也显得越来越重要。文本情感分类的关键技术有网页文本内容提取、文本表示(向量空间模型、布尔模型、概率模型)、特征提取(文档频率、卡方统计、互信息、信息增益、期望交叉熵、文本证据权)以及文本分类器(贝叶斯分类器、支持向量机、KNN、神经网络)。本文的主要研究内容和工作包括以下几个方面:(1)实现了网页文本提取技术,并对文本预处理技术进行了研究。在研究从Web服务器获取网页源码技术的基础上,设计了一个正则表达式,以实现网页纯文本 的提取,并设计和实现了向量空间模型表示文本的预处理方法。(2) 设计并实现了基于情感词典的情感句识别算法和基于朴素贝叶斯的 情感句识别算法来进行文本情感主观性分类:前者经过文本预处理、文本表示,通过与情感词典的比对得到主观句集和客观句集;而后者经过文本预处理、文本表示、提取特征,最后利用朴素贝叶斯分类模型得到主观句集和客观句集。实验表明,基于情感词典的情感句识别算法的分类效果要优于基于朴素贝叶斯的情感句识别... 【英文摘要】Text sentiment classification is automatically classifying sentiment of text by mining and analyzing subjective information in the text, such as standpoint, view, 脑电信号特征提取及分类 第 1 章绪论 1.1引言 大脑又称端脑,是脊椎动物脑的高级的主要部分,由左右两半球组成及连接两个半球的中间部分,即第三脑室前端的终板组成。它是控制运动、产生感觉及实现高级脑功能的高级神经中枢[1]。大脑是人的身体中高级神经活动中枢,控制着人体这个复杂而精密的系统,对人脑神经机制及高级功能进行多层次、多学科的综合研究已经成为当代脑科学发展的热点方向之一。 人的思维、语言、感知和运动能力都是通过大脑对人体器官和相应肌肉群的有效控制来实现的[2]。人的大脑由大约1011个互相连接的单元体组成,其中每个单元体有大约104个连接,这些单元体称做神经元。在生物学中,神经元是由三个部分组成:树突、轴突和细胞体。神经元的树突和其他神经元的轴突相连,连接部分称为突触。神经元之间的信号传递就是通过这些突触进行的。生物电信号的本质是离子跨膜流动而不是电子的流动。每有一个足够大的刺激去极化神经元细胞时,可以记录到一个持续1-2ERP的沿轴突波形传导的峰形电位-动作电位。动作电位上升到顶端后开始下降,产生一些小的超极化波动后恢复到静息电位(静息电位(Resting Potential,RP)是指细胞未受刺激时,存在于细胞膜内外两侧的外正内负的电位差)。人的神经细胞的静息电位为-70mV(就是膜内比膜外电位低70mV)。这个变化过程的电位是局部电位。局部电位是神经系统分析整合信息的基础。细胞膜的电特性决定着神经元的电活动[3]。当神经元受到外界刺激时,神经细胞膜内外两侧的电位差被降低从而提高了膜的兴奋性,当兴奋性超过特定阈值时就会产生神经冲动或兴奋,神经冲动或兴奋通过突触传递给下一个神经元。由上述可知,膜电位是神经组织实现正常功能的基本条件,是兴奋产生的本质。膜电位使神经元能够接收刺激信号并将这一刺激信号沿神经束传递下去。在神经元内部,树突的外形就像树根一样发散,由很多细小的神经纤维丝组成,可以接收电信号,然后传递给细胞体。如果说树突是树根的话,那么细胞体就是树桩,对树突传递进来的信号进行处理,如果信号超过特定的阈值,细胞体就把信号继续传递给轴突。轴突的形状像树干,是一根细长的纤维体,它把细胞体传递过来的信号通过突触发送给相邻神经元的树突。突触的连接强度和神经元的排列方式都影响着神经组织的输出结果。而正是这种错综复杂的神经组织结构和复杂的信息处理机制,才使得人脑拥有高度的智慧。我们的大脑无时无刻不在产生着脑电波,对脑来说,脑细胞就像是脑内一个个“微小的发电站”。早在1857年,英国的青年生理科学工作者卡通(R.Caton)就在猴脑和兔脑上记录 基于特征值提取文本分类方案 ————————————————————————————————作者:————————————————————————————————日期: 目录 一、综述 (4) (一)实现目标 (4) (二)主要功能 (4) 二、总体架构 (5) 三、各模块建模挖掘层详解 (7) (一)无监督学习模块 .......................................... 错误!未定义书签。 (二)有监督学习模块 .......................................... 错误!未定义书签。 四、输入层和输出层详解 (9) (一)输入层 (9) (二)输出层 (9) 基于特征值提取文本分类设计方案 一、综述 (一)实现目标 本模块实现了对文本文档集合的分类特征值提取。对输入的分类文档,基于词频、互信息、类别信息的综合特征,从每个分类中挖掘出对应的有效特征值。 该模块还实现了对特征值的权重计算,按照特征词的权重值,构造了分类器。新增文本可以通过文本分类器进行分类,无法分类的文本可以人工分类后重新执行特征值抽取功能,重新调整特征值,从而达到优化分类器的目的。 该模块由Java编写,可用于任何需要挖掘文本主题的项目中,也可以单独使用。 (二)主要功能 该模块的主要功能包括以下几个方面: ●对原始语料库进行中文分词、去除停用词 ●词性过滤,只提取名词,动词 ●按类别进行特征词提取 ●特征词权重计算 ●文本分类 二、总体架构 训练数据 预处理词库停用词 词性过滤 综合特征选择 权重计算 主题权重文件输出(主题名,前N 个特征,特征权重) 待分析数 据 预处理 词库停用词 改进贝叶斯的快速文本分类器 分类结果 输入层 数据挖掘层 输出层 第八讲特征提取和特征选择 一、基本概念 1、特征的生成 (1)原始特征的采集和转换 通过对原始特征的信号采集,获得样本的原始表达数据, 从原始数据中选择或计算出对分类任务有用的原始特征,并转换成可用 的形式 原始数据: 像素点RGB值矩阵 可用的原始特征: 轮廓特征 颜色特征 纹理特征 数学特征 (2)有效特征的生成 目的: 降低特征维数,减少信息冗余 提升特征的有效性 方法: 特征提取:提高特征对类别的分辨能力 特征选择:寻找对分类最重要的特征 2、 特征提取 通过某种变换,将原始特征从高维空间映射到低维空间。 A :X →Y ; A 为特征提取器,通常是某种正交变换。 最优特征提取:J(A*)=max J(A), J 是准则函数 3、 特征选择 从一组特征中挑选出一些最有效的特征,以达到降低特征空间维数的目的。 D d d i S y y y y F x x x S i d D <=∈→;,...,2,1,} ,......,,{:},......,,{:2121 原始特征集合S 中包含D 个特征,目标特征集合F 中包含d 个特征; 最优特征选择:J(F*)=max J(F), J 是准则函数 4、 准则函数的选取 (1) 准则函数的选取原则 分类正确率是最佳的特征提取和特征选择准则函数,但难以计算。 实用的类别可分性准则函数应满足以下要求: 与分类正确率有单调递增关系 当特征独立时具有可加性:∑==d k k ij d ij x J x x x J 1 )()...21,, ,( 具有标量测度特性:?? ? ??===≠>ji ij ij ij J J j i J j i J 时 ,当时 ,当00 本科生毕业设计(论文)文献综述题目:人脸特征提取与识别 姓名: 学号: 学院: 专业: 年级: 指导教师:(签名)系主任(或教研室主任):(签章) 目录 1 前言 (1) 2 人脸特征提取与识别方法 (1) 2.1 基于几何特征的方法 (1) 2.2 基于特征脸的方法 (2) 2.3 局部特征分析LFA方法 (3) 2.4 基于弹性模型的方法 (4) 2.5 神经网络方法 (4) 2.6 其他方法 (5) 3 总结 (5) 致谢: (6) 参考文献: (6) 人脸特征提取与识别 1前言 近年来,Internet和多媒体技术飞速发展,多媒体(包括图像、视频等)数据规模急剧膨胀。为了快速、准确地找到感兴趣的图像或视频,人们提出了基于内容的图像检索(content-based image retrieval,简称CBIR)技术,研究让计算机对图像进行分类和检索的算法。CBIR涉及图像内容表示、相似性度量、高维索引技术等方面。[1]图像内容的表示是需要首先解决的问题。为了实现对图像内容的存取、访问和检索,MPEG-7提出了图像内容描述子的概念,例如颜色描述子、纹理描述子、形状描述子等。 图像颜色内容通常用颜色直方图来表示,纹理特征以纹理模式区分图像,形状特征用于包含特定形状对象的图像检索。颜色直方图(或称为颜色谱)因其简单、有效的性能而在大多数CBIR系统中得到应用,但是颜色直方图对纹理图像的检索效果不好。不同的纹理图像可能有非常相似的颜色直方图。 所谓图像纹理,它反映的是图像的一种局部结构化特征,具体表现为图像像素点某邻域内像素点灰度级或者颜色的某种变化,而且这种变化是空间统计相关的,它由纹理基元和基元的排列两个要素构成。纹理分析方法有统计方法、结构方法和基于模型的方法。 2人脸特征提取与识别方法 人脸识别本质上是三维塑性物体二维投影图像的匹配问题,它的困难体现在:(1)人脸塑性变形(如表情等)的不确定性;(2)人脸模式的多样性(如胡须、发型、眼镜、化妆等);(3)图像获取过程中的不确定性(如光照的强度、光源方向等)。识别人脸主要依靠人脸上的特征。也就是说依据那些在不同个体上存在的较大差异而对同一个人则比较稳定的度量。由于人脸变化复杂,因此特征表述和特征提取十分困难。 在对人脸图像进行特征提取和分类之前一般需要做几何归一化和灰度归一化。几何归一化是指根据人脸定位结果将图像中人脸变换到同一位置和同样大小,灰度归一化是指对图像进行光照补偿等处理,光照补偿能够一定程度地克服光照变化的影响而提高识别率。 2.1 基于几何特征的方法 人脸由眼睛、鼻子、嘴巴、下巴等部件构成,正因为这些部件的形状、大小和结构上的各种差异才使得世界上每个人脸干差万别,因此对这些部件的形状和结构关系的几何描述,可以作为人脸识别的重要特征。几何特征最早是用于人脸侧面轮廓的描述与识别,首文本特征提取方法研究

故障特征提取的方法研究.

文本特征提取以及分类结果分析

文本分类的常见方法

文本分类论文:文本分类 特征提取 文本情感分类

脑电信号特征提取及分类

基于特征值提取文本分类实施方案

第八讲 特征提取和特征选择(讲义)

人脸特征提取与识别参考