cephFS存储集群配置以及测试方案

⑨OpenStack高可用集群部署方案—CentOS8安装与配置Ceph集群

⑨OpenStack高可用集群部署方案—CentOS8安装与配置Ceph集群CentOS8安装与配置Ceph Octopus版1. Ceph介绍1.1 为什么要用CephCeph是当前非常流行的开源分布式存储系统,具有高扩展性、高性能、高可靠性等优点,同时提供块存储服务(rbd)、对象存储服务(rgw)以及文件系统存储服务(cephfs),Ceph在存储的时候充分利用存储节点的计算能力,在存储每一个数据时都会通过计算得出该数据的位置,尽量的分布均衡。

目前也是OpenStack的主流后端存储,随着OpenStack在云计算领域的广泛使用,ceph也变得更加炙手可热。

国内目前使用ceph搭建分布式存储系统较为成功的企业有x-sky,深圳元核云,上海UCloud等三家企业。

分布式存储Ceph GFS HDFS Swift Lustre平台属性开源闭源开源开源开源系统架构去中心化架构中心化架构中心化架构去中心化架构中心化架构数据存储方式块、文件对象文件文件对象文件元数据节点数量多个1个1个(主备) 多个1个数据冗余多副本/纠删码多副本/纠删码多副本/纠删码多副本/纠删码无数据一致性强一致性最终一致性过程一致性弱一致性无分块大小4MB 64MB 128MB 视对象大小1MB适用场景频繁读写场景/IaaS 大文件连续读写大数据场景云的对象存储大型集群/超算1.2 Ceph架构介绍Ceph使用RADOS提供对象存储,通过librados封装库提供多种存储方式的文件和对象转换。

外层通过RGW(Object,有原生的API,而且也兼容Swift和S3的API,适合单客户端使用)、RBD(Block,支持精简配置、快照、克隆,适合多客户端有目录结构)、CephFS(File,Posix接口,支持快照,社会和更新变动少的数据,没有目录结构不能直接打开)将数据写入存储。

•高性能 a. 摒弃了传统的集中式存储元数据寻址的方案,采用CRUSH算法,数据分布均衡,并行度高 b.考虑了容灾域的隔离,能够实现各类负载的副本放置规则,例如跨机房、机架感知等 c. 能够支持上千个存储节点的规模,支持TB到PB级的数据•高可扩展性 a. 去中心化 b. 扩展灵活 c. 随着节点增加而线性增长•特性丰富 a. 支持三种存储接口:块存储、文件存储、对象存储 b. 支持自定义接口,支持多种语言驱动目前来说,ceph在开源社区还是比较热门的,但是更多的是应用于云计算的后端存储。

ceph 集群配置案例

ceph 集群配置案例Ceph是一个开源的分布式存储系统,可以提供高可靠性、高性能的存储服务。

在配置Ceph集群时,需要考虑多个因素,包括硬件要求、网络配置、监控和调优等。

下面是一些Ceph集群配置的案例,用于提供参考。

1. 硬件配置:Ceph集群的性能和可靠性与硬件配置密切相关。

一般建议使用性能较高的服务器,包括多核CPU、大内存和高速硬盘。

同时,硬盘的选择也很重要,可以使用SSD来提高性能,使用HDD来降低成本。

此外,还需要考虑网络适配器的类型和带宽,以及RAID控制器的选择等。

2. 网络配置:Ceph集群使用多个节点进行数据复制和数据传输,因此需要进行网络配置来保证高性能和低延迟。

可以使用双网卡进行数据传输和管理网络的隔离,同时使用高带宽的网络设备来提高传输速度。

此外,还可以使用Jumbo Frame来减少网络开销。

3. 存储池配置:Ceph集群使用存储池来管理数据,可以根据不同的需求创建不同的存储池。

例如,可以为不同的应用程序创建独立的存储池,并设置不同的副本数和数据分布策略。

还可以根据数据的访问模式和重要性来设置存储池的性能和可靠性等参数。

4. 数据复制策略:Ceph集群使用数据复制来提高数据的可靠性。

可以根据需求设置数据的副本数,一般建议设置为3个副本。

此外,还可以使用EC编码来替代副本,以减少存储空间的消耗。

5. MON节点配置:Ceph集群需要至少一个MON节点来进行监控和管理。

一般建议使用奇数个MON节点,以提高故障容忍能力。

可以将MON节点部署在独立的服务器上,也可以将其与其他组件部署在同一台服务器上。

6. OSD节点配置:Ceph集群的数据存储和处理由OSD节点负责。

可以根据需求设置OSD节点的数量,一般建议使用多个节点来提高性能和可靠性。

同时,还需要配置OSD节点的存储设备和文件系统等。

7. 安全配置:Ceph集群的数据安全性非常重要,可以通过配置防火墙和访问控制列表来限制网络访问。

Ceph性能测试工具和方法。

Ceph性能测试⼯具和⽅法。

0. 测试环境同⼀⽂中的测试环境。

1. 测试准备1.1 磁盘读写性能1.1.1 单个 OSD 磁盘写性能,⼤概 165MB/s。

root@ceph1:~# echo 3 > /proc/sys/vm/drop_cachesroot@ceph1:~# dd if=/dev/zero of=/var/lib/ceph/osd/ceph-0/deleteme bs=1G count=1 oflag=direct测试发现,其结果变化⾮常⼤,有时候上 75,有时是150.1.1.2 两个OSD同时写性能,⼤概 18 MB/s。

怎么差距那么⼤呢?⼏乎是单个磁盘的 1/10 了。

root@ceph1:~# for i in `mount | grep osd | awk '{print $3}'`; do (dd if=/dev/zero of=$i/deleteme bs=1G count=1 oflag=direct &) ; done1.1.4 单个 OSD 磁盘读性能,⼤概 460 MB/s。

root@ceph1:~# dd if=/var/lib/ceph/osd/ceph-0/deleteme of=/dev/null bs=2G count=1 iflag=direct1.1.5 两个 OSD 同时读性能,⼤概 130 MB/s。

for i in `mount | grep osd | awk '{print $3}'`; do (dd if=$i/deleteme of=/dev/null bs=1G count=1 iflag=direct &); done1.2 ⽹络性能在 ceph1上运⾏ iperf -s -p 6900,在 ceph2 上运⾏ iperf -c ceph1 -p 6900,反复多次,两节点之间的带宽⼤约在 1 Gbits/sec = 128 MB/s。

分布式文件存储CephFS详尽介绍及使用经验

分布式文件存储 CephFS详尽介绍及使用经验1. Ceph架构介绍Ceph是一种为优秀的性能、可靠性和可扩展性而设计的统一的、分布式文件系统。

特点如下:- 高性能a. 摒弃了传统的集中式存储元数据寻址的方案,采用CRUSH算法,数据分布均衡,并行度高。

b.考虑了容灾域的隔离,能够实现各类负载的副本放置规则,例如跨机房、机架感知等。

c. 能够支持上千个存储节点的规模,支持TB到PB级的数据。

- 高可用性a. 副本数可以灵活控制。

b. 支持故障域分隔,数据强一致性。

c. 多种故障场景自动进行修复自愈。

d. 没有单点故障,自动管理。

- 高可扩展性a. 去中心化。

b. 扩展灵活。

c. 随着节点增加而线性增长。

- 特性丰富a. 支持三种存储接口:块存储、文件存储、对象存储。

b. 支持自定义接口,支持多种语言驱动。

使用场景:•块存储 (适合单客户端使用)o典型设备:磁盘阵列,硬盘。

o使用场景:a. docker容器、虚拟机远程挂载磁盘存储分配。

b. 日志存储。

...•文件存储 (适合多客户端有目录结构)o典型设备:FTP、NFS服务器。

o使用场景:a. 日志存储。

b. 多个用户有目录结构的文件存储共享。

...•对象存储 (适合更新变动较少的数据,没有目录结构,不能直接打开/修改文件) o典型设备:s3, swift。

o使用场景:a. 图片存储。

b. 视频存储。

c. 文件。

d. 软件安装包。

e. 归档数据。

...系统架构:Ceph 生态系统架构可以划分为四部分:1.Clients:客户端(数据用户)2.mds:Metadata server cluster,元数据服务器(缓存和同步分布式元数据)3.osd:Object storage cluster,对象存储集群(将数据和元数据作为对象存储,执行其他关键职能)4.mon:Cluster monitors,集群监视器(执行监视功能)2. NFS介绍1. NAS(Network Attached Storage)- 网络存储基于标准网络协议NFSv3/NFSv4实现数据传输。

Red Hat Ceph Storage 4 文件系统指南 配置和挂载 Ceph 文件系统说明书

Red Hat Ceph Storage 4文件系统指南配置和挂载 Ceph 文件系统Last Updated: 2023-08-26Red Hat Ceph Storage 4 文件系统指南配置和挂载 Ceph 文件系统Enter your first name here. Enter your surname here.Enter your organisation's name here. Enter your organisational division here. Enter your email address here.法律通告Copyright © 2022 | You need to change the HOLDER entity in the en-US/File_System_Guide.ent file |.The text of and illustrations in this document are licensed by Red Hat under a Creative Commons Attribution–Share Alike 3.0 Unported license ("CC-BY-SA"). An explanation of CC-BY-SA is available at/licenses/by-sa/3.0/. In accordance with CC-BY-SA, if you distribute this document or an adaptation of it, you must provide the URL for the original version.Red Hat, as the licensor of this document, waives the right to enforce, and agrees not to assert, Section 4d of CC-BY-SA to the fullest extent permitted by applicable law.Red Hat, Red Hat Enterprise Linux, the Shadowman logo, the Red Hat logo, JBoss, OpenShift, Fedora, the Infinity logo, and RHCE are trademarks of Red Hat, Inc., registered in the United States and other countries.Linux ® is the registered trademark of Linus Torvalds in the United States and other countries. Java ® is a registered trademark of Oracle and/or its affiliates.XFS ® is a trademark of Silicon Graphics International Corp. or its subsidiaries in the United States and/or other countries.MySQL ® is a registered trademark of MySQL AB in the United States, the European Union and other countries.Node.js ® is an official trademark of Joyent. Red Hat is not formally related to or endorsed by the official Joyent Node.js open source or commercial project.The OpenStack ® Word Mark and OpenStack logo are either registered trademarks/service marks or trademarks/service marks of the OpenStack Foundation, in the United States and other countries and are used with the OpenStack Foundation's permission. We are not affiliated with, endorsed or sponsored by the OpenStack Foundation, or the OpenStack community.All other trademarks are the property of their respective owners.摘要本指南说明了如何配置 Ceph 元数据服务器(MDS),以及如何创建、挂载和使用 Ceph 文件系统(CephFS)。

5.6、ceph集群添加和删除OSD

5.6、ceph集群添加和删除OSD4 添加和删除OSD新加节点 hostname: ceph-node04 IP: 172.16.1.34 OS: CentOS7.5 Cpu/Memory: 2vcpu/2GB disk /: 60GB4.1 添加OSD1 在新创建的 172.16.1.34 节点上新增加两块未使⽤的硬盘"/dev/sdb(20GB)、/dev/sdc(20GB)"。

[root@ceph-node04 ~]# lsblkNAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTsda 8:0 0 60G 0 disk├─sda1 8:1 0 200M 0 part /boot├─sda2 8:2 0 2G 0 part└─sda3 8:3 0 57.8G 0 part /sdb 8:16 0 20G 0 disksdc 8:32 0 20G 0 disksr0 11:0 1 1024M 0 rom2 在 ceph-deploy 节点上添加 ceph-node04 节点的 hosts 解析[root@ceph-deploy my-cluster]# echo "172.16.1.34 ceph-node04" >> /etc/hosts3 在 ceph-deploy 节点上分发秘钥到 ceph-node04 节点上(1) 分发秘钥[root@ceph-deploy my-cluster]# ssh-copy-id root@ceph-node04(2) 检查秘钥是否分发成功[root@ceph-deploy my-cluster]# ssh root@ceph-node04[root@ceph-node04 ~]# exit4 在 ceph-node04 节点上配置阿⾥云 yum 源(1) 配置 ceph 源[root@ceph-node04 ~]# cat > /etc/yum.repos.d/ceph.repo << EOF[Ceph]name=Ceph packages for $basearchbaseurl=/ceph/rpm-octopus/el7/\$basearchgpgcheck=0[Ceph-noarch]name=Ceph noarch packagesbaseurl=/ceph/rpm-octopus/el7/noarchgpgcheck=0[ceph-source]name=Ceph source packagesbaseurl=/ceph/rpm-octopus/el7/SRPMSgpgcheck=0EOF(2) 配置 base、epel 源[root@ceph-node04 ~]# wget -O /etc/yum.repos.d/CentOS-Base.repo https:///repo/Centos-7.repo [root@ceph-node04 ~]# wget -O /etc/yum.repos.d/epel.repo /repo/epel-7.repo(3) ⽣成 yum 源缓存[root@ceph-node04 ~]# yum clean all[root@ceph-node04 ~]# yum makecache5 通过 ceph-deploy 命令在 ceph-node04 节点上安装 ceph 相关的软件包[root@ceph-deploy my-cluster]# ceph-deploy install --no-adjust-repos ceph-node046 使⽤ ceph-deploy 命令将配置⽂件 ceph.conf 和 admin key 复制到 ceph-node04 节点的 "/etc/ceph" ⽬录下,以便每次执⾏ceph CLI 命令⽆需指定 monitor 地址和 ceph.client.admin.keyring[root@ceph-deploy my-cluster]# ceph-deploy admin ceph-node047 通过 ceph-deploy 命令添加 ceph-node04 节点上的 OSD 到 ceph 集群[root@ceph-deploy my-cluster]# ceph-deploy osd create --data /dev/sdb ceph-node04[root@ceph-deploy my-cluster]# ceph-deploy osd create --data /dev/sdc ceph-node048 在 ceph-node04 节点查看 osd 进程[root@ceph-node04 ~]# ceph -scluster:id: 14912382-3d84-4cf2-9fdb-eebab12107d8health: HEALTH_OKservices:mon: 3 daemons, quorum ceph-node01,ceph-node02,ceph-node03 (age 12m)mgr: ceph-node01(active, since 12m), standbys: ceph-node03, ceph-node02osd: 8 osds: 8 up (since 3m), 8 in (since 3m)pools: 1 pools, 1 pgsobjects: 0 objects, 0 Busage: 8.1 GiB used, 152 GiB / 160 GiB availpgs: 1 active+clean[root@ceph-node04 ~]# ps -ef | grep -v grep | grep ceph图⽰:4.2 删除OSD将 ceph-node04 172.16.1.34 节点 osd.6、osd.7 下线说明:ceph-node04 节点上 /dev/sdb 磁盘对应的 osd id 为 6,/dev/sdc 磁盘对应的 osd id 为 7。

ceph磁盘挂载详解rbd cephfs

8:验证挂载信息:

config file /etc/modprobe.conf, all config files belong into /etc/modprobe.d/.

df -h

Filesystem Size Used Avail Use% Mounted on

12:查看创建的池

ceph osd lspools

13:从池中取出一个块设备,请执行以下命令,请更换大括号内相关的镜像的名字,池的名称替换{池名称}的名称及替换大括号内{镜像}名称:

rbd rm {image-name} -p {pool-name} 示例:

rbd rm rbdpoolimages -p rbdpool

##########################cephFS挂载####################################

创建cephfs文件系统

对于一个刚创建的MDS服务,虽然服务是运行的,但是它的状态直到创建 pools 以及文件系统的时候才会变为Active.

3:验证数据生成

[root@web-3-136 ~]# ceph mds stat

e10: 1/1/1 up {0=dn-5-228=up:active}, 2 up:standby

##########################cephfs客户端挂载###############################

4:验证挂载结果:

df -Th

Filesystem Type Size Used Avail Use% Mounted on

172.17.5.225:6789:/ ceph 30T 648M 30T 1% /cephfs

ceph性能测试

子鳴 我简单地逐一回答你的提问: 1. 由于开始学习的时候是0.56的版本,我采用了mkcephfs的方式来部署。仔细阅读下ceph的官方 文档,了解了如何添加mon和osd后,其实完全可以手动部署。

/?p=1223

2015-8-8

2. RBD设备也使用XFS,但使用默认的挂载选项,其挂载过程如下所示:

sudo rbd -p test create -s 11264 data sudo rbd -p test map data sudo mkfs.xfs /dev/rbd/test/data sudo mount /dev/rbd/test/data /mnt/dest

2013年6月1日 回复 顶 转发

zyc1_1 你好,能告我你的联系方式吗?请教一下ceph的性能测试.我的QQ:271168735,等待你的回复. 谢谢

分布式文件系统Ceph性能测试 | UC技术博客 UC技术博客

页码,1/12

• 首页 • 关于我们 • 加盟我们 • 开源项目 • 留言小本

6 留言小本

分布式文件系统Ceph性能测试

Posted by 子鳴 on 2013 年 5 月 30 日 Tweet25

Ceph是一个无单点故障的分布式存储平台,支持数据无缝复制和并发读写等优秀特性。 Ceph 的核心是 RADOS,我们针对RADOS 的 RBD 设备进行了 IO 的性能测试,并将结果 加以整理和分析。

关。

4 总结

本次测试的结果给出了Ceph整体上的性能,有如下几点结论:

1. 由于千兆网络的局限,Ceph的性能上限无法测定; 2. 小块文件的写性能较低,与Ceph对每个文件进行分配带来的额外开销有关以及相应

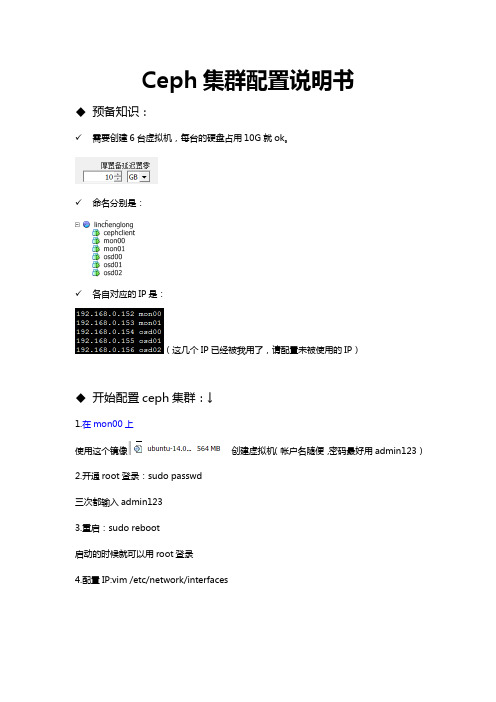

Ceph集群配置说明书

Ceph集群配置说明书◆预备知识:✓需要创建6台虚拟机,每台的硬盘占用10G就ok。

✓命名分别是:✓各自对应的IP是:(这几个IP已经被我用了,请配置未被使用的IP)◆开始配置ceph集群:↓1.在mon00上使用这个镜像创建虚拟机(帐户名随便,密码最好用admin123)2.开通root登录:sudo passwd三次都输入admin1233.重启:sudo reboot启动的时候就可以用root登录4.配置IP:vim /etc/network/interfaces152这个ip被我用了,请用未被使用的。

5.修改主机名:vim /etc/hostname6.再次重启reboot以便激活新的主机名和IP。

7.更新一下,并且安装opssh-server以便用这个软件来远程。

sudo apt-get update && sudo apt-get install openssh-server8.为了能远程root帐户,请再修改一下:vim /etc/ssh/sshd_config将这一行改成截图的样子。

(原来是without-password)9.重启,关掉控制台,我们去远程它。

记住ip是192.168.0.15210.修改hosts:vim /etc/hosts11.安装cephwget -q -O-'https:///git/?p=ceph.git;a=blob_plain;f=keys/release.asc' | sudo apt-key add -enter echo deb /debian $(lsb_release -sc) main | sudo tee /etc/apt/sources.list.d/ceph.list enter sudo apt-get update && sudo apt-get install ceph -yenter 以上步骤就是ubuntu14.04+ceph 的模版了,关掉mon00虚拟机的电源,将mon00的模版替换掉里面的其他5台虚拟机的配置。

Ceph分布式存储平台部署手册

Ceph分布式存储平台部署手册目录1.CEPH的架构介绍 (5)2.CEPH在OPENSTACK中应用的云存储的整体规划 (6)3.CEPH集群安装在UBUNTU 12.04 (7)3.1.配置ceph源73.2.依需求修改ceph.conf配置文件73.3.设置主机的hosts 93.4.设置集群节点之间无密钥访问93.5.创建目录103.6.创建分区与挂载103.7.执行初始化113.8.启动ceph 113.9.ceph健康检查114.CEPH集群安装在CENTOS6.4 (12)4.1.安装更新源124.2.使用rpm安装ceph0.67.4 124.3.依需求修改ceph.conf配置文件134.4.设置主机的hosts 214.5.设置集群节点之间无密钥访问214.6.创建目录224.7.执行初始化224.8.启动ceph 224.9.ceph健康检查235.OPENSTACK GLANCE 使用CEPH集群的配置 (24)5.1.创建卷池和图像池245.2.增加两个池的复制水平245.3.为池创建 Ceph 客户端和密钥环245.4.在计算节点应用密钥环245.4.1.创建libvirt密钥245.4.2.计算节点ceph安装255.5.更新你的 glance-api 配置文件256.OPENSTACK VOLUMES使用CEPH集群的配置 (27)6.1.计算节点ceph安装276.2.创建临时的 secret.xml 文件276.3.设定 libvirt 使用上面的密钥286.4.更新 cinder 配置286.4.1.cinder.conf文件更改286.4.2.更改 cinder 启动脚本配置文件296.4.3.更改/etc/nova/nova.conf配置296.4.4.重启 cinder 服务296.5.验证cinder-volume 296.6.验证rdb创建volume 307.挂载CEPHFS (31)7.1.配置/etc/fstab 317.2.挂载vm实例目录318.FQA (32)1.CEPH的架构介绍CEPH的组件主要包括客户端ceph client(数据用户),元数据服务器mds(缓存和同步分布式元数据),一个对象存储集群osd(将数据和元数据作为对象存储,执行其他关键职能),集群监视器mon(执行监视功能)。

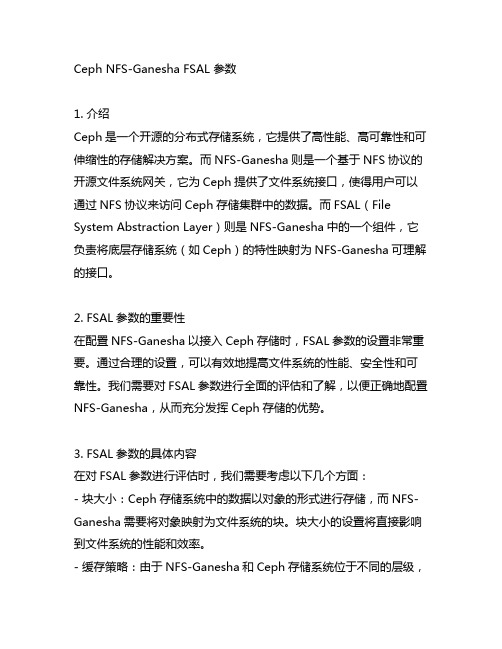

ceph nfs-ganesha fsal 参数

Ceph NFS-Ganesha FSAL 参数1. 介绍Ceph是一个开源的分布式存储系统,它提供了高性能、高可靠性和可伸缩性的存储解决方案。

而NFS-Ganesha则是一个基于NFS协议的开源文件系统网关,它为Ceph提供了文件系统接口,使得用户可以通过NFS协议来访问Ceph存储集群中的数据。

而FSAL(File System Abstraction Layer)则是NFS-Ganesha中的一个组件,它负责将底层存储系统(如Ceph)的特性映射为NFS-Ganesha可理解的接口。

2. FSAL参数的重要性在配置NFS-Ganesha以接入Ceph存储时,FSAL参数的设置非常重要。

通过合理的设置,可以有效地提高文件系统的性能、安全性和可靠性。

我们需要对FSAL参数进行全面的评估和了解,以便正确地配置NFS-Ganesha,从而充分发挥Ceph存储的优势。

3. FSAL参数的具体内容在对FSAL参数进行评估时,我们需要考虑以下几个方面:- 块大小:Ceph存储系统中的数据以对象的形式进行存储,而NFS-Ganesha需要将对象映射为文件系统的块。

块大小的设置将直接影响到文件系统的性能和效率。

- 缓存策略:由于NFS-Ganesha和Ceph存储系统位于不同的层级,为了提高文件系统的访问速度,需要合理地配置缓存策略,包括读写缓存的大小和更新策略等。

- 安全设置:在配置NFS-Ganesha时,需要考虑到文件系统的安全性,并根据实际需求设置相应的权限、认证方式和访问控制策略,确保数据的安全性和隐私性。

- 高可用性:Ceph存储系统具有高可用性的特点,而NFS-Ganesha也需要具备相应的高可用性能力,因此需要对FSAL参数进行合理的配置,以确保文件系统在各种故障情况下能够快速恢复和提供持续的访问服务。

4. 个人观点和理解在我看来,FSAL参数的设置是配置NFS-Ganesha的关键步骤之一。

Ceph集群概念以及部署

Ceph集群概念以及部署⼀、Ceph基础: 1、基础概念: ceph 是⼀个开源的分布式存储,同时⽀持对象存储、块设备、⽂件系统 ceph是⼀个对象(object)式存储系统,它把每⼀个待管理的数据流(⽂件等数据)切分伟⼀到多个固定⼤⼩(默认4M)的对象数据,并以其为原⼦单元(原⼦是构成元素的最⼩单元)完成数据的读写 对象数据的底层存储服务是由多个存储主机(host)组成的存储集群,该集群也被称之为RADOS(reliable automatic distributed object store)存储集群,即可靠的、⾃动化的、分布式的对象存储系统 librados是RADOS存储集群的API,⽀持C/C++/JAVA/Python/ruby/go/php等多种编程语⾔客户端 2、ceph的设计思想: ceph的设计宗旨在实现以下⽬标: 每⼀组件皆可扩展 ⽆单点故障 基于软件(⽽⾮专业设备)并且开源(⽆供应商) 在现有的廉价硬件上运⾏ 尽可能⾃动管理,减少⽤户⼲预 3、ceph版本: x.0.z - 开发版 x.1.z - 候选版 x.2.z - 稳定、修正版 4、ceph集群⾓⾊定义: 5、ceph集群的组成部分: 若⼲的Ceph OSD(对象存储守护进程) ⾄少需要⼀个Ceph Monitor 监视器(数量最好为奇数1,3,5,7........) 两个或以上的Ceph管理器 managers,运⾏Ceph⽂件系统客户端时还需要⾼可⽤的Ceph Metadata Server(⽂件系统元数据服务器) RADOS Cluster:由多台host存储服务器组成的ceph集群 OSD(Object Storage Daemon):每台存储服务器的磁盘组成的存储空间 Mon(Monitor):Ceph的监视器,维护OSD和PG的集群状态,⼀个Ceph集群⾄少有⼀个Mon节点,可以是⼀三五七等这样的奇数个 Mgr(Manager):负责跟踪运⾏时指标和Ceph集群的当前状态,包括存储利⽤率,当前性能指标和系统负载等 6、Ceph集群术语详细介绍: 6.1 Monitor(ceph-mon)ceph监视器: 软件包名&进程名:ceph-mon 在⼀个主机上运⾏的⼀个守护进程,⽤于维护集群状态映射(maintains maps of the cluster state),⽐如ceph 集群中有多少存储池、每个存储池有多少PG 以及存储池和PG的映射关系等, monitor map, manager map, the OSD map, the MDS map, and the CRUSH map,这些映射是Ceph 守护程序相互协调所需的关键群集状态,此外监视器还负责管理守护程序和客户端之间的⾝份验证(认证使⽤cephX 协议)。

Ceph安装部署与测试调优

Ceph安装部署及测试调优目录1.熟悉Ceph存储的基本原理与架构2.掌握Ceph集群的安装部署方法3.掌握Ceph常见的性能测试调优方法目录1.基本概念及架构2.安装部署3.测试调优Ceph是一个统一的分布式存储系统,具有高扩展性、高可靠性、高性能,基于RADOS(reliable, autonomous, distributed object store ),可提供对象存储、块设备存储、文件系统存储三种接口RADOS:是Ceph集群的精华,为用户实现数据分配、Failover等集群操作。

LIBRADOS:Librados是RADOS的提供库,上层的RBD、RGW和CephFS都是通过LIBRADOS访问的,目前提供PHP、Ruby、Java、Python、C和C++支持。

RBD:RBD全称RADOS block device,是Ceph对外提供的块设备服务。

RGW:RGW全称RADOS gateway,是Ceph对外提供的对象存储服务,接口与S3和Swift兼容。

CephFS:CephFS全称Ceph File System,是Ceph对外提供的文件系统服务OSD :Ceph OSD 进程,功能是负责读写数据,处理数据的复制、恢复、回填、再均衡,并通过检查其他OSD 守护进程的心跳来向Ceph Monitors 提供一些监控信息。

Monitor :集群的管理进程,维护着展示集群状态的各种图表,包括监视器图、OSD 图、归置组(PG )图、和CRUSH 图。

MDS :Ceph 元数据服务器,为Ceph 文件系统存储元数据(也就是说,Ceph 块存储和Ceph 对象存储不使用MDS )。

Ceph存储集群Object :Ceph 最底层的存储单元是Object 对象,每个Object 包含元数据和原始数据。

PG :PG 全称Placement Groups ,即归置组,是存放objects 的逻辑概念,一个PG 可映射到多个OSD 。

ceph 集群配置iscsi的操作步骤

ceph 集群配置iscsi的操作步骤1. 引言1.1 概述本文将介绍如何在Ceph集群中配置iSCSI,并提供操作步骤以帮助读者完成配置过程。

iSCSI(Internet Small Computer System Interface)是一种基于IP 网络的存储协议,它允许主机通过网络访问远程存储设备,模拟出本地连接的效果。

Ceph是一个开源、分布式存储平台,具有高扩展性和可靠性,与iSCSI结合使用能够提供更多的存储解决方案。

1.2 文章结构本文将包含以下几个部分:概述、ceph与iSCSI集成优势、准备工作、ceph集群配置步骤、配置iSCSI Initiator客户端和结论。

首先,文章将通过简要介绍概述部分来引入话题,并描述本文的组织结构。

然后,我们将讨论为什么选择使用ceph与iSCSI集成,并探讨该集成在存储环境中所带来的优势。

接下来,我们将介绍在进行配置之前需要做的准备工作。

随后,在ceph集群配置步骤部分,我们将详细说明如何安装和配置ceph集群,并创建Pool和RBD镜像。

然后,在配置iSCSI Initiator客户端部分,我们将讲解如何在客户端安装Initiator软件包、发现远程iSCSI目标并连接,以及格式化与挂载iSCSI磁盘的步骤。

最后,在结论部分,我们将总结本文的主要内容,并展望ceph与iSCSI集成在未来的发展方向。

1.3 目的本文旨在帮助读者了解如何在Ceph集群中配置iSCSI,并提供详细的操作步骤。

通过阅读本文,读者将能够掌握配置Ceph集群和设置iSCSI Initiator客户端所需的技能,并了解Ceph和iSCSI集成所带来的优势。

无论是初学者还是有经验的存储管理员,都可以从本文中获得有益的知识和参考指导。

将Ceph和iSCSI 相结合可以为存储环境提供更灵活、可靠和可扩展的解决方案,本文也旨在推广这种集成应用并促进其未来发展。

2. ceph 集群配置iscsi的操作步骤:2.1 iSCSI简介:iSCSI(Internet Small Computer System Interface)是一种基于IP网络的存储协议,它允许远程主机通过TCP/IP网络访问存储设备。

cephFS存储集群配置以及测试方案

概述

存储集群部署方案

存储服务器配置

集群方案

1、设计3个存储节点;

2、每个存储节点11个OSD;

3、采用SATA盘作为主存,没有SSD盘;

4、采用2副本模式;

5、创建mds,文件系统;

6、在存储网关服务器上mountcephFS文件系统到本地目录;

7、启动ftp服务,并绑定文件系统目录;

拓扑图

后端cephFS文件存储性能测试

通过fio工具对FlexStorage后端文件系统进行性能测试,主要指标包括IOPS、时延、速率等。

性能指标规划:()

测试工具:

fio

上层ftp业务性能测试

在ceph存储网关服务器上搭建ftp server,ftp服务器mount cephFS文件系统目录。

用户能够通过ftp访问cephFS,进行文件读写操作。

性能指标规划:

4KB文件写:通过脚本在本地生成5242880个4KB文件,通过linux ftp客户端上传这些文件,并计算消耗时长;

4KB文件读:通过linux ftp客户端下载5242880个4KB文件,并计算消耗时长;

64KB文件写:通过脚本在本地生成327680个64KB文件,通过linux ftp客户端上传这些文件,并计算消耗时长;

64KB文件读:通过linux ftp客户端下载327680个64KB文件,并计算消耗时长;

20GB文件写:通过linux ftp客户端上传1个20GB文件,并计算消耗时长;

20GB文件读:通过linux ftp客户端下载1个20GB文件,并计算消耗时长;。

ceph集群性能测试结果

ceph集群性能测试结果对ceph存储集群(8台万兆服务器)从以下⼏个⽅⾯进⾏测试的结果1、读写稳定性⽆故障下的ceph集群性能完全满⾜业务对磁盘性能的需求。

测试数据结果如下表1-1,1-22、业务稳定性ceph集群出现节点脱离的故障状态时,设置恢复QoS可以有效的保证业务正常运⾏⽆中断。

测试数据结果如下表2-13、节点故障恢复时间节点故障的恢复时间依据故障时间段内的新增数据的⼤⼩决定,若移除或添加⼀个11T的节点,并且不做恢复速度限制,那么数据恢复时间⼤约在6到8⼩时。

测试数据结果如下表3-1,3-2,4-14、对系统资源的使⽤情况ceph底层ssd盘起缓存的作⽤,使⽤率是随热数据的上升与下沉⽽变化(测试阶段最⾼达到70%);SATA盘随着数据的不断写⼊使⽤率⼀直上升。

5台业务服务器在进⾏8k块⼤⼩连续2⼩时并⾏读写操作时,集群的cpu使⽤率会升⾼到50%-80%,内存使⽤率46.61%基本⽆波动。

5台业务服务器在进⾏8k块⼤⼩连续2⼩时并⾏读写操作时,业务服务器资源内存消耗瞬间增长到7G(总内存8G)随后下降,CPU使⽤率升⾼到15%-25%。

测试图标如下5-1,5-2,5-3,5-4Ceph分布式存储的物理和业务空间使⽤如下:裸物理空间349.3TB 已使⽤的裸物理空间94.8TB三个副本的总空间116.44T 三个副本已使⽤的空间31.58TBceph的数据存储⽬前基本都在15%以内,存储超过70%时,业务的性能会少量低下。

1、稳定性(ceph集群⽆故障)⼀个业务的性能表1-1:bw(MB/s)iops(每秒的读写次数)randread(磁盘分区未对齐)10914032randwrite(磁盘分区未对齐)759335randwrite(磁盘分区对齐)79.71102025个业务的性能表1-2:bw(MB/s)x5iops(每秒的读写次数)x5randread(磁盘分区未对齐)10813832randwrite(磁盘分区未对齐)415190randwrite(磁盘分区对齐)50.4564572、业务稳定性(随机写数据为例,数据恢复速度限制,⼀个业务的性能测试)表2-1bw(MB/s)iops(每秒的读写次数)相⽐正常测试值下降百分⽐⼀个节点脱离集群68844210%-20%两个节点脱离集群67828110%-20%3、节点故障恢复时间(⽆业务运⾏状态下,⼀个业务性能测试)表3-1读写速度范围(MB/s)数据量(T)恢复时间(hour)移除⼀个节点1100-2200116移除两个节点1100-22002212表3-2添加移除的⼀个节点300-500118添加移除的两个节点300-50022134、关闭数据恢复限制的状态下,5个业务的性能表4-1bw(MB/s)x5iops(每秒的读写次数)x5randread15.41969randwrite7.689835、系统资源使⽤情况Ceph集群内存变化图5-1:Ceph集群CPU变化图5-2:业务服务器CPU变化图5-3:业务服务器内存变化图5-4:6、数据库备份运⾏状态下,磁盘分区对业务性能的影响⼀个业务的性能2-1:bw(MB/s)iops(每秒的读写次数)randwrite(磁盘分区未对齐)59.127567randwrite(磁盘分区对齐)77.0698635个业务的性能2-2:bw(MB/s)x5iops(每秒的读写次数)x5 randwrite(磁盘分区未对齐)41.375295randwrite(磁盘分区对齐)506400。

ceph性能测试

ceph性能测试部署⽅案:整个Ceph Cluster使⽤4台ECS,均在同⼀VPC中,结构如图:以下是 Ceph 的测试环境,说明如下:Ceph 采⽤ 10.2.10 版本,安装于 CentOS 7.4 版本中;系统为初始安装,没有调优。

每个 OSD 存储服务器都是4核8GB,挂载1块300G⾼效云盘(⾮SSD硬盘);操作系统和OSD存储均⽤同⼀个磁盘。

[root@node1 ~]# ceph osd treeID WEIGHT TYPE NAME UP/DOWN REWEIGHT PRIMARY-AFFINITY-6 0 rack test-bucket-5 0 rack demo-1 0.86458 root default-2 0.28819 host node20 0.28819 osd.0 up 1.00000 1.00000-3 0.28819 host node31 0.28819 osd.1 up 1.00000 1.00000-4 0.28819 host node42 0.28819 osd.2 up 1.00000 1.00000使⽤ Test pool,此池为 64 个 PGs,数据存三份;[root@node1 ~]# ceph osd pool create test 64 64pool 'test' created[root@node1 ~]# ceph osd pool get test sizesize: 3[root@node1 ~]# ceph osd pool get test pg_numpg_num: 64Ceph osd 采⽤ xfs ⽂件系统(若使⽤ brtf ⽂件系统读写性能将翻 2 倍,但brtf不建议在⽣产环境使⽤);Ceph 系统中的Block采⽤默认安装,为 64K;性能测试客户端运⾏在node1上,在同⼀VPC下使⽤同⼀⽹段访问 Ceph 存贮系统进⾏数据读写;本次测试中,发起流量的客户端位于Ceph Cluster中,故⽹络延时较⼩,真正⽣产环境中还需要考虑⽹络瓶颈。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

概述

存储集群部署方案

存储服务器配置

集群方案

1、设计3个存储节点;

2、每个存储节点11个OSD;

3、采用SATA盘作为主存,没有SSD盘;

4、采用2副本模式;

5、创建mds,文件系统;

6、在存储网关服务器上mountcephFS文件系统到本地目录;

7、启动ftp服务,并绑定文件系统目录;

拓扑图

后端cephFS文件存储性能测试

通过fio工具对FlexStorage后端文件系统进行性能测试,主要指标包括IOPS、时延、速率等。

性能指标规划:()

测试工具:

fio

上层ftp业务性能测试

在ceph存储网关服务器上搭建ftp server,ftp服务器mount cephFS文件系统目录。

用户能够通过ftp访问cephFS,进行文件读写操作。

性能指标规划:

4KB文件写:通过脚本在本地生成5242880个4KB文件,通过linux ftp客户端上传这些文件,并计算消耗时长;

4KB文件读:通过linux ftp客户端下载5242880个4KB文件,并计算消耗时长;

64KB文件写:通过脚本在本地生成327680个64KB文件,通过linux ftp客户端上传这些文件,并计算消耗时长;

64KB文件读:通过linux ftp客户端下载327680个64KB文件,并计算消耗时长;

20GB文件写:通过linux ftp客户端上传1个20GB文件,并计算消耗时长;

20GB文件读:通过linux ftp客户端下载1个20GB文件,并计算消耗时长;。