压缩主成分估计的一些性质_李胜宏

平衡损失下回归系数James_Stein估计的性质_李胜宏

文章编号: 1672-6146(2003)04-0007-02平衡损失下回归系数James-Stein估计的性质*李胜宏1 周占功2(1.湘潭大学数学系 湖南湘潭 411105;2.嘉兴学院 浙江嘉兴 314001)摘 要: 在平衡损失下给出了回归系数James-Stein估计优于最小二乘(LS)估计的充要条件,得到了在Pitman close-ness准则下James-Stein估计相对于LS估计的优良性.关键词: James-Stein估计;最小二乘估计;平衡损失;Pit-man closeness准则中图分类号:O212.1 文献标识码:A设有线性模型Y=Xβ+e,e~N(0,σ2I n)(1)其中Y为n维观测向量,X为n×p阶病态矩阵,p >2,β∈R p和σ2>0为未知参数,ε为n维随机误差向量.β和σ2的LS估计分别为β=(X′X)-1X′Y和σ2=‖Y-Xβ‖2(n-p),它们是基于(Y-Xd)′(Y-Xd)达到最小的d值.就β估计的精度而言,通常在二次损失函数(d-β)′(d-β)下考虑其优良性.Stein[1]证明了p>2时β不再是β的容许估计,文献[2]中定义了β的James-Stein(JS)估计βJS(c) =(1-cσ2β′X′Xβ)β.文献[3]在二次损失函数下讨论了βJS(c)优于LS估计β,而文献[4]则在损失函数(d-β)′X′X(d-β)和Pitman Closeness(PC)准则下比较JS估计βJS(c)相对于LS估计β的优良性.本文引入Zelner[5]提出的平衡损失函数:L(d,β)=ω(Y-Xd)′(Y-Xd)+(1-ω)(d-β)′S(d-β)(2)其中0≤ω≤1为已知,S为已知的正定矩阵.对于回归系数β估计的精度和模型(1)拟合的优良性,(2)式是一个全面而合理的标准.采用损失函数(2),对一些特定估计的风险进行研究,目前已有一些结果[5-7].本文在0≤ω<1为已知,取S=X′X及平衡损失函数(2)和PC准则下给出了JS估计βJS(c)相对于LS估计β的优良性,其结果是文献[4]的进一步推广.收稿日期:2002-10-03*基金项目:国家自然科学基金资助项目[10271020]第一作者:李胜宏(1977-)女硕士研究生研究方向为数理统计.定理1 在模型(1)及平衡损失函数(2)下,若0≤ω<1为已知,S=X′X.则β的JS估计βJS(c)优于LS估计β的充要条件是:0<c<2(1-ω)(p-2)(n-p)n-p+2.证明 EL(β,β)=ωE(Y-Xβ)′(Y-Xβ)+ (1-ω)E(β-β)′X′X(β-β)=ωσ2(n-p)+pσ2(1 -ω).EL(βJS(c),β)=ωE(Y-Xβ+cσ2Xββ′X′Xβ′)′(Y-Xβ+cσ2Xββ′X′Xβ)+(1-ω)E(β-β+cσ2ββX′Xβ)′X′X(β-β+cσ2ββ′X′Xβ)=ωσ2(n-p)+c2Eσ4E1β′X′Xβ+(1-ω)·(pσ2-2cEσ2Eβ″XX(β-β)β′X′Xβ).由文献[4]中引理1、2知:EL(βJS(c),β)-EL(β,β)=[c2n-p+2n-p-2c(1-ω)(p-2)]σ2E[1(p-2+2k)]<0c2n-p+2n-p-2c(1-ω)(p-2)<00<c< 2(1-ω)(p-2)(n-p)n-p+2.其中K~P(‖(X′X)1/2β‖2/2).定理证毕.定理2 在模型(1)及平衡损失函数(2)下,若0≤ω<1为已知,S=X′X.则当c=(1-ω)(p-1) (3p+1)2p时,有P(L(βJS(c),β)≤L(β,β))> 0.5,即在PC则准下βJS(c)优于β.证明 由于L(βJS(c),β)-L(β,β)=(cσ2)2β′X′Xβ-2c(1-ω)σ2β″X X(β-β)β′X′Xβ.因此L(βJS(c),β)-L(β,β)≤0cσ2-2(1-ω)β′X′Xβ≤0.由文献[4]中定理2之证可知,当c=(1-ω)(p-1)(3p+1)2p时,有P(L(βJS(c),β)≤L(β,β))>0.5.定理证毕.第15卷第4期湖南文理学院学报(自然科学版)Vol.15No.4 2003年12月Journal of Hunan University of Arts and Science(Natural Science Edition)Dec.2003参 考 文 献1 Stein C.Inadmissibility of the Usual Estimator for Mean of Multivariat e Normal Distribution.Proceedings of the Third Berkely Symposium on Mathematical and Statistic Probabili-ty(Jerz y Neyman,ed),Vol1,Univ.of California,Berkley.1956,197-206.2 Chen xiru,Wan g Songgui.Modern Regression Analysis [M].Hefei:Anhui Education Press,1987.3 王松桂.线性模型的理论及其应用[M].合肥:安徽教育出版社,1987.4 林明,韦来生.回归系数Stein压缩估计的小样性质[J].应用数学学报.2002,25(3),497-504.5 Zellner A.Bayesian and non-Bayesian estimator usin g balance loss function.In:Gupta S S,Berger J O eds.Statis-tical decision theory and related topic[M].New York: Spring-Verlag,1994,377-390.6 Giles J A,Giles D E A,Ohtani K.The exact risk of some pretest and Stein-type regression estimators under balance loss[J].Communications in Statistics Theory and Methods, 1996,25:2901-2919.7 Ohtani K.The exact risk of a weighted averge estimator ofthe els and Stein-rule estimators in regression under bal-ance loss[J].Statistics and Decision,1998,16:35-45.THE PROPERTIES OF JAMES-STEIN ETIMATOR FOR REGRESSI ONC OEFFICIENT UNDER BALANC E LOSSLI Sheng-hong1 Zhou Zhan-gong2(1.Department of Mathematics,Xian gtanUniversity,Xiangtan,Hunan411105;2.Jiaxin University,Jiaxin Zhejiang314001) Abstract The necessary and sufficient condition that James-Stein estimator were better than least sq uare(LS)estimator based on the balanced loss function.The superiority of the James-Stein esti-mator over LS estimator was obtained under Pitman closeness(PC) criterion. Key words James-Stein estimator;LS estimator;balance loss;PC criterion(责任编校:江 河) 更名启事经国家新闻出版署批准,自2003年第3期起,《常德师范学院学报》(自然科学版)更名为《湖南文理学院学报》(自然科学版)。

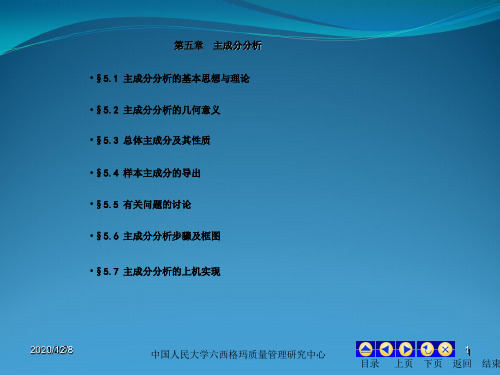

主成分分析多元统计分析

维的情况。

Y1,Y2, ,YP

20210/21/28/8

中国人民大学六西格玛质量管理研究中心

1111 目录 上页 下页 返回 结束

§5.2 主成分分析的几何意义

N 设有 个样品,每个样品有两个观测变量

点散布的情况如带状,见图5-1。

X1, X2

,这样,在由变量

N

组成X的1,坐X标2 空间中, 个样品

1. ui'ui 1,即: ui21ui22ui2p1 (i1,2,...p.)。

2. Yi与Y j相互无关(i j; i, j1,2,...p.)。

Y 性组3.合是中方差1 最大X 者1 ;,的…X 一,2 切, 是满足与,原X 则P1的线性都组不合相中关方的差最大者;

是与 不相关的

所有线

的所有线性组合中方差最大者。

况,有类似的结论。

Y1

U

20210/21/28/8

中国人民大学六西格玛质量管理研究中心

1155 目录 上页 下页 返回 结束

§5.2 主成分分析的几何意义

设变量 X遵1、 从二X元2正态分布,分布密度为:

f(X 1,X 2)21 2 112exp 2 1 2 { 2 21 (12)[X (1 1)2 2 2 2 1 2 2 2 (X 1 1)X (2 2) 1 2(X 2 2)2]}

考虑 (X μ)Σ ' 1((X 为 常μ 数)) ,为d 方2便,d不妨设

μ 0 上式有如下展开形式:

1 1 2 X 1 1 22 X 1 1 X 2 2 X 2 2 2 d2

令 Z1X1/1, ,Z则2上面X的2/方程2变为:

Z 1 2 2Z 1 Z 2 Z 2 2 d 2 ( 1 2 ).

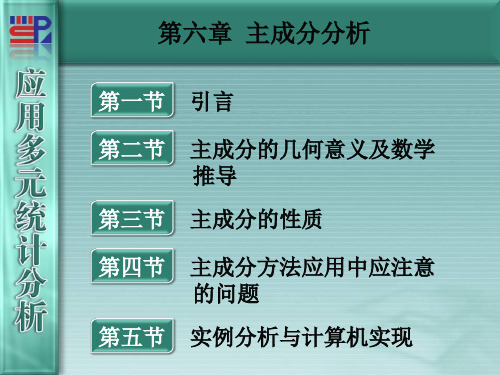

厦门大学《应用多元统计分析》第06章__主成分分析

另一种是椭圆扁平到了极限,变成y1轴上的一条线,第一主成 分包含有二维空间点的全部信息,仅用这一个综合变量代替原 始数据不会有任何的信息损失,此时的主成分分析效果是非常 理想的,其原因是,第二主成分不包含任何信息,舍弃它当然 没有信息损失。

矩阵表示形

式为:

Y1 Y2

cos sin

sin cos

X1 X2

TX

(6.2)

其中, T为旋转变换矩阵,它是正交矩阵,即有 T T1

或 TT I 。

易见,n个点在新坐标系下的坐标Y1和Y2几乎不相关。称它 们为原始变量X1和X2的综合变量,n个点y1在轴上的方差达 到最大,即在此方向上包含了有关n个样品的最大量信息。

i 1

性质 3 主成分 Yk 与原始变量 X i 的相关系数为

(6.20) (6.21)

(Yk , Xi )

k ii

tki

并称之为因子负荷量(或因子载荷量)。

(6.22)

证明:事实上

(Yk , Xi )

Cov(Yk , Xi ) Cov(TkX, eiX)

D(Yk )D(Xi )

k ii

其中的 ei (0, , 0,1, 0, , 0) ,它是除第 i 个元素为 1 外其他元

素均为 0 的单位向量。而

Cov(TkX, eiX) TkΣei ei(ΣTk ) ei(kTk ) keiTk ktki

武汉大学数理统计ppt 8 主成分分析

如果我们将Xl 轴和X2轴先平移,再同时按逆时针方向旋转角度,得

到新坐标轴Fl和F2。Fl和F2是两个新变量。 根据旋转变换的公式:

F1 F2

cos sin

sin cos

X1 X2

UX

U为旋转变换矩阵,它是正交矩阵,即有

U U1, UU I

旋转变换的目的是为了使得n个样品点在Fl轴方向上的离散程度 最大,即Fl的方差最大。变量Fl代表了原始数据的绝大 部分信息, 即使不考虑变量F2也无损大局。经过上述旋转变换原始数据的大部 分信息集中到Fl轴上,对数据中包含的信息起到了浓缩作用。

对于 X 的协差阵 Σ 的特征根 1 2 p 0 。由(6.15)和

(6.16)知道 Yk 的最大方差值为第 k 大特征根 k ,其相应的单位化的特

征向量为 Tk 。

综上所述,设 X (X1, , X p ) 的协差阵为 Σ ,其特征根为 1 2

p 0 ,相应的单位化的特征向量为 T1,T2 , ,Tp 。那么,由此所确

由主成分的性质 2 可以看出,主成分分析把 p 个原始变量

X1, X2 , , X p 的总方差 tr(Σ) 分解成了 p 个相互独立的

p

变量 Y1,Y2 , ,Yp 的方差之和 k 。主成分分析的目的是 k 1

减少变量的个数,所以一般不会使用所有 p 个主成分的,

忽略一些带有较小方差的主成分将不会给总方差带来太

果受变量单位的影响。不同的变量往往有不同的单位,对同

一变量单位的改变会产生不同的主成分,主成分倾向于多归

纳方差大的变量的信息,对于方差小的变量就可能体现得不

够,也存在“大数吃小数”的问题。为使主成分分析能够均

等地对待每一个原始变量,消除由于单位的不同可能带来的

主成分分析法

主成分分析法什么事主成分分析法:主成分分析(principal components analysis,PCA)又称:主分量分析,主成分回归分析法主成分分析也称主分量分析,旨在利用降维的思想,把多指标转化为少数几个综合指标。

在统计学中,主成分分析(principal components analysis,PCA)是一种简化数据集的技术。

它是一个线性变换。

这个变换把数据变换到一个新的坐标系统中,使得任何数据投影的第一大方差在第一个坐标(称为第一主成分)上,第二大方差在第二个坐标(第二主成分)上,依次类推。

主成分分析经常用减少数据集的维数,同时保持数据集的对方差贡献最大的特征。

这是通过保留低阶主成分,忽略高阶主成分做到的。

这样低阶成分往往能够保留住数据的最重要方面。

但是,这也不是一定的,要视具体应用而定。

主成分分析的基本思想:在实证问题研究中,为了全面、系统地分析问题,我们必须考虑众多影响因素。

这些涉及的因素一般称为指标,在多元统计分析中也称为变量。

因为每个变量都在不同程度上反映了所研究问题的某些信息,并且指标之间彼此有一定的相关性,因而所得的统计数据反映的信息在一定程度上有重叠。

在用统计方法研究多变量问题时,变量太多会增加计算量和增加分析问题的复杂性,人们希望在进行定量分析的过程中,涉及的变量较少,得到的信息量较多。

主成分分析正是适应这一要求产生的,是解决这类题的理想工具。

同样,在科普效果评估的过程中也存在着这样的问题。

科普效果是很难具体量化的。

在实际评估工作中,我们常常会选用几个有代表性的综合指标,采用打分的方法来进行评估,故综合指标的选取是个重点和难点。

如上所述,主成分分析法正是解决这一问题的理想工具。

因为评估所涉及的众多变量之间既然有一定的相关性,就必然存在着起支配作用的因素。

根据这一点,通过对原始变量相关矩阵内部结构的关系研究,找出影响科普效果某一要素的几个综合指标,使综合指标为原来变量的线性拟合。

常用统计方法

主成分分析主成分分析(principal component analysis)将多个变量通过线性变换以选出较少个数重要变量的一种多元统计分析方法。

又称主分量分析。

在实际课题中,为了全面分析问题,往往提出很多与此有关的变量(或因素),因为每个变量都在不同程度上反映这个课题的某些信息。

但是,在用统计分析方法研究这个多变量的课题时,变量个数太多就会增加课题的复杂性。

人们自然希望变量个数较少而得到的信息较多。

在很多情形,变量之间是有一定的相关关系的,当两个变量之间有一定相关关系时,可以解释为这两个变量反映此课题的信息有一定的重叠。

主成分分析是对于原先提出的所有变量,建立尽可能少的新变量,使得这些新变量是两两不相关的,而且这些新变量在反映课题的信息方面尽可能保持原有的信息。

主成分分析首先是由K.皮尔森对非随机变量引入的,尔后H.霍特林将此方法推广到随机向量的情形。

信息的大小通常用离差平方和或方差来衡量。

(1)主成分分析的原理及基本思想。

原理:设法将原来变量重新组合成一组新的互相无关的几个综合变量,同时根据实际需要从中可以取出几个较少的总和变量尽可能多地反映原来变量的信息的统计方法叫做主成分分析或称主分量分析,也是数学上处理降维的一种方法。

基本思想:主成分分析是设法将原来众多具有一定相关性(比如P个指标),重新组合成一组新的互相无关的综合指标来代替原来的指标。

通常数学上的处理就是将原来P个指标作线性组合,作为新的综合指标。

最经典的做法就是用F1(选取的第一个线性组合,即第一个综合指标)的方差来表达,即Var(F1)越大,表示F1包含的信息越多。

因此在所有的线性组合中选取的F1应该是方差最大的,故称F1为第一主成分。

如果第一主成分不足以代表原来P个指标的信息,再考虑选取F2即选第二个线性组合,为了有效地反映原来信息,F1已有的信息就不需要再出现再F2中,用数学语言表达就是要求Cov(F1, F2)=0,则称F2为第二主成分,依此类推可以构造出第三、第四,……,第P个主成分。

基于KPCA的图像压缩方法

基于KPCA的图像压缩方法

蔡楠;李萍

【期刊名称】《无线电工程》

【年(卷),期】2018(48)12

【摘要】为了解决主成分分析算法在图像压缩中不能有效提取非线性特征问题,采用核主成分分析算法对原输入空间进行非线性变换将其映射到特征空间,在特征空间下使用主成分分析算法提取特征从而达到了对非线性特征的提取.通过累计贡献率选取主成分实现数据压缩的目的.采用峰值信噪比和压缩比分别评定图像压缩质量和压缩程度.仿真结果表明,在相同的累计贡献率下核主成分分析的峰值信噪比和压缩比分别提高了约2倍和1.6倍,并有更好的非线性特征提取能力.通过与传统的JPEG对比,该方法具有更好的性能,从而说明核主成分分析算法适用于图像压缩.【总页数】4页(P1061-1064)

【作者】蔡楠;李萍

【作者单位】宁夏大学物理与电子电气工程学院, 宁夏银川 750021;宁夏大学物理与电子电气工程学院, 宁夏银川 750021

【正文语种】中文

【中图分类】TP391

【相关文献】

1.基于图像欧式距离的KPCA SAR图像目标识别算法 [J], 周强;杨智勇;孙小燕;张静

2.基于BEMD图像特征点的图像压缩方法 [J], 高凤娇;何艳;田晓英;费磊

3.基于KPCA与KFDA的SAR图像舰船目标识别 [J], 刘磊;孟祥伟;于柯远

4.基于改进图像块分类算法的图像压缩方法 [J], 俞华;韩钰;牛彪;高义斌;赵亚宁

5.基于图像感兴趣区域的图像压缩方法 [J], 孔玲君;孙叶维

因版权原因,仅展示原文概要,查看原文内容请购买。

清华大学系统工程

2 (y ˆk) k/N 1 , k

《系统工程导论》

第25页

5.3 主成分的计算方法及有关性质

主成分的样本方差之和

n

n

N1 2(yˆk)

N ~xT(t)q(k)qT(k)~x(t)

k1

k1 t1

N ~xT(t) n q(k)qT(k)~x(t)

《系统工程导论》

第3页

5.1 引言

观察:长、宽、高之间近似存在线性关系 若存在一个线性关系

或者 x 1 ( t ) b 0 ( 1 ) b 2 ( 1 ) x 2 ( t ) b 3 ( 1 ) x 3 ( t ) 或者 x 2 ( t ) b 0 ( 2 ) b 1 ( 2 ) x 1 ( t ) b 3 ( 2 ) x 3 ( t ) 或者 x 3 ( t ) b 0 ( 3 ) b 1 ( 3 ) x 1 ( t ) b 2 ( 3 ) x 2 ( t ) )

《系统工程导论》

第9页

5.2 主成分分析基本原理

主成分分析几何意义:

平移+旋转,使得样本点在第一主轴的方差最大

u u12 x1xc1soin sx2xs2cinos c1c2

u2

u1

x2

g

O

《系统工程导论》

x1

第10页

5.2 主成分分析基本原理

基本准则:分类变量的分散程度越大越有利 变量的样本均值

e ( y 1 ) l 0 ( 1 ) l 1 ( 1 ) e ( x 1 ) l 2 ( 1 ) e ( x 2 ) l 3 ( 1 ) e ( x 3 )

y 1 (t) e(y 1 ) l1 (1 )x 1 (t) e(x 1 ) l2(1 )x 2(t) e(x2) l3(1 )x 3(t) e(x 3)

第六章-主成分分析法精选全文

可编辑修改精选全文完整版第六章 主成分分析法主成分分析法是将高维空间变量指标转化为低维空间变量指标的一种统计方法。

由于评价对象往往具有多个属性指标,较多的变量对分析问题会带来一定的难度和复杂性。

然而,这些指标变量彼此之间常常又存在一定程度的相关性,这就使含在观测数据中的信息具有一定的重叠性。

正是这种指标间的相互影响和重叠,才使得变量的降维成为可能。

即在研究对象的多个变量指标中,用少数几个综合变量代替原高维变量以达到分析评价问题的目的。

当然,这少数指标应该综合原研究对象尽可能多的信息以减少信息的失真和损失,而且指标之间彼此相互独立。

第一节 引言主成分分析,也称主分量分析,由皮尔逊(Pearson )于1901年提出,后由霍特林(Hotelling )于1933年发展了,这也正是现在多元统计分析中的一种经典统计学观点。

经典统计学家认为主成分分析是确定一个多元正态分布等密度椭球面的主轴,这些主轴由样本来估计。

然而,现代越来越多的人从数据分析的角度出发,用一种不同的观点来考察主成分分析。

这时,不需要任何关于概率分布和基本统计模型的假定。

这种观点实际上是采用某种信息的概念,以某种代数或几何准则最优化技术对一个数据阵的结构进行描述和简化。

主成分分析方法的主要目的就是通过降维技术把多个变量化为少数几个主要成分进行分析的统计方法。

这些主要成分能够反映原始变量的绝大部分信息,它们通常表示为原始变量的某种线性组合。

为了使这些主要成分所含的信息互不重迭,应要求它们互不相关。

当分析结束后,最后要对主成分做出解释。

当主成分用于回归或聚类时,就不需要对主成分做出解释。

另外,主成分还有简化变量系统的统计数字特征的作用。

对于任意p 个变量,描述它们自身及其相互关系的数字特征包括均值、方差、协方差等,共有)1(21-+p p p 个参数。

经过主成分分析后,每个新变量的均值和协方差都为零,所以,变量系统的数字特征减少了)1(21-+p p p 个。

线性模型中压缩主成分估计的若干性质

1 0 <0 ≤ 0 ) l 2≤ … ≤ O p<1 2 0 < A ; ) P≤ 0 2≤ … ≤ A 0 ll<1 .

常熟理工学 院学报( 自然科学 )

2 0 矩 08

:

J 【 丽 1

,

2 ’ …

r’ r+ 一 , p

为型△ 分 岭组主 成

当 0= i ,, ,, i A ~,=l2 … pO<七 时 , 为根方有偏估 计. <1 & 张启全在文献 E ] 3 中对 & 的优 良性作 了很多 的工作 , 文做 了一些 补充. 明 了此 岭估计在 一定条件 下 , 本 证

E &一& A 尸 P ( ( )P P X &一& )+& ( ,一P P )X X( A ,一P P ) : A &

E( &一& A E &一& )P P ( )+& P ,一A)E : ( P&

f[ APCV & ]+&P( rP O( ) ,一A)E =6t( ) ( P& rA + ,一A) .

( )l y 一 的均方误差变得很大, 使平均模 E( =M E & + I I 过长, && S () I &I 其中 A ≥A ≥… ≥A 。 : 。>0

为 的特征值 , 因此使得对 &的改进 变得十分重要.

为了改进 &, 人们提出了一些有偏压缩估计, 如岭估计、 岭型组合主成分估计[ ] si压缩估计、 1、e tn 变根有偏 估计[] 2 等.由文献[ ] 3 中提出的压缩成分估计, 包含了以上估计, 定义如下 :

线性模型中压缩主成分估计的若干性质_闻斌

第22卷第10期Vol.22No.102008年10月Oct.,2008常熟理工学院学报(自然科学)Journal of Changshu Institute Technology (Natural Sciences )摘要:讨论了压缩主成分估计的若干性质,证明了在一定条件下此估计比最小二乘估计有更小的广义均方误差,并且在PC 准则下也优于最小二乘估计.关键词:压缩主成分估计;广义均方误差;PC 准则中图分类号:O212.0文献标识码:A 文章编号:1008-2794(2008)10-0027-04收稿日期:2008-03-19作者简介:闻斌(1980—),男,江苏太仓人,常熟理工学院数学系讲师,硕士,研究方向:线性模型及广义线性模型.线性模型中压缩主成分估计的若干性质闻斌(常熟理工学院数学系,江苏常熟215500)0引言常熟理工学院学报(自然科学)2008年281GMSE下压缩主成分估计相对于LS的优良性2PC 准则下的优良性第10期闻斌:线性模型中压缩主成分估计的若干性质29常熟理工学院学报(自然科学)2008年参考文献:[1]徐文莉,林文干.岭型组合主成分估计[J].应用概率统计,1995,11(1):52-59.[2]夏结来.回归系数的根方有偏估计及其应用[J].数理统计和应用概率,1988,11(1):21-29.[3]张起全.压缩主成分估计[J].山东师范大学学报,2002,17(1):15-17.[4]Rorbert C.On some accurate bounds for the quantities of a Noncentral of Clossness[J].Statistics and Probability,1990,10:101-106.[5]Rorbert,Mason parisom of linear estimators using Pitman’s Measure of Clossness [J].ASA,1990,85:579-581.[6]Kadiyala.Mixed regression estimator under misspectification[J].Economic Letters,1986,21:27-30.Some Characteristics of the Shrunken Principal Estimator in Linear Model WEN Bin (Department of Mathematics,Changshu Institute of Technology,Changshu 215500,China)Abstract :The paper discusses some characteristics of the shrunken principal estimator and proves that the shrunhen principal estimate is better than LS estimator under GMSM and Pitman ’s Measure of Clossness.Key words :shrunken principal estimator;general mean square error;Pitman ’s Measure of closenessIntegral Form Abelian Lemma and Its Applications in the Theory of Improper IntegralYAN Li-li ,WANG Jian-yong(Department of Mathematics ,Changshu Institute of Technology ,Changshu 215500,China )Abstract :This paper deals with the integral form Abelian transformation and Abelian Lemma ,and obtains their applications in the theory of improper integral.Key words :integral form Abelian transformation ;integral form Abelian Lemma ;improper integral 参考文献:[1]华东师范大学数学系.数学分析[M].北京:高等教育出版社,2001.[2]ΓΜ菲赫金哥尔茨.微积分学教程第一卷一分册[M].北京:人民教育出版社,1959.(上接第21页)30。

主成分分析方法在像压缩中的应用

主成分分析方法在像压缩中的应用主成分分析方法在图像压缩中的应用图像压缩是一种有效降低图像数据量、减少图像存储空间和传输带宽的技术。

随着数字图像的广泛应用,图像压缩成为了一个重要的研究领域。

在图像压缩中,主成分分析(Principal Component Analysis,PCA)方法被广泛应用,本文将探讨主成分分析方法在图像压缩中的应用。

一、图像压缩原理和方法简介图像压缩的目标是通过尽可能少的数据存储和传输来表示和重建图像。

在图像压缩中,通常会使用两种基本的压缩方法:有损压缩和无损压缩。

有损压缩方法通过舍弃一些数据和信息来实现压缩,减少了存储空间和传输带宽的需求,但也丢失了一部分图像质量。

无损压缩方法则将图像压缩为与原始图像完全相同的数据,但需要更大的存储空间和传输带宽。

二、主成分分析方法简介主成分分析是一种统计学方法,用于降维数据以减少信息丢失。

它将高维数据转换为低维数据,同时最大程度地保留原始数据的差异。

主成分分析通过找到数据的主要特征方向(主成分),将数据投影到这些主成分上,以实现降维和压缩。

三、主成分分析方法在图像压缩中的应用主成分分析方法在图像压缩中的应用主要有两个方面:特征提取和数据降维。

1. 特征提取在图像压缩中,主成分分析可以用于提取图像的主要特征。

通过对图像进行主成分分析,可以找到图像中最重要和最相关的像素信息,并将这些信息用于重建图像。

使用主成分分析进行特征提取可以减少图像数据的冗余性,达到压缩图像数据的目的。

2. 数据降维主成分分析可以将高维图像数据降维为低维数据,从而减少图像数据的存储空间和传输带宽。

通过选择最具代表性的主成分,可以保留大部分数据信息并实现图像的重建。

主成分分析降维的过程是通过计算协方差矩阵、求解特征值和特征向量,选择前N个主成分进行数据投影来实现的。

四、主成分分析方法在图像压缩中的效果评估为了评估主成分分析方法在图像压缩中的效果,可以使用均方误差(Mean Squared Error,MSE)和峰值信噪比(Peak Signal-to-Noise Ratio,PSNR)作为评价指标。

基于主成分分析的高光谱数据压缩与重构方法研究

基于主成分分析的高光谱数据压缩与重构方法研究近年来,随着高光谱遥感技术的发展,人们越来越能够使用高光谱数据获取地球表面的信息。

高光谱数据的处理需要大量的计算和存储资源,因此数据压缩和重构方法的研究在高光谱数据处理中变得至关重要。

本文旨在研究基于主成分分析的高光谱数据压缩与重构方法。

一、高光谱数据简介高光谱数据是指在可见光波段外的波长范围内采集的连续光谱数据,其包含了每一个像素点的光谱信息,可以用来提取出目标区域内不同物质的成分和空间分布信息等。

因此,在许多领域,如农业、地质、环境、遥感和人工智能等领域中,高光谱数据的应用都非常广泛。

在高光谱数据的处理中,数据占据了最大的存储和计算资源。

因此,高光谱数据的压缩和重构方法变得尤为重要。

二、主成分分析简介主成分分析(Principal Component Analysis,简称PCA)是一种常用的数据分析方法,用于发现数据中的主要成分。

在高光谱数据处理中,PCA可以将高维的数据降维为低维数据,并能够保留数据中最重要的信息。

在PCA中,首先需要求解数据的协方差矩阵。

协方差矩阵的特征向量和特征值可以用来描述数据的主成分。

通过保留其中一部分的主成分,可以实现数据的降维,同时保留数据中的大部分重要信息。

三、基于PCA的高光谱数据压缩方法基于PCA的高光谱数据压缩方法的基本思路是,先通过PCA 将高光谱数据降维,再进行编码和压缩。

具体步骤如下:1. 计算高光谱数据的协方差矩阵;2. 求解协方差矩阵的特征向量和特征值;3. 选择其中一部分特征向量作为主成分,对高光谱数据进行降维;4. 对降维后的数据进行编码和压缩。

在该方法中,选择保留多少的主成分对数据的压缩效果起着至关重要的作用。

如果保留的主成分过多,虽然能够保留大部分数据信息,但会增加压缩后数据的体积。

相反,如果保留的主成分过少,则可能会丢失数据中的重要信息。

因此,在进行PCA降维时需要根据具体应用场景来决定保留数据的主成分个数。

回归讲稿_8_12年

cov(Yi, Yj ) = i' j = i' jj = 0, i j

5

§8.1 主成分回归

二、主成分的基本性质2

5

由以上结论,我们把 X1, X2, ..., Xp 的协方差矩阵 的非零特征值 1 2 ... p > 0 对应的标准化特征向量 1, 2, ..., p 分别作为系数 向量, Y1 = 1' X , Y2 = 2' X , ..., Yp = p' X 分别称为第一主成分、第 二主成分、……、第 p 主成分。 性质1: Y 的协方差矩阵为对角矩阵 ,其对角元素为 1, 2, ..., p. 性质2: 记 = ( ij )pp,则 i i i . 称 k = 称

点击Analyze → Dimension Reduction → Factor 进入因子分析 (含主成分 分析) 对话框;

把 x1 ~ x5 这 5 个变量选入Variables变量框条中;

点击 Extraction 按钮把抽取因子 (主成分) 数目(Fixed number of factors) 设为 5;也就是原始变量个数;

Extraction Method: Principal Component Analysis. a. 5 components extracted.

10

三、主成分回归实例4

§8.1 主成分回归

10

SPSS的做因子分析时可以输出因子得分,表8.1(p.192)是其数 值。我们可以通过因子得分与主成分的关系计算出主成分。 在SPSS的因子分析可得因子得分矩阵 Fac = X**A–1, 所以, 对第 i 个样本的因子得分为 Fac(i) = –1A' X**(i) ( i = 1, 2, ..., n )。 而主成分得分矩阵

主成分分析、聚类分析、因子分析的基本思想及优缺点

之马矢奏春创作主成份分析:利用降维(线性变换)的思想, 在损失很少信息的前提下把多个指标转化为几个综合指标(主成份),用综合指标来解释多变量的方差- 协方差结构, 即每个主成份都是原始变量的线性组合,且各个主成份之间互不相关,使得主成份比原始变量具有某些更优越的性能(主成份必需保管原始变量90%以上的信息), 从而到达简化系统结构, 抓住问题实质的目的综合指标即为主成份.求解主成份的方法:从协方差阵动身(协方差阵已知), 从相关阵动身(相关阵R已知).(实际研究中, 总体协方差阵与相关阵是未知的, 必需通过样本数据来估计)注意事项:1. 由协方差阵动身与由相关阵动身求解主成份所得结果纷歧致时, 要恰当的选取某一种方法;2. 对怀抱单元或是取值范围在同量级的数据, 可直接求协方差阵;对怀抱单元分歧的指标或是取值范围彼此不同非常年夜的指标, 应考虑将数据标准化, 再由协方差阵求主成份;3.主成份分析不要求数据来源于正态分布;4. 在选取初始变量进入分析时应该特别注意原始变量是否存在多重共线性的问题(最小特征根接近于零, 说明存在多重共线性问题).优点:首先它利用降维技术用少数几个综合变量来取代原始多个变量, 这些综合变量集中了原始变量的年夜部份信息.其次它通过计算综合主成份函数得分, 对客观经济现象进行科学评价.再次它在应用上偏重于信息贡献影响力综合评价.缺点:当主成份的因子负荷的符号有正有负时, 综合评价函数意义就不明确.命名清晰性低.聚类分析:将个体(样品)或者对象(变量)按相似水平(距离远近)划分类别, 使得同一类中的元素之间的相似性比其他类的元素的相似性更强.目的在于使类间元素的同质性最年夜化和类与类间元素的异质性最年夜化..其主要依据是聚到同一个数据集中的样本应该彼此相似, 而属于分歧组的样本应该足够不相似.经常使用聚类方法:系统聚类法, K-均值法, 模糊聚类法, 有序样品的聚类, 分解法, 加入法.注意事项:1. 系统聚类法可对变量或者记录进行分类, K-均值法只能对记录进行分类;2. K-均值法要求分析人员事先知道样品分为几多类;3. 对变量的多元正态性, 方差齐性等要求较高.应用领域:细分市场, 消费行为划分, 设计抽样方案等优点:聚类分析模型的优点就是直观, 结论形式简明.缺点:在样本量较年夜时, 要获得聚类结论有一定困难.由于相似系数是根据被试的反映来建立反映被试间内在联系的指标, 而实践中有时尽管从被试反映所得出的数据中发现他们之间有紧密的关系, 但事物之间却无任何内在联系, 此时, 如果根据距离或相似系数得出聚类分析的结果, 显然是不适当的, 可是, 聚类分析模型自己却无法识别这类毛病.因子分析:利用降维的思想, 由研究原始变量相关矩阵内部的依赖关系动身, 把一些具有扑朔迷离关系的变量归结为少数几个综合因子.(因子分析是主成份的推广, 相对主成份分析, 更倾向于描述原始变量之间的相关关系), 就是研究如何以最少的信息丧失, 将众多原始变量浓缩成少数几个因子变量, 以及如何使因子变量具有较强的可解释性的一种多元统计分析方法.求解因子载荷的方法:主成份法, 主轴因子法, 极年夜似然法, 最小二乘法, a因子提取法.注意事项:5. 因子分析中各个公共因子之间不相关, 特殊因子之间不相关, 公共因子和特殊因子之间不相关.应用领域:解决共线性问题, 评价问卷的结构效度, 寻找变量间潜在的结构, 内在结构证实.优点:第一它不是对原有变量的取舍, 而是根据原始变量的信息进行重新组合, 找出影响变量的共同因子, 化简数据;第二, 它通过旋转使得因子变量更具有可解释性, 命名清晰性高.缺点:在计算因子得分时, 采纳的是最小二乘法, 此法有时可能会失效.判别分析:从已知的各种分类情况中总结规律(训练出判别函数), 当新样品进入时, 判断其与判别函数之间的相似水平(概率最年夜, 距离最近, 离差最小等判别准则).经常使用判别方法:最年夜似然法, 距离判别法, Fisher判别法, Bayes判别法, 逐步判别法等.注意事项:1. 判别分析的基本条件:分组类型在两组以上, 解释变量必需是可测的;2. 每个解释变量不能是其它解释变量的线性组合(比如呈现多重共线性情况时, 判别权重会呈现问题);3. 各解释变量之间服从多元正态分布(不符合时, 可使用Logistic回归替代), 且各组解释变量的协方差矩阵相等(各组协方方差矩阵有显著不同时, 判别函数不相同).4. 相对而言, 即使判别函数违反上述适用条件, 也很稳健, 对结果影响不年夜.应用领域:对客户进行信用预测, 寻找潜在客户(是否为消费者, 公司是否胜利, 学生是否被录用等等), 临床上用于鉴别诊断.对应分析/最优标准分析:利用降维的思想以到达简化数据结构的目的, 同时对数据表中的行与列进行处置, 寻求以低维图形暗示数据表中行与列之间的关系.对应分析:用于展示变量(两个/多个分类)间的关系(变量的分类数较多时较佳);最优标准分析:可同时分析多个变量间的关系, 变量的类型可以是无序多分类, 有序多分类或连续性变量, 并对多选题的分析提供了支持.典范相关分析:借用主成份分析降维的思想, 分别对两组变量提取主成份, 且使从两组变量提取的主成份之间的相关水平到达最年夜, 而从同一组内部提取的各主成份之间互不相关.相同点:1.主成份分析法和因子分析法都是用少数的几个变量(因子) 来综合反映原始变量(因子) 的主要信息, 变量虽然较原始变量少, 但所包括的信息量却占原始信息的85 %以上, 所以即使用少数的几个新变量, 可信度也很高, 也可以有效地解释问题.而且新的变量彼其间互不相关, 消除多重共线性.2.这两种分析法得出的新变量, 其实不是原始变量筛选后剩余的变量.在主成份分析中, 最终确定的新变量是原始变量的线性组合, 如原始变量为x1 , x2 , . . . , x3 , 经过坐标变换, 将原有的p个相关变量xi 作线性变换, 每个主成份都是由原有p 个变量线性组合获得.在诸多主成份Zi 中, Z1 在方差中占的比重最年夜, 说明它综合原有变量的能力最强, 越往后主成份在方差中的比重也小, 综合原信息的能力越弱.因子分析是要利用少数几个公共因子去解释较多个要观测变量中存在的复杂关系, 它不是对原始变量的重新组合, 而是对原始变量进行分解, 分解为公共因子与特殊因子两部份.公共因子是由所有变量共同具有的少数几个因子;特殊因子是每个原始变量单独具有的因子.3.对新发生的主成份变量及因子变量计算其得分, 就可以将主成份得分或因子得分取代原始变量进行进一步的分析, 因为主成份变量及因子变量比原始变量少了许多, 所以起到了降维的作用, 为我们处置数据降低了难度.4.聚类分析是把研究对象视作多维空间中的许多点, 并合理地分成若干类, 因此它是一种根据变量域之间的相似性而逐步归群成类的方法, 它能客观地反映这些变量或区域之间的内在组合关系.它是通过一个年夜的对称矩阵来探索相关关系的一种数学分析方法, 是多元统计分析方法, 分析的结果为群集.对向量聚类后, 我们对数据的处置难度也自然降低, 所以从某种意义上说, 聚类分析也起到了降维的作用.分歧之处:1.主成份分析是研究如何通过少数几个主成份来解释多变量的方差一协方差结构的分析方法, 也就是求出少数几个主成份(变量) , 使它们尽可能多地保管原始变量的信息, 且彼此不相关.它是一种数学变换方法, 即把给定的一组变量通过线性变换, 转换为一组不相关的变量(两两相关系数为0 , 或样本向量彼此相互垂直的随机变量) , 在这种变换中, 坚持变量的总方差(方差之和) 不变, 同时具有最年夜方差, 称为第一主成份;具有次年夜方差, 称为第二主成份.依次类推.若共有p 个变量, 实际应用中一般不是找p 个主成份, 而是找出m (m < p) 个主成份就够了, 只要这m 个主成份能反映原来所有变量的绝年夜部份的方差.主成份分析可以作为因子分析的一种方法呈现.2.因子分析是寻找潜在的起支配作用的因子模型的方法.因子分析是根据相关性年夜小把变量分组, 使得同组内的变量之间相关性较高, 但分歧的组的变量相关性较低, 每组变量代表一个基本结构, 这个基本结构称为公共因子.对所研究的问题就可试图用最少个数的不成测的所谓公共因子的线性函数与特殊因子之和来描述原来观测的每一分量.通过因子分析得来的新变量是对每个原始变量进行内部剖析.因子分析不是对原始变量的重新组合, 而是对原始变量进行分解, 分解为公共因子和特殊因子两部份.具体地说,就是要找出某个问题中可直接丈量的具有一定相关性的诸指标,如何受少数几个在专业中有意义、又不成直接丈量到、且相对自力的因子支配的规律, 从而可用各指标的测定来间接确定各因子的状态.因子分析只能解释部份变异, 主成份分析能解释所有变异.3.聚类分析算法是给定m 维空间R 中的n 个向量, 把每个向量归属到k 个聚类中的某一个, 使得每一个向量与其聚类中心的距离最小.聚类可以理解为: 类内的相关性尽量年夜, 类间相关性尽量小.聚类问题作为一种无指导的学习问题, 目的在于通过把原来的对象集合分成相似的组或簇, 来获得某种内在的数据规律.从三类分析的基本思想可以看出, 聚类分析中并没于发生新变量, 可是主成份分析和因子分析都发生了新变量.就数据标准化来说, 区别如下:1.主成份分析中为了消除量纲和数量级, 通常需要将原始数据进行标准化, 将其转化为均值为0方差为1 的无量纲数据.2.因子分析在这方面要求不是太高, 因为在因子分析中可以通过主因子法、加权最小二乘法、不加权最小二乘法、重心法等很多解法来求因子变量, 而且因子变量是每一个变量的内部影响变量, 它的求解与原始变量是否同量纲关系其实不太年夜, 固然在采纳主成份法求因子变量时, 仍需标准化.不外在实际应用的过程中, 为了尽量防止量纲或数量级的影响,建议在使用因子分析前还是要进行数据标准化.在构造因子变量时采纳的是主成份分析方法, 主要将指标值先进行标准化处置获得协方差矩阵, 即相关矩阵和对应的特征值与特征向量, 然后构造综合评价函数进行评价.3.聚类分析中如果介入聚类的变量的量纲分歧会招致毛病的聚类结果.因此在聚类过程进行之前必需对变量值进行标准化, 即消除量纲的影响.分歧方法进行标准化, 会招致分歧的聚类结果要注意变量的分布.如果是正态分布应该采纳z 分数法.总结来说:1. 目的分歧:因子分析把诸多变量看成由对每一个变量都有作用的一些公共因子和仅对某一个变量有作用的特殊因子线性组合而成, 因此就是要从数据中控查出对变量起解释作用的公共因子和特殊因子以及其组合系数;主成份分析只是从空间生成的角度寻找能解释诸多变量变异的绝年夜部份的几组彼此不相关的新变量(主成份).2. 线性暗示方向分歧:因子分析是把变量暗示成各公因子的线性组合;而主成份分析中则是把主成份暗示成各变量的线性组合.3. 假设条件分歧:主成份分析中不需要有假设;因子分析的假设包括:各个公共因子之间不相关, 特殊因子之间不相关, 公共因子和特殊因子之间不相关.4. 提取主因子的方法分歧:因子分析抽取主因子不单有主成份法, 还有极年夜似然法, 主轴因子法, 基于这些方法获得的结果也分歧;主成份只能用主成份法抽取.5. 主成份与因子的变动:当给定的协方差矩阵或者相关矩阵的特征值唯一时, 主成份一般是固定的;而因子分析中因子不是固定的, 可以旋转获得分歧的因子.6. 因子数量与主成份的数量:在因子分析中, 因子个数需要分析者指定(SPSS根据一定的条件自动设定, 只要是特征值年夜于1的因子主可进入分析), 指定的因子数量分歧而结果也分歧;在主成份分析中, 成份的数量是一定的, 一般有几个变量就有几个主成份(只是主成份所解释的信息量不等).7. 功能:和主成份分析相比, 由于因子分析可以使用旋转技术帮手解释因子, 在解释方面更加有优势;而如果想把现有的变量酿成少数几个新的变量(新的变量几乎带有原来所有变量的信息)来进入后续的分析, 则可以使用主成份分析.固然, 这种情况也可以使用因子得分做到, 所以这种区分不是绝对的.。

主成分分析简介课件

4、如未收敛则回到步骤3

注:其中 k和 k 是两个待调整的参数;

函数g(y)的选择见参考文献[2]P68

逐次提取独立成分

—投影追踪方法

度量非正态性(非高斯性):

可以认为,两个独立变量之和形成的分布比两 个原始变量中的任意一个都更接近于正态分布

由于Z是Y的线性组合,只要找到一个度 量非正态性的量,使达到最大,就可以 使Y中各分量独立性最大

所找到的矩阵起到将 Qz (M ) 对角化的作 用

基于四阶累积量的JADE法

步骤: 1、取一组矩阵 M i , 由定义分别求 Qz (M i ) (矩阵的简单取法:取N*N个矩阵,分别

只有一个元素为1,或取一组对称/反对 称的基矩阵,引自[2]P53) 通过优化求解U,使各 Qz (M i ) 联合 对角化(使 (M i ) 中非对角元素的平方 和最小)

此法的矩阵集合可取为 Z [K ijkliikk ijkl (Z )]2

分解结果:

Aˆ W U , Bˆ Aˆ 1 U W , Y BX U WX

非线性PCA的自适应算法

以均方误差最小作为收敛判据, 非线性PCA引入非线性因素等效于考虑高

阶矩 算法具体步骤为: 1、对观测值求均值,用递归法求白化阵

—投影追踪方法

5、归一化: ui (k 1) ui (k 1) 2

ui (k 1)

如果 u p 未收敛,回到步骤3;

令p加1,当p<=m时,回到步骤3。

参考文献

[1] A.Hyvarinen等著,周宗潭等译,独 立成分分析,北京:电子工业出版社, 2007年

[2]杨福生、洪波著,独立分量分析的原 理与应用,北京:清华大学出版社, 2006年

基于主成分分析与K-L变换的双重属性优化方法

基于主成分分析与K-L变换的双重属性优化方法赵加凡;陈小宏【摘要】利用主成分分析客观赋权原理计算地震属性在预测目标参数时贡献率的大小,通过去除权重系数较小的属性参数,实现了地震属性的敏感性分析,建立储层参数与有效属性之间的匹配关联;在此基础上,利用K-L变换将属性样本空间的高维属性映射为低维属性,去除了属性之间的相关性,有效地解决了属性组合的优化问题,表明了主成分分析和K-L变换相结合的属性双重优化方法克服了单纯使用每种方法时的局限性,充分发挥了各自的优点,有助于属性分析、关联以及组合优化问题的解决,提高了地震储层参数预测的运算速度和精度.【期刊名称】《物探与化探》【年(卷),期】2005(029)003【总页数】4页(P253-256)【关键词】地震数据处理;主成分分析;K-L变换;神经网络;属性组合与优化【作者】赵加凡;陈小宏【作者单位】石油大学,CNPC物探重点实验室,北京,102249;石油大学,CNPC物探重点实验室,北京,102249【正文语种】中文【中图分类】N37;P631.4地震属性优化是指利用专家的先验知识或数学方法,优选出对所求解问题最敏感的、属性个数最少的地震属性或地震属性组合,以提高储层参数预测精度,改善与地震属性有关的处理和解释效果。

属性优化是提高储层参数预测精度的重要途径[1]。

通常,属性优化过程包括属性的敏感性分析和多属性的优化。

近几年来,围绕多属性优化问题,涌现出很多新的方法,但是大多数方法或只针对属性选择,或者只针对属性样本分类,不能系统地解决属性分析和优化问题。

如何使选取的属性参数更具有代表性、如何有效地建立多属性与目标参数的关联,以及如何快速地优化属性,单纯地用一种方法都不可能很好地解决这个难题。

笔者提出了一种双重优化方法,即:利用主成分分析计算权重系数的客观赋权思想对地震属性进行敏感性分析,建立属性与目标预测参数的关联;然后利用K-L(Karhumen-loeve)变换进行属性组合的正交变换,从高维属性中优选出低维的属性组合。

压缩主成分估计

山 东 师 大 学 报 ( 然 科 学 版) 自 Ju a o hn o gNor l i ( aL Si e) or l f ad n rm n S r um t N td e n ̄ y 1 e

口 △1 +△2 2 ∞ .

其 中 △1 d ̄( 2 i 0, q— 1

,…

,

审 p )△ dgO l 1…, p 1. 一 ,2 h (1 一 , 一 ) ^

要 使 MS M( ) E  ̄ 一MS M( ≤0 只 须 △l 一△2 , , 口 , ≤ 一 △2az' =一( △2 ) E  ̄) , ≤ ∞ △ 2即 △1 , a' 2  ̄ , a 对 一切 都成 立 . 由于 △l , 以 ,2 一( △2 ) , , 一切 都 成立 . C uh —Sh az不等 式 <O所 0≥ . , 口 △l 对 从 acy cw r 可 得 一口 △ △2≥ 一( △2 ) , , 而 得到 ≥ 一( △2 ) , 成 立 的一 个 充 分条 件 是 口 ≥ , △2 口 , a △1 从 , 口 △l

中国分类号 o221 1 考 虑 线 性 回 归 模 型

j。 y_

其 中 Y 为 x1观测 向量 , 为 x

i () 0GvE= E e= ,_() J

n 1

…

P满列秩 设计 矩 阵 , Px1未知 参数 向量 , p为 E为 ×1随机误 差 向量 .

我 知 卢 L 估 的 方 差MEp= 们 道,的OS 计p 均 误 s() 耋^‘ 里^ A … > 为x 征 , , 1 2 ≥ 0 这 ≥ ≥ x特 根 当

f _

当 0:

: ,…. 1, r 2

( ≥0 )

I 南

4.3 主成分的性质

前m个主成分的贡献率之和

i 1 i i 1

m

p

i

称为主成分F1,F2, ⋯,Fm的累计贡献率,它表明F1,F2,

⋯,Fm解释X1,X2, ⋯,Xp的能力。

通常取(相对于p)较小的m ,使得累计贡献达到一个较 高的百分比(如80%~90%)。此时,F1,F2, ⋯,Fm可用 来代替X1,X2, ⋯,Xp,从而达到降维的目的,同时信息的损 失却不多。

12 5.83 * 0.383 1 0.925

2 2 2 * ( 0.924)

12 1 u21

5 0.998

13 0

5.原始变量对主成分的影响

Fk=t1kX1+t2kX2+⋯+tpkXp 称tik为第k主成分Fk在第i个原始变量Xi上的载荷,它度

量了Xi对Fk的重要程度。

* * 1 * 2

* p

有与总体主成分相同的性质。 ,

21

从R出发的主成分性质

* * (1)E(F*)=0,V(F*)=Λ*,其中 Λ* diag 1* , 2 ,, p

p

* (2) i p 。 i 1

(3)变量 X i与主成分 Fk 之间的相关系数 即有

*

*

例1 设 X 1 , X 2 , X 3的协方差矩阵为:

1 2 0 2 5 0 0 0 2

解得特征根为: 1 5.83 2 2.00 3 0.17

0 0.383 0 U U1 0.924 2 1 0.000

经计算,Σ的特征值及特征向量为

16 2 30 Σ 2 1 4 30 4 100

线性模型广义压缩预测的性质

线性模型广义压缩预测的性质刘丽芳【摘要】考虑线性模型的参数预测问题,在设计矩阵的复共线性下,提出了广义压缩预测,并讨论了它们的性质.%The author considered the parameter forecast problems for the linear model.And the author gave the generalized compressed predictor character of the model and discussed the character of them under the supposed condition.【期刊名称】《湖南城市学院学报(自然科学版)》【年(卷),期】2011(020)004【总页数】3页(P37-39)【关键词】线性模型;压缩估计;广义压缩预测【作者】刘丽芳【作者单位】湖南文理学院数学与计算科学学院,湖南常德415000【正文语种】中文【中图分类】O212.1设线性模型:(责任编校:库文珍)【相关文献】[1]张金槐. 线性模型参数估计及其改进[M]. 长沙: 国防科大出版社, 1999.[2]Trenkler G. Baised estimators in the linear regression model[M].Oelgeschlarger: Gunn and Hail, 1981.[3]Cheng P. Admissibility of simcdtaneous estimation of several parameters[J]. Journal of System Science and Mathmatical Sciences, 1982, 21: 176-195.[4]Rao C R. Estimation of parameters in a linear model[J]. Ann Math Statist, 1976, 4(6): 1023-1037.[5]王松桂. 有限总体的自适应岭型预测[J]. 科学通报, 1990(11):804-806.。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

(3)

(4)

2 )若 á ′[ I − ( I + A ) −1 ] 2 Ëá ≥

2σ 2 p[1 − (θ p λ p ) 2 ](θ1λ1 ) 2 2 − 3(θ1λ1 ) + (θ p λ p ) (θ1λ1 )

2 2 2

~ 时, â 在 PC 准则下不可能优于 ∠.

则

证明 利用文献[5] 的方法,取 C = ( X ′X ) − PAP ′X ′XPAP ′, G = ( X ′X )( I − PAP ′)C −1 ~ W ( â ,âˆ,â ) ≤ 0 ⇔ âˆ′ C∠− âˆ′ CGâ − â ′ G ′C∠+ â ′ G ′CGâ ≥ â ′ G ′CGâ ˆ − Gâ ) ≥ â ′ G ′CGâ ⇔ (∠− Gâ ) ′C ( â

2 设 U 服从自由度为 l 的非中心参数为 λ 的非中心卡方分布, 即 U ~ χ l2 (λ ) ,χ 0 .5 (l , λ )

表示非中心 χ l2 (λ ) 的中位数,则有

2 2 2 min ( χ 0 .5 (l , λ ) − λ ) = l − 1 , max ( χ 0.5 ( l , λ ) − λ ) = χ 0 .5 (l ) , λ λ 2 此处 χ 0 .5 (l ) 为自由度为 l 的中心卡方分布,此时显然有 2 P(U ≥ l − 1 + λ ) ≥ P(U ≥ χ 0 .5 (l , λ )) = 0. 5 . 证明 (3)式见文献[4] ,而(4)式是(3)式的结果. 定理 3 设仍令在损失(2)下: 2σ 2 ( p − 1)[1 − (θ 1λ1 ) 2 ](θ p λ p ) 2 ~ 时, â 在 PC 准则下优于 ∠. 1)若 á ′[ I − ( I + A ) −1 ] 2Ëá ≤ 2 2 2 2 − 3(θ p λ p ) + (θ 1λ1 ) (θ p λ p )

第 17 卷

第4期

李胜宏等:压缩主成分估计的一些性质

21

L ( d ,â ) = ( d − â ) ′ X ′X ( d − â ) = d − â ~ ˆ ~ 记 W ( â ,â ,â ) = â − â 引理 1

2 X ′X

2 X ′X

,

(2)

− ∠− â

2 X ′X

.

为证下面定理需要以下引理.

又因为 ( X ′X ) −1 正定,故 ( X ′X ) −1 = LL′ ,使 RL′CLR ′ = D 为对角阵,若将上式左边记为 U , ˆ − â ),â * = RL−1 ( I − G )â ˆ * +â * ) 则 U = ( ∠* +â * ) ′ D( â 其中 âˆ* = RL−1 ( â 由 Courant 定理可知 1 − (θ1λ1 ) 2 = d p ≤ ˆ * +â *) ′D ( â ˆ * +â * ) (â ≤ d1 = 1 − (θ p λ p ) 2 ˆ ˆ ′ (â * +â * ) ( â * +â * ) 其中 d1 , d p 为 D 的最大、最小特征值.于是 ˆ * +â * ) ≥ U ≥ d p ( â ˆ * +â * ) ′( ∠* +â * ) . d 1 ( ∠* +â * ) ′( â 再由 Courant 定理 1 â ′ G ′CGâ 1 − 1 = hp ≤ ≤ h1 = −1, 2 ′ ′ ′ ( ) ( ) â I − G X I − G â θ (θ 1λ1 ) pλp (6) (5)

2) 0 < θ p λ p ≤ L ≤ θ 1λ1 < 1 . ~ 称 â = PAP ′ ∠为 â 的 压 缩 主 成 分 估 计 , 这 里 A = diag (θ 1λ1 , θ 2 λ 2 , L ,θ p λ p ) , P ′X ′XP =

−1 diag( λ1 , λ 2 L , λ p ) , ∠= ( X ′X ) X ′Y .

收稿日期:2003-04-27 作者简介:李胜宏(1977- ) ,女,山东菏泽人,硕士研究生,主要从事数理统计的研究.

20

五邑大学学报(自然科学版)

2003 年

~ −1 当θ i = λk i , i = 1, L , p, 0 < k < 1 时, â 为根方有偏估计. ~ 张启全在文献 [3] 中对 â 的优良性作了很多工作,本文做一些补充 . 证明了此估计在一定条 ~ ~ ~ ,且有更好的优效性,在 PC 准则下也优于 â . 件下, â 比 â 有更小的广义均方误差(GMSE)

1 GMSE 下压缩主成分估计相对于 LS 的优良性

~ 定理 1 在椭球 á ′( I − A ) 2Ëá ≤ ó 2 ( P − tr A 2 ) 内, GMSE( â ) ≤ GMSE( âˆ) 其中 á = P ′â , P 、 A 如定义 1,以下也如此. 证明 ˆ − â ) ′ X ′X ( ∠− â ) = tr{cov[( X ′X ) 2 ( ∠− â )]} = pσ 2 GMSE( âˆ) = E ( â ~ ˆ− â ) = GMSE( â ) = E ( PAP ′∠− â ) ′ X ′X ( PAP ′â ˆ − PAP ′â + PAP ′â − â ) ′ X ′X ( PAP ′â ˆ − PAP ′â + PAP ′â − â ) = E ( PAP ′â ˆ − PAP ′â ) ′ X ′X ( PAP ′â ˆ − PAP ′â ) + E ( PAP ′â − â ) ′ X ′X ( PAP ′â − â ) = E ( PAP ′â ˆ − â ) + â ′( I − PAP ) ′ X ′X ( I − PAP )â = E ( ∠− â ) ′ PAP ′X ′XPA P ′( â

≤

σ 2 tr( AË −1 ) p −1 + σ 2θ P + á ′ á σ 2 tr( AË −1 ) P −1 + σ 2 / λ P

上式成立,因为当 a < b 时,

x+a 是 x 的递增函数. ( AË −1 ) p −1 为 AË −1 的前 p − 1 阶矩阵. x+b ~ 以上定理证明了在一定条件下, â 改进了 ∠.

2 2 2 2 2 2 ⇔ á ′( I − A ) Ëá ≤ pσ − σ tr( A ) = σ ( p − tr A ) . 得证. 相对效率是比较两个估计量好坏的另一主要标准,采用文献[4] 中的相对效率概念如下: ˆ) cov(θ 1 ˆ 相对于 θ ˆ 的效率,其中 • = tr(•) ,θ ˆ ,θ ˆ ˆ ˆ ˆ ˆ 为θ 称 e(θ 1 | θ 2 ) = 1 2 1 2 为 θ 的估计 . e(θ 1 | θ 2 ) ˆ) cov(θ 2

2 PC 准则下的优良性

ˆ 、θ ˆ 是 参 数 θ 的 两 个 不 同 估 计 , θ ∈ Θ , L (•, θ ) 为 损 失 函 数 , 如 果 满 足 定义 2 设θ 1 2 ˆ ˆ ˆ 在 PC 准则下优于 θ ˆ . 此处 Θ P( L (θ1 , θ ) ≤ L (θ 2 , θ )) ≥ 0.5 且严格不等式至少对一个成立, 则称 θ 1 2 为参数空间. 本节取损失函数

其中 h1 , h p 为 H = ( G ′CG )[( I − G ) ′ X ′X ( I − G )] −1 的最大、最小特征值.于是 h pâ ′( I − G ) ′ X ′X ( I − G ) â ≤ â ′ E ′CGâ ≤ h1â ′( I − G ) ′ X ′X ( I − G ) â . 因为 âˆ* ~ N (0, σ 2 I ), 其中 λ = 故 1 ˆ ( â * +â * ) ′( ∠* +â * ) ~ χ 2 p(λ), σ2

第 17 卷 第 4 期 2003 年 12 月

JOURNAL

OF

五邑大学学报(自然科学版) WUYI UNIVERSITY (Natural Science Edition)

Vol.17 No.4 Dec. 2003

文章编号:1006-7302(2003)04-功

(湘潭大学 数学系,湖南 湘潭 411105)

摘要:讨论了压缩主成分估计的一些性质,证明了在一定条件下,此估计比最小二乘估计 有更小的广义均方误差并且在 PC 准则下也优于最小二乘估计. 对 Y 的预测量做了比较. 关键词:压缩主成分估计;广义均方误差;PC 准则 中图分类号:O212.0 设有线性模型 Yn×1 = X n× pâ p×1 + å n×1 å ~ N (0, σ 2 I n ) (1) 其中 Y 为观测阵, X 为设计阵, â 为待估参数, å 为随机误差阵,设 R( X ) = p. 当设计阵 X 含有多重共线性时, X ′X 接近奇异,它的某些特征值接近于 0. 这使最小二乘 2 1 估计( LS ) ∠= ( X ′X ) − X ′Y 的均方误差变得很大 ,使平均模 E ( âˆ′ âˆ) = MSE( âˆ) + â 过长,其中 λ1 ≥ λ 2 ≥ L λ p > 0 为 X ′X 的特征值,因此使得对 ∠的改进变得十分重要. 为了改进 ∠,人们提出了一些有偏压缩估计,如岭估计、岭型组合主成分估 计 [1] 、 stein 压 缩估计、变根有偏估计 [2] 等 . 由张启全在文献 [3] 中提出的压缩主成分估计,包含了以上估计, 定义如下: 定 义 1 对 ( 1 ) 式 的 线 性 模 型 , 若 ∃r ,1 ≤ r ≤ p, 使 λ1 ≥ λ 2 ≥ L ≥ λ r ≥ 1 > λ r +1 ≥ L ≥ λ p > 0, θ i (i = 1,2, L , p) 满足: 1) 0 < θ1 ≤ θ 2 ≤ L ≤ θ p < 1 ; 文献标识码:A