多源数据融合算法综述

多源信息融合软件的设计与实现精编WORD版

多源信息融合软件的设计与实现精编W O R D 版 IBM system office room 【A0816H-A0912AAAHH-GX8Q8-GNTHHJ8】

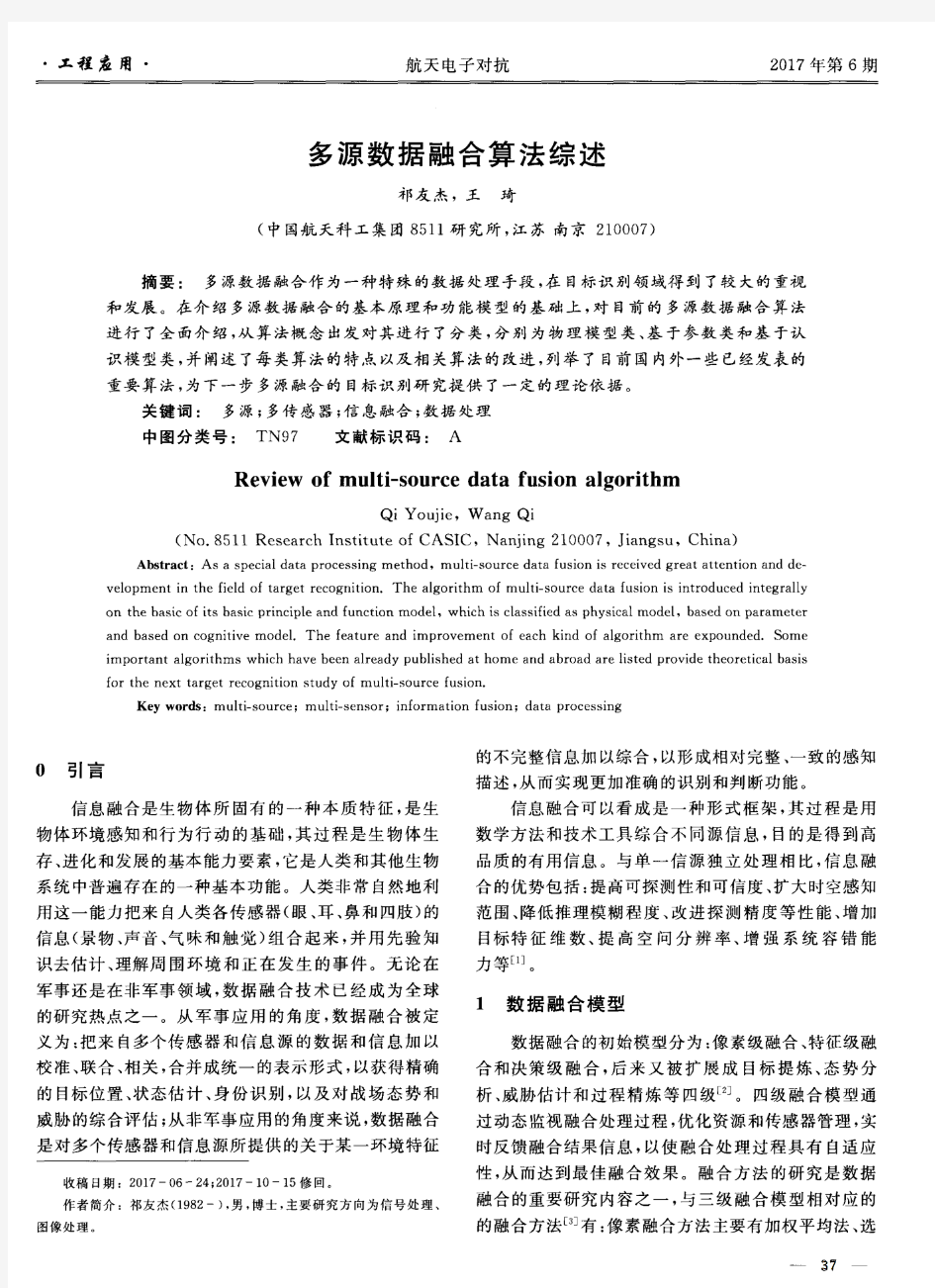

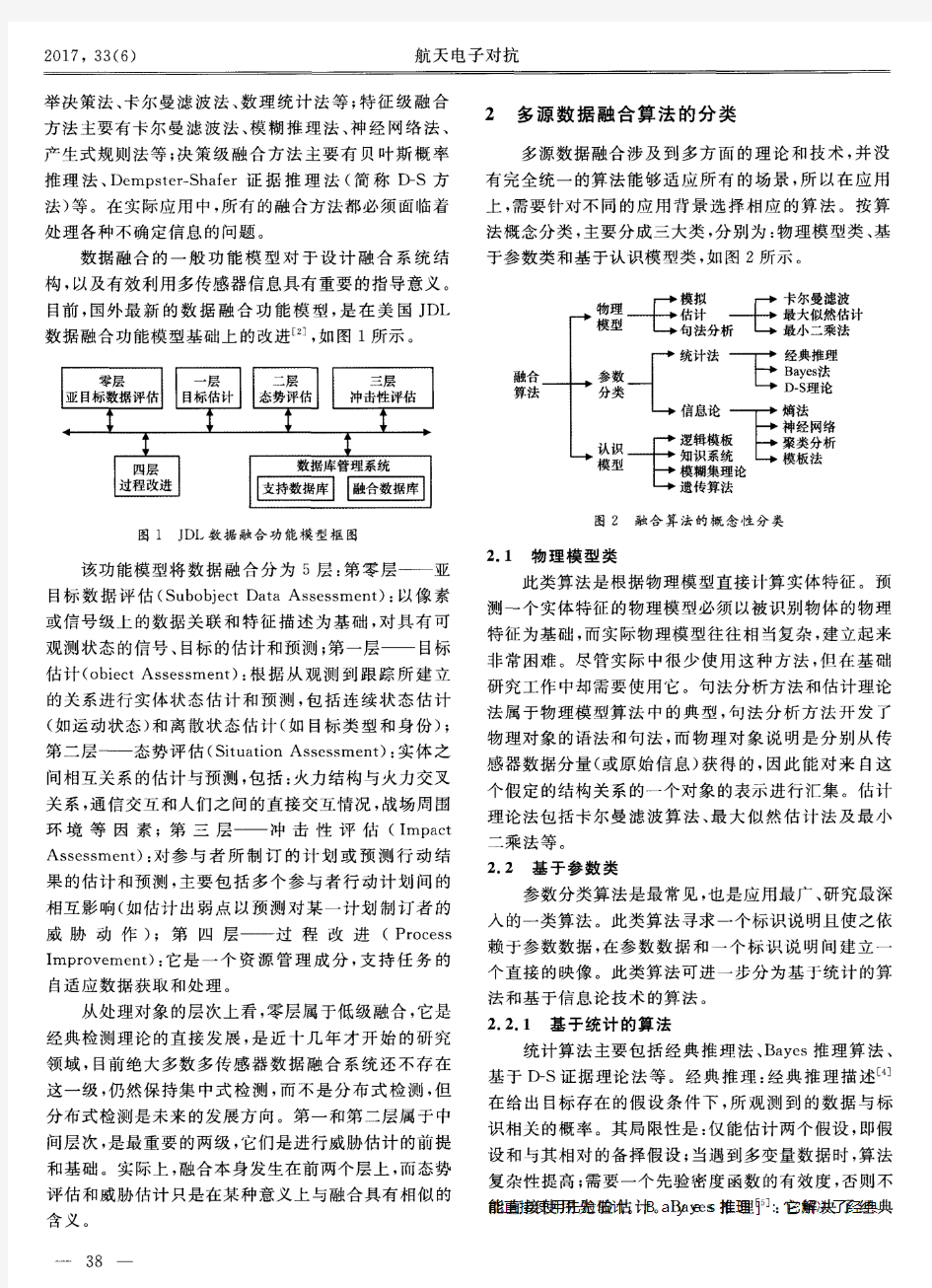

多源信息融合软件的设计与实现 摘要:针对多源信息类型不一致影响信息利用效率的问题,文章在分析传统多源数据融合模型的基础上,研究了多源信息融合软件的架构及相关技术,设计并开发的软件具有较高的实用价值。 关键词:多源信息;信息融合;软件开发 多源信息融合是通过将多种信源在空间上和时间上的互补与冗余信息依据某种优化准则组合起来,产生对特点对象的一致性解释与描述。数据融合技术是指利用计算机对获得的信息,在一定准则下加以自动分析、综合,以完成所需决策和评估任务而进行的信息处理技术。主要包括对各类信息源给出有用信息的采集、传输、综合、过滤、相关及合成,以便辅助人们进行态势/环境判定、规划、探测、验证。 数据格式统一是进行数据处理的前提。由于信息的来源多,数据格式类别差异较大,对于数据处理带来不便。多源信息融合软件能够实现多源异构数据信息整合,对于充分利用信息资源、提高数据处理系统性能具有实用价值。 1 多源数据融合模型 根据对输入信息的抽象或融合输出结果的不同,可以将信息融合分为不同的3级,包括数据级融合、特征级融合及决策级融合。 作为数据级的多源数据融合模型的结构如图1所示。多源数据经过数据清理、数据集成、数据变换,形成有效数据,通过数据处理形成数据挖掘分析等处理工作的有效数据。

数据清理是指去除源数据集中的噪声数据和无关数据,处理遗留数据和清洗脏数据,去除数据域的知识背景上的白噪声,考虑时间顺序和数据变化等。主要包括处理噪声数据,处理空值,纠正不一致数据等。 数据集成就是将多文件或多数据库运行环境中的异构数据进行合并处理,将多个数据源中的数据结合起来存放在一个一致的数据存储中。 数据变换就是将数据变换成统一的适合处理的形式。数据变换主要包括平滑、聚集、属性构造、数据泛化和规范化等内容。 2 多源信息融合软件设计 2.1 软件架构 多源信息融合软件的技术要求是实现多源异构数据向指定关系数据库进行可靠转换。就是按照指定关系数据库的表结构要求,实现多源异构数据的数据导入及格式转换问题。软件的组成框图如图2所示。软件主要包括2个主要模块,多源数据预处理模块和数据导入模块。数据预处理模块主要进行数据清理及格式转换,实现常用的数据(txt、xls、关系数据库等数据)转换为目标数据库支持的数据格式。数据导入实现指定类型数据转换为指定结构数据。 2.2 关键技术 为了保证多源信息软件的可靠运行,需解决数据类型的适应性和扩展性问题,以及数据转换的可靠性、可预制性、数据转换过程的可监督性问题。 2.2.1 基于模块化设计的类型转换

聚类分析K-means算法综述

聚类分析K-means算法综述 摘要:介绍K-means聚类算法的概念,初步了解算法的基本步骤,通过对算法缺点的分析,对算法已有的优化方法进行简单分析,以及对算法的应用领域、算法未来的研究方向及应用发展趋势作恰当的介绍。 关键词:K-means聚类算法基本步骤优化方法应用领域研究方向应用发展趋势 算法概述 K-means聚类算法是一种基于质心的划分方法,输入聚类个数k,以及包含n个数据对象的数据库,输出满足方差最小标准的k个聚类。 评定标准:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算。 解释:基于质心的划分方法就是将簇中的所有对象的平均值看做簇的质心,然后根据一个数据对象与簇质心的距离,再将该对象赋予最近的簇。 k-means 算法基本步骤 (1)从n个数据对象任意选择k 个对象作为初始聚类中心 (2)根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离;并根据最小距离重新对相应对象进行划分 (3)重新计算每个(有变化)聚类的均值(中心对象) (4)计算标准测度函数,当满足一定条件,如函数收敛时,则算法终止;如果条件不满足则回到步骤(2) 形式化描述 输入:数据集D,划分簇的个数k 输出:k个簇的集合 (1)从数据集D中任意选择k个对象作为初始簇的中心; (2)Repeat (3)For数据集D中每个对象P do (4)计算对象P到k个簇中心的距离 (5)将对象P指派到与其最近(距离最短)的簇;

(6)End For (7)计算每个簇中对象的均值,作为新的簇的中心; (8)Until k个簇的簇中心不再发生变化 对算法已有优化方法的分析 (1)K-means算法中聚类个数K需要预先给定 这个K值的选定是非常难以估计的,很多时候,我们事先并不知道给定的数据集应该分成多少个类别才最合适,这也是K一means算法的一个不足"有的算法是通过类的自动合并和分裂得到较为合理的类型数目k,例如Is0DAIA算法"关于K一means算法中聚类数目K 值的确定,在文献中,根据了方差分析理论,应用混合F统计量来确定最佳分类数,并应用了模糊划分嫡来验证最佳分类数的正确性。在文献中,使用了一种结合全协方差矩阵RPCL算法,并逐步删除那些只包含少量训练数据的类。文献中针对“聚类的有效性问题”提出武汉理工大学硕士学位论文了一种新的有效性指标:V(k km) = Intra(k) + Inter(k) / Inter(k max),其中k max是可聚类的最大数目,目的是选择最佳聚类个数使得有效性指标达到最小。文献中使用的是一种称为次胜者受罚的竞争学习规则来自动决定类的适当数目"它的思想是:对每个输入而言不仅竞争获胜单元的权值被修正以适应输入值,而且对次胜单元采用惩罚的方法使之远离输入值。 (2)算法对初始值的选取依赖性极大以及算法常陷入局部极小解 不同的初始值,结果往往不同。K-means算法首先随机地选取k个点作为初始聚类种子,再利用迭代的重定位技术直到算法收敛。因此,初值的不同可能导致算法聚类效果的不稳定,并且,K-means算法常采用误差平方和准则函数作为聚类准则函数(目标函数)。目标函数往往存在很多个局部极小值,只有一个属于全局最小,由于算法每次开始选取的初始聚类中心落入非凸函数曲面的“位置”往往偏离全局最优解的搜索范围,因此通过迭代运算,目标函数常常达到局部最小,得不到全局最小。对于这个问题的解决,许多算法采用遗传算法(GA),例如文献中采用遗传算法GA进行初始化,以内部聚类准则作为评价指标。 (3)从K-means算法框架可以看出,该算法需要不断地进行样本分类调整,不断地计算调整后的新的聚类中心,因此当数据量非常大时,算法的时间开销是非常大 所以需要对算法的时间复杂度进行分析,改进提高算法应用范围。在文献中从该算法的时间复杂度进行分析考虑,通过一定的相似性准则来去掉聚类中心的候选集,而在文献中,使用的K-meanS算法是对样本数据进行聚类。无论是初始点的选择还是一次迭代完成时对数据的调整,都是建立在随机选取的样本数据的基础之上,这样可以提高算法的收敛速度。

聚类算法综述

西南民族大学学报·自然科学版第37卷5月专辑 Journal of Southwest University for Nationalities ?Natural Science Edition May. 2011___________________________________________________________________ ___________________________ 收稿日期:2011-03-01 作者简介:向培素(1974-), 女, 副教授, 主要研究方向: 计算机应用, 检索技术. 基金项目:本文是“西南民族大学校级科研项目”(09NYB007)的研究成果之一. 文章编号: 1003-2843(2011)05专-0112-03 聚类算法综述 向培素 (西南民族大学电气信息工程学院, 四川成都 610041) 摘 要: 聚类分析是一种基本的数据分析方法,它在数据挖掘,统计学,空间数据库技术,人工智能,生物学研究,机器学习, 模式识别等领域都得到了广泛的应用. 论文介绍了各类主要的聚类算法,并概述了其主要应用领域. 关键词: 聚类算法; 半监督聚类 中图分类号: G642 文献标志码: A doi :10.3969/j.issn.1003-2483.2011.05专.33 随着信息技术的发展, 人们积累了越来越多的音、视频数据, 以及文本, 图片等数据, 为了从这些海量数据中查找, 提取有用信息, 出现了数据挖掘技术. 聚类作为数据挖掘的重要技术之一, 在机器学习、工程学、神经网络、生物学、统计学、地球科学以及社会科学和经济学等许多领域起着越来越重要的作用. 传统的聚类算法大致分为两类:层次聚类算法, 分割聚类算法. 1 层次聚类算法 层次聚类是对给定的数据对象的集合进行层次的分界, 根据一些指定标准把数据排列成一个树状结构的算法. 根据层次分界的表示方式, 层次聚类方法又可以分为凝聚的和分裂的两种. 凝聚算法先将每个数据作为一个簇, 然后根据一定的规则将簇合并, 凝聚算法又有单连接(single linkage)、全连接(complete linkage)和平均连接(average linkage)方法. 单连接是指当两个簇之间存在互连的边, 并且簇中数据最小距离小于等于给定的阈值, 则认为这两个簇的距离足够小, 可以合并. 全连接和单连接类似, 不过全连接是使用簇中数据的最大距离作为簇间距离. 平均连接使用两簇中数据的两两距离的平均值作为簇间距离. 分裂聚类先将所有数据归在一个簇里, 然后对簇中联系不紧密的数据进行分裂, 分到其他簇里, 分裂聚类有一些简化的算法, 如单元分裂法和多元分裂法. 单元分裂法每一次选取一个变量对簇进行分裂, 和变量相同的数据归为一类, 和变量不同的数据归为另一类. 多元分裂则是选取一个距离其他数据最远的数据构成分离组, 然后计算簇中每一个数据距离分离组的距离并和该数据与簇中其他数据的距离进行比较, 若该数据距离分离组的距离更近, 则将该数据划入分离组. 重复这个过程, 直到找不到这样的数据为止. 2 分割聚类算法 分割聚类法先对所有数据点进行较为粗略的划分, 然后通过重复的迭代算法使某个准则达到最优化来对划分进行修正. 分割聚类法又可以分为基于密度的算法, 基于网格的算法, 基于图论的算法, 基于平方误差的迭代重分配算法.

一种多源异构数据融合技术在PGIS系统中的研究与应用

一种多源异构数据融合技术在PGIS系统中 的研究与应用 周凯1,2 (1.四川省公安科研中心,四川成都610015;2.四川大学,四川成都610064) [摘要]警用地理信息系统是公安机关维稳处突、打击违法犯罪行为的重要技术支撑平台。多源异构数据是维护该平台安全稳定、高效运行的底层核心数据。文章以某PGIS平台为例,针对多源异构数据使用中遇到的数据不兼容、格式不统一、属性数据非空间化、空间数据格式转化等问题,提出了一种多源异构数据的融合模型。通过属性清洗、属性追加、空间匹配、格式转化等流程化操作,实现了空间与非空间、结构与非结构等数据的融合使用。并可以基于PGIS平台,统一加载、统一展示、统一应用。通过利用该技术,挖掘了数据的利用价值,为类似平台数据处理提供了技术参考与经验。 [关键词]多源异构;PGIS;数据融合 [中图分类号]P208[文献标识码]A[文章编号]1674-5019(2019)02-0051-05 A Multi-Source Heterogeneous Data Fusion Technology in PGIS System Research and Application ZHOU Kai 1引言 数据融合的本质是多方数据协同处理,以达到减少冗余、综合互补和捕捉协同信息的目的。该技术已成为数据处理、目标识别、态势评估以及智能决策等领域的研究热点[1]。通过数据融合,能够将研究对象获取的所有信息全部统一在一个时空体系内,得到比单独输入数据更多的信息。警用地理信息系统(Police Geographic Information System,简称“PGIS”)是多源异构数据技术、地理信息技术和公安系统业务工作高度结合的产物[2]。利用多源异构数据融合技术的PGIS平台,可以实现跨省、市、县等行政区域的一张图展示,可达到资源的高度统一利用。但在实际工作过程中,支撑PGIS平台的基础地理信息数据种类繁多,从平面线划图到精细化三维成果,从空间数据到非空间数据,从海量兴趣点数据(poi)到各种图像数据应有尽有。面对大数据时代海量的数据资源,如何保障PGIS平台业务数据、测绘地理信息数据、“一标三实”等数据高效利用,互补短板,统一承载于警用地理信息平台,协同发挥数据最大价值,提高数据在分析决策中的应用价值,是当下PGIS平台发展研究的热点问题[2-3]。 2研究方法2.1多源异构数据融合技术 数据集成是数据融合的基础,融合是集成基础上的深化应用,通过数据集成与融合,可派生出更高更有价值的新数据,从而得到数据的更多利用价值[4]。马茜等人[5]基于物联网背景下多源数据获取、存储等存在的不足,提出了一种约束数据质量的异构多源多模态感知数据获取方法,提高了数据精度,降低了网络资源消耗。韩双旺[6]基于XML语言实现异构多源空间数据的映射和模式转换,利用WebGIS技术实现了空间数据的集成和互操作。惠国保[7]结合深度学习技术,构思了一种泛化性强的多源异构影像数据融合深度学习模型,实现了深度学习技术在多源异构数据方面的信息提取与挖掘。李文闯等人[8]提出了一种基于可交换图像文件(EXIF)原理以数字图像为载体融合空间位置信息和一般形式属性的数据模型,实现了空间位置和一般属性嵌入到数字图像物理结构,达到了数据融合的效果。 本文不仅需要解决各种数据的属性嵌套、数据集成,而且要解决空间数据和非空间数据、空间数据与空间数据、结构数据与非结构数据之间的转化问题。因此鉴于实际需求,本文提出了基于FME平台下自主构建多源异构数据引擎,开展数据融合,实现多源异构数据的集成统一、高效利用。

基于聚类的图像分割方法综述

信息疼术2018年第6期文章编号=1009 -2552 (2018)06 -0092 -03 DOI:10.13274/https://www.360docs.net/doc/c814900096.html,ki.hdzj.2018. 06.019 基于聚类的图像分割方法综述 赵祥宇\陈沫涵2 (1.上海理工大学光电信息与计算机学院,上海200093; 2.上海西南位育中学,上海200093) 摘要:图像分割是图像识别和机器视觉领域中关键的预处理操作。分割理论算法众多,文中 具体介绍基于聚类的分割算法的思想和原理,并将包含的典型算法的优缺点进行介绍和分析。经过比较后,归纳了在具体应用中如何对图像分割算法的抉择问题。近年来传统分割算法不断 被科研工作者优化和组合,相信会有更多的分割新算法井喷而出。 关键词:聚类算法;图像分割;分类 中图分类号:TP391.41 文献标识码:A A survey of image segmentation based on clustering ZHAO Xiang-yu1,CHEN Mo-han2 (1.School of Optical Electrical and Computer Engineering,University of Shanghai for Science and Technology,Shanghai200093,China;2.Shanghai Southwest Weiyu Middle School,Shanghai200093,China) Abstract:Image segmentation is a key preprocessing operation in image recognition and machine vision. There are many existing theoretical methods,and this paper introduces the working principle ol image segmentation algorithm based on clustering.Firstly,the advantages and disadvantages ol several typical algorithms are introduced and analyzed.Alter comparison,the paper summarizes the problem ol the selection ol image segmentation algorithm in practical work.In recent years,the traditional segmentation algorithms were improved and combined by the researchers,it believes that more new algorithms are blown out. Key words:clustering algorithm;image segmentation;classilication 0引百 近年来科学技术的不断发展,计算机视觉和图像 识别发挥着至关重要的作用。在实际应用和科学研 究中图像处理必不可少,进行图像处理必然用到图像 分割方法,根据检测图像中像素不重叠子区域,将感 兴趣目标区域分离出来。传统的图像分割方法:阈值 法[1]、区域法[2]、边缘法[3]等。近年来传统分割算法 不断被研究人员改进和结合,出现了基于超像素的分 割方法[4],本文主要介绍超像素方法中基于聚类的经 典方法,如Mean Shift算法、K-m eans 算法、Fuzzy C-mean算法、Medoidshilt算法、Turbopixels算法和 SLIC 算法。简要分析各算法的基本思想和分割效果。 1聚类算法 1.1 Mean Shil't算法 1975年,Fukunaga[5]提出一种快速统计迭代算法,即Mean Shilt算法(均值漂移算法)。直到1995 年,Cheng[6]对其进行改进,定义了核函数和权值系 数,在全局优化和聚类等方面的应用,扩大了 Mean shil't算法适用范围。1997至2003年间,Co-maniciu[7-9]提出了基于核密度梯度估计的迭代式 搜索算法,并将该方法应用在图像平滑、分割和视频 跟踪等领域。均值漂移算法的基本思想是通过反复 迭代计算当前点的偏移均值,并挪动被计算点,经过 反复迭代计算和多次挪动,循环判断是否满足条件, 达到后则终止迭代过程[10]。Mean shil't的基本形 式为: 收稿日期:2017-06 -13 基金项目:国家自然科学基金资助项目(81101116) 作者简介:赵祥宇(1992-),男,硕士研究生,研究方向为数字图像处理。 —92 —

【CN110110082A】多源异构数据融合优化方法【专利】

(19)中华人民共和国国家知识产权局 (12)发明专利申请 (10)申请公布号 (43)申请公布日 (21)申请号 201910294678.8 (22)申请日 2019.04.12 (71)申请人 黄红梅 地址 510610 广东省广州市天河区沾益直 街1号 申请人 何卓华 谢新屋 (72)发明人 黄红梅 何卓华 谢新屋 (74)专利代理机构 北京联瑞联丰知识产权代理 事务所(普通合伙) 11411 代理人 张学府 (51)Int.Cl. G06F 16/35(2019.01) G06F 16/903(2019.01) (54)发明名称 多源异构数据融合优化方法 (57)摘要 本发明公开了一种多源异构数据融合优化 方法,包括如下步骤:A)对数据实例、类别和属性 进行提取和分析,建立词库和短文本库;B)从互 联网获取多源异构数据;C)对多源异构数据进行 规范化处理,生成短文本;短文本有多个词构成, 规范化处理包括分词和去除停用词;D)将短文本 作为待匹配短文本,将待匹配短文本与短文本库 中存储的短文本进行匹配,得到短文本匹配结 果;E )根据短文本匹配结果对数据进行融合,建 立大数据内容模型,得到数据融合结果;F )对数 据融合结果进行评价,得到评价结果;评价结果 包括优、良、中和差。本发明能建立完整性、准确 性和一致性较强的高质量的大数据知识库。权利要求书2页 说明书5页 附图1页CN 110110082 A 2019.08.09 C N 110110082 A

1.一种多源异构数据融合优化方法,其特征在于,包括如下步骤: A)对数据实例、类别和属性进行提取和分析,建立词库和短文本库; B)从互联网获取多源异构数据; C)对所述多源异构数据进行规范化处理,生成短文本;所述短文本由多个词构成,所述规范化处理包括分词和去除停用词; D)将所述短文本作为待匹配短文本,将所述待匹配短文本与短文本库中存储的短文本进行匹配,得到短文本匹配结果; E)根据所述短文本匹配结果对数据进行融合,建立大数据内容模型,得到数据融合结果; F)对所述数据融合结果进行评价,得到评价结果;所述评价结果包括优、良、中和差。 2.根据权利要求1所述的多源异构数据融合优化方法,其特征在于,所述步骤D)进一步包括: D1)计算所述待匹配短文本与短文本库中的短文本之间的字符匹配因子; D2)计算所述待匹配短文本与短文本库中的短文本之间的词匹配因子; D3)根据所述字符匹配因子和词匹配因子,对所述待匹配短文本与短文本库中的短文本进行匹配,计算短文本匹配因子。 3.根据权利要求2所述的多源异构数据融合优化方法,其特征在于,所述字符匹配因子 采用如下公式进行计算: 其中,F 1表示所述字符匹配因子,c 1表示所述待匹配短文本包含的字符数,c 2表示所述短文本库中的短文本包含的字符数,p表示匹配的字符数,h表示换位的数目。 4.根据权利要求3所述的多源异构数据融合优化方法,其特征在于,所述词匹配因子采 用如下公式进行计算: 其中,F 2表示所述词匹配因子,n表示维数较高短文本向量的维数,σ表示修正因子,σ∈ [0.9,1.3],用于修正增加词带来的误差,A i 为所述待匹配短文本中的第i个词,B i 为短文本库中的短文本中的第i个词。 5.根据权利要求4所述的多源异构数据融合优化方法,其特征在于,所述短文本匹配因 子采用如下公式进行计算: 其中,Y表示短文本的匹配因子;设定匹配阈值Y 0,若Y≥Y 0,则说明所述待匹配短文本与短文本库中的短文本相匹配,若Y<Y 0,则说明所述待匹配短文本与短文本库中的短文本不匹配。 6.根据权利要求5所述的多源异构数据融合优化方法,其特征在于,所述步骤E)具体 权 利 要 求 书1/2页2CN 110110082 A

论中医药多源异构大数据融合方法研究的意义

Traditional Chinese Medicine 中医学, 2018, 7(5), 282-285 Published Online September 2018 in Hans. https://www.360docs.net/doc/c814900096.html,/journal/tcm https://https://www.360docs.net/doc/c814900096.html,/10.12677/tcm.2018.75047 On the Significance of the Method of Multi-Source Heterogeneous Data Fusion in TCM Hanqing Zhao, Zhiguo Wang* Institute of Basic Research in Clinical Medicine, China Academy of Chinese Medical Sciences, Beijing Received: Aug. 18th, 2018; accepted: Aug. 26th, 2018; published: Sep. 3rd, 2018 Abstract Multi-source isomerism is one of the basic features of large data. It is a hot issue in recent years to study traditional Chinese medicine diagnosis and treatment methods based on data. Building a generalization model is one of the methods to solve multisource heterogeneous data fusion and shares and extends the scope of traditional Chinese medicine data. However, the complexity of the large data of traditional Chinese medicine is high. Many problems, such as rich semantics, uneven distribution and poor objectivity, have greatly restricted the research and application of big data in Chinese medicine. In this paper, the importance of multi-source heterogeneous data fusion me-thod under the background of Internet+ large data is discussed, and the importance of mul-ti-source heterogeneous data fusion method based on the combination of disease and syndrome is discussed. It is the original cause of the important component of the large data of traditional Chi-nese medicine in the future, and the further study of the multi-source isomerism of traditional Chinese medicine. The method of large data fusion provides a theoretical reference. Keywords TCM Informatization, Diagnosis and Treatment Mode, Combination of Disease and Syndrome, Big Data, Multi-Source Heterogeneous Fusion 论中医药多源异构大数据融合方法研究的意义 赵汉青,王志国* 中国中医科学院中医临床基础医学研究所,北京 收稿日期:2018年8月18日;录用日期:2018年8月26日;发布日期:2018年9月3日 *通讯作者。

智慧城市多源异构大数据处理框架

智慧城市多源异构大数据处理框架 摘要:智慧城市建设的重心已由传统IT系统和信息资源共享建设,转变为数据的深度挖掘利用和数据资产的运营流通。大数据中心是数据资产管理和利用的实体基础,其核心驱动引擎是大数据平台及各类数据挖掘与分析系统。讨论了智慧城市大数据中心建设的功能架构,围绕城市多源异构数据处理的实际需要,对数据中心大数据平台的架构进行了拆分讲解,并以视频大数据处理为例,阐述了数据中心中大数据平台的运转流程。 关键词:智慧城市;大数据;多源异构;视频分析 1 引言 随着智慧城市建设逐步由信息基础设施和应用系统建设迈入数据资产集约利用与运营管理阶段,城市大数据中心已成为智慧城市打造核心竞争力、提升政府管理效能的重要工具。一方面政府借助大数据中心建设可以将有限的信息基础设施资源集中高效管理和利用,大幅降低各自为政、运维机关庞杂、财政压力过大的问题;另一方面,可以在国务院、发展和改革委员会大力支持的政策东风下,打破部门间数据壁垒,推动政府各部门职能由管理转为服务,提高数据共享利用率和透明度。以大数据中心为核心构建城市驾驶舱,实现城市运转过程的实时全面监控,提高政府决策的科学性和及时性。智慧城市大数据中心建设功能框架如图1所示,其中针对不同部门的数据源,由数据收集系统完成数据的汇聚,并根据数据业务类型和内容的差异进行粗分类。为避免过多“脏数据”对大数据平台的污染,对于批量数据,不推荐直接将数据汇入大数据平台,而是单设一个前端原始数据资源池,在这里暂时存储前端流入的多源异构数据,供大数据平台处理调用。

图1 智慧城市大数据中心功能框架 大数据平台是城市大数据中心运转的核心驱动引擎,主要完成多源数据导入、冗余存储、冷热迁移、批量计算、实时计算、图计算、安全管理、资源管理、运维监控等功能[1],大数据平台的主体数据是通过专线连接或硬件复制各政府部门数据库的方式获得,例如地理信息系统(geographic information system,GIS)数据、登记信息等。部分数据通过直连业务部门传感监测设备的方式获得,例如监控视频、河道流量等。大数据平台的输出主要是结构化关联数据以及统计分析结果数据,以方便各类业务系统的直接使用。 不同部门间共享与交换的数据不推荐直接使用原始数据,一方面是因为原始数据内容密级存在差异,另一方面是因为原始数据内容可能存在错误或纰漏。推荐使用经过大数据平台分类、过滤和统计分析后的数据。不同使用部门经过政务信息门户统一需求申请和查看所需数据,所有数据的交换和审批以及数据的监控运维统一由数据信息中心负责,避免了跨部门协调以及数据管理不规范等人为时间的损耗,极大地提高了数据的流通和使用效率。另外,针对特定的业务需求,可以基于大数据平台拥有的数据进行定制开发,各业务系统属于应用层,建设时不宜与大数据平台部署在同一服务器集群内,并且要保证数据由大数据平台至业务系统的单向性,尽量设置业务数据过渡区,避免应用系统直接对大数据平台核心区数据的访问。 目前主流大数据平台都采用以Hadoop为核心的数据处理框架,例如Cloudera公司的CDH(Cloud er a Distribution for Hadoop)和星环信息科技(上海)有限公司(Transwarp)的TDH(Transwarp Data Hub)、Apache Hadoop等。以Hadoop为核心的大数据解决方案占大数据市场95%以上的份额,目前国内80%的市场被Cloudera占有,剩余20%的市场由星环信息科技(上海)有限公司、北京红象云腾系统技术有限公司、华为技术有限公司等大数据公司分享。随着数据安全意识的增强、价格竞争优势的扩大,国内企业在国内大数据市场的份额和影响力正在快速提升。大数据的应用历程可归纳为3个阶段:第一个阶段是面向互联网数据收集、处理的搜索推荐时代;第二个阶段是面向金融、安全、广播电视数据的用户画像和关系发现时代;第三个阶段是面向多数据源与多业务领域数据的融合分析与数据运营时代,并且对数据处理规模和实时性的要求大幅提高。 本文在智慧城市大数据中心建设方案的基础上,阐述了多源异构大数据处理的框架和流程,并以最典型的非结构化视频大数据处理为例,介绍了多源异构大数据处理框架运转的流程。 2 多源异构大数据处理框架 2.1 系统整体架构 多源异构是大数据的基本特征[2],为适应此类数据导入、存储、处理和交互分析的需求,本文设计了如图2所示的系统框架,主要包括3个层面的内容:基础平台层、数据处理层、应用展示层。其中,基础平台层由Hadoop生态系统组件以及其他数据处理工具构成,除了提供基本的存储、计算和网络资源外,还提供分布式流计算、离线批处理以及图计算等计算引擎;数据处理层由多个数据处理单元组成,除了提供基础的数据抽取与统计分析算法外,还提供半结构化和非结构化数据转结构化数据处理算法、数据内容深度理解算法等,涉及自然语言处理、视频图像内容理解、文本挖掘与分析等,是与人工智能联系最紧密的层,该层数据处理效果的好坏直接决定了业务应用层数据统计分析的准确性和客户体验;应用展

数据挖掘中的聚类算法综述

收稿日期:2006201204;修返日期:2006203219基金项目:国家自然科学基金资助项目(60473117) 数据挖掘中的聚类算法综述 3 贺 玲,吴玲达,蔡益朝 (国防科学技术大学信息系统与管理学院,湖南长沙410073) 摘 要:聚类是数据挖掘中用来发现数据分布和隐含模式的一项重要技术。全面总结了数据挖掘中聚类算法的研究现状,分析比较了它们的性能差异和各自存在的优点及问题,并结合多媒体领域的应用需求指出了其今后的发展趋势。 关键词:数据挖掘;聚类;聚类算法 中图法分类号:TP391 文献标识码:A 文章编号:100123695(2007)0120010204 Survey of Clustering A lgorith m s in Data M ining HE L ing,WU L ing 2da,CA I Yi 2chao (College of Infor m ation Syste m &M anage m ent,N ational U niversity of D efense Technology,Changsha Hunan 410073,China ) Abstract:Clustering is an i m portant technique in Data M ining (DM )f or the discovery of data distributi on and latent data pattern .This paper p r ovides a detailed survey of current clustering algorith m s in DM at first,then it makes a comparis on a mong the m,illustrates the merits existing in the m,and identifies the p r oblem s t o be s olved and the ne w directi ons in the fu 2ture according t o the app licati on require ments in multi m edia domain .Key works:Data M ining;Clustering;Clustering A lgorith m 1 引言 随着信息技术和计算机技术的迅猛发展,人们面临着越来越多的文本、图像、视频以及音频数据,为帮助用户从这些大量数据中分析出其间所蕴涵的有价值的知识,数据挖掘(Data M ining,DM )技术应运而生。所谓数据挖掘,就是从大量无序 的数据中发现隐含的、有效的、有价值的、可理解的模式,进而发现有用的知识,并得出时间的趋向和关联,为用户提供问题求解层次的决策支持能力。与此同时,聚类作为数据挖掘的主要方法之一,也越来越引起人们的关注。 本文比较了数据挖掘中现有聚类算法的性能,分析了它们各自的优缺点并指出了其今后的发展趋势。 2 DM 中现有的聚类算法 聚类是一种常见的数据分析工具,其目的是把大量数据点的集合分成若干类,使得每个类中的数据之间最大程度地相似,而不同类中的数据最大程度地不同。在多媒体信息检索及数据挖掘的过程中,聚类处理对于建立高效的数据库索引、实现快速准确的信息检索具有重要的理论和现实意义。 本文以聚类算法所采用的基本思想为依据将它们分为五类,即层次聚类算法、分割聚类算法、基于约束的聚类算法、机器学习中的聚类算法以及用于高维数据的聚类算法,如图1所示。 聚类 层次聚类算法 聚合聚类:Single 2L ink,Comp lete 2L ink,Average 2L ink 分解聚类 分割聚类算法基于密度的聚类基于网格的聚类 基于图论的聚类 基于平方误差的迭代重分配聚类:概率聚类、最近邻 聚类、K 2medoids 、K 2means 基于约束的聚类算法 机器学习中的聚类算法 人工神经网络方法 基于进化理论的方法:模拟退火、遗传算法用于高维数据的聚类算法 子空间聚类 联合聚类 图1 聚类算法分类示意图 211 层次聚类算法 层次聚类算法通过将数据组织成若干组并形成一个相应的树状图来进行聚类,它又可以分为两类,即自底向上的聚合层次聚类和自顶向下的分解层次聚类。聚合聚类的策略是先将每个对象各自作为一个原子聚类,然后对这些原子聚类逐层进行聚合,直至满足一定的终止条件;后者则与前者相反,它先将所有的对象都看成一个聚类,然后将其不断分解直至满足终止条件。 对于聚合聚类算法来讲,根据度量两个子类的相似度时所依据的距离不同,又可将其分为基于Single 2L ink,Comp lete 2L ink 和Average 2L ink 的聚合聚类。Single 2L ink 在这三者中应用最为广泛,它根据两个聚类中相隔最近的两个点之间的距离来评价这两个类之间的相似程度,而后两者则分别依据两类中数据点之间的最远距离和平均距离来进行相似度评价。 CURE,ROCK 和CHAME LE ON 算法是聚合聚类中最具代 表性的三个方法。 Guha 等人在1998年提出了C URE 算法 [1] 。该方法不用 单个中心或对象来代表一个聚类,而是选择数据空间中固定数目的、具有代表性的一些点共同来代表相应的类,这样就可以

【大数据】多源异构通用大数据处理服务平台

一、项目背景及必要性 (一)国内外现状和技术发展趋势 大数据是指海量的数据加上复杂的数据类型。从产业的发展角度看,我们对数据的利用经历了传输、传播、处理三个阶段,而今眼目下,对数据的利用正处在处理这个阶段,即如何处理、如何管理、如何应用,如何优化是现阶段的主要工作。 大数据的具体特点主要表现为四个“V”:一是体量浩大(Volume),数据集合的规模已从GB到TB再到PB级,甚至已经开始以EB和ZB来计算。著名咨询公司IDC的研究报告称,未来10年全球大数据将增加50倍,管理数据仓库的服务器的数量将增加10倍。二是类型复杂(Variety),大数据类型包括结构化数据、半结构化数据和非结构化数据。现代互联网应用呈现出非结构化数据大幅增长的特点,到20152年末非结构化数据将达到整个数据量的75%以上。三是生成迅速(Velocity),大数据通常以数据流的形式动态、快速地产生,具有很强的时效性。数据自身的状态与价值也随时空变化而发生演变,数据的涌现特征明显。四是价值巨大但利用密度低(Value),基于传统思维与技术让人们在实际环境中面临信息泛滥而知识匮乏的窘态。 当今社会,新摩尔定律得到验证,大数据以成为各行各业的焦点。数据的来源多样化:以多源异构数据为代表的非结构化数据占世界上信息总量的95%以上,剩下的5%为结构化数据,包括网页、文本、交易数据、邮件、高清视频、3D视频、语音、图片、地质勘测

数据、多源异构数据探测数据等等,这些数亿TB的数据正以超乎人们想象的速度增长,这对数据的存储系统的容量和实时计算速度提出了空前的要求。同时,大到智慧地球,小到智慧城市的数字化建设,使其越来越多的人、设备和传感器通过数字网络连接起来,产生、传送、分享和访问数据的能力也得到彻底变革。这些行业包括:互联网、制造业、医疗行业、媒体行业、零售销售行业、金融业、能源业、航空航天等等。预计2015年,超过40亿人(世界人口的60%)在使用各种智能终端,以全方位的方式与各行各业发生交互融合。其中大约12%拥有智能终端——其渗透率以每年20%以上的速度增长。如今,3000多万联网传感器节点分布在互联网、交通、汽车、工业、公用事业和零售部门,其数量正以每年30%以上的速度增长。预计到2020年,全球数据使用量预计暴增44倍,达到35.2ZB。35.2ZB也就是说全球大概需要376亿个1TB硬盘来存储数据。 人们对数据日益广泛的需求导致存储系统的规模变得越来越庞大,管理越来越复杂,数据的爆炸性增长和管理能力的相对不足之间的矛盾日益尖锐。同时,数据的高速增长也对存储系统的可靠性和扩展性提出了挑战,海量数据的共享、分析、搜索也显得越来越重要,充分挖掘海量数据中的有效价值。这就要求我们得实现一种有别于传统系统而全新的存储管理平台,该平台必须具备高扩展性、高可靠性、高时效性,同时也需要具备高经济性,只有这样才能更好的为国民经济和生活服务。 国外的大数据发展现状,以GOOGLE/FACEBOOK为代表的

聚类算法研究综述

电脑知识与技术 本栏目责任编辑:闻翔军 数据库及信息管理 1引言 数据挖掘是指从从大量无序的数据中提取隐含的、有效的、可理解的、对决策有潜在价值的知识和规则,为用户提供问题求解层次的决策支持能力。数据挖掘主要的算法有分类模式、关联规则、决策树、序列模式、聚类模式分析、神经网络算法等等。聚类算法是一种有效的非监督机器学习算法,是数据挖掘中的一个非常重要的研究课题。当人们使用数据挖掘工具对数据中的模型和关系进行辨识的时候,通常第一个步骤就是聚类,其目的就是将集中的数据人为地划分成若干类,使簇内相似度尽可能大、簇间相似度尽可能小,以揭示这些数据分布的真实情况。但任何聚类算法都对数据集本身有一定的预先假设,根据文献[1]的理论,如果数据集本身的分布并不符合预先的假设,则算法的结果将毫无意义。因此,面对特定的应用问题,如何选择合适的聚类算法是聚类分析研究中的一个重要课题。本文比较了数据挖掘中现有聚类算法的性能,分析了它们各自的优缺点,并指出了其今后的发展趋势。 2聚类算法分类研究 聚类的目的是把大量数据点的集合分成若干类,使得每个类中的数据之间最大程度地相似,而不同类中的数据最大程度地不同。通常聚类算法可以分为层次聚类、分割聚类、密度型聚类、网格型聚类和其他聚类等几种。 2.1层次聚类 层次聚类算法通过将数据组织成若干组并形成一个相应的树状图来进行聚类,它又可以分为两类,即自底向上的聚合层次聚类和自顶向下的分裂层次聚类。聚结型算法采用自底向上的策略,首先把每个对象单独作为一个聚类,然后根据一定的规则合并成为越来越大的聚类,直到最后所有的对象都归入到一个聚类中。大多数层次聚类算法都属于聚结型算法,它们之间的区别在于类间相似度的定义不同。与聚结型算法相反,分裂型算法采用自顶向下的方法,它先将所有的对象都看成一个聚类,然后将其不断分解直至每个对象都独自归入一个聚类。一般情况下不使用分裂型方法,因为在较高的层次很难进行正确的拆分。纯粹的层次聚类算法的缺点在于一旦进行合并或分裂之后,就无法再进行调整。现在的一些研究侧重于层次聚类算法与循环的重新分配方法的结合。 主要的层次聚类算法有BIRCH,CURE,ROCK, CHAMELEON,AMOEBA,COBWEB,ClusteringwithRandomWalks算法等。CURE算法[2]不用单个中心或对象来代表一个聚 类,而是选择数据空间中固定数目的、 具有代表性的一些点共同来代表相应的类,这样就可以识别具有复杂形状和不同大小的聚类,从而能很好地过滤孤立点。ROCK算法[3]是对CURE的改进,除了具有CURE算法的一些优良特性之外,它还适用于类别属性的数据。CHAMELEON算法[4]是Karypis等人于1999年提出来的,它在聚合聚类的过程中利用了动态建模的技术。 2.2分割聚类 分割聚类算法是另外一种重要的聚类方法。它先将数据点集分为k个划分,每个划分作为一个聚类,然后从这k个初始划分开始,通过重复的控制策略,使某个准则最优化,而每个聚类由其质心来代表(k-means算法),或者由该聚类中最靠近中心的一 个对象来代表(k-medoids算法),以达到最终的结果。 分割聚类算法收敛速度快,缺点在于它倾向于识别凸形分布大小相近、密度相近的聚类,不能发现分布形状比较复杂的聚类,它要求类别数目k可以合理地估计,并且初始中心的选择和噪声会对聚类结果产生很大影响。这类方法又可分为基于密度的聚类、基于网格的聚类等。 很多算法中都使用距离来描述数据之间的相似性,但是,对于非凸数据集,只用距离来描述是不够的。对于这种情况,要用密度来取代相似性,这就是基于密度的聚类算法。基于密度的算法从数据对象的分布密度出发,把密度足够大的区域连接起来,从而可以发现任意形状的类。此类算法除了可以发现任意形状的类,还能够有效去除噪声。 基于网格的聚类算法,把空间量化为有限个单元(即长方体或超长方体),然后对量化后的空间进行聚类。此类算法具有很快的处理速度。缺点是只能发现边界是水平或垂直的聚类,而不能检测到斜边界。此类算法具有很快的处理速度。时间复杂度一般由网格单元的数目决定,而与数据集的大小无关。此外,聚类的精度取决于网格单元的大小。此类算法不适用于高维情况,因为网格单元的数目随着维数的增加而呈指数增长。所有基于网格的聚类算法都存在下列问题:一是如何选择合适的单元大小和数目;二是怎样对每个单元中对象的信息进行汇总。 主要的分割聚类算法有k-means,EM,k-medoids, 收稿日期:2007-06-10 作者简介:项冰冰(1980-),女,安徽合肥人,安徽大学助教,工学学士,研究方向:数据挖掘,人工智能;钱光超(1982-),男,安徽安徽无为人,安徽大学计算机科学与技术学院05级研究生,工学学士。 聚类算法研究综述 项冰冰1,钱光超2 (1.安徽大学数学与计算科学学院安徽合肥23039;2.安徽大学计算机科学与技术学院安徽合肥230039) 摘要:聚类是数据挖掘中用来发现数据分布和隐含模式的一项重要技术。阐述了聚类算法基本原理,总结了聚类算法的研究现状,按照聚类算法的分类,分析比较了几种典型聚类的性能差异和各自存在的优点及问题,并结合应用需求指出了其今后的发展趋势。 关键词:数据挖掘;聚类分析;聚类算法 中图分类号:TP301.6 文献标识码:A文章编号:1009-3044(2007)12-21500-02TheResearchofClusteringAlgorithms XIANGBing-bing1,QIANGuang-chao2 (1.SchoolofMathematicsandComputationalScience,AnhuiUniversity,Hefei,AnhuiProvince230039,China;2.SchoolofComputerScience andTechnology,AnhuiUniversity,Hefei,AnhuiProvince230039,China) Abstract:Clusteringisanimportanttechniqueindatamining.It’ susedtodiscoverthedatadistributionandconcealedpatterns.Thepaperelucidatethebasicprincipleoftheclusteringalgorithmsandsumupthecontemporaryresearchoftheclusteringalgorithms.Italsoanalyzeafewrepresentativeclusteringalgorithmsandcomparetheirdifferences,advantagesanddisadvantages.Atlast,thepaperindicatethedevelopmenttrendofclusteringintegratingtheapplicationdemand. Keyword:Datamining;ClusteringAnalysis;ClusteringAlgorithms 1500