神经网络一个简单实例

OpenCV的ml模块实现了人工神经网络(Artificial Neural Networks,ANN)最典型的多层感知器(multi-layer perceptrons, MLP)模型。由于ml模型实现的算法都继承自统一的CvStatModel基类,其训练和预测的接口都是train(),predict(),非常简单。

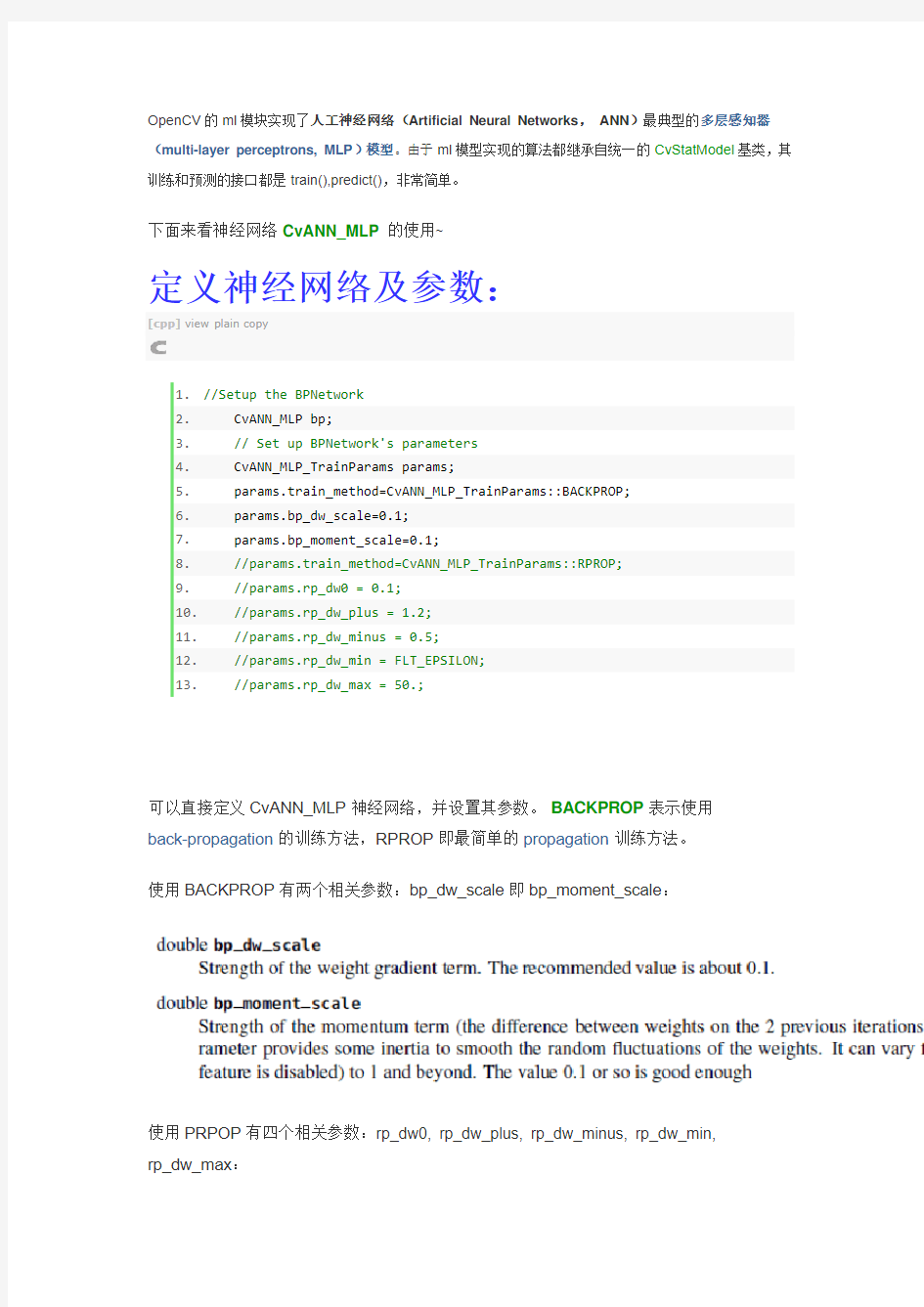

下面来看神经网络CvANN_MLP 的使用~

定义神经网络及参数:

[cpp]view plain copy

1.//Setup the BPNetwork

2. CvANN_MLP bp;

3.// Set up BPNetwork's parameters

4. CvANN_MLP_TrainParams params;

5. params.train_method=CvANN_MLP_TrainParams::BACKPROP;

6. params.bp_dw_scale=0.1;

7. params.bp_moment_scale=0.1;

8.//params.train_method=CvANN_MLP_TrainParams::RPROP;

9.//params.rp_dw0 = 0.1;

10.//params.rp_dw_plus = 1.2;

11.//params.rp_dw_minus = 0.5;

12.//params.rp_dw_min = FLT_EPSILON;

13.//params.rp_dw_max = 50.;

可以直接定义CvANN_MLP神经网络,并设置其参数。BACKPROP表示使用

back-propagation的训练方法,RPROP即最简单的propagation训练方法。

使用BACKPROP有两个相关参数:bp_dw_scale即bp_moment_scale:

使用PRPOP有四个相关参数:rp_dw0, rp_dw_plus, rp_dw_minus, rp_dw_min,

rp_dw_max:

上述代码中为其默认值。

设置网络层数,训练数据:

[cpp]view plain copy

1.// Set up training data

2.float labels[3][5] = {{0,0,0,0,0},{1,1,1,1,1},{0,0,0,0,0}};

3. Mat labelsMat(3, 5, CV_32FC1, labels);

4.

5.float trainingData[3][5] = { {1,2,3,4,5},{111,112,113,114,115}, {21,22,2

3,24,25} };

6. Mat trainingDataMat(3, 5, CV_32FC1, trainingData);

7. Mat layerSizes=(Mat_

8. bp.create(layerSizes,CvANN_MLP::SIGMOID_SYM);//CvANN_MLP::SIGMOID_SYM

9.//CvANN_MLP::GAUSSIAN

10.//CvANN_MLP::IDENTITY

11. bp.train(trainingDataMat, labelsMat, Mat(),Mat(), params);

layerSizes设置了有三个隐含层的网络结构:输入层,三个隐含层,输出层。输入层和输出层节点数均为5,中间隐含层每层有两个节点。

create第二个参数可以设置每个神经节点的激活函数,默认为

CvANN_MLP::SIGMOID_SYM,即Sigmoid函数,同时提供的其他激活函数有Gauss和阶跃函数。

使用训练好的网络结构分类新的数据:然后直接使用predict函数,就可以预测新的节点:

[cpp]view plain copy

1.Mat sampleMat = (Mat_

2. Mat responseMat;

3. bp.predict(sampleMat,responseMat);

完整程序代码:

[cpp]view plain copy

1.//The example of using BPNetwork in OpenCV

2.//Coded by L. Wei

3.#include

4.#include

5.#include

6.#include

7.#include

8.

https://www.360docs.net/doc/1312656591.html,ing namespace std;

https://www.360docs.net/doc/1312656591.html,ing namespace cv;

11.

12.int main()

13.{

14.//Setup the BPNetwork

15. CvANN_MLP bp;

16.// Set up BPNetwork's parameters

17. CvANN_MLP_TrainParams params;

18. params.train_method=CvANN_MLP_TrainParams::BACKPROP;

19. params.bp_dw_scale=0.1;

20. params.bp_moment_scale=0.1;

21.//params.train_method=CvANN_MLP_TrainParams::RPROP;

22.//params.rp_dw0 = 0.1;

23.//params.rp_dw_plus = 1.2;

24.//params.rp_dw_minus = 0.5;

25.//params.rp_dw_min = FLT_EPSILON;

26.//params.rp_dw_max = 50.;

27.

28.// Set up training data

29.float labels[3][5] = {{0,0,0,0,0},{1,1,1,1,1},{0,0,0,0,0}};

30. Mat labelsMat(3, 5, CV_32FC1, labels);

31.

32.float trainingData[3][5] = { {1,2,3,4,5},{111,112,113,114,115}, {21,22,2

3,24,25} };

33. Mat trainingDataMat(3, 5, CV_32FC1, trainingData);

34. Mat layerSizes=(Mat_

35. bp.create(layerSizes,CvANN_MLP::SIGMOID_SYM);//CvANN_MLP::SIGMOID_SYM

36.//CvANN_MLP::GAUSSIAN

37.//CvANN_MLP::IDENTITY

38. bp.train(trainingDataMat, labelsMat, Mat(),Mat(), params);

39.

40.

41.// Data for visual representation

42.int width = 512, height = 512;

43. Mat image = Mat::zeros(height, width, CV_8UC3);

44. Vec3b green(0,255,0), blue (255,0,0);

45.// Show the decision regions given by the SVM

46.for (int i = 0; i < image.rows; ++i)

47.for (int j = 0; j < image.cols; ++j)

48. {

49. Mat sampleMat = (Mat_

50. Mat responseMat;

51. bp.predict(sampleMat,responseMat);

52.float* p=responseMat.ptr

53.float response=0.0f;

54.for(int k=0;k<5;i++){

55.// cout< 56. response+=p[k]; 57. } 58.if (response >2) 59. image.at 60.else 61. image.at 62. } 63. 64.// Show the training data 65.int thickness = -1; 66.int lineType = 8; 67. circle( image, Point(501, 10), 5, Scalar( 0, 0, 0), thickness, lineType); 68. circle( image, Point(255, 10), 5, Scalar(255, 255, 255), thickness, lineType); 69. circle( image, Point(501, 255), 5, Scalar(255, 255, 255), thickness, lineType); 70. circle( image, Point( 10, 501), 5, Scalar(255, 255, 255), thickness, lineType); 71. 72. imwrite("result.png", image); // save the image 73. 74. imshow("BP Simple Example", image); // show it to the user 75. waitKey(0); 76. 77.} 结果: 人工神经网络原理及实际应用 摘要:本文就主要讲述一下神经网络的基本原理,特别是BP神经网络原理,以及它在实际工程中的应用。 关键词:神经网络、BP算法、鲁棒自适应控制、Smith-PID 本世纪初,科学家们就一直探究大脑构筑函数和思维运行机理。特别是近二十年来。对大脑有关的感觉器官的仿生做了不少工作,人脑含有数亿个神经元,并以特殊的复杂形式组成在一起,它能够在“计算"某些问题(如难以用数学描述或非确定性问题等)时,比目前最快的计算机还要快许多倍。大脑的信号传导速度要比电子元件的信号传导要慢百万倍,然而,大脑的信息处理速度比电子元件的处理速度快许多倍,因此科学家推测大脑的信息处理方式和思维方式是非常复杂的,是一个复杂并行信息处理系统。1943年Macullocu和Pitts融合了生物物理学和数学提出了第一个神经元模型。从这以后,人工神经网络经历了发展,停滞,再发展的过程,时至今日发展正走向成熟,在广泛领域得到了令人鼓舞的应用成果。本文就主要讲述一下神经网络的原理,特别是BP神经网络原理,以及它在实际中的应用。 1.神经网络的基本原理 因为人工神经网络是模拟人和动物的神经网络的某种结构和功能的模拟,所以要了解神经网络的工作原理,所以我们首先要了解生物神经元。其结构如下图所示: 从上图可看出生物神经元它包括,细胞体:由细胞核、细胞质与细胞膜组成; 轴突:是从细胞体向外伸出的细长部分,也就是神经纤维。轴突是神经细胞的输出端,通过它向外传出神经冲动;树突:是细胞体向外伸出的许多较短的树枝状分支。它们是细胞的输入端,接受来自其它神经元的冲动;突触:神经元之间相互连接的地方,既是神经末梢与树突相接触的交界面。 对于从同一树突先后传入的神经冲动,以及同一时间从不同树突输入的神经冲动,神经细胞均可加以综合处理,处理的结果可使细胞膜电位升高;当膜电位升高到一阀值(约40mV),细胞进入兴奋状态,产生神经冲动,并由轴突输出神经冲动;当输入的冲动减小,综合处理的结果使膜电位下降,当下降到阀值时。细胞进入抑制状态,此时无神经冲动输出。“兴奋”和“抑制”,神经细胞必呈其一。 突触界面具有脉冲/电位信号转换功能,即类似于D/A转换功能。沿轴突和树突传递的是等幅、恒宽、编码的离散电脉冲信号。细胞中膜电位是连续的模拟量。 神经冲动信号的传导速度在1~150m/s之间,随纤维的粗细,髓鞘的有无而不同。 神经细胞的重要特点是具有学习功能并有遗忘和疲劳效应。总之,随着对生物神经元的深入研究,揭示出神经元不是简单的双稳逻辑元件而是微型生物信息处理机制和控制机。 而神经网络的基本原理也就是对生物神经元进行尽可能的模拟,当然,以目前的理论水平,制造水平,和应用水平,还与人脑神经网络的有着很大的差别,它只是对人脑神经网络有选择的,单一的,简化的构造和性能模拟,从而形成了不同功能的,多种类型的,不同层次的神经网络模型。 2.BP神经网络 目前,再这一基本原理上已发展了几十种神经网络,例如Hopficld模型,Feldmann等的连接型网络模型,Hinton等的玻尔茨曼机模型,以及Rumelhart 等的多层感知机模型和Kohonen的自组织网络模型等等。在这众多神经网络模型中,应用最广泛的是多层感知机神经网络。 这里我们重点的讲述一下BP神经网络。多层感知机神经网络的研究始于50年代,但一直进展不大。直到1985年,Rumelhart等人提出了误差反向传递学习算法(即BP算),实现了Minsky的多层网络设想,其网络模型如下图所示。它可以分为输入层,影层(也叫中间层),和输出层,其中中间层可以是一层,也可以多层,看实际情况而定。 第四章计算智能(1):神经计算模糊计算4-1 计算智能的含义是什么?它涉及哪些研究分支? 贝兹德克认为计算智能取决于制造者提供的数值数据,而不依赖于知识。计算智能是智力的低层认知。 主要的研究领域为神经计算,模糊计算,进化计算,人工生命。 4-2 试述计算智能(CI)、人工智能(AI)和生物智能(BI)的关系。 计算智能是智力的低层认知,主要取决于数值数据而不依赖于知识。人工智能是在计算智能的基础上引入知识而产生的智力中层认知。生物智能,尤其是人类智能,则是最高层的智能。即CI包含AI包含BI 4-3 人工神经网络为什么具有诱人的发展前景和潜在的广泛应用领域? 人工神经网络具有如下至关重要的特性: (1) 并行分布处理 适于实时和动态处理 (2)非线性映射 给处理非线性问题带来新的希望 (3) 通过训练进行学习 一个经过适当训练的神经网络具有归纳全部数据的能力,能够解决那些由数学模型或描述规则难以处理的问题 (4) 适应与集成 神经网络的强适应和信息融合能力使得它可以同时输入大量不同的控制信号,实现信息集成和融合,适于复杂,大规模和多变量系统 (5) 硬件实现 一些超大规模集成是电路实现硬件已经问世,使得神经网络成为具有快速和大规模处理能力的网络。 4-4 简述生物神经元及人工神经网络的结构和主要学习算法。 生物神经元 大多数神经元由一个细胞体(cell body或soma)和突(process)两部分组成。突分两类,即轴突(axon)和树突(dendrite),轴突是个突出部分,长度可达1m,把本神经元的输出发送至其它相连接的神经元。树突也是突出部分,但一般较短,且分枝很多,与其它神经元的轴突相连,以接收来自其它神经元的生物信号。 轴突的末端与树突进行信号传递的界面称为突触(synapse),通过突触向其它神经元发送信息。对某些突触的刺激促使神经元触发(fire)。只有神经元所有输入的总效应达到阈值电平,它才能开始工作。此时,神经元就产生一个全强度的输出窄脉冲,从细胞体经轴突进入轴突分枝。这时的神经元就称为被触发。突触把经过一个神经元轴突的脉冲转化为下一个神经元的兴奋或抑制。学习就发生在突触附近。 每个人脑大约含有10^11-10^12个神经元,每一神经元又约有10^3-10^4个突触。神经元通过突触形成的网络,传递神经元间的兴奋与抑制。大脑的全部神经元构成极其复杂的拓扑网络群体,用于实现记忆与思维。 人工神经网络的结构 人工神经网络由神经元模型构成。每个神经元具有单一输出,并且能够与其它神经元连接,存在许多输出连接方法,每种连接方法对应于一个连接权系数。 人工神经网络的结构分为2类, (1)递归(反馈)网络 有些神经元的输出被反馈至同层或前层神经元。信号能够从正向和反向流通。Hopfield网络,Elmman网络和Jordan网络是代表。 (2) 前馈网络 具有递阶分层结构,由一些同层神经元间不存在互连的层级组成。从输入层至输出层的信号通过单向连接流通,神经元从一层连接至下一层,不存在同层神经元之间的连接。多层感知器(MLP),学习矢量量化网络(LVQ),小脑模型连接控制网络(CMAC)和数据处理方法网络(GMDH)是代表。 人工神经网络的主要学习算法 (1) 指导式(有师)学习 根据期望和实际的网络输出之间的差来调整神经元连接的强度或权。包括Delta规则,广义Delta规则,反向传播算法及LVQ算法。 (2) 非指导(无导师)学习 训练过程中,神经网络能自动地适应连接权,以便按相似特征把输入模式分组聚集。包括 基于人工神经网络的通信信号分类识别 冯 涛 (中国电子科技集团公司第54研究所,河北石家庄050081) 摘 要 通信信号的分类识别是一种典型的统计模式识别问题。系统地论述了通信信号特征选择、特征提取和分类识别的原理和方法。设计了人工神经网络分类器,包括神经网络模型的选择、分类器的输入输出表示、神经网络拓扑结构和训练算法,并提出了分层结构的神经网络分类器。 关键词 模式识别;特征提取;分类器;神经网中图分类号 TP391 文献标识码 A Classification and Identification of Communication Signal Using Artificial Neural Networks FE NG Tao (T he 54th Research Institute of CETC,Shijia zhuan g Hebei 050081,China) Abstract The classification and identificati on of communication signal is a typical statistical pattern identification.The paper discusses the theory and method of feature selection,feature extraction and classi fication &identificaiton of communication signal.A classifier based on artificial neural networks is designed,includin g the selection of neural network model,the input and output expression of the classifier,neural network topology and trainin g algorithm.Finally a hierarchical archi tecture classifier based on artificial neural networks is presented. Key words pattern recognition;features extraction;classifier;neural networks 收稿日期:2005-12-16 0 引言 在通信对抗侦察中,侦察接收设备在截获敌方通信信号后,必须经过对信号的特征提取和对信号特征的分析识别,才能变为有价值的通信对抗情报。通过对信号特征的分析识别,可以得到信号种类、通信体制、网路组成等方面的情报,从而为研究通信对抗策略、研制和发展通信对抗装备提供重要参考依据。 1 通信信号分类识别的原理 通信信号的分类识别是一种典型的模式识别应用,其作用和目的就是将某一接收到的信号正确地归入某一种类型中。一般过程如图1 所示。 图1 通信信号分类识别的一般过程 下面简单介绍这几部分的作用。 信号获取:接收来自天线的信号x (t),并对信号进行变频、放大和滤波,输出一个中频信号; A/D 变换:将中频模拟信号变换为计算机可以运算的数字信号x (n); 以上2步是信号空间x (t)到观察空间x (n )的变换映射。 特征提取:为了有效地实现分类识别,必须对原始数据进行变换,得到最能反映分类差别的特征。这些特征的选择和提取是非常重要的,因为它强烈地影响着分类器的设计和性能。理想情况下,经过特征提取得到的特征向量对不同信号类型应该有明显的差别; 分类器设计和分类决策:分类问题是根据识别对象特征的观察值将其分到某个类别中去。首先,在样本训练集基础上确定合适的规则和分类器结构,然后,学习训练得到分类器参数。最后进行分类决策,把待识别信号从特征空间映射到决策空间。 2 通信信号特征参数的选择与特征提取 2 1 通信信号特征参数的选择 选择好的特征参数可以提高低信噪比下的正确 识别率,降低分类器设计的难度,是基于统计模式识别方法最为关键的一个环节。试图根据有限的信号 信号与信息处理 24 2006Radio Engineering Vo1 36No 6 人工神经网络(ANN)又称神经网络,是在现代神经科学研究成果的基础上,对生物神经系统的结构和功能进行数学抽象、简化和模仿而逐步发展起来的一种新型信息处理和计算系统。由于人工神经网络具有自学习、高容错、高度非线性描述能力等优点,现已广泛应用于经济、机器人和自动控制、军事、医疗、化学等领域[l ~ 3],并取得了许多成果。本文简要介绍人工神经网络的原理和特点,论述人工神经网络在高分子科学与工程领域的应用。 橡胶配方是决定橡胶制品性能的关键因素,由于材料配方与制品性能之间存在很复杂的非线性关系,多数情况下无法建立完整精确的理论模型,只能借助于回归方法得到经验公式。 传统的回归方法存在以下局限性: (1)使用不同的回9j方法可获得不同的经验公式,导致经验公式的繁多和不一致; (2)当配方项目及性能指标项目较多时,采用回归公式无法完全再现实验数据; (3)当实验进一步完善,实验数据增多的时候.其他人员再进行回归时,如果无法找到原来的回归方法、程序和实验数据,原来的回归公式将不能被利用,造成一定的浪费。随着计箅机的发展而出现的人工神经网络是人工智能方法.它不像回归方法那样,需预先给定基本函数,而是以实验数据为基础.经过有限次的迭代计算而获得的一个反映实验数据内在联系的数学模型,具有极强的非线性处理、自组织调整、自适应学习及容错抗噪能力,特别适用于研究像材料配方与制品性能之间关系的复杂非线性系统特性【¨】。因此,人们开始将人工神经网络应用于橡胶配方设计”J。 随着橡胶制品在各领域应用的拓展,橡胶配方设计变得越来越重要。人们进行橡胶配方设计主要有3个目的:提高制品的性能;改善加工工艺;降低生产成本。传统的橡胶配方设计方法有全因素设计、正交试验设计n_3]、均匀设计[4‘60等,而这些配方设计试验数据的处理方法无外乎方差分析和回归分析口]。由于材料的配方和性能之问存在非常复杂的非线性关系,回归分析只适合于单目标优化数据处理的模型,对于不同的性能,需要建立不同的模型,因此将其应用于配方设计有一定的局限性。近年来,发展日趋成熟的人工神经网络技术,尤其是BP神经网络凭借其结构简单、收敛速度快、预测精度高等优势越来越多地应用到橡胶配方设计试验中。 1橡胶配方设计 1.1橡胶配方设计概述 配方设计¨J是橡胶工业中的首要技术问题,在橡胶工业中占有重要地位。所谓配方设计,就是根据产品的性能要求和工艺条件,通过试验、优化、鉴定,合理地选用原材料,确定各种原材料的用量配比关系。 橡胶配方人员的主要工作就是要确定一系列变量对橡胶各项性能的定量或定性影响。变量可以是硫化剂、促进剂、填充剂、防老剂等,也可以是加工:[艺条件(如硫化温度、硫化时间等),总之是配方人员可能控制或测得的变量。橡胶各项基本性能包括拉伸强度、撕裂强度、硬度、定伸应力等物理机械性能,以 及加工性能、光洁度、外观等。 橡胶配方设计常常是多变量的试验设计,配方设计理论和试验设计方法对于 配方设计具有重要意义。 X X X X大学 研究生考查课 作业 课程名称:智能控制理论与技术 研究生姓名:学号: 作业成绩: 任课教师(签名) 交作业日时间:2010年12月22日 人工神经网络(artificial neural network,简称ANN)是在对大脑的生理研究的基础上,用模拟生物神经元的某些基本功能元件(即人工神经元),按各种不同的联结方式组成的一个网络。模拟大脑的某些机制,实现某个方面的功能,可以用在模仿视觉、函数逼近、模式识别、分类和数据压缩等领域,是近年来人工智能计算的一个重要学科分支。 人工神经网络用相互联结的计算单元网络来描述体系。输人与输出的关系由联结权重和计算单元来反映,每个计算单元综合加权输人,通过激活函数作用产生输出,主要的激活函数是Sigmoid函数。ANN有中间单元的多层前向和反馈网络。从一系列给定数据得到模型化结果是ANN的一个重要特点,而模型化是选择网络权重实现的,因此选用合适的学习训练样本、优化网络结构、采用适当的学习训练方法就能得到包含学习训练样本范围的输人和输出的关系。如果用于学习训练的样本不能充分反映体系的特性,用ANN也不能很好描述与预测体系。显然,选用合适的学习训练样本、优化网络结构、采用适当的学习训练方法是ANN的重要研究内容之一,而寻求应用合适的激活函数也是ANN研究发展的重要内容。由于人工神经网络具有很强的非线性多变量数据的能力,已经在多组分非线性标定与预报中展现出诱人的前景。人工神经网络在工程领域中的应用前景越来越宽广。 1人工神经网络基本理论[1] 1.1神经生物学基础 可以简略地认为生物神经系统是以神经元为信号处理单元,通过广泛的突触联系形成的信息处理集团,其物质结构基础和功能单元是脑神经细胞即神经元(neu ron)。(1)神经元具有信号的输入、整合、输出三种主要功能作用行为。突触是整个神经系统各单元间信号传递驿站,它构成各神经元之间广泛的联接。(3)大脑皮质的神经元联接模式是生物体的遗传性与突触联接强度可塑性相互作用的产物,其变化是先天遗传信息确定的总框架下有限的自组织过程。 1.2建模方法 神经元的数量早在胎儿时期就已固定,后天的脑生长主要是指树突和轴突从神经细胞体中长出并形成突触联系,这就是一般人工神经网络建模方法的生物学依据。人脑建模一般可有两种方法:①神经生物学模型方法,即根据微观神经生物学知识的积累,把脑神经系统的结构及机理逐步解释清楚,在此基础上建立脑功能模型。②神经计算模型方法,即首先建立粗略近似的数学模型并研究该模型的动力学特性,然后再与真实对象作比较(仿真处理方法)。 1.3概念 人工神经网络用物理可实现系统来模仿人脑神经系统的结构和功能,是一门新兴的前沿交叉学科,其概念以T.Kohonen.Pr的论述最具代表性:人工神经网络就是由简单的处理单元(通常为适应性)组成的并行互联网络,它的组织能够模拟生物神经系统对真实世界物体所作出的交互反应。 1.4应用领域 人工神经网络在复杂类模式识别、运动控制、感知觉模拟方面有着不可替代的作用。概括地说人工神经网络主要应用于解决下述几类问题:模式信息处理和模式识别、最优化问题、信息的智能化处理、复杂控制、信号处理、数学逼近映射、感知觉模拟、概率密度函数估计、化学谱图分析、联想记忆及数据恢复等。 1.5理论局限性 (1)受限于脑科学的已有研究成果由于生理试验的困难性,目前对于人脑思维与记忆机制的认识尚很肤浅,对脑神经网的运行和神经细胞的内部处理机制还没有太多的认识。 (2)尚未建立起完整成熟的理论体系目前已提出的众多人工神经网络模型,归纳起来一般都是一个由节点及其互连构成的有向拓扑网,节点间互连强度构成的矩阵可通过某种学 《神经网络原理》 一、填空题 1、从系统的观点讲,人工神经元网络是由大量神经元通过极其丰富和完善的连接而构成的自适应、非线性、动力学系统。 2、神经网络的基本特性有拓扑性、学习性和稳定收敛性。 3、神经网络按结构可分为前馈网络和反馈网络,按性能可分为离散型和连续型,按学习方式可分为有导师和无导师。 4、神经网络研究的发展大致经过了四个阶段。 5、网络稳定性指从t=0时刻初态开始,到t时刻后v(t+△t)=v(t),(t>0),称网络稳定。 6、联想的形式有两种,它们分是自联想和异联想。 7、存储容量指网络稳定点的个数,提高存储容量的途径一是改进网络的拓扑结构,二是改进学习方法。 8、非稳定吸引子有两种状态,一是有限环状态,二是混沌状态。 9、神经元分兴奋性神经元和抑制性神经元。 10、汉明距离指两个向量中对应元素不同的个数。 二、简答题 1、人工神经元网络的特点? 答:(1)、信息分布存储和容错性。 (2)、大规模并行协同处理。 (3)、自学习、自组织和自适应。 (4)、人工神经元网络是大量的神经元的集体行为,表现为复杂 的非线性动力学特性。 (5)人式神经元网络具有不适合高精度计算、学习算法和网络设计没有统一标准等局限性。 2、单个神经元的动作特征有哪些? 答:单个神经元的动作特征有:(1)、空间相加性;(2)、时间相加性;(3)、阈值作用;(4)、不应期;(5)、可塑性;(6)疲劳。 3、怎样描述动力学系统? 答:对于离散时间系统,用一组一阶差分方程来描述: X(t+1)=F[X(t)]; 对于连续时间系统,用一阶微分方程来描述: dU(t)/dt=F[U(t)]。 4、F(x)与x 的关系如下图,试述它们分别有几个平衡状态,是否为稳定的平衡状态? 答:在图(1)中,有两个平衡状态a 、b ,其中,在a 点曲线斜率|F ’(X)|>1,为非稳定平稳状态;在b 点曲线斜率|F ’(X)|<1,为稳定平稳状态。 在图(2)中,有一个平稳状态a ,且在该点曲线斜率|F ’(X)|>1,为非稳定平稳状态。 Train.txt 5.0,3.0,1.6,0.2,1 5.0,3.4,1.6,0.4,1 5.2,3.5,1.5,0.2,1 5.2,3.4,1.4,0.2,1 4.7,3.2,1.6,0.2,1 4.8,3.1,1.6,0.2,1 5.4,3.4,1.5,0.4,1 5.2,4.1,1.5,0.1,1 5.5,4.2,1.4,0.2,1 4.9,3.1,1.5,0.1,1 5.0,3.2,1.2,0.2,1 5.5,3.5,1.3,0.2,1 4.9,3.1,1.5,0.1,1 4.4,3.0,1.3,0.2,1 5.1,3.4,1.5,0.2,1 5.0,3.5,1.3,0.3,1 4.5,2.3,1.3,0.3,1 4.4,3.2,1.3,0.2,1 5.0,3.5,1.6,0.6,1 5.1,3.8,1.9,0.4,1 4.8,3.0,1.4,0.3,1 5.1,3.8,1.6,0.2,1 4.6,3.2,1.4,0.2,1 5.3,3.7,1.5,0.2,1 5.0,3.3,1.4,0.2,1 6.6,3.0,4.4,1.4,2 6.8,2.8,4.8,1.4,2 6.7,3.0,5.0,1.7,2 6.0,2.9,4.5,1.5,2 5.7,2.6,3.5,1.0,2 5.5,2.4,3.8,1.1,2 5.5,2.4,3.7,1.0,2 5.8,2.7,3.9,1.2,2 6.0,2.7,5.1,1.6,2 5.4,3.0,4.5,1.5,2 6.0,3.4,4.5,1.6,2 6.7,3.1,4.7,1.5,2 6.3,2.3,4.4,1.3,2 5.6,3.0,4.1,1.3,2 5.5,2.5,4.0,1.3,2 5.5,2.6,4.4,1.2,2 6.1,3.0,4.6,1.4,2 5.8,2.6,4.0,1.2,2 人工神经网络发展前景 姓名 单位 摘要 在分析人工神经网络的发展过程、基本功能、应用范围的基础上,着重论述了神经网络与专家系统、模糊技术、遗传算法、灰色系统及小波分析的融合。 关键词 英文摘要 英文关键词 1前言 人工神经网络的发展起源于何时,说法不一。一般认为,其起源可追溯到Warren WcCulloch和Walter Pitts提出的MP模型。从此拉开了神经网络的序幕。20世纪50年代后期,Frank Rosenblatt定义了一种以后常用的神经网络结构,称为感知器。这是人工神经网络第一个实际应用;20世纪60年代,Bernard Widrow和Ted Hoff提出了一个新的学习算法用于训练自适应线性神经网络;20世纪70年代,Grossberg 提出了自适应共振理论。他研究了两种记忆机制(短期记忆和长期记忆),提出了一种可视系统的自组织神经网络,这是一种连续时间竞争网络,是构成自适应谐振理论网络基础;20世纪80年代,Hopfield 及一些学者提出了Hopfield网络模型,这是一种全连接的反馈网络。此外,Hinton等提出了Boltzman机。Kumellhart等人提出误差反向 传播神经网络,简称BP网络。目前BP神经网络已成为广泛使用的网络。 2应用现状 神经网络以及独特的结构和处理信息的方法,在许多实际应用领域中取得了显著的成效,主要应用如下: 1)信号处理。神经网络广泛应用于自适应信号处理和非线性信号处理中。前者如信号的自适应滤波、时间序列预测、谱估计、噪声消除等;后者如非线性滤波、非线性预测、非线性编码、调制/解调等。2)模式识别。神经网络不仅可以处理静态模式如固定图像、固定能谱等,还可以处理动态模式如视频图像、连续语音等。 3)系统识别。基于神经网络的系统辨识是以神经网络作为被识对象的模型,利用其非线性特性,可建立非线性系统的静态或动态模型。 4)智能检测。在对综合指标的检测(例如对环境舒适度这类综合指标检测)中,以神经网络作为智能检测中的信息处理联想等数据融合处理,从而实现单一传感器不具备的功能。 5)汽车工程。神经网络在汽车刹车自动控制系统中也有成功的应用,该系统能在给定刹车距离、车速和最大减速度的情况下,以人体能感受到的最小冲击实现平稳刹车,而不受路面坡度和车重影响。 6)化学工程。神经网络在光谱分析、判定化学反应的生成物、判定离子浓度及研究生命体中某些化合物的含量与生物活性的对应关系都有广泛应用并取得了一定成果。 7)卫生保健、医疗。比如通过训练自主组合的多层感知器可以区分 OpenCV的ml模块实现了人工神经网络(Artificial Neural Networks,ANN)最典型的多层感知器(multi-layer perceptrons, MLP)模型。由于ml模型实现的算法都继承自统一的CvStatModel基类,其训练和预测的接口都是train(),predict(),非常简单。 下面来看神经网络CvANN_MLP 的使用~ 定义神经网络及参数: [cpp]view plain copy 1.//Setup the BPNetwork 2. CvANN_MLP bp; 3.// Set up BPNetwork's parameters 4. CvANN_MLP_TrainParams params; 5. params.train_method=CvANN_MLP_TrainParams::BACKPROP; 6. params.bp_dw_scale=0.1; 7. params.bp_moment_scale=0.1; 8.//params.train_method=CvANN_MLP_TrainParams::RPROP; 9.//params.rp_dw0 = 0.1; 10.//params.rp_dw_plus = 1.2; 11.//params.rp_dw_minus = 0.5; 12.//params.rp_dw_min = FLT_EPSILON; 13.//params.rp_dw_max = 50.; 可以直接定义CvANN_MLP神经网络,并设置其参数。BACKPROP表示使用 back-propagation的训练方法,RPROP即最简单的propagation训练方法。 使用BACKPROP有两个相关参数:bp_dw_scale即bp_moment_scale: 使用PRPOP有四个相关参数:rp_dw0, rp_dw_plus, rp_dw_minus, rp_dw_min, rp_dw_max: 人工神经网络的发展与应用 神经网络发展 启蒙时期 启蒙时期开始于1980年美国著名心理学家W.James关于人脑结构与功能的研究,结束于1969年Minsky和Pape~发表的《感知器》(Perceptron)一书。早在1943年,心理学家McCulloch和数学家Pitts合作提出了形式神经元的数学模型(即M—P模型),该模型把神经细胞的动作描述为:1神经元的活动表现为兴奋或抑制的二值变化;2任何兴奋性突触有输入激励后,使神经元兴奋与神经元先前的动作状态无关;3任何抑制性突触有输入激励后,使神经元抑制;4突触的值不随时间改变;5突触从感知输入到传送出一个输出脉冲的延迟时问是0.5ms。可见,M—P模型是用逻辑的数学工具研究客观世界的事件在形式神经网络中的表述。现在来看M—P 模型尽管过于简单,而且其观点也并非完全正确,但是其理论有一定的贡献。因此,M—P模型被认为开创了神经科学理论研究的新时代。1949年,心理学家D.0.Hebb 提出了神经元之间突触联系强度可变的假设,并据此提出神经元的学习规则——Hebb规则,为神经网络的学习算法奠定了基础。1957年,计算机学家FrankRosenblatt提出了一种具有三层网络特性的神经网络结构,称为“感知器”(Perceptron),它是由阈值性神经元组成,试图模拟动物和人脑的感知学习能力,Rosenblatt认为信息被包含在相互连接或联合之中,而不是反映在拓扑结构的表示法中;另外,对于如何存储影响认知和行为的信息问题,他认为,存储的信息在神经网络系统内开始形成新的连接或传递链路后,新 的刺激将会通过这些新建立的链路自动地激活适当的响应部分,而不是要求任何识别或坚定他们的过程。1962年Widrow提出了自适应线性元件(Ada—line),它是连续取值的线性网络,主要用于自适应信号处理和自适应控制。 低潮期 人工智能的创始人之一Minkey和pape~经过数年研究,对以感知器为代表的网络系统的功能及其局限性从数学上做了深入的研究,于1969年出版了很有影响的《Perceptron)一书,该书提出了感知器不可能实现复杂的逻辑函数,这对当时的人工神经网络研究产生了极大的负面影响,从而使神经网络研究处于低潮时期。引起低潮的更重要的原因是:20世纪7O年代以来集成电路和微电子技术的迅猛发展,使传统的冯·诺伊曼型计算机进入发展的全盛时期,因此暂时掩盖了发展新型计算机和寻求新的神经网络的必要性和迫切性。但是在此时期,波士顿大学的S.Grossberg教授和赫尔辛基大学的Koho—nen教授,仍致力于神经网络的研究,分别提出了自适应共振理论(Adaptive Resonance Theory)和自组织特征映射模型(SOM)。以上开创性的研究成果和工作虽然未能引起当时人们的普遍重视,但其科学价值却不可磨灭,它们为神经网络的进一步发展奠定了基础。 复兴时期 20世纪80年代以来,由于以逻辑推理为基础的人工智能理论和冯·诺伊曼型计算机在处理诸如视觉、听觉、联想记忆等智能信息处理问题上受到挫折,促使人们 BP神经网络模型 第1节基本原理简介 近年来全球性的神经网络研究热潮的再度兴起,不仅仅是因为神经科学本身取得了巨大的进展.更主要的原因在于发展新型计算机和人工智能新途径的迫切需要.迄今为止在需要人工智能解决的许多问题中,人脑远比计算机聪明的多,要开创具有智能的新一代计算机,就必须了解人脑,研究人脑神经网络系统信息处理的机制.另一方面,基于神经科学研究成果基础上发展出来的人工神经网络模型,反映了人脑功能的若干基本特性,开拓了神经网络用于计算机的新途径.它对传统的计算机结构和人工智能是一个有力的挑战,引起了各方面专家的极大关注. 目前,已发展了几十种神经网络,例如Hopficld模型,Feldmann等的连接型网络模型,Hinton等的玻尔茨曼机模型,以及Rumelhart等的多层感知机模型和Kohonen的自组织网络模型等等。在这众多神经网络模型中,应用最广泛的是多层感知机神经网络。多层感知机神经网络的研究始于50年代,但一直进展不大。直到1985年,Rumelhart等人提出了误差反向传递学习算法(即BP算),实现了Minsky的多层网络 设想,如图34-1所示。 BP 算法不仅有输入层节点、输出层节点,还可有1个或多个隐含层节点。对于输入信号,要先向前传播到隐含层节点,经作用函数后,再把隐节点的输出信号传播到输出节点,最后给出输出结果。节点的作用的激励函数通常选取S 型函数,如 Q x e x f /11)(-+= 式中Q 为调整激励函数形式的Sigmoid 参数。该算法的学习过程由正向传播和反向传播组成。在正向传播过程中,输入信息从输入层经隐含层逐层处理,并 传向输出层。每一层神经元的状态只影响下一层神经 本文首先分析了图像识别技术以及bp神经网络算法,然后详细地阐述了人工神经网络图像识别技术。 【关键词】人工神经网络 bp神经网络图像识别识别技术 通常而言,所谓图像处理与识别,便是对实际图像进行转换与变换,进而达到识别的目的。图像往往具有相当庞大的信息量,在进行处理图像的时候要进行降维、数字化、滤波等程序,以往人们进行图像识别时采用投影法、不变矩法等方法,随着计算机技术的飞速发展,人工神经网络的图像识别技术将逐渐取代传统的图像识别方法,获得愈来愈广泛的应用。 1 人工神经网络图像识别技术概述 近年来,人工智能理论方面相关的理论越来越丰富,基于人工神经网络的图像识别技术也获得了非常广泛的应用,将图像识别技术与人工神经网络技术结合起来的优点是非常显著的,比如说: (1)由于神经网络具有自学习功能,可以使得系统能够适应识别图像信息的不确定性以及识别环境的不断变化。 (2)在一般情况下,神经网络的信息都是存储在网络的连接结构以及连接权值之上,从而使图像信息表示是统一的形式,如此便使得知识库的建立与管理变得简便起来。 (3)由于神经网络所具有的并行处理机制,在处理图像时可以达到比较快的速度,如此便可以使图像识别的实时处理要求得以满足。 (4)由于神经网络可增加图像信息处理的容错性,识别系统在图像遭到干扰的时候仍然能正常工作,输出较准确的信息。 2 图像识别技术探析 2.1 简介 广义来讲,图像技术是各种与图像有关的技术的总称。根据研究方法以及抽象程度的不同可以将图像技术分为三个层次,分为:图像处理、图像分析以及图像理解,该技术与计算机视觉、模式识别以及计算机图形学等学科互相交叉,与生物学、数学、物理学、电子学计算机科学等学科互相借鉴。此外,随着计算机技术的发展,对图像技术的进一步研究离不开神经网络、人工智能等理论。 2.2 图像处理、图像识别与图像理解的关系 图像处理包括图像压缩、图像编码以及图像分割等等,对图像进行处理的目的是判断图像里是否具有所需的信息并滤出噪声,并对这些信息进行确定。常用方法有灰度,二值化,锐化,去噪等;图像识别则是将经过处理的图像予以匹配,并且对类别名称进行确定,图像识别可以在分割的基础之上对所需提取的特征进行筛选,然后再对这些特征进行提取,最终根据测量结果进行识别;所谓图像理解,指的是在图像处理与图像识别的基础上,根据分类作结构句法分析,对图像进行描述与解释。所以,图像理解包括图像处理、图像识别和结构分析。就图像理解部分而言,输入是图像,输出是对图像的描述解释。 3 人工神经网络结构和算法 在上个世纪八十年代,mcclelland与rumelhant提出了一种人工神经网络,截止现在,bp神经网络已经发展成为应用最为广泛的神经网络之一,它是一种多层前馈神经网络,包括输入层、输出层和输入层输出层之间隐藏层,如图1所示,便是一种典型的bp神经网络结构。 bp神经网络是通过不断迭代更新权值使实际输入与输出关系达到期望,由输出向输入层反向计算误差,从而通过梯度下降方法不断修正各层权值的网络。 bp神经网络结构算法如下所述: (1)对权值矩阵,学习速率,最大学习次数,阈值等变量和参数进行初始化设置; (2)在黑色节点处对样本进行输入; 人工神经网络的发展及应用 西安邮电学院电信系樊宏西北电力设计院王勇日期:2005 1-21 1 人工神经网络的发展 1.1 人工神经网络基本理论 1.1.1 神经生物学基础生物神经系统可以简略地认为是以神经元为信号的处理单元,通过广泛的突触联系形成的信息处理集团,其物质结构基础和功能单元是脑神经细胞,即神经元(neuron) 。 (1)神经元具有信号的输人、整合、输出三种主要功能作用行为,结构如图1 所示: (2)突触是整个神经系统各单元间信号传递驿站,它构成各神经元之间广泛的联接。 (3)大脑皮质的神经元联接模式是生物体的遗传性与突触联接强度可塑性相互作用的产物,其变化是先天遗传信息确定的总框架下有限的自组织过程。 1.1.2 建模方法神经元的数量早在胎儿时期就已固定,后天的脑生长主要是指树突和轴突从神经细胞体中长出并形成突触联系,这就是一般人工神经网络建模方法的生物学依据。人脑建模一般可有两种方法:①神经生物学模型方法,即根据微观神经生物学知识的积累,把脑神经系统的结构及机理逐步解释清楚,在此基础上建立脑功能模型;②神 经计算模型方法,即首先建立粗略近似的数学模型并研究该模型的动力学特性,然后冉与真实对象作比较(仿真处理方法)。1.1.3 概 念人工神经网络用物理町实现系统采模仿人脑神经系统的结构和功能,是一门新兴的前沿交义学科,其概念以T.Kohonen.Pr 的论述 最具代表性:人工神经网络就是由简单的处理单元(通常为适应性神经元,模型见图2)组成的并行互联网络,它的组织能够模拟生物神 经系统对真实世界物体所作出的交互反应。 1.2 人工神经网络的发展 人工神经网络的研究始于40 年代初。半个世纪以来,经历了兴起、高潮与萧条、高潮及稳步发展的较为曲折的道路。1943 年,心理学家W.S.Mcculloch 和数理逻辑学家W.Pitts 提出了M—P 模型, 这是第一个用数理语言描述脑的信息处理过程的模型,虽然神经元的功能比较弱,但它为以后的研究工作提供了依据。1949 年,心理学家D. O. Hebb提出突触联系可变的假设,根据这一假设提出的学习规律为神经网络的学习算法奠定了基础。1957 年,计算机科学家Rosenblatt 提出了著名的感知机模型,它的模型包含了现代计算机的一些原理,是第一个完整的人工神经网络。1969 年,美国著名人工智能学者M.Minsky 和S.Papert 编写了影响很大的Perceptron 一书,从理论上证明单层感知机的能力有限,诸如不能解决异或问题,而且他们推测多层网络的感知能也不过如此,在这之后近10 年,神经网络研究进入了一个缓慢发展的萧条期。美国生物物理学家J.J.Hopfield 于1982年、1984 年在美国科学院院刊发表的两篇文章,有力地推动了神经网络的研究,引起了研究神经网络的 神经网络Matlab p=p1';t=t1'; [pn,minp,maxp,tn,mint,maxt]=premnmx(p,t); %原始数据归一化net=newff(minmax(pn),[5,1],{'tansig','purelin'},'traingdx');%设置网络,建立相应的BP网络 net.trainParam.show=2000; % 训练网络 net.trainParam.lr=0.01; net.trainParam.epochs=100000; net.trainParam.goal=1e-5; [net,tr]=train(net ,pn,tn); %调用TRAINGDM算法训练BP网络 pnew=pnew1'; pnewn=tramnmx(pnew,minp,maxp); anewn=sim(net,pnewn); %对BP网络进行仿真 anew=postmnmx(anewn,mint,maxt); %还原数据 y=anew'; 1、BP网络构建 (1)生成BP网络 = net newff PR S S SNl TF TF TFNl BTF BLF PF (,[1 2...],{ 1 2...},,,) R?维矩阵。 PR:由R维的输入样本最小最大值构成的2 S S SNl:各层的神经元个数。 [1 2...] TF TF TFNl:各层的神经元传递函数。 { 1 2...} BTF:训练用函数的名称。 (2)网络训练 = [,,,,,] (,,,,,,) net tr Y E Pf Af train net P T Pi Ai VV TV (3)网络仿真 = [,,,,] (,,,,) Y Pf Af E perf sim net P Pi Ai T {'tansig','purelin'},'trainrp' BP网络的训练函数 训练方法训练函数 梯度下降法traingd 有动量的梯度下降法traingdm 自适应lr梯度下降法traingda 自适应lr动量梯度下降法traingdx 弹性梯度下降法trainrp Fletcher-Reeves共轭梯度法traincgf Ploak-Ribiere共轭梯度法traincgp Powell-Beale共轭梯度法traincgb 量化共轭梯度法trainscg 拟牛顿算法trainbfg 一步正割算法trainoss Levenberg-Marquardt trainlm 人工神经网络作业M A T L A B 仿真(共3篇) -标准化文件发布号:(9456-EUATWK-MWUB-WUNN-INNUL-DDQTY-KII 人工神经网络仿真作业(3篇) 人工神经网络仿真作业1: 三级倒立摆的神经网络控制 人工神经网络仿真作业2: 基于模型整体逼近的机器人RBF网络自适应控制 人工神经网络仿真作业3: 基于RBF的机械手无需模型自适应控制研究 神经网络仿真作业1:三级倒立摆的神经网络控制 摘要:建立了基于人工神经网络改进BP 算法的三级倒立摆的数学模型,并给 出了BP 网络结构,利用Matlab 软件进行训练仿真,结果表明,改进的BP 算法控制倒立摆精度高、收敛快,在非线性控制、鲁棒控制等领域具有良好的应用前景。 1.引言 倒立摆系统的研究开始于19世纪50年代,它是一个典型的非线性、高阶次、多变量、强耦合和绝对不稳定系统.许多抽象的控制概念,如系统的稳定性、可控性、系统的收敛速度和抗干扰能力都可以通过倒立摆直观地表现出来。随着现代控制理论的发展,倒立摆的研究对于火箭飞行控制和机器人控制等现代高科技的研究具有重要的实践意义。目前比较常见的倒立摆稳定控制方法有线性控制,如LQR,LQY 等;智能控制,如变论域自适应模糊控制,遗传算法,预测控制等。 2.系统的数学模型 2.1三级倒立摆的模型及参数 三级倒立摆主要由小车,摆1、摆2、摆3组成,它们之间自由链接。小车可以在水平导轨上左右平移,摆杆可以在铅垂平面内运动,将其置于坐标系后如图1 所示: 规定顺时针方向的转角和力矩均为正。此外,约定以下记号:u 为外界作用力,x 为小车位移,i (i =1,2,3)为摆i 与铅垂线方向的夹角, i O 分别为摆i 的链接点位置。其它的系统参数说明如下: 神经网络 在石灰窑炉的建模与控制中的应用神经网络应用广泛,尤其在系统建模与控制方面,都有很好应用。下面简要介绍神经网络在石灰窑炉的建模与控制中的应用,以便更具体地了解神经网络在实际应用中的具体问题和应用效果。 1 石灰窑炉的生产过程和数学模型 石灰窑炉是造纸厂中一个回收设备,它可以使生产过程中所用的化工原料循环使用,从而降低生产成本并减少环境污染。其工作原理和过程如图1所示,它是一个长长的金属圆柱体,其轴线和水平面稍稍倾斜,并能绕轴线旋转,所以又 CaCO(碳酸钙)泥桨由左端输入迴转窑,称为迴转窑。含有大约30%水分的 3 由于窑的坡度和旋转作用,泥桨在炉内从左向右慢慢下滑。而燃料油和空气由右端喷入燃烧,形成气流由右向左流动,以使泥桨干燥、加热并发生分解反应。迴转窑从左到右可分为干燥段、加热段、煅烧段和泠却段。最终生成的石灰由右端输出,而废气由左端排出。 图1石灰窑炉示意图 这是一个连续的生产过程,原料和燃料不断输入,而产品和废气不断输出。在生产过程中首先要保证产品质量,包括CaO的含量、粒度和多孔性等指标,因此必须使炉内有合适的温度分布,温度太低碳酸钙不能完全分解,会残留在产品中,温度过高又会造成生灰的多孔性能不好,费燃料又易损坏窑壁。但是在生产过程中原料成分、含水量、进料速度、燃油成分和炉窑转速等生产条件经常会发生变化,而且有些量和变化是无法实时量测的。在这种条件下,要做到稳定生产、高质量、低消耗和低污染,对自动控制提出了很高的要求。 以前曾有人分析窑炉内发生的物理-化学变化,并根据传热和传质过程来建立窑炉的数学模型,认为窑炉是一个分布参数的非线性动态系统,可以用二组偏人工神经网络原理及实际应用

人工智能习题&答案-第4章-计算智能1-神经计算-模糊计算

基于人工神经网络的通信信号分类识别

人工神经网络

人工神经网络大作业

人工神经网络复习题

BP神经网络测试例子(附数据)

人工神经网络发展前景111

神经网络一个简单实例

人工神经网络的发展及应用

BP神经网络模型应用实例

基于人工神经网络的图像识别

人工神经网络的发展及应用

BP神经网络matlab实例

人工神经网络作业MATLAB仿真(共3篇)

神经网络应用实例