BP神经网络例二(分类)

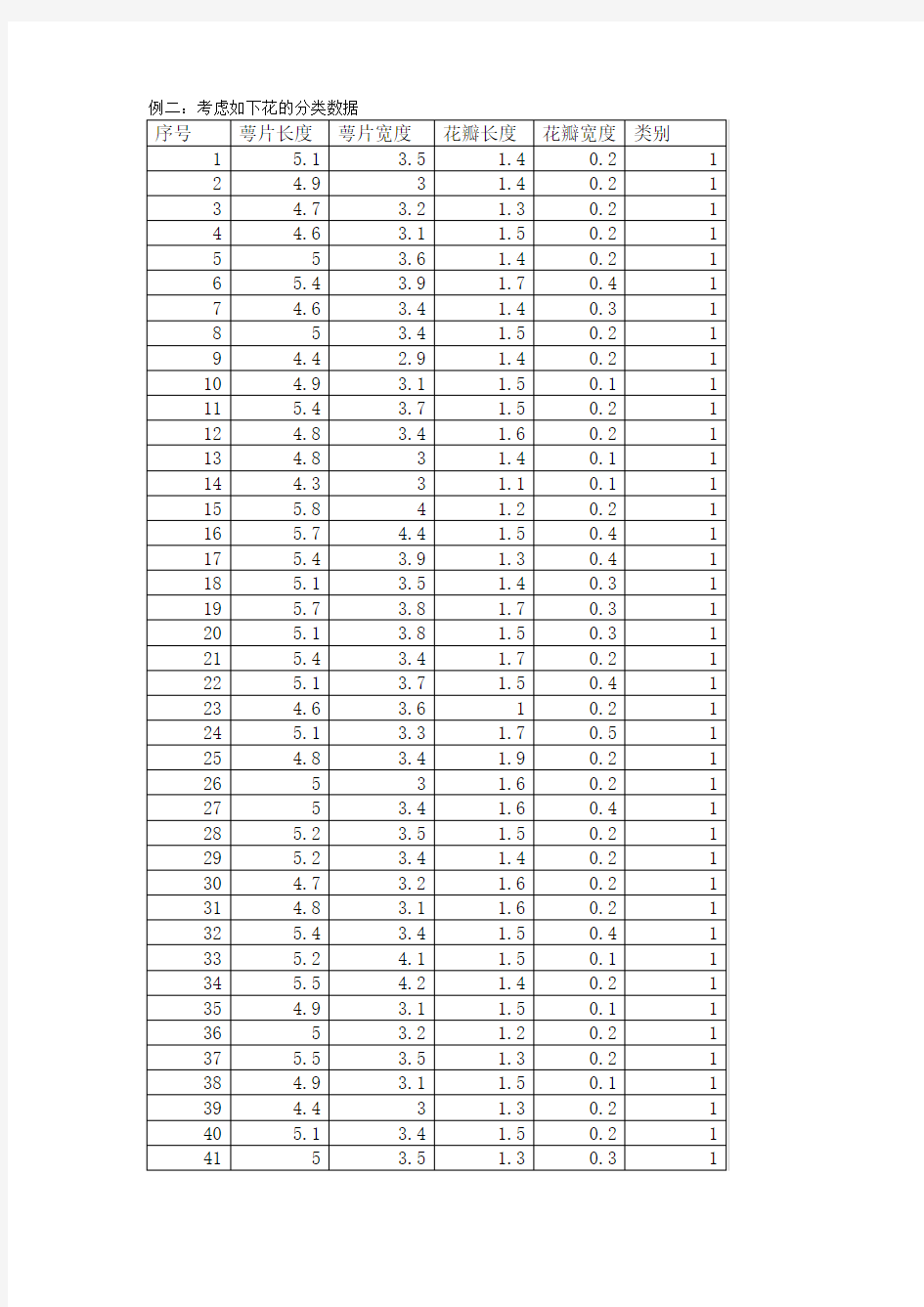

例二:考虑如下花的分类数据

这是一个三类问题,为了验证算法的性能,用每类的前25个数据(共75)作为训练样本,用BP神经网络进行建模,并对剩下的样本用该网络进行判别。

p=[5.1,3.5,1.4,0.2;

4.9,3.0,1.4,0.2; 4.7,3.2,1.3,0.2;

4.6,3.1,1.5,0.2;

5.0,3.6,1.4,0.2; 5.4,3.9,1.7,0.4;

4.6,3.4,1.4,0.3;

5.0,3.4,1.5,0.2; 4.4,2.9,1.4,0.2;

4.9,3.1,1.5,0.1;

5.4,3.7,1.5,0.2; 4.8,3.4,1.6,0.2; 4.8,3.0,1.4,0.1;

4.3,3.0,1.1,0.1;

5.8,4.0,1.2,0.2; 5.7,4.4,1.5,0.4; 5.4,3.9,1.3,0.4; 5.1,3.5,1.4,0.3; 5.7,3.8,1.7,0.3; 5.1,3.8,1.5,0.3; 5.4,3.4,1.7,0.2; 5.1,3.7,1.5,0.4;

5.1,3.3,1.7,0.5;

4.8,3.4,1.9,0.2;

7.0,3.2,4.7,1.4;

6.4,3.2,4.5,1.5;

6.9,3.1,4.9,1.5;

5.5,2.3,4.0,1.3;

6.5,2.8,4.6,1.5;

5.7,2.8,4.5,1.3;

6.3,3.3,4.7,1.6;

4.9,2.4,3.3,1.0;

6.6,2.9,4.6,1.3;

5.2,2.7,3.9,1.4;

5.0,2.0,3.5,1.0;

5.9,3.0,4.2,1.5;

6.0,2.2,4.0,1.0;

6.1,2.9,4.7,1.4;

5.6,2.9,3.6,1.3;

6.7,3.1,4.4,1.4;

5.6,3.0,4.5,1.5;

5.8,2.7,4.1,1.0;

6.2,2.2,4.5,1.5;

5.6,2.5,3.9,1.1;

5.9,3.2,4.8,1.8;

6.1,2.8,4.0,1.3;

6.3,2.5,4.9,1.5;

6.1,2.8,4.7,1.2;

6.4,2.9,4.3,1.3;

6.3,3.3,6.0,2.5;

5.8,2.7,5.1,1.9;

7.1,3.0,5.9,2.1;

6.3,2.9,5.6,1.8;

6.5,3.0,5.8,2.2;

7.6,3.0,6.6,2.1;

4.9,2.5,4.5,1.7;

7.3,2.9,6.3,1.8;

6.7,2.5,5.8,1.8;

7.2,3.6,6.1,2.5;

6.5,3.2,5.1,2.0;

6.4,2.7,5.3,1.9;

6.8,3.0,5.5,2.1;

5.7,2.5,5.0,2.0;

5.8,2.8,5.1,2.4;

6.4,3.2,5.3,2.3;

7.7,3.8,6.7,2.2;

7.7,2.6,6.9,2.3;

6.0,2.2,5.0,1.5;

6.9,3.2,5.7,2.3;

5.6,2.8,4.9,2.0;

7.7,2.8,6.7,2.0;

6.3,2.7,4.9,1.8;

6.7,3.3,5.7,2.1]';

for i=1:4

P(i,:)=(p(i,:)-min(p(i,:)))/(max(p(i,:))-min(p(i,:))); end

T=[1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

1 0 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 1 0;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1;

0 0 1]';

threshold=[0 1;0 1;0 1;0 1];

net=newff(threshold,[9,3],{'tansig','logsig'},'trainlm'); net=train(net,P,T);

y_test=sim(net,P)'

p_test=[5.0,3.0,1.6,0.2;

5.0,3.4,1.6,0.4;

5.2,3.5,1.5,0.2;

5.2,3.4,1.4,0.2;

4.7,3.2,1.6,0.2;

4.8,3.1,1.6,0.2;

5.4,3.4,1.5,0.4;

5.2,4.1,1.5,0.1;

5.5,4.2,1.4,0.2;

4.9,3.1,1.5,0.1;

5.0,3.2,1.2,0.2;

5.5,3.5,1.3,0.2;

4.9,3.1,1.5,0.1;

4.4,3.0,1.3,0.2;

5.1,3.4,1.5,0.2;

5.0,3.5,1.3,0.3;

4.5,2.3,1.3,0.3;

4.4,3.2,1.3,0.2;

5.0,3.5,1.6,0.6;

5.1,3.8,1.9,0.4;

4.8,3.0,1.4,0.3;

5.1,3.8,1.6,0.2;

4.6,3.2,1.4,0.2;

5.3,3.7,1.5,0.2;

5.0,3.3,1.4,0.2;

6.6,3.0,4.4,1.4;

6.8,2.8,4.8,1.4;

6.7,3.0,5.0,1.7;

6.0,2.9,4.5,1.5;

5.7,2.6,3.5,1.0;

5.5,2.4,3.8,1.1;

5.5,2.4,3.7,1.0;

5.8,2.7,3.9,1.2;

6.0,2.7,5.1,1.6;

5.4,3.0,4.5,1.5;

6.0,3.4,4.5,1.6;

6.7,3.1,4.7,1.5;

6.3,2.3,4.4,1.3;

5.6,3.0,4.1,1.3;

5.5,2.5,4.0,1.3;

5.5,2.6,4.4,1.2;

6.1,3.0,4.6,1.4;

5.8,2.6,4.0,1.2;

5.0,2.3,3.3,1.0;

5.6,2.7,4.2,1.3;

5.7,3.0,4.2,1.2;

5.7,2.9,4.2,1.3;

6.2,2.9,4.3,1.3;

5.1,2.5,3.0,1.1;

5.7,2.8,4.1,1.3;

7.2,3.2,6.0,1.8;

6.2,2.8,4.8,1.8;

6.1,3.0,4.9,1.8;

6.4,2.8,5.6,2.1;

7.2,3.0,5.8,1.6;

7.4,2.8,6.1,1.9;

7.9,3.8,6.4,2.0;

6.4,2.8,5.6,2.2;

6.3,2.8,5.1,1.5;

6.1,2.6,5.6,1.4;

7.7,3.0,6.1,2.3;

6.3,3.4,5.6,2.4;

6.4,3.1,5.5,1.8;

6.0,3.0,4.8,1.8;

6.9,3.1,5.4,2.1;

6.7,3.1,5.6,2.4;

6.9,3.1,5.1,2.3;

5.8,2.7,5.1,1.9;

6.8,3.2,5.9,2.3;

6.7,3.3,5.7,2.5;

6.7,3.0,5.2,2.3;

6.3,2.5,5.0,1.9;

6.5,3.0,5.2,2.0;

6.2,3.4,5.4,2.3;

5.9,3.0,5.1,1.8]';

for i=1:4

P_test(i,:)=(p_test(i,:)-min(p_test(i,:)))/(max(p_test(i,:))-min(p_test(i,:))); end

format long ;

y=sim(net,P_test)'

yy=y;

输出结果如下表:表一

对训练样本的错判率为0;

模型检验(用模型对剩下的样本进行判断检验)如下表:

基于人工神经网络的通信信号分类识别

基于人工神经网络的通信信号分类识别 冯 涛 (中国电子科技集团公司第54研究所,河北石家庄050081) 摘 要 通信信号的分类识别是一种典型的统计模式识别问题。系统地论述了通信信号特征选择、特征提取和分类识别的原理和方法。设计了人工神经网络分类器,包括神经网络模型的选择、分类器的输入输出表示、神经网络拓扑结构和训练算法,并提出了分层结构的神经网络分类器。 关键词 模式识别;特征提取;分类器;神经网中图分类号 TP391 文献标识码 A Classification and Identification of Communication Signal Using Artificial Neural Networks FE NG Tao (T he 54th Research Institute of CETC,Shijia zhuan g Hebei 050081,China) Abstract The classification and identificati on of communication signal is a typical statistical pattern identification.The paper discusses the theory and method of feature selection,feature extraction and classi fication &identificaiton of communication signal.A classifier based on artificial neural networks is designed,includin g the selection of neural network model,the input and output expression of the classifier,neural network topology and trainin g algorithm.Finally a hierarchical archi tecture classifier based on artificial neural networks is presented. Key words pattern recognition;features extraction;classifier;neural networks 收稿日期:2005-12-16 0 引言 在通信对抗侦察中,侦察接收设备在截获敌方通信信号后,必须经过对信号的特征提取和对信号特征的分析识别,才能变为有价值的通信对抗情报。通过对信号特征的分析识别,可以得到信号种类、通信体制、网路组成等方面的情报,从而为研究通信对抗策略、研制和发展通信对抗装备提供重要参考依据。 1 通信信号分类识别的原理 通信信号的分类识别是一种典型的模式识别应用,其作用和目的就是将某一接收到的信号正确地归入某一种类型中。一般过程如图1 所示。 图1 通信信号分类识别的一般过程 下面简单介绍这几部分的作用。 信号获取:接收来自天线的信号x (t),并对信号进行变频、放大和滤波,输出一个中频信号; A/D 变换:将中频模拟信号变换为计算机可以运算的数字信号x (n); 以上2步是信号空间x (t)到观察空间x (n )的变换映射。 特征提取:为了有效地实现分类识别,必须对原始数据进行变换,得到最能反映分类差别的特征。这些特征的选择和提取是非常重要的,因为它强烈地影响着分类器的设计和性能。理想情况下,经过特征提取得到的特征向量对不同信号类型应该有明显的差别; 分类器设计和分类决策:分类问题是根据识别对象特征的观察值将其分到某个类别中去。首先,在样本训练集基础上确定合适的规则和分类器结构,然后,学习训练得到分类器参数。最后进行分类决策,把待识别信号从特征空间映射到决策空间。 2 通信信号特征参数的选择与特征提取 2 1 通信信号特征参数的选择 选择好的特征参数可以提高低信噪比下的正确 识别率,降低分类器设计的难度,是基于统计模式识别方法最为关键的一个环节。试图根据有限的信号 信号与信息处理 24 2006Radio Engineering Vo1 36No 6

BP神经网络的数据分类MATLAB源代码.doc

%%%清除空间 clc clear all ; close all ; %%%训练数据预测数据提取以及归一化 %%%下载四类数据 load data1 c1 load data2 c2 load data3 c3 load data4 c4 %%%%四个特征信号矩阵合成一个矩阵data ( 1:500 , : ) = data1 ( 1:500 , :) ; data ( 501:1000 , : ) = data2 ( 1:500 , : ) ; data ( 1001:1500 , : ) = data3 ( 1:500 , : ) ; data ( 1501:2000 , : ) = data4 ( 1:500 , : ) ; %%%%%%从1到2000间的随机排序 k = rand ( 1 , 2000 ) ; [ m , n ] = sort ( k ) ; %%m为数值,n为标号

%%%%%%%%%%%输入输出数据 input = data ( : , 2:25 ) ; output1 = data ( : , 1) ; %%%%%%把输出从1维变到4维 for i = 1 : 1 :2000 switch output1( i ) case 1 output( i , :) = [ 1 0 0 0 ] ; case 2 output( i , :) = [ 0 1 0 0 ] ; case 3 output( i , :) = [ 0 0 1 0 ] ; case 4 output( i , :) = [ 0 0 0 1 ] ; end end %%%%随机抽取1500个样本作为训练样本,500个样本作为预测样本 input_train = input ( n( 1:1500 , : ) )’ ; output_train = output ( n( 1:1500 , : ) )’ ; input_test = input ( n( 1501:2000 , : ) )’ ;

MATLAB程序代码--BP神经网络的设计实例

MATLAB程序代码--BP神经网络的设计实例 例1 采用动量梯度下降算法训练 BP 网络。 训练样本定义如下: 输入矢量为 p =[-1 -2 3 1 -1 1 5 -3] 目标矢量为 t = [-1 -1 1 1] 解:本例的 MATLAB 程序如下: close all clear echo on clc % NEWFF——生成一个新的前向神经网络 % TRAIN——对 BP 神经网络进行训练 % SIM——对 BP 神经网络进行仿真 pause % 敲任意键开始 clc % 定义训练样本 % P 为输入矢量 P=[-1, -2, 3, 1; -1, 1, 5, -3]; % T 为目标矢量 T=[-1, -1, 1, 1]; pause; clc % 创建一个新的前向神经网络 net=newff(minmax(P),[3,1],{'tansig','purelin'},'traingdm') % 当前输入层权值和阈值 inputWeights=net.IW{1,1} inputbias=net.b{1} % 当前网络层权值和阈值 layerWeights=net.LW{2,1} layerbias=net.b{2} pause clc % 设置训练参数 net.trainParam.show = 50; net.trainParam.lr = 0.05; net.trainParam.mc = 0.9;

net.trainParam.epochs = 1000; net.trainParam.goal = 1e-3; pause clc % 调用 TRAINGDM 算法训练 BP 网络 [net,tr]=train(net,P,T); pause clc % 对 BP 网络进行仿真 A = sim(net,P) % 计算仿真误差 E = T - A MSE=mse(E) pause clc echo off 例2 采用贝叶斯正则化算法提高 BP 网络的推广能力。在本例中,我们采用两种训练方法,即 L-M 优化算法(trainlm)和贝叶斯正则化算法(trainbr),用以训练 BP 网络,使其能够拟合某一附加有白噪声的正弦样本数据。其中,样本数据可以采用如下MATLAB 语句生成:输入矢量:P = [-1:0.05:1]; 目标矢量:randn(’seed’,78341223); T = sin(2*pi*P)+0.1*randn(size(P)); 解:本例的 MATLAB 程序如下: close all clear echo on

1BP神经网络实现(JAVA代码)

BP神经网络实现(Java代码) 神经网络的原理虽然理解起来不难,但是要是想实现它,还是需要做一些工作的,并且有很多细节性的东西需要注意。通过参阅各种相关资料,以及参考网络上已有的资源,自己写了一个含有一个隐含层,且只能有一个输出单元的简单的BP网络,经过测试,达到了预期的效果。 需要说明的是,神经网络的每个输入都在[0,1]中,输出也在[0,1]中,在使用神经网络解决实际问题的时候,还需要对实际问题的输入输出进行归一化处理。另外,尽量不要使得神经网络的输入或输出接近于0或1,这样会影响拟合效果。 我用正弦函数进行了一次测试,效果如图所示: 以下是相关的代码: 1.神经网络代码 [java]view plaincopy 1.package pkg1; 2. 3.import java.util.Scanner; 4. 5./* 6.* 7.*/ 8.public class TestNeuro{

9. 10.private int INPUT_DIM=1; 11.private int HIDDEN_DIM=20; 12.private double LEARNING_RATE=0.05; 13.double[][]input_hidden_weights=new double[INPUT_DIM][HIDDEN_DIM]; 14.double[]hidden_output_weights=new double[HIDDEN_DIM]; 15.double[]hidden_thresholds=new double[HIDDEN_DIM]; 16.double output_threshold; 17. 18.public static void main(String[]args){ 19.Scanner in=new Scanner(System.in); 20.TestNeuro neuro=new TestNeuro(1,5); 21.neuro.initialize(); 22.for(int i=0;i<10000;i++){ 23.double[]input=new double[1]; 24.input[0]=Math.random(); 25.double expectedOutput=input[0]*input[0]; 26.//System.out.println("input:"+input[0]+"\t\texpectedOutput: "+expectedOutput); 27.//System.out.println("predict before training:"+neuro.predict (input)); 28.neuro.trainOnce(input,expectedOutput); 29.//System.out.println("predict after training:"+neuro.predict( input)); 30.//in.next(); 31.} 32.while(true){ 33.//neuro.printLinks(); 34.double[]input=new double[1]; 35.input[0]=in.nextDouble(); 36.double expectedOutput=in.nextDouble(); 37.System.out.println("predict before training:"+neuro.predict(i nput)); 38.neuro.trainOnce(input,expectedOutput); 39.System.out.println("predict after training:"+neuro.predict(in put)); 40. 41.} 42.} 43. 44.public TestNeuro(int input_dimension,int hidden_dimension){ 45.this.INPUT_DIM=input_dimension; 46.this.HIDDEN_DIM=hidden_dimension; 47.this.initialize();

基于遗传算法的BP神经网络MATLAB代码

用遗传算法优化BP神经网络的Matlab编程实例(转) 由于BP网络的权值优化是一个无约束优化问题,而且权值要采用实数编码,所以直接利用Matlab遗传算法工具箱。以下贴出的代码是为一个19输入变量,1个输出变量情况下的非线性回归而设计的,如果要应用于其它情况,只需改动编解码函数即可。 程序一:GA训练BP权值的主函数 function net=GABPNET(XX,YY) %-------------------------------------------------------------------------- % GABPNET.m % 使用遗传算法对BP网络权值阈值进行优化,再用BP算法训练网络 %-------------------------------------------------------------------------- %数据归一化预处理 nntwarn off XX=[1:19;2:20;3:21;4:22]'; YY=[1:4]; XX=premnmx(XX); YY=premnmx(YY); YY %创建网络 net=newff(minmax(XX),[19,25,1],{'tansig','tansig','purelin'},'tra inlm'); %下面使用遗传算法对网络进行优化 P=XX; T=YY; R=size(P,1); S2=size(T,1); S1=25;%隐含层节点数 S=R*S1+S1*S2+S1+S2;%遗传算法编码长度 aa=ones(S,1)*[-1,1]; popu=50;%种群规模 save data2 XX YY % 是将 xx,yy 二个变数的数值存入 data2 这个MAT-file,initPpp=initializega(popu,aa,'gabpEval');%初始化种群 gen=100;%遗传代数

神经网络在数据挖掘中的应用

神经网络在数据挖掘中的应用

————————————————————————————————作者:————————————————————————————————日期: ?

神经网络在数据挖掘中的应用 摘要:给出了数据挖掘方法的研究现状,通过分析当前一些数据挖掘方法的局限性,介绍一种基于关系数据库的数据挖掘方法——神经网络方法,目前,在数据挖掘中最常用的神经网络是BP网络。在本文最后,也提出了神经网络方法在数据挖掘中存在的一些问题. 关键词:BP算法;神经网络;数据挖掘 1.引言 在“数据爆炸但知识贫乏”的网络时代,人们希望能够对其进行更高层次的分析,以便更好地利用这些数据。数据挖掘技术应运而生。并显示出强大的生命力。和传统的数据分析不同的是数据挖掘是在没有明确假设的前提下去挖掘信息、发现知识。所得到的信息具有先未知,有效性和实用性三个特征。它是从大量数据中寻找其规律的技术,主要有数据准备、规律寻找和规律表示三个步骤。数据准备是从各种数据源中选取和集成用于数据挖掘的数据;规律寻找是用某种方法将数据中的规律找出来;规律表示是用尽可能符合用户习惯的方式(如可视化)将找出的规律表示出来。数据挖掘在自身发展的过程中,吸收了数理统计、数据库和人工智能中的大量技术。作为近年来来一门处理数据的新兴技术,数据挖掘的目标主要是为了帮助决策者寻找数据间潜在的关联(Relation),特征(Pattern)、趋势(Trend)等,发现被忽略的要素,对预测未来和决策行为十分有用。 数据挖掘技术在商业方面应用较早,目前已经成为电子商务中的关键技术。并且由于数据挖掘在开发信息资源方面的优越性,已逐步推广到保险、医疗、制造业和电信等各个行业的应用。 数据挖掘(Data Mining)是数据库中知识发现的核心,形成了一种全新的应用领域。数据挖掘是从大量的、有噪声的、随机的数据中,识别有效的、新颖的、有潜在应用价值及完全可理解模式的非凡过程。从而对科学研究、商业决策和企业管理提供帮助。 数据挖掘是一个高级的处理过程,它从数据集中识别出以模式来表示的知识。它的核心技术是人工智能、机器学习、统计等,但一个DM系统不是多项技术的简单组合,而是一个完整的整体,它还需要其它辅助技术的支持,才能完成数据采集、预处理、数据分析、结果表述这一系列的高级处理过程。所谓高级处理过程是指一个多步骤的处理过程,多步骤之间相互影响、反复调整,形成一种螺旋式上升过程。最后将分析结果呈现在用户面前。根据功能,整个DM系统可以大致分为三级结构。 神经网络具有自适应和学习功能,网络不断检验预测结果与实际情况是否相符。把与实际情况不符合的输入输出数据对作为新的样本,神经网络对新样本进行动态学习并动态改变网络结构和参数,这样使网络适应环境或预测对象本身结构和参数的变化,从而使预测网络模型有更强的适应性,从而得到更符合实际情况的知识和规则,辅助决策者进行更好地决策。而在ANN的

BP神经网络matlab源程序代码

close all clear echo on clc % NEWFF——生成一个新的前向神经网络 % TRAIN——对 BP 神经网络进行训练 % SIM——对 BP 神经网络进行仿真 % 定义训练样本 % P为输入矢量 P=[0.7317 0.6790 0.5710 0.5673 0.5948;0.6790 0.5710 0.5673 0.5948 0.6292; ... 0.5710 0.5673 0.5948 0.6292 0.6488;0.5673 0.5948 0.6292 0.6488 0.6130; ... 0.5948 0.6292 0.6488 0.6130 0.5654; 0.6292 0.6488 0.6130 0.5654 0.5567; ... 0.6488 0.6130 0.5654 0.5567 0.5673;0.6130 0.5654 0.5567 0.5673 0.5976; ... 0.5654 0.5567 0.5673 0.5976 0.6269;0.5567 0.5673 0.5976 0.6269 0.6274; ... 0.5673 0.5976 0.6269 0.6274 0.6301;0.5976 0.6269 0.6274 0.6301 0.5803; ... 0.6269 0.6274 0.6301 0.5803 0.6668;0.6274 0.6301 0.5803 0.6668 0.6896; ... 0.6301 0.5803 0.6668 0.6896 0.7497]; % T为目标矢量 T=[0.6292 0.6488 0.6130 0.5654 0.5567 0.5673 0.5976 ... 0.6269 0.6274 0.6301 0.5803 0.6668 0.6896 0.7497 0.8094]; % Ptest为测试输入矢量 Ptest=[0.5803 0.6668 0.6896 0.7497 0.8094;0.6668 0.6896 0.7497 0.8094 0.8722; ... 0.6896 0.7497 0.8094 0.8722 0.9096]; % Ttest为测试目标矢量 Ttest=[0.8722 0.9096 1.0000]; % 创建一个新的前向神经网络 net=newff(minmax(P'),[12,1],{'logsig','purelin'},'traingdm'); % 设置训练参数 net.trainParam.show = 50; net.trainParam.lr = 0.05; net.trainParam.mc = 0.9; net.trainParam.epochs = 5000; net.trainParam.goal = 0.001; % 调用TRAINGDM算法训练 BP 网络 [net,tr]=train(net,P',T); % 对BP网络进行仿真 A=sim(net,P'); figure; plot((1993:2007),T,'-*',(1993:2007),A,'-o'); title('网络的实际输出和仿真输出结果,*为真实值,o为预测值'); xlabel('年份'); ylabel('客运量'); % 对BP网络进行测试 A1=sim(net,Ptest');

BP神经网络MATLAB代码

BP神经网络matlab代码 p=[284528334488;283344884554;448845542928;455429283497;29283497 2261;... 349722616921;226169211391;692113913580;139135804451;35804451 2636;... 445126363471;263634713854;347138543556;385435562659;35562659 4335;... 265943352882;433528824084;433528821999;288219992889;19992889 2175;... 288921752510;217525103409;251034093729;340937293489;37293489 3172;... 348931724568;317245684015;]'; %====期望输出======= t=[4554292834972261692113913580445126363471385435562659... 4335288240841999288921752510340937293489317245684015... 3666]; ptest=[284528334488;283344884554;448845542928;455429283497;29283497 2261;... 349722616921;226169211391;692113913580;139135804451;35804451 2636;... 445126363471;263634713854;347138543556;385435562659;35562659 4335;... 265943352882;433528824084;433528821999;288219992889;19992889 2175;... 288921752510;217525103409;251034093729;340937293489;37293489 3172;... 348931724568;317245684015;456840153666]'; [pn,minp,maxp,tn,mint,maxt]=premnmx(p,t);%将数据归一化 NodeNum1=20;%隐层第一层节点数 NodeNum2=40;%隐层第二层节点数 TypeNum=1;%输出维数 TF1='tansig'; TF2='tansig'; TF3='tansig'; net=newff(minmax(pn),[NodeNum1,NodeNum2,TypeNum],{TF1TF2 TF3},'traingdx');

BP神经网络的数据分类-语音特征信号分类

clear %% 训练数据预测数据提取及归一化 %下载四类语音信号 load data1 c1 load data2 c2 load data3 c3 load data4 c4 %四个特征信号矩阵合成一个矩阵 data(1:500,:)=c1(1:500,:); data(501:1000,:)=c2(1:500,:); data(1001:1500,:)=c3(1:500,:); data(1501:2000,:)=c4(1:500,:); %从1到2000间随机排序 k=rand(1,2000); [m,n]=sort(k); %输入输出数据 input=data(:,2:25); output1 =data(:,1); %把输出从1维变成4维 for i=1:2000 switch output1(i) case 1 output(i,:)=[1 0 0 0]; case 2 output(i,:)=[0 1 0 0]; case 3 output(i,:)=[0 0 1 0]; case 4 output(i,:)=[0 0 0 1]; end end %随机提取1500个样本为训练样本,500个样本为预测样本input_train=input(n(1:1500),:)'; output_train=output(n(1:1500),:)'; input_test=input(n(1501:2000),:)'; output_test=output(n(1501:2000),:)'; %输入数据归一化 [inputn,inputps]=mapminmax(input_train); %% 网络结构初始化 innum=24; midnum=25; outnum=4;

matlab30个案例分析案例12-SVM神经网络的数据分类预测

%% SVM神经网络的数据分类预测----意大利葡萄酒种类识别 %% 清空环境变量 close all; clear; clc; format compact; %% 数据提取 % 载入测试数据wine,其中包含的数据为classnumber = 3,wine:178*13的矩阵,wine_labes:178*1的列向量 load chapter12_wine.mat; % 画出测试数据的box可视化图 figure; boxplot(wine,'orientation','horizontal','labels',categories); title('wine数据的box可视化图','FontSize',12); xlabel('属性值','FontSize',12); grid on; % 画出测试数据的分维可视化图 figure subplot(3,5,1); hold on for run = 1:178 plot(run,wine_labels(run),'*'); end xlabel('样本','FontSize',10); ylabel('类别标签','FontSize',10); title('class','FontSize',10); for run = 2:14 subplot(3,5,run); hold on; str = ['attrib ',num2str(run-1)]; for i = 1:178 plot(i,wine(i,run-1),'*'); end xlabel('样本','FontSize',10); ylabel('属性值','FontSize',10); title(str,'FontSize',10); end % 选定训练集和测试集 % 将第一类的1-30,第二类的60-95,第三类的131-153做为训练集

人工神经网络的发展和分类

人工神经网络的发展和分类 人工神经网络是一种应用类似于大脑神经突触联接的结构进行信息处理的数学模型。在工程与学术界也常直接简称为神经网络或类神经网络。神经网络是一种运算模型,由大量的节点(或称神经元)和之间相互联接构成。每个节点代表一种特定的输出函数,称为激励函数(activation function)。每两个节点间的连接都代表一个对于通过该连接信号的加权值,称之为权重,这相当于人工神经网络的记忆。网络的输出则依网络的连接方式,权重值和激励函数的不同而不同。而网络自身通常都是对自然界某种算法或者函数的逼近,也可能是对一种逻辑策略的表达。 它的构筑理念是受到生物(人或其他动物)神经网络功能的运作启发而产生的。人工神经网络通常是通过一个基于数学统计学类型的学习方法(Learning Method)得以优化,所以人工神经网络也是数学统计学方法的一种实际应用,通过统计学的标准数学方法我们能够得到大量的可以用函数来表达的局部结构空间,另一方面在人工智能学的人工感知领域,我们通过数学统计学的应用可以来做人工感知方面的决定问题(也就是说通过统计学的方法,人工神经网络能够类似人一样具有简单的决定能力和简单的判断能力),这种方法比起正式的逻辑学推理演算更具有优势。 1943年,心理学家W.S.McCulloch和数理逻辑学家W.Pitts建立了神经网络和数学模型,称为MP模型。他们通过MP模型提出了神经元的形式化数学描述和网络结构方法,证明了单个神经元能执行逻辑功能,从而开创了人工神经网络研究的时代。 1949年,心理学家提出了突触联系强度可变的设想。60年代,人工神经网络的到了进一步发展,更完善的神经网络模型被提出。其中包括感知器和自适应线性元件等。M.Minsky等仔细分析了以感知器为代表的神经网络系统的功能及局限后,于1969年出版了《Perceptron》一书,指出感知器不能解决高阶谓词问题。他们的论点极大地影响了神经网络的研究。加之当时串行计算机和人工智能所取得的成就,掩盖了发展新型计算机和人工智能新途径的必要性和迫切性,使人工神经网络的研究处于低潮。 在此期间,一些人工神经网络的研究者仍然致力于这一研究,提出了适应谐ART,同时进行了神经网络数学理论的研究。以上研究为神经网络的研究和发展奠定了基础。1982年,美国加州工学院物理学家J.J.Hopfield提出了Hopfield神经网格模型,引入了“计算能量”概念,给出了网络稳定性判断。 1984Hopfield神经网络模型,为神经计算机的研究做了开拓性的工作,开创了神经网络用于联想记忆和优化计算的新途径,有力地推动了神经网络的研究。1985年,又有学者提出了波耳兹曼模型,在学习中采用统计热力学模拟退火技术,保证整个系统趋于全局稳定点。 1986年进行认知微观结构地研究,提出了并行分布处理的理论。人工神经网络的研究受到了各个发达国家的重视。美国国会通过决议将1990年1月5日开始的十年定为“脑的十年”,国际研究组织号召它的成员国将“脑的十年”变 RWC项目中,人工智能的研究成了一个重要的组成部分。 人工神经网络的模型很多,可以按照不同的方法进行分类。其中,常见的两

BP神经网络matlab源程序代码

BP神经网络matlab源程序代码) %******************************% 学习程序 %******************************% %======原始数据输入======== p=[2845 2833 4488;2833 4488 4554;4488 4554 2928;4554 2928 3497;2928 3497 2261;... 3497 2261 6921;2261 6921 1391;6921 1391 3580;1391 3580 4451;3580 4451 2636;... 4451 2636 3471;2636 3471 3854;3471 3854 3556;3854 3556 2659;3556 2659 4335;... 2659 4335 2882;4335 2882 4084;4335 2882 1999;2882 1999 2889;1999 2889 2175;... 2889 2175 2510;2175 2510 3409;2510 3409 3729;3409 3729 3489;3729 3489 3172;... 3489 3172 4568;3172 4568 4015;]'; %===========期望输出======= t=[4554 2928 3497 2261 6921 1391 3580 4451 2636 3471 3854 3556 2659 ... 4335 2882 4084 1999 2889 2175 2510 3409 3729 3489 3172 4568 4015 ... 3666]; ptest=[2845 2833 4488;2833 4488 4554;4488 4554 2928;4554 2928 3497;2928 3497 2261;... 3497 2261 6921;2261 6921 1391;6921 1391 3580;1391 3580 4451;3580 4451 2636;... 4451 2636 3471;2636 3471 3854;3471 3854 3556;3854 3556 2659;3556 2659 4335;... 2659 4335 2882;4335 2882 4084;4335 2882 1999;2882 1999 2889;1999 2889 2175;... 2889 2175 2510;2175 2510 3409;2510 3409 3729;3409 3729 3489;3729 3489 3172;... 3489 3172 4568;3172 4568 4015;4568 4015 3666]'; [pn,minp,maxp,tn,mint,maxt]=premnmx(p,t); %将数据归一化 NodeNum1 =20; % 隐层第一层节点数 NodeNum2=40; % 隐层第二层节点数 TypeNum = 1; % 输出维数 TF1 = 'tansig';

BP神经网络实例含源码

BP神经网络实例含源码 BP神经网络算法实现 一:关于BP网络 BP (Back Propagation)神经网络,即误差反传误差反向传播算法的学习过程,由信息的正向传播和误差的反向传播两个过程组成。输入层各神经元负责接收来自外界的输入信息,并传递给中间层各神经元;中间层是内部信息处理层,负责信息变换,根据信息变化能力的需求,中间层可以设计为单隐层或者多隐层结构;最后一个隐层传递到输出层各神经元的信息,经进一步处理后,完成一次学习的正向传播处理过程,由输出层向外界输出信息处理结果。 当实际输出与期望输出不符时,进入误差的反向传播阶段。误差通过输出层,按误差梯度下降的方式修正各层权值,向隐层、输入层逐层反传。周而复始的信息正向传播和误差反向传播过程,是各层权值不断调整的过程,也是神经网络学习训练的过程,此过程一直进行到网络输出的误差减少到可以接受的程度,或者预先设定的学习次数为止。 BP网络主要应用于以下方面:函数逼近、模式识别和分类、数据压缩。BP神经网络有较强的泛化性能,使网络平滑的逼近函数,能合理的响应被训练以外的输入。 同时,BP网络又有自己的限制与不足,主要表现在:需要较长的训练时间、网络训练的结果可能使得权值逼近局部最优、训练数据范围外的数据泛化能力较差。 为了避免训练陷入局部最优解,本程序采用改进的BP网络训练,既加入动量因子,使得网络在最优解附近有一定的震荡,跳出局部最优的范围。 BP网络训练中学习速率与动量因子的选择很重要,在后面的内容中将进行详细的讨论。

二:训练的函数 程序中训练的函数为一个三输入一输出的非线性函数,如下所示: x3xR,yxxe,,,,2sin(),,,12 网络结构为:3—5—1 三:程序及相关界面(VB) 1 主界面 1 代码: Private Sub Command1_Click() form2.Visible = False Form3.Visible = True End Sub Private Sub Command2_Click() form2.Visible = False Form1.Visible = True End Sub Private Sub Command3_Click() form2.Visible = False Form4.Visible = True End Sub Private Sub Command4_Click() form2.Visible = False

神经网络的类型

概述 本文主要介绍了当前常用的神经网络,这些神经网络主要有哪些用途,以及各种神经网络的优点和局限性。 1 BP神经网络 BP (Back Propagation)神经网络是一种神经网络学习算法。其由输入层、中间层、输出层组成的阶层型神经网络,中间层可扩展为多层。相邻层之间各神经元进行全连接,而每层各神经元之间无连接,网络按有教师示教的方式进行学习,当一对学习模式提供给网络后,各神经元获得网络的输入响应产生连接权值(Weight)。然后按减小希望输出与实际输出误差的方向,从输出层经各中间层逐层修正各连接权,回到输入层。此过程反复交替进行,直至网络的全局误差趋向给定的极小值,即完成学习的过程。 初始权值阈值的确定:所以权值及阈值的初始值应选为均匀分布的小数经验 值,约为(-2.4/F~2.4/F)之间,其中F 为所连单元的输入层节点数 1.1 主要功能 (1)函数逼近:用输入向量和相应的输出向量训练一个网络以逼近一个函数。 (2)模式识别:用一个待定的输出向量将它与输入向量联系起来。 (3)分类:把输入向量所定义的合适方式进行分类。 (4)数据压缩:减少输出向量维数以便传输或存储。 1.2 优点及其局限性 BP神经网络最主要的优点是具有极强的非线性映射能力。理论上,对于一个三层和三层以上的BP网络,只要隐层神经元数目足够多,该网络就能以任意精度逼近一个非线性函数。其次,BP神经网络具有对外界刺激和输入信息进行联想记忆的能力。这是因为它采用了分布并行的信息处理方式,对信息的提取必须采用联想的方式,才能将相关神经元全部调动起来。BP 神经网络通过预先存储信息和学习机制进行自适应训练,可以从不完整的信息和噪声干扰中恢复原始的完整信息。这种能力使其在图像复原、语言处理、模式识别等方面具有重要应用。再次,BP 神经网络对外界输入样本有很强的识别与分类能力。由于它具有强大的非线性处理能力,因此可以较好地进行非线性分类, 解决了神经网络发展史上的非线性分类难题。另外,BP 神经网络具有优化计算能力。BP神经网络本质上是一个非线性优化问题, 它可以在已知的约束条件下,寻找一组参数组合,使该组合确定的目标函数达到最小。不过,其优化计算存在局部极小问题,必须通过改进完善。 由于BP网络训练中稳定性要求学习效率很小,所以梯度下降法使得训练很慢。动量法因为学习率的提高通常比单纯的梯度下降法要快一些,但在实际应用中还是速度不够,这两种方法通常只应用于递增训练。 多层神经网络可以应用于线性系统和非线性系统中,对于任意函数模拟逼近。当然,感知器和线性神经网络能够解决这类网络问题。但是,虽然理论上是可行的,但实际上BP网络并

BP神经网络用于分类

clear,clc % 关闭图形窗口 close all %% 读入数据 % 打开文件 fid = fopen('german.data', 'r'); % 按格式读取每一行 % 每行包括21项,包括字符串和数字 C = textscan(fid, '%s %d %s %s %d %s %s %d %s %s %d %s %d %s %s %d %s %d %s %s %d\n'); % 关闭文件 fclose(fid); % 将字符串转换为整数 N = 20; % 存放整数编码后的数值矩阵 C1=zeros(N+1,1000); for i=1:N+1 % 类别属性 if iscell(C{i}) for j=1:1000 % eg: 'A12' -> 2 if i<10

d = textscan(C{i}{j}, '%c%c%d'); % eg: 'A103' -> 3 else d = textscan(C{i}{j}, '%c%c%c%d'); end C1(i,j) = d{end}; end % 数值属性 else C1(i,:) = C{i}; end end %% 划分训练样本与测试样本 % 输入向量 x = C1(1:N, :); % 目标输出 y = C1(N+1, :); % 正例 posx = x(:,y==1); % 负例 negx = x(:,y==2); % 训练样本

trainx = [ posx(:,1:350), negx(:,1:150)]; trainy = [ones(1,350), ones(1,150)*2]; % 测试样本 testx = [ posx(:,351:700), negx(:,151:300)]; testy = trainy; %% 样本归一化 % 训练样本归一化 [trainx, s1] = mapminmax(trainx); % 测试样本归一化 testx = mapminmax('apply', testx, s1); %% 创建网络,训练 % 创建BP网络 net = newff(trainx, trainy); % 设置最大训练次数 net.trainParam.epochs = 1500; % 目标误差 net.trainParam.goal = 1e-13; % 显示级别 net.trainParam.show = 1; % 训练 net = train(net,trainx, trainy); %% 测试

BP神经网络数据分类matlab程序代码

BP神经网络数据分类matlab程序代码BP神经网络数据分类 %把输出从1维变成4维 ——语音信号特征分类 for i=1:2000 switch output1(i) MatLab程序代码 case 1 output(i,:)=[1 0 0 0]; %% 清空环境变量 case 2 clc output(i,:)=[0 1 0 0]; clear case 3 output(i,:)=[0 0 1 0]; %% 训练数据预测数据提取及归一化 case 4 output(i,:)=[0 0 0 1]; %下载四类语音信号 end load data1 c1 end load data2 c2 load data3 c3 %随机提取1500个样本为训练样本,load data4 c4 500个样本为预测样本 input_train=input(n(1:1500),:)'; %四个特征信号矩阵合成一个矩阵 output_train=output(n(1:1500),:)'; data(1:500,:)=c1(1:500,:); input_test=input(n(1501:2000),:)'; data(501:1000,:)=c2(1:500,:); output_test=output(n(1501:2000),:)'; data(1001:1500,:)=c3(1:500,:); data(1501:2000,:)=c4(1:500,:); %输入数据归一化

[inputn,inputps]=mapminmax(input_trai%从1到2000间随机排序 n); k=rand(1,2000); [m,n]=sort(k); %% 网络结构初始化 innum=24; %输入输出数据 midnum=25; input=data(:,2:25); outnum=4; output1 =data(:,1); %权值初始化 %计算误差 w1=rands(midnum,innum); e=output_train(:,i)-yn; b1=rands(midnum,1); E(ii)=E(ii)+sum(abs(e)); w2=rands(midnum,outnum); b2=rands(outnum,1); %计算权值变化率 dw2=e*Iout; w2_1=w2;w2_2=w2_1; db2=e'; w1_1=w1;w1_2=w1_1; b1_1=b1;b1_2=b1_1; for j=1:1:midnum b2_1=b2;b2_2=b2_1; S=1/(1+exp(- I(j))); FI(j)=S*(1-S); %学习率 end xite=0.1 for k=1:1:innum alfa=0.01; for j=1:1:midnum dw1(k,j)=FI(j)*x(k)*(e(1)*w2(j,1)+e(2)%% 网络训练 *w2(j,2)+e(3)*w2(j,3)+e(4)*w2(j,4)); for ii=1:10 E(ii)=0; db1(j)=FI(j)*(e(1)*w2(j,1)+e(2)*w2(j,2) for i=1:1:1500 +e(3)*w2(j,3)+e(4)*w2(j,4)); %% 网络预测输出 end x=inputn(:,i); end % 隐含层输出