常用算法简介

机器视觉中常用图像处理算法

机器视觉就是用机器代替人眼来做测量和判断。机器视觉系统是指通过机器视觉产品(即图像摄取装置,分CMOS 和CCD 两种)将被摄取目标转换成图像信号,传送给专用的图像处理系统,得到被摄目标的形态信息,根据像素分布和亮度、颜色等信息,转变成数字化信号;图像系统对这些信号进行各种运算来抽取目标的特征,进而根据判别的结果来控制现场的设备动作。机器视觉是使用计算机(也许是可移动式的)来模拟人的视觉,因此模拟才是计算机视觉领域的最终目标,而真正意义上的图像处理侧重在“处理”图像:如增强,还原,去噪,分割,等等,如常见的Photoshop就是功能强大的图像处理软件。大部分的机器视觉,都包含了图像处理的过程,只有图像处理过后,才能找到图像中需要的特征,从而更进一步的执行其它的指令动作。在我们实际工程应用中研究的一些图像算法,实际上是属于机器视觉,而不是纯粹的图像处理。总的来说,图像处理技术包括图像压缩,增强和复原,匹配、描述和识别3个部分,在实际工程中,这几块不是独立的,往往是环环相扣、相互辅助来达到实际效果。接下来简单介绍一下机器视觉中常用的图像处理算法。

一、滤波

滤波一般在图像预处理阶段中使用,改善图像信息,便于后续处理,当然,这不是绝对的,在图像算法过程中如果有需要,随时可以进行滤波操作。比较常用的滤波方法有以下三种:

1、均值滤波

均值滤波也称为线性滤波,其采用的主要方法为邻域平均法。线性滤波的基本原理是用均值代替原图像中的各个像素值,即对待处理的当前像素点(,)

x y,选择一个模板,该模板由其近邻的若干像素组成,求模板中所有像素的均值,再把该均值赋予当前像素点(,)

g x y,即

x y,作为处理后图像在该点上的灰度值(,)

波方法可以平滑图像,速度快,算法简单。但是无法去掉噪声,只能减弱噪声。

2、中值滤波

中值滤波法是一种非线性平滑技术,它将每一像素点的灰度值设置为该点某邻域窗口内的所有像素点灰度值的中值。其实现过程为:

1)从图像中的某个采样窗口取出奇数个数据进行排序

2)用排序后的中值作为当前像素点的灰度值

在图像处理中,中值滤波常用来保护边缘信息,是经典的平滑噪声的方法,该方法对消除椒盐噪声非常有效,在光学测量条纹图像的相位分析处理方法中有特殊作用。

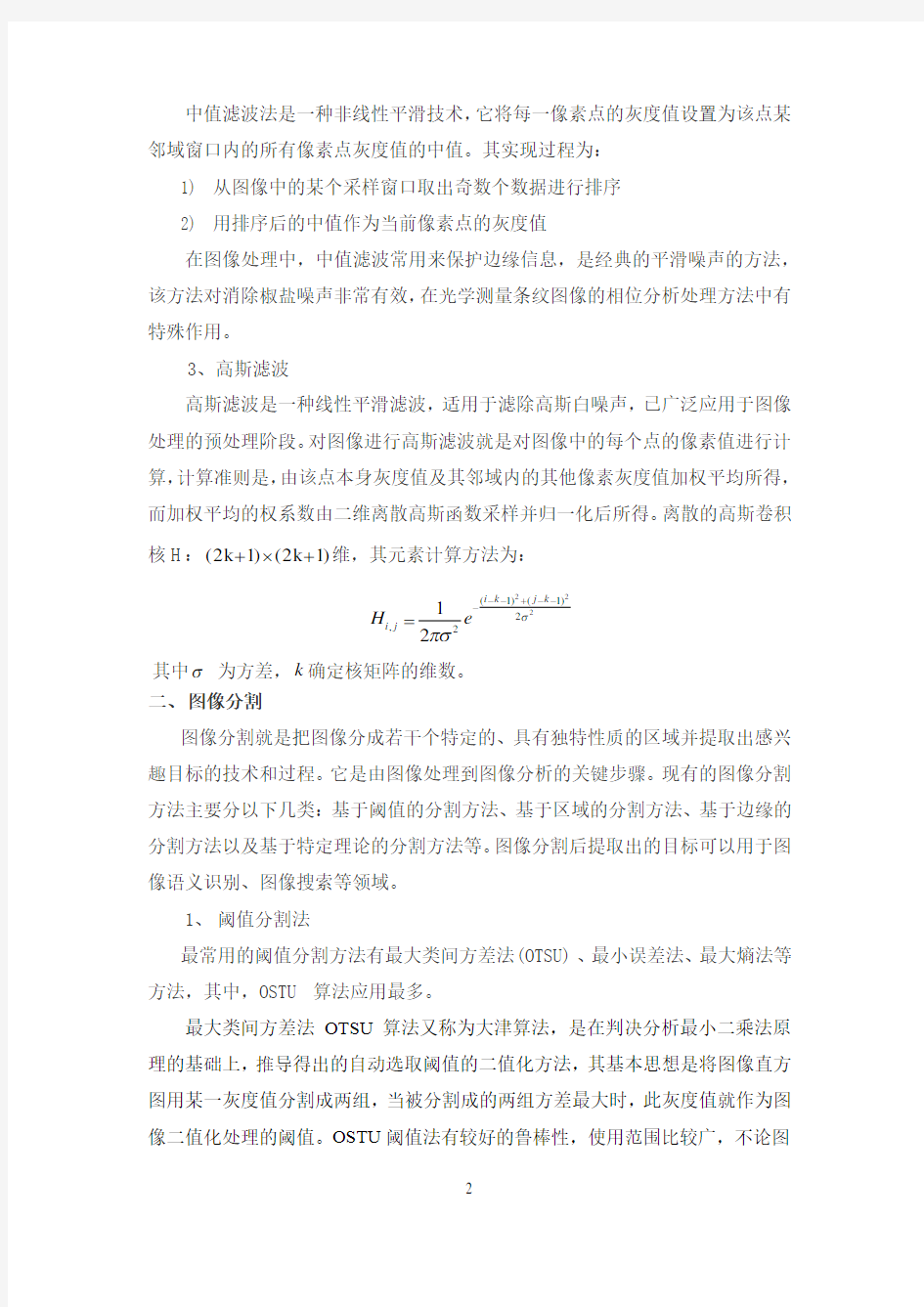

3、高斯滤波

二、图像分割

图像分割就是把图像分成若干个特定的、具有独特性质的区域并提取出感兴趣目标的技术和过程。它是由图像处理到图像分析的关键步骤。现有的图像分割方法主要分以下几类:基于阈值的分割方法、基于区域的分割方法、基于边缘的分割方法以及基于特定理论的分割方法等。图像分割后提取出的目标可以用于图像语义识别、图像搜索等领域。

1、阈值分割法

最常用的阈值分割方法有最大类间方差法(OTSU)、最小误差法、最大熵法等方法,其中,OSTU算法应用最多。

最大类间方差法OTSU算法又称为大津算法,是在判决分析最小二乘法原理的基础上,推导得出的自动选取阈值的二值化方法,其基本思想是将图像直方图用某一灰度值分割成两组,当被分割成的两组方差最大时,此灰度值就作为图像二值化处理的阈值。OSTU阈值法有较好的鲁棒性,使用范围比较广,不论图

像的直方图有无明显的双峰,都能得到比较满意的分割效果。

设灰度图像(,)f x y 的灰度级为0:L ,灰度级i 的像素数为i n ,则图像中总像素数为0L i i N n ==∑,灰度级i 出现的概率为i i p n N =,0i p ≥,01L

i i p ==∑,总的灰

度平均值为0L

i i ip μ==∑。

设阈值k 将灰度级分为两组0C 、1C ,分别代表背景和目标:00:C k =,11:C k L =+,则有:

0C 产生的概率:00

k

i k i p ωω===∑

1C 产生的概率:111L i k i k p ωω=+=

=-∑ 0C 的均值:000k i

k i k ip μμωω===∑,其中0k k i i ip μ==∑ 1C 的均值:1111L i

k i k k

ip μμμωω=+-=

=-∑ 则两组间的数学期望为:0011ωμωμμ+=

按照模式识别理论,可求出这两类的类间方差为:

以类间方差2()k σ作为衡量不同阈值导出的类别分离性能的测量准则,极大化2()k σ的过程就是自动确定阈值的过程,因此,最佳阈值h T 为:

20arg max ()h k L

T k σ≤≤= 因方差是灰度分布均匀性的一种度量,方差值越大,说明构成图像的两部分差别越大,当部分目标错分为背景或部分背景错分为目标都会导致两部分差别变小,因此类间方差最大的分割意味着错分概率最小。

2、基于区域的分割法

区域增长法是一种比较普遍的方法,在没有先验知识可以利用时,可以取得最佳的性能,可以用来分割比较复杂的图像,如自然景物。但是,区域增长方法是一种迭代的方法,空间和时间开销都比较大。

区域生长的基本思想是将具有相似性质的像素集合起来构成区域。具体先对每个需要分割的区域找一个种子像素作为生长起点,然后将种子像素和周围邻域中与种子像素有相同或相似性质的像素(区域内像素的相似性度量可以包括平均灰度值、纹理、颜色等信息)合并到种子像素所在的区域中。将这些新像素当作新的种子继续上面的过程,直到没有满足条件的像素可被包括进来。这样一个区域就生长成了。

除此之外还有区域分裂合并的方法,基本思想是先确定一个分裂合并的准则,即区域特征一致性的测度,当图像中某个区域的特征不一致时就将该区域分裂成

4 个相等的子区域,当相邻的子区域满足一致性特征时则将它们合成一个大区域,直至所有区域不再满足分裂合并的条件为止。当分裂到不能再分的情况时,分裂结束,然后它将查找相邻区域有没有相似的特征,如果有就将相似区域进行合并,最后达到分割的作用。在一定程度上区域生长和区域分裂合并算法有异曲同工之妙,互相促进相辅相成的,区域分裂到极致就是分割成单一像素点,然后按照一定的测量准则进行合并,在一定程度上可以认为是单一像素点的区域生长方法。区域生长比区域分裂合并的方法节省了分裂的过程,而区域分裂合并的方法可以在较大的一个相似区域基础上再进行相似合并,而区域生长只能从单一像素点出发进行生长(合并)。一致性准则的选择及阈值设定是影响区域分割算法的关键因素。

3、活动轮廓的分割法

最经典、使用最广的活动轮廓模型是Snake模型,它以构成一定形状的一些控制点为模板(轮廓线),通过模板自身的弹性形变,与图像局部特征相匹配达到调和,即某种能量函数极小化,完成对图像的分割。再通过对模板的进一步分析而实现图像的理解和识别。

Snake模型首先需要在感兴趣区域的附近给出一条初始曲线,接下来最小化能量泛函,让曲线在图像中发生变形并不断逼近目标轮廓。

其中第1项称为弹性能量是v的一阶导数的模,第2项称为弯曲能量,是v的二阶导数的模,第3项是外部能量(外部力),在基本Snakes模型中一般只取控制点或连线所在位置的图像局部特征例如梯度:

三、特征提取

1、HOG特征

方向梯度直方图(Histogram of Oriented Gradient ,HOG )特征是一种在计算机视觉和图像处理中用来进行物体检测的特征描述子。它通过计算和统计图像局部区域的梯度方向直方图来构成特征。HOG 特征结合SVM 分类器已经被广泛应用于图像识别中,尤其在行人检测中获得了极大的成功。HOG+SVM 进行行人检测的方法是法国研究人员Dalal 在2005的CVPR 上提出的,如今虽然有很多行人检测算法不断提出,但基本都是以HOG+SVM 的思路为主。HOG 特征的提取过程如下:

其中,(,)

x G x y 、(,)y G x y 和(,)I x y 分别表示输入图像中像素点(,)x y 处的水平方向梯度、垂直方向梯度和像素值。像素点(,)x y 处的梯度幅值和梯度方向分别为:

这一步的目的是为局部图像区域提供一个编码。将图像分成若干个“单元格cell”,例如每个cell为6*6个像素。假设采用9个bin的直方图来统计这6*6个像素的梯度信息。也就是将cell的梯度方向360度分成9个方向块,如图所示:

例如:如果这个像素的梯度方向是20-40度,直方图第2个bin的计数就加上这个像素的梯度幅值,这样,对cell内每个像素用梯度方向在直方图中进行加权投影(映射到固定的角度范围),就可以得到这个cell的梯度方向直方图了,就是该cell对应的9维特征向量(因为有9个bin)。

4)把细胞单元组合成大的块(block),块内归一化梯度直方图

由于局部光照的变化以及前景-背景对比度的变化,使得梯度强度的变化范围非常大。这就需要对梯度强度做归一化。归一化能够进一步地对光照、阴影和边缘进行压缩。方法是:把各个细胞单元组合成大的、空间上连通的区间(blocks)。这样,一个block内所有cell的特征向量串联起来便得到该block的HOG特征。这些区间是互有重叠的,这就意味着:每一个单元格的特征会以不同的结果多次出现在最后的特征向量中,归一化之后的块描述符(向量)就称之为HOG描述符。

5)收集HOG特征

最后一步就是将检测窗口中所有重叠的块进行HOG特征的收集,并将它们结合成最终的特征向量供分类器使用。

2、SIFT特征

SIFT特征是具有尺度不变性的局部特征检测算法。整个算法分为以下几个部分:

1)构建尺度空间

这是一个初始化操作,通过生成尺度空间来创建原始图像的多层表示以保证尺度不变性。高斯卷积核是实现尺度变换的唯一线性核,一幅二维图像的尺度空间定义为:

中间的检测点和它同尺度的8个相邻点和上下相邻尺度对应的9×2个点共26个点比较,以确保在尺度空间和二维图像空间都检测到极值点。一个点如果在DOG尺度空间本层以及上下两层的26个领域中是最大或最小值时,就认为该点是图像在该尺度下的一个特征点。

在极值比较的过程中,每一组图像的首末两层是无法进行极值比较的,为了满足尺度变化的连续性,在每一组图像的顶层继续用高斯模糊生成 3 幅图像,所以,高斯金字塔有每组S+3层图像,DOG金字塔每组有S+2层图像。

3)除去不好的特征点

这一步本质上要去掉DoG局部曲率非常不对称的像素。通过拟和三维二次函数精确确定关键点的位置和尺度(达到亚像素精度),同时去除低对比度的关键点和不稳定的边缘响应点(因为DoG算子会产生较强的边缘响应),以增强匹配稳定性、提高抗噪声能力,使用近似Harris角点检测器。

方图,生成具有独特性的向量,这个向量是该区域图像信息的一种抽象,具有唯一性。

⑤关键点描述子的生成

首先将坐标轴旋转为关键点的方向,以确保旋转不变性。以关键点为中心取8×8的窗口。

Figure.16*16的图中其中1/4特征点梯度方向及幅值,右图为其加权到8个主方向后的效果。

图左部分的中央为当前关键点的位置,每个小格代表关键点邻域所在尺度空间的一个像素,利用公式求得每个像素的梯度幅值与梯度方向,箭头方向代表该像素的梯度方向,箭头长度代表梯度模值,然后用高斯窗口对其进行加权运算。图中蓝色的圈代表高斯加权的范围(越靠近关键点的像素梯度方向信息贡献越大)。然后在每4×4的小块上计算8个方向的梯度方向直方图,绘制每个梯度方向的累加值,即可形成一个种子点,如图右部分示。此图中一个关键点由2×2共4个种子点组成,每个种子点有8个方向向量信息。这种邻域方向性信息联合的思想增强了算法抗噪声的能力,同时对于含有定位误差的特征匹配也提供了较好的容错性。

计算关键点周围的16*16的窗口中每一个像素的梯度,而且使用高斯下降函数降低远离中心的权重。

在每个4*4的1/16象限中,通过加权梯度值加到直方图8个方向区间中的一个,计算出一个梯度方向直方图。这样就可以对每个feature 形成一个4*4*8=128维的描述子,将这个向量归一化之后,就进一步去除了光照的影响。

3、 颜色特征

颜色特征是在图像检索中应用最为广泛的视觉特征,主要原因在于颜色往往和图像中所包含的物体或场景十分相关。此外,与其他的视觉特征相比,颜色特征对图像本身的尺寸、方向、视角的依赖性较小,从而具有较高的鲁棒性。颜色特征最常用的表示方法就是颜色直方图,表示为:1,2,...,{}u u m q q ==,1[()]n

u i

i q C b x u δ==-∑,δ是Kronecker 函数,()i b x 表示像素i x 所属的颜色区间。

计算颜色直方图需要将颜色空间划分成若干个小的颜色区间,每个小区间成为直方图的一个bin 。这个过程称为颜色量化(color quantization )。然后,通过计算颜色落在每个小区间内的像素数量可以得到颜色直方图。而且在不同的情况下可以选择不同的颜色空间计算直方图,提高颜色特征的鲁棒性。在实际工程中,由于采集到的数据通常是YCbCr 格式,而且亮度分量与颜色分量是分开的,所以,在后续的处理中应用YCbCr 模型比较多。

四、 目标识别

目标识别是指一个特殊目标(或一种类型的目标)从其它目标(或其它类型的目标)中被区分出来的过程。它既包括两个非常相似目标的识别,也包括一种类型的目标同其他类型目标的识别。在机器视觉中,目标识别的过程一般都是根

据提取出的目标特征,通过训练好的分类器来得到目标所属的类别,从而达到识别的目的。前面已经介绍了几种常用的特征提取方法,当然还有其他的很多特征,比如Haar 特征、Harris 角点特征、简单的形态学特征等等。在分类器方面,使用比较多的有SVM 、AdaBoost 、随机森林等。

1、 SVM 分类器

支持向量机(SVM )是一个由分类超平面定义的判别分类器。也就是说给定一组带标签的训练样本,算法将会输出一个最优超平面对新样本(测试样本)进行分类。一个线性判别函数是指由x 的各个分量的线性组合而成的函数,0()T g x x ωω=+,ω是超平面的法向量。对于两类问题的决策规则为:如果

()0g x >,则判定x 属于C1;如果()0g x <,则判定x 属于C2;如果()0g x =,则可以将x 任意分到某一类或者拒绝判定。设p x 是在判别面()0g x =外的一点,可知,该点到判别面的距离为:

所以,(x )r , r=d p g ω=±。判别函数()g x 正比于点x 到超平面的代数距离(带正

负号)。当点x 在超平面的正侧时,()0g x >;当点x 在超平面的负侧时,

()0g x <。

最小,而要求分类面对所有样本正确分类,就要求0y ()10T i i x ωω+-≥,

0,1,...,i n =。

一般来说,任意高次判别函数()g x ,都可以通过适当的变换,转化为线性判别函数处理,()x A y =,所以最优分类函数变为:

0(x)sgn((,))i i i i

f y K x x αω=+∑,

()K ?为核函数,上式就是支持向量机。

2、 AdaBoost 分类器

Adaboost 是一种迭代算法,其核心思想是针对同一个训练集训练不同的分类器(弱分类器),然后把这些弱分类器集合起来,构成一个更强的最终分类器(强分类器)。这里阐述下算法的具体过程:

1) 给定一个训练数据集1122{(,),(,),...,(,)}n n T x y x y x y =,i y 属于标记集合{1,1}-。初始化训练数据的权值分布。每一个训练样本最开始时都被赋予相同的权重:2) 进行多轮迭代,用1,2,...,m M =表示迭代次数。使用具有权值分布m ω的训练数据集学习,得到基本分类器()m G x 。

3) 计算()m G x 在训练数据集上的分类误差率。

1()(())N

m m m i i i e i I G x y ω==≠∑,

()m G x 在训练数据集上的误差率m e 就是被()m G x 误分类样本的权值之和。

4) 计算()m G x 的系数,m α表示()m G x 在最终分类器中的重要程度。

5) 更新训练数据集的权值分布,用于下一轮迭代。

m Z 是规范化因子。

6) 组合各个弱分类器。

1()()M m m m f x G x α==∑, 得到最终分类器,

1()sgn(())M

m m m G x G x α==∑。

3、 随机森林

随机森林指的是利用多棵树对样本进行训练并预测的一种分类器。简单来说,随机森林就是由多棵CART (Classification And Regression Tree )构成的。对于每棵树,它们使用的训练集是从总的训练集中有放回采样出来的,这意味着,总的训练集中的有些样本可能多次出现在一棵树的训练集中,也可能从未出现在一棵树的训练集中。在训练每棵树的节点时,使用的特征是从所有特征中按照一定比例随机地无放回的抽取的,根据Leo Breiman 的建议,假设总的特征数量为M ,

(1) 给定训练集S ,测试集T ,特征维数F 。确定参数:使用到的CART 的数量t ,每棵树的深度d ,每个节点使用到的特征数量f 。终止条件:节点上最少样本数s ,节点上最少的信息增益m 对于第1t -棵树,1i t =-。

(2) 从S 中有放回的抽取大小和S 一样的训练集()S i ,作为根节点的样本,从根节点开始训练。

(3) 如果当前节点上达到终止条件,则设置当前节点为叶子节点,如果是分类问题,该叶子节点的预测输出为当前节点样本集合中数量最多的那一类()c j ,概率p 为()c j 占当前样本集的比例;如果是回归问题,预测输出为当前节点样本集各个样本值的平均值。然后继续训练其他节点。如果当前节点没有达到终止条件,则从F 维特征中无放回的随机选取f 维特征。利用这f 维特征,寻找分类效果最好的一维特征k 及其阈值th ,当前节点上样本第k 维特征小于th 的样本被划分到左节点,其余的被划分到右节点。继续训练其他节点。

(4) 重复(2)(3)直到所有节点都训练过了或者被标记为叶子节点。

(5) 重复(2),(3),(4)直到所有CART 都被训练过。

利用随机森林的预测过程如下:

对于第1t -棵树,1i t =-: (1)从当前树的根节点开始,根据当前节点的阈值th ,判断是进入左节点(th <)还是进入右节点(th ≥),直到到达,某个叶子节点,并输出预测值。

(2)重复执行(1)直到所有t 棵树都输出了预测值。如果是分类问题,则输出为所有

树中预测概率总和最大的那一个类,即对每个()

c j的p进行累计;如果是回归问题,则输出为所有树的输出的平均值。

五、图像匹配

图像匹配是指通过一定的匹配算法在两幅或多幅图像之间查找同一目标或区域,主要可分为以图像像素值为基础的模板匹配和以特征为基础的匹配。

模板匹配是一种用于在源图像S中寻找定位给定目标图像T(即模板图像)的技术。其原理很简单,就是通过一些相似度准则来衡量两个图像块之间的相似度Similarity(S,T),源图像和模板图像可以是二值图像、灰度图像、彩色图像。一般而言,模板匹配有两种使用场景:

1)如果源图像S与模板图像T大小(高和宽)一致,则直接使用相似度计算公式对这两个图像进行相似度计算。

2)如果源图像S的size大于模板图像T,则在S中匹配T时,需要滑动匹配窗口(即模板图像的大小),计算模板图像与该窗口对应的图像区域之间的相似度。对整张S图像滑动完后,得到多个匹配结果。这里,有两种方式获取匹配结果。一种是返回所有匹配结果中的最佳匹配结果(最小值或最大值,依相似度计算方式而定)。另一种,是设定一个阈值,大于或小于该阈值的匹配结果都认为是有效的匹配。

模板匹配中常用的相似度计算方法有:

以特征为基础的匹配就是根据从图像中提取出的有效特征向量来进行匹配,

一些常用的特征提取及描述方法已经在前面做了简单介绍,这里不再赘述。

六、 视觉跟踪 目标跟踪是绝大多数视觉系统中不可或缺的环节。在二维视频跟踪算法中,基于目标颜色信息或基于目标运动信息等方法是常用的跟踪方法,在特定的场景应用中(如视频监控等领域)主要有三种经典的跟踪算法:CamShift 算法、光流跟踪以及粒子滤波算法。

1、 CamShift (Continuously Adaptive Mean Shift )跟踪算法

CamShift 算法是一种基于均值漂移的算法。均值移动的理论基础是概率密度估计。均值移动的过程实际上就是在概率密度空间中寻找局部极大点。从其全称可知CamShift 的算法基础实际上是MeanShift 算法,均值移动的操作过程可用如下几步来表示:

(a) 计算以初始点0x 为中心的某一核窗所对应的均值移动向量0()G m x 。 (b) 根据0()G m x 来移动核窗的中心位置,也即把0()G m x 中的加权平均值部

分赋予0x ,把0x 作为新的初始点,并转回步骤(a);

(c) 重复(a)、(b)过程,直到满足某一预定的条件。

因此,均值移动过程就是寻找数据分布最密集处的过程。均值移动的实现过程可图示为:

(1) 计算目标区域的均值、移动目标区域

(2) 重新计算目标区域均值,还存在移动向量,继续移动目标区域

(3)移动向量越来越小

(4)找到局部极大点,停止移动

以上过程只是一次MeanShift算法过程,在连续帧上使用MeanShift算法就是CamShift跟踪算法。CamShift同经典的均值移动跟踪算法的基本思想是相同的,所不同的它是建立在颜色概率分布图和矩的基础之上。CamShift对室内环境

下的目标跟踪具有较高的鲁棒性。

2、 光流跟踪算法

将三维空间中的目标和场景对应于二维图像平面运动时,他们在二维图像平面的投影就形成了运动,这种运动以图像平面亮度模式表现出来的流动就称为光流。光流法是对运动序列图像进行分析的一个重要方法,光流不仅包含图像中目标的运动信息,而且包含了三维物理结构的丰富信息,因此可用来确定目标的运动情况以及反映图像其它等信息。

光流是空间运动物体在观测成像面上的像素运动的瞬时速度。光流的研究是利用图像序列中的像素强度的时域变化和相关性来确定各自像素位置的“运动”,即研究图像灰度在时间上的变化与景象中物体结构及其运动的关系。一般情况下,光流由相机运动、场景中目标运动或两者的共同运动产生。

Lucas –Kanade 光流算法是最常见,最流行的。它计算两帧在时间t 到t t δ+之间每个像素点位置的移动。由于它是基于图像信号的泰勒级数,这种方法称为差分,这就是对于空间和时间坐标使用偏导数。

图像约束方程可以写为(,,,)(,,,)I x y z t I x x y y z z t t δδδδ=++++,假设移动足够的小,那么对图像约束方程使用泰勒公式,我们可以得到:

...H O T 指更高阶,在移动足够小的情况下可以忽略。从这个方程中我们可以得到:

或者

可以得到:

写做:

T

t I V I ??=- 这个方程有三个未知量,尚不能被解决,这也就是所谓光流算法的光圈问题。那么要找到光流向量则需要另一套解决的方案。而Lucas-Kanade 算法是一个非迭代的算法:

假设流(,,)x y z V V V 在一个大小为(m 1)m m m **>的小窗口中是一个常数,那么从像素1,2,...,n ,3n m =中可以得到下列一组方程:

1111

2222

x x y y z z t x x y y z z t xn x yn y zn z tn I V I V I V I I V I V I V I I V I V I V I ++=-++=-++=-

三个未知数但是有多于三个的方程,这个方程组自然是个超定方程,也就是说方程组内有冗余,方程组可以表示为:

11112222 x y z t x x y z t y z tn xn yn zn I I I I V I I I I V V I I I I ??-????????-??????=??????????????-??????

记作:Av b =- 。为了解决这个超定问题,采用最小二乘法:

1()()()

T T T T A Av A b v A A A b -=-=- 得到:

1222 xi xi yi xi zi xi ti x y xi yi yi

yi zi yi ti z zi ti xi zi yi zi zi I I I I I I I V V I I I I I I I V I I I I I I I -????-????????=-????????????-????????

??∑∑∑∑∑∑∑∑∑∑∑∑ 其中的求和是从1到n 。也就是说寻找光流可以通过在四维上图像导数的分别累加得出。这个算法的不足在于它不能产生一个密度很高的流向量,优点在于对噪

常用分析方法

绍的主要方法有六种,分别为:1、对比分析法:将A公司和B公司进行对比、2、外部因素评价模型(EFE)分析、3、内部因素评价模型(IFE)分析、4、swot 分析方法、5、三种竞争力分析方法、6、五种力量模型分析。对比分析法是最常用,简单的方法,将一个管理混乱、运营机制有问题的公司和一个管理有序、运营良好的公司进行对比,观察他们在组织结构上、资源配臵上有什么不同,就可以看出明显的差别。在将这些差别和既定的管理理论相对照,便能发掘出这些差异背后所蕴含的管理学实质。企业管理中经常进行案例分析,将A和B公司进行对比,发现一些不同。各种现象的对比是千差万别的,最重要的是透过现象分析背后的管理学实质。所以说,只有表面现象的对比是远远不够的,更需要有理论分析。外部因素评价模型(EFE)和内部因素评价模型(IFE)分析来源于战略管理中的环境分析。因为任何事物的发展都要受到周边环境的影响,这里的环境是广义的环境,不仅指外部环境,还指企业内部的环境。通常我们将企业的内部环境称作企业的禀赋,可以看作是企业资源的初始值。公司战略管理的基本控制模式由两大因素决定:外部不可控因素和内部可控因素。其中公司的外部不可控因素主要包括:政府、合作伙伴(如银行、投资商、供应商)、顾客(客户)、公众压力集团(如新闻媒体、消费者协会、宗教团体)、竞争者,除此之外,社会文化、政治、法律、经济、技术和自然等因素都将制约着公司的生存和发展。由此分析,外部不可控因素对公司来说是机会与威胁并存。公司如何趋利避险,在外部因素中发现机会、把握机会、利用机会,洞悉威胁、规避风险,对于公司来说是生死攸关的大事。在瞬息万变的动态市场中,公司是否有快速反应(应变)的能力,是否有迅速适应市场变化的能力,是否有创新变革的能力,决定着公司是否有可持续发展的潜力。公司的内部可控因素主要包括:技术、资金、人力资源和拥有的信息,除此之外,公司文化和公司精神又是公司战略制定和战略发展中不可或缺的重要部分。一个公司制定公司战略必须与公司文化背景相联。内部

构建哈夫曼树及输出哈夫曼代码及算法思想

哈夫曼树描述文档 一、思路 通过一个argv[]数组存储从test文件中读取字母,然后利用ascal 码循环计算每个字母的权值,利用weight[]是否为零,确定叶子节点,节点个数为count,传入到构建哈夫曼树的子程序中,然后利用cd[]数组存储每一个叶子节点的哈夫曼代码.输出代码时,通过与argv[]数组的比对,扫描ht数组,进而读出所有的数据。 二、截图 三、代码 #include

intrchild; }HTNode; typedefstruct { char cd[50]; int start; }HCode; using namespace std; int enter(char argv[])//进行读入操作 { fstream in; ofstream out; char c; int number=0;//字母个数置为0 in.open("test.txt",ios::in); //打开文件test.txt out.open ("code.txt",ios::trunc); //打开文件code.txt,如果不存在就新建一个,如果存在就清空 if(!in.eof()) in>>c; //从test.txt中读取一个字符存入c printf("原文本是:\n"); while(! in.eof()){ //文件不为空,循环读取一个字符 cout<

基于协同过滤的推荐算法及代码实现

基于协同过滤的推荐算法与代码实现 什么是协同过滤? 协同过滤是利用集体智慧的一个典型方法。要理解什么是协同过滤(Collaborative Filtering, 简称CF),首先想一个简单的问题,如果你现在想看个电影,但你不知道具体看哪部,你会怎么做?大部分的人会问问周围的朋友,看看最近有什么好看的电影推荐,而我们一般更倾向于从口味比较类似的朋友那里得到推荐。这就是协同过滤的核心思想。 协同过滤一般是在海量的用户中发掘出一小部分和你品位比较类似的,在协同过滤中,这些用户成为邻居,然后根据他们喜欢的其他东西组织成一个排序的目录作为推荐给你。当然其中有一个核心的问题: 如何确定一个用户是不是和你有相似的品位? 如何将邻居们的喜好组织成一个排序的目录? 简单来说: 1. 和你兴趣合得来的朋友喜欢的,你也很有可能喜欢; 2. 喜欢一件东西A,而另一件东西B 与这件十分相似,就很有可能喜欢B; 3. 大家都比较满意的,人人都追着抢的,我也就很有可能喜欢。 三者均反映在协同过滤的评级(rating)或者群体过滤(social filtering)这种行为特性上。 深入协同过滤的核心 首先,要实现协同过滤,需要一下几个步骤: 1. 收集用户偏好 2. 找到相似的用户或物品 3. 计算推荐 (1)收集用户偏好 要从用户的行为和偏好中发现规律,并基于此给予推荐,如何收集用户的偏好信息成为系统推荐效果最基础的决定因素。用户有很多方式向系统提供自己的偏好信息,而且不同的应用也可能大不相同,下面举例进行介绍:

以上列举的用户行为都是比较通用的,推荐引擎设计人员可以根据自己应用的特点添加特殊的用户行为,并用他们表示用户对物品的喜好。 在一般应用中,我们提取的用户行为一般都多于一种,关于如何组合这些不同的用户行为,基本上有以下两种方式: 将不同的行为分组:一般可以分为“查看”和“购买”等等,然后基于不同的行为,计算不同的用户/物品相似度。类似于当当网或者Amazon 给出的“购买了该图书的人还购买了...”,“查看了图书的人还查看了...”

国密算法(国家商用密码算法简介)

国家商用密码算法简介 密码学是研究编制密码和破译密码的技术科学,起源于隐秘消息传输,在编码和破译中逐渐发展起来。密码学是一个综合性的技术科学,与语言学、数学、电子学、声学、信息论、计算机科学等有着广泛而密切的联系。密码学的基本思想是对敏感消息的保护,主要包括机密性,鉴别,消息完整性和不可否认性,从而涉及加密,杂凑函数,数字签名,消息认证码等。 一.密码学简介 密码学中应用最为广泛的的三类算法包括对称算法、非对称算法、杂凑算法。 1.1 对称密码 对称密码学主要是分组密码和流密码及其应用。分组密码中将明文消息进行分块加密输出密文区块,而流密码中使用密钥生成密钥流对明文消息进行加密。世界上应用较为广泛的包括DES、3DES、AES,此外还有Serpent,Twofish,MARS和RC6等算法。对称加密的工作模式包括电码本模式(ECB 模式),密码反馈模式(CFB 模式),密码分组链接模式(CBC 模式),输入反馈模式(OFB 模式)等。1.2 非对称密码 公钥密码体制由Diffie和Hellman所提出。1978年Rivest,Shamir和Adleman提出RAS密码体制,基于大素数分解问题。基于有限域上的离散对数问题产生了ElGamal密码体制,而基于椭圆曲线上的离散对数问题产生了椭圆曲线密码密码体制。此外出现了其他公钥密码体制,这些密码体制同样基于困难问题。目前应用较多的包括RSA、DSA、DH、ECC等。 1.3杂凑算法 杂凑算法又称hash函数,就是把任意长的输入消息串变化成固定长的输出串的一种函数。这个输出串称为该消息的杂凑值。一个安全的杂凑函数应该至少满足以下几个条件。 1)输入长度是任意的; 2)输出长度是固定的,根据目前的计算技术应至少取128bits长,以便抵抗生日攻击; 3)对每一个给定的输入,计算输出即杂凑值是很容易的; 4)给定杂凑函数的描述,找到两个不同的输入消息杂凑到同一个值是计算上不可行的,或给定 杂凑函数的描述和一个随机选择的消息,找到另一个与该消息不同的消息使得它们杂凑到同一个值是计算上不可行的。 杂凑函数主要用于完整性校验和提高数字签名的有效性,目前已有很多方案。这些算法都是伪随机函数,任何杂凑值都是等可能的。输出并不以可辨别的方式依赖于输入;在任何输入串中单个比特

16种常用数据分析方法

一、描述统计 描述性统计是指运用制表和分类,图形以及计筠概括性数据来描述数据的集中趋势、离散趋势、偏度、峰度。 1、缺失值填充:常用方法:剔除法、均值法、最小邻居法、比率回归法、决策树法。 2、正态性检验:很多统计方法都要求数值服从或近似服从正态分布,所以之前需要进行正态性检验。常用方法:非参数检验的K-量检验、P-P图、Q-Q图、W检验、动差法。 二、假设检验 1、参数检验 参数检验是在已知总体分布的条件下(一股要求总体服从正态分布)对一些主要的参数(如均值、百分数、方差、相关系数等)进行的检验。 1)U验使用条件:当样本含量n较大时,样本值符合正态分布 2)T检验使用条件:当样本含量n较小时,样本值符合正态分布 A 单样本t检验:推断该样本来自的总体均数μ与已知的某一总体均数μ0 (常为理论值或标准值)有无差别; B 配对样本t检验:当总体均数未知时,且两个样本可以配对,同对中的两者在可能会影响处理效果的各种条件方面扱为相似; C 两独立样本t检验:无法找到在各方面极为相似的两样本作配对比较时使用。 2、非参数检验 非参数检验则不考虑总体分布是否已知,常常也不是针对总体参数,而是针对总体的某些一股性假设(如总体分布的位罝是否相同,总体分布是否正态)进行检验。 适用情况:顺序类型的数据资料,这类数据的分布形态一般是未知的。 A 虽然是连续数据,但总体分布形态未知或者非正态; B 体分布虽然正态,数据也是连续类型,但样本容量极小,如10以下; 主要方法包括:卡方检验、秩和检验、二项检验、游程检验、K-量检验等。 三、信度分析 检査测量的可信度,例如调查问卷的真实性。 分类: 、外在信度:不同时间测量时量表的一致性程度,常用方法重测信度1. 2、内在信度;每个量表是否测量到单一的概念,同时组成两表的内在体项一致性如何,常用方法分半信度。 四、列联表分析 用于分析离散变量或定型变量之间是否存在相关。 对于二维表,可进行卡方检验,对于三维表,可作Mentel-Hanszel分层分析。 列联表分析还包括配对计数资料的卡方检验、行列均为顺序变量的相关检验。 五、相关分析 研究现象之间是否存在某种依存关系,对具体有依存关系的现象探讨相关方向及相关程度。 1、单相关:两个因素之间的相关关系叫单相关,即研究时只涉及一个自变量和一个因变量; 2、复相关:三个或三个以上因素的相关关系叫复相关,即研究时涉及两个或两个以上的自变量和因变量相关; 3、偏相关:在某一现象与多种现象相关的场合,当假定其他变量不变时,其中两个变量之间的相关关系称为偏相关。

哈夫曼编码算法实现完整版

实验三树的应用 一.实验题目: 树的应用——哈夫曼编码 二.实验内容: 利用哈夫曼编码进行通信可以大大提高信道的利用率,缩短信息传输的时间,降低传输成本。根据哈夫曼编码的原理,编写一个程序,在用户输入结点权值的基础上求哈夫曼编码。 要求:从键盘输入若干字符及每个字符出现的频率,将字符出现的频率作为结点的权值,建立哈夫曼树,然后对各个字符进行哈夫曼编码,最后打印输出字符及对应的哈夫曼编码。 三、程序源代码: #include

个性化推荐算法概述与展望

Hans Journal of Data Mining 数据挖掘, 2019, 9(3), 81-87 Published Online July 2019 in Hans. https://www.360docs.net/doc/2c15171389.html,/journal/hjdm https://https://www.360docs.net/doc/2c15171389.html,/10.12677/hjdm.2019.93010 Overview and Prospect of Personalized Recommendation Algorithm Xinxin Li Dalian University of Foreign Languages, Dalian Liaoning Received: Jun. 19th, 2019; accepted: Jul. 2nd, 2019; published: Jul. 9th, 2019 Abstract In recent years, the word “information overload” frequently appears in people’s vision, it has be-come a hot word in the field of computer, and it is also an important problem that researchers ur-gently need to solve. In order to solve the problem of information overload, researchers in the field of computer constantly optimize the personalized recommendation algorithm, strive to re-duce the difficulty of information retrieval for users, to provide users with the best personalized recommendation results. This paper gives a brief overview of the personalized recommendation methods which are widely used and common. Combined with the experience of using personalized recommendation algorithm to generate results in daily life, the author puts forward expectations for the development of personalized recommendation algorithm in the future. Keywords Personalized Recommendation, Collaborative Filtering, Hybrid Recommendation 个性化推荐算法概述与展望 李鑫欣 大连外国语大学,辽宁大连 收稿日期:2019年6月19日;录用日期:2019年7月2日;发布日期:2019年7月9日 摘要 近年来,“信息过载”一词频繁出现在人们的视野中,它成为了计算机相关领域中的热门词汇,同时它也是研究人员急待解决的重要问题。为解决信息超载的问题,计算机领域研究人员不断优化个性化推荐

哈夫曼算法及其改进

霍夫曼编码及其改进 在通信中,为了提高信息传输效率,得到或接近信息熵的最小信息率,我们需要解决信源编码的问题。在信源编码中,我们试图让信源编码的平均码长尽可能缩短,减少冗余度,从而提高编码效率。信源编码又分为无失真信源编码和限失真信源编码。 哈夫曼编码(Huffman Coding)是一种无失真编码方式,是可变字长编码(VLC)的一种,由Huffman于1952年提出,该方法完全依据字符出现概率来构造异字头的平均长度最短的码字,有时称之为最佳编码,一般就叫作Huffman编码。哈夫曼编码是一种最优的前缀编码技术。 对于多元独立信源,哈夫曼编码为最佳编码,之所以称之为最佳编码,因为其拥有以下特性:(1) 保证概率大的对应短码,概率小的对应长码,即短码得到充分利用;(2) 每次缩减信源的最后两个码字,总是最后面的一个码元不同,而前面的各个码元相同;(3) 每次缩减信源的最长两个码字有相同的码长。 平均码长n=2×10+8 38+3×7+6+3 38 +4×2 38 +5×1+1 38 =2.68 冗余度 哈夫曼编码是一种非唯一性编码,其编码方式并不唯一。首先,因为对缩减信源最后两个概率小的符号用0和1码的赋予可以是任意的,故可以得到不同的码,但是它们只是码的具体形式不同。其码长n不变,平均码长?也不变,所以没有本质区别。其次,若当缩减信源中合并后的符号概率与其他信源符号概率相同时,从编码方法上说哪个在上面哪个在下面是没有本质区别的,但是得到的码是不相同的对这两种不同的码,它们的码长n不同,但是平均码长?是相同的。 为了克服哈夫曼编码方式存在的问题,提高哈夫曼编码的可用性,我们需要设法降低哈夫曼编码树的存储空间。在数据特定的情况下,我们可以让编码器和解码器使用事先约定的编码树,如此可以消除哈夫曼树生成和传输储存的时间,但是当信源变化,此种方法就不再适用,不具备通用性。

数据挖掘分类算法比较

数据挖掘分类算法比较 分类是数据挖掘、机器学习和模式识别中一个重要的研究领域。通过对当前数据挖掘中具有代表性的优秀分类算法进行分析和比较,总结出了各种算法的特性,为使用者选择算法或研究者改进算法提供了依据。 一、决策树(Decision Trees) 决策树的优点: 1、决策树易于理解和解释.人们在通过解释后都有能力去理解决策树所表达的意义。 2、对于决策树,数据的准备往往是简单或者是不必要的.其他的技术往往要求先把数据一般化,比如去掉多余的或者空白的属性。 3、能够同时处理数据型和常规型属性。其他的技术往往要求数据属性的单一。 4、决策树是一个白盒模型。如果给定一个观察的模型,那么根据所产生的决策树很容易推出相应的逻辑表达式。 5、易于通过静态测试来对模型进行评测。表示有可能测量该模型的可信度。 6、在相对短的时间内能够对大型数据源做出可行且效果良好的结果。 7、可以对有许多属性的数据集构造决策树。 8、决策树可很好地扩展到大型数据库中,同时它的大小独立于数据库的大小。 决策树的缺点: 1、对于那些各类别样本数量不一致的数据,在决策树当中,信息增益的结果偏向于那些具有更多数值的特征。 2、决策树处理缺失数据时的困难。 3、过度拟合问题的出现。 4、忽略数据集中属性之间的相关性。 二、人工神经网络 人工神经网络的优点:分类的准确度高,并行分布处理能力强,分布存储及学习能力强,对噪声神经有较强的鲁棒性和容错能力,能充分逼近复杂的非线性关系,具备联想记忆的功能等。 人工神经网络的缺点:神经网络需要大量的参数,如网络拓扑结构、权值和阈值的初始值;不能观察之间的学习过程,输出结果难以解释,会影响到结果的可信度和可接受程度;学习时间过长,甚至可能达不到学习的目的。

基于内容的推荐算法

基于内容的推荐算法(Content-Based Recommendation)1.基本思想 基本思想就是给用户推荐与他们曾经喜欢的项目内容相匹配的新项目。 基于内容的推荐的基本思想是:对每个项目的内容进行特征提取(FeatureExtraction),形成特征向量(Feature Vector);对每个用户都用一个称作用户的兴趣模型(User Profile)的文件构成数据结构来描述其喜好;当需要对某个用户进行推荐时,把该用户的用户兴趣模型同所有项目的特征矩阵进行比较得到二者的相似度,系统通过相似度推荐文档。 (基于内容的推荐算法不用用户对项目的评分,它通过特定的特征提取方法得到项目特征用来表示项目,根据用户所偏好的项目的特征来训练学习用户的兴趣模型,然后计算一个新项目的内容特征和用户兴趣模型的匹配程度,进而把匹配程度高的项目推荐给用户。) 2.基于内容的推荐层次结构图:

CB的过程一般包括以下三步: (1)Item Representation:为每个item抽取出一些特征(也就是item的content 了)来表示此item;对应着上图中的Content Analyzer。 (2)Profile Learning:利用一个用户过去喜欢(及不喜欢)的item的特征数据,来学习出此用户的喜好特征(profile);对应着上图中的Profile Learner。 (3)Recommendation Generation:通过比较上一步得到的用户profile与候选item 的特征,为此用户推荐一组相关性最大的item。对应着上图中的Filtering Component。 3.详细介绍上面的三个步骤: 3.1 Item Representation 项目表示:对项目进行特征提取,比如最著名的特征向量空间模型,它首先将一份文本(项目)以词袋形式来表示,然后对每一个词用词频-逆向文档频率(TF-IDF)来计算权重,找出若干权重较大的词作为关键词(特征)。每个文本(项目)都可以表示成相同维度的一个向量 TF-IDF词频-逆文档频率计算: TF 词项t在文档d中出现的次数,df 表示词项t在所有文档出现的次数,idf 为反向文档频率,N为文档集中所有文档的数目。 TF-IDF公式同时引入词频和反向文档频率,词频TF表示词项在单个文档中的局部权重,某一词项在文档中出现的频率越高,说明它区分文档内容的属性越强,权重越大。IDF表示词项在整个文档集中的全局权重,某一词项在各大文档都有出现,说明它区分文档类别属性的能力越低,权值越小。

转 常用加密算法介绍

转常用加密算法介绍 5.3.1古典密码算法 古典密码大都比较简单,这些加密方法是根据字母的统计特性和语言学知识加密的,在可用计算机进行密码分析的今天,很容易被破译。虽然现在很少采用,但研究这些密码算法的原理,对于理解、构造和分析现代密码是十分有益的。表5-1给出了英文字母在书报中出现的频率统计。 表5-1英文字母在书报中出现的频率 字母 A B C D E F G H I J K L M 频率 13.05 9.02 8.21 7.81 7.28 6.77 6.64 6.64 5.58 4.11 3.60 2.93 2.88 字母 N O P Q

R S T U V W X Y Z 频率 2.77 2.62 2.15 1.51 1.49 1.39 1.28 1.00 0.42 0.30 0.23 0.14 0.09 古典密码算法主要有代码加密、替换加密、变位加密、一次性密码簿加密 等几种算法。 1.代码加密 代码加密是一种比较简单的加密方法,它使用通信双方预先设定的一组有 确切含义的如日常词汇、专有名词、特殊用语等的代码来发送消息,一般只能 用于传送一组预先约定的消息。 密文:飞机已烧熟。 明文:房子已经过安全检查。 代码加密的优点是简单好用,但多次使用后容易丧失安全性。 2.替换加密 将明文字母表M中的每个字母替换成密文字母表C中的字母。这一类密码 包括移位密码、替换密码、仿射密码、乘数密码、多项式代替密码、密钥短语 密码等。这种方法可以用来传送任何信息,但安全性不及代码加密。因为每一 种语言都有其特定的统计规律,如英文字母中各字母出现的频度相对基本固定,根据这些规律可以很容易地对替换加密进行破解。以下是几种常用的替换加密 算法。

哈夫曼算法的实现及应用

摘要:哈夫曼树是带权路径长度(WPL)最小的二叉树,通过对哈夫曼算法的研究,提出一种求取哈夫曼树带权路径长度的计算方法和应用。 关键词:哈夫曼算法、二叉树、WPL、编码 1 引言: 哈夫曼树是一种特殊的二叉树,又称最优二叉树:假设有一组(无序)实数{w1,w2,w3,w4,…,wm},现要构造一棵以wi(i=1,2,3,4…,m)为权的m个外部结点的扩充二叉树,使得带权的外部路径长度WPL最小。满足这一要求的扩充二叉树就称为哈夫曼树或最优二叉树。若l表示从根到第i个外部结点的路径长度,m为外部结点的个数,wi 为第i个外部结点的权值,则有WPL=∑wili(0 推荐系统的出现 推荐系统的任务就是解决,当用户无法准确描述自己的需求时,搜索引擎的筛选效果不佳的问题。联系用户和信息,一方面帮助用户发现对自己有价值的信息,另一方面让信息能够展现在对他感兴趣的人群中,从而实现信息提供商与用户的双赢。 推荐算法介绍 基于人口统计学的推荐 这是最为简单的一种推荐算法,它只是简单的根据系统用户的基本信息发现用户的相关程度,然后将相似用户喜爱的其他物品推荐给当前用户。 系统首先会根据用户的属性建模,比如用户的年龄,性别,兴趣等信息。根据这些特征计算用户间的相似度。比如系统通过计算发现用户A和C比较相似。就会把A喜欢的物品推荐给C。 优缺点: ?不需要历史数据,没有冷启动问题 ?不依赖于物品的属性,因此其他领域的问题都可无缝接入。 ?算法比较粗糙,效果很难令人满意,只适合简单的推荐 基于内容的推荐 与上面的方法相类似,只不过这次的中心转到了物品本身。使用物品本身的相似度而不是用户的相似度。 系统首先对物品(图中举电影的例子)的属性进行建模,图中用类型作为属性。 在实际应用中,只根据类型显然过于粗糙,还需要考虑演员,导演等更多信息。 通过相似度计算,发现电影A和C相似度较高,因为他们都属于爱情类。系统还会发现用户A喜欢电影A,由此得出结论,用户A很可能对电影C也感兴趣。 于是将电影C推荐给A。 优缺点: ?对用户兴趣可以很好的建模,并通过对物品属性维度的增加,获得更好的推荐精度 ?物品的属性有限,很难有效的得到更多数据 ?物品相似度的衡量标准只考虑到了物品本身,有一定的片面性 ?需要用户的物品的历史数据,有冷启动的问题 协同过滤 协同过滤是推荐算法中最经典最常用的,分为基于用户的协同过滤和基于物品的协同过滤。那么他们和基于人口学统计的推荐和基于内容的推荐有什么区别和联系呢? 基于用户的协同过滤——基于人口统计学的推荐 基于用户的协同过滤推荐机制和基于人口统计学的推荐机制都是计算用户的相似度,并基于“邻居”用户群计算推荐,但它们所不同的是如何计算用户的相似度,基于人口统计学的机制只考虑用户本身的特征,而基于用户的协同过滤机制可是在用户的历史偏好的数据上计算用户的相似度,它的基本假设是,喜欢类似物品的用户可能有相同或者相似的口味和偏好。 基于物品的协同过滤——基于内容的推荐 常用加密算法概述 常见的加密算法可以分成三类,对称加密算法,非对称加密算法和Hash算法。 对称加密 指加密和解密使用相同密钥的加密算法。对称加密算法的优点在于加解密的高速度和使用长密钥时的难破解性。假设两个用户需要使用对称加密方法加密然后交换数据,则用户最少需要2个密钥并交换使用,如果企业内用户有n个,则整个企业共需要n×(n-1) 个密钥,密钥的生成和分发将成为企业信息部门的恶梦。对称加密算法的安全性取决于加密密钥的保存情况,但要求企业中每一个持有密钥的人都保守秘密是不可能的,他们通常会有意无意的把密钥泄漏出去——如果一个用户使用的密钥被入侵者所获得,入侵者便可以读取该用户密钥加密的所有文档,如果整个企业共用一个加密密钥,那整个企业文档的保密性便无从谈起。 常见的对称加密算法:DES、3DES、DESX、Blowfish、IDEA、RC4、RC5、RC6和AES 非对称加密 指加密和解密使用不同密钥的加密算法,也称为公私钥加密。假设两个用户要加密交换数据,双方交换公钥,使用时一方用对方的公钥加密,另一方即可用自己的私钥解密。如果企业中有n个用户,企业需要生成n对密钥,并分发n个公钥。由于公钥是可以公开的,用户只要保管好自己的私钥即可,因此加密密钥的分发将变得十分简单。同时,由于每个用户的私钥是唯一的,其他用户除了可以可以通过信息发送者的公钥来验证信息的来源是否真实,还可以确保发送者无法否认曾发送过该信息。非对称加密的缺点是加解密速度要远远慢于对称加密,在某些极端情况下,甚至能比非对称加密慢上1000倍。 常见的非对称加密算法:RSA、ECC(移动设备用)、Diffie-Hellman、El Gamal、DSA(数字签名用) Hash算法 Hash算法特别的地方在于它是一种单向算法,用户可以通过Hash算法对目标信息生成一段特定长度的唯一的Hash值,却不能通过这个Hash值重新获得目标信息。因此Hash算法常用在不可还原的密码存储、信息完整性校验等。 常见的Hash算法:MD2、MD4、MD5、HAVAL、SHA、SHA-1、HMAC、HMAC-MD5、HMAC-SHA1 加密算法的效能通常可以按照算法本身的复杂程度、密钥长度(密钥越长越安全)、加解密速度等来衡量。上述的算法中,除了DES密钥长度不够、MD2速度较慢已逐渐被淘汰外,其他算法仍在目前的加密系统产品中使用。 加密算法的选择 前面的章节已经介绍了对称解密算法和非对称加密算法,有很多人疑惑:那我们在实际使用的过程中究竟该使用哪一种比较好呢? 首都师范大学 硕士学位论文 数据挖掘分类算法的研究与应用 姓名:刘振岩 申请学位级别:硕士 专业:计算机应用技术 指导教师:王万森 2003.4.1 首都师范入学硕.卜学位论Z数据挖掘分类算法的研究与应用 摘要 , f随着数据库技术的成熟应用和Internet的迅速发展,人类积累的数据量正在以指数速度增长。科于这些数据,人{}j已经不满足于传统的查询、统计分析手段,而需要发现更深层次的规律,对决策或科研工作提供更有效的决策支持。正是为了满足这种要求,从大量数据中提取出隐藏在其中的有用信息,将机器学习应用于大型数据库的数据挖掘(DataMining)技术得到了长足的发展。 所谓数据挖掘(DataMining,DM),也可以称为数据库中的知识发现(KnowledgeDiscoverDat曲鹅e,KDD),就是从大量的、不完全的、有噪声的、模糊的、随机的数据r},,提取隐含在其中的、人们事先不知道的、但又是潜在有用的信息和知识的过程。发现了的知识可以被用于信息管理、查询优化、决策支持、过程控制等,还可以用于数据自身的维护。因此,数据挖掘是数据库研究中的一个很有应用价值的新领域,它又是一门广义的交叉学科,融合了数据库、人工智能、机器学习、统计学等多个领域的理论和技术。 分类在数据挖掘中是一项非常重要的任务,目前在商业上应用最多。分类的目的是学会一个分类函数或分类模型,该模型能把数据库中的数据项映射到给定类别中的某一个。{乍多分类的方法已被机器学习、专家系统、统计学和神经生物学方面的研究者提}H。本论文主要侧重数据挖掘中分类算法的研究,并将分类算法划分为急切分类和懒散分类,全部研究内容基本围绕着这种划分方法展开。.1本文的主要研究内容:, l,讨论了数掂挖掘中分类的基本技术,包括数据分类的过程,分类数据所需的数据预处理技术,以及分类方法的比较和评估标准;比较了几种典 型的分类算法,包括决策树、k.最近邻分类、神经网络算法:接着,引 出本文的研究重点,即将分类算法划分为急切分类和懒散分类,并基于 这种划分展歼对数据挖掘分类算法的研究。 2.结合对决簸树方法的研究,重点研究并实现了一个“懒散的基于模型的分类”思想的“懒散的决策树算法”。在决策树方法的研究中,阐述了决 策树的基本概念以及决策树的优缺点,决策树方法的应用状况,分析了 决策树算法的迸一步的研究重点。伪了更好地满足网络环境下的应用需 求,结合传统的决策树方法,基于Ⅶ懒散的基于模型的分类”的思想, 实现了一个网络环境下基于B/S模式的“懒散的决策树算法”。实践表明: 在WEB应fH程序叶i采用此算法取得了很好的效果。、 ≯ 3.选取神经H络分类算法作为急切分类算法的代表进行深入的研究。在神经网络中,重点分析研究了感知器基本模型,包括感知器基本模型的构 造及其学习算法,模型的几何意义及其局限性。并针对该模型只有在线 性可分的情况一F彳‘能用感知器的学习算法进行分类的这一固有局限性, 研究并推广了感知器模型。 Computer Science and Application 计算机科学与应用, 2019, 9(9), 1803-1813 Published Online September 2019 in Hans. https://www.360docs.net/doc/2c15171389.html,/journal/csa https://https://www.360docs.net/doc/2c15171389.html,/10.12677/csa.2019.99202 Review of Classical Recommendation Algorithms Chunhua Zhou, Jianjing Shen, Yan Li, Xiaofeng Guo Information Engineering University, Zhengzhou Henan Received: Sep. 3rd, 2019; accepted: Sep. 18th, 2019; published: Sep. 25th, 2019 Abstract Recommender systems are effective tools of information ?ltering that are prevalent due to cont i-nuous popularization of the Internet, personalization trends, and changing habits of computer us-ers. Although existing recommender systems are successful in producing decent recommend a-tions, they still suffer from challenges such as cold-start, data sparsity, and user interest drift. This paper summarizes the research status of recommendat ion system, presents an overview of the field of recommender systems, describes the classical recommendation methods that are usually classified into the following three main categories: content-based, collaborative and hybrid recommendation algorithms, a nd prospects future research directions. Keywords Recommender Systems, Cold-Start, Data Sparsity, Collaborative Filtering 经典推荐算法研究综述 周春华,沈建京,李艳,郭晓峰 信息工程大学,河南郑州 收稿日期:2019年9月3日;录用日期:2019年9月18日;发布日期:2019年9月25日 摘要 推荐系统作为一种有效的信息过滤工具,由于互联网的不断普及、个性化趋势和计算机用户习惯的改变,将变得更加流行。尽管现有的推荐系统也能成功地进行推荐,但它们仍然面临着冷启动、数据稀疏性和用户兴趣漂移等问题的挑战。本文概述了推荐系统的研究现状,对推荐算法进行了分类,介绍了几种经 用C语言实现凯撒加密算法 一、凯撒加密算法的来源与简介 “凯撒密码”据传是古罗马凯撒大帝用来保护重要军情的加密系统。它是一种替代密码,通过将字母按顺序推后起3位起到加密作用,如将字母A换作字母D,将字母B 换作字母E。据说凯撒是率先使用加密函的古代将领之一,因此这种加密方法被称为凯撒密码。 假如有这样一条指令: RETURN TO ROME 用凯撒密码加密后就成为: UHWXUA WR URPH 如果这份指令被敌方截获,也将不会泄密,因为字面上看不出任何意义。 这种加密方法还可以依据移位的不同产生新的变化,如将每个字母左19位,就 产生这样一个明密对照表: 明:A B C D E F G H I J K L M N O P Q R S T U V W X Y Z 密:T U V W X Y Z A B C D E F G H I J K L M N O P Q R S 在这个加密表下,明文与密文的对照关系就变成: 明文:THE FAULT, DEAR BRUTUS, LIES NOT IN OUR STARS BU T IN OURSELVES. 密文:MAX YTNEM, WXTK UKNMNL, EBXL GHM BG HNK LMTKL UNM BG HNKLXEOXL. 很明显,这种密码的密度是很低的,只需简单地统计字频就可以破译。于是人们在单一凯撒密码的基础上扩展出多表密码,称为“维吉尼亚”密码。它是由16世纪 法国亨利三世王朝的布莱瑟·维吉尼亚发明的,其特点是将26个凯撒密表合成一个,见下表: 原: A B C D E F G H I J K L M N O P Q R S T U V W X Y Z A :A B C D E F G H I J K L M N O P Q R S T U V W X Y Z B :B C D E F G H I J K L M N O P Q R S T U V W X Y Z A C: C D E F G H I J K L M N O P Q R S T U V W X Y Z A B D: D E F G H I J K L M N O P Q R S T U V W X Y Z A B C E: E F G H I J K L M N O P Q R S T U V W X Y Z A B C D F: F G H I J K L M N O P Q R S T U V W X Y Z A B C D E G: G H I J K L M N O P Q R S T U V W X Y Z A B C D E F H: H I J K L M N O P Q R S T U V W X Y Z A B C D E F G I: I J K L M N O P Q R S T U V W X Y Z A B C D E F G H J: J K L M N O P Q R S T U V W X Y Z A B C D E F G H I K: K L M N O P Q R S T U V W X Y Z A B C D E F G H I J L: L M N O P Q R S T U V W X Y Z A B C D E F G H I J K M: M N O P Q R S T U V W X Y Z A B C D E F G H I J K L N: N O P Q R S T U V W X Y Z A B C D E F G H I J K L M 《数据挖掘》 数据挖掘分类算法综述 专业:计算机科学与技术专业学号:S2******* 姓名:张靖 指导教师:陈俊杰 时间:2011年08月21日 数据挖掘分类算法综述 数据挖掘出现于20世纪80年代后期,是数据库研究中最有应用价值的新领域之一。它最早是以从数据中发现知识(KDD,Knowledge Discovery in Database)研究起步,所谓的数据挖掘(Data Mining,简称为DM),就从大量的、不完全的、有噪声的、模糊的、随机的、实际应用的数据中提取隐含在其中的、人们不知道的但又有用的信息和知识的过程。 分类是一种重要的数据挖掘技术。分类的目的是根据数据集的特点构造一个分类函数或分类模型(也常常称作分类器)。该模型能把未知类别的样本映射到给定类别中的一种技术。 1. 分类的基本步骤 数据分类过程主要包含两个步骤: 第一步,建立一个描述已知数据集类别或概念的模型。如图1所示,该模型是通过对数据库中各数据行内容的分析而获得的。每一数据行都可认为是属于一个确定的数据类别,其类别值是由一个属性描述(被称为类别属性)。分类学习方法所使用的数据集称为训练样本集合,因此分类学习又可以称为有指导学习(learning by example)。它是在已知训练样本类别情况下,通过学习建立相应模型,而无指导学习则是在训练样本的类别与类别个数均未知的情况下进行的。 通常分类学习所获得的模型可以表示为分类规则形式、决策树形式或数学公式形式。例如,给定一个顾客信用信息数据库,通过学习所获得的分类规则可用于识别顾客是否是具有良好的信用等级或一般的信用等级。分类规则也可用于对今后未知所属类别的数据进行识别判断,同时也可以帮助用户更好的了解数据库中的内容。 图1 数据分类过程中的学习建模 第二步,利用所获得的模型进行分类操作。首先对模型分类准确率进行估计,例如使用保持(holdout)方法。如果一个学习所获模型的准确率经测试被认为是可以接受的,那么就可以使用这一模型对未来数据行或对象(其类别未知)进行分类。例如,在图2中利用学习获得的分类规则(模型)。对已知测试数据进行模型推荐系统的常用算法原理和实现

常用加密算法概述

数据挖掘分类算法的研究与应用

经典推荐算法研究综述

加密算法

分类算法综述