MAX7219工作原理简介

MAX7219工作原理简介

MAX7219是一个采用3线串行接口的8位共阴极7段LED显示驱动器。本文分析了MAX7219各个寄存器的功能,并结合MAX7219的工作时序,给出了MAX7219在Motorola MC68HC908单片机系统中的一个应用实例。关键词: MCU;MAX7219;LED Motorola MC68HC908

MAX7219工作时序及其寄存器

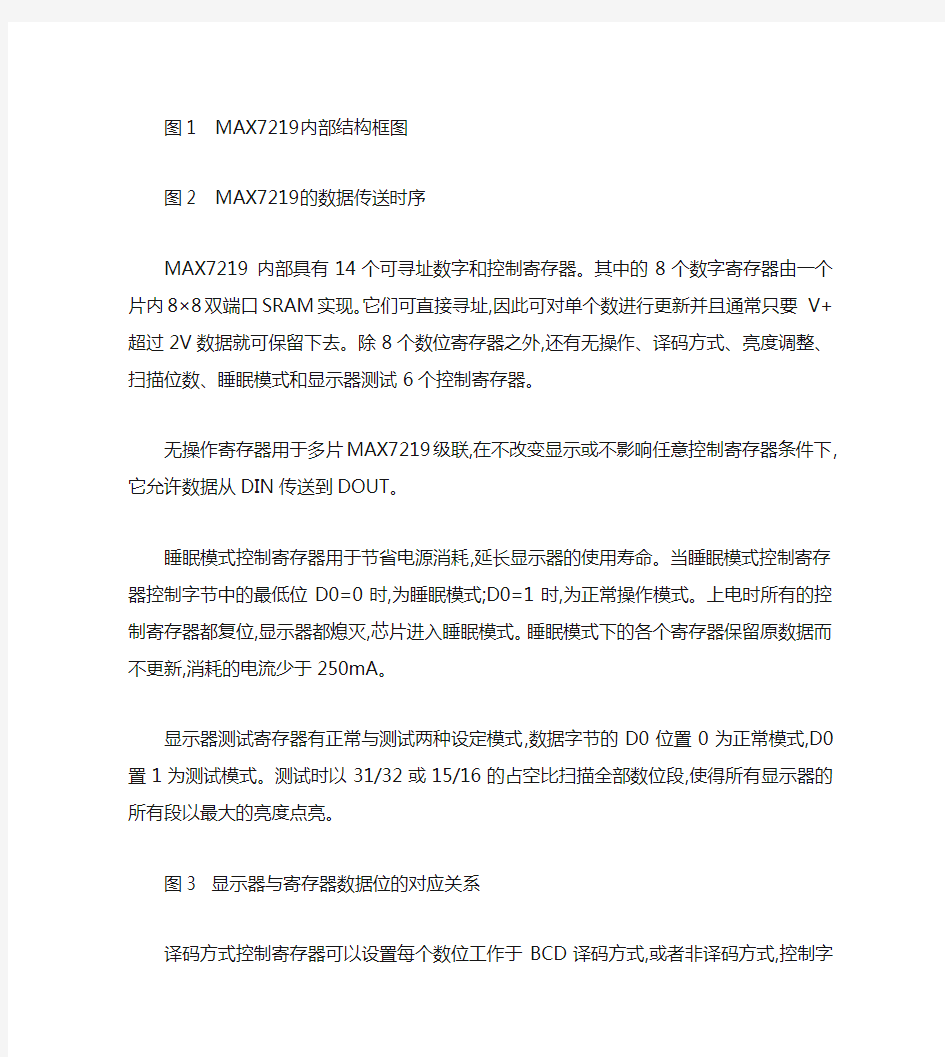

MAX7219是一个高性能的多位LED显示驱动器,可同时驱动8位共阴极LED或64个独立的LED。其内部结构框图如图1所示,主要包括移位寄存器、控制寄存器、译码器、数位与段驱动器以及亮度调节和多路扫描电路等。

MAX7219 采用串行接口方式,只需LOAD、DIN、CLK三个管脚便可实现数据传送。DIN管脚上的16位串行数据包不受LOAD状态的影响,在每个CLK的上升沿被移入到内部16位移位寄存器中。然后,在LOAD的上升沿数据被锁存到数字或控制寄存器中。LOAD必须在第16个时钟上降沿或之后,但在下一个时钟上升沿之前变高,否则数据将会丢失。DIN端的数据通过移位寄存器传送,并在16.5个时钟周期后出现在DOUT端,随CLK 的下降沿输出。 MAX7219的操作时序如图2所示。

MAX7219的串行数据标记为D15~D0,其中低8位表示显示数据本身,最高的4位D15~D12未使用,寻址内部寄存器的地址位占用D11~D8,选择14个内部寄存器,见表1。

图1 MAX7219内部结构框图

图2 MAX7219的数据传送时序

MAX7219 内部具有14个可寻址数字和控制寄存器。其中的8个数字寄存器由一个片内8×8双端口SRAM实现。它们可直接寻址,因此可对单个数进行更新并且通常只要 V+超过2V数据就可保留下去。除8个数位寄存器之外,还有无操作、译码方式、亮度调整、扫描位数、睡眠模式和显示器测试6个控制寄存器。

无操作寄存器用于多片MAX7219级联,在不改变显示或不影响任意控制寄存器条件下,它允许数据从DIN传送到DOUT。

睡眠模式控制寄存器用于节省电源消耗,延长显示器的使用寿命。当睡眠模式控制寄存器控制字节中的最低位D0=0时,为睡眠模式;D0=1时,为正常操作模式。上电时所有的控制寄存器都复位,显示器都熄灭,芯片

进入睡眠模式。睡眠模式下的各个寄存器保留原数据而不更新,消耗的电流少于250mA。

显示器测试寄存器有正常与测试两种设定模式,数据字节的D0位置0为正常模式,D0置1为测试模式。测试时以31/32或15/16的占空比扫描全部数位段,使得所有显示器的所有段以最大的亮度点亮。

图3 显示器与寄存器数据位的对应关系

译码方式控制寄存器可以设置每个数位工作于BCD译码方式,或者非译码方式,控制字节的8位正好对应8个数位,该位为1表示该数位工作于BCD码方式,为0 表示该数位工作于非译码方式。当采用代码BCD译码方式时,对10个数字“0~9”和5个字符“-,E,H,L,P”,译码器仅针对数字寄存器中数据的低四位D3~D0,而不考虑D6~D4位。设置小数点(SEG DP)的D7与编码方式,点亮时,D7置"1",熄灭时,D7置“0”即可。表2是BCD码的字符编码。

当选择不译码方式时,数据位D7~D0对应于LED的段线如图3所示。

显示器的亮度可以通过模拟与数字两种方式进行调整,模拟方式是在Vcc与ISET引脚之间外接一个电阻RSET,这时段驱动器提供的峰值电流约为ISET引脚电流的100倍,调整该电阻的大小即可改变显示器亮度,电阻的最小值为9.53KW,此时提供的段驱动电流典型值为40mA。

亮度的数字化调整是使用亮度调整寄存器,此时芯片内启用一个脉宽调制器,它受亮度调整寄存器低半字节D3~D0的控制,产生16种占空比不同的输出脉冲,形成16级亮度调整,此时以RSET设定峰值电流。寄存器数据为×0H时,脉冲占空比为1/32,表示MAX7219驱动的段点亮时间仅为整周期的1/32,这是最暗的情况。数据从×0H变化到×FH,表示脉冲占空比由1/32变化到31/32 (注意这里的分子只有奇数),此时扫描消隐期按比例递减,亮度线性递增。因此寄存器数据为×FH时最亮,消隐期仅为1/32。

图4 MAX7219应用连接图

MAX7219 有驱动8个数码管的能力,但实际应用中不一定恰好是8个。扫描位数寄存器用于设置显示器数码管的实际扫描个数,由扫描位数寄存器的D2~D0设定,其数据为×0H时,表示仅扫描数位0,数据为01H时,

扫描数位0与数位1,如此类推,直至数据为×7H,表示8个全扫描。8个全部扫描时,扫描速率为 800Hz,只扫描N个时,扫描速率为8fOSC/N。应注意扫描的位数变化对亮度有明显影响。当扫描的数码管等于或少于3个时,单个数位驱动器将消耗较大的功率,因而必须依据使用的数码管实际数量调整电阻RSET的大小,限制消耗的电流。

显示器测试寄存器有正常与测试两种设定模式,数据字节的D0位置0为正常模式,D0置1为测试模式。测试时,以31/32的占空比扫描MAX7219全部数位段,使得所有显示器的所有段以最大的亮度点亮。

MAX7219与MC68HC908GP32接口应用

MAX7219 采用串行通信,只需通过CLK、LOAD、DIN三根线便可与多种MCU 接口。M68HC908系列单片机是新一类 Motorola高性能的8位单片机,具有速度高、功能强和价格低等特点,其指令码与M68HC05完全兼容。Motorola自1999年推出该系列单片机以来,至今已推出了三十余种不同型号的MC68HC908单片机。本文以Motorola在中国大力推广的通用型芯片MC68HC908GP32为例,介绍MAX7219与MC68HC908系列单片机的接口电路,如图4所示。由于MC68HC908系列的单片机都具有一定数量的I/O管脚,所以该应用实例同样适用于其它型号的MC68HC908单片机,具有一定的代表性。

图中MC68HC908GP32的PORTB口工作于输出方式,并结合MAX7219的工作时序,对MAX7219进行控制。WRI_INSTRU为MAX7219控制子程序,它在CLK管脚产生8个时钟脉冲,并将入口参数A中的8位值在CLK的上升沿串行输出到DIN。LED_WR为MAX7219控制主程序,它首先置LOAD为低电平,然后通过两次调用 WRI_INSTRU完成向MAX7219写入16位串行数据,最后再置LOAD为高电平,产生一个上升沿脉冲以满足MAX7219的数据传送时序。

结语

MAX7219 能够驱动8个LED,可方便地对每位LED进行单独控制、刷新,不需重写整个显示器寄存器,通信方式采用串行数据方式,可与任何一种单片机方便接口。Motorola MC68HC908系列单片机,多采用32.768KHz外部晶体,或内部集成了晶振电路,功能强大,抗干扰能力强。它们构成的显示系统可应用在条状图形显示器、7段数码管显示器、工业控制器显示模板、面板表与LED矩阵显示器等众多场合。■

搜索引擎基本工作原理

搜索引擎基本工作原理 目录 1工作原理 2搜索引擎 3目录索引 4百度谷歌 5优化核心 6SEO优化 ?网站url ? title信息 ? meta信息 ?图片alt ? flash信息 ? frame框架 1工作原理 搜索引擎的基本工作原理包括如下三个过程:首先在互联网中发现、搜集网页信息;同时对信息进行提取和组织建立索引库;再由检索器根据用户输入的查询关键字,在索引库中快速检出文档,进行文档与查询的相关度评价,对将要输出的结果进行排序,并将查询结果返回给用户。 1、抓取网页。每个独立的搜索引擎都有自己的网页抓取程序爬虫(spider)。爬虫Spider顺着网页中的超链接,从这个网站爬到另一个网站,通过超链接分析连续访问抓取更多网页。被抓取的网页被称之为网页快照。由于互联网中超链接的应用很普遍,理论上,从一定范围的网页出发,就能搜集到绝大多数的网页。 2、处理网页。搜索引擎抓到网页后,还要做大量的预处理工作,才能提供检索服务。其中,最重要的就是提取关键词,建立索引库和索引。其他还包括去除重

复网页、分词(中文)、判断网页类型、分析超链接、计算网页的重要度/丰富度等。 3、提供检索服务。用户输入关键词进行检索,搜索引擎从索引数据库中找到匹配该关键词的网页;为了用户便于判断,除了网页标题和URL外,还会提供一段来自网页的摘要以及其他信息。 搜索引擎基本工作原理 2搜索引擎 在搜索引擎分类部分我们提到过全文搜索引擎从网站提取信息建立网页数据库 的概念。搜索引擎的自动信息搜集功能分两种。一种是定期搜索,即每隔一段时间(比如Google一般是28天),搜索引擎主动派出“蜘蛛”程序,对一定IP 地址范围内的互联网站进行检索,一旦发现新的网站,它会自动提取网站的信息和网址加入自己的数据库。 另一种是提交网站搜索,即网站拥有者主动向搜索引擎提交网址,它在一定时间内(2天到数月不等)定向向你的网站派出“蜘蛛”程序,扫描你的网站并将有关信息存入数据库,以备用户查询。由于搜索引擎索引规则发生了很大变化,主动提交网址并不保证你的网站能进入搜索引擎数据库,因此目前最好的办法是多获得一些外部链接,让搜索引擎有更多机会找到你并自动将你的网站收录。 当用户以关键词查找信息时,搜索引擎会在数据库中进行搜寻,如果找到与用户要求内容相符的网站,便采用特殊的算法——通常根据网页中关键词的匹配程度,

搜索引擎基本工作原理

搜索引擎基本原理 一.全文搜索引擎 在搜索引擎分类部分我们提到过全文搜索引擎从网站提取信息建立网页数据库的概念。搜索引擎的自动信息搜集功能分两种。一种是定期搜索,即每隔一段时间(比如Google一般是28天),搜索引擎主动派出“蜘蛛”程序,对一定IP地址范围内的互联网站进行检索,一旦发现新的网站,它会自动提取网站的信息和网址加入自己的数据库。 另一种是提交网站搜索,即网站拥有者主动向搜索引擎提交网址,它在一定时间内(2天到数月不等)定向向你的网站派出“蜘蛛”程序,扫描你的网站并将有关信息存入数据库,以备用户查询。由于近年来搜索引擎索引规则发生了很大变化,主动提交网址并不保证你的网站能进入搜索引擎数据库,因此目前最好的办法是多获得一些外部链接,让搜索引擎有更多机会找到你并自动将你的网站收录。 当用户以关键词查找信息时,搜索引擎会在数据库中进行搜寻,如果找到与用户要求内容相符的网站,便采用特殊的算法——通常根据网页中关键词的匹配程度,出现的位置/频次,链接质量等——计算出各网页的相关度及排名等级,然后根据关联度高低,按顺序将这些网页链接返回给用户。 二.目录索引 与全文搜索引擎相比,目录索引有许多不同之处。 首先,搜索引擎属于自动网站检索,而目录索引则完全依赖手工操作。用户提交网站后,目录编辑人员会亲自浏览你的网站,然后根据一套自定的评判标准甚至编辑人员的主观印象,决定是否接纳你的网站。 其次,搜索引擎收录网站时,只要网站本身没有违反有关的规则,一般都能登录成功。而目录索引对网站的要求则高得多,有时即使登录多次也不一定成功。

尤其象Yahoo!这样的超级索引,登录更是困难。(由于登录Yahoo!的难度最大,而它又是商家网络营销必争之地,所以我们会在后面用专门的篇幅介绍登录Yahoo雅虎的技巧) 此外,在登录搜索引擎时,我们一般不用考虑网站的分类问题,而登录目录索引时则必须将网站放在一个最合适的目录(Directory)。 最后,搜索引擎中各网站的有关信息都是从用户网页中自动提取的,所以用户的角度看,我们拥有更多的自主权;而目录索引则要求必须手工另外填写网站信息,而且还有各种各样的限制。更有甚者,如果工作人员认为你提交网站的目录、网站信息不合适,他可以随时对其进行调整,当然事先是不会和你商量的。 目录索引,顾名思义就是将网站分门别类地存放在相应的目录中,因此用户在查询信息时,可选择关键词搜索,也可按分类目录逐层查找。如以关键词搜索,返回的结果跟搜索引擎一样,也是根据信息关联程度排列网站,只不过其中人为因素要多一些。如果按分层目录查找,某一目录中网站的排名则是由标题字母的先后顺序决定(也有例外)。 目前,搜索引擎与目录索引有相互融合渗透的趋势。原来一些纯粹的全文搜索引擎现在也提供目录搜索,如Google就借用Open Directory目录提供分类查询。而象 Yahoo! 这些老牌目录索引则通过与Google等搜索引擎合作扩大搜索范围。在默认搜索模式下,一些目录类搜索引擎首先返回的是自己目录中匹配的网站,如国内搜狐、新浪、网易等;而另外一些则默认的是网页搜索,如Yahoo。

BFD技术白皮书(迈普)

BFD技术白皮书 本文档介绍了双向转发检测(BFD)技术的原理及应用,BFD是一套用来快速检测的国际标准协议,提供了一种轻负荷,短周期的故障检测。迈普公司已在高端网络产品上实现了BFD技术,可以为用户提供完整的解决方案,从而能够大幅提高网络的服务质量。

目录 1概述 (3) 2 技术简介 (3) 2.1BFD技术原理 (3) 2.2 术语 (4) 3 关键技术 (4) 3.1 报文格式 (4) 3.2 协议状态机 (6) 3.3工作模式 (7) 3.4会话的建立 (8) 4 典型应用 (11) 4.1 BFD加快路由协议收敛 (11) 4.2 BFD加快VRRP协议收敛 (12)

1概述 众所周知,IP网络并不具备秒级以下的间歇性故障修复功能,而传统路由架构在对实时应用(如语音)进行准确故障检测方面能力有限。随着VoIP应用的激增,实现快速网络故障检测和修复越发显得必要。网络设备的一个日益重要的特色就是可以迅速的检测到临近系统之间的通信故障,以便更快的建立或切换到备用路径。在某些环境中由于数据链路硬件的作用可以使故障检测相当的迅速(例如SDH)。但是很多媒介并没有提供这种能力(例如以太),还有一些无法实现端到端的路径检测。 如果硬件不能够对故障检测提供帮助时,网络中将使用缓慢的Hello机制来进行故障检测,这一般是由路由协议来提供。而目前存在的路由协议所能够提供的可以检测到网络故障的最快时间基本都是秒级的,这对于某些应用来说实在是太长了,并且当网络业务达到吉比特时,秒级的故障检测速度将会导致大量数据的丢失。此外,路由协议所提供的Hello机制只有当该路由协议被使用时才有效,并且路由协议所提供的检测含义略有不同——它们检测的是两个路由协议引擎之间路径上的故障。 双向转发检测(Bidirectional Forwarding Detection ,BFD)能大大提高网络的故障检测速度。IETF草案标准BFD提供了一种简单、轻量和抽象的方法,对网络链接能力和系统通信转发功能进行检测。BFD的目标之一就是在临近的转发引擎之间的路径上提供低耗费、短周期的故障检测。而另一个目标则是提供一种专门的机制用于存活检测,适用于任何媒介、任何协议,并为检测周期和耗费提供较宽的选择范围,以避免不同检测方式的重叠。BFD协议的出现,为上述问题提出了一种解决方案,BFD能够在系统之间的任何类型通道上进行故障检测,这些通道包括直连的物理链路,虚电路,隧道,MPLS LSP,多跳路由通道,以及非直连的通道。同时正是由于BFD实现故障检测的简单、单一性,致使BFD能够专注于转发故障的快速检测,使故障检测时间提高到毫秒级。BFD功能实现简单,是针对通信转发故障检测的最好方案。 2 技术简介 2.1BFD技术原理 BFD是一种高速的独立Hello协议,可以用于检测一对邻近系统之间任何类型的路径故障。BFD在一对邻近系统间进行对等会话,一对邻近系统在它们之间建立会话的通道上周期性或间歇性的发送检测报文,如果某个系统在足够长的时间内没有收到对端的检测报文,则

搜索引擎工作原理

搜索引擎工作原理 在搜索引擎的后台,有一些收集网页信息的程序。收集到的信息一般是能够表明网站内容的关键词或短语。然后,信息的索引存储在数据库中。 搜索引擎的系统架构和操作模式吸收了信息检索系统设计中的许多宝贵经验,并根据万维网数据和用户的特点进行了许多修改。其核心文档处理和查询处理的过程基本上是类似传统信息检索系统的工作原理,但它处理的数据对象的复杂特征,也就是说,万维网数据,确定搜索引擎系统必须调整其系统结构,以满足数据处理和用户查询的需求搜索引擎的基本工作原理包括如下三个过程:首先在互联网中发现、搜集网页信息;同时对信息进行提取和组织建立索引库;再由检索器根据用户输入的查询关键字,在索引库中快速检出文档,进行文档与查询的相关度评价,对将要输出的结果进行排序,并将查询结果返回给用户。 3、1、抓取网页。每个独立的搜索引擎都有自己的网页抓取程序爬虫(spider)。爬虫Spider顺着网页中的超链接,从这个网站爬到另一个网站,通过超链接分析连续访问抓取更多网页。被抓取的网页被称之为网页快照。由于互联网中超链接的应用很普遍,理论上,从一定范围的网页出发,就能搜集到绝大多数的网页。 4、2、处理网页。搜索引擎抓到网页后,还要做大量的预处理工作,才能提供检索服务。其中,最重要的就是提取关键词,建立索引库和索引。其他还包括去除重复网页、分词(中文)、判断网页类型、分

析超链接、计算网页的重要度/丰富度等。 5、提供检索服务。用户输入关键词进行检索,搜索引擎从索引数据库中找到匹配该关键词的网页;为了用户便于判断,除了网页标题和URL外,还会提供一段来自网页的摘要以及其他信息。 在搜索引擎分类部分我们提到过全文搜索引擎从网站提取信息建立网页数据库的概念。搜索引擎的自动信息搜集功能分两种。一种是定期搜索,即每隔一段时间(比如Google一般是28天),搜索引擎主动派出“蜘蛛”程序,对一定IP地址范围内的互联网站进行检索,一旦发现新的网站,它会自动提取网站的信息和网址加入自己的数据库。 另一种是提交网站搜索,即网站拥有者主动向搜索引擎提交网址,它在一定时间内(2天到数月不等)定向向你的网站派出“蜘蛛”程序,扫描你的网站并将有关信息存入数据库,以备用户查询。由于搜索引擎索引规则发生了很大变化,主动提交网址并不保证你的网站能进入搜索引擎数据库,因此目前最好的办法是多获得一些外部链接,让搜索引擎有更多机会找到你并自动将你的网站收录。 当用户以关键词查找信息时,搜索引擎会在数据库中进行搜寻,如果找到与用户要求内容相符的网站,便采用特殊的算法——通常根据网页中关键词的匹配程度,出现的位置、频次,链接质量等——计算出各网页的相关度及排名等级,然后根据关联度高低,按顺序将这些网页链接返回给用户。

百度搜索引擎工作原理

以及其他信息。 搜索引擎基本工作原理

与全文搜索引擎相比,目录索引有许多不同之处。 首先,搜索引擎属于自动网站检索,而目录索引则完全依赖手工操作。用户提交网站后,目录编辑人员会亲自浏览你的网站,然后根据一套自定的评判标准甚至编辑人员的主观印象,决定是否接纳你的网站。 其次,搜索引擎收录网站时,只要网站本身没有违反有关的规则,一般都能登录成功。而目录索引对网站的要求则高得多,有时即使登录多次也不一定成功。尤其象Yahoo!这样的超级索引,登录更是困难。 此外,在登录搜索引擎时,我们一般不用考虑网站的分类问题,而登录目录索引时则必须将网站放在一个最合适的目录(Directory)。 最后,搜索引擎中各网站的有关信息都是从用户网页中自动提取的,所以用户的角度看,我们拥有更多的自主权;而目录索引则要求必须手工另外填写网站信息,而且还有各种各样的限制。更有甚者,如果工作人员认为你提交网站的目录、网站信息不合适,他可以随时对其进行调整,当然事先是不会和你商量的。 目录索引,顾名思义就是将网站分门别类地存放在相应的目录中,因此用户在查询信息时,可选择关键词搜索,也可按分类目录逐层查找。如以关键词搜索,返回的结果跟搜索引擎一样,也是根据信息关联程度排列网站,只不过其中人为因素要多一些。如果按分层目录查找,某一目录中网站的排名则是由标题字母的先后顺序决定(也有例外)。 目前,搜索引擎与目录索引有相互融合渗透的趋势。原来一些纯粹的全文搜索引擎现在也提供目录搜索,如Google就借用Open Directory目录提供分类查询。而象Yahoo! 这些老牌目录索引则通过与Google等搜索引擎合作扩大搜索范围(注),在默认搜索模式下,一些目录类搜索引擎首先返回的是自己目录中匹配的网站,如国内搜狐、新浪、网易等;而另外一些则默认的是网页搜索,如Yahoo。 新竞争力通过对搜索引擎营销的规律深入研究认为:搜索引擎推广是基于网站内容的推广——这就是搜索引擎营销的核心思想。这句话说起来很简单,如果仔细分析会发现,这句话的确包含了搜索引擎推广的一般规律。本文作者在“网站推广策略之内容推广思想漫谈”一文中提出一个观点:“网站内容不仅是大型ICP网站的生命源泉,对于企业网站网络营销的效果同样是至关重要的”。因为网站内容本身也是一种有效的网站推广手段,只是这种推广需要借助于搜索引擎这个信息检索工具,因此网站内容推广策略实际上也就是搜索引擎推广策略的具体应用。 百度谷歌 编辑 查询处理以及分词技术 随着搜索经济的崛起,人们开始越加关注全球各大搜索引擎的性能、技术和日流量。作为企业,会根据搜索引擎的知名度以及日流量来选择是否要投放广告等;作为普通网民,会根据搜索引擎的性能和技术来选择自己喜欢的引擎查找资料;作为技术人员,会把有代表性的搜索引擎作为研究对象。搜索引擎经济的崛起,又一次向人们证明了网络所蕴藏的巨大商机。网络离开了搜索将只剩下空洞杂乱的数据,以及大量等待去费力挖掘的金矿。

百度搜索引擎工作原理

第二讲:百度搜索引擎及工作原理 一、百度搜索引擎及工作原理? 1、抓取: 搜索引擎蜘蛛又叫爬虫或机器人,是一套信息抓取的程序,百度蜘蛛是通过网络上链接来爬取、搜集网页上的内容信息。 分为深度抓取和广度抓取,怎么让蜘蛛来抓取呢?一般有三种途径:外链、主动提交链接、蜘蛛自己来。我们可以通过服务器日志及百度站长平台抓取频率来判断蜘蛛是否来抓取网页了。在抓取的过程当中影响蜘蛛抓取的因素有路径(过长、中文)以及服务器打开速度。 2、过滤: 通过过滤系统将一些低质量的垃圾内容过滤掉,比如说复制来的,采集来的,主题内容不相关的无价值内容,不够丰富的内容(内容是否为高质量、稀缺性内容)通通过滤掉。 另外,对于一些无法识别的:js、没有添加alt属性的图片、视频上下方没有加加文字说明的、flash、iframe框架结构、登录页面都会过滤掉。 3、收录:

将通过过滤模块的页面储存在索引库里,我们称之为收录。 怎么查询呢?直接在搜索框内输入网址即可查询是否被收录了,查询整个网站收录量用到site指令:site+域名 收录了并不一定有排名,它是网页参与排名的前提条件并非充分条件。只有网站单个页面权重提升了整个网站权重才会更高更强大。 搜索引擎对网站的信任度非常重要,是一个长期积累过程,最终可以达到一个秒收的程度。 4、排序: 通过百度算法系统进行评分,来计算页面的综合得分情况进行排序,最后展现在搜索引擎的搜索结果页中。 因此,我们必须研究搜索引擎排名机制和影响页面排名的因素有哪些。 二、你知道网站不收录的原因有哪些? 1、有没有通知蜘蛛来或对蜘蛛有没有进行封禁 2、页面内容质量低 3、排名周期(观察期) 4、网页内容是否能够被蜘蛛识别

搜索引擎的工作原理

搜索引擎到工作原理 第一节搜索引擎的定义和功能构成 所谓“搜索引擎”,说到底是一个计算机应用软件系统,或者说是一个网络应用软件系统。从网络用户的角度看,它根据用户提交的类自然语言查询词或者短语,返回一系列很可能与该查询相关的网页信息,供用户进一步判断和选取。为了有效地做到这一点,它大致上被分成三个功能模块,或者三个子系统:即网页搜集,预处理和查询服务。 应该指出,在实践中这三个部分是相对独立的,它们的工作形成了搜索引擎工作的三个阶段,通常分别由人工启动。同时我们注意到,在早期的搜索引擎中,系统处理的网页数量少,预处理部分的工作比较简单,只是涉及到汉语的分词(英文还没有这个问题)和建索引,因此也有将分词合并到网页搜集过程中,将建索引归到查询服务子系统中,从而整个系统看起来只有两个模块的安排。 图片一:搜索引擎三段式工作原理模式图 第二节、网页搜集 搜索引擎这样一个软件系统应该是何种工作方式?如果说软件系统是工作在某还是即时。我们都有经验,在网络比较畅通的引擎服务的基础应该是一批预先搜集好的网页个数据集合上的程序的话,这个软件系统操作的数据不仅包括内容不可预测的用户查询,还要包括在数量上动态变化的海量网页,并且这些网页不会主动送到系统来,而是需要由系统去抓取。 首先,我们考虑抓取的时机:事先情况下,从网上下载一篇网页大约需要1秒钟左右,因此如果在用户查询的时候即时去网上抓来成千上万的网页,一个个分析处理,和用户的查询匹配,不可能满足搜索引擎的响应时间要求。不仅如此,这样做的系统效益也不高(会重

复抓取太多的网页);面对大量的用户查询,不可能想象每来一个查询,系统就到网上“搜索”一次。 因此我们看到,大规模引擎服务的基础应该是一批预先搜集好的网页(直接或者间接1)。这一批网页如何维护?可以有两种基本的考虑。 定期搜集,每次搜集替换上一次的内容,我们称之为“批量搜集”。由于每次都是重新来一次,对于大规模搜索引擎来说,每次搜集的时间通常会花几周。而由于这样做开销大,较通常两次搜集的间隔时间也不会很短(例如早期天网的版本大约每3个月来一次,Google在一段时间曾是每隔28天来一次)。这样做的好处是系统实现比较简单,主要缺点“是时新性”(freshness)不高,还有重复搜集所带来的额外带宽的消耗。 增量搜集,开始时搜集一批,往后只是(1)搜集新出现的网页,(2)搜集那些在上次 搜集后有过改变的网页,(3)发现自从上次搜集后已经不再存在了的网页,并从库中删除。由于除新闻网站外,许多网页的内容变化并不是很经常的(有研究指出50%网页的平均生 命周期大约为50天,这样做每次搜集的网页量不会很大(例如我们在2003年初估计中 国每天有30-50万变化了的网页),于是可以经常启动搜集过程(例如每天)。30万网页,一台PC机,在一般的网络条件下,半天也就搜集完了。这样的系统表现出来的信息时 新性就会比较高,主要缺点是系统实现比较复杂;这种复杂还不仅在于搜集过程,而是还 在于下面要谈到的建索引的过程。 上面讲的是系统网页数据库维护的基本策略。在这两种极端的情况之间也可能有一些折中的方案,J. Cho博士在这方面做过深入的研究[Cho and Garcia-Molina,2000],[Cho,2002], 根据一种网页变化模型和系统所含内容时新性的定义,提出了相应优化的网页搜集策略。其 中一个有趣的结论是:在系统搜集能力一定的情况下,若有两类网页(例如“商业”和“教育”),它们的更新周期差别很大(例如“商业”类网页平均更新周期是“天”,而“教育”类 网页平均更新周期是“月”),则系统应该将注意力放在更新慢的网页上[Cho and Garcia-Molina,2000],以使系统整体的时新性达到比较高的取值。 在具体搜集过程中,如何抓取一篇篇的网页,也可以有不同的考虑。最常见的一种是所 谓“爬取”:将Web上的网页集合看成是一个有向图,搜集过程从给定起始URL集合S (或者说“种子”)开始,沿着网页中的链接,按照先深、先宽、或者某种别的策略遍历,不 停的从S中移除URL,下载相应的网页,解析出网页中的超链接URL,看是否已经被访 问过,将未访问过的那些URL加入集合S。整个过程可以形象地想象为一个蜘蛛(spider)在蜘蛛网(Web)上爬行(crawl)。后面我们会看到,真正的系统其实是 多“个蜘蛛”同时在爬。 这种方式的好处除了概念很漂亮,一般实现起来也不困难外,还有很重要的一条是容易通过一定的策略,使搜集到的网页相对比较“重要”。前面提过,任何搜索引擎是不可能将Web 上的网页搜集完全的,通常都是在其他条件的限制下决定搜集过程的结束(例如磁盘满,或者搜集时间已经太长了)。因此就有一个尽量使搜到的网页比较重要的问题,这对于那些并不追求很大的数量覆盖率的搜索引擎特别重要。研究表明,按照先宽搜索方式得到的网页集合要比先深搜索得到的集合重要(这里当然有一个重要性的指标问题)。这种方式的一个困难是要从每一篇网页中提取出所含的URL。由于HTML的灵活性,其中出现URL的方式各种各样,将这个环节做得彻底不容易(例如我们现在还没有很好的简单办法从JavaScript 脚本中提取URL)。同时,由于Web 的“蝴蝶结”形状,这种方式搜集到的网页不大会超过所有目标网页数量2的2/3。 另外一种可能的方式是在第一次全面网页搜集后,系统维护相应的URL集合S,往 后的搜集直接基于这个集合。每搜到一个网页,如果它发生变化并含有新的URL,则将它们 对应的网页也抓回来,并将这些新URL也放到集合S中;如果S中某个url对应的

《自动控制原理及应用》

中国农业大学继续教育学院《自动控制原理及其应用》试卷 专业 姓名 成绩 一.填空题(每空0.5分,共25分) 1、反馈控制又称偏差控制,其控制作用是通过 与反馈量的差值进行的。 2、复合控制有两种基本形式:即按 的前馈复合控制和按 的前馈复合控制。 3、若某系统的单位脉冲响应为0.20.5()105t t g t e e --=+,则该系统的传递函数G(s)为 。 4、根轨迹起始于 ,终止于 。 5、设某最小相位系统的相频特性为101()()90()tg tg T ?ωτωω--=--,则该系统的开环传递函数为 。 6、PI 控制器的输入-输出关系的时域表达式是 ,其相应的传递函数为 ,由于积分环节的引入,可以改善系统的 性能。 7、在水箱水温控制系统中,受控对象为 ,被控量为 。 8、自动控制系统有两种基本控制方式,当控制装置与受控对象之间只有顺向作用而无反向联系时,称为 ;当控制装置与受控对象之间不但有顺向作用而且还有反向联系时,称为 ;含有测速发电机的电动机速度控制系统,属于 。 9、稳定是对控制系统最基本的要求,若一个控制系统的响应曲线为衰减振荡,则该系统 。判断一个闭环线性控制系统是否稳定,在时域分析中采用 ;在频域分析中采用 。 10、传递函数是指在 初始条件下、线性定常控制系统的 与 之比。 11、频域性能指标与时域性能指标有着对应关系,开环频域性能指标中的幅值穿越频率c ω对应时域性能指标 ,它们反映了系统动态过程的 。 12、对自动控制系统的基本要求可以概括为三个方面,即: 、快速性和 。 13、控制系统的 称为传递函数。一阶系统传函标准是 ,二阶系统传函标准形式是 。 14、在经典控制理论中,可采用 、根轨迹法或 等方法判断线性控制系统稳定性。 15、控制系统的数学模型,取决于系统 和 , 与外作用及初始条件无关。 16、线性系统的对数幅频特性,纵坐标取值为 ,横坐标为 。 17、在二阶系统的单位阶跃响应图中,s t 定义为 。%σ是 。 18、PI 控制规律的时域表达式是 。P I D 控制规律的传递函数表达式是 。 19、对于自动控制系统的性能要求可以概括为三个方面,即: 、 和 ,其中最基本的要求是 。 20、若某单位负反馈控制系统的前向传递函数为()G s ,则该系统的开环传递函数为 。 21、能表达控制系统各变量之间关系的数学表达式或表示方法,叫系统的数学模型,在古典控制理论中系统数学模型有 、 等。 22、判断一个闭环线性控制系统是否稳定,可采用 、 、 等方法。 23、PID 控制器的输入-输出关系的时域表达式是 ,其相应的传递函数为 。 24、最小相位系统是指 。 二. 选择题(每题1分,共22分) 1、采用负反馈形式连接后,则 ( ) A 、一定能使闭环系统稳定; B 、系统动态性能一定会提高; C 、一定能使干扰引起的误差逐渐减小,最后完全消除; D 、需要调整系统的结构参数,才能改善系统性能。 2、下列哪种措施对提高系统的稳定性没有效果 ( )。 A 、增加开环极点; B 、在积分环节外加单位负反馈; C 、增加开环零点; D 、引入串联超前校正装置。 3、对于以下情况应绘制0°根轨迹的是( ) A 、主反馈口符号为“-” ; B 、除r K 外的其他参数变化时; C 、非单位反馈系统; D 、根轨迹方程(标准形式)为1)()(+=s H s G 。 4、开环频域性能指标中的相角裕度γ对应时域性能指标( ) 。 A 、超调%σ B 、稳态误差ss e C 、调整时间s t D 、峰值时间p t 5、已知开环幅频特性如图2所示, 则图中不稳定的系统是( )。 系统① 系统② 系统③ A 、系 统 ① B 、系统② C 、系统③ D 、都不稳定 6、若某最小相位系统的相角裕度 γ >,则下列说法正确的是 ( )。 A 、不稳定; B 、只有当幅值裕度 1 g k >时才稳定; C 、稳定; D 、不能判用相角裕度判断系统的稳定性。

王乃成信息检索工具的工作原理

课题:信息检索工具的工作原理 课型:新授课 课时:1 课时 教学目标: 1.了解常用的英特网信息检索工具类型;能描述信息检索工具的基本工作原理和特点。 2.体验因特网信息检索工具的优缺点。 3. 掌握常用因特网信息检索工具的使用方法,能熟练使用信息检索工具获取所需信息。 内容分析: 本节为“因特网信息资源检索”中的重点部分,介绍了全文和目录索引类搜索引擎的工作原理,这是学习的重点。教材中通过搜索奥运信息的例子来说明在网上检索信息的过程, 以达到简化原理、帮助学生理解的目的。教学中应尽量选取贴近生活的例子来说明复杂的工 作原理,降低难度,以提高学生的检索能力为最终目的。 教学过程: 1.情境引入 已搜索一首歌曲为基础,提出问题:同学们想像一下信息检索工具该如何工作呢?有几种方法能达到,让学生们互相讨论,并展开对比讨论,选出最恰当的方法。 2.教学过程 方法一:全文搜索引擎的工作原理 (1)提出问题 ①去超市购买一枝钢笔的过程。 购物→描述商品特征→取货→交给顾客 ②利用全文搜索引擎查找夏季奥运会的由来,并观察操作的一般过程。如图 1-1 ~ 1-3 所示。 图 1-1 百度检索首页

图 1-2 百度检索结果页面 图 1-3 百度检索答案举例页面 总结 全文搜索引擎检索信息的过程: 搜索关键字或词→数据库中检索→搜索结果。 (2)通过上述范例引申 从专业的角度拓展给学生讲解搜索引擎的组成。 ①搜索器:负责定期地自动到各个网站上,把网页抓下来,并顺着上面的链接,持 续不断地抓取网页。 ②索引器:把搜索器抓来的网页进行分析,按照关键词句进行索引,并存入服务器 的数据库中。 ③检索器:面向用户,接收用户提交的查询字串,在索引数据库中查询,并将结果 反馈给用户。 巩固练习:搜索江苏省2012年高考方案 进一步总结,得出全文搜索引擎的工作包括三个过程。 ①搜索器在因特网中发现、搜集网页信息。 ②索引器对所搜集的信息进行提取和组织,并建立索引库。 ③由检索器根据用户输入的查询关键词,在索引库中快速检出相关文档,进行文档与查询内容的相关比较,对检出的结果进行排序,并将查询结果返回给用户。 方法二:目录索引类搜索引擎的基本工作原理 (1)提出问题 ①如果去学校图书馆借阅“短篇小说集”,该怎么去做,描述一般过程。 借阅图书→找书目→找相应书籍→从书架拿出 ②利用目录类搜索引擎查找“北京大学”的信息,如图 1-4 ~ 1-7所示。

搜索引擎工作原理

一、搜索引擎引题 搜索引擎是什么? 这里有个概念需要提一下。信息检索(Information Retrieval 简称IR) 和搜索(Search) 是有区别的,信息检索是一门学科,研究信息的获取、表示、存储、组织和访问,而搜索只是信息检索的一个分支,其他的如问答系统、信息抽取、信息过滤也可以是信息检索。 本文要讲的搜索引擎,是通常意义上的全文搜索引擎、垂直搜索引擎的普遍原理,比如Google、Baidu,天猫搜索商品、口碑搜索美食、飞猪搜索酒店等。 Lucene 是非常出名且高效的全文检索工具包,ES 和Solr 底层都是使用的Lucene,本文的大部分原理和算法都会以Lucene 来举例介绍。 为什么需要搜索引擎? 看一个实际的例子:如何从一个亿级数据的商品表里,寻找名字含“秋裤”的商品。 使用SQL Like select * from item where name like '%秋裤%' 如上,大家第一能想到的实现是用like,但这无法使用上索引,会在大量数据集上做一次遍历操作,查询会非常的慢。有没有更简单的方法呢,可能会说能不能加个秋裤的分类或者标签,很好,那如果新增一个商品品类怎么办呢?要加无数个分类和标签吗?如何能更简单高效的处理全文检索呢?

使用搜索引擎 答案是搜索,会事先build 一个倒排索引,通过词法语法分析、分词、构建词典、构建倒排表、压缩优化等操作构建一个索引,查询时通过词典能快速拿到结果。这既能解决全文检索的问题,又能解决了SQL查询速度慢的问题。 那么,淘宝是如何在1毫秒从上亿个商品找到上千种秋裤的呢,谷歌如何在1毫秒从万亿个网页中找寻到与你关键字匹配的几十万个网页,如此大的数据量是怎么做到毫秒返回的。 二、搜索引擎是怎么做的? Part1. 分词 分词就是对一段文本,通过规则或者算法分出多个词,每个词作为搜索的最细粒度一个个单字或者单词。只有分词后有这个词,搜索才能搜到,分词的正确性非常重要。分词粒度太大,搜索召回率就会偏低,分词粒度太小,准确率就会降低。如何恰到好处的分词,是搜索引擎需要做的第一步。 正确性&粒度 分词正确性 “他说的确实在理”,这句话如何分词? “他-说-的确-实在-理”[错误语义] “他-说-的-确实-在理”[正确语义] 分词的粒度 “中华人民共和国宪法”,这句话如何分词?

搜索引擎分类及工作原理

搜索引擎的分类及工作原理 姓名:XXX 班级:XXX 摘要:这篇论文是关于搜索引擎的分类及原理的分析。在浩瀚的网络资源中,搜索引擎(Search Engine)是一种网上信息检索工具,它能帮助用户迅速而全面地找到所需要的信息。它是一个集中了千千万万个站点的地方,主要功能是给人们搜索这些站点。它还会分门别类的把一些好的站点列出来,以方便人们查找资料,有了搜索引擎你就能很容易的找到你想要的内容或站点,因此掌握好使用搜索引擎对于任何上网的用户至关重要。一个好的搜索引擎,不仅数据库容量要大,更新频率、检索速度要快,支持对多语言的搜索,而且随着数据库容量的不断膨胀,还要能从庞大的资料库中精确地找到正确的资料。 关键词:搜索引擎工作原理分类蜘蛛搜集网站 1.前言 获得网站网页资料,能够建立数据库并提供查询的系统,我们都可以把它叫做搜索引擎。搜索引擎并不真正搜索互联网,它搜索的实际上是预先整理好的网页索引数据库。真正意义上的搜索引擎,通常指的是收集了因特网上几千万到几十亿个网页并对网页中的每一个词(即关键词)进行索引,建立索引数据库的全文搜索引擎。 当用户查找某个关键词的时候,所有在页面内容中包含了该关键词的网页都将作为搜索结果被搜出来。在经过复杂的算法进行排序后,这些结果将按照与搜索关键词的相关度高低,依次排列。 2.搜索引擎分类 搜索引擎按其工作方式主要可分为三种,分别是全文搜索引擎(Full Text Search Engine)、目录索引类搜索引擎(Search Index/Directory)和元搜索引擎(Meta Search Engine)。 2.1全文搜索引擎 全文搜索引擎是从网站提取信息建立网页数据库。搜索引擎的自动信息搜集功能分两种。一种是定期搜索,即每隔一段时间搜索引擎主动派出“蜘蛛”程

策略路由配置与BFD讲课讲稿

策略路由配置与BFD 38.1 理解策略路由 38.1.1 策略路由概述 策略路由 ( PBR :Policy-Based Routing )提供了一种比基于目的地址进行路由转发更加灵活的数据包路由转发机制。策略路由可以根据IP/IPv6 报文源地址、目的地址、端口、报文长度等内容灵活地进行路由选择。 现有用户网络,常常会出现使用到多个ISP ( Internet Server Provider ,Internet 服务提供商)资源的情形,不同ISP 申请到的带宽不一;同时,同一用户环境中需要对重点用户资源保证等目的,对这部分用户不能够再依据普通路由表进行转发,需要有选择的进行数据报文的转发控制,因此,策略路由技术即能够保证ISP 资源的充分利用,又能够很好的满足这种灵活、多样的应用。 IP/IPv6 策略路由只会对接口接收的报文进行策略路由,而对于从该接口转发出去的报文不受策略路由的控制;一个接口应用策略路由后,将对该接口接收到的所有包进行检查,不符合路由图任何策略的数据包将按照普通的路由转发 进行处理,符合路由图中某个策略的数据包就按照该策略中定义的操作进行转发。 一般情况下,策略路由的优先级高于普通路由,能够对IP/IPv6 报文依据定义的策略转发;即数据报文先按照IP/IPv6 策略路由进行转发,如果没有匹配任意一个的策略路由条件,那么再按照普通路由进行转发。用户也可以配置策略 路由的优先级比普通路由低,接口上收到的IP/IPv6 报文则先进行普通路由的转发,如果无法匹配普通路由,再进 行策略路由转发。 用户可以根据实际情况配置设备转发模式,如选择负载均衡或者冗余备份模式,前者设置的多个下一跳会进行负载均衡,还可以设定负载分担的比重;后者是应用多个下一跳处于冗余模式,即前面优先生效,只有前面的下一跳无效 时,后面次优的下一跳才会生效。用户可以同时配置多个下一跳信息。 策略路由可以分为两种类型:一、对接口收到的IP 报文进行策略路由。该类型的策略路由只会对从接口接收的报 文进行策略路由,而对于从该接口转发出去的报文不受策略路由的控制; 二、对本设备发出的IP 报文进行策略路由。该类型策略路由用于控制本机发往其它设备的IP 报文,对于外部设备 发送给本机的IP 报文则不受该策略路由控制。 38.1.2 策略路由基本概念/特性 38.1.2.1 策略路由应用过程 应用策略路由,必须先创建路由图,然后在接口上应用该路由图。一个路由图由很多条策略组成,每条策略都有对应的序号( Sequence ),序号越小,该条策略的优先级越高。 每条策略又由一条或者多条match 语句以及对应的一条或者多条set 语句组成。match 语句定义了IP/IPv6 报文的匹配规则,set 语句定义了对符合匹配规则的IP/IPv6 报文处理动作。在策略路由转发过程,报文依优先级从高到底依次匹配,只要匹配前面的策略,就执行该策略对应的动作,然后退出策略路由的执行。

搜索引擎分类及工作原理修订稿

搜索引擎分类及工作原 理 WEIHUA system office room 【WEIHUA 16H-WEIHUA WEIHUA8Q8-

搜索引擎的分类及工作原理 姓名:XXX 班级:XXX 摘要:这篇论文是关于搜索引擎的分类及原理的分析。在浩瀚的网络资源中,搜索引擎(Search Engine)是一种网上信息检索工具,它能帮助用户迅速而全面地找到所需要的信息。它是一个集中了千千万万个站点的地方,主要功能是给人们搜索这些站点。它还会分门别类的把一些好的站点列出来,以方便人们查找资料,有了搜索引擎你就能很容易的找到你想要的内容或站点,因此掌握好使用搜索引擎对于任何上网的用户至关重要。一个好的搜索引擎,不仅数据库容量要大,更新频率、检索速度要快,支持对多语言的搜索,而且随着数据库容量的不断膨胀,还要能从庞大的资料库中精确地找到正确的资料。 关键词:搜索引擎工作原理分类蜘蛛搜集网站 1.前言 获得网站网页资料,能够建立数据库并提供查询的系统,我们都可以把它叫做搜索引擎。搜索引擎并不真正搜索互联网,它搜索的实际上是预先整理好的网页索引数据库。真正意义上的搜索引擎,通常指的是收集了因特网上几千万到几十亿个网页并对网页中的每一个词(即关键词)进行索引,建立索引数据库的全文搜索引擎。 当用户查找某个关键词的时候,所有在页面内容中包含了该关键词的网页都将作为搜索结果被搜出来。在经过复杂的算法进行排序后,这些结果将按照与搜索关键词的相关度高低,依次排列。 2.搜索引擎分类

搜索引擎按其工作方式主要可分为三种,分别是全文搜索引擎(Full Text Search Engine)、目录索引类搜索引擎(Search Index/Directory)和元搜索引擎(Meta Search Engine)。 全文搜索引擎 全文搜索引擎是从网站提取信息建立网页数据库。搜索引擎的自动信息搜集功能分两种。一种是定期搜索,即每隔一段时间搜索引擎主动派出“蜘蛛”程序,对一定IP地址范围内的互联网站进行检索,一旦发现新的网站,它会自动提取网站的信息和网址加入自己的数据库。 另一种是提交网站搜索,即网站拥有者主动向搜索引擎提交网址,它在一定时间内(2天到数月不等)定向向你的网站派出“蜘蛛”程序,扫描你的网站并将有关信息存入数据库,以备用户查询。由于近年来搜索引擎索引规则发生了很大变化,主动提交网址并不保证你的网站能进入搜索引擎数据库,因此目前最好的办法是多获得一些外部链接,让搜索引擎有更多机会找到你并自动将你的网站收录。 当用户以关键词查找信息时,搜索引擎会在数据库中进行搜寻,如果找到与用户要求内容相符的网站,便采用特殊的算法——通常根据网页中关键词的匹配程度,出现的位置/频次,链接质量等——计算出各网页的相关度及排名等级,然后根据关联度高低,按顺序将这些网页链接返回给用户。 目录索引 首先,搜索引擎属于自动网站检索,而目录索引则完全依赖手工操作。用户提交网站后,目录编辑人员会亲自浏览你的网站,然后根据一套自定的评判标准甚至编辑人员的主观印象,决定是否接纳你的网站。

搜索引擎的工作原理大致可以分为

搜索引擎的工作原理大致可以分为: 1、搜集信息:搜索引擎的信息搜集基本都是自动的。搜索引擎利用称为网络蜘蛛(spider)的自动搜索机器人程序来连上每一个网页上的超连结。机器人程序根据网页链到其他中的超链接,就象日常生活中所说的“一传十,十传百……”一样,从少数几个网页开始,连到数据库上所有到其他网页的链接。理论上,若网页上有适当的超连结,机器人便可以遍历绝大部分网页。 2、整理信息:搜索引擎整理信息的过程称为“建立索引”。搜索引擎不仅要保存搜集起来的信息,还要将它们按照一定的规则进行编排。这样,搜索引擎根本不用重新翻查它所有保存的信息而迅速找到所要的资料。想象一下,如果信息是不按任何规则地随意堆放在搜索引擎的数据库中,那么它每次找资料都得把整个资料库完全翻查一遍,如此一来再快的计算机系统也没有用。 3、接受查询:用户向搜索引擎发出查询,搜索引擎接受查询并向用户返回资料。搜索引擎每时每刻都要接到来自大量用户的几乎是同时发出的查询,它按照每个用户的要求检查自己的索引,在极短时间内找到用户需要的资料,并返回给用户。目前,搜索引擎返回主要是以网页链接的形式提供的,这些通过这些链接,用户便能到达含有自己所需资料的网页。通常搜索引擎会在这些链接下提供一小段来自这些网页的摘要信息以帮助用户判断此网页是否含有自己需要的内容。 以上是在百度搜索的结果。 下面谈一下我个人对FTP搜索的见解。 首先是第一步,搜集信息。每隔一段时间,派出“蜘蛛”程序。(我想这里的蜘蛛程序跟网页搜索引擎的“蜘蛛”程序是有所区别的。网页搜索引擎的“蜘蛛”程序是指自动访问互联网,并沿着任何网页中的所有URL爬到其它网页,不断重复这过程,并把爬过的所有网页收集回来的程序。而这里的“蜘蛛”程序,我猜是在某一个时刻,利用文件系统方面的类方法,自动历遍所有的已知的校内FTP站点的文件夹,然后把每一个文件的名字、大小、类型、地址、路径等相关信息收集回来的程序。) 第二步,整理信息。“蜘蛛”程序搜集回来的信息,输入数据库,这样的话,用户要查询的文件可以很快地得出,并且用户可以不必按照文件的名字来查询,以类型、大小等查询也是可以的,同时在给出查询结果的时候,可以按照大小、日期等来排序。 第三步,接受查询。用户登陆一个门户网站,就像北大天网那样,在搜索框里填入关键词,查询的类型,是否模糊查找等,这个页面就可以会把表单的内容传到服务器上、查询数据库,然后返回查询结果。还有支持用链接的方式,点击分类,然后可以浏览这个方面的信息,如下载排行、推荐下载等。 关于疑问方面,就是那个PNG图的构架不是很清楚,sniffer跟spider是什么关系呢? 还有一个就是ipv6的问题,人大内不是有个ipv6的ftp吗?查询结果要标注是ipv6吗?

搜索引擎工作原理三个阶段简介

SEO实战密码:搜索引擎工作原理三个阶段简介 搜索引擎工作过程非常复杂,接下来的几节我们简单介绍搜索引擎是怎样实现网页排名的。这里介绍的内容相对于真正的搜索引擎技术来说只是皮毛,不过对SEO人员已经足够用了。 搜索引擎的工作过程大体上可以分成三个阶段。 (1)爬行和抓取:搜索引擎蜘蛛通过跟踪链接访问网页,获得页面HTML代码存入数据库。 (2)预处理:索引程序对抓取来的页面数据进行文字提取、中文分词、索引等处理,以备排名程序调用。 (3)排名:用户输入关键词后,排名程序调用索引库数据,计算相关性,然后按一定格式生成搜索结果页面。 爬行和抓取 爬行和抓取是搜索引擎工作的第一步,完成数据收集的任务。 1.蜘蛛 搜索引擎用来爬行和访问页面的程序被称为蜘蛛(spider),也称为机器人(bot)。 搜索引擎蜘蛛访问网站页面时类似于普通用户使用的浏览器。蜘蛛程序发出页面访问请求后,服务器返回HTML代码,蜘蛛程序把收到的代码存入原始页面数据库。搜索引擎为了提高爬行和抓取速度,都使用多个蜘蛛并发分布爬行。 蜘蛛访问任何一个网站时,都会先访问网站根目录下的robots.txt文件。如果robots.txt文件禁止搜索引擎抓取某些文件或目录,蜘蛛将遵守协议,不抓取被禁止的网址。 和浏览器一样,搜索引擎蜘蛛也有标明自己身份的代理名称,站长可以在日志文件中看到搜索引擎的特定代理名称,从而辨识搜索引擎蜘蛛。下面列出常见的搜索引擎蜘蛛名称:· Baiduspider+(+https://www.360docs.net/doc/374856432.html,/search/spider.htm)百度蜘蛛 · Mozilla/5.0 (compatible; Yahoo! Slurp China; https://www.360docs.net/doc/374856432.html,/help.html)雅虎中国蜘蛛 · Mozilla/5.0 (compatible; Yahoo! Slurp/3.0; https://www.360docs.net/doc/374856432.html,/help/us/ysearch/slurp)英文雅虎蜘蛛 · Mozilla/5.0 (compatible; Googlebot/2.1; +https://www.360docs.net/doc/374856432.html,/bot.html)Google蜘蛛 · msnbot/1.1 (+https://www.360docs.net/doc/374856432.html,/msnbot.htm)微软 Bing蜘蛛 · Sogou+web+robot+(+https://www.360docs.net/doc/374856432.html,/docs/help/webmasters.htm#07)搜狗蜘蛛 · Sosospider+(+https://www.360docs.net/doc/374856432.html,/webspider.htm)搜搜蜘蛛 · Mozilla/5.0 (compatible; YodaoBot/1.0;