常见非空闲等待事件:影响性能-性能优化

一些常见的非空闲等待事件有:

.. db file scattered read

.. db file sequential read

.. buffer busy waits

.. free buffer waits

.. enqueue

.. latch free

.. log file parallel write

.. log file sync

下面结合AWR和statspack中的一些等待事件进行讲述。--收集整理--

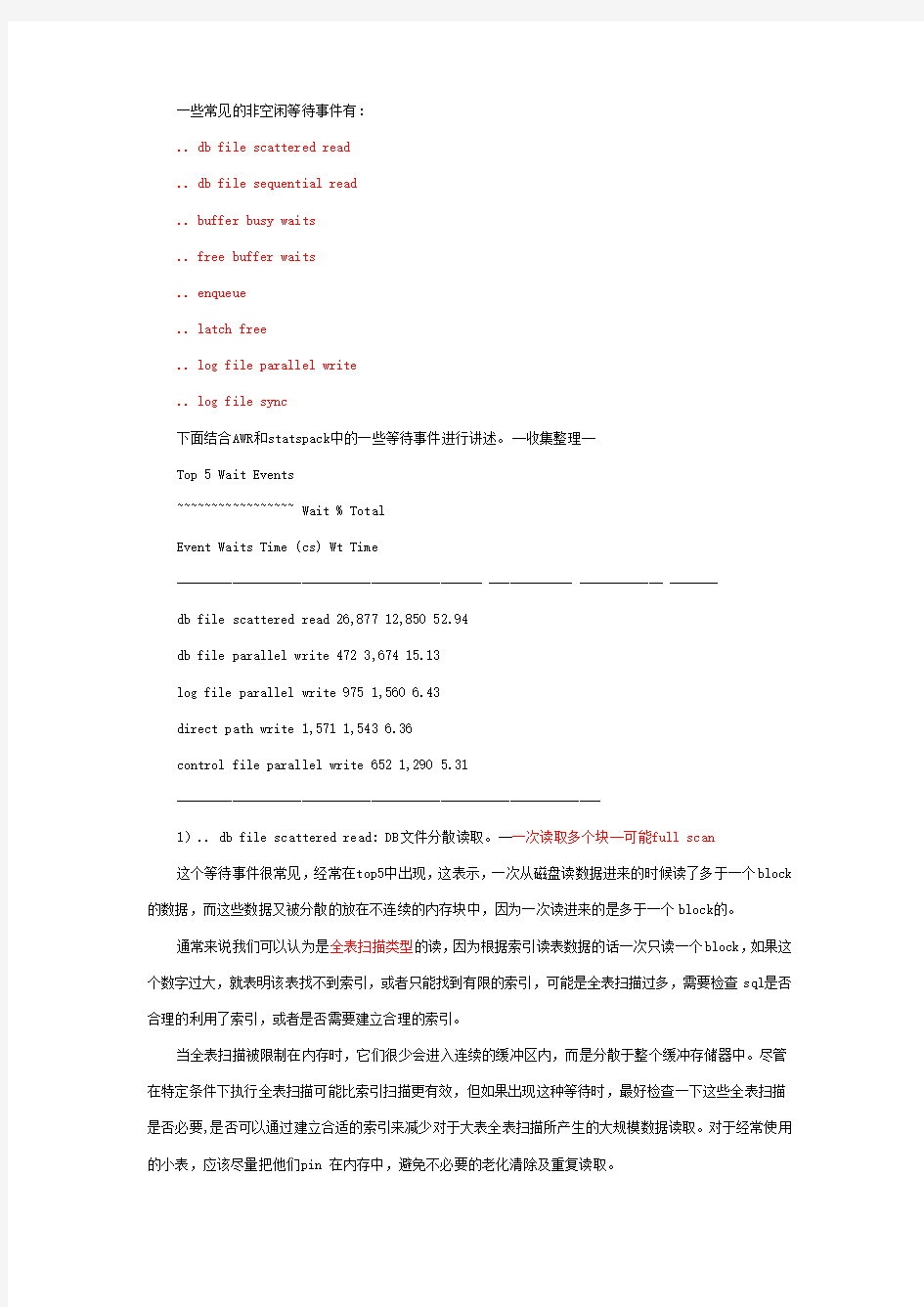

Top 5 Wait Events

~~~~~~~~~~~~~~~~~ Wait % Total

Event Waits Time (cs) Wt Time

-------------------------------------------- ------------ ------------ -------

db file scattered read 26,877 12,850 52.94

db file parallel write 472 3,674 15.13

log file parallel write 975 1,560 6.43

direct path write 1,571 1,543 6.36

control file parallel write 652 1,290 5.31

-------------------------------------------------------------

1).. db file scattered read: DB文件分散读取。--一次读取多个块--可能full scan

这个等待事件很常见,经常在top5中出现,这表示,一次从磁盘读数据进来的时候读了多于一个block 的数据,而这些数据又被分散的放在不连续的内存块中,因为一次读进来的是多于一个block的。

通常来说我们可以认为是全表扫描类型的读,因为根据索引读表数据的话一次只读一个block,如果这个数字过大,就表明该表找不到索引,或者只能找到有限的索引,可能是全表扫描过多,需要检查sql是否合理的利用了索引,或者是否需要建立合理的索引。

当全表扫描被限制在内存时,它们很少会进入连续的缓冲区内,而是分散于整个缓冲存储器中。尽管在特定条件下执行全表扫描可能比索引扫描更有效,但如果出现这种等待时,最好检查一下这些全表扫描是否必要,是否可以通过建立合适的索引来减少对于大表全表扫描所产生的大规模数据读取。对于经常使用的小表,应该尽量把他们pin 在内存中,避免不必要的老化清除及重复读取。

2).. db file sequential read: DB文件连续读取。--一次读取一块,单块,可能表的连接顺序不好,索引使用不好。--sql优化

通常显示单个块的读取(通常指索引读取),表示的是读进磁盘的block被放在连续的内存块中。事实上大部分基本代表着单个block的读入,可以说象征着 IO 或者说通过索引读入的比较多。因为一次IO若读进多个的block,放入连续的内存块的几率是很小的,分布在不同block的大量记录被读入就会遇到此事件。因为根据索引读数据的话,假设100条记录,根据索引,不算索引本身的读,而根据索引每个值去读一下表数据,理论上最多可能产生100 buffer gets,而如果是full table scan,则100条数据完全可能在一个block 里面,则几乎一次就读过这个block了,就会产生这么大的差异。这种等待的数目很多时,可能显示表的连接顺序不佳,或者不加选择地进行索引。

对于高级事务处理(high-transaction)、调整良好(welltuned)的系统,这一数值很大是很正常的,但在某些情况下,它可能暗示着系统中存在问题。你应当将这一等待统计量与Statspack 报告中的已知问题(如效率较低的SQL)联系起来。检查索引扫描,以保证每个扫描都是必要的,并检查多表连接的连接顺序。DB_CACHE_SIZE 也是这些等待出现频率的决定因素。有问题的散列区域(Hash-area)连接应当出现在PGA 内存中,但它们也会消耗大量内存,从而在顺序读取时导致大量等待。它们也可能以直接路径读/写等待的形式出现。

表明有许多索引读取:调优代码(特别是连接)

3).. Free Buffer Wait: 释放缓冲区。

这种等待表明系统正在等待内存中的缓冲,因为内存中已经没有可用的缓冲空间了。如果所有SQL 都得到了调优,这种等待可能表示你需要增大DB_BUFFER_CACHE。释放缓冲区等待也可能表示不加选择的SQL 导致数据溢出了带有索引块的缓冲存储器,没有为等待系统处理的特定语句留有缓冲区。这种情况通常表示正在执行相当多数量的DML(插入/更新/删除),并且可能说明DBWR 写的速度不够快,缓冲存储器可能充满了相同缓冲器的多个版本,从而导致效率非常低。为了解决这个问题,可能需要考虑增加检查点、利用更多的DBWR 进程,或者增加物理磁盘的数量。

4).. Buffer Busy Wait: 缓冲区忙。

该等待事件表示正在等待一个以unshareable方式使用的缓冲区,或者表示当前正在被读入buffer cache。也就是当进程想获取或者操作某个block的时候却发现被别的进程在使用而出现等待。一般来说Buffer Busy Wait不应大于1%。检查缓冲等待统计部分(或V$WAITSTAT),看一下等待是否位于段头。如

果是,可以考虑增加自由列表(freelist,对于Oracle8i DMT)或者增加freelist groups.其修改语法为:SQL> alter table sp_item storage (freelists 2);

对于Oracle8i而言,增加freelist参数,在很多时候可以明显缓解等待,如果使用LMT,也就是 Local Manangement Tablespace,区段的管理就相对简单。还可以考虑修改数据块的pctusedpctfree值,比如增大pctfree可以扩大数据的分布,在某种程度上就可以减少热点块的竞争。如果这一等待位于undo header,可以通过增加回滚段(rollback segment)来解决缓冲区的问题。如果等待位于undo block上,我们可能需要检查相关应用,适当减少大规模的一致性读取,或者降低一致性读取(consistent read)的表中的数据密度或者增大DB_CACHE_SIZE。如果等待处于data block,可以考虑将频繁并发访问的表或数据移到另一数据块或者进行更大范围的分布(可以增加pctfree 值,扩大数据分布,减少竞争),以避开这个"热点"数据块,或者可以考虑增加表中的自由列表或使用本地化管理的表空间(Locally Managed Tablespaces)。如果等待处于索引块,应该考虑重建索引、分割索引或使用反向键索引。反向键索引在很多情况下,可以极大地缓解竞争,其原理有点类似于hash分区的功效。反向键索引(reverse key index)常建在一些值是连续增长的列上,例如列中的值是由sequence产生的。为了防止与数据块相关的缓冲忙等待,也可以使用较小的块:在这种情况下,单个块中的记录就较少,所以这个块就不是那么"繁忙";或者可以设置更大的pctfree,使数据扩大物理分布,减少记录间的热点竞争。在执行DML (insert/update/ delete)时,Oracle 向数据块中写入信息,对于多事务并发访问的数据表,关于ITL的竞争和等待可能出现,为了减少这个等待,可以增加initrans,使用多个ITL槽。

从本质上讲,这个等待事件的产生仅说明了一个会话在等待一个Buffer(数据块),但是导致这个现象的原因却有很多种。常见的两种是:

当一个会话视图修改一个数据块,但这个数据块正在被另一个会话修改时。

当一个会话需要读取一个数据块,但这个数据块正在被另一个会话读取到内存中时。

Oracle 操作的最小单位是块(Block),即使你要修改一条记录,也需要对这条记录所在的这个数据块做操作。当你对这个数据块做修改时,其他的会话将被阻止对这个数据块上的数据做修改(即使其他用户修改的不是当前用户修改的数据),但是可以以一致性的方式读取这个数据块(from undo)。当前的用户修改完这个数据块后,将会立即释放掉加在这个数据块上的排他锁,这样另一个会话就可以继续修改它。修改操作是一个非常短暂的时间,这种加锁的机制我们叫Latch。

当一个会话修改一个数据块时,是按照以下步骤来完成的:

以排他的方式获得这个数据块(Latch)

修改这个数据块。

释放Latch。

Buffer busy waits等待事件常见于数据库中存在的热快的时候,当多个用户频繁地读取或者修改同样的数据块时,这个等待事件就会产生。如果等待的时间很长,我们在AWR或者statspack 报告中就可以看到。

这个等待事件有三个参数。查看有几个参数我们可以用以下SQL:

SQL> select name, parameter1, parameter2, parameter3 from v$event_name where name=''buffer busy waits'';

NAME PARAMETER1 PARAMETER2 PARAMETER3

-------------------- ---------- ---------- ----------

buffer busy waits file# block# class#

在下面的示例中,查询的方法和这个一样,所以其他事件对参数的查询将不做过多的说明。

File#: 等待访问数据块所在的文件id号。

Blocks:等待访问的数据块号。

ID:在10g之前,这个值表示一个等待时间的原因,10g之后则表示等待事件的类别。

5).. latch free: latch释放

latch 是一种低级排队机制,用于保护SGA 中共享内存结构。

latch就像是一种快速地被获取和释放的内存锁。latch用于防止共享内存结构被多个用户同时访问。如果latch不可用,就会记录latch释放失败(latch free miss)。

有两种与闩有关的类型:立刻和可以等待。

假如一个进程试图在立刻模式下获得闩,而该闩已经被另外一个进程所持有,如果该闩不能立刻可用的话,那么该进程就不会为获得该闩而等待。它将继续执行另一个操作。

大多数latch 问题都与以下操作相关:

没有很好的是用绑定变量(library cache latch)、重作生成问题(redo allocation latch)、缓

冲存储器竞争问题(cache buffers LRU chain),以及buffer cache中的存在"热点"块(cache buffers chain)。通常我们说,如果想设计一个失败的系统,不考虑绑定变量,这一个条件就够了,对于异构性极强的系统,不使用绑定变量的后果是极其严重的。另外也有一些latch 等待与bug 有关,应当关注Metalink 相关bug 的公布及补丁的发布。当latch miss ratios大于0.5%时,就应当研究这一问题。Oracle 的 latch 机制是竞争,其处理类似于网络里的CSMA/CD,所有用户进程争夺latch,对于愿意等待类型(willing-to-wait)

的latch,如果一个进程在第一次尝试中没有获得latch,那么它会等待并且再尝试一次,如果经过

_spin_count 次争夺不能获得latch, 然后该进程转入睡眠状态,持续一段指定长度的时间,然后再次醒来,按顺序重复以前的步骤.在8i/9i 中默认值是 _spin_count=2000。如果SQL语句不能调整,在8.1.6版本以上,Oracle提供了一个新的初始化参数: CURSOR_SHARING,可以通过设置CURSOR_SHARING = force 在服务器端强制绑定变量。设置该参数可能会带来一定的副作用,对于Java的程序,有相关的bug,具体应用应该关注Metalink的bug公告。

6).. enqueue

enqueue 是一种保护共享资源的锁定机制。该锁定机制保护共享资源,如记录中的数据,以避免两个人在同一时间更新同一数据。enqueue 包括一个排队机制,即FIFO(先进先出)排队机制。Enqueue 等待常见的有ST、HW 、TX 、TM 等。ST enqueue 用于空间管理和字典管理的表空间(DMT)的分配。对于支持LMT 的版本,可以考虑使用本地管理表空间,对于Oracle8i,因为相关bug 不要把临时表空间设置为LMT. 或者考虑预分配一定数量的区。HW enqueue 指段的高水位标记相关等待;手动分配适当区段可以避免这一等待。TX 是最常见的enqueue 等待。TX enqueue 等待通常是以下三个问题之一产生的结果。第一个问题是唯一

索引中的重复索引,你需要执行提交(commit)/回滚(rollback)操作来释放enqueue。第二个问题是对

同一位图索引段的多次更新。因为单个位图段可能包含多个行地址(rowid),所以当多个用户试图更新同一段时,等待出现。直到提交或回滚, enqueue 释放。第三个问题,也是最可能发生的问题是多个用户同时更新同一个块。如果没有自由的ITL 槽,就会发生块级锁定。通过增大initrans 和/或maxtrans 以允许使用多个ITL 槽,或者增大表上的pctfree值,就可以很轻松地避免这种情况。TM enqueue 在DML 期间产生,以避免对受影响的对象使用DDL。如果有外键,一定要对它们进行索引,以避免这种常见的锁定问题。

7).. Log Buffer Space: 日志缓冲空间

当你将日志缓冲(log buffer)产生重做日志的速度比LGWR 的写出速度快,或者是当日志转换(log switch)太慢时,就会发生这种等待。为解决这个问题,可以增大日志文件的大小,或者增加日志缓冲器

的大小。另外一个可能的原因是磁盘I/O 存在瓶颈,可以考虑使用写入速度更快的磁盘。

8).. log file switch (archiving needed)

这个等待事件出现时通常是因为日志组循环写满以后,第一个日志归档尚未完成,出现该等待可能是IO 存在问题。

解决办法:

.. 可以考虑增大日志文件和增加日志组

.. 移动归档文件到快速磁盘

.. 调整log_archive_max_processes .

9).. log file switch (checkpoint incomplete): 日志切换(检查点未完成)

当你的日志组都写完以后,LGWR 试图写第一个log file,如果这时数据库没有完成写出记录在第一个log file 中的dirty 块时(例如第一个检查点未完成),该等待事件出现。该等待事件说明你的日志组过少或者日志文件过小。你可能需要增加你的日志组或日志文件大小。

10).. Log File Switch: 日志文件转换

所有的提交请求都需要等待"日志文件转换(必要的归档)"或"日志文件转换(chkpt.不完全)"。确保归档磁盘未满,并且速度不太慢。 DBWR 可能会因为输入/输出(I/O)操作而变得很慢。你可能需要增加更多或更大的重做日志,而且如果DBWxR 是问题症结所在的话,可能需要增加数据库书写器。

11).. log file sync: 日志文件同步

当一个用户提交或回滚数据时,LGWR 将session 会话的重做由redo buffer 写入到重做日志中。log file sync 必须等待这一过程成功完成(Oracle 通过写redo log file 保证commit 成功的数据不丢失),这个事件说明提交可能过于频繁,批量提交可以最大化LGWR 的效率,过分频繁的提交会引起LGWR频繁的激活,扩大了LGWR 的写代价。为了减少这种等待事件,可以尝试每次提交更多的记录。将重做日志置于较快的磁盘上,或者交替使用不同物理磁盘上的重做日志,以降低归档对LGWR的影响。对于软RAID,一般来说不要使用RAID 5,RAID5 对于频繁写入得系统会带来较大的性能损失,可以考虑使用文件系统直接输入/输出,或者使用裸设备(raw device),这样可以获得写入的性能提高。

12).. log file single write

该事件仅与写日志文件头块相关,通常发生在增加新的组成员和增进序列号时。头块写单个进行,因

为头块的部分信息是文件号,每个文件不同。更新日志文件头这个操作在后台完成,一般很少出现等待,无需太多关注。

13).. log file parallel write

从log buffer 写redo 记录到redo log 文件,主要指常规写操作(相对于log file sync)。

如果你的Log group 存在多个组成员,当flush log buffer 时,写操作是并行的,这时候此等待事件可能出现。尽管这个写操作并行处理,直到所有I/O 操作完成该写操作才会完成(如果你的磁盘支持异步IO 或者使用IO SLAVE,那么即使只有一个redo log file member,也有可能出现此等待)。这个参数和log file sync 时间相比较可以用来衡量log file 的写入成本。通常称为同步成本率。

14).. control file parallel write: 控制文件并行写

当server 进程更新所有控制文件时,这个事件可能出现。

如果等待很短,可以不用考虑。如果等待时间较长,检查存放控制文件的物理磁盘I/O 是否存在瓶颈。多个控制文件是完全相同的拷贝,用于镜像以提高安全性。对于业务系统,多个控制文件应该存放在不同的磁盘上,一般来说三个是足够的,如果只有两个物理硬盘,那么两个控制文件也是可以接受的。在同一个磁盘上保存多个控制文件是不具备实际意义的。减少这个等待,可以考虑如下方法:.. 减少控制文件的个数(在确保安全的前提下)

.. 如果系统支持,使用异步IO

.. 转移控制文件到IO 负担轻的物理磁盘

15).. control file sequential read/ control file single write

控制文件连续读/控制文件单个写。对单个控制文件I/O 存在问题时,这两个事件会出现。

如果等待比较明显,检查单个控制文件,看存放位置是否存在I/O 瓶颈。使用查询获得控制文件访问状态:

select P1 from V$SESSION_WAIT where EVENT like 'control file%' and STATE='WAITING';

解决办法:

.. 移动有问题的控制文件到快速磁盘

.. 如果系统支持,启用异步I/O

16).. direct path write: 直接路径写

该等待发生在,等待确认所有未完成的异步I/O 都已写入磁盘。你应该找到I/O 操作频繁的数据文件,

调整其性能。也有可能存在较多的磁盘排序,临时表空间操作频繁,可以考虑使用Local 管理表空间,分成多个小文件,写入不同磁盘或者裸设备。

17).. SQL*Net message from dblink

该等待通常指与分布式处理(从其他数据库中SELECT)有关的等待。这个事件在通过DBLINKS 联机访问其他数据库时产生。如果查找的数据多数是静态的,可以考虑移动这些数据到本地表并根据需要刷新,通过快照或者物化视图来减少跨数据库的访问,会在性能上得到很大的提高。

18).. slave wait: 从属进程等

Slave Wait 是Slave I/O 进程等待请求,是一个空闲参数,一般不说明问题。

19)buffer latch

内存中数据块的存放位置是记录在一个hash列表(cache buffer chains)当中的。当一个会话需要访问某个数据块时,它首先要搜索这个hash 列表,从列表中获得数据块的地址,然后通过这个地址去访问需要的数据块,这个列表Oracle会使用一个latch来保护它的完整性。当一个会话需要访问这个列表时,需要获取一个Latch,只有这样,才能保证这个列表在这个会话的浏览当中不会发生变化。

产生buffer latch的等待事件的主要原因是:

Buffer chains太长,导致会话搜索这个列表花费的时间太长,使其他的会话处于等待状态。

同样的数据块被频繁访问,就是我们通常说的热快问题。

产生buffer chains太长,我们可以使用多个buffer pool的方式来创建更多的buffer chains,或者使用参数DB_BLOCK_LRU_LATCHES来增加latch的数量,以便于更多的会话可以获得latch,这两种方法可以同时使用。

这个等待事件有两个参数:

Latch addr:会话申请的latch在SGA中的虚拟地址,通过以下的SQL语句可以根据这个地址找到它对应的Latch名称:

select * from v$latch a,v$latchname b where

addr=latch addr -- 这里的latch addr 是你从等待事件中看到的值

and https://www.360docs.net/doc/42333825.html,tch#=https://www.360docs.net/doc/42333825.html,tch#;

chain#: buffer chains hash 列表中的索引值,当这个参数的值等于s 0xfffffff时,说明当前的会话正在等待一个LRU latch。

20) Control file parallel write

当数据库中有多个控制文件的拷贝时,Oracle 需要保证信息同步地写到各个控制文件当中,这是一个并行的物理操作过程,因为称为控制文件并行写,当发生这样的操作时,就会产生control file parallel write等待事件。

控制文件频繁写入的原因很多,比如:

日志切换太过频繁,导致控制文件信息相应地需要频繁更新。

系统I/O 出现瓶颈,导致所有I/O出现等待。

当系统出现日志切换过于频繁的情形时,可以考虑适当地增大日志文件的大小来降低日志切换频率。

当系统出现大量的control file parallel write 等待事件时,可以通过比如降低控制文件的拷贝数量,将控制文件的拷贝存放在不同的物理磁盘上的方式来缓解I/O 争用。

这个等待事件包含三个参数:

Files: Oracle 要写入的控制文件个数。

Blocks:写入控制文件的数据块数目。

Requests:写入控制请求的I/O 次数。

21). Control file sequential read

当数据库需要读取控制文件上的信息时,会出现这个等待事件,因为控制文件的信息是顺序写的,所以读取的时候也是顺序的,因此称为控制文件顺序读,它经常发生在以下情况:

备份控制文件

RAC 环境下不同实例之间控制文件的信息共享

读取控制文件的文件头信息

读取控制文件其他信息

这个等待事件有三个参数:

File#:要读取信息的控制文件的文件号。

Block#:读取控制文件信息的起始数据块号。

Blocks:需要读取的控制文件数据块数目。

22)Db file parallel read

这是一个很容易引起误导的等待事件,实际上这个等待事件和并行操作(比如并行查询,并行DML)没有关系。这个事件发生在数据库恢复的时候,当有一些数据块需要恢复的时候,Oracle会以并行的方式把他们从数据文件中读入到内存中进行恢复操作。

这个等待事件包含三个参数:

Files:操作需要读取的文件个数。

Blocks:操作需要读取的数据块个数。

Requests:操作需要执行的I/O次数。

23). Db file parallel write

这是一个后台等待事件,它同样和用户的并行操作没有关系,它是由后台进程DBWR产生的,当后台进程DBWR想磁盘上写入脏数据时,会发生这个等待。

DBWR会批量地将脏数据并行地写入到磁盘上相应的数据文件中,在这个批次作业完成之前,DBWR将出现这个等待事件。如果仅仅是这一个等待事件,对用户的操作并没有太大的影响,当伴随着出现free buffer waits等待事件时,说明此时内存中可用的空间不足,这时候会影响到用户的操作,比如影响到用户将脏数据块读入到内存中。

当出现db file parallel write等待事件时,可以通过启用操作系统的异步I/O的方式来缓解这个等待。当使用异步I/O时,DBWR不在需要一直等到所有数据块全部写入到磁盘上,它只需要等到这个数据写入到一个百分比之后,就可以继续进行后续的操作。

这个等待事件有两个参数:

Requests:操作需要执行的I/O次数。

Timeouts:等待的超时时间。

24)Db file single write

这个等待事件通常只发生在一种情况下,就是Oracle 更新数据文件头信息时(比如发生Checkpoint)。

当这个等待事件很明显时,需要考虑是不是数据库中的数据文件数量太大,导致Oracle 需要花较长的时间来做所有文件头的更新操作(checkpoint)。

这个等待事件有三个参数:

File#: 需要更新的数据块所在的数据文件的文件号。

Block#:需要更新的数据块号。

Blocks:需要更新的数据块数目(通常来说应该等于1)。

10. Direct path read

这个等待事件发生在会话将数据块直接读取到PGA当中而不是SGA中的情况,这些被读取的数据通常是这个会话私有的数据,所以不需要放到SGA作为共享数据,因为这样做没有意义。这些数据通常是来自与临时段上的数据,比如一个会话中SQL的排序数据,并行执行过程中间产生的数据,以及Hash Join,merge join产生的排序数据,因为这些数据只对当前的会话的SQL操作有意义,所以不需要放到SGA当中。

当发生direct path read等待事件时,意味着磁盘上有大量的临时数据产生,比如排序,并行执行等操作。或者意味着PGA中空闲空间不足。

这个等待事件有三个参数:

Descriptor address: 一个指针,指向当前会话正在等待的一个direct read I/O。

First dba: descriptor address 中最旧的一个I/O数据块地址。

Block cnt: descriptor address上下文中涉及的有效的buffer 数量。

11. Direct path write

这个等待事件和direct path read 正好相反,是会话将一些数据从PGA中直接写入到磁盘文件上,而不经过SGA。

这种情况通常发生在:

使用临时表空间排序(内存不足)

数据的直接加载(使用append方式加载数据)

并行DML操作。

这个等待事件有三个参数:

Descriptor address: 一个指针,指向当前会话正在等待的一个direct I/O.

First dba: descriptor address 中最旧的一个I/O数据块地址。

Block cnt: descriptor address 上下文中涉及的有效地 buffer 数量。

12. Enqueue

Enqueue 这个词其实是lock 的另一种描述语。

当我们在AWR 报告中发现长时间的enqueue 等待事件时,说明数据库中出现了阻塞和等待,可以关联AWR报告中的enqueue activity部分来确定是哪一种锁定出现了长时间等待。

这个等待事件有2个参数:

Name: enqueue 的名称和类型。

Mode: enqueue的模式。

可以使用如下SQL 查看当前会话等待的enqueue名称和类型:

/* Formatted on 2010/8/12 11:00:56 (QP5 v5.115.810.9015) */

SELECT CHR (TO_CHAR (BITAND (p1, -16777216)) / 16777215)

|| CHR (TO_CHAR (BITAND (p1, 16711680)) / 65535)

"Lock",

TO_CHAR (BITAND (p1, 65535)) "Mode"

FROM v$session_wait

WHERE event = ''enqueue''

Oracle 的enqueue 包含以下模式:

Oracle的enqueue 有如下类型:

Enqueue 缩写

缩写解释

BL Buffer Cache management

BR Backup/Restore

CF Controlfile transaction

CI Cross-instance Call Invocation

CU Bind Enqueue

DF Datafile

DL Direct Loader Index Creation

DM Database Mount

DR Distributed Recovery Process

DX Dirstributed Transaction

FP File Object

FS File Set

HW High-water Lock

IN Instance Number

IR Instance Recovery

IS Instance State

IV Library Cache Invalidation

JI Enqueue used during AJV snapshot refresh

JQ Job Queue

KK Redo Log “Kick”

KO Multiple Object Checkpoint

L[A-p] Library Cache Lock

LS Log start or switch

MM Mount Definition

MR Media recovery

N[A-Z] Library Cache bin

PE Alter system set parameter =value PF Password file

PI Parallel slaves

PR Process startup

PS Parallel slave synchronization

Q[A-Z] Row Cache

RO Object Reuse

RT Redo Thread

RW Row Wait

SC System Commit Number

SM SMON

SN Sequence Number

SQ Sequence Number Enqueue

SR Synchronized replication

SS Sort segment

ST Space management transaction

SV Sequence number Value

TA Transaction recovery

TC Thread Checkpoint

TE Extend Table

TM DML enqueue

TO Temporary Table Object Enqueue

TS Temporary Segement(also TableSpace)

TT Temporary Table

TX Transaction

UL User-defined Locks

UN User name

US Undo segment, Serialization

WL Being Written Redo Log

XA Instance Attribute Log

XI Instance Registration Lock

关于enqueue 可以参考如下的连接:Wait Events - Enqueue Waits

https://www.360docs.net/doc/42333825.html,/KNOWLEDGE/KnowledgeXpertforOracle/tabid/648/TopicID/WE1/Default.asp x

25)

Library cache lock

这个等待时间发生在不同用户在共享中由于并发操作同一个数据库对象导致的资源争用的时候,比如当一个用户正在对一个表做DDL 操作时,其他的用户如果要访问这张表,就会发生library cache lock等待事件,它要一直等到DDL操作完成后,才能继续操作。

这个事件包含四个参数:

Handle address: 被加载的对象的地址。

Lock address:锁的地址。

Mode:被加载对象的数据片段。

Namespace:被加载对象在v$db_object_cache 视图中namespace名称。

16. Library cache pin

这个等待事件和library cache lock 一样是发生在共享池中并发操作引起的事件。通常来讲,如果Oracle 要对一些PL/SQL 或者视图这样的对象做重新编译,需要将这些对象pin到共享池中。如果此时这个对象被其他的用户特有,就会产生一个library cache pin的等待。

这个等待事件也包含四个参数:

Handle address: 被加载的对象的地址。

Lock address:锁的地址。

Mode:被加载对象的数据片段。

Namespace:被加载对象在v$db_object_cache 视图中namespace名称。

17. Log file parallel write

后台进程LGWR 负责将log buffer当中的数据写到REDO 文件中,以重用log buffer的数据。如果每个REDO LOG组里面有2个以上的成员,那么LGWR进程会并行地将REDO 信息写入这些文件中。

如果数据库中出现这个等待事件的瓶颈,主要的原因可能是磁盘I/O性能不够或者REDO 文件的分布导致了I/O争用,比如同一个组的REDO 成员文件放在相同的磁盘上。

这个等待事件有三个参数:

Files:操作需要写入的文件个数。

Blocks:操作需要写入的数据块个数。

Requests:操作需要执行的I/O次数。

18. Log buffer space

当log buffer 中没有可用空间来存放新产生的redo log数据时,就会发生log buffer space等待事件。如果数据库中新产生的redo log的数量大于LGWR 写入到磁盘中的redo log 数量,必须等待LGWR 完成写入磁盘的操作,LGWR必须确保redo log写到磁盘成功之后,才能在redo buffer当中重用这部分信息。

如果数据库中出现大量的log buffer space等待事件,可以考虑如下方法:

(1)增加redo buffer的大小。

(2)提升磁盘的I/O性能

19. Log file sequential read

这个等待事件通常发生在对redo log信息进行读取时,比如在线redo 的归档操作,ARCH进程需要读取redo log的信息,由于redo log的信息是顺序写入的,所以在读取时也是按照顺序的方式来读取的。

这个等待事件包含三个参数:

Log#:发生等待时读取的redo log的sequence号。

Block#:读取的数据块号。

Blocks:读取的数据块个数。

20. Log file single write

这个等待事件发生在更新redo log文件的文件头时,当为日志组增加新的日志成员时或者redo log的sequence号改变时,LGWR 都会更新redo log文件头信息。

这个等待事件包含三个参数:

Log#:写入的redo log组的编号。

Block#:写入的数据块号。

Blocks:写入的数据块个数。

21. Log file switch(archiving needed)

在归档模式下,这个等待事件发生在在线日志切换(log file switch)时,需要切换的在线日志还没有被归档进程(ARCH)归档完毕的时候。当在线日志文件切换到下一个日志时,需要确保下一个日志文件已经被归档进程归档完毕,否则不允许覆盖那个在线日志信息(否则会导致归档日志信息不完整)。

出现这样的等待事件通常是由于某种原因导致ARCH 进程死掉,比如ARCH进程尝试向目的地写入一个归档文件,但是没有成功(介质失效或者其他原因),这时ARCH进程就会死掉。如果发生这种情况,在数据库的alert log文件中可以找到相关的错误信息。

这个等待事件没有参数。

22. Log file switch(checkpoint incomplete)

当一个在线日志切换到下一个在线日志时,必须保证要切换到的在线日志上的记录的信息(比如一些脏数据块产生的redo log)被写到磁盘上(checkpoint),这样做的原因是,如果一个在线日志文件的信息被覆盖,而依赖这些redo 信息做恢复的数据块尚未被写到磁盘上(checkpoint),此时系统down掉的话,Oracle将没有办法进行实例恢复。

在v$log 视图里记录了在线日志的状态。通常来说,在线日志有三种状态。

Active: 这个日志上面保护的信息还没有完成checkpoint。

Inactive:这个日志上面保护的信息已完成checkpoint。

Current:当前的日志。

Oracle 在做实例恢复时,会使用状态为current和Active的日志进行实例恢复。

如果系统中出现大量的log file switch(checkpoint incomplete)等待事件,原因可能是日志文件太小或者日志组太少,所以解决的方法是,增加日志文件的大小或者增加日志组的数量。

这个等待事件没有参数。

23. Log file sync

这是一个用户会话行为导致的等待事件,当一个会话发出一个commit命令时,LGWR进程会将这个事务产生的redo log从log buffer里面写到磁盘上,以确保用户提交的信息被安全地记录到数据库中。

会话发出的commit指令后,需要等待LGWR将这个事务产生的redo 成功写入到磁盘之后,才可以继续进行后续的操作,这个等待事件就叫作log file sync。

当系统中出现大量的log file sync等待事件时,应该检查数据库中是否有用户在做频繁的提交操作。

这种等待事件通常发生在OLTP系统上。 OLTP 系统中存在很多小的事务,如果这些事务频繁被提交,

可能引起大量的log file sync的等待事件。

这个等待事件包含一个参数:

Buffer#: redo buffer 中需要被写入到磁盘中的buffer。

24.SQL*Net more data to client"--非空闲等待

这说明数据库在向客户端发送数据,而且是"more",不停的发送,如果网络状况不好,或者网络流量过大,都可能导致这一等待非常显著。

客户的这个环境属于前者,由于通过公网访问,网络质量不够理想,出现了访问延迟的问题。

25.rdbms ipc reply事件的等待分类是other,不是User I/O类也不是System I/O类。

rdbms ipc reply应该是rdbms进程间通讯回复的意思吧,我理解进程通信回复慢应该是CPU出现瓶颈了。

web性能优化(服务器优化)

Web网站性能优化的相关技术 来源:站长网 https://www.360docs.net/doc/42333825.html, 2011-03-04 06:50:47 Web站点性能问题吸引或者迫使越来越多的人投入到这个问题的研究中来,产生了很多解决方案。下面是我根据自身的理解对这些技术进行了归类总结,如有不足之处欢迎拍砖。 一、提高服务器并发处理能力 我们总是希望一台服务器在单位时间内能处理的请求越多越好,这也成了web 服务器的能力高低的关键所在。服务器之所以可以同时处理多个请求,在于操作系统通过多执行流体系设计,使得多个任务可以轮流使用系统资源,这些资源包括CPU、内存以及I/O等。这就需要选择一个合适的并发策略来合理利用这些资源,从而提高服务器的并发处理能力。这些并发策略更多的应用在apache、nginx、lighttpd等底层web server软件中。 二、Web组件分离 这里所说的web组件是指web服务器提供的所有基于URL访问的资源,包括动态内容,静态网页,图片,样式表,脚本,视频等等。这些资源在文件大小,文件数量,内容更新频率,预计并发用户数,是否需要脚本解释器等方面有着很大的差异,对不同特性资源采用能充分发挥其潜力的优化策略,能极大的提高web 站点的性能。例如:将图片部署在独立的服务器上并为其分配独立的新域名,对静态网页使用epoll模型可以在大并发数情况下吞吐率保持稳定。 三、数据库性能优化和扩展。 Web服务器软件在数据库方面做的优化主要是减少访问数据库的次数,具体做法就是使用各种缓存方法。也可以从数据库本身入手提高其查询性能,这涉及到数据库性能优化方面的知识本文不作讨论。另外也可以通过主从复制,读写分离,使用反向代理,写操作分离等方式来扩展数据库规模,提升数据库服务能力。 四、Web负载均衡及相关技术 负载均衡是web站点规模水平扩展的一种手段,实现负载均衡的方法有好几种包括基于HTTP重定向的负载均衡,DNS负载均衡,反向代理负载均衡,四层负载均衡等等。 对这些负载均衡方法做简单的介绍:基于HTTP重定向的负载均衡利用了HTTP 重定向的请求转移和自动跳转功能来实现负载均衡,我们熟悉的镜像下载就使用这种负载均衡。DNS负载均衡是指在一个DNS服务器中为同一个主机名配置多个IP地址,在应答DNS查询时返回不同的解析结果将客户端的访问引到不同的机

网络优化解决方案

网优中心 针对多厂家交换数据的装置 基于数据仓库技术的元数据驱动设计及多维分析方法 基于 基于数据仓库多维分析方法的网络性能分析、指标( 网络运行性能、运行资源、运行收益及客户满意度的综合分析网络关键数据的自动发布、监控告警体系 网络容量、性能、负荷等运行趋势分析、预测 网络资源、负荷、话务等均衡优化 基于 用户自定义的多维报表体系 为网络的中高级领导层提供管理决策支持 为网络的综合监测、网络优化、网络规划提供服务

参数高速的跟踪分析,发现影响网络性能的关键参数及参数最优设置 运行参数与设计参数的对比分析,指导参数的设置和检查规划数据的合理性不同时期的参数对比分析,发现影响网络性能的关键参数及参数最优设置可视化、地理化的参数查询 运行参数自动合理性检查 适应网络体系结构的变化,可以进行基站割接、增加和删除等操作 根据不同的用户设置不同的权限 方便的网优维护日志管理 针对多厂家话务数据的装载 主要网元( 可由用户自定义的网络性能指标体系和计算公式 多维度的指标分析、追踪 异常网元的定位 网络性能指标的地理化分析 实时自动生成用户定义的动态报表体系 自动生成专业的分析报告 针对典型网络问题的专家分析 用户定义的网络性能监控与报警 针对单个或多个呼叫过程的跟踪、分析 失败事件的统计、跟踪和分析,根据失败信令点的无线环境和 小区无线指标分布分析( 小区无线统计报告 移动网络测试优化分析系统

带有数字化电子地图实时地理导航 测试和回放时所有窗口实时关联、互相对应测试时自动识别网络 广播信道 时隙测试功能 CQT

强制切换测试和锁频测试 可同时对移动 实时邻频干扰载干比测试 GSM 测试和回放时测试点与服务主小区实时连线 扫频支持: 支持 主叫自动拨号、被叫自动应答 CDD 地理化描述无线网络的各项测试参数 专题分析无线下行覆盖、干扰、切换等网络问题 话务数据的地理化观测 准确的双网关对比统计报告,用户可选的强大综合统计报告空闲 频率复用的地理化观测 利用高速扫频数据做信号传播及干扰分析 主小区的 六个邻小区信息 三层信令信息 信道和无线 SQI 网络参数信息( 信令事件实时显示和统计 采集事件实时显示和统计 GSM/DCS 协议支持 对于 连续信道场强扫频速度 设备尺寸长 移动网络室内测试系统

云计算平台最核心的五项技术

云计算平台最核心的五项技术 不知不觉间,一向以高大上形象示人的云计算也开始慢慢为普通人所熟知,那么今天我就在这里分析一下云计算平台最核心的五项技术: 1、云服务器 云服务器提供简单高效,处理能力可弹性伸缩的计算服务,支持国内领先的云计算技术和大规模分布存储技术,使您的系统更稳定、数据更安全、传输更快速、部署更灵活。 功能特点 机型丰富 通过高性能服务器虚拟化为云服务器,提供丰富配置类型虚拟机,极大简化数据存储、数据库搭建、web服务器搭建等工作; 仅需要几分钟,根据CPU、内存、数据存储空间和网络带宽等需求,或根据已经配置好的云服务器镜像,大批量生产iServer计算资源。 完全管理 快速搭建专属服务器,配置操作简单,轻松搭建专属您的各种应用; 提供直观可视化的管理页面,方便进行服务器日常管理; 对云服务器的操作系统有完全控制权,资源独享,无需配置,不限流量,省力省心。 弹性扩容 根据业务发展需求自选配置、期限,快速部署N多台云服务器业务,对计算资源及网络资源进行升降级操作,杜绝资源浪费; 5分钟内停机升级CPU和内存,在线不停机升级带宽; 云计算资源池弹性扩容、在线无缝升级。 安全防护 专业团队打造资源隔离、数据安全、密码安全、安全加固等多种安全防护手段; 采用安全级别最高的Raid10数据保护阵列,Vlan网络隔离技术,以及免费的系统安全配置,有效保护数据及网络安全。

优势 稳定 云磁盘数据可靠性不低于99.99% 服务可用性不低于99.95% 系统性能报警 安全 防DDoS系统、安全组规则保护 多用户隔离,防密码破解 提供备机、快照、数据备份等多种快速恢复措施 高性能 BGP骨干网络100MB接入 国内顶尖的硬件设备 良好的综合性能,优化的IO能力 2、云网站 云网站提供可伸缩、安全且灵活的 Web 应用程序运行空间,支持ASP、https://www.360docs.net/doc/42333825.html,、JAVA、PHP 等最新的 Web 技术。 功能特点 快捷建站 自己购买服务器到安装软件需要较长的时间,而使用虚拟主机只需要几分钟; 不必为使用和维护服务器的技术问题担心,选择适合的虚拟主机,马上就可以开通。 自助管理 提供直观可视化的管理页面,方便进行日常管理;

服务器运维方案教学内容

服务器运维方案 为保官网的正常稳定运行,也为了更好的对服务器进行管理维护,特制定以下运维方案: 1.硬件系统管理 一、服务器运行稳定性 服务器在运往托管商处上架前,应对服务器的稳定性进行全面的测试,包括网站主程序的测试,网站数据库的测试,网站压力测试等多项内容,对服务器的运行稳定性进行检验,在硬件上特别是容易松动的地方进行检查加固。 服务器上架后,每天对服务器状态进行不间断的监控,每月对服务器出具一次安全检测报告,分析是否存在异常。 二、服务器性能 服务器的性能进行全面检测,特别是对服务器处理大批量数据的情况下的CPU的占用率,内存的占用率等进行查看,以确保服务器的性能。 三、服务器软硬兼容性 服务器需用windows sever自带的兼容性检查软件进行兼容性检查,列出兼容性及不兼容的硬件以备查看,特别是自行开发的程序是否有对硬件要求特别严格地方,需跟研发共同商议解决。 四、磁盘阵列等存储设备管理 如服务器有磁盘阵列,需对每块硬盘进行编号,并记录在案,对软件设置中的参数也要进行详细的记录,以备远程维护时指导机房人员进行远程操作。 五、机柜、电源、网线布局管理 1、服务器上架后,应对服务器进行拍照,确认各线路位置。 2、需对服务器的电源部分进行编号整理。 六、服务器安全 服务器上架前应对服务器各主要部件进行登记编号,如箱体可锁,应上锁,并加盖封条,对于可抽出部分,应详细记录编号。 七、服务器硬件巡检制度

每季度安排专人进入机房对服务器进行一次常规确认,包含服务器线路检查、服务器故障排除等。巡检完成后填写巡检登记表并留档备查。 八、托管机房的联系 应制作托管机房联系人表,对365天24*7内的机房人员、电话、手机登记在案。 2.网站运行管理 一、网站不间断运行稳定性监测 为了保证网站的稳定性及不间断性应对服务器异动情况进行检测,如服务器有异常可通过邮件或短信通知管理员。 每日对网站进行7*24小时流量及安全监控,分析出是否存在恶意攻击以及攻击来源,并对此进行安全处理,每月提交一次分析报告。 二、域名服务指向管理 为保持网站的稳定性,域名管理权限应该有专人统一持有,避免因域名服务指向原因引起的网站访问失效或访问错误的问题。 三、公司所属网站一级、二级、邮件服务器域名指向管理 公司域名的制订规则,公司域名制订后应由专人向域名持有人提供书面修改方案,域名持有人根据书面修改方案进行修改,修改并对书面文件进行备案,以防责任不清的情况发生。 四、域名DNS转向稳定性监控,DNS性能监控 公司注册域名因代理商不同,所以DNS转向服务器也不相同,在DNS转向服务器出现问题后应及时寻找解决途径,应对每个域名的DNS转向服务器提供者的联系方式进行备案,方便出现问题后的查找。 五、网站ICP注册管理,其它相关的注册管理 公司网站属营业性网站,并带有论坛BLOG系统等,应相通信管理局及新闻出版局等部门申请注册管理,并对非法内容进行监管,应有专人负责。

物流云平台的设计与功能

应跨界融合,而非单打独斗 物流云平台的设计与功能 一、物流云计算服务平台概念:? 物流云计算服务平台是面向各类物流企业、物流枢纽中心及各类综合型企业的物流部门等的完整解决方案,依靠大规模的云计算处理能力、标准的作业流程、灵活的业务覆盖、精确的环节控制、智能的决策支持及深入的信息共享来完成物流行业的各环节所需要的信息化要求。 我们把物流云计算服务平台划分为:物流公共信息平台、物流管理平台、物流园区管理平台三个部分。 这三个平台有各自适合的作用层面,物流公共信息平台针对的是客户服务层,他拥有强大的信息获取能力;物流管理平台针对的是用户作业层,他可以大幅度的提高物流及其相关企业的工作效率,甚至可以拓展出更大范围的业务领域;物流园区管理平台针对的是决策管理层,他可以帮助物流枢纽中心、物流园区等管理辖区内的入驻企业,帮助他们进行规划和布局。? 二、各部分功能:? 公共信息平台: ●首页?? 通过浏览网页首页快速获知物流相关新闻内容,物流行业相关资讯信息,同时对生产供应商新货品信息一目了然,相对应的可以知晓可提供的货品信息的显示需求。 ●服务提供??

注册用户能够在信息平台上发布货品信息,发布车辆服务信息,发布仓储服务信息,发布配送专线服务信息,发布园区商铺信息以及发布有货求车信息 ●会员注册 客户通过会员注册,可以成为登录公共信息系统并享有根据会员不同身份对应的服务。将会员注册分为个人会员注册和企业会员注册,并且在企业会员注册中按照企业类型更为详细的分类分为仓储企业,车辆企业,贸易企业。 ●在线交易?? 显示各物流服务类别的交易信息,同时显示和个人(企业)会员类别贴近的物流服务信息。在其中的会员购买信息中包括已接收的服务(已经有意购买,但并未正式成交),已接受的服务(已经购买并享有的服务),已发布的服务(会员企业发布可提供的服务信息)三个功能模块。 ●物流资讯?? 较为详细和全面的显示物流行业资讯信息以及物流热点新闻信息。 ●综合查询?? 多角度,多维度提供详细查询可提供物流服务的企业信息,可提供的货品信息,可提供物流服务的车辆信息,可提供物流服务的车辆信息以及可提供运输配送线路信息? 物流管理平台:? ●订单管理系统? 该系统可以接收客户下的订单,支持多种下单方式,包括电话、传真、Email、电子商务等多种接收方式。订单管理系统可以对订单进行

系统性能优化方案

系统性能优化方案 (第一章) 系统在用户使用一段时间后(1年以上),均存在系统性能(操作、查询、分析)逐渐下降趋势,有些用户的系统性能下降的速度非常快。同时随着目前我们对数据库分库技术的不断探讨,在实际用户的生产环境,现有系统在性能上的不断下降已经非常严重的影响了实际的用户使用,对我公司在行业用户内也带来了不利的影响。 通过对现有系统的跟踪分析与调整,我们对现有系统的性能主要总结了以下几个瓶颈: 1、数据库连接方式问题 古典C/S连接方式对数据库连接资源的争夺对DBServer带来了极大的压力。现代B/S连接方式虽然不同程度上缓解了连接资源的压力,但是由于没有进行数据库连接池的管理,在某种程度上,随着应用服务器的不断扩大和用户数量增加,连接的数量也会不断上升而无截止。 此问题在所有系统中存在。 2、系统应用方式(架构)问题(应用程序设计的优化) 在业务系统中,随着业务流程的不断增加,业务控制不断深入,分析统计、决策支持的需求不断提高,我们现有的业务流程处理没有针对现有的应用特点进行合理的应用结构设计,例如在‘订单、提油单’、‘单据、日报、帐务的处理’关系上,单纯的数据关系已经难以承载多元的业务应用需求。 3、数据库设计问题(指定类型SQL语句的优化)

目前在系统开发过程中,数据库设计由开发人员承担,由于缺乏专业的数据库设计角色、单个功能在整个系统中的定位模糊等原因,未对系统的数据库进行整体的分析与性能设计,仅仅实现了简单的数据存储与展示,随着用户数据量的不断增加,系统性能逐渐下降。 4、数据库管理与研究问题(数据存储、物理存储和逻辑存储的优化) 随着系统的不断增大,数据库管理员(DBA)的角色未建立,整个系统的数据库开发存在非常大的随意性,而且在数据库自身技术的研究、硬件配置的研究等方面未开展,导致系统硬件、系统软件两方面在数据库管理维护、研究上无充分认可、成熟的技术支持。 5、网络通信因素的问题 随着VPN应用技术的不断推广,在远程数据库应用技术上,我们在实际设计、开发上未充分的考虑网络因素,在数据传输量上的不断加大,传统的开发技术和设计方法已经无法承载新的业务应用需求。 针对以上问题,我们进行了以下几个方面的尝试: 1、修改应用技术模式 2、建立历史数据库 3、利用数据库索引技术 4、利用数据库分区技术 通过尝试效果明显,仅供参考!

无线网络优化方案.

无线网络优化方案 调整 AP 覆盖方向或天线角度 应用说明: 在设备的工程安装过程中,合理选择 AP 的位置,合理调整 AP 的覆盖方向或外置天线的角度,尽量减少覆盖盲点和同频干扰,改善信号覆盖质量。目标覆盖区域的信号覆盖强度目标 -65dBm~-70dBm。 信道规划 应用说明: 信道规划和功率调整将是 WLAN 网络的首要的、最先实施的优化方法。在实际的安装部署中, 通常一个 AP 的信号覆盖范围可能很大, 但为了提高覆盖信号质量以及接入密度,又必须部署相应数量的 AP ,造成 AP 的覆盖范围出现重叠, AP 之间互相可见。如果所有的 AP 都工作在相同信道,这些 AP 只能共享一个信道的频率资源,造成整个 WLAN 网络性能较低。 WLAN 协议本身提供了一些不重叠的物理信道,可以构建多个虚拟的独立的 WLAN 网络, 各个网络独立使用一个信道的带宽, 例如使用 2.4G 频段时可以使用 1、 6、 11三个非重叠信道构建 WLAN 网络。 同时信道规划调整需要考虑三维空间的信号覆盖情况,无论是水平方向还是垂直方向都要做到无线的蜂窝式覆盖,最大可能的避免同楼层和上下楼层间的同频干扰。 强烈推荐:802.11n 网络在实际部署时,无论是 2.4G 频段或 5G 频段,建议都采用20MHz 模式进行覆盖,以加强信道隔离与复用,提升 WLAN 网络整 体性能。 功率调整

应用说明: 信道规划和功率调整将是 WLAN 网络的首要的、最先实施的优化方法。完成信道规划就相当于完成了多个虚拟 WLAN 网络的构建。 AP 发射功率的调整需要逐个关注每个虚拟 WLAN 网络,通过调整同一信道的 AP 的发射功率, 降低这些 AP 之间的可见度, 加强相同信道频谱资源的复用, 提高 WLAN 网络的整体性能。 禁止弱信号终端接入 应用说明: 在 WLAN 网络中, 信号强度较弱的无线客户端, 虽然也可以接入到网络中,但是所能够获取的网络性能和服务质量要比信号强度较强的无线客户端差很多。如果弱信号的无线客户端在接入到 WLAN 网络的同时还在大量地下载数据,就会占用较多的信道资源,最终必然对其他的无线客户端造成很大的影响。 禁止弱信号客户端接入功能,通过配置允许接入的无线客户端的最小信号强度门限值,可以直接拒绝信号强度低于指定门限的无线客户端接入到 WLAN 网络中,减少弱信号客户端对其他无线客户端的影响,从而提升整个 WLAN 网络的应用效果。 对于信号强度比较弱的终端,或者距离比较远的终端,关闭低速率应用后可能会出现丢包现象。但是正常的室内覆盖,信号强度可以保证,所以要求在室内覆盖情况下此功能为必选项。 低速率用户限制,对于典型的“占着信道不使用的情况”进行限制,这个 数值建议在 -75到 -80,前提是要做好信号覆盖: 调整 Beacon 帧发送间隔 应用说明:

容器云平台监控架构设计及优化

容器云平台监控架构设计及优化

目录 1. 概述 (1) 2. 价值和意义 (1) 3. 监控方案选型 (1) 3.1 容器云监控方案有哪些 (1) 3.2 方案对比并确定 (3) 4. 基于prometheus的容器云平台监控架构设计 (4) 4.1 prometheus介绍 (4) 4.2 架构设计 (5) 4.3 监控点有哪些 (7) 4.4 重要组件介绍 (10) 4.5 数据可视化 (14) 4.6 高可用设计 (16) 4.7 性能优化与容量预估 (22)

1 概述 随着容器化的大力发展,容器云平台已经基本由Kubernetes作为统一的容器管理方案。当我们使用Kubernetes进行容器化管理时,传统监控工具如Zabbix无法对Kubernetes做到统一有效的全面监控,全面监控Kubernetes也就成为我们需要探索的问题。使用容器云监控,旨在全面监控Kubernetes集群、节点、服务、实例的统计数据,验证集群是否正常运行并创建相应告警。本章旨在于介绍容器云平台监控的架构设计及优化。 2 价值和意义 监控是运维体系中是非常重要的组成部分,通过监控可以实时掌握系统运行状态,对故障提前预警,以及历史状态的回放,还可以通过监控数据为系统的容量规划提供辅助决策,为系统性能优化提供真实的用户行为和体验。为容器云提供良好的监控环境是保证容器服务的高可靠性、高可用性和高性能的重要部分,通过对本章的学习,能够快速认识当前容器环境下都有哪些监控方案,并对主流的监控方案有一个系统的了解和认识。 3 监控方案选型 3.1 容器云监控方案有哪些 (1)Zabbix Zabbix是由Alexei Vladishev开源的分布式监控系统,支持多种采集方式和采集客户端,同时支持SNMP、IPMI、JMX、Telnet、SSH等多种协议,它将采集到的数据存放到数据库中,然后对其进行分析整理,如果符合告警规则,则触发相应的告警。 Zabbix核心组件主要是Agent和Server,其中Agent主要负责采集数据并通过主动或者被动的方式采集数据发送到Server/Proxy,除此之外,为了扩展监控项,Agent还支持执行自定义脚本。Server主要负责接

web服务器性能优化

web服务器性能优化 导读:本文web服务器性能优化,仅供参考,如果觉得很不错,欢迎点评和分享。 作为一种资源的组织和表达机制,Web已成为Internet最主要的信息传送媒介。因此Web的性能已经成为判断一个网站成功与否的一个重要评估标准。而Web服务器则是决定Web性能的重要环节。 Web服务器性能就是指一个Web服务器响应用户请求的能力。为了提高Web服务器的性能人们进行了诸多尝试,已经取得了可喜的成果。本文通过对前人研究结果的分析,提出了在具体应用环境中优化Web服务器的方法和策略。 Web服务器概述 Web系统在现在网络中广泛使用,而Web服务器则是Web系统的一个重要组成部分。完整的Web结构应包括:HTTP协议,Web 服务器,通用网关接口CGI、Web应用程序接口、Web浏览器。 Web服务器是指驻留在因特网上某种类型计算机的程序。它是在网络中信息提供者基干HTTP的为实现信息发布、资料查询、数据处理等诸多应用搭建基本平台的服务器,其主要功能是提供网上信息浏览服务。当Web浏览器(客户端)连到服务器并请求文件时,服务器将处理该请求并将文件发送到该浏览器上,附带的信息会告诉浏览器如何查看该文件(即文件类型)。

Web服务器在web页面处理中大致可分为三个步骤:第一步,web浏览器向一个特定的服务器发出Web页面请求;第二步,Web 服务器接收到web页面请求后,寻找所请求的web页面,并将所请求的Web页面传送给Web浏览器;第三步,Web服务器接收到所请求的web页面,并将它显示出来。 web服务器不仅能够存储信息,还能在用户通过Web浏览器提供的信息的基础上运行脚本和程序。在Web上,常见的大多数表单核搜索引擎上都是用的是CGI脚本。 影响web应用服务器性能的因素 Web服务器的性能就是指一个Web服务器响应用户请求的能力,服务器的性能对于一个Web系统来说至关重要。为了提高Web 服务器的性能人们进行了许多尝试,也采用了许多技术和方法,但是这些技术和方法往往缺乏适用性。 通过对前人的研究分析可以发现,在web服务器的优化方而存在这种问题的原因主要有两个:一方面是服务器性能评测造成的,一方面是选用优化方案时考虑不全面造成的。 现行的服务器性能评测工具在对Web服务器进行评测时,其实是由一台或几台计算机模拟客户机,与被测的Web服务器进行通信,它们其实组成的只是一个局域网的环境,这与真正的广域网的环境有一定的差别。 另外,评测工具在选择网络负载时,虽然已经尽可能的接近真实负载,但是与持续的高频率负载要求仍有差距;再者,在性能测试指

医院信息系统软硬件性能优化方案

目录 [背景] (2) [目标] (2) [性能分析] (2) [优化内容和步骤] (2) [结果检验和日常核查] (4) [注明] (4)

[背景] 随着医院业务量的增长和所使用信息系统模块的增加,数据库容量增长很快,三级医院保留半年的数据情况下,可以达到25G-30G,且使用模块和接口的数量也在增加,现象是速度明显放慢,操作人员使用不顺畅,影响了窗口正常工作,带来软件性能低下的评价。 硬件方案设计时要考虑承载能力和生命周期;对性能问题的考虑应贯穿于开发阶段的全过程,不应只在出现问题时才考虑性能问题。 [目标] 性能调节的目的是通过将网络流通、磁盘I/O 和CPU 时间减到最小,使每个查询的响应时间最短并最大限度地提高整个数据库服务器的吞吐量。 最终通过对性能分析,制定相应的编程规范,引导开发工作,提高产品质量。 [性能分析] 分析对象: 一、服务器 1、处理器:峰值在85%以下 2、缓存、内存:达到一个稳定值 3、磁盘:检测磁盘错误信息和磁盘空间大小(!!) 4、网络:跟踪网络流量 二、数据库 三、应用程序 分析手段方式: 1、性能跟踪器:发现服务器性能瓶颈 2、检查数据库(使用dbcc工具):是否是数据库对象错误引起 3、SQL SERVER Profiler:跟踪软件后台脚本性能,通过统计分析语句问题 4、主业务程序单元运行调试 5、其他跟踪分析工具 [优化内容和步骤] 一、硬件配置 1、硬件性能降低原因 (1)资源不足,并且需要附加或升级的组件;局部硬件存在瓶颈 (2)资源共享工作负载不平均,需要平衡。 (3)资源出现故障,需要替换。 (4)资源不正确,需要更改配置设置。 2、解决办法(升级的量级待定?) (1)服务器升级硬件配置或增加服务器,更改软件配置 (2)升级网络设备,或更改逻辑结构

网络性能优化

网络性能优化总结 网络性能优化的目的是减少网络系统的瓶颈、设法提高网络系统的运行效率。对于不同的网络硬件环境和软件环境,可以存在不同的优化方法和内容。例如,在一个配置比较落后而又需要提供各种新服务的网络中,管理员往往需要对内存、CPU、磁盘、网络接口和服务器等分别进行优化处理,以便适应新的网络运行要求。但是,在一个网络服务比较少而硬件配置比较高的网络中,管理员不需要考虑整个网络的性能问题,只要利用一些性能和网络监视工具对系统进行监视,然后对发现的问题进行专项处理即可。下面对网络性能优化过程中的重要内容分别进行介绍。 7.2.1 内存优化 内存是操作系统中的重要资源,不仅操作系统的运行需要它,而且各种应用程序和服务都需要调用它才能使用。从应用的角度来看,系统内存是引起各种系统问题的重要原因,是需要用户和管理员着重考虑的优化对象。 1. 合理使用内存 在内存一定的情况下,合理地使用内存可以提高网络的性能。这要求管理员必须对系统中的内存使用情况非常了解,对于那些不再需要的功能、应用程序或服务应及时关闭,以便释放内存给其他应用程序和服务。另外,管理员还可以通过系统设置来决定内存的主要优化对象。一般,服务器的主要优化对象应该是后台服务,而工作站和单个计算机的主要优化对象应该是前台应用程序。 要选择内存优化的主要对象,可执行下面的操作步骤: (1) 打开“控制面板”窗口,右击“系统”图标,从弹出的快捷菜单中选择“打开”命令,打开“系统特性”对话框。 (2) 单击“高级”标签,切换到“高级”选项卡,然后单击“性能”选项组中的“性能选项”按钮,打开“性能选项”对话框,如图7-1所示。 图7-1 “性能选项”对话框

最全的云计算平台设计方案

1.云计算参考架构 在私有云当中,主要包含以下几个组件:物理基础架构、虚拟化层、服务自动化层、服务门户、安全体系、云API和可集成的其它功能。(如图私有云参考架构) 图3.4 私有云参考架构 a) 物理基础架构 物理架构的定义是组成私有云的各种计算资源,包括存储、计算服务器、网络,无论是云还是传统的数据中心,都必须基于一定的物理架构才能运行。 在私有云参考架构中的物理基础架构其表现形式应当是以资源池模式出现,也就是说,所有的物理基础架构应当是统一被管,且任一设备可以看成是无状态,或者说并不与其它的资源,或者是上层应用存在紧耦合关系,可以被私有云根据最终用户的需求,和预先定制好的策略,对其进行改变。 b) 虚拟化层 虚拟化是实现私有云的前提条件,通过虚拟化的方式,可以让计算资源运行超过以前更

多的负载,提升资源利用率。虚拟化让应用和物理设备之间采用松耦合部署,物理资源状态的变更不影响到虚拟化的逻辑计算资源。且可以根据物力基础资源变化而动态调整,提升整体的灵活性。 c) 服务自动化层 服务自动化层实现了对计算资源操作的自动化处理。它可以集中的监控目前整体计算资源的状态,比如性能、可用性、故障、事件汇总等等,并通过预先定义的自动化工作流进行相关的处理。 服务自动化层是计算资源与云计算服务门户相关联的重要部件,服务自动化层拥有自动化配置和部署功能,可以进行服务模板的制定,并将服务内容和选择方式在云计算服务门户上注册,用户可以通过服务门户上的服务目录来选择相应的计算资源请求,由服务自动化层实现服务交付。 d) 云API 云应用开发接口提供了一组方法,让云服务门户和不同的服务自动化层进行联系,通过云API,可以在一个私有云当中接入多个不同地方的计算资源池,包括不同架构的计算资源,并通过各自的服务自动化体系去进行服务交互。 e) 云服务门户 云服务门户是用户使用私有云计算资源的接口,云服务门户上提供了所有可用服务的目录,并提供了完善的服务申请流程,用户可以执行申请、变更、退回等计算资源使用服务。 云服务门户收到最终用户的请求时,将根据预先定义好的策略对该请求进行立刻供应、预留或者排队。 不同的用户通过同一个云服务门户当中,将会看到只属于自己的应用、计算资源和服务目录,这是云计算当中的多租户技术,用户使用的资源在后台集中,但是在前端是完全的逻

网络优化基本方法

随着CDMA技术在国内运营商的成熟应用,CDMA的网络优化成为运营商、设计单位和设备商共同关注的焦点。CDMA网络优化有其自身特点,CDMA特有的软切换方式使基站信号的控制比其他移动通信系统更为重要,这也增加了控制难度,如果信号控制不当,可能造成导频污染、强干扰等致使网络性能下降的问题。在实际工程中,应对出现的网络问题进行归纳总结,结合实地勘察、路测和OMC报表分析得出原因,不断积累网络优化的工程经验,打造精品网 络。 前向链路干扰问题 一是邻集列表丢失。解决方案:将该PN添加到激活扇区的邻集列表内。若该PN已经在 邻集列表内,则将其优先级提升。 二是突发强PN干扰。解决方案:引入软切换消除突发强PN干扰小区,可以通过增大导频功率,将突发PN顺利软切换,也可通过调整天线方向角、导频功率等措施,将信号发射至原来的阻挡区域以造成覆盖,或是降低切换参数T_ADD。还可适当增大SRCH_WIN_x窗口,以便手机发现该PN。消除突发PN的方法还有,先通过降低导频功率清除突发PN,或是通过调整天线方向、下倾角、更换天线等物理方法进行优化。 三是共PN干扰。解决方案:改变其中一个基站的PN值。定期对PN进行重新调整,这是一个长期艰难的工作,但对系统有很大好处。 边缘覆盖问题 由于该区域噪声电平Io通常很低,因而即使信号很弱,Ec/Io仍然较好。这种情况下的服务小区通常在网络的边缘,在网络建设期,为了增大覆盖,这些基站一般来说较高。可能的解决方案:如果是小区覆盖范围过大,则可以加大天线下倾角,减小导频功率,更换低增益天线,必要时在基站发射天线的馈线上加一个衰减器;如果希望增加小区覆盖范围,则可以增加导频功率,更换高增益天线;如果反向链路受限,小区天线加装塔放会有一定效果。 覆盖空洞 这种情况通常由于覆盖不够引起,可能是服务基站太远,或者服务基站被阻挡,FFER 在一些地区是好的,但在某些场所较差。解决方法:增加某一扇区的导频功率使之有主导频;对一个或多个服务扇区的物理参数进行优化(如天线方位角、倾角及天线类型);在容量不受限的情况下,使用直放站增加覆盖;增加新站来覆盖空洞;在高话务区增加载波;采用波瓣跨度较窄、增益较高的天线来覆盖某一建筑物;建筑密集区可用六扇区方式来解决,但要根 据路测结果来调整天线的物理参数。 导频污染 有超过三个的导频信号强度差不多,而Ec/Io值大于-12dB,则认为是导频污染。解决方案:控制无线环境从而减少导频过覆盖;降低不需要的导频功率;优化天线的物理参数;减少导频污染的方法:在该区域画出所有基站的导频覆盖图,注明所有过覆盖的PN,或是

服务器性能调优

服务器性能优化 1、Apache+tomcat集群方式 服务器基本设置:1个apache集成二个tomcat。 安装apache http server省略,访问地址为http://127.0.0.1:8081 安装tomcat,解压apache-tomcat-6.0.20.zip,测试时我是把两个tomcat分开放在不同的虚拟机,其中一个是和apache同一台虚拟机。 两个tomcat分别命名为worker2和worker3 先说tomcat.worker2的配置: server.xml 第一步:配置http监听端口,这里端口设为8079,该步骤非必要,只要不冲突就行了。

如何优化局域网提升网络性能

优化局域网提升网络性能 目前,几乎任何稍微大一点的企业和学校都会建立一个局域网供使用,网络已经无处不在了。作为局域网络的网管人员,对于网络速度是非常敏感的,如何有效的利用带宽,避免不必要的速度损失,从而达到对整个网络的优化,就是一个非常重要的问题。 一、设计的成败 设计决定了整个网络的速度。一个好的网络整体规划设计不但能够满足性能的要求,而且使用了最少的投入,同时还应该便于支持日后对于网络的扩大处理。网络设计是一个非常大的课题,从交换机和路由器的选择和配置,到综合布线,都有许多的学问。笔者个人建议是,请一名经验非常丰富的设计人员或者雇用网络布线公司是一个企业公司最初建网的最好选择。笔者早期的切身经验是,同样的设备,存在两种不同的连线法,按照理论二者是等价的,但是无论怎么试,就是连不上网,后来一位高手只是稍微改动了一根线的位置,就连通了。好多时候,经验远比书本上的知识重要。 通常,好的设计满足一下几个要求: 功能性:这个网络必须能够工作。它要使得用户能够满足工作上的需要,必须以合理的速度和可靠性为用户提供"用户到用户"和"用户到应用"的连接。 可扩展性:这个网络应该能够增长。最初的设计应能在不对全局做较大改动的情况下使网络增长。 适应性:这个网络在设计时应该具有长远的目光,考虑到未来技术的发展。并且,不应该包含新技术在网络中开展的因素。 易管理性:应该支持网络监控和管理,以保证运行中的持续稳定。 二、服务、服务器与QoS 企业网的稳定与否往往决定于一些关键性的服务器和服务是否稳定运行。通常,在一个现代的企业中,都会使用一些MIS、ERP系统对企业进行管理。在一些大型企业中,甚至实现了完全基于计算机信息系统的管理和运作。所以,为了保证整个企业能够顺利的运作,网管就必须不惜一切代价保证这些信息系统的稳定运行。 一般的企业管理信息系统大都使用B/S(如SAP)和C/S(J2EE和.NET)构架。无论何种构架,一台高档的服务器是不可少的。现代的技术如J2EE等虽然稳定可靠,但服务器的负载是早期的数倍。通过使用双或四核处理器,SCSI接口的硬盘,RAID阵列或者增大内存都能够大大提高服务器的性能。同时,为服务器买一块名牌网卡或者升级至千兆以太网而不是2、30元的“地摊货”也是很好的方法。当然,鉴于Oracle、BEA、IBM等对于Linux最近都增加了支持力度,所有的产品都有移植到Linux平台,而Linux在服务方面的特性确实要好一些,所以用户不妨考虑Linux平台。如果公司的规模非常大,那么使用IBM、HP等大厂的服务器和完整解决方案远胜于一台你认为很好的普通服务器。 QoS是最近交换机和软件厂商等倡导的一项技术,QoS能够保证企业关键性的服务稳定,通过在交换机中保留一定的带宽给关键服务数据包,关键服务的性能能够得到保证。但是,QoS的开启意味着20%以上的普通网络通讯速度流失,所以对于企业网和网上业务密集的网络,开启QoS,否则,关掉它。 三、路由、交换 交换机和路由的配置也是非常重要的网络性能因素。 先说交换机的配置,通常对于最常见的提高性能的方法是设置VLAN。VLAN是把物理上通过同等方式的连接虚拟成为多个不同的子网。VLAN最大的功能就是防止广播风暴。一般来说,如果一个网络的广播包占到所有的通讯包的30%以上,网络性能就显着下降。现在,几乎所有的交换机都提供了VLAN的支持。虽然VLAN设置有一点点的麻烦,但是因为其

服务器解决方案

连云港党校服务器解决方案 第一章:中心服务器系统双机热备方案-服务器 一:系统设计原则 在系统设计中主要遵循以下原则: (1)系统设计的前瞻性。 充分考虑到用户需求,确保在系统满足未来的业务发展需要。(2)系统设计的先进性。 在经费的技术许可的范围内,引进、吸收和应用先进技术。在数据存储管理系统软件设计和存储网络设计以及存储设备选择上采用目前国际先进方案,在建立先进的存储结构的同时,获得较好的数据系统运行效率。 (3)开放性原则 系统采用的各种硬件设备和软件系统均遵循国际标准或工业标准及国际流行标准,符合开放性设计原则,使用权其具备优良的可扩展性、可升级性和灵活性。 (4)安全性原则 数据备份系统构成应用系统的保障子系统。数据备份系统的最终目的是确保应用系统的安全运行和故障恢复机制,系统设计的首要目标是建立这一系统安全体系。 (5)稳定性原则 在采用国际先进的存储技术的同时,着重考虑了系统的稳定性和

可行性,其中又重点考虑系统可靠的平滑升级方式,使系统的运营风险降低到最小。这样,系统能够充分享受先进的存储技术带来的巨大收益。 (6)系统设计的可扩展性 在考虑各子系统的设计中,均按业务要求对系统扩展的可行性进行了考虑。 (7)经济性 在满足所有需求的前提下,选择合适的存储管理软件,存储设备和相关存储设备,使系统具有较好的性能价格比。 二:系统总体结构说明 鉴于用户业务性质需求。在本方案设计中所有设备完全使用冗余架构确保系统任意一点出现故障时业务的可持续运行。 (1)产品选型 基于性能价格比和目前的应用,IBM X-SERVER+FastT600全光纤存储服务器。 服务器推荐IBM X-server X366,确保系统的稳定性和用户数据安全性。IBM X-SERVER X366 高性能、低密度 IBM eServer xSeries 366 是采用灵活的双核4路处理器,更高的机柜密度和强大管理功能设计的机架优化服务器,提供领先的性能/价格比和投资保护特性。第二代IBM 企业级X-架构(EXA)设计和运行速度高达3.0GHz的双核Intel Xeon处理器MP提供强大的功能以运行关键任务应用,例如企业资源规划(ERP)、数据库和协作型应用等。

云平台运维建设方案报告

xxx 区国土资源 一张图工程和服务平台系统 基础支撑平台与运维保障平台

建

设

方

案

目录

1 项目概述....................................................................................................... 2

1.1 项目背景 ................................................................................................... 2 1.2 项目目标 ................................................................................................... 2 1.3 建设内容 ................................................................................................... 2

2 现状及需求分析.............................................................................................. 3

2.1 信息化现状 ................................................................................................ 3 2.2 存在的问题 ................................................................................................ 4

2.2.1 运维保障面临主要问题 .......................................................................... 4 2.2.2 现有保障手段不能满足需求 .................................................................... 4 2.2.3 管理运维问题 ....................................................................................... 5

3 方案总体设计................................................................................................. 6

3.1 设计原则 ................................................................................................... 6 3.2 总体架构设计 ............................................................................................. 7 3.3 实施思路 ................................................................................................... 7

4 虚拟桌面技术方案设计................................................................................... 10

5 服务器虚拟化方案设计................................................................................... 11

6 业务系统运维保障设计................................................................................... 13

6.1 架构设计 ..................................................................................................13 6.2 业务系统应急 ............................................................................................14 6.3 数据保障 ..................................................................................................15 6.4 运维迁移 ..................................................................................................15

7 项目实施计划............................................................................................... 16

8 项目组织保障............................................................................................... 17

8.1 工作领导小组 ............................................................................................17 8.2 项目专家小组 ............................................................................................17 8.3 项目技术小组 ............................................................................................17