神经网络实例--对正弦函数拟合

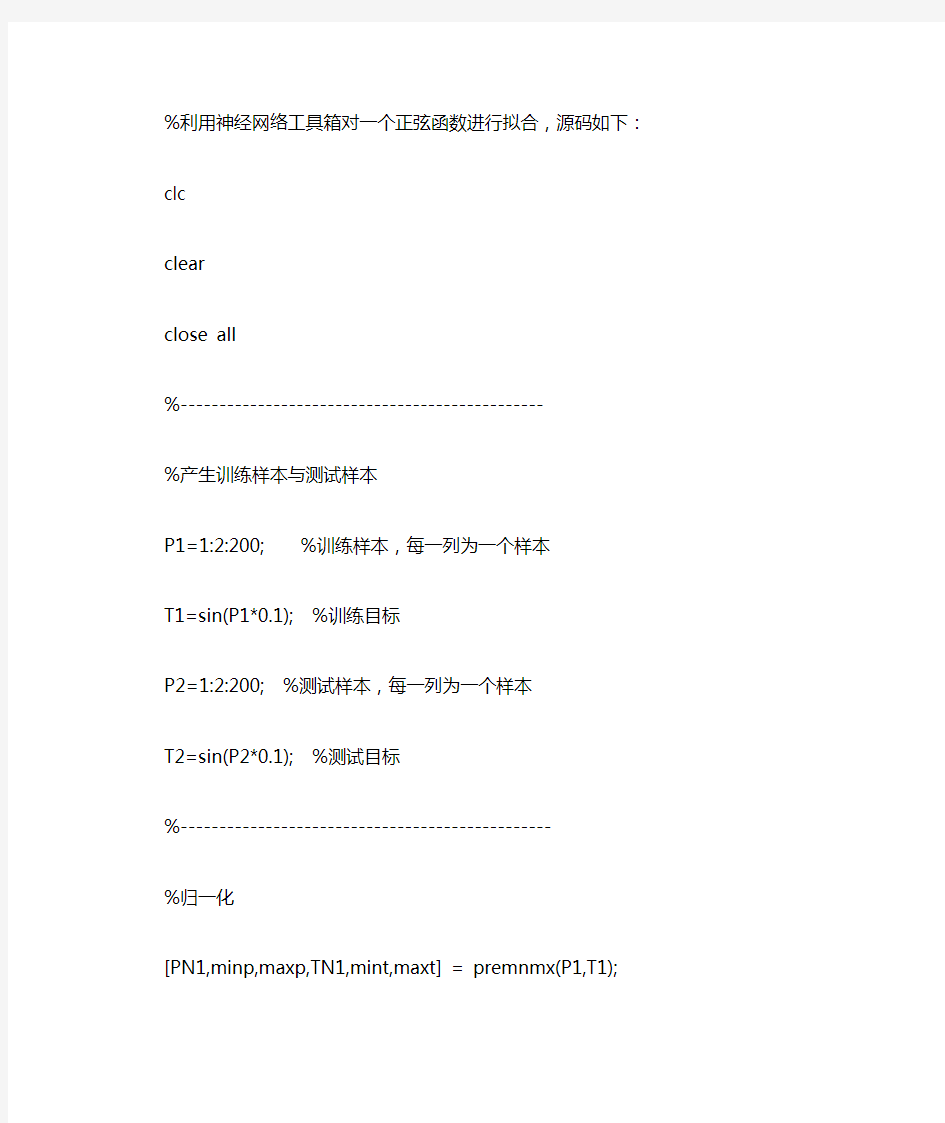

%利用神经网络工具箱对一个正弦函数进行拟合,源码如下:

clc

clear

close all

%-----------------------------------------------

%产生训练样本与测试样本

P1=1:2:200; %训练样本,每一列为一个样本

T1=sin(P1*0.1); %训练目标

P2=1:2:200; %测试样本,每一列为一个样本

T2=sin(P2*0.1); %测试目标

%------------------------------------------------

%归一化

[PN1,minp,maxp,TN1,mint,maxt] = premnmx(P1,T1);

PN2=tramnmx(P2,minp,maxp);

TN2=tramnmx(T2,mint,maxt);

%-------------------------------------------

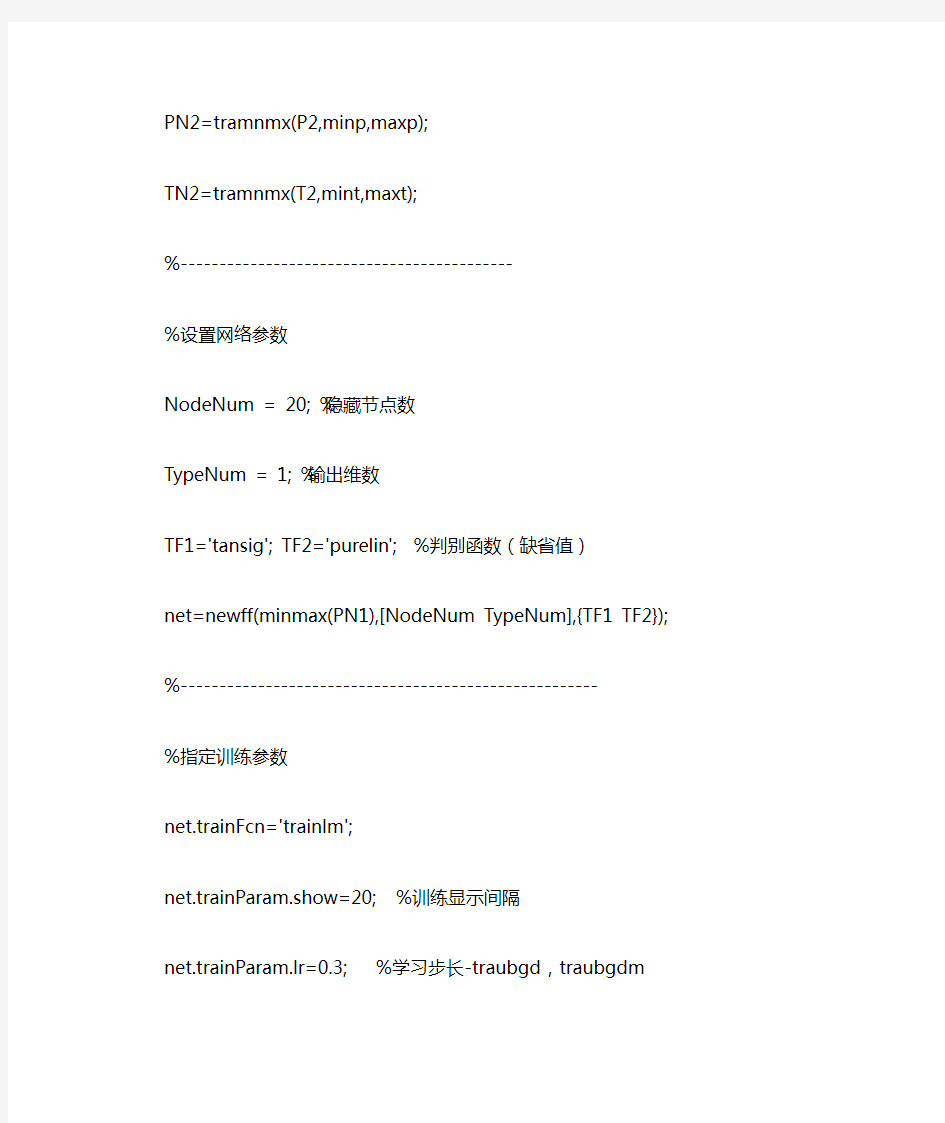

%设置网络参数

NodeNum = 20; %隐藏节点数

TypeNum = 1; %输出维数

TF1='tansig'; TF2='purelin'; %判别函数(缺省值)

net=newff(minmax(PN1),[NodeNum TypeNum],{TF1 TF2});

%------------------------------------------------------

%指定训练参数

net.trainFcn='trainlm';

net.trainParam.show=20; %训练显示间隔

net.trainParam.lr=0.3; %学习步长-traubgd,traubgdm

net.trainParam.mc=0.95; %动量项系数-traingdm,traingdx

net.trainParam.mem_reduc=1; %分块计算Hessian矩阵(仅对Levenberg-Marquardt算法有效)

net.trainParam.epochs=1000; %最大训练次数

net.trainParam.goal=1e-8; %最小均方误差

net.trainParam.min_grad=1e-20; %最小梯度

net.trainParam.time=inf; %最大训练时间

%-------------------------------------------------------

%训练

net=train(net,PN1,TN1); %训练

%--------------------------------------------------

%测试

YN1=sim(net,PN1); %训练样本实际输出

YN2=sim(net,PN2); %测试样本实际输出

MSE1=mean((TN1-YN1).^2);

MSE2=mean((TN2-YN2).^2);

%-------------------------------------------

%反归一化

Y2=postmnmx(YN2,mint,maxt);

%-----------------------------------------

%结果作图

plot(1:length(T2),T2,'r+:',1:length(Y2),Y2,'bo:'); title('+为真实值,o为预测值');

运行结果图:

基于BP神经网络的曲线拟合

神经网络实验报告 基于BP网络的曲线拟合 学院:控制学院 姓名:李嘉頔 学号:09423021 2015年6月

一、实验目的 ⑴掌握BP神经网络的权值修改规则 ⑵利用BP网络修改权值对y=sin(x)曲线实现拟合 二、实验要求 人工神经网络是近年来发展起来的模拟人脑生物过程的人工智能技术,具有自学习、自组织、自适应和很强的非线性映射能力。在人工神经网络的实际应用中,常采用BP神经网络或它的变化形式,BP神经网络是一种多层神经网络,因采用BP算法而得名,主要应用于模式识别和分类、函数逼近、数据压缩等领域。 BP网络是一种多层前馈神经网络,由输入层、隐层和输出层组成。层与层之间采用全互连方式,同一层之间不存在相互连接,隐层可以有一个或多个。BP算法的学习过程由前向计算过程和误差反向传播过程组成,在前向计算过程中,输入信息从输入层经隐层逐层计算,并传向输出层,每层神经元的状态只影响下一层神经元的状态。如输出层不能得到期望的输出,则转入误差反向传播过程,误差信号沿原来的连接通路返回,通过修改各层的神经元的权值,使得网络系统误差最小,最终实现网络的实际输出与各自所对应的期望输出逼近。 三、实验内容 3.1训练数据导入 要对BP网络进行训练,必须准备训练样本。对样本数据的获取,可以通过用元素列表直接输入、创建数据文件,从数据文件中读取等方式,具体采用哪种方法,取决于数据的多少,数据文件的格式等。 本文采用直接输入100个样本数据的方式,同时采用归一化处理,可以加快网络的训练速度。将输入x和输出y都变为-1到1之间的数据,归一化后的训练样本如下图: 3.2网络初始化

根据系统输入输出序列,确定网络输入层节点数为1,隐含层节点数H 为20,输出层节点数为1。初始化输入层、隐含层和输出层神经元之间的连接权值ij w , jk v ,初始化隐含层阈值0t ,输出层阈值1t ,给定学习速率0a ,1a 和u ,给定算法 迭代次数inum 和最大可接受误差error ,同时给定神经元激励函数sigmoid 。 3.3前向输出计算 根据输入变量x ,输入层和隐含层间连接权值ij w 和隐含层阈值0t ,计算隐含层输出P : ) )((∑=-?=n i j i ij j t x w u f P 10l j ,...,,21=其中n 为输入层节点数,本实验中取1;l 为隐含层节点数,本实验中取20;f 为隐含层激励函数,该函数可设置为多种形式,本实验中所选函数为: x e x f -+= 11 )(根据隐含层输出P ,隐含层和输出层间连接权值jk v 和输出层阈值1t ,计算BP 神经网络预测输出k Q : ∑=-=l j k jk j k t v P Q 11m k ,...,,21=其中m 为输出层节点数,本实验中取1。 3.4权值修正 根据网络预测输入Q 和期望输出y ,计算网络预测误差e : k k k Q y e -=BP 神经网络采用梯度修正法作为权值和阈值的学习算法,从网络预测误差的负梯度方向修正权值和阈值。在本实验采用的sigmoid 激励函数下,隐含层和输出层间连接权值和输出层阈值更新公式为: k j jk jk e P a u v v 1*+=m k l j ,...,,;,...,,2121==k k k e u t t *+=11m k ,...,,21=输入层和隐含层间连接权值和输出层阈值更新公式为: ∑=*-+=m k k jk i j j ij ij e v u x P P a w w 101)(l j n i ,...,,;,...,,2121==∑=*-+=m k k jk j j j j e v u P P a t t 1 0001)(l j ,...,,21=

(采用BP神经网络完成非线性函数的逼近)神经网络

控制系统仿真与模型处理设计报告 (采用BP神经网络完成非线性函数的逼近)

1、题目要求: (1)确定一种神经网络、网络结构参数和学习算法。 (2)选择适当的训练样本和检验样本,给出选取方法。 (3)训练网络使学习目标误差函数达到0.01,写出学习结束后的网络各参数,并绘制学习之前、第100次学习和学习结束后各期望输出曲线、实际输出曲线。绘制网络训练过程的目标误差函数曲线。 (4)验证网络的泛化能力,给出网络的泛化误差。绘制网络检验样本的期望输出曲线和网络输出曲线。 (5)分别改变神经网络的中间节点个数、改变网络的层数、改变学习算法进行比较实验,讨论系统的逼近情况,给出你自己的结论和看法。 2、设计方案: 在MATLAB中建立M文件下输入如下命令: x=[0:0.01:1]; y=2.2*power(x-0.25,2)+sin(5*pi*x); plot(x,y) xlabel('x'); ylabel('y'); title('非线性函数'); 得到如下图形,即所给的非线性函数曲线图:

构造一个1-7-1的BP神经网络,第一层为输入层,节点个数为1;第二层为隐层,节点个数为7;变换函数选正切s型函数(tansig);第三层为输出层,节点个数为1,输出层神经元传递函数为purelin函数。并且选Levenberg-Marquardt算法(trainlm)为BP网络的学习算法。对于该初始网络,我们选用sim()函数观察网络输出。继续在M函数中如下输入。 net=newff(minmax(x),[1,7,1],{'tansig','tansig','purelin'},'trainlm'); y1=sim(net,x); figure; plot(x,y,'b',x,y1,'r') title('期望输出与实际输出比较'); xlabel('t'); 则得到以下所示训练的BP网络期望输出与实际输出曲线比较: 应用函数train()对网络进行训练之前,需要预先设置训练参数。将最大训练次数为100次,训练精度设置为0.01,学习速度为0.01。 net.trainParam.epochs=100; net.trainParam.goal=0.001; net.trainParam.lr=0.01; net=train(net,x,y); y2=sim(net,x);

BP神经网络逼近非线性函数

BP神经网络逼近非线性函数3、试用BP神经网络逼近非线性函数 f(u) = )5.0 u(9.1 e+ - sin(10u) 其中,u∈[-0.5,0.5] 解题步骤: ①网络建立:使用“net=newff(minmax(x), [20, 1], {'tansig’,’ purelin' });,语句建立个前馈BP神经网络。该BP神经网络只含个隐含层,且神经元的个数为20。隐含层和输出层神经元的传递函数分别为tansig和pure-lin。其他参数默认。 ②网络训练:使用“net=train (net, x , y) ;”语句训练建立好的BP神经网络。当然在网络训练之前必须设置好训练参数。如设定训练时间为50个单位时间,训练目标的误差小于0.01,用“net.trainParam.epochs=50; net.train-Param.goal=0.01;”,语句实现。其他参数默认。 ③网络仿真:使用“y1=sim(net, x); y2=sim(net, x};”语句仿真训练前后的BP神经网络。 (2)程序如下: clear all; x=[-0.5:0.01:0.5]; y=exp(-1.9*(0.5+x)).*sin(10*x); net=newff(minmax(x),[20,1],{'tansig' 'purelin'}); y1=sim(net,x); %未训练网络的仿真结果net.trainParam.epochs=50; net.trainParam.goal=0.01; net=train(net,x,y); y2=sim(net,x); %训练后网络的仿真结果figure;

神经网络建模及Matlab中重要的BP网络函数

神经网络建模及Matlab中重要的BP网络函数一、神经组织的基本特征 1.细胞体是一个基本的初等信号处理器,轴突是信号的输出通路,树突是信号的输入通路。信号从一个神经细胞经过突触传递到另一个细胞。 2.不同的神经元之间有不同的作用强度,称为联接强度。当某细胞收到信号时,它的电位发生变化,如果电位超过某一阈值时,该细胞处于激发态,否则处于抑制状态。 3.两神经元之间的联接强度随其激发与抑制行为相关性的时间平均值正比变化,也就是说神经元之间的联接强度不是一成不变的。这就是生物学上的Hebb律。

∑t j ij t S w )(二、人工神经元的M-P 模型(McCulloch 、Pitts,1943) 1.构造一个模拟生物神经组织的人工神经网络的三要素: (1).对单个神经元给出定义; (2).定义网络结构:决定神经元数量及连接方式; (3).给出一种方法,决定神经元之间的联接强度。 2.M-P 模型 其中,t 表示时间 S i (t)表示第i 个神经元在t 时刻的状态,S i (t)=1表示处于激发态,S i (t)=0表示处于抑制态 w ij 表示第j 个神经元到第i 个神经元的联接强度,称之为权,可正可负 表示第i 个神经元在t 时刻所接收到的所有信号的线性迭加。 μi 表示神经元i 的阈值, 可以在模型中增加一个S k (t)=1神经元k ,并且w ik =-μi ,则阈值可归并到和号中去。 注: 1.M-P 神经元虽然简单,但可以完成任何计算。 2.神经元的状态可以取[0,1]中的连续值,如用以下函数代替θ(x): ???<≥=-=+∑0 0011x x x t S w t S i j j ij i )() )(()(θμθ

神经网络在数据拟合中的应用

神经网络在数据拟合中的应用 [摘要] 相对于回归分析等方法,神经网络在拟合曲线的平滑度、精度等方面具有优势。本文通过两个实例,介绍了用BP人工神经网络来进行数据拟合处理的方法。表明采用神经网络方法进行数据拟合处理具有实用和精确的特点。 [关键词] 曲线拟合BP网络 引言 在科研生产中,我们经常会处理这样一些数据,它们的特点是:有一组输入,并且有一组对应的输出,但由于受到各种确定和随机因素的影响,我们难于找到输入输出之间的对应关系,更无法用函数关系来表示对应关系。大多数情况下,人们用数学上的曲线拟合来解决这个问题,例如一元线性回归分析,二次曲线拟合等方法。但是实际中大多数对应关系很复杂,难于拟合或者拟合出的残差较大,而且这种曲线拟合方法难以处理具有多个输入多个输出的情况。 神经网络方法在处理这样的数据时具有优势。具有偏差和至少一个S 型隐含层加上一个线性输出层的BP人工神经网络能够逼近任何有理函数。我们可以利用BP人工神经网络来进行数据拟合处理,能够得到平滑的曲线,不会出现数据有极值点的现象。 一、BP人工神经网络的结构 BP网络是典型的多层网络,分为输入层,隐含层,输出层,层与层之间采用全互联方式,同一层神经元之间不存在相互连接,如图1: 图1BP网络结构 二、BP人工神经网络在频率特性校正中的应用 我们以感应线圈的灵敏度-频率特性数据为例,说明BP网络的设计。为了纠正频率响应特性,需要找 到灵敏度-频率特性之间的对应关系,但由于物理变化过程十分复杂,很难找到它们之间的函数表达式,于是用BP人工神经网络拟合灵敏度-频率特性曲线,输入矩阵是一组频率数值,用T表示,输出矩阵是对应的灵敏度数值,用V 表示。 1.选取神经元数:输入矩阵T有6个数据,是一个列向量,则输入层有一个神经元,如图1,是一个16×6矩阵;是偏差向量,隐含层的激活函数;是输出层的向量,是输出层的偏差;输出层的激活函数;A2即V为输出目标矢量,有6个数据,输出层一个神经元。关键在于如何选取隐含层的神经元数。一般而言

粒子群算法在神经网络非线性函数拟合中的应用【精品文档】(完整版)

粒子群算法在神经网络非线性函数 拟合中的应用 一、本文研究和解决的问题 在自动控制问题中,系统辨识的目的是为了建立被控对象的数学模型。多年来,控制领域对于复杂的非线性对象的辨识一直未能很好的解决,神经网络所具有的非线性特性和学习能力使其在系统辨识方面有很大的潜力。为解决具有复杂的非线性、不确定性和不确知对象的辨识问题开辟了一条有效的途径。基于神经网络的系统辨识是以神经网络作为被辨识对象的模型,利用其非线性特性,可建立非线性系统的静态或动态模型。理论上,多层前馈神经网络能够以任意精度逼近任意非线性映射。 但传统神经网络学习算法中存在的收敛速度慢、容易陷入局部最优等缺点,于是设计了基于标准粒子群算法的神经网络非线性函数拟合系统。 二、传统的BP神经网络 BP 神经网络即采用误差反向传播算法的网络,是一种至今仍然最为流行的前馈型神经网络模型。BP 神经网络有很强的非线性映射能力,它能学习和存贮大量输入-输出模式映射关系,而无需事先了解描述这种映射关系的数学方程。只要能提供足够多的样本模式对供给网络进行学习训练,它便能完成由n 维输入空间到m 维输出空间的非线性映射。BP 学习算法属于误差修正型学习,其关键在于根据误差修正输出层和隐含层的连接权值。其学习的基本实现方法是基于最小平方误差准则和梯度下降优化方法来确定权值调整法则。 BP网络建模特点: 非线性映照能力:神经网络能以任意精度逼近任何非线性连续函数。在建模过程中的许多问题正是具有高度的非线性。 并行分布处理方式:在神经网络中信息是分布储存和并行处理的,这使它具有很强的容错性和很快的处理速度。 自学习和自适应能力:神经网络在训练时,能从输入、输出的数据中提取出规律性的知识,记忆于网络的权值中,并具有泛化能力,即将这组权值应用于一般情形的能力。神经网络的学习也可以在线进行。 数据融合的能力:神经网络可以同时处理定量信息和定性信息,因此它可以利用传统的工程技术(数值运算)和人工智能技术(符号处理)。 多变量系统:神经网络的输入和输出变量的数目是任意的,对单变量系统与多变量系统提供了一种通用的描述方式,不必考虑各子系统间的解耦问题。

BP神经网络在Matlab函数逼近中的应用

燕山大学 模式识别与智能系统导论 题目:BP网络在函数逼近中的应用 专业:控制工程 姓名: X X X 学号:

一BP神经网络及其原理............................................................ - 1 - 1.1 BP神经网络定义............................................................. - 1 - 1.2 BP神经网络模型及其基本原理..................................... - 1 - 1.3 BP神经网络的主要功能................................................. - 3 - 1.4 BP网络的优点以及局限性............................................. - 3 - 二基于MATLAB的BP神经网络工具箱函数 ........................ - 6 - 2.1 BP网络创建函数............................................................. - 7 - 2.2 神经元上的传递函数...................................................... - 7 - 2.3 BP网络学习函数............................................................. - 8 - 2.4 BP网络训练函数............................................................. - 9 - 三BP网络在函数逼近中的应用.............................................. - 10 - 3.1 问题的提出.................................................................... - 10 - 3.2 基于BP神经网络逼近函数......................................... - 10 - 3.3 不同频率下的逼近效果................................................ - 14 - 3.4 讨论................................................................................ - 17 -

神经网络作业(函数逼近)

智能控制理论及应用作业 1资料查询 BP 神经网络的主要应用: 人脸识别、风电功率预测、短时交通流混沌预测、高炉熔渣粘度预测、汇率预测、价格预测、函数逼近等 Rbf神经网络的主要应用: 函数逼近、短时交通流预测、模式识别、降水预测、民航客运量预测、遥感影像分析、声纹识别、语言识别、人脸识别、车牌识别、汇率预测 Hopfield网络应用: 车牌识别、图像识别、遥感影像分类、字母识别、交通标志识别、优化计算中的应用、联想记忆存储器的实现、 2 BP编程算法: 2.1 利用样本训练一个BP网络 注:此程序自李国勇书中学习而来 程序部分: function [ output_args ] = bp( input_args ) %UNTITLED Summary of this function goes here % Detailed explanation goes here %此设计为两层BP神经网络,3输入,3隐含层节点,两个输出 %初始化部分: lr=0.05; %%需要给定学习速率 error_goal=0.001; %期望的误差 max_epoch=100000; %训练的最大步长 a=0.9; %惯性系数 Oi=0; Ok=0; %给两组输入,以及目标输出: X=[1 1 1;-1 -1 1;1 -1 1;]; %随便给一组输入输入,训练BP网络

T=[1 1 1 ;1 1 1]; %X=-1:0.1:1; %输入范围 %T=sin(pi*X); %X=[] q=3; %隐含层的节点数自己定义,在此给3个 %初始化 [M,N]=size(X); %输入节点个数为M,N为样本数 [L,N]=size(T); %输出节点个数为L wij=rand(q,M); %先给定加权系数一组随机值 wki=rand(L,q); wij0=zeros(size(wij)); %加权系数矩阵的初始值 wki0=zeros(size(wki)); for epoch=1:max_epoch %计算开始 NETi=wij*X; %各个隐含层的净输入 for j=1:N for i=1:q Oi(i,j)=2/(1+exp(-NETi(i,j)))-1; %再输入作用下,隐含层的输出 end end NETk=wki*Oi; %各个输出层的净输入 for i=1:N for k=1:L Ok(k,i)=2/(1+exp(-NETk(k,i)))-1; %在输入作用下,输出层的输出end end E=((T-Ok)'*(T-Ok))/2; %性能指标函数,就是误差 if(E 人工神经网络及其数据拟合中的应用 人工神经网络及其数据拟合中的应用 摘要 本文将讲述人工神经网络及其数据拟合中的应用。人工神经网络是在现代神经科学的基础上提出和发展起来的,旨在反映人脑结构及功能的一种抽象数学模型。它在模式识别,图像处理,智能控制,组合优化,金融预测与管理通信机器人以及专家系统等领域得到广泛的应用。文章首先介绍人工神经元和人工神经网络的数学结构,然后介绍神经网络的建立、训练与泛化的概念以及MATLAB语言的神经网络工具箱在解决这些问题中的应用。通过实际例题来巩固这些知识点。 关键词:人工神经网络拟合径向基结构MATLAB 一、神经网络基础知识 1.1人工神经元模型 (i )一组连接(对应于生物神经元的突触) ,连接强度由各连接上的权值表示,权值为正表示激活,为负表示抑制。 (ii )一个求和单元,用于求取各输入信号的加权和(线性组合) 。 (iii )一个非线性激活函数,起非线性映射作用并将神经元输出幅度限制在一定范围内(一般限制在(0,1)或(-1,1)之间)。 此外还有一个阈值 以上作用可分别以数学式表达出来: 式中n x x x ,,21为输入信号, 为神经元k 之 权值, 为线性组合结果, 为阈值, 为激活函数又称为传输函数, 为神经元k 的输出。 常用的传输函数有:Sigmoid 函数和对数Sigmoid 函数。 在神经元中,权值和传输函数是两个关键的因素。权值的物理意义是输入信号的强度,多个神经元则是连接强度。神经元的权值应该通过神经元对样本点反复的学习过程而确定,这个过程称为训练。 1.2神经网络结构 从连接方式上可将其划分为前馈型网络和反馈型网络。 (i )前馈型网络 各神经元接受前一层的输入,并输出给下一层,没有反馈。结点分为两类,即输入单元和计算单元,每一计算单元可有任意个输入,但只有一个输出(它可耦合到任意多个其它结点作为其输入) 。通常前馈网络可分为不同的层,第i 层的输入只与第 1 ? i 层输出相连,输入和输出结点与外界相连,而其它中间层则称为隐层。 (ii )反馈型网络 所有结点都是计算单元,同时也可接受输入,并向外界输出。 1.3神经网络结构工作方式 神经网络的工作过程主要分为两个阶段: 第一个阶段是学习期,此时各计算单元状态不变,各连线上的权值可通过学习来修改;第二阶段是工作期,此时各连接权固定,计算单元状态变化,以达到某种稳定状态。 从作用效果看,前馈网络主要是函数映射,可用于模式识别和函数逼近。反馈网络按对能量函数的极小点的利用来分类有两种:第一类是能量函数的所有极小点都起作用,这一类主要用作各种联想存储器;第二类只利用全局极小点,它主要用于求解最优化问题。 所以我们知道,神经网络要解决的问题是通过已知数据,反复训练神经网络, 得到加权量和阀值,使得神经网络的计算输出信号 与实际期望输出信号 误差最小 。一种较适合的方式就是使得误差的平方和最小,即 ∑==-==p j k k k k k j kj k v y u v x w u 1 ) (,,ψθkp k k w w w ,...,,21k u k θ(.)ψk y i y 机器学习作业一BP神经网络实现函数逼近 一.算法描述 BP(Back Propagation)神经网络是1986年由Rumelhart和McCelland为首的科学家小组提出,是一种按误差逆传播算法训练的多层前馈网络,是目前应用最广泛的神经网络模型之一。BP网络能学习和存贮大量的输入-输出模式映射关系,而无需事前揭示描述这种映射关系的数学方程。它的学习规则是使用梯度下降法,通过反向传播来不断调整网络的权值和阈值,使网络的误差平方和最小。BP神经网络模型拓扑结构包括输入层(input)、隐层(hidden layer)和输出层(output layer)。 二.数据描述 逼近函数y = sin(x) 三.算法参数 输入学习率,迭代次数,逼近函数,神经网络规模 输出逼近的函数 四.实验流程 反向传播算法(Back Propagation)分二步进行,即正向传播和反向传播。 这两个过程简述如下: 1.正向传播 输入的样本从输入层经过隐单元一层一层进行处理,传向输出层;在逐层处理的过程中。在输出层把当前输出和期望输出进行比较,如果现行输出不等于期望输出,则进入反向传播过程。 2.反向传播 反向传播时,把误差信号按原来正向传播的通路反向传回,逐层修改连接权值,以望代价函数趋向最小。 输入层输入向量(n维):X=(x1,x2,…,xi,…,xn)T 隐层输出向量(隐层有m个结点):Y=(y1,y2,…,yj,…,ym)T 输出层输出向量(l维):O=(o1,o2,…,ok,…,ol)T 期望输出向量:d=(d1, d2,…,dk,…,dl)T 输入层到隐层之间的权值矩阵:V=(V1,V2,…,Vj,…,Vm) 隐层到输出层之间的权值矩阵用:W=(W1,W2,…,Wk,…,Wl) 对输出层第k个结点和隐含层的第j个结点有如下关系: 第一节、神经网络基本原理 1. 人工神经元( Artificial Neuron )模型 人工神经元是神经网络的基本元素,其原理可以用下图表示: 图1. 人工神经元模型 图中x1~xn是从其他神经元传来的输入信号,wij表示表示从神经元j 到神经元i的连接权值,θ表示一个阈值( threshold ),或称为偏置( bias )。则神经元i的输出与输入的关系表示为: 图中yi表示神经元i的输出,函数f称为激活函数( Activation Function )或转移函数( Transfer Function ) ,net称为净激活(net activation)。若将阈值看成是神经元i的一个输入x0的权重wi0,则上面的式子可以简化为: 若用X表示输入向量,用W表示权重向量,即: X = [ x0 , x1 , x2 , ....... , xn ] 则神经元的输出可以表示为向量相乘的形式: 若神经元的净激活net为正,称该神经元处于激活状态或兴奋状态(fire),若净激活net为负,则称神经元处于抑制状态。 图1中的这种“阈值加权和”的神经元模型称为M-P模型 ( McCulloch-Pitts Model ),也称为神经网络的一个处理单元( PE, Processing Element )。 2. 常用激活函数 激活函数的选择是构建神经网络过程中的重要环节,下面简要介绍常用的激活函数。 (1) 线性函数( Liner Function ) (2) 斜面函数( Ramp Function ) (3) 阈值函数( Threshold Function ) 图2 . 阈值函数图像 以上3个激活函数都是线性函数,下面介绍两个常用的非线性激活函数。 (4) S形函数( Sigmoid Function ) 该函数的导函数: (5) 双极S形函数 神经网络作业(函数逼近) 智能控制理论及应用作业 1资料查询 BP 神经网络的主要应用: 人脸识别、风电功率预测、短时交通流混沌预测、高炉熔渣粘度预测、汇率预测、价格预测、函数逼近等 Rbf神经网络的主要应用: 函数逼近、短时交通流预测、模式识别、降水预测、民航客运量预测、遥感影像分析、声纹识别、语言识别、人脸识别、车牌识别、汇率预测 Hopfield网络应用: 车牌识别、图像识别、遥感影像分类、字母识别、交通标志识别、优化计算中的应用、联想记忆存储器的实现、 2 BP编程算法: T=[1 1 1 ;1 1 1]; %X=-1:0.1:1; %输入范围 %T=sin(pi*X); %X=[] q=3; %隐含层的节点数自己定义,在此给3个 %初始化 [M,N]=size(X); %输入节点个数为M,N为样本数 [L,N]=size(T); %输出节点个数为L wij=rand(q,M); %先给定加权系数一组随机值 wki=rand(L,q); wij0=zeros(size(wij)); %加权系数矩阵的初始值 wki0=zeros(size(wki)); for epoch=1:max_epoch %计算开始 NETi=wij*X; %各个隐含层的净输入 for j=1:N for i=1:q Oi(i,j)=2/(1+exp(-NETi(i,j)))-1; %再输入作用下,隐含层的输出 end end NETk=wki*Oi; %各个输出层的净输入 for i=1:N for k=1:L Ok(k,i)=2/(1+exp(-NETk(k,i)))-1; %在输入作用下,输出层的输出 end end E=((T-Ok)'*(T-Ok))/2; %性能指标函数,就是误差 if(E 神经网络在数据拟合方面的应用 摘要 本文将讲述人工神经网络及其数据拟合中的应用。人工神经网络是从信息处 理角度对人脑神经元网络进行抽象,建立某种简单模型,按不同的连接方式组成不同的网络。它在模式识别、智能机器人、自动控制、预测估计、生物、医学、经济等领域得到广泛的应用。本文主要研究神经网络在数据拟合中的应用,通过对背景、基础知识及其神经网络的相关理论,推出神经网络的发展历程及其模型,最后得出神经网络在数据拟合中的算法的设计与实现。本文通过实例介绍了用神 经网络来进行数据拟合处理的方法。 关键词:人工神经网络; 拟合; 径向基结构; MATLAB Abstract This paper will describe the application of artificial neural network and its data fitting. Artificial neural network is a kind of simple model, which is based on the information processing point of view of the human brain neural network to establish a simple model. The different connection ways form different networks. It is widely used in pattern recognition, intelligent robot, automatic control, prediction and estimation, biology, medicine, economy and so on. This paper studied the neural network in the data fitting application. By the background, basic knowledge and neural network theory, we introduced the development process of neural network and its models, and finally we got the design and implementation of algorithm of neural network in data fitting. This paper introduced the method of using neural network to fit the data through an example. Key Words:Curve fitting; Surface fitting; Least-squares method; Engineering applications 应用BP神经网络逼近非线性函 一、实验要求 1、逼近的非线性函数选取为y=sin(x1)+cos(x2),其中有两个自变量即x1,x2,一个因变量即y。 2、逼近误差<5%,即:应用测试数据对网络进行测试时,神经网络的输出与期望值的最大误差的绝对值小于期望值的5%。 3、学习方法为经典的BP算法或改进形式的BP算法,鼓励采用改进形式的BP算法。 4、不允许采用matlab中现有的关于神经网络建立、学习、仿真的任何函数及命令。 二、实验基本原理 2.1 神经网络概述 BP神经网络是一种多层前馈神经网络,该网络的主要特点是信号前向传播,误差反向传播。在前向传递中,输入信号从输入层经隐含层逐层处理,直至输出层。每一层的神经元状态只影响下一层神经元状态。如果输出层得不到期望输出,则转入反向传播,根据预判误差调整网络权值和阈值,从而使BP神经网络预测输出不断逼近期望输出。BP神经网络的拓扑结构如图所示。 2.2 BP神经网络训练步骤 BP神经网络预测前首先要训练网络,通过训练使网络具有联想记忆和预测能力。BP神经网络的训练过程包括以下几个步骤。 步骤1:网络初始化。根据系统输入输出序列(X,Y)确定网络输入层节点数n、隐含层节点数l、输出层节点数m,初始化输入层、隐含层和输出层神经元之间的连接权值ωij,ωjk,初始化隐含层阈值a,输出层阈值b,给定学习速率和神经元激励函数。 步骤2:隐含层输出计算。根据输入变量X,输入层和隐含层间连接权值ωij 以及隐含层阈值a,计算隐含层输出H。 j 1 (a )n j ij i i H f x ω==-∑ j=1,2,…,l 式中,l 为隐含层节点数,f 为隐含层激励函数,该函数有多种形式,一般选取为1 (x)1x f e -=+ 步骤3:输出层输出计算。根据隐含层输出H ,连接权值ωjk 和阈值b ,计算BP 神经 网络预测输出O 。 1 l k j jk k j O H b ω==-∑ k=1,2,…,m 步骤4:误差计算。根据网络预测输出O 和期望输出Y ,计算网络预测误差e 。 k k k e Y O =- k=1,2,…,m 步骤5:权值更新。根据网络预测误差e 更新网络连接权值ωij ,ωjk 1 (1)x(i)m ij ij j j jk k k H H e ωωηω==+-∑ i=1,2,…,n j=1,2,…,l jk jk j k H e ωωη=+ j=1,2,…,l k=1,2,…,m 步骤6:阈值更新。根据网络预测误差e 更新网络节点阈值a ,b 。 1 (1)m j j j j jk k k a a H H e ηω==+-∑ j=1,2,…,l k k k b b e =+ k=1,2,…,m 步骤7:判断算法迭代是否结束,若没有结束,返回步骤2。 2.3 附加动量法 经典BP 神经网络采用梯度修正法作为权值和阈值的学习算法,从网络预测误差的负梯 度方向修正权值和阈值,没有考虑以前经验的积累,学习过程收敛缓慢。对于这个问题,可以采用附加动量法来解决,带附加动量的算法学习公式为 [](k)(k 1)(k)a (k 1)(k 2)ωωωωω=-+?+--- 式中,ω(k),ω(k-1),ω(k-2)分别为k ,k-1,k-2时刻的权值;a 为动量学习率,一般取值为0.95。 BP 神经网络与多项式拟合曲线 摘要 首先介绍了曲线拟合的原理及其在曲线拟合中的应用。接着讨论了BP 神经网络的原理,研究了非线性拟合的在MATLAB 中仿真过程 通过比较可以看出利用神经网络进行非线性拟合具有拟合速度快、拟合精度高的特点。 关键词:曲线拟合;BP 神经网络;MATLAB 0 引言 在实际工程应用和科学实践中,为了描述不同变量之间的关系,需要根据一组测定的数据去求得自变量x 和因变量y 的一个函数关系)(x f y =,使其在某种准则下最佳地接近已知数据。 曲线拟合是用连续曲线近似地刻画或比拟平面上离散点组所表示坐标之间的函数关系的一种数据处理方法。从一组实验数据(i i y x ,) 中寻求自变量x 和因变量y 之间的函数关系)(x f y =来反映x 和y 之间的依赖关系,即在一定意义下最佳地逼近已知数据。应用曲线拟合的方法揭示数据之间内在规律具有重要的理论和现实意义。 1 多项式曲线拟合 1.1 曲线拟合原理 最小二乘法原理:对给定的数据点(i i y x ,)(N i ,...,2,1 =),在取定的函数类 φ中,求函数φ∈)(x f ,使误差i i y x f -)((N i ,...,1,0=)的平方和最小,即 [] ∑=-N i i i y x f 0 2 )(取到最小值。从几何意义上讲,就是寻求与给定点(i i y x ,) (N i ,...,2,1=)的距离平方和为最小的曲线)(x f y =。函数)(x f 称为拟合函数或最小二乘解,求拟合函数)(x f 的方法称为曲线拟合的最小二乘法。拟合函数和标志数据点之间的垂直距离是该点的误差。对该数据点垂直距离求平方,并把平方距离全加起来,拟合曲线应是使误差平方和尽可能小的曲线,即是最佳拟合。 1.2 最小二乘法曲线拟合 %利用神经网络工具箱对一个正弦函数进行拟合,源码如下: clc clear close all %----------------------------------------------- %产生训练样本与测试样本 P1=1:2:200; %训练样本,每一列为一个样本 T1=sin(P1*0.1); %训练目标 P2=1:2:200; %测试样本,每一列为一个样本 T2=sin(P2*0.1); %测试目标 %------------------------------------------------ %归一化 [PN1,minp,maxp,TN1,mint,maxt] = premnmx(P1,T1); PN2=tramnmx(P2,minp,maxp); TN2=tramnmx(T2,mint,maxt); %------------------------------------------- %设置网络参数 NodeNum = 20; %隐藏节点数 TypeNum = 1; %输出维数 TF1='tansig'; TF2='purelin'; %判别函数(缺省值) net=newff(minmax(PN1),[NodeNum TypeNum],{TF1 TF2}); %------------------------------------------------------ %指定训练参数 net.trainFcn='trainlm'; net.trainParam.show=20; %训练显示间隔 net.trainParam.lr=0.3; %学习步长-traubgd,traubgdm net.trainParam.mc=0.95; %动量项系数-traingdm,traingdx net.trainParam.mem_reduc=1; %分块计算Hessian矩阵(仅对Levenberg-Marquardt算法有效) net.trainParam.epochs=1000; %最大训练次数 net.trainParam.goal=1e-8; %最小均方误差 net.trainParam.min_grad=1e-20; %最小梯度 net.trainParam.time=inf; %最大训练时间 %------------------------------------------------------- %训练 net=train(net,PN1,TN1); %训练 %-------------------------------------------------- %测试 YN1=sim(net,PN1); %训练样本实际输出 YN2=sim(net,PN2); %测试样本实际输出 MSE1=mean((TN1-YN1).^2); MSE2=mean((TN2-YN2).^2); 神经网络近似函数 题目: 采用神经网络逼近下列函数: 双极值型算例 9655 .0,537.0] 3,0[2/)3)(89.22.3()(max max 2==∈-+--=f x x x x x x x f 最优值 解: )(x f 的实际图如下: 神经网络训练前: 应用newff()函数建立BP 网络结构。隐层神经元数目n 可以改变,暂设为n=5,输出层有一个神经元。选择隐层和输出层神经元传递函数分别为tansig 函数和purelin 函数,网络训练的算 法采用Levenberg – Marquardt算法trainlm。 因为使用newff( )函数建立函数网络时,权值和阈值的初始化是随机的,所以网络输出结构很差,根本达不到函数逼近的目的,每次运行的结果也不同。 神经网络训练后 应用train()函数对网络进行训练之前,需要预先设置网络训练参数。将训练时间设置为500,训练精度设置为0.001,其余参数使用缺省值。训练后得到的误差变化过程如下所示。 由上图可知,逼近结果未达到目标,为此我们增加神经元数目n=20; 仿真结果如下: 至此,神经网络逼近结果符合要求。 下图是训练时间图: 从以上结果可以看出,网络训练速度很快,很快就达到了要求的精度0.001。 结论: 1.n 取不同的值对函数逼近的效果有很大的影响。改变BP 网络隐层神经元的数目,可以改变BP 神经网络对于函数的逼近效果。隐层神经元数目越多,则BP 网络逼近非线性函数的能力越强。(左边n=3,右边n=20) 2.不同的精度要求,对函数的逼近效果也不同。精度要求越高,逼近效果越好。 (左边精度为0.01,右边为0.001) 程序文本: clear all; x=[0:0.001:3]; y=-x.*(x.*x-3.2*x+2.89).*(x-3)/2.0; net=newff(minmax(x),[5,1],{'tansig''purelin'},'trainlm'); y1=sim(net,x); %神经网络训练前 net.trainParam.epochs=500; net.trainParam.goal=0.001; net=train(net,x,y); 基于BP神经网络的非线性函数拟合 摘要:本文建立BP神经网络对一个多输入多输出系统的二元非线性函数进行拟合,仿真实验表明:在样本数据充足且不含噪声的情况下,训练的精度越高,逼近的效果越好;数据不充足且不含噪声时,训练精度的高低在一定范围内对于网络性能没有决定性的影响,网络性能主要取决于初始化;不管训练数据是否充足,若含有噪声,训练精度过高会使网络泛化能力降低。 0引言 作为当前应用最为广泛的一种人工神经网络,BP网络在函数逼近、模式识别、数据压缩、智能控制等领域有着非常广泛的应用。BP网络由大量简单处理单元广泛互联而成,是一种对非线性函数进行权值训练的多层映射网络,结构简单,工作状态稳定,具有优良的非线性映射能力,理论上它能够以任意精度逼近任意非线性函数。BP神经网络通过学习能够存储大量输入输出样本中蕴含的映射关系,只需提供足够的样本模式对BP网络进行训练,而无需事先了解数学方程。本文采用BP神经网络解决下列函数拟合问题。 函数逼近:设计一个神经网络拟合下列多输入多输出函数: y1=2+x1RP1.5-1.5sin(3x2); y2=x2sin(x1)+x1cos(x2); 1< x1, x2<5 产生200个数据,其中100个用来训练网络,另外100个用于网络模型的测试。1BP神经网络结构和算法 一个典型的3层BP神经网络结构如图1所示,包括输入层、隐含层和输出层。各层 神经元之间无反馈连接,各层内神经元之间无任何连接。其中隐含层的状态影响输入输出之间的关系,及通过改变隐含层的权系数,就可以改变整个多层神经网络的性能。BP 神经网络的学习过程由正向传播和反向传播组成。在正向传播中,输入的样本从输入层经过隐含层之后,传向输出层,在逐层处理的过程中,每一层神经元的状态只对下一层神经元的状态产生影响。在输出层把现行输出和期望输出进行比较,如果现行输出不等于期望输出,则进入反向传播过程。反向传播过程中,误差信号从输出层向输入层传播,并对每个隐含层的各个神经元的权系数进行修改,使误差不断减少,直至达到精度要求。BP 算法的实质是求取误差函数最小值问题,通过多个样本的反复训练,一般采用非线性规划中的最速下降方法,按误差函数的负梯度方向修改权系数。 隐含节点 图1 典型3层BP神经网络结构图 2用于函数拟合的BP神经网络模型的建立 为建立函数拟合的BP神经网络模型,一般要考虑以下几步: (1) 样本数据的产生 为简单起见,在x1,x2均属于[1,5]区间内选择均匀分布的200个数据点分别作为训练和测试样本。如图2所示。人工神经网络及其数据拟合中的应用

BP神经网络实现函数逼近python实现

神经网络

神经网络作业(函数逼近)

神经网络在数据拟合方面的应用分析

BP神经网络逼近非线性函数

BP神经网络与多项式拟合曲线

神经网络实例--对正弦函数拟合

神经网络逼近函数

基于BP神经网络的非线性函数拟合