最新版ENVI5.3下高分二号(GF2)数据预处理

ENVI5.3下高分二号(GF2)数据预处理

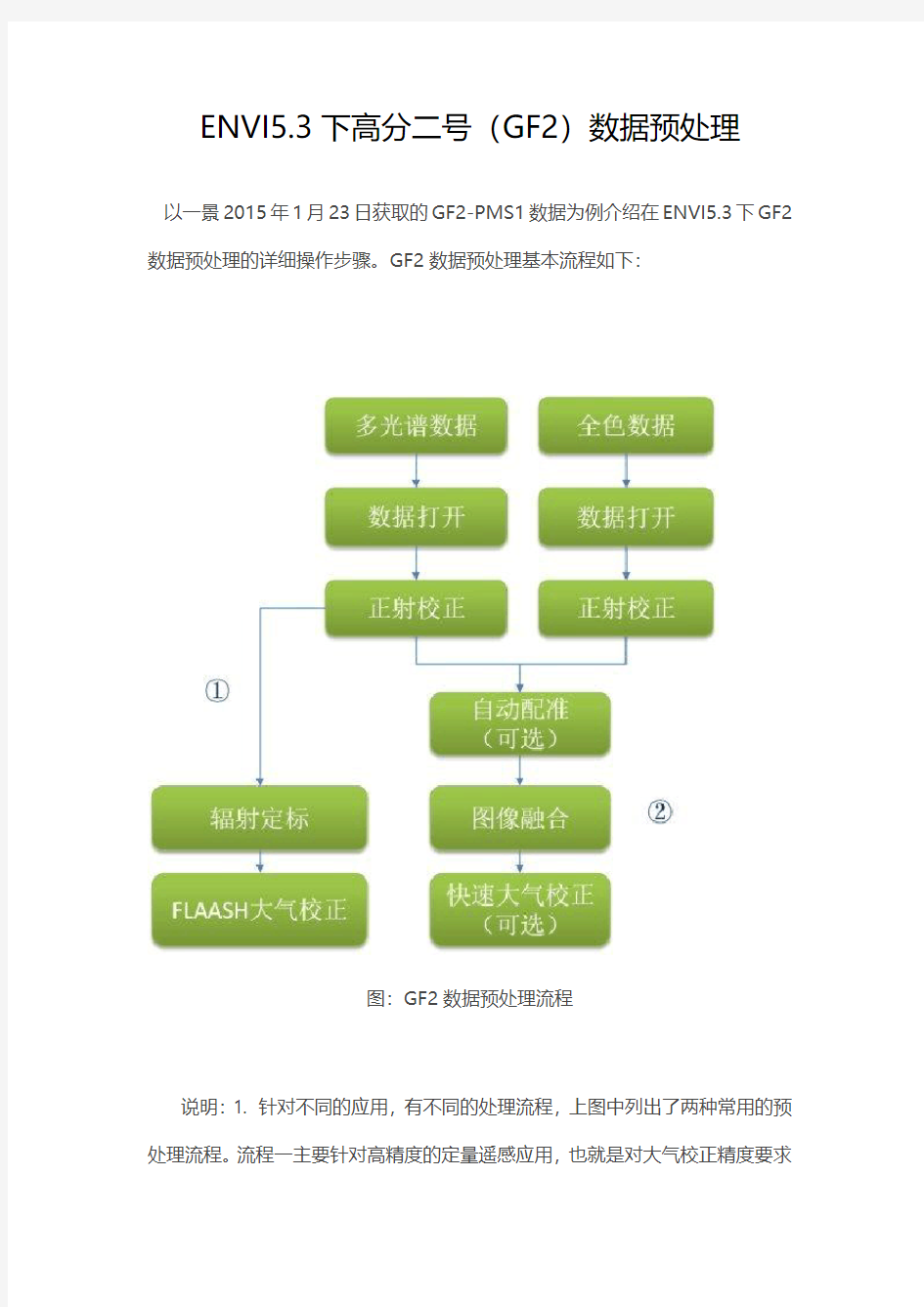

以一景2015年1月23日获取的GF2-PMS1数据为例介绍在ENVI5.3下GF2数据预处理的详细操作步骤。GF2数据预处理基本流程如下:

图:GF2数据预处理流程

说明:1. 针对不同的应用,有不同的处理流程,上图中列出了两种常用的预处理流程。流程一主要针对高精度的定量遥感应用,也就是对大气校正精度要求

比较高应用,比如:植被参数定量反演等;流程二主要针对定性遥感或者对大气校正精度要求比较低的遥感应用,比如:土地利用类型分类等。本文介绍的主要是流程二的详细操作步骤,流程一的实现可参考日志:ENVI5.2下高分二号数据FLAASH大气校正;另外,中国资源卫星应用中心网站已经公布了最新的GF2数据绝对辐射定标系数和两个传感器的波谱响应函数,大家可以下载使用。2. 本例中所有操作都是在ENVI5.3版本下进行的,除NNDiffuse Pan Sharpening 图像融合(ENVI5.2新增,ENVI5.1中可以使用G-S融合方法)外,其他操作在ENVI5.1/5.2下同样可以完成。

1. 数据打开

启动ENVI5.3,在菜单栏中,选择File > Open,弹出Open对话框,找到GF2数据文件夹所在位置,选中扩展名为.tiff的两个文件,点击打开。

图2 打开GF2多光谱和全色数据

在左侧图层管理Layer Manager面板中,选择多光谱或全色数据图层,右键View Metadata查看其元数据信息,可以看到ENVI很好地识别了数据的RPC 信息。

图3 ENVI自动识别GF2数据RPC信息

2. 正射校正

有了RPC信息之后,下面我们就可以基于这些RPC信息分别对多光谱和全色数据进行正射校正。这里我们以多光谱数据正射校正为例,全色数据正射校正操作完全相同。

在Toolbox中,选择Geometric Correction > Orthorectification > RPC Orthorectification Workflow,打开正射校正流程化工具。

在File Selection面板中,Input File选择多光谱数据,DEM File会默认选择全球分辨率为900米的DEM数据,我们这里保持默认(如果有更高分辨率的DEM数据,可以替换此数据),点击Next。

图4 正射校正流程化工具文件选择面板

在RPC Refinement面板中,有四个选项卡可以选择。如果我们有实测的或从其他途径(比如:从地形图中采集)获取的控制点数据,可以在该面板中进行添加,添加后在Statistics选项卡中可以看到相应的误差统计信息切换到Advanced选项卡,修改输出像元大小Output Pixel Size为4米,重采样方法Image Resampling选择三次卷积法,其他参数保持默认。

图5 正射校正流程化工具参数设置选项卡

切换到Export选项卡,选择输出文件格式,设置输出路径及文件名,点击Finish。

至此,我们已经完成了GF2多光谱数据的正射校正,全色数据的正射校正操作与多光谱数据的正射校正完全相同,需要提醒的地方是GF2全色数据正射校正时输出像元大小需设置为1米,以便我们下面进行图像融合。

3. 图像融合

在进行图像融合之前,我们需要对正射校正后的多光谱和全色数据进行浏览,查看二者是否完全配准,如果没有完全配准,就需要对其进行配准,这里我们推荐大家使用ENVI中的自动配准流程化工具,以全色数据为基准对多光谱数据进行配准,此工具的位置在:Geometric Correction > Registration > Image Registration Workflow,

图6 查看GF2多光谱和全色正射校正结果配准情况

对本次操作中正射校正后的多光谱和全色数据的对比发现,二者配准的比较好(目前,大部分高分辨率数据正射校正后多光谱和全色数据配准的均比较好),所以我们这里不进行图像配准,直接进行图像融合。图像融合方法我们使用从ENVI5.2版本起新增的NNDiffuse Pan Sharpening方法,大家也可以使用Gram-Schmidt Pan Sharpening等其它方法进行融合。

在进行融合之前,还需要说明的是:经过我们的测试,不同的数据存储格式会对融合的速度产生影响,当多光谱数据的存储格式为BIL或BIP时,其融合速度较BSQ格式来说,可以提高三倍左右。所以,我们建议大家融合之前可以先查看其数据存储格式,如果是BSQ,可以将其转化为BIL或BIP(转换时需要用到的工具:Raster Management > Convert Interleave),以便提高融合效率,这里,我们也为大家提供了将上述步骤与融合步骤合并为一个步骤的扩展工具:NNDiffuse Pan Sharpening (BIL)。

在Toolbox中,选择Extensions > NNDiffuse Pan Sharpening (BIL),弹出NNDiffuse Pan Sharpening面板。Input Low Resolution Raster选择上一步正射校正后的多光谱数据,Input High Resolution Raster选择上一步正射校正后的全色数据,其他参数保持默认。这里,需要说明的是NNDiffuse Pan Sharpening工具要求输入的多光谱和全色数据的空间分辨率是整数倍的(比如:本例中正射校正时分别将多光谱的全色的分辨率重采样为4米和1米,就是为了方便该工具的使用)。如果二者不是整数倍,使用此工具时需要将其重采样成整数倍;该工具对输入文件还有一些要求,平时我们使用的数据也基本满足这些要求,如果使用过程中报错可以查看帮助文档,判断输入数据是否满足相应要求。

图7 NNDiffuse Pan Sharpening参数设置面板

至此,我们已经完成了GF2数据图像融合处理,融合结果局部截图如下所示:

图8 GF2数据融合前后对比(左:融合前,右:融合后)

4. 快速大气校正(可选)

对于部分定性和定量遥感应用来说,大气校正是一个必需的预处理步骤。而对于一些对大气校正精度要求不是很高的应用来说,大气校正我们可以采用ENVI提供的快速大气校正工具进行。对于一些非定量遥感应用来说(比如:制作影像底图),该步骤可以不做。

在Toolbox中,选择Radiometric Correction > Atmospheric Correction Module > QUick Atmospheric Correction (QUAC),弹出QUAC参数设置面板。Input Raster选择上一步图像融合后的结果,Sensor Type选择Generic/Unknown Sensor,设置输出路径和文件名,点击OK。

图9 快速大气校正参数设置面板

快速大气校正前后同一位置的植被光谱曲线如下图所示。可以看到,快速大气校正基本消除或减弱了大气的影响。

图10 快速大气校正前后植被光谱曲线对比

数据采集与处理讲解

1数据的采集与处理 1.1数据的采集 施工监控中需对影响施工及控制精度的数据进行收集,主要包括环境参数和结构参数,前者又主要是指风速风向数据;后者主要指结构容重、弹模等数据。施工监控需进行收集的数据如表1-1所示。 1.1.2数据采集方法 基于港珠澳大桥特殊的地理位置,采用远程数据采集系统,与传统的数据采集系统相比,具有不受地理环境、气候、时间的影响等优势。而借助无线传输手段的远程数据采集系统,更具有工程造价和人力资源成本低,传输数据不受地域的影响,可靠性高,免维护等优点。远程无线数据采集系统的整体结构如图1-2所示。 1-2 远程无线数据采集系统组成结构图

1.2数据的处理与评估 在数据分析之前, 数据处理要能有效地从监测数据中寻找出异常值, 必须对监测数据进行可靠性检验, 剔除粗差的影响, 以保证监测数据的准确、可靠。我们拟采用的是最常用的μ检验法来判别系统误差; 用“3σ准则”剔除粗差; 采用了“五点二次中心平滑”法对观测数据进行平滑修正。同时, 在数据处理之后, 采用关联分析技术寻找某一测点的最佳关联点, (为保证系统评判的可靠性, 某一测点的关联点宜选用2 个以上)。我们选用3 个关联测点, 如果异常测值的关联测点有2 个以上发生异常, 且异常方向一致, 则认为测值异常是由结构变化引起, 否则, 认为异常是由监测系统异常引起。出现异常时, 经过判定, 自动提醒用户检查监测系统或者相应的结构(根据测点所在位置), 及时查明情况, 并采取一些必要的应急措施, 同时对测值做标注, 形成报表, 进行评估。 1.2.1系统误差的判别 判别原则: 异常值检验方法是建立在随机样本观测值遵从正态分布和小概率原理的基础之上的。根据观测值的正态分布特征性, 出现大偏差观测值的概率是很小的。当测值较少时, 在正常情况下, 根据小概率原理, 它们是不会出现的, 一旦出现则表明有异常值。依统计学原理: 偏差处于2 倍标准差或3 倍标准差范围内的数据为正常值, 之外的则判定为异常。事实上标准差σ多数情况下是求知的, 通常用样本值计算的标准差S 来替代。桥梁健康监测资料的数据量特别大, 一般都为大样本, 所以我们用μ检验。在分析中, 我们将所得的数据分成两组Y1 、Y2,并设()1211,1Y N u δ, ()2222,2Y N u δ择统计量为 : 'y y U -= (1) 式中12y y 、—两组样本的平均值: 21n 、n —两组样本的子样数: 21S S 、 —两组样本的方差。若 '2 a U U ≥ (2) 则存在系统误差。否则, 不存在系统误差。 1.2.2 粗差点的剔除 在观测次数充分多的前提下, 其测值的跳动特征描述如下式: ()112j j j j d y y y +-=-+ (3) 式中j y (j=1,2,3,4,……,n- 1)是一系列观测值。

Matlab笔记——数据预处理——剔除异常值及平滑处理

012. 数据预处理(1)——剔除异常值及平滑处理测量数据在其采集与传输过程中,由于环境干扰或人为因素有可能造成个别数据不切合实际或丢失,这种数据称为异常值。为了恢复数据的客观真实性以便将来得到更好的分析结果,有必要先对原始数据(1)剔除异常值; 另外,无论是人工观测的数据还是由数据采集系统获取的数据,都不可避免叠加上“噪声”干扰(反映在曲线图形上就是一些“毛刺和尖峰”)。为了提高数据的质量,必须对数据进行(2)平滑处理(去噪声干扰); (一)剔除异常值。 注:若是有空缺值,或导入Matlab数据显示为“NaN”(非数),需要①忽略整条空缺值数据,或者②填上空缺值。 填空缺值的方法,通常有两种:A. 使用样本平均值填充;B. 使用判定树或贝叶斯分类等方法推导最可能的值填充(略)。 一、基本思想: 规定一个置信水平,确定一个置信限度,凡是超过该限度的误差,就认为它是异常值,从而予以剔除。

二、常用方法:拉依达方法、肖维勒方法、一阶差分法。 注意:这些方法都是假设数据依正态分布为前提的。 1. 拉依达方法(非等置信概率) 如果某测量值与平均值之差大于标准偏差的三倍,则予以剔除。 3x i x x S -> 其中,11 n i i x x n ==∑为样本均值,1 2 211()1n x i i S x x n =?? ??? =--∑为样本的标准偏差。 注:适合大样本数据,建议测量次数≥50次。 代码实例(略)。 2. 肖维勒方法(等置信概率) 在 n 次测量结果中,如果某误差可能出现的次数小于半次时,就予以剔除。 这实质上是规定了置信概率为1-1/2n ,根据这一置信概率,可计算出肖维勒系数,也可从表中查出,当要求不很严格时,还可按下列近似公式计算:

大数据处理流程的主要环节

大数据处理流程的主要环节 大数据处理流程主要包括数据收集、数据预处理、数据存储、数据处理与分析、数据展示/数据可视化、数据应用等环节,其中数据质量贯穿于整个大数据流程,每一个数据处理环节都会对大数据质量产生影响作用。通常,一个好的大数据产品要有大量的数据规模、快速的数据处理、精确的数据分析与预测、优秀的可视化图表以及简练易懂的结果解释,本节将基于以上环节分别分析不同阶段对大数据质量的影响及其关键影响因素。 一、数据收集 在数据收集过程中,数据源会影响大数据质量的真实性、完整性数据收集、一致性、准确性和安全性。对于Web数据,多采用网络爬虫方式进行收集,这需要对爬虫软件进行时间设置以保障收集到的数据时效性质量。比如可以利用八爪鱼爬虫软件的增值API设置,灵活控制采集任务的启动和停止。 二、数据预处理 大数据采集过程中通常有一个或多个数据源,这些数据源包括同构或异构的数据库、文件系统、服务接口等,易受到噪声数据、数据值缺失、数据冲突等影响,因此需首先对收集到的大数据集合进行预处理,以保证大数据分析与预测结果的准确性与价值性。

大数据的预处理环节主要包括数据清理、数据集成、数据归约与数据转换等内容,可以大大提高大数据的总体质量,是大数据过程质量的体现。数据清理技术包括对数据的不一致检测、噪声数据的识别、数据过滤与修正等方面,有利于提高大数据的一致性、准确性、真实性和可用性等方面的质量; 数据集成则是将多个数据源的数据进行集成,从而形成集中、统一的数据库、数据立方体等,这一过程有利于提高大数据的完整性、一致性、安全性和可用性等方面质量; 数据归约是在不损害分析结果准确性的前提下降低数据集规模,使之简化,包括维归约、数据归约、数据抽样等技术,这一过程有利于提高大数据的价值密度,即提高大数据存储的价值性。 数据转换处理包括基于规则或元数据的转换、基于模型与学习的转换等技术,可通过转换实现数据统一,这一过程有利于提高大数据的一致性和可用性。 总之,数据预处理环节有利于提高大数据的一致性、准确性、真实性、可用性、完整性、安全性和价值性等方面质量,而大数据预处理中的相关技术是影响大数据过程质量的关键因素 三、数据处理与分析 1、数据处理 大数据的分布式处理技术与存储形式、业务数据类型等相关,针对大数据处理的主要计算模型有MapReduce分布式计算框架、分布式内存计算系统、分布式流计算系统等。

数据采集与预处理-课程标准_教学大纲

《数据采集与预处理》课程标准 1. 概述 1.1课程的性质 本课程是大数据技术与应用专业、云计算技术与应用专业、软件技术专业的专业核心课程,是校企融合系列化课程,该课程教学内容以任务驱动为主线,围绕企业级应用进行项目任务设计。 1.2课程设计理念 本课程遵循应用型本科和高等职业教育规律,以大数据技术与应用实际工作岗位需求为导向选取课程内容,完成了数据采集和预处理平台搭建、网络爬虫实践、日志数据采集实践和数据预处理实践等完整的数据采集与预处理应用案例,课程目标是培养学生具备“大数据分析”应用项目所需数据采集与预处理的综合职业能力;坚持开放性设计原则,吸收企业专家参与,构建以“工作任务”为载体的“项目化”课程结构;课程教学实施教、学、做一体,坚持理论为实践服务的教学原则,通过模拟企业大数据采集与预处理应用业务进行组织,锻炼学生的实践操作能力。 1.3课程开发思路 通过岗位技能的项目化以及大数据采集与预处理任务的序列化,对内容体系结构进行了适当调 整与重构,以适应教学课程安排。以项目案例及其任务实现为驱动,凭借翔实的操作步骤和准确的 说明,帮助学生迅速掌握大数据采集与预处理的相关知识与技能,并且充分考虑学习操作时可能发 生的问题,并提供了详细的解决方案,突出岗位技能训练。 2.课程目标 本课程的培养目标是使学生以大数据分析岗位需求为依托,以实际工作任务为导向,理清大数据采集与预处理中常用工具的作用及应用,培养学生大数据采集与预处理的实际操作技能。 2.1知识目标 本课程本书以任务驱动为主线,围绕企业级应用进行项目任务设计,完成了数据采集和预处理平台搭建、网络爬虫实践、日志数据采集实践和数据预处理实践等完整的数据采集与预处理应用案例,要求学生系统掌握scrapy、Flume、pig、kettle、Pandas、openrefine和urllib、selenium基本库 1

Matlab学习系列012.大数据预处理1剔除异常值及平滑处理

012. 数据预处理(1)——剔除异常值及平滑处理 测量数据在其采集与传输过程中,由于环境干扰或人为因素有可能造成个别数据不切合实际或丢失,这种数据称为异常值。为了恢复数据的客观真实性以便将来得到更好的分析结果,有必要先对原始数据(1)剔除异常值; 另外,无论是人工观测的数据还是由数据采集系统获取的数据,都不可避免叠加上“噪声”干扰(反映在曲线图形上就是一些“毛刺和尖峰”)。为了提高数据的质量,必须对数据进行(2)平滑处理(去噪声干扰); (一)剔除异常值。 注:若是有空缺值,或导入Matlab数据显示为“NaN”(非数),需要①忽略整条空缺值数据,或者②填上空缺值。 填空缺值的方法,通常有两种:A. 使用样本平均值填充;B. 使用判定树或贝叶斯分类等方法推导最可能的值填充(略)。 一、基本思想: 规定一个置信水平,确定一个置信限度,凡是超过该限度的误差,

就认为它是异常值,从而予以剔除。 二、常用方法:拉依达方法、肖维勒方法、一阶差分法。 注意:这些方法都是假设数据依正态分布为前提的。 1. 拉依达方法(非等置信概率) 如果某测量值与平均值之差大于标准偏差的三倍,则予以剔除。 3x i x x S -> 其中,11 n i i x x n ==∑为样本均值,1 2 211()1n x i i S x x n =?? ??? =--∑为样本的标准偏差。 注:适合大样本数据,建议测量次数≥50次。 代码实例(略)。 2. 肖维勒方法(等置信概率) 在 n 次测量结果中,如果某误差可能出现的次数小于半次时,就予以剔除。 这实质上是规定了置信概率为1-1/2n ,根据这一置信概率,可计算出肖维勒系数,也可从表中查出,当要求不很严格时,还可按下

数据采集与处理技术

数据采集与处理技术 参考书目: 1.数据采集与处理技术马明建周长城西安交通大学出版社 2.数据采集技术沈兰荪中国科学技术大学出版社 3.高速数据采集系统的原理与应用沈兰荪人民邮电出版社 第一章绪论 数据采集技术(Data Acquisition)是信息科学的一个重要分支,它研究信息数据的采集、存贮、处理以及控制等作业。在智能仪器、信号处理以及工业自动控制等领域,都存在着数据的测量与控制问题。将外部世界存在的温度、压力、流量、位移以及角度等模拟量(Analog Signal)转换为数字信号(Digital Signal), 在收集到计算机并进一步予以显示、处理、传输与记录这一过程,即称为“数据采集”。相应的系统即为数据采集系统(Data Acquisition System,简称DAS)数据采集技术以在雷达、通信、水声、遥感、地质勘探、震动工程、无损检测、语声处理、智能仪器、工业自动控制以及生物医学工程等领域有着广泛的应用。 1.1 数据采集的意义和任务 数据采集是指将温度、压力、流量、位移等模拟量采集、转换为数字量后,再由计算机进行存储、处理、显示或打印的过程。相应的系统称为数据采集系统。 数据采集系统的任务:采集传感器输出的模拟信号并转换成计算机能识别的数字信号,然后送入计算机,根据不同的需要由计算机进行相应的计算和处理,得出所需的数据。与此同时,将计算得到的数据进行显示或打印,以便实现对某些物理量的监视,其中一部分数据还将被生产过程中的计算机控制系统用来控制某些物理量。 数据采集系统的好坏,主要取决于精度和速度。 1.2 数据采集系统的基本功能 1.数据采集:采样周期

高光谱数据处理基本流程

高光谱分辨率遥感 用很窄(10-2l)而连续的光谱通道对地物持续遥感成像的技术。在可见光到短波红外波段其光谱分辨率高达纳米(nm)数量级,通常具有波段多的特点,光谱通道数多达数十甚至数百个以上,而且各光谱通道间往往是连续的,每个像元均可提取一条连续的光谱曲线,因此高光谱遥感又通常被称为成像光谱(ImagingSpectrometry)遥感。 高光谱遥感具有不同于传统遥感的新特点: (1)波段多——可以为每个像元提供几十、数百甚至上千个波段; (2)光谱范围窄——波段范围一般小于10nm; (3)波段连续——有些传感器可以在350~2500nm的太阳光谱范围内提供几乎连续的地物光谱; (4)数据量大——随着波段数的增加,数据量成指数增加; (5)信息冗余增加——由于相邻波段高度相关,冗余信息也相对增加。 优点: (1)有利于利用光谱特征分析来研究地物; (2)有利于采用各种光谱匹配模型; (3)有利于地物的精细分类与识别。 ENVI高光谱数据处理流程: 一、图像预处理 高光谱图像的预处理主要是辐射校正,辐射校正包括传感器定标和大气纠正。辐射校正一般由数据提供商完成。 二、显示图像波谱 打开高光谱数据,显示真彩色图像,绘制波谱曲线,选择需要的光谱波段进行输出。 三、波谱库 1、标准波谱库 软件自带多种标准波谱库,单击波谱名称可以显示波谱信息。 2、自定义波谱库 ENVI提供自定义波谱库功能,允许基于不同的波谱来源创建波谱库,波谱

来源包括收集任意点波谱、ASCII文件、由ASD波谱仪获取的波谱文件、感兴趣区均值、波谱破面和曲线等等。 3、波谱库交互浏览 波谱库浏览器提供很多的交互功能,包括设置波谱曲线的显示样式、添加注记、优化显示曲线等 四、端元波谱提取 端元的物理意义是指图像中具有相对固定光谱的特征地物类型,它实际上代表图像中没有发生混合的“纯点”。 端元波谱的确定有两种方式: (1)使用光谱仪在地面或实验室测量到的“参考端元”,一般从标准波谱库选择; (2)在遥感图像上得到的“图像端元”。 端元波谱获取的基本流程: (1)MNF变换 重要作用为:用于判定图像内在的维数;分离数据中的噪声;减少计算量;弥补了主成分分析在高光谱数据处理中的不足。 (2)计算纯净像元指数PPI PPI生成的结果是一副灰度的影像,DN值越大表明像元越纯。 作用及原理: 纯净像元指数法对图像中的像素点进行反复迭代,可以在多光谱或者高光谱影像中寻找最“纯”的像元。(通常基于MNF变换结果来进行)

大数据采集技术和预处理技术

现如今,很多人都听说过大数据,这是一个新兴的技术,渐渐地改变了我们的生活,正是由 于这个原因,越来越多的人都开始关注大数据。在这篇文章中我们将会为大家介绍两种大数 据技术,分别是大数据采集技术和大数据预处理技术,有兴趣的小伙伴快快学起来吧。 首先我们给大家介绍一下大数据的采集技术,一般来说,数据是指通过RFID射频数据、传 感器数据、社交网络交互数据及移动互联网数据等方式获得的各种类型的结构化、半结构化 及非结构化的海量数据,是大数据知识服务模型的根本。重点突破高速数据解析、转换与装 载等大数据整合技术设计质量评估模型,开发数据质量技术。当然,还需要突破分布式高速 高可靠数据爬取或采集、高速数据全映像等大数据收集技术。这就是大数据采集的来源。 通常来说,大数据的采集一般分为两种,第一就是大数据智能感知层,在这一层中,主要包 括数据传感体系、网络通信体系、传感适配体系、智能识别体系及软硬件资源接入系统,实 现对结构化、半结构化、非结构化的海量数据的智能化识别、定位、跟踪、接入、传输、信 号转换、监控、初步处理和管理等。必须着重攻克针对大数据源的智能识别、感知、适配、 传输、接入等技术。第二就是基础支撑层。在这一层中提供大数据服务平台所需的虚拟服务器,结构化、半结构化及非结构化数据的数据库及物联网络资源等基础支撑环境。重点攻克 分布式虚拟存储技术,大数据获取、存储、组织、分析和决策操作的可视化接口技术,大数 据的网络传输与压缩技术,大数据隐私保护技术等。 下面我们给大家介绍一下大数据预处理技术。大数据预处理技术就是完成对已接收数据的辨析、抽取、清洗等操作。其中抽取就是因获取的数据可能具有多种结构和类型,数据抽取过 程可以帮助我们将这些复杂的数据转化为单一的或者便于处理的构型,以达到快速分析处理 的目的。而清洗则是由于对于大数并不全是有价值的,有些数据并不是我们所关心的内容, 而另一些数据则是完全错误的干扰项,因此要对数据通过过滤去除噪声从而提取出有效数据。在这篇文章中我们给大家介绍了关于大数据的采集技术和预处理技术,相信大家看了这篇文 章以后已经知道了大数据的相关知识,希望这篇文章能够更好地帮助大家。

红外与近红外光谱常用数据处理算法

一、数据预处理 (1)中心化变换 (2)归一化处理 (3)正规化处理 (4)标准正态变量校正(标准化处理)(Standard Normal Variate,SNV)(5)数字平滑与滤波(Smooth) (6)导数处理(Derivative) (7)多元散射校正(Multiplicative Scatter Correction,MSC) (8)正交信号校正(OSC) 二、特征的提取与压缩 (1)主成分分析(PCA) (2)马氏距离 三、模式识别(定性分类) (1)基于fisher意义下的线性判别分析(LDA) (2)K-最邻近法(KNN) (3)模型分类方法(SIMCA) (4)支持向量机(SVM) (5)自适应boosting方法(Adaboost) 四、回归分析(定量分析) (1)主成分回归(PCR) (2)偏最小二乘法回归(PLS) (3)支持向量机回归(SVR)

一、数据预处理 (1) 中心化变换 中心化变换的目的是在于改变数据相对于坐标轴的位置。一般都是希望数据集的均值与坐标轴的原点重合。若x ik 表示第i 个样本的第k 个测量数据,很明显这个数据处在数据矩阵中的第i 行第k 列。中心化变换就是从数据矩阵中的每一个元素中减去该元素所在元素所在列的均值的运算: u ik k x x x =- ,其中k x 是n 个样本的均值。 (2) 归一化处理 归一化处理的目的是是数据集中各数据向量具有相同的长度,一般为单位长度。其公式为: 'ik x = 归一化处理能有效去除由于测量值大小不同所导致的数据集的方差,但是也可能会丢失重要的方差。 (3)正规化处理 正规化处理是数据点布满数据空间,常用的正规化处理为区间正规化处理。其处理方法是以原始数据集中的各元素减去所在列的最小值,再除以该列的极差。 min() 'max()min() ik ik k k x xk x x x -= - 该方法可以将量纲不同,范围不同的各种变量表达为值均在0~1范围内的数据。但这种方法对界外值很敏感,若存在界外值,则处理后的所有数据近乎相等。 (4) 标准化处理(SNV )也称标准正态变量校正 该处理能去除由单位不同所引起的不引人注意的权重,但这种方法对界外点不像区间正规化那样的敏感。标准化处理也称方差归一化。它是将原始数据集各个元素减去该元素所在列的元素的均值再除以该列元素的标准差。 ';ik k ik k k x x x S S -==

大数据采集与处理技术考试卷

一、绪论 (一)、1、“数据采集”是指什么? 将温度、压力、流量、位移等模拟量经测量转换电路输出电量后再采集转换成数字量后,再由PC 机进行存储、处理、显示或打印的过程。 2、数据采集系统的组成? 由数据输入通道,数据存储与管理,数据处理,数据输出及显示这五个部分组成。 3、数据采集系统性能的好坏的参数? 取决于它的精度和速度。 4、数据采集系统具有的功能是什么? (1)、数据采集,(2)、信号调理,(3)、二次数据计算,(4)、屏幕显示,(5)、数据存储,(6)、打印输出,(7)、人机联系。 5、数据处理系统的分类? 分为预处理和二次处理两种;即为实时(在线)处理和事后(脱机)处理。 6、集散式控制系统的典型的三级结构? 一种是一般的微型计算机数据采集系统,一种是直接数字控制型计算机数据采集系统,还有一种是集散型数据采集系统。 7、控制网络与数据网络的结合的优点? 实现信号的远程传送与异地远程自动控制。 (二)、问答题: 1、数据采集的任务是什么? 数据采集系统的任务:就是传感器输出信号转换为数字信号,送入工业控制机机处理,得出所需的数据。同时显示、储存或打印,以便实现对某些物理量的监视,还将被生产过程中的PC机控制系统用来控制某些物理量。 2、微型计算机数据采集系统的特点是 (1)、系统结构简单;(2)、微型计算机对环境要求不高;(3)、微型计算机的价格低廉,降低了数据采集系统的成本;(4)、微型计算机数据采集系统可作为集散型数据采集系统的一个基本组成部分;(5)、微型计算机的各种I/O模板及软件齐全,易构成系统,便于使用和维修; 3、简述数据采集系统的基本结构形式,并比较其特点? (1)、一般微型计算机数据采集与处理系统是由传感器、模拟多路开关、程控放大器、采样/保持器、A/D转换器、计算机及外设等部分组成。 (2)、直接数字控制型数据采集与处理系统(DDC)是既可对生产过程中的各个参数进行巡回检测,还可根据检测结果,按照一定的算法,计算出执行器应该的状态(继电器的通断、阀门的位置、电机的转速等),完成自动控制的任务。系统的I/O通道除了AI和DI外,还有模拟量输出(AO)通道和开关量输出(FDO)通道。 (3)、集散式控制系统也称为分布式控制系统,总体思想是分散控制,集中管理,即用几台计算机分别控制若干个回路,再用监督控制计算机进行集中管理。 (三)、分析题: 1、如图所示,分析集散型数据采集与处理系统的组成原理,系统有那些特点?

脑电数据预处理步骤讲解学习

脑电数据预处理步骤

1)脑电预览。首先要观察被试脑电基本特征,然后剔除原始信号中一些典型的干扰噪声、肌肉运动等所产生的十分明显的波形漂移数据。 2)眼电去除。使用伪迹校正(correction)的方法,即从采集的 EEG 信号中减去受眼电(EOG)伪迹影响的部分。首先寻找眼电的最大绝对值,用最大值的百分数来定义 EOG 伪迹。接着构建平均伪迹,将超过 EOG 最大值某个百分比(如10%)的眼电导联电位识别为 EOG 脉冲,对识别的 EOG 脉冲进行平均,由协方差估计公式(2-1)计算平均 EOG 脉冲和其它电极之间的 EEG 的传递系数 b: b=cov(EOG, EEG)/var(EOG) (2-1) 其中 cov 表示协方差(covariance),var 表示方差(variance)。 最后根据公式(2-2)对受眼动影响的电极在产生眼动的时间段的波形进行校正,点对点地用 EEG 减去 EOG: corrected EEG=original EEG-b×EOG (2-2) 实验中设置最小眨眼次数为 20 次,眨眼持续时间 400ms。 3)事件提取与脑电分段。ERP 是基于事件(刺激)的诱发脑电,所以不同刺激诱发的 ERP 应该分别处理。在听觉认知实验中,多种类型的刺激会重复呈现,而把同种刺激诱发的脑电数据提取出来的过程叫做事件提取。这样,连续的脑电数据就会根据刺激事件为标准划分为若干段等长数据。以实验刺激出现的起始点为 0 时刻点,根据实验出现的事件对应的事件码,将脑电数据划分成许多个数据段,每段为刺激前 100ms 到刺激后 600ms。对每个试次(一个刺激以及相应的一段加工过程)提取一段同样长度的数据段。 4)基线校正。此步骤用于消除自发脑电活动导致的脑电噪声,以 0 时刻点前的数据作为基线,假设 0 时刻点前的脑电信号代表接收刺激时的自发脑电,用 0时刻点后的数据减去 0 时刻点前的各点数据的平均值,可以消除部分的自发脑

光谱预处理方法的作用与目的

光谱预处理方法的作用与目的 光谱预处理的方法有很多,应结合实际情况合理选取最好的预处理方法。 1.均值中心化(mean centering):增加样品光谱之间的差异,从而提高模型的 稳健性和预测能力。 2.标准化(autoscaling):该方法给光谱中所有变量相同的权重,在对低浓度 成分建立模型时特别适用。 3.归一化(normalization):常用于微小光程差异引起的光谱变化。 4.平滑去噪算法(smoothing):是消除噪声最常用的一种方法。其效果与选择 的串口数有关,窗口数太大,容易失真;窗口数过小,效果不佳。 5.导数(derivative):可有效的消除基线和其他背景的干扰,分别重叠峰,提 高分辨率和灵敏度。 6.标准正太变换(SNV):主要用来消除固体颗粒大小、表面散射以及光程变 化对漫反射光谱的影响。去趋势算法常用在SNV处理后的光谱,用来消除南反射光谱的基线漂移。 7.多元散射校正(msc):作用于SNV 差不多,主要是消除颗粒分布不均匀及 颗粒大小产生的散射影响,在固体漫反射和浆状物透射和反射光谱中运用比较多。 8.傅里叶变换(FT):能够实现时域和频域之间的转换。仪器的噪声相对于信 息信号而言,其振幅更小,频率更高,故舍去高频率的部分信号可以消除大部分光谱噪声,使信号更加平滑,利用低频信号,通过傅里叶反变换,对原始光谱数据重构,达到去除噪声的目的。 9.小波变换(WT):将信号转变成一系列的小波函数的叠加,这些小波函数都 是由一个母小波函数经过平移和尺度伸缩得到,小波变换在时域和频域同时具有良好的局部化性质,他可以对高频成分采用逐步精细化的时域或空间域取代步长,从而达到聚焦到对象的任意细节。

振动信号的采集与预处理

振动信号的采集与预处理 几乎所有的物理现象都可看作是信号,但这里我们特指动态振动信号。 振动信号采集与一般性模拟信号采集虽有共同之处,但存在的差异更多,因此,在采集振动信号时应注意以下几点: 1. 振动信号采集模式取决于机组当时的工作状态,如稳态、瞬态等; 2. 变转速运行设备的振动信号采集在有条件时应采取同步整周期采集; 3. 所有工作状态下振动信号采集均应符合采样定理。 对信号预处理具有特定要求是振动信号本身的特性所致。信号预处理的功能在一定程度上说是影响后续信号分析的重要因素。预处理方法的选择也要注意以下条件: 1. 在涉及相位计算或显示时尽量不采用抗混滤波; 2. 在计算频谱时采用低通抗混滤波; 3. 在处理瞬态过程中1X矢量、2X矢量的快速处理时采用矢量滤波。 上述第3条是保障瞬态过程符合采样定理的基本条件。在瞬态振动信号采集时,机组转速变化率较高,若依靠采集动态信号(一般需要若干周期)通过后处理获得1X和2X矢量数据,除了效率低下以外,计算机(服务器)资源利用率也不高,且无法做到高分辨分析数据。机组瞬态特征(以波德图、极坐标图和三维频谱图等型式表示)是固有的,当组成这些图谱的数据间隔过大(分辨率过低)时,除许多微小的变化无法表达出来,也会得出误差很大的分析结论,影响故障诊断的准确度。一般来说,三维频谱图要求数据的组数(△rpm分辨率)较少,太多了反而影响对图形的正确识别;但对前面两种分析图谱,则要求较高的分辨率。目前公认的方式是每采集10组静态数据采集1组动态数据,可很好地解决不同图谱对数据分辨率的要求差异。 影响振动信号采集精度的因素包括采集方式、采样频率、量化精度三个因素,采样方式不同,采集信号的精度不同,其中以同步整周期采集为最佳方式;采样频率受制于信号最高频率;量化精度取决于A/D转换的位数,一般采用12位,部分系统采用16位甚至24位。 振动信号的采样过程,严格来说应包含几个方面: 1. 信号适调 由于目前采用的数据采集系统是一种数字化系统,所采用的A/D芯片对信号输入量程有严格限制,为了保证信号转换具有较高的信噪比,信号进入A/D以前,均需进行信号适调。适调包括大信号的衰减处理和弱信号的放大处理,或者对一些直流信号进行偏置处理,使其满足A/D输入量程要求。 2. A/D转换

最常见的近红外光谱的预处理技术的综述

最常见的近红外光谱的预处理技术的综述 smund Rinnan,Frans van den Berg,S?ren Balling Engelsen 摘要:预处理在近红外(NIR)光谱数据处理化学计量学建模中已经成为不可分割的一部分。预处理的目的是消除光谱中物理现象在为了提高后续多元回归、分类模型或探索性分析。最广泛使用的预处理技术可以分为两类:散射校正方法和光谱间隔方法。综述和比较了算法的基础理论和当前的预处理方法以及定性和定量的后果的应用程序。其目的是提供更好的NIR 最终模型的建立,在此我们通过对光谱的预处理基本知识进行梳理。 关键词:乘法散射校正;近红外光谱法;标准化;诺里斯威廉姆斯推导;预处理;Savitzky-Golay 平滑;散射校正;光谱导数;标准正态变量;综述 1.引言 目前为止,没有能够优化数据来进行代替,但是经过适当的数据收集和处理将会起到优化效果,对光谱数据进行预处理是最重要的一步(例如最优化之前叠层建模),常用的方法有主成分分析(PCA)和偏最小二乘法(PLS)。在大量的文献中,多变量光谱应用食品、饲料和医药分析,比较不同的预处理的结果研究模型的预测结果是不可分割的组成部分。近红外反射/透射率(NIR / NIT)光谱的光谱技术,到目前为止最多被使用的和最大的多样性在预处理技术,主要是由于入非线性光散射的光谱可以引起显著影响。由于类似规模的波长的电磁辐射和粒子大小的近红外光谱在生物样品,近红外光谱技术是一种不被广泛使用是由于存在散射效应(包括基线转变和非线性),这将会影响样品光谱的结果的记录。然而,通过应用合适的预处理,可以很大程度上消除这些影响。 在应用研究中,比较了几乎完全不同的定标模型(定量描述符和相应关系)。几乎没有出现评估的差异和相似性的报道。替代技术即修正的含义(例如,谱描述符数据)在研究中很少被讨论。本文旨在讨论建立了预处理方法对近红外光谱和模型之间的关系,更具体地说,这些技术都是对应独立的响应变量,所以我们只讨论方法,不需要一个响应值。我们同时关注预处理工艺理论方面的和实际效果,这种方法适用于近红外光谱/ NIT光谱。 对固体样品,干扰系统的差异主要是因为光散射的不同和有效路径长度的不同。这些不受欢迎的变化常常构成了样本集的总变异的主要部分,可以观察到得转变基线(乘法效应)和其他现象称为非线性。一般来说,近红外光谱反射率测量的一个示例将测量普及性的反映和镜面反射辐射(镜面反射)。镜面反射通常由仪表设计和几何的采样最小化,因为它们不含任何化学信息。这个diffusively反射的光,这反映在广泛的方向,是信息的主要来源在近红外光谱。然而,diffusively反射光将包含信息的化学成分不仅示例(吸收)而且结构(散射)。主要的形式的光散射(不包括能量转移与样品)瑞利和洛伦兹米氏。两者都是过程中电磁辐射是分散的(例如,通过小粒子,泡沫,表面粗糙度,水滴,晶体缺陷,microorganelles、细胞、纤维和密度波动)。 当粒子尺寸大于波长,因为通常情况下,NIR光谱,是主要的洛仑兹米氏散射。相比之下,瑞利散射,是各向异性,洛伦兹米氏散射依赖的形状散射粒子和不强烈波长依赖性。 对生物样品,散射特性是过于复杂,所以软或自适应补偿,光谱预处理技术,正如我们近红外光谱在本文中进行讨论,要求删除散射从纯粹的、理想的吸收光谱。 显然,预处理不能纠正镜面反射率(直接散射),自谱不包含任何精细结构。光谱主要由镜面反射率应该总是被移除之前为离群值多元数据分析,因为他们仍将是局外人,甚至在预处理。图1显示了一组13好蔗糖和样品不同粒径加一坏蔗糖的例子展示如何(极端)镜面反射率表现比正常的光谱。 图1还演示了总体布局的大多数数据在本文中。上部的图,一个条形图显示了主成分得分值第一主成分(PC)后的样本集数据意味着定心[1]。下面部分显示预处理效果的数据集(或

大数据分析和处理的方法步骤

大数据处理数据时代理念的三大转变:要全体不要抽样,要效率不要绝对精确,要相关不要因果。具体的大数据处理方法其实有很多,但是根据长时间的实践,天互数据总结了一个基本的大数据处理流程,并且这个流程应该能够对大家理顺大数据的处理有所帮助。整个处理流程可以概括为四步,分别是采集、导入和预处理、统计和分析,以及挖掘。 采集 大数据的采集是指利用多个数据库来接收发自客户端的数据,并且用户可以通过这些数据库来进行简单的查询和处理工作。比如,电商会使用传统的关系型数据库MySQL和Oracle等来存储每一笔事务数据,除此之外,Redis和MongoDB 这样的NoSQL数据库也常用于数据的采集。 在大数据的采集过程中,其主要特点和挑战是并发数高,因为同时有可能会有成千上万的用户来进行访问和操作,比如火车票售票网站和淘宝,它们并发的访问量在峰值时达到上百万,所以需要在采集端部署大量数据库才能支撑。并且如何在这些数据库之间进行负载均衡和分片的确是需要深入的思考和设计。 统计/分析 统计与分析主要利用分布式数据库,或者分布式计算集群来对存储于其内的海量数据进行普通的分析和分类汇总等,以满足大多数常见的分析需求,在这方面,一些实时性需求会用到EMC的GreenPlum、Oracle的Exadata,以及基于MySQL 的列式存储Infobright等,而一些批处理,或者基于半结构化数据的需求可以使用Hadoop。统计与分析这部分的主要特点和挑战是分析涉及的数据量大,其对系统资源,特别是I/O会有极大的占用。 导入/预处理 虽然采集端本身会有很多数据库,但是如果要对这些海量数据进行有效的分析,还是应该将这些来自前端的数据导入到一个集中的大型分布式数据库,或者分布式存储集群,并且可以在导入基础上做一些简单的清洗和预处理工作。也有一些用户会在导入时使用来自Twitter的Storm来对数据进行流式计算,来满足

数据采集和数据预处理

数据采集和数据预处理 3.2.1 数据采集 数据采集功能主要用于实现对DSM分析研究中所需的电力供需、相关政策法规等原始数据、信息的多种途径采集。数据采集为使用者提供定时数据采集、随机采集、终端主动上报数据等多种数据采集模式,支持手工输入、电子表格自动导入等多种导入方式,且能够对所采集的数据进行维护,包括添加、修改、删除等,并能进行自动定期备份。在需求侧管理专业化采集中,` 采集的数据根据结构特点,可以分为结构化数据和非结构化数据,其中,结构化数据包括生产报表、经营报表等具有关系特征的数据;非结构化数据,主要包括互联网网页( HTML)、格式文档( Word、PDF)、文本文件(Text)等文字性资料。这些数据目前可以通过关系数据库和专用的数据挖掘软件进行挖掘采集。特别是非结构化数据,如DSM相关的经济动态、政策法规、行业动态、企业动态等信息对DSM分析研究十分重要,综合运用定点采集、元搜索、主题搜索等搜索技术,对互联网和企业内网等数据源中符合要求的信息资料进行搜集,保证有价值信息发现和提供的及时性和有效性。DSM信息数据采集系统中数据采集类型如图2所示。在数据采集模块中,针对不同的数据源,设计针对性的采集模块,分别进行采集工作,主要有网络信息采集模块、关系数据库信息采集模块、文件系统资源采集模块和其他信息源数据的采集模块。 (1)网络信息采集模块。网络信息采集模块的主要功能是实时监控和采集目标网站的内容,对采集到的信息进行过滤和自动分类处理,对目标网站的信息进行实时监控,并把最新的网页及时采集到本地,形成目标站点网页的全部信息集合,完整记录每个网页的详细信息,包括网页名称、大小、日期、标题、文字内容及网页中的图片和表格信息等。 (2)关系数据库采集模块。该模块可以实现搜索引擎数据库与关系型数据库(包括Oracle、Sybase、DB2、SQL Server、MySQL等)之间的数据迁移、数据共享以及两者之间的双向数据迁移。可按照预设任务进行自动化的信息采集处理。 ( 3)文件系统资源采集模块。该模块可以实现对文件系统中各种文件资源(包括网页、XML文件、电子邮件、Office文件、PDF文件、图片、音视频多媒体文件、图表、公文、研究报告等)进行批量处理和信息抽取。 ( 4)其他信息源数据的采集。根据数据源接入方式,利用相应的采集工具进行信息获取、过滤等。 3.2.2 数据预处理 数据预处理的本质属于数据的“深度采集”,是信息数据的智能分析处理。利用网页内容分析、自动分类、自动聚类、自动排重、自动摘要/主题词抽取等智能化处理技术,对采集到的海量数据信息进行挖掘整合,最终按照统一规范的组织形式存储到DSM数据仓库,供图1 系统体系结构分析研究使用。数据预处理的工作质量很大程度上决定最终服务数据的质量,是DSM类项目(如,DSM项目全过程管理、有序用电方案评价等)深度分析的重要基础。在数据智能分析处理中,主要包括:1)自动分类,用于对采集内容的自动分类;2)自动摘要,用于对采集内容的自动摘要;3)自动排重,用于对采集内容的重复性判定。 ************************************** 电力数据采集与传输是电力系统分析和处理的一个重要环节。从采集被测点的各种信息,如母线电压,线路电压、电流、有功、无功,变压器的分接头位置,线路上的断路器、隔离开关及其它设备状态、报警、总有功功率、事件顺序等,对电力系统运行管理具有重要作用[ 1]。********************************** 电力信息的数据采集与集成 电力作为传统[业,其下属分系统众多,因而数据的种类也相当繁杂。数据类型包括工程

004-振动信号的采集与预处理

004-振动信号的采集与预处理

振动信号的采集与预处理 1振动信号的采集 振动信号采集与一般性模拟信号采集虽有共同之处,但存在的差异更多。在采集振动信号时应注意以下几点: 1.振动信号采集模式取决于机组当时的工作状态,如稳态、瞬态等; 2.变转速运行设备的振动信号采集在有条件时应采取同步整周期采集; 3.所有工作状态下振动信号采集均应符合采样定理。 1.1 信号适调 由于目前采用的数据采集系统是一种数字化系统,所采用的A/D芯片对信号输入量程有严格限制,为了保证信号转换具有较高的信噪比,信号进入A/D以前,均需进行信号适调。适调包括大信号的衰减处理和弱信号的放大处理,或者对一些直流信号进行偏置处理,使其满足A/D输入量程要求。 1.2 A/D转换 A/D转换包括采样、量化和编码三个组成部分。 1.2.1采样 采样(抽样),是利用采样脉冲序列p(t)从模拟信号x(t)中抽取一系列离散样值,使之成为采样信号x(n△t)(n=0,1,2,…)的过程。△t称为采样间隔,其倒数称1/△t=f s之为采样频率。采样频率的选择必须符合采样定理要求。 1.2.2量化 由于计算机对数据位数进行了规定,采样信号x(n△t)经舍入的方法变为只有有限个有效数

字的数,这个过程称为量化。由于抽样间隔长度是固定的(对当前数据来说),当采样信号落入某一小间隔内,经舍入方法而变为有限值时,则 产生量化误差。如8位二进制为28 =256,即量化增量为所测信号最大电压幅值的1/256。 1.2.3 编码 振动信号经过采样和量化后,量化后的数据按照一定的协议进行编码,成为处理器可以处理的数据。 采样定理解决的问题是确定合理的采样间隔△t 以及合理的采样长度T ,保障采样所得的数字信号能真实地代表原来的连续信号x(t)。 衡量采样速度高低的指标称为采样频率f s 。一般来说,采样频率f s 越高,采样点越密,所获得的数字信号越逼近原信号。为了兼顾计算机存储量和计算工作量,一般保证信号不丢失或歪曲原信号信息就可以满足实际需要了。这个基本要求就是所谓的采样定理,是由Shannon 提出的,也称为Shannon 采样定理。 Shannon 采样定理规定了带限信号不丢失信息的最低采样频率为: 2s m f f ≥或2s m ωω≥ 式中f m 为原信号中最高频率成分的频率。 采集的数据量大小N 为: T N t =? 因此,当采样长度一定时,采样频率越高,采集的数据量就越大。 使用采样频率时有几个问题需要注意。 一, 正确估计原信号中最高频率成分的频率,对于采用电涡流传感器测振的系统来说,一

数据预处理综述

数据预处理综述 摘要:当今社会生物信息学已成为整个生命科学发展的重要组成部分,成为生命科学研究的前沿。随着测序技术的不断进步,获取基因序列的时间不断缩短,测序分析中的关键步骤之一的数据预处理也变得尤为重要。本文对基因测序的主要两种方法,数据预处理的概念及方法等方面进行了论述。随着技术的不断革新我们对生物信息学的掌握将更加深入更加灵活,数据预处理技术的要求也越来越高,它在功能基因的准确发现与识别、基因与蛋白质的表达与功能研究方面都将发挥关键的作用。 关键词:sanger测序法,Illumina,Sequencing by Synthesis ,FASTQC,Trimmomatic 1 主要的测序方法 重点描述sanger法和以Illumina/Solexa Genome Analyzer 的测序。 Sanger法是根据核苷酸在某一固定的点开始,随机在某一个特定的碱基处终止,并且在每个碱基后面进行荧光标记,产生以A、T、C、G结束的四组不同长度的一系列核苷酸,然后在尿素变性的PAGE胶上电泳进行检测,从而获得可见的DNA碱基序列。 原理:是利用一种DNA聚合酶来延伸结合在待定序列模板上的引物。直到掺入一种链终止核苷酸为止。每一次序列测定由一套四个单独的反应构成,每个反应含有所有四种脱氧核苷酸三磷酸(dNTP),并混入限量的一种不同的双脱氧核苷三磷酸(ddNTP)。由于ddNTP缺乏延伸所需要的3-OH基团,使延长的寡聚核苷酸选择性地在G、A、T或C处终止。终止点由反应中相应的双脱氧而定。每一种dNTPs和ddNTPs的相对浓度可以调整,使反应得到一组长几百至几千碱基的链终止产物。它们具有共同的起始点,但终止在不同的的核苷酸上,可通过高分辨率变性凝胶电泳分离大小不同的片段,凝胶处理后可用X-光胶片放射自显影或非同位素标记进行检测。DNA的复制需要:DNA聚合酶,双链DNA模板,带有3'-OH末端的单链寡核苷酸引物,4种dNTP(dATP、dGTP、dTTP和dCTP)。聚合酶用模板作指导,不断地将dNTP加到引物的3'-OH末端,使引物延伸,合成出新的互补DNA链。如果加入一种特殊核苷酸,双脱氧核苷三磷酸(ddNTP),因它在脱氧核糖的3’位置缺少一个羟基,故不能同后续的dNTP形成磷酸二酯键。如,存在ddCTP、dCTP和三种其他的dNTP(其中一种为α-32P标记)的情况下,将引物、模板和DNA聚合酶一起保温,即可形成一种全部具有相同的5'-引物端和以ddC残基为3’端结尾的一系列长短不一片段的混合物。经变性聚丙烯酰胺凝胶电泳分离制得的放射性自显影区带图谱将为新合成的不同长度的DNA链中C的分布提供准确信息,从而将全部C的位置确定下来。类似的方法,在ddATP、ddGTP和ddTTP存在的条件下,可同时制得分别以ddA、ddG和ddT残基为3‘端结尾的三组长短不一的片段。将制得的四组混合物平行地点加在变性聚丙烯酰胺凝胶电泳板上进行电泳,每组制品中的各个组分将按其链长的不同得到分离,制得相应的放射性自显影图谱。从所得图谱即可直接读得DNA的碱基序列。与DNA复制不同的是sanger测序中的引物是单引物或者是单链。 第二代DNA序列测序技术(以Illumina/Solexa Genome Analyzer 测序为例) 核心思想:边合成边测序(Sequencing by Synthesis),即通过捕捉新合成的末端的标记来确定DNA的序列 基本原理:Illumina/Solexa Genome Analyzer测序的基本原理是边合成边测序。在Sanger 等测序方法的基础上,通过技术创新,用不同颜色的荧光标记四种不同的dNTP,当DNA聚合酶合成互补链时,每添加一种dNTP就会释放出不同的荧光,根据捕捉的荧光信号并经过特定的计算机软件处理,从而获得待测DNA的序列信息。 操作流程: 1)测序文库的构建(Library Construction):首先准备基因组DNA(虽然测序公司