09级信息论与编码复习材料

一、填空

1. 信息论基础主要研究信息的测度、 信道容量 、 信源和信道编码理论 等问题。

2. 必然事件的自信息量是0,不可能事件的自信息量是无穷大。

3. 若把掷骰子的结果作为一离散信源,则信源熵为

2log 6

。

4. 当事件i x 和j y 彼此之间相互独立时,平均互信息量为 0 。

5. 若二维平稳信源的信源熵为3bit/sign ,则其平均符号熵为1.5bit/sign 。

6. 信源熵H(X)表示信源输出后每个消息所提供的 平均信息量 。

7. 布袋中有红白球各50只,若从中随意取出一只球,则判断其颜色所需的信息量为 1bit 。 8. 单符号离散信源是用随机变量来描述的,则多符号离散信源用随机矢量来描述。 9. 平均互信息量与信息熵、联合熵的关系是I(X;Y)=H(X)+H(Y)-H(XY) 。 10. 条件熵H (x|y )和无条件熵H (X )的关系是小于等于。 11. 对于理想信道,H (x|y )等于0 ;I (x ;y )= H (X )。

12. 若YZ 统计独立,则H (YZ )和H (Y )、H (Z )之间的关系是H (YZ )=H (Y )+H (Z ) 。 13. 对某含有7个消息的信源,其熵的最大值为2log 7,对应为等概分布分布。 14. 对某含有8个消息的信源,其熵的最大值为2log 8,对应为等概分布。 15. 对某含有6个消息的信源,其熵的最大值为2log 6,对应为等概分布。 16. 对某含有9个消息的信源,其熵的最大值为2log 9,对应为等概分布。 17. 十六进制脉冲所含的信息量是四进制脉冲的2 倍。 18. 八进制脉冲所含的信息量是二进制脉冲的3倍。 19. 十六进制脉冲所含的信息量是二进制脉冲的 4倍。

20. 离散平稳无记忆信源的N 次扩展信源的熵等于离散信源熵的N 倍。 21. 离散信源的熵越小,则该信源消息之间的平均不确定性越弱。 22. 对于r 进制树图,n 级节点的个数一般为n

r 。

23. 信道中任一时刻输出符号仅统计依赖于对应时刻的输入符号,而与非对应时刻的输入符号及其它任何时刻的输出符号无关,

这种信道称之为 有干扰无记忆信道 。

24. 对于某一信源和某一符号集来说,若有一个唯一可译码,其平均码长小于所有其它唯一可译码的平均码长,则称该码为紧致

码或最佳码 。

25. 分组码是前向纠错码 ,它可以在无需重新发射的情况下检测出有限个错码,并加以纠正。 26. 信源编码的目的是提高通信的有效性。

27. 对于香农编码和哈夫曼编码,编码方法唯一的是香农编码 。

28. 若纠错码的最小距离为dmin,则可以纠错任意小于等于(dmin-1)/2个差错。 29. 线性分组码是同时具有线性特性和分组特性的纠错码。

30. 道的输出仅与当前输入有关,而与过去无关的信道称无记忆信道。 31. 唯一可译码存在的充要条件是11i n

k i m -=≤∑。

32. 编码分为信源编码和信道编码两种。

33. 信道无失真传输信息的条件是信息传输速率小于信道容量。

34. 对称信道中,信源的最佳分布为等概分布。

35. 信源编码和信道编码的最大区别在于信源编码需减少信源的冗余度,而信道编码需增加信源的冗余。

36. 信道编码的目的是提高通信的可靠性。

37. 离散信源分为离散无记忆信源 和 离散有记忆信源。

38. ()R D 是D 的下凸函数。

39. 码字10100001与码字01100000之间的距离是 3 。 40. 码字011111101、100111001之间的最汉明距离为5。 41. 码字101110101、100111001之间的最汉明距离为3。

42. 码字101111101、011111101、100111001之间的最小汉明距离为 2 。 43. 码字101010101、100111001之间的最汉明距离为4。 44. 码字101010101、100101001之间的最汉明距离为5。 45. 码字10100001与码字01100000之间的距离是 3 。 46. 将循环码0010111循环左移位1之后的码字10101110。 47. 将循环码0010111循环左移位2之后的码字1011100。 48. 将循环码0010111循环左移4位之后的码字1110010。

二、解释下列名词

自信息量:一个随机事件发生某一结果后所带来的信息量称为自信息量,简称自信息。2()log ()i i I a p a =-

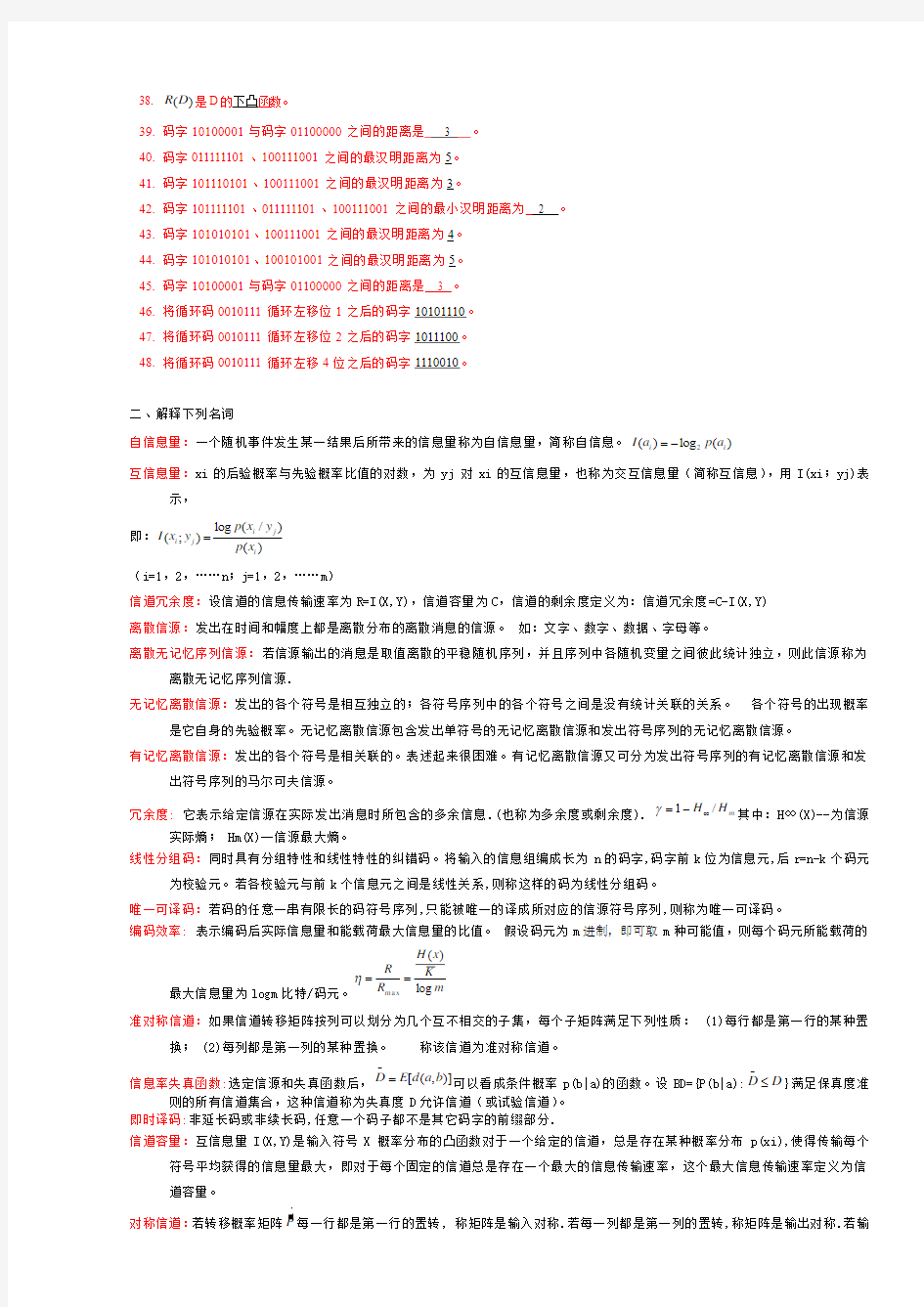

互信息量:xi 的后验概率与先验概率比值的对数,为yj 对xi 的互信息量,也称为交互信息量(简称互信息),用I(xi ;yj)表

示, 即:log (/)

(;)()

i j i j i p x y I x y p x =

(i=1,2,……n ;j=1,2,……m )

信道冗余度:设信道的信息传输速率为R=I(X,Y),信道容量为C ,信道的剩余度定义为:信道冗余度=C-I(X,Y) 离散信源:发出在时间和幅度上都是离散分布的离散消息的信源。 如:文字、数字、数据、字母等。

离散无记忆序列信源:若信源输出的消息是取值离散的平稳随机序列,并且序列中各随机变量之间彼此统计独立,则此信源称为

离散无记忆序列信源.

无记忆离散信源:发出的各个符号是相互独立的;各符号序列中的各个符号之间是没有统计关联的关系。 各个符号的出现概率

是它自身的先验概率。无记忆离散信源包含发出单符号的无记忆离散信源和发出符号序列的无记忆离散信源。

有记忆离散信源:发出的各个符号是相关联的。表述起来很困难。有记忆离散信源又可分为发出符号序列的有记忆离散信源和发

出符号序列的马尔可夫信源。

冗余度: 它表示给定信源在实际发出消息时所包含的多余信息.(也称为多余度或剩余度).

m H H /1∞-=γ其中:H ∞(X)--为信源

实际熵; Hm(X)--信源最大熵。

线性分组码:同时具有分组特性和线性特性的纠错码。将输入的信息组编成长为n 的码字,码字前k 位为信息元,后r=n-k 个码元

为校验元。若各校验元与前k 个信息元之间是线性关系,则称这样的码为线性分组码。

唯一可译码:若码的任意一串有限长的码符号序列,只能被唯一的译成所对应的信源符号序列,则称为唯一可译码。

编码效率: 表示编码后实际信息量和能载荷最大信息量的比值。 假设码元为m 进制,即可取m 种可能值,则每个码元所能载荷的

最大信息量为logm 比特/码元。

m K

x H R R log )

(max ==η 准对称信道:如果信道转移矩阵按列可以划分为几个互不相交的子集,每个子矩阵满足下列性质: (1)每行都是第一行的某种置

换; (2)每列都是第一列的某种置换。 称该信道为准对称信道。

信息率失真函数:选定信源和失真函数后,)],([b a d E D =-

可以看成条件概率p(b|a)的函数。设BD={P(b|a):D D ≤-

}满足保真度准

则的所有信道集合,这种信道称为失真度D 允许信道(或试验信道)。 即时译码:非延长码或非续长码,任意一个码子都不是其它码字的前缀部分.

信道容量:互信息量I(X,Y)是输入符号X 概率分布的凸函数对于一个给定的信道,总是存在某种概率分布p(xi),使得传输每个

符号平均获得的信息量最大,即对于每个固定的信道总是存在一个最大的信息传输速率,这个最大信息传输速率定义为信道容量。

对称信道:若转移概率矩阵P 每一行都是第一行的置转, 称矩阵是输入对称.若每一列都是第一列的置转,称矩阵是输出对称.若输

入输出都对称,称对称DMC 信道。

汉明距离:长度为n 的两个符号序列(码字)αi 和βj 之间的汉明距离为αi 和βj 对应位置上不同码元的个数, 汉明距离记为d(α

i,βj)

循环码:设c 是线性分组码的任一码字,如果c 经循环移位c=(c1,c 2,…,cn-1,cn)→c ⑴=(c2,c3,…,cn-1cn,c1)后的序列仍然

是码字, 那么称该线性分组码为循环码。

无损压缩:长是利用数据的统计冗余进行压缩,可完全回复原始数据而不引起任何失真。 但压缩率是受到数据统计冗余度的理论

限制,一般为2:1到5:1。

有损压缩:经过压缩、解压的数据与原始数据不同,但是非常接近的压缩方法,又称破坏型压缩,即将次要的信息数据压缩掉,牺

牲一些质量来减少数据量,使压缩比提高。

输出对称信道:如果信道转移概率矩阵中所有列矢量都是第一列的某种置换,则称信道是关于输出对称离散信道。

有噪无损信道:信道输出符号Y 集合的数量大于信道符号X 集合的数量,即r <s,形成一对多的映射关.由于一对多的映射关系,不

能由输入完全确定信道的输出,H(X ︱Y) >0,H(X)<H(Y),I(X;Y)=H(X).

{}{}()

()

max (;)max ()log p x p x C I X Y H x r ===

码树:码树有一个树根A,树根有m 个树枝,树枝的尽头称为节点,每个节点生出是树枝的数量等于码符号的数量m ,从而形成m 进

制的码树。

非即时译码:接收端收到一个完整的码字后,不能立即译码,而等下一码字开始接收后才判断是否可以码. 平均码长:编码后的每个信源符号平均所需的码元(码符号)个数。

1()q

i i i K P x K ==∑

3.简答

简述信息、消息、信号及其区别。

答:信息是事物运动状态或存在方式的不确定性的描述。信息的基本概念在于它的不确定性,任何确定的事物都不会有信息。用文字、符号、数据、语言、音符、图片、图像等能够被人们感觉器官所感知的形式,把客观物质运动和主观思维活动的状态表达出来就成为消息。消息包含信息,是信息的载体,但不是物理性的。把消息换成适合信道传输的物理量(如电信号、光信号、声信号、生物信号等),这种物理量称为信号。信号是信息的载体,是物理性的。

信息量、联合自信息量和条件自信息量三者之间的关系。

信息是事物运动状态或存在方式的不确定性的描述。信息的基本概念在于它的不确定性,任何确定的事物都不会有信息。用文字、符号、数据、语言、音符、图片、图像等能够被人们感觉器官所感知的形式,把客观物质运动和主观思维活动的状态表达出来就成为消息。消息包含信息,是信息的载体,但不是物理性的。把消息换成适合信道传输的物理量(如电信号、光信号、声信号、生物信号等),这种物理量称为信号。信号是信息的载体,是物理性的。 简述信源熵物理含义。

(1)信息熵H(X)表示了信源输出前,信源的平均不确定性; (2)信息熵H(X)表示了信源输出后,每个消息或符号所提供的平均信息量; (3)信息熵H(X)反映了随机变量X 的随机性。 描述最大离散熵定理的内容。

离散无记忆信源输出M 个不同的信息符号,当且仅当各个符号出现概率相等时(即pi=1/M ),熵最大。111

()(,,..,)log H X H M M M M

≤= 简答描述单符号离散信源的数学模型。

单符号离散信源输出的消息是以一个符号的形式出现.信源每次只发出一个符号代表一个消息,可用离散随机变量来描述。 设X={ a1,a2 · · · an },这n 个符号消息的概率分布是:12{(),(),

()}n p p a p a p a =

1

212.......

()()......().....()i n i n a a a a X p a p a p a P a P ??

??=????????0≤p(ai)≤1,()1i p a =∑

信源熵、条件熵、联合熵之间的关系。

H(XY)= H(X)+H(Y/X) H(XY)= H(Y)+H(X/Y)

条件熵小于无条件熵,H(Y/X)≤H(Y)。当且仅当y 和x 相互独立p(y/x)=p(y),H(Y/X)=H(Y)。

两个条件下的条件熵小于一个条件下的条件熵H(Z/X,Y)≤H(Z/Y) 当且仅当p(z/x,y)=p(z/y)时取等号。 简述香农第二定理的内容。

答:对任意一个离散无记忆平稳信道,设信道容量为C,则只要信息传输率R 道编码方案(n 足够大),以小于ε的错误概率实现可靠通信。反之,R>C 时不可能找到一种编码,使错误概率pe 趋于零。 简述信源编码的实质。 是对信源的原始符号按一定的数学规则进行的一种变换,以码字代替原始信源符号,使变换后得到的码符号接近等概率分布,从而提高信息的传输有效性。 简述单个符号变长编码定理。 若一离散无记忆信源的符号熵为H(X),每个信源符号用m 进制码元进行变长编码,一定存在一种无失真编码方法,其码字平均长 简单叙述香农编码的步骤。 编码步骤如下: (1)将信源发出的q 个消息符号按其概率的递减次序依次排列:12...q p p p ≥≥≥; (2)按下式计算第i 个消息的二进制代码组的码长i l ,并取整;log ()log ()1i i i p s l p s -≤<-+ (3)为了编成唯一可译码,首先计算第i 个消息的累加概率1 1 ()i i k k P p s -==∑; (4)将累加概率i P (为小数)变换成二进制。 (5)去除小数点,并根据码长i l ,取小数点后i l 位数作为第i 个信源符号的码字,由下式确定:log ()1i i l p s =-+。 写出费诺编码步骤。 答:1. 将信源消息符号按其出现概率大小依次排列: p(x1)≥p(x2) …. p(xn)。2 .将依次排列的信源符号按概率植分两大组,并对各组赋予一个二进制元码0、1。3.将每一大组的信源符号进一步分组,使划分后的两组概率和近于相同并又赋两组0,1。4.如此重复,至两组只剩下一个信源符号为止。5.信源符号所对应的码字即为费诺码. 写出哈夫曼编码步骤。 (1) 将n 个信源消息符号按其出现的概率大小依次排列,p(x1)≥p(x2)≥…≥p(xn) (2) 取两个概率最小的字母分别配以0和1两码元,并将这两个概率相加作为一个新字母的概率,与未分配的二进符号的字母重新排队。 (3) 重复步骤(2)的过程,直到最后两个符号配以0和1为止; (4)从最后一级开始,向前返回得到各个信源符号所对应的码元序列。 描述克劳夫特不等式。 用码树的概念可以推导出唯一可译码存在的充要条件,即各码字的长度K i 应符合不等式11i n k i m -=≤∑ m 是进制数,n 是信源符号数 称之为克劳夫特(Kraft)不等式 简单叙述无噪无损信道、无噪有损信道、有噪无损信道的信道容量。 无噪无损信道: {}{}符号比特/log )(max );(max 1 )() (r X H Y X I C r x p x p ==== 无噪有损信道: {}{}符号比特/log )(max );(max ) () (s Y H Y X I C x p x p === 有噪无损信道: {}{})/(log )(max );(max ) () (符号比特r x H Y X I C x p x p === 简单叙述离散信道、连续信道、半连续半离散信道。 离散信道:又称数字信道,该类信道中输入空间、输出空间均为离散时间集合,集合中事件的数量是有限的,或者无限的,随机变量取值都是离散的。连续信道:又称为模拟信道,输入空间、输出空间均为连续事件集合,集合中事件的数量是无限的、不可数的,即随机变量的取 值数量是无限的,或者不可数的。半离散半连续信道:输入空间、输出空间一个为离散事件集合,而另一个则为连续事件集合,即输入、输出随机变量一个是离散的,另一个是连续的。 简述一个通信系统包括的各主要功能模块及其作用 简单叙述算术编码的步骤。 四、大题 某地二月份天气的概率分布统计如下:晴天的概率是1/2,阴天的概率是1/4,雨天的概率是1/8,雪天的概率也是1/8。求此四种气候的自信息量分别的是多少? 解:“I(a1)=1(比特) I(a2)=2(比特),I(a3)=3(比特),I(a4)=3(比特) 英文字母中“e ”出现的概率是0.105,“c ”出现的概率是0.023,“o ”出现的概率 是0.001。分别计算其自信息量。 解:“e ”:I(e)=-㏒20.105=3.25(比特) “c ”:I(c)=-㏒20.023=5.44(比特) “o ”:I(o)=-㏒20.001=9.97(比特) 一个布袋内放有100个球,其中80个球是红色的,20个球是白色的,若随机摸取一个球,猜测其颜色,求平均摸取一次所能获得的自信息量。 x1表示摸出的球为红球,x2表示摸出的球为白球 当被告知摸出的是红球,则获得的信息量是: I(x1)=-㏒p(x1)=-㏒0.8(比特) 当被告知摸出的是白球,则获得的信息量是: I(x2)=-㏒p(x2)=-㏒0.2(比特) 同时掷2颗色子,事件A 、B 、C 分别表示:(A)仅有一个色子是3;(B)至少有一个色子是4;(C)色子上点数的总和为偶数。试计算事件A 、B 、C 发生后所提供的信息量。(见课本2-1) 居住某地区的女孩子有20%是大学生,在女大学生中有60%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 答:设随机变量X 代表女孩子学历 X x 1(是大学生) x 2(不是大学生) P(X) 0.20 0.80 设随机变量Y 代表女孩子身高 Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5 已知:在女大学生中有60%是身高160厘米以上的 即: 11(/)0.6p y x = 求:身高160厘米以上的某女孩是大学生的信息量 即:11111111()(/)0.20.625 (/)log (/)log log log ()0.56 p x p x y I x y p x y bit p y ?=-=-=-= 一信源有4种输出符号码,Xi(i=0,1,2,3),且p(Xi)=1/4。设信源向信宿发出X3,但由于传输中的干扰,接收者收到X3后,认为其可信度 为0.9。于是信源再次向信宿发送该符号(X3),信宿无误收到。问信源在两次发送中发出的信息量各是多少?信宿在两次接收中得到的信息量又各是多少? 第一次收到的符号为y ,第二次发送无误收到,发、收信息量相等,则 I(X3/y)=-log2p(Xi/y)=-log20.9=0.15(比特) 第一次发出的信息量为 I(X3)=-log2p(Xi)=-log20.25=2(比特) 第一次传送的信息量为两次发送信息量之差, 即 I(X3;y)=I(X3)-I(X3/y)=1.85(比特) 画出一个通信系统包括的各主要功能模块。 一个无记忆信源,随机变量X ∈{0;1}等概分布。 求(1)以单个消息出现的信源熵; (2)两个消息出现信源熵; (3)信源的平均符号熵 (1)11 ()()log ()log 2122i i i H X p a p a =-=-?=∑ (2)两个消息出现:(N=2的序列) 随机序列(00,01,10,11)X ∈ 11 ()()log ()log 4244i i i H X p a p a =-=-?=∑ (3)信源的平均符号熵: 211 ()()2122 H X H X = =?= 已知X ,Y ∈{0,1},X ,Y 构成的联合概率为p(00)=p(11)=1/8,p(01)=p(10)=3/8,计算条件熵H(X/Y)。 211(/)()log (/)n m i j i j i j H X Y p x y p x y ===-∑∑ 2222(00)log (0/0)(01)log (0/1)(10)log (1/0)(11)log (1/1)p p p p p p =---- p(y1=0)=p(x1y1=00)+p(x2y1=10)=1/8+3/8=4/8=1/2 p(y2=1)=p(x1y2=01)+p(x2y2=11)=1/8+3/8=4/8=1/2 P(0/0)=p(x=0,y=0)=p(x1y1)/p(y1)=p(00)/p(0) =(1/8)∕(1/2)=1/4 = p(1/1) 同理有p(1/0)=p(0/1)=3/4 ∴H(X/Y) =-1/8㏒(1/4)-3/8㏒(3/4)-3/8㏒(3/4)-1/8㏒(1/4) =0.406(比特/符号) 设随机变量X 的概率分布为2221111 [,,,,,,]10101010101010 ,随机变量Y 是X 的函数,其分布为将X 的4个最小的概率分布合并为一个: 2224[,,,]10101010 (1)显然H(X)<log27,请解释原因; (2) 计算H(X),H(Y); (3)计算H(X/Y)并解释其结果。 通信系统物理模型 1) H(X)<log27,请解释原因 根据熵的极值性,当随机变量等概分布时,随机变量的熵最大。有7个可能取值的随机变量的最大熵为Hmax (X )=log27, 而随机变量X 不是等概分布,所以H(X)<log27。 (2)2222211 ()()log ()3log 4log 10101010 H X p x p x =-=-? -? 226 log 10log 2 3.3220.6 2.72210 =- =-= (3)222 2244 ()()log ()3log log 10101010 H Y p y p y =-=-? - 22264 log 10log 2log 4 3.3220.60.8 1.9221010 =--=--= 有一离散平稳无记忆信源 1)( ,4141,2 1)(3 1 32 1=??? ???????=???? ??∑=i i a p a a a X p X 求:这个信源的二次扩展信源的熵 解:求二次扩展信源。扩展信源是长度为2的消息序列。信源有3个不同的消息,每两个消息组成的不同排列共有32=9种,构成二次扩展信源的9个不同元素. )()()(21i i i a p a p a p = (il ,i2 =1,2,3; i=1,2….9) 二次扩展信源的熵为 )(log )()()(291 i i i N a p a p X H X H ∑=-== 将表中的数据代入可得)/(3)()(符号比特==N X H X H 一马尔可夫信源的符号集为{0,1,2}X =,其状态集123{,,}S s s s =,各状态之间的状态转移改概率如表,求平稳后信源的概率分布。 (1)根据题意有: 111121231321212223233 131232333()()(/)()(/)()(/)()()(/)()(/)()(/)()()(/)()(/)()(/) p s p s p s s p s p s s p s p s s p s p s p s s p s p s s p s p s s p s p s p s s p s p s s p s p s s =++?? =++??=++? 112212 33 12311()()()23112()()()()433111()()()()433p s p s p s p s p s p s p s p s p s p s p s ?=?+??? ? ?=?+?+??? ? =?+?+??? 112323 ()8/29 ()()()1()12/29()9/29p s p s p s p s p s p s =?? ++=?=??=? 111121231321212223233131232333()()(/)()(/)()(/)8/29()()(/)()(/)()(/)12/29()()(/)()(/)()(/)9/29 p x p s p x s p s p x s p s p x s p x p s p x s p s p x s p s p x s p x p s p x s p s p x s p s p x s =++=?? =++=??=++=? 012()8/2912/299/29X P X ?????=???????? 有一个马尔可夫信源,己知转移概率为p(el/el)=2/3,p(e2/e1)=1/3,p(e1/e2)=1,p(e2/e2)=0。试画出状态转移图,并求出信源熵。 (见课本2-8) 设信源符号X ∈{0,1},编码器输出符号Y ∈{0,1,2},规定失真函数为d(0,0)=d(1,1)=0;d(0,1)=d(1,0)=1;d(0,2)=d(1,2)=0.5, 求失真矩阵d 。Dmax 111213212223(,),(,),(,)[](,),(,),(,)d x y d x y d x y d d x y d x y d x y ??== ???(0,0),(0,1),(0,2)(1,0),(1,1),(1,2)d d d d d d ?? ??? 0,1,0.51,0,0.5??= ??? Dmax=0.5 一个信源含有三个消息,概率分布为p1=0.2,p2=0.3,p3=0.5,失真函数矩阵为 ?? ??? ?????=102230024][d 求:Dmax,Dmin, R(Dmax),R(Dmin) 在给定的失真函数矩阵中,对每一个x i 找一个最小的d ij 然后求 0min )(min ==∑ij y i i d x p D j R(Dmax)=0, R(Dmin)=R(0)=Hmax(x)=-[0.2log0.2+0.3log0.3+0.5log0.5] 设输入输出符号X=Y={0,1},输入概率分布为p(x)={1/3,2/3},失真矩阵为11122122(,),(,)0,1(,),(,)1,0d x y d x y d d x y d x y ???? == ? ??? ?? 求Dmax 。Dmin max 1,2 (1) min n i ij j m i D p d ===∑ 1112211122221,2 min(,)j p d p d p d p d ==++ 1,2 min(1/302/31;1/312/30)j ==?+??+? 1,2min(2/3;1/3)j ==1 3= Dmin=0 画出表格中所对应编码的码树。 max 1,2 (1) min (0.240.52;20.230.3;0.320.51) r i ij j s i D p d ====?+??+??+?∑ 画出表格中所对应的两种编码方案的码树。 设有离散无记忆信源 123456 111111 448888 x x x x x x X P ?? ???? = ???? ?? ?? (1)编出平均码长最小的哈夫曼码; (2)计算其平均码长; 解:(1)利用霍夫曼编码方法,从而得到 123456 x x x x x x 、、、、、平均码长最小的霍夫曼码为:10、11、00、01、010、011。 (2)该霍夫曼码的平均码长为: 5 1 111119 ()222232 448884 i i i L p s l = ==?+?+?+?+??= ∑ 设有离散无记忆信源? ? ? ? ? ? = ? ? ? ? ? ? 05 .0 05 .0 05 .0 05 .0 1.0 1.0 2.0 4.0 8 7 6 5 4 3 2 1 s s s s s s s s P S (1)编出平均码长最小的哈夫曼码; (2)计算其平均码长 解:(1)利用霍夫曼编码方法,从而得到s 1 s 2 s 3 s 4 s 5 s 6 s 7 s 8 平均码长最小的霍夫曼码为: 00、11、100、101、0100、0101、0110、0111 (2)该霍夫曼码的平均码长为: 6.2 4 05 .0 4 3 1.0 2 2 2.0 2 4.0 ) ( 8 1 = ? ? + ? ? + ? + ? = = - = ∑i i i l s p L 设信源共7个符号消息,其数学模型如下 1234567 ()0.20.190.180.170.150.10.01 X x x x x x x x P X ?? ?? =?? ?? ???? 利用哈夫曼编码方法进行信源编码,画出其过程。 信道转移矩阵为P ???? ? ??? ??=316131616161313 1P 求该信道的信道容量 。 该信道是准对称信道,可以分解为三个互不相交的子集,分别为 ??????????=??????????=??????????=6161,3131,31616131321 P P P 3 /13/22/16/13/12 /16/13/1321321======+=M M M N N N 信道转移矩阵为P ???? ? ??? ??=3131616 16161313 1P 求该信道的信道容量 。 解:由信道转移矩阵可知,矩阵的第二行是第一行的置换,每一列都是第一列的置换,所以信道是对称的,所以信道容量为 ),,,(log 21s p p p H s C -= )6 1 ,61,31,31(4log H -= 082.0=比特∕符号 信道转移矩阵为P ??????----=q p q p p q q p P 11 求该信道的信道容量 。 解:从该信道转移矩阵可以看出,该信道是一个准对称信道,可以分解为 ??????----=q p p p q p P 111 ??????=q q P 2 q M q M q N q N 2,1,12121=-==-= 由准对称离散信道的信道容量计算公式 若已知信道矩阵1001000 10010010P ?? ??? ? ??=???????? ,根据该信道矩阵画出信道图。 画出二元纯对称删除信道。 某二元离散无记忆信道的转移矩阵为? ?????--=p p p p P 11求对信道进行二次扩展,扩展后的信道转移矩阵及信道容量。 ? ? ?? ? ?????? ? ??------------=222222 2 2)1() 1() 1()1()1()1()1()1()1()1()1()1(p p p p p p p p p p p p p p p p p p p p p p p p Q 由扩展信道的转移矩阵知,二次扩展信道是 对称信道,当输入序列等概率分布时可以达到信息容量C2,将扩展后的每种序列排列认 为是一个符号,二次扩展信道就等价于四元信道,四元对称信道的信道容量为 )),1(),1(,)1((4log 222p p p p p p H C ----= )),1(),1(,)1((222p p p p p p H ----= 比特/序列 假设信道的输入、输出符号数相等,都等于r,且信道条件转移矩阵为 111111111 p p p r r p p p r r p p p r r ? ?-?? --? ??? -?? --??????-? ? ?--? 求信道容量 。 解:显然该信道是对称的,信道容量为 log (1, ,,)1 1 p p C r H p r r =---- log (1)log(1)(1)log 11 p p r p p r r r =+--+--- log ()log(1)r H p p r =--- 设有单符号离散信道,信道矩阵为?? ?? ? ?????=0.4 0.3 0.30.5 0.3 0.20.2 0.3 5.0P 求下面译码函数(规则)的pe 。 1 - q a 1 b 1 b 2 a 2 b 3 1 - q ?????===2*33* 21*1)()()(:a b F a b F a b F A ?? ???===3*32*21*1)()()(:a b F a b F a b F B 解:根据最大似然译码准则可选取译码函数A,在输入等概率分布时可使pe 最小。 ∑∑=≠=s j i i j e a b p p 1* )|(31 =(1/3)(0.2+0.3+0.3+0.3+0.2+0.4)=0.567 若选择B: ' e p =(1/3)(0.2+0.3+0.3+0.3+0.2+0.5)=0.600 分别写出循环码(7,4)对应于序列0100和1001的码字。 对0100: 3223210()m x m x m x m x m x =+++=…….(3分) 232542()()()(1)c x m x g x x x x x x x ==++=++…….(2分) 得0110100…….(1分) 对1001 3()1m x x =+653()1c x x x x =+++…….(5分) 得 1101001…….(1分)。 《信息论与编码》课程论文 ——通过信息论对已有知识产生的新认识 马赛 1143031014 《信息论与编码》课程是通信专业的一门基础课。其讲述的理论——香农信息论是当今信息科学的基础,可以说没有信息论的理论支持,就没有当今的信息化社会。 通过对于信息论的学习,我认识到,信息论的贡献就是解释了什么是“信息”,同时使用数学工具,对信息及伴随它产生的各种事物概念进行了解析。近代科学的重大飞跃往往都是因人类对于一个事物有了强有力的分析工具而产生的。有了信息论这一近乎完备(存在一些缺陷)的解析理论,人类才得以驾驭信息,社会才有了长足的进步。 在学习时,我习惯于把正在学习的知识和自己已经掌握的知识进行联系。通过这种方法,可以增进对正在学习知识的理解,同时对已掌握的知识也有新的认识。下文中,列举了两个问题,同时使用信息论的角度去进行解释。 一、计算机的存储容量与信息量的联系 当今的计算机已经十分普及。存储容量,无论内存还是外存,都是判定一台计算机性能的重要指标。现在的个人计算机硬盘容量已经达到了TB级别,而在20年前,几百MB的硬盘都十分罕见。在追求更高的存储容量时,我们是否思考过存储的东西是什么?KB、MB、GB等单位究竟代表的含义是什么? 这是计算机科学的基本知识:“8 bit = 1 byte”。bit即“位”,这是计算机存储单元最基本的单位;而信息论中也将信息量——用于衡量信息的量的单位称为bit,这两个概念有什么联系吗? 在课程讲解时提到过这个问题,幻灯片上的答案如是解释:两者代表着不同的概念,信息论中的bit代表着信息量;而计算机中的bit代表着计算机中的二元数字1和0。 我认为两者是同一种概念,都代表信息量,而计算机中的bit是更为细化的概念,单指计算机中的信息量。信息的一种解释是:对于不确定性的消除。信息量是对信息的一种衡量手段,描述对事件不确定性消除的程度。而描述事件不确定性的量就是这个事件发生的概率,因此一个事件发生的概率与事件包含的信息量具有对应的关系。这是香农信息论对于信息量的定义。 计算机存储的依然是信息,只是信息的存储形式是01二进制数字。如果说计算机中的bit只是二元数字的话,那么这个单位就丧失了“信息”这个定义了。 用户通过互联网下载各种资料,下载的资料需要占用本地的存储空间,这是一个众所周知的例子。其实这个过程就是一个消除不确定性的过程。我们一般常识中的“空”硬盘,实际上是没有存储信息,而空间就在那里,空间中的信息有不确定,有不确定度;写入信息,实际上就是在消除不确定性,让空间中的信息确定,让其有序。这就是一种典型的信息传递过程。 计算机是2元存储结构,一个二进制符号代表1bit,根据实际计算,一个二进制符号的最大信息量即H0(X) = log22 = 1bit,这是一个将符号等同于无记忆的,每个符号之间没有联系,达到了信息量的最大值。这是最为简化的处理结果,也是最为可行的处理结果。如果严格按照信息论的角度去分析,其实每个符号之间是有联系的——各种编码、指令,如果01只是随机出现,那么只是一盘散沙。当然这是严格的理论解释,如果实际应用到存储信息的计量,那么将是不可行,计算机界的先驱是非常有远见的。 二、关于称硬币问题的思考 1、有一个二元对称信道,其信道矩阵如下图所示。设该信道以1500个二元符号/秒的速度传输输入符号。现有一消息序列共有14000个二元符号,并设在这消息中P(0)=P(1)=1/2。问从信息传输的角度来考虑,10秒钟内能否将这消息序列无失真地传送完? 解答:消息是一个二元序列,且为等概率分布,即P(0)=P(1)=1/2,故信源的熵为H(X)=1(bit/symbol)。则该消息序列含有的信息量=14000(bit/symbol)。 下面计算该二元对称信道能传输的最大的信息传输速率: 信道传递矩阵为: 信道容量(最大信息传输率)为: C=1-H(P)=1-H(0.98)≈0.8586bit/symbol 得最大信息传输速率为: Rt ≈1500符号/秒× 0.8586比特/符号 ≈1287.9比特/秒 ≈1.288×103比特/秒 此信道10秒钟内能无失真传输得最大信息量=10× Rt ≈ 1.288×104比特 可见,此信道10秒内能无失真传输得最大信息量小于这消息序列所含有的信息量,故从信息传输的角度来考虑,不可能在10秒钟内将这消息无失真的传送完。 2、若已知信道输入分布为等概率分布,且有如下两个信道,其转移概率矩阵分别为: 试求这两个信道的信道容量,并问这两个信道是否有噪声? 3 、已知随即变量X 和Y 的联合分布如下所示: 01100.980.020.020.98P ?? =?? ??11112222 1111222212111122221111222200000000000000000000000000000000P P ???????? ????==???? ????????11 2222111 22222log 4(00)1/()log 42/log 8(000000)2/(),H bit symbol H X bit symbol C C H bit symbol H X C =-===>=-==1解答:(1)由信道1的信道矩阵可知为对称信道故C 有熵损失,有噪声。(2)为对称信道,输入为等概率分布时达到信道容量无噪声 一、(11’)填空题 (1)1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。 (2)必然事件的自信息是 0 。 (3)离散平稳无记忆信源X的N次扩展信源的熵等于离散信源X的熵的 N倍。 (4)对于离散无记忆信源,当信源熵有最大值时,满足条件为__信源符号等概分布_。 (5)若一离散无记忆信源的信源熵H(X)等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为 3 。 (6)对于香农编码、费诺编码和霍夫曼编码,编码方法惟一的是香农编码。(7)已知某线性分组码的最小汉明距离为3,那么这组码最多能检测出_2_______个码元错误,最多能纠正___1__个码元错误。 (8)设有一离散无记忆平稳信道,其信道容量为C,只要待传送的信息传输率R__小于___C(大于、小于或者等于),则存在一种编码,当输入序列长度n足够大,使译码错误概率任意小。(9)平均错误概率不仅与信道本身的统计特性有关,还与___译码规则____________和___编码方法___有关 三、(5')居住在某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。 假如我们得知“身高1.6米以上的某女孩是大学生”的消息,问获得多少信息量? 解:设A表示“大学生”这一事件,B表示“身高1.60以上”这一事件,则 P(A)=0.25 p(B)=0.5 p(B|A)=0.75 (2分) 故 p(A|B)=p(AB)/p(B)=p(A)p(B|A)/p(B)=0.75*0.25/0.5=0.375 (2分) I(A|B)=-log0.375=1.42bit (1分) 四、(5')证明:平均互信息量同信息熵之间满足 I(X;Y)=H(X)+H(Y)-H(XY) 证明: 1. 有一个马尔可夫信源,已知p(x 1|x 1)=2/3,p(x 2|x 1)=1/3,p(x 1|x 2)=1,p(x 2|x 2)=0,试画出该信源的香农线图,并求出信源熵。 解:该信源的香农线图为: 1/3 ○ ○ 2/3 (x 1) 1 (x 2) 在计算信源熵之前,先用转移概率求稳定状态下二个状态x 1和 x 2 的概率)(1x p 和)(2x p 立方程:)()()(1111x p x x p x p =+)()(221x p x x p =)()(2132x p x p + )()()(1122x p x x p x p =+)()(222x p x x p =)(0)(2131x p x p + )()(21x p x p +=1 得4 3 1)(=x p 4 12)(=x p 马尔可夫信源熵H = ∑∑- I J i j i j i x x p x x p x p )(log )()( 得 H=0.689bit/符号 2.设有一个无记忆信源发出符号A 和B ,已知4 341)(.)(= =B p A p 。求: ①计算该信源熵; ②设该信源改为发出二重符号序列消息的信源,采用费诺编码方法,求其平均信息传输速率; ③又设该信源改为发三重序列消息的信源,采用霍夫曼编码方法,求其平均信息传输速率。 解:①∑- =X i i x p x p X H )(log )()( =0.812 bit/符号 ②发出二重符号序列消息的信源,发出四种消息的概率分别为 用费诺编码方法 代码组 b i BB 0 1 BA 10 2 AB 110 3 AA 111 3 无记忆信源 624.1)(2)(2 ==X H X H bit/双符号 平均代码组长度 2B =1.687 bit/双符号 B X H R )(22==0.963 bit/码元时间 ③三重符号序列消息有8个,它们的概率分别为 用霍夫曼编码方法 代码组 b i BBB 64 27 0 0 1 BBA 64 9 0 )(6419 1 110 3 香农信息论的基本理论探究 制作者:陈喆指导老师:杜奕 【内容摘要】:信息是自从人类出现以来就存在于这个世界上了,天地万物,飞禽走兽,以及人类的生存方式都离不开信息的产生和传播。人类每时每刻都在不停的接受信息,传播信息,以及利用信息。从原来的西汉时期的造纸,到近代西方的印刷术,以及现在的计算机,信息技术在人类历史的进程当中随着生产力的进步而发展。而信息理论的提出却远远落后于信息的出现,它是在近代才被提出来而形成一套完整的理论体系。信息论的主要基本理论包括:信息的定义和度量;各类离散信源和连续信源的信息熵;有记忆、无记忆离散和连续信道的信道容量;无失真信源编码定理。 【关键词】:平均自信息信道容量信源编码霍夫曼码 1211()()log()q q i j i j i j H X X P a a a a ===-∑∑ 此联合熵表明原来信源X 输出任意一对可能的消息的共熵,即描述信源X 输出长度为2的序列的平均不确定性,或者说所含有的信息量。可以用1122() H X X 作为二维离散平稳信源X 的信息熵的近视值。 除了平稳离散信源之外,还存在着非平稳离散信源。在非平稳离散信源中有一类特殊的信源。这种信源输出的符号序列中符号之间的依赖关系是有限的,这种关系满足我们在随机过程中讲到的马尔可夫链的性质,因此可用马尔可夫链来处理。马尔可夫信源是一种非常重要的非平稳离散信源。那么马尔可夫信源需要满足一下两个条件: (1) 某一时刻信源符号的输出只与此刻信源所出的状态有关,而与以前的状态及以前的输出符号都无关。 (2) 信源某l 时刻所处的状态由当前的输出符号和前一时刻(l -1)信源的状态唯一决定。 马尔可夫信源的输出的符号是非平稳的随机序列,它们的各维概率分布随时间的推移可能会改变。第l 时间信源输出什么符号,不但与前一(l -1)时刻信源所处的状态和所输出的符号有关,而且一直延续到与信源初始所处的状态和所输出的符号有关。一般马尔可夫信源的信息熵是其平均符号熵的极限值,它的表达式就是: 121()lim ()N N H H X H X X X N ∞∞→∞== . 二.平均互信息 信道的任务是以信号方式传输信息和存储信息的。我们知道信源输出的是携带着信息的消息。消息必须要转换成能在信道中传输或存储的信号,然后通过信道传送到收信者。并且认为噪声或干扰主要从信道中引入。信道根据用户的多少,可以分为两端信道,多端信道。 根据信道输入端和输出端的关联,可以分为无反馈信道,反馈信道。根据信道的参数与时间的关系信道可以分为固定参数信道,时变参数信道。根据输入和输出信号的统计特性可以分为离散信道,连续信道,半离散或半连续信道和波形信道。 为了能够引入平均互信息量的定义,首先要看一下单符号离散信道的数学模型,在这种信道中,输出变量和输入变量的传递概率关系: (|)(|)(|)(1,2,,;1,2,,)j i j i P y x P y b x a P b a i r j s ====== 传递概率所表达的意思是,在信道当输入符号为a ,信道的输出端收到b 的概率。 我们知道,信道输入信源X 的熵是表明接收端收到符号之前信源的平均不确定性,可以称为先验熵。如果信道中无干扰噪声,信道输出符号与输出符号一一对应,那么,接受到传送过来的符号就消除了对发送符号的先验不确定性。但是我们实际的生活中一般信道中有干扰存在,接收到输出后对发送的是什么符号仍有不确定性。表示在输出端收到输出变量Y 的符号后,对于输入端的变量X 尚存在的平均不确定性。即信道疑义度: ,1(|)()log (|)X Y H X Y P xy P x y =∑ 这个信道的疑义度是由于干扰噪声引起的。前面我们看到了输出端接收到输出符号前关于变量X 的先验熵,以及接收到输出符号后关于输入变量X 的平均不确定性,通过信道传输消除了一定的不确定性,获得了一定的信息。那么定义单符号信道的平均互信息量 (;)()(|)I X Y H X H X Y =- 1. 在无失真的信源中,信源输出由 H (X ) 来度量;在有失真的信源中,信源输出由 R (D ) 来度量。 2. 要使通信系统做到传输信息有效、可靠和保密,必须首先 信源 编码, 然后_____加密____编码,再______信道_____编码,最后送入信道。 3. 带限AWGN 波形信道在平均功率受限条件下信道容量的基本公式,也就是有名的香农公式是log(1)C W SNR =+;当归一化信道容量C/W 趋近于零时,也即信道完全丧失了通信能力,此时E b /N 0为 -1.6 dB ,我们将它称作香农限,是一切编码方式所能达到的理论极限。 4. 保密系统的密钥量越小,密钥熵H (K )就越 小 ,其密文中含有的关于明文的信息量I (M ;C )就越 大 。 5. 已知n =7的循环码4 2 ()1g x x x x =+++,则信息位长度k 为 3 ,校验多项式 h(x)= 3 1x x ++ 。 6. 设输入符号表为X ={0,1},输出符号表为Y ={0,1}。输入信号的概率分布为p =(1/2,1/2),失真函数为d (0,0) = d (1,1) = 0,d (0,1) =2,d (1,0) = 1,则D min = 0 ,R (D min )= 1bit/symbol ,相应的编码器转移概率矩阵[p(y/x )]=1001?? ???? ;D max = 0.5 ,R (D max )= 0 ,相应的编码器转移概率矩阵[p(y/x )]=1010?? ? ??? 。 7. 已知用户A 的RSA 公开密钥(e,n )=(3,55),5,11p q ==,则()φn = 40 ,他的秘密密钥(d,n )=(27,55) 。若用户B 向用户A 发送m =2的加密消息,则该加密后的消息为 8 。 二、判断题 1. 可以用克劳夫特不等式作为唯一可译码存在的判据。 (√ ) 2. 线性码一定包含全零码。 (√ ) 3. 算术编码是一种无失真的分组信源编码,其基本思想是将一定精度数值作为序列的 编码,是以另外一种形式实现的最佳统计匹配编码。 (×) 4. 某一信源,不管它是否输出符号,只要这些符号具有某些概率特性,就有信息量。 (×) 5. 离散平稳有记忆信源符号序列的平均符号熵随着序列长度L 的增大而增大。 (×) 6. 限平均功率最大熵定理指出对于相关矩阵一定的随机矢量X ,当它是正态分布时具 有最大熵。 (√ ) 7. 循环码的码集中的任何一个码字的循环移位仍是码字。 (√ ) 8. 信道容量是信道中能够传输的最小信息量。 (×) 9. 香农信源编码方法在进行编码时不需要预先计算每个码字的长度。 (×) 10. 在已知收码R 的条件下找出可能性最大的发码i C 作为译码估计值,这种译码方 法叫做最佳译码。 (√ ) 一、概念简答题(每题5分,共40分) 1.什么是平均自信息量与平均互信息,比较一下这两个概念的异同? 答:平均自信息为 表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。 平均互信息 表示从Y获得的关于每个X的平均信息量,也表示发X前后Y的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。 2.简述最大离散熵定理。对于一个有m个符号的离散信源,其最大熵是多少? 答:最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。 最大熵值为。 3.解释信息传输率、信道容量、最佳输入分布的概念,说明平均互信息与信源的概率分布、信道的传递概率间分别是什么关系? 答:信息传输率R指信道中平均每个符号所能传送的信息量。信道容量是一个信道所能达到的最大信息传输率。信息传输率达到信道容量时所对应的输入概率分布称为最佳输入概率分布。 平均互信息是信源概率分布的∩型凸函数,是信道传递概率的U型凸函数。 4.对于一个一般的通信系统,试给出其系统模型框图,并结合此图,解释数据处理定理。 答:通信系统模型如下: 数据处理定理为:串联信道的输入输出X、Y、Z组成一个马尔可夫链,且有, 。说明经数据处理后,一般只会增加信息的损失。 5.写出香农公式,并说明其物理意义。当信道带宽为5000Hz,信噪比为30dB时求信道容量。 .答:香农公式为,它是高斯加性白噪声信道在单位时间内的信道容量,其值取决于信噪比和带宽。 由得,则 6.解释无失真变长信源编码定理。 .答:只要,当N足够长时,一定存在一种无失真编码。 7.解释有噪信道编码定理。 答:当R<C时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。 8.什么是保真度准则?对二元信源,其失真矩阵,求a>0时率失真函数的和? 答:1)保真度准则为:平均失真度不大于允许的失真度。 2)因为失真矩阵中每行都有一个0,所以有,而。 二、综合题(每题10分,共60分) 1.黑白气象传真图的消息只有黑色和白色两种,求: 香农信息论对现代社会的影响 摘要:1948年香农在Bell System Technical Journal上发表了《A Mathematical Theory of Communication 》。论文由香农和威沃共同署名。这篇奠基性的论文是建立在香农对通信的观察上,即“通信的根本问题是报文的再生,在某一点与另外选择的一点上报文应该精确地或者近似地重现”。这篇论文建立了信息论这一学科,给出了通信系统的线性示意模型,即信息源、发送者、信道、接收者、信息宿,这是一个新思想。此后,通信就考虑为把电磁波发送到信道中,通过发送1和0的比特流,人们可以传输图像、文字、声音等等。今天这已司空见惯,但在当时是相当新鲜的。他建立的信息理论框架和术语已经成为技术标准。他的理论在通信工程师中立即获得成功,并刺激了今天信息时代所需要的技术发展。 关键词:香农、通信、编码 Abstract: In 1948, Shannon Bell System Technical Journal published "A Mathematical Theory of Communication". Paper co-signed by the Hong farmers. This ground-breaking paper is based on Shannon's observation of the communication that "the fundamental problem of communication is the message of regeneration, at some point with another point to report the selected text should be reproduced exactly or approximately." This paper established the discipline of information theory, given the linear signal model of communication system, that information source, sender, channel, receiver, message places, this is a new idea. Since then, the communication to consider the electromagnetic waves sent to the channel, by sending a stream of bits 1 and 0, one can transfer images, text, and so on. It has become commonplace today, but was very fresh. He established the theoretical framework and terminology of information technology has become the standard. His theory in communications engineer in immediate success, and stimulate the need for the information age of today's technology. Keywords:Shannon、Communications、Coding 信息论的理论定义是由当代伟大的数学家美国贝尔实验室杰出的科学家香农在他1948年的著名论文《通信的数学理论》所定义的,它为信息论奠定了理论基础。后来其他科学家,如哈特莱、维纳、朗格等人又对信息理论作出了更加深入的探讨。使得信息论到现在形成了一套比较完整的理论体系。 上个世纪四十年代,半导体三极管还未发明,电子计算机也尚在襁褓之中。但是通信技术已经有了相当的发展。从十九世纪中叶,电报就已经很普遍了。电报所用的摩斯码(Morse Code),就是通信技术的一项杰作。摩斯码用点和线(不同长度的电脉冲)来代表字母,而用空格来代表字母的边界。但是每个字母的码不是一样长的。常用的字母E只有一个点。而 信息论与编码理论习题解 第二章-信息量和熵 解: 平均每个符号长为:154 4.0312.032= ?+?秒 每个符号的熵为9183.03log 3 1 23log 32=?+?比特/符号 所以信息速率为444.34 15 9183.0=?比特/秒 解: 同步信号均相同不含信息,其余认为等概, 每个码字的信息量为 3*2=6 比特; 所以信息速率为600010006=?比特/秒 解:(a)一对骰子总点数为7的概率是 36 6 所以得到的信息量为 585.2)366(log 2= 比特 (b) 一对骰子总点数为12的概率是36 1 所以得到的信息量为 17.536 1 log 2= 比特 解: (a)任一特定排列的概率为 ! 521 ,所以给出的信息量为 58.225! 521 log 2 =- 比特 (b) 从中任取13张牌,所给出的点数都不相同的概率为 1352 13 13 521344!13C A =? 所以得到的信息量为 21.134 log 1313 52 2=C 比特. 解:易证每次出现i 点的概率为 21 i ,所以 比特比特比特比特比特比特比特398.221 log 21)(807.1)6(070.2)5(392.2)4(807.2)3(392.3)2(392.4)1(6,5,4,3,2,1,21 log )(26 12=-==============-==∑ =i i X H x I x I x I x I x I x I i i i x I i 解: 可能有的排列总数为 27720! 5!4!3! 12= 没有两棵梧桐树相邻的排列数可如下图求得, Y X Y X Y X Y X Y X Y X Y X Y 图中X 表示白杨或白桦,它有???? ??37种排法,Y 表示梧桐树可以栽 种的位置,它有???? ??58种排法,所以共有???? ??58*???? ??37=1960种排法保证没有 两棵梧桐树相邻,因此若告诉你没有两棵梧桐树相邻时,得到关于树排列的信息为1960log 27720log 22-= 比特 解: X=0表示未录取,X=1表示录取; Y=0表示本市,Y=1表示外地; Z=0表示学过英语,Z=1表示未学过英语,由此得 一填空题(本题20分,每小题2分) 1、平均自信息为 表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。 平均互信息 表示从Y获得的关于每个X的平均信息量,也表示发X前后Y的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。 2、最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。 3、最大熵值为。 4、通信系统模型如下: 5、香农公式为为保证足够大的信道容量,可采用(1)用频带换信噪比;(2)用信噪比换频带。 6、只要,当N足够长时,一定存在一种无失真编码。 7、当R<C时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。 8、在认识论层次上研究信息的时候,必须同时考虑到形式、含义和效用三个方面的因素。 9、1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。 按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。 按照信息的地位,可以把信息分成客观信息和主观信息。 人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。 信息的可度量性是建立信息论的基础。 统计度量是信息度量最常用的方法。 熵是香农信息论最基本最重要的概念。 事物的不确定度是用时间统计发生概率的对数来描述的。 10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。 11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。 12、自信息量的单位一般有比特、奈特和哈特。 13、必然事件的自信息是 0 。 14、不可能事件的自信息量是∞。 15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。 16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量趋于变小。 17、离散平稳无记忆信源X的N次扩展信源的熵等于离散信源X的熵的 N倍。 18、离散平稳有记忆信源的极限熵,。 19、对于n元m阶马尔可夫信源,其状态空间共有 nm 个不同的状态。 20、一维连续随即变量X在[a,b]区间内均匀分布时,其信源熵为 log2(b-a)。 信息论与编码期中试题答案 一、(10’)填空题 (1)1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。 (2)必然事件的自信息是0 。 (3)离散平稳无记忆信源X的N次扩展信源的熵等于离散信源X的熵的N倍。 (4)对于离散无记忆信源,当信源熵有最大值时,满足条件为__信源符号等概分布_。 (5)若一离散无记忆信源的信源熵H(X)等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为 3 。 二、(10?)判断题 (1)信息就是一种消息。(? ) (2)信息论研究的主要问题是在通信系统设计中如何实现信息传输、存储和处理的有效性和可靠性。(? ) (3)概率大的事件自信息量大。(? ) (4)互信息量可正、可负亦可为零。(? ) (5)信源剩余度用来衡量信源的相关性程度,信源剩余度大说明信源符号间的依赖关系较小。 (? ) (6)对于固定的信源分布,平均互信息量是信道传递概率的下凸函数。(? ) (7)非奇异码一定是唯一可译码,唯一可译码不一定是非奇异码。(? ) (8)信源变长编码的核心问题是寻找紧致码(或最佳码)。 (? ) (9)信息率失真函数R(D)是关于平均失真度D的上凸函数. ( ? ) 三、(10?)居住在某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。 假如我们得知“身高1.6米以上的某女孩是大学生”的消息,问获得多少信息量? 解:设A表示“大学生”这一事件,B表示“身高1.60以上”这一事件,则 P(A)=0.25 p(B)=0.5 p(B|A)=0.75 (5分) 故p(A|B)=p(AB)/p(B)=p(A)p(B|A)/p(B)=0.75*0.25/0.5=0.375 (4分) I(A|B)=-log0.375=1.42bit (1分) 一个马尔可夫信源有3个符号{}1,23,u u u ,转移概率为:()11|1/2p u u =,()21|1/2p u u =, ()31|0p u u =,()12|1/3p u u =,()22|0p u u =,()32|2/3p u u =,()13|1/3p u u =,()23|2/3p u u =,()33|0p u u =,画出状态图并求出各符号稳态概率。 解:状态图如下 状态转移矩阵为: 1/21/2 01/302/31/32/30p ?? ?= ? ??? 设状态u 1,u 2,u 3稳定后的概率分别为W 1,W 2、W 3 由1231WP W W W W =??++=?得1231132231231 112331223 231W W W W W W W W W W W W ?++=???+=???=???++=? 计算可得1231025925625W W W ?=??? =?? ?=?? 由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =,(0|11)p =,(1|00)p =, (1|11)p =,(0|01)p =,(0|10)p =,(1|01)p =,(1|10)p =。画出状态图,并计算各状态 的稳态概率。 解:(0|00)(00|00)0.8p p == (0|01)(10|01)0.5p p == (0|11)(10|11)0.2p p == (0|10)(00|10)0.5p p == (1|00)(01|00)0.2p p == (1|01)(11|01)0.5p p == (1|11)(11|11)0.8p p == (1|10)(01|10)0.5p p == 信息论与编码课程论文 电子邮件安全与密码学的应用 刘畅,200900840179 山东大学威海分校机电与信息工程学院,威海 264209 摘要:本文分析了传统电子邮件系统存在的安全性问题,探讨应用密码技术采弥补这些安全漏洞,并且绍了在安全电子邮件系统中使用的密码技术。 关键词:RSA;PGB;PEM 1、概述 随着计算机技术和网络技术的迅速发展,电子邮件的应用也越来越广泛.成为网络牛活中重要的组成部分,大有取代传统邮件之势。作为一种新的信息传递技术,电子邮件以其简单、快捷、方便的优势被人们所接受和喜爱。但是也存在一些问题妨碍了它的推广。其中关键之一就是电子邮件的信息安全。由于电子邮件技术在设计之初是为了科学家之间的通信方便,所以并来考虑信息安全因素。但是髓着时代的发展。尤其是电子商务的速成长。作为其沟通手段的电子邮件的安全性问题就不得不受到高度重视。人们很自然的想到把已经成熟的密码技术商用于电子邮件系统。密码技术就是对信息进行重新编码。从而达到隐藏信息内容使非法用户无法获取真实信息内容的一种手段。本文就浅述一下密码技术安全电子邮件中的应用。 2、密码学简介 2.1、加密的历史 作为保障数据安全的一种方式,数据加密起源于公元前2000年。埃及人是最先使用特别的象形文字作为信息编码的人。随着时间推移,巴比伦,希腊等都开始使用一些方法来保护他们的书面信息。对信息进行编码曾被Julias Caesar(恺撒大帝)使用,也曾用于历次战争中,包括美国独立战争,美国内战和两次世界大战。最广为人知的编码机器是German Enigma机,在第二次世界大战中德国人利用它创建了加密信息。此后,由于Alan Turing 和Ultra计划及其他人的努力,终于对德国人的密码进行了破解。当初,计算机的研究就是为了破解德国人的密码,当时人们并没有想到计算机给今天带来的信息革命。随着计算机的发展,运算能力的增强,过去的密码都变的十分简单了。于是人们又不断地研究出了新的数据加密方式,如私有密钥算法和公有密钥算法。可以说,是计算机推动了数据加密技术的发展。 2.2、密码学的发展 密码学的发展可以分为两个阶段。第一个阶段是计算机出现之前的四千年(早在四千年前,古埃及就开始使用密码传递消息),这是传统密码学阶段,基本上靠人工对消息加密、传输和防破译。第二阶段是计算机密码学阶段,包括: ①传统方法的计算机密码学阶段。解密是加密的简单逆过程,两者所用的密钥是可以简单地互相推导的,因此无论加密密钥还是解密密钥都必须严格保密。这种方案用于集中式系统是行之有效的。 ②包括两个方向:一个方向是公用密钥密码(RSA),另一个方向是传统方法的计算机密码体制——数据加密标准(DES)。 上海大学2011~2012学年度冬季学期试卷(A卷) 课程名:信息论与编码课程号: 07276033学分: 4 应试人声明: 我保证遵守《上海大学学生手册》中的《上海大学考场规则》,如有考试违纪、作弊行为,愿意接受《上海大学学生考试违纪、作弊行为界定及处分规定》的纪律处分。 应试人应试人学号应试人所在院系 题号 1 2 3 4 得分——————————————————————————————————————一:填空题(每空2分,共40分) 1:掷一个正常的骰子,出现‘5’这一事件的自信息量为________,同时掷两个正常的骰子,‘点数之和为5’这一事件的自信息量为___________.(注明物理单位) 2:某信源包含16个不同的离散消息,则信源熵的最大值为___________,最小值为_____________. 3:信源X经过宥噪信道后,在接收端获得的平均信息量称为______________. 4:一个离散无记忆信源输出符号的概率分别为p(0)=0.5,p(1)=0.25,p(2)=0.25,则由60个符号构成的消息的平均自信息量为__________. 5:信源编码可提高信息传输的___有效___性,信道编码可提高信息传输的___可靠_性. 6:若某信道的信道矩阵为 ? ? ? ? ? ? ? ? ? ? ? ? 001 100 010 100 ,则该信道为具有____归并____性能的信道 7:根据香农第一定理(定长编码定理)若一个离散无记忆信源X的信源熵为H(X),对其n个符号进行二元无失真编码时,其码字的平均长度必须大于____________ 8:若某二元序列是一阶马尔科夫链,P(0/0)=0.8,P(1/1)=0.7,则‘0’游程长度为4的概率为____________,若游程序列为312314,则原始的二元序列为_________. 9:若循环码的生成多项式为1 ) (2 3+ + =x x x g,则接收向量为(1111011)的伴随多项式为_______________ 10:对有32个符号的信源编4进制HUFFMAN码,第一次取_______个信源进行编码. 11:若一个线性分组码的所有码字为:00000,10101,01111,11010,则该码为(____,_____),该码最多可以纠正_______位错误,共有________陪集. 12:码长为10的线性分组码若可以纠正2个差错,其监督吗至少有__5____位. 13:(7,4)汉明码的一致校验矩阵为 ? ? ? ? ? ? ? ? ? ? 1,0,1,0,1, ,1 0,1,1,0,0, ,1 0,0,0,1,1, ,1 3 2 1 r r r ,则3 2 1 r r r 为__________. _______________________________________________________________ 草稿纸 成绩 《信息论与编码(第二版)》曹雪虹答案 第二章 2.1一个马尔可夫信源有3个符号{}1,23,u u u ,转移概率为:()11|1/2p u u =,()21|1/2p u u =, ()31|0p u u =,()12|1/3p u u =,()22|0p u u =,()32|2/3p u u =,()13|1/3p u u =,()23|2/3p u u =,()33|0p u u =,画出状态图并求出各符号稳态概率。 解:状态图如下 状态转移矩阵为: 1/21/2 01/302/31/32/30p ?? ?= ? ??? 设状态u 1,u 2,u 3稳定后的概率分别为W 1,W 2、W 3 由1231WP W W W W =??++=?得1231132231231 112331223231W W W W W W W W W W W W ?++=???+=???=???++=? 计算可得1231025925625W W W ?=??? =? ? ?=?? 2.2 由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =0.8,(0|11)p =0.2, (1|00)p =0.2,(1|11)p =0.8,(0|01)p =0.5,(0|10)p =0.5,(1|01)p =0.5,(1|10)p =0.5。画出 状态图,并计算各状态的稳态概率。 解:(0|00)(00|00)0.8p p == (0|01)(10|01)0.5p p == (0|11)(10|11)0.2p p == (0|10)(00|10)0.5p p == (1|00)(01|00)0.2p p == (1|01)(11|01)0.5p p == (1|11)(11|11)0.8p p == (1|10)(01|10)0.5p p == 信息论与编码理论习题答案全解 第二章 信息量和熵 2.2 八元编码系统,码长为3,第一个符号用于同步,每秒1000个码字,求它的 信息速率。 解:同步信息均相同,不含信息,因此 每个码字的信息量为 2?8log =2?3=6 bit 因此,信息速率为 6?1000=6000 bit/s 2.3 掷一对无偏骰子,告诉你得到的总的点数为:(a) 7; (b) 12。问各得到多少 信息量。 解:(1) 可能的组合为 {1,6},{2,5},{3,4},{4,3},{5,2},{6,1} )(a p =366=6 1 得到的信息量 =) (1 log a p =6log =2.585 bit (2) 可能的唯一,为 {6,6} )(b p =361 得到的信息量=) (1 log b p =36log =5.17 bit 2.4 经过充分洗牌后的一副扑克(52张),问: (a) 任何一种特定的排列所给出的信息量是多少? (b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量? 解:(a) )(a p =! 521 信息量=) (1 log a p =!52log =225.58 bit (b) ???????花色任选 种点数任意排列 13413!13 )(b p =13 52134!13A ?=1352 13 4C 信息量=1313 52 4log log -C =13.208 bit 2.9 随机掷3颗骰子,X 表示第一颗骰子的结果,Y 表示第一和第二颗骰子的 点数之和,Z 表示3颗骰子的点数之和,试求)|(Y Z H 、)|(Y X H 、 ),|(Y X Z H 、)|,(Y Z X H 、)|(X Z H 。 解:令第一第二第三颗骰子的结果分别为321,,x x x ,1x ,2x ,3x 相互独立, 则1x X =,21x x Y +=,321x x x Z ++= )|(Y Z H =)(3x H =log 6=2.585 bit )|(X Z H =)(32x x H +=)(Y H =2?( 361log 36+362log 18+363log 12+364log 9+365log 536)+36 6 log 6 =3.2744 bit )|(Y X H =)(X H -);(Y X I =)(X H -[)(Y H -)|(X Y H ] 而)|(X Y H =)(X H ,所以)|(Y X H = 2)(X H -)(Y H =1.8955 bit 或)|(Y X H =)(XY H -)(Y H =)(X H +)|(X Y H -)(Y H 而)|(X Y H =)(X H ,所以)|(Y X H =2)(X H -)(Y H =1.8955 bit ),|(Y X Z H =)|(Y Z H =)(X H =2.585 bit )|,(Y Z X H =)|(Y X H +)|(XY Z H =1.8955+2.585=4.4805 bit 2.10 设一个系统传送10个数字,0,1,…,9。奇数在传送过程中以0.5的概 率错成另外一个奇数,其余正确接收,求收到一个数字平均得到的信息量。 解: 信道 X Y 9,7,5,3,1=i 8,6,4,2,0=i √Χ );(Y X I =)(Y H -)|(X Y H 因为输入等概,由信道条件可知, 信息论与编码应用报告互信息技术在数字图像配准中的应用 专业班级:电子信息工程 姓名: 学号:201 时间:2014年6月9日 指导老师: 2014年6月9日 目录 摘要: (1) Abstract: (2) 前言 (3) 1 概述 (4) 1.1 互信息与信息论 (4) 1.2 数字图像配准 (5) 1.2.1 数字图像配准的介绍 (5) 1.2.2 数字图像配准的方式 (5) 1.2.3 数字图像配准的发展 (6) 2 配准方法 (7) 2.1 变换和插值模型 (7) 2.2 特征点的提取 (8) 2.3 多元互信息 (11) 2.4 优化算法 (12) 2.4.1 编码方式 (12) 2.4.2适应度表示 (12) 2.4.3轮盘赌法和最优保存策略 (12) 3 互信息技术在图像配置中的应用 (13) 3.1 Harris角点后的CT图和PET图 (14) 3.2 配准过程及结果 (14) 4 总结 (14) 参考文献: (16) 互信息技术在数字图像配准中的应用 信息与计算科学专业 指导教师 【摘要】:医学图像配准技术已经被应用于心脏病诊断和包括脑瘤在内的各种各样的神经混乱诊断研究中。图像配准是使两幅图像上的对应点达到空间上一致的一个过程。本文介绍了一种基于最大互信息原理的图像配准技术。并针对基于最大互信息图像配准的不足,研究了基于Harris角点算子的多模态医学图像配准。在计算互信息的时候,采用部分体积插值法计算联合灰度直方图。在优化互信息函数的时候采用了改进的遗传算法将配准参数收敛到最优值附近。实验结果表明本方法具有较高的配准精度和稳定性。 【关键词】:图像配准互信息 Harris角点算子部分体积插值遗传算法 前言 互信息是信息论的一个基本概念,是两个随机变量统计相关性的测度。Woods用测试图像的条件熵作为配准的测度,用于PET 到MR 图像的配准。Collignon 、Wells[1] 等人用互信息作为多模态医学图像的配准测度。以互信息作为两幅图像的相似性测度进行配准时,如果两幅基于共同解剖结构的图像达到最佳配准时,它们对应的图像特征互信息应为最大。最大互信息法几乎可以用在任何不同模式图像的信息论与编码课程论文

答案~信息论与编码练习

信息论与编码试卷与答案

信息论与编码课后习题答案

信息论与编码课程论文[1]

信息论与编码试题集与答案(新)

信息论与编码试卷及答案(多篇)

信息论与编码论文(香农信息论对现代的影响)

信息论与编码理论课后习题答案高等教育出版社

信息论与编码试题集与答案

信息论与编码期中试卷及答案

信息论与编码课后答案

信息论与编码课程论文

信息论与编码期末试卷

信息论与编码(第二版)曹雪虹(最全版本)答案

信息论与编码理论习题答案全解

信息论与编码课程论文