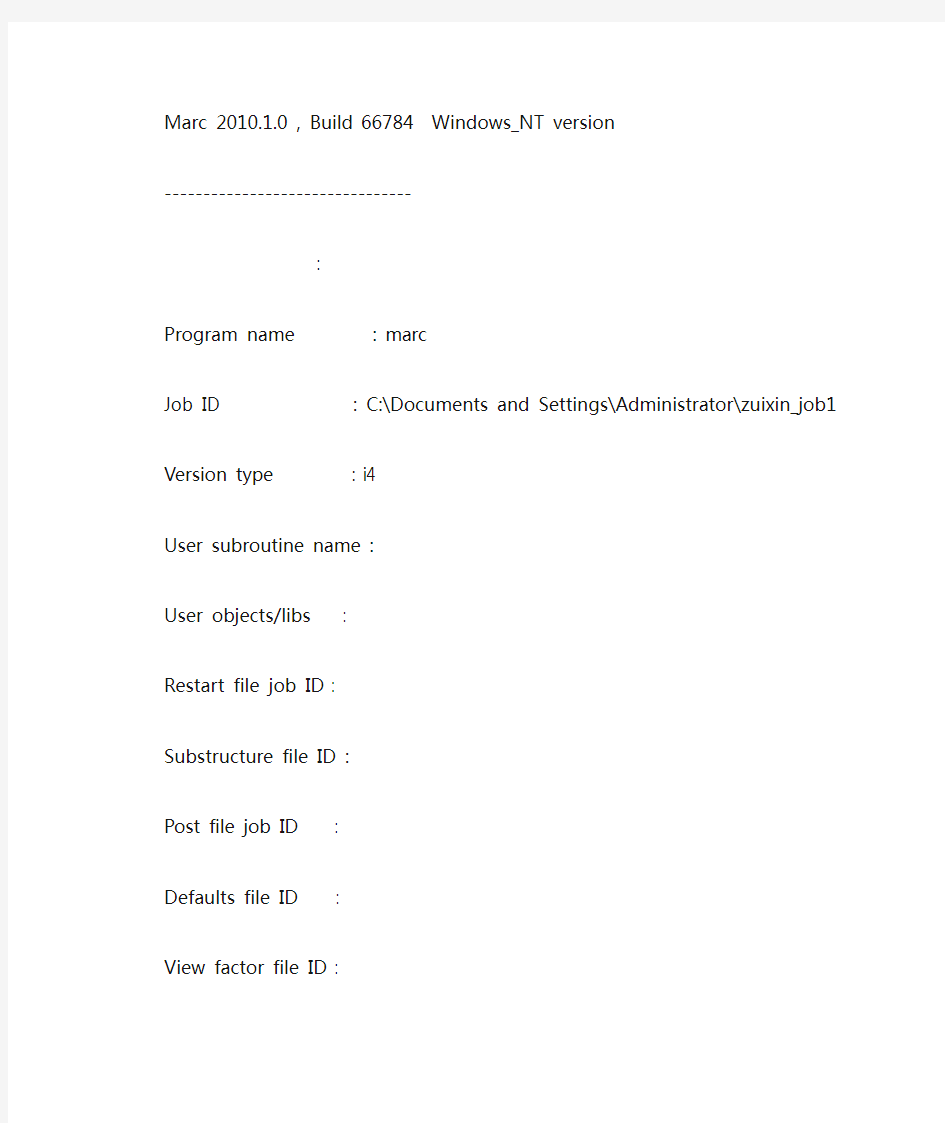

marc的log文件

Marc 2010.1.0 , Build 66784 Windows_NT version

--------------------------------

:

Program name : marc

Job ID : C:\Documents and Settings\Administrator\zuixin_job1 Version type : i4

User subroutine name :

User objects/libs :

Restart file job ID :

Substructure file ID :

Post file job ID :

Defaults file ID :

View factor file ID :

Save generated module: no

MPI library : intel-mpi

Auto restart : 0

Contact decoupling : 0

DDM processes : 0

Solver processes : 0

Host file :

Distributed i/o :

Run directory : C:\Documents and Settings\Administrator

Scratch directory : C:\Documents and Settings\Administrator

Default bin directory: E:\marc2010\marc2010\bin\win32

Material database : E:\marc2010\marc2010\AF_flowmat\

:

2012-10-15 星期一

15:21

Marc 2010.1.0 zuixin_job1 begins execution

(c) COPYRIGHT 2010 MSC.Software Corporation, all rights reserved VERSION: Marc 2010.1.0, Build 66784 build date: Tue Mar 30 12:14:08 2010

Date: Mon Oct 15 15:21:51 2012

Marc 2010.1.0 execution begins

general memory initially set to = 25 MByte

maximum available memory set to = 895 MByte

Date: Mon Oct 15 15:21:52 2012

MSC Id: 4061866dade8 (ethernet) (Intel)

Hostname: PC-201012151512 (user Administrator, display PC-201012151512) License files: E:\marc2010\license.dat

CEID: 866DADE8-A4AF6GB2

User: Administrator

Display: PC-201012151512

LAPI Version: LAPI 8.0.1-1866 (FLEXlm 11.6.0.0)

Acquired 1 license for Marc from license server on host PC-201012151512

MSC Customer Entitlement ID

866DADE8-A4AF6GB2

general memory increasing from 25 MByte to 53 MByte

wall time = 3.00

*** error - element inside out at element 6897 integration point 1

wall time = 3.00

Returned 1 license for Marc

memory usage: MByte words % of total

within general memory:

element stiffness matrices: 0 61832 0.3

solver: first part 0 0 0.0

overallocation initial allocation 53 13934650 62.3

other: 0 5449 0.0

allocated separately:

nodal vectors: 1 221800 1.0

defined sets: 0 180 0.0

transformations: 0 3146 0.0

kinematic boundary conditions: 0 566 0.0

points, curves and surfaces: 0 6462 0.0

mem_none: 0 102205 0.5

element storage: 4 1020642 4.6

material properties: 0 1556 0.0

executable and common blocks: 27 7000000 31.3

miscellaneous 0 15175 0.1

---------------------------------------------------------------

total: 85 22373663

general memory allocated: 53 14001931

general memory used: 0 67281

peak memory usage: 105 27555531

timing information: wall time cpu time

total time for input: 0.67 0.62

total time for stiffness assembly: 0.00 0.00

total time for stress recovery: 0.00 0.00

total time for matrix solution: 0.00 0.00

total time for output: 0.00 0.00

total time for miscellaneous: 2.55 2.00

---------------------------------------------------------------

total time: 3.22 2.62

**************************************************************************

Data errors have been detected during data input. Refer to

output for location of error. Likely causes are misspelled

keywords, mistyped lines or invalid input options.

**************************************************************************

Marc 2010.1.0

Exit number 13

Message.log日志说明.

一、日志文件Message.log的说明 日志文件中输出的是实际的消息包的内容,以16进制的方式打印的 //下面的蓝色文字为说明文字 对Message.log文件中记录的信息的说明: 1.ICD表示是由客服系统传送过来的消息 ICD = 后面的字符串,如:ICD = 20002,则20002表示客服系统使用的命令字或者调用过程名 2.MID表示是由营帐系统传送过来的消息 MID = 后面的字符串,如:MID = 20002,则20002表示客服与营帐接口协议中使用的命令字(注: 此处的说法不是很正确,如果客服与营帐协议中不存在命令字定义时,此处使用的是一种定义关系,一般是将协议中的某项或者某几项的组合作为可以唯一标识该条报文的命令字处理 3./TRANS表示转换后的信息记录. 4./ERROR MESSAGE表示该信息有错误或者无法处理,错误详细情况分析请见协议接口调试手册中的说明 说明:此处将客服的命令字与客服与营帐接口的命令字区分出来,原因是: 1、客服系统使用命令字的概念, 2、客服与营帐接口中的一项协议可能对应客服系统的多项不同调用,而客服系统在处理时每项调用的命令字都应当是唯一的,为此保证客服系统命令字的唯一及确定协议的转换方式,需要存在一个对应关系

3、客服系统,如IVR的请求中的调用过程名是固定的,不可能直接使用协议中定义的命令字,为此需要和协议中命令字的对应关系 4、由于存在上述的一对多的情况存在,日志记录中的MID = 后面命令字不一定正确,因此要结合具体的数据中的消息察看 5、上述的命令字的对应关系在DtProxyDll.ini文件中设定,由下列项目确定 [COMMAND] ICDCDM = //客服系统使用的命令字 MIDCMD = //客服与营帐接口协议中使用的命令字 6、具体的命令字对应的转换工作由DtProxyDll.dll完成 (1将客服发送过来的消息按照客服与营帐系统之间的协议转换后的数据 [2000/11/06 13:48:48] ICD = 20002/TRANS IP=10.108.22.192ID=35 记录时间ICD业务站点的IP ICD业务站点的ID 00 00 00 4b a8 23 00 32 30 30 30 32 00 00 00 00 00 00 00 00 00 00 00 00 ...K.#.20002............ 00 00 00 00 58 00 00 00 00 00 00 00 00 3b 00 00 00 00 7e 00 00 00 00 00 ....X........;....~..... 00 00 00 00 00 00 00 00 00 31 33 39 32 33 37 31 32 38 31 30 7e 38 38 38 .........139********~888 38 3b 00 8;. (2客服发送过来的消息,消息格式分成两类:IVR类,AppSrv类 可根据DtProxy.ini中IVRID和AppSvrID的设定对应下面信息中的ID值确定是那种消息格式

C#将异常打印到LOG文件

///

虚拟机系统日志文件详解-Henry

虚拟机系统日志文件详解 Friday, October 08, 2010---Henry 除了事件和警报列表,vSphere 组件还会生成各种日志。这些日志包含有关vSphere 环境中活动的详细信息。 1、查看系统日志条目 可以查看vSphere 组件生成的系统日志。 访问和查看系统日志的步骤: 1 在连接vCenter Server 系统或ESX/ESXi 主机的vSphere Client 的主页中,单击系统日志。 2 在下拉菜单中,选择要查看的日志和条目。 3 选择查看> 筛选以引用筛选选项。 4 在数据字段中输入文本。 5 单击清除以清空该数据字段。 2、外部系统日志 VMware 技术支持可能会请求多个文件以帮助解决您使用产品时遇到的任何问题。本节介绍在各种ESX 4.0 组件系统上找到的日志文件的类型和位置。 ---------------------------------------------------------------------------------------------------------------------- 注意:在Windows 系统中,多个日志文件存储在位于C:\Documents and Settings\

Log4记录日志使用说明

一、 想要让Log4net日志(以下称日志)按每月自动归类为一个文件夹,为此,学习和修改了log4net.config文件。查了资料,重点是以下这些参数: 众说纷纭,许多说得让人看后似懂非懂,经过说起来都是泪的实验,终于有了明确的结论,整理发表出来避免后人走弯路。 1.StaticLogFileName的值如果为true,则当前日志文件(相对于历史日志文件而言)的文件名只取File参数。如果为false,则文件名取File+DatePattern。 2.File的值是静态的如果写“yyyy-MM”就是“yyyy-MM”而不会转成当前的年份和月份,而且斜扛“/”与反斜扛“\”效果相同,连续2扛也与1扛相同。 3.DatePattern的值是动态的“yyyy”代表4位年份,详细参考网上的众多资料(这个不难得到)。如果想表达静态的字符(如“y”)有2种办法,1是使用转义字符“\”,即“\y”,2是使用一对单引号限定,即“'y'”。如上面的value="_yyyy-MM-dd.'config'",就是因为fig有特殊含义,所以把“config”用单引号包含起来了。 4.修改了(网站上的)log4net.config文件,使它生效的方法是重启网站(我没有试着去操作应用程序池)。实测重启网站有约10%没有使它生效,但如果是先停止网站再启动,则100%生效。 以上4点最关键是第1点,也是众多资料所没有说清楚的(本人的汉字理解能力有问题?)。最终符合我要求的配置如下: 以上是基于我自己做的实验而得出的结论,难免不够系统和全面,限于本人水平,难免有错误。如有发现错漏,欢迎指正。 二、 log4net配置文件设置 2011-11-16 13:15:41| 分类:Notes|举报|字号订阅

网站日志文件-网站log文件详解

IIS Log参数详解: date(日期) 2007-11-17 time(时间) 16:02:09 cs-method(方法) GET cs-uri-stem(URI资源) /b2b_cplist.asp //代表访问的资源是当前这个文件 cs-uri-query(URI查询) catid=30 // 具体的访问参数 (cs-uri-stem+ cs-uri-query=实际访问的文件:/b2b_cplist.asp? catid=30) s-port(服务器端口) 80 c-ip(客户端IP) 211.155.23.176(实际是网站所在服务器的IP) cs(User-Agent) Baiduspider+(+https://www.360docs.net/doc/64164667.html,/search/spider.htm) //百度在收录你呢J cs(Referer) (引用站点) https://www.360docs.net/doc/64164667.html, 搜索的站点 sc-status(协议状态) 200 //200表示OK sc-substatus(协议子状态) 0 sc-win32-status(Win32状态) 0 sc-bytes(发送的字节数) 1329 //表示当前文件的大小 日期date 时间time 客户IP地址c-ip 用户名cs-username 方法cs-method URI资源cs-uri-stem 协议状态sc-status 发送字节数sc-bytes 协议版本cs-version 用户代理cs(User-Agent) 参照cs(Referer) HTTP协议状态码的含义,协议状态sc-status,是服务器日记扩展属性的一项。下面是各状态码含义列表: "100" : Continue 客户必须继续发出请求 "101" : witching Protocols 客户要求服务器根据请求转换HTTP协议版本200交易成功 "200" : OK 交易成功 "201" : Created 提示知道新文件的URL "202" : Accepted 接受和处理、但处理未完成 "203" : Non-Authoritative Information 返回信息不确定或不完整 "204" : No Content 请求收到,但返回信息为空 "205" : Reset Content 服务器完成了请求,用户代理必须复位当前已经浏览过的文件 "206" : Partial Content 服务器已经完成了部分用户的GET请求"300" : Multiple Choices 请求的资源可在多处得到 "301" : Moved Permanently 删除请求数据

log文件整理心得

log文件整理心得 1.要注意时间,因为每次做的东西都会跟在log文件后面,所以要根据时间取舍,不是所有的log文件中的内容就有用的,一开始我建议从新建一个文件开始。 2.最好每做一步看一下log文件,可以知道自己的操作对应哪些命令 3.有些关于存盘、显示视角等命令可以删除。 4.选取实体时往往会产生很多命令,可以简化。 5.整理命令流时要新建立一个文本文件,以便从log文件中拷贝所需要的。 6.File菜单中的Read input from可以读入自己所建立的命令流来执行。 7.可以增加注释语句以增强可读性 下面以一简单模型为例大致说明一下: /BATCH /COM,ANSYS RELEASE 5.7.1 UP20010418 15:42:42 09/12/2003 /input,menust,tmp ,'',,,,,,,,,,,,,,,,1 /GRA,POWER /GST,ON /PLO,INFO,3 /COL,PBAK,ON,1,BLUE 这一段基本上没有用,是开始的设置,每个分析都是差不多这样,因此可以删除。 /PREP7 进入前处理器。在这一句前面可以加上fini /clear,这样可以把模型原来的内容清空。 !* ET,1,PLANE42 !* 定义单元 MPTEMP,,,,,,,, MPTEMP,1,0 MPDATA,EX,1,,2e11 MPDATA,PRXY,1,,0.33 MPTEMP,,,,,,,, MPTEMP,1,0 MPDATA,DENS,1,,2700 定义材料类型 K,1,0,0,, K,2,50,0,, K,3,50,10,, K,4,10,10,, K,5,10,50,, K,6,0,50,, 建立关键点 FLST,2,6,3 FITEM,2,1 FITEM,2,2 FITEM,2,3

入侵Linux系统后日志文件及入侵后日志如何清除

Linux系统的LOG日志文件及入侵后日志的清除 UNIX网管员主要是靠系统的LOG,来获得入侵的痕迹.当然也有第三方工具记录入侵系统 的痕迹,UNIX系统存放LOG文件,普通位置如下: /usr/adm - 早期版本的UNIX /var/adm - 新一点的版本使用这个位置 /var/log - 一些版本的Solaris,linux BSD,Free BSD使用这个位置 /etc - 多数UNIX版本把utmp放在这里,有些也把wtmp放在这里,syslog.conf在这里 下面的一些文件根据你所在的目录不同而不同: acct 或pacct -- 记录每个用户使用的命令记录 access_log -- 主要当服务器运行NCSA HTTPD时, 记录什么站点连接过你的服务器aculog -- 保存着你拨出去的MODEMS记录 lastlog -- 记录了用户最近的LOGIN记录和每个用户的最初目的地,有时是最后不 成功LOGIN的记录,当一个用户登陆到unix系统,注册程序在lastlog文件中查找该用户的uid,如果该程序找到了 该用户的uid,unix就会显示最后一次登陆的时间和tty(终端号) loginlog -- 记录一些不正常的LOGIN记录 messages -- 记录输出到系统控制台的记录,另外的信息由syslog来生成 security -- 记录一些使用UUCP系统企图进入限制范围的事例 sulog -- 记录使用su命令的记录.它通常在/var/adm/sulog.如果你在机器上使用了su命令,别忘了清除哦. utmp -- 记录当前登录到系统中的所有用户,这个文件伴随着用户进入和离开系统而不断变化.它还会为系统中的用户保持很长的历史记录,utmp日志通常存放在/var/adm/utmp目录下.可以用w和who命令查看,其他命令也可以访问这个文件.如:finger root就可以.现在的utmp一般都有utmpx文件作为日志记录的补充. utmpx -- UTMP的扩展 wtmp -- 记录用户登录和退出事件.它和utmp日志文件相似,但它随着登陆次数的增加,它会变的越来越大,有些系统的ftp访问也在这个文件里记录,同时它也记录正常的系统退出时间,可以用ac和last命令访问. syslog -- 最重要的日志文件,使用syslogd守护程序来获得日志信息,通常情况下通过查看/etc/syslog.conf.我们可以知道syslog记录些什么.缺省时,它把大多的消息传给 /var/adm/message. /dev/log -- 一个UNIX域套接字,接受在本地机器上运行的进程所产生的消息

LogExplorer教程

数据库恢复神器--Log Explorer 4.2使用教程介绍 Log Explorer主要用于对MSSQLServer的事务分析和数据恢复。可以浏览日志、导出数据、恢复被修改或者删除的数据(包括执行过update,delete,drop和truncate语句的表格)。一旦由于系统故障或者人为因素导致数据丢失,它能够提供在线快速的数据恢复,最大程度上保证恢复期间的其他事务不间断执行。 他可以支持SQLServer7.0和SQLServer2000以及SQLServer2005.提取标准数据库的日志文件或者备份文件中的信息。 软件下载地址:https://www.360docs.net/doc/64164667.html,/c0ojf3kule 主要功能: 其中提供两个强大的工具:日志分析浏览,对象恢复。具体功能如下: ●日志文件浏览 ●数据库变更审查 ●计划和授权变更审查 ●将日志记录导出到文件或者数据库表 ●实时监控数据库事务 ●计算并统计负荷 ●通过有选择性的取消或者重做事务来恢复数据 ●恢复被截断或者删除表中的数据

运行SQL脚本 LogExplore包含两部分 1、客户端软件 2、服务器代理 服务器端代理是保存在SQLServer主机中的一个只读存储过程,他的作用是接受客户端请求,读取在线事务日志块并通过网络传给客户端软件,由客户端软件来读取这些原始的数据块来完成Log Explore所提供的所有功能。 他依赖来的网络协议包括: 1、Named Pipe:局域网中适用 2、Tcp/Ip:广域网中适用 数据库相关介绍 事务日志(Transaction Log) SQLServer的每个数据库都包含事务日志,它以文件的形式存储,可以记录数据库的任何变化。发生故障时SQLServer就是通过它来保证数据的完整性。 操作(Operation) 操作是数据库中定义的"原子行为",每个操作都在日志文件中保存为一条记录。它可以是用户直接输入的SQL语句,比如标准的insert 命令,日志文件中便会记录一条操作代码来标志这个insert操作。 事务(Transaction) 事务是一系列操作组成的序列。他可以理解为直观的不可分割的一笔业务,可以执行成功或者失败。典型的事务比如由应用程序发出的具有开启-提交功能的一组SQL语句。不同的事务靠事务Id号(transaction ID)来区分,具有相同ID的事务记录的日志也相同。 在线事务日志(Online Transaction Log) 在线事务日志是指当前活动数据库所用的日志。可以通过如下命令来确定其对应文件

教你如何查看网站日志

教你如何查看网站日志 笔者有加了几个SEO的群,经常在群里看到很多新手SEO朋友问怎么查看网站日志,这里笔者就做一个系统的总结分享给新手SEO朋友们,希望有用,如果你是老鸟觉得不屑一顾你可以忽视本文。就拿笔者最近优化的展览器材行业网站来做个案例分析吧。我做的企业网站关键词是易拉宝。笔者每天会通过提取服务器的日志来查看蜘蛛抓取情况,看看有哪些蜘蛛今天来爬了,爬了多少次,具体爬到哪个页面蜘蛛爬不下去就走了等等。然后分析做出合理优化。 1.首先你等下一个日志分析工具:笔者用的光年日志分析。百度光年日志分析工具就可以下载了,这里不提供下载页面。下载完后安装解压,如图所示 2.如果你的FTP里面没有LOG文件夹的话那么就得登入你的空间服务器提取log日志。系统默认的日志文件路径是:C:WINDOWSsystem32LogFiles , W3SVC就是你要提取的文件,这个文件里面有你网站每天的日志文件.这里需要补充一点的就是如果你服务器里面有多个网站的话,那么你得先弄清楚哪个文件夹是你需要的日志文件夹。按如下步骤操作:打开空间管理器——找到你网站——右键——属性——网站--属性P——浏览下面就能看到文件夹名称(详见如图红色部位)

3.提取出的文件放到你的D盘网站跟目录下然后通过FTP传送到本地电脑。 4.打开光年日志工具GnAnalyzer.exe——新建分析任务(找到你刚下载的日志文件)——选择分析文件存放路劲——确定。分析结束后找到你存放结果的文件夹找到HTM结果的文件就能看到日志分析结果了。

如上图所示就能查看到蜘蛛来我网站的情况了,由于笔者现在优化的展览器材行业网站是一个新站,特别是易拉宝这个关键词也比较热,所以现在蜘蛛来拍的次数和抓取量比较可怜。如上图所示左边就可以查看到各大搜索引擎的蜘蛛到底爬了你网站的哪个页面,到了哪个页面走不下去了。 以上由杭州邦美展览器材易拉宝网/编辑,希望对新手朋友们有用,内容如有变差望见谅。 文章来源于:https://www.360docs.net/doc/64164667.html,/article-24577-1.html

收集日志的方法

收集日志的方法(V5.5及以下版本) 刘奇liuqi@https://www.360docs.net/doc/64164667.html,2010-9-14 说明:本文档非本人编写,为深圳同事总结。 举例说明,怎样把程序出错时,或者程序运行慢的前台界面现象截图,前台详细日志,后台详细日志收集和提交。 1. 某客户查询凭证时,前台报错。 2.下面介绍怎样把日志收集完整给开发, 在打开这个出错节点之前,我们先打开前台日志,在程序的右上角上一个日志按钮, 并把log level设置为debug, 按clear 按钮清除之前的日志,让收集的日志更为准确 3.在服务器端运行wassysconfig.bat—log- 日志配置http://localhost:88 –读取(中间件必须在启动状态),下图中88为nc的web访问端口,如果是80端口访问nc,请在此输入80. 把anonymous和nclog 级别设置为debug,滚动策略中最大字节设置为10m,最大文件数设置为20,并按保存。如下图,这个时候,所在访问nc服务器的88端口的操作,将会有debug输出到指定目录的指定文件。(ncv5产品是可以动态打开和关闭日志,不需要重新启动中间件才生效)

4.在服务器端打开日志目录D:\ufida\ufsoft\nclogs\server1,按日期排序日志文件,记下nc-log 和anony-log当前正在输出的文件(可能有很多nc-log和anony-log文件,要记住正在输出的最新的日志文件),如下图nc-log[0].log和anony-log[0].log是正在输入的日志文件 1.准备工作都完成了,我们需要把问题重现一次。以便生成日志并提交给开发。如下图, 我们操作凭证查询,界面报错,我们可以使用键盘上的prtscreen键直接截图到word文件,把前台直接看到的错误保存下来。 2.问题重现后,我们立即去把后台日志的级别设置为error,并保存。防止其他用户操作nc 产生大量的日志输出,不便查找我们所要的信息,如下图

marc的log文件

Marc 2010.1.0 , Build 66784 Windows_NT version -------------------------------- : Program name : marc Job ID : C:\Documents and Settings\Administrator\zuixin_job1 Version type : i4 User subroutine name : User objects/libs : Restart file job ID : Substructure file ID : Post file job ID : Defaults file ID : View factor file ID : Save generated module: no MPI library : intel-mpi Auto restart : 0 Contact decoupling : 0 DDM processes : 0 Solver processes : 0 Host file : Distributed i/o : Run directory : C:\Documents and Settings\Administrator Scratch directory : C:\Documents and Settings\Administrator Default bin directory: E:\marc2010\marc2010\bin\win32 Material database : E:\marc2010\marc2010\AF_flowmat\ : 2012-10-15 星期一 15:21 Marc 2010.1.0 zuixin_job1 begins execution (c) COPYRIGHT 2010 MSC.Software Corporation, all rights reserved VERSION: Marc 2010.1.0, Build 66784 build date: Tue Mar 30 12:14:08 2010 Date: Mon Oct 15 15:21:51 2012 Marc 2010.1.0 execution begins

查归档日志文件每小时生成量

在O racle数据库中,通过v$archived_log数据字典视图查询该数据库的归档日志文件的生成情况。如果你以为在rac下需要查的gv$archvied_log视图,这其实是一个错误的想法。无论在单实例数据库,还是多实例的RAC数据库,都是查这个视图来获取信息。 查当天每小时的归档日志生成量 select logtime, count(*), round(sum(blocks * block_size) / 1024 / 1024) mbsize from (select trunc(first_time, 'hh') as logtime, a.BLOCKS, a.BLOCK_SIZE from v$archived_log a where a.DEST_ID = 1 and a.FIRST_TIME > trunc(sysdate)) group by logtime order by logtime desc; 查最近一周每天的归档日志生成量 select logtime, count(*), round(sum(blocks * block_size) / 1024 / 1024) mbsize from (select trunc(first_time, 'dd') as logtime, a.BLOCKS, a.BLOCK_SIZE from v$archived_log a where a.DEST_ID = 1 and a.FIRST_TIME > trunc(sysdate - 7))

group by logtime order by logtime desc; 如果你需要知道RAC下各个节点的归档日志情况,我将上面脚本略作修改,增加thread#列。 查当天每小时的各个实例的归档日志生成量 select THREAD#, logtime, count(*), round(sum(blocks * block_size) / 1024 / 1024) mbsize from (select a.THREAD#, trunc(first_time, 'hh') as logtime, a.BLOCKS, a.BLOCK_SIZE from v$archived_log a where a.DEST_ID = 1 and a.FIRST_TIME > trunc(sysdate)) group by THREAD#, logtime order by THREAD#, logtime desc; 查最近一周每天的各个实例的归档日志生成量

db2diag.log文件内容分析

db2diag.log文件中的标记都表示什么含义? 环境: 产品: db2 udb 平台: Cross Platform 软件版本: v6, v7, v8 问题描述: db2diag.log文件中的标记都表示什么含义? 解答: 对db2diag.log文件的正确分析往往是排除错误的第一步, 该文件位于数据库管理器的配置参数DIAGPATH指定的目录下.下面是db2diag.log的部分摘取, 我们来分析一下它们的含义. (1) 2002-05-17-17.30.32.140000 (2) Instance:DB2MPP (3) Node:000 (4) PID:2204(db2bp.exe) (5) TID:2224 (6) Appid:*LOCAL.DB2MPP.020********* (7) database_utilities (8) sqlubckp (9) Probe:26 DiagData (10) 2cfc ffff 2002-05-17-20.17.20.793000 Instance:DB2MPP Node:000 PID:596(db2syscs.exe) TID:2176 Appid: base_sys_utilities sqleMergeSqlca Probe:20 Database:SAMPLE Received sqlcode 1496 for request 8000001e from node number 1 (11) Data Title:SQLCA PID:596 TID:2176 Node:000 sqlcaid : SQLCA sqlcabc: 136 sqlcode: 1496 sqlerrml: 0 sqlerrmc: sqlerrp : SQLESRSU sqlerrd : (1) 0x00000000 (2) 0x00000000 (3) 0x00000000 (4) 0x00000000 (5) 0x00000000 (6) 0x00000001 sqlwarn : (1) (2) (3) (4) (5) (6) (7) (8) (9) (10) (11) sqlstate: 1. 表示记这条日志时的时间戳 2. 实例名. 该例子中的实例名是db2mpp 3. 分区号. 在单分区的数据库中该值总为0 4. 应用或代理的进程ID. 5. 应用或代理的线程ID. 该值只有在windows平台上有效. 6. 应用ID. 该值对应于LIST APPLICATIONS命令的输出.每一个应用都有唯一的应用ID. 7. 组件名称(component). 8. 报错或信息的功能模块名, 该功能模块从属于上面的组件. 9. 功能模块的probe point. 对应于返回错误和信息的功能模块的源代码的位置. 10. 诊断信息. 该例子中的db2diag.log文件来源于Windows平台, 所以dump的信息是反字节顺序的.为了把该信息转化为sqlcode, 您需要把2cfc ffff转化成为ffff fc2c同时从十六进制

【精编范文】shell脚本分析log日志-范文模板 (12页)

本文部分内容来自网络整理,本司不为其真实性负责,如有异议或侵权请及时联系,本司将立即删除! == 本文为word格式,下载后可方便编辑和修改! == shell脚本分析log日志 篇一:nginx日志分析解决方案 nginx日志分析解决方案- Awstats 很多PHP搭建的网站都在由apache转向了nginx。nginx的日志信息如何分析呢?当然你可以自己写一个,但是这里也推荐一款结果信息非常详尽的开源工具——Awstats,它基于perl编写,它的介绍如下: AWStats is a free powerful and featureful tool that generates advanced web, streaming, ftp or mail server statistics, graphically. This log analyzer works as a CGI or from command line and shows you all possible information your log contains, in few graphical web pages. It uses a partial information file to be able to process large log files, often and quickly. It can analyze log files from all major server tools like Apache log files (NCSA combined/XLF/ELF log format or common/CLF log format), WebStar, IIS (W3C log format) and a lot of other web, proxy, wap, streaming servers, mail servers and some ftp servers. 点击这里去官方网站 第一步,日志的处理。 最好每天分割一下日志,一开始没注意这个工作,结果不久日志文件就上G了,很痛苦。分割日志很简单,首先把日志文件复制到别的地方,然后再通知 nginx重新生成日志就可以了。shell脚本如下: #!/bin/bash logs_path="/nginx/logs/" mv ${logs_path}access.log ${logs_path}access_$(date -d "yesterday" +"%Y%m%d").log

日志结构

bugreport 1.概述:bugreport记录android启动过程的log,以及启动后的系统状态,包括进程列表,内存信息,VM信息等等到。 2.结构: (1)dumpstate MEMORY INFO 获取该log:读取文件/proc/meminfo 系统内存使用状态 CPU INFO 获取该log:执行/system/bin/top -n 1 -d 1 -m 30 -t 系统CPU使用状态 PROCRANK 获取该log:执行/system/bin/procrank 执行/system/xbin/procrank后输出的结果,查看一些内存使用状态 VIRTUAL MEMORY STATS 获取该log:读取文件/proc/vmstat 虚拟内存分配情况 vmalloc申请的内存则位于vmalloc_start~vmalloc_end之间,与物理地址没有简单的转换关系,虽然在逻辑上它们也是连续的,但是在物理上它们不要求连续。 VMALLOC INFO 获取该log:读取文件/proc/vmallocinfo 虚拟内存分配情况 SLAB INFO 获取该log:读取文件/proc/slabinfo SLAB是一种内存分配器.这里输出该分配器的一些信息 ZONEINFO 获取该log:读取文件/proc/zoneinfo zone info SYSTEM LOG(需要着重分析) 获取该log:执行/system/bin/logcat -v time -d *:v 会输出在程序中输出的Log,用于分析系统的当前状态 VM TRACES

获取该log:读取文件/data/anr/traces.txt 因为每个程序都是在各自的VM中运行的,这个Log是现实各自VM的一些traces EVENT LOG TAGS 获取该log:读取文件/etc/event-log-tags EVENT LOG 获取该log:执行/system/bin/logcat -b events -v time -d *:v 输出一些Event的log RADIO LOG 获取该log:执行/system/bin/logcat -b radio -v time -d *:v 显示一些无线设备的链接状态,如GSM,PHONE,STK(Satellite Tool Kit)... NETWORK STATE 获取该log:执行/system/bin/netcfg (得到网络链接状态) 获取该log:读取文件/proc/net/route (得到路由状态) 显示网络链接和路由 SYSTEM PROPERTIES 获取该log:参考代码实现 显示一些系统属性,如Version,Services,network... KERNEL LOG 获取该log:执行/system/bin/dmesg 显示Android内核输出的Log KERNEL WAKELOCKS 获取该log:读取文件/proc/wakelocks 内核对一些程式和服务唤醒和休眠的一些记录 KERNEL CPUFREQ (Linux kernel CPUfreq subsystem) Clock scaling allows you to change the clock speed of the CPUs on the fly. This is a nice method to save battery power, because the lower the clock speed is, the less power the CPU consumes. PROCESSES 获取该log:执行ps -P 显示当前进程

Linux log 日志查看

Linux log 日志查看 其实,可以说成是监控系统的记录,系统一举一动基本会记录下来。这样由于信息非常全面很重要,通常只有 root 可以进行视察!通过登录文件(日志文件)可以根据屏幕上面的错误讯息与再配合登录文件的错误信息,几乎就可以解决大部分的 Linux 问题!所以日志文件异常重要,作为一个合格的linux 系统工程师,日志文件是必要熟练掌握的部分。 常见的几个登录文件有: /var/log/secure:记录登入系统存取数据的文件,例如 pop3, ssh, telnet, ftp 等都会被记录; /var/log/wtmp:记录登入者的讯息数据,由于本文件已经被编码过,所以必须使用last指令来取出文件的内容; /var/log/messages:尤为重要,几乎发生的错误讯息(或是重要信息)都会被记录在此; /var/log/boot.log:记录开机或者是一些服务启动的时候,所显示的启动或关闭讯息; /var/log/maillog 或 /var/log/mail/*:纪录邮件存取或往来( sendmail 与 pop3 )的使用者记录; /var/log/cron:记录 crontab 这个例行性服务的内容的。 /var/log/httpd, /var/log/news, /var/log/mysqld.log, /var/log/samba, /var/log/procmail.log:分别是几个不同的网络服务的记录文件! 登录文件的纪录程序之一: syslogd 通常经过 syslog 而记录下来的数据主要有: 事件发生的日期与时间; 发生此事件的主机名称; 启动此事件的服务名称 (如 samba, xinetd 等) 或函式名称 (如 libpam ..); 该讯息数据内容 syslogd的daemon配置文件:/etc/syslog.conf 内容语法是这样的: 服务名称[.=!]讯息等级讯息记录的文件名或装置或主机

linux系统中如何查看日志 (常用命令)

cat tail -f 日志文件说明 /var/log/message 系统启动后的信息和错误日志,是Red Hat Linux中最常用的日志之一/var/log/secure 与安全相关的日志信息 /var/log/maillog 与邮件相关的日志信息 /var/log/cron 与定时任务相关的日志信息 /var/log/spooler 与UUCP和news设备相关的日志信息 /var/log/boot.log 守护进程启动和停止相关的日志消息 系统: # uname -a # 查看内核/操作系统/CPU信息 # cat /etc/issue # cat /etc/redhat-release # 查看操作系统版本 # cat /proc/cpuinfo # 查看CPU信息 # hostname # 查看计算机名 # lspci -tv # 列出所有PCI设备 # lsusb -tv # 列出所有USB设备 # lsmod # 列出加载的内核模块 # env # 查看环境变量 资源: # free -m # 查看内存使用量和交换区使用量 # df -h # 查看各分区使用情况 # du -sh <目录名> # 查看指定目录的大小 # grep MemTotal /proc/meminfo # 查看内存总量 # grep MemFree /proc/meminfo # 查看空闲内存量 # uptime # 查看系统运行时间、用户数、负载 # cat /proc/loadavg # 查看系统负载 磁盘和分区: # mount | column -t # 查看挂接的分区状态 # fdisk -l # 查看所有分区 # swapon -s # 查看所有交换分区 # hdparm -i /dev/hda # 查看磁盘参数(仅适用于IDE设备) # dmesg | grep IDE # 查看启动时IDE设备检测状况 网络: # ifconfig # 查看所有网络接口的属性 # iptables -L # 查看防火墙设置 # route -n # 查看路由表 # netstat -lntp # 查看所有监听端口 # netstat -antp # 查看所有已经建立的连接 # netstat -s # 查看网络统计信息 进程:

Log4Net之记录日志到文档详解

前面一章、我们简单的介绍了log4net的功能,以及一个记录日志到文档的案例。 本节、将带领大家详细了解上节案例中各行代码的意思。 首先是配置log4net.config