Linux服务器性能评估与优

一、影响Linux服务器性能的因素

1. 操作系统级

CPU

内存

磁盘I/O带宽

网络I/O带宽

2.程序应用级

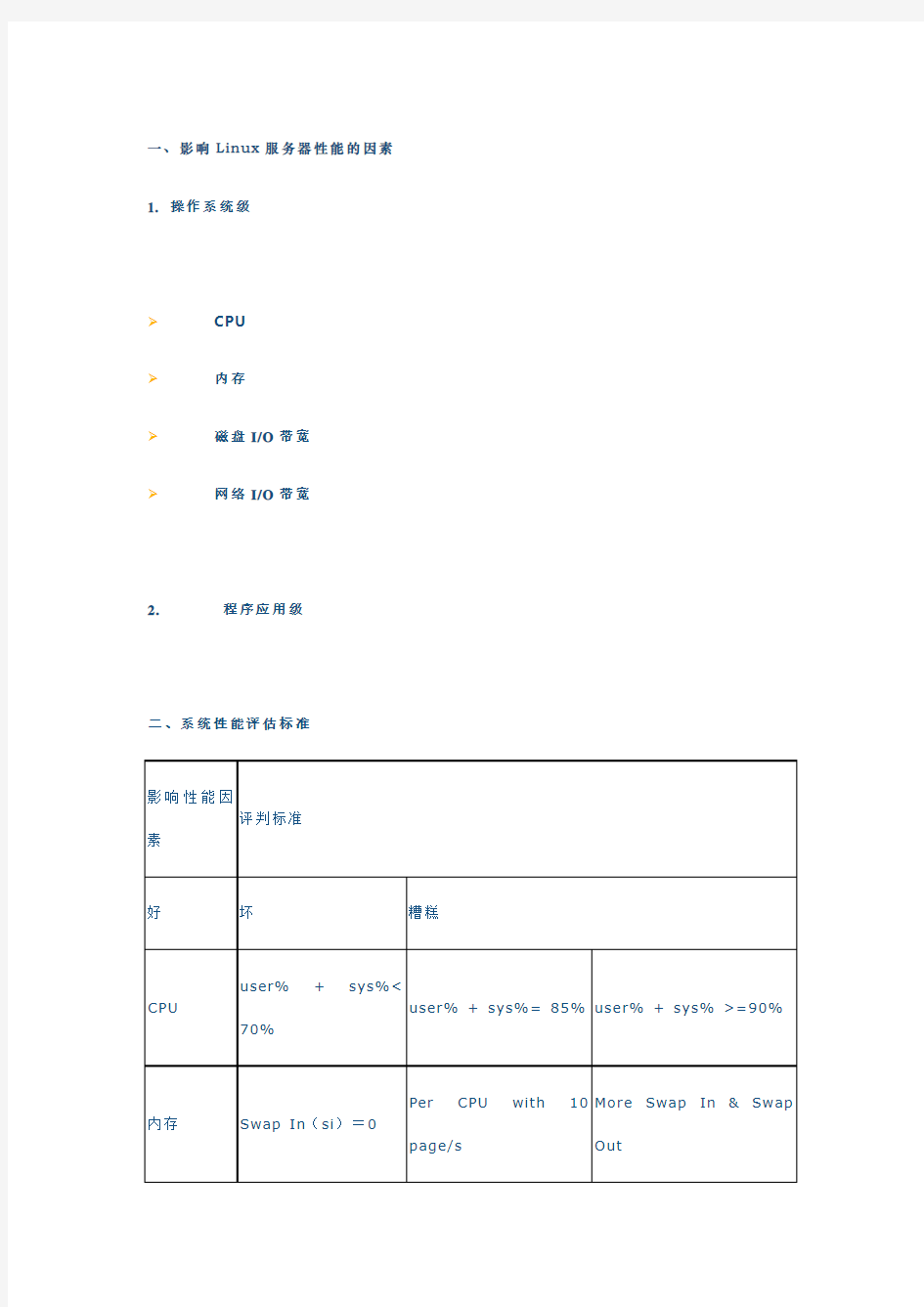

二、系统性能评估标准

影响性能因

素

评判标准

好坏糟糕

CPU

user% + sys%<

70%

user% + sys%= 85%user% + sys% >=90%

内存Swap In(si)=0

Per CPU with 10

page/s More Swap In & Swap Out

Swap Out(so)=0

磁盘iowait % < 20%iowait % =35%iowait % >= 50%

其中:

%user:表示CPU处在用户模式下的时间百分比。

%sys:表示CPU处在系统模式下的时间百分比。

%iowait:表示CPU等待输入输出完成时间的百分比。

swap in:即si,表示虚拟内存的页导入,即从SWAP DISK交换到RAM

swap out:即so,表示虚拟内存的页导出,即从RAM交换到SWAP DISK。

三、系统性能分析工具

1.常用系统命令

Vmstat、sar、iostat、netstat、free、ps、top等

2.常用组合方式

?用vmstat、sar、iostat检测是否是CPU瓶颈

?用free、vmstat检测是否是内存瓶颈

?用iostat检测是否是磁盘I/O瓶颈

?用netstat检测是否是网络带宽瓶颈

四、Linux性能评估与优化

1. 系统整体性能评估(uptime命令)

[root@web1 ~]# uptime

16:38:00 up 118 days, 3:01, 5 users, load average: 1.22, 1.02, 0.91

这里需要注意的是:load average这个输出值,这三个值的大小一般不能大于系统CPU 的个数,例如,本输出中系统有8个CPU,如果load average的三个值长期大于8时,说明CPU很繁忙,负载很高,可能会影响系统性能,但是偶尔大于8时,倒不用担心,一般不会影响系统性能。相反,如果load average的输出值小于CPU的个数,则表示CPU还有空闲的时间片,比如本例中的输出,CPU是非常空闲的。

2. CPU性能评估

(1)利用vmstat命令监控系统CPU

该命令可以显示关于系统各种资源之间相关性能的简要信息,这里我们主要用它来看

CPU一个负载情况。

下面是vmstat命令在某个系统的输出结果:

[root@node1 ~]# vmstat 2 3

procs -----------memory---------- ---swap-- -----io---- --system--

-----cpu------

r b swpd free buff cache si so bi bo in

cs us sy id wa st

0 0 0 162240 8304 67032 0 0 13 21 1007

23 0 1 98 0 0

0 0 0 162240 8304 67032 0 0 1 0 1010

20 0 1 100 0 0

0 0 0 162240 8304 67032 0 0 1 1 1009

18 0 1 99 0 0

●Procs

r列表示运行和等待cpu时间片的进程数,这个值如果长期大于系统CPU的个数,说明CPU不足,需要增加CPU。

b列表示在等待资源的进程数,比如正在等待I/O、或者内存交换等。

●Cpu

us列显示了用户进程消耗的CPU 时间百分比。us的值比较高时,说明用户进程消耗

的cpu时间多,但是如果长期大于50%,就需要考虑优化程序或算法。

sy列显示了内核进程消耗的CPU时间百分比。Sy的值较高时,说明内核消耗的CPU 资源很多。

根据经验,us+sy的参考值为80%,如果us+sy大于80%说明可能存在CPU资源不足。

(2)利用sar命令监控系统CPU

sar功能很强大,可以对系统的每个方面进行单独的统计,但是使用sar命令会增加系统开销,不过这些开销是可以评估的,对系统的统计结果不会有很大影响。

下面是sar命令对某个系统的CPU统计输出:

[root@webserver ~]# sar -u 3 5

Linux 2.6.9-42.ELsmp (webserver) 11/28/2008 _i686_ (8 CPU) 11:41:24 AM

CPU %user %nice %system %iowait %steal %idle

11:41:27 AM all 0.88 0.00 0.29 0.00 0.00 98.83

11:41:30 AM all 0.13 0.00 0.17 0.21 0.00 99.50

11:41:33 AM all 0.04 0.00 0.04 0.00 0.00

99.92

11:41:36 AM all 90.08 0.00 0.13 0.16

0.00 9.63

11:41:39 AM all 0.38 0.00 0.17 0.04 0.00 99.41

Average: all 0.34 0.00 0.16 0.05 0.00 99.45

对上面每项的输出解释如下:

●%user列显示了用户进程消耗的CPU 时间百分比。

●%nice列显示了运行正常进程所消耗的CPU 时间百分比。

●%system列显示了系统进程消耗的CPU时间百分比。

●%iowait列显示了IO等待所占用的CPU时间百分比

●%steal列显示了在内存相对紧张的环境下pagein强制对不同的页面进行的steal操作。

●%idle列显示了CPU处在空闲状态的时间百分比。

问题

1.你是否遇到过系统CPU整体利用率不高,而应用缓慢的现象?

在一个多CPU的系统中,如果程序使用了单线程,会出现这么一个现象,CPU的

整体使用率不高,但是系统应用却响应缓慢,这可能是由于程序使用单线程的原因,单线程只使用一个CPU,导致这个CPU占用率为100%,无法处理其它请求,而其它的CPU却闲置,这就导致了整体CPU使用率不高,而应用缓慢现象的发生。

3. 内存性能评估

(1)利用free指令监控内存

free是监控linux内存使用状况最常用的指令,看下面的一个输出:

[root@webserver ~]# free -m

total used free shared buffers cached

Mem: 8111 7185926 0 243

6299

-/+ buffers/cache: 643 7468

Swap: 8189 0 8189

一般有这样一个经验公式:应用程序可用内存/系统物理内存>70%时,表示系统内存资源非常充足,不影响系统性能,应用程序可用内存/系统物理内存<20%时,表示系统内存资源紧缺,需要增加系统内存,20%<应用程序可用内存/系统物理内存<70%时,表示系统内存资源基本能满足应用需求,暂时不影响系统性能。

3.内存性能评估

(1)利用free指令监控内存

free是监控linux内存使用状况最常用的指令,看下面的一个输出:

[root@webserver ~]# free -m

total used free shared buffers cached

Mem: 8111 7185926 0 243

6299

-/+ buffers/cache: 643 7468

Swap: 8189 0 8189

一般有这样一个经验公式:应用程序可用内存/系统物理内存>70%时,表示系统内存资源非常充足,不影响系统性能,应用程序可用内存/系统物理内存<20%时,表示系统内存资源紧缺,需要增加系统内存,20%<应用程序可用内存/系统物理内存<70%时,表示系统内存资源基本能满足应用需求,暂时不影响系统性能。

(2)利用vmstat命令监控内存

[root@node1 ~]# vmstat 2 3

procs -----------memor y---------- ---swap-- -----io---- --system--

-----cpu------

r b swpd free buff cache si so bi bo in

cs us sy id wa st

0 0 0 162240 8304 67032 0 0 13 21 1007 23

0 1 98 0 0

0 0 0 162240 8304 67032 0 0 1 0 1010 20 0 1 100 0 0

0 0 0 162240 8304 67032 0 0 1 1 1009 18

0 1 99 0 0

●memor y

swpd列表示切换到内存交换区的内存数量(以k为单位)。如果swpd的值不为0,或者比较大,只要si、so的值长期为0,这种情况下一般不用担心,不会影响系统性能。

free列表示当前空闲的物理内存数量(以k为单位)

buff列表示buffers cache的内存数量,一般对块设备的读写才需要缓冲。

cache列表示page cached的内存数量,一般作为文件系统cached,频繁访问的文件都会被cached,如果cache值较大,说明cached的文件数较多,如果此时IO中bi比较小,说明文件系统效率比较好。

●swap

si列表示由磁盘调入内存,也就是内存进入内存交换区的数量。

so列表示由内存调入磁盘,也就是内存交换区进入内存的数量。

一般情况下,si、so的值都为0,如果si、so的值长期不为0,则表示系统内存不足。需要增加系统内存。

4.磁盘I/O性能评估

(1)磁盘存储基础

●熟悉RAID存储方式,可以根据应用的不同,选择不同的RAID方式。

●尽可能用内存的读写代替直接磁盘I/O,使频繁访问的文件或数据放入内存中进行操作处理,因为内存读写操作比直接磁盘读写的效率要高千倍。

●将经常进行读写的文件与长期不变的文件独立出来,分别放置到不同的磁盘设备上。

●对于写操作频繁的数据,可以考虑使用裸设备代替文件系统。

使用裸设备的优点有:

?数据可以直接读写,不需要经过操作系统级的缓存,节省了内存资源,避免了内存资源争用。

?避免了文件系统级的维护开销,比如文件系统需要维护超级块、I-node等。?避免了操作系统的cache预读功能,减少了I/O请求。

使用裸设备的缺点是:

?数据管理、空间管理不灵活,需要很专业的人来操作。

(2)利用iostat评估磁盘性能

[root@webserver ~]# iostat -d 2 3

Linux 2.6.9-42.ELsmp (webser ver) 12/01/2008 _i686_ (8 CPU)

Device: tps Blk_read/s Blk_wrtn/s Blk_read Blk_wrtn

sda 1.87 2.58 114.12 6479462 286537372

Device: tps Blk_read/s Blk_wrtn/s Blk_read Blk_wr tn

sda 0.00 0.00 0.00 0

Device: tps Blk_read/s Blk_wrtn/s Blk_read Blk_wrtn

sda 1.00 0.00 12.00 0

24

对上面每项的输出解释如下:

Blk_read/s表示每秒读取的数据块数。

Blk_wrtn/s表示每秒写入的数据块数。

Blk_read表示读取的所有块数。

Blk_wrtn表示写入的所有块数。

可以通过Blk_read/s和Blk_wrtn/s的值对磁盘的读写性能有一个基本的了解,如果Blk_wrtn/s值很大,表示磁盘的写操作很频繁,可以考虑优化磁盘或者优化程序,

如果Blk_read/s值很大,表示磁盘直接读取操作很多,可以将读取的数据放入内存中进行操作。

对于这两个选项的值没有一个固定的大小,根据系统应用的不同,会有不同的值,但是有一个规则还是可以遵循的:长期的、超大的数据读写,肯定是不正常的,这种情况一定会影响系统性能。

(3)利用sar评估磁盘性能

通过“sar –d”组合,可以对系统的磁盘IO做一个基本的统计,请看下面的一个输出:

[root@webserver ~]# sar -d 2 3

Linux 2.6.9-42.ELsmp (webserver) 11/30/2008 _i686_ (8 CPU)

11:09:33 PM DEV tps rd_sec/s wr_sec/s avgrq-sz avgqu-sz await svctm %util

11:09:35 PM dev8-0 0.00 0.00 0.00 0.00

0.00 0.00 0.00 0.00

11:09:35 PM DEV tps rd_sec/s wr_sec/s avgrq-sz avgqu-sz await svctm %util

11:09:37 PM dev8-0 1.00 0.00 12.00 12.00 0.00 0.00 0.00 0.00

11:09:37 PM DEV tps rd_sec/s wr_sec/s avgrq-sz avgqu-sz await svctm %util

11:09:39 PM dev8-0 1.99 0.00 47.76 24.00 0.00 0.50 0.25 0.05

Average: DEV tps rd_sec/s wr_sec/s avgrq-sz avgqu-sz await svctm %util

Average: dev8-0 1.00 0.00 19.97 20.00

0.00 0.33 0.17 0.02

需要关注的几个参数含义:

await表示平均每次设备I/O操作的等待时间(以毫秒为单位)。

svctm表示平均每次设备I/O操作的服务时间(以毫秒为单位)。

%util表示一秒中有百分之几的时间用于I/O操作。

对以磁盘IO性能,一般有如下评判标准:

正常情况下svctm应该是小于await值的,而svctm的大小和磁盘性能有关,CPU、

内存的负荷也会对svctm值造成影响,过多的请求也会间接的导致svctm值的增加。

await值的大小一般取决与svctm的值和I/O队列长度以及I/O请求模式,如果svctm的值与await很接近,表示几乎没有I/O等待,磁盘性能很好,如果await的值远高于svctm的值,则表示I/O队列等待太长,系统上运行的应用程序将变慢,此时可以通过更换更快的硬盘来解决问题。

%util项的值也是衡量磁盘I/O的一个重要指标,如果%util接近100%,表示磁盘产生的I/O请求太多,I/O系统已经满负荷的在工作,该磁盘可能存在瓶颈。长期下去,势必影响系统的性能,可以通过优化程序或者通过更换更高、更快的磁盘来解决此问题。

5. 网络性能评估

(1)通过ping命令检测网络的连通性

(2)通过netstat –i组合检测网络接口状况

(3)通过netstat –r组合检测系统的路由表信息

(4)通过sar –n组合显示系统的网络运行状态

五、Oracle在Linux下的性能优化

Oracle数据库内存参数的优化

与oracle相关的系统内核参数

SGA、PGA参数设置

Oracle下磁盘存储性能优化

文件系统的选择(ext2/ext3、xfs、ocfs2) Oracle ASM存储

1.优化oracle性能参数之前要了解的情况

1)物理内存有多大

2)操作系统估计要使用多大内存

3)数据库是使用文件系统还是裸设备

4)有多少并发连接

5)应用是OLTP类型还是OLAP类型

2.oracle数据库内存参数的优化

(1)系统内核参数

修改/etc/sysctl.conf 这个文件,加入以下的语句:kernel.shmmax = 2147483648

kernel.shmmni = 4096

kernel.shmall = 2097152

kernel.sem = 250 32000 100 128

fs.file-max = 65536

net.ipv4.ip_local_port_range = 1024 65000

参数依次为:

Kernel.shmmax:共享内存段的最大尺寸(以字节为单位)。

Kernel.shmmni:系统中共享内存段的最大数量。

Kernel.shmall:共享内存总量,以页为单位。

fs.file-max:文件句柄数,表示在Linux系统中可以打开的文件数量。

net.ipv4.ip_local_port_range:应用程序可使用的IPv4端口范围。

需要注意的几个问题

关于Kernel.shmmax

Oracle SGA 由共享内存组成,如果错误设置SHMMAX可能会限制SGA 的大小,SHMMAX设置不足可能会导致以下问题:ORA-27123:unable to attach to shared memory segment,如果该参数设置小于Oracle SGA设置,那么SGA就会被分配多个共享内存段。这在繁忙的系统中可能成为性能负担,带来系统问题。

Oracle建议Kernel.shmmax最好大于sga,以让oracle共享内存区SGA在一个共享内存段中,从而提高性能。

关于Kernel.shmall

表示系统共享内存总大小,以页为单位。

一个32位的Linux系统,8G的内存,可以设置kernel.shmall = 2097152,即为:2097152*4k/1024/1024 = 8G就是说可用共享内存一共8G,这里的4K是32位操作系统一页的大小,即4096字节。

关于Kernel.shmmni

表示系统中共享内存段的最大数量。系统默认是4096,一般无需修改,在SUN OS 下还有Kernel.shmmin参数,表示共享内存段最小尺寸,勿要混肴!(2)SGA、PAG 参数的设置

A Oracle在内存管理方面的改进

Oracle 9i通过参数PGA_AGGREGATE_TARGET参数实现PGA自动管理Oracle 10g通过参数SGA_TARGET参数实现了SGA的自动管理,

Oracle 11g实现了数据库所有内存块的全自动化管理,使得动态管理SGA和PGA 成为现实。

自动内存管理的两个参数:

MEMORY_TARGET:表示整个ORACLE实例所能使用的内存大小,包括PGA和SGA 的整体大小,即这个参数是动态的,可以动态控制SGA和PGA的大小。

MEMORY_MAX_TARGET:这个参数定义了MEMORY_TARGET最大可以达到而不用重启实例的值,如果没有设置MEMORY_MAX_TARGET值,默认等于MEMORY_TARGET

的值。

使用动态内存管理时,SGA_TARGET和PGA_AGGREGATE_TARGET代表它们各自内存区域的最小设置,要让Oracle完全控制内存管理,这两个参数应该设置为0。

B Oracle五种内存管理方式

自动内存管理,即AMM (Automatic Memory Management)

自动共享内存管理,即ASMM(Automatic Shared Memory Management) 手动共享内存管理

自动PGA管理

手动PGA管理

自动内存管理(AMM)

默认安装oracle11g的实例就是AMM方式。通过如下查看:

示例如下:

SQL> show parameters target

NAME TYPE

VALUE

------------ --------------------- ------------------ ----------------------

archive_lag_target integer 0

db_flashback_retention_target integer 1860

fast_start_io_target in teger 0

fast_start_mttr_target integer 0 memory_max_target big integer 1400M memory_target big integer 1400M pga_aggregate_target big integer 0

sga_target big integer 0注意:如果初始化参数LOCK_SGA =true ,则AMM 是不可用的。

自动共享内存管理

Linux性能监控、调优(CPU篇)

Linux性能监控、调优(CPU篇) 前言: 网上其实有很多关于这方面的文章,那为什么还会有此篇呢,有这么几个原因,是我翻 译的动力,第一,概念和内容虽然老套,但都讲得很透彻,而且还很全面.第二,理论结合实际,其中案例分析都不错.第三,不花哨,采用的工具及命令都是最基本的,有助于实际操作.但本人才疏学浅,译文大多数都是立足于自己对原文的理解,大家也可以自己去OSCAN上找原文,如果有什么较大出入,还望留言回复,甚是感激! 1.0 性能监控介绍 性能优化就是找到系统处理中的瓶颈以及去除这些的过程,多数管理员相信看一些相关的"cook book"就可以实现性能优化,通常通过对内核的一些配置是可以简单的解决问题,但并不适合每个环境,性能优化其实是对OS 各子系统达到一种平衡的定义,这些子系统包括了: CPU Memory IO Network 这些子系统之间关系是相互彼此依赖的,任何一个高负载都会导致其他子系统出现问题.比如: 大量的页调入请求导致内存队列的拥塞 网卡的大吞吐量可能导致更多的CPU开销 大量的CPU开销又会尝试更多的内存使用请求 大量来自内存的磁盘写请求可能导致更多的CPU 以及IO问题 所以要对一个系统进行优化,查找瓶颈来自哪个方面是关键,虽然看似是某一个子系统 出现问题,其实有可能是别的子系统导致的. 1.1 确定应用类型 基于需要理解该从什么地方来入手优化瓶颈,首先重要的一点,就是理解并分析当前系 统的特点,多数系统所跑的应用类型,主要为2种: IO Bound(译注:IO 范畴): 在这个范畴中的应用,一般都是高负荷的内存使用以及存储系统,这实际上表示IO 范畴的应用,就是一个大量数据处理的过程.IO 范畴的应用不对CPU 以及网络发起更多请求(除非类似NAS这样的网络存储硬件).IO 范畴的应用通常使用CPU 资源都是为了产生IO 请求以及进入到内核调度的sleep 状态.通常数据库软件(译 注:mysql,oracle等)被认为是IO 范畴的应用类型.

(整理)linux系统监控性能评估.

总控服务器性能: 一、Cpu性能评估 Vmstat命令的参数解释: 对上面每项的输出解释如下: procs r列表示运行和等待cpu时间片的进程数,这个值如果长期大于系统CPU的个数,说明CPU 不足,需要增加CPU。? b列表示在等待资源的进程数,比如正在等待I/O、或者内存交换等。 Memory swpd列表示切换到内存交换区的内存数量(以k为单位)。如果swpd的值不为0,或者比较大,只要si、so的值长期为0,这种情况下一般不用担心,不会影响系统性能。 free列表示当前空闲的物理内存数量(以k为单位)? buff列表示buffers cache的内存数量,一般对块设备的读写才需要缓冲。 cache列表示page cached的内存数量,一般作为文件系统cached,频繁访问的文件都会被cached,如果cache值较大,说明cached的文件数较多,如果此时IO中bi比较小,说明文件系统效率比较好。 swap si列表示由磁盘调入内存,也就是内存进入内存交换区的数量。 so列表示由内存调入磁盘,也就是内存交换区进入内存的数量。 一般情况下,si、so的值都为0,如果si、so的值长期不为0,则表示系统内存不足。需要增加系统内存。? IO项显示磁盘读写状况? Bi列表示从块设备读入数据的总量(即读磁盘)(每秒kb)。 Bo列表示写入到块设备的数据总量(即写磁盘)(每秒kb) 这里我们设置的bi+bo参考值为1000,如果超过1000,而且wa值较大,则表示系统磁盘IO有问题,应该考虑提高磁盘的读写性能。 system 显示采集间隔内发生的中断数 in列表示在某一时间间隔中观测到的每秒设备中断数。 cs列表示每秒产生的上下文切换次数。 上面这2个值越大,会看到由内核消耗的CPU时间会越多。 CPU项显示了CPU的使用状态,此列是我们关注的重点。 us列显示了用户进程消耗的CPU 时间百分比。us的值比较高时,说明用户进程消耗的cpu 时间多,但是如果长期大于50%,就需要考虑优化程序或算法。 sy列显示了内核进程消耗的CPU时间百分比。Sy的值较高时,说明内核消耗的CPU资源很多。 根据经验,us+sy的参考值为80%,如果us+sy大于 80%说明可能存在CPU资源不足。 id 列显示了CPU处在空闲状态的时间百分比。 wa列显示了IO等待所占用的CPU时间百分比。 wa值越高,说明IO等待越严重,根据经验,wa的参考值为20%,如果wa超过20%,说明IO等待严重,引起IO等待的原因可能是磁盘大量随机读写造成的,也可能是磁盘或者磁盘控制器的带宽瓶颈造成的(主要是块操作)。综上所述,在对CPU的评估中,需要重点注意

linux_操作系统优化方案

按照传统,Linux不同的发行版本和不同的内核对各项参数及设置均做了改动,从而使得系统能够获得更好的性能。下边将分四部分介绍在Red Hat Enterprise Linux AS和SUSE LINUX Enterprise Server系统下,如何用以下几种技巧进行性能的优化: 1、Disabling daemons (关闭daemons) 2、Shutting down the GUI (关闭GUI) 3、C hanging kernel parameters (改变内核参数) 4、Kernel parameters (内核参数) 5、Tuning the processor subsystem(处理器子系统调优) 6、Tuning the memory subsystem (内存子系统调优) 7、Tuning the file system(文件系统子系统调优) 8、Tuning the network subsystem(网络子系统调优) 1 关闭daemons 有些运行在服务器中的daemons (后台服务),并不是完全必要的。关闭这些daemons可释放更多的内存、减少启动时间并减少C PU处理的进程数。减少daemons数量的同时也增强了服务器的安全性。缺省情况下,多数服务器都可以安全地停掉几个daemons。 Table 10-1列出了Red Hat Enterprise Linux AS下的可调整进程. Table 10-2列出了SUSE LINUX Enterprise Server下的可调整进程

注意:关闭xfs daemon将导致不能启动X,因此只有在不需要启动GUI图形的时候才可以关闭xfs daemon。使用startx 命令前,开启xfs daemon,恢复正常启动X。 可以根据需要停止某个进程,如要停止sendmail 进程,输入如下命令: Red Hat: /sbin/service sendmail stop SUSE LINUX: /etc/init.d/sendmail stop 也可以配置在下次启动的时候不自动启动某个进程,还是send mail: Red Hat: /sbin/chkconfig sendmail off SUSE LINUX: /sbin/chkconfig -s sendmail off 除此之外,LINUX还提供了图形方式下的进程管理功能。对于Red Hat,启动GUI,使用如下命令:/usr/bin/redhat-config-serv ices 或者鼠标点击M ain M enu -> System Settings -> Serv er Settings -> Serv ices.

优化服务器的性能

优化服务器的性能 第18章服务器性能监视及优化 服务器的安全管理是网络管理人员日常工作的重要内容。服务器的安全管理涉及系统安全、设备安全、网络安全、应用安全、数据安全等方面。因此,只有重视服务器的安全性,掌握网站服务器应用过程中的安全因素,才能制定出服务器的安全措施,并保证网站服务器的正常、安全、高效、稳定运行。本章详细介绍如何加强服务器的安全管理。 18.1 优化服务器的性能 作为系统管理员,不仅担负着对网络和服务器的维护工作,同时还应当随时掌握服务器系统的运行情况,随时了解和掌握系统的各种性能参数,如CPU使用率、内存占用量、网络负载等状况,并通过必要的方法优化系统性能,解决系统存在的潜在问题,保证网络和服务器能够高效、稳定运行,为企业和用户提供各项优质服务。 18.1.1 检测服务器的性能 可以通过任务管理工具来检测和查询服务器的系统性能,并快速获得服务器的系统信息。 1.检测和管理进程 进程与系统性能有着很大的关系。执行应用程序将产生一个进程,并占用服务器系统的资源,进程越多,占用的系统资源也就越多。任务管理器是监视计算机性能的关键指示器,可以查看正在运行的程序的状态,并终止已停止响应的程序。还可以使用多个参数评估正在运行进程的活动,查看反映CPU和内存使用情况的图形和数据。 STEP1 在Windows Server 2003正常运行的情况下,按下组合键Ctrl+Alt+Delete,出现Windows安全管理窗口,单击“任务管理器”按钮,出现如图18-1所示的窗口。 STEP2 在Windows任务管理器的“进程”选项卡中,可查看系统正在运行的进程情况,如用户名、CPU、内存使用等信息。同时,在窗口的底端显示了当前的进程数、CPU使用率和内存使用等情况。 STEP3 选择菜单“查看→选择列”命令,出现如图18-2所示的对话框。选择其中需要显示的选项,可以在列表框中列出多达几十个有关进程的信息。最好选中“基本优先级”复选框,方便查看正在运行程序的优先级。单击“确定”按钮返回Windows任务管理器。根据进程列表中的信息,分析进程是否需要更改优先级或者结束运行。

系统性能评估

第7章 1.工程工作站:具有实现工程计算、程序编制和调试、作图、通信、资源共享的计算机环 境。 2.早期CAD环境:“大型机(超级小型机)+多路终端 3.工作站从应用对象、范围和功能需求上都不同于普通PC机 4.工作站与PC在配置上的一般区别:1. 图形处理能力:专业图形卡2. 可靠性: 采用多种 可靠性措施3. 性能: 采用高性能器件4. 扩展能力: 内存、多处理器等5. 软件配置: 操作系统、高性能图形处理软件等。 5.系统性能评价技术:从技术上, 主要有分析、模拟、测量三种技术 6.常采用的分析技术有:常采用排队论、随机过程、均值分析等方法进行近似求解,比如 流水线性能、多处理器系统性能分析、软件可靠性静态评估等。 7.分析技术的特点:特点是理论严密, 对基础理论的掌握要求较高。优点是节约人力/物 力, 可应用于设计中的系统。 8.模拟技术的特点:既可以应用于设计中或实际应用中的系统, 也可以与分析技术相结 合, 构成一个混合系统。 9.测量技术的特点: 10.模拟技术是基于试验数据的系统建模, 主要有: (1) 按系统的运行特性建立系统模型; (2) 按系统工作负载情况建立工作负载模型; (3) 编写模拟程序, 模拟被评价系统的运 行。 11.测量技术:该技术是对已投入使用的系统进行测量, 通常采用不同层次的基准测试程序 评估。不同层次指的是:核心程序、实际应用程序、合成测试程序 12.几乎所有基于模拟的评价方法都依赖于测试数据或实验值 13.总结:分为三种性能评价技术,分别是分析、模拟、测量,这三种技术分别对用不同成 熟度的系统。分析技术对应理论研究,特点是理论严密,基础知识掌握度高。模拟技术是对正在设计以及已经用于实际应用的系统进行建模,建模数据来源是实验数据。而测量技术的应用是对已经投入使用的系统进行测量。通常采用不同层次的基准测试程序,不同层次值的是:核心程序、实际应用程序、合成测试程序。 14.系统性能评价对象:内存、I?O、网络、操作系统、编译器的性能。 15.与程序执行的时间相关的两大因素:(1) 时钟频率(MHz);(2) 执行程序使用的总时钟周期 数。 16.CPU时间= 总时钟周期数?时钟周期= 总时钟周期数/ 时钟频率 17.IC(程序执行的指令数)和CPI(每条指令所需时钟数 18.CPU时间= CPI?IC ?时钟周期= CPI?IC /时钟频率 19.(1) 时钟频率: 反映计算机实现、工艺和组织技术; 20.(2) CPI: 反映计算机实现、指令集结构和组织; 21.(3) IC: 反映计算机指令集结构和编译技术。 22.系统性能评价标准:(1) 时钟频率(主频): 用于同类处理机之间(2) 指令执行速度法 (MIPS —定点运算) (3) 等效指令速度:吉普森(Gibson)法4)数据处理速率PDR(processing data rate)法(5) 基准程序测试法 23.MIPS指标的主要缺点是不能反映以下情况: ①不能反映不同指令对速度的影响②不能 反映指令使用频率差异的影响③不能反映程序量对程序执行速度的影响 24.吉普森(Gibson)法的主要缺点:(1) 同类指令在不同的应用中被使用的频率不同;(2) 程序 量和数据量对Cache 影响; (3) 流水线结构中指令执行顺序对速度的影响;(4) 编译程序对系统性能的影响。

LINUX性能调优方法总结

LINUX性能调优方法总结 大多数 Linux 发布版都定义了适当的缓冲区和其他 Transmission Control Protocol(TCP)参数。可以修改这些参数来分配更多的内存,从而改进网络 性能。设置内核参数的方法是通过 proc 接口,也就是通过读写 /proc 中的值。幸运的是,sysctl 可以读取 /etc/sysctl.conf 中的值并根据需要填充 /proc,这样就能够更轻松地管理这些参数。清单 2 展示在互联网服务器上应用于 Internet 服务器的一些比较激进的网络设置。 # Use TCP syncookies when needed net.ipv4.tcp_syncookies = 1 # Enable TCP window scaling net.ipv4.tcp_window_scaling: = 1 # Increase TCP max buffer size net.core.rmem_max = 16777216 net.core.wmem_max = 16777216 # Increase Linux autotuning TCP buffer limits net.ipv4.tcp_rmem = 4096 87380 16777216 net.ipv4.tcp_wmem = 4096 65536 16777216 # Increase number of ports available net.ipv4.ip_local_port_range = 1024 65000 将这些设置添加到 /etc/sysctl.conf 的现有内容中。第一个设置启用TCP SYN cookie。当从客户机发来新的 TCP 连接时,数据包设置了 SYN 位,服务 器就为这个半开的连接创建一个条目,并用一个 SYN-ACK 数据包进行响应。在正常操作中,远程客户机用一个 ACK 数据包进行响应,这会使半开的连接 转换为全开的。有一种称为 SYN 泛滥(SYN flood)的网络攻击,它使 ACK 数据包无法返回,导致服务器用光内存空间,无法处理到来的连接。SYN cookie 特性可以识别出这种情况,并使用一种优雅的方法保留队列中的空间(细节参见参考资料一节)。大多数系统都默认启用这个特性,但是确保配 置这个特性更可靠。 启用 TCP 窗口伸缩使客户机能够以更高的速度下载数据。TCP 允许在未从远程端收到确认的情况下发送多个数据包,默认设置是最多 64 KB,在与延迟比 较大的远程客户机进行通信时这个设置可能不够。窗口伸缩会在头中启用更多的位,从而增加窗口大小。 后面四个配置项增加 TCP 发送和接收缓冲区。这使应用程序可以更快地丢掉它的数据,从而为另一个请求服务。还可以强化远程客户机在服务器繁忙时发

读懂服务器性能指标

读懂服务器性能指标 用户总希望有一种简单、高效的度量标准,来量化评价服务器系统,以便作为选型的依据。但实际上,服务器的系统性能很难用一两种指标来衡量。包括TPC、SPEC、SAP SD、Linpack和HPCC在内的众多服务器评测体系,从处理器性能、服务器系统性能、商业应用性能直到高性能计算机的性能,都给出了一个量化的评价指标。在如此多的标准中,用户该如何选择最适合自身应用环境的评价体系呢?这里,我们选择了应用面较广泛的TPC和SPEC,作一个深入介绍。 ■走出误区 深入TPC-C指标 TPC体系是影响最大的评测基准之一,尤其近两年,国内媒体对TPC指标的报道可谓海量。但有多少用户真正了解其中的含义呢?本文以TPC-C为例,让用户深入了解这项基准测试。 tpmC值在国内外被广泛用于衡量服务器系统的事务处理能力。但究竟什么是tpmC值呢?笔者曾向一些用户、专业媒体记者乃至某些国外大公司的技术人员问过这个问题,但回答的精确度与tpmC值的流行程度差异甚远。不少人将之误写为TPMC,甚至与TPC组织混为一谈。 TPC(Transactionprocessing Performance Council,事务处理性能委员会)是由数十家会员公司创建的非盈利组织,总部设在美国。TPC的成员主要是计算机软硬件厂家,而非计算机用户,其功能是制定商务应用基准程序的标准规范、性能和价格度量,并管理测试结果的发布。 TPC不给出基准程序的代码,而只给出基准程序的标准规范。任何厂家或其他测试者都可以根据规范,最优地构造出自己的测试系统(测试平台和测试程序)。为保证测试结果的完整性,被测试者(通常是厂家)必须提交给TPC一套完整的报告(Full Disclosure Report),包括被测系统的详细配置、分类价格和包含5年维护费用在内的总价格。该报告必须由TPC授权的审核员核实(TPC本身并不做审计)。TPC 在全球只有不到10名审核员,全部在美国。 TPC推出过11套基准程序,分别是正在使用的TPC-App、TPC-H、TPC-C、TPC-W,过时的TPC-A、TPC-B、TPC-D和TPC-R,以及因为不被业界接受而放弃的TPC-S(Server专门测试基准程序)、TPC-E(大型企业信息服务测试基准程序)和TPC-Client/Server。而目前最为“流行”的TPC-C是在线事务处理(OLTP)的基准程序,于1992年7月完成,后被业界逐渐接受。 TPC-C使用三种性能和价格度量,其中性能由tpmC(transactions per minute,tpm)衡量,C指TPC中的C基准程序。它的定义是每分钟内系统处理的新订单个数。TPC-C还经常以系统性能价格比的方式体现,单位是$/tpmC,即以系统的总价格(单位是美元)/tpmC数值得出。 解读tpmC 从TPC-C的定义不难知道,这套基准程序是用来衡量整个IT系统的性能,而不是评价服务器或某种硬件系统的标准,而且tpmC数值的高低直接受到各个环节的影响,右表大概可以说明系统设置对tpmC 测试的影响。此处的“IT系统”包括服务器、外设(如硬盘或RAID)、服务器端操作系统、数据库软件、客户端及其操作系统、数据库软件和网络连接等。因此,如何解读tpmC数值会因不同的采购需求有非常大的差异。

AIX系统的CPU性能评估

1、vmstat 使用vmstat来进行性能评估,该命令可获得关于系统各种资源之间的相关性能的简要信息。当然我们也主要用它来看CPU的一个负载情况。 下面是我们调用vmstat命令的一个输出结果: $vmstat 1 2 System configuration: lcpu=16 mem=23552MB kthr memory page faults cpu ----- ----------- ------------------------ ----------------- ----------- r b avm fre re pi po fr sr cy in sy cs us sy id wa 0 0 3091988 2741152 0 0 0 0 0 0 1849 26129 4907 8 1 88 3 0 0 3091989 2741151 0 0 0 0 0 0 2527 32013 6561 15 2 77 6 对上面的命令解释如下: Kthr段显示内容 ¨ r列表示可运行的内核线程平均数目,包括正在运行的线程和等待CPU 的线程。如果这个数字大于CPU 的数目,则表明有线程需要等待CPU。 ¨ b列表示处在非中断睡眠状态的进程数。包括正在等待文件系统I/O 的线程,或由于内存装入控制而被挂起的线程。 Memory段显示内容 ¨ avm列表示活动虚拟内存的页面数,每页一般4KB ¨ fre空闲的页面数,每页一般4KB Page段显示内容 ¨ re –该列无效 ¨ pi 从磁盘交换到内存的交换页(调页空间)数量,4KB/页。调页空间是驻留在硬盘上的虚拟内存的一部分。当内存使用过量时,会将溢出的工作组页面存储到调页空间中(窃取页)。当进程访问一个窃取页时,就产生了一个缺页故障,而这一页页必须从调页空间中读入到内存中。 ¨ po 从内存交换到磁盘的交换页数量,4KB/页。如果窃取的工作也在调页空间中不存在或者已经作了修改,则写入调页空间中。如果不被再次访问,它会留在调度空间中直到进程终止或者放弃空间。 ¨ fr 根据页面替换算法每秒释放的页数。当VMM页面替换例程扫描页面帧表(Page Frame Table,PFT)时,它会根据一些条件选取需要窃取的页面以补充空闲列表。该条件中包含工作页面和计算页面,释放的页面中,计算页面不产生I/O,工作页面如果数据没有发生修改,也不需要写回磁盘,也不会产生I/O。 ¨ sr 根据页面替换算法每秒所检查的页数。sr值比fr值高的越多,说明替换算法要查找可以替换的页面就越困难。 ¨ cy 每秒页面替换代码扫描了PFT多少次。因为增加空闲列表达到maxfree值,不一定需要完全扫描PFT表,而所有vmstat输出都为整数,所以通常cy列值为0。 Faults段显示内容(其实这段内容不需太多关注) ¨ in 在该时间间隔中观测到的每秒设备中断数。 ¨ sy 在该时间间隔中观测到的每秒系统调用次数。 ¨ cs 在该时间间隔中观测到的每秒钟上下文切换次数。 Cpu段显示内容 ¨ us 列显示了用户模式所消耗的CPU 时间。

WEB服务器性能测试基本指标

WEB服务器性能测试基本指标 1说明 随着公司业务的发展,公司网站、管理后台、app服务器的访问量在不断增加,但通常在软件设计开发的时候很难模拟出大量用户同时访问系统的实际情况,因此,当Web网站遇到访问高峰时,容易发生服务器响应速度变慢甚至服务中断。为了避免这种情况,需要一种能够真实模拟大量用户访问Web应用系统的性能测试工具进行压力测试,来测试静态HTML页面的响应时间,甚至测试动态网页(包括PHP、JSP 等)的响应时间,为服务器的性能优化和调整提供数据依据。 Web性能测试的部分概况一般来说,一个Web请求的处理包括以下步骤: (1)客户发送请求 (2)web server接受到请求,进行处理; (3)web server 向DB获取数据; (4)web server生成用户的object(页面),返回给用户。给客户发送请求开始到最后一个字节的时间称为响应时间(第三步不包括在每次请求处理中)。

2网络拓扑图 3系统配置

4主要指标 4.1事务(Transaction) 在web性能测试中,一个事务表示一个“从用户发送请求->web server接受到请求,进行处理-> we b server向DB获取数据->生成用户的object(页面),返回给用户”的过程,一般的响应时间都是针对事务而言的。 4.2请求响应时间 请求响应时间指的是从客户端发起的一个请求开始,到客户端接收到从服务器端返回的响应结束,这个过程所耗费的时间,在某些工具中,响应通常会称为“TTLB”,即"time to last byte",意思是从发起一个请求开始,到客户端接收到最后一个字节的响应所耗费的时间,响应时间的单位一般为“秒”或者“毫秒”。一个公式可以表示:响应时间=网络响应时间+应用程序响应时间。标准可参考国外的3/5/10原则: (1)在3秒钟之内,页面给予用户响应并有所显示,可认为是“很不错的”; (2)在3~5秒钟内,页面给予用户响应并有所显示,可认为是“好的”; (3)在5~10秒钟内,页面给予用户响应并有所显示,可认为是“勉强接受的”; (4)超过10秒就让人有点不耐烦了,用户很可能不会继续等待下去; 4.3事务响应时间 事务可能由一系列请求组成,事务的响应时间主要是针对用户而言,属于宏观上的概念,是为了向用户说明业务响应时间而提出的.例如:跨行取款事务的响应时间就是由一系列的请求组成的.事务响应时间是直接衡量系统性能的参数. 4.4并发用户数 并发一般分为2种情况。一种是严格意义上的并发,即所有的用户在同一时刻做同一件事情或者操作,这种操作一般指做同一类型的业务。比如在信用卡审批业务中,一定数目的拥护在同一时刻对已经完成的审批业务进行提交;还有一种特例,即所有用户进行完全一样的操作,例如在信用卡审批业务中,所有的用户可以一起申请业务,或者修改同一条记录。 另外一种并发是广义范围的并发。这种并发与前一种并发的区别是,尽管多个用户对系统发出了请求或者进行了操作,但是这些请求或者操作可以是相同的,也可以是不同的。对整个系统而言,仍然是有很多用户同时对系统进行操作,因此也属于并发的范畴。 可以看出,后一种并发是包含前一种并发的。而且后一种并发更接近用户的实际使用情况,因此对于大多数的系统,只有数量很少的用户进行“严格意义上的并发”。对于WEB性能测试而言,这2种并发情况一般都需要进行测试,通常做法是先进行严格意义上的并发测试。严格意义上的用户并发一般发生在使用比较频繁的模块中,尽管发生的概率不是很大,但是一旦发生性能问题,后果很可能是致命的。严格意义

linux中的weblogic性能调优

Linux中的Weblogic性能测试调整 一.操作系统参数调整 1.linux TCP连接数调整 通过命令:ulimit –n 查看当前最大TCP连接数,这表示当前用户的每个 进程最多允许同时打开多少个文件。一般系统默认为1024,在并发量大 的情况下肯定不够用。 修改此限制的最简单办法:ulimit –n

服务器性能测试指标介绍

服务器性能测试指标介绍 当前业界常见的服务器性能指标有: TPC-C TPC-E TPC-H SPECjbb2005 SPECjEnterprise2010 SPECint2006 及SPECint_rate_2006 SPECfp2006 及SPECfp_rate_2006 SAP SD 2-Tier LINPACK RPE2 一、TPC (Transaction Processing Performance Council) 即联机交易处理性能协会, 成立于1988年的非盈利组织,各主要软硬件供应商均参与,成立目标: 为业界提供可信的数据库及交易处理基准测试结果,当前发布主要基准测试为: TPC-C : 数据库在线查询(OLTP)交易性能 TPC-E : 数据库在线查询(OLTP)交易性能 TPC-H : 商业智能/ 数据仓库/ 在线分析(OLAP)交易性能 1.TPC-C测试内容:数据库事务处理测试, 模拟一个批发商的订单管理系统。实际衡量服务器及数据库软件处理在线查询交易处理(OLTP)的性能表现. 正规TPC-C 测试结果发

布必须提供tpmC值, 即每分钟完成多少笔TPC-C 数据库交易(TPC-C Transaction Per Minute), 同时要提供性价比$/tpmC。如果把TPC-C 测试结果写成为tpm, TPM, TPMC, TPCC 均不属正规。 2.TPC-E测试内容:数据库事务处理测试,模拟一个证券交易系统。与TPC-C一样,实际衡量服务器及数据库软件处理在线查询交易处理(OLTP)的性能表现。正规TPC-E测试结果必须提供tpsE值,即每秒钟完成多少笔TPC-E数据库交易(transaction per second),同时提供$/tpsE。测试结果写成其他形式均不属正规。 对比:TPC-E测试较TPC-C测试,在测试模型搭建上增加了应用服务器层,同时增加了数据库结构的复杂性,测试成本相对降低。截止目前,TPC-E的测试结果仅公布有50种左右,且测试环境均为PC服务器和windows操作系统,并无power服务器的测试结果。除此之外,TPC官方组织并未声明TPC-E取代TPC-C,所以,说TPC-E取代TPC-C并没有根据。 附TPC-C与TPC-E数据库结构对比 3.TPC-H测试内容:对大型数据仓库进行决策支持(decision support)的基准测试。TPC-H包含一组复杂的业务查询及修改操作,属于商业智能/数据仓库/在线分析(OLAP)

Linux-2.6.31内核优化指南

Linux 2.6.31内核优化指南 作者:Ken Wu Email: ken.wug@https://www.360docs.net/doc/7c410080.html, 介绍 本文档是一篇关于Linux Kernel 2.6.31的最简优化指南。作者旨在编译一份性 能最佳且适合普通Application/Server开发用的内核。(非生产环境) 本文提及的内核调优,主要是通过选择最佳编译选项,删除无用驱动,减少内核尺寸,关闭部分安全特性等方式来进行的。 优化后的效果,主要体现在OS启动时间,启动后的内存占用以及应用程序运行性能。 由于作者水平有限,如果描述错误,还请不吝指教。 运行环境 虚拟机Virtualbox 3.1.4 CPU Core 2 Duo P9500 2.53G双核开启vt-x, APIC 磁盘 虚拟10G的SATA磁盘 内存 分了1G物理内存 网卡 虚拟AMD PCNet32 100M 其他USB,串口,显卡,声卡全关 作者是在虚拟机中编译的内核,如果你与作者的运行环境不同,则本文档中的部分描述可能会与你的实际情况有一定出入。 不过,相信大部分用户在看到选项释义时,能做出适合自己的选择。 说明 下列选项中,通过"// "注释的行,代表金国步写的内核选项简介中未提及的选项释义。 通过红色"<==="注释的行,代表内核默认开启,本文档推荐关闭的选项,释

义部分会给出关闭的理由。 参考资料 金国步写的内核选项简介 Linux Kernel Database Linuxsir BBS 优化前后性能对比 项目优化前优化后 内核尺寸 4.1M 1.6M 启动时间(含dhcp+默认init service)22s14s 启动后的内存占用25M22M APP SPEC测试成绩待测待测 General setup ---> [ ] Prompt for development and/or incomplete code/drivers <===显示尚在开发中或尚未完成的代码和驱动.我不是内核或驱动开发人员。 () Local version - append to kernel release [ ] Automatically append version information to the version string Kernel compression mode (Bzip2) ---> <===对比默认的Gzip,Bzip2拥有更高的压缩比 [*] Support for paging of anonymous memory (swap) [*] System V IPC [*] BSD Process Accounting

Linux 性能测试与分析报告

Linux 性能测试与分析 Linux 性能测试与分析 Revision History 1 性能测试简介 l 性能测试的过程就是找到系统瓶颈的过程。 l 性能测试(包括分析和调优)的过程就是在操作系统的各个子系统之间取得平衡的过程。l 操作系统的各个子系统包括: ?CPU

?Memory ?IO ?Network 他们之间高度依赖,互相影响。比如: 1. 频繁的磁盘读写会增加对存的使用 2. 大量的网络吞吐,一定意味着非常可观的CPU利用率 3. 可用存的减少可能增加大量的swapping,从而使系统负载上升甚至崩溃 2 应用程序类型 性能测试之前,你首先需要判断你的应用程序是属于那种类型的,这可以帮助你判断哪个子系统可能会成为瓶颈。 通常可分为如下两种: CPU bound –这类程序,cpu往往会处于很高的负载,当系统压力上升时,相对于磁盘和存,往往CPU首先到达瓶颈。Web server,mail server以及大部分服务类程序都属于这一类。 I/O bound –这类程序,往往会频繁的访问磁盘,从而发送大量的IO请求。IO类应用程序往往利用cpu发送IO请求之后,便进入sleep状态,从而造成很高的IOWAIT。数据库类程序,cache服务器往往属于这种类型。 3 CPU

3.1 性能瓶颈 3.1.1 运算性能瓶颈 作为计算机的计算单元,其运算能力方面,可能出现如下瓶颈: 1. 用户态进程CPU占用率很高 2. 系统态(核态)CPU占用率很高 测试CPU的运算性能,通常是通过计算圆周率来测试CPU的浮点运算能力和稳定性。据说Pentium CPU的一个运算bug就是通过计算圆周率来发现的。圆周率的计算方法,通常是计算小数点后104万位,通过比较运算时间来评测CPU的运算能力。 常用工具: 1. SUPER PI(π) 2. Wprime 与SuperPI不同的是,可以支持多核CPU的运算速度测试 3. FritzChess 一款国际象棋测试软件,测试每秒钟可运算的步数 突破CPU的运算瓶颈,一般只能靠花钱。比如提高时钟频率,提高L1,L2 cache容量或不断追求新一代的CPU架构: Core -> Nehalem(E55x,如r710,dsc1100) -> Westmere –> Sandy Bridge 3.1.2 调度性能瓶颈 CPU除了负责计算之外,另一个非常重要的功能就是调度。在调度方面,CPU可能会出现如下性能瓶颈: 1. Load平均值超过了系统可承受的程度 2. IOWait占比过高,导致Load上升或是引入新的磁盘瓶颈 3. Context Switch过高,导致CPU就像个搬运工一样,频繁在寄存器(CPU Register)和运行队列(run queue)之间奔波 4. 硬中断CPU占比接近于100% 5. 软中断CPU占比接近于100% 超线程 超线程芯片可以使得当前线程在访问存的间隙,处理器可以使用它的机器周期去执行另外一个线程。一个超线程的物理CPU可以被kernel看作是两个独立的CPU。 3.2 典型监控参数 图1:top

控制系统性能评估1

对于一个控制系统来说,系统稳定是前提,在这个前提下,控制系统性能评估主要关心控制系统的动态性能和稳态性能。动态性能指标反映给定输入信号快速平稳的跟踪能力,或者扰动下恢复正常工作的能力。稳态性能指标反映控制性能的最终控制精度。动态性能和稳态性能的性能指标对评估一个控制系统有较重要的作用。 对于控制系统的分析主要有三种方法:时域分析法,频域分析法,根轨迹法。不同的分析方法有不同的稳态和动态性能指标,下面是我的具体介绍。 一、时域:评估一个具体控制系统,我们要得到它的性能指标,在此我给控制系统输入一个阶跃信号,由控制系统输出响应曲线来求出性能指标,仿真可在MATLAB或Simulink进行。 1、一阶系统:数学模型: 阶跃响应曲线: 图一 性能指标:过渡时间ts=4T(98%),上升时间tr=0.13T。上升时间和过渡时间越小,说明其稳态性能和动态性能越好。 2、二阶系统: 数学模型:

单位阶跃响应(衰减振荡形式): 图二 (1)衰减比:n=B/B1,B表示第一个波振幅,B1表示第二个波振幅,n是恒大于1的,n越大稳定性越高,实际操作将n控制在4:1到10:1范围内,则控制性能较好。 (2)超调量δ%:超过目标值的最大偏差量与目标值之比,用百分比表示。阻尼比越小,超调量越大,与自然频率无关。在实际系统中阻尼比一般在0.5-0.8之间。 超调量越大说明稳定性越差,而快速性越好,它们是相互制约的、矛盾的。 (3)调节时间ts:从开始上升到不断调整后进入到稳定的误差范围内的时间。正是这段时间也可以称作动态过程,之后的时间称为稳态。通常所指的动态性能指标包括稳定性和快速性,稳态性能指标就是准确性。稳定性和稳态是不能混为一谈的,一定要分清。 (4)振荡次数N:从开始上升到反复穿越目标值的次数。理想状态下希望N=0.5次。这是考虑到三项指标的综合性。 (5)上升时间tr:从开始上升时间到第一次到达目标值的时间。阻尼比不变时,Wn越大,上升时间越小;自然频率不变,阻尼比越小,上升时间越小。理想状态下希望越短越好,在实际的自动控制系统中是不可能的。 (6)稳态误差ess,反映控制系统的稳态精度,越小越好。 对于一些高阶,复杂的系统,可以在一定范围内简化为典型的系统,便于对控制系统进行分析。 3、高阶系统的性能分析:

linux系统性能优化及瓶颈分析

linux系统性能优化及瓶颈分析 一,用vmstat分析系统I/O情况 [root@localhost ~]# vmstat -n 3 (每个3秒刷新一次) procs-----------memory--------------------swap--- ---io---- --system---- ------cpu-------- r b swpd free buff cache si so bi bo in cs us sy id wa 1 0 144 186164 105252 2386848 0 0 18 166 83 2 48 21 31 0 2 0 144 189620 105252 2386848 0 0 0 177 1039 1210 34 10 56 0 0 0 144 214324 105252 2386848 0 0 0 10 1071 670 32 5 63 0 0 0 144 202212 105252 2386848 0 0 0 189 1035 558 20 3 77 0 2 0 144 158772 105252 2386848 0 0 0 203 1065 2832 70 14 15 0 IO -bi:从块设备读入的数据总量(读磁盘)(KB/S) -bo:写入到块设备的数据总量(写磁盘)(KB/S) 随机磁盘读写的时候,这2个值越大(如超出1M),能看到CPU在IO等待的值也会越大 二,用iostat分析I/O子系统情况 如果你的系统没有iostat,sar,mpstat等命令,安装sysstat- 7.0.2-1.el5.i386.rpm包,iostat工具将对系统的磁盘操作活动进行监视。它的特点是汇报磁盘活动统计情况,同时也会汇报出CPU 使用情况。同vmstat

服务器性能估算

服务器处理性能估算 系统的建设,必须满足未来5年业务发展和管理的需求,所以下面对服务器性能指标的估算,将以满足未来5年的需要为基准。 1. 数据库服务器 1.1. TPCC值估算 约定: 系统同时在线用户数为100人(U1); 平均每个用户每分钟发出2次业务请求(N1); 系统发出的业务请求中,更新、查询、统计各占1/3; 平均每次更新业务产生3个事务(T1); 平均每次查询业务产生8个事务(T2); 平均每次统计业务产生13个事务(T3); 一天内忙时的处理量为平均值的5倍; 经验系数为1.6;(实际工程经验) 考虑服务器保留30%的冗余; 服务器需要的处理能力为: TPC-C=U1*N1*(T1+T2+T3)/3*3*经验系数/冗余系数 则数据库服务器的处理性能估算为: TPC-C= 100*2*(3+8+13)/3*5*1.6/0.7= 18,285 TPM 1.2. 内存估算 该服务器内存主要由操作系统占用内存、数据库系统占用内存、并发连接占用内存等几部分组成。 约定: 操作系统占用约400M内存空间; 数据库系统占用内存0.8G ; 每个并发连接占用5 M; 考虑服务器内存保留15%的冗余; 则服务器的内存估算为: Mem =(400M + 0.8GB + 100*5M) /(1-15%) = 2 GB

预算管理系统中存储着预算编制数据等资料信息以及日志等管理信息。 在已经考虑了数据冗余的前提下,约定: ? 每月有100个分局或部室编制预算; ? 每月每个分局或部室编制1次预算; ? 预算模板共含6000个预算指标; ? 每个预算指标含5条明细项目; ? 每条记录占用空间300B; 每月的预算数据存储容量需求:6000*5*100*500B=1.5G 每月的日志数据存储容量需求:0.1G 每月进行数据备份一次,数据存储容量需求:12*9G=108G 整年总共需用存储容量:12*1.5G+1.5G+12*0.1G+12*9G=20.7G+108G=128.7G 约定系统中预算编制数据等资料信息以及日志等管理信息在线保存5年(备份数据每年进行清除),则预算管理系统的存储容量估算为: 5*20.7G+108G =103.5G+108G=211.5G 1.4. 服务器安装软件 该服务器中将需要安装的软件如下: 操作系统为:Windows 2000 Server 数据库:Oracle 1.5. 建议配置 根据以上的性能指标建议数据库服务器标准配置如下: 应用名称功能描述数量说明 数据库服务器CPU: TPCC值应大于18,285 TPM 内存:2G及以上 硬盘:211.5GB以上(建议通过RAID5或镜像等方式进行数据备份) 以太网卡:100M及以上 1 1.2. 中间件应用服务器