第2章 数据预处理-作业

第二章 数据预处理

2-1【解】

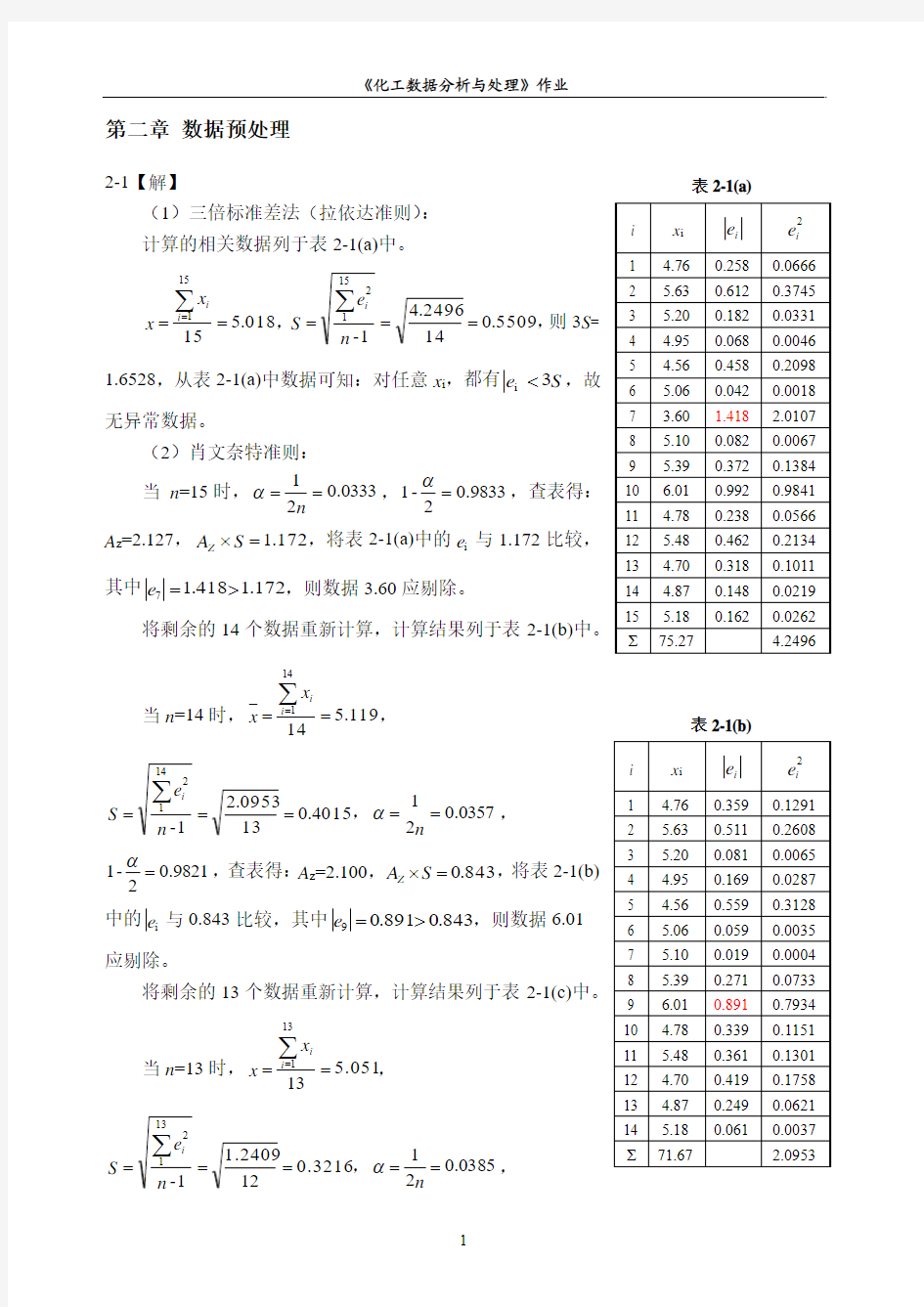

(1)三倍标准差法(拉依达准则): 计算的相关数据列于表2-1(a)中。

018.51515

1==∑

=i i x x ,5509.0142496

.41-15

12

===∑

n e S i ,

则3S = 1.6528,从表2-1(a)中数据可知:对任意x i ,都有S e 3i <,故

无异常数据。

(2)肖文奈特准则:

当 n =15时,0333.021==n α,9833.02-1=α

,查表得:A z =2.127,172.1=?S A Z ,将表2-1(a)中的i e 与1.172比较,其中172.1418.17>=e ,则数据3.60应剔除。 将剩余的14个数据重新计算,计算结果列于表2-1(b)中。

当n =14时,119.514

14

1

==

∑=i i

x

x ,

0154.013

0953

.21-141

2

==

=

∑n e

S i

,0357.021==n α,9821.02

-1=α

,查表得:A z =2.100,843.0=?S A Z ,将表2-1(b)中的i e 与0.843比较,其中843.0891.09>=e ,则数据6.01

应剔除。

将剩余的13个数据重新计算,计算结果列于表2-1(c)中。

当n =13时, 5.0513

1311==∑

=i i

x x ,

0.32162

11.24091

-3

11

2

==

=

∑

n e S i ,8503.021==

n

α,

表2-1(a)

表2-1(b)

0898.02

-

1=α

,查表得:A z =2.070,666.0=?S A Z ,将表2-1(c)中的i e 与0.666比较,对

任意x i ,都有S A e ? 综上,3.60和6.01为异常数据。 (3)格拉布斯准则: 将测量数据按由小到大的顺序排列,并算出g i 列于表2-1(d)中。其中018.5=x , 5509.0=S ,S e g i i = 。 选定显著性水平0.05=α,查格拉布斯检验系数表得到:409.2(15)05.0=g ,将表2-1(d)中的g i 与2.409相比较,其中409.25737.21>=g ,则该数据为粗差,应剔除数据3.60。 对剩余的14个数据重新计算,列于表2-1(e)中。其中.1195=x ,.40150=S ,S e g i i = 。 选定显著性水平0.05=α,查格拉布斯检验系数表得到:.3712(14)05.0=g ,将表2-1(e)中的g i 与2.371相比较,对任意x i ,都有()1405.0g g i <,则剩余的14个数据都符合本方法的要求,属于正常数据。 综上,3.60为异常数据。 表2-1(c) 表2-1(d) 表2-1(e) 2-2【解】 (1)三点线性平滑法: 系数矩阵为:????? ???521-2221-2561 的系数的系数~的系数141321U U U U 计算结果列于表2-2中。 (2)五点线性平滑法: 系数矩阵为:??? ??? ? ? ? ??64202-4321022222 012342-0246101 的系数的系数的系数~的系数的系数 143121321U U U U U U 计算结果列于表2-2中。 (3)将表2-2中的数据作图,如图2-1所示。 图中,平滑程度:五点线性平滑曲线>三点线性平滑曲线>原数据曲线。 表2-2 《化工数据分析与处理》作业 u i t i 图2-1 线性平滑对比图 2-3【解】 (1)三点线性平滑法: 系数矩阵为:????? ???521-2221-2561 的系数的系数~的系数01921U U U U 五点线性平滑法: 系数矩阵为:??? ??? ? ? ? ??64202-4321022222 012342-0246101 的系数的系数的系数~的系数的系数 1098321U U U U U U 七点线性平滑法: 系数矩阵为:?????? ????? ???1310 7412-5-10864202-765432144 4444412345672-02468105-2-1471013281 的系数 的系数的系数的系数 ~的系数的系数的系数109874321U U U U U U U U 计算结果列于表2-3中。 (2)二次五点平滑法: 系数矩阵为:? ? ??? ? ? ? ???3193-5-39131265-3-1217123-5-61213935-3-931351 的系数的系数的系数~的系数的系数1098321U U U U U U 二次七点平滑法: 系数矩阵为:? ?? ????? ? ? ? ???321534-6-3-5151296303391212936-4-612141264-6-3912129330369121553-6-4-31532421 的系数的系数的系数的系数~的系数的系数的系数109874321U U U U U U U U 计算结果列于表2-3中。 (3)三次五点平滑法: 系数矩阵为:??? ??? ?? ? ??6946 -41-4542416-46-243424 6-416-245441-4 6-4 69701 的系数的系数的系数~的系数的系数1098321U U U U U U 三次七点平滑法: 系数矩阵为:?????? ????? ???398 4 -4-1 4 2 -819 166 4-7-44-16191224-14-612141264 -14-21219164-47 -4-6161982-4 1 4 -4-8 39 421 的系数 的系数的系数的系数 ~的系数的系数的系数109874321U U U U U U U U 计算结果列于表2-3中。 将表2-3中的数据作图,如图2-2所示。 从图中可知:平滑的点数越多、平滑程度越好,平滑的次数越高,平滑程度越好。 表2-3 u i t i 图2-2 不同平滑方法效果的对比 2-4【解】 a)对P~T数据作二次五点平滑处理,结果列于表2-4中。 b)对ln P~1/T数据作线性三点平滑处理,结果列于表2-4中。 c)将以上两种平滑处理结果分别绘图,如图2-3(a)和2-3(b)所示。 表2-4 P i / a t m T i / K 图2-3(a) l n P 1/T (K -1 ) 图2-3(b) 1数据的采集与处理 1.1数据的采集 施工监控中需对影响施工及控制精度的数据进行收集,主要包括环境参数和结构参数,前者又主要是指风速风向数据;后者主要指结构容重、弹模等数据。施工监控需进行收集的数据如表1-1所示。 1.1.2数据采集方法 基于港珠澳大桥特殊的地理位置,采用远程数据采集系统,与传统的数据采集系统相比,具有不受地理环境、气候、时间的影响等优势。而借助无线传输手段的远程数据采集系统,更具有工程造价和人力资源成本低,传输数据不受地域的影响,可靠性高,免维护等优点。远程无线数据采集系统的整体结构如图1-2所示。 1-2 远程无线数据采集系统组成结构图 1.2数据的处理与评估 在数据分析之前, 数据处理要能有效地从监测数据中寻找出异常值, 必须对监测数据进行可靠性检验, 剔除粗差的影响, 以保证监测数据的准确、可靠。我们拟采用的是最常用的μ检验法来判别系统误差; 用“3σ准则”剔除粗差; 采用了“五点二次中心平滑”法对观测数据进行平滑修正。同时, 在数据处理之后, 采用关联分析技术寻找某一测点的最佳关联点, (为保证系统评判的可靠性, 某一测点的关联点宜选用2 个以上)。我们选用3 个关联测点, 如果异常测值的关联测点有2 个以上发生异常, 且异常方向一致, 则认为测值异常是由结构变化引起, 否则, 认为异常是由监测系统异常引起。出现异常时, 经过判定, 自动提醒用户检查监测系统或者相应的结构(根据测点所在位置), 及时查明情况, 并采取一些必要的应急措施, 同时对测值做标注, 形成报表, 进行评估。 1.2.1系统误差的判别 判别原则: 异常值检验方法是建立在随机样本观测值遵从正态分布和小概率原理的基础之上的。根据观测值的正态分布特征性, 出现大偏差观测值的概率是很小的。当测值较少时, 在正常情况下, 根据小概率原理, 它们是不会出现的, 一旦出现则表明有异常值。依统计学原理: 偏差处于2 倍标准差或3 倍标准差范围内的数据为正常值, 之外的则判定为异常。事实上标准差σ多数情况下是求知的, 通常用样本值计算的标准差S 来替代。桥梁健康监测资料的数据量特别大, 一般都为大样本, 所以我们用μ检验。在分析中, 我们将所得的数据分成两组Y1 、Y2,并设()1211,1Y N u δ, ()2222,2Y N u δ择统计量为 : 'y y U -= (1) 式中12y y 、—两组样本的平均值: 21n 、n —两组样本的子样数: 21S S 、 —两组样本的方差。若 '2 a U U ≥ (2) 则存在系统误差。否则, 不存在系统误差。 1.2.2 粗差点的剔除 在观测次数充分多的前提下, 其测值的跳动特征描述如下式: ()112j j j j d y y y +-=-+ (3) 式中j y (j=1,2,3,4,……,n- 1)是一系列观测值。 本科生实验报告 实验课程数据挖掘 学院名称信息科学与技术学院 专业名称计算机科学与技术 学生姓名代星 学生学号201413030317 指导教师 实验地点 实验成绩 二〇一六年11月二〇一六年11月 第1章实验内容 使用心脏病患者数据集(CardiologyNumerical.arff)的前两百个实例进行反向传播学习训练,剩余的103个实例作为检验集实例进行模型检验。改变网络结构和参数,使之达到更为理想的检验及效果。 第2章实验目的 对心脏病患者数据集中的数据用反向传播学习训练方法进行分类,查看分类的效果。并通过改变网络的结构和参数,使分类效果更加理想。 第3章算法思想 BP算法是一种有监督式的学习算法,其主要思想是:输入学习样本,使用反向传播算法对网络的权值和偏差进行反复的调整训练,使输出的向量与期望向量尽可能地接近,当网络输出层的误差平方和小于指定的误差时训练完成,保存网络的权值和偏差。具体步骤如下: (1)初始化,随机给定各连接权[w],[v]及阀值θi,rt。 (2)由给定的输入输出模式对计算隐层、输出层各单元输出。 (3)选取下一个输入模式对返回第2步反复训练直到网络设输出误差达到要求结束训练。 第4章实验过程 4.1数据准备 从网上下载数据集,生成.csv文件,加载到Weka。 4.2 建立神经网络结构 1、在Weka Explorer中切换到Classify选项卡,单击Classify窗口的Choose 按钮,选择分类器MultilayerPerceptron,即基于BP学习算法的多层前馈神经网络。 2、在Choose按钮右边的文本框点击,打开分类器的属性设置对话框,将GUi 设置为true,使得在训练前,可查看包含神经网络体系结构的GUI界面,并可交互式地修改结构和设置其他参数,且可以在网络训练过程中暂停,进行结构和参数的反复修改。在属性设置对话框中,设置hiddenLayers为“5,3”,表示有两个隐层,分别有5个和3个隐层节点;设置learning-Rate为0.5,trainingTime 为5000. 3、单击OK按钮,回到Weka Explorer的Classifier窗口,在测试集的选择上题目要求前两百个数据作为实例,最后103个作为检验集,设置Test Options 为Percentage split(取实例个数的百分比作为检验集),并设置为34%满足题目要求。单击More options按钮,打开Classifier evaluation options对话框,选中Output复选框,以确保在输出中能够看到检验集的分类情况。 4、单击start按钮,开始神经网络的训练过程。弹出神经网络的GUI界面,单击start按钮,执行训练,并选择accept训练结果。 5、修改参数,重复上述步骤,重新实验,并对比实验结果。 第5章实验结果 实验一:全部作为实例 浙江大学远程教育学院 《数据挖掘》课程作业 姓名:学号: 年级:学习中心:————————————————————————————— 第一章引言 一、填空题 (1)数据库中的知识挖掘(KDD)包括以下七个步骤:数据清理、数据集成、数据选择、数据交换、数据挖掘、模式评估和知识表示 (2)数据挖掘的性能问题主要包括:算法的效率、可扩展性和并行处理 (3)当前的数据挖掘研究中,最主要的三个研究方向是:统计学、数据库技术和机器学习 (4)孤立点是指:一些与数据的一般行为或模型不一致的孤立数据 二、简答题 (1)什么是数据挖掘? 答:数据挖掘指的是从大量的数据中挖掘出那些令人感兴趣的、有用的、隐含的、先前未知的和可能有用的模式或知识。 (2)一个典型的数据挖掘系统应该包括哪些组成部分? 答:一个典型的数据挖掘系统应该包括以下部分:1、数据库、数据仓库或其他信息库,2、数据库或数据仓库服务器,3、知识库,4、数据挖掘引擎,5、模式评估魔磕,6图形用户界面。 (3)Web挖掘包括哪些步骤? 答:数据清理:(这个可能要占用过程60%的工作量)、数据集成、将数据存入数据仓库、建立数据立方体、选择用来进行数据挖掘的数据、数据挖掘(选择适当的算法来找到感兴趣的模式)、展现挖掘结果、将模式或者知识应用或者存入知识库。 (4)请列举数据挖掘应用常见的数据源。 (或者说,我们都在什么样的数据上进行数据挖掘) 答:常见的数据源包括关系数据库、数据仓库、事务数据库和高级数据库系统和信息库。其中高级数据库系统和信息库包括:空间数据库、时间数据库和时间序列数据库、流数据、多媒体数据库、面向对象数据库和对象——关系数据库、异种数据库和遗产数据库、文本数据库和万维网等。 数据采集与预处理教案 通过API获取外部数据,增强电子表格中的内容。 二、任务实施; (1)在OpenRefine目录中使用“./refine”命令启动OpenRefine服务,如图4-8所示。 图4-8 启动OpenRefine服务 (2)进入其Web操作界面,单击“浏览…”按钮,选择bus_info.csv 文件,单击“打开”按钮,再单击“下一步”按钮,导入数据。 (3)进入一个新界面,在该界面中可以发现上传的CSV文件,如果文件出现乱码,则可以设置字符编码,应选择支持中文的编码,这里选择“GBK”编码,单击界面右上角的“新建项目”按钮。 (4)进入北京公交线路信息显示界面,在其“运行时间”列中有一些多余的信息,可将这些多余信息删除,以使数据更加简洁和直观,如图4-9所示。 图4-9 删除多余信息 (5)在“运行时间”下拉列表中选择“编辑单元格”中的“转换...”选项,启动转换功能。 (6)弹出“自定义文本转换于列运行时间”对话框,在“表达式”文本框中编写表达式,去除列中“运行时间:”多余信息,编写结束后,根据“预览”选项卡中的结果判断表达式编写是否正确。清洗结果满意后单击“确定”按钮,完成自定义文本转换操作。 (7)界面上方弹出一个黄色通知框,通知相关操作导致改变的单元格数,再次进行确认操作。在界面左边的“撤销/重做”选项卡中会显示刚刚的操作记录,如果不想进行相关操作,则可以单击界面左侧对应操作的上一步操作链接,以恢复操作。 同理,可以对其余几列执行类似操作。 (8)操作记录及结果如图4-45所示。 (9)下面将“公司”列中的“服务热线”信息抽取出来并使其独立成列。在“公司”下拉列表中选择“编辑列”中的“由此列派生新列...”选项。 (10)弹出“基于当前列添加列公司”对话框,设置“新列名称”和数据抽取的表达式。 (11)操作结束后,需要将预处理后的数据导出为文件。在界面右上 数据挖掘第二次作业 第一题: 1. a)Compute the Information Gain for Gender, Car Type and Shirt Size. b)Construct a decision tree with Information Gain. 答案: a)因为class分为两类:C0和C1,其中C0的频数为10个,C1的频数为10,所以class 元组的信息增益为Info(D)==1 1.按照Gender进行分类: Info gender(D)==0.971 Gain(Gender)=1-0.971=0.029 2.按照Car Type进行分类 Info carType(D)= =0.314 Gain(Car Type)=1-0.314=0.686 3.按照Shirt Size进行分类: Info shirtSize(D)= =0.988 Gain(Shirt Size)=1-0.988=0.012 b)由a中的信息增益结果可以看出采用Car Type进行分类得到的信息增益最大,所以决策树为: 第二题: 2.(a) Design a multilayer feed-forward neural network (one hidden layer) for the data set in Q1. Label the nodes in the input and output layers. (b)Using the neural network obtained above, show the weight values after one iteration of the back propagation algorithm, given the training instance “(M, Family, Small)". Indicate your initial weight values and biases and the learning rate used. a) 《数据采集与预处理》课程标准 1. 概述 1.1课程的性质 本课程是大数据技术与应用专业、云计算技术与应用专业、软件技术专业的专业核心课程,是校企融合系列化课程,该课程教学内容以任务驱动为主线,围绕企业级应用进行项目任务设计。 1.2课程设计理念 本课程遵循应用型本科和高等职业教育规律,以大数据技术与应用实际工作岗位需求为导向选取课程内容,完成了数据采集和预处理平台搭建、网络爬虫实践、日志数据采集实践和数据预处理实践等完整的数据采集与预处理应用案例,课程目标是培养学生具备“大数据分析”应用项目所需数据采集与预处理的综合职业能力;坚持开放性设计原则,吸收企业专家参与,构建以“工作任务”为载体的“项目化”课程结构;课程教学实施教、学、做一体,坚持理论为实践服务的教学原则,通过模拟企业大数据采集与预处理应用业务进行组织,锻炼学生的实践操作能力。 1.3课程开发思路 通过岗位技能的项目化以及大数据采集与预处理任务的序列化,对内容体系结构进行了适当调 整与重构,以适应教学课程安排。以项目案例及其任务实现为驱动,凭借翔实的操作步骤和准确的 说明,帮助学生迅速掌握大数据采集与预处理的相关知识与技能,并且充分考虑学习操作时可能发 生的问题,并提供了详细的解决方案,突出岗位技能训练。 2.课程目标 本课程的培养目标是使学生以大数据分析岗位需求为依托,以实际工作任务为导向,理清大数据采集与预处理中常用工具的作用及应用,培养学生大数据采集与预处理的实际操作技能。 2.1知识目标 本课程本书以任务驱动为主线,围绕企业级应用进行项目任务设计,完成了数据采集和预处理平台搭建、网络爬虫实践、日志数据采集实践和数据预处理实践等完整的数据采集与预处理应用案例,要求学生系统掌握scrapy、Flume、pig、kettle、Pandas、openrefine和urllib、selenium基本库 1 由于数据库系统所获数据量的迅速膨胀(已达 或 数量级),从而导致了现实世界数据库中常常包含许多含有噪声、不完整( )、甚至是不一致( )的数据。显然对数据挖掘所涉及的数据对象必须进行预处理。那么如何对数据进行预处理以改善数据质量,并最终达到完善最终的数据挖掘结果之目的呢? 数据预处理主要包括:数据清洗( )、数据集成( )、数据转换( )和数据消减( )。本章将介绍这四种数据预处理的基本处理方法。 数据预处理是数据挖掘(知识发现)过程中的一个重要步骤,尤其是在对包含有噪声、不完整,甚至是不一致数据进行数据挖掘时,更需要进行数据的预处理,以提高数据挖掘对象的质量,并最终达到提高数据挖掘所获模式知识质量的目的。例如:对于一个负责进行公司销售数据分析的商场主管,他会仔细检查公司数据库或数据仓库内容,精心挑选与挖掘任务相关数据对象的描述特征或数据仓库的维度( ),这包括:商品类型、价格、销售量等,但这时他或许会发现有数据库中有几条记录的一些特征值没有被记录下来;甚至数据库中的数据记录还存在着一些错误、不寻常( )、甚至是不一致情况,对于这样的数据对象进行数据挖掘,显然就首先必须进行数据的预处理,然后才能进行正式的数据挖掘工作。 所谓噪声数据是指数据中存在着错误、或异常(偏离期望值)的数据;不完整( )数据是指感兴趣的属性没有值;而不一致数据则是指数据内涵出现不一致情况(如:作为关键字的同一部门编码出现不同值)。而数据清洗是指消除数据中所存在的噪声以及纠正其不一致的错误;数据集成则是指将来自多个数据源的数据合并到一起构成一个完整的数据集;数据转换是指将一种格式的数据转换为另一种格式的数据;最后数据消减是指通过删除冗余特征或聚类消除多余数据。 不完整、有噪声和不一致对大规模现实世界的数据库来讲是非常普遍的情况。不完整数据的产生有以下几个原因:( )有些属性的内容有时没有,如:参与销售事务数据中的顾客信息;( )有些数据当时被认为是不必要的;( )由于 数据采集与处理技术 参考书目: 1.数据采集与处理技术马明建周长城西安交通大学出版社 2.数据采集技术沈兰荪中国科学技术大学出版社 3.高速数据采集系统的原理与应用沈兰荪人民邮电出版社 第一章绪论 数据采集技术(Data Acquisition)是信息科学的一个重要分支,它研究信息数据的采集、存贮、处理以及控制等作业。在智能仪器、信号处理以及工业自动控制等领域,都存在着数据的测量与控制问题。将外部世界存在的温度、压力、流量、位移以及角度等模拟量(Analog Signal)转换为数字信号(Digital Signal), 在收集到计算机并进一步予以显示、处理、传输与记录这一过程,即称为“数据采集”。相应的系统即为数据采集系统(Data Acquisition System,简称DAS)数据采集技术以在雷达、通信、水声、遥感、地质勘探、震动工程、无损检测、语声处理、智能仪器、工业自动控制以及生物医学工程等领域有着广泛的应用。 1.1 数据采集的意义和任务 数据采集是指将温度、压力、流量、位移等模拟量采集、转换为数字量后,再由计算机进行存储、处理、显示或打印的过程。相应的系统称为数据采集系统。 数据采集系统的任务:采集传感器输出的模拟信号并转换成计算机能识别的数字信号,然后送入计算机,根据不同的需要由计算机进行相应的计算和处理,得出所需的数据。与此同时,将计算得到的数据进行显示或打印,以便实现对某些物理量的监视,其中一部分数据还将被生产过程中的计算机控制系统用来控制某些物理量。 数据采集系统的好坏,主要取决于精度和速度。 1.2 数据采集系统的基本功能 1.数据采集:采样周期 数据挖掘第二章作业 2. a)用AM和PM表示的时间 离散的、定量的、区间的。 b)根据曝光表测出的亮度 离散的、定量的、比率的。 c)根据人的判断测出的亮度 连续的、定性的、序数的。 d)按度测出的0和360之间的角度 离散的、定量的、比率的。(可以是连续的,因为按度测出的角度值可以是实数值得属性) e)奥运会上授予的铜牌、银牌、和金牌 离散的、定量的、比率的。 f)海拔高度 连续的、定量的、比率的。 g)医院中的病人数 离散的、定量的、比率的。 h)书的ISBN号(查找网上的格式) 离散的、定性的、标称的。 i)用如下值表示的透光能力:不透明、半透明、透明 离散的、定性的、序数的。 j)军衔 离散的、定性的、序数的。 K)到校园中心的距离 连续的、定量的、比率的。 l)用每立方厘米克表示的物质密度 连续的、定量的、比率的。 m)外套寄存号码 离散的、定性的、标称的。 14. 用欧几里得度量来对这些大象进行比较或分组。 因为第一所有的属性测出的值都是数值性质的,并且根据取值规模的不同有很大的取值范围;其次同一对象的不同属性之间是没有什么关系的,所以不用相关性度量;再者在本题中每个对象的量值是重要的,而余弦相似度不考虑数据对象的量值;最后将属性值标准化成平均数为0,标准差为1后再应用欧几里得距离是适当的方法。 16. a)如果出现在一个文档中,tf’ij=tfij*log(m); 如果出现在每个文档中,tf’ij=0; b)这个标准化反应了如果一个词出现在每一个文档中,那么就不能通过这个词来区分不同的文档,如果这个词出现的很少,那么就可以通过这个词来区分不同的文档。 18. a)x=010******* y=010******* 汉明距离=3; f01=1; f10=2; f11=2; Jaccard相似度=2/(1+2+2)=0.4; b)汉明距离更相似于简单匹配系数,因为简单匹配系数=1—汉明距离/所有位数;Jaccard相似度更相似于余弦度量,因为他们都忽略了0-0匹配。 c)用Jaccard相似度更合适。因为我们想要知道两个个体有多少基因是共享的。 d)用汉明距离更适合。因为两个同物种的基因相同的部分很多,所以如果要比较则更关注于基因不同的部分,因此汉明距离更适合。 现如今,很多人都听说过大数据,这是一个新兴的技术,渐渐地改变了我们的生活,正是由 于这个原因,越来越多的人都开始关注大数据。在这篇文章中我们将会为大家介绍两种大数 据技术,分别是大数据采集技术和大数据预处理技术,有兴趣的小伙伴快快学起来吧。 首先我们给大家介绍一下大数据的采集技术,一般来说,数据是指通过RFID射频数据、传 感器数据、社交网络交互数据及移动互联网数据等方式获得的各种类型的结构化、半结构化 及非结构化的海量数据,是大数据知识服务模型的根本。重点突破高速数据解析、转换与装 载等大数据整合技术设计质量评估模型,开发数据质量技术。当然,还需要突破分布式高速 高可靠数据爬取或采集、高速数据全映像等大数据收集技术。这就是大数据采集的来源。 通常来说,大数据的采集一般分为两种,第一就是大数据智能感知层,在这一层中,主要包 括数据传感体系、网络通信体系、传感适配体系、智能识别体系及软硬件资源接入系统,实 现对结构化、半结构化、非结构化的海量数据的智能化识别、定位、跟踪、接入、传输、信 号转换、监控、初步处理和管理等。必须着重攻克针对大数据源的智能识别、感知、适配、 传输、接入等技术。第二就是基础支撑层。在这一层中提供大数据服务平台所需的虚拟服务器,结构化、半结构化及非结构化数据的数据库及物联网络资源等基础支撑环境。重点攻克 分布式虚拟存储技术,大数据获取、存储、组织、分析和决策操作的可视化接口技术,大数 据的网络传输与压缩技术,大数据隐私保护技术等。 下面我们给大家介绍一下大数据预处理技术。大数据预处理技术就是完成对已接收数据的辨析、抽取、清洗等操作。其中抽取就是因获取的数据可能具有多种结构和类型,数据抽取过 程可以帮助我们将这些复杂的数据转化为单一的或者便于处理的构型,以达到快速分析处理 的目的。而清洗则是由于对于大数并不全是有价值的,有些数据并不是我们所关心的内容, 而另一些数据则是完全错误的干扰项,因此要对数据通过过滤去除噪声从而提取出有效数据。在这篇文章中我们给大家介绍了关于大数据的采集技术和预处理技术,相信大家看了这篇文 章以后已经知道了大数据的相关知识,希望这篇文章能够更好地帮助大家。 第二章数据的处理 数据是数量生态学的基础,我们对数据的类型和特点应该有所了解。在数量分析之前,根据需要对数据进行一些预处理,也是必要的。本章将对数据的性质、特点、数据转化和标准化等做简要介绍。 第一节数据的类型 根据不同的标准,数据可以分成不同的类型。下面我们将介绍数据的基本类型,它是从数学的角度,根据数据的性质来划分的;然后叙述生态学数据,它是根据生态意义而定义的,不同的数据含有不同的生态信息。 一、数据的基本类型 1、名称属性数据 有的属性虽然也可以用数值表示,但是数值只代表属性的不同状态,并不代表其量值,这种数据称为名称属性数据,比如5个土壤类型可以用1、2、3、4、5表示。这类数据在数量分析中各状态的地位是等同的,而且状态之间没有顺序性,根据状态的数目,名称属性数据可分成两类:二元数据和无序多状态数据。 (1)二元数据:是具有两个状态的名称属性数据。如植物种在样方中存在与否,雌、雄同株的植物是雌还是雄,植物具刺与否等等,这种数据往往决定于某种性质的有无,因此也叫定性数据(qualitative data)。对二元数据一般用1和0两个数码表示,1表示某性质的存在,而0表示不存在。 (2)无序多状态数据:是指含有两个以上状态的名称属性数据。比如4个土壤母质的类型,它可以用数字表示为2、1、4、3,同时这种数据不能反映状态之间在量上的差异,只能表明状态不同,或者说类型不同。比如不能说1与4之差在量上是1与2之差的3倍,这种数据在数量分析中用得很少,在分析结果表示上有时使用。 2.顺序性数据 这类数据也是包含多个状态,不同的是各状态有大小顺序,也就是它一定程度上反映量的大小,比如将植物种覆盖度划为5级,1=0~20%,2=21%~40%,3=41%~60%,4=61%~80%,5=81%~100%。这里1~5个状态有顺序性,而且表示盖度的大小关系。比如5级的盖度就是明显大于1级的盖度,但是各级之间的差异又是不等的,比如盖度值分别为80%和81%的两个种,盖度仅差1%,但属于两个等级4和5;而另外两个盖度值分别为41%和60%,相差19%,但属于同一等级。顺序性数据作为数量数据的简化结果在植被研究中有着较广泛的应用,但在数量分析中,这种数据所提供的信息显然不如数量数据。因此,使用并不十分普遍。 3、数量属性数据 E N V I对S A R数据的预处理过程(详细版) 一、数据的导入: (1) 在 Toolbox 中,选择 SARscape ->Basic->Import Data->Standard Formats- >ALOS PALSAR。 (2) 在打开的面板中,数据类型(Data Type):JAXA-FBD Level 1.1。 注:这些信息可以从数据文件名中推导而来。 (3) 单击 Leader/Param file,选择 d1300816-005-ALPSRP246750820-H1.1__A\LED-ALPSRP246750820-H1.1__A文件。 (4) 点击 Data list,选择 d1300816-005-ALPSRP246750820-H1.1__A\IMG-HH-ALPSRP246750820- H1.1__A文件 (4) 单击 Output file,选择输出路径。 注:软件会在输入文件名的基础上增加几个标识字母,如这里增加“_SLC”(5) 单击 Start 执行,最后输出结果是 ENVI 的slc文件,sml格式的元数据文件,hdr格式的头文件等。 (6) 可在 ENVI 中打开导入生成的以slc为后缀的 SAR 图像文件。 二、多视 单视复数(SLC)SAR 图像产品包含很多的斑点噪声,为了得到最高空间分辨率的 SAR图像,SAR 信号处理器使用完整的合成孔径和所有的信号数据。多视处理是在图像的距离向和方位向上的分辨率做了平均,目的是为了抑制 SAR 图像的斑点噪声。多视的图像提高了辐射分辨率,降低了空间分辨率。 (1) 在 Toolbox 中,选择 SARscape->Basic ->Multilooking。 (2) 单击 Input file 按钮,选择一景 SLC 数据(前面导入生成的 ALOS PALSAR 数据)。 注意:文件选择框的文件类型默认是*_slc,就是文件名以_slc 结尾的文件,如不是,可选择*.*。 (3) 设置:方位向视数(Azimuth Looks):5,距离向视数(Range Looks):1 注:详细的计算方法如下所述。另外,单击 Look 按钮可以估算视数。 一、绪论 (一)、1、“数据采集”是指什么? 将温度、压力、流量、位移等模拟量经测量转换电路输出电量后再采集转换成数字量后,再由PC 机进行存储、处理、显示或打印的过程。 2、数据采集系统的组成? 由数据输入通道,数据存储与管理,数据处理,数据输出及显示这五个部分组成。 3、数据采集系统性能的好坏的参数? 取决于它的精度和速度。 4、数据采集系统具有的功能是什么? (1)、数据采集,(2)、信号调理,(3)、二次数据计算,(4)、屏幕显示,(5)、数据存储,(6)、打印输出,(7)、人机联系。 5、数据处理系统的分类? 分为预处理和二次处理两种;即为实时(在线)处理和事后(脱机)处理。 6、集散式控制系统的典型的三级结构? 一种是一般的微型计算机数据采集系统,一种是直接数字控制型计算机数据采集系统,还有一种是集散型数据采集系统。 7、控制网络与数据网络的结合的优点? 实现信号的远程传送与异地远程自动控制。 (二)、问答题: 1、数据采集的任务是什么? 数据采集系统的任务:就是传感器输出信号转换为数字信号,送入工业控制机机处理,得出所需的数据。同时显示、储存或打印,以便实现对某些物理量的监视,还将被生产过程中的PC机控制系统用来控制某些物理量。 2、微型计算机数据采集系统的特点是 (1)、系统结构简单;(2)、微型计算机对环境要求不高;(3)、微型计算机的价格低廉,降低了数据采集系统的成本;(4)、微型计算机数据采集系统可作为集散型数据采集系统的一个基本组成部分;(5)、微型计算机的各种I/O模板及软件齐全,易构成系统,便于使用和维修; 3、简述数据采集系统的基本结构形式,并比较其特点? (1)、一般微型计算机数据采集与处理系统是由传感器、模拟多路开关、程控放大器、采样/保持器、A/D转换器、计算机及外设等部分组成。 (2)、直接数字控制型数据采集与处理系统(DDC)是既可对生产过程中的各个参数进行巡回检测,还可根据检测结果,按照一定的算法,计算出执行器应该的状态(继电器的通断、阀门的位置、电机的转速等),完成自动控制的任务。系统的I/O通道除了AI和DI外,还有模拟量输出(AO)通道和开关量输出(FDO)通道。 (3)、集散式控制系统也称为分布式控制系统,总体思想是分散控制,集中管理,即用几台计算机分别控制若干个回路,再用监督控制计算机进行集中管理。 (三)、分析题: 1、如图所示,分析集散型数据采集与处理系统的组成原理,系统有那些特点? 振动信号的采集与预处理 几乎所有的物理现象都可看作是信号,但这里我们特指动态振动信号。 振动信号采集与一般性模拟信号采集虽有共同之处,但存在的差异更多,因此,在采集振动信号时应注意以下几点: 1. 振动信号采集模式取决于机组当时的工作状态,如稳态、瞬态等; 2. 变转速运行设备的振动信号采集在有条件时应采取同步整周期采集; 3. 所有工作状态下振动信号采集均应符合采样定理。 对信号预处理具有特定要求是振动信号本身的特性所致。信号预处理的功能在一定程度上说是影响后续信号分析的重要因素。预处理方法的选择也要注意以下条件: 1. 在涉及相位计算或显示时尽量不采用抗混滤波; 2. 在计算频谱时采用低通抗混滤波; 3. 在处理瞬态过程中1X矢量、2X矢量的快速处理时采用矢量滤波。 上述第3条是保障瞬态过程符合采样定理的基本条件。在瞬态振动信号采集时,机组转速变化率较高,若依靠采集动态信号(一般需要若干周期)通过后处理获得1X和2X矢量数据,除了效率低下以外,计算机(服务器)资源利用率也不高,且无法做到高分辨分析数据。机组瞬态特征(以波德图、极坐标图和三维频谱图等型式表示)是固有的,当组成这些图谱的数据间隔过大(分辨率过低)时,除许多微小的变化无法表达出来,也会得出误差很大的分析结论,影响故障诊断的准确度。一般来说,三维频谱图要求数据的组数(△rpm分辨率)较少,太多了反而影响对图形的正确识别;但对前面两种分析图谱,则要求较高的分辨率。目前公认的方式是每采集10组静态数据采集1组动态数据,可很好地解决不同图谱对数据分辨率的要求差异。 影响振动信号采集精度的因素包括采集方式、采样频率、量化精度三个因素,采样方式不同,采集信号的精度不同,其中以同步整周期采集为最佳方式;采样频率受制于信号最高频率;量化精度取决于A/D转换的位数,一般采用12位,部分系统采用16位甚至24位。 振动信号的采样过程,严格来说应包含几个方面: 1. 信号适调 由于目前采用的数据采集系统是一种数字化系统,所采用的A/D芯片对信号输入量程有严格限制,为了保证信号转换具有较高的信噪比,信号进入A/D以前,均需进行信号适调。适调包括大信号的衰减处理和弱信号的放大处理,或者对一些直流信号进行偏置处理,使其满足A/D输入量程要求。 2. A/D转换 数据采集和数据预处理 3.2.1 数据采集 数据采集功能主要用于实现对DSM分析研究中所需的电力供需、相关政策法规等原始数据、信息的多种途径采集。数据采集为使用者提供定时数据采集、随机采集、终端主动上报数据等多种数据采集模式,支持手工输入、电子表格自动导入等多种导入方式,且能够对所采集的数据进行维护,包括添加、修改、删除等,并能进行自动定期备份。在需求侧管理专业化采集中,` 采集的数据根据结构特点,可以分为结构化数据和非结构化数据,其中,结构化数据包括生产报表、经营报表等具有关系特征的数据;非结构化数据,主要包括互联网网页( HTML)、格式文档( Word、PDF)、文本文件(Text)等文字性资料。这些数据目前可以通过关系数据库和专用的数据挖掘软件进行挖掘采集。特别是非结构化数据,如DSM相关的经济动态、政策法规、行业动态、企业动态等信息对DSM分析研究十分重要,综合运用定点采集、元搜索、主题搜索等搜索技术,对互联网和企业内网等数据源中符合要求的信息资料进行搜集,保证有价值信息发现和提供的及时性和有效性。DSM信息数据采集系统中数据采集类型如图2所示。在数据采集模块中,针对不同的数据源,设计针对性的采集模块,分别进行采集工作,主要有网络信息采集模块、关系数据库信息采集模块、文件系统资源采集模块和其他信息源数据的采集模块。 (1)网络信息采集模块。网络信息采集模块的主要功能是实时监控和采集目标网站的内容,对采集到的信息进行过滤和自动分类处理,对目标网站的信息进行实时监控,并把最新的网页及时采集到本地,形成目标站点网页的全部信息集合,完整记录每个网页的详细信息,包括网页名称、大小、日期、标题、文字内容及网页中的图片和表格信息等。 (2)关系数据库采集模块。该模块可以实现搜索引擎数据库与关系型数据库(包括Oracle、Sybase、DB2、SQL Server、MySQL等)之间的数据迁移、数据共享以及两者之间的双向数据迁移。可按照预设任务进行自动化的信息采集处理。 ( 3)文件系统资源采集模块。该模块可以实现对文件系统中各种文件资源(包括网页、XML文件、电子邮件、Office文件、PDF文件、图片、音视频多媒体文件、图表、公文、研究报告等)进行批量处理和信息抽取。 ( 4)其他信息源数据的采集。根据数据源接入方式,利用相应的采集工具进行信息获取、过滤等。 3.2.2 数据预处理 数据预处理的本质属于数据的“深度采集”,是信息数据的智能分析处理。利用网页内容分析、自动分类、自动聚类、自动排重、自动摘要/主题词抽取等智能化处理技术,对采集到的海量数据信息进行挖掘整合,最终按照统一规范的组织形式存储到DSM数据仓库,供图1 系统体系结构分析研究使用。数据预处理的工作质量很大程度上决定最终服务数据的质量,是DSM类项目(如,DSM项目全过程管理、有序用电方案评价等)深度分析的重要基础。在数据智能分析处理中,主要包括:1)自动分类,用于对采集内容的自动分类;2)自动摘要,用于对采集内容的自动摘要;3)自动排重,用于对采集内容的重复性判定。 ************************************** 电力数据采集与传输是电力系统分析和处理的一个重要环节。从采集被测点的各种信息,如母线电压,线路电压、电流、有功、无功,变压器的分接头位置,线路上的断路器、隔离开关及其它设备状态、报警、总有功功率、事件顺序等,对电力系统运行管理具有重要作用[ 1]。********************************** 电力信息的数据采集与集成 电力作为传统[业,其下属分系统众多,因而数据的种类也相当繁杂。数据类型包括工程 一、数据的导入: (1) 在Toolbox 中,选择SARscape ->Basic->Import Data->Standard Formats->ALOS PALSAR。 (2) 在打开的面板中,数据类型(Data Type):JAXA-FBD Level 1.1。 注:这些信息可以从数据文件名中推导而来。 (3) 单击Leader/Param file,选择 d1300816-005-ALPSRP246750820-H1.1__A\LED-ALPSRP246750820-H1.1__A文件。 (4) 点击Data list,选择 d1300816-005-ALPSRP246750820-H1.1__A\IMG-HH-ALPSRP246750820-H1.1__A文件 (4) 单击Output file,选择输出路径。 注:软件会在输入文件名的基础上增加几个标识字母,如这里增加“_SLC” (5) 单击Start 执行,最后输出结果是ENVI 的slc文件,sml格式的元数据文件,hdr格式的头文件等。 (6) 可在ENVI 中打开导入生成的以slc为后缀的SAR 图像文件。 二、多视 单视复数(SLC)SAR 图像产品包含很多的斑点噪声,为了得到最高空间分辨率的SAR图像,SAR 信号处理器使用完整的合成孔径和所有的信号数据。多视处理是在图像的距离向和方位向上的分辨率做了平均,目的是为了抑制SAR 图像的斑点噪声。多视的图像提高了辐射分辨率,降低了空间分辨率。 (1) 在Toolbox 中,选择SARscape->Basic ->Multilooking。 (2) 单击Input file 按钮,选择一景SLC 数据(前面导入生成的ALOS PALSAR 数据)。 注意:文件选择框的文件类型默认是*_slc,就是文件名以_slc 结尾的文件,如不是,可选择*.*。 (3) 设置:方位向视数(Azimuth Looks):5,距离向视数(Range Looks):1 注:详细的计算方法如下所述。另外,单击Look 按钮可以估算视数。 (4) Border Resize 选项,选择此项,会对检测结果边缘中的无效值,进而重新计算输出图像的大小。这里不选择。 (5) 输出路径会依据软件默认参数设置自动添加或自行修改,单击Start 按钮执行。 (6) 计算完之后在Display 中显示结果,可以看到图像的斑点噪声得到的抑制,但是降低了空间分辨率 数据导入和预处理系统设计与实现 传统数据仓库随着Hadoop技术的发展受到巨大挑战,Hadoop从最初解决海量数据的存储难题,到现在被越来越多的企业用来解决大数据处理问题,其应用广泛性越来越高。本文主要研究基于Hadoop系统对传统数据库数据和文本数据进行迁移,帮助传统数据仓库解决在大数据存储处理等方面遇到的难题,同时依靠Hadoop的扩展性提升数据存储和处理的性能。论文中系统根据现今传统数据仓库的应用情况及Hadoop大数据平台的前景预测,针对传统数据仓库已无法满足用户需求的问题,设计出传统数据仓库与基于Hadoop的hdfs文件系统协作进行数据存储与处理的架构,同时解决企业用户数据控制权限的要求。系统分为四个部分,数据管理、数据预处理、系统管理和发布管理提供从数据导入到数据控制,数据预处理最终实现数据发布共享的功能。 系统的主要功能是采集数据和对采集到的数据进行预处理,系统设计成能够对多种类型的数据进行采集和预处理,同时系统能够实现很好的扩展功能,为系统中增加机器学习算法节点对数据进一步挖掘处理提供了可能。系统采用当下流行的Hadoop基本架构,同时结合Haddoop生态圈中的数据仓库Hive和数据迁移工具Sqoop进行数据的迁移和处理。在一定程度上能够满足企业的基本需求。系统以Web系统的方式实现,方便用户使用,在实现Web系统时采用成熟的ssm框架进行开发,保证系统的稳定性。 系统从企业的实际需求出发,同时充分考虑传统数据库在企业中的应用,设计实现基于Hadoop的数据管理平台原型,为企业提供实际应用指导。本论文从系统实现的背景、系统系统需求、系统设计、系统实现以及系统测试五大模块对系统进行了全面详细的论述,全面阐述了系统实现的意义,有一定的实际应用指导意义。 重庆交通大学信息科学与工程学院 实验报告 班级:曙光1701班 姓名学号: 实验项目名称:数据导入与预处理实验一 实验项目性质:验证性、设计性 实验所属课程:《数据导入与预处理》实验室(中心):语音楼八楼 指导教师: 实验完成时间: 2019 年 11 月 1 日 一.实验目的 1.了解和掌握数据库的恢复,数据库数据的变换,数据的统计以及可视化;掌握Json数据集的API下载方法,数据提取,以及导入其他数据结构的方法。 2.了解和掌握不同数据格式之间的转换方法;掌握用计算机编程语言实现数据的格式转换以及数据信息的提取。 二.实验要求 1.安装Mysql数据库,以及mysql workbench客户端, 2.下载对公众开放的安然(Enron)公司的电子邮件数据集。 下载地址: 3.在mysql中恢复Enron数据库。 4.数据统计每一天和每一周发邮件的数量,并用可视化软件实现可视化。 5.采用iTunes API做个小实验,利用关键词来生成JSON数据结果集。iTunes是由Apple公司提供的一个音乐服务,任何人都可以利用iTunes服务来查找歌曲、艺术家和专辑。在查找的时候需要把搜索关键词添加到iTunes API URL的后面。URL中,=后面的是搜索关键词,是一个乐队的名字,the Growlers。注意:URL中用+代替空格字符,URL不允许包含空格字符。 iTunes API 会根据提供的关键词从音乐库中返回50个结果。整个结果集形成一个JSON文件,每一条音乐信息中的元素,以名字-值的格式存放在JSON文件中。 The Growlers Apple iTunes的开发文档: 6.使用一种熟悉的语言,编写程序,将下载下来的the Growlers的所有音乐的歌名提取出来,并可视化显示。 三、需求分析 1.提取出安然公司数据集中的每天的阅读量和每周的阅读量,并画出趋势图 2.提取出iTunes中的trackname数据 四、实验过程 1.安装好Mysql和Mysql Workbench 004-振动信号的采集与预处理 振动信号的采集与预处理 1振动信号的采集 振动信号采集与一般性模拟信号采集虽有共同之处,但存在的差异更多。在采集振动信号时应注意以下几点: 1.振动信号采集模式取决于机组当时的工作状态,如稳态、瞬态等; 2.变转速运行设备的振动信号采集在有条件时应采取同步整周期采集; 3.所有工作状态下振动信号采集均应符合采样定理。 1.1 信号适调 由于目前采用的数据采集系统是一种数字化系统,所采用的A/D芯片对信号输入量程有严格限制,为了保证信号转换具有较高的信噪比,信号进入A/D以前,均需进行信号适调。适调包括大信号的衰减处理和弱信号的放大处理,或者对一些直流信号进行偏置处理,使其满足A/D输入量程要求。 1.2 A/D转换 A/D转换包括采样、量化和编码三个组成部分。 1.2.1采样 采样(抽样),是利用采样脉冲序列p(t)从模拟信号x(t)中抽取一系列离散样值,使之成为采样信号x(n△t)(n=0,1,2,…)的过程。△t称为采样间隔,其倒数称1/△t=f s之为采样频率。采样频率的选择必须符合采样定理要求。 1.2.2量化 由于计算机对数据位数进行了规定,采样信号x(n△t)经舍入的方法变为只有有限个有效数 字的数,这个过程称为量化。由于抽样间隔长度是固定的(对当前数据来说),当采样信号落入某一小间隔内,经舍入方法而变为有限值时,则 产生量化误差。如8位二进制为28 =256,即量化增量为所测信号最大电压幅值的1/256。 1.2.3 编码 振动信号经过采样和量化后,量化后的数据按照一定的协议进行编码,成为处理器可以处理的数据。 采样定理解决的问题是确定合理的采样间隔△t 以及合理的采样长度T ,保障采样所得的数字信号能真实地代表原来的连续信号x(t)。 衡量采样速度高低的指标称为采样频率f s 。一般来说,采样频率f s 越高,采样点越密,所获得的数字信号越逼近原信号。为了兼顾计算机存储量和计算工作量,一般保证信号不丢失或歪曲原信号信息就可以满足实际需要了。这个基本要求就是所谓的采样定理,是由Shannon 提出的,也称为Shannon 采样定理。 Shannon 采样定理规定了带限信号不丢失信息的最低采样频率为: 2s m f f ≥或2s m ωω≥ 式中f m 为原信号中最高频率成分的频率。 采集的数据量大小N 为: T N t =? 因此,当采样长度一定时,采样频率越高,采集的数据量就越大。 使用采样频率时有几个问题需要注意。 一, 正确估计原信号中最高频率成分的频率,对于采用电涡流传感器测振的系统来说,一数据采集与处理讲解

数据挖掘 主题:第六章作业

数据挖掘离线作业

《数据采集与预处理》教学教案—11用OpenRefine进行数据预处理

大数据挖掘第二次作业

数据采集与预处理-课程标准_教学大纲

Microsoft Word - 第二章 数据预处理

数据采集与处理技术

数据挖掘第二章作业

大数据采集技术和预处理技术

数量生态学(第二版)第2章 数据处理

ENVI对SAR数据的预处理过程(详细版)资料

大数据采集与处理技术考试卷

振动信号的采集与预处理

数据采集和数据预处理

ENVI对SAR大数据地预处理过程(详细版)

数据导入和预处理系统设计与实现

数据预处理实验1

004-振动信号的采集与预处理