GMM-UBM

一 GMM-UBM(MAP-GMM)说话人所识别系统

1 UBM(Universal Background Model)

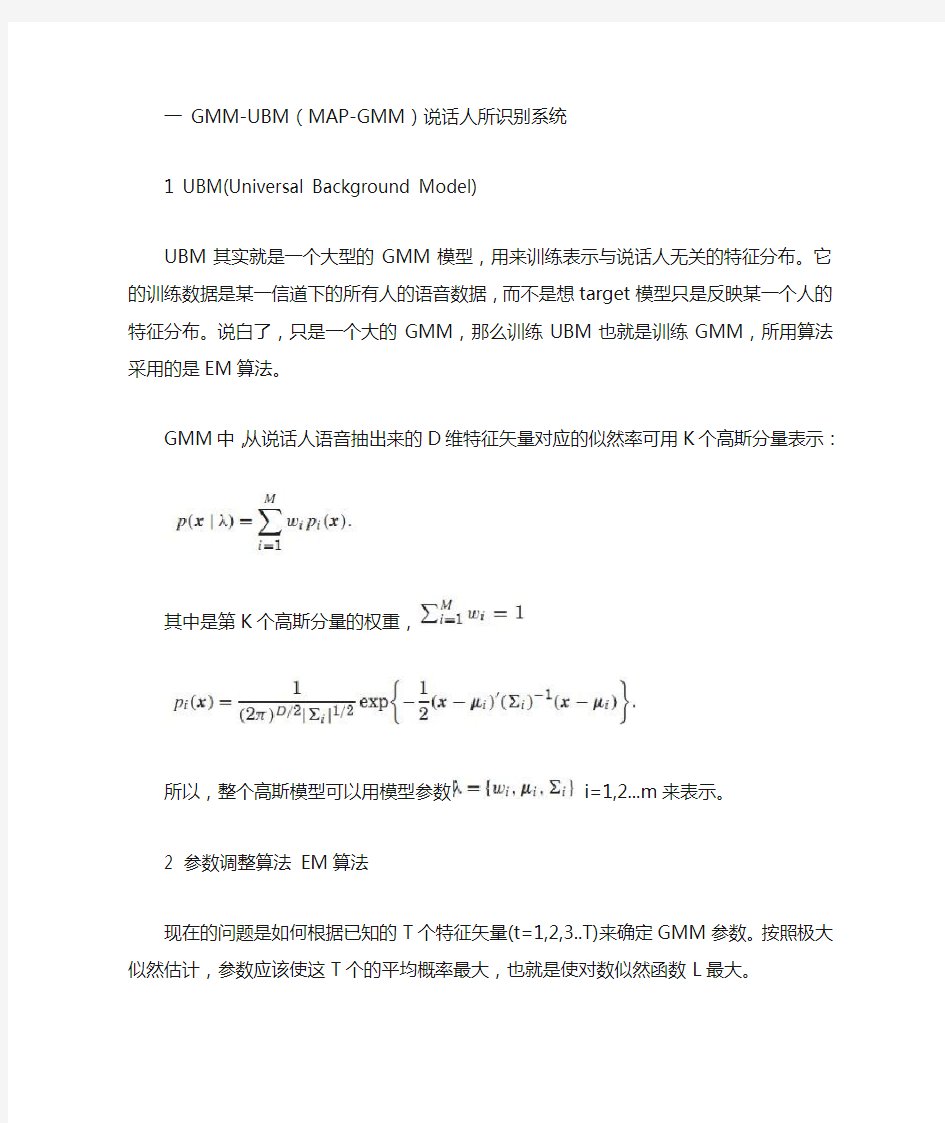

UBM其实就是一个大型的GMM模型,用来训练表示与说话人无关的特征分布。它的训练数据是某一信道下的所有人的语音数据,而不是想target模型只是反映某一个人的特征分布。说白了,只是一个大的GMM,那么训练UBM也就是训练GMM,所用算法采用的是EM算法。 GMM中,从说话人语音抽出来的D维特征矢量对应的似然率可用K 个高斯分量表示:

其中是第K个高斯分量的权重,

所以,整个高斯模型可以用模型参数 i=1,2...m来表示。

2 参数调整算法 EM算法

现在的问题是如何根据已知的T个特征矢量(t=1,2,3..T)来确定GMM参数。按照极大似然估计,参数应该使这T个的平均概率最大,也就是使对数似然函数L最大。

GMM参数的估计基于最大似然准则ML,通过EM迭代算法来实现,这时可以得到GMM模型中权重,均值,方差的迭代公式:

其中,p(i|Xj,θ)是第i个混合分量的后验概率

模型初值的设定通常使用K-means算法。

3 说话人模型的自适应

基本思想是,从训练后的UBM模型参数通过自适应来更新其参数进而导出目标说话人的GMM模型。

这种自适应算法分为两步:第一步,与EM算法的E-Step一样,对

UBM的每个混合成分计算目标说话人训练语音的充分统计的估计;第二部与EM算法不同,这些新的充分估计与老的充分估计用一个语料相关的混合系数结合起来。具体计算方法:

第一步:

给定GMM模型和目标说话人的训练矢量(t=1,2,3..T),首先算出训练矢量在UBM 混合成员中的概率分布。即对第i个混合成员:

然后利用Pr(i|)和混合加权值,平均值向量,方差进行从分统计:

这里与EM算法中的E-Step一样。

最后,这些由训练数据产生的新的充分统计量用来更新UBM的第i个混合成员的充分统计量:

其中,是自适应系数,用来控制新的和老的估计量之间的平衡,分别控制权重,均值,方差。

自适应系数定义为

是一个固定参数的因子。通常,只有平均均值向量做自适应的时候会得到最

好的识别率,因此,我们只对话着模型中每个高斯分布的平均值向量做自适应,自适应公式:

其中,a是经验值。

二测试:对数似然比(LLR)

测试特征矢量序列X的对数似然比可用下式来计算:

因为目标说话人模型是从UBM 模型自适应得来的,所以,对数似然比可以用快速的方法来计算。该方法基于两个事实,第一,当一个大型的GMM对一个特征矢量进行测评时,只有少数的混合成员对最终的似然值有贡献。这样似然值可以用前C个最佳混合成员的得分来近似;第二个方面是自适应后的GMM仍然保留了与UBM 相对应的混合成员。在实际计算中C通常取5或10 。

参考文献:Speaker Veri?cation Using Adapted Gaussian Mixture Models