Hadoop 100道面试题及答案解析

3.6

误)

3.7Hadoop支持数据的随机读写。(错) (8)

NameNode负责管理metadata,client端每次读写请求,它都会从磁盘中3.8

读取或则会写入metadata信息并反馈client端。(错误) (8)

NameNode本地磁盘保存了Block的位置信息。(个人认为正确,欢迎提出其它意见) (9)

3.9

3.10 3.11DataNode通过长连接与NameNode保持通信。(有分歧) (9)

Hadoop自身具有严格的权限管理和安全措施保障集群正常运行。(错误)9

3.12 3.13 3.14Slave节点要存储数据,所以它的磁盘越大越好。(错误) (9)

hadoop dfsadmin–report命令用于检测HDFS损坏块。(错误) (9)

Hadoop默认调度器策略为FIFO(正确) (9)

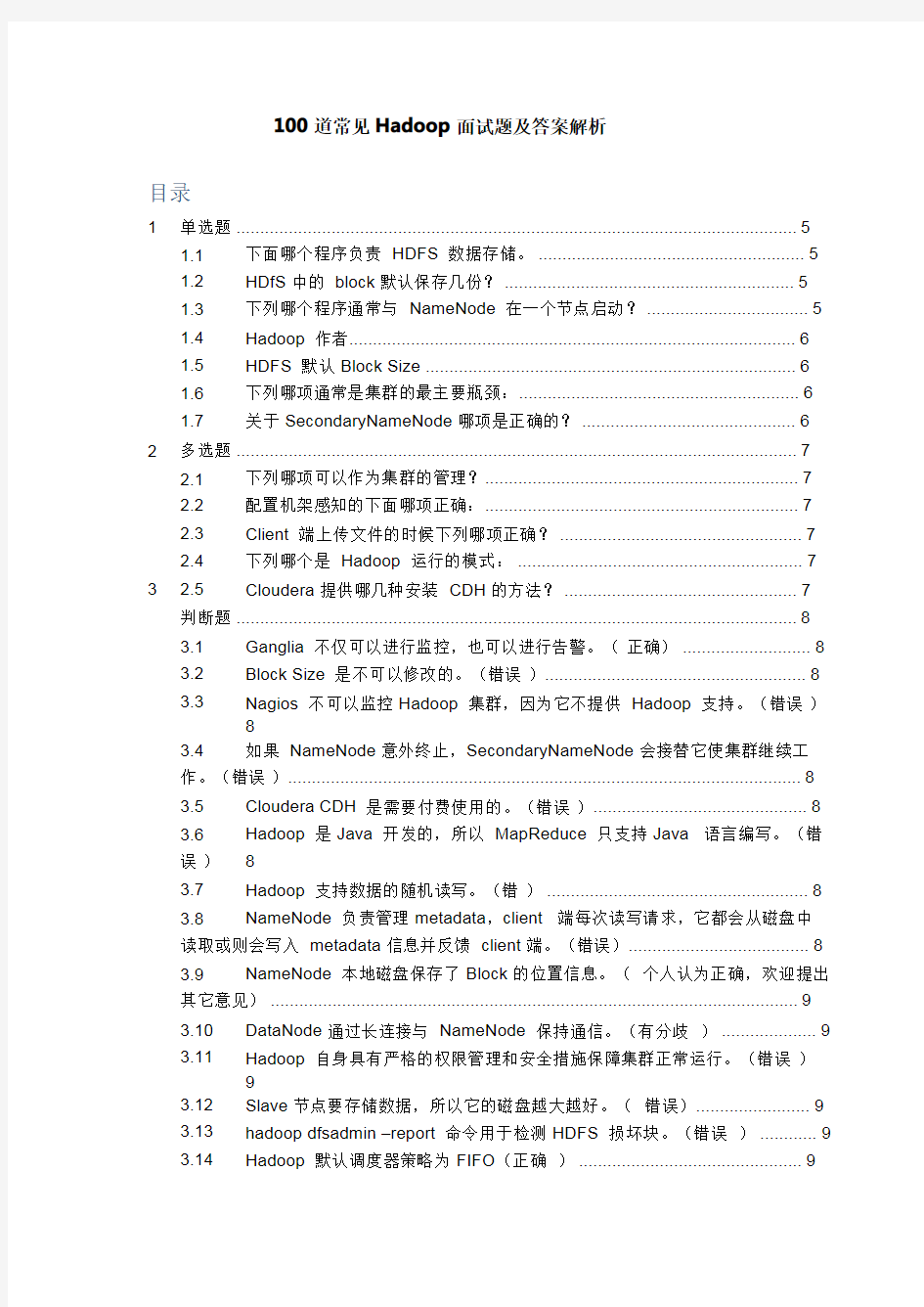

100道常见Hadoop面试题及答案解析

目录

1单选题 (5)

1.1 1.2 1.3 1.4 1.5 1.6 1.7下面哪个程序负责HDFS数据存储。 (5)

HDfS中的block默认保存几份? (5)

下列哪个程序通常与NameNode在一个节点启动? (5)

Hadoop作者 (6)

HDFS默认Block Size (6)

下列哪项通常是集群的最主要瓶颈: (6)

关于SecondaryNameNode哪项是正确的? (6)

2 3多选题 (7)

2.1

2.2

2.3

2.4

2.5

下列哪项可以作为集群的管理? (7)

配置机架感知的下面哪项正确: (7)

Client端上传文件的时候下列哪项正确? (7)

下列哪个是Hadoop运行的模式: (7)

Cloudera提供哪几种安装CDH的方法? (7)

判断题 (8)

3.1

3.2

3.3

Ganglia不仅可以进行监控,也可以进行告警。(正确) (8)

Block Size是不可以修改的。(错误) (8)

Nagios不可以监控Hadoop集群,因为它不提供Hadoop支持。(错误)

8

3.4如果NameNode意外终止,SecondaryNameNode会接替它使集群继续工作。(错误) (8)

3.5Cloudera CDH是需要付费使用的。(错误) (8)

Hadoop是Java开发的,所以MapReduce只支持Java语言编写。(错

8

3.15

集群内每个节点都应该配RAID ,这样避免单磁盘损坏,影响整个节点运行。(错误).................................................................................................................93.16

因为HDFS 有多个副本,所以NameNode 是不存在单点问题的。(错误)93.17

3.18

3.19

误)

3.20

每个map 槽就是一个线程。(错误).......................................................9Mapreduce 的input split 就是一个block 。(错误)..............................10NameNode 的Web UI 端口是50030,它通过jetty 启动的Web 服务。(错10Hadoop 环境变量中的HADOOP_HEAPSIZE 用于设置所有Hadoop 守护线程的内存。它默认是200GB 。(错误).............................................................10DataNode 首次加入cluster 的时候,如果log 中报告不兼容文件版本,那3.21

需要NameNode 执行“Hadoop namenode -format”操作格式化磁盘。(错误)......10问答题(一). (10)

4 4.1

Hadoop 集群可以运行的3个模式?........................................................10单机(本地)模式中的注意点?................................................................10伪分布模式中的注意点?..........................................................................10VM 是否可以称为Pseudo ?....................................................................10全分布模式又有什么注意点?...................................................................10Hadoop 是否遵循UNIX 模式?...............................................................11Hadoop 安装在什么目录下?...................................................................11Namenode 、Jobtracker 和tasktracker 的端口号是?............................11Hadoop 的核心配置是什么?...................................................................11那当下又该如何配置?..............................................................................11RAM 的溢出因子是?...............................................................................11fs.mapr.working.dir 只是单一的目录?....................................................11hdfs-site.xml 的3个主要属性?..............................................................11如何退出输入模式?.................................................................................11当你输入hadoopfsck/造成“connectionrefusedjavaexception’”时,系4.2

4.3

4.4

4.5

4.6

4.7

4.8

4.9

4.10

4.11

4.12

4.13

4.14

4.15

统究竟发生了什么?...............................................................................................11我们使用Ubuntu 及Cloudera ,那么我们该去哪里下载Hadoop ,或者是默认就与Ubuntu 一起安装? (11)

4.16

4.17

4.18

4.19

4.20

4.21

4.22

4.23

4.24“jps”命令的用处?................................................................................11如何重启Namenode ?............................................................................11Fsck 的全名?...........................................................................................12如何检查Namenode 是否正常运行?......................................................12mapred.job.tracker 命令的作用?...........................................................12/etc/init.d 命令的作用是?.......................................................................12如何在浏览器中查找Namenode ?..........................................................12如何从SU 转到Cloudera ? (12)

4.25 4.26 4.27 4.28 4.29 4.30 4.31 4.32 4.33 4.34 4.35 4.36 4.37 4.38 4.39 4.40 4.41 4.42 4.43 4.44 4.45启动和关闭命令会用到哪些文件? (12)

Slaves由什么组成? (12)

Masters由什么组成? (12)

hadoop-env.sh是用于做什么的? (12)

Master文件是否提供了多个入口? (12)

hadoop-env.sh文件当下的位置? (12)

在Hadoop_PID_DIR中,PID代表了什么? (12)

/var/hadoop/pids用于做什么? (12)

hadoop-metrics.properties文件的作用是? (12)

Hadoop需求什么样的网络? (13)

全分布式环境下为什么需求password-lessSSH? (13)

这会导致安全问题吗? (13)

SSH工作的端口号是? (13)

SSH中的注意点还包括? (13)

为什么SSH本地主机需要密码? (13)

如果在SSH中添加key,是否还需要设置密码? (13)

假如Namenode中没有数据会怎么样? (13)

当JobTracker宕掉时,Namenode会发生什么? (13)

是客户端还是Namenode决定输入的分片? (13)

是否可以自行搭建Hadoop集群? (13)

是否可以在Windows上运行Hadoop? (13)

5问答题(二) (13)

5.1 5.2 5.3 5.4 5.5 5.6 5.7 5.8 5.9写出以下执行命令 (13)

简述一下hdfs的数据压缩算法,工作中用的是那种算法,为什么? (14)

三个datanode,当有一个datanode出现错误会怎样? (14)

hdfs原理,以及各个模块的职责? (14)

哪个进程通常与namenode在一个节点启动?并做分析 (16)

hdfs的体系结构? (16)

HDFS,replica如何定位 (17)

HDFS存储的机制? (17)

hdfs的client端,复制到第三个副本时宕机,hdfs怎么恢复保证下次写第三

副本?18

5.10 5.11 5.12 5.13 5.14 5.15block块信息是先写dataNode还是先写nameNode? (18)

Hive的join有几种方式,怎么实现join的? (18)

hive内部表和外部表的区别? (19)

hive是如何实现分区的? (19)

hive支持not in吗? (19)

Hive有哪些方式保存元数据,各有哪些优缺点。 (19)

5.16 5.17 5.18 5.19 5.20hive如何优化 (19)

hive能像关系数据库那样,建多个库吗? (19)

hive中的压缩格式RCFile、TextFile、SequenceFile各有什么区别?.19 hive相对于Oracle来说有那些优点? (20)

Hive的sort by和order by的区别 (20)

1单选题

1.1下面哪个程序负责HDFS数据存储。

a)NameNode

b)Jobtracker

c)Datanode

d)secondaryNameNode

e)tasktracker

答案C datanode

1.2HDfS中的block默认保存几份?

a)3份

b)2份

c)1份

d)不确定

答案A默认3分

1.3下列哪个程序通常与NameNode在一个节点启动?

a)SecondaryNameNode

b)DataNode

c)TaskTracker

d)Jobtracker

答案D,此题分析:

hadoop的集群是基于master/slave模式,namenode和jobtracker属于master,datanode和tasktracker属于slave,master只有一个,而slave有多个SecondaryNameNode内存需求和NameNode在一个数量级上,所以通常secondary NameNode(运行在单独的物理机器上)和NameNode运行在不同的机器上。JobTracker和TaskTracker

JobTracker对应于NameNode

TaskTracker对应于DataNode

DataNode和NameNode是针对数据存放来而言的

JobTracker和TaskTracker是对于MapReduce执行而言的

mapreduce中几个主要概念,mapreduce整体上可以分为这么几条执行线索:obclient,JobTracker与TaskTracker。

1、JobClient会在用户端通过JobClient类将应用已经配置参数打包成jar文件存储到hdfs,并把路径提交到Jobtracker,然后由JobTracker创建每一个Task(即MapTask和

ReduceTask)并将它们分发到各个TaskTracker服务中去执行。

2、JobTracker是一个master服务,软件启动之后JobTracker接收Job,负责调度Job

的每一个子任务task运行于TaskTracker上,并监控它们,如果发现有失败的task就重新

运行它。一般情况应该把JobTracker部署在单独的机器上。

3、TaskTracker是运行在多个节点上的slaver服务。TaskTracker主动与JobTracker通信,接收作业,并负责直接执行每一个任务。TaskTracker都需要运行在HDFS的DataNode 上。

1.4Hadoop作者

a)Martin Fowler

b)Kent Beck

c)Doug cutting

答案C Doug cutting

1.5HDFS默认Block Size

a)32MB

b)64MB

c)128MB

答案:B

(因为版本更换较快,这里答案只供参考)

1.6下列哪项通常是集群的最主要瓶颈:

a)CPU

b)网络

c)磁盘IO

d)内存

答案:C磁盘

该题解析:

首先集群的目的是为了节省成本,用廉价的pc机,取代小型机及大型机。小型机和大型机

有什么特点?

1.cpu处理能力强

2.内存够大

所以集群的瓶颈不可能是a和d

3.网络是一种稀缺资源,但是并不是瓶颈。

4.由于大数据面临海量数据,读写数据都需要io,然后还要冗余数据,hadoop一般备3

份数据,所以IO就会打折扣。

1.7关于SecondaryNameNode哪项是正确的?

a)它是NameNode的热备

b)它对内存没有要求

c)它的目的是帮助NameNode合并编辑日志,减少NameNode启动时间

d)SecondaryNameNode应与NameNode部署到一个节点。

答案C

2多选题

2.1下列哪项可以作为集群的管理?

a)Puppet

b)Pdsh

c)Cloudera Manager

d)Zookeeper

答案:ABD

2.2配置机架感知的下面哪项正确:

a)如果一个机架出问题,不会影响数据读写

b)写入数据的时候会写到不同机架的DataNode中

c)MapReduce会根据机架获取离自己比较近的网络数据

答案ABC

2.3Client端上传文件的时候下列哪项正确?

a)数据经过NameNode传递给DataNode

b)Client端将文件切分为Block,依次上传

c)Client只上传数据到一台DataNode,然后由NameNode负责Block复制工作

答案B,该题分析:

Client向NameNode发起文件写入的请求。

NameNode根据文件大小和文件块配置情况,返回给Client它所管理部分DataNode的信息。

Client将文件划分为多个Block,根据DataNode的地址信息,按顺序写入到每一个DataNode块中。

2.4下列哪个是Hadoop运行的模式:

a)单机版

b)伪分布式

c)分布式

答案ABC

2.5Cloudera提供哪几种安装CDH的方法?

a)Cloudera manager

b)Tarball

c)Yum

d)Rpm

答案:ABCD

3判断题

3.1Ganglia不仅可以进行监控,也可以进行告警。(正确)

分析:此题的目的是考Ganglia的了解。严格意义上来讲是正确。ganglia作为一款最常用的Linux环境中的监控软件,它擅长的的是从节点中按照用户的需求以较低的代价采集数据。但是ganglia在预警以及发生事件后通知用户上并不擅长。最新的ganglia已经有了部分

这方面的功能。但是更擅长做警告的还有Nagios。Nagios,就是一款精于预警、通知的软件。通过将Ganglia和Nagios组合起来,把Ganglia采集的数据作为Nagios的数据源,

然后利用Nagios来发送预警通知,可以完美的实现一整套监控管理的系统。

3.2Block Size是不可以修改的。(错误)

分析:它是可以被修改的Hadoop的基础配置文件是hadoop-default.xml,默认建立一

个Job的时候会建立Job的Config,Config首先读入hadoop-default.xml的配置,然

后再读入hadoop-site.xml的配置(这个文件初始的时候配置为空),hadoop-site.xml中主要配置需要覆盖的hadoop-default.xml的系统级配置。

3.3Nagios不可以监控Hadoop集群,因为它不提供Hadoop支持。(错误)

分析:Nagios是集群监控工具,而且是云计算三大利器之一

3.4如果NameNode意外终止,SecondaryNameNode会接替它使集群继续工作。

(错误)

分析:SecondaryNameNode是帮助恢复,而不是替代,如何恢复,可以查看

3.5Cloudera CDH是需要付费使用的。(错误)

分析:第一套付费产品是Cloudera Enterpris,Cloudera Enterprise在美国加州举行的Hadoop大会(Hadoop Summit)上公开,以若干私有管理、监控、运作工具加强Hadoop的功能。收费采取合约订购方式,价格随用的Hadoop叢集大小变动。

3.6Hadoop是Java开发的,所以MapReduce只支持Java语言编写。(错误)

分析:rhadoop是用R语言开发的,MapReduce是一个框架,可以理解是一种思想,可

以使用其他语言开发。

3.7Hadoop支持数据的随机读写。(错)

分析:lucene是支持随机读写的,而hdfs只支持随机读。但是HBase可以来补救。HBase

提供随机读写,来解决Hadoop不能处理的问题。HBase自底层设计开始即聚焦于各种可

伸缩性问题:表可以很“高”,有数十亿个数据行;也可以很“宽”,有数百万个列;水平

分区并在上千个普通商用机节点上自动复制。表的模式是物理存储的直接反映,使系统有可

能提高高效的数据结构的序列化、存储和检索。

3.8NameNode负责管理metadata,client端每次读写请求,它都会从磁盘中读

取或则会写入metadata信息并反馈client端。(错误)

此题分析:

NameNode不需要从磁盘读取metadata,所有数据都在内存中,硬盘上的只是序列化

的结果,只有每次namenode启动的时候才会读取。

1)文件写入

Client向NameNode发起文件写入的请求。

NameNode根据文件大小和文件块配置情况,返回给Client它所管理部分DataNode的

信息。

Client将文件划分为多个Block,根据DataNode的地址信息,按顺序写入到每一个DataNode块中。

2)文件读取

Client向NameNode发起文件读取的请求。

3.9NameNode本地磁盘保存了Block的位置信息。(个人认为正确,欢迎提出其

它意见)

分析:DataNode是文件存储的基本单元,它将Block存储在本地文件系统中,保存了Block 的Meta-data,同时周期性地将所有存在的Block信息发送给NameNode。NameNode

返回文件存储的DataNode的信息。

Client读取文件信息。

3.10DataNode通过长连接与NameNode保持通信。(有分歧)

这个有分歧:具体正在找这方面的有利资料。下面提供资料可参考。

首先明确一下概念:

(1).长连接

Client方与Server方先建立通讯连接,连接建立后不断开,然后再进行报文发送和接收。

这种方式下由于通讯连接一直存在,此种方式常用于点对点通讯。

(2).短连接

Client方与Server每进行一次报文收发交易时才进行通讯连接,交易完毕后立即断开连接。此种方式常用于一点对多点通讯,比如多个Client连接一个Server.

3.11Hadoop自身具有严格的权限管理和安全措施保障集群正常运行。(错误)hadoop只能阻止好人犯错,但是不能阻止坏人干坏事

3.12Slave节点要存储数据,所以它的磁盘越大越好。(错误)

分析:一旦Slave节点宕机,数据恢复是一个难题

3.13hadoop dfsadmin–report命令用于检测HDFS损坏块。(错误)

3.14Hadoop默认调度器策略为FIFO(正确)

3.15集群内每个节点都应该配RAID,这样避免单磁盘损坏,影响整个节点运行。(错

误)

分析:首先明白什么是RAID,可以参考百科磁盘阵列。这句话错误的地方在于太绝对,具

体情况具体分析。题目不是重点,知识才是最重要的。因为hadoop本身就具有冗余能力,所以如果不是很严格不需要都配备RAID。具体参考第二题。

3.16因为HDFS有多个副本,所以NameNode是不存在单点问题的。(错误)

3.17每个map槽就是一个线程。(错误)

分析:首先我们知道什么是map槽,map槽->map slotmap slot只是一个逻辑值(org.apache.hadoop.mapred.TaskTracker.TaskLauncher.numFreeSlots),而不是对应

着一个线程或者进程

3.18Mapreduce的input split就是一个block。(错误)

3.19NameNode的Web UI端口是50030,它通过jetty启动的Web服务。(错

误)

3.20Hadoop环境变量中的HADOOP_HEAPSIZE用于设置所有Hadoop守护线

程的内存。它默认是200GB。(错误)

hadoop为各个守护进程

(namenode,secondarynamenode,jobtracker,datanode,tasktracker)统一分配的内存

在hadoop-env.sh中设置,参数为HADOOP_HEAPSIZE,默认为1000M。

3.21DataNode首次加入cluster的时候,如果log中报告不兼容文件版本,那需

要NameNode执行“Hadoop namenode-format”操作格式化磁盘。(错误)

分析:

首先明白介绍,什么ClusterID

ClusterID

添加了一个新的标识符ClusterID用于标识集群中所有的节点。当格式化一个Namenode,需要提供这个标识符或者自动生成。这个ID可以被用来格式化加入集群的其他Namenode。二次整理

有的同学问题的重点不是上面分析内容:内容如下:

这个报错是说明DataNode所装的Hadoop版本和其它节点不一致,应该检查DataNode

的Hadoop版本

4问答题(一)

4.1Hadoop集群可以运行的3个模式?

单机(本地)模式

伪分布式模式

全分布式模式

4.2单机(本地)模式中的注意点?

在单机模式(standalone)中不会存在守护进程,所有东西都运行在一个JVM上。这里同样没有DFS,使用的是本地文件系统。单机模式适用于开发过程中运行MapReduce

程序,这也是最少使用的一个模式。

4.3伪分布模式中的注意点?

伪分布式(Pseudo)适用于开发和测试环境,在这个模式中,所有守护进程都在同一

台机器上运行。

4.4VM是否可以称为Pseudo?

不是,两个事物,同时Pseudo只针对Hadoop。

4.5全分布模式又有什么注意点?

全分布模式通常被用于生产环境,这里我们使用N台主机组成一个Hadoop集群,Hadoop守护进程运行在每台主机之上。这里会存在Namenode运行的主机,Datanode

运行的主机,以及tasktracker运行的主机。在分布式环境下,主节点和从节点会分开。

4.6Hadoop是否遵循UNIX模式?

是的,在UNIX用例下,Hadoop还拥有“conf”目录。

4.7Hadoop安装在什么目录下?

Cloudera和Apache使用相同的目录结构,Hadoop被安装在

cd/usr/lib/hadoop-0.20/。

4.8Namenode、Jobtracker和tasktracker的端口号是?

Namenode,70;Jobtracker,30;Tasktracker,60。

4.9Hadoop的核心配置是什么?

Hadoop的核心配置通过两个xml文件来完成:1,hadoop-default.xml;2,hadoop-site.xml。这些文件都使用xml格式,因此每个xml中都有一些属性,包括名称和值,但是当下这些文件都已不复存在。

4.10那当下又该如何配置?

Hadoop现在拥有3个配置文件:1,core-site.xml;2,hdfs-site.xml;3,mapred-site.xml。这些文件都保存在conf/子目录下。

4.11RAM的溢出因子是?

溢出因子(Spillfactor)是临时文件中储存文件的大小,也就是Hadoop-temp目录。

4.12fs.mapr.working.dir只是单一的目录?

fs.mapr.working.dir只是一个目录。

4.13hdfs-site.xml的3个主要属性?

https://www.360docs.net/doc/3216809090.html,.dir决定的是元数据存储的路径以及DFS的存储方式(磁盘或是远端)

dfs.data.dir决定的是数据存储的路径

fs.checkpoint.dir用于第二Namenode

4.14如何退出输入模式?

退出输入的方式有:1,按ESC;2,键入:q(如果你没有输入任何当下)或者键入:wq (如果你已经输入当下),并且按下Enter。

4.15当你输入hadoopfsck/造成“connectionrefusedjavaexception’”时,系统究

竟发生了什么?

这意味着Namenode没有运行在你的VM之上。

4.16我们使用Ubuntu及Cloudera,那么我们该去哪里下载Hadoop,或者是默认

就与Ubuntu一起安装?

这个属于Hadoop的默认配置,你必须从Cloudera或者Edureka的dropbox下载,然后在你的系统上运行。当然,你也可以自己配置,但是你需要一个Linuxbox,Ubuntu 或者是RedHat。在Cloudera网站或者是Edureka的Dropbox中有安装步骤。

4.17“jps”命令的用处?

这个命令可以检查Namenode、Datanode、TaskTracker、JobTracker是否正常工作。

4.18如何重启Namenode?

点击stop-all.sh,再点击start-all.sh。

键入sudohdfs(Enter),su-hdfs(Enter),/etc/init.d/ha(Enter),及/etc/init.d/hadoop-0.20-namenodestart(Enter)。

4.19Fsck的全名?

全名是:FileSystemCheck。

4.20如何检查Namenode是否正常运行?

如果要检查Namenode是否正常工作,使用命令

/etc/init.d/hadoop-0.20-namenodestatus或者就是简单的jps。

4.21mapred.job.tracker命令的作用?

可以让你知道哪个节点是JobTracker。

4.22/etc/init.d命令的作用是?

/etc/init.d说明了守护进程(服务)的位置或状态,其实是LINUX特性,和Hadoop 关系不大。

4.23如何在浏览器中查找Namenode?

如果你确实需要在浏览器中查找Namenode,你不再需要localhost:8021,Namenode的端口号是50070。

4.24如何从SU转到Cloudera?

从SU转到Cloudera只需要键入exit。

4.25启动和关闭命令会用到哪些文件?

Slaves及Masters。

4.26Slaves由什么组成?

Slaves由主机的列表组成,每台1行,用于说明数据节点。

4.27Masters由什么组成?

Masters同样是主机的列表组成,每台一行,用于说明第二Namenode服务器。4.28hadoop-env.sh是用于做什么的?

hadoop-env.sh提供了Hadoop中.JAVA_HOME的运行环境。

4.29Master文件是否提供了多个入口?

是的你可以拥有多个Master文件接口。

4.30hadoop-env.sh文件当下的位置?

hadoop-env.sh现在位于conf。

4.31在Hadoop_PID_DIR中,PID代表了什么?

PID代表了“ProcessID”。

4.32/var/hadoop/pids用于做什么?

/var/hadoop/pids用来存储PID。

4.33hadoop-metrics.properties文件的作用是?

hadoop-metrics.properties被用做“Reporting”,控制Hadoop报告,初始状态是“nottoreport”。

4.34Hadoop需求什么样的网络?

Hadoop核心使用Shell(SSH)来驱动从节点上的服务器进程,并在主节点和从节点

之间使用password-lessSSH连接。

4.35全分布式环境下为什么需求password-lessSSH?

这主要因为集群中通信过于频繁,JobTracker需要尽可能快的给TaskTracker发布任务。

4.36这会导致安全问题吗?

完全不用担心。Hadoop集群是完全隔离的,通常情况下无法从互联网进行操作。与

众不同的配置,因此我们完全不需要在意这种级别的安全漏洞,比如说通过互联网侵入等等。Hadoop为机器之间的连接提供了一个相对安全的方式。

4.37SSH工作的端口号是?

SSH工作的端口号是NO.22,当然可以通过它来配置,22是默认的端口号。

4.38SSH中的注意点还包括?

SSH只是个安全的shell通信,可以把它当做NO.22上的一种协议,只需要配置一个

密码就可以安全的访问。

4.39为什么SSH本地主机需要密码?

在SSH中使用密码主要是增加安全性,在某些情况下也根本不会设置密码通信。

4.40如果在SSH中添加key,是否还需要设置密码?

是的,即使在SSH中添加了key,还是需要设置密码。

4.41假如Namenode中没有数据会怎么样?

没有数据的Namenode就不能称之为Namenode,通常情况下,Namenode肯定

会有数据。

4.42当JobTracker宕掉时,Namenode会发生什么?

当JobTracker失败时,集群仍然可以正常工作,只要Namenode没问题。

4.43是客户端还是Namenode决定输入的分片?

这并不是客户端决定的,在配置文件中以及决定分片细则。

4.44是否可以自行搭建Hadoop集群?

是的,只要对Hadoop环境足够熟悉,你完全可以这么做。

4.45是否可以在Windows上运行Hadoop?

你最好不要这么做,RedHatLinux或者是Ubuntu才是Hadoop的最佳操作系统。在Hadoop安装中,Windows通常不会被使用,因为会出现各种各样的问题。因此,Windows 绝对不是Hadoop的推荐系统。

5问答题(二)

5.1写出以下执行命令

1)如何杀死一个job

先Hadoop job-list得到jobid杀死job:hadoop job-kill jobid

2)删除hdfs上的/tmp/xxx目录hadoop fs-rm-r/tmp/xxx

3)加入一个新的存储节点和删除一个计算节点,需要刷新集群状态命令

加入新节点时:

Hadoop-daemon.sh start datanode

Hadoop-daemon.sh start tasktracker

删除节点时

Hadoop maradmin-refreshnodes

Hadoop dfsadmin-refreshnodes

5.2简述一下hdfs的数据压缩算法,工作中用的是那种算法,为什么?

1、在HDFS之上将数据压缩好后,再存储到HDFS

2、在HDFS内部支持数据压缩,这里又可以分为几种方法:

2.1、压缩工作在DataNode上完成,这里又分两种方法:

2.1.1、数据接收完后,再压缩

这个方法对HDFS的改动最小,但效果最低,只需要在block文件close后,调用压缩工具,将block文件压缩一下,然后再打开block文件时解压一下即可,几行代码就可以搞定

2.1.2、边接收数据边压缩,使用第三方提供的压缩库

效率和复杂度折中方法,Hook住系统的write和read操作,在数据写入磁盘之前,先压缩一下,但write和read对外的接口行为不变,比如:原始大小为100KB的数据,压缩后大小为10KB,当写入100KB后,仍对调用者返回100KB,而不是10KB

2.2、压缩工作交给DFSClient做,DataNode只接收和存储

这个方法效果最高,压缩分散地推给了HDFS客户端,但DataNode需要知道什么时候一个block块接收完成了。

推荐最终实现采用2.2这个方法,该方法需要修改的HDFS代码量也不大,但效果最高。

1、Datanode在什么情况下不会备份?

单节点的情况下不会备份!

2、datanode首次加入cluster的时候,如果log报告不兼容文件版本,那

需要namenode

3、执行格式化操作,这样处理的原因是?这个说法是错误的!

添加了一个新的标识符ClusterID用于标识集群中所有的节点。当格式化一个Namenode,需要提供这个标识符或者自动生成。这个ID可以被用来格式化加入集群的其他Namenode 应该检查hadoop的版本是不是与其他的hadoop版本一致!

5.3三个datanode,当有一个datanode出现错误会怎样?

Datanode以数据块作为容错单位通常一个数据块会备份到三个datanode上,如果一个datanode出错,则回去其他备份数据块的datanode上读取,并且会把这个datanode 上的数据块再复制一份以达到备份的效果!

5.4hdfs原理,以及各个模块的职责?

Client:切分文件;访问或通过命令行管理HDFS;与NameNode交互,获取文件位置信息;与DataNode交互,读取和写入数据。

NameNode:Master节点,只有一个,管理HDFS的名称空间和数据块映射信息;配置

副本策略;处理客户端请求。

DataNode:Slave节点,存储实际的数据;执行数据块的读写;汇报存储信息给NameNode。Secondary NameNode:辅助NameNode,分担其工作量;定期合并fsimage和fsedits,

推送给NameNode;紧急情况下,可辅助恢复NameNode,但Secondary NameNode

并非NameNode的热备

Hdfs文件读取

1.首先调用FileSystem对象的open方法,其实是一个DistributedFileSystem的实

例

2.DistributedFileSystem通过rpc获得文件的第一批个block的locations,同一block按照重复数会返回多个locations,这些locations按照hadoop拓扑结构排序,距

离客户端近的排在前面.

3.前两步会返回一个FSDataInputStream对象,该对象会被封装成DFSInputStream

对象,DFSInputStream可以方便的管理datanode和namenode数据流。客户端调用read

方法,DFSInputStream最会找出离客户端最近的datanode并连接。

4.数据从datanode源源不断的流向客户端。

5.如果第一块的数据读完了,就会关闭指向第一块的datanode连接,接着读取下一块。

这些操作对客户端来说是透明的,客户端的角度看来只是读一个持续不断的流。

6.如果第一批block都读完了,DFSInputStream就会去namenode拿下一批blocks

的location,然后继续读,如果所有的块都读完,这时就会关闭掉所有的流

Hdfs的文件写入

1.客户端通过调用DistributedFileSystem的create方法创建新文件

2.DistributedFileSystem通过RPC调用namenode去创建一个没有blocks关联的新文

件,创建前,namenode会做各种校验,比如文件是否存在,客户端有无权限去创建等。

如果校验通过,namenode就会记录下新文件,否则就会抛出IO异常.

3.前两步结束后会返回FSDataOutputStream的对象,和读文件的时候相似,FSDataOutputStream被封装成DFSOutputStream,DFSOutputStream可以协调namenode和datanode。客户端开始写数据到DFSOutputStream,DFSOutputStream

会把数据切成一个个小packet,然后排成队列data quene。

4.DataStreamer会去处理接受data quene,他先问询namenode这个新的block最适合

存储的在哪几个datanode里,比如重复数是3,那么就找到3个最适合的datanode,把

他们排成一个pipeline.DataStreamer把packet按队列输出到管道的第一个datanode中,

第一个datanode又把packet输出到第二个datanode中,以此类推。

5.DFSOutputStream还有一个对列叫ack quene,也是有packet组成,等待datanode

的收到响应,当pipeline中的所有datanode都表示已经收到的时候,这时akc quene才

会把对应的packet包移除掉。

6.客户端完成写数据后调用close方法关闭写入流

7.DataStreamer把剩余得包都刷到pipeline里然后等待ack信息,收到最后一个ack后,

通知datanode把文件标示为已完成。

5.5哪个进程通常与namenode在一个节点启动?并做分析

JobTracker

hadoop的集群是基于master/slave模式,namenode和jobtracker属于master,

datanode和tasktracker属于slave,master只有一个,而slave有多个SecondaryNameNode内存需求和NameNode在一个数量级上,所以通常secondary

NameNode(运行在单独的物理机器上)和NameNode运行在不同的机器上。JobTracker和TaskTracker

JobTracker对应于NameNode

TaskTracker对应于DataNode

DataNode和NameNode是针对数据存放来而言的

JobTracker和TaskTracker是对于MapReduce执行而言的

mapreduce中几个主要概念,mapreduce整体上可以分为这么几条执行线索:jobclient,JobTracker与TaskTracker。

1、JobClient会在用户端通过JobClient类将应用已经配置参数打包成jar文件存储到hdfs,

并把路径提交到Jobtracker,然后由JobTracker创建每一个Task(即MapTask和ReduceTask)

并将它们分发到各个TaskTracker服务中去执行

2、JobTracker是一个master服务,软件启动之后JobTracker接收Job,负责调度Job

的每一个子任务task运行于TaskTracker上,

并监控它们,如果发现有失败的task就重新运行它。一般情况应该把JobTracker部署在单

独的机器上。

3、TaskTracker是运行在多个节点上的slaver服务。TaskTracker主动与JobTracker通信,接收作业,并负责直接执行每一个任务。

TaskTracker都需要运行在HDFS的DataNode上。

5.6hdfs的体系结构?

HDFS采用了主从(Master/Slave)结构模型,一个HDFS集群是由一个NameNode

和若干个DataNode组成的。其中NameNode作为主服务器,管理文件系统的命名空间

和客户端对文件的访问操作;集群中的DataNode管理存储的数据。HDFS允许用户以文

件的形式存储数据。从内部来看,文件被分成若干个数据块,而且这若干个数据块存放在一

组DataNode上。NameNode执行文件系统的命名空间操作,比如打开、关闭、重命名

文件或目录等,它也负责数据块到具体DataNode的映射。DataNode负责处理文件系统

客户端的文件读写请求,并在NameNode的统一调度下进行数据块的创建、删除和复制工作。NameNode和DataNode都被设计成可以在普通商用计算机上运行。这些计算机通

常运行的是GNU/Linux操作系统。HDFS采用Java语言开发,因此任何支持Java的机器

都可以部署NameNode和DataNode。一个典型的部署场景是集群中的一台机器运行一个NameNode实例,其他机器分别运行一个DataNode实例。当然,并不排除一台机器运行多个DataNode实例的情况。集群中单一的NameNode的设计则大大简化了系统的架构。NameNode是所有HDFS元数据的管理者,用户数据永远不会经过NameNode。

5.7HDFS,replica如何定位

//查找某个文件在HDFS集群的位置

public static void getFileLocal()throws IOException{

//返回FileSystem对象

FileSystem fs=getFileSystem();

//文件路径

Path path=

new Path("hdfs://https://www.360docs.net/doc/3216809090.html,:9000/middle/weibo/weibo.txt");

//获取文件目录

FileStatus filestatus=fs.getFileStatus(path);

//获取文件块位置列表

BlockLocation[]blkLocations=

fs.getFileBlockLocations(filestatus,0,filestatus.getLen());

//循环输出块信息

for(int i=0;i String[]hosts=blkLocations[i].getHosts(); System.out.println("block_"+i+"_location:"+hosts[0]); } 5.8HDFS存储的机制? HDFS的三个实体 数据块 每个磁盘都有默认的数据块大小,这是磁盘进行读写的基本单位.构建于单个磁盘之上的文件系统通过磁盘块来管理该文件系统中的块.该文件系统中的块一般为磁盘块的整数倍.磁盘块一般为512字节.HDFS也有块的概念,默认为64MB(一个map处理的数据大小).HDFS上的文件也被划分为块大小的多个分块,与其他文件系统不同的是,HDFS中小于一个块大小的文件不会占据整个块的空间. HDFS用块存储带来的第一个明显的好处一个文件的大小可以大于网络中任意一个磁盘的容量,数据块可以利用磁盘中任意一个磁盘进行存储.第二个简化了系统的设计,将控制单元 设置为块,可简化存储管理,计算单个磁盘能存储多少块就相对容易.同时也消除了对元数据 的顾虑,如权限信息,可以由其他系统单独管理. DataNode节点 DataNode是HDFS文件系统的工作节点,它们根据需要存储并检索数据块,受NameNode 节点调度.并且定期向NameNode发送它们所存储的块的列表 NameNode节点 NameNode管理HDFS文件系统的命名空间,它维护着文件系统树及整棵树的所有的文件及目录.这些文件以两个文件形式永久保存在本地磁盘上(命名空间镜像文件和编辑日志文件).NameNode记录着每个文件中各个块所在的数据节点信息但并不永久保存这些块的位置信息,因为这些信息在系统启动时由数据节点重建. 没有NameNode,文件系统将无法使用.如提供NameNode服务的机器损坏,文件系统上的所有文件丢失,我们就不能根据DataNode的块来重建文件.因此,对NameNode的容错非常重要.第一种机制,备份那些组成文件系统元数据持久状态的文件.通过配置使NameNode 在多个文件系统上保存元数据的持久状态或将数据写入本地磁盘的同时,写入一个远程挂载的网络文件系统.当然这些操作都是原子操作.第二种机制是运行一个辅助的NameNode,它会保存合并后的命名空间镜像的副本,并在Name/Node发生故障时启用.但是辅助NameNode保存.态总是滞后于主力节点,所以在主节点全部失效后难免丢失数据.在这种情况下,一般把存储在远程挂载的网络文件系统的数据复制到辅助NameNode并作为新的主NameNode运行 5.9hdfs的client端,复制到第三个副本时宕机,hdfs怎么恢复保证下次写第三副 本? Datanode会定时上报block块的信息给namenode,namenode就会得知副本缺失,然后namenode就会启动副本复制流程以保证数据块的备份! 5.10block块信息是先写dataNode还是先写nameNode? Client向NameNode发起文件写入的请求。 NameNode根据文件大小和文件块配置情况,返回给Client它所管理部分DataNode 的信息。 Client将文件划分为多个Block,根据DataNode的地址信息,按顺序写入到每一个DataNode块中。 5.11Hive的join有几种方式,怎么实现join的? 答:3种join方式: 1)在reduce端进行join,最常用的join方式。 Map端的主要工作:为来自不同表(文件)的key/value对打标签以区别不同来源的记录。然后 用连接字段作为key,其余部分和新加的标志作为value,最后进行输出。 reduce端的主要工作:在reduce端以连接字段作为key的分组已经完成,我们只需要在每一 个分组当中将那些来源于不同文件的记录(在map阶段已经打标志)分开,最后进行笛卡尔。 2)在map端进行join,使用场景:一张表十分小、一张表很大: 在提交作业的时候先将小表文件放到该作业的DistributedCache中,然后从DistributeCache中 取出该小表进行join key/value解释分割放到内存中(可以放大Hash Map等等容器中)。然后扫描大 表,看大表中的每条记录的join key/value值是否能够在内存中找到相同join key的记录,如果有则 直接输出结果 3)SemiJoin,semijoin就是左边连接是reducejoin的一种变种,在map端过滤掉一些数据,在网络传输过程中,只传输参与连接的数据,减少了shuffle的网络传输量,其他和reduce 的思想是一样的。 实现:将小表中参与join的key单独抽取出来通过DistributeCache分发到相关节点, 在map阶段扫描连接表,将join key不在内存hashset的纪录过滤掉,让参与join的纪录 通过shuffle传输到reduce端进行join,其他和reduce join一样。 5.12hive内部表和外部表的区别? 内部表:建表时会在hdfs创建一个表的存储目录,增加分区的时候,会将数据复制到此location下,删除数据的时候,将表的数据和元数据一起删除。 外部表:一般会建立分区,增加分区的时候不会将数据移到此表的location下,删除数据的时候,只删除了表的元数据信息,表的数据不会删除。 5.13hive是如何实现分区的? 建表语句: create table tablename(id)partitioned by(dt string) 增加分区: alter table tablenname add partition(dt=‘2016-03-06’) 删除分区: alter table tablename drop partition(dt=‘2016-03-06’) 5.14hive支持not in吗? 不支持,可以用left join实现此功能 5.15Hive有哪些方式保存元数据,各有哪些优缺点。 1)存储于derby数据库,此方法只能开启一个hive客户端,不推荐使用 2)存储于mysql数据库中,可以多客户端连接,推荐使用。 5.16hive如何优化 1)join优化,尽量将小表放在join的左边,如果一个表很小可以采用mapjoin 2)排序优化,order by一个reduce效率低,distirbute by+sort by也可以实现全局排序 3)使用分区,查询时可减少数据的检索,从而节省时间。 5.17hive能像关系数据库那样,建多个库吗? 可以建立多个库,多库多表都支持。 5.18hive中的压缩格式RCFile、TextFile、SequenceFile各有什么区别? TextFile:默认格式,数据不做压缩,磁盘开销大,数据解析开销大 SequenceFile:Hadoop API提供的一种二进制文件支持,使用方便,可分割,可压缩,支 持三种压缩,NONE,RECORD,BLOCK RCFILE是一种行列存储相结合的方式。首先,将数据按行分块,保证同一个record在同 一个块上,避免读一个记录读取多个block。其次,块数据列式存储,有利于数据压缩和快 速的列存取。数据加载的时候性能消耗大,但具有较好的压缩比和查询响应。 5.19hive相对于Oracle来说有那些优点? 1)存储,hive存储在hdfs上,oracle存储在本地文件系统 2)扩展性,hive可以扩展到数千节点,oracle理论上只可扩展到100台左右 3)单表存储,数据量大hive可以分区分桶,oracle数据量大只能分表。 5.20Hive的sort by和order by的区别 order by会对输入数据做全局排序,只有一个reduce,数据量较大时,很慢。 sort by不是全局排序,只能保证每个reduce有序,不能保证全局有序,需设置mapred.reduce.tasks>1 面试考题及答案 一、自报家门(※) 答:6局X处X科+职务+姓名。 二、是否自愿参加本组织?(※) 答:自愿参加。 三、本组织的发起时间?(※)领导留有赠言时间? 答:我们的组织于2019.8.16日接到指令并发起;2019.8.26日正式启动,领导留有赠言。 四、身体健康否?(※) 答:健康不太好(如实回答) 五、团队运作的八字方针是什么? 答:低调运作,高度保密。 六、年龄规定是多大? 答:18~65周岁,有特殊才能放宽到70周岁。语音表达能力强,组织能力强,电脑手机运用能力强,比如:群主讲师统计等。七、招募范围? 答:面向全国各行各业,各大平台,各大团队优秀的、合法的中国公民。 八、招募新人的条件是什么? 答:是“三正”和“六有” 1.“三正”:正知、正念、正能量; 2.“六有”:有福、有缘、有德、有胆、有识、有信仰。 九、是否党员? 答:是,或不是。 十、能否走出家门服从分配? 答:可以或不能。 十一、一个中心: 以实现中国梦为中心。 十二、两个基本点: 1.选拔人才; 2.团队组建和管理。 十三、三个思想: 1.特殊的时间发起背景; 2.特殊的模式理念; 3.特殊的历史使命(忠于祖国,忠于人民,全心全意为人民服务)。十四、我们必须做到团队建设的五个统一: 1.统一目标。 2.统一思想。 3.统一规则。 4.统一行动。 5.统一声音。 十五、(中国梦)十六字方针: “国家富强、民族振兴、人民幸福、社会和谐”。 十六、团队的理念 我们每个人都是团队最宝贵的力量,我们有着共同的理想和目标,我们必须要做到团队铁一样的纪律,坚定信念,坚定团队整体目标 的实现。 注明: 以上16个问题每人须回答10题以上即可,有※是必答题,其余为选答题。 考评标准: 1.答对11道题以上者为优秀; 2.回答9题以上者合格; 3.回答5题以内出错者不合格。 二〇二〇年五月十五日 1. 以下哪一项不属于Hadoop可以运行的模式___C___。 A. 单机(本地)模式 B. 伪分布式模式 C. 互联模式 D. 分布式模式 2. Hadoop的作者是下面哪一位__B____。 A. Martin Fowler B. Doug cutting C. Kent Beck D. Grace Hopper 3. 下列哪个程序通常与 NameNode 在同一个节点启动__D___。 A. TaskTracker B. DataNode C. SecondaryNameNode D. Jobtracker 4. HDFS 默认 Block Size的大小是___B___。 5. 下列哪项通常是集群的最主要瓶颈____C__。 A. CPU B. 网络 C. 磁盘IO D. 内存 6. 下列关于MapReduce说法不正确的是_____C_。 A. MapReduce是一种计算框架 B. MapReduce来源于google的学术论文 C. MapReduce程序只能用java语言编写 D. MapReduce隐藏了并行计算的细节,方便使用 8. HDFS是基于流数据模式访问和处理超大文件的需求而开发的,具有高容错、高可靠性、高可扩展性、高吞吐率等特征,适合的读写任务是 __D____。 A.一次写入,少次读 B.多次写入,少次读 C.多次写入,多次读 D.一次写入,多次读 9. HBase依靠__A____存储底层数据。 A. HDFS B. Hadoop C. Memory D. MapReduce 10. HBase依赖___D___提供强大的计算能力。 A. Zookeeper B. Chubby C. RPC D. MapReduce 运维工程师面试题 姓名: 答题时间: 1.新安装MYSQL后怎样提升MYSQL的安全级别? A.修改mysql默认端口 下可以通过iptables来限制访问mysql端口的IP地址 C.对所有用户设置较复杂密码并严格指定对应账号的访问IP(可在mysql库中user表中指定用户的访问可访问IP地址) 特权账号的处理(建议给root账号设置强密码,并指定只允许本地登录) E.开启二进制查询日志和慢查询日志 安装目录及数据存储目录权限控制:给mysql安装目录读取权限,给mysql日志和数据所在目录读取和写入权限 G.删除无用mysql账号和删除无用的数据库(安装好的mysql默认会有个test库,可将其删除) 2.MYSQL的主从原理,怎么配置文件? 整体上来说,复制有3个步骤: 将改变记录到二进制日志(binary log)中(这些记录叫做二进制日志事件,binary log events); 将master的binary log events拷贝到它的中继日志(relay log); 重做中继日志中的事件,将改变反映它自己的数据。 3.mysql主从复制的优点 <1> 如果主服务器出现问题,可以快速切换到从服务器提供的服务; <2> 可以在从服务器上执行查询操作,降低主服务器的访问压力; <3> 可以在从服务器上执行备份,以避免备份期间影响主服务器的服务。 4.Mysql复制的基本原理过程 (1)Slave上面的IO线程连接上Master,并请求从指定日志文件的指定位置(或者从最开始的日志)之后的日志内容; (2)Master接收到来自Slave的IO线程的请求后,通过负责复制的IO线程根据请求信息读取指定日志指定位置之后的日志信息,返回给Slave端的IO线程。返回信息中除了日志所包含的信息之外,还包括本次返回的信息在Master端binary log文件的名称以及在Binary log中的位置; (3)Slave的IO线程收到信息后,将接收到的日志内容依次写入到Slave端的RelayLog 文件()的最末端,并将读取到的Master端的bin-log的文件名和位置记录到master-info文件中,以便在下一次读取的时候能够清楚的告诉master“我需要从某个bin-log的哪个位置开始往后的日志内容,请发给我” (4)Slave的SQL线程检测到Relay Log中新增加了内容后,会马上解析该Log文件中的内容成为在Master端真实执行时候的那些可执行的查询或操作语句,并在自身执行那些查询或操作语句,这样,实际上就是在master端和Slave端执行了同样的查询或操作语句,所以两端的数据是完全一样的。 5.为MYSQL添加一个用户? mysql> grant select,insert,update,delete on book.* to test2@localhost identified by “abc”;? ? #增加test2用户,密码为abc。并只能在localhost这台主机上登录,并且只能访问book这个库中的表,具有查询,插入,更新,删除权限; 语法:mysql> GRANT <权限> ON <库>.<表> TO ‘用户’@’主机名’ identified by “密码”; 6.写一个脚本将数据库备份并打包至远程服务器/backup目录下。 mount /mnt cd /mnt /usr/local/mysql/bin/mysqldump -hlocalhost -uroot test > tar czf rm -f 软件实施面试题答案 ?1、你熟悉的远程有哪些方法?各种方法应该怎么配置? 参考答案: (1)、最简单的QQ上有,打开对话框上边有个“应用”图标点击“远程协助”。 (2)、系统自带的远程桌面服务,右击我的电脑—属性,点远程,把两个够都打上去。 (3)、远程协助软件,在要远程的主机安装代理程序后,即可使用远程服务。 (4)、专业通信系统,即时通、 OA之类的。 ?2、在你进行实施的过程中,公司制作的一款软件系统缺少某一项功能,而且公司也明确表示不会再为 系统做任何的修改或添加任何的功能,而客户也坚决要求需要这一项功能!对于实施人员来说,应该怎么去合理妥善处理这个问题? 参考答案: 先看客户要求合不合理,不合理就可以坚决退还需求。如果需求合理的话,可以 (1)、申请做二次开发,并且收取一定的费用,这个两边都要沟通好。 (2)、第二种方法,使用第三方软件做补助。 3、在项目实施过程中,使用者对产品提出了适合自己习惯的修改意见,但多个使用者相互矛盾,应该如何去处理? 参考答案: 对于客户提出的修改意见,我们实施人员应该有自己的方案。当使用者之间意见出现不一致时,我们应当引导他们内部之间的意见统一,和客户经过沟通或确认后,找到切实可行的方案,双方认可并达成共识。 4、同一个网络环境中,A电脑访问不到B电脑的共享文件。此现象可能是哪些方面所导致?怎样处理? 参考答案: 首先检查网络是否有问题,再确定是不是在一个工作组内,只有在一个工作组内才可以共享文件,然后看有没有被防火墙阻止,最后确定文件是不是已经被共享。 5、什么是DHCP?如何快速为多台(20台)电脑安装操作系统?多台电脑如何组网? 参考答案: (1)、DHCP:动态主机设置协议,是一个局域网的网络协议,使用UDP协议工作,主要有两个用途:给内部网络或网络服务供应商自动分配IP地址、给用户给内部网络管理员作为对所有计算机作中央管理的手段。 (2)、可以通过网络硬盘克隆,过程为:在装有软驱的工作站上,用一张引导盘来启动机器,连接到服务器,使用Ghost 多播服务(Multicast Server)将硬盘或分区的映像克隆到工作站,这样就实现了不拆机、安全、快速的网络硬盘克隆。 大数据工程师面试题 大数据工程师面试,对于很多人来说应该都不陌生了吧,虽说大数据就业前景很好,但想要成功进入名企,并不是一件容易的事情,不仅仅需要专业的技能,还需要你在面试的时候认真准备一下。面试的时候,我们会遇到各种各样的问题,千锋讲师今天就先讲解一下面试经常会遇到的问题,Hadoop是如何工作的? Hadoop是一个分布式文件系统(Hadoop Distributed File System),简称HDFS。Hadoop是一个能够对大量数据进行分布式处理的软件框架,以一种可靠、高效、可伸缩的方式进行数据处理。所以说Hadoop解决了大数据如何存储的问题,因而在大数据培训机构中是必须学习的课程,也是面试中面试官非常注重的一个技术点。 Hadoop是如何工作的? Hadoop是从Google文件系统发源而来,并且他是一个用Java开发的跨平台的应用。核心组件有: Hadoop Common,拥有其他模块所依赖的库和基础 工具,Hadoop分布式文件系统(HDFS),负责存储,Hadoop YARN,管理计算资源,和Hadoop MapReduce,负责处理的过程。 Hadoop把文件拆成小块并且把他们分发给集群中的节点。然后,它使用打包的代码分发到节点上并行处理数据。这意味着可以处理数据的速度会比使用传统的体系结构的更快。 一个典型的Hadoop集群都会有主节点和从节点或者叫工作节点。主节点有一个任务跟踪器,任务调度,名字节点和数据节点组成。从节点通常作为一个数据节点和任务调度器,不过特殊的场景下程序可能只有数据节点然后在其他的从节点进行处理计算。 在大的Hadoop集群中,通常会使用一个专用的名字节点来管理HDFS节点的文件系统索引信息,这防止了文件系统的数据丢失和损坏。 千锋教育拥有一支的强师队伍,在教学研究方面,我们老师不断的推陈出新,探索更新的教学方式,结合时代所需不断更新课程大纲,加强学生对于知识的理解和运用。千锋讲师对于大数据行业时刻保持一定的敏感性和前瞻性,定期与各大企业的技术官交流分析,掌握大数据的发展动向,不仅仅可以帮助同学们更好的学习大数据技术,还会预测一些大数据工程师面试题,为同学们的就业之路披荆斩棘。 关键词:大数据工程师面试题 h a d o o p练习题--带 答案 Hadoop 练习题姓名:分数: 单项选择题 1.下面哪个程序负责HDFS数据存储。 a)NameNode b)Jobtracker c)Datanode √ d)secondaryNameNode e)tasktracker 2.HDfS中的block默认保存几份? a)3份√ b)2份 c)1份 d)不确定 3.下列哪个程序通常与NameNode在一个节点启动? a)SecondaryNameNode b)DataNode c)TaskTracker d)Jobtracker√ 4.Hadoop作者 a)Martin Fowler b)Kent Beck c)Doug cutting√ 5.HDFS默认Block Size a)32MB b)64MB√ c)128MB 6.下列哪项通常是集群的最主要的性能瓶颈 a)CPU b)网络 c)磁盘√ d)内存 7.关于SecondaryNameNode哪项是正确的? a)它是NameNode的热备 b)它对内存没有要求 c)它的目的是帮助NameNode合并编辑日志,减少NameNode启动时间√ d)SecondaryNameNode应与NameNode部署到一个节点 8.一个gzip文件大小75MB,客户端设置Block大小为64MB,请我其占用几个Block? a) 1 b)2√ c) 3 d) 4 9.HDFS有一个gzip文件大小75MB,客户端设置Block大小为64MB。当运行mapreduce 任务读取该文件时input split大小为? a)64MB b)75MB√ c)一个map读取64MB,另外一个map读取11MB 10.HDFS有一个LZO(with index)文件大小75MB,客户端设置Block大小为64MB。当运 行mapreduce任务读取该文件时input split大小为? a)64MB b)75MB c)一个map读取64MB,另外一个map读取11MB√ 多选题: 11.下列哪项可以作为集群的管理工具 a)Puppet√ b)Pdsh√ c)Cloudera Manager√ d)Rsync + ssh + scp√ 12.配置机架感知的下面哪项正确 a)如果一个机架出问题,不会影响数据读写√ b)写入数据的时候会写到不同机架的DataNode中√ c)MapReduce会根据机架获取离自己比较近的网络数据√ 13.Client端上传文件的时候下列哪项正确 a)数据经过NameNode传递给DataNode b)Client端将文件以Block为单位,管道方式依次传到DataNode√ c)Client只上传数据到一台DataNode,然后由NameNode负责Block复制工作 d)当某个DataNode失败,客户端会继续传给其它DataNode √ 2017年事业单位面试题及解析 【题目】 你所在的小区有一块空置的绿化地,有居民提议建停车场,也有居民提议保留绿地,双方因此产生争吵,领导让你去调解,你会怎么做? 【参考答案】 作为社区工作人员,我有责任维护小区居民的和谐和安全。针对此次出现的居民因为空置绿地而产生的争吵,我会采取如下方法加以调解。 首先,第一时间赶到争吵现场,拉开双方进行劝架,告知双方争吵无益于问题解决,希望双方能够在心态平和的情况下推举出代表以促成问题的解决。 其次,联系小区物业及开发商,详细查询设置此块绿地的目的及本小区的车位数量和日常停车情况,以做到对绿地去留心中有数。 再次,与两方居民代表进行交谈,了解双方诉求。有居民提议建停车场,可能是因本小区存在停车难的问题,鉴于此我会结合前期在小区物业管理部门得到的信息以及居民的陈述,综合考虑于空置绿地上兴建停车场的建议是否可行。有居民提议保留绿地,可能是出于绿地的紧急避难功能,我也会认真考虑该部分居民的意见,同时结合从物业部门和开发商处了解到的信息综合考虑解决方案。 再次,联系物业部门负责人、交通部门负责人及居民代表等坐下来共同商讨空置绿地的处置办法。若空置绿地是为小区居民保留紧急室外避难场所而建,且小区内停车难问题并不严重,则会从保护居民人身安全角度出发,空置绿地需要保留。如果小区内车位紧张,停车难现象严重,则我会和物业及交通部门商讨,考虑能否在不影响绿地作为紧急避难场地之功能的前提下,从绿地中划出一小块地方用于停车,以缓解小区内部停车难的现状。 最后,召开小区居民大会,将全部保留绿地和部分保留绿地两种预设方案公诸于众,并详细阐明两种方案制定的原因及绿地的作用和小区内当前面临的停车难问题。由小区居民公开投票,自己选择绿地的处置办法。待投票结束后,总结居民的意愿,妥善处理空置绿地,以使空置绿地更好发挥作用。 【题目】 目前,针对老年人的电话诈骗事件越来越多,为提高老年人防骗意识,你所在的社区要组织一次老年人防骗知识讲座,领导将此任务交给你负责,你将如何组织? 【参考答案】 Hadoop面试题目及答案(附目录) 选择题 1.下面哪个程序负责HDFS 数据存储。 a)NameNode b)Jobtracker c)Datanode d)secondaryNameNode e)tasktracker 答案C datanode 2. HDfS 中的block 默认保存几份? a)3 份b)2 份c)1 份d)不确定 答案A 默认3 份 3.下列哪个程序通常与NameNode 在一个节点启动? a)SecondaryNameNode b)DataNode c)TaskTracker d)Jobtracker 答案D 分析:hadoop 的集群是基于master/slave 模式,namenode 和jobtracker 属于master,datanode 和tasktracker 属于slave,master 只有一个,而slave 有多个SecondaryNameNode 内存需求和NameNode 在一个数量级上,所以通常secondaryNameNode(运行在单独的物理机器上)和NameNode 运行在不同的机器上。 JobTracker 和TaskTracker JobTracker 对应于NameNode,TaskTracker 对应于DataNode,DataNode 和NameNode 是针对数据存放来而言的,JobTracker 和TaskTracker 是对于MapReduce 执行而言的。mapreduce 中几个主要概念,mapreduce 整体上可以分为这么几条执行线索:jobclient,JobTracker 与TaskTracker。 1、JobClient 会在用户端通过JobClient 类将应用已经配置参数打包成jar 文件存储到hdfs,并把路径提交到Jobtracker,然后由JobTracker 创建每一个Task(即MapTask 和ReduceTask)并将它们分发到各个TaskTracker 服务中去执行。 2、JobTracker 是一个master 服务,软件启动之后JobTracker 接收Job,负责调度Job 的每一个子任务task 运行于TaskTracker 上,并监控它们,如果发现有失败的task 就重新运行它。一般情况应该把JobTracker 部署在单独的机器上。 3、TaskTracker 是运行在多个节点上的slaver 服务。TaskTracker 主动与JobTracker 通信,接收作业,并负责直接执行每一个任务。TaskTracker 都需要运行在HDFS 的DataNode 上。 4. Hadoop 作者 a)Martin Fowler b)Kent Beck c)Doug cutting 答案C Doug cutting 5. HDFS 默认Block Size a)32MB b)64MB c)128MB 答案:B 6. 下列哪项通常是集群的最主要瓶颈 a)CPU b)网络c)磁盘IO d)内存 答案:C 磁盘 首先集群的目的是为了节省成本,用廉价的pc 机,取代小型机及大型机。小型机和大型机 Hadoop测试题 一.填空题,1分(41空),2分(42空)共125分 1.(每空1分) datanode 负责HDFS数据存储。 2.(每空1分)HDFS中的block默认保存 3 份。 3.(每空1分)ResourceManager 程序通常与NameNode 在一个节点启动。 4.(每空1分)hadoop运行的模式有:单机模式、伪分布模式、完全分布式。 5.(每空1分)Hadoop集群搭建中常用的4个配置文件为:core-site.xml 、hdfs-site.xml 、mapred-site.xml 、yarn-site.xml 。 6.(每空2分)HDFS将要存储的大文件进行分割,分割后存放在既定的存储块 中,并通过预先设定的优化处理,模式对存储的数据进行预处理,从而解决了大文件储存与计算的需求。 7.(每空2分)一个HDFS集群包括两大部分,即namenode 与datanode 。一般来说,一 个集群中会有一个namenode 和多个datanode 共同工作。 8.(每空2分) namenode 是集群的主服务器,主要是用于对HDFS中所有的文件及内容 数据进行维护,并不断读取记录集群中datanode 主机情况与工作状态,并通过读取与写入镜像日志文件的方式进行存储。 9.(每空2分) datanode 在HDFS集群中担任任务具体执行角色,是集群的工作节点。文 件被分成若干个相同大小的数据块,分别存储在若干个datanode 上,datanode 会定期向集群内namenode 发送自己的运行状态与存储内容,并根据namnode 发送的指令进行工作。 10.(每空2分) namenode 负责接受客户端发送过来的信息,然后将文件存储位置信息发 送给client ,由client 直接与datanode 进行联系,从而进行部分文件的运算与操作。 11.(每空1分) block 是HDFS的基本存储单元,默认大小是128M 。 12.(每空1分)HDFS还可以对已经存储的Block进行多副本备份,将每个Block至少复制到 3 个相互独立的硬件上,这样可以快速恢复损坏的数据。 13.(每空2分)当客户端的读取操作发生错误的时候,客户端会向namenode 报告错误,并 请求namenode 排除错误的datanode 后,重新根据距离排序,从而获得一个新的的读取路径。如果所有的datanode 都报告读取失败,那么整个任务就读取失败。14.(每空2分)对于写出操作过程中出现的问题,FSDataOutputStream 并不会立即关闭。 客户端向Namenode报告错误信息,并直接向提供备份的datanode 中写入数据。备份datanode 被升级为首选datanode ,并在其余2个datanode 中备份复制数据。 NameNode对错误的DataNode进行标记以便后续对其进行处理。 15.(每空1分)格式化HDFS系统的命令为:hdfs namenode –format 。 16.(每空1分)启动hdfs的shell脚本为:start-dfs.sh 。 17.(每空1分)启动yarn的shell脚本为:start-yarn.sh 。 18.(每空1分)停止hdfs的shell脚本为:stop-dfs.sh 。 19.(每空1分)hadoop创建多级目录(如:/a/b/c)的命令为:hadoop fs –mkdir –p /a/b/c 。 20.(每空1分)hadoop显示根目录命令为:hadoop fs –lsr 。 21.(每空1分)hadoop包含的四大模块分别是:Hadoop common 、HDFS 、 2018年5月27日南京及各地市事业单位面试试题及解析 第一题:有两个和尚他们分别住在相邻的两座山上的庙里。这两座山之间有一条溪,于是这两个和尚每天都会在同一时间下山去溪边挑水。就这样不知不觉过了五年。突然有一天开始左边这座山的和尚不再下山挑水,右边这座山的和尚好奇找到他去探一究竟。原来这五年来,左边山的和尚每天做完功课后都会抽空挖井,即使有时很忙,能挖多少就算多少。如今终于挖出井水,他就不用再下山挑水。请结合工作谈谈对你的启示。 【解析】这个故事对我有以下几点启示: 一是要善于思考总结。甲乙俩和尚一起去山下小溪挑水五年,甲和尚每天循规蹈矩,但是乙和尚善于思考,每天观察地形并付诸行动,最终挖出了水井,为以后的生活提供了较大的便利。古希腊物理学家阿基米德就是在洗澡的时候都勤于思考,从而总结出了著名的阿基米德原理。在工作中踏实肯干是值得肯定的,但更重要的是要勤于思考,及时总结,只有这样才能不断进步取得成功。 二是要懂得灵活变通,富有创新精神。乙和尚下山打水五年,虽然每天非常辛苦,但一直不知道变通,没有创新精神,等到别人成功后已经后悔莫及。创新精神是我们这个时代必须有的一种思想与能力,不思进取原地踏步只能被时代所淘汰。曾经著名的相机胶卷巨头柯达公司,由于缺乏创新精神和前瞻性,只是按部就班的躺在业务舒适区,埋头生产胶片相机,未曾想到会迅速被数码相机取代,濒临破产。在知识经济与互联网经济的新时代,只有努力的创新才能跟上时代变幻的步伐。 三是确定目标后须坚持不懈。乙和尚勘察地形后,每天回来挖一点,终于挖出了水井。选定目标后一定要为之努力坚持下去,退休老书记杨善洲为了实现“帮家乡办点实事”的承诺,放弃安稳的退休生活,毅然选择扎根林场20年,最终将山秃水枯的大亮山改造成价值超过3亿元郁郁葱葱的林场,并将林场无偿捐献给国家,为子孙后代留下了一比宝贵的财富。人首先要有正确的目标,然而树立正确的目标固然重要,但更为重要的是要为之努力奋斗,不然再好的目标也只能成为空谈。 四是要懂得团队协作。乙和尚如果早点将计划告知甲和尚,两个人一起努力,定能更快的挖出水井,让两个人都能早点喝到更为便捷、干净的井水。众人拾柴火焰高,所有巨大的成功都不是靠一个人完成的,蔺相如有廉颇、马云有十八罗汉,为了同样的目标而团结协作、努力奋斗更能激发出潜力,更加有机会取得成功。 在以后的工作中,我定会努力的完成好本职工作,同时要及时的思考总结,努力寻求工作中的创新点;要明确个人的奋斗目标,且个人目标要与团队目标相契合,加强团队合作,提升为群众的办事效率。 android面试题目及其答案大全 1,++i和i++ 区别 2,makefile文件代码,写代码 3,隐藏与重写的区别 4,linux 基本命令使用如:如何查询帮助文档(man),如何查处文件(fiind),常用命令5,进程间通信有几种,效率如何 6、什么是嵌入式实时操作系统, Android 操作系统属于实时操作系统吗? 7,tcp/ip 有几层 8、一条最长的短信息约占多少byte? 9,p2p 和SMTP分别在哪层 10、android中的动画有哪几类,它们的特点和区别是什么? 11,多态概念(父类引用子类参数) 12、handler机制的原理 13,java 写1+N的和 14,数据结构与算法如排序,二叉树 15,MVC概念(为什么有DAO层,什么作用) 16,GC回收机制 17、说说mvc模式的原理,它在android中的运用 18,android项目自述 19,java 的进程与线程维护 20、Activity的生命周期 21,N*N 打印出来的样子是(例如N=4) 1 2 3 4 12 13 14 5 11 16 15 6 10 9 8 7 22,linux 末行,输入,命令三个模式 23、Android dvm的进程和Linux的进程, 应用程序的进程是否为同一个概念 24,android 四层架构分别的作用(android系统框图) 25、sim卡的EF 文件有何作用 26,android四大组件,生命周期,onpause()与onstop()的区别 27,UMI建模概念 28,C语言打印N*N数组,规律如下: 2维 1 2 3 4 3维 1 2 3 8 9 4 7 6 5 4维 1 2 3 4 12 13 14 5 11 16 15 6 10 9 8 7 大数据技术Hadoop面试题,看看你能答对多少? 单项选择题 1. 下面哪个程序负责HDFS 数据存储。 a)NameNode b)Jobtracker c)Datanode d)secondaryNameNode e)tasktracker 2. HDfS 中的block 默认保存几份? a)3 份 b)2 份 c)1 份 d)不确定 3. 下列哪个程序通常与NameNode 在一个节点启动? a)SecondaryNameNode b)DataNode c)TaskTracker d)Jobtracker 4. Hadoop 作者 a)Martin Fowler b)Kent Beck c)Doug cutting 5. HDFS 默认Block Size a)32MB b)64MB c)128MB 6. 下列哪项通常是集群的最主要瓶颈 a)CPU b)网络 c)磁盘 d)内存 7. 关于SecondaryNameNode 哪项是正确的? a)它是NameNode 的热备 b)它对内存没有要求 c)它的目的是帮助NameNode 合并编辑日志,减少NameNode 启动时间 d)SecondaryNameNode 应与NameNode 部署到一个节点 多选题: 8. 下列哪项可以作为集群的管理工具 a)Puppet b)Pdsh c)Cloudera Manager d)d)Zookeeper 9. 配置机架感知的下面哪项正确 a)如果一个机架出问题,不会影响数据读写 b)写入数据的时候会写到不同机架的DataNode 中 c)MapReduce 会根据机架获取离自己比较近的网络数据 10. Client 端上传文件的时候下列哪项正确 a)数据经过NameNode 传递给DataNode b)Client 端将文件切分为Block,依次上传 c)Client 只上传数据到一台DataNode,然后由NameNode 负责Block 复制工作 11. 下列哪个是Hadoop 运行的模式 a)单机版 b)伪分布式 c)分布式 12. Cloudera 提供哪几种安装CDH 的方法 a)Cloudera manager b)Tar ball c)Yum d)Rpm 判断题: 13. Ganglia 不仅可以进行监控,也可以进行告警。() 14. Block Size 是不可以修改的。() 15. Nagios 不可以监控Hadoop 集群,因为它不提供Hadoop 支持。() 16. 如果NameNode 意外终止,SecondaryNameNode 会接替它使集群继续工作。() 17. Cloudera CDH 是需要付费使用的。() 18. Hadoop 是Java 开发的,所以MapReduce 只支持Java 语言编写。() 19. Hadoop 支持数据的随机读写。() 20. NameNode 负责管理metadata,client 端每次读写请求,它都会从磁盘中读取或则会写入metadata 信息并反馈client 端。() 21. NameNode 本地磁盘保存了Block 的位置信息。() 22. DataNode 通过长连接与NameNode 保持通信。() 23. Hadoop 自身具有严格的权限管理和安全措施保障集群正常运行。() 24. Slave 节点要存储数据,所以它的磁盘越大越好。() 25. hadoop dfsadmin –report 命令用于检测HDFS 损坏块。() 26. Hadoop 默认调度器策略为FIFO() 27. 集群内每个节点都应该配RAID,这样避免单磁盘损坏,影响整个节点运行。() 28. 因为HDFS 有多个副本,所以NameNode 是不存在单点问题的。() 29. 每个map 槽就是一个线程。() 30. Mapreduce 的input split 就是一个block。() 31. NameNode 的Web UI 端口是50030,它通过jetty 启动的Web 服务。() 32. Hadoop 环境变量中的HADOOP_HEAPSIZE 用于设置所有Hadoop 守护线程的内存。它默认是200 GB。() 33. DataNode 首次加入cluster 的时候,如果log 中报告不兼容文件版本,那需要NameNode执行“Hadoop namenode -format”操作格式化磁盘。() 【编辑推荐】 没有数据分析大数据什么也不是...... 大数据告诉你,真正的白富美的生活是怎样的呢? 2009-2010事业单位面试真题及解析 真题:您是市政府的工作人员,需要调查大学生村官的工作情况,面对基层群众(农民)、基层工作人员分别作一个开场白。 【题型分析】情景模拟 【参考答案】 1.面对基层群众(农民):大叔大婶,你们好!我是咱们市政府的小王。眼看着一年又快到头了,今年的天儿不错,家里收成还好吧?…… 听说咱们这儿来了些大学生,到咱这儿当村官,不知道干的咋样啊?…… 2.面对基层工作人员:XX,你好!我是市政府的工作人员王XX(同时出示工作证),这次来到这里,主要是想调查一下大学生村官的工作情况,希望得到你们的配合和协助。你们长期在基层工作,比较辛苦,对于大学生们在村里的工作情况也比较了解。知道你工作很忙,所以我会尽量抓紧时间…… 真题:金无足赤,人无完人,您有什么缺点和不足?假如您被录用,您将怎么克服您的缺点和不足? 【题型分析】认识自己 【参考答案】每一个人都有自己的缺点和不足,我也一样。我认为我的缺点是有时候有点追求完美,这样一来有可能会拖慢办事的效率,偶尔也会给合作伙伴带来压力。有缺点和不足并不可怕,重要的是能够改正缺点,弥补不足。我将从以下几个方面加强学习,进行改正。 第一,摆正心态正确认识。在遇到每一项工作的时候,我都应该准确地把握工作实质、明确目标,在思想上做好充分准备。不能因为自己的喜好而偏离工作应有的方向和要求。 第二,制定工作计划表。在开始每一项工作的时候,我都要制定好详细的工作进度控制表,将每个阶段的工作目标、内容以及时间详细列好。在开展工作的时候严格按照计划表进行,以免拖慢工作的进程。借此来养成好的工作习惯,以提高办事效率。 第三,加强与同事合作。每一项工作都不可能是自己独立一个人能够做好的,都是需要和同事一起合作才能将其做到真正的完美。这就要求我要在以后的工作中,多多与同事交流,虚心向同事学习。 假如有幸我能够通过此次考试,在以后的工作岗位上,我将严格要求自己,加强学习,发扬优点,改正缺点,竭尽所能做好领导交办的每一项任务,做一名合格的公务员。 真题:您作为单位的新进工作人员,领导让您制定一份单位的规章制度,您对单位不熟悉,您将怎么办? 【题型分析】如何做事 【参考答案】俗话说:“无规矩不成方圆”,好的规章制度能够在保证单位良好工作秩序方面发挥积极的作用。领导将这项任务交予我完成,我一定会努力做好,我将从以下几个方面入手,开展此项工作。 面试试题 1、假如你是某单位的副职,该单位的正职比较固执.而他在处理某一问题上有比较明显的错误,你如何办? 【测试要素】:处理上下级关系的能力,应变能力。 2、你现在是XX的副处长或副主任,在给下属安排工作的会议上,有一下属公开顶撞你,使你很难堪,你该怎么办?说明你的实际步骤和方法。 【测试要素】:控制情绪的能力,考虑问题的全面性。 3、你的一位朋友曾有恩于你,现在登门拜访,求你给个方便,如果你答应他的要求.可能会违背原则.但也并不严重,你该怎么办? 4、你对“一山难容二虎”这句话如何看? 【测试要素】:思维能力和处理与其他领导的关系的能力。 5、一个单位往往有一些人由于性格、爱好等原因而聚集在一起,你对这种现象怎么看? 这对正常的工作有些什么影响? 【测试要素】:组织协调能力。 6、如果上级领导下达给你单位的任务指标遭到众多职工的反对,而你恰好又是执行者,你将怎样处理?【测试要素】:求实精神,组织能力,责任感,对下用的关系。 7、请谈谈副职在决策中的作用(限时5分钟)。 8、领导风格的粗和细你怎么看(限时5分钟)。 9、谦虚使人进步,骄傲使人落后,但在现代社会又强调表现自我,你怎么看? “谦虚使人进步,骄傲使人落后”这是一个工作成功准则。现代社会中虽然强调表现自我,但并不是说主张骄傲。如果一个人只认为自己是最好的,一味地表现自我,自以为是,结果只会适得其反,令人对你反感。如果这样得不到别人支持,到最后就落到个众叛亲离的地步,工作就不能展开,不可能提高成绩,更不可能进步。相反,如果一个在工作中默默无闻,谦虚学习、工作的人,往往就能不断地提高自身各方面的能力,才能在强调表现自我的现代社会永远立于不败之地。所以“谦虚使人进步,骄傲使人落后”是一条不变的成功准则。 10、你最不喜欢的工作是什么?为什么? ①就工作本身而言,它不存在优劣和高低,工作或就业最基础的是我们谋生的手段,所以,对工作着的人而言,那只能说是个人对所从事的工作的适应度和驾驭度。而我们首先应该做的是适应工作,适应环境,而不是去抱怨和用个人喜好做事。②当然,如果能够在工作中找到自己的挖掘点,那是社会的幸福也是个人价值的体现。“兴趣是第一动力”,它带动良性循环,但我们不应该在工作中一味去讨论主观上的喜欢 第一章大数据概述 1.互联网的发展分为______个阶段。 A.一 B.三 C.二 D.四 2.下列不属于大数据特点的是()。 A.种类和来源多样化 B.数据量巨大 C.分析处理速度快 D.价值密度高 3.互联网发展的第_____个时代为智能互联网。 A.3.0 B.4.0 C.1.0 D.2.0 4.关于大数据叙述不正确的一项是()。 A.大数据=“海量数据”+“复杂类型的数据” B.大数据是指在一定时间对内容抓取、管理和处理的数据集合 C.大数据可以及时有效的分析海量的数据 D.数据包括结构化数据、半结构化数据、结构化数据。 5.下列数据换算正确的一项为()。 A.1YB=1024EB B.1TB=1024MB C.1PB==1024EB D.1024ZB=1EB 6.结构化数据的表现形式为______。 A.文本 B.视图 C.二维表 D.查询 7.结构化的数据,先有________,再有_________. A.数据结构 B.结构数据 C.内容结构 D.结构内容 8.结构化的数据,先有________,再有_________. A.数据结构 B.结构数据 C.内容结构 D.结构内容 9.软件是大数据的_________。 A.核心 B.部件 C.引擎 D.集合 10.大数据技术不包括( )。 A.数据计算 B.数据存储 C.数据冗余 D.数据采集 11.大数据的特点不包括()。 A.数量大 B.类型少 C.速度快 D.价值高 第二章Hadoop简介 1.下列对云栈架构层数不正确的一项为________。 A.三层云栈架构 B.四层云栈架构 C.五层云栈架构 D.六层云栈架构 2.下列______不是云计算三层架构的概括。 事业单位面试题及答案 答面试题是事业单位人力资源测评的一种重要方法,那你知道事业单位的面试会出什么题目吗?下面是由分享的事业单位面试题及答案,希望对你有用。 事业单位面试题及答案(一) 有人说,世界上有三种人。第一种,先知先觉,能够创造机会;第二种,善于抓住机会;第三种,既不能创造机会也不能把握机会。请问你是哪种人? 答案 第一,培根曾说过善于识别与把握时机是极为重要的。在一切大事上,人在开始做事前要象千眼神那样察知时机,而在进行时要象千手神那样抓住时机。 第二,我是一个普通的人,我不能每件事都去创造机会,但是在生活和工作中我会去寻找机会,为每一件事的成功做好铺垫。当机会来临的时候,我会主动抓住机会。西蒙说机会对于不能利用它的人又有什么用呢?正如风只对于能利用它的人才是动力。所以机会永远是给有准备的人。如果你没有准备,当机会来临的时候,你还没有反应,当机会消逝的时候你才发现原来机会曾经来过。生活中,工作中,我随时做好准备,做一个能够捕捉机会,能够抓住机会的人。 第三我是一个平凡的人,不属于每件事都先知先觉的人,也不属于让机会溜走的人。我相信机会永远只给有准备的人。有些事没有 机会我会创造机会,当机会来临的时候我会紧紧地抓住机会。因为我牢记:机会永远是给有准备的人的。 事业单位面试题及答案(二) 现在公务员报考很热,有人说这是一种社会的退步,你怎么看? 答案 随着我国社会经济进入转型期,在严峻的就业形势下,不高的考试成本和相对公正的录用程序使很多人将国家公务员考试作为职业规划的备选,而长期以来国家公务员队伍建设成效和明显的比较优势,也成为人们报考国家公务员的主要考虑因素。 第一,公务员录用考试制度实施以来,应该说取得了很大成绩,公开、平等、竞争、择优的原则得到了较好贯彻,较为全面地向社会开放公共职位,吸纳了大量的社会人才进入公共部门工作,公务员队伍的能力和效率得到了较为全面的提升,也正是这一改革成果使得公务员职位成为众多应届毕业生和社会人才最为关心的职业选择。 第二,近年来,由于就业压力的增大,公务员报考热进一步升温。特别是中央国家机关以及省市机关公务员职位更深得求职者青睐,这主要与这些地区或部门在户籍制度、生活条件、工作条件、薪酬水平、自我实现等方面所具有的比较优势有关。 第三,公务员这个社会岗位吸引了众多的人才,但是由于报考公务的人大多数都是应届毕业生,缺乏实际工作经验和对基层工作了解不多,往往在工作过程当中会出现工作效率低下,工作执行不到位的现象。在扩大公务员队伍招收的情况下,国家在考试过程当中应当 3.6 误) 3.7Hadoop支持数据的随机读写。(错) (8) NameNode负责管理metadata,client端每次读写请求,它都会从磁盘中3.8 读取或则会写入metadata信息并反馈client端。(错误) (8) NameNode本地磁盘保存了Block的位置信息。(个人认为正确,欢迎提出其它意见) (9) 3.9 3.10 3.11DataNode通过长连接与NameNode保持通信。(有分歧) (9) Hadoop自身具有严格的权限管理和安全措施保障集群正常运行。(错误)9 3.12 3.13 3.14Slave节点要存储数据,所以它的磁盘越大越好。(错误) (9) hadoop dfsadmin–report命令用于检测HDFS损坏块。(错误) (9) Hadoop默认调度器策略为FIFO(正确) (9) 100道常见Hadoop面试题及答案解析 目录 1单选题 (5) 1.1 1.2 1.3 1.4 1.5 1.6 1.7下面哪个程序负责HDFS数据存储。 (5) HDfS中的block默认保存几份? (5) 下列哪个程序通常与NameNode在一个节点启动? (5) Hadoop作者 (6) HDFS默认Block Size (6) 下列哪项通常是集群的最主要瓶颈: (6) 关于SecondaryNameNode哪项是正确的? (6) 2 3多选题 (7) 2.1 2.2 2.3 2.4 2.5 下列哪项可以作为集群的管理? (7) 配置机架感知的下面哪项正确: (7) Client端上传文件的时候下列哪项正确? (7) 下列哪个是Hadoop运行的模式: (7) Cloudera提供哪几种安装CDH的方法? (7) 判断题 (8) 3.1 3.2 3.3 Ganglia不仅可以进行监控,也可以进行告警。(正确) (8) Block Size是不可以修改的。(错误) (8) Nagios不可以监控Hadoop集群,因为它不提供Hadoop支持。(错误) 8 3.4如果NameNode意外终止,SecondaryNameNode会接替它使集群继续工作。(错误) (8) 3.5Cloudera CDH是需要付费使用的。(错误) (8) Hadoop是Java开发的,所以MapReduce只支持Java语言编写。(错 8面试考题及答案

Hadoop题库

运维面试题 含答案

软件实施 面试题(含答案)

大数据工程师面试题

hadoop练习题--带答案资料

2017年事业单位面试题及解析

Hadoop最全面试题整理(附目录)

(完整版)hadoop常见笔试题答案

2018年5月27日南京及各地市事业单位面试试题及解析

面试题目及其答案大全

大数据技术Hadoop面试题

最全的事业单位面试题及答案

公务员面试试题及答案

(完整版)hadoop习题册

事业单位面试题及答案

Hadoop 100道面试题及答案解析