机器学习算法优缺点改进总结

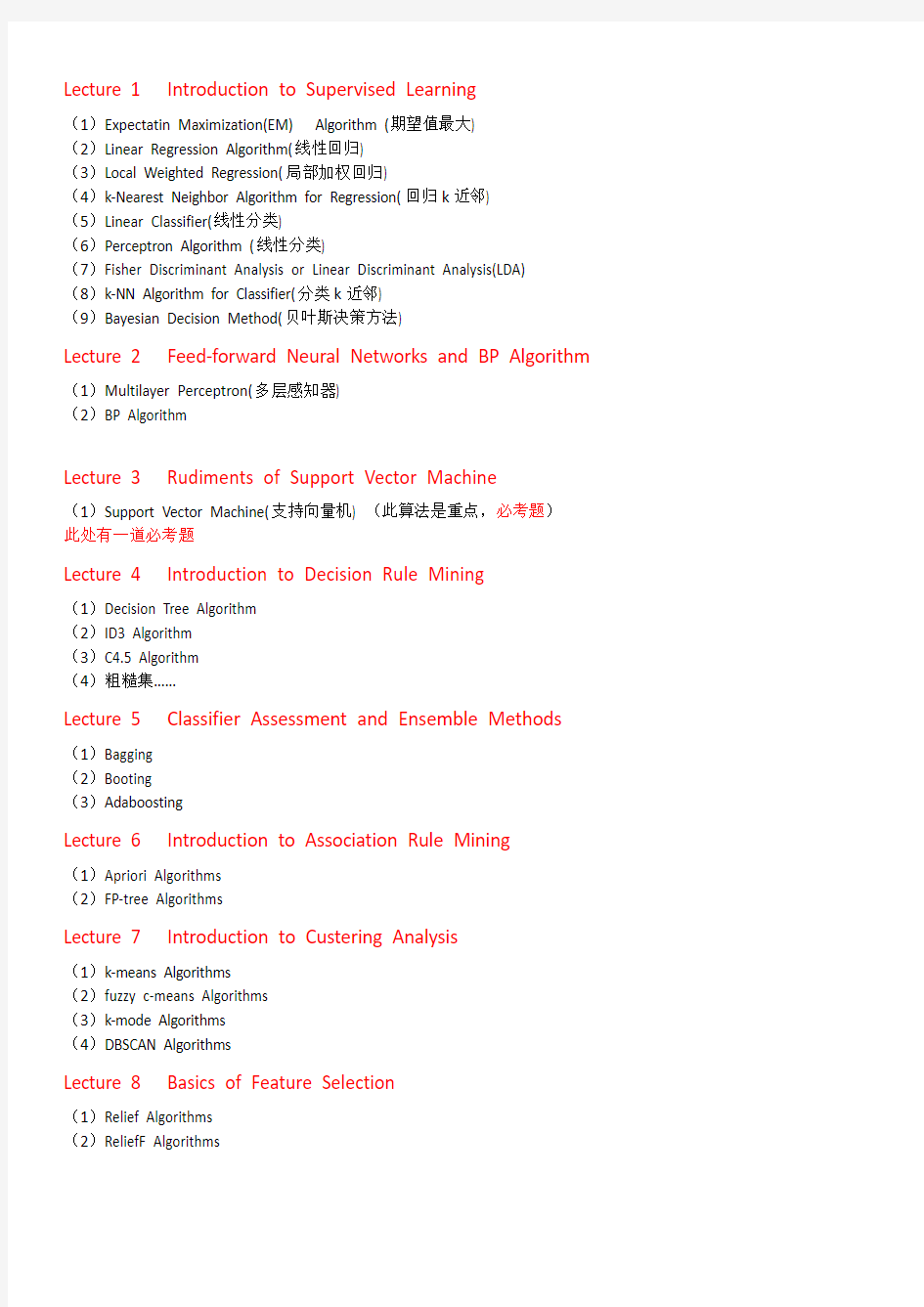

Lecture 1 Introduction to Supervised Learning

(1)Expectatin Maximization(EM) Algorithm (期望值最大)

(2)Linear Regression Algorithm(线性回归)

(3)Local Weighted Regression(局部加权回归)

(4)k-Nearest Neighbor Algorithm for Regression(回归k近邻)

(5)Linear Classifier(线性分类)

(6)Perceptron Algorithm (线性分类)

(7)Fisher Discriminant Analysis or Linear Discriminant Analysis(LDA)

(8)k-NN Algorithm for Classifier(分类k近邻)

(9)Bayesian Decision Method(贝叶斯决策方法)

Lecture 2 Feed-forward Neural Networks and BP Algorithm (1)Multilayer Perceptron(多层感知器)

(2)BP Algorithm

Lecture 3 Rudiments of Support Vector Machine

(1)Support Vector Machine(支持向量机) (此算法是重点,必考题)

此处有一道必考题

Lecture 4 Introduction to Decision Rule Mining

(1)Decision Tree Algorithm

(2)ID3 Algorithm

(3)C4.5 Algorithm

(4)粗糙集……

Lecture 5 Classifier Assessment and Ensemble Methods (1)Bagging

(2)Booting

(3)Adaboosting

Lecture 6 Introduction to Association Rule Mining

(1)Apriori Algorithms

(2)FP-tree Algorithms

Lecture 7 Introduction to Custering Analysis

(1)k-means Algorithms

(2)fuzzy c-means Algorithms

(3)k-mode Algorithms

(4)DBSCAN Algorithms

Lecture 8 Basics of Feature Selection

(1)Relief Algorithms

(2)ReliefF Algorithms

(3)mRMR Algorithms最小冗余最大相关算法

(4)attribute reduction Algorithms

比较了几种分类算法性质。(以下两个表格来自两篇该领域经典论文)

Lecture 1 Introduction to Supervised Learning

(1)Expectatin Maximization(EM) Algorithm (期望值最大)

①算法思想:

EM算法又称期望最大化算法,是对参数极大似然估计的一种迭代优化策略,它是一种可以从非完整的数据集中对参数进行极大似然估计的算法,应用于缺损数据,截尾数据,带有噪声的非完整数据。

最大期望算法经过两个步骤交替进行计算:

第一步计算期望(E):也就是将隐藏的变量对象能够观察到的一样包含在内,从而计算最大似然的期望值;

另外一步是最大化(M),也就是最大化在E步上找到的最大似然期望值,从而计算参数的似然估计。M 步上找到的参数然后用于另一个E步计算。

重复上面2步直至收敛。

②优点:1)M步仅涉及完全数据极大似然,通常计算比较简单

2)收敛是稳定的,因为每次迭代的似然函数是不断增加的。

③缺点:1)表现在对缺失数据较多或是多维高斯分布的情形下,计算量大,收敛速度较慢。

2)对于某些特殊的模型,要计算算法中的M步,即完成对似然函数的估计是比较困难的。

3)在某些情况下,要获得EM算法中E步的期望显式是非常困难的。

4)EM算法的收敛速度,非常依赖初始值的设置,设置不当,计算代价相当大。

5)EM算法中的M-Step依然是采用求导函数的方法,所以它找到的是极值点,即局

部最优解,而不一定是全局最优解。

④改进:针对1)改进:扩大参数空间来加快收敛

针对2)改进:ECM算法,该算法通过在M步构建计算比较简单的小循环对EM

算法进行了改进,从而使期望函数极大化更加容易和有效,从而解决这一问题。

针对3)改进:MCEM算法,将E步积分求期望用蒙特卡洛模拟方法来实现,使

得E步求期望更容易实现。

针对4)初始值的获取可以通过k-means算法,层次聚类算法或是数据数据进行随

机分割,然后重复EM效果进行初始点选择。

针对5)结合遗传算法的全局搜索能力,扩大EM算法的搜索空间,有效降低EM

算法对初始值的依赖度,改善局部最优值的缺陷。

(2)Linear Regression Algorithm(线性回归)

①算法思想:

线性回归(Linear Regression)是利用称为线性回归方程的最小平方函数对一个或多个自变量和因变量之间关系进行建模的一种回归分析。这种函数是一个或多个称为回归系数的模型参数的线性组合。只有一个自变量的情况称为简单回归,大于一个自变量情况的叫做多元回归。

回归模型:

其中 和C是未知参数,对于每个训练样本(x i,y i)可得到)

h,用来预测真实值y i。损失函数:

(x i

即误差值的平方。

1:对于训练集,求取θ,使得损失函数最小。(使用最小二乘法,梯度下降法)

2:对于新输入x,其预测输出为θTx

②优点:结果易于理解,实现简单,计算简单

③缺点:1)对于非线性的数据拟合效果不好(原因:因为线性回归将数据视为线性的,

可能出现欠拟合现象,导致结果不能取得最好的预测效果)

2)如果训练数据如果有些数据偏差特别大,这回造成最后训练的模型可能对整体数据都不具备很好的准确性

④改进:针对2)改进:局部加权回归

(3)Local Weighted Regression(局部加权回归)

①算法思想:

给每个待预测点周围的点赋予一定的权重,越近的点权重越高,以此来选出该预测点对应的数据子集,然后在此数据子集上基于最小均方差进行普通的回归.局部加权回归实质上是对于需要预测的点,只是根据其附近的点进行训练,其他的没有改变。

对于局部线性加权算法:

1:对于输入x,找到训练集中与x邻域的训练样本

2:对于其邻域的训练样本,求取θ,使得其∈x的邻域)最小。其中w(i)为权重值。

3.预测输出为θTx

4.对于新输入,重复1-3过程。

其中τ为带宽(bandwidth)常量,距离输入越远,权重越小,

反之越大。

②优点:1)局部加权回归还是对训练数据拟合的比较好

2)不太依赖特征的选择,而且只需要用线性模型就能够训练出不错的拟合模型、

③缺点:1)计算量较大。(因为局部加权回归的损失数随着预测值的不同而不同,这样θ

就无法事先确定,每次预测时都需要扫描所有的数据并重新计算θ)

2)局部加权回归容易出现过拟合现象,过拟合现象很明显

3)关注局部的训练数据,忽略了全局数据,如果预测点在出现偏差的训练数据附

近,那么预测值会偏差很大。

④改进:

(4)k-Nearest Neighbor Algorithm for Regression(回归k近邻)

①算法思想:

通过找出一个样本的k个最近邻居,将这些邻居的属性的平均值赋给该样本,就可以得到该样本的属性。更有用的方法是将不同距离的邻居对该样本产生的影响给予不同的权值(weight),如权值与距离成正比。

如果一个样本在特征空间中的k个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类别。

KNN算法不仅可以用于分类,还可以用于回归。通过找出一个样本的k个最近邻居,将这些邻居的属性的平均值赋给该样本,就可以得到该样本的属性。更有用的方法是将不同距离的邻居对该样本产生的影响给予不同的权值(weight),如权值与距离成反比。

②优点:

1)简单、有效。

2)重新训练的代价较低(类别体系的变化和训练集的变化,在Web环境和电子商务应用中是很常见的)。

3)计算时间和空间线性于训练集的规模(在一些场合不算太大)。

4)由于KNN方法主要靠周围有限的邻近的样本,而不是靠判别类域的方法来确定所属类别的,因此对于类域的交叉或重叠较多的待分样本集来说,KNN方法较其他方法更为适合。

5)该算法比较适用于样本容量比较大的类域的自动分类,而那些样本容量较小的类域采用这种算法比较容易产生误分。

③缺点:

(1)KNN在对属性较多的训练样本进行分类时,由于计算量大而使其效率大大降低,效果不是很理想。

(2)当样本不平衡时,如一个类的样本容量很大,而其他类样本容量很小时,有可能导致当输入一个新样本时,该样本的K个邻居中大容量类的样本占多数。

(3)对数据的局部结构比较敏感。如果查询点是位于训练集较密集的区域,那预测相对比其他稀疏集来说更准确。(4)对k值敏感。

(5)维数灾难:临近距离可能被不相干属性主导(因此特征选择问题)

④改进:

(1)分类效率:事先对样本属性进行约简,删除对分类结果影响较小的属性,快速的得出待分类样本的类别。该算法比较适用于样本容量比较大的类域的自动分类,而那些样本容量较小的类域采用这种算法比较容易产生误分。(2)分类效果:采用权值的方法(和该样本距离小的邻居权值大)来改进,Han等人于2002年尝试利用贪心法,针对文件分类实做可调整权重的k最近邻居法WAkNN (weighted adjusted k nearest neighbor),以促进分类效果;而Li等人于2004年提出由于不同分类的文件本身有数量上有差异,因此也应该依照训练集合中各种分类的文件数量,选取不同数目的最近邻居,来参与分类。

(3)该算法在分类时有个主要的不足是,当样本不平衡时,如一个类的样本容量很大,而其他类样本容量很小时,有可能导致当输入一个新样本时,该样本的K个邻居中大容量类的样本占多数。该算法只计算“最近的”邻居样本,某一类的样本数量很大,那么或者这类样本并不接近目标样本,或者这类样本很靠近目标样本。无论怎样,数量并不能影响运行结果。可以采用权值的方法(和该样本距离小的邻居权值大)来改进。

(4)K 值的选择会对算法的结果产生重大影响。K值较小意味着只有与输入实例较近的训练实例才会对预测结果起作用,但容易发生过拟合;如果K 值较大,优点是可以减少学习的估计误差,但缺点是学习的近似误差增大,这时与输入实例较远的训练实例也会对预测起作用,是预测发生错误。在实际应用中,K 值一般选择一个较小的数值,通常采用交叉验证的方法来选择最优的K 值。随着训练实例数目趋向于无穷和K=1 时,误差率不会超过贝叶斯误差率的2倍,如果K也趋向于无穷,则误差率趋向于贝叶斯误差率。

(5)该方法的另一个不足之处是计算量较大,因为对每一个待分类的文本都要计算它到全体已知样本的距离,才能求得它的K个最近邻点。目前常用的解决方法是事先对已知样本点进行剪辑,事先去除对分类作用不大的样本。

该算法比较适用于样本容量比较大的类域的自动分类,而那些样本容量较小的类域采用这种算法比较容易产生误分。

(5)Linear Classifier(线性分类器)

①算法思想:线性分类器使用线性判别函数,实现线性判别函数分类的方法有感知器算法、LMSE分类算法和Fisher 分类。

在分类问题中,因变量Y可以看做是数据的label,属于分类变量。所谓分类问题,就是能够在数据的自变量X空间内找到一些决策边界,把label不同的数据分开,如果某种方法所找出的这些决策边界在自变量X空间内是线性的,这时就说这种方法是一种线性分类器。

C1和C2是要区分的两个类别,在二维平面中它们的样本如上图所示。中间的直线就是一个分类函数,它可以将两类样本完全分开。

线性分类器在数学上被理解为线性判别函数(Linear Discriminant Functions),在几何上可以理解为决策超平面(Decision Hyperplanes)。

②优点:算法简单

③缺点:只能处理线性问题

④改进:要处理其他非线性问题,可以向高维转化,例如用SVM方法。线性分类器是分类方法,不是具体算法。(6)Perceptron Algorithm (感知器算法)

①算法思想:

感知机(Perceptron)是二类分类的线性分类模型,其输入为实例的特征向量,输出为实例的类别,取+1和-1二值。感知机对应于输入空间(特征空间)中将实例划分为正负两类的分离超平面,属于判别模型。

②优点:

(1)感知机学习算法是基于随机梯度下降法的对损失函数的最优化算法,有原始形式和对偶形式。算法简单且易于实现;

(2)它提出了自组织自学习的思想。对能够解决的问题有一个收敛的算法,并从数学上给出了严格的证明。

(3)当样本线性可分情况下,学习率合适时,算法具有收敛性。

③缺点:

(1)即感知机无法找到一个线性模型对异或问题进行划分。

(2)其实不光感知机无法处理异或问题,所有的线性分类模型都无法处理异或分类问题。

(3)收敛速度慢;当样本线性不可分情况下,算法不收敛,且无法判断样本是否线性可分。

④改进:单个感知器虽然无法解决异或问题,但却可以通过将多个感知器组合,实现复杂空间的分割。

(7)线性判别分析(LDA,Linear Discriminant Analysis)

①基础概念

(1)判别分析概念

根据已知对象的某些观测指标和所属类别来判断未知对象所属类别的统计方法。

利用已知类别的样本信息求判别函数,根据判别函数对未知样本所属类别进行判别。

(2)判别分析分类

按判别组数来分,有两组判别分析和多组判别分析

按数学模型(函数形式)来分,有线性判别分析和非线性判别分析

按判别方法来分,有Fisher判别分析、Bayes判别分析和距离判别(K-NN)

注:线性判别分析就是一般化的Fisher判别分析

(3)Fisher判别分析与Bayes判别分析优缺点比较

Fisher判别方法对总体分布没有特殊要求,但是Fisher判别法未考虑各总体出现概率的大小,不能给出后验概率以及错判造成的损失。

Bayes判别法可以给出后验概率以及错判造成的损失。但是要求即各种变量必须服从多元正态分布、各组协方差矩阵必须相等、各组变量均值均有显著性差异。

②LDA缺点

LDA有两个突出缺点:

(1)处理高维图像时容易产生“小样本问题”, 即样本维数大大超过训练图像个数的问题;

(2)由此引发的边缘类主导特征空间分解的问题。

(3)LDA的其余缺点(限制):

LDA至多可生成C-1维子空间。

LDA不适合对非高斯分布的样本进行降维。

LDA在样本分类信息依赖方差而不是均值时,效果不好。

LDA可能过度拟合数据。

③针对“小样本问题”的改进方法

可以利用本文设计的改进PCA 算法与LDA 算法相结合来解决小样本问题,即将结合了基于标准差和局部均值的图像增强处理算法的PCA 算法与LDA 算法相结合。具体的应用过程即为: 先采用改进的PCA 算法对样本进行降维处理,以便确保样本的类内离散度矩阵为非奇异的,利用改进的PCA 算法将原始样本图像往一个特征子空间中投影,从而使得样本的类内离散度矩阵是非奇异的。再利用LDA 算法在次特征子空间中求得最优变换。

LDA与PCA的比较

两者都是为了在对原始数据降维之后进行分类。PCA(Principal Component Analysis,主成分分析)是无监督的方式,它没有分类标签,降维之后需要采用K-Means或自组织映射网络等无监督的算法进行分类。LDA是有监督的方式,它先对训练数据进行降维,然后找出一个线性判别函数。

(8)k-NN(k-Nearest Neighbor for classifier,分类最近邻估计)

①算法思想:

(1)k-NN介绍

如果一个样本在特征空间中的k个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类别。KNN算法中,所选择的邻居都是已经正确分类的对象。该方法在定类决策上只依据最邻近的一个或者几个样本的类别来决定待分样本所属的类别。KNN方法虽然从原理上也依赖于极限定理,但在类别决策时,只与极少量的相邻样本有关。

(2)k-NN概念

k-NN算法通常以“欧氏距离(Euclidean Distance)”为其分类模型, 欧氏距离公式的定义如下:

设在n 维空间中有两个点X =(x1,x2,…,xn)和Y =(y1,y2,…,yn), 它们之间的欧氏距离定义为:

其中, n是维数, Xi和Yi分别是X和Y的第k个属性值。

②优点

(1)简单,易于理解,易于实现,无需估计参数,无需训练

(2)适合对稀有事件进行分类(例如当流失率很低时,比如低于0.5%,构造流失预测模型)

(3)特别适合于多分类问题(multi-modal,对象具有多个类别标签),例如根据基因特征来判断其功能分类,kNN比SVM的表现要好.

③缺点

(1)计算量大,由于要逐个计算到每条记录的欧氏距离, 对于海量数据, 该算法时间效率非常低。它在对每一个查询实例(Query Instance)进行分类时, 都需要搜索整个训练集来寻找最近邻, 所以它的运算开销巨大, 时间代价高昂, 这导致了它的运行速度非常低下。

(2)可解释性较差,无法给出决策树那样的规则。

(3)当样本不平衡时,如一个类的样本容量很大,而其他类样本容量很小时,有可能导致当输入一个新样本时,该样本的K个邻居中大容量类的样本占多数。该算法只计算“最近的”邻居样本,某一类的样本数量很大,那么或者这类样本并不接近目标样本,或者这类样本很靠近目标样本。无论怎样,数量并不能影响运行结果。

(4)由于所有属性均等地参与计算, 没有突出属性的重要程度, 分类结果易受单个属性的影响;

④改进

缺点1:目前常用的解决方法是事先对已知样本点进行剪辑,事先去除对分类作用不大的样本。该算法比较适用于样本容量比较大的类域的自动分类,而那些样本容量较小的类域采用这种算法比较容易产生误分。

缺点4:利用信息增益来衡量属性的重要程度(即属性权重系数) ,将属性划分为关键属性、次要属性及无关属性, 解决属性均等用力的问题;

缺点3,可考虑从K值设定回答

1、k值设定为多大?

k太小,分类结果易受噪声点影响;k太大,近邻中又可能包含太多的其它类别的点。(对距离加权,可以降低k 值设定的影响)

k值通常是采用交叉检验来确定(以k=1为基准)

经验规则:k一般低于训练样本数的平方根

补充去年相关习题:

请阐述kNN 近邻分类算法的基本思想,并分析它的主要优缺点。关于k 的取值,你有什么合理的建议(至少1 条)。

优点

(1)简单,易于理解,易于实现,无需估计参数,无需训练

(2)适合对稀有事件进行分类(例如当流失率很低时,比如低于0.5%,构造流失预测模型)

(3)特别适合于多分类问题,例如根据基因特征来判断其功能分类,kNN比SVM的表现要好

缺点

(1)懒惰算法,对测试样本分类时的计算量大,内存开销大,评分慢

(2)当样本不平衡时,如一个类的样本容量很大,而其他类样本容量很小时,有可能导致当输入一个新样本时,该样本的K个邻居中大容量类的样本占多数;

(3)可解释性较差,无法给出决策树那样的规则。

k值设定

k值选择过小,得到的近邻数过少,会降低分类精度,同时也会放大噪声数据的干扰;而如果k值选择过大,并且待分类样本属于训练集中包含数据数较少的类,那么在选择k个近邻的时候,实际上并不相似的数据亦被包含进来,造成噪声增加而导致分类效果的降低。

k太小,分类结果易受噪声点影响;k太大,近邻中又可能包含太多的其它类别的点。(对距离加权,可以降低k 值设定的影响)

K值设定的建议

k值通常是采用交叉检验来确定(以k=1为基准)

k一般低于训练样本数的平方根

(9)贝叶斯决策方法(Bayesian Decision Method)

①贝叶斯决策概念

贝叶斯决策(Bayesian Decision Theory)就是在不完全情报下,对部分未知的状态用主观概率估计,然后用贝叶斯公式对发生概率进行修正,最后再利用期望值和修正概率做出最优决策。

贝叶斯决策属于风险型决策,决策者虽不能控制客观因素的变化,但却掌握其变化的可能状况及各状况的分布概率,并利用期望值即未来可能出现的平均状况作为决策准则。

贝叶斯决策理论方法是统计模型决策中的一个基本方法,其基本思想是:

已知类条件概率密度参数表达式和先验概率。

利用贝叶斯公式转换成后验概率。

根据后验概率大小进行决策分类。

②贝叶斯决策方法优缺点

优点:

贝叶斯决策能对信息的价值或是否需要采集新的信息做出科学的判断

它能对调查结果的可能性加以数量化的评价,而不是像一般的决策方法那样,对调查结果或者是完全相信,或者是

完全不相信

如果说任何调查结果都不可能完全准确,先验知识或主观概率也不是完全可以相信的,那么贝叶斯决策则巧妙地将这两种信息有机地结合起来了

它可以在决策过程中根据具体情况下不断地使用,使决策逐步完善和更加科学

缺点:

它需要的数据多,分析计算比较复杂,特别在解决复杂问题时,这个矛盾就更为突出

有些数据必须使用主观概率,有些人不太相信,这也妨碍了贝叶斯决策方法的推广使用

③贝叶斯决策改进方法

将决策问题转化成收益矩阵,通过对收益矩阵的分析,得出各行动方案的期望值,按照一定的准则选出最优方案。

以各状况下最大收益值或效用值为基础,求出MaxE(x),以此作为完全确定情况下的收益值,用该值减去最优方案的期望值得出完全信息价值(EVPⅠ),根据完全信息期望值判断是否需要补充信息量。

在第2步得到肯定回答后,首先在预先后验分析中从理论上把各种可能的抽样方案及结果列举出来,计算各种抽样方案的抽样信息期望值EVSI=EVPI-R(n),其中R(n)为抽样风险,其大小是样本大小的函数。

以EVSI-C(其中C为抽样成本)作为标准选取最大值对应的抽样方案为最优抽样方案。

按照理论上得出的最优抽样方案进行抽样,然后,根据贝叶斯理论公式推导出后验概率分布的数字描述,最后,以此为依据按照贝叶斯决策准则选出最优方案。

补充朴素贝叶斯

朴素贝叶斯模型发源于古典数学理论,有着坚实的数学基础,以及稳定的分类效率。

同时,NBC模型所需估计的参数很少,对缺失数据不太敏感,算法也比较简单。理论上,NBC模型与其他分类方法相比具有最小的误差率。但是实际上并非总是如此,这是因为NBC模型假设属性之间相互独立,这个假设在实际应用中往往是不成立的,这给NBC模型的正确分类带来了一定影响。在属性个数比较多或者属性之间相关性较大时,NBC模型的分类效率比不上决策树模型。而在属性相关性较小时,NBC模型的性能最为良好。

补充朴素贝叶斯优点:

1)朴素贝叶斯算法是基于贝叶斯理论,逻辑清楚明了

2)本算法进行分类是,时间快,在内存上需要的也不大

3)本算法鲁棒性高,即使数据包含的噪声点,无关属性和缺失值的属性,分类性能不好又太大的变化,健壮性好

补充朴素贝叶斯算法缺点:

1)朴素贝叶斯算法要求样本各属性直接是独立的,而真实的数据符合这个条件很少。

2)当样本数据少时,分类器可能会无法正确分类

Lecture 2 Feed-forward Neural Networks and BP Algorithm

(1)Multilayer Perceptron(多层感知器)

①算法思想

多层感知器(Multilayer Perceptron,缩写MLP)是一种前向结构的人工神经网络。MLP算法一般包括三层,分别是一个输入层,一个输出层和一个或多个隐藏层的神经网络组成。一个“神经元”的输出就可以是另一个“神经元”的输入。MLP可以被看作是一个有向图,由多个的节点层所组成,每一层都全连接到下一层。除了输入节点,每个神经元都有几个输入和输出神经元,每个神经元通过输入权重加上偏置计算输出值,并选择一种激活函数进行转换。一种被称为反向传播算法(BP)的监督学习方法常被用来训练MLP。MLP是感知器的推广,克服了感知器不能对线性不可分数据进行识别的弱点。

激活函数

若每个神经元的激活函数都是线性函数,那么,任意层数的MLP都可被约简成一个等价的单层感知器。实际上,MLP本身可以使用任何形式的激活函数,但为了使用反向传播算法进行有效学习,激活函数必须限制为可微函数。由于具有良好可微性,很多乙形函数,尤其是双曲正切函数(Hyperbolic tangent)及逻辑乙形函数(logistic sigmoid function),被采用为激活函数。激活函数常见的有三种,分别是恒等函数,Sigmoid函数和高斯函数。

②优点:

(1)高度的并行性

人工神经网络是由许多相同的简单处理单元并联组合而成,虽然每个单元的功能简单,但大量简单单元的并行活动,使其对信息的处理能力与效果惊人。

(2)高度的非线性全局作用

神经网络系统是由大量简单神经元构成的,每个神经元接受大量其他神经元的输入,通过非线性输入、输出关系,产生输出影响其它神经元。网络就是这样互相制约相互影响,实现从输入状态空间到输出状态空间非线性映射的。网络的演化遵从全局性作用原则,从输入状态演化到终态而输出。从全局观点来看,网络整体性能不是网络局部性能的简单迭加,而表现某种集体性行为;而电脑遵从串行式局域性操作原则,每一步计算与上一步计算紧密相关,并对下一步产生影响,问题是通过算法逐步进行处理的。

(3)良好的容错性与联想记忆功能

人工神经网络通过自身的网络结构能够实现对信息的记忆,而所记忆的信息是存储在神经元之间的权值中。从单个权值中看不出所储存的信息内容,因而是分布式的存储方式。这使得网络具有良好的容错性,并能进行聚类分析、特征提取、缺损模式复原等模式信息处理工作。

(4)十分强的自适应、自学习功能人工神经网络可以通过训练和学习来获得网络的权值与结构,呈现出很强的自学习能力和对环境的自适应能力。

③缺点

(1)网络的隐含节点个数选取问题至今仍是一个世界难题;

(2)停止阈值、学习率、动量常数需要采用”trial-and-error”法,极其耗时(动手实验);

(3)学习速度慢;

(4)容易陷入局部极值,学习不够充分。

④改进

(1)改进BP算法(见bp)

(2)权值初始化

在初始化权值的时候,我们一般需要它们在0附近,要足够小(在激活函数的近似线性区域可以获得最大的梯度)。另一个特性,尤其对深度网络而言,是可以减小层与层之间的激活函数的方差和反向传导梯度的方差。这就可以让信息更好的向下和向上的传导,减少层间差异。

(3)学习率

随着时间的推移减小学习速率有时候也是一个好主意。一个简单的方法是使用这个公式:u/(1+d*t),u是初始速率(可以使用上面讲的网格搜索选择),d是减小常量,用以控制学习速率,可以设为0.001或者更小,t是迭代次数或者时间。可以基于分类错误率自适应的选择学习率。

(4)隐藏节点数

这个参数是非常基于数据集的。模糊的来说就是,输入分布越复杂,去模拟它的网络就需要更大的容量,那么隐藏单元的数目就要更大。

(5)正则化参数

典型的方法是使用L1/L2正则化。

L2正则化就是在代价函数后面再加上一个正则化项:

C0代表原始的代价函数,后面那一项就是L2正则化项,它是这样来的:所有参数w的平方的和,除以训练集的样本大小n。λ就是正则项系数,权衡正则项与C0项的比重。另外还有一个系数1/2,1/2经常会看到,主要是为了后面求导的结果方便,后面那一项求导会产生一个2,与1/2相乘刚好凑整。

过拟合,就是拟合函数需要顾忌每一个点,最终形成的拟合函数波动很大。在某些很小的区间里,函数值的变化很剧烈。这就意味着函数在某些小区间里的导数值(绝对值)非常大,由于自变量值可大可小,所以只有系数足够大,才能保证导数值很大。而正则化是通过约束参数的范数使其不要太大,所以可以在一定程度上减少过拟合情况。

L1正则化项就是在原始的代价函数后面加上一个正则化项,即所有权重w的绝对值的和,乘以λ/n(这里不像L2正则化项那样):

比原始的更新规则多出了η *λ * sgn(w)/n这一项。当w为正时,更新后的w变小。当w为负时,更新后的w 变大——因此它的效果就是让w往0靠,使网络中的权重尽可能为0,也就相当于减小了网络复杂度,防止过拟合。(2)BP Algorithm

①算法思想

BP算法是一种有监督式的学习算法,其主要思想是:输入学习样本,使用反向传播算法对网络的权值和偏差进行反复的调整训练,使输出的向量与期望向量尽可能地接近,当网络输出层的误差平方和小于指定的误差时训练完成,保存网络的权值和偏差。

②优点:

(1)网络实质上实现了一个从输入到输出的映射功能,而数学理论已证明它具有实现任何复杂非线性映射的功能。这使得它特别适合于求解内部机制复杂的问题;

(2)网络能通过学习带正确答案的实例集自动提取“合理的”求解规则,即具有自学习能力;

(3)网络具有一定的推广、概括能力。

③缺点

主要包括以下几个方面的问题。

(1)由于学习速率是固定的,因此网络的收敛速度慢,需要较长的训练时间。对于一些复杂问题,BP算法需要的训练时间可能非常长,这主要是由于学习速率太小造成的。

(2)BP算法可以使权值收敛到某个值,但并不保证其为误差平面的全局最小值,这是因为采用梯度下降法可能产生一个局部最小值

(3)网络隐含层的层数和单元数的选择尚无理论上的指导,一般是根据经验或者通过反复实验确定。因此,网络往往存在很大的冗余性,在一定程度上也增加了网络学习的负担。

(4)网络的学习和记忆具有不稳定性。也就是说,如果增加了学习样本,训练好的网络就需要从头开始训练,对于以前的权值和阈值是没有记忆的。但是可以将预测、分类或聚类做的比较好的权值保存。

(5)网络的预测能力(也称泛化能力、推广能力)与训练能力(也称逼近能力、学习能力)的矛盾。一般情况下,训练能力差时,预测能力也差,并且一定程度上,随训练能力地提高,预测能力也提高。但这种趋势有一个极限,当达到此极限时,随训练能力的提高,预测能力反而下降,即出现所谓“过拟合”现象。此时,网络学习了过多的样本细节,而不能反映样本内含的规律。

(6)网络训练失败的可能性较大,其原因有:

a 从数学角度看,BP算法为一种局部搜索的优化方法,但它要解决的问题为求解复杂非线性函数的全局极值,因此,算法很有可能陷入局部极值,使训练失败;

b 网络的逼近、推广能力同学习样本的典型性密切相关,而从问题中选取典型样本实例组成训练集是一个很困难的问题。

④改进

1 .变步长法

BP算法的有效性和收敛性在很大程度上取决于学习步长η的值。采用一般的固定长梯度下降法求解时,起码可能导致两个主要问题:局部极小解;收敛速度慢。所以,一般要求是,当训练到误差曲面的平坦区时,梯度较小,为加快收敛应使η增大;当训练到深而窄的误差曲面时,应使η减小,以免因步长过大而出现振荡现象。为加快收敛,应使η合理化,可采用变步长算法。变步长算法的基本思想是,先设一个初始步长η,若一次迭代后误差增大,则将步长乘以β(<1),沿原方向重新计算该迭代点;若一次迭代后误差减小,则将步长乘以α(>1),计算下一个迭代点,以缩短学习时间。

2. 加动量项法

为了加速BP算法的收敛,可考虑在权值调整算式中加入动量项,即

式中,α为动量因子,一般取0.1~0.8。这时权值修正量加上了有关上一时刻权值修改方向的记忆,加速了网络的收敛。加动量项法的具体原理:若相邻两次迭代点处的梯度方向是一致的,引入动量项可使权值的调整量增大,从而加速收敛;若相邻两次迭代点处的梯度方向相反,引入动量项可使权值的调整量减小,避免了来回振荡,加快了收敛。

3. 串连法

BP算法的收敛速度主要取决于输入-输出模式间非线性映射的复杂程度。显然,这种非线性映射关系越复杂,收敛时间越长。因此,对那些高度复杂的非线性问题,用两个串连的BP网络代替一个BP网络,能够有效地缩短训练时间。

4. 利用遗传算法优化BP算法

BP算法的优点是寻优具有精确性,但它易陷入局部极小、收敛速度慢,而遗传算法(GeneticAlgorithm,GA)是基于自然选择和遗传规律的全局优化搜索算法,具有很强的宏观搜索能力和寻优全局性。因此,在BP神经网络理论中引入遗传算法的思想,则可以很好地达到全局寻优和快速高效的目的。

Lecture 3 Rudiments of Support Vector Machine

(1)Support Vector Machine(支持向量机) (此算法是重点,必考题)

①算法思想

SVM的主要思想是针对两类分类问题,寻找一个超平面作为两类训练样本点的分割,以保证最小的分类错误率。在线性可分的情况下,存在一个或多个超平面使得训练样本完全分开,SVM的目标是找到其中的最优超平面,最优超平面是使得每一类数据与超平面距离最近的向量与超平面之间的距离最大的这样的平面,对于线性不可分的情况,通过使用核函数(一种非线性映射算法)将低维输入空间线性不可分的样本转化为高维特征空间使其线性可分。

②优点

(1)小样本,并不是说样本的绝对数量少(实际上,对任何算法来说,更多的样本几乎总是能带来更好的效果),而是说与问题的复杂度比起来,SVM算法要求的样本数是相对比较少的。

(2)非线性,是指SVM擅长应付样本数据线性不可分的情况,主要通过松弛变量(也有人叫惩罚变量)和核函数技术来实现,

(3)高维模式识别是指样本维数很高,例如文本的向量表示,如果没有经过降维处理,出现几万维的情况很正常,其他算法基本就没有能力应付了,SVM却可以,主要是因为SVM 产生的分类器很简洁,用到的样本信息很少(仅仅用到那些称之为“支持向量”的样本,此为后话),使得即使样本维数很高,也不会给存储和计算带来大麻烦(相对照而言,kNN算法在分类时就要用到所有样本,样本数巨大,每个样本维数再一高,这日子就没法过了……)。

③缺点

(1)SVM算法对大规模训练样本难以实施由于SVM是借助二次规划来求解支持向量,而求解二次规划将涉及m阶矩阵的计算(m为样本的个数),当m数目很大时该矩阵的存储和计算将耗费大量的机器内存和运算时间。

(2)用SVM解决多分类问题存在困难

④改进:

经典的支持向量机算法只给出了二类分类的算法,而在数据挖掘的实际应用中,一般要解决多类的分类问题。

可以通过多个二类支持向量机的组合来解决。

主要有

一对多组合模式、一对一组合模式和SVM决策树;

再就是通过构造多个分类器的组合来解决。

主要原理是克服SVM固有的缺点,结合其他算法的优势,解决多类问题的分类精度。

如:

与粗集理论结合,形成一种优势互补的多类问题的组合分类器。

此处有一道必考题

Lecture 4 Introduction to Decision Rule Mining

(1)ID3 Algorithm

①算法思想:

补充:

ID3算法(Iterative Dichotomiser 3 迭代二叉树3代)是一个由Ross Quinlan发明的用于决策树的算法。这个算法便是:从信息论知识中我们知道,期望信息越小,信息增益越大,从而纯度越高。ID3算法的核心思想就是以信息增益度量属性选择,选择分裂后信息增益最大的属性进行分裂。该算法采用自顶向下的贪婪搜索遍历可能的决策树空间。

所以,ID3的思想便是:

自顶向下的贪婪搜索遍历可能的决策树空间构造决策树(此方法是ID3算法和C4.5算法的基础);

从“哪一个属性将在树的根节点被测试”开始;

使用统计测试来确定每一个实例属性单独分类训练样例的能力,分类能力最好的属性作为树的根结点测试(如何定义或者评判一个属性是分类能力最好的呢?这便是下文将要介绍的信息增益,or 信息增益率)。

然后为根结点属性的每个可能值产生一个分支,并把训练样例排列到适当的分支(也就是说,样例的该属性值对应的分支)之下。

重复这个过程,用每个分支结点关联的训练样例来选取在该点被测试的最佳属性。

②优点:

(1)分类精度高;

(2)实现比较简单,产生的规则如果用图表示出来的话,清晰易懂;

优点补充:

(4)ID3算法的假设空间包含了所有的决策树,不存在无解风险

(5)ID3算法非常适合处理离散样本数据,利用属性结果提取分类规则,且容易理解

(6)引进了信息论的中的熵,使得算法得到结点最少的决策树

③缺点:

(1)ID3算法往往偏向于选择取值较多的属性,而在很多情况下取值较多的属性并不总是最重要的属性,即按照使熵值最小的原则被ID3算法列为应该首先判断的属性在现实情况中却并不一定非常重要。例如:在银行客户分析中,姓名属性取值多,却不能从中得到任何信息。(简略写:由于使用信息增益,会在属性选择时偏向选择取值多的属性)

(2)ID3算法对于噪声数据敏感,ID3算法不能处理具有连续值的属性,也不能处理具有缺失数据的属性。

(3)用互信息作为选择属性的标准存在一个假设,即训练子集中的正、反例的比例应与实际问题领域中正、反例的比例一致。一般情况很难保证这两者的比例一致,这样计算训练集的互信息就会存在偏差。

(4)在建造决策树时,每个结点仅含一个属性,是一种单变元的算法,致使生成的决策树结点之间的相关性不够强。虽然在一棵树上连在一起,但联系还是松散的。

(5)ID3算法虽然理论清晰,但计算比较复杂,在学习和训练数据集的过程中机器内存占用率比较大,耗费资源。(计算复杂,有很多对数计算)

(6)ID3不够健壮,当有一个项数据有改变时,整棵树的结构可能改变很大。

改进:用R-C4.5的思想,在进行测试属性选择时,合并分类贡献小的分支,避免出现过细的分枝,提高树的健壮性。补充:

(7)当训练集增加或减少的时候,决策树都会随之改变,对渐进学习不方便。

④改进:

(1)对决策树进行剪枝。可以采用交叉验证法和加入正则化的方法。

(2)使用基于决策树的combination算法,如bagging算法,randomforest算法,可以解决过拟合的问题

(3)引入用户兴趣度

给定a(0≤a≤1)为用户对不确定知识的兴趣度,a的大小由决策者根据先验知识或领域知识来确定。它是一个模糊的概念,通常指关于某一事务的先验知识,包括领域知识和专家建议,具体到决策树学习中则是指在决策树训练过程中除了用于生成和修改决策树的实例集之外的所有影响决策树规则生成和选择的因素。

(2)C4.5 Algorithm

补充:

既然说C4.5算法是ID3的改进算法,那么C4.5相比于ID3改进的地方有哪些呢?

用信息增益率来选择属性。ID3选择属性用的是子树的信息增益,这里可以用很多方法来定义信息,ID3使用的是熵(entropy,熵是一种不纯度度量准则),也就是熵的变化值,而C4.5用的是信息增益率。对,区别就在于一个是信息增益,一个是信息增益率。(因此,C4.5克服了ID3用信息增益选择属性时偏向选择取值多的属性的不足。)

在树构造过程中进行剪枝,在构造决策树的时候,那些挂着几个元素的节点,不考虑最好,不然容易导致overfitting。对非离散数据也能处理。

能够对不完整数据进行处理

①算法思想:

②优点:

(1)产生的分类规则易于理解,准确率较高。

(2)对非离散数据也能处理。

C4.5既可以处理离散型描述属性,也可以处理连续性描述属性。在选择某节点上的分枝属性时,对于离散型描述属性,C4.5的处理方法与ID3相同,按照该属性本身的取值个数进行计算;对于某个连续性描述属性Ac,假设在某个结点上的数据集的样本数量为total,C4.5将作以下处理。

1)将该结点上的所有数据样本按照连续型描述属性的具体数值,由小到大进行排序,得到属性值的取值序列{A1c,A2c,……Atotalc}。

2)在取值序列中生成total-1个分割点。第i(0 3)从total-1个分割点中选择最佳分割点。对于每一个分割点划分数据集的方式,C4.5计算它的信息增益比,并且从中选择信息增益比最大的分割点来划分数据集。 (3)能够对不完整数据进行处理。 在某些情况下,可供使用的数据可能缺少某些属性的值。假如〈x,c(x)〉是样本集S中的一个训练实例,但是其属 性A的值A(x)未知。处理缺少属性值的一种策略是赋给它结点n所对应的训练实例中该属性的最常见值;另外一种更复杂的策略是为A的每个可能值赋予一个概率。例如,给定一个布尔属性A,如果结点n包含6个已知A=1和4个A=0的实例,那么A(x)=1的概率是0.6,而A(x)=0的概率是0.4。于是,实例x的60%被分配到A=1的分支,40%被分配到另一个分支。这些片断样例(fractional examples)的目的是计算信息增益,另外,如果有第二个缺少值的属性必须被测试,这些样例可以在后继的树分支中被进一步细分。C4.5就是使用这种方法处理缺少的属性值。(4)克服了用信息增益来选择属性时偏向选择值多的属性的不足。 (5)采用了一种后剪枝方法 避免树的高度无节制的增长,避免过度拟合数据,该方法使用训练样本集本身来估计剪枝前后的误差,从而决定是否真正剪枝。方法中使用的公式如下: 其中N是实例的数量,f=E/N为观察到的误差率(其中E为N个实例中分类错误的个数),q为真实的误差率,c 为置信度(C4.5算法的一个输入参数,默认值为0.25),z为对应于置信度c的标准差,其值可根据c的设定值通过查正态分布表得到。通过该公式即可计算出真实误差率q的一个置信度上限,用此上限为该节点误差率e做一个悲观的估计: 通过判断剪枝前后e的大小,从而决定是否需要剪枝。 树剪枝 在决策树的创建时,由于数据中的噪声和离群点,许多分枝反映的是训练数据中的异常。剪枝方法是用来处理这种过分拟合数据的问题。通常剪枝方法都是使用统计度量,剪去最不可靠的分枝。 剪枝一般分两种方法:先剪枝和后剪枝。 先剪枝方法中通过提前停止树的构造(比如决定在某个节点不再分裂或划分训练元组的子集)而对树剪枝。一旦停止,这个节点就变成树叶,该树叶可能取它持有的子集最频繁的类作为自己的类。先剪枝有很多方法,比如(1)当决策树达到一定的高度就停止决策树的生长;(2)到达此节点的实例具有相同的特征向量,而不必一定属于同一类,也可以停止生长(3)到达此节点的实例个数小于某个阈值的时候也可以停止树的生长,不足之处是不能处理那些数据量比较小的特殊情况(4)计算每次扩展对系统性能的增益,如果小于某个阈值就可以让它停止生长。先剪枝有个缺点就是视野效果问题,也就是说在相同的标准下,也许当前扩展不能满足要求,但更进一步扩展又能满足要求。这样会过早停止决策树的生长。 另一种更常用的方法是后剪枝,它由完全成长的树剪去子树而形成。通过删除节点的分枝并用树叶来替换它。树叶一般用子树中最频繁的类别来标记。 C4.5采用悲观剪枝法,它使用训练集生成决策树又用它来进行剪枝,不需要独立的剪枝集。 悲观剪枝法的基本思路是:设训练集生成的决策树是T,用T来分类训练集中的N的元组,设K为到达某个叶子节点的元组个数,其中分类错误地个数为J。由于树T是由训练集生成的,是适合训练集的,因此J/K不能可信地估 计错误率。所以用(J+0.5)/K来表示。设S为T的子树,其叶节点个数为L(s),为到达此子树的叶节点的元组 个数总和,为此子树中被错误分类的元组个数之和。在分类新的元组时,则其错误分类个数为 ,其标准错误表示为:。当用此树分类训练集时,设E 为分类错误个数,当下面的式子成立时,则删掉子树S,用叶节点代替,且S的子树不必再计算。 ③缺点: (1)构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算法的低效。 (2)C4.5只适合于能够驻留于内存的数据集,当训练集大得无法在内存容纳时程序无法运行。 (3)在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算法的低效。 ④改进: (1)SLIQ算法 SLIQ算法对C4.5决策树分类算法的实现方法进行了改进,在决策树的构造过程中采用了“预排序”和“广度优先策略”两种技术。 1)预排序。对于连续属性在每个内部结点寻找其最优分裂标准时,都需要对训练集按照该属性的取值进行排序,而排序是很浪费时间的操作。为此,SLIQ算法采用了预排序技术。所谓预排序,就是针对每个属性的取值,把所有的记录按照从小到大的顺序进行排序,以消除在决策树的每个结点对数据集进行的排序。具体实现时,需要为训练数据集的每个属性创建一个属性列表,为类别属性创建一个类别列表。 2)广度优先策略。在C4.5算法中,树的构造是按照深度优先策略完成的,需要对每个属性列表在每个结点处都进行一遍扫描,费时很多,为此,SLIQ采用广度优先策略构造决策树,即在决策树的每一层只需对每个属性列表扫描一次,就可以为当前决策树中每个叶子结点找到最优分裂标准。 SLIQ算法由于采用了上述两种技术,使得该算法能够处理比C4.5大得多的训练集,在一定范围内具有良好的随记录个数和属性个数增长的可伸缩性。 然而它仍然存在如下缺点: 1)由于需要将类别列表存放于内存,而类别列表的元组数与训练集的元组数是相同的,这就一定程度上限制了可以处理的数据集的大小。 2)由于采用了预排序技术,而排序算法的复杂度本身并不是与记录个数成线性关系,因此,使得SLIQ算法不可能达到随记录数目增长的线性可伸缩性。 (2)SPRINT算法 为了减少驻留于内存的数据量,SPRINT算法进一步改进了决策树算法的数据结构,去掉了在SLIQ中需要驻留于内存的类别列表,将它的类别列合并到每个属性列表中。这样,在遍历每个属性列表寻找当前结点的最优分裂标准时,不必参照其他信息,将对结点的分裂表现在对属性列表的分裂,即将每个属性列表分成两个,分别存放属于各个结点的记录。 SPRINT算法的优点是在寻找每个结点的最优分裂标准时变得更简单。其缺点是对非分裂属性的属性列表进行分裂变得很困难。解决的办法是对分裂属性进行分裂时用哈希表记录下每个记录属于哪个孩子结点,若内存能够容纳下整个哈希表,其他属性列表的分裂只需参照该哈希表即可。由于哈希表的大小与训练集的大小成正比,当训练集很大时,哈希表可能无法在内存容纳,此时分裂只能分批执行,这使得SPRINT算法的可伸缩性仍然不是很好。 5 (3)随机森林(Random Forest)(对C4.5,ID3改进,提高准确率) 随机森林是一个最近比较火的算法,它有很多的优点: 在数据集上表现良好 在当前的很多数据集上,相对其他算法有着很大的优势 它能够处理很高维度(feature很多)的数据,并且不用做特征选择 在训练完后,它能够给出哪些feature比较重要 在创建随机森林的时候,对generlization error使用的是无偏估计 训练速度快 在训练过程中,能够检测到feature间的互相影响 容易做成并行化方法 实现比较简单 随机森林顾名思义,是用随机的方式建立一个森林,森林里面有很多的决策树组成,随机森林的每一棵决策树之间是没有关联的。在得到森林之后,当有一个新的输入样本进入的时候,就让森林中的每一棵决策树分别进行一下判断,看看这个样本应该属于哪一类(对于分类算法),然后看看哪一类被选择最多,就预测这个样本为那一类。 在建立每一棵决策树的过程中,有两点需要注意–采样与完全分裂。首先是两个随机采样的过程,random forest 对输入的数据要进行行、列的采样。对于行采样,采用有放回的方式,也就是在采样得到的样本集合中,可能有重复的样本。假设输入样本为N个,那么采样的样本也为N个。这样使得在训练的时候,每一棵树的输入样本都不是全部的样本,使得相对不容易出现over-fitting。然后进行列采样,从M个feature中,选择m个(m << M)。之后就 是对采样之后的数据使用完全分裂的方式建立出决策树,这样决策树的某一个叶子节点要么是无法继续分裂的,要么里面的所有样本的都是指向的同一个分类。一般很多的决策树算法都一个重要的步骤–剪枝,但是这里不这样干,由于之前的两个随机采样的过程保证了随机性,所以就算不剪枝,也不会出现over-fitting。 按这种算法得到的随机森林中的每一棵都是很弱的,但是大家组合起来就很厉害了。我觉得可以这样比喻随机森林算法:每一棵决策树就是一个精通于某一个窄领域的专家(因为我们从M个feature中选择m让每一棵决策树进行学习),这样在随机森林中就有了很多个精通不同领域的专家,对一个新的问题(新的输入数据),可以用不同的角度去看待它,最终由各个专家,投票得到结果。 随机森林的过程请参考Mahout的random forest 。这个页面上写的比较清楚了,其中可能不明白的就是Information Gain,可以看看之前推荐过的Moore的页面。 Lecture 5 Classifier Assessment and Ensemble Methods 1、bagging bagging是一种用来提高学习算法准确度的方法,这种方法通过构造一个预测函数系列,然后以一定的方式将它们组合成一个预测函数。 ?基本思想 1.给定一个弱学习算法,和一个训练集; 2.单个弱学习算法准确率不高; 3.将该学习算法使用多次,得出预测函数序列,进行投票; 4.最后结果准确率将得到提高. Bagging要求“不稳定”(不稳定是指数据集的小的变动能够使得分类结果的显著的变动)的分类方法。比如:决策树,神经网络算法 2、Booting Boosting方法是一种用来提高弱分类算法准确度的方法,这种方法通过构造一个预测函数系列,然后以一定的方式将他们组合成一个预测函数。Boosting是一种提高任意给定学习算法准确度的方法。他是一种框架算法,主要是通过对样本集的操作获得样本子集,然后用弱分类算法在样本子集上训练生成一系列的基分类器。可以用来提高其他弱分类算法的识别率。 Bagging与Boosting的区别 二者的主要区别是取样方式不同。Bagging采用均匀取样,而Boosting根据错误率来取样,因此Boosting的分类精度要优于Bagging。Bagging的训练集的选择是随机的,各轮训练集之间相互独立,而Boostlng的各轮训练集的选择与前面各轮的学习结果有关;Bagging的各个预测函数没有权重,而Boosting是有权重的;Bagging的各个预测函数可以并行生成,而Boosting的各个预测函数只能顺序生成。对于象神经网络这样极为耗时的学习方法。Bagging 可通过并行训练节省大量时间开销。 bagging和boosting都可以有效地提高分类的准确性。在大多数数据集中,boosting的准确性比bagging高。在有些数据集中,boosting会引起退化--- Overfit。 Boosting思想的一种改进型AdaBoost方法在邮件过滤、文本分类方面都有很好的性能。 3、Adaboost(Adaptive Boosting) 算法简介 Adaboost是一种迭代算法,其核心思想是针对同一个训练集训练不同的分类器(弱分类器),然后把这些弱分类器集合起来,构成一个更强的最终分类器(强分类器)。其算法本身是通过改变数据分布来实现的,它根据每次训练集之中每个样本的分类是否正确,以及上次的总体分类的准确率,来确定每个样本的权值。将修改过权值的新数据集送给下层分类器进行训练,最后将每次训练得到的分类器最后融合起来,作为最后的决策分类器。使用adaboost分类器可以排除一些不必要的训练数据特征,并放在关键的训练数据上面。 算法分析 该算法其实是一个简单的弱分类算法提升过程,这个过程通过不断的训练,可以提高对数据的分类能力。整个过程如下所示: 1. 先通过对N个训练样本的学习得到第一个弱分类器; 2. 将分错的样本和其他的新数据一起构成一个新的N个的训练样本,通过对这个样本的学习得到第二个弱分类器; 3. 将1和2都分错了的样本加上其他的新样本构成另一个新的N个的训练样本,通过对这个样本的学习得到第三个弱分类器; 4. 最终经过提升的强分类器。即某个数据被分为哪一类要由各分类器权值决定。 算法优点:高精度;简单,无需做特征筛选;可以使用各种方法构建子分类器,Adaboost算法提供的是框架; 当使用简单分类器时,计算出的结果是可以理解的,而且弱分类器构造极其简单;不会过度拟合。 对于boosting算法,存在两个问题: 1. 如何调整训练集,使得在训练集上训练的弱分类器得以进行; 2. 如何将训练得到的各个弱分类器联合起来形成强分类器。 针对以上两个问题,Adaboost算法进行了调整: 1. 使用加权后选取的训练数据代替随机选取的训练样本,这样将训练的焦点集中在比较难分的训练数据样本上; 2. 将弱分类器联合起来,使用加权的投票机制代替平均投票机制。让分类效果好的弱分类器具有较大的权重,而分类效果差的分类器具有较小的权重。 与Boosting算法不同的是,Adaboost算法不需要预先知道弱学习算法学习正确率的下限即弱分类器的误差,并且最后得到的强分类器的分类精度依赖于所有弱分类器的分类精度,这样可以深入挖掘弱分类器算法的能力。 算法缺点:训练时间过长,执行效果依赖于弱分类器的选择。对噪声数据和离群值敏感。 改进:限制样本权重的调整在各目标类内部进行 1、权值更新方法的改进 Allende等人提出了RADA算法,该算法是对原算法中误分类样本权值抑制的方法。算法最突出的贡献有三点:第一点是对的抑制,第二点,用当前层分类器来判断样本是否分类正 确,而非原算法中的当前弱分类器,第三点,增加age变量记录误分类情况,并作了阈值限制,这里有效缓解了过拟合的问题。RADA 比传统AdaBoost 算法更加稳定,有效解决了误分类样本权值偏高的问题。 2、训练方法的改进 Merler等人提出了AdaBoost的并行计算方法P-AdaBoost算法。其主要思想是,将AdaBoost训练过程分为两个阶段,第一阶段和原算法一样,经过多轮训练,获得一个较为可靠的样本分布ωi(s),第二阶段采用并行方法提高训练效率,训练中不再对样本权值进行更新,而统一采用ωi(s),最后输出为 。 采用这种方法能大大减少训练成本,与原算法相比,多了S 轮的样本分布初始化工作,并且避免了差样本因多次分类而造成权值过大的问题。 3、多算法结合的改进 Yunlong提出了EAdaBoost算法,是AdaBoost结合k近邻算法的产物。AdaBoost算法具有高度拟合的特点,噪声会对训练产生很大的影响,Yunlong等人在AdaBoost算法的基础之上加入了kNN算法,对噪声样本进行了有效处理,提高了算法的精确度。EAdaBoost算法的主要过程如下: (a) 准备训练样本,对样本权值进行初始化。 (b) 计算训练误差,并挑选最优的弱分类器。 (c) 更新样本权值。 (d) 用KNN 算法排除噪声样本,将权值设为0。 该算法中有两个非常关键的问题,什么样的样本称为噪声样本和每次要处理多少个噪声样本的问题,原文中称之为suspect sample,算法中取的是那种难于学习、让分类器出错过多的样本。 4、综合方法的改进 Rong Xiao等人提出了Boosting Chain算法,用链表的方式来组织分类器,算法先用boosting特征快速排除 大量非人脸窗口,再用boosting chain和SVM分类器进行再判别,实验效果相比FloatBoost还要略好。Adaboosting 一、德尔菲法 优点: 1、能充分发挥各位专家的作用,集思广益,准确性高。 2、能把各位专家意见的分歧点表达出来,取各家之长,避各家之短。 3、权威人士的意见影响他人的意见; 4、有些专家碍于情面,不愿意发表与其他人不同的意见; 5、出于自尊心而不愿意修改自己原来不全面的意见。 缺点: 德尔菲法的主要缺点是过程比较复杂,花费时间较长。 适用范围:项目规模宏大且环境条件复杂的预测情境。 二、类比法 优点:1、它不涉及任何一般性原则,它不需要在“一般性原则”的基础上进行推理。它只是一种由具体情况到具体情况的推理方式,其优越性在于它所得出的结论可以在今后的超出原案例事实的情况下进行应用。 2、类比法比其他方法具有更高的精确性; 3、类比过程中的步骤可以文档化以便修改。 缺点: 1 严重依赖于历史数据的可用性; 2 能否找出一个或一组好的项目范例对最终估算结果的精确度有着决 定性的影响; 3 对初始估算值进行调整依赖于专家判断。 适用范围:类比法是按同类事物或相似事物的发展规律相一致的原则,对预测目标事物加以对比分析,来推断预测目标事物未来发展趋向与可能水平的一种预测方法。类比法应用形式很多,如由点推算面、由局部类推整体、由类似产品类推新产品、由相似国外国际市场类推国内国际市场等等。类比法一般适用于预测潜在购买力和需求量、开拓新国际市场、预测新商品长期的销售变化规律等。类比法适合于中长期的预测。 三、回归分析法 优点:1、从收入动因的高度来判断收入变化的合理性,彻底抛弃了前述“无重大波动即为正常”的不合理假设。并且,回归分析不再只是简单的数据比较,而是以一整套科学的统计方法为基础。 、运用回归方法对销售收入进行分析性复核,可以考虑更多的影响因素作为解释变量,即使被审计单位熟悉了这种方法,其粉饰和操纵财务报表的成本也十分高昂。 缺点:需要掌握大量数据, 应用:社会经济现象之间的相关关系往往艰以用确定性的函数关系来描述,它们大多是随机性的,要通过统计观察才能找出其中规律。回归分桥是利用统计学原理描述随机变量间相关关系的一种重要方法。 四、时间序列分析法 优点:根据市场过去的变化趋势预测未来的发展,根据客观事物发展的这种连续规律性,运用过去的历史数据,通过统计分析,进一步推测市场未来的发展趋势。 缺点:运用时间序列分析进行量的预测,实际上将所有的影响因素归结到时间这一因素上,只承认所有影响因素的综合作用,并在未来对预测对象仍然起作用,并未去分析探讨预测对象和影响因素之间的因果关系。由于事物的发展不仅有连续性的特点,而且又是复杂多样的。。 适用范围:中短期预测 五、弹性系数分析法 优点:简单易行,计算方便,计算成本低;需要的数据少,应用灵活广泛。 缺点:1、分析带有一定的局部性和片面性。只考虑两个变量间的关系,忽略了其他相关变量的影响; 2、结果比较粗糙,很多时候要根据弹性系数的变动趋势对弹性系数进行 修正。 应用:应用利用弹性系数预测未来时期能源需求时,可以通过对未来产业结构变化趋势、技术节能潜力等因素的分析,以及参照世界大多数国家发展历程中所皇现的共同规律,给出未来年份能源消费弹性系数的变化趋势或构想方案,以预测未来的能源需求量。 人工智能之机器学习常见算法 摘要机器学习无疑是当前数据分析领域的一个热点内容。很多人在平时的工作中都或多或少会用到机器学习的算法。这里小编为您总结一下常见的机器学习算法,以供您在工作和学习中参考。 机器学习的算法很多。很多时候困惑人们都是,很多算法是一类算法,而有些算法又是从其他算法中延伸出来的。这里,我们从两个方面来给大家介绍,第一个方面是学习的方式,第二个方面是算法的类似性。 学习方式 根据数据类型的不同,对一个问题的建模有不同的方式。在机器学习或者人工智能领域,人们首先会考虑算法的学习方式。在机器学习领域,有几种主要的学习方式。将算法按照学习方式分类是一个不错的想法,这样可以让人们在建模和算法选择的时候考虑能根据输入数据来选择最合适的算法来获得最好的结果。 监督式学习: 在监督式学习下,输入数据被称为训练数据,每组训练数据有一个明确的标识或结果,如对防垃圾邮件系统中垃圾邮件非垃圾邮件,对手写数字识别中的1,2,3,4等。在建立预测模型的时候,监督式学习建立一个学习过程,将预测结果与训练数据的实际结果进行比较,不断的调整预测模型,直到模型的预测结果达到一个预期的准确率。监督式学习的常见应用场景如分类问题和回归问题。常见算法有逻辑回归(LogisTIc Regression)和反向传递神经网络(Back PropagaTIon Neural Network) 非监督式学习: 在非监督式学习中,数据并不被特别标识,学习模型是为了推断出数据的一些内在结构。常见的应用场景包括关联规则的学习以及聚类等。常见算法包括Apriori算法以及k-Means 算法。 半监督式学习: 在此学习方式下,输入数据部分被标识,部分没有被标识,这种学习模型可以用来进行预 X射线:波长很短的电磁波 特征X射线:是具有特定波长的X射线,也称单色X射线。 连续X射线:是具有连续变化波长的X射线,也称多色X射线。 荧光X射线:当入射的X射线光量子的能量足够大时,可以将原子内层电子击出,被打掉了内层的受激原子将发生外层电子向内层跃迁的过程,同时辐射出波长严格一定的特征X射线 二次特征辐射:利用X射线激发作用而产生的新的特征谱线 Ka辐射:电子由L层向K层跃迁辐射出的K系特征谱线 相干辐射:X射线通过物质时在入射电场的作用下,物质原子中的电子将被迫围绕其平衡位置振动,同时向四周辐射出与入射X射线波长相同的散射X射线,称之为经典散射。由于散射波与入射波的频率或波长相同,位相差恒定,在同一方向上各散射波符合相干条件,称为相干散射 非相干辐射:散射位相与入射波位相之间不存在固定关系,故这种散射是不相干的 俄歇电子:原子中一个K层电子被激发出以后,L层的一个电子跃迁入K层填补空白,剩下的能量不是以辐射 原子散射因子:为评价原子散射本领引入系数f (f≤E),称系数f为原子散射因子。他是考虑了各个电子散射波的位相差之后原子中所有电子散射波合成的结果 结构因子:定量表征原子排布以及原子种类对衍射强度影响规律的参数,即晶体结构对衍射强度的影响 多重性因素:同一晶面族{ hkl}中的等同晶面数 系统消光:原子在晶体中位置不同或种类不同引起某些方向上衍射线消失的现象 吸收限 1 x射线的定义性质连续X射线和特征X射线的产生 X射线是一种波长很短的电磁波 X射线能使气体电离,使照相底片感光,能穿过不透明的物体,还能使荧光物质发出荧光。呈直线传播,在电场和磁场中不发生偏转;当穿过物体时仅部分被散射。对动物有机体能产生巨大的生理上的影响,能杀伤生物细胞。 连续X射线根据经典物理学的理论,一个带负电荷的电子作加速运动时,电子周围的电磁场将发生急剧变化,此时必然要产生一个电磁波,或至少一个电磁脉冲。由于极大数量的电子射到阳极上的时间和条件不可能相同,因而得到的电磁波将具有连续的各种波长,形成连续X射线谱。 特征X射线处于激发状态的原子有自发回到稳定状态的倾向,此时外层电子将填充内层空位,相应伴随着原子能量的降低。原子从高能态变成低能态时,多出的能量以X射线形式辐射出来。因物质一定,原子结构一定,两特定能级间的能量差一定,故辐射出的特征X射波长一定。 2 x 射线方向理论布拉格方程和艾瓦尔德图解 3 试述解决X射线衍射方向问题常用方法有哪些并进行比较 4 简述材料研究X射线试验方法在材料研究中的主要应用 精确测定晶体的点阵常数物相分析宏观应力测定测定单晶体位相测定多晶的织够问题 5 试推导布拉格方程,解释方程中各符号的意义并说明布拉格方程的应用 假设: 1)晶体视为许多相互平行且d相等的原子面 2)X射线可照射各原子面 3)入射线、反射线均视为平行光 一束波长为λ的平行X射线以θ照射晶体中晶面指数为(hkl)的各原子面,各原子面产生反射。 当Ⅹ射线照射到晶体上时,考虑一层原子面上散射Ⅹ射线的干涉。 当Ⅹ射线以θ角入射到原子面并以θ角散射时,相距为a的两原子散射x射的光程差为: 即是说,当入射角与散射角相等时,一层原子面上所有散射波干涉将会加强。与可见光的反射定律相类似,Ⅹ射线从一层原子面呈镜面反射的方向,就是散射线干涉加强的方向,因此,常将这种散射称 机器学习中常见的几种优化方法 阅读目录 1. 梯度下降法(Gradient Descent) 2. 牛顿法和拟牛顿法(Newton's method & Quasi-Newton Methods) 3. 共轭梯度法(Conjugate Gradient) 4. 启发式优化方法 5. 解决约束优化问题——拉格朗日乘数法 我们每个人都会在我们的生活或者工作中遇到各种各样的最优化问题,比如每个企业和个人都要考虑的一个问题“在一定成本下,如何使利润最大化”等。最优化方法是一种数学方法,它是研究在给定约束之下如何寻求某些因素(的量),以使某一(或某些)指标达到最优的一些学科的总称。随着学习的深入,博主越来越发现最优化方法的重要性,学习和工作中遇到的大多问题都可以建模成一种最优化模型进行求解,比如我们现在学习的机器学习算法,大部分的机器学习算法的本质都是建立优化模型,通过最优化方法对目标函数(或损失函数)进行优化,从而训练出最好的模型。常见的最优化方法有梯度下降法、牛顿法和拟牛顿法、共轭梯 度法等等。 回到顶部 1. 梯度下降法(Gradient Descent) 梯度下降法是最早最简单,也是最为常用的最优化方法。梯度下降法实现简单,当目标函数是凸函数时,梯度下降法的解是全局解。一般情况下,其解不保证是全局最优解,梯度下降法的速度也未必是最快的。梯度下降法的优化思想是用当前位置负梯度方向作为搜索方向,因为该方向为当前位置的最快下降方向,所以也被称为是”最速下降法“。最速下 降法越接近目标值,步长越小,前进越慢。梯度下降法的搜索迭代示意图如下图所示: 牛顿法的缺点: (1)靠近极小值时收敛速度减慢,如下图所示; (2)直线搜索时可能会产生一些问题; (3)可能会“之字形”地下降。 从上图可以看出,梯度下降法在接近最优解的区域收敛速度明显变慢,利用梯度下降法求解需要很多次的迭代。 在机器学习中,基于基本的梯度下降法发展了两种梯度下降方法,分别为随机梯度下降法和批量梯度下降法。 个人工作总结优缺点 个人优缺点总結 总结分析自身优缺点 优点: 1、做人真诚,做事认真负责。 2、喜欢与人交往,善于组织策划活动和项目。 3、积极务实,敢于主动承担自己的责任。 4、能坚持。确定了正确方向,我就能把所有的力气砸向那个方向。有执行能力。 5、勤奋,善于学习自己感兴趣的知识和事物。做事喜欢列个计划,分出轻重缓急。缺点: 1、性格方面的弱点,有时给自己压力过大,急丁?求成,过犹不及。 2、在担任团队领导的时候,涉及到队员的利益的时候,有时为队员考虑的太多,导致做决定的时候会花比较多的时间。 3、不主动锻炼身体,除了和朋友一起打篮球和其他球类运动。 4、工作起来,有时会忘记时间。昨天晚上就很晚睡,大概24: 00过的样子,一宜忙省分行领导给的2014届新入行大学生培训电子杂志的工作。 5、在交朋友的时候,喜欢故事经历丰富的朋友,不喜欢朋友没有故事,太平淡。 体验与完善 领导是团队的核心,领导艺术的高低,决定学校的发展。 回顾历往工作实践,我具备以下的优点: 1、良好的组织能力。经过多年的中层干部经历锤炼,特别在负责政教工作期间,多次组织学校大型活动,如艺术节、六一儿童节、学生文明礼仪教育等活动,每次活动都有条不紊地开展,展示了组织魄力。自2009年转任支部书记后,开始独挡一面分管党务,一年一度的党员生活会、 师徳教育活动,我都能未雨绸缪,安排具体,措施得力,更展示了在组织技巧上风范。 2、灵活的沟通、协调指挥能力。善于沟通、巧于沟通,协调八方,调动全体,运筹得当是一个领导必备的素质。在任校长助理期间,分管后勤工作,面对的是一批年龄大、资格老、个性强的工作人员,工作难度大。沟通、协调非常关键。协调好了,每个人的优势都能发挥;协调不好,相互拆台,推下层磨。在我分管期间,同志们关系融洽和谐了,工作积极肯干了。学校先后被评为“十堰市后勤管理先进单位”、“十堰市文明食堂”等荣誉称号。 3、硬实的工作能力。近年来,我在各级活动中多次获奖,荣获国家级“双龙杯”书画赛辅导银奖、丹江口市体音美术个人基本功比赛第二名等。在T.作中,我始终以身作则,模范带头,律己以严,待人以宽,个人威信高,工作说服力强,办事效率高,有扎实的群众基础。 人无完人,金无足赤。我对个人缺点也有清醒认识,有待今后渴力改正。 1、见到领导过于谨慎,不善言语。 2、处事低调,导致做决定的时候用的时间比较多。 3、工作时间观念差,劳逸结合的科学工作方法不得当。 4、工作、生活安排缺乏合理性,重工作,轻生活现象严重,不利身心健康发展。 缺点: 总结分析自身优缺点 优点: 1、做人真诚,做事认真负责。 2、喜欢与人交往,善于组织策划活动和项目。 3、积极务实,敢于主动承担自己的责任。 4、能坚持。确定了正确方向,我就能把所有的力气砸向那个方向。有执行能力。 5、勤奋,善于学习自己感兴趣的知识和事物。做事喜欢列个计划,分出轻重缓急。 缺点: 1、性格方面的弱点,有时给自己压力过大,急于求成,过犹不及。 2、在担任团队领导的时候,涉及到队员的利益的时候,有时为队员考虑的太多,导致做决定的时候会花比较多的时间。 3、工作起来,有时会忘记时间。昨天晚上就很晚睡,大概24:00过的样子,一直忙省分行领导给的2009届新入行大学生培训电子杂志的工作。 对未来职业生涯的展望和规划 我,金融学和信息管理与信息系统双学位毕业,对金融有很浓厚的兴趣。我有一个人生目标:做最有影响力的自己。它不是靠哗众取宠能够得来的,而是需要不断提升梦想的高度、拓展心灵的宽度、累积思想的厚度!我相信,我的人生目标在以后的路上会一直影响我的职业生涯。 有了梦想还要有明确的规划,更要有实际的行动。要记住仰望星空,更要在仰望星空的同时看看脚下,从本职做起、从小事做起、从细节做起,不断努力跳跃并尝试触摸自己的梦想。我知道,我们每个人都会分到下边分理处做柜台,我赞同这种安排,我明白,银行中几乎所有的产品都是会通过柜台面向我们的客户,假如没有柜员的锻炼,我相信,把我们分到其他业务岗位,我们很难上手,因为我们少了在柜员岗的锻炼,不熟悉业务和产品。相反,在我们经历了柜员岗的锻炼后,再把我们分到其他岗位上,我相信,那时我们会更加的有自信,也能更好的完成工作。所以,我会珍惜在柜员岗的机会,铆劲提升自身的业务能力,熟练掌握我们的产品。力争做个业务骨干!这是我在柜员岗对自己一个总体要求! 在柜员岗夯实了业务和产品的基础后,我目前的想法是进公司业务部和销售部门(理财和销贷)工作。公司业务部很累,压力很大,很有挑战,我清楚!但我相信自己的做事态度 哪些问题适合于用机器学习来解决 我们和大家分享了哪些问题适合于用机器学习来解决。在明确了问题之后我们就需要来解决问题,本文要描述的是产品经理在开发机器学习产品时所需要的能力。第一部分提到产品经理的核心能力并不会因为应用到机器学习技术而改变,而只是在某些方面需要有所加强。产品经理一般需要五种核心能力,包括客户共情/设计分解,沟通、合作、商业策略和技术理解力。在机器学习领域需要增强的可能是技术方面的理解能力,因为产品经理需要理解机器学习系统的操作才能做出较好的产品决策。你可以向工程师学习也可以通过书本和网络教程充电。但如果你对机器学习系统的运行没有很好的理解,那么你的产品很可能会遇到很多问题。 算法的局限性 机器学习使用的每一个算法都基于特定的任务进行优化,无法覆盖真实情况下每一个细微的差别。理解算法的能力和局限将会帮助你把握住用户体验中存在的差距,并且通过优化产品设计或算法来解决。这是作为产品经理必须要掌握的能力。关于算法的不足我们用几个例子来说明。 数据中的偏差 机器学习算法从数据中学习模式,所以数据的质量决定了算法的表现。机器学习产品需要面对的第一个挑战便是这些数据要能够充分代表你的用户。有一个很负面的例子,就是google将黑人兄弟识别成了大猩猩。 所以保证数据代表你所有的用户是产品成功的关键。有时候偏差的存在并不是来自于数据收集的错误,而是数据固有的特性。就像IBM沃森利用俚语的都市字典进行训练后会输出恶毒的语言一样。我们期待的是输出礼貌的语言,但机器学习却学到了语言集中不好的部分。所以在精训练的时候需要对数据进行一定的清晰。 另一个例子,一般发达国家的互联网人数相较于发展中国家多。如果你基于搜索次数对搜索习惯进行建模的话,就会得到发达国家更多的结果,那么建模就不能准确的反映各国人民的上网习惯了,例如非洲的用户。对于数据偏差的审视将帮助你意识到产品不希望出现 机器学习常见算法分类汇总 ?作者:王萌 ?星期三, 六月25, 2014 ?Big Data, 大数据, 应用, 热点, 计算 ?10条评论 机器学习无疑是当前数据分析领域的一个热点内容。很多人在平时的工作中都或多或少会用到机器学习的算法。这里IT经理网为您总结一下常见的机器学习算法,以供您在工作和学习中参考。 机器学习的算法很多。很多时候困惑人们都是,很多算法是一类算法,而有些算法又是从其他算法中延伸出来的。这里,我们从两个方面来给大家介绍,第一个方面是学习的方式,第二个方面是算法的类似性。 学习方式 根据数据类型的不同,对一个问题的建模有不同的方式。在机器学习或者人工智能领域,人们首先会考虑算法的学习方式。在机器学习领域,有几种主要的学习方式。将算法按照学习方式分类是一个不错的想法,这样可以让人们在建模和算法选择的时候考虑能根据输入数据来选择最合适的算法来获得最好的结果。 监督式学习: 在监督式学习下,输入数据被称为“训练数据”,每组训练数据有一个明确的标识或结果,如对防垃圾邮件系统中“垃圾邮件”“非垃圾邮件”,对手写数字识别中的“1“,”2“,”3“,”4“等。在建立预测模型的时候,监督式学习建立一个学习过程,将预测结果与“训练数据”的实际结果进行比较,不断的调整预测模型,直到模型的预测结果达到一个预期的准确率。监督式学习的常见应用场景如分类问题和回归问题。常见算法有逻辑回归(Logistic Regression)和反向传递神经网络(Back Propagation Neural Network) 非监督式学习: 在非监督式学习中,数据并不被特别标识,学习模型是为了推断出数据的一些内在结构。常见的应用场景包括关联规则的学习以及聚类等。常见算法包括Apriori算法以及k-Means算法。 半监督式学习: 个人优缺点总结:优点 1、勤奋,善于学习自己感兴趣的知识和事物。做事喜欢列个计划,分出轻重缓急。 2、做人真诚,做事认真负责。 3、用心务实,敢于主动承担自己的职责。 4、喜欢与人交往,善于组织策划活动和项目。 5、能坚持。确定了正确方向,我就能把所有的力气砸向那个方向。有执行潜力。 个人优缺点总结:缺点 1、不主动锻炼身体,除了和朋友一齐打篮球和其他球类运动。 2、工作起来,有时会忘记时间。昨日晚上就很晚睡,大概:过的样貌,一向忙省分行领导给新入行大学生培训电子杂志的工作。 3、在交朋友的时候,喜欢故事经历丰富的朋友,不喜欢朋友没有故事,太平淡。 4、性格方面的弱点,有时给自己压力过大,急于求成,过犹不及。 尊敬的公司领导: 我是×××,我在××年××月××日应聘进入××公司,任××一职。三个月来,我积极学习公司文化与制度,努力提升自己的专业素质,迅速地融入公司集体与部门团队,配合部门经理与其他成员,完成各项工作。现将这三个月来的工作体会与未来展望向各位领导汇报。 一、工作总结 作为××,我的工作主要是××××。三个月以来,我积极收集与学习行业有关的行业信息、政策、法律法规,具备较好的专业素质,配合××团队完成各项工作。主要工作成果有: 1. 建立××部的资料档案台帐。资料档案台帐合理、简要、系统,查阅方便。 2. 建立××部的费用台帐。费用台帐简明扼要,准确记录资金进入与支出,有利于节约开发成本。 3. 管理××部的资料档案台帐。收集整理资料档案,保证资料档案的齐备;资料的借用、收回规范有序,保证资料档案的完整。 4. 管理××部的费用台帐,每月和财务部核对××部借支与冲账金额,保证台帐的准确。 5. 配合完成××部的月度工作总结、下月度计划及每月开发部资金计划的汇编、上报工作。 6. 负责××部的内勤管理工作,跟踪工作进度,跟进配套文件。 7. 协助经理协调与各部门之间的关系。 二、工作计划 根据个人岗位职责及任务分配,针对前阶段工作中存在的问题,加以思考、分析、改进,对下一步的工作有清晰的计划,明确的目标。主要工作计划有: 1.完成之前未完成的工作:跟进××工作;跟进××××事宜。 2.完成个人岗位下一步工作:改进资料档案台帐与资金台帐,做到动态控制,节约××成本;改进××部××的问题,积极跟进每个环节;更好地配合部门经理及部门成员跟进工作;更好完成部门内勤管理工作及协调工作。 3.接受并负责完成更多的××管理工作:积极学习××工作流程,提高专业素质,接受并完成各项××××工作。 三、工作展望 以成为一个优秀的职业经理人为目标。 1. 积极学习××相关的专业知识和相关法律法规,具备优秀的专业素质。 2. 积极学习公司制度与文化,热爱××××公司,以服务××公司为荣,具备 强烈的责任感与使命感,有较高的道德素质和心理素质。 3. 积极思考,努力学习、进步,具备优秀的思考与解决问题的能力,以丰富的 材料分析方法 1.x射线是一种波长很短的电磁波,具有波粒二相性,粒子性往往表现突出,故x射线也可视为一束具有一定能量的光量子流。X射线有可见光无可比拟的穿透能力,可使荧光物质发光,可使气体或其它物质电离等。 2.相干散射:亦称经典散射,物质中的电子在X射线电场的作用下,产生强迫振动。这样每个电子在各方向产生与入射X射线同频率的电磁波。新的散射波之间发生的干涉现象称为相干散射。 3.不相干散射:亦称量子散射,X射线光子与束缚力不大的外层电子,或自由电子碰撞时电子获得一部分动能成为反冲电子,X射线光子离开原来方向,能量减小,波长增加。 4.吸收限:物质原子序数越大,对X射线的吸收能力越强;对一定的吸收体,X射线的波长越短,穿透能力越强,表现为吸收系数的下降,但随着波长的的降低,质量吸收系数并非呈连续的变化,而是在某些波长位置上突然升高,出现了吸收限。 5.荧光辐射:由入射X射线所激发出来的特征X射线称为荧光辐射(荧光X 射线,二次X射线)。 6.俄歇效应:由于光电效应而处于激发态的原子还有一种释放能量的方式,及俄歇效应。原子中一个K层电子被入射光量子击出后,L层一个电子跃入K层填补空位,此时多余的能量不以辐射X光量子放出,而是以另一个L层电子活的能量跃出吸收体,这样的一个K层空位被两个L层空位代替的过程称为俄歇效应,跃出的L层电子称为俄歇电子。 7.光电子:当入射光量子的能量等于或大于吸收体原子某壳体层电子的结合能时,此光量子就很容易被电子吸收,获得能量的电子从内层溢出,成为自由电子,称为光电子。原子则处于激发态,这种原子被入射辐射电离的现象即光电效应。8.滤波片的作用:滤波片是利用吸收限两侧吸收系数差很大的现象制成的,用以吸收不需要的辐射而得到基本单色的光源。 9.布拉格方程只是获得衍射的必要条件而非充分条件。 10.晶面(hkl)的n级反射面(nh nk nl),用符号(HKL)表示,称为反射面或干涉面。 11.掠射角是入射角(或反射角)与晶面的夹角,可表征衍射的方向。 12.衍射极限条件:在晶体中,干涉面的划取是无极限的,但并非所有的干涉面均能参与衍射,因存在关系dsinθ=λ/2,或d>=λ/2,说明只有间距大于或等于X 射线半波长的那些干涉面才能参与反射。 13.劳埃法:采用连续X射线照射不动的单晶体,因为X射线的波长连续可变,故可从中挑选出其波长满足布拉格关系的X射线使产生衍射。 14.周转晶体法:采用单色X射线照射转动的单晶体,并用一张以旋转轴为轴的圆筒形底片来记录。 15.粉末法:采用单色X射线照射多晶体,试样是由数量众多、取向混乱的微晶体组成。 16.吸收因数:由于试样本身对X射线的吸收,使衍射强度的实测值与计算值不符,为了修正这一影响,则在强度公式中乘以吸收因数。 17.温度因数:原子热振动使晶体点阵原子排列的周期性受到破坏,使得原来严格满足布拉格条件的相干散射产生附加的相差,从而使衍射强度减弱。为修正实验温度给衍射强度带来的影响,需要在积分强度公式中乘以温度因数。 由于人工智能的火热,现在很多人都开始关注人工智能的各个分支的学习。人工智能由很多知识组成,其中人工智能的核心——机器学习是大家格外关注的。所以说,要想学好人工智能就必须学好机器学习。其中机器学习中涉及到了很多的算法,在这几篇文章中我们就给大家介绍一下关于机器学习算法的优缺点。 首先我们给大家介绍一下正则化算法,这是回归方法的拓展,这种方法会基于模型复杂性对其进行惩罚,它喜欢相对简单能够更好的泛化的模型。其中,正则化算法的例子有很多,比如说岭回归、最小绝对收缩与选择算子、GLASSO、弹性网络、最小角回归。而正则化算法的优点有两点,第一就是其惩罚会减少过拟合。第二就是总会有解决方法。而正则化算法的缺点也有两点,第一就是惩罚会造成欠拟合。第二就是很难校准。 接着我们给大家说一下集成算法,集成方法是由多个较弱的模型集成模型组,其中的模型可以单独进行训练,并且它们的预测能以某种方式结合起来去做出一个总体预测。该算法主要的问题是要找出哪些较弱的模型可以结合起来,以及结合的方法。这是一个非常强大的技术集,因此广受欢迎。这种算法的案例有很多,比如说Boosting、Bootstrapped Aggregation (Bagging)、AdaBoost、层叠泛化、梯度推进机、梯度提升回归树、随机森林。而集成算法的优点就是当前最先进的预测几乎都使用了算法集成,它比使用单个模型预测出来的结果要 精确的多。而缺点就是需要大量的维护工作。 然后我们给大家介绍一下决策树算法,决策树学习使用一个决策树作为一个预测模型,它将对一个 item(表征在分支上)观察所得映射成关于该 item 的目标值的结论(表征在叶子中)。而树模型中的目标是可变的,可以采一组有限值,被称为分类树;在这些树结构中,叶子表示类标签,分支表示表征这些类标签的连接的特征。决策树算法的案例有很多,比如说分类和回归树、Iterative Dichotomiser 3(ID3)、C4.5 和 C5.0。决策树算法的优点有两种,第一就是容易解释,第二就是非参数型。缺点就是趋向过拟合,而且可能或陷于局部最小值中,最后就是没有在线学习。 在这篇文章中我们给大家介绍了机器学习中涉及到的正则化算法、集成算法以及决策树算法的案例、优点以及缺点,这些知识都是能够帮助大家理解机器学习的算法,希望这篇文章能够帮助到大家。 个人工作优缺点总结 优点: 一、思想方面:我有热爱祖国,热爱党的优良传统,思想上积极要求上进,认真学习三个代表重要思想和与时俱进的时代特色,以一名新世纪团员的要求时刻鞭策自己。这一年来我始终坚持自强不息,立志成材的信念,始终保持着昂扬的斗志和坚韧不拔的作风,坚定不移地朝着既定的奋斗目标前进。 二、学习方面:我勤奋好学,态度端正,目标明确,对于专业知识会投入很多的时间。我知道身为一名学生要以学业为主,需要掌握好专业知识,成为有用之才更好的回报社会。学习专业知识的同时我还会利用课余的时间学一些其他的知识。希望收获更多。 三、工作方面:我工作积极,有热心。可以认真完成班级、老师分配的任务。不会因为这件事情不关自己的事而不去接受这份工作。 工作中自己有不足的地方会虚心接受他人的意见。对于工作我会继续努力, 做到工作学习两不误。 四、生活方面:我有良好的生活习惯,生活充实而有条理,有严谨的生活态度和良好的生活作风,为人热情大方,诚实守信,乐于助人,拥有自己的良好做事原则,能与同学们和睦相处;积极参加各项课外活动,从而不断的丰富自己的阅历。在心理方面,我锻炼坚强的意志品质,塑造健康人格,努力克服各种心理障碍,以适应社会发展要求。 缺点: 一、思想方面:我的理论性知识不够扎实,也还未能灵活的去运用,自我提高的意识有待加强,没有进行深入系统的学习,以至于无法深刻理解理论知识的精髓,也就不能很好把理论结合到实际生活中。因此,今后将投入更多的时间,切实加强自身的思想建设,不断提高自身的政治思想觉悟、法制观念,努力争取将思想与实践相结合,积极向党组织靠拢。对时事政治我关注不够多,我知道作为一名合格的党员是要去了解的。今后将更加关注时事和党的方针政策。 二、学习方面:对于知识没能很好的掌握和运用,集体学习的意识有待加强。 机器学习复习总结 选择目标函数的表示选择函数逼近算法最终设计选择训练经验第一个关键属性,训练经验能否为系统的决策提供直接或间接的反馈第二个重要属性,学习器在多大程度上控制样例序列第三个重要属性,训练样例的分布能多好地表示实例分布,通过样例来衡量最终系统的性能最终设计执行系统用学会的目标函数来解决给定的任务鉴定器以对弈的路线或历史记录作为输入,输出目标函数的一系列训练样例。泛化器以训练样例为输入,产生一个输出假设,作为它对目标函数的估计。实验生成器以当前的假设作为输入,输出一个新的问题,供执行系统去探索。第二章一致,满足,覆盖的定义:一致:一个假设h与训练样例集合D一致,当且仅当对D中每一个样例 策树空间能够表示定义在离散实例上的任何离散值函数)n 从根向下推断决策树,为每个要加入树的新决策分支贪婪地选择最佳的属性。n 归纳偏置,优先选择较小的树观察ID3的搜索空间和搜索策略,认识到这个算法的优势和不足假设空间包含所有的决策树,它是关于现有属性的有限离散值函数的一个完整空间维护单一的当前假设(不同于第二章的变型空间候选消除算法)不进行回溯,可能收敛到局部最优每一步使用所有的训练样例,不同于基于单独的训练样例递增作出决定,容错性增强ID3和候选消除算法的比较ID3的搜索范围是一个完整的假设空间,但不彻底地搜索这个空间候选消除算法的搜索范围是不完整的假设空间,但彻底地搜索这个空间ID3的归纳偏置完全是搜索策略排序假设的结果,来自搜索策略候选消除算法完全是假设表示的表达能力的结果,来自对搜索空间的定义过度拟合:对于一个假设,当存在其他的假设对训练样例的拟合比它差,但事实上在实例的整个分布上表现得却更好时,我们说这个假设过度拟合训练样例定义:给定一个假设空间H,一个假设h?H,如果存在其他的假设h’?H,使得在训练样例上h的错误率比h’小,但在整个实例分布上h’的错误率比h小,那么就说假设h过度拟合训练数据导致过度拟合的原因 1、一种可能原因是训练样例含有随机错误或噪声 2、特别是当少量的样例被关联到叶子节点时,很可能出现巧合的规律性,使得一些属性恰巧可以很好地分割样例,但却与实 销售人员个人优缺点总 结 Company number:【WTUT-WT88Y-W8BBGB-BWYTT-19998】 销售人员个人优缺点总结人们常常对已做过的工作进行回顾、分析,并提到理论高度,肯定已取得的成绩,指出应汲取的教训,以便今后做得更好。下面就是整理的销售人员个人优缺点总结,一起来看一下吧。 销售人员个人优缺点总结篇一转眼间,20XX年就要挥手告别了,在这新年来临之际,回想自己半年多所走过的路,所经历的事,没有太多的感慨,没有太多的惊喜,没有太多的业绩,多了一份镇定,从容的心态。 一、工作感悟 在这XX个月多的时间里有失败,也有成功,遗憾的是;欣慰的是;自身业务知识和能力有了提高。首先得感谢公司给我提供了那么好的工作条件和生活环境,有那么好的,有经验的老板给我指导,带着我前进;他们的实战经验让我们终生受益,从他们身上学到的不仅是做事的方法,更重要的是做人的道理,做人是做事的前 从2月开始进入公司,不知不觉中,一年的时间一晃就过了,在这段时间里,我从一个对产品知识一无所知的新人转变到一个能独立操作业务的业务员,完成了职业的角色转换,并且适应了这份工作。业绩没什么突出,以下是一年的工作业务明细: 进入一个新的行业,每个人都要熟悉该行业产品的知识,熟悉公司的操作模式和建立客户关系群。在市场开发和实际工作中,如何定位市场方向和产品方向,抓重点客户和跟踪客户,如何在淡旺季里的时间安排以及产品有那些,当然这点是远远不够的,应该不断的学习,积累,与时俱进。 在工作中,我虽有过虚度,有过浪费上班时间,但对工作我是认真负责的。经过时间的洗礼,我相信我会更好,俗话说:只有经历才能成长。世界没有完美的事情,每个人都有其优缺点,一旦遇到工作比较多的时候,容易急噪,或者不会花时间去检查,也会粗心。工作多的时候,想得多的是自己把他搞定,每个环节都自己去跑,、我要改正这种心态,再发挥自身的优势:贸易知识,学习接受。不断总结和改进,提高素质。 自我剖析:以目前的行为状况来看,我还不是一个合格业务员,或者只是一个刚入门的业务员,本身谈吐,口才还不行,表达能力不够突出。根源:没有突破自身的缺点,脸皮还不够厚,心理素质不过关,这根本不象是我自己,还远没有发掘自身的潜力,个性的飞跃。在我的内心中,我一直相信自己能成为一个优秀的业务员,这股动力;这份信念一直储藏在胸中,随时准备着爆发,内心一直渴望成 一、德尔菲法 优点:1、能充分发挥各位专家的作用,集思广益,准确性高。 2、能把各位专家意见的分歧点表达出来,取各家之长,避各家之短。 3、权威人士的意见影响他人的意见; 4、有些专家碍于情面,不愿意发表与其他人不同的意见; 5、出于自尊心而不愿意修改自己原来不全面的意见。 缺点: 德尔菲法的主要缺点是过程比较复杂,花费时间较长。 适用范围:项目规模宏大且环境条件复杂的预测情境。 二、类比法 优点:1、它不涉及任何一般性原则,它不需要在“一般性原则”的基础上进行推理。它只是一种由具体情况到具体情况的推理方式,其优越性在于它所得出的结论可以在今后的超出原案例事实的情况下进行应用。 2、类比法比其他方法具有更高的精确性; 3、类比过程中的步骤可以文档化以便修改。 缺点: 1 严重依赖于历史数据的可用性; 2 能否找出一个或一组好的项目范例对最终估算结果的精确度有着决 定性的影响; 3 对初始估算值进行调整依赖于专家判断。 适用范围:类比法是按同类事物或相似事物的发展规律相一致的原则,对预测目标事物加以对比分析,来推断预测目标事物未来发展趋向与可能水平的一种预测方 法。类比法应用形式很多,如由点推算面、由局部类推整体、由类似产品类推新产品、由相似国外国际市场类推国内国际市场等等。类比法一般适用于预测潜在购买力和需求量、开拓新国际市场、预测新商品长期的销售变化规律等。类比法适合于中长期的预测。 三、回归分析法 优点:1、从收入动因的高度来判断收入变化的合理性,彻底抛弃了前述“无重大波动即为正常”的不合理假设。并且,回归分析不再只是简单的数据比较,而是以一整套科学的统计方法为基础。 、运用回归方法对销售收入进行分析性复核,可以考虑更多的影响因素作为解释变量,即使被审计单位熟悉了这种方法,其粉饰和操纵财务报表的成本也十分高昂。 缺点:需要掌握大量数据, 应用:社会经济现象之间的相关关系往往艰以用确定性的函数关系来描述,它们大多是随机性的,要通过统计观察才能找出其中规律。回归分桥是利用统计学原理描述随机变量间相关关系的一种重要方法。 四、时间序列分析法 优点:根据市场过去的变化趋势预测未来的发展,根据客观事物发展的这种连续规律性,运用过去的历史数据,通过统计分析,进一步推测市场未来的发展趋势。 缺点:运用时间序列分析进行量的预测,实际上将所有的影响因素归结到时间这一因素上,只承认所有影响因素的综合作用,并在未来对预测对象仍然 机器学习实战之分类算法 第一章机器学习概论 (4) 机器学习基本概念 (4) 机器学习的主要任务以及相应的算法 (4) 如何选择合适的算法? (4) 机器学习应用的步骤 (5) 第二章 K近邻算法(KNN) (5) 工作原理 (5) 实现步骤 (6) K近邻算法的优缺点 (6) 第三章决策树 (7) 基本思路 (7) 集合无序程度测量 (7) 应用场景 (7) 优缺点 (7) 第四章朴素贝叶斯分类 (8) 基本思路 (8) 基本假设 (8) 条件概率 (8) 词袋模型和词集模型 (9) 优缺点 (10) 标称型和数值型数据的区别 (10) 主要应用及步骤 (10) 第五章逻辑回归 (12) 基本思想 (12) 使用场景 (12) 优缺点 (12) Sigmoid函数 (13) 回归系数 (13) 梯度上升法 (14) 特征缺失处理 (14) 标签缺失处理 (14) 第六章支持向量机SVM (14) 基本思想 (14) SVM第一层理解 (15) 超平面的确定 (15) 函数间隔和几何间隔 (15) 最大间隔分类器 (16) SMO优化算法 (16) 核函数 (19) 应用场景 (19) 第七章 AdaBoost分类 (19) Bagging (20) Boosting (20) Adaboost (20) Adaboost的优点 (20) Adaboost实现步骤 (21) 第八章非均衡分类问题 (23) 分类性能指标 (23) 混淆矩阵 (23) ROC曲线 (24) 处理非均衡问题的数据抽样 (24) 第一章机器学习概论 机器学习基本概念 机器学习就是将无序的数据转化为有用的信息。一个实例有n个特征,由n列组成。机器学习最主要的任务就是分类,另一个就是回归,回归中比较典型的就是线性拟合。分类和回归都属于监督学习,因为这类算法必须知道要预测什么,即已知目标变量的分类信息。与监督学习对应的是无监督学习,此时数据没有类别信息,也不会给定目标值,将数据集合分成由类似的对象组成的多个类的过程叫做聚类。将描述数据统计值的过程称之为密度估计。分类首先要进行训练,训练样本集必须确定目标变量的值,以便发现特征与目标变量之间的关系。特征或者属性通常是训练样本集的列,他们是独立测量得到的结果,多个特征联系在一起共同组成一个训练样本。 机器学习的主要任务以及相应的算法 如何选择合适的算法? 如果要预测目标变量的值: 个人工作总结优缺点第1篇第2篇第3篇第4篇第5篇更多顶部目录 第一篇:个人优缺点总结 第二篇:个人优缺点总结 第三篇:个人优缺点总结 第四篇:个人优缺点总结 第五篇:个人优缺点总结 正文 第一篇:个人优缺点总结 个人优缺点总结 总结分析自身优缺点 优点: 1、做人真诚,做事认真负责。 2、喜欢与人交往,善于组织策划活动和项目。 3、积极务实,敢于主动承担自己的责任。 4、能坚持。确定了正确方向,我就能把所有的力气砸向那个方向。有执行能力。 5、勤奋,善于学习自己感兴趣的知识和事物。做事喜欢列个计划,分出轻重缓急。缺点: 1、性格方面的弱点,有时给自己压力过大,急于求成,过犹不及。 2、在担任团队领导的时候,涉及到队员的利益的时候,有时为队员考虑的太多,导致做决定的时候会花比较多的时间。 3、不主动锻炼身体,除了和朋友一起打篮球和其他球类运动。 4、工作起来,有时会忘记时间。昨天晚上就很晚睡,大概24:00过的样子,一直忙省分行领导给的2020届新入行大学生培训电子杂志的工作。 5、在交朋友的时候,喜欢故事经历丰富的朋友,不喜欢朋友没有故事,太平淡。 体验与完善 领导是团队的核心,领导艺术的高低,决定学校的发展。 回顾历往工作实践,我具备以下的优点: 1、良好的组织能力。经过多年的中层干部经历锤炼,特别在负责政教工作期间,多次组织学校大型活动,如艺术节、六一儿童节、学生文明礼仪教育等活动,每次活动都有条不紊地开展,展示了组织魄力。自2009年转任支部书记后,开始独挡一面分管党务,一年一度的党员生活会、师德教育活动,我都能未雨绸缪,安排具体,措施得力,更展示了在组织技巧上风范。 2、灵活的沟通、协调指挥能力。善于沟通、巧于沟通,协调八 问题的定义:就是当现状与标准,或预期的状态有了差距时,我们就说我们遇到了问题。 问题分为:是什么,为什么,怎么办三类 一、问题是什么: 1、确定问题真实性: (1)自己调查研究(眼见为实,以数据说话) (2)他人说法(多人打听说法跟接近事情原型) “真的吗,谁说的,我来看看怎么回事” 2、界定问题(5W1H):“事情目前是怎么一个状况”(给予目前事情定性) (1)什么时间(when)包括曾经及可能发生 (2)什么地方(where) (3)什么事(what)包括主语、谓语(方法)、宾语(对象)、环境(全面考虑事物所有的因素和优缺点) (4)什么原因(why)--(下一节内容) (5)什么程度(how)量化问题程度以及问题的严重性、紧急性、发展性(“为什么这个问题显得很重要?”“为什么要在这个时候解决这个问题?”“如果什么也不做,会如何?”)(轻重缓急) 1、层别法:二、问题的原因:具体描述造成现象有差异造成现象未差异差异原因 时间 地点主语 方法 宾语 环境 程度 可能原因(可用假设)验证原因 证实未发生证实发生无法证实确定主因(用反正法)暂时对策永久对策 2、鱼骨图(使用创新思维能力): ,注意资料收集:根本问题不在一个层面(漏油)5WHY、3. 三、问题解决:(其他有直觉法、经验法、冷处理法) 1、明确决策目的(必须目标、愿望目标)(短期、长期) (1)什么时间(when) (2)什么地方(where) (3)什么事(what)包括主语、谓语(方法)、宾语(对象)、环境(4)什么程度(how)量化问题程度 2、评估选择方案(创新能力)采用层别法和鱼骨图 3、评估决策风险:效益性、把握性、困难性 4、做出最终决策(权衡利弊)(制定标准和惩罚机制) 工作自我评价优缺点 自我评价是很重要的,下面小编整理了工作自我评价优缺点,欢迎阅读! 自我评价优缺点 对生活充满热情,而且还经常用自己的积极地生活态度感染别人,引导别人,一些好朋友遇到不愉快的事情都会找我说,然后我会开到他们让他们重新积极的面对生活。 很有原则性,对自己非常的严格,对自己订立的计划会严格的执行。 在工作上很注意别人的感受,能理解别人,并和别人很好的合作;大学期间和别人有过多次的合作,并获得别人的好评。 自己在日常生活中很注意理性的分析自己的压力或烦恼,对自己面临的问题也会做理性的分析,然后分好轻重缓急的去快速解决待续……珍贵的四年大学生活已接近尾声,感觉非常有必要总结一下大学四年的得失,从中继承做得好的方面改进不足的地方,使自己回顾走过的路,也更是为了看清将来要走的路。 学习成绩不是非常好,但我却在学习的过程中收获了很多。首先是我端正了学习态度。在我考进大学时,脑子里想的是好好放松从重压下解放出来的自己,然而很快我就明白了,大学仍需努力认真的学习。看到周围的同学们拼命的学习,我也打消了初衷,开始大学的学习旅程。其次是极大程度的提高了自己的自学能力。由于大学的授课已不再像高中时填鸭式那样,而是一节课讲述很多知识,只靠课堂上 听讲是完全不够的。这就要求在课下练习巩固课堂上所学的知识,须自己钻研并时常去图书馆查一些相关资料。日积月累,自学能力得到了提高。再有就是懂得了运用学习方法同时注重独立思考。要想学好只埋头苦学是不行的,要学会"方法",做事情的方法。古话说的好,授人以鱼不如授人以渔,我来这里的目的就是要学会"渔",但说起来容易做起来难,我换了好多种方法,做什么都勤于思考,遇有不懂的地方能勤于请教。在学习时,以"独立思考"作为自己的座右铭,时刻不忘警戒。随着学习的进步,我不止是学到了公共基础学科知识和很多专业知识,我的心智也有了一个质的飞跃,能较快速的掌握一种新的技术知识,我认为这对于将来很重要。在学习知识这段时间里,我更与老师建立了浓厚的师生情谊。老师们的谆谆教导,使我体会了学习的乐趣。我与身边许多同学,也建立了良好的学习关系,互帮互助,克服难关。现在我已经大四,正在做毕业设计,更锻炼了自我的动手和分析问题能力,受益匪浅。 自我评价优缺点怎么写 什么是自我评价?在求职应聘中,为了让招聘方能够更深入的了解自己,而对自我进行的一种科学评价,是人们对于自己的能力、状态和发展趋势的评价性认识,同时也将促使主体维持自我的一致性。 那么自我评价优缺点怎么写却让不少求职者难以下手,对此,我们不妨借鉴以下内容。 自我评价优缺点,在描述"优点"的时候,建议最好是是这个职位所需要的素质,同时也要符合自身的真是情况,最好来自这三个方面分析方法总结及优缺点

人工智能之机器学习常见算法

材料分析方法复习总结

机器学习中常见的几种优化方法

个人工作总结优缺点

总结分析自身优缺点

哪些问题适合于用机器学习来解决

机器学习常见算法分类汇总

缺点 个人工作总结优缺点(最新)

(完整版)材料分析方法期末考试总结

机器学习中各个算法的优缺点(一)

个人工作优缺点总结

机器学习复习总结

销售人员个人优缺点总结

分析方法总结及优缺点

机器学习实战之分类算法

最新个人工作总结优缺点

问题分析与解决总结

自我评价 工作自我评价优缺点