6个角度分析流程建模

企业信息化:从六个角度分析流程建模流程是由多个要素组成的系统,可以从不同的维度或视角(perspective)描述,通常包括功能、业务逻辑、组织、知识、目标、数据和产品等,它们表达流程的不同本体(ontology)。其中功能视图表示流程的活动或任务(task)组成;业务逻辑与流程执行方式有关,由若干逻辑控制单元组成;组织视图涉及组织结构、执行主体角色定位等内容;而信息视图包括流程的数据(活动的输入、约束控制和输出)及其关系,涉及流程管理的信息或产品实体描述(product entity details)。此外,面向产品的流程模型强调产品(活动结果)在流程中的转换过程,包括状态顺序及转化条件等内容,弱化了功能活动。目标是与流程的功能粒度有关系的,即流程的子目标与流程的分解对应,是考核功能主体绩效的依据,常用的方法是平衡记分法。从不同视角得到

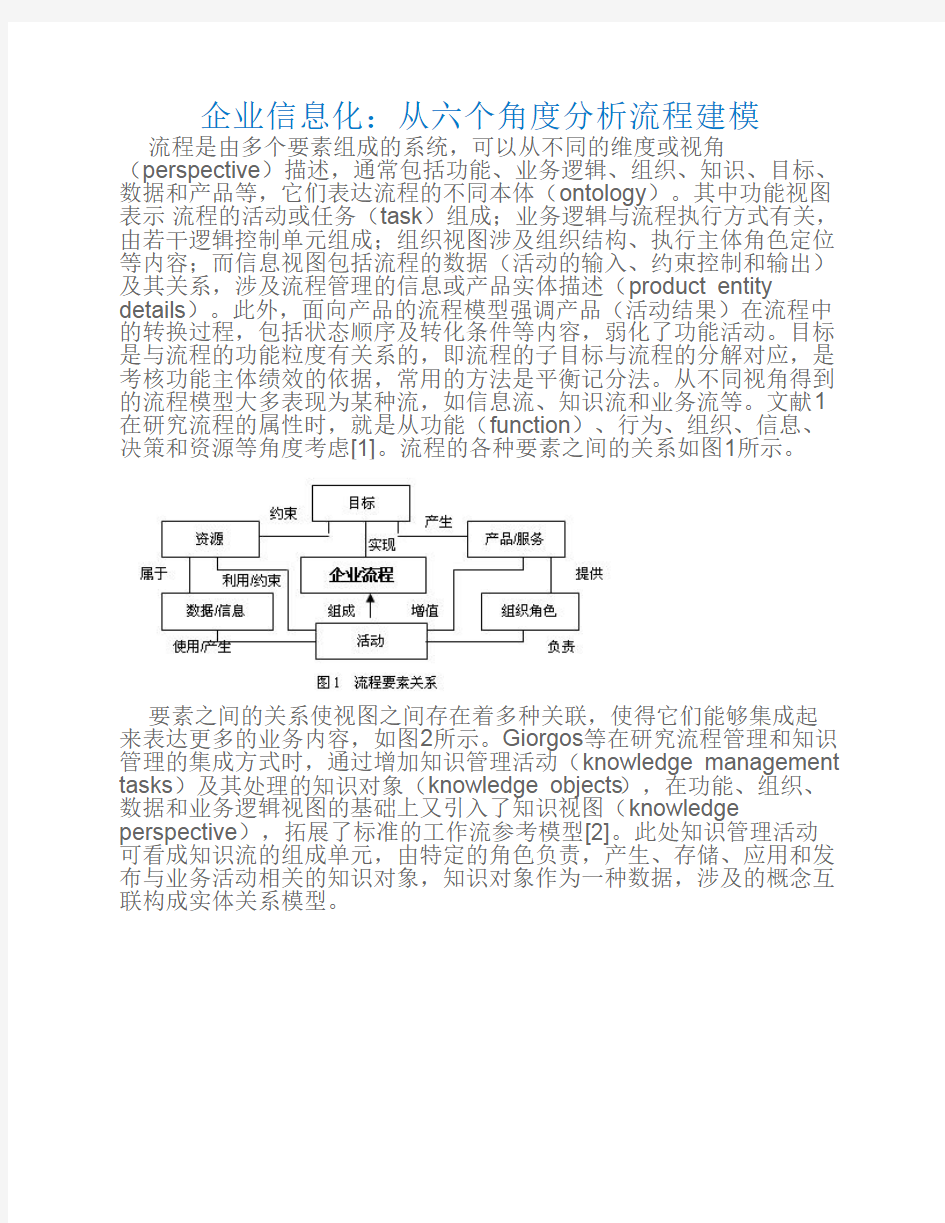

的流程模型大多表现为某种流,如信息流、知识流和业务流等。文献1在研究流程的属性时,就是从功能(function)、行为、组织、信息、决策和资源等角度考虑[1]。流程的各种要素之间的关系如图1所示。

要素之间的关系使视图之间存在着多种关联,使得它们能够集成起来表达更多的业务内容,如图2所示。Giorgos等在研究流程管理和知识管理的集成方式时,通过增加知识管理活动(knowledge management tasks)及其处理的知识对象(knowledge objects),在功能、组织、数据和业务逻辑视图的基础上又引入了知识视图(knowledge perspective),拓展了标准的工作流参考模型[2]。此处知识管理活动可看成知识流的组成单元,由特定的角色负责,产生、存储、应用和发布与业务活动相关的知识对象,知识对象作为一种数据,涉及的概念互联构成实体关系模型。

目前已出现许多流程建模方法,这些建模方法在流程的分析和优化中是必不可少的工具。由于不同的流程建模方法突出一种流程要素,而使其他的若干要素弱化或隐藏,因此很难在一种流程模型中表达流程所有的要素,建模方法的选择主要取决于应用的需要。如在管理信息系统开发时,需求分析会用到由活动及其业务逻辑构成的流程图以及分析数据在组织内部流动情况的数据流图DFD(data flow diagram),而在研究流程参与者之间如何协作完成流程的目标时,可以用角色活动图RAD(role activity diagram)[3]和基于通讯(communication-based)的工作流[4]等描述方法。但较全面的流程描述是以某种要素视图为核心,其他要素视图(表)为辅组成。如许多咨询在分析企业流程时,很多采用基于活动的通用流程建模方法(如跨功能的流程图),而其中功能或活动的负责角色、岗位职责等内容用相关的表格表示。在企业建模体系中,往往要综合多角度、多层次的内容才能反映企业业务的全貌,所描述出的模型比较复杂。动态企业建模体系结构CIMOSA(computer integrated manufacturing openness system architecture)的视图维就是以业务逻辑视图(工作流模型)为核心,其它视图(功能视图、信息视图、组织视图与资源视图)为辅助统一集成建模。表1是各种常见建模方法的简单分类。

表1 常见的流程建模方法

通用建模信息建模组织建模企业建

模

SADT、IEDF0、IDEF3、DFD、

ERM(实体关系模型)、

IDEF!、IDEF1X

RAD、

communication-

based

workflow

CIMOSA

强调了业务逻辑,整合了信息、组织从数据(信息)流动过程来考

察实际业务的处理模式,整合

了功能、产品和业务逻辑等内

容。面向产品的建模方法可看

强调多个角色交

互、协同完成流程

目标的过程,整合

了信息、业务逻辑

整合各

种流程

要素

030742003《数据分析与建模》教学大纲

《数据分析与建模教学大纲》课程教学大纲 课程代码:030742003 课程英文名称:Data Analysis and Modeling 课程总学时:48 讲课:40 实验:8 上机:0 适用专业:电子信息科学与技术 大纲编写(修订)时间:2011.9 一、大纲使用说明 (一)课程的地位及教学目标 数据分析与建模是一门综合运用分析、试验、量化的手段对生产实践、科学研究、军事工程等各种实际问题建立数学模型并进行求解的应用数学。它系统地介绍数学模型、数学建模和建模过程中的常用方法与实例,为学生今后各专业课程的学习和工作时间打下必不可缺的专业基础。 通过本课程的学习,学生将达到以下要求: 1.掌握数学模型的基本思想、方法与技巧。 2.学会正确的分析、归纳的思维方式和思考习惯,能够根据各种实际问题的不同情况采取不同方法建立数学模型。 3.运用所学的知识和技巧进行数学模型的求解、分析、检验与评价。 4.掌握有关计算机软件的使用,提高解决复杂问题的能力。 (二)知识、能力及技能方面的基本要求 1.基本知识:学生应掌握与建模相关的数学和计算机软件知识。 2.基本理论和方法:掌握线性规划与非线性规划、无约束最优化、微分方程、最短路问题、数据统计描述与分析、回归分析、计算机模拟以及插值与拟合等建模与求解的基本理论和方法。 3.基本技能: 掌握一定的解决实际建模问题的能力,能熟练运用计算机与相关软件并具备相关的编程计算技能,掌握撰写数据分析与建模论文或报告的能力。 (三)实施说明 1.教学方法:课堂讲授中要重点对基本概念、基本方法和解题思路的讲解;采用启发式教学,培养学生思考问题、分析问题和解决问题的能力;引导和鼓励学生通过实践和自学获取知识,培养学生的自学能力;增加讨论课,调动学生学习的主观能动性;注意培养学生提高利用各种媒体获取技术资料的能力。讲课要联系实际并注重培养学生的创新能力。 2.教学手段:在教学中采用电子教案、CAI课件及多媒体教学系统等先进教学手段,以确保在有限的学时内,全面、高质量地完成课程教学任务。 3.教学实施:教师在授课时可根据实际情况酌情安排各部分学时,后面的课时分配可供参考;可自行安排讲授的章节顺序,使之更符合学生的实际。 (四)对先修课的要求 学生应在学习《C语言程序设计》、《高等数学1》、《高等数学2》、《线性代数》、《概率论与数理统计》、《数值分析》、《离散数学》等课程之后学习《数据分析与建模》。 (五)对习题课、实验环节的要求 1.对重点、难点章节应安排习题课,例题的选择以培养学生消化和巩固所学知识,用以解决实际问题为目的。对于学生完成的习题要检查改错。对每种建模方法,要让学生上机实践并给予指导,使学生确切掌握要领,付诸应用。学生在上机过程中可以采用MATLAB、

数据分析算法与模型一附答案

精品文档 数据分析算法与模型模拟题(一) 一、计算题(共4题,100分) 1、影响中国人口自然增长率的因素有很多,据分析主要因素可能有:(1)从宏观经济上看,经济整体增长是人口自然增长的基本源泉;(2)居民消费水平,它的高低可能会间接影响人口增长率。(3)文化程度,由于教育年限的高低,相应会转变人的传统观念,可能会间接影响人口自然增长率(4)人口分布,非农业与农业人口的比率也会对人口增长率有相应的影响。为了全面反映中国“人口自然增长率”的全貌,选择人口增长率作为被解释变量,以反映中国人口的增长;选择“国名收入”及“人均GDP”作为经济整体增长的代表;选择“居民消费价格指数增长率”作为居民消费水平的代表。暂不考虑文化程度及人口分布的影响。 从《中国统计年鉴》收集到以下数据(见表1): 表1 中国人口增长率及相关数据 人口自然增长率国民总收入居民消费价格指数增长人均GDP 年份(元)率((亿元) CPI(%。))% 1366 15037 1988 15.73 18.8 1519 1989 18 17001 15.04 1644 18718 1990 14.39 3.1 1893 21826 3.4 1991 12.98 2311 26937 11.6 6.4 1992 2998 35260 14.7 11.45 1993 4044 48108 1994 24.1 11.21 5046 17.1 10.55 59811 1995 5846 70142 1996 10.42 8.3 6420 10.06 1997 2.8 78061 -0.8 1998 9.14 83024 6796 8.18 7159 1999 88479 -1.4 7858 2000 0.4 7.58 98000 精品文档. 精品文档

剖析大数据分析方法论的几种理论模型

剖析大数据分析方法论的几种理论模型 做大数据分析的三大作用,主要是:现状分析、原因分析和预测分析。什么时候开展什么样的数据分析,需要根据我们的需求和目的来确定。 作者:佚名来源:博易股份|2016-12-01 19:10 收藏 分享 做大数据分析的三大作用,主要是:现状分析、原因分析和预测分析。什么时候开展什么样的数据分析,需要根据我们的需求和目的来确定。 利用大数据分析的应用案例更加细化的说明做大数据分析方法中经常用到的几种理论模型。 以营销、管理等理论为指导,结合实际业务情况,搭建分析框架,这是进行大数据分析的首要因素。大数据分析方法论中经常用到的理论模型分为营销方面的理论模型和管理方面的理论模型。 管理方面的理论模型: ?PEST、5W2H、时间管理、生命周期、逻辑树、金字塔、SMART原则等?PEST:主要用于行业分析 ?PEST:政治(Political)、经济(Economic)、社会(Social)和技术(Technological) ?P:构成政治环境的关键指标有,政治体制、经济体制、财政政策、税收政策、产业政策、投资政策、国防开支水平政府补贴水平、民众对政治的参与度等。?E:构成经济环境的关键指标有,GDP及增长率、进出口总额及增长率、利率、汇率、通货膨胀率、消费价格指数、居民可支配收入、失业率、劳动生产率等。?S:构成社会文化环境的关键指标有:人口规模、性别比例、年龄结构、出生率、死亡率、种族结构、妇女生育率、生活方式、购买习惯、教育状况、城市特点、宗教信仰状况等因素。

?T:构成技术环境的关键指标有:新技术的发明和进展、折旧和报废速度、技术更新速度、技术传播速度、技术商品化速度、国家重点支持项目、国家投入的研发费用、专利个数、专利保护情况等因素。 大数据分析的应用案例:吉利收购沃尔沃 大数据分析应用案例 5W2H分析法 何因(Why)、何事(What)、何人(Who)、何时(When)、何地(Where)、如何做(How)、何价(How much) 网游用户的购买行为: 逻辑树:可用于业务问题专题分析

大数据分析的六大工具介绍

大数据分析的六大工具介绍 2016年12月 一、概述 来自传感器、购买交易记录、网络日志等的大量数据,通常是万亿或EB的大小,如此庞大的数据,寻找一个合适处理工具非常必要,今天我们为大家分学在大数据处理分析过程中六大最好用的工具。 我们的数据来自各个方面,在面对庞大而复杂的大数据,选择一个合适的处理工具显得很有必要,工欲善其事,必须利其器,一个好的工具不仅可以使我们的工作事半功倍,也可以让我们在竞争日益激烈的云计算时代,挖掘大数据价值,及时调整战略方向。 大数据是一个含义广泛的术语,是指数据集,如此庞大而复杂的,他们需要专门设il?的硬件和软件工具进行处理。该数据集通常是万亿或EB的大小。这些数据集收集自各种各样的来源:传感器、气候信息、公开的信息、如杂志、报纸、文章。大数据产生的其他例子包括购买交易记录、网络日志、病历、事监控、视频和图像档案、及大型电子商务。大数据分析是在研究大量的数据的过程中寻找模式, 相关性和其他有用的信息,可以帮助企业更好地适应变化,并做出更明智的决策。 二.第一种工具:Hadoop Hadoop是一个能够对大量数据进行分布式处理的软件框架。但是Hadoop是 以一种可黑、高效、可伸缩的方式进行处理的。Hadoop是可靠的,因为它假设计算元素和存储会失败,因此它维护多个工作数据副本,确保能够针对失败的节点重新分布处理。Hadoop 是高效的,因为它以并行的方式工作,通过并行处理加快处理速度。Hadoop还是可伸缩的,能够处理PB级数据。此外,Hadoop依赖于社区服务器,因此它的成本比较低,任何人都可以使用。

Hadoop是一个能够让用户轻松架构和使用的分布式计算平台。用户可以轻松地 在Hadoop上开发和运行处理海量数据的应用程序。它主要有以下儿个优点: ,高可黑性。Hadoop按位存储和处理数据的能力值得人们信赖。,高扩展性。Hadoop是 在可用的计?算机集簇间分配数据并完成讣算任务 的,这些集簇可以方便地扩展到数以千计的节点中。 ,高效性。Hadoop能够在节点之间动态地移动数据,并保证各个节点的动 态平衡,因此处理速度非常快。 ,高容错性。Hadoop能够自动保存数据的多个副本,并且能够自动将失败 的任务重新分配。 ,Hadoop带有用Java语言编写的框架,因此运行在Linux生产平台上是非 常理想的。Hadoop上的应用程序也可以使用其他语言编写,比如C++。 第二种工具:HPCC HPCC, High Performance Computing and Communications(高性能计?算与通信)的缩写° 1993年,山美国科学、工程、技术联邦协调理事会向国会提交了“重大挑战项 U:高性能计算与通信”的报告,也就是被称为HPCC计划的报告,即美国总统科学战略项U ,其U的是通过加强研究与开发解决一批重要的科学与技术挑战 问题。HPCC是美国实施信息高速公路而上实施的计?划,该计划的实施将耗资百亿 美元,其主要U标要达到:开发可扩展的计算系统及相关软件,以支持太位级网络 传输性能,开发千兆比特网络技术,扩展研究和教育机构及网络连接能力。

数据分析建模简介

数据分析建模简介 观察和实验是科学家探究自然的主要方法,但如果你有数据,那么如何让这些数据开口说话呢?数据用现代人的话说即信息,信息的挖掘与分析也是建模的一个重要方法。 1.科学史上最有名的数据分析例子 开普勒三定律 数据来源:第谷?布拉赫(1546-1601,丹麦人),观察力极强的天文学家,一辈子(20年)观察记录了750颗行星资料,位置误差不超过0.67°。 观测数据可以视为实验模型。 数据处理:开普勒(1571-1630,德国人),身体瘦弱、近视又散光,不适合观天,但有一个非常聪明的数学头脑、坚韧的性格(甚至有些固执)和坚强的信念(宇宙是一个和谐的整体),花了16年(1596-1612)研究第谷的观测数据,得到了开普勒三定律。 开普勒三定律则为唯象模型。 2.数据分析法 2.1 思想 采用数理统计方法(如回归分析、聚类分析等)或插值方法或曲线拟合方法,对已知离散数据建模。 适用范围:系统的结构性质不大清楚,无法从理论分析中得到系统的规律,也不便于类比,但有若干能表征系统规律、描述系统状态的数据可利用。 2.2 数据分析法 2.2.1 基础知识 (1)数据也称观测值,是实验、测量、观察、调查等的结果,常以数量的形式给出; (2)数据分析(data analysis)是指分析数据的技术和理论; (3)数据分析的目的是把隐没在一大批看来杂乱无章的数据中的信息集中、萃取和提炼出来,以找出所研究对象的内在规律;

(4)作用:在实用中,它可帮助人们作判断,以采取适当行动。 (5)实际问题所涉及的数据分为: ①受到随机性影响(随机现象)的数据; ②不受随机性影响(确定现象)的数据; ③难以确定性质的数据(如灰色数据)。 (6)数理统计学是一门以收集和分析随机数据为内容的学科,目的是对数据所来自的总体作出判断,总体有一定的概率模型,推断的结论也往往一概率的形式表达(如产品检验合格率)。 (7)探索性数据分析是在尽量少的先验假定下处理数据,以表格、摘要、图示等直观的手段,探索数据的结构及检测对于某种指定模型是否有重大偏离。它可以作为进一步分析的基础,也可以对数据作出非正式的解释。 实验者常常据此扩充或修改其实验方案(作图法也该法的重要方法,如饼图、直方图、条形图、走势图或插值法、曲线(面)拟合法等)。 2.2.2 典型的数据分析工作步骤 第一步:探索性数据分析 目的:通过作图、造表、用各种形式的方程拟合、计算某些特征量等手段探索规律性的可能形式,即往什么方向和用何种方式去寻找和揭示隐含在数据中的规律性。 第二步:模型选定分析 目的:在探索性分析的基础上,提出一类或几类可能的模型(如进一步确定拟合多项式(方程)的次数和各项的系数)。 第三步:推断分析 目的:通常用数理统计或其它方法对所选定的模型或估计的可靠程度或精确程度作出推断(如统计学中的假设检验、参数估计、统计推断)。3.建模中的概率统计方法 现实世界存在确定性现象和随机现象,研究随机现象主要由随机数学来承担,随机数学包括十几个分支,但主要有概率论、数理统计、试验设计、贝叶

spss的数据分析报告范例

关于某地区361个人旅游情况统计分析报告 一、数据介绍: 本次分析的数据为某地区361个人旅游情况状况统计表,其中共包含七变量,分别是:年龄,为三类变量;性别,为二类变量(0代表女,1代表男);收入,为一类变量;旅游花费,为一类变量;通道,为二类变量(0代表没走通道,1代表走通道);旅游的积极性,为三类变量(0代表积极性差,1代表积极性一般,2代表积极性比较好,3代表积极性好 4代表积极性非常好);额外收入,一类变量。通过运用spss统计软件,对变量进行频数分析、描述性统计、方差分析、相关分析,以了解该地区上述方面的综合状况,并分析个变量的分布特点及相互间的关系。 二、数据分析 1、频数分析。基本的统计分析往往从频数分析开始。通过频数分地区359个人旅游基本 状况的统计数据表,在性别、旅游的积极性不同的状况下的频数分析,从而了解该地区的男女职工数量、不同积极性情况的基本分布。 统计量 积极性性别 N 有效359 359 缺失0 0 首先,对该地区的男女性别分布进行频数分析,结果如下

性别 频率百分比有效百分 比 累积百分 比 有效女198 55.2 55.2 55.2 男161 44.8 44.8 100.0 合计359 100.0 100.0 表说明,在该地区被调查的359个人中,有198名女性,161名男性,男女比例分别为44.8%和55.2%,该公司职工男女数量差距不大,女性略多于男性。 其次对原有数据中的旅游的积极性进行频数分析,结果如下表: 积极性 频率百分比有效百分 比 累积百分 比 有效差171 47.6 47.6 47.6 一般79 22.0 22.0 69.6 比较 好 79 22.0 22.0 91.6 好24 6.7 6.7 98.3 非常 好 6 1. 7 1.7 100.0 合计359 100.0 100.0 其次对原有数据中的积极性进行频数分析,结果如下表: 其次对原有数据中的是否进通道进行频数分析,结果如下表:

常用生物软件简介汇总(window 版)

一、基因芯片: 1、基因芯片综合分析软件。 ArrayVision 7.0 一种功能强大的商业版基因芯片分析软件,不仅可以进行图像分析,还可以进行数据处理,方便protocol的管理功能强大,商业版正式版:69 00美元。 Arraypro 4.0 Media Cybernetics公司的产品,该公司的gelpro, imagepro一直以精确成为同类产品中的佼佼者,相信arraypro也不会差。 phoretix™ Array Nonlinear Dynamics公司的基因片综合分析软件。 J-express 挪威Bergen大学编写,是一个用JAVA语言写的应用程序,界面清晰漂亮,用来分析微矩阵(microarray)实验获得的基因表达数据,需要下载安装JAVA运行环境JRE1.2后(5.1M)后,才能运行。 2、基因芯片阅读图像分析软件 ScanAlyze 2.44 ,斯坦福的基因芯片基因芯片阅读软件,进行微矩阵荧光图像分析,包括半自动定义格栅与像素点分析。输出为分隔的文本格式,可很容易地转化为任何数据库。 3、基因芯片数据分析软件 Cluster 斯坦福的对大量微矩阵数据组进行各种簇(Cluster)分析与其它各种处理

的软件。 SAM Significance Analysis of Microarrays 的缩写,微矩阵显著性分析软件,E XCEL软件的插件,由Stanford大学编制。 4.基因芯片聚类图形显示 TreeView 1.5 斯坦福开发的用来显示Cluster软件分析的图形化结果。现已和Cluster 成为了基因芯片处理的标准软件。 FreeView 是基于JAVA语言的系统树生成软件,接收Cluster生成的数据,比Tr eeview增强了某些功能。 5.基因芯片引物设计 Array Designer 2.00 DNA微矩阵(microarray)软件,批量设计DNA和寡核苷酸引物工具 二、RNA二级结构。 RNA Structure 3.5 RNA Sturcture 根据最小自由能原理,将Zuker的根据RNA一级序列预测RNA二级结构的算法在软件上实现。预测所用的热力学数据是最近由Turner实验室获得。提供了一些模块以扩展Zuker算法的能力,使之为一个界面友好的RNA折叠程序。允许你同时打开多个数据处理窗口。主窗口的工具条提供一些基本功能:打开文件、导入文件、关闭文件、设置程序参数、重排窗口、以及即时帮助和退出程序。RNAdraw中一

流行统计分析软件简介

流行统计分析软件简介 曹 阳 一 SAS 决策分析系统 SAS 系统是用于决策支持的大型集成信息系统由总部设在美国北卡罗莱纳州凯瑞市的SAS 研究所研 制的 该研究所为一家私人公司目前已跻身于世界前十名独立软件公司中 该系统早期的全称为统计 分析系统 STATISTICAL ANALYSIS SYSTEM 目前已发展成一个由三十多个专用模块组成的大型集成式软件系统 1SAS 的工作环境 (1)程序窗口 (2)日志窗口 (3)运行结果窗口 (4)图形窗口 2SAS 的ASSIST 模块 该模块集成了SAS 系统其它模块的各种功能提供了一个菜单驱动任务导向的用户界面藉助它用 户不需编程 只要根据处理数据任务的需要用鼠标在屏幕上指定选项就可方便地使用SAS 提供的各种功能 3SAS 的INSIGHT 模块 INSIGHT 是SAS 下进行数据分析的一个完整的子 系统它为用户提供了一个进行交互式数据探索和分析的工具强有力的图象表现功能是INSIGHT 的重要特点 二SPSS 统计分析软件 SPSS(Statistical Package for the Social Science)是世界著名的统计分析软件之一它在各在学科领域都发挥着巨大的作用 1SPSS 的数据编辑窗口 2 SPSS 的输出导航窗口 3 SPSS 的图形输出窗口

三STATISTIC 软件 STATISTICA 美国STATSOFT 公司发行1995年发行了 5.0版本运行环境为Windows 32 或 Windows 95486/60以上微机8兆以上内存 分为 四个版本标准版Quick 版质量控制版和Quick 质量控制版可进行基本统计分析(Basic Statistics and Tables)非参数统计分析(Nonparametrics/Distrib)方差分析(ANOVA/MANOVA)多元回归分析(Multip Regression)可靠性/项目分析(Reliability 曲/Item Analysis)等等 菜单操作方式所有工作在四个基本 窗口中完成数据编辑窗口统计结果显示窗口图形显示窗口和文本输出窗口具有强大的统计分析和作图功能 1STATISTIC 的数据编窗口和结果显示窗口 2STATISTIC 的图表输出窗口和文本编辑输出窗口 四S-PLUS S-PLUS Mathsoft 研究所研制AT&T 公司发行 采用交互命令方式具有大量的函数库可进行一般的统计分析多元统计分析生存分析时间序列分 析等并产生相应的统计图形及报表具有数据管理管理功能可引入dBase 数据Excel 工作表和ASCII 数据等十多种数据文件并具有简单的数据编辑功能 对数据的运算十分简单主要的分析都是建立在矩阵的运算上在生存分析和时间列分析方面有独到之处 在熟悉其命令和函数的情况下统计分析和作图都很 简单操作十分方便 但操作方式不够直观命令和 函数较多 对于初学者来说掌握其中的命令函数和众多的参数 选择项及独特的语言格式尚需一定 的时间 由于其操作方式的局限性非专业人士知之 较少应用范围较窄 五MATLAB MATLAB MathWorks 研究所研制数学分析和 控制系统仿真工具可进行函数分析矩阵运算快速傅立叶变换和图形制作等在图形的处理方面的表 现能力较强具有独特的着色和渲染功能 六MATHEMATICA MATHEMATICA 美国Illnois 州Wolfram 研究所完全安装约需10兆空间是一个强大的数学分析软件包具有函数运算求解反函数导数积分矩阵运算 二维及三维图形制作等功能在生成三维及多维函数图形方面具有独特之处同时具有文字处理功

数据分析与建模实验报告

学生学号实验课成绩 学生实验报告书 实验课程名称数据分析与建模 开课学院 指导教师姓名 学生姓名 学生专业班级 2015 —2016 学年第 1 学期

实验报告填写规范 1、实验是培养学生动手能力、分析解决问题能力的重要环节;实验报告是反映实验教学水 平与质量的重要依据。为加强实验过程管理,改革实验成绩考核方法,改善实验教学效果,提高学生质量,特制定本实验报告书写规范。 2、本规范适用于管理学院实验课程。 3、每门实验课程一般会包括许多实验项目,除非常简单的验证演示性实验项目可以不写实 验报告外,其他实验项目均应按本格式完成实验报告。在课程全部实验项目完成后,应按学生姓名将各实验项目实验报告装订成册,构成该实验课程总报告,并给出实验课程成绩。 4、学生必须依据实验指导书或老师的指导,提前预习实验目的、实验基本原理及方法,了 解实验内容及方法,在完成以上实验预习的前提下进行实验。教师将在实验过程中抽查学生预习情况。 5、学生应在做完实验后三天内完成实验报告,交指导教师评阅。 6、教师应及时评阅学生的实验报告并给出各实验项目成绩,同时要认真完整保存实验报 告。在完成所有实验项目后,教师应将批改好的各项目实验报告汇总、装订,交课程承担单位(实验中心或实验室)保管存档。

画出图形 由图x=4时,y最大等于1760000 (2)求关于所做的15%假设的灵敏性 粗分析: 假设C=1000 即给定r y=f(x)=(1500-100x)1000(1+rx)=-100000rx^2+1500000rx-100000x+1500000 求导,f’(x)=-200000rx+1500000r-100000,令f’(x)=0,可得相应x值,x=(15r-1)/2r Excel画出相应图形

常用统计软件介绍

常用统计软件介绍

常用统计软件介绍 《概率论与数理统计》是一门实践性很强的课程。但是,目前在国内,大多侧重基本方法的介绍,而忽视了统计实验的教学。这样既不利于提高学生创新精神和实践能力,也使得这门课程的教学显得枯燥无味。为此,我们介绍一些常用的统计软件,以使学生对统计软件有初步的认识,为以后应用统计方法解决实际问题奠定初步的基础。 一、统计软件的种类 1.SAS 是目前国际上最为流行的一种大型统计分析系统,被誉为统计分析的标准软件。尽管价格不菲,SAS已被广泛应用于政府行政管理,科研,教育,生产和金融等不同领域,并且发挥着愈来愈重要的作用。目前SAS已在全球100多个国家和地区拥有29000多个客户群,直接用户超过300万人。在我国,国家信息中心,国家统计局,卫生部,中国科学院等都是SAS系统的大用户。尽管现在已经尽量“傻瓜化”,但是仍然需要一定的训练才可以使用。因此,该统计软件主要适合于统计工作者和科研工作者使用。 2.SPSS SPSS作为仅次于SAS的统计软件工具包,在社会科学领域有着广泛的应用。SPSS是世界上最早的统计分析软件,由美国斯坦福大学的三位研究生于20世纪60年代末研制。由于SPSS容易操作,输出漂亮,功能齐全,价格合理,所以很快地应用于自然科学、技术科学、社会科学的各个领域,世界上许多有影响的报刊杂志纷纷就SPSS 的自动统计绘图、数据的深入分析、使用方便、功能齐全等方面给予了高度的评价与称赞。迄今SPSS软件已有30余年的成长历史。全球

约有25万家产品用户,它们分布于通讯、医疗、银行、证券、保险、制造、商业、市场研究、科研教育等多个领域和行业,是世界上应用最广泛的专业统计软件。在国际学术界有条不成文的规定,即在国际学术交流中,凡是用SPSS软件完成的计算和统计分析,可以不必说明算法,由此可见其影响之大和信誉之高。因此,对于非统计工作者是很好的选择。 3.Excel 它严格说来并不是统计软件,但作为数据表格软件,必然有一定统计计算功能。而且凡是有Microsoft Office的计算机,基本上都装有Excel。但要注意,有时在装 Office时没有装数据分析的功能,那就必须装了才行。当然,画图功能是都具备的。对于简单分析,Excel 还算方便,但随着问题的深入,Excel就不那么“傻瓜”,需要使用函数,甚至根本没有相应的方法了。多数专门一些的统计推断问题还需要其他专门的统计软件来处理。 4.S-plus 这是统计学家喜爱的软件。不仅由于其功能齐全,而且由于其强大的编程功能,使得研究人员可以编制自己的程序来实现自己的理论和方法。它也在进行“傻瓜化”,以争取顾客。但仍然以编程方便为顾客所青睐。 5.Minitab 这个软件是很方便的功能强大而又齐全的软件,也已经“傻瓜化”,在我国用的不如SPSS与SAS那么普遍。

数据处理与建模流程_1

数据处理与建模流程: 1数据处理 1.1 替换缺失值: 数据完整没有缺失值的情况基本不存在,我们的数据中,0点-5点的航班为0的情况很多,所以数据缺失比较严重。时间序列分析要求时间周期完整,如果将缺失的数据只简单地用其他所有数据的缺失值填充,误差较大。经过反复尝试,发现用临近两点均值填充,结果最为理想。 2 时间序列的预处理 2.1 时间序列平稳化 首先绘制替换缺失值之后的原始数据的自相关图与偏自相关图。如下图所示: 可以看到自相关图并没有收敛到置信区间之内,趋近0以后又增长,且所有值均在置信区间之外。故序列不平稳。 为了进行时间序列平稳化,首先进行差分,即前值减后值,消除前后数据的依赖性。再次制作自相关图,勾选一次差分。结果如图所示:

如图所示偏ACF图仍然所有值均在置信区间之外。序列仍不平稳。勾选季节性差分再次制作自相关图,后一个周期相同位置的值减去前一个周期相同位置的值称为季节性差分。 结果如图所示: 从图中可知ACF为截尾,PACF为拖尾。序列已稳定。 故将原始序列先进行差分,后进行季节性差分。 2.2 平稳序列的检验 为了考察单个序列是否的确已经转换为平稳的随机序列,制作自相关图(ACF)与偏相关图(PACF)。此次将延迟拉大,观察相关图是否具有周期性:

图中所示,ACF在1阶之后骤减,为截尾。进一步观察,发现其具有周期性,在q+Sq后仍然骤减。PACF拖尾。根据下图,符合MA(q),Seas.MA(Q)模型。 (ACF与PACF怎么看:第一列数为lag值,第二列为相关系数的估计值,第三列为标准误差,其余为Box-Ljung检验结果。如果相关系数是突然收敛到置信区间之内,95%的值在置信区间之内,为截尾。如果相关系数像一条常常的尾巴,95%的值在置信区间之外,为拖尾。故,自相关图为截尾,偏相关图为拖尾。符合MA模型) 3 指数平滑与ARIMA的比较 指数平滑: 用序列过去值的加权均数来预测将来的值,并给序列中近期的数据以较大的权重,远期的数据以较小的权重。理由是随着时间的流逝,过去值的影响逐渐减小。基本公式: Ft是t时刻的预测值,Y是t时刻的实际值。指数平滑沿袭了修正的思想,T+1时刻的

常用分子生物学软件简介

常用分子生物学软件 一、基因芯片: 1、基因芯片综合分析软件。 ArrayVision 7.0 一种功能强大的商业版基因芯片分析软件,不仅可以进行图像分析,还可以进行数据处理,方便protocol的管理功能强大,商业版正式版:6900美元。 Arraypro 4.0 Media Cybernetics公司的产品,该公司的gelpro, imagepro一直以精确成为同类产品中的佼佼者,相信arraypro也不会差。 phoretix?Array Nonlinear Dynamics公司的基因片综合分析软件。 J-express 挪威Bergen大学编写,是一个用JAVA语言写的应用程序,界面清晰漂亮,用来分析微矩阵(microarray)实验获得的基因表达数据,需要下载安装JAVA运行环境JRE1.2后(5.1M)后,才能运行。 2、基因芯片阅读图像分析软件 ScanAlyze 2.44 ,斯坦福的基因芯片基因芯片阅读软件,进行微矩阵荧光图像分析,包括半自动定义格栅与像素点分析。输出为分隔的文本格式,可很容易地转化为任何数据库。 3、基因芯片数据分析软件 Cluster 斯坦福的对大量微矩阵数据组进行各种簇(Cluster)分析与其它各种处理的软件。 SAM Significance Analysis of Microarrays 的缩写,微矩阵显著性分析软件,EXCEL软件的插件,由Stanford大学编制。 4.基因芯片聚类图形显示 TreeView 1.5 斯坦福开发的用来显示Cluster软件分析的图形化结果。现已和Cluster成为了基因芯片处理的标准软件。 FreeView 是基于JAVA语言的系统树生成软件,接收Cluster生成的数据,比Treeview增强了某些功能。 5.基因芯片引物设计 Array Designer 2.00 DNA微矩阵(microarray)软件,批量设计DNA和寡核苷酸引物工具 二、RNA二级结构。 RNA Structure 3.5 RNA Sturcture 根据最小自由能原理,将Zuker的根据RNA一级序列预测RNA二级结构的算法在软件上实现。预测所用的热力学数据是最近由T urner实验室获得。提供了一些模块以扩展Zuker算法的能力,使之为一个界面友好的RNA折叠程序。允许你同时打开多个数据处理窗口。主窗口的工具条提供一些基本功能:打开文件、导入文件、关闭文件、设置程序参数、重排窗口、以及即时帮助和退出程序。RNAdraw中一个非常非常重要的特征是鼠

数据分析和数据建模

数据分析和数据建模 大数据应用有几个方面,一个是效率提升,帮助企业提升数据处理效率,降低数据存储成本。另外一个是对业务作出指导,例如精准营销,反欺诈,风险管理以及业务提升。过去企业都是通过线下渠道接触客户,客户数据不全,只能利用财务数据进行业务运营分析,缺少围绕客户的个人数据,数据分析应用的领域集中在企业内部经营和财务分析。 大数据应用有几个方面,一个是效率提升,帮助企业提升数据处理效率,降低数据存储成本。另外一个是对业务作出指导,例如精准营销,反欺诈,风险管理以及业务提升。过去企业都是通过线下渠道接触客户,客户数据不全,只能利用财务数据进行业务运营分析,缺少围绕客户的个人数据,数据分析应用的领域集中在企业内部经营和财务分析。 数字时代到来之后,企业经营的各个阶段都可以被记录下来,产品销售的各个环节也被记录下来,客户的消费行为和网上行为都被采集下来。企业拥有了多维度的数据,包括产品销售数据、客户消费数据、客户行为数据、企业运营数据等。拥有数据之后,数据分析成为可能,企业成立了数据分析团队整理数据和建立模型,找到商品和客户之间的关联关系,商品之间关联关系,另外也找到了收入和客户之间的关联关系。典型的数据分析案例如沃尔玛啤酒和尿布、蛋挞和手电筒,Target的判断16岁少女怀孕都是这种关联关系的体现。

关联分析是统计学应用最早的领域,早在1846年伦敦第二次霍乱期间,约翰医生利用霍乱地图找到了霍乱的传播途径,平息了伦敦霍乱,打败了霍乱源于空气污染说的精英,拯救了几万人的生命。伦敦霍乱平息过程中,约翰医生利用了频数分布分析,建立了霍乱地图,从死亡案例分布的密集程度上归纳出病人分布同水井的关系,从而推断出污染的水源是霍乱的主要传播途径,建议移除水井手柄,降低了霍乱发生的概率。 另外一个典型案例是第二次世界大战期间,统计分析学家改造轰炸机。英美联盟从1943年开始对德国的工业城市进行轰炸,但在1943年年底,轰炸机的损失率达到了英美联盟不能承受的程度。轰炸军司令部请来了统计学家,希望利用数据分析来改造轰炸机的结构,降低阵亡率,提高士兵生还率。统计学家利用大尺寸的飞机模型,详细记录了返航轰炸机的损伤情况。统计学家在飞机模型上将轰炸机受到攻击的部位用黑笔标注出来,两个月后,这些标注布满了机身,有的地方标注明显多于其他地方,例如机身和侧翼。有的地方的标注明显少于其他地方,例如驾驶室和发动机。统计学家让军火商来看这个模型,军火商认为应该加固受到更多攻击的地方,但是统计学家建议对标注少的地方进行加固,标注少的原因不是这些地方不容易被击中,而是被击中的这些地方的飞机,很多都没有返航。这些标注少的地方被击中是飞机坠毁的一个主要原因。军火商按照统计学家的建议进行了飞机加固,大大提高了轰炸机返航的比率。以二战著名的B-17轰炸机为例,其阵亡率由26%降到了7%,帮助美军节约了几亿美金,大大提高了士兵的生还率。 一数据分析中的角色和职责 数据分析团队应该在科技部门内部还在业务部门内部一直存在争议。在业务部门内部,对数据场景比较了解,容易找到数据变现的场景,数据分析对业务提升帮助较大,容易出成绩。但是弊端是仅仅对自己部门的业务数据了解,分析只是局限独立的业务单元之内,在数据获取的效率上,数据维度和数据视角方面缺乏全局观,数据的商业视野不大,对公司整体业务的推动发展有限。业务部门的数据分析团队缺少数据技术能力,无法利用最新的大数据计算和分析技术,来实现数

业绩数据分析模型(终审稿)

业绩数据分析模型 TPMK standardization office【 TPMK5AB- TPMK08- TPMK2C- TPMK18】

营销总经理的业绩数据分析模型--营销总经理的工作模型(一) 前言 营销总经理这个职位压力大而且没有安全 感——天气变化、竞品动态、本品产品质量、 公司的战略方向、费用投入、经销商的突然变 化、行业动荡、上游采购成本等等诸多因素影 响业绩。营销行业没有常胜将军,但是这个行业以成败论英雄。 营销总经理这个职位事情多而且杂乱琐碎:营销总经理要遥控管理庞大的营销团队,服务于全国几千万家经销商和终端。工作千头万绪,哪怕每天干25个小时,工作还是俄罗斯方块一样堆积。 压力和杂务干扰之下,就容易迷失,做营销总经理需要热情、能力、经验、更需要固化的可复制的工作模型,帮助自己脱身庶务,联系市场实际,提升管理绩效。 营销总经理工作模型一:数据分析模型 一、营销总经理数据分析流程概述 数据分析好像“业绩体检报告”,告诉营销总经理哪里有问题。营销总经理要每天按照固定的数据分析模型对当日发货量、累计业绩进度、发货客户数、

发货品项数、产品结构、区域结构等关键指标进行全方位多维次的实时监控。随时关注整体业绩达成的数量和质量。 如果公司整体业绩分析没问题就下延看区域业绩有没问题,没问题就结束分析。如果公司整体业绩有问题;就要思考有没有特殊原因——比如:天气下雨造成三天发货量下滑,天晴后业绩会恢复。公司上半月集中力量乡镇市场压货,所以低价产品业绩上升高价产品业绩下滑是计划内正常现象。如果没有特殊原因,确实属于业绩异常,就要立刻从这个指标着手深度分析:通常是从产品、区域、客户三条主线来研究。发现问题产品(哪个产品需要重点管理)、发现问题区域(哪个区域需要重点巡查)、发现问题客户(哪个重点零售ka系统重点经销商的业绩不正常)。除非问题非常严重,一般营销总经理的数据分析下延到直接下级(大区或者省区层面)即可,然后要求问题区域的大区经理做出解释,拿出整改方案。大区省区经理再做区域内数据分析,寻找问题产品、问题片区和问题经销商。 数据分析得出结论就找到了管理重点,接下来营销总经理要采取针对性有的放失的管理动作——比如立刻去巡检重点问题区域、要求问题区域限期改善、更改当月的促销投入或者产品价格、设立新的工作任务(比如乡镇铺货)等等,整个分析流程图示如下:

几种常用大数据分析工具

几种常用大数据分析工具 大数据可以概括4个V,数据量大,速度快,类型多,价值密度低。大数据作为时下最火热的IT行业的词汇,随之而来的数据仓库,数据安全,数据分析,数据挖掘等等围绕大数据的商业价值的利用逐渐成为行业人士争相追捧的利润焦点。今天我们北大青鸟贵州大数据学院为大家分享的就是大数据分析工具。 Hadoop Hadoop是一个能够让用户轻松架构和使用的分布式计算平台。用户可以轻松地在Hadoop上开发和运行处理海量数据的应用程序。它主要有以下几个优点:高可靠性:Hadoop按位存储和处理数据的能力值得人们信赖。高扩展性:Hadoop是在可用的计算机集簇间分配数据并完成计算任务的,这些集簇可以方便地扩展到数以千计的节点中。高效性:Hadoop能够在节点之间动态地移动数据,并保证各个节点的动态平衡,因此处理速度非常快。高容错性:Hadoop能够自动保存数据的多个副本,并且能够自动将失败的任务重新分配。了解详情 1、HPCC HPCC,High Performance Computing and Communications(高性能计算与通信)的缩写。HPCC是美国实施信息高速公路而上实施的计划,该计划的实施将耗资百亿美元,其主要目标要达到:开发可扩展的计算系统及相关软件,以支持太位级网络传输性能,开发千兆比特网络技术,扩展研究和教育机构及网络连接能力。点击咨询

2、Storm Storm是自由的开源软件,一个分布式的、容错的实时计算系统,可以非常可靠的处理庞大的数据流,用于处理Hadoop的批量数据。Storm很简单,支持许多种编程语言,使用起来非常有趣。Storm有许多应用领域:实时分析、在线机器学习、不停顿的计算、分布式RPC(远过程调用协议,一种通过网络从远程计算机程序上请求服务)、 3、Pentaho BI Pentaho BI 平台不同于传统的BI 产品,它是一个以流程为中心的,面向解决方案(Solution)的框架。其目的在于将一系列企业级BI产品、开源软件、API等等组件集成起来,方便商务智能应用的开发。以上就是北大青鸟贵州大数据学院大数据分析工具的简单介绍,更多大数据学习详情,大家可以到北大青鸟贵州大数据学院大数据咨询了解。

【数据分析技术系列】之用户画像数据建模方法

【数据分析技术系列】 之用户画像数据建模方法 目录 一、什么是用户画像? (1) 二、为什么需要用户画像 (1) 三、如何构建用户画像 (2) 3.1数据源分析 (2) 静态信息数据 (3) 动态信息数据 (3) 3.2目标分析 (3) 3.3数据建模方法 (4) 四、总结: (6)

从1991年Tim Berners-Lee发明了万维网(World Wide Web)开始到2011年,互联网真正走向了一个新的里程碑,进入了“大数据时代”。经历了12、13两年热炒之后,人们逐渐冷静下来,更加聚焦于如何利用大数据挖掘潜在的商业价值,如何在企业中实实在在的应用大数据技术。伴随着大数据应用的讨论、创新,个性化技术成为了一个重要落地点。相比传统的线下会员管理、问卷调查、购物篮分析,大数据第一次使得企业能够通过互联网便利地获取用户更为广泛的反馈信息,为进一步精准、快速地分析用户行为习惯、消费习惯等重要商业信息,提供了足够的数据基础。伴随着对人的了解逐步深入,一个概念悄然而生:用户画像(UserProfile),完美地抽象出一个用户的信息全貌,可以看作企业应用大数据的根基。 一、什么是用户画像? 男,31岁,已婚,收入1万以上,爱美食,团购达人,喜欢红酒配香烟。 这样一串描述即为用户画像的典型案例。如果用一句话来描述,即:用户信息标签化。 如果用一幅图来展现,即: 二、为什么需要用户画像 用户画像的核心工作是为用户打标签,打标签的重要目的之一是为了让人能够理解并且方便计算机处理,如,可以做分类统计:喜欢红酒的用户有多少?喜

欢红酒的人群中,男、女比例是多少?也可以做数据挖掘工作:利用关联规则计算,喜欢红酒的人通常喜欢什么运动品牌?利用聚类算法分析,喜欢红酒的人年龄段分布情况? 大数据处理,离不开计算机的运算,标签提供了一种便捷的方式,使得计算机能够程序化处理与人相关的信息,甚至通过算法、模型能够“理解” 人。当计算机具备这样的能力后,无论是搜索引擎、推荐引擎、广告投放等各种应用领域,都将能进一步提升精准度,提高信息获取的效率。 三、如何构建用户画像 一个标签通常是人为规定的高度精炼的特征标识,如年龄段标签:25~35岁,地域标签:北京,标签呈现出两个重要特征:语义化,人能很方便地理解每个标签含义。这也使得用户画像模型具备实际意义。能够较好的满足业务需求。如,判断用户偏好。短文本,每个标签通常只表示一种含义,标签本身无需再做过多文本分析等预处理工作,这为利用机器提取标准化信息提供了便利。 人制定标签规则,并能够通过标签快速读出其中的信息,机器方便做标签提取、聚合分析。所以,用户画像,即:用户标签,向我们展示了一种朴素、简洁的方法用于描述用户信息。 3.1 数据源分析 构建用户画像是为了还原用户信息,因此数据来源于:所有用户相关的数据。 对于用户相关数据的分类,引入一种重要的分类思想:封闭性的分类方式。如,世界上分为两种人,一种是学英语的人,一种是不学英语的人;客户分三类,高价值客户,中价值客户,低价值客户;产品生命周期分为,投入期、成长期、成熟期、衰退期…所有的子分类将构成了类目空间的全部集合。 这样的分类方式,有助于后续不断枚举并迭代补充遗漏的信息维度。不必担心架构上对每一层分类没有考虑完整,造成维度遗漏留下扩展性隐患。另外,不同的分类方式根据应用场景,业务需求的不同,也许各有道理,按需划分即可。 本文将用户数据划分为静态信息数据、动态信息数据两大类。

经济数据分析与建模

经济数据分析与建模 一、某企业自动打包机的标准打包重量为500克。为检验该打包机工作是否正常,他们抽取了15个样本。在显著水平0.05下,判断打包机是否处于正常工作状态。 495.9,501.3,500.2,498.7,495.7,502.1,505.2,503.2,492.6,493.5,502.4,495.3,499.7,50 0.4,496.2 首先,进行正态性检验。 1) H0假设:打包机的打包重量服从正态分布。 2) SPSS命令:1-Sample K-S。这是一种非参数正态检验的方法。 3)在0.05显著性水平下,打包机的打包重量服从正态分布的概率分别为0.854,大于0.05,接受H0假设。 表1.1单样本 Kolmogorov-Smirnov 检验 VAR00001 N 15 正态参数a,b 均值498.8267 标准差 3.77311 最极端差别绝对值.157 正.157 负-.125 Kolmogorov-Smirnov Z .607 渐近显著性(双侧) .854 4)得出对实际问题的分析结论。 打包机的打包重量服从正态分布。 正态性检验的结果说明可以进行参数检验。 1) H0假设:该自动打包机打包的平均重量与500克无显著差异,处于正常工作状态。 2) SPSS命令:单样本T检验。这种方法是检验某变量的总体均值是否与某个“特定值”(常量)相等(存在或不存在差异)的假设检验,而这里是检验该打包机工作是否正常,即检验自动打包机的标准打包重量是否为500克,通过单样本T 检验能够达到这个目的。 3)15个样本的均值为498.8267克。在显著性水平为为0.05的条件下,H0发生