随机森林与逻辑回归模型在违约预测中的应用

2016年第21期

信息与电脑

China Computer&Communication

计算机工程应用技术

随机森林与逻辑回归模型在违约预测中的应用

刘开元

(广州大学 计算机科学与教育软件学院,广东 广州 510006)

摘 要:近几年来随着国家经济以及汽车消费信贷市场的发展,贷款违约问题逐渐成为各家信贷机构关注的焦点。目前,汽车信贷违约预测的方法还不够完善,为了建立起一套行之有效的模型,笔者通过将随机森林组合算法与逻辑回归相结合,对某商业银行的汽车信贷数据进行分析,构建了一个易于解释且实用的违约判别模型。

关键词:随机森林;逻辑回归;违约预测;汽车贷款

中图分类号:P642.22 文献标识码:A 文章编号:1003-9767(2016)21-111-02

1 引言

21世纪初,车辆信贷市场在国内打开,许多银行预感汽车信贷的获利机遇,纷纷开始进入车贷市场。在接下来的几年里,车辆信贷业务发展迅猛,仅仅两年多的时间里,银行车辆信贷业务增加了数倍,据统计,仅2003年车贷额就增加30亿左右,平均每月增加2亿至3亿,最多的月增加达到6亿多。2003年底,上海一个市的银行发放汽车贷款超过80亿。然而在车贷市场迅猛发展的同时,车贷违约问题逐渐暴露出来,因为车贷风险要比房贷来得快而高,车贷风险释放使银行违约率上升的同时,车贷坏账最终的受害者也是银行本身。为了降低坏账率,构建一个适用的违约判别模型就成为了各家信贷机构关注的重大点。本文在传统决策树模型的基础上引入随机森林组合算法,使得模型在易于解释的同时能得到更好的预测结果。

2 随机森林与逻辑回归组合模型

2.1 决策树与随机森林

决策树是一个贪婪算法,它代表的是对象属性与对象值之间的一种映射关系。决策树通过熵增益率或Gini 系数下降幅度对对象属性进行分组判断,理想的分组应尽量使两组输出变量值的Gini 系数下降幅度或熵增益率最大。

Gini 系数表达式为:2

1i Gini p =?∑。信息熵表达式为:2log ()i i info p p =∑。

其中为样本类别在当前分类样本下出现的频率。

随机森林最早起源于贝尔实验室Tin Kam Ho 提出的随即决策森林(Random Decision Forests )算法,后由Leo Breiman 和Adele Cutler 提出。随机森林实际上由许多决策树组成,最后分类结果取决于各个决策树分类器的简单多数选举。

随机森林是一个由一组决策树分类器(h (X ,f k (θ)),k =1~K )组成的分类器集合,其中为输入向量集,

f (x )表示单个决策树,θk 是服从独立同分布的输入向量集的子集,K 表示随机森林中决策树的个数,在给定自变量X 的情况下,每个决策树通

过投标来决定最优的分类结果。

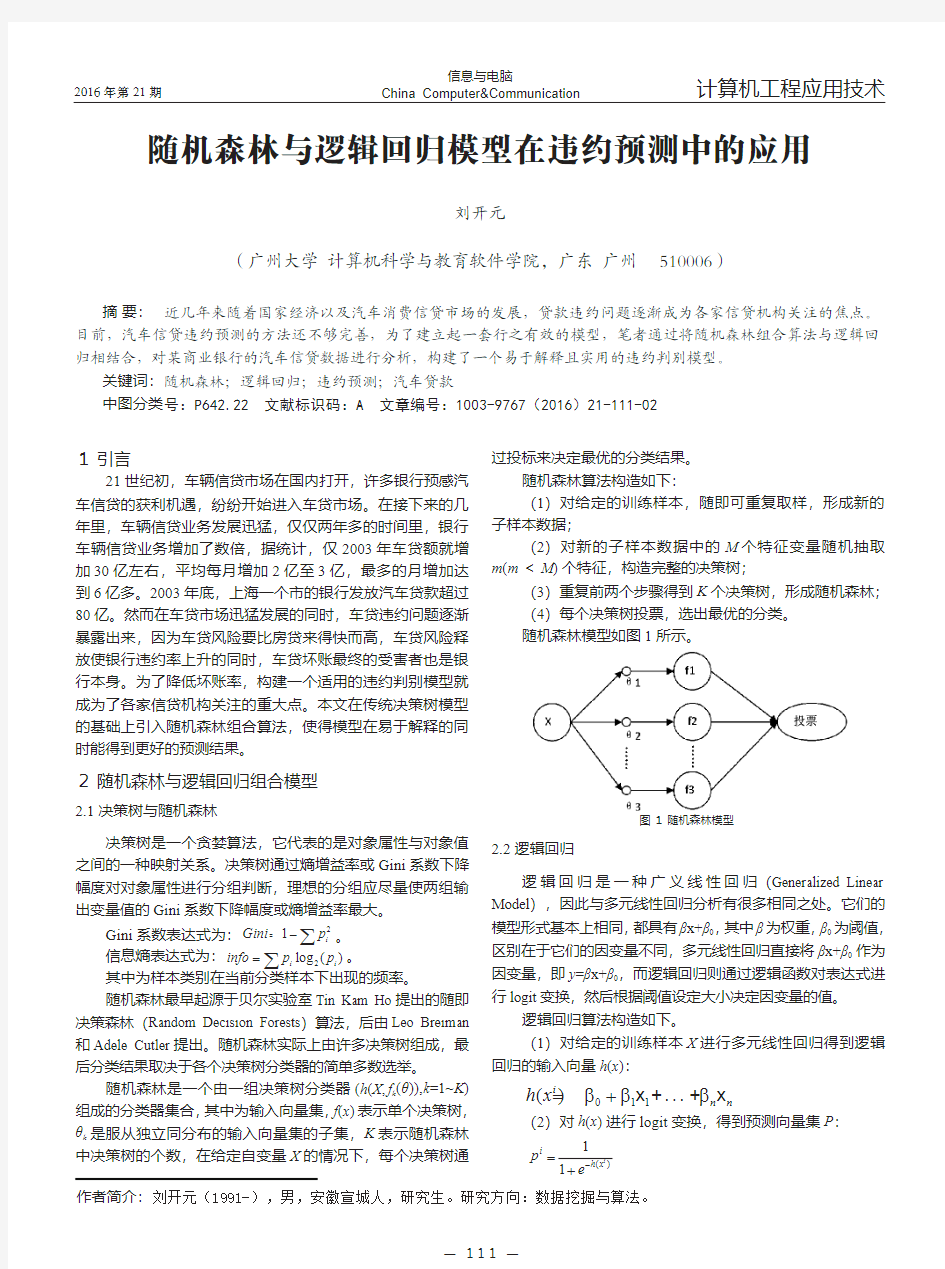

随机森林算法构造如下:

(1)对给定的训练样本,随即可重复取样,形成新的子样本数据;

(2)对新的子样本数据中的M 个特征变量随机抽取m (m <M )个特征,构造完整的决策树;

(3)重复前两个步骤得到K 个决策树,形成随机森林;(4)每个决策树投票,选出最优的分类。随机森林模型如图1

所示。

图1 随机森林模型

2.2 逻辑回归

逻辑回归是一种广义线性回归(Generalized Linear Model ),因此与多元线性回归分析有很多相同之处。它们的模型形式基本上相同,都具有βx+β0,其中β为权重,β0为阈值,区别在于它们的因变量不同,多元线性回归直接将βx+β0作为因变量,即y =βx+β0,而逻辑回归则通过逻辑函数对表达式进行logit 变换,然后根据阈值设定大小决定因变量的值。

逻辑回归算法构造如下。

(1)对给定的训练样本X 进行多元线性回归得到逻辑回归的输入向量h (x ): 011()

i

n n

h x βββ=+x +...+x (2)对h (x )进行logit 变换,得到预测向量集P :

()

1

1i

i

h x p e ?=

+作者简介:刘开元(1991-),男,安徽宣城人,研究生。研究方向:数据挖掘与算法。

— 111 —

生存分析-随机森林实验与代码

随机森林模型在生存分析中的应用 【摘要】目的:本文探讨随机森林方法用于高维度、强相关、小样本的生 存资料分析时,可以起到变量筛选的作用。方法:以乳腺癌数据集构建乳腺癌转 移风险评估模型为实例进行实证分析, 使用随机森林模型进行变量选择,然后拟 合cox 回归模型。 结果:随机森林模型通过对变量的选择,有效的解决数据维 度高且强相关的情况,得到了较高的 AUC 值。 一、数据说明 该乳腺癌数据集来自于NCBI ,有77个观测值以及22286个基因变量。通过 筛选选取454个基因变量。将数据随机分为训练集合测试集,其中2/3为训练集, 1/3为测试集。绘制K-M 曲线图: 二、随机森林模型 随机森林由许多的决策树组成,因为这些决策树的形成采用了随机的方法, 因此也叫做随机决策树。随机森林中的树之间是没有关联的。当测试数据进入随 机森林时,其实就是让每一颗决策树进行分类,最后取所有决策树中分类结果最 多的那类为最终的结果。因此随机森林是一个包含多个决策树的分类器, 并且其 输出的类别是由个别树输出的类别的众数而定 使用randomForestSRC 包得到的随机森林模型具有以下性质: Kaplan-Meker estlmaie wHh 95% conndence bounds S ?2 S

Number of deaths: 27 Number of trees: 800 Mini mum term inal node size: 3 Average no. of term inal no des: 14.4275 No. of variables tried at each split: 3 Total no. of variables: 452 Analysis: RSF Family: surv Splitting rule: logrank Error rate: 19.87% 发现直接使用随机森林得到的模型,预测误差很大,达到了19.8%进一步考虑使用随机森林模型进行变量选择,结果如下: > our.rf$rfsrc.refit.obj Sample size: 52 Number of deaths: 19 Number of trees: 500 Minimum terminal node size: 2 Average no. of term inal no des: 11.554 No. of variables tried at each split: 3 Total no. of variables: 9 Analysis: RSF Family: surv Splitting rule: logrank *random* Number of random split points: 10 Error rate: 11.4% > our.rf$topvars [1] "213821_s_at" "219778_at" "204690_at" "220788_s_at" "202202_s_at" [6] "211603_s_at" "213055_at" "219336_s_at" "37892_at" 一共选取了9个变量,同时误差只有11.4% 接下来,使用这些变量做cox回归,剔除模型中不显著(>0.01 )的变量,最终 参与模型建立的变量共有4个。模型结果如下: exp(coef) exp(-coef) lower .95 upper .95 '218150_at' 1.6541 0.6046 0.11086 24.6800 '200914_x_at' 0.9915 1.0086 0.34094 2.8833 '220788_s_at' 0.2649 3.7750 0.05944 1.1805 '201398_s_at' 1.7457 0.5729 0.33109 9.2038 '201719 s at' 2.4708 0.4047 0.93808 6.5081

逻辑回归模型分析见解

1.逻辑回归模型 1.1逻辑回归模型 考虑具有p个独立变量的向量,设条件概率为根据观测量相对于某事件发生的概率。逻辑回归模型可表示为 (1.1) 上式右侧形式的函数称为称为逻辑函数。下图给出其函数图象形式。 其中。如果含有名义变量,则将其变为dummy变量。一个具有k个取值的名义变量,将变为k-1个dummy变量。这样,有 (1.2) 定义不发生事件的条件概率为 (1.3) 那么,事件发生与事件不发生的概率之比为 (1.4) 这个比值称为事件的发生比(the odds of experiencing an event),简称为odds。因为0

得到的概率。在同样条件下得到的条件概率为。于是,得到一个观测值的概率为 (1.6) 因为各项观测独立,所以它们的联合分布可以表示为各边际分布的乘积。 (1.7) 上式称为n个观测的似然函数。我们的目标是能够求出使这一似然函数的值最大的参数估计。于是,最大似然估计的关键就是求出参数,使上式取得最大值。 对上述函数求对数 (1.8) 上式称为对数似然函数。为了估计能使取得最大的参数的值。 对此函数求导,得到p+1个似然方程。 (1.9) ,j=1,2,..,p. 上式称为似然方程。为了解上述非线性方程,应用牛顿-拉斐森(Newton-Raphson)方法进行迭代求解。 1.3牛顿-拉斐森迭代法 对求二阶偏导数,即Hessian矩阵为 (1.10) 如果写成矩阵形式,以H表示Hessian矩阵,X表示 (1.11) 令

MA AB 回归预测模型

MATLAB---回归预测模型 Matlab统计工具箱用命令regress实现多元线性回归,用的方法是最小二乘法,用法是: b=regress(Y,X) [b,bint,r,rint,stats]=regress(Y,X,alpha) Y,X为提供的X和Y数组,alpha为显着性水平(缺省时设定为0.05),b,bint为回归系数估计值和它们的置信区间,r,rint为残差(向量)及其置信区间,stats 是用于检验回归模型的统计量,有四个数值,第一个是R2,第二个是F,第三个是与F对应的概率 p ,p <α拒绝 H0,回归模型成立,第四个是残差的方差 s2 。 残差及其置信区间可以用 rcoplot(r,rint)画图。 例1合金的强度y与其中的碳含量x有比较密切的关系,今从生产中收集了一批数据如下表 1。 先画出散点图如下: x=0.1:0.01:0.18; y=[42,41.5,45.0,45.5,45.0,47.5,49.0,55.0,50.0]; plot(x,y,'+') 可知 y 与 x 大致上为线性关系。

设回归模型为y =β 0+β 1 x 用regress 和rcoplot 编程如下: clc,clear x1=[0.1:0.01:0.18]'; y=[42,41.5,45.0,45.5,45.0,47.5,49.0,55.0,50.0]'; x=[ones(9,1),x1]; [b,bint,r,rint,stats]=regress(y,x); b,bint,stats,rcoplot(r,rint) 得到 b =27.4722 137.5000 bint =18.6851 36.2594 75.7755 199.2245 stats =0.7985 27.7469 0.0012 4.0883 即β 0=27.4722 β 1 =137.5000 β 的置信区间是[18.6851,36.2594], β 1 的置信区间是[75.7755,199.2245]; R2= 0.7985 , F = 27.7469 , p = 0.0012 , s2 =4.0883 。

随机森林实验报告

随机森林实验报告 实验目的 实现随机森林模型并测试。 实验问题 Kaggle第二次作业Non-linear classification 算法分析与设计 一.算法设计背景: 1.随机森林的原子分类器一般使用决策树,决策树又分为拟合树和分类树。这两者的区别在于代价估值函数的不同。 2.根据经验,用拟合树做分类的效果比分类树略好。 3.对于一个N分类问题,它总是可以被分解为N个2分类问题,这样分解的好处是其决策树更加方便构造,更加简单,且更加有利于用拟合树来构建分类树。对于每一个2分类问题,构造的树又叫CART树,它是一颗二叉树。 4.将N个2分类树的结果进行汇总即可以得到多分类的结果。 树构造:

6.随机森林构造: 二.算法思路: 将一个N分类问题转化为N个二分类问题。转化方法是:构造N棵二叉拟合树,这里假设N为26,然后我们给N棵二叉树依次标号为1,2,3...26。1号树的结果对应于该条记录是不是属于第一类,是则输出1,否则输出号树的结果对应于该条记录是不是属于第二类,是则1否则0,依此类推。这样,我们的26棵二叉树的结果就对应了26个下标。 例如对于某条记录,这26个二叉树的结果按序号排列为{0,0,0,0,0,0,0,0,0,0,0,0,0,0,0,...1,0},那么这条记录的分类应该为25。要将一个26维的0,1序列变回

一个索引,我们只需要找出这个序列中值最大的元素的索引,这个索引即是序列号。 我们将上面的26棵分别对26个索引做是否判断的二分类树视为一个整体,在多线程的环境下,构造多个这样的整体,然后进行求和运算,最后取出每个结果序列中值最大的元素的下标作为分类值,那么久得到了我们想要的结果,随机森林完成。 三.算法流程: 1.读入训练集trainset,测试集testset 2.将训练集分割为输入trainIn,输出trainOut 3.这里假设类别数N为26,将trainOut[记录条数] 映射为 transformTrainOut[训练记录数][26] 4.初始化transformTestOut[测试记录数][26]全部为0 i = 1 : ForestSize: 策树 在这里,我们每一次26分类是由26棵CART共同完成的,CART的cost function采用的是gini系数,CART的最大层数为7,分裂停止条件为当前节点GINI为0或者当前节点所在层数到达了7. 2.随机森林 a.随机森林每次循环的训练集采样为原训练集的. b.对于森林中每一棵决策树每一次分割点的选取,对属性进行了打乱抽样,抽样数为25,即每次分割只在25个属性中寻找最合适的值。并且对于每个选取的属性,我们进行了行采样。即如果这个属性所拥有的属性值数大于30,我们选取其中30个作为分割候选,如果小于30,则全部纳入分割候选。 四.代码详解 1.训练集/测试集的读入 a.在中定义了:

二元logistic逻辑回归分析1

SPSS与社会统计学课程作业二 [1]陈昱,陈银蓉,马文博. 基于Logistic模型的水库移民安置区居民土地流转意愿分析——四川、湖南、湖北移民安置区的调查[J]. 资源科学,2011,06:1178-1185. 一、变量赋值 1.被解释变量用0表示不愿意流转,1表示愿意流转,有意愿上的状态表示效果。 2.性别分别用1和2表示男女,男女不存在有没有状态的表征,所以用1、2赋值非常合适;它的预计影响方向为负,是基于学者张林秀、刘承芳等认为:由于农村男性外出打工的几率高于女性,女性更愿意在家耕种土地,这就可能导致女性不愿意转出土地的基础上设定的。 3.教育程度越高赋值越高,且预测影响为正,这个也是在文章前面定量分析的时候引用学者李实的观点说明赋值的理由。 4.职业类型中,兼业化程度越高赋值越高,且为正向。从家庭收入对农业收入的依赖性原理角度来看这个不难理解。 5.其它变量的赋值依据实际情况初步判断也不能理解其赋值的缘由。然而对于“是否为村干部”这一变量来看,预测的趋向是:是村干部则不愿意流转,前面的分析并没有说明为什么会是这样。虽然这知识一种预判,但是若能够给出预判的一丁点理由就更好了。 二、系数解读

1.标准化系数中,x1,x3,x7,x9,x11,x12系数为付,意味着性别是男、与市中心距离 越近、家庭人口和劳动力人数越少、农业收入占比越少、认为土地经营权权属则土地流转的意愿越强; 2.其中X3(与市中心距离),x9(劳动力人数)影响系数绝对值较大,分别为0.815,0.322。 在显著性检验方面,x3、x9、x11分别通过了15%、1%、5%的显著性检验。也就是说,土地不愿意流转与劳动力人数多有显著相关性,与农业收入占比高有较显著的相关,与市中心距离近相关性不显著。 3.系数为正的变量中,影响系数均不高,但能通过显著性检验的有:x2、x5(15%);x10、 x13(5%);x4(1%)。说明文化程度高对愿意流转的影响是非常显著的,而且在系数为正的变量中,x4的系数为最大,说明x4与y(1)显著相关。 三、模型检验

完整版逻辑回归模型分析见解

1.逻辑回归模型 1.1 逻辑回归模型 考虑具有p个独立变量的向量■',设条件概率卩;上二?丨门二广为根据观测 量相对于某事件发生的概率。逻辑回归模型可表示为 :「( 1.1) 上式右侧形式的函数称为称为逻辑函数。下图给出其函数图象形式。 其中-" I' 1 c' ■-..【?。如果含有名义变量,则将其变为dummy 变量。一个具有k个取值的名义变量,将变为k-1个dummy 变量。这样,有 — I ( 1.2) 这个比值称为事件的发生比(the odds of experie ncing an event), 0

得到I 的概率。在同样条件下得到-- 的条件概率为丨:一"。 得到一个观测值的概率为 因为各项观测独立,所以它们的联合分布可以表示为各边际分布的乘积。 (1.7) 上式称为n个观测的似然函数。我们的目标是能够求出使这一似然函数的值最大的参数估 譏备心)( 」' (1.10 是, ◎ )*(1 ¥严(1.6 ) i-l 计。于是,最大似然估计的关键就是求出参数:- ,使上式取得最大值。 对上述函数求对数 — (1.8) 上式称为对数似然函数。为了估计能使亠取得最大的参数的值。 对此函数求导,得到p+1个似然方程。 Ei 片 n:—E L尹—心肿一时 (1.9 ) ^叶切迄尸,j=1,2,..,p. 上式称为似然方程。为了解上述非线性方程,应用牛顿-拉斐森 进行迭代求解。 (Newto n-Raphs on) 方法1.3 牛顿-拉斐森迭代法 对-八?求二阶偏导数,即Hessian矩阵为 如果写成矩阵形式,以H表示Hessian矩阵,X表示 (1.11 )

随机森林算法介绍及R语言实现

随机森林算法介绍及R语言实现 随机森林算法介绍 算法介绍: 简单的说,随机森林就是用随机的方式建立一个森林,森林里面有很多的决策树,并且每棵树之间是没有关联的。得到一个森林后,当有一个新的样本输入,森林中的每一棵决策树会分别进行一下判断,进行类别归类(针对分类算法),最后比较一下被判定哪一类最多,就预测该样本为哪一类。 随机森林算法有两个主要环节:决策树的生长和投票过程。 决策树生长步骤: 1.从容量为N的原始训练样本数据中采取放回抽样方式(即bootstrap取样) 随机抽取自助样本集,重复k(树的数目为k)次形成一个新的训练集N,以此生成一棵分类树; 2.每个自助样本集生长为单棵分类树,该自助样本集是单棵分类树的全部训 练数据。设有M个输入特征,则在树的每个节点处从M个特征中随机挑选m(m < M)个特征,按照节点不纯度最小的原则从这m个特征中选出一个特征进行分枝生长,然后再分别递归调用上述过程构造各个分枝,直到这棵树能准确地分类训练集或所有属性都已被使用过。在整个森林的生长过程中m将保持恒定; 3.分类树为了达到低偏差和高差异而要充分生长,使每个节点的不纯度达到 最小,不进行通常的剪枝操作。 投票过程: 随机森林采用Bagging方法生成多个决策树分类器。 基本思想: 1.给定一个弱学习算法和一个训练集,单个弱学习算法准确率不高,可以视 为一个窄领域专家; 2.将该学习算法使用多次,得出预测函数序列,进行投票,将多个窄领域专 家评估结果汇总,最后结果准确率将大幅提升。 随机森林的优点: ?可以处理大量的输入变量; ?对于很多种资料,可以产生高准确度的分类器; ?可以在决定类别时,评估变量的重要性; ?在建造森林时,可以在内部对于一般化后的误差产生不偏差的估计;

Logistic回归分析报告结果解读分析

L o g i s t i c回归分析报告结果解读分析 Company number:【0089WT-8898YT-W8CCB-BUUT-202108】

Logistic回归分析报告结果解读分析Logistic回归常用于分析二分类因变量(如存活和死亡、患病和未患病等)与多个自变量的关系。比较常用的情形是分析危险因素与是否发生某疾病相关联。例如,若探讨胃癌的危险因素,可以选择两组人群,一组是胃癌组,一组是非胃癌组,两组人群有不同的临床表现和生活方式等,因变量就为有或无胃癌,即“是”或“否”,为二分类变量,自变量包括年龄、性别、饮食习惯、是否幽门螺杆菌感染等。自变量既可以是连续变量,也可以为分类变量。通过Logistic回归分析,就可以大致了解胃癌的危险因素。 Logistic回归与多元线性回归有很多相同之处,但最大的区别就在于他们的因变量不同。多元线性回归的因变量为连续变量;Logistic回归的因变量为二分类变量或多分类变量,但二分类变量更常用,也更加容易解释。 回归的用法 一般而言,Logistic回归有两大用途,首先是寻找危险因素,如上文的例子,找出与胃癌相关的危险因素;其次是用于预测,我们可以根据建立的Logistic回归模型,预测在不同的自变量情况下,发生某病或某种情况的概率(包括风险评分的建立)。 2.用Logistic回归估计危险度 所谓相对危险度(risk ratio,RR)是用来描述某一因素不同状态发生疾病(或其它结局)危险程度的 比值。Logistic回归给出的OR(odds ratio)值与相对危险度类似,常用来表示相对于某一人群,另一人群发生终点事件的风险超出或减少的程度。如不同性别的胃癌发生危险不同,通过Logistic回归可以求出危险度的具体数值,例如,这样就表示,男性发生胃癌的风险是女性的倍。这里要注意估计的方向问题,以女性作为参照,男性患胃癌

SPSS操作方法:逻辑回归

SPSS操作方法之五 SPSS操作方法:逻辑回归 例证8.3: 在一次关于公共交通的社会调查中,一个调查项目是“乘公交车上下班,还是骑自行车上下班”因变量Y=1表示乘车,Y=0表示骑车。自变量X1表示年龄;X2表示表示月收入;X3表示性别,取1时为男性,取0时为女性。调查对象为工薪族群体。数据见下表:试建立Y与自变量之间的Logistic回归。 逻辑回归SPSS操作方法的具体步骤: 1.选择Analyze→Regreessin→Binary Logistic,打开对话框如图1所示:

图1 主对话框Logistic回归。 2.选择因变量Y进入Dependent框内,将自变量选择进入Convariates框。也可以将不同的自变量组放在不同的块(block)中,可以分析不同的自变量组对因变量的贡献。 3.在Mothed框内选择自变量的筛选策略: Enter表示强行进入法;(本例选择) Forword和Bacword都表示逐步筛选策略;Forword 为自变量逐步进入,Bacword是自变量逐步剔出。Conditional ;LR; Wald分别表示不同的检验统计量,如Forword Wald表示自变量进入方程的依据是Wald统计量。 4.在Selection中选择一个变量作为条件变量,只有满足条件的变量数据才能参与回归分析。 5.单击Categorical打开Categorical对话框如图2所示:对定性变量的自变量选择参照类。常用的方法是Indicator,即以某个特定的类为参照类,Last表示以最大值对应的类为参照类(系统默认),First表示以最小值对应的类为参照类。选择后点击Continue按钮返回主对话框。(本例不作选择性) 图2 Categorical对话框 6.单击Option按钮,打开Option对话框如图3所示

线性回归和灰色预测模型案例

预测未来2015年到2020年的货运量 灰色预测模型 是通过少量的、不完全的信息,建立数学模型并做出预测的一种预测方法.当我们应用运筹学的思想方法解决实际问题,制定发展战略和政策、进行重大问题的决策时,都必须对未来进行科学的预测. 预测是根据客观事物的过去和现在的发展规律,借助于科学的方法对其未来的发展趋势和状况进行描述和分析,并形成科学的假设和判断. 灰色系统的定义 灰色系统是黑箱概念的一种推广。我们把既含有已知信息又含有未知信息的系统称为灰色系统.作为两个极端,我们将称信息完全未确定的系统为黑色系统;称信息完全确定的系统为白色系统.区别白色系统与黑色系统的重要标志是系统各因素之间是否具有确定的关系。

建模原理 模型的求解

原始序列为: ) 16909 15781 13902 12987 12495 11067 10149 9926 9329 10923 7691())6(),...1(()0()0()0(==x x x 构造累加生成序列 ) 131159,114250,98469,84567,71580,59085, 48018,37869,27943,18614,7691())6(),...1(()1()1()1(==x x x 归纳上面的式子可写为 称此式所表示的数据列为原始数据列的一次累加生成,简称为一次累加生成. 对(1)X 作紧邻均值生成 ,.... 2)) 1()((21)()1() 1() 1(=-+=k k z k z k z MATLAB 代码如下: x=[7691 18614 27943 37869 48018 590857 71580 84567 98469 114250 131159]; z(1)=x(1); for i=2:6 z(i)=0.5*(x(i)+x(i-1)); end format long g z z = Columns 1 through 3 7691 13152.5 23278.5 Columns 4 through 6 32906 42943.5 319437.5

随机森林与逻辑回归模型在违约预测中的应用

2016年第21期 信息与电脑 China Computer&Communication 计算机工程应用技术 随机森林与逻辑回归模型在违约预测中的应用 刘开元 (广州大学 计算机科学与教育软件学院,广东 广州 510006) 摘 要:近几年来随着国家经济以及汽车消费信贷市场的发展,贷款违约问题逐渐成为各家信贷机构关注的焦点。目前,汽车信贷违约预测的方法还不够完善,为了建立起一套行之有效的模型,笔者通过将随机森林组合算法与逻辑回归相结合,对某商业银行的汽车信贷数据进行分析,构建了一个易于解释且实用的违约判别模型。 关键词:随机森林;逻辑回归;违约预测;汽车贷款 中图分类号:P642.22 文献标识码:A 文章编号:1003-9767(2016)21-111-02 1 引言 21世纪初,车辆信贷市场在国内打开,许多银行预感汽车信贷的获利机遇,纷纷开始进入车贷市场。在接下来的几年里,车辆信贷业务发展迅猛,仅仅两年多的时间里,银行车辆信贷业务增加了数倍,据统计,仅2003年车贷额就增加30亿左右,平均每月增加2亿至3亿,最多的月增加达到6亿多。2003年底,上海一个市的银行发放汽车贷款超过80亿。然而在车贷市场迅猛发展的同时,车贷违约问题逐渐暴露出来,因为车贷风险要比房贷来得快而高,车贷风险释放使银行违约率上升的同时,车贷坏账最终的受害者也是银行本身。为了降低坏账率,构建一个适用的违约判别模型就成为了各家信贷机构关注的重大点。本文在传统决策树模型的基础上引入随机森林组合算法,使得模型在易于解释的同时能得到更好的预测结果。 2 随机森林与逻辑回归组合模型 2.1 决策树与随机森林 决策树是一个贪婪算法,它代表的是对象属性与对象值之间的一种映射关系。决策树通过熵增益率或Gini 系数下降幅度对对象属性进行分组判断,理想的分组应尽量使两组输出变量值的Gini 系数下降幅度或熵增益率最大。 Gini 系数表达式为:2 1i Gini p =?∑。信息熵表达式为:2log ()i i info p p =∑。 其中为样本类别在当前分类样本下出现的频率。 随机森林最早起源于贝尔实验室Tin Kam Ho 提出的随即决策森林(Random Decision Forests )算法,后由Leo Breiman 和Adele Cutler 提出。随机森林实际上由许多决策树组成,最后分类结果取决于各个决策树分类器的简单多数选举。 随机森林是一个由一组决策树分类器(h (X ,f k (θ)),k =1~K )组成的分类器集合,其中为输入向量集, f (x )表示单个决策树,θk 是服从独立同分布的输入向量集的子集,K 表示随机森林中决策树的个数,在给定自变量X 的情况下,每个决策树通 过投标来决定最优的分类结果。 随机森林算法构造如下: (1)对给定的训练样本,随即可重复取样,形成新的子样本数据; (2)对新的子样本数据中的M 个特征变量随机抽取m (m <M )个特征,构造完整的决策树; (3)重复前两个步骤得到K 个决策树,形成随机森林;(4)每个决策树投票,选出最优的分类。随机森林模型如图1 所示。 图1 随机森林模型 2.2 逻辑回归 逻辑回归是一种广义线性回归(Generalized Linear Model ),因此与多元线性回归分析有很多相同之处。它们的模型形式基本上相同,都具有βx+β0,其中β为权重,β0为阈值,区别在于它们的因变量不同,多元线性回归直接将βx+β0作为因变量,即y =βx+β0,而逻辑回归则通过逻辑函数对表达式进行logit 变换,然后根据阈值设定大小决定因变量的值。 逻辑回归算法构造如下。 (1)对给定的训练样本X 进行多元线性回归得到逻辑回归的输入向量h (x ): 011() i n n h x βββ=+x +...+x (2)对h (x )进行logit 变换,得到预测向量集P : () 1 1i i h x p e ?= +作者简介:刘开元(1991-),男,安徽宣城人,研究生。研究方向:数据挖掘与算法。 — 111 —

Logistic回归分析报告结果解读分析

Logistic回归分析报告结果解读分析Logistic回归常用于分析二分类因变量(如存活和死亡、患病和未患病等)与多个自变量的关系。比较常用的情形是分析危险因素与是否发生某疾病相关联。例如,若探讨胃癌的危险因素,可以选择两组人群,一组是胃癌组,一组是非胃癌组,两组人群有不同的临床表现和生活方式等,因变量就为有或无胃癌,即“是”或“否”,为二分类变量,自变量包括年龄、性别、饮食习惯、是否幽门螺杆菌感染等。自变量既可以是连续变量,也可以为分类变量。通过Logistic 回归分析,就可以大致了解胃癌的危险因素。 Logistic回归与多元线性回归有很多相同之处,但最大的区别就在于他们的因变量不同。多元线性回归的因变量为连续变量;Logistic回归的因变量为二分类变量或多分类变量,但二分类变量更常用,也更加容易解释。 回归的用法 一般而言,Logistic回归有两大用途,首先是寻找危险因素,如上文的例子,找出与胃癌相关的危险因素;其次是用于预测,我们可以根据建立的Logistic 回归模型,预测在不同的自变量情况下,发生某病或某种情况的概率(包括风险评分的建立)。 2.用Logistic回归估计危险度 所谓相对危险度(risk ratio,RR)是用来描述某一因素不同状态发生疾病(或其它结局)危险程度的 比值。Logistic回归给出的OR(odds ratio)值与相对危险度类似,常用来表示相对于某一人群,另一人群发生终点事件的风险超出或减少的程度。如不同性别的胃癌发生危险不同,通过Logistic回归可以求出危险度的具体数值,例如,这样就表示,男性发生胃癌的风险是女性的倍。这里要注意估计的方向问题,以女性作为参照,男性患胃癌的OR是。如果以男性作为参照,算出的OR将会是(1/,表示女性发生胃癌的风险是男性的倍,或者说,是男性的%。撇开了参照组,相对危险度就没有意义了。

逻辑回归模型分析见解

逻辑回归模型分析见解

1.逻辑回归模型 1.1逻辑回归模型 考虑具有P个独立变量的向量*=(Xl,X2,”q),设条件概率= 为根据观测量相对于某事件发生 的概率。逻辑回归模型可表示为 1 L十严 上式右侧形式的函数称为称为逻辑函数。下图给出其函数图象形式。 其中。如果含有名义变量,则将其变为dummy 变量。一个具有k个取值的名义变量,将变为k-1个dummy 变量。这样,有 定义不发生事件的条件概率为 (1.1) (1.2)

尸wmx 十各-占 (1.3 ) 那么,事件发生与事件不发生的概率之比为 F (H =1|幻—P “曲 = Q | x ) \-p 这个比值称为事件 的发生比 (the odds of experie ncing an eve nt), 简称为 odds 。 因为0

于是,最大似然估计的关键就是求出参数 ,使上式取得 最大值。 对上述函数求对数 山应?*的?召仙恥区;]丨门丫」訓:叩丄】 (i 8 ) 上式称为对数似然函数。为了估计能使 £(旳取得 最大的参数的值。 对此函数求导,得到p+1个似然方程。 纠片-v 相严纠# _ ]新.站卄”和丸 (i 9 ) 圣屮.『;-* 几-百工 一 f Ji' j=1 2 p 上式称为似然方程。为了解上述非线性方程,应 用牛顿一拉斐森 (Newto n-Raphso n ) 方法 进行迭代求解。 亦占二址(1-隔) 兰丝二-S 耳赳兀(1-花) 阴阴处心“ (1.10 ) 如果写成矩阵形式,以H 表示 Hessian 矩阵, X 表示 1.3 牛顿-拉斐森迭代法 对心;求二阶偏导数,即Hessian 矩阵为 护 M - i-l

实验报告及分析_R中bagging回归与随机森林以及boosting回归

一、R中boosting回归 这个主要用R中的mboost包中的mboost函数来实现。但是作为铺助,还要加载party包。函数如下 mboost(formula, data = list(),baselearner = c("bbs", "bols", "btree", "bss", "bns"), ...) 其中的参数需要注意formula的输入格式。至于data也可以是数据框。我们用决策树的boosting方法。要注意查看formula的输入格式,参见下面的具体例子。 一个具体的例子 我们使用我的电脑上自带的数据,即E:\Documents\R中的mg文本文件中的数据。该数据无任何说明,知道它是由6个自变量和一个因变量构成。试验如下。 > library(party) > library(mboost) > w<-read.table('mg.txt',header=T) >B1<-mboost(y~btree(x1)+btree(x2)+btree(x3)+btree(x4)+btree(x5)+btre e(x6),data=w[-1,]) #构建分类器,用除掉第一个样本的数据做训练数据。>y0<-predict(B1,w[1,]) #用第一个样本作测试。 二、bagging回归

与boosting回归想法类似,bagging回归的做法就是不断放回地对训练样本进行再抽样,对每个自助样本都建立一棵回归树,对于每一个观测,每棵树给一个预测,最后将其平均。 使用到的函数包为ipred,使用函数为bagging(),用法如下:bagging(formula, data, subset, na.action=na.rpart, ...) 主要参数介绍: formula:回归方程形式 data:数据集(数据框) control:对树枝的控制,使用函数rpart.control(),可以控制诸如cp值,xval等参量。(注意必须加载过rpart包,才能找到rpart.control 函数) 下面是用bagging对iris数据进行测试的例子。 > data(iris) > ir<-iris > set.seed(124) > count.test<-round(runif(50,1,150)) > test<-ir[count.test,] > library(ipred) > reg<-bagging(Species~.,data=ir)

Logistic回归模型

Logistic 回归模型 1 Logistic 回归模型的基本知识 1.1 Logistic 模型简介 主要应用在研究某些现象发生的概率p ,比如股票涨还是跌,公司成功或失败的概率,以及讨论概率 p 与那些因素有关。显然作为概率值,一定有10≤≤p ,因此很难用线性模型描述概率p 与自变量的关 系,另外如果p 接近两个极端值,此时一般方法难以较好地反映p 的微小变化。为此在构建p 与自变量关系的模型时,变换一下思路,不直接研究p ,而是研究p 的一个严格单调函数)(p G ,并要求)(p G 在p 接近两端值时对其微小变化很敏感。于是Logit 变换被提出来: p p p Logit -=1ln )( (1) 其中当p 从10→时,)(p Logit 从+∞→∞-,这个变化范围在模型数据处理上带来很大的方便, 解决了上述面临的难题。另外从函数的变形可得如下等价的公式: X T X T T e e p X p p p Logit βββ+= ?=-=11ln )( (2) 模型(2)的基本要求是,因变量(y )是个二元变量,仅取0或1两个值,而因变量取1的概率 )|1(X y P =就是模型要研究的对象。而T k x x x X ),,,,1(21 =,其中i x 表示影响y 的第i 个因素,它可以 是定性变量也可以是定量变量,T k ),,,(10ββββ =。为此模型(2)可以表述成: k x k x k x k x k k e e p x x p p βββββββββ+++++++=?+++=- 1101 1011011ln (3) 显然p y E =)(,故上述模型表明) (1) (ln y E y E -是k x x x ,,,21 的线性函数。此时我们称满足上面条件 的回归方程为Logistic 线性回归。 Logistic 线性回归的主要问题是不能用普通的回归方式来分析模型,一方面离散变量的误差形式服从伯努利分布而非正态分布,即没有正态性假设前提;二是二值变量方差不是常数,有异方差性。不同于多元线性回归的最小二乘估计法则(残差平方和最小),Logistic 变换的非线性特征采用极大似然估计的方法寻求最佳的回归系数。因此评价模型的拟合度的标准变为似然值而非离差平方和。 定义1 称事件发生与不发生的概率比为 优势比(比数比 odds ratio 简称OR),形式上表示为 OR= k x k x e p p βββ+++=- 1101 (4) 定义2 Logistic 回归模型是通过极大似然估计法得到的,故模型好坏的评价准则有似然值来表征,称 -2?ln ()L β 为估计值β?的拟合似然度,该值越小越好,如果模型完全拟合,则似然值?()L β为1,而拟合似然度达到最小,值为0。其中?()lnL β 表示β?的对数似然函数值。 定义3 记)?(β Var 为估计值β?的方差-协方差矩阵,2 1 )]?([)?(ββVar S =为β?的标准差矩阵,则称 k i S w ii i i ,,2,1,]?[ 2 ==β (5) 为i β?的Wald 统计量,在大样本时,i w 近似服从)1(2 χ分布,通过它实现对系数的显著性检验。

随机森林

随机森林 为了克服决策树容易过度拟合的缺点,Breiman(2001)提出了一种新的组合分类器算法——随机森林算法(Random Forests , RF)。他把分类决策树组合成随即森林,即在变量(列)的使用和数据(行)的使用上进行随机化,生成很多分类树,再汇总分类树的结果。随机森林在运算量没有显著提高的前提下提高了预测精度,对多元共线性不敏感,可以很好地预测多达几千个解释变量的作用,被称为当前最好的算法之一。 基本原理 1.随机森林的定义 随机森林是一个由决策树分类器集合{} θ构成的组合分类器模 x ,2,1 k h (= ), , k 型,其中参数集{} θ是独立同分布的随机向量,x是输入向量。当给定输入向量 k 时每个决策树有一票投票权来选择最优分类结果。每一个决策树是由分类回归树(CART)算法构建的未剪枝的决策树。因此与CART相对应,随机森林也分为随机分类森林和随机回归森林。目前,随机分类森林的应用较为普遍,它的最终结果是单棵树分类结果的简单多数投票。而随机回归森林的最终结果是单棵树输出结果的简单平均。 2.随机森林的基本思想 随机森林是通过自助法(Bootstrap)重复采样技术,从原始训练样本集N 中有放回地重复随机抽取k个样本生成新的训练集样本集合,然后根据自助样本生成k决策树组成的随机森林。其实质是对决策树算法的一种改进,将多个决策树合并在一起,每棵树的建立依赖一个独立抽取的样本,森林中的每棵树具有相同的分布,分类误差取决于每一棵树的分类能力和它之间的相关性。 3.随机森林的生成过程 根据随机森林的原理和基本思想,随机森林的生成主要包括以下三个步骤:首先,通过Bootstrap方法在原始样本集S中抽取k个训练样本集,一般情况下每个训练集的样本容量与S一致; 其次,对k个训练集进行学习,以此生成k个决策树模型。在决策树生成过

基于因子分析和Logistic回归分析的

基于因子分析和Logistic回归分析的 儿童心理发展状况及其对策研究 摘要:目前,在儿童心理健康研究中,归纳方法已经比较成熟了,而对数据进行数学分析的方法还不够完善,本文主要运用因子分析、主成分分析和Logistics分析等多元统计学中的分析方法,对儿童心理健康状况做了一定的科学分析。通过分析,得到了影响孩子心理健康的因素,并提出针对性的解决方案,提出了一些行之有效的解决措施。通过归纳法与数据分析法的比较,数据分析比归纳法更具有科学依据也更为准确。 关键词:因子分析;主成分分析;Logistics回归分析;心理健康;儿童 Abstract:At present, in the study of children's mental health, the method of induction has become more mature, and the method of mathematical analysis of data is still not perfect. This article mainly uses multivariate analysis methods such as factor analysis, principal component analysis, and logistic analysis. The children's mental health status has done some scientific analysis. Through analysis, the factors that affect the children's mental health are obtained, and specific solutions are proposed, and some effective solutions are proposed. By comparing the induction method with the data analysis method, the data analysis is more scientific and accurate than the induction method. Key word: Factor analysis; Principal component analysis; Logistics analysis ; Mental health; Children

对线性回归逻辑回归各种回归的概念学习以与一些误差等具体含义

对线性回归、逻辑回归、各种回归的概念学习回归问题的条件/前提: 1)收集的数据 2)假设的模型,即一个函数,这个函数里含有未知的参数,通过学习,可以估计出参数。然后利用这个模型去预测/分类新的数据。 1. 线性回归 假设特征和结果都满足线性。即不大于一次方。这个是针对收集的数据而言。 收集的数据中,每一个分量,就可以看做一个特征数据。每个特征至少对应一个未知的参数。这样就形成了一个线性模型函数,向量表示形式: 这个就是一个组合问题,已知一些数据,如何求里面的未知参数,给出一个最优解。一个线性矩阵方程,直接求解,很可能无法直接求解。有唯一解的数据集,微乎其微。 基本上都是解不存在的超定方程组。因此,需要退一步,将参数求解问题,转化为求最小误差问题,求出一个最接近的解,这就是一个松弛求解。 求一个最接近解,直观上,就能想到,误差最小的表达形式。仍然是一个含未知参数的线性模型,一堆观测数据,其模型与数据的误差最小的形式,模型与数据差的平方和最小: 这就是损失函数的来源。接下来,就是求解这个函数的方法,有最小二乘法,梯度下降法。 https://www.360docs.net/doc/c64132319.html,/wiki/%E7%BA%BF%E6%80%A7%E6%96%B9%E7%A8%8B%E7%BB%84 最小二乘法 是一个直接的数学求解公式,不过它要求X是列满秩的, 梯度下降法 分别有梯度下降法,批梯度下降法,增量梯度下降。本质上,都是偏导数,步长/最佳学习率,更新,收敛的

问题。这个算法只是最优化原理中的一个普通的方法,可以结合最优化原理来学,就容易理解了。 2. 逻辑回归 逻辑回归与线性回归的联系、异同? 逻辑回归的模型是一个非线性模型,sigmoid函数,又称逻辑回归函数。但是它本质上又是一个线性回归模型,因为除去sigmoid映射函数关系,其他的步骤,算法都是线性回归的。可以说,逻辑回归,都是以线性回归为理论支持的。只不过,线性模型,无法做到sigmoid的非线性形式,sigmoid可以轻松处理0/1分类问题。 另外它的推导含义:仍然与线性回归的最大似然估计推导相同,最大似然函数连续积(这里的分布,可以使伯努利分布,或泊松分布等其他分布形式),求导,得损失函数。 逻辑回归函数 表现了0,1分类的形式。 应用举例: 是否垃圾分类? 是否肿瘤、癌症诊断? 是否金融欺诈? 3. 一般线性回归 线性回归是以高斯分布为误差分析模型;逻辑回归采用的是伯努利分布分析误差。 而高斯分布、伯努利分布、贝塔分布、迪特里特分布,都属于指数分布。 而一般线性回归,在x条件下,y的概率分布p(y|x) 就是指指数分布.