web系统性能测试报告)

1.总述

1.1测试对象

web系统

1.2测试目的

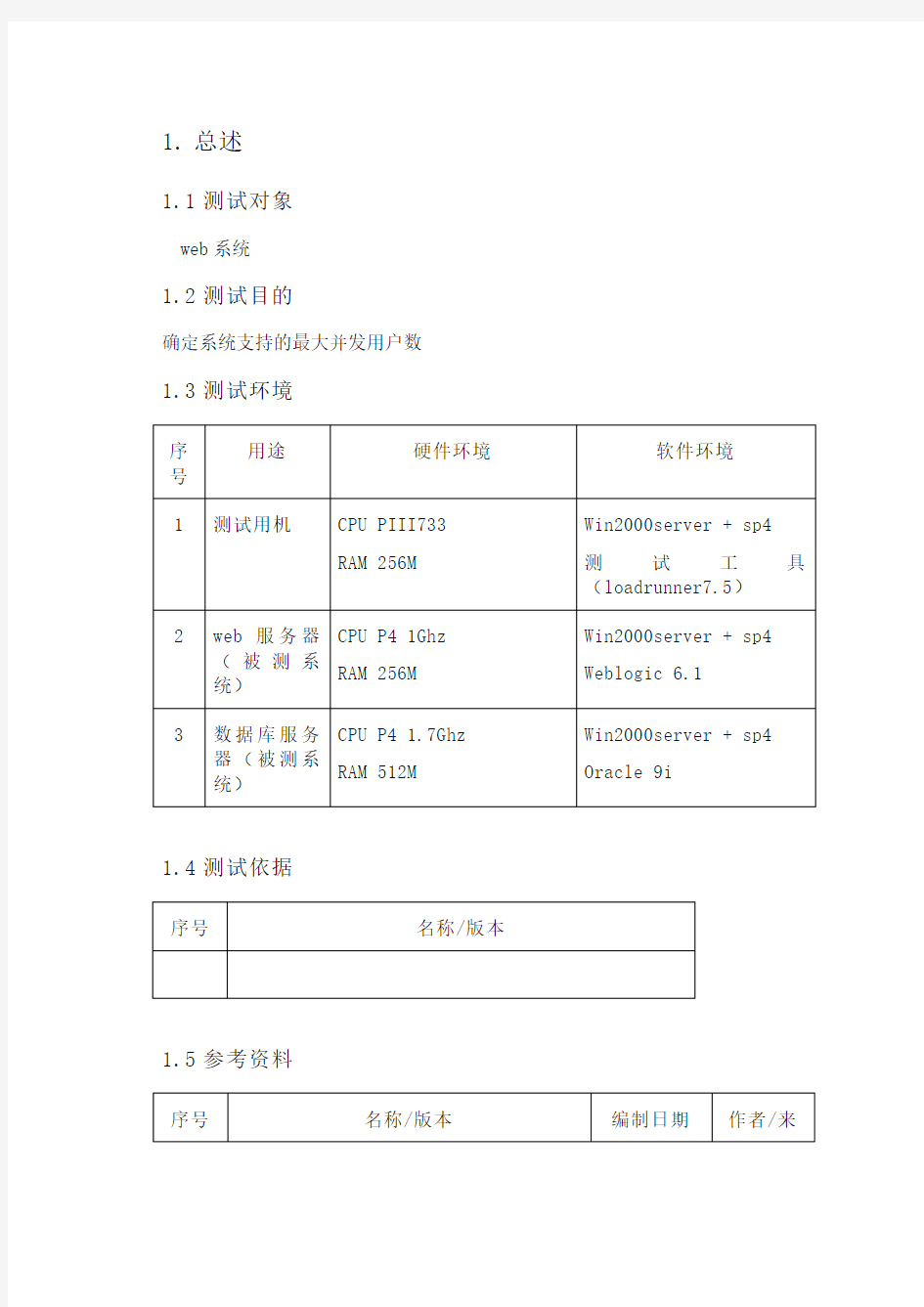

确定系统支持的最大并发用户数1.3测试环境

1.4测试依据

1.5参考资料

1.6术语及缩写词

●测试时间:一轮测试从开始到结束所使用的时间

●并发线程数:测试时同时访问被测系统的线程数。注意,由于测试过程中,每

个线程都是以尽可能快的速度发请求,与实际用户的使用有极大差别,所以,此数据不等同于实际使用时的并发用户数。

●每次时间间隔:测试线程发出一个请求,并得到被测系统的响应后,间隔多少

时间发出下一次请求。

●平均响应时间:测试线程向被测系统发请求,所有请求的响应时间的平均值。

●处理能力:在某一特定环境下,系统处理请求的速度。

●cache影响系数:测试数据未必如实际使用时分散,cache在测试过程中会比

实际使用时发挥更大作用,从而使测试出的最高处理能力偏高,考虑到这个因素而引入的系数。

●用户习惯操作频率:根据用户使用习惯估算出来的,单个用户在一段时间内,

使用此类功能的次数。通常以一天内某段固定的高峰使用时间来统计,如果一天内没有哪段时间是固定的高峰使用时间,则以一天的工作时间来统计。

●预期平均响应时间:由用户提出的,希望系统在多长时间内响应。注意,这个

值并不是某一次访问的时间,而是一段时间多次访问后的平均值。

●最大并发用户数:在给定的预期平均响应时间下,系统最多能支持多少个并发

用户。这个数据就是实际可以同时使用系统的用户数。

1.7计算公式

●成功率=成功次数÷(成功次数+失败次数)

●处理能力=成功次数÷测试时间

●最短平均响应时间=MIN(平均响应时间)

●最高处理能力=MAX(处理能力)×(1-cache影响系数)

●最大并发用户数=(最高处理能力-1÷(预期平均响应时间-最短平均响应

时间+(1÷最高处理能力)))÷用户习惯操作频率,此公式要注意各时间单位的不同和转换

2.测试方法

2.1测试模型

2.2测试过程简述

通过编写特定的测试流程,使用多线程技术,模拟多个浏览器持续一段时间并发访问被测系统,记录系统相关的一系列信息,计算出系统支持的最大并发用户数2.3需记录的数据

测试时间

成功次数

失败次数

web服务器CPU利用率(平均、最大)

数据库服务器CPU利用率(平均、最大)

3.测试用例

4.测试结果

4.1查看记录内容

测试时间

(分钟)

并发线程数每次时

间间隔

(秒)

平均响

应时间

(秒)

成功次

数

失败次

数

成功率

处理能力

(次/分)

web服务器

CPU利用率

(%)

数据库服务器

CPU利用率

(%)

平均最大平均最大

cache影响系数

最短平均响应时间(秒)

最高处理

能力(次/

分)

用户习惯

操作频率

(次/天)

预期平均

响应时间

(秒)

最大并发

用户数

5.附件

5.1excel格式的原始数据和计算结果

欢迎您的下载,

资料仅供参考!

致力为企业和个人提供合同协议,策划案计划书,学习资料等等

打造全网一站式需求

web性能测试计划

XXXX性能测试 页脚内容1

目录 1.文档介绍 (4) 1.1 文档目的 (4) 1.2 参考文献 (4) 1.3编写目的 (4) 2.性能相关描述 (5) 2.1性能测试指标 (5) 2.2性能测试范围 (5) 2.3 名词术语约定 (6) 页脚内容2

3 测试环境 (7) 3.1生产环境系统架构 (7) 3.2测试环境系统架构 (8) 3.3 生产环境软硬件配置 (9) 3.4 测试环境软硬件配置 (9) 3.5 负载机软硬件配置 (10) 4.需求分析 (11) 4.1业务模型 (11) 4.2 性能指标 (12) 5 测试策略 (14) 5.1测试执行策略 (15) 5.2 测试监控策略 (16) 6测试场景 (17) 6.1前台开单测试场景 (17) 7测试准备 (19) 7.1测试工具准备 (19) 7.2测试脚本及程序准备 (20) 页脚内容3

7.3测试数据准备 (21) 7.4测试环境准备 (21) 8测试组织架构 (22) 9项目风险 (23) 1.文档介绍 1.1 文档目的 本测试报告为XXX平台项目的性能测试报告,目的在于总结测试阶段的测试以及分析测试结果,描述系统是否符合性能需求。 1.2 参考文献 1.3编写目的 从文档描述XXX发布系统性能测试的范围、方法、资源、进度,作为XXX发布系统性能测试的依据,该文档的目的主要有: 1、明确测试范围、测试对象 2、明确测试目标 3、明确测试环境需求,包括:测试需要的软、硬件环境以及测试人力需求 4、确定测试方案,测试的方法和步骤 页脚内容4

5、指定测试工作的时间安排 6、分析测试的风险,寻找规避办法 7、确定测试需求输出的结果和结果表现形式 2.性能相关描述 2.1性能测试指标 (1).基于XXX业务量的要求,评估XXX平台是否能满足性能要求 (2).进行配置测试,找到相对合理的测试 (3).对XXX进行定容定量,提供规划参考 (4).验证系统的稳定性,验证系统的容错能力 (5).测试并找到系统可能存在的性能问题,分析系统瓶颈 2.2性能测试范围 通过性能测试需求调研,分析用户使用行为.对系统的用户及业务数据量作了定量分析,性能测试将主要集中在表A-1中列出的业务过程. 表A-1 测试范围 页脚内容5

web项目测试实战性能测试结果分析样章报告

5.4.2测试结果分析 LoadRunner性能测试结果分析是个复杂的过程,通常可以从结果摘要、并发数、平均事务响应时间、每秒点击数、业务成功率、系统资源、网页细分图、Web服务器资源、数据库服务器资源等几个方面分析,如图5- 1所示。性能测试结果分析的一个重要的原则是以性能测试的需求指标为导向。我们回顾一下本次性能测试的目的,正如错误!未找到引用源。所列的指标,本次测试的要求是验证在30分钟内完成2000次用户登录系统,然后进行考勤业务,最后退出,在业务操作过程中页面的响应时间不超过3秒,并且服务器的CPU 使用率、内存使用率分别不超过75%、70%,那么按照所示的流程,我们开始分析,看看本次测试是否达到了预期的性能指标,其中又有哪些性能隐患,该如何解决。 图5- 1性能测试结果分析流程图 结果摘要 LoadRunner进行场景测试结果收集后,首先显示的该结果的一个摘要信息,如图5- 2所示。概要中列出了场景执行情况、“Statistics Summary(统计信息摘要)”、“Transaction Summary(事务摘要)”以及“HTTP Responses Summary(HTTP响应摘要)”等。以简要的信息列出本次测试结果。 图5- 2性能测试结果摘要图

场景执行情况 该部分给出了本次测试场景的名称、结果存放路径及场景的持续时间,如图5- 3所示。从该图我们知道,本次测试从15:58:40开始,到16:29:42结束,共历时31分2秒。与我们场景执行计划中设计的时间基本吻合。 图5- 3场景执行情况描述图 Statistics Summary(统计信息摘要) 该部分给出了场景执行结束后并发数、总吞吐量、平均每秒吞吐量、总请求数、平均每秒请求数的统计值,如图5- 4所示。从该图我们得知,本次测试运行的最大并发数为7,总吞吐量为842,037,409字节,平均每秒的吞吐量为451,979字节,总的请求数为211,974,平均每秒的请求为113.781,对于吞吐量,单位时间内吞吐量越大,说明服务器的处理能越好,而请求数仅表示客户端向服务器发出的请求数,与吞吐量一般是成正比关系。 图5- 4统计信息摘要图 Transaction Summary(事务摘要) 该部分给出了场景执行结束后相关Action的平均响应时间、通过率等情况,如图5- 5所示。从该图我们得到每个Action的平均响应时间与业务成功率。

基于Web系统的性能测试

基于Web系统的性能测试 摘要:Web应用系统具有方便、快速、易操作性等特点,使得社会中的各行业越来越倾向于使用Web应用系统开展自身业务以及扩大社会影响力。随着Web应用系统的广泛使用,用户对性能的要求越来越高。该文主要介绍了Web应用系统的关键性能指标及测试方法,结合案例评估和分析Web应用系统性能的过程。 关键词:Web应用系统性能测试性能指标LoadRunner 中图分类号:TP311 文献标识码:A 文章编号: 1007-9416(2014)04-0156-02 基于Web的应用系统在当今互联网盛行的时代被广泛应用于社会的各个领域,比如:教育行业、交通系统、移动通信、金融系统以及政府部门等各个领域。由于Web系统所具有的快捷、易使用的特点,使得社会中人们对Web系统更加依赖,也促使了社会各个领域对Web应用系统的重视,纷纷把原有的业务操作模式网络化。但是在网络化的过程中,随着工作流的增加、使用人员的增多以及业务数据量的剧增,问题也随之而来:如果交互的信息量过大,经常会导致系统反应速度骤降或者系统宕机。因此,社会各领域中的Web应用系统能否承受住大量的数据访问以及业务操作、并

能够快速地响应使用者的请求、系统能否长时间稳定地运行,系统的性能瓶颈所在,这些都是用户所关心的性能表现。性能测试的目的是检测系统性能是否符合用户的需求,有无性能方面的瓶颈;所以性能测试是项目建设过程中重要的一环。测试方法一般采用负载测试、压力测试等方法。 1 性能测试简介 性能测试考察的是通过性能指标验证系统有无性能问题。测试方法主要包括负载测试、压力测试、大数据量测试、疲劳强度测试等。在测试过程中通常是模拟真实用户使用环境下的负载量,统计分析系统各方面的性能数据,得出性能测试结论。在实际的测试工作中,通常要结合几种测试方法,综合分析测试过程中体现出来的各种数据。 1.1 性能测试类型 (1)负载测试:是在系统真实的用户环境下或模拟系统真实运行环境及用户真实业务使用场景情况下,通过不断给系统增加压力,在一定压力下延长系统运行时间,来验证系统各项性能指标的变化情况,直到系统性能出现拐点。目前一般采用业内经常使用的测试工具LoadRunner来执行测试。当然也可以采用其他的测试工具。本文是利用LoadRunner进行测试。 (2)压力测试:是对系统不断增加负载,让系统在处于极限负载的情况下或者是某项指标已经处于饱和的状态

Web性能测试方案

Web性能测试方案 1测试目的 此处阐述本次性能测试的目的,包括必要性分析与扩展性描述。 性能测试最主要的目的是检验当前系统所处的性能水平,验证其性能是否能满足未来应用的需求,并进一步找出系统设计上的瓶颈,以期改善系统性能,达到用户的要求。 2测试范围 此处主要描述本次性能测试的技术及业务背景,以及性能测试的特点。 编写此方案的目的是为云应用产品提供web性能测试的方法,因此方案内容主要包括测试环境、测试工具、测试策略、测试指标与测试执行等。 2.1测试背景 以云采业务为例,要满足用户在互联网集中采购的要求,实际业务中通过云采平台询报价、下单的频率较高,因此云采平台的性能直接决定了业务处理的效率,并能够支撑业务并发的压力。 例如:支撑100家企业用户的集中访问,以及业务处理要求。 2.2性能度量指标 响应时间(TTLB) 即“time to last byte”,指的是从客户端发起的一个请求开始,到客户端接收到从服务器端返回的响应结束,这个过程所耗费的时间,响应时间的单位一般为“秒”或者“毫秒”。响应时间=网络响应时间+应用程序响应时间。 响应时间标准:

事务能力TPS(transaction per second) 服务器每秒处理的事务数; 一个事务是指一个客户机向服务器发送请求然后服务器做出反应的过程。 客户机在发送请求时开始计时,收到服务器响应后结束计时,一次来计算使用的时间和完成的事务个数。它是衡量系统处理能力的重要指标。 并发用户数 同一时刻与服务器进行交互的在线用户数量。 吞吐率(Throughput) 单位时间内网络上传输的数据量,也可指单位时间内处理的客户端请求数量,是衡量网络性能的重要指标。 吞吐率=吞吐量/传输时间 资源利用率 这里主要指CPU利用率(CPU utilization),内存占用率。 3测试内容 此处对性能测试整体计划进行描述,包括测试内容以及关注的性能指标。Web性能测试内容包含:压力测试、负载测试、前端连接测试。 3.1负载测试 负载测试是为了测量Web系统在某一负载级别上的性能,以保证Web系统在需求范围内能正常工作。负载级别可以是某个时刻同时访问Web系统的用户数量,也可以是在线数据处理的数量。例如:Web应用系统能允许多少个用户同时在线?如果超过了这个数量,会出现什么现象?Web应用系统能否处理大

系统压力测试报告

xx压力测试报告 编写部门:软件测试部 编写地址:xx项目现场 编写时间:2017年8月 目录 一、引言 .............................................................. 错误!未定义书签。 1.测试目的............................................................ 错误!未定义书签。 2.术语说明............................................................ 错误!未定义书签。 二、系统环境 .......................................................... 错误!未定义书签。 三、测试场景设计....................................................... 错误!未定义书签。 1.测试场景说明........................................................ 错误!未定义书签。 2.并发响应情况........................................................ 错误!未定义书签。

四、测试结果概要信息................................................... 错误!未定义书签。 1.虚拟用户增加、减少趋势图........................................ 错误!未定义书签。 2.每秒点击量结果图 ............................................... 错误!未定义书签。 3.系统吞吐量结果图 ............................................... 错误!未定义书签。 4.事物汇总结果图 ................................................. 错误!未定义书签。 5.事物平均响应时间结果图 ......................................... 错误!未定义书签。 五、测试结果总结:..................................................... 错误!未定义书签。

web系统性能测试报告

1.总述 1.1测试对象 web系统 1.2测试目的 确定系统支持的最大并发用户数1.3测试环境

1.4测试依据 序号名称/版本 1.5参考资料 序号名称/版本编制日期作者/来 源1N/A N/A N/A 1.6术语及缩写词 测试时间:一轮测试从开始到结束所使用的时间 并发线程数:测试时同时访问被测系统的线程数。注意,由于测试过程中,每个线程都是以尽可能快的速度发请求,与实际用户的使用有极大差别,所以,此数据不等同于实际使用时的并发用户数。 每次时间间隔:测试线程发出一个请求,并得到被测系统的响应后,间隔多少时间发出下一次请求。 平均响应时间:测试线程向被测系统发请求,所有请求的响应时间的平均值。 处理能力:在某一特定环境下,系统处理请求的速度。 cache影响系数:测试数据未必如实际使用时分散,cache在测试过程中会比实际使用时发挥更大作用,从而使测试出的最高处理能力偏高,考虑到这个因素而引入的系数。

用户习惯操作频率:根据用户使用习惯估算出来的,单个用户在一段时间内,使用此类功能的次数。通常以一天内某段固定的高峰使用时间来统计,如果一天内没有哪段时间是固定的高峰使用时间,则以一天的工作时间来统计。 预期平均响应时间:由用户提出的,希望系统在多长时间内响应。注意,这个值并不是某一次访问的时间,而是一段时间多次访问后的平均值。 最大并发用户数:在给定的预期平均响应时间下,系统最多能支持多少个并发用户。这个数据就是实际可以同时使用系统的用户数。 1.7计算公式 成功率=成功次数÷(成功次数+失败次数) 处理能力=成功次数÷测试时间 最短平均响应时间=MIN(平均响应时间) 最高处理能力=MAX(处理能力)×(1-cache影响系数) 最大并发用户数=(最高处理能力-1÷(预期平均响应时间-最短平均响应时间+(1÷最高处理能力)))÷用户习惯操作频率,此公式要注意各时间单位的不同和转换

《Web项目测试实战》性能测试需求分析章节样章

5.1.2性能测试需求提取 复习了一些常见的理论概念后,我们开始性能测试需求的提取。这个过程是非常重要的,往往测试失败,就是因为在这个过程中不知道如何得到确切的性能指标,而导致测试无法正常开展。性能测试需求提取一般的流程如图5- 1所示。 图5- 1性能测试需求提取流程 分析提取指标 在用户需求规格说明书中,会给出系统的功能、界面与性能的要求。规范的需求规格说明书都会给出明确的性能指标,比如单位时间内访问量要达到多少、业务响应时间不超过多少、业务成功率不低于多少、硬件资源耗用要在一个合理的范围中,这些指标都会以可量化的数据进行说明。如果,实际项目并没有这些正规的文档时,项目经理部署测试任务给测试组长时,一般就会说明是否要对项目的哪些业务模块进行性能测试,以及测试的要求是什么的。最麻烦的就是项目经理或者客户要求给出一个测试部门认为可以的数据,这样非常难做的。可是“甲方”往往都是提要求的,“乙方”只能“无条件”接受! 表5- 1需求规格说明书中的性能要求 表5- 1给出的指标非常明确,在测试过程中,我们只需收集用户登录模块的响应时间、登录成功率、并发数、CPU使用率、内存使用率的数据,然后与表5- 1的指标进行比较即可,通过的,就认为达到了客户要求的性能,未达到就分析原因,并给出测试报告及解决建议。 大多数是没有明确的需求,需要我们自己根据各种资料、使用各种方法去采集测试指标。以OA系统为例,假设《OA系统需求规格说明书》中并未指明系统的性能测试要求,需要测试工程师自己分析被测系统及采集性能衡量指标。 分析OA系统的结构,所有功能中仅有考勤模块可能是被测系统最终用户经常使用的业务点,那么我们的重点应该在放在该模块上。一般我们可以从下面三个方面来确定性能测试点: 第一、用户常用的功能。常用的功能一旦性能无法满足,比如登录功能,从输入用户名与密码点击登录按钮到显示成功登录信息,花了5分钟,这样的速度是 人无法忍受的。而对于用户不常用的,比如年度报表汇总功能,三个季度甚 至是一年才使用,等个10分钟也是正常的,这些是跟用户的主观感受相关 的,得根据实际情况区分。

管道系统压力测试报告(精)

管道系统压力测试报告 测试日期:2011年10月10日 一、试压、试漏工作的意义 试压、试漏是一项重要工作,必须严格认真完成。易燃、易爆、有毒介质的泄漏将危害工厂的安全生产和工作人员的生命安全。 二、试压、试漏前应具备的条件 1. 试验范围内管道安装工程除涂漆、绝热外,已按设计图纸全部完成,安装质量符合有关规定。 2. 焊缝和其它待试验部分尚未涂漆和绝热。 3. 试验用压力表已经校验,其精度不得低于1?6级,表的满刻度值应为被测最大压力的1?5~2?0倍,压力表不得少于6块。 4. 待测管道与无关系统已用盲板或采用其它方式隔开。 5. 待测管道上的安全阀、仪表元件等己经拆下或加以隔离。 三、试压、试漏前应准备的工具 准备好试压、试漏所用的无油干燥压缩空气或干燥的氮气,以及准备肥皂水、刷子(油漆刷即可、吸耳球等试气密工具若干。 1、无油干燥压缩空气或干燥的氮气, 2、洗衣粉(洗洁精) 3、没有用过的油漆刷,吸耳球 4、盛水用的盆子

5、做标志明示牌用的小牌若干,记号笔 6、临时压力表 (1)气压强度实验 使压力缓慢升高。至试验压力的50%时停止进气。检查,若无泄露及管道变形,进入下一步。 1. 继续按实验压力的10%逐渐升至实验压力,每一级稳压3min ,检查。(要求同上) 2. 达到实验压力后,稳定5min ,以无明显泄露,目测无变形为合格。 (2)气密性实验 1. 将压力升至试验压力的1/3时,用肥皂水涂抹所有的管道连接处、设备密封口、管道焊缝和螺纹接头处。 2. 开关前、后压力相等的手动截止阀2~3次,重复检查阀门的阀杆和填料压盖处。 3. 开关所有调节阀3~4次,重复检查调节阀的阀杆和填料压盖处。 4. 开关前、后压力相等的程控阀5~6次,重复检查阀门的阀杆和填料压盖处,同时检查程控阀整个行程所用的时间(应当在规定值范围内)和程控阀的动作是否与程序一致。 5. 装置试压、试漏过程中必须做好记录,记录好所有气体泄漏处。 6. 在压力≤0?25MPa 设备和管路上,发现小量气体泄漏允许小心地带压处理,较大的泄漏必须泄压处理。 7. 在压力≥0?25MPa 设备和管路上,发现气体泄漏必须泄压处理。

web端性能测试报告

Xxxx 性能测试报告 文档编号: 密级: 版本信息:Vxxxx 建立日期:2017-06 创建人:XXX

1引言 1.1编写目的 根据性能测试方案,给出结果和分析以及结论和建议。 测试方案预期读者:开发人员、测试人员、和项目相关人员。 1.2项目背景 1.3术语定义 虚拟用户:通过执行测试脚本模仿真实用户与被测试系统进行通信的进程或线程。 测试脚本:通过执行特定业务流程来模拟真实用户操作行为的脚本代码。 场景:通过组织若干类型、若干数量的虚拟用户来模拟真实生成环境中的负载场景。 集合点:用来确定某一步操作由多少虚拟用户同步执行(并发)。 事务:设置事务是为了明确某一个或多个业务或者某一个按钮操作的响应时间。 HPS:每秒点击数,一般情况下,与TPS成正比。 TPS:每秒事务数,是指每秒内,每个事务通过、失败以及停止的次数,可以确定系统在任何给定时刻的实际事务负载。 系统资源利用率:是指在对被测试系统执行性能测试时,系统部署的相关应用服务器、数据库等系统资源利用,比如CUP,内存,网络等。

2测试业务及性能需求 服务器配置如下: Web服务器: 操作系统:Windows7 旗舰版64位; 处理器:Intel(R) Xeon(R) CPUI5 -5200U@2.20GHz 2.20GHz 3场景设及计执行结果 3.1场景设计

3.2测试结果 3.2.1“提交”事务情况汇总 3.2.2每秒点击量(hps) 1、CJ-TJ_001和CJ-TJ_004点击率在大概维持在13-15左右的点击率 2、CJ-TJ_003和CJ-TJ_004点击率在场景持续变发60或者80个用户时,hPS会有明显的下降

WEB性能测试报告

Xxx项目_性能测试报告 一、概述 1.1 测试对象 web系统 1.2 测试目的 确定系统支持的最大并发用户数 1.3 测试环境 序 号 用途硬件环境软件环境 1 测试用机CPU PIII733 RAM 256M Win2000server + sp4 测试工具(loadrunner7.5) 2 web服务器(被 测系统)CPU P4 1Ghz RAM 256M Win2000server + sp4 Weblogic 6.1 3 数据库服务器 (被测系统)CPU P4 1.7Ghz RAM 512M Win2000server + sp4 Oracle 9i 1.4 测试依据 序号名称/版本 1.5 参考资料 序号名称/版本编制日期作者/来源 1 N/A N/A N/A

1.6 术语及缩写词 ●测试时间:一轮测试从开始到结束所使用的时间 ●并发线程数:测试时同时访问被测系统的线程数。注意,由于测试过程中,每个线程都是以尽可 能快的速度发请求,与实际用户的使用有极大差别,所以,此数据不等同于实际使用时的并发用户数。 ●每次时间间隔:测试线程发出一个请求,并得到被测系统的响应后,间隔多少时间发出下一次请 求。 ●平均响应时间:测试线程向被测系统发请求,所有请求的响应时间的平均值。 ●处理能力:在某一特定环境下,系统处理请求的速度。 ●cache影响系数:测试数据未必如实际使用时分散,cache在测试过程中会比实际使用时发挥更大 作用,从而使测试出的最高处理能力偏高,考虑到这个因素而引入的系数。 ●用户习惯操作频率:根据用户使用习惯估算出来的,单个用户在一段时间内,使用此类功能的次 数。通常以一天内某段固定的高峰使用时间来统计,如果一天内没有哪段时间是固定的高峰使用时间,则以一天的工作时间来统计。 ●预期平均响应时间:由用户提出的,希望系统在多长时间内响应。注意,这个值并不是某一次访 问的时间,而是一段时间多次访问后的平均值。 ●最大并发用户数:在给定的预期平均响应时间下,系统最多能支持多少个并发用户。这个数据就 是实际可以同时使用系统的用户数。 1.7 计算公式 ●成功率=成功次数÷(成功次数+失败次数) ●处理能力=成功次数÷测试时间 ●最短平均响应时间=MIN(平均响应时间) ●最高处理能力=MAX(处理能力)×(1-cache影响系数) ●最大并发用户数=(最高处理能力-1÷(预期平均响应时间-最短平均响应时间+(1÷最高 处理能力)))÷用户习惯操作频率,此公式要注意各时间单位的不同和转换 2.测试方法 2.1 测试模型 2.2 测试过程简述 通过编写特定的测试流程,使用多线程技术,模拟多个浏览器持续一段时间并发访问被测系统,记录系

Web Tours网站性能测试计划

Web Tours网站性能测试计划 作者:fzw 发布日期:2012 文档版本: 文档编号: 文档历史: 变更记录 变更日期作者版本变更摘要 相关文档 发布日期文档标题版本备注

文档目的 描述Web Tours性能测试流程、范围、环境、风险等因素作为性能测试实施依据。 项目背景介绍 Web Tourd是HP LoadRunner软件自带一个飞机订票系统网站,是一款基于https://www.360docs.net/doc/f814819435.html,平台的网站。基于先进的.NET Framework,默认支持SOL Server数据库,可扩展支持ACCESS、MySql等多种数据库。支持基于IE、Chrome、Firefox、Opera等浏览器。 Web Tours网站主要是提供方全世界用户进行网上订票、查看订票信息、预订机票、修改预订机票的功能支持。 术语及缩写 性能测试(Performance Testing):在一定负载的情况下,系统响应时间、吞吐量等性能是否满足用户特定的性能需求。 负载测试(Load Testing):在一定的软件、硬件及网络环境下,在不同虚拟用户数量的情况下进行一种或多种业务,测试服务器的性能指标是否在用户要求的范围内,用于确定系统所能承受的最大用户数、最大有效用户数以及不同用户数下的系统响应时间和服务器的资源利用率。 压力/强度测试:(stres Testing):在一定软件、硬件及网络环境下,通过模拟大量的虚拟用户向服务器产生负载,使服务器的资源处于极限状态下长时间持续运行,以测试服务器在高负载情况下是否能够稳定工作。 配置测试(Configuration Testing):在不同软件、硬件及网络环境下,在一定的虚拟用户数量的情况下运行一种或者多种业务,获得不同配置的性能指标,用于选择最佳的设备及参数配置。 输入 《项目计划文档》 《性能需求规格说明书》 《系统架构计划文档》 其他性能测试文档 入口标准 系统运行环境 1)网络拓扑图

接口压力测试报告

接口压力测试报告文件排版存档编号:[UYTR-OUPT28-KBNTL98-UYNN208]

性能测试报告 (****接口服务系统) 2016年12月22日 目录 1.测试目的、范围 . 测试目的 本次性能测试的目的是检测****接口服务系统的性能情况。即:为了系统上线后能够稳定运行,有必要在上线前对核心业务场景的压力情况有充分了解。因此,希望在模拟生产环境的情况下,模拟上线后的用户并发数,对系统核心业务进行压力测试,收集相应的系统参数,并最终作为上线的依据。编写本方案的目的是指导本次性能测试有序的进行,相关人员了解本次性能测试。 . 测试指标范围 本次性能测试需要获得的性能指标如下所列:

系统的响应时间。 系统可支持的并发用户数量。 2.测试环境 模拟客户使用环境(最好模拟客户实际使用的配置环境)。具体如下:. 测试环境 硬件环境: 应用服务器数量:1台 配置:4核心8G内存 数据库服务器数量:1台 配置:16核心40G内存 测试客户端数量:1台 配置:双核心8G内存 软件环境: 操作系统:Windows 7 数据库: Oracle 10g . 测试工具 Loadrunner11 Xshell 3.测试功能点 本次测试****接口访问时的响应时间及并发量瓶颈。 4.准备工作 1)测试功能点全部通过功能测试,确保功能上没有问题;

2)准备测试环境服务器: 3)准备测试客户机,机器安装Loadrunner11; 4)对于测试功能点,事先录制好相应的测试脚本,包括参数化、关联等,准备好测试数据,脚本能够成功的回放,保证在测试的时候能够顺利的运行; 5)创建测试场景,并配置好每个场景的设置; 6)测试过程中保存好脚本和分析结果。 5.测试用例及结果 本次主要测试访问接口时接口服务所能承受的压力,测试接口无需登录,直接访问即可,因此不存在同一用户与不同用户访问的差异。 由下表测试结果可看出当并发数增大时,响应时间逐渐增大,服务器所受压力也逐渐增大。 本次测试环境数据库最大线程为600。当并发数大于500时,测试环境服务器CPU使用率溢出,测试过程中报出错误数过多。主要错误类型为:;。经过和开发沟通,解决了27740类型的BUG,但并发数为600时仍有过多超时错误。 当并发数设为500时,运行过程中仍然出现了2个错误,但是在整个操作中占比小于%。 具体测试数据如下:

WEB性能测试方法

性能测试用例主要分为预期目标用户测试,用户并发测试,疲劳强度与大数据量测试,网络性能测试,服务器性能测试五大部分,具体编写测试用例时要根据实际情况进行裁减,在项目应用中遵守低成本,策略为中心,裁减,完善模型,具体化等原则; 一、WEB 全面性能测试模型 Web 性能测试模型提出的主要依据是:一种类型的性能测试可以在某些条件下转化成为另外一种类型的性能测试,这些类型的性能测试的实施是有着相似之处的; 1. 预期指标的性能测试 系统在需求分析和设计阶段都会提出一些性能指标,完成这些指标的相关的测试是性能测试的首要工作之一,这些指标主要诸于“系统可以支持并发用户200个;”系统响应时间不得超过2 0秒等,对这种预先承诺的性能要求,需要首先进行测试验证; 2. 独立业务性能测试 独立业务实际是指一些核心业务模块对应的业务,这些模块通常具有功能比较复杂,使用比较频繁,属于核心业务等特点。 用户并发测试是核心业务模块的重点测试内容,并发的主要内容是指模拟一定数量的用户同时使用某一核心的相同或者不同的功能,并且持续一段时间。对相同的功能进行并发测试分为两种类型,一类是在同一时刻进行完全一样的操作。另外一类是在同一时刻使用完全一样的功能。 3. 组合业务性能测试 通常不会所有的用户只使用一个或者几个核心业务模块,一个应用系统的每个功能模块都可能被使用到;所以WEB性能测试既要模拟多用户的相同操作,又要模拟多用户的不同操作;组合业务性能测试是最接近用户实际使用情况的测试,也是性能测试的核心内容。通常按照用户的实际使用人数比例来模拟各个模版的组合并发情况;组合性能测试是最能反映用户使用情况的测试往往和服务器性能测试结合起来,在通过工具模拟用户操作的同时,还通过测试工具的监控功能采集服务器的计数器信息进而全面分析系统瓶颈。 用户并发测试是组合业务性能测试的核心内容。组合并发的突出特点是根据用户使用系统的情况分成不同的用户组进行并发,每组的用户比例要根据实际情况来匹配; 4. 疲劳强度性能测试 疲劳强度测试是指在系统稳定运行的情况下,以一定的负载压力来长时间运行系统的测试,其主要目的是确定系统长时间处理较大业务量时的性能,通过疲劳强度测试基本可以判定系统运行一段时间后是否稳定; 5. 大数据量性能测试 一种是针对某些系统存储,传输,统计查询等业务进行大数据量时的性能测试,主要针对某些特殊的核心业务或者日常比较常用的组合业务的测试; 第二种是极限状态下的数据测试,主要是指系统数据量达到一定程度时,通过性能测试来评估系统的响应情况,测试的对象也是某些核心业务或者常用的组合业务。 第三种大数据量测试结合了前面两种的测试,两种测试同时运行产生较大数据量的系统性能测试; 大数据量测试通常在投产环境下进行,并独立出来和疲劳强度测试放在一起,在整个性能测试的后期进行;大数据量的测试可以理解为特定条件下的核心业务或者组合业务测试; 6. 网络性能测试 主要是为了准确展示带宽,延迟,负载和端口的变化是如何影响用户的响应时间的,在实际的软件项目中 主要是测试应用系统的用户数目与网络带宽的关系。网络测试的任务通常由系统集成人员完成; 7. 服务器(操作系统,WEB服务器,数据库服务器)性能测试

XXXXXX网站平台压力测试报告-NEW.doc资料

XXXXXX网站平台压力测试报告 XXXXXX科技有限公司 2013-11-25

1.测试项目 1.1功能描述: XXXXXXXX网站平台压力测试是XXXXXX科技有限公司对XXXXXXXX网站平台服务器进行性能测试手段,通过模拟大批量用户的并发访问操作,从而可以预测系统在大量用户并发发访问操作的情况下,系统可以响应的时间及服务器资源占用等性能情况。 本文主要描述了对服务器进行性能压力测试的过程及结果。 本次测试主要关心的指标: ●平均响应时间 ●总用时 ●服务器CPU利用率 ●内存占用等。 1.2系统压力强度估算 系统响应时间判断原则如下: ?系统业务响应时间小于2-5秒,判为优秀,用户对系统感觉很好; ?系统业务响应时间在5-10秒之间,判为良好,用户对系统感觉一般; ?系统业务响应时间超过15秒,判断为一般,用户体验不佳。2.测试环境: 2.1 服务器端测试环境描述:

硬件配置:(例如HP LXr 8500 Server 双PIIIXeon/900 (2MB Cache)、4GB内存、2个36GB 硬盘、磁带机、双网卡) 软件配置:(例如Windows 2003 Server、Oracle10g、IIS5.1、.NET FRAMEWORK2.0等) 2.2 客户端测试环境描述: DELL A840商务笔记本 CPU:T1400 频率1.73GHz双核处理器 内存:2G 硬盘:120G 计算机版本:WindowsXP SP3 2.3 网络测试环境描述: 服务器和客户端用的是10M网络带宽。 3.测试工具 微软Microsoft Web Application Stress Tool 1.1(W AS)

web性能测试基本性能指标

web性能测试基本性能指标 Web性能测试的部分概况一般来说,一个Web请求的处理包括以下步骤: (1)客户发送请求 (2)web server接受到请求,进行处理; (3)web server向DB获取数据; (4)web server生成用户的object(页面),返回给用户。给客户发送请求开始到最后一个字节的时间称为响应时间(第三步不包括在每次请求处理中)。 1.事务(Transaction) 在web性能测试中,一个事务表示一个“从用户发送请求->web server接受到请求,进行处理->we b server向DB获取数据->生成用户的object(页面),返回给用户”的过程,一般的响应时间都是针对事务而言的。 2.请求响应时间 请求响应时间指的是从客户端发起的一个请求开始,到客户端接收到从服务器端返回的响应结束,这个过程所耗费的时间,在某些工具中,响应通常会称为“TTLB”,即"time to last byte",意思是从发起一个请求开始,到客户端接收到最后一个字节的响应所耗费的时间,响应时间的单位一般为“秒”或者“毫秒”。一个公式可以表示:响应时间=网络响应时间+应用程序响应时间。标准可参考国外的3/5/10原则: (1)在3秒钟之内,页面给予用户响应并有所显示,可认为是“很不错的”; (2)在3~5秒钟内,页面给予用户响应并有所显示,可认为是“好的”; (3)在5~10秒钟内,页面给予用户响应并有所显示,可认为是“勉强接受的”; (4)超过10秒就让人有点不耐烦了,用户很可能不会继续等待下去; 3、事务响应时间 事务可能由一系列请求组成,事务的响应时间主要是针对用户而言,属于宏观上的概念,是为了向用户说明业务响应时间而提出的.例如:跨行取款事务的响应时间就是由一系列的请求组成的.事务响应时间是直接衡量系统性能的参数. 4.并发用户数 并发一般分为2种情况。一种是严格意义上的并发,即所有的用户在同一时刻做同一件事情或者操作,这种操作一般指做同一类型的业务。比如在信用卡审批业务中,一定数目的拥护在同一时刻对已经完成的审批业务进行提交;还有一种特例,即所有用户进行完全一样的操作,例如在信用卡审批业务中,所有的用户可以一起申请业务,或者修改同一条记录。 另外一种并发是广义范围的并发。这种并发与前一种并发的区别是,尽管多个用户对系统发出了请求或者进行了操作,但是这些请求或者操作可以是相同的,也可以是不同的。对整个系统而言,仍然是有很多用户同时对系统进行操作,因此也属于并发的范畴。

WEB-Tours订票系统性能测试报告

WEB Tours订票系统性能测试报告 姓名: 班级: 学号: 指导老师:

目录 1 前言 (2) 2 被测系统定义 (4) 功能简介 (4) 性能测试指标............................. 错误!未定义书签。 3 系统结构及流程 (5) 系统总体结构 (5) 关键点描述 (5) 性能测试环境 (5) 4 性能测试 (5) 性能测试概述 (6) 测试目的 (6) 测试方法及测试用例....................... 错误!未定义书签。 测试指标及期望 (7)

测试数据准备 (8) 运行状况记录 (8) 5 测试过程及结果描述 (8) 测试描述 (9) 测试场景 (9) 测试结果 (13) 6测试分析和结论 (25)

1前言 目前,WEB Tours订票系统成功上线,从而航空公司的机票信息管理逐步走上了集中管控的道路,从而将会势必出现新业务系统中信息大量增长的态势。 随着新业务系统在生产状态下日趋稳定、成熟,系统的性能问题也逐步成为了我们关注的焦点:大数据量的“冲击”,在多名用户信息进入时,系统能稳定在什么样的性能水平,面临公司业务冲刺时,系统能否经受住“考验”,这些问题需要通过一个完整的性能测试来给出答案。 本报告前部分即是基于上述考虑,参考科学的性能测试方法而撰写的,用以指导即将进行的WEB Tours订票系统的性能测试。 2被测系统定义 WEB Tours订票系统作为本次测试的被测系统,该订票系统的主要功能包括:注册和登录用户信息,订票办理,退票办理,查询客户已订票信息等。在本次测试中,将针对上述的功能进行压力测试,检查并评估在模拟环境中,系统对负载的承受能力,在不同的用户连接情况下,系统地吞吐能力和响应能力,以及在预计的数据容量中,系统能够容忍的最大用户数,

web项目测试实战性能测试结果分析样章

w e b项目测试实战性能测试结果分析样章 Last revision on 21 December 2020

LoadRunner性能测试结果分析是个复杂的过程,通常可以从结果摘要、并发数、平均事务响应时间、每秒点击数、业务成功率、系统资源、网页细分图、Web服务器资源、数据库服务器资源等几个方面分析,如所示。性能测试结果分析的一个重要的原则是以性能测试的需求指标为导向。我们回顾一下本次性能测试的目的,正如所列的指标,本次测试的要求是验证在30分钟内完成2000次用户登录系统,然后进行考勤业务,最后退出,在业务操作过程中页面的响应时间不超过3秒,并且服务器的CPU使用率、内存使用率分别不超过75%、70%,那么按照所示的流程,我们开始分析,看看本次测试是否达到了预期的性能指标,其中又有哪些性能隐患,该如何解决。 图5- 1性能测试结果分析流程图 结果摘要 LoadRunner进行场景测试结果收集后,首先显示的该结果的一个摘要信息,如所示。概要中列出了场景执行情况、“Statistics Summary(统计信息摘要)”、“Transaction Summary(事务摘要)”以及“HTTP Responses Summary(HTTP响应摘要)”等。以简要的信息列出本次测试结果。 图5- 2性能测试结果摘要图 场景执行情况 该部分给出了本次测试场景的名称、结果存放路径及场景的持续时间,如所示。从该图我们知道,本次测试从15:58:40开始,到16:29:42结束,共历时31分2秒。与我们场景执行计划中设计的时间基本吻合。 图5- 3场景执行情况描述图

Statistics Summary(统计信息摘要) 该部分给出了场景执行结束后并发数、总吞吐量、平均每秒吞吐量、总请求数、平均每秒请求数的统计值,如所示。从该图我们得知,本次测试运行的最大并发数为7,总吞吐量为842,037,409字节,平均每秒的吞吐量为451,979字节,总的请求数为211,974,平均每秒的请求为,对于吞吐量,单位时间内吞吐量越大,说明服务器的处理能越好,而请求数仅表示客户端向服务器发出的请求数,与吞吐量一般是成正比关系。 图5- 4统计信息摘要图 Transaction Summary(事务摘要) 该部分给出了场景执行结束后相关Action的平均响应时间、通过率等情况,如所示。从该图我们得到每个Action的平均响应时间与业务成功率。 图5- 5事务摘要图 HTTP Responses Summary(HTTP响应摘要) 该部分显示在场景执行过程中,每次HTTP请求发出去的状态,是成功还是失败,都在这里体现,如所示。从图中可以看到,在本次测试过程中LoadRunner 共模拟发出了211974次请求(与“统计信息摘要”中的“Total Hits”一致),其中“HTTP 200”的是209811次,而“HTTP 404”则有2163,说明在本次过程中,经过发出的请求大部分都能正确响应了,但还是有部分失败了,但未影响测试结果,“HTTP 200”表示请求被正确响应,而“HTTP 404”表示文件或者目录未能找到。有朋友可能会问,这里出现了404的错误,为什么结果还都通

【网站测试报告】通用版-网站压力测试报告模板

网站压力测试报告模板 ***项目压力测试报告 XXXXXX 有限公司 撰稿人:时间:年月日 目录 1.测试项目:................................................................................................................................. 2 1.1 功能描述:...................................................................................................................... 2 1.2 测试项目描述:.............................................................................................................. 2 2.测试环境:................................................................................................................................. 3 2.1 服务器端测试环境描述:............................................................................................. 3 2.2 客户端测试环境描述:................................................................................................. 3 2.3 网络测试环境描述:..................................................................................................... 3 3.测试人与测试时间:................................................................................................................. 4 4.测试案例的测试结果:........................................................................... 错误!未定义书签。错误!未定义书签。 5. 测试总结: (7)