ELK日志分析系统

ELK日志分析系统

一、ELK日志分析系统介绍

1.1传统的日志统计及分析方式

日志主要包括系统日志、应用程序日志和安全日志。系统运维和开发人员可以通过日志了解服务器软硬件信息、检查配置过程中的错误及错误发生的原因。经常分析日志可以了解服务器的负荷,性能安全性,从而及时采取措施纠正错误。

通常,日志被分散的储存不同的设备上。如果你管理数十上百台服务器,你还在使用依次登录每台机器的传统方法查阅日志。这样是不是感觉很繁琐和效率低下。当务之急我们使用集中化的日志管理,例如:开源的syslog,将所有服务器上的日志收集汇总。

集中化管理日志后,日志的统计和检索又成为一件比较麻烦的事情,一般我们使用grep、awk和wc等Linux命令能实现检索和统计,但是对于要求更高的查询、排序和统计等要求和庞大的机器数量依然使用这样的方法难免有点力不从心。

1.2 ELK介绍

开源实时日志分析ELK平台能够完美的解决我们上述的问题,ELK由ElasticSearch、Logstash和Kiabana三个开源工具组成。

(1)、Elasticsearch是个开源分布式搜索引擎,它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等。

(2)、Logstash是一个完全开源的工具,可以对日志进行收集、过滤,并将其存储供以后使用(如:搜索)。

(3)、Kibana 也是一个开源和免费的可视化工具,可以为Logstash 和ElasticSearch 提供的日志分析友好的Web 界面,可以帮助汇总、分析和搜索重要数据日志。

1.2.1 Elasticsearch介绍

Elasticsearch是一个基于Apache Lucene(TM)的开源搜索引擎,Lucene是当前行业内最先进、性能最好的、功能最全的搜索引擎库。但Lucene只是一个库。无法直接使用,必须使用Java作为开发语言并将其直接集成到应用中才可以使用,而且Lucene非常复杂,需要提前深入了解检索的相关知识才能理解它是如何工作的。

Elasticsearch也使用Java开发并使用Lucene作为其核心来实现所有索引和搜索的功能,但是它的目的是通过简单的RESTful API来隐藏Lucene的复杂性,从而让全文搜索变得简单。

但Elasticsearch不仅仅值是Lucene库和全文搜索,它还有以下用途:

?分布式的实时文件存储,每个字段都被索引并可被搜索

?分布式的实时分析搜索引擎

?可以扩展到上百台服务器,处理PB级结构化或非结构化数据

1.2.2 Elasticsearch基础概念

Elasticsearch有几个核心概念。从一开始理解这些概念会对整个学习过程有莫大的帮助。

(1)、接近实时(NRT)

Elasticsearch是一个接近实时的搜索平台。意味着检索一个文档直到这个文档能够被检索到有一个轻短暂的延迟(通常是1秒)。

(2)、集群(cluster)

集群就是由一个或多个节点组织在一起,它们共同持有整个的数据,并一起提供索引和搜索功能。集群由一个唯一的名字标识,这个名字默认就是“elasticsearch”。这个名字很重要,因为一个节点只能通过指定某个集群的名字,来加入这个集群。在产品环境中显式地设定这个名字是一个好习惯,但是使用默认值来进行测试/开发也可以。

(3)、节点(node)

节点是值集群中的具体服务器,作为集群的一部分,它可存储数据,参与集群的索引和搜索功能。和集群类似,一个节点也是由一个名字来标识的,默认情况下,这个名字是一个随机名字,这个名字会在服务启动时赋予节点。这个名字对于管理者非常重要,因为在管理过程中,需要确定网络中的哪些服务器对应于Elasticsearch集群中的哪些节点。

节点可以通过配置集群名称的方式来加入一个指定的集群。默认情况下,每个节点都会被安排加入到一个叫做“elasticsearch”的集群中,这意味着如果在网络中启动了若干个节点,并假定它们能够相互发现彼此,那么各节点将会自动地形成并加入到一个叫做“elasticsearch”的集群中。

在一个集群里,可以拥有任意多个节点。并且,如果当前网络中没有运行任何Elasticsearch节点,这时启动一个节点,会默认创建并加入一个叫做“elasticsearch”的集群。

(4)、索引(index)

索引是指一个拥有相似特征的文档的集合。比如说,你可以有一个客户数据的索引,另一个产品目录的索引,还有一个订单数据的索引。每个索引均由一个名字来标识(必须全部是小写字母的),并且当要对对应于这个索引中的文档进行索引、搜索、更新和删除的时候,都要使用到这个名字。

“索引”有两个意思:

A.作为动词,索引指把一个文档“保存”到ES 中的过程,某个文档被索引后,就可以使用ES 搜索到这个文档

B.作为名词,索引指保存文档的地方,相当于数据库概念中的“库”

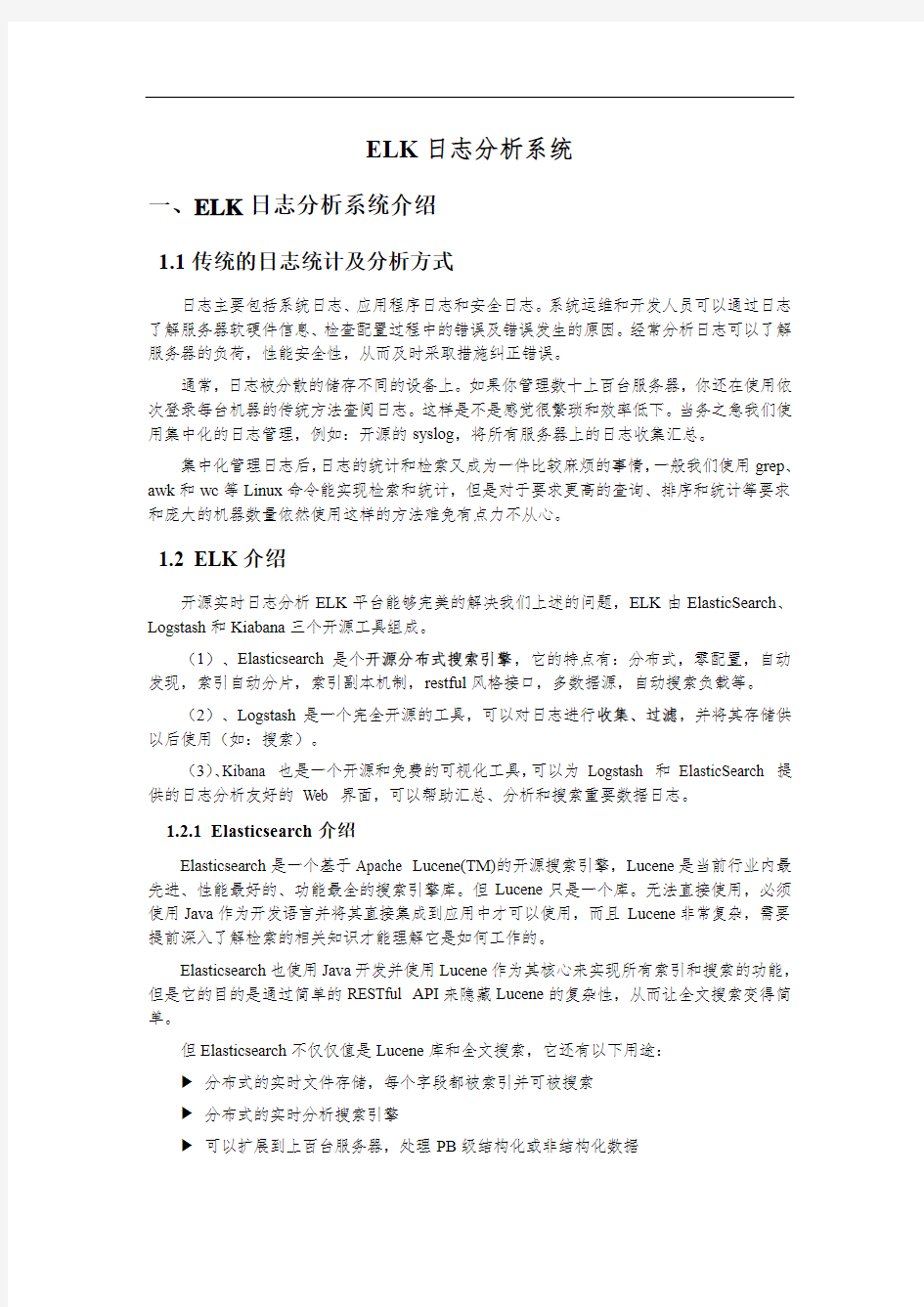

为了方便理解,我们可以将ES 中的一些概念对应到我们熟悉的关系型数据库上:

在一个集群中,可以定义任意多的索引。

(5)、类型(type)

在一个索引中,可以定义一种或多种类型。类型是指索引的一个逻辑上的分类/分区,其语义可自定义。通常情况下,会为具有一组共同字段的文档定义一个类型。比如说,我们

假设运营一个博客平台并且将所有的数据存储到一个索引中。在这个索引中,可以为用户数据定义一个类型,为博客数据定义另一个类型,当然,也可以为评论数据定义另一个类型。

(6)、文档(document)

文档是指可被索引的基础信息单元。比如,你可以拥有某一个客户的文档,某一个产品的一个文档,当然,也可以拥有某个订单的一个文档。文档以JSON(Javascript Object Notation)格式来表示,而JSON是一个普遍存在的互联网数据交互格式。

在一个index/type里面,可以存储任意多的文档。注意,尽管一个文档物理上存在于一个索引之中,但文档必须被赋予一个索引的type。

(7)、分片和复制(shards & replicas)

一个索引可以存储超出单个节点磁盘限制的大量数据。比如以下情况,一个具有10亿文档的索引占据1TB的磁盘空间,而集群中任一节点都没有这样大的磁盘空间;或者单个节点处理搜索请求,响应太慢。

为了解决此问题,Elasticsearch提供了将索引划分成多份的能力,这些份就叫做分片。当创建一个索引的时候,可以指定想要的分片的数量。每个分片本身也是一个功能完善并且独立的“索引”,这个“索引”可以被放置到集群中的任何节点上。

分片之所以重要,主要有两方面的原因:

A.允许水平分割/扩展内容容量

B.允许在分片(潜在地,位于多个节点上)之上进行分布式的、并行的操作,进而提高性能/吞吐量

至于一个分片怎样分布,它的文档怎样聚合搜索请求,是完全由Elasticsearch管理的,用户对此是透明的。

在一个网络/云的环境里,失败随时都可能发生,在某个分片/节点无原因就处于离线状态,或者由于任何原因消失了的情况下,Elasticsearch提供一个故障转移机制,它允许你创建分片的一份或多份拷贝,这些拷贝叫做复制分片,或者直接叫复制。

复制之所以重要,有两个主要原因:

A.在分片/节点失败的情况下,提供了高可用性。因为这个原因,注意到复制分片从不与原/主要(original/primary)分片置于同一节点上是非常重要的。

B.扩展你的搜索量/吞吐量,因为搜索可以在所有的复制上并行运行

总之,每个索引可以被分成多个分片。一个索引也可以被复制0次(意思是没有复制)或多次。一旦复制了,每个索引就有了主分片(作为复制源的原来的分片)和复制分片(主分片的拷贝)之别。分片和复制的数量可以在索引创建的时候指定。在索引创建之后,可以在任何时候动态地改变复制的数量,但是事后不能改变分片的数量。

默认情况下,Elasticsearch中的每个索引被分片5个主分片和1个复制,这意味着,如果你的集群中至少有两个节点,你的索引将会有5个主分片和另外5个复制分片(1个完全拷贝),这样的话每个索引总共就有10个分片。

1.2.3 Logstash介绍

Logstash的主要功能是收集和过滤,类似于shell中的管道符“|”。它的工作过程是将数据进行收集,并对收集的入职根据策略进行分类和过滤,最后进行输出.

实际上,Logstash 是用不同的线程来实现收集、过滤、输出功能的,可运行top 命令然后按下H 键查看线程。

数据在线程之间以事件的形式流传。并且,logstash 可以处理多行事件。

Logstash 会给事件添加一些额外信息。其中最重要的就是@timestamp,是用来标记事件的发生时间。因为这个字段涉及到Logstash 的内部流转,所以必须是一个json对象,如果自定义给一个字符串字段重命名为@timestamp 的话,Logstash会直接报错,那么就需要使用filters/date插件来管理这个特殊字段。额外信息还包括以下几个概念:

A.host 标记事件发生在哪里。

B.type 标记事件的唯一类型。

C.tags 标记事件的某方面属性。这是一个数组,一个事件可以有多个标签。

也可以自定义个事件添加字段或者从事件里删除字段。事实上事件本身就是是一个Ruby对象。

1.2.4 Kibana介绍

Kibana是一个开源的分析与可视化平台,用于和Elasticsearch一起使用,可以用kibana 搜索、查看、交互存放在Elasticsearch索引里的数据,使用各种不同的图表、表格、地图等kibana能够很轻易地展示高级数据分析与可视化。

Kibana对大量数据的呈现非常清晰。它简单、基于浏览器的接口能快速创建和分享实时展现Elasticsearch查询变化的动态仪表盘。

本次安装部署的Kibana版本为4.3.1版本,对应Elasticsearch版本为2.4.6版本。

二ELK安装配置

2.1 系统架构介绍

此架构的工作流程是Logstash agent(shipper)监控并过滤客户端日志,将过滤后的日志内容发给Redis(indexer),此处的Redis既充当消息队列的角色,由于其优越的持久化机制也被用来做缓存,然后Logstash Server(indexer)从Redis的对应位置拿出日志数据,并将其输出到ElasticSearch中,ElasticSearch获取到数据后开始生产索引,然后使用Kibana 进行页面展示。这是一个完成的日志收集、存储、检索流程。

2.2 安装Elasticsearch

OS:Centos 6.5

elk-node1:10.20.20.48

elk-node2:10.20.20.47

在两台主机上分别安装Elasticsearch。

准备工作:

(1)、关闭防火墙、Selinux

# iptables -F

# chkconfig iptables off

# setenforce 0

# vim /etc/sysconfig/selinux

改为:

SELINUX=disabled

(2)、配置java环境

# yum install -y java

# java -version

java version "1.7.0_151"

OpenJDK Runtime Environment (rhel-2.6.11.0.el6_9-x86_64 u151-b00)

OpenJDK 64-Bit Server VM (build 24.151-b00, mixed mode)

(3)、配置主机信息

node1、node2节点分别配置:

其中node1是master,node2是slave

# vim /etc/hosts

10.20.20.48 elk-node1

10.20.20.47 elk-node2

2.2.1 Yum方式安装

(1)、下载并安装GPG-Key

# rpm --import https://packages.elastic.co/GPG-KEY-elasticsearch

(2)、添加yum仓库

# vim /etc/yum.repos.d/elasticsearch.repo

[elasticsearch-2.x]

name=Elasticsearch repository for 2.x packages

baseurl=http://packages.elastic.co/elasticsearch/2.x/centos

gpgcheck=1

gpgkey=http://packages.elastic.co/GPG-KEY-elasticsearch

enabled=1

(3)、安装elasticsearch

# yum install -y elasticsearch

(4)、安装测试软件

注:提前先下载安装epel源:epel-release-latest-6.noarch.rpm,否则yum会报错:No Package.....

# wget http://ftp.riken.jp/Linux/fedora/epel/epel-release-latest-6.noarch.rpm

# rpm -ivh epel-release-latest-6.noarch.rpm

# yum install -y redis

# yum install -y nginx

(5)、部署配置

# mkdir -p /data/es-data

elk-node1:

# vim /etc/elasticsearch/elasticsearch.yml

https://www.360docs.net/doc/209929122.html,: nova ##集群名称

https://www.360docs.net/doc/209929122.html,: elk-node1 ##节点名,建议和主机一致

node.master: true ##指定该节点是否有资格被选举成为master node,默认是true,es是默认集群中的第一台机器为master,如果这台机挂了就会重新选举master。

node.data: false ##指定该节点是否存储索引数据,默认为true。

path.data: /data/es-data ##数据存放路径

path.logs: /var/log/elasticsearch/ ##日志存放文件

bootstrap.memory_lock: true ##内存锁机制,锁住内存,不被使用到交换分区去

network.host: 0.0.0.0 ##网络主机访问权限设置

http.port: 9200 ##web端口

elk-node2:

# vim /etc/elasticsearch/elasticsearch.yml

https://www.360docs.net/doc/209929122.html,: nova ##集群名称

https://www.360docs.net/doc/209929122.html,: elk-node2 ##节点名,建议和主机一致

node.master: false ##指定该节点是否有资格被选举成为master node,默认是true,默认集群中的第一台机器为master,如果这台机挂了就会重新选举master。

node.data: true ##指定本节点为数据存储节点

path.data: /data/es-data ##数据存放路径

path.logs: /var/log/elasticsearch/ ##日志存放文件

bootstrap.memory_lock: true ##内存锁机制,锁住内存,不被使用到交换分区去

network.host: 0.0.0.0 ##网络主机访问权限设置

http.port: 9200 ##web端口

discovery.zen.ping.multicast.enabled: false##多播自动发现禁用开关,当前设置为关闭

discovery.zen.ping.unicast.hosts: ["10.20.20.48", "10.20.20.47"]

# chown -R elasticsearch.elasticsearch /data/

(6)、启动服务

# /etc/init.d/elasticsearch start

Starting elasticsearch: [ OK ]

# chkconfig elasticsearch on

# /etc/init.d/elasticsearch status

elasticsearch (pid 2309) is running...

# netstat -antplu| egrep "9200|9300"

tcp 0 0 :::9200 :::* LISTEN 2309/java

tcp 0 0 :::9300 :::* LISTEN 2309/java

(7)、验证

1)、web浏览器访问

打开浏览器(最好是google浏览器),输入IP+端口:10.20.20.48:9200,查看界面显示。

验证正确。

2)、通过命令的方式查看

注:即可在本机查看,也可在其他主机查看。

# curl -i -XGET 'http://10.20.20.48:9200/_count?pretty' -d '{"query":{"match_all":{}}}' HTTP/1.1 200 OK ##访问成功

Content-Type: application/json; charset=UTF-8

Content-Length: 95

{

"count" : 0,

"_shards" : {

"total" : 0,

"successful" : 0,

"failed" : 0

}

}

2.2.2 源码安装

(1)、获取elasticsearch-2.4.6.tar.gz源码包,并保存在系统/usr/local/src中。

(2)、解压安装

# cd /usr/local/src

# tar -xvf elasticsearch-2.4.6.tar.gz

# mv elasticsearch-2.4.6 /usr/loca/es

(3)、创建es用户及数据目录

# groupadd es

# useradd -g es es

# mkdir -r /data/es-data

# chown -R es:es /data/es-data

# mkdir -r /var/log/elasticsearch

# chown -R es:es /var/log/elasticsearch

(4)、es配置

# vim /usr/local/es/config/elasticsearch.yml

注:配置参数时,需要先设置一个空格,否则启动时会报错。

https://www.360docs.net/doc/209929122.html,: nova

https://www.360docs.net/doc/209929122.html,: elk-node3

node.master: false

node.data: true

path.data: /data/es-data

path.logs: /data/logs/es

path.logs: /data/logs/es

network.host: 0.0.0.0

http.port: 9200

discovery.zen.ping.multicast.enabled: false

discovery.zen.ping.unicast.hosts: ["10.20.20.48", "10.20.20.47","10.20.20.38"]

(5)、启动

源码安装的es不能使用root用户启动,必须使用创建好的普通用户进行启动。

# su - es

$ /usr/local/es/bin/elasticsearch &

[2017-09-29 23:57:38,334][WARN ][bootstrap] unable to install syscall filter: seccomp unavailable: CONFIG_SECCOMP not compiled into kernel, CONFIG_SECCOMP and CONFIG_SECCOMP_FILTER are needed

[2017-09-29 23:57:38,346][WARN ][bootstrap] Unable to lock JVM Memory: error=12,reason=Cannot allocate memory

[2017-09-29 23:57:38,346][WARN ][bootstrap] This can result in part of the JVM being swapped out.

[2017-09-29 23:57:38,346][WARN ][bootstrap] Increase RLIMIT_MEMLOCK, soft limit: 65536, hard limit: 65536

[2017-09-29 23:57:38,346][WARN ][bootstrap] These can be adjusted by modifying /etc/security/limits.conf, for example: # allow user 'es' mlockall

es soft memlock unlimited

es hard memlock unlimited

[2017-09-29 23:57:38,347][WARN ][bootstrap] If you are logged in interactively, you will have to re-login for the new limits to take effect.

[2017-09-29 23:57:38,704][INFO ][node] [elk-node3] version[2.4.6], pid[3375], build[5376dca/2017-07-18T12:17:44Z]

[2017-09-29 23:57:38,704][INFO ][node] [elk-node3] initializing ...

[2017-09-29 23:57:39,167][INFO ][plugins] [elk-node3] modules [lang-groovy, reindex, lang-expression], plugins [], sites [] [2017-09-29 23:57:39,205][INFO ][env] [elk-node3] using [1] data paths, mounts [[/ (/dev/mapper/vg_nginx-lv_root)]], net usable_space [33.2gb], net total_space [36.8gb], spins? [possibly], types [ext4]

[2017-09-29 23:57:39,205][INFO ][env] [elk-node3] heap size [1015.6mb], compressed ordinary object pointers [true]

[2017-09-29 23:57:39,205][WARN ][env] [elk-node3] max file descriptors [4096] for elasticsearch process likely too low, consider increasing to at least [65536]

[2017-09-29 23:57:40,645][INFO ][node] [elk-node3] initialized

[2017-09-29 23:57:40,645][INFO ][node] [elk-node3] starting ...

[2017-09-29 23:57:40,691][INFO ][transport] [elk-node3] publish_address {10.20.20.38:9300}, bound_addresses {[::]:9300} [2017-09-2923:57:40,695][INFO][discovery][elk-node3] nova/DSP41KSoR2C_RdXJNPO4zg

显示以上信息表示es启动成功。

$ netstat -antplu | grep java

tcp 0 0 :::9200 :::* LISTEN 3375/java

tcp 0 0 :::9300 :::* LISTEN 3375/java

端口已开启。

验证:

$ curl -i -XGET 'http://10.20.20.38:9200/_count?pretty' -d '{"query":{"match_all":{}}}' HTTP/1.1 200 OK

Content-Type: application/json; charset=UTF-8

Content-Length: 98

{

"count" : 78,

"_shards" : {

"total" : 21,

"successful" : 21,

"failed" : 0

}

}

验证正常。

2.2.3 head插件安装

(1)、方法一:直接安装

# /usr/share/elasticsearch/bin/plugin install mobz/elasticsearch-head

安装完成,进行验证。

打开浏览器,输入http://10.20.20.48:9200/_plugin/head/,查看显示结果。

插件安装成功。

删除插件:

# /usr/share/elasticsearch/bin/plugin list

Installed plugins in /usr/share/elasticsearch/plugins:

- head ##当前已安装插件

# /usr/share/elasticsearch/bin/plugin remove head

-> Removing head...

Removed head ##删除成功

注:源码安装的es,在安装head插件后,重启会报错。

报错信息:

Exception in thread "main" https://www.360docs.net/doc/209929122.html,ng.IllegalArgumentException: Property [version] is missing for plugin [head]

解决方案:

# vim /usr/local/es/plugins/head/plugin-descriptor.properties

description=head - A web front end for an elastic search cluster

version=master

site=true

name=head

然后进行重启,重启后正常。

(2)、方法二:源码安装

head插件包百度云盘下载:https://https://www.360docs.net/doc/209929122.html,/s/1boBE0qj,提取密码:ifj7

# cd /usr/local/src/

# unzip elasticsearch-head-master.zip

# cd /usr/share/elasticsearch/plugins/

# mkdir head

# cd head/

# cp -r /usr/local/src/elasticsearch-head-master/* ./

# chown -R elasticsearch:elasticsearch /usr/share/elasticsearch/plugins

# /etc/init.d/elasticsearch restart

# curl -i -XGET 'http://10.20.20.48:9200/_count?pretty' -d '{"query":{"match_all":{}}}'

命令测试插件安装成功。

Web界面显示正确,说明插件安装成功。

2.2.4 实例测试

(1)、插入数据实例测试

打开”复合查询“,在POST选项下,任意输入如/index-demo/test,然后在下面输入数据,查看返回结果。

注:内容之间换行的逗号不要漏掉

点击”验证JSON“->”提交请求“,提交成功后,观察右栏里出现的信息:有index,type,version等信息,failed:0(成功消息)

测试成功。

(2)、实例测试

选择"复合查询"选项,选择GET选项,在/index-demo/test/后面输入上面POST结果中的id号,不输入内容,即{}括号里为空!

点击”验证JSON“和"提交请求",观察右栏内显示结果。

结果中有上述插入的数据,这就是elasticsearch检索功能的具体体现。(3)、实例查询

打开"基本查询",查看下数据,如下,即可查询到(1)步骤中插入的数据。

打开“数据浏览”,也能查看到插入的数据。

其中也可通过mesg和user关键字检索相应数据。

2.2.5 kopf监控插件

(1)、方法一

# /usr/share/elasticsearch/bin/plugin install lmenezes/elasticsearch-kopf

安装成功。

(2)、方法二:源码安装

# wget https://https://www.360docs.net/doc/209929122.html,/lmenezes/elasticsearch-kopf/archive/master.zip # unzip master.zip

# cd /usr/share/elasticsearch/plugins/

# mkdir kopf

# cd kopf

# cp -r /usr/local/src/elasticsearch-kopf-master/* ./

# chown -R elasticsearch:elasticsearch /usr/share/elasticsearch/plugins

# /etc/init.d/elasticsearch restart

Stopping elasticsearch: [FAILED]

Starting elasticsearch: [ OK ] 测试验证:

2.3 安装Logstash

安装包:https://www.360docs.net/doc/209929122.html,/components/cache/logstash/logstash-2.3.4.tar.gz 2.3.1 下载源码安装包

# wget https://www.360docs.net/doc/209929122.html,/components/cache/logstash/logstash-2.3.4.tar.gz 2.3.2 安装

# tar -xvf logstash-2.3.4.tar.gz

# mv logstash-2.3.4/ /usr/local/logstash

2.3.3 配置环境

# vim /etc/profile

export PATH=$PATH:/usr/local/logstash/bin

# source /etc/profile

2.3.4 重启elasticsearch

# /etc/init.d/elasticsearch restart

2.3.5 数据测试

logstash常用参数:

-e :指定logstash的配置信息,可以用于快速测试;

-f :指定logstash的配置文件;可以用于生产环境;

(1)、基本输入输出(数据未写入elasticsearch中)

# logstash -e 'input { stdin{} } output { stdout{} }'

Settings: Default filter workers: 1

Logstash startup completed

hello ##输入

2017-09-19T18:51:29.082Z 0.0.0.0 hello ##输出

world ##输入

2017-09-19T18:51:38.151Z 0.0.0.0 world ##输出

(2)、使用rubydebug详细输出(数据未写入elasticsearch中)

# logstash -e 'input { stdin{} } output { stdout{ codec => rubydebug} }'

Settings: Default filter workers: 1

Logstash startup completed

hello ##输入

{ ##输出下面信息

"message" =>"hello",

"@version" =>"1",

"@timestamp" =>"2017-09-19T19:32:44.701Z",

"host" =>"0.0.0.0"

}

world ##输入

{ ##输出线面信息

"message" =>"world",

"@version" =>"1",

"@timestamp" =>"2017-09-19T19:32:55.357Z",

"host" =>"0.0.0.0"

}

(3)、把输入内容输出到elasticsearch中

# logstash -e 'input { stdin{} } output { elasticsearch { hosts => ["10.20.20.49:19200"]} }' Settings: Default filter workers: 1

Logstash startup completed

123456 ##输入内容

nova

hello

world

SIGINT received. Shutting down the pipeline. {:level=>:warn}

Logstash shutdown completed

注:使用rubydebug和写到elasticsearch中的区别:其实就在于后面标准输出的区别,前者使用codec;后者使用elasticsearch。

测试:写到elasticsearch中内容在logstash中查看,如下图:

注:master收集到日志后,会把一部分数据碎片到salve上(随机的一部分数据),master 和slave又都会各自做副本,并把副本放到对方机器上,这样就保证了数据不会丢失。

如下,master收集到的数据放到了自己的第3分片上,其他的放到了slave的第0,1,2,4分片上。

(1)、elasticsearch查看

(2)、Logstash查看

(3)、文本查看

(4)、既写到elasticsearch中又写到文件中

# logstash -e 'input { stdin{} } output { elasticsearch { hosts => ["10.20.20.49:19200"]} stdout{ codec => rubydebug}}'

Settings: Default filter workers: 1

Logstash startup completed

yangguoqiang ##输入

{ ##输出内容

"message" =>"yangguoqiang",

"@version" =>"1",

"@timestamp" =>"2017-09-19T21:02:36.313Z",

"host" =>"0.0.0.0"

}

nihao ##输入

{ ##输出内容

"message" =>"nihao",

"@version" =>"1",

"@timestamp" =>"2017-09-19T21:02:39.163Z",

"host" =>"0.0.0.0"

}

Logstash shutdown completed

注:以上文本可以长期保留、操作简单、压缩比大。

验证:

输出信息被记录在文本中,可实时查询。

2.3.6 logstash的配置和文件编写

参考文档:https://www.elastic.co/guide/en/logstash/current/configuration.html

https://www.elastic.co/guide/en/logstash/current/configuration-file-structure.html # mkdir /etc/logstash

(1)、logstash的配置

# vim /etc/logstash/conf.d/01.logstash.conf

input{stdin{ }}

output{

elasticsearch { hosts => ["10.20.20.49:19200"]}

stdout { codec => rubydebug }

}

执行:

# logstash -f /etc/logstash/conf.d/01.logstash.conf

Settings: Default filter workers: 1

Logstash startup completed

beijing ##输入信息

{ ##输出信息

"message" =>"beijing",

"@version" =>"1",

"@timestamp" =>"2017-09-20T09:00:46.581Z",

"host" =>"0.0.0.0"

}

验证:

(2)、收集系统日志配置

# vim /etc/logstash/log_file.conf

input {

file {

日志分析系统调研分析-ELK-EFK

日志分析系统 目录 一. 背景介绍 (2) 二.日志系统比较 (2) 1.怎样收集系统日志并进行分析 (2) A.实时模式: (2) B.准实时模式 (2) 2.常见的开源日志系统的比较 (3) A. FaceBook的Scribe (3) B. Apache的Chukwa (3) C. LinkedIn的Kafka (4) E. 总结 (8) 三.较为成熟的日志监控分析工具 (8) 1.ELK (9) A.ELK 简介 (9) B.ELK使用场景 (10) C.ELK的优势 (10) D.ELK的缺点: (11) 2.EFK (11) 3. Logstash 于FluentD(Fluentd)对比 (11)

一. 背景介绍 许多公司的平台每天会产生大量的日志(一般为流式数据,如,搜索引擎的pv,查询等),处理这些日志需要特定的日志系统,一般而言,这些系统需要具有以下特征: (1)构建应用系统和分析系统的桥梁,并将它们之间的关联解耦; (2)支持近实时的在线分析系统和类似于Hadoop之类的离线分析系统; (3)具有高可扩展性。即:当数据量增加时,可以通过增加节点进行水平扩展。二.日志系统比较 1.怎样收集系统日志并进行分析 A.实时模式: 1 在打印日志的服务器上部署agent 2 agent使用低耗方式将日志增量上传到计算集群 3 计算集群解析日志并计算出结果,尽量分布式、负载均衡,有必要的话(比如需要关联汇聚)则采用多层架构 4 计算结果写入最适合的存储(比如按时间周期分析的结果比较适合写入Time Series模式的存储) 5 搭建一套针对存储结构的查询系统、报表系统 补充:常用的计算技术是storm B.准实时模式 1 在打印日志的服务器上部署agent 2 agent使用低耗方式将日志增量上传到缓冲集群 3 缓冲集群将原始日志文件写入hdfs类型的存储 4 用hadoop任务驱动的解析日志和计算 5 计算结果写入hbase 6 用hadoop系列衍生的建模和查询工具来产出报表 补充:可以用hive来帮助简化

日志分析系统

Web日志集中管理系统的研究与实现 吴海燕朱靖君程志锐戚丽 (清华大学计算机与信息管理中心,北京100084) E-mail:wuhy@https://www.360docs.net/doc/209929122.html, 摘要: Web服务是目前互联网的第一大网络服务,Web日志的分析对站点的安全管理与运行维护非常重要。在实际运行中,由于应用部署的分散性和负载均衡策略的使用,使得Web日志被分散在多台服务器上,给日志的管理和分析带来不便。本文设计并实现了一个Web日志集中管理系统(命名为ThuLog),系统包括日志集中、日志存储和日志分析三个模块。目前,该系统已经在清华大学的多个关键Web应用系统上进行了应用,能够帮助系统管理员清晰地了解系统运行情况,取得了较好的运行效果。 关键词:Web日志日志分析日志集中管理系统 The Research and Implementation of a Centralized Web Log Management System Wu Haiyan Zhu Jingjun Cheng Zhirui Qi Li (Computer&Information Center,Tsinghua University,Beijing100084) Abstract:Web is now the biggest network service on the Internet.The analysis of Web logs plays an important role in the security management and the maintenance of a website.But because of the decentralization of deployment and the use of load balancing,Web logs are often seperated on each Web server,which makes the management and analysis of them not so convenient.This paper designs and implements a Web Log Centralized Management System(named ThuLog),which includes3modules:the centralization of logs,the storage of logs and the analysis of logs.Through log analysis of several critical Web systems in Tsinghua University,it could help system administrators learn clearly what happens in information systems and achieves good operating results. Key words:Web Logs Log Analysis Web Log Centralized Management System 1.引言 近年来,随着计算机网络技术的迅速发展,Web正以其广泛性、交互性、快

技术参数日志实时监视系统提供实时的日志滚动显示和

技术参数:日志实时监视:系统提供实时的日志滚动显示和查询,可自定义实时监视的日志内容,可查看实时日志详细信息;统一监控主页:系统应提供从总体上把握日志告警和日志统计分析的实时综合性监控界面。界面由多个监控组件组成,用户可以自定义监控主页;生产厂商:北京启明星辰信息安全技术有限公司;日志关联分析告警:系统支持异常行为分析,维护一个与用户信息 系统相关的合法账号的正常行为集合,以此区分入侵者的行为和合法用户的异常行为;系统应至少默认有50条告警规则,系统提供可视化规则编辑器,对告警规则进行增删改查。系统内置针对服务器和其他安全设备的访问ip地址、访问账户和访问时间的访问控制规则;告警规则可按照树型结构组织,并可在该树型结构上直接查看该规则的告警信息,对告警日志可按各告警字 段进行分组排序。可对不同类型设备的日志之间进行关联分析,支持递归关联,统计关联,时序关联,这几种关联方式能同时应用于一个关联分析规则;日志审计查询:所有日志采用统一的日志查询界面,用户可以自定义各种查询场景。查询场景可保存,并可支持在查询结果中继续查询。支持原始消息中的关键字查询,可进行全文检索,可对查询结果进行分组排序,查询结 果可导出;二次开发接口:支持二次开发功能;型号:TSOC-SA-SW-SC;趋势分析:可对收集的日志根据过滤条件,针对设备地址、源地址、目标地址等进行事件数量等的趋势分析;支持端口监控:支持对服务器开启的无用端口、短时间使用不同的口令多次尝试连接服务器的审计;告警和响应管理:通过关联分析,对于发现的严重事件可以进行自动告警,告警内容支持 用户自定义字段。告警方式包括邮件、短信、SNMP Trap、Syslog等。响应方式包括:自动执行预定义脚本,自动将事件属性作为参数传递给特定命令行程序;移动存储介质使用痕迹审计:应能够对受控主机使用过的移动存储介质进行常规审计;应能够将受控主机删除后的移动存储介质使用痕迹进行深度审计;备份归档:支持数据库备份归档;支持历史日志恢复导入;支 持各种配置项的备份和导入;报表管理:提供丰富的报表管理功能,预定义了针对各类服务器、网络设备、防火墙、入侵检测系统、防病毒系统、终端安全管理系统、数据库、策略变更、流量,设备事件趋势以及总体报表,根据时间、数据类型等生成报表,提供导出以及邮件送达等服务;直观地为管理员提供决策和分析的数据基础,帮助管理员掌握网络及业务系统的状况。 报表可以保存为html、excel、pdf等多种格式。提供自定义报表,用户可根据自身需要进行定制。报表可根据设置自动运行,调度生成日报、周报和月报;日志实时分析和统计:可对收集的日志进行分类实时分析和统计,从而快速识别安全事故。分析统计结果支持柱图、饼图、曲线图等形式并自动实时刷新,图表数据支持数据下钻。日志实时图表数据支持数据下钻。日志实时分析在内存中完成,不需借助数据库和文件系统;告警查询:支持显示所有和按规则树结果分别显示告警事件信息,对告警查询结果字段可以分别二次排序显示;采集方式:审计中心可通过syslog、snmptrap、jdbc/odbc、agent等多种方式完成日志收集功能;告警:支持告警,告警动作支持多种常规告警方式;支持主机状态监控与审计:应能审计账户快照、操作系统版 本、主机名称、内存容量、硬盘容量、CPU信息等;售后服务内容:1、为最终用户提供技术服务热线。2、提供3年的产品授权和原厂服务,原厂服务为与产品出厂市场服务标准一致的原厂服务。3、提供5*8小时技术支持服务。4、提供如下 故障保修服务:两小时电话响应,两个工作日解决问题。对于未能解决的问题和故障应提供可行的升级方案等。5、发生非人为因素故障,在七日内免费对产品进行补充或者更换。;核心功能:对日志进行归一、汇总、分析将海量安全日志转化为少量安全事件;采集器:日志采集前置可以分布式部署,以降低网络传输、分散负载,可以在需要时增设新的日志采集前置,从而 提高系统的伸缩性;支持异常监控审计:主要审计终端电脑上对CPU占有率、内存占有率和运行时间超过策略中设置值的信息,包括计算机账户、IP地址、MAC地址、事件类型、运行时间等信息;支持多操作系统:支持Windows、Linux等主流操作系统;供货要求:供货商按照客户约定的时间和地点提供相应的产品和服务,并完成现场交付和安全调试:(1)负责产品的安 装与现场调试服务(2)完成软件的安装与调试服务(3)负责提供安装与调试所需的相应工具和设备等(4)负责提供所需相关保护设备。(5)交付产品时应提供配套的技术资料,包括但不限于:系统说明文件、用户手册(安装、操作、维护、故障排除)等;支持文件操作痕迹检查:系统应能够对主机文件操作痕迹进行检查,操作行为应包括:编辑、保存、复制、粘贴等常规文件操作行为;日志关联分析:系统具有日志关联分析的能力,能够对不同的日志进行相关性分析,发掘潜在的信息;系统支持编写自定义关联规则;品牌:启明/QEEMEE;过滤归并:支持对无用日志的可设置过滤条件和归并规则;支持未授权操作信息:支持对未经授权卸载、删除、修改终端审计;应能够审计未经过授权删除终端安装目录文件的日志,包括计算机账户、IP地址 、MAC地址、时间类型、进程路径、文件路径等信息;管理权限分级分域:管理员分级分权,可以自行设置管理员权限和策略。如管理员、安全员、操作员、审计员等。;报表:提供报表功能,支持自定义生成报表;是否需要安装:需要;综合日志审计:采集日志,日志信息汇集到审计中心,通过统一的控制台界面进行实时、可视化的呈现分析,能对网络设备、安全设备和 系统、主机操作系统、数据库以及各种应用系统的日志、事件、告警等安全信息进行全面的审计;日志范式化:系统具备日志范式化功能,实现对异构日志格式的统一化;针对不支持的事件类型做范式化不需改动编码,通过修改配置文件即可完成;日志审计对象:包括主流网络设备、安全设备、安全系统、主机操作系统、数据库、应用系统、网管系统告警日志、终端管理系

Linux 系统日志收集分析系统

Linux 系统日志收集分析系统 一、搭建环境 系统:centos6.5 软件:lamp、rsyslog、rsyslog-mysql 、loganalyzer rsyslog用来收集远程服务器系统日志信息 rsyslog-mysql是rsyslog连接数据库的模块 loganalyzer用来分析系统日志 二、软件安装 a、httpd安装 tar -jxvf apr-1.5.1.tar.bz2 ./configure --prefix=/usr/local/apr make && make install tar -zxvf apr-util-1.5.4.tar.gz ./configure --prefix=/usr/local/apr-util --with-apr=/usr/local/apr/ make && make install tar -zxvf httpd-2.4.12.tar.gz yum install -y pcre-devel zlib-devel openssl-devel ./configure --prefix=/data/program/apache2 --enable-so --enable-rewrite --enable-ssl --enable-cgi --enab le-cgid --enable-modules=most --enable-mods-shared=most --enable- mpms-share=all --with-apr=/usr/local/apr --with-apr-util=/usr/local/apr-util --enable-deflate make -j 6 && make install ++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++++ 修改httpd配置文件,添加如下两行 AddType application/x-httpd-php .php AddType application/x-httpd-php-source .phps 定位至DirectoryIndex index.htm DirectoryIndex index.php index.html 注释掉主服务的站点目录 #DocumentRoot "/data/program/apache2/htdocs" 开启虚拟主机需要加载 Include conf/extra/httpd-vhosts.conf LoadModule log_config_module modules/mod_log_config.so 添加虚拟主机

日志分析系统

日志分析系统 1.前言 随着江苏中烟信息化程度的不断提升,信息化系统的数目也不断增加,运维任务也不断增加。为了应对日益增加的信息化需求,提升服务质量,减轻运维工作,在信息系统服务化的基础上,迫切需要一个管理平台,实现对所有服务的管理和监控,这就是微服务平台。微服务平台能够实现devOps,服务的注册、发现、权限管理、监控、测试、故障预警,故障恢复等。 日志分析系统是微服务平台的重要组成部分,它能够对各服务的日志进行采集,存储,分析(找出异常的请求、统计报错情况、统计QPS、统计系统功能的使用情况、超负荷预警等)。同时,对系统资源的监控信息也可以以日志的形式,由日志分析系统分析。日志分析系统后台使用大数据平台来存储和分析日志,能够支持大量的日志,不需要担心日志的存储问题。 2.日志分析系统 2.1.功能 日志分析系统主要功能包括日志的采集、存储、分析。 日志采集常见的场景如:对webserver服务器的log文件进行监控,发现有变动时,采集变动的信息;对网络的某个端口监控,当此端口出现数据流时,采集数据流;监控程序定时的获取系统资源信息(同理,也适用于对JVM,tomcat的监控);采集Http请求和响应(同理适用于rpc远程调用)。 日志的存储使用大数据平台。根据日志的类型,可以以非结构化或者结构化数据存储,也可以使用图数据库存储。 日志分析包括日志的离线和在线分析。离线分析借助大数据平台提供的SQL,对日志数据库中的所有数据进行统计分析,适合于统计QPS,系统功能使用情况。在线分析(实时分析)处理即时产生的日志信息,适合于预警,异常请求的监控。 2.2.结构

3.实现 3.1.要求 ?能够适配不同的日志数据,例如web server log、rpc log、syslog ?能够处理突发的大流量数据 ?能够检测日志系统的个节点的运行状态,并自动恢复 ?能够方便的和Hive、Spark、Hbase等集成 ?稳定的运行,尽量少占用资源 3.2.日志收集和路由 logstash是一种分布式日志收集框架,非常简洁强大,经常与ElasticSearch,Kibana配置,组成著名的ELK技术栈,非常适合用来做日志数据的分析。Logstash分为Shipper(收集日志),Broker(日志集线器,可以连接多个Shipper),Indexer(日志存储)。Shipper 支持多种类型的日志文件,且可以自定义插件支持更多的种类。Logstash采用JRuby语言实现,插件开发相对困难。Logstash可以通过配置正则表达式的方式,将日志解析为结构化数

日志分析:千亿级数量下日志分析系统的技术架构选型

日志分析:千亿级数量下日志分析系统的技术架构选型 随着数据已经逐步成为一个公司宝贵的财富,大数据团队在公司往往会承担更加重要的角色。大数据团队往往要承担数据平台维护、数据产品开发、从数据产品中挖掘业务价值等重要的职责。所以对于很多大数据工程师,如何根据业务需求去选择合适的大数据组件,做合适的大数据架构工作就是日常工作中最常遇到的问题。在这里根据七牛云在日增千亿级的日志分析工作,和大家分享一下大数据技术架构选型的一些经验。 大数据架构师在关注什么 在一个大数据团队中,大数据架构师主要关注的核心问题就是技术架构选型问题。架构选型问题一般会受到哪些因素的影响呢?在我们的实践中,一般大数据领域架构选型最受以下几个因素影响: 数据量级 这一点在大数据领域尤其是一个重要的因素。不过从根本上讲,数据量级本身也是一种业务场景的衡量。数据量级的不同往往也就昭示着业务场景的不同。

业务需求 经验丰富的大数据架构师能够从纷繁的业务需求中提炼出核心技术点,根据抽象的技术点选择合适的技术架构。主要的业务需求可能包括:应用实时性要求、查询的维度和灵活程度、多租户、安全审计需求等等。 维护成本 这一点上大数据架构师一方面要能够清楚的了解各种大数据技术栈的优劣势,在满足业务需求的要求下,能够充分的优化架构,合理的架构能够降低维护的成本,提升开发的效率。 另一方面,大数据架构师要能清楚的了解自己团队成员,能了解其他同学的技术专长和品位,能够保证自己做的技术架构可以得到认可和理解,也能得到最好的维护和发展。 接下来我们会围绕这几个方面去看看,做一个最适合自己团队业务的架构选型会如何受到这些因素的影响? 技术架构选型 业务需求是五花八门的,往往影响我们做技术选型的不是种种需求的细节,而是经过提炼后的一些具体的场景。就好比,业务需求提出我们要做一个日志分析系统,或者要做一个用户行为分析系统,这些具体需求背后我们要关注哪些具体的点?这是一个很有趣的问题,我们在做大数据的过程中,常发现我们对这些需求的疑问很多时候会落在以下几个问题上。 其中数据量级作为一个重要的因素影响着我们对于技术选型的决定,另外在数据量的变化之外各种业务场景的需要也会影响我们对技术组件的选择。 数据量级

大数据日志分析系统

点击文章中飘蓝词可直接进入官网查看 大数据日志分析系统 大数据时代,网络数据增长十分迅速。大数据日志分析系统是用来分析和审计系统及 事件日志的管理系统,能够对主机、服务器、网络设备、数据库以及各种应用服务系统等 产生的日志进行收集和细致分析,大数据日志分析系统帮助IT管理员从海量日志数据中准确查找关键有用的事件数据,准确定位网络故障并提前识别安全威胁。大数据日志分析系 统有着降低系统宕机时间、提升网络性能、保障企业网络安全的作用。 南京风城云码软件公司(简称:风城云码)南京风城云码软件技术有限公司是获得国 家工信部认定的“双软”企业,具有专业的软件开发与生产资质。多年来专业从事IT运维监控产品及大数据平台下网络安全审计产品研发。开发团队主要由留学归国软件开发人员 及管理专家领衔组成,聚集了一批软件专家、技术专家和行业专家,依托海外技术优势, 使开发的软件产品在技术创新及应用领域始终保持在领域上向前发展。 审计数据采集是整个系统的基础,为系统审计提供数据源和状态监测数据。对于用户 而言,采集日志面临的挑战就是:审计数据源分散、日志类型多样、日志量大。为此,系 统综合采用多种技术手段,充分适应用户实际网络环境的运行情况,采集用户网络中分散 在各个位置的各种厂商、各种类型的海量日志。 分析引擎对采集的原始数据按照不同的维度进行数据的分类,同时按照安全策略和行 为规则对数据进行分析。系统为用户在进行安全日志及事件的实时分析和历史分析的时候 提供了一种全新的分析体验——基于策略的安全事件分析过程。用户可以通过丰富的事件分析策略对的安全事件进行多视角、大跨度、细粒度的实时监测、统计分析、查询、调查、追溯、地图定位、可视化分析展示等。

基于关联规则的日志分析系统的设计与实现

第44卷 增刊厦门大学学报(自然科学版) Vo l.44 Sup. 2005年6月 Journal of Xiam en U niversity (Natural Science) Jun.2005 基于关联规则的日志分析系统的设计与实现 收稿日期:2005 01 21 基金项目:福建省自然基金项目(A0310008),福建省高新技术研究 开放计划重点项目(2003H 043),厦门大学中央行动计划院士基金项目(X01122)资助 作者简介:文娟(1982-),女,硕士研究生. 文 娟,薛永生,段江娇,王劲波 (厦门大学计算机科学系,福建厦门361005) 摘要:网上广告势必成为中国广告业不可取代的部分,广告人总是期望广告能获得最好的效果.为此,本文设计并实现了 一个基于关联规则数据挖掘的日志分析系统,数据挖掘引擎在实现过程中针对挖掘数据的特点对A prior i 算法进行了改进,并通过仿真数据库对挖掘结果进行了验证,日志分析系统获得的 知识 可以直接用于改善Web 的信息服务. 关键词:日志分析系统;数据挖掘;关联规则 中图分类号:T P 311 文献标识码:A 文章编号:0438 0479(2005)Sup 0258 04 数据挖掘技术在科学发现、商业应用、市场营销、金融投资等领域都有广阔的应用前景.目前,大型数据挖掘系统有Intelligent Miner,SPSS,DBM iner 等,国 内也有研究[1,2],但是,这些大型的数据挖掘系统功能布局相对不合理,并且价格昂贵,当实现某些行业的某些特定目的的数据挖掘时,没有突出的特色. 网上广告已经成为广告业中不可忽视的部分,这涉及如何从网站上丰富的数据中提取有效信息的问题.W eb 日志挖掘可以发现用户的浏览模式,用于改进Web 服务器的设计以方便用户使用和提高Web 服务器的性能,增加个性化服务和在电子商务中发现潜在的客户群等.目前用于Web 日志挖掘的关联规则算法有FP [3] ,Tv p [4] ,Apriori [5] 等.本文以邮政网络的日志分析为例,实现了基于Aprior i 算法的关联规则的分析系统,对网站日志进行挖掘分析,得到网页组相应的最大频繁项集,即商家决策者所感兴趣的 黄金网页组合 ,据此改善Web 的信息服务,有效地提高网站的效益,同时在实现过程中针对挖掘数据的特点对Apri o ri 算法做了一些改进,并通过仿真数据库对挖掘结果进行了验证. 1 日志分析系统的基本模块 本文基于关联规则的日志分析系统是专门为邮政部门优化网络系统开发的.该系统分为数据预处理,数据挖掘和知识转化3个模块.数据预处理模块将原始日志文件先导入数据库管理系统SQL Ser ver 2000 中,然后数据过滤得到用户会话文件,即数据库的表,最后生成布尔型事务数据库,事务数据存于文本文件中;数据挖掘引擎采用关联规则中的经典算法Apriori 算法实现,并针对挖掘数据的特点对Apiro ri 算法进行了改进;知识转化模块将挖掘得到最大频繁项集及相关信息转化成知识,生成强关联规则,网站设计者可根据这些强关联规则改善信息服务.整个系统的模块结构如图1所示. 图1 日志分析系统的模块结构 F ig.1 M odule structur e of W eblog analysis system 2 日志分析系统的具体实现 2.1 数据预处理 数据预处理一般根据具体源数据的数据要求进行再加工,如检查数据的完整性及数据的一致性,对丢失的数据进行填补,消除 脏 数据等.常见的预处理方法有:数据清理、数据集成、数据变换和数据归约.该系统的数据预处理不仅面临数据清理问题,还需要将数据转化成数据挖掘引擎需要的数据形式,即如何将源数据转换成事务数据库的问题,所以,预处理分为数据导入,数据清理和生成布尔型事务数据库三步来实现.2.1.1数据导入和清理 挖掘的原始日志数据如下,且保存在文本文档中.

用Kibana和logstash快速搭建实时日志查询、收集与分析系统

用Kibana和logstash快速搭建实时日志查询、收集与分析系统 Logstash是一个完全开源的工具,他可以对你的日志进行收集、分析,并将其存储供以后使用(如,搜索),您可以使用它。说到搜索,logstash带有一个web界面,搜索和展示所有日志。 kibana 也是一个开源和免费的工具,他可以帮助您汇总、分析和搜索重要数据日志并提供友好的web界面。他可以为 Logstash 和 ElasticSearch 提供的日志分析的 Web 界面 说到这里,我们看看 kibana 和 logstash到底能为我们做些什么呢?下面是kibana的界面 简单来讲他具体的工作流程就是 logstash agent 监控并过滤日志,将过滤后的日志内容发给redis(这里的redis只处理队列不做存储),logstash index将日志收集在一起交给

全文搜索服务ElasticSearch 可以用ElasticSearch进行自定义搜索通过Kibana来结合自定义搜索进行页面展示,下图是 Kibana官网上的流程图 好了让我们一步步的把这套环境搭建起来吧,先看看都需要安装什么软件包 ruby 运行Kibana 必须, rubygems 安装ruby扩展必须 bundler 功能类似于yum JDK 运行java程序必须 redis 用来处理日志队列 logstash 收集、过滤日志

ElasticSearch 全文搜索服务(logstash集成了一个) kibana 页面展示 这里有三台服务器 192.168.233.128 logstash index,ElasticSearch,kibana,JDK 192.168.233.129 logstash agent,JDK 192.168.233.130 redis 首先到 logstash index服务器上面,logstash分为 index和aget ,agent负责监控、过滤日志,index负责收集日志并将日志交给ElasticSearch 做搜索 此外 logstash 的收集方式分为 standalone 和 centralized。 standalone 是所有功能都在一个服务器上面,自发自收,centralized 就是集中收集,一台服务器接收所有shipper(个人理解就是logstash agent)的日志。 其实 logstash本身不分什么 shipper 和 collector ,只不过就是配置文件不同而已,我们这次按照集中的方式来测试 在 logstash index上安装基础的软件环境 1.[19 2.168.23 3.128 root@nodec:~] 2.# cd /soft/ 3.[192.168.233.128 root@nodec:/soft] 4.# wget https://www.360docs.net/doc/209929122.html,/distfiles/jdk-6u13-dlj-linux-i586. bin 5.从oracle下载实在是太慢了,从CU下载会快一些,如果需要最新版本请访问这里 6.https://www.360docs.net/doc/209929122.html,/technetwork/java/javase/downloads/jdk7-downloa ds-1880260.html 7.[192.168.233.128 root@nodec:/soft] 8.# sh jdk-6u13-dlj-linux-i586.bin

基于C#的服务器日志分析系统的设计与实现-毕业论文

题目:基于C#的服务器日志分析系统 的设计与实现 学院:计算机科学与工程学院专业:计算机科学与技术 班级:2013级1班 姓名:樊慧波 学号:20131303040 指导教师:祁瑞丽 2017 年 4 月27 日

毕业作品基本信息

摘要 随科技发展,越来越多的科技型企业都需要对数据中心已老化的服务器进行 更换,也就是我们所说的数据中心IDC迁移。而一众的老牌服务器厂商(HUAWEI、IBM、CISICO、DELL、HP、Lenovo、H3C等)均对此提供一定的 技术支持,为客户提供相应的技术服务方案。然而,国内大多企业数据中心往往 不会单一采用某一家公司的产品,而各大厂商单一服务成本昂贵。为解决此现状,第三方服务运维应运而生。 2016年7月始,实习于神州数码系统集成服务有限公司,该公司旗下品牌 《锐行服务》作为国内最大的第三方维护商,为众多公司服务器运维提供复杂的 技术解决方案。实习期间,在国家税务总局、中国外运长航集团的数据中心迁移 中参与完成3000余台设备迁移。 在服务器主机系统迁移中,主要由p2v、v2p两项构成。其中,必须先对服务 器信息进行调研,才能够进行迁移方案的规划。在此过程中,任何一项信息调研 出错都有可能导致迁移不成功。面对两千余台服务器,单一服务器信息调研数量 20余条的巨大工作量,我们花费了大量的时间以及人力完成此工作,而调研自动 化便成为我们工作中的迫切需求。 为提高工作效率,简化工作流程,结合所学知识,针对调研关键环节日志信 息读取设计并开发此Log日志分析系统。该系统主要采用基于面向对象的C#开发,能够对log日志进行批量读取、分析,并能按需提取有效信息进行分析、统计,并生成直观、简洁、可进行格式调整的Excel文档。 【关键词】服务器系统日志日志分析调研自动化

日志分析系统调研分析-ELK-EFK

日志分析系统调研分析-ELK-EFK

日志分析系统 目录 一. 背景介绍 (3) 二.日志系统比较 (3) 1.怎样收集系统日志并进行分析 (3) A.实时模式: (3) B.准实时模式 (3) 2.常见的开源日志系统的比较 (4) A. FaceBook的Scribe (4) B. Apache的Chukwa (4) C. LinkedIn的Kafka (5) E. 总结 (9) 三.较为成熟的日志监控分析工具 (9) 1.ELK (10) A.ELK 简介 (10) B.ELK使用场景 (11) C.ELK的优势 (12) D.ELK的缺点: (12) 2.EFK (13) 3. Logstash 于FluentD(Fluentd)对比 (13)

一. 背景介绍 许多公司的平台每天会产生大量的日志(一般为流式数据,如,搜索引擎的pv,查询等),处理这些日志需要特定的日志系统,一般而言,这些系统需要具有以下特征: (1)构建应用系统和分析系统的桥梁,并将它们之间的关联解耦; (2)支持近实时的在线分析系统和类似于Hadoop之类的离线分析系统; (3)具有高可扩展性。即:当数据量增加时,可以通过增加节点进行水平扩展。 二.日志系统比较 1.怎样收集系统日志并进行分析 A.实时模式: 1 在打印日志的服务器上部署agent 2 agent使用低耗方式将日志增量上传到计算集群 3 计算集群解析日志并计算出结果,尽量分布式、负载均衡,有必要的话(比如需要关联汇聚)则采用多层架构 4 计算结果写入最适合的存储(比如按时间周期分析的结果比较适合写入Time Series模式的存储) 5 搭建一套针对存储结构的查询系统、报表系统 补充:常用的计算技术是storm B.准实时模式 1 在打印日志的服务器上部署agent 2 agent使用低耗方式将日志增量上传到缓冲集群 3 缓冲集群将原始日志文件写入hdfs类型的存储 4 用hadoop任务驱动的解析日志和计算 5 计算结果写入hbase 6 用hadoop系列衍生的建模和查询工具来产出报表 补充:可以用hive来帮助简化

日志收集与分析系统

点击文章中飘蓝词可直接进入官网查看 日志收集与分析系统 安全日志就是计算机系统、设备、软件等在某种情况下记录的信息。日志收集与分析 是其中比较重要的环节,事前及时预警发现故障,事后提供详实的数据用于追查定位问题,下面给大家介绍一下日志收集与分析系统中关于日志审计数据收集,日志分析,审计管理 平台等相关内容。并谈一谈日志收集与分析系统哪家好? 南京风城云码软件技术有限公司是获得国家工信部认定的“双软”企业,具有专业的 软件开发与生产资质。多年来专业从事IT运维监控产品及大数据平台下网络安全审计产品研发。开发团队主要由留学归国软件开发人员及管理专家领衔组成,聚集了一批软件专家、技术专家和行业专家,依托海外技术优势,使开发的软件产品在技术创新及应用领域始终 保持在领域上向前发展。 目前公司软件研发部门绝大部分为大学本科及以上学历;团队中拥有系统架构师、软 件工程师、中级软件工程师、专业测试人员;服务项目覆盖用户需求分析、系统设计、代码开发、测试、系统实施、人员培训、运维整个信息化过程,并具有多个项目并行开发的 能力。 日志收集与分析系统通过高性能的日志收集引擎,实时自动化收集日志,解决手工处 理的低效率问题。收集到的所有日志均统一加密存储管理,可根据存储空间情况灵活扩展 存储位置。支持常见操作系统、应用系统、数据库、网络设备、安全设备等类型的日志收集,对于客户网络中特定的日志类型,支持定制扩展收集分析脚本,不再忧心类型复杂问题。可将不同系统和设备日志授权给指定人员进行管理,管理人员各司其职,负责自身所 管辖的系统或设备日志的审计管理,互不干涉、互不影响,使日志审计工作更加清晰、易 操作。 实时收集应用程序的日志信息,进行实时的统计和数据过滤。 实时显示应用程序中业务功能的动态性能视图,提供阀值报警。

日志分析系统调研分析-ELK-EFK

日志分析系统 目录

一. 背景介绍 许多公司的平台每天会产生大量的日志(一般为流式数据,如,搜索引擎的pv,查询等),处理这些日志需要特定的日志系统,一般而言,这些系统需要具有以下特征: (1)构建应用系统和分析系统的桥梁,并将它们之间的关联解耦; (2)支持近实时的在线分析系统和类似于Hadoop之类的离线分析系统; (3)具有高可扩展性。即:当数据量增加时,可以通过增加节点进行水平扩展。 二.日志系统比较 1.怎样收集系统日志并进行分析 A.实时模式: 1 在打印日志的服务器上部署agent 2 agent使用低耗方式将日志增量上传到计算集群 3 计算集群解析日志并计算出结果,尽量分布式、负载均衡,有必要的话(比如需要关联汇聚)则采用多层架构 4 计算结果写入最适合的存储(比如按时间周期分析的结果比较适合写入Time Series模式的存储) 5 搭建一套针对存储结构的查询系统、报表系统 补充:常用的计算技术是storm B.准实时模式 1 在打印日志的服务器上部署agent 2 agent使用低耗方式将日志增量上传到缓冲集群 3 缓冲集群将原始日志文件写入hdfs类型的存储 4 用hadoop任务驱动的解析日志和计算

5 计算结果写入hbase 6 用hadoop系列衍生的建模和查询工具来产出报表 补充:可以用hive来帮助简化 2.常见的开源日志系统的比较 A. FaceBook的Scribe Scribe是facebook开源的日志收集系统,在facebook内部已经得到大量的应用。它能够从各种日志源上收集日志,存储到一个中央存储系统(可以是NFS,分布式文件系统等)上,以便于进行集中统计分析处理。它为日志的“分布式收集,统一处理”提供了一个可扩展的,高容错的方案。 特点:容错性好。当后端的存储系统crash时,scribe会将数据写到本地磁盘上,当存储系统恢复正常后,scribe将日志重新加载到存储系统中。 架构: scribe的架构比较简单,主要包括三部分,分别为scribe agent, scribe和存储系统。 (1) scribe agent scribe agent实际上是一个thrift client。向scribe发送数据的唯一方法是使用thrift client, scribe内部定义了一个thrift接口,用户使用该接口将数据发送给server。 (2) scribe scribe接收到thrift client发送过来的数据,根据配置文件,将不同topic 的数据发送给不同的对象。scribe提供了各种各样的store,如 file, HDFS 等,scribe可将数据加载到这些store中。 (3) 存储系统 存储系统实际上就是scribe中的store,当前scribe支持非常多的store,包括file(文件),buffer(双层存储,一个主储存,一个副存储),network (另一个scribe服务器),bucket(包含多个 store,通过hash的将数据存到不同store中),null(忽略数据),thriftfile(写到一个Thrift TFileTransport文件中)和multi(把数据同时存放到不同store中)。

日志分析平台建设方案

日志分析平台建设方案 目录 一、现状和需求 (2) (一)现状与问题 (2) (二)需求说明与分析 (2) 二、建设目标 (2) 三、系统设计 (2) (一)技术选型 (2) (二)系统架构 (2) 1. 架构图 (3) 2. 架构分析 (3) (三)系统介绍 (3) 四、实施方案 (4) (一)系统配置 (4) 1. 软件 (4) 2. 硬件 (4) (二)系统搭建 (4)

一、现状和需求 (一)现状与问题 1. 日志文件分散在各个应用服务器,开发人员必须远程登录才能查看日志,不利于 服务器安全管控,加大生产服务器的风险; 2. 服务器上各项目日志配置很随意,文件分布杂乱,没有统一的规范和管理; 3. 日志文件占用服务器大量的硬盘空间,如不及时清理会发生硬盘占满,影响系统的正常运行; 4. 对于超过百兆的日志文件根本没法打开和关键字搜索,不利于问题的快速定位和 排查; 5. 集群和分布式的系统需要查看多个服务器的日志 6. 日志保存的时间不统一,不能长时间保存日志 (二)需求说明与分析 1. 不需要开发人员登录生产服务器就能查看日志; 2. 统一规范日志的配置和输出格式; 3. 实时的将日志文件从服务器中迁出; 4. 提供日志的检索和统计分析的平台; 二、建设目标 搭建支持高并发高可靠的日志分析平台,方便开发人员快速的检索日志,排查问题,同时提供友好的分析和统计的界面。 三、系统设计 (一)技术选型 针对这些问题,为了提供分布式的实时日志搜集和分析的监控系统,我们采用了业界通用的日志数据管理解决方案-它主要包括 Elasticsearch、 Logstash和Kibana 三个系统。通常,业界把这套方案简称为ELK,取三个系统的首字母。调研了ELK技术 栈,发现新一代的 logstash-forward 即 Filebeat,使用了 golang,性能超 logstash,部署简单,占用资源少,可以很方便的和logstash和ES对接,作为日志文件采集组件。 所以决定使用ELK+Filebeat的架构进行平台搭建。 为了支持日志的高并发和高可靠需要进了消息队列(MQ),这里选择了 kafka,相对其他消息中间件,kafka有支持大并发,快速持久化等优点,而且ELK+Filebeat对kafka 的兼容性也很好。 最终,我们采用 Elasticsearch+ Logstash+ Kiba na+ Filebeat+ Kafka+ Zookeeper 的架 构搭建日志分析平台。