20100428第三章 并行计算模型和任务分解策略

第三章并行计算模型和任务分解策略

首先,我们将研究不同类型的并行计算机,为了不严格限定于某个指定机型,我们通过模型把并行计算机抽象为几个特定属性。为了说明并行程序中处理器之间的通信概念模型我们讨论了不同的程序模型,另外为了分析和评估我们算法的性能,我们讨论了多计算机架构下评估并行算法复杂度的代价模型。在介绍并分析的各种代价模型的基础上给出了改进型的代价模型。

其次我们定义这样几个指标如负载均衡和网络半径等用来研究图分解问题的主要特性。并把图分解问题归纳为一般类型和空间映射图类型。我们重点研究的是后者,因为多尺度配置真实感光照渲染算法可以很方便的描述成空间映射图形式。

3.1 并行计算机模型

以下给出并行计算机的模型的概述,根据其结构并行计算机大致可分为以下几类。

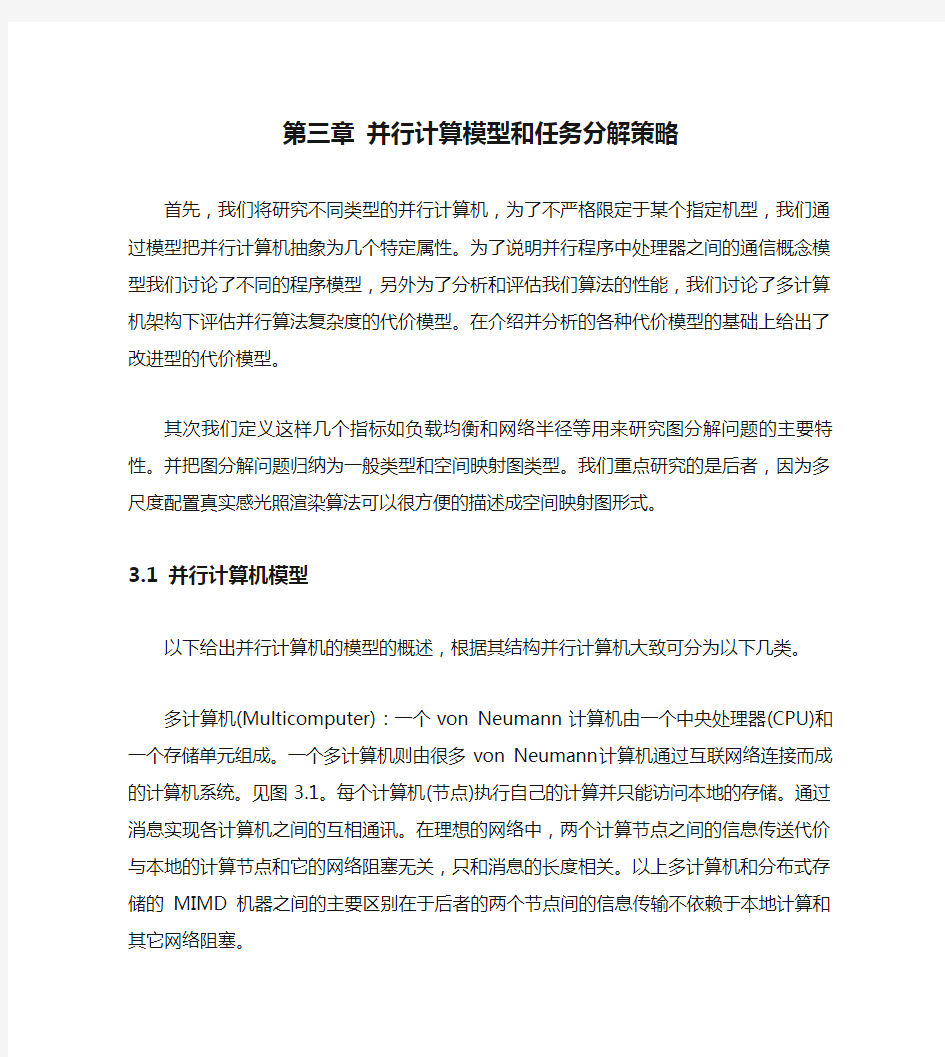

多计算机(Multicomputer):一个von Neumann计算机由一个中央处理器(CPU)和一个存储单元组成。一个多计算机则由很多von Neumann计算机通过互联网络连接而成的计算机系统。见图3.1。每个计算机(节点)执行自己的计算并只能访问本地的存储。通过消息实现各计算机之间的互相通讯。在理想的网络中,两个计算节点之间的信息传送代价与本地的计算节点和它的网络阻塞无关,只和消息的长度相关。以上多计算机和分布式存储的MIMD机器之间的主要区别在于后者的两个节点间的信息传输不依赖于本地计算和其它网络阻塞。

分布式存储的MIMD类型的机器主要有IBM的SP, Intel的Paragon, 曙光4000系列, Cray 的T3E, Meiko的CS-2, NEC的Cenju 3, 和nCUBE等。通过本地网络的连接的集群系统可以认为是分布式存储的MIMD型计算机。

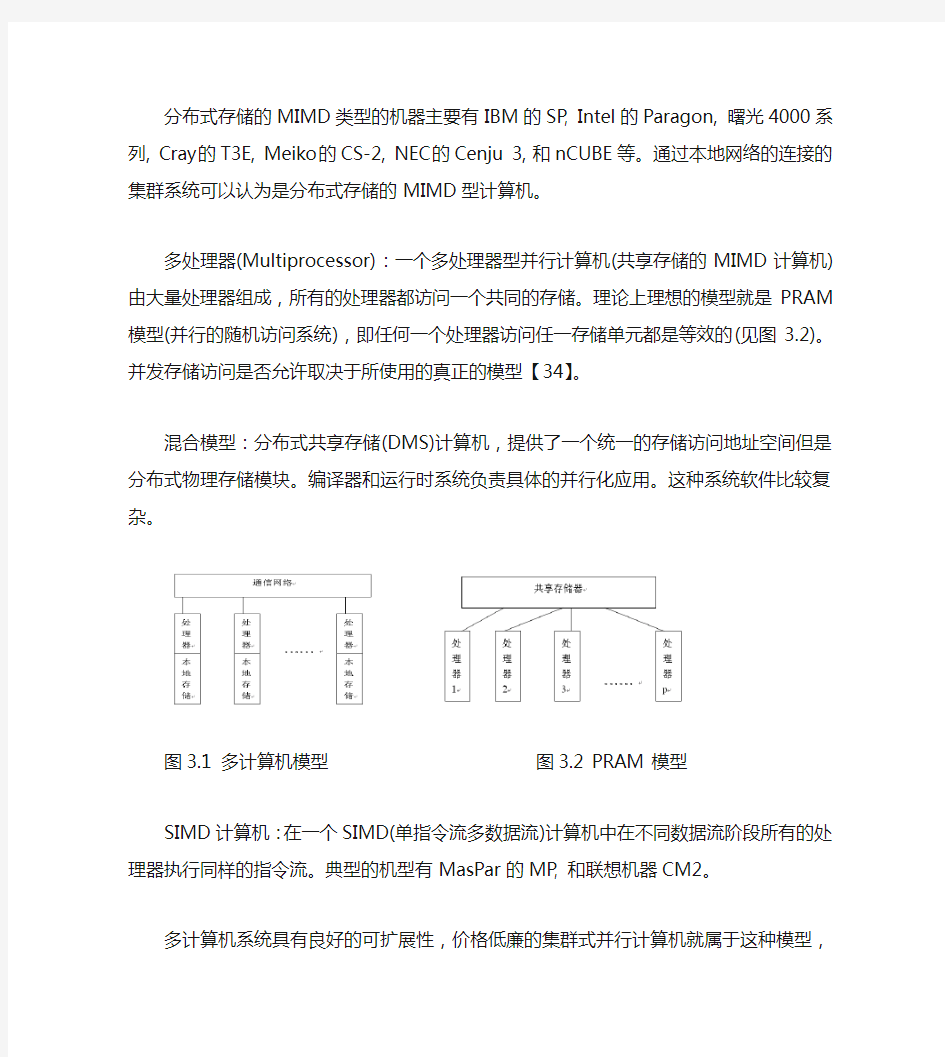

多处理器(Multiprocessor):一个多处理器型并行计算机(共享存储的MIMD计算机)由大量处理器组成,所有的处理器都访问一个共同的存储。理论上理想的模型就是PRAM模型(并行的随机访问系统),即任何一个处理器访问任一存储单元都是等效的(见图3.2)。并发存储访问是否允许取决于所使用的真正的模型【34】。

混合模型:分布式共享存储(DMS)计算机,提供了一个统一的存储访问地址空间但是分布式物理存储模块。编译器和运行时系统负责具体的并行化应用。这种系统软件比较复杂。

图3.1 多计算机模型图3.2 PRAM 模型

SIMD计算机:在一个SIMD(单指令流多数据流)计算机中在不同数据流阶段所有的处理器执行同样的指令流。典型的机型有MasPar的MP, 和联想机器CM2。

多计算机系统具有良好的可扩展性,价格低廉的集群式并行计算机就属于这种模型,本文中的算法主要基于多计算机体系结构。

3.2 程序模型

并行程序的编程语言如C或Fortan。并行结构以某种类库的形式直接整合进这些编程语言中。编程模型确定了并行程序的风格。一般可分为数据并行、共享存储和消息传递等模型[35]。

数据并行编程:数据并行模型开始于编写同步SIMD并行计算机程序。程序员需要在每个处理器上独立执行一个程序,每个处理器均有其自己的存储器。程序员需要定义数据如何分配到每个局部存储中。实际应用中大量的条件分支的需要使得其很难高效的运行在SIMD型的机器上。

共享存储编程:共享存储模型是一个简单的模型,因为程序员写并行程序就像写串行程序一样。一个程序的执行与几个处理器独立,也不需要同步。一个处理器的执行状态独立于其它处理器的运

行状态。由于所有运行程序均访问统一的全局存储器,这就需要小心处理任何一个处理器需要访问的数据都必须和其它处理器的访问之间没有任何冲突。

消息传递模型:我们把消息传递模型和SPMD(单一程序多数据)应用技术结合使用。每个程序独立在几个处理器上执行,不需要同步(MIMD系统)。每个程序均立即访问本地存储,通过消息传递实现远程的存储访问。通信方式主要有一下几个不同类型:

点对点通信(point-to-point communication):一个处理器发送一个数据包到另一个处理器,使用发送操作,目标处理器必须调用一个接受操作获得这些数据。我们假定一个处理器可以同时和其它处理器通信,我们还假定一个处理器在同一时间只能和一个处理器通信。且通信为异步,也就是说接收处理器可以在发送操作完成后的任意时间调用接收命令。

集合通信(collective communication):集合通信涉及到多处理器之间的通信。

投射(cast):一个处理器同时拷贝同样的信息到其它多个处理器的过程。

聚合(combine):组内每个处理器只负责发送整个数据段的一部分,由一个主处理器接受所有结果,这个过程需要一个额外的数据统计数据项的个数。

M个处理器之间的集合通信可以通过大量的点对点通信以树形方式在时间内完成,这里假定每个处理器之间的通信物理链路均是独立的。

对于并行语言的实现方面,很多的研究工作在对现有的串行程序语言的基础上进行扩展以实现并行化计算方面作出了大量有益的尝试,如H PC++[36]或HPF [37]等试图在C++或Fortran语言中应用不同的程序模型。现在把并行性能整合到现有的编成语言中的一个可行方案就是给对语言提供能实现并行处理和通信的运行库。这其中关键的挑战在于扩展已有语言中新的语言元素和关键字。

目前对现有语言进行并行化扩展的工作还处于比较初级的阶段。建立一个标准去规范这方面的应用是必要的,基于这样标准可以整合大量不同的计算模型,因此,使用消息传递作为编程模型可以使得程序保持一定的灵活性,随着将来并行语言的不断扩充和发展而已有的并行应用方案在不需要修改。

本文采用的编程模型是消息传递模型。这在过去的若干年里业界已形成了消息传递模型的一个标准—MP I【38,39】。当前很多超级计算机实现了大量高效的MPI应用。采用免费、高效、可移植性好的称之为MPICH的并行编程语言构建适用于集群系统的并行计算的应用,可以使得我们基于MPI的应用可以很容易的移植到其它很多并行计算环境中。

3.3 代价模型

确定了基于消息传递模型进行并行算法的设计,接着就需要分析该算法的算法复杂度。对于算法复杂度问题,由于大量不同类型的超级计算机的存在使得统一且能准确预测一个算法的特性几乎不可能。因此我们必须指定一个代价模型作为我们的分析依据。显然这个模型应该尽可能模拟当前的超级计算机的性能结构。前人已在该领域做了大量的工作来定义一般的代价模型,使得我们可以通过该模型准确预测并行算法的复杂性,而不用考虑编程模型或使用哪种硬件。首先介绍目前比较常见的几种并行计算代价模型,接着在同步性、通信方式和参数等3个方面对它们作一简单分析比较。详细的概述文章见【40】。

本文采用的机器模型是多计算机,该模型包括了p个独立的处理器,每个只能访问其本地的存储。处理器间异步工作且通过一个由处理器对之间的双向通信链路连接而成的网络进行通信。以点对点方式通信,例如,一个处理器发送数据包到另一个处理器,就是用send操作。目标处理器调用receive 操作接收数据。衡量点对点通信的代价的方法很多,下面介绍一些主要方法。

真正具有大规模处理器的超级计算机不会给每对处理器之间提供独立的物理的通信链路。而是采用处理器之间的通道共享方式。如果两处理器对之间需要同时占用该通道进行通信时就会发生消息阻塞。由于这种阻塞和特定的网络拓扑结构有关,所以以下一般代价模型没有考虑这些问题。但我们将在第3.4.3中讨论如何避免或减少阻塞的一般方法。这还考虑了在分布式存储模型上整合其它的作为原子操作的通信类如涉及到群组处理器之间的集合通信。显然这些通信可以通过大量的点对点通信方式得到。我们只使用点对点的通信模式,使得我们的算法不需要依赖那些需要更高效的专门的硬件支持集合通信。

3.3.1 Postal模型

Postal【67】模型主要用来描述具有下面3个方面特点的消息传递的通信系统:完全连通、同时I/O和通信延迟。一个带有n个处理机和通信延迟的消息传递系统有下面3个属性:

(1)完全的连通性。系统中的每一个处理机能够向系统中的任何其他处理机发送点对点消息;

(2)同时的I/O。一个处理机p可以在给处理机q发送消息的同时接收处理机r发送来的消息;

(3)通信延迟。如果在t时刻处理机P向处理机q发送我消息M.则P在时间间隔内忙

于发送消息M,而且q在时间间隔内忙于接收消息M。

上面是从处理机的观点来分析一个消息传递系统。在这样的一个系统中,处理机之间靠通过一个通信网络互相发送和接收消息来通信,这样就产生了一个抽象的全连通的系统。而在很多系统中,通过不同的输人输出端口,处理机确实可以同时发送和接收消息。

在Postal模型中,message被用来表示一个在处理机之间进行通信的不可分割的数据单元,一个message在发送的时候、传输的时候和接收的时候都不能被分成更小的快。一个原子message 被定义为一个数据大小的单元,而发送或者接收一个message的时间被定义为一个时间单元。发送大块数据的时候,这些数据会首先被分成多个message,每个message都被单独地发送和接收,这在许多报文交换系统(packet switching)中都是一种标准的实现。

上面所说的通信延迟中包括各方面的系统开销,具体来说包括消息准备时间、输出缓冲拷贝时间、输出端口提交延迟、网络传输延迟、输人端口延迟、输人缓冲拷贝时间和消息中断时间。这里的通信延迟还包括所有的软件开销和硬件开销。从形式上来说,的值为消息M的发送方开始发送消息到接收方完全接收完消息所用的时间。尽管从形式上来说是这样,可实际^

的精确值可能取决于实际的发送接收组和宴际通信网络的负载;通常,的值应该是相对固定不变的,不同的处理机之间不能有很大的浮动。

3.3.2 BSP 模型

根据BSP (bulk synchronous parallel)[66]模型,一个并行计算机由下面3部分组成:第一,若干个存储器或者处理机组件;第二,这些组件之间的点对点通信;第三,这些组件之间的同步机制。为简单起见,可以认为每个组件中包含一个处理机和本地存储器;在模型中,不要求关于通信系统、互连网络和同步系统的额外信息。

在BSP模型中,一个并行系统由下面3个参数来表示:

(1)P,系统中处理机的数目;

(2)g,把通信开销转换为计算开销的因子;

(3)L,两个同步之间的最短时间。

连续的两个同步之间的周期被定义为超步(superstep)。在一个超步中一个处理机可以进行3个操作:首先各处理机处理本地存储器中的数据,可以是本地计算;然后各处理机向别的处理机提出远程内存读写请求,而通信实际发生在超步中的时间是不可预知的;最后,所有处理机进行障栅同步,本次超步的数据通信仅当同步以后有效。

在BSP模型中,计算操作的总量用处理机在计算过程中所做的基本操作的数目来表示,通信量则用字数来表示。假设在同一次计算和通信中数据项的大小是一样的,而且假设在一个超步中的通信总量是被发送或者接受的最大字数。通过因子g,通信开销被转换成计算开销,其中g 是系统中计算带宽与通信带宽的比值。具体地说,就是每个处理机发送或者接收至多h个字的开销与在相同的时间内进行加次计算操作。L表示连续的两次同步之间所能执行的操作的次数,它的具体值由同步操作的实现和上层算法来决定。

同步操作使得超步之间相互无关,根据BSP模型实现的算法的总开销就是所有超步开销的总和,而每一个超步的开销由该超步中计算开销和通信开销所决定。

BSP模型的一个不足之处在于处理器的同步只在superstep之间。一个消息在一个superstep开始时发送只能被用于下一个superstep,即使superstep的长度比网络延时还要长;另一个缺点就是这个模型不能统计消息注入网络的时间。这些不足可由以下模型弥补。

3.3.3 LogP 模型

LogP【68】是一个能很好地符合并行计算机系统中这种分布式存储、多处理器网络通信机制的计算模型。利用LogP模型,通过4个重要参数就可以设计良好的适应不同处理器的算法。这4个参数及含义如下:

(1)P(处理器/存储模块的个数)设处理器进行本地操作的单位时间为一个周期;

(2)L(最大通信延迟) 即从源模块到目的模块传输包含一个字或几个字的信息所用的时间;

(3)o(通信开销)即一个处理器发送一个信息所用的时间长度,在此时间段中处理器不能执行其它操作;

(4)g(通信间距) 即一个处理器连续进行信息收发的最小时间间隔,g的倒数对应于通信带宽。

在LogP模型中,通信网络被认为有有限的能力,因此在某一个时刻至多只有[L/g]消息从任何处理机到任何别的处理机。如果某个处理机尝试传输消息时超过这个限制,这个超出的消息将被延迟,直到网络中别的消息已经传送完毕后再传输。

性能参数L、o和g都用处理机操作的周期数来表示。LogP模型是异步的,延迟也只有一个上限,按一定的顺序发出的消息到达时的顺序可能不一致。并且假设所有的消息都是短消息。这些参数的选择是在忠实地获得实际机器的执行特点、提供一个有效的算法设计和分析的框架之问取一个折衷。

参数取得太少,不能很好地描述系统的特点;但参数取得太多,又会使算法的设计变得异常困难。在不同的情况下,LogP模型中的各个参数也可以适当地化简来降低系统的复杂性。这是因为在不同的情况下,各个参数的重要性也是不一样的,在某些情况下可以忽略一个或者更多参数,使模型变得更简单。比如说,在不常进行通信的算法中,可以忽略带宽和网络能力有限带来的影响;在某些算法中,消息是由长的数据流以流水线的方式通过网络,这可以认为消息的传输时间主要受g的限制,而不用考虑通信延迟L;而在某些机器中,系统的瓶颈是o,则可以认为g=o,这样就可以不考虑g对算法的影响。

LogP模型通过抽象出来的4个参数来评价一个互连通信网络的性能,使得算法设计者不需要关心具体的网络信息,可以更容易地设计符合这种模型的算法。

3.3.4 LogGP[69]模型

LogGP模型是LogP模型的扩展,它发送长消息的理想模型[65]。长消息由一个新参数gap表示:G:对于长消息每个字的间隔,对于长消息来说定义为每个字所需要的时间。对于长消息来说G标识每个处理器的有效通信带宽。

g:消息的间隔,定义为在一个处理器消息的连续发送或接收之间的最小时间间隔,g表示每个处理器处理短消息的有效通信带宽。

在LogP模型中,并不对长消息做特别的处理,但是现在许多并行计算机对长消息都提供了特别的支持,比如IBM的SP2等。与发送短消息相比,许多并行机采用处理长消息的方法来达到更高的带宽。因此,在LogGP模型中引入了对长消息的支持,它比LogP多一个参数G,代表长消息每字节间距,即发送长消息每字节所需要的时间,它的倒数对应于处理机发送长消息时的带宽。

在新的LogGP模型中发送一具有k个字的消息需要花费周期。发送和接收的处理器仅在第o个周期比较忙,其它时间周期它们都能把通信和计算重叠进行。如果一个处理器需要在一行中发送两个长消息,那么在第一个消息发出之后和在第二个消息的首个字节传送到网络之前它必须等待g周期。

3.3.5 改进的模型

LogP模型是一个应用广泛的模型,但不太适合发送长消息。LogGP模型又比较复杂,因为它引入两个通信间距参数。我们的目标在于定性而不是定量的估计动态负载平衡算法的开销。例如我们将部分使用O标记说明结果负载,对于这个结果如果只关注短消息和长消息之间的差别就太学究味

了。为了简化计算我们假定长消息和短消息之间的间隔相等,即有g=G。这时发送具有k个字的消息的花费为。

和LogGP模型相比我们假定发送和接收处理器在周期都很忙。这是合理的,因为设置一个长消息的花费要比短消息长。LogGP模型不包括发送消息的开始时间,因为它的目的仅测量通信开销,后续部分我们将以此分析一个并行算法的整个开销,当采用长消息通信时整个开销的确很大。

本文中的计算程序均设计为异步通信SPMD风格的程序。仅有少量的全局通信的同步点,在这些点之间所有处理器都处于动态平衡负载的处理状态。该程序的延迟几乎被计算过程重叠或略掉。这

样我们将忽略这个延迟,这样我们的理论的开销为:

3.4 任务分解策略

我们定义一些指标如负载均衡和网络半径等以此来研究图分解问题的主要特性。首先概述文献中对解决图分解问题所提到的策略,并将之归纳为一般类型和空间映射图类型。本文主要侧重于后者,因为真实感光照渲染算法可以很方便的描述成空间映射图形式。

3.4.1图嵌入问题

在并行处理器上部署一个并行算法,首先要解决图嵌入问题[42]。假定H代表计算节点间通信网络拓扑图,以此描述处理器的节点和通信链路。一个任务图G表示应用的各子进程之间的通信需求。把图G嵌入到并行体系结构H中就产生一个并行算法,使得应用的各子进程能较均匀的分配到每个处理节点上。衡量把G嵌入到H中后等到的并行算法的性能主要有负载均衡性,可扩展性和阻塞等。下面介绍几个关键概念:

负载(load):每个处理器具有相同的负载是图嵌入问题的最重要的目标,一个应用的总的运行时间取决于具有最大负载的处理器的运行时间。

膨胀(dilation):描述了一个时间周期(或称之为路径长度)即G中两个直连节点之间的通信消息在H中遍历所需要的时间。

阻塞(congestion): 测量路由通过H中任一条链路的G中边的最大数量。阻塞从实践的观点看很重要,目前的映射技术的研究工作很少考虑到阻塞这个因素。

3.4.2 图分解问题

图分解法是图嵌入问题的一个可能的近似解决方案,分解就是把计算任务均衡的分配到各子进程中,并得到最小网络半径的过程。这里没有考虑任务簇映射到处理器的过程,扩展的开销比较小,完全或略阻塞的影响。

Bokhari曾把图分解问题(他称之为映射问题[43])简化为图的同构问题,他定义的G的进程数量小于H的节点数量,尽管很多研究人员都研究过这个问题,但其多项式时间还是未知的。实践中经常使用启发式方法计算一个网络半径尽可能低的已经非常平衡的任务分解问题。

如果G是动态变化的则问题变得较复杂,这样我们必须动态产生一个初始的分解方法。图

分解问题的一个完整定义如下。设G=(V,E),它代表一个由顶点V= 和间接边

组成的图。每个顶点v的顶点权重为。每个边

有一个独一无二的边权重,顶点/边的M的权重定义为所包含的边/顶点的权重之和。

图G被分解为p个部分,定义为:

。

衡量分解算法的主要性能指标即该图的平衡性和网络半径。分解的负载均衡性是一个关于h的元组:

如果则这个分解结果称之为负载均衡。分解的网络半径即横截面所包括的所有边的权重,例如:

任务分解的过程就是找到一个具有最小网络半径且负载均衡的分解方法。一般情况下一个完美的任务分解是不会存在的,我们要做的就是寻找一个尽可能平衡的分解方案。

3.4.3 通信和阻塞

一旦一个应用被分解,根据 3.3部分的代价模型可以找到两个处理器之间的高效的通信方法,主要遵循以下几个原则:

(a)尽可能的使用本地存储

(b)尽可能使得计算和通信重叠(延迟隐藏)

(c)尽量使用长消息而避免使用较多的短消息。

网络带宽参数对于一个处理器由于本地带宽有限而很少发消息的情况下影响很有限。如果一个处理器能了解整个网络情况那么在全局网络阻塞严重的情况下就可以决定不发送消息,既然处理器不了解全局的通信情况,可以执行这样一个策略即消息被异步且独立发送的地方发生消息阻塞的概率比较低。然而,一个同步通信策略在不同阶段可以使用高效的集合通信方法如

如果通信量需求比较大时即使使用异步消息传递也会发生阻塞。显然,在一个每对处理器

间直接相连的通信网络中,任何两个消息和可以相互独立发送且没有相互干扰。然而,在一个稀疏网络中也存在真实的相互干扰可能。由于我们关注与可移植性算法,所以并不打算专注于特定的网络拓扑。而且我们希望这个算法在整个网络上同时只有很小一部分的链接。为此,我们还要增加一个原则:

(d)在同一时刻仅使用少量的网络连接

对于一般的应用很难满足这个要求,幸运的是很多应用并不是总体上都是非规则通信要求。例如,区域分解计算如计算流体动力学或有限元定义位于空间的各任务间的局部依赖。多尺度配置真实感光照渲染算法可以被定义成只需要局部通信的并行计算(参考4.3)。

3.5 一般解决方案

首先介绍一些图分解问题的一半解决方案。

3.5.1 易并行

最简单的类型即易并行计算应用,在子问题之间很少或几乎没有相互的依赖[45,46,44]。这种情况下过载处理器的任务就被随机发送到其它未过载的处理器。目标处理器的选择不会影响任何子任务间的独立关系。但基于物理的真实感渲染显然不是易并行计算应用,各子问题之间存在大量的依存关系。

3.5.2 多用途的图分解

已有很多的文献在阐述图分解问题的研究成果,这些涵盖了从基础性的理论工作[53,54]到包括

快速多层方法的软件包[47,48,52,50,49,51]。但这些方法大多只适合静态的负载均衡问题,由于负载是静态的,因此任务只需要在计算前作一次分解。如果负载情况经常随着时间变化而波动,经过初始的分解后随着个节点间任务的平衡性改变后还需要重新平衡各节点间的计算任务[55,56,57]。

过去,研究人员采用一般图分解方法去解决真实感光照渲染算法[58,59,60]。结果却并不理想,一个可能的原因就是图分解策略没有考虑阻塞造成的额外计算和通信开销。而空间簇方法则可以有效减少这种阻塞的可能。

3.5.3 空间映射图

很多科学应用所定义的应用图,图的顶点可以自然映射到多维空间中。如果只有所有对象的一小部分子集时应用就调用局部通信,而只需要通过对象簇的边缘对象和其它簇进行通信。这种情况下,构建空间簇是个很好的策略(图3.3)。

Figure 3.4:二维的局部任务通信

为了最小化通信量使用能最大限度地减少了表面体积比的簇的形状。理想的形状就是一个超球体,但是,它不可能通过非重叠的超球体覆盖整个空间的表面。

如果应用需要执行较长距离的远程数据访问,那么一个的目录列表就可以告诉需要那个处理器那个任务,该列表可以被复制到每个处理器的局部存储器中。远程数据访问和应用的局部通信不相互冲突。例如一个把任务映射到2D空间的应用和每个任务和其它共享顶点坐标的任务(图3.4上半部分)就是局部通信,因为任何任务只取决于所有任务中的某个簇的子任务。图3.4的下面显示规则的任务分解,每个处理器索引都保存着能被简单计算的特定任务。在一个不规则的分解中,一个目录列表非常有用,它可以说明每个给定任务的处理器索引。不幸的是,一般情况下我们只能通过不规则的分解获取良好的负载平衡性能。

膨胀方法[61,62]在相邻处理器上保持任务的连接时重新映射任务。相邻处理器根据本地负载的不同而交换负载。

正交递归二分法[12,17]有一个紧凑的树形表达方法。重新平衡操作可以异步且独立的在子树中执行[70]。为了最小化表面对体积的比率,一个多维二分策略要比一维簇要好,这因为一维簇可能产生细长条。

矩形网格簇如图3.4 (底部/左面)所示经常被用于矩阵和矢量的乘法[63]。无法通过简单的移动超平面而得到一个精确的负载均衡性能。而且任务必须被随机置换为了得到具有高概率的平衡性能[64]。

[34] J. Jaja. An Introduction to Parallel Algorithms. Addison Wesley, 1992.

[35]I. Foster. Designing and Building Parallel Programs. Addison Wesley, 1995.

[36]HPC++ Consortium. HPC++-homepage. https://www.360docs.net/doc/7d5002189.html,/hpc++/.

[37] HPF-Forum. HPF-homepage. https://www.360docs.net/doc/7d5002189.html,/HPFF/.

[38]Message-Passing-Interface-Forum. https://www.360docs.net/doc/7d5002189.html,.

[39]Message-Passing-Interface Forum. MPI: A message-passing interface standard. International Journal of Supercomputing Applications, 1994.

[40] B. M. Maggs, L. R. Matheson, and R. E. Tarjan. Models of parallel computation: A survey and synthesis. In Proc. 28th Hawaii Int. Conf. on System Sciences (HICSS-28), volume 2, pages 61–70, 1995. [41]A. Barnoy and S. Kipnis. Designing algorithms in the postal model for message passing systems. In Proc. of the 4th Annual ACM Symposium on Parallel Algorithms and Architectures, pages 13–22, 1992.

[42]B. Monien, R. Diekmann, R. Feldmann, R. Klasing, R. L¨ uling, K. Menzel, T. R¨ omke, and U.-P. Schroeder. Efficient use of parallel & distributed systems: From theory to practice. In J. van Leeuwen, editor, Trends in Computer Science, Lecture Notes in Computer Science. Springer, Berlin, 1995.

[43]S. H. Bokhari. On the mapping problem. IEEE Transactions on computers, C-30(3), 1981.

[44]M. Adler, S. Chakrabarti, M. Mitzenbacher, and L. Ras mussen. Parallel randomized load balancing. In ACM-SIGACT Symposium on the Theory of Computing (STOC), pages 238–247, 1995.

[45]W. A iello, B. Awerbuch, B. Maggs, and S. Rao. Approximate load balancing on dynamic and asynchronous networks. In Proceedings of the 25th Annual ACM Symposium on Theory of Computing (STOC), pages 632–641, May 1993.

[46]R. L¨ uling and B. Monien. A dynamic distributed load balancing algorithm with provable good performance. In Proc. of the 5th ACM Symposium on Parallel Algorithms and Architectures (SPAA ’93), pages 164–173, 1993.

[47]B. Hendrickson and R. Leland. Chaco. https://www.360docs.net/doc/7d5002189.html,/CRF/chac.html. [48]B. Hendrickson and R. Leland. The Chaco User’s Guide Version 2.0. Technical Report SAND95-2344, Sandia National Laboratories, Albuquerque, NM 87185-1110, July 1995.

[49]G. Karypis and V. Kumar. Metis – multilevel partitioning. https://www.360docs.net/doc/7d5002189.html,/?

karypis/metis.

[50]G. Karypis and V. Kumar. METIS: Unstructured graph partitioning and sparse matrix ordering system, version 2.0. Technical report, University of Minnesota, Dept. of CS, Minneapolis, MN 55455, August 1995.

[51] R. Preis and R. Diekmann. Party partitioning library. http://www.uni-paderborn.

de/cs/robsy/party.html.

[52]C. Walshaw. Jostle – mesh partitioning software. https://www.360docs.net/doc/7d5002189.html,/jo

[53]B. W. Kernighan and S. Lin. An efficient heuristic procedure for partitioning graphs. The Bell System Technical Journal, 49:291–307, February 1970.

[54]C. M. Fiduccia and R. M. Mattheyses. A linear-time heuristic for improving network partitions. In 19th IEEE Design Automation Conference, pages 175–181, 1982.

[55]R. Williams. Performance of dynamic load balancing algorithms for unstructured mesh calculations. Con-currency, 3:457–481, 1991.

[56]R. van Driessche and D. Roose. An improved spectral bisection algorithm and its application t o dynamic load balancing. Parallel Computing, 21:29–48, 1995.

[57]P. Diniz, S. Plimpton, B. Hendrickson, and R. Leland. Parallel algorithms for dynamically partitioning unstructured grids. In Proc. 7th SIAM Conf. Parallel Proc. Sci. Comput., February 1995.

[58]R. Garmann. Paralleles Hierarchisches Radiosity auf der CM-5. Diplomarbeit, Fachbereich Informatik, Universit¨ at Dortmund, Germany, D-44221 Dortmund, November 1994.

[59]R. Garmann, C.-A. Bohn, and H. M¨ uller. Parallel Hierarchical Radiosity on the CM-5. Technical Report 557, Fachbereich Informatik, Universit¨ at Dortmund, Germany, D-44221 Dortmund, December 1994.

[60]C.-A. Bohn and R. Garmann. A Parallel Approach to Hierarchical Radiosity. In V. Skala, editor, Proceedings of the Winter School of Comp uter Graphics and CAD Systems ’95, pages 26–35, Plzen, Czech Republic, February 1995. University of West Bohemia.

[61]A. Heirich and S. Taylor. A parabolic load balancing method. In Proc. 24th Int. Conf. Par. Proc., volume III, pages 192–202, New York, 1995. CRC Press.

[62]C.-Z. Xu and F. C. M. Lau. The generalized dimension exchange method for load balancing in k-ary

n-cubes and variants. J. Par. Distr. Comp., 24(1):72–85, January 1995.

[63]B. Hendrickson, R. Leland, and S. Plimpton. An efficient parallel algorithm for matrix-vector multiplication. Intl. J. High Speed Comput., 7(1):73–88, 1995.

[64]A. T. Ogielski and W. Aiello. Sparse matrix computations on parallel processor arrays. SIAM J. Sci. Comput., 14(3):519–530, May 1993.

[65] A. Alexandrov, M. F. Ionescu, K. E. Schauser, and C. Scheiman. LogGP: Incorporating long messages into the LogP model — one step closer towards a realistic model for parallel computation. Technical Report TRCS95-09, Computer Science Department, University of California, Santa Barbara, April 1995.【66】Krizanc R,Saarirrmki. A Bulk Synchronous Parallel: Practical Experience with a Model for Parallel Computing, Parallel Architectures and Compilation Techniques. In Proc. of the 1996 Conf., 1996.208-217. 【67】 Bar-Noy A,Kipnis S. Designing Broadcasting Algorithms in the Postal Model for

Message.Passing Systems.In:Proc. of the fourthannual ACM symposium on Parallel algorithms and architectures.1992,13~22

【68】Culler D E,Karp R M,Patterson D,et al. LogP:Towards a Realistic Model of Parallel Computation. Communications of the ACM, 1996,39(11):78-85 .

[69]Alexandrov A,Ionescu M,Schauser K E,et a1.LogGP:Incorporating Long Messages into the LogP Model-One Step Closer Towards a Realistic Model of Parallel Computation.In:Proc.Seventh Ann ACM Symp Parallel Algorithms and Arehiteetures,1995.95~105

并行计算综述

并行计算综述 姓名:尹航学号:S131020012 专业:计算机科学与技术摘要:本文对并行计算的基本概念和基本理论进行了分析和研究。主要内容有:并行计算提出的背景,目前国内外的研究现状,并行计算概念和并行计算机类型,并行计算的性能评价,并行计算模型,并行编程环境与并行编程语言。 关键词:并行计算;性能评价;并行计算模型;并行编程 1. 前言 网络并行计算是近几年国际上并行计算新出现的一个重要研究方向,也是热门课题。网络并行计算就是利用互联网上的计算机资源实现其它问题的计算,这种并行计算环境的显著优点是投资少、见效快、灵活性强等。由于科学计算的要求,越来越多的用户希望能具有并行计算的环境,但除了少数计算机大户(石油、天气预报等)外,很多用户由于工业资金的不足而不能使用并行计算机。一旦实现并行计算,就可以通过网络实现超级计算。这样,就不必要购买昂贵的并行计算机。 目前,国内一般的应用单位都具有局域网或广域网的结点,基本上具备网络计算的硬件环境。其次,网络并行计算的系统软件PVM是当前国际上公认的一种消息传递标准软件系统。有了该软件系统,可以在不具备并行机的情况下进行并行计算。该软件是美国国家基金资助的开放软件,没有版权问题。可以从国际互联网上获得其源代码及其相应的辅助工具程序。这无疑给人们对计算大问题带来了良好的机遇。这种计算环境特别适合我国国情。 近几年国内一些高校和科研院所投入了一些力量来进行并行计算软件的应用理论和方法的研究,并取得了可喜的成绩。到目前为止,网络并行计算已经在勘探地球物理、机械制造、计算数学、石油资源、数字模拟等许多应用领域开展研究。这将在计算机的应用的各应用领域科学开创一个崭新的环境。 2. 并行计算简介[1] 2.1并行计算与科学计算 并行计算(Parallel Computing),简单地讲,就是在并行计算机上所作的计算,它和常说的高性能计算(High Performance Computing)、超级计算(Super Computing)是同义词,因为任何高性能计算和超级计算都离不开并行技术。

销售团队目标制定与分解

一:销售团队的目标制定: 一个企业的发展要有战略,一个营销团队也是如此,没有目标的团队没有凝聚力, 1:对个人而言,目标的威力就是: 给人的行为设定明确的方向,使人充分了解自己每一个工作的目的; 使自己知道什么是最重要的事情,有助于合理安排时间; 迫使自己未雨绸缪,把握今天; 使人能清晰地评估每一个工作的进展,正面检讨每一个工作的效率; 使人在没有得到结果之前,就能“看”到结果,从而产生持续的信心、热情与动力;: 2:对企业而言: 目标管理能促进“公司战略计划的达成”; 目标管理能带来“提升斗志、把握重点、集中精力”的效果; 目标管理使“解决问题”成为可能; 目标管理能培养能干的人; 3:我们营销团队制定目标应该考虑的因素: 行业大环境的影响: 任何一个行业都会受到国家政策和市场环境的影响,有些行业是在下滑,有些行业是在告诉增长,我们在制定营销团队的目标时,一定要结合当下的经济形势,恰当的调整营销目标战略。 竞争对手的分析: 在营销领域,我一直坚信,当竞争对手疲软的时候,就是我们进攻的最好机会,同时大家也要记住,没有淡季的市场,只有淡季的思想,所谓的淡季我们塑造品牌,培训团队,历练内功,而不是在家里休息,当旺季到来的时候,我们拼命的做利润,占领市场,因此我们要结合竞争对手的竞争策略,来制定我们的营销目标;如果我们的目标没有竞争对手的增长率快,我们在未来的竞争中,有可能处于被动地位。 自己营销团队的现状:

自己的营销团队的作战能力,和优势以及劣势,要做好深度分析,如果自己的目标制定好了,营销团队的营销能力跟不上,人员不稳定,目标只能变成纸上谈兵;营销目标的达成一定是建立在目前营销团队的营销能力之上的,人员是否稳定,是否有足够的营销能力培训体系,以及客户服务的体系。 4:营销目标达不成的危害 公司战略落实不了; 被竞争对手抢占市场; 公司利润有所下降; 客户和员工都得不到很好的服务和待遇; 营销团队没有斗志和目标感; 公司整体执行力下降; 二:销售团队目标分解的流程: 1:目标分解程序: 销售团队的目标分解一定是自上而下的去分解: 如果一个营销团队的目标从下而上来制定,会出现什么情况呢? 举例分析:销售经理王冠军:他在一家家具行业做了很长时间了,所带领的营销团队的业绩一直没有太大的突破和发展,公司决定在年底进行整顿和改革,把不合适的团队进行合并,这次整顿的前提及时看一些各个营销团队的管理者对明年的团队发展思路和业绩达标的决心。公司总经理在一次管理人员大会上,让每一位营销管理者进行明年各个团队销售计划以及销售业绩目标的制定,这是王冠军也说出了自己团队的销售目标,看来他已经想好了,也准备好了,毫不犹豫的脱口而出,其他的部门经理思考了半天,还没有说出一个数字。 到最后,所有营销部门都把业绩报完之后,王冠军的业绩时所有营销团队业绩目标最少的一个。 会后,总经理找到王冠军进行讨论,最后得知,他的目标制定方法是让下属每一个人写下下一年的销售业绩目标,最后他加在一起,就汇报给了总经理。 我们试想一下,王冠军这样的目标制定合理吗? 在一个营销团队,很多营销人员自己制定的目标基本都是根据自己过去的业绩达成情况制定的,很多营销人员制定的目标都非常保守,没有挑战性,甚至不用怎么努力就可以完成的哪一种。想想一下,这样的营销团队在市场竞争中一定是一只绵羊,没有战斗力和挑战性。

并行计算-练习题

2014年《并行计算系统》复习题 (15分)给出五种并行计算机体系结构的名称,并分别画出其典型结构。 ①并行向量处理机(PVP) ②对称多机系统(SMP) ③大规模并行处理机(MPP) ④分布式共享存储器多机系统(DSM) ⑤工作站机群(COW) (10分)给出五种典型的访存模型,并分别简要描述其特点。 ①均匀访存模型(UMA): 物理存储器被所有处理机均匀共享 所有处理机访存时间相同 适于通用的或分时的应用程序类型 ②非均匀访存模型(NUMA): 是所有处理机的本地存储器的集合 访问本地LM的访存时间较短 访问远程LM的访存时间较长 ③Cache一致性非均匀访存模型(CC-NUMA): DSM结构 ④全局Cache访存模型(COMA): 是NUMA的一种特例,是采用各处理机的Cache组成的全局地址空间 远程Cache的访问是由Cache目录支持的 ⑤非远程访存模型(NORMA): 在分布式存储器多机系统中,如果所有存储器都是专用的,而且只能被本地存储机访问,则这种访问模型称为NORAM 绝大多数的NUMA支持NORAM 在DSM中,NORAM的特性被隐匿的 3. (15分)对于如下的静态互连网络,给出其网络直径、节点的度数、对剖宽度,说明该网络是否是一个对称网络。 网络直径:8 节点的度数:2 对剖宽度:2 该网络是一个对称网络 4. (15分)设一个计算任务,在一个处理机上执行需10个小时完成,其中可并行化的部分为9个小时,不可并行化的部分为1个小时。问: (1)该程序的串行比例因子是多少,并行比例因子是多少? 串行比例因子:1/10

并行比例因子:9/10 如果有10个处理机并行执行该程序,可达到的加速比是多少? 10/(9/10 + 1) = 5.263 (3)如果有20个处理机并行执行该程序,可达到的加速比是多少? 10/(9/20 + 1)= 6.897 (15分)什么是并行计算系统的可扩放性?可放性包括哪些方面?可扩放性研究的目的是什么? 一个计算机系统(硬件、软件、算法、程序等)被称为可扩放的,是指其性能随处理机数目的增加而按比例提高。例如,工作负载能力和加速比都可随处理机的数目的增加而增加。可扩放性包括: 1.机器规模的可扩放性 系统性能是如何随着处理机数目的增加而改善的 2.问题规模的可扩放性 系统的性能是如何随着数据规模和负载规模的增加而改善 3.技术的可扩放性 系统的性能上如何随着技术的改变而改善 可扩放性研究的目的: 确定解决某类问题时何种并行算法与何种并行体系结构的组合,可以有效的利用大量的处理器; 对于运用于某种并行机上的某种算法,根据在小规模处理机的运行性能预测移植到大规模处理机上的运行性能; 对固定问题规模,确定最优处理机数和可获得的最大的加速比 (15分)给出五个基本的并行计算模型,并说明其各自的优缺点。 ①PRAM:SIMD-SM 优点: 适于表示和分析并行计算的复杂性; 隐匿了并行计算机的大部底层细节(如通信、同步),从而易于使用。 缺点: 不适于MIMD计算机,存在存储器竞争和通信延迟问题。 ②APRAM:MIMD-SM 优点: 保存了PRAM的简单性; 可编程性和可调试性(correctness)好; 易于进行程序复杂性分析。 缺点: 不适于具有分布式存储器的MIMD计算机。 ③BSP:MIMD-DM 优点: 把计算和通信分割开来; 使用hashing自动进行存储器和通信管理; 提供了一个编程环境。 缺点: 显式的同步机制限制并行计算机数据的增加; 在一个Superstep中最多只能传递h各报文。

LBGK模型的分布式并行计算

万方数据

2LBGKD2Q9模型的并行计算 2.1数据分布 将流场划分成N。xN,的网格。设有P=只×Pv个进程参与并行计算,进程号P。=H以(0≤i<只,0≤J<尸v)。将数据按照重叠一条边的分块分布到各进程中。其中,进程P。存储并处理的数据网格点集,如图l所示。 图1进程珊存储并处理的区域(斜线处为重叠部分) 2.2交替方向的Jacobi迭代通信 Jacobi迭代是一类典型的通信迭代操作。文献[4】主要讨论了一个方向的Jacobi迭代。根据数据分布及计算要求,需要采用2个方向交替的Jacobi迭代通信操作。本文认为,“即发即收”的通信策略能有效避免完全的“先发后收”可能造成的通信数据“堆积”过多,从而避免数据的丢失。进程Pli的通信操作如下(见图2): (1)Ifi≠只一1then发送数据到进程P¨,; (2)Ifi≠0then从进程Pf_J,接收数据; (3)If,≠只-1then发送数据到进程Pml; (4)IfJ≠0then从进程P—l接收数据。 各进程并行执行上述操作。 图2交普方向的Jacobi迭代 2.3通信时间理论 由一般的通信模型可知,若发送、接收信息长度为n字节的数据所需时间为:丁(n)=口+n∥,其中,常数口为通信启动时间;∥为常系数,则上述一次交替方向的Jacobi迭代通信操作的时间约为 20e+2fl'N、.P,=1 P。=1 其他 其中,∥7=∥sizeof(double)。 一般情况下,当等3鲁,即等=鲁时,通信的数据量(字节数)是最少的,为4口+4∥,./丝堡。可见,通信的信息 V只×0 总量和通信时间随进程总数只×尸v的增加而减少。 由于c语言中数组是按“行”存放的(Fortran是按“列”存放的),当存放、发送列数据时,需要一定的辅助操作,这就增加了并行计算的计算时间,因此在只:Pv无法恰好等于Nx:N。时,需要综合考虑流场形状及大小、数据在内存中的按“行”(或按“列”)的存放方式,以确定数据的最佳分布方案。 3数值实验 数值实验是在“自强3000”计算机上进行的ou自强3000”计算机拥有174个计算结点,每个计算结点上有2个3.06CPU,2GB内存。本文的实验使用了其中的32个计算结点共64个CPU。程序采用MPI及C语言编写,程序执行时,每个计算结点中启动2个进程。数值实验针对不同规模的网格划分、不同进程数以及不同的数据分布方案进行了大量实验,测得如下结果:不同的流场规模对应着各自的最佳网格划分方式;计算次数越多,加速比越大,越能体现并行计算的优越性。 由表1数据可以得知,对于规模为Nx×N、,=400x400,数据划分成6×6块时的加速比最高,而对于MXNy=600x200,数据划分为12×3块则更具优越性。合适的划分方式可以使总体通信量减至最少,从而提高加速比和并行效率。另外,计算规模越大,加速比越大。 表1并行计算D2Q9模型的加速比(进程数为36) 在固定计算规模,增加处理器的情况下,并行系统的加速比会上升,并行效率会下降;在固定处理器数目,增加计算规模的情况下,并行系统的加速比和效率都会随之增加。 从表2可见,流场规模越大,并行计算的优越性越显著。因为此时计算规模(粒度)较大,相对于通信量占有一定的优势。由图3可见,加速比随进程数呈线性增长,这表明LBGKD2Q9模型的并行计算具有良好的可扩展性。 表2漉场规模固定时并行计算D2Q9模型的加速比 0816243240485664 numofprocess 图3藐场规模固定时D2Q9模型并行计算的加速比 4结束语 本文讨论了LBGKD2Q9模型的分布式并行计算,通过大量的数值实验重点研究了数据分布方案如何与问题规模匹配,以获得更高的并行效率的问题。展示了LBGK模型方法良好的并行性和可扩展性。得到了二维LBGK模型并行计算数据分布的一般原则、交替方向Jacobi迭代的通信策略。这些结论对进一步开展三维LBGK模型的并行计算及其他类似问题的并行计算有一定的指导意义。(下转第104页) 一101—万方数据

MATLAB分布式并行计算服务器配置和使用方法Word版

Windows下MATLAB分布式并行计算服务器配置和使用方 法 1MATLAB分布式并行计算服务器介绍 MATLAB Distributed Computing Server可以使并行计算工具箱应用程序得到扩展,从而可以使用运行在任意数量计算机上的任意数量的worker。MATLAB Distributed Computing Server还支持交互式和批处理工作流。此外,使用Parallel Computing Toolbox 函数的MATLAB 应用程序还可利用MATLAB Compiler (MATLAB 编译器)编入独立的可执行程序和共享软件组件,以进行免费特许分发。这些可执行应用程序和共享库可以连接至MATLAB Distributed Computing Server的worker,并在计算机集群上执行MATLAB同时计算,加快大型作业执行速度,节省运行时间。 MATLAB Distributed Computing Server 支持多个调度程序:MathWorks 作业管理器(随产品提供)或任何其他第三方调度程序,例如Platform LSF、Microsoft Windows Compute Cluster Server(CCS)、Altair PBS Pro,以及TORQUE。 使用工具箱中的Configurations Manager(配置管理器),可以维护指定的设置,例如调度程序类型、路径设置,以及集群使用政策。通常,仅需更改配置名称即可在集群间或调度程序间切换。 MATLAB Distributed Computing Server 会在应用程序运行时在基于用户配置文件的集群上动态启用所需的许可证。这样,管理员便只需在集群上管理一个服务器许可证,而无需针对每位集群用户在集群上管理单独的工具箱和模块集许可证。 作业(Job)是在MATLAB中大量的操作运算。一个作业可以分解不同的部分称为任务(Task),客户可以决定如何更好的划分任务,各任务可以相同也可以不同。MALAB中定义并建立作业及其任务的会话(Session)被称为客户端会话,通常这是在你用来编写程序那台机器上进行的。客户端用并行计算工具箱来定义和建立作业及其任务,MDCE通过计算各个任务来执行作业并负责把结果返

并行计算-期末考试模拟题原题

Reviews on parallel programming并行计算英文班复习考试范围及题型:(1—10章) 1 基本概念解释;Translation (Chinese) 2 问答题。Questions and answer 3 算法的画图描述。Graphical description on algorithms 4 编程。Algorithms Reviews on parallel programming并行计算 1 基本概念解释;Translation (Chinese) SMP MPP Cluster of Workstation Parallelism, pipelining, Network topology, diameter of a network, Bisection width, data decomposition, task dependency graphs granularity concurrency process processor, linear array, mesh, hypercube, reduction,

prefix-sum, gather, scatter, thread s, mutual exclusion shared address space, synchronization, the degree of concurrency, Dual of a communication operation, 2 问答题。Questions and answer Chapter 1 第1章 1) Why we need parallel computing? 1)为什么我们需要并行计算? 答: 2) Please explain what are the main difference between parallel computing and sequential computing 2)解释并行计算与串行计算在算法设计中的主要不同点在那里? 答: Chapter 2 第2章 1) What are SIMD, SPMD and MIMD denote? 1)解释SIMD, SPMD 和 MIMD是什么含义。 答: 2) Please draw a typical architecture of SIMD and a typical architecture of MIMD to explan. 2)请绘制一个典型的SIMD的体系结构和MIMD的架构。 答:

20100428第三章 并行计算模型和任务分解策略

第三章并行计算模型和任务分解策略 首先,我们将研究不同类型的并行计算机,为了不严格限定于某个指定机型,我们通过模型把并行计算机抽象为几个特定属性。为了说明并行程序中处理器之间的通信概念模型我们讨论了不同的程序模型,另外为了分析和评估我们算法的性能,我们讨论了多计算机架构下评估并行算法复杂度的代价模型。在介绍并分析的各种代价模型的基础上给出了改进型的代价模型。 其次我们定义这样几个指标如负载均衡和网络半径等用来研究图分解问题的主要特性。并把图分解问题归纳为一般类型和空间映射图类型。我们重点研究的是后者,因为多尺度配置真实感光照渲染算法可以很方便的描述成空间映射图形式。 3.1 并行计算机模型 以下给出并行计算机的模型的概述,根据其结构并行计算机大致可分为以下几类。 多计算机(Multicomputer):一个von Neumann计算机由一个中央处理器(CPU)和一个存储单元组成。一个多计算机则由很多von Neumann计算机通过互联网络连接而成的计算机系统。见图3.1。每个计算机(节点)执行自己的计算并只能访问本地的存储。通过消息实现各计算机之间的互相通讯。在理想的网络中,两个计算节点之间的信息传送代价与本地的计算节点和它的网络阻塞无关,只和消息的长度相关。以上多计算机和分布式存储的MIMD机器之间的主要区别在于后者的两个节点间的信息传输不依赖于本地计算和其它网络阻塞。 分布式存储的MIMD类型的机器主要有IBM的SP, Intel的Paragon, 曙光4000系列, Cray 的T3E, Meiko的CS-2, NEC的Cenju 3, 和nCUBE等。通过本地网络的连接的集群系统可以认为是分布式存储的MIMD型计算机。 多处理器(Multiprocessor):一个多处理器型并行计算机(共享存储的MIMD计算机)由大量处理器组成,所有的处理器都访问一个共同的存储。理论上理想的模型就是PRAM模型(并行的随机访问系统),即任何一个处理器访问任一存储单元都是等效的(见图3.2)。并发存储访问是否允许取决于所使用的真正的模型【34】。 混合模型:分布式共享存储(DMS)计算机,提供了一个统一的存储访问地址空间但是分布式物理存储模块。编译器和运行时系统负责具体的并行化应用。这种系统软件比较复杂。 图3.1 多计算机模型图3.2 PRAM 模型 SIMD计算机:在一个SIMD(单指令流多数据流)计算机中在不同数据流阶段所有的处理器执行同样的指令流。典型的机型有MasPar的MP, 和联想机器CM2。 多计算机系统具有良好的可扩展性,价格低廉的集群式并行计算机就属于这种模型,本文中的算法主要基于多计算机体系结构。 3.2 程序模型 并行程序的编程语言如C或Fortan。并行结构以某种类库的形式直接整合进这些编程语言中。编程模型确定了并行程序的风格。一般可分为数据并行、共享存储和消息传递等模型[35]。 数据并行编程:数据并行模型开始于编写同步SIMD并行计算机程序。程序员需要在每个处理器上独立执行一个程序,每个处理器均有其自己的存储器。程序员需要定义数据如何分配到每个局部存储中。实际应用中大量的条件分支的需要使得其很难高效的运行在SIMD型的机器上。 共享存储编程:共享存储模型是一个简单的模型,因为程序员写并行程序就像写串行程序一样。一个程序的执行与几个处理器独立,也不需要同步。一个处理器的执行状态独立于其它处理器的运

分布式与并行计算报告

并行计算技术及其应用简介 XX (XXX,XX,XXX) 摘要:并行计算是实现高性能计算的主要技术手段。在本文中从并行计算的发展历程开始介绍,总结了并行计算在发展过程中所面临的问题以及其发展历程中出现的重要技术。通过分析在当前比较常用的实现并行计算的框架和技术,来对并行计算的现状进行阐述。常用的并行架构分为SMP(多处理系统)、NUMA (非统一内存存储)、MPP(巨型并行处理)以及集群。涉及并行计算的编程模型有MPI、PVM、OpenMP、TBB及Cilk++等。并结合当前研究比较多的云计算和大数据来探讨并行计算的应用。最后通过MPI编程模型,进行了并行编程的简单实验。 关键词:并行计算;框架;编写模型;应用;实验 A Succinct Survey about Parallel Computing Technology and It’s Application Abstract:Parallel computing is the main technology to implement high performance computing. This paper starts from the history of the development of Parallel Computing. It summarizes the problems faced in the development of parallel computing and the important technologies in the course of its development. Through the analysis of framework and technology commonly used in parallel computing currently,to explain the current situation of parallel computing.Framework commonly used in parallel are SMP(multi processing system),NUMA(non uniform memory storage),MPP(massively parallel processing) and cluster.The programming models of parallel computing are MPI, PVM, OpenMP, TBB and Cilk++, etc.Explored the application of parallel computing combined with cloud computing and big data which are very popular in current research.Finally ,through the MPI programming model,a simple experiment of parallel programming is carried out. Key words:parallel computing; framework; programming model; application; experiment 1引言 近年来多核处理器的快速发展,使得当前软件技术面临巨大的挑战。单纯的提高单机性能,已经不能满足软件发展的需求,特别是在处理一些大的计算问题上,单机性能越发显得不足。在最近AlphaGo与李世石的围棋大战中,AlphaGo就使用了分布式并行计算技术,才能获得强大的搜索计算能力。并行计算正是在这种背景下,应运而生。并行计算或称平行计算时相对于串行计算来说的。它是一种一次可执行多个指令的算法,目的是提高计算速度,及通过扩大问题求解规模,解决大型而复杂的计算问题。可分为时间上的并行和空间上的并行。时间上的并行就是指流水线技术,而空间上的并行则是指用多个处理器并发的执行计算。其中空间上的并行,也是本文主要的关注点。 并行计算(Parallel Computing)是指同时使用多种计算资源解决计算问题的过程,是提高计算机系统计算速度和处理能力的一种有效手段。它的基本思想是用多个处理器来协同求解同一问题,即将被求解的问题分解成若干个部分,各部分均由一个独立的处理机来并行计算。并行计算系统既可以是专门设计的,含有多个处理器的超级计算机,也可以是以某种方式互联的若干台的独立计算机构成的集群。通过并行计算集群完成数据的处理,再将处理的结果返回给用户。 目前常用的并行计算技术中,有调用系统函数启动多线程以及利用多种并行编程语言开发并行程序,常用的并行模型有MPI、PVM、OpenMP、TBB、Cilk++等。利用这些并行技术可以充分利用多核资源适应目前快速发展的社会需求。并行技术不仅要提高并行效率,也要在一定程度上减轻软件开发人员负担,如近年来的TBB、Cilk++并行模型就在一定程度上减少了开发难度,提高了开发效率,使得并行软件开发人员把更多精力专注于如何提高算法本身效率,而非把时间和精力放在如何去并行一个算法。

华南理工大学分布式计算期末考试卷题整理

华南理工大学分布式计算期末考试卷题整 理 第一章:分布式 1)并行计算与分布式计算区别? (1)所谓分布式计算是一门计算机科学,它研究如何把一个需要非常巨大的计算能力才能 解决的问题分成许多小的部分,然后把这些部分分配给许多计算机进行处理,最后把这些 计算结果综合起来得到最终的结果。 与并行计算不同的是,并行计算是使用多个处理器并行执行单个计算。 2)分布式计算的核心技术是? 进程间通信IPC!!! 3)解决进程间通信死锁的两种方法? 超时和多线程 4)分布式系统的CAP理论是什么? 一致性,可用性,分区容忍性 第二章:范型 1)网络应用中使用的最多的分布式计算范型是? 客户-服务器范型(简称CS范型) 2)消息传递范型与消息中间件范型异同? 消息传递:一个进程发送代表请求的消息,该消息被传送到接受者;接受者处理该请求,并发送一条应答消息。随后,该应答可能触发下一个请求,并导致下一个应答消息。如 此不断反复传递消息,实现两个进程间的数据交换. 基于该范型的开发工具有Socket应用程序接口(Socket API)和信息传递接口(Message Passing Interface,MPI)等 消息系统模型可以进一步划分为两种子类型:点对点消息模型(Point- to-point message model)和发布订阅消息模型(Public/Subscribe message model)。 在这种模型中,消息系统将来自发送者的一条消息转发到接收者的消息 队列中。与基本的消息传递模型不同的是,这种中间件模型提供了消息 暂存的功能,从而可以将消息的发送和接受分离。与基本的消息传递模 型相比,点对点消息模型为实现异步消息操作提供了额外的一层抽象。 如果要在基本的消息传递模型中达到同样的结果,就必须借助于线程或 者子进程技术。 3)一个分布式应用能否使用多个分布式计算范型? 可以,部分。

分布式与并行计算报告

分布式与并行计算报告

————————————————————————————————作者:————————————————————————————————日期: ?

并行计算技术及其应用简介 XX (XXX,XX,XXX) 摘要:并行计算是实现高性能计算的主要技术手段。在本文中从并行计算的发展历程开始介绍,总结了并行计算在发展过程中所面临的问题以及其发展历程中出现的重要技术。通过分析在当前比较常用的实现并行计算的框架和技术,来对并行计算的现状进行阐述。常用的并行架构分为SMP(多处理系统)、NUMA(非统一内存存储)、MPP(巨型并行处理)以及集群。涉及并行计算的编程模型有MPI、PVM、Ope nMP、TBB及Cilk++等。并结合当前研究比较多的云计算和大数据来探讨并行计算的应用。最后通过MPI编程模型,进行了并行编程的简单实验。 关键词:并行计算;框架;编写模型;应用;实验 A Succinct SurveyaboutParallelComputing Technology and It’sApplication Abstract:Parallel computing is the main technology to implement high performance computing. Thispaper starts fromthe historyofthe development of Parallel Computing. It summarizes the problems faced in the development of parallel computingand the i mportant technologies in the course of itsdevelopment. Through theanalysis of framework andtechnologycommonly used inparallel computing currently,to explain the current situationofparallelcomputing.Framework commonlyused in parallel areSMP(multi processing system),NUMA(non uniform memory storage),MPP(massivel yparallel processing)and cluster.The programming models of parallelcomputing areMPI, PVM,OpenMP, TBB and Cilk++,etc.Explored the application ofparallel computing combinedwithcloudcomputingand big data whichare very popular incu rrentresearch.Finally ,through the MPI programming model,asimple experiment ofparallel programming iscarried out. Keywords:parallel computing; framework;programming model;application; experiment 1引言 近年来多核处理器的快速发展,使得当前软件技术面临巨大的挑战。单纯的提高单机性能,已经不能满足软件发展的需求,特别是在处理一些大的计算问题上,单机性能越发显得不足。在最近AlphaGo与李世石的围棋大战中,AlphaGo就使用了分布式并行计算技术,才能获得强大的搜索计算能力。并行计算正是在这种背景下,应运而生。并行计算或称平行计算时相对于串行计算来说的。它是一种一次可执行多个指令的算法,目的是提高计算速度,及通过扩大问题求解规模,解决大型而复杂的计算问题。可分为时间上的并行和空间上的并行。时间上的并行就是指流水线技术,而空间上的并行则是指用多个处理器并发的执行计算。其中空间上的并行,也是本文主要的关注点。 并行计算(Parallel Computing)是指同时使用多种计算资源解决计算问题的过程,是提高计算机系统计算速度和处理能力的一种有效手段。它的基本思想是用多个处理器来协同求解同一问题,即将被求解的问题分解成若干个部分,各部分均由一个独立的处理机来并行计算。并行计算系统既可以是专门设计的,含有多个处理器的超级计算机,也可以是以某种方式互联的若干台的独立计算机构成的集群。通过并行计算集群完成数据的处理,再将处理的结果返回给用户。 目前常用的并行计算技术中,有调用系统函数启动多线程以及利用多种并行编程语言开发并行程序,常用

月目标任务分解表

行政月目标任务分解表(初稿)以下只是月目标,学期目标和年度目标请参看《各行政部门工作考核目标》,请老师、行政提宝贵意见,在下周一前发在 lmm0872@https://www.360docs.net/doc/7d5002189.html,。 行政每月从绩效中抽取600元作为考核奖,布置的工作及时完成,每超过一天扣50元,超过规定时间一周,另行安排。在各项工作中块均处于领先位置,根据所参评的学校数,每上升一名总分加一分,每落后一名扣一分。被县局、市局、省顶厅青表扬或批评的,每次一次分别加(扣)100元、200、300元。教导、信息、办公室由吴金亮分管;政教、后勤、对外联络由卞正阳分管。分管人吴金亮,卞正阳的绩效与分管部门的绩效挂勾,享受其分管部门的三分之一。管理及其他特色或临时性工作加分项由各分管领导提出交由教代会决定。在每月的最后一周之前提出。所加的钱数从所扣的钱数中抽取,所扣的钱数,用于各负责人再平均分配。分管领导按三分之一进行分配。 一、教导处(孙卫红): 业务培训4次;教师的业务考核每人不少于4次。3个以上课题组,且每个组活动不少于4次。上传每周的考核结果不少于4次。每少一次扣50元。其它日常工作。 二、政教处(王守佳): 政治学习4次;上传每周的考核结果不少于4次。安全检查不少于五次(上报周查,月查记录),全体老师安全教育不少于一次。

宿舍被褥晾晒不少于一次。每少一次扣50元。其它日常工作。 三、信息中心(刘如东): 县教育信息网上用稿每月不低于 4 件。校内网上每月不低于10篇。每周更新一次以上校园网。每少一次扣50元。每天把校内业务检查,内务检查,卫生查检,校内好人好事,通知公告,来人来访等各部门写好后及时上传。每少一项扣10元。其它日常工作。 四、办公室(冯景波): 考勤工作月总结四次。每少一次扣50元。每天做好灌云教育信息网通知工作,每误一次扣100元,会议记录每少一次扣20元。做好每月的文书、资料归档工作。办公室其他事务等。 五、后勤(马建华): 每月对设备进行一次检查维护,每月对帐务进行一次公布。水电管理,每一次没及时关水扣20元,每一次没及时关灯扣10元,空调一次扣50元。食堂一次不留样扣50元。每月上报食堂卫生检查记录,消毒记录,留样记录,每月上报每周核算情况。每月对食堂进行全面扫除不少于4次。每月对后勤人员开会不少于四次。每一项没做到的扣50元。日常其他工作。 六、对外联络部(卞正阳): 每月与非教育机关至少联系一次,外来参观人员不得少于20人次。达不到的一次扣50元。与实践学校联系及其他日常和临时性工作。

ANSYS分布式并行计算步骤

ANSYS11.0分布式并行计算步骤 Example: Running Distributed ANSYS on Windows 一、准备工作 (1)在主从机上分别安装ansys11.0到相同的目录下。 (2)在主从机上分别注册相同的用户名(管理员身份)和密码。 (3)在主从机上分别安装dotnetfx.exe。 (4)在主从机上分别为ansys创建相同的工作目录。 (5)把测试例题命令流tutor1_carrier_win.inp复制到主机的工作目录下。 命令流位于C:\Program Files\ANSYS Inc\v110\ANSYS\data\models的目录下。 二、安装mpich2并进行测试 (1)在主从机上分别安装mpich2-1.0.3-1-win32-ia32.msi,此文件在C:\Program Files\ANSYS Inc\v110\ANSYS\MPICH2中,采用默认安装目录见下图。 (2)在运行开始>程序>MPICH2>wmpiregister,输入用户名和密码,单击register,单击OK,如图所示。 (3)单机测试:在主从机上分别在DOS模式下进入C:\Program Files\Ansys Inc\v110\ANSYS\bin\intel,运行ansys110 -np 2 -mpitest命令,见下图所示。 (3)打开C:\Program Files\Ansys Inc\v110\ANSYS\bin\intel,用记事本打开machines,进行编辑,见下图,其中A13A7DA13157493为主机计算机名,PC-200907230929为从机计算机名。必须为偶数个结点,每两个核构成一个结点,所以为核数为奇数。例如A13A7DA13157493电脑为4核,设置了2核,PC-200907230929为2核,设置了1核,3核构成2个结点。

并行计算的基本概念

并行计算的基本概念 [转贴2008-02-25 09:57:26] 1、并行计算:并行计算是指同时对多个任务或多条指令、或对多个数据项进行处理。完成此项处理的计算机系统称为并行计算机系统,它是将多个处理器通过网络连接以一定的方式有序地组织起来。 2、指令流:机器执行的指令序列; 3、数据流:由指令流调用的数据序列,包括输入数据和中间结果。 4、SIMD计算机:有一个控制部件和许多处理单元,所有的处理单元在控制部件的统一控制下工作。控制部件向所有的处理单元广播同一条指令,所有的处理单元同时执行这条指令,但是每个处理单元操作的数据不同。 5、MIMD计算机没有统一的控制部件,含有多个处理器,各处理器可以独立地执行不同的指令,每个处理器都有控制部件,各处理器通过互连网络进行通信。 6、并行向量处理机(PVP)在并行向量处理机中有少量专门定制的向量处理器。每个向量处理器有很高的处理能力。并行向量处理机通过向量处理和多个向量处理器并行处理两条途径来提高处理能力。 7、大规模并行处理机(MPP)大规模并行处理机一般指规模非常大的并行计算机系统,含有成千上万个处理器。它一般采用分布的存储器,存储器一般为处理器私有,各处理器之间用消息传递的方式通信。大规模并行处理机的互连网络一般是专门设计定制的。 8、分布式共享存储器多处理机(DSM)分布式共享存储器多处理机的主要特点是它的存储器在物理上是分布在各个结点中的,但是通过硬件和软件为用户提供一个单一地址的编程空间,即形成一个虚拟的共享存储器。它通过高速缓存目录支持分布高速缓存的一致性。 9、机群(COW或NOW) 是由高档商品微机(包括工作站)用高速商品互连网络(有的商用机群也使用定制的网络)连接而成,每个结点都是一台完整的计算机(可能没有鼠标、显示器等外设)。 10、对称多处理机(SMP)对称多处理机的最大特点是其中的各处理器完全平等,无主从之分。所有的处理器都可以访问任何存储单元和I/O设备。存储器一般使用共享存储器,只有一个地址空间。因为使用共享存储器,通信可用共享变量(读写同一内存单元)来实现。 11、UMA UMA是Uniform Memory Access(均匀存储访问)模型的缩写。在这种并行机中所有的处理器均匀共享物理存储器。所有处理器访问任何存储字需要相同的时间(此即为均匀存储访问名称的来源)。每台处理器可以有私有高速缓存。UMA结构适用于通用或分时应用。 12、NUMA NUMA是Nonuniform Memory Access(非均匀存储访问)模型的缩写。在NUMA中,共享存储器在物理上是分布的,所有的本地存储器构成了全局地址空间。NUMA与UMA的区别在于处理器访问本地存储器和群内共享存储器比访问远程存储器或全局共享存储器快。 13、COMA COMA是Cache-Only Memory Architecture(全高速缓存存储结构)模型的缩写。COMA 实际是NUMA的一种特例,将NUMA中的分布存储器换成高速缓存就得到了COMA。在COMA 中,每个结点上没有存储层次结构,所有的高速缓存构成了全局地址空间。访问远程高速缓存要借助分布的高速缓存目录。 14、CC-NUMA CC-NUMA是Cache-Coherent Nonuniform Memory Access(高速缓存一致性非均匀存储访问)模型的缩写。CC-NUMA结构的并行机实际上是将一些SMP机作为结点互连起来而构成的并行机,绝大多数商用CC-NUMA多处理机系统使用基于目录的高速缓存一致性协议;它的存储器在物理上是分布的,所有的局部存储器构成了共享的全局地址空间。 15、NORMA NORMA是No-Remote Memory Access(非远程存储访问)模型的缩写。在NORMA 中,所有的存储器都是处理器私有的,仅能由其处理器访问。各处理器之间通过消息传递方式通信。 16、静态网络(Static Networks)静态网络是指结点间有着固定连接通路且在程序执行期间,这种连接保持不变的网络 17、动态网络(Dynamic Networks)动态网络是用开关单元构成的,可按应用程序的要求动态地

年度销售计划目标任务如何进行分解.

年度销售计划如何进行目标分解 世界上最远的距离,是从头到脚, 世界上最难的管理,是从战略到动作。 年度销售计划和目标分解,这样的话题,应属老生常谈了,但又不得不谈,而且常谈常新。08年笔者访谈了多家公司的销售部门领导和公司高层,对这个问题是高度重视(毕竟销售部门是产出部门,是公司的生命线,但又讲不明白。比如,你问一些公司的销售部经理:你们是怎么制定年度销售计划的?他可能说:公司下任务,我这里分解;还有的就是说,根据去年完成销量情况适当增加某个比例。反正就是粗略的一个想法和目标。分解任务基本是下压式,没有沟通,就算有那也是例行通报。 那么公司的销售计划和目标分解怎样做才能算科学、合理、有效呢? 在这里,我只能说大致的科学、合理、有效,因为各个行业、企业的市场发展、竞争状况、市场基础、渠道、品牌、团队各不一样,不可能放之四海而皆准。 我们先来看一个目标细化的故事: 美国科学家曾经做过这样的一组实验:将30个人分为A、B、C三组,让他们分别走路到50公里外的村子里去。 A组人员:没有小目标,也不知路程有多远,不知道村庄的名字,只管跟着向导不停地走就行了。结果,走到五分之一的距离,大家都开始叫苦;不到一半的路程,大家有开始抱怨;走完四分之三的路程,大家都愤怒了;走完全程,大家情绪都很低落,花费的时间是最长的,而且大家也很痛苦。 B组人员:有大目标(知道村子名字,也知道路线和终点,但是路上没有里程碑,没有时间和速度,只根据经验估计猜测。结果,走到一半的距离,有人开始询问;走完四分之三的路程,大家普遍情绪低落,最后大家都疲累不堪,同时路上花费的时间也是比较长的。

C组人员:不仅知道方向,也知道终点位置,而且路程上还有路碑,向导有手表还知道大家行进的速度,明确剩下的距离。一路上,大家有说有笑,还有人在唱歌,在快乐的情绪中大家走完全程。结果,花费的时间是最短的,也是最快乐的一组。 这个故事说明了什么? 第一:目标设计得越具体越细化,越容易实现 第二:如果清晰知道行动目标和进展速度,人们就能自觉克服困难,努力达到目标 第三:看不到目标容易让人心生恐惧和愤怒 第四:将目标简单化、轻松化,更容易实现 第五:目标需要不断地被细化(阶段性标志、小目标 第六:方向比努力更重要,快乐也是生产力 下面我们看看一般企业是怎么进行销售计划和目标分解的? 大多数企业用的是:指令式分解。指令式分解是分解前不与下级商量,由领导者确定分解方案,以指令或指示、计划的形式下达。 有一些企业用的是协商式分解。协商式分解使上下级对总体目标的分解和层次目标的落实进行充分的商谈或讨论,取得一致意见。 前者容易使目标构成一个完整的体系,但也容易造成某些目标难以落实下去,不利于下级积极性的激励和能力的发挥;后者容易使目标落到实处,也有利于下级积极性的调动和能力的发挥,但要注意“民主”之后的“集中”。 要做好年度销售计划和目标分解,主要应围绕三方面进行工作,基本就可以达到科学、合理、有效。 第一方面:销售计划与目标分解制度