视频中移动目标检测综述

基于视频的移动目标检测

论文研读报告

苏航00748178

智能科学系信息科学技术学院

北京大学

摘要

基于视频的移动目标检测是一个重要且有挑战性的任务,在许多应用中都起到相当关键的作用。本次论文研读围绕该主题展开,深入阅读了十余篇论文,在本文总结了视频中移动目标检测的一些主要方法及各自的优劣,并将几个重要的方法大致分为了两个不同的类别:基于像素的移动目标检测和基于区域的移动目标检测。在基于像素的方法中,图像特征完全由各个像素的坐标及灰度值(或颜色值)确定,而在基于区域的方法中,各个像素属性之间的关联成为主要特征来用以提取移动目标。另外本文还讨论了以上两类之外的一些方法。

关键词

视频移动目标检测背景差分高斯混合模型直方图

正文

1 引言

基于视频的移动目标检测在许多实际应用中都担当着核心的任务。譬如视频监视、人机交互、视频编码等广泛的领域都需要有效地进行该工作。帧差法(Frame Differencing)12是视频中检测移动目标最简单直观的方法,其在视频片段中固定间隔的两帧之间计算绝对差,该差值大于一定阈限的像素就认为是运动物体可能存在的区域:

D t(x,y)=Abs.F t(x,y)?F t?k(x,y)/(1)

这种简单的方法有时十分有效,但在更多应用环境下并不能获得期望的效果。这主要是由于视频中各帧之间的差异并不仅仅来源于运动的物体,而同时可能来

1R. Jain and H. Nagel, “On the Analysis of Accumulative Difference Pictures from Image Sequences of Real World

S cenes”, IEEE Trans. Pattern Analysis and Machine Intelligence, vol. 1, no. 2, pp. 206–214, 1979.

2为了避免混淆,本文中将作为主要研读对象的文章列在报告最后的“参考文献”一栏中,而其他引用的

文献则作为脚注注明。

源于很多别的因素。例如在室外道路监视中,由于太阳位置及云雾遮挡阳光的情况不断改变,路面整体的亮度并不固定而是不断改变的,甚至有可能出现大的变化。类似这样可能被错误识别成移动物体的因素还有很多,如移动物体产生的阴影、水面的波纹、摄像机的抖动等。另外,在特定的应用场景下还有其他一些至关重要的问题需要考虑。例如在道路监视中,车辆往往有复杂的遮挡现象,而且车辆的阴影很大程度加剧了这种现象的出现。当然这些困难也并不总是存在的,有些应用中并不会出现这些问题,如室内视频监视就没有大尺度光照变化的问题;也有些应用中并不需要考虑这些问题,如传统的视频编码中阴影、水波等本身并不能忽略所以可以一并视为运动物体。

以上这些分析可以简单看出,视频中的移动目标检测是一件非常有挑战性的工作,而且不同应用环境的需求存在很大的差异。在一个应用中性能很好的算法可能在另一个场景中完全不适用,所以很难使用单一的技术应对所有的应用环境,这也就导致相关的算法技术不断涌现。

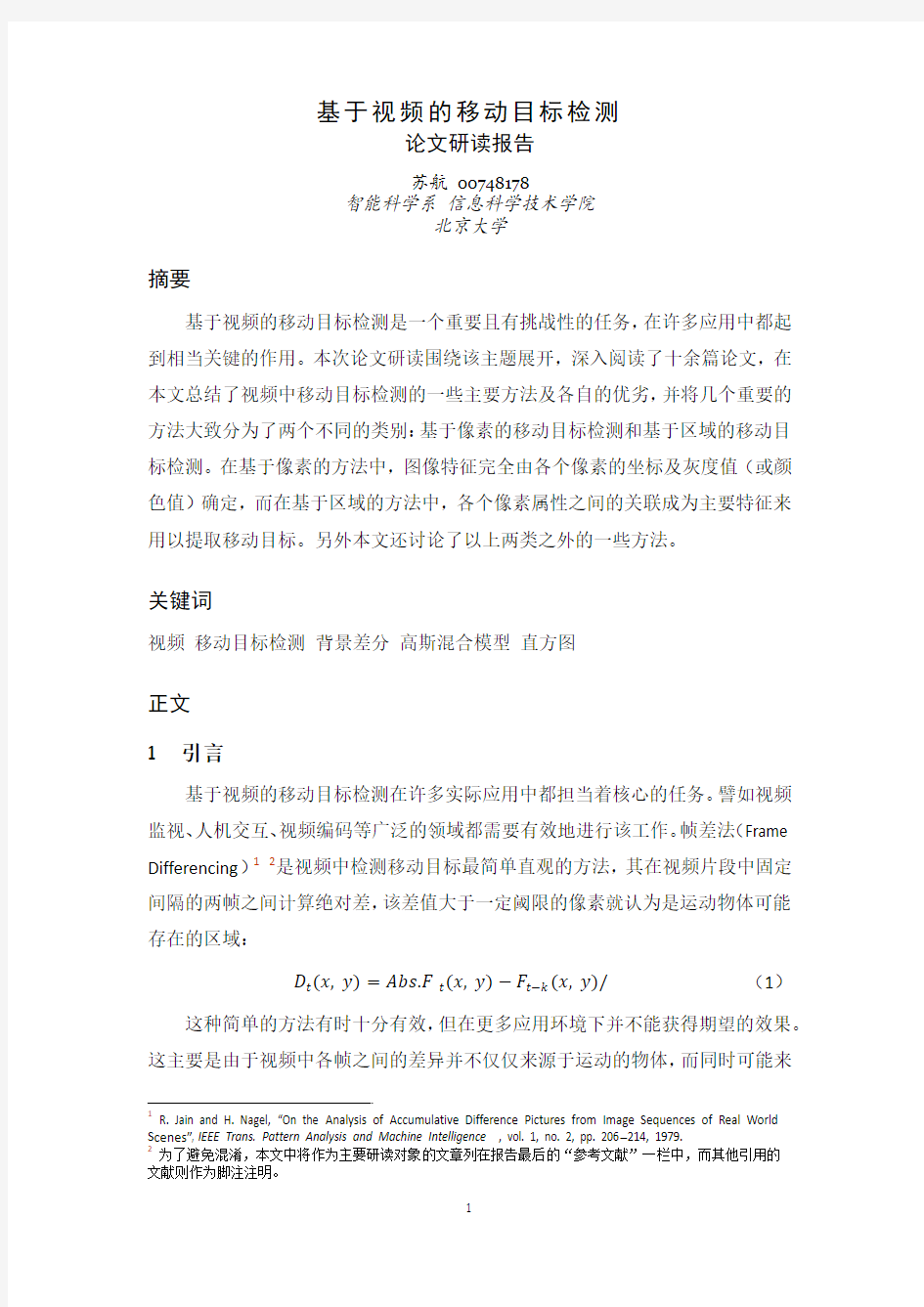

Category Method Author and Time

Simplest Method Frame Differencing Jain and Nagel 1979

Pixel-based Methods Mean-threshold Method Wren et al. 1997

3 Gaussians N Friedman, S Russell 1997 Gaussian Mixture Model(GMM) Stauffer and Grimson 2000 Non-parametric Model Elgammal and Davis 2000

Region-based Methods LBP (texture) Heikkila, M. et al. 2006

Co-occurrence matrices (texture) Luo Di, Huang Xiangnian 2008 Covariance matrices Oncel Tuzel et al. 2006 Accumulated Histogram Fatih Porikli 2005

Other Methods Eigenspace decomposition Oliver et al. 2000 早期提出的移动目标检测方法大都单独地处理各个像素的灰度值或颜色而没有考虑较大尺度上的特征,故称它们为基于像素的方法。典型的方法包括均值-阈限方法、高斯混合模型[1]、非参数模型[2]等。由于这些方法没有充分利用局部像素之间的关系信息,很多有效的图像特征无法得到表示,从而导致移动目标检测精度及效度都受到影响。后期大量的检测方法都不同程度地利用了局部区域层次的信息,称为基于区域的方法。典型的基于区域的方法包括纹理方法[5][6]、直方图方法[7]等。

报告接下来的部分组织如下:第二节介绍一般问题的陈述及典型的应用,第三节与第四节分别介绍基于像素的移动目标检测方法与基于区域的移动目标检测方法,第五节进行简单的讨论与总结。

2 问题陈述及应用

一般而言移动目标检测并不单独地构成应用,而是作为一个组件出现在许多实际的应用之中。故移动目标检测的具体要求随着应用的改变而有很大的不同。例如对足球场上球员及足球的检测与跟踪就和对视频中用户手势的跟踪有所不同,前者的关键在于如何应对复杂的光照变化有效提取运动物体,后者的难点则在于如何从整个躯体大范围的运动背景中将手势的运动识别并提取出来。

尽管不同的应用可能提出不同的技术上的要求,但是相当一部分这类问题还是可以在同一的框架下进行探讨和比较的。以下就是本文讨论范围内一般问题的陈述(Figure1):

a.高层次的模型一般具有检测、跟踪、识别三个模块,其中识别模块并不

必须;

b.检测模块可细分为移动目标区域检测与移动目标分组,其中前者是这个

模块能够顺利工作的保证,其目的是将各帧内移动目标所在的区域标出;

c.该模型的输入为连续的视频,输出为跟踪的物体(即轨迹)或分类的物

体。

Figure1 系统框架

图中即为一个典型的流程图,其中省略了分类模块并把运动目标区域检测规定为背景差分方法。

该模型的典型应用场景是室内\外的视频监视分析(Figure2),特别是交通数据

的分析。另外体育运动视频(如足球或台球)的分析也能在该模型下解决。

Figure2 移动目标检测的典型应用:视频监控

本文讨论的就是这样一个系统之中移动目标检测部分内容,并且将重点放在了如何判定移动目标区域的部分。这是这样的系统中的最初的处理,对于之后的处理能否获得有效的信息至关重要。该内容主要涉及两个问题:如何提取运动的前景,及如何建立一个良好的背景模型。后者一般并不是应用任务中所要求完成的,但往往是用以提取运动前景很好辅助工具,将新的一帧“减去”背景即可获得移动前景,故同时具有这两个步骤的方法也被称为“背景差分”,是移动目标检测中的一大类主流方法,本报告中涉及的大部分方法即属于这一类。

3 基于像素的移动目标检测

3.1 均值-阈限方法

均值-阈限(Figure3)的基本思路是计算每个像素的平均值和标准差作为它的背景模型。

Figure3 均值-阈限方法

图中为某视频中单个像素在一定时间内不断更新得到的平均值和平均差值3,该像素处在天空的位置,在一段时间后有人的手挥过该区域,可以看到由于前景目标明显不如背景中的天空明亮,所以可以很容易将其分辨出来。

实际上均值-阈限方法就是赋予视频中每个像素一个统计上的背景模型,例如高斯分布模型4。每个点需要两个参数来衡量:均值与方差。后面将看到,许多更先进的基于像素的移动目标检测方法其实无非采用了更复杂的分布模型来描述每个像素。

3.2 阴影去除及三高斯模型

简单的帧差值或均值-阈限方法在很多应用中都面临一个很严重的问题:阴影。在某些光照条件下,移动物体产生的阴影相对背景具有非常显著的差别从而被识别成了前景,有时这些阴影比物体本身还大,并且导致原本独立的运动物体连接在一起无法分割。

一种简单的思路是放弃使用灰度值进行背景建模,而采用颜色信息从而将阴影的移动去除掉。这类方法需要一条假设:移动目标投射到路面上的阴影主要改变了该位置的亮度而对色度没有大的影响5。部分情况下确实可以承认该假设。在不同的颜色模型下有不同提取亮度信息的方式。在HSV等空间中这个任务尤为简单,因为亮度本身就是一个独立的分量,所以在该分量以外的维度上进行背景建模与差分就能消除一定的阴影。如果在常用的RGB颜色空间中,亮度的提取就稍微复杂[3]。

Figure4 RGB空间中的亮度与色度

3类似标准差的作用,但是计算更快捷。

4C.R. Wren, A. Azarbayejani, T. Darrell, and A.P. Pentland, “Pfinder: Real-Time Tracking of the Human B ody,” IEEE Trans. Pattern Analysis and Machine Intelligence, vol. 19, no. 7, pp. 780-785, July 1997.

5J. M. Alvarez, A. López, and R. Baldrich, "Illuminant-Invariant Model-Based Road Segmentation", IEEE Intelligent Vehicles Symposium, June 2008.

将一个像素的颜色值在RGB 三维空间中表示(Figure4),背景建模就是确定了穿过原点的一条色度直线,所有在该直线上的颜色都认为是背景色。当前颜色相对参考颜色(背景)的亮度分量αi 由最小化下式给出:

?(αi )=(I i ?αi E i )2 (2)

αi 表示该像素当前值相对参考背景色的相对亮度。如果其值为1则代表亮度相同,大于1代表比背景更亮,小于1代表比背景更暗。

当前颜色到色度直线的垂直距离就表示色度的偏离:

CD i =‖I i ?αi E i ‖ (3)

利用色度与亮度的偏离值就可以将新的颜色值分为四个类别:

M (i )={

Forground: CD i ?>τCD or αi ?>ταlow ,else

Background: αi ?<τα1 and αi ?>τα2, else S adow: αi

?<0, else Hig lig t: ot erwise (4)

其中CD i ?与αi ?分别代表均一化之后的两个偏离分量。

这些方强烈依赖于上面提到的假设:阴影仅仅改变背景亮度而不改变色度。但是这个假设实际上并不总是有效,很多时候还需要更复杂的方法达到去除阴影,鉴别真正移动目标的目的。三高斯模型[4]就是针对去除阴影的考虑提出的。

这个模型中采用三个高斯分布相结合(Figure5)对各像素进行建模。三个高斯成分分别为:道路、运动前景及阴影。这三个成分组合成为了完整的混合模型。

Figure5 三个高斯分布相结合

此方法之后面临的主要问题是如何通过一定时间的学习获得每个高斯分布的参数从而建立有效的模型。相关文献中提出采用EM算法(Expectation Maximization Algorithm)6进行学习。EM算法是一个迭代的算法,通过有限步的迭代就能够获得较好的模型估计。一般而言,为了从一个数据集中获得该数据集满足的混合分布,可以采用最大后验概率估计的方法进行估计,但是这样的方法需要关于每个数据分类的信息(即每个值属于哪个类别)。然而在移动目标检测过程中往往都是无监督的学习从而不可能获得这样的分类信息,而只能自动设定一个预先的分类,然后通过迭代不断改进,这就是EM算法的基本思路。

另外,由于各点的数据是不断改变的,于是采用原始的EM算法对每一帧都进行重复的迭代既不必要也不现实,可以采用EM算法的一个变种:增量EM算法。

3.3 高斯混合模型(GMM)

3.3.1 背景建模

在某些场景之下,采用三个高斯分布的混合模型仍然无法有效地描述复杂的现实环境,于是高斯混合模型[1]被提出了。高斯混合模型采用类似3.2中三个高斯模型的思路,希望采用多个高斯分布相结合的方法来描述环境。与前面的模型不同的是,现在高斯分布的个数不是固定的一个或三个了,而是随着各个像素实际的需要动态地进行设定。另外该方法也放弃采用费时的EM算法而采用更快捷的方式进行背景建模与更新。

假设已知像素(x0,y0)在过去一段时间中的颜色值或灰度值:

{X1,…,X t}=*I(x0,y0,i):1≤i≤t+(5)若由K个高斯分布的高斯混合模型对该像素进行建模,则新观察到一个颜色值或灰度值的概率为:

K

P(X t)=∑ωi, t?η(X t, μi, t, Σi, t)

(6)

i=1

在RGB等彩色空间中为了简化计算可以采用如下公式:

=?k2I(7)

Σ

k,t

6A. Dempster, N. Laird, and D. Rubin, "Maximum Likelihood from Incomplete Data via the EM Algorithm", Journal of the Royal Statistical Society, pp. 1-38, 1977.

这个公式假设了各个颜色分量是相互独立的。尽管事实并不如此,但这样计算在保留充分的精确性的同时大大降低了计算复杂性。

这样每个像素就采用K 个峰的高斯混合模型完成了建模。剩余的问题同样是如何对模型中的各个参数进行估计,以及如何判别前景。

3.3.2 背景更新

背景更新大致有这几个步骤:

a. 每一个新的值都与所有K 个高斯分布进行匹配,直到找到充分吻合的分布(判断方式与均值-阈限方法类似);

b. 若新的值与所有K 个分布都不接近,则将K 个分布中权值最小的一个替换成一个新的分布,该分布以新的值为均值,并且具有很高的初始方差和很低的初始权重;

c. 若新的值与某个分布充分接近,则认为其属于该分布并更新各个分布的权值及参数:

ωk, t =(1?α)ωk, t?1+α?M k, t

(8) μt =(1?ρ)μt?1+ρ?X t

(9) ?t 2=(1?ρ)?t?12+ρ(X t ?μt )T (X t ?μt )

(10) where ρ=α?η(X t |μk , ?k ) (11)

其中(8)式中M k, t 对于匹配上的分布唯1,对于其他分布为0;

α表示适应性的强弱,α越大,给予新的值的权重越大,也就适应得越快;

(9)式(10)式仅针对匹配上的分布,而其他分布的参数保持不表。

3.3.3 前景检测

运动前景的检测主要有以下几个步骤:

a. 对所有的高斯分布按照ω/σ进行从大到小的排序;

b. 取前B 个高斯分布,满足:

B =argmin b (∑ωk >T b

k=1

) (12)

其中T 表示背景应该占的比重,如果T 取得较小则类似于前面介绍的均值-阈限模型,T 取得较大则允许背景有更丰富的特性,如随风摆动的树叶

或水面的波纹等等。

c.如果当前出现的新的值并不符合这B个高斯分布,则认为是运动的前景,

否则认为是背景。

3.4 非参数模型

3.4.1 背景建模

为了能够更快速地适应变化的背景,并且保证对移动物体的敏感性,马里兰大学A. Elgammal等人提出采用非参数的模型[2]对各个像素进行建模。该方法并不指定确切模型形式,而采用核函数来利用历史数据建立模型。在采用高斯核的情况下,一个颜色出现的概率7:

P(x t)=1

N

∑K(x t?x i)

N

i=1

=1

N

∑

1

√2π?j2

?

1

2

.x t j?x i

j

/

2

σj2

d

j=1

N

i=1

(13)

这样实际上就是对考虑范围内所有的历史值都建立一个高斯分布,并利用所有这些分布对当前值进行分析。由于高斯分布的假设,故(x i+1?x i)~N(0,2?2),于是可以估计方差:

?=m

(14)

其中m是|x i+1?x i|的中位数。

另外由于在这种方法下需要大量计算核函数的值,故可以预先计算出一定精度的核函数数据表,通过查表的方法大大加快计算的速度。实验表明这样的方法在一般的PC机上是可以达到实时的计算要求的。

3.4.2 减少错误检测

为了降低由于局部抖动(如树叶抖动、摄像机抖动)带来的错误检测,该方法利用了一定的区域信息。原先的P(x t)现在改用P N(x t)代替:

P N(x t)=max y∈N(x)Pr *x t|B y+(15)此处N(x)指该像素周围的一个小区域,B y指像素y对应的背景模型。这样就充分降低了由于小范围抖动导致的错误检测。

7该式成立仍然需要假设各个颜色分量相互独立。

该方法需要维护两个背景模型:长期模型及短期模型。其中短期的模型是为了能够快速适应变化的背景而提出的,仅利用相当短的一段历史值建立模型,另外该模型采用选择更新机制(仅对判定属于背景的值进行更新);长期的模型在相当长的时间内通过盲更新机制(对所有值进行更新)获得。两个模型判定结果的交集能够进一步降低错误的检测,但同时也去除了部分实际上是移动目标的部分。最终采用的策略为:所有由短期模型检测出来,并且与两个模型判定结果交集相邻的像素被视作运动的前景。

3.4.3 去除阴影

这个方法同样提到了去除阴影的问题(Figure6)。

采用RGB颜色模型的一个变种

r=

R

R+G+B

,g=

G

R+G+B

,b=

B

R+G+B

, (16)s=R+G+B(17)

令A为某个像素在一定时间内的取值,而定义B如下:

B=*x i|x i∈A?α≤s t

s i

≤β+(18)其含义就是该像素过去的背景取值中与当前值亮度接近的值的集合

利用B中的值在(r, g)二维空间上进行上述的背景建模及前景检测,就能很有效地消除检测的阴影。

Figure6 非参数模型下的阴影去除

4 基于区域的移动目标检测

从上面的介绍的方法来看,建立的背景模型越来越复杂:高斯分布的个数从一个到三个,再到K个,再到每个历史值各一个。这样的背景模型已经具有了高度的复杂性,但是在有些应用环境下效果仍然并不理想。反思一下这些方法的特点,仅仅利用各个像素的独立信息而没有考虑像素之间的关联性是关键的原因。其实在3.4.2中采用方法实际上已经开始尝试以局部区域作为考虑问题的范围,

并且很好地提高算法的检测能力。针对这个方面考虑,应该采用基于区域信息的方法对背景进行建模,下面就针对几个典型的基于区域的方法进行介绍。

4.1 LBP纹理

基于区域的检测中很大一类方法都是利用图像的纹理信息来提取有效的运动物体的。此时用何种方法来提取并表示纹理特征称为关键的问题。LBP(Local Binary Pattern, Figure7)[5]即为一种简单有效的纹理提取及表示方式。

LBP是一种优秀的纹理特征描述子,它将一幅图像中各个像素周围的像素与中心像素做差,并将差值表示为一个二进制数列(Binary Pattern)。最初提出的LBP仅仅考虑了一个像素周围的8个像素8,然而其定义可以很容易地扩展到任意圆周范围内任意多个像素:

LBP P, R(x c, y c)=∑s(g p?g c)2p

P?1

p=0

, (19)

s(x)={1x≥0

0x<0

(20)

Figure7 Local Binary Pattern

若仅仅有这样一个二进制串来表示表示中心点的纹理,这样的特征过于简陋而很难有效地区分各个位置的纹理。实际上采用的方法是在一定大小的区域内对各个像素的LBP进行计算并生成关于LBP特征的直方图,以该直方图作为该区域中心点的纹理特性。

有了这样一个对各个点纹理的良好表达,剩下的部分可以完全采用与之前相同的方式。最流行的方法还是GMM中采用的背景更新和前景提取的方法:

m k

????? =αb ?+(1?αb)m k

????? , αb∈,0,1-,(21)

8T. Ojala, M. Pietika¨inen, and D. Harwood, “A Comparative Study of Texture Measures with Classification Based on Feature Distributions,” Pattern Recognition, vol. 29, no. 1, pp. 51-59, 1996.

ωk =αωM k +(1?αω)ωk , αω∈,0,1-, (22)

ω0+ω1+?+ωB?1>T B , T B ∈,0,1-, (23)

(21)~(24)式与标准的GMM 模型中的从形式与内涵上均一致。需要注意的是,现在每个像素的特征采用直方图的结构表示,故需要定义一种方式来衡量两个直方图之间的相似程度。可采用两个直方图的交(即相同成分的计数)来衡量该相似程度:

?(a , b

? )=∑min (a n , b n )N?1

n=0

, (24) 4.2 Co-Occurrence Matrices

正如前面提到的,基于区域的方法的关键在于如何找到良好的描述纹理特征的描述子。Co-Occurrence Matrices [6]也是这样一种描述纹理的描述子。

图像中每个像素的纹理特征由一个m x n 的矩阵表示,称之为Co-Occurrence Matrix 。其表示以该像素为中心的m x n 的区域内的纹理信息:

C (i,j )=∑∑{1, if I (p,q )=i and I (p +Δx,q +Δy )=j 0, ot erwise m

q=1n p=1 (25) 这实际上就是对该区域中各种偏移模式进行统计,并利用该矩阵对这些统计数据进行一致的描述。

基于Co-Occurrence Matrices 的移动目标检测完全可以套用GMM 模型中的背景建模方式,只需要类似(24)定义两个矩阵之间相似程度的衡量标准即可。

另外也可以通过计算该矩阵的一些统计信息来作为区域特性的衡量:

Energy: ∑∑C 2(i,j )j

i , (26)

Entropy: ?∑∑C (i,j )log C (i,j )j

i , (27)

Contrast: ∑∑(i,j)2C (i,j )j

i , (28)

Inverse Difference Moment: ∑∑C(i,j)|i ?j|2

,i ≠j j

i , (29) 其中能量表示纹理的一致性,当图像具有较强的周期性时能量值较高;熵衡

量的是图像的无序性;对比度衡量的是图像局部的变化程度;而逆差异距衡量图像的同质性。

利用这些统计特征,不仅可以有效地提取移动目标,还可以充当去除阴影的工具。(Figure8)

对于初步识别为前景的像素,计算其当前特征与背景特征的相似度: Sim =Eng ×Eng +Ent ×Ent +Con ×Con +Inv ×Inv I 2I 2I 2I 2B 2B 2B 2B 2(30)

若Sim 小于某个阈值,则重新将该像素划为背景而不计入运动物体的范围。

Figure8 Co-Occurrence Matrices 方法中的阴影检测 另外,后期对移动物体进行跟踪时也能采用该相似度:在连续帧之间进行计算,从而判断当前帧内的移动物体与先前帧内移动物体的对应关系。

4.3 直方图方法

采用类似LBP 方法中的思路,可以直接以灰度值或颜色值的直方图作为特征进行移动目标的检测[7]。

在自然的环境下,每个像素的可见性与颜色快速地变化。为了能够获得较稳定的直方图,该方法中抛弃采用区域特征代表像素行为的思路,而本身就以小的区域作为最小的单元进行背景建模与移动目标的检测。可以看出最终的检测结果也是以一定大小的区域为基本单位的。(Figure9)

Figure9 直方图方法

与3.4中非参数方法类似,该方法也引入两种类型的直方图:短时间直方图与长时间直方图。当有移动目标进入一个区域时,该区域的短时间直方图形状有较大的变化,而长时间的直方图则基本维持原先的形状。(Figure10)这样通过计算两个直方图之间的差异大小就能够判断该区域当前是否有移动目标出现。

Figure10 两帧各自的短时间直方图(上)与长时间直方图(下)

剩下来的问题就是如何计算两个直方图之间的相似程度。可以采用 4.1节LBP 纹理法中取交集的方法,也可以采用其他的方法。

下面介绍另外一个较快速且有效的方法。

将长时间直方图H L t (i,j )与短时间直方图H S t (i,j )之间的关联表述为:

C t (i,j )=max,C 1t (i,j ),C 2t (i,j )- (31)

其中C 1t (i,j )与C 2t (i,j )分别定义如下:

C 1t (i,j )=max ?dδ≤δ<0K 1(δ) (32)

C 2t (i,j )=max 0≤δ≤dδK 2(δ) (33)

其中K 1(δ)与K 2(δ)分别是:

K 1(δ)=∑H t (i,j ),

l

?δ-H t (i,j ),l -255+δl=0

√∑H S t (i,j ),l ?δ-2255+δl=0√∑H L t (i,j ),l-2255+δl=0(34)

K2(δ)=

∑H t(i,j),l?δ-H t(i,j),l-

255+δ

l=0

√∑H S t(i,j),l?δ-2

255

l=δ

√∑H L t(i,j),l-2

255

l=δ

(35)

C t(i,j)只是两个直方图之间关联度的衡量指标,具体进行背景更新及前后景判别还需要一些技术上的处理(Figure11),这里不详细介绍。

Figure11 直方图方法详细流程

4.4 Covariance Matrices

针对移动目标检测的各种像素级、区域级特征不断被提出,它们各有各的优缺点。如何能够设计一种特征将这些特征统一地结合在一起,从而充分利用各自的优势显得非常有意义。

一种简单的思路是用几种特征组成特征向量,并利用该向量作为各个像素的特征[8][9]:

f k=[x,y,I(x,y),LBP(x,y),|I x(x,y)|,|I y(x,y)|],(36)其中各元素依次为:两个空间坐标,Local Binary Pattern, 两个方向的梯度;将M X N的区域用该向量的协方差矩阵表示:

C R=

1

MN

∑(f k?μR)(f k?μR)T

MN

k=1

,(37)

采用协方差矩阵作为区域的描述子具有很多方面的优势:首先个别样本的噪声在平均的处理中被过滤掉;另外协方差矩阵对于整体均值的偏移不敏感,这在亮度变化的环境下十分重要;而且协方差矩阵使得各种特征之间的相互关系非常明确,从而能够帮助用户选择最有效的特征;最后,协方差矩阵可以通过Integral Image Representation9进行非常快速的计算。

为了能够再次利用GMM模型中背景更新及前景检测的方法,需要定义两个协方差矩阵之间差异的衡量指标:

ρ(A,B)=√∑ln2λi(A,B)

d

i=1

,(38)

其中*λi(A,B)+i=1,…,d为两个协方差矩阵之间的广义特征值10(Generalized Eigenvalues)。接下来的背景更新与前景检测与GMM模型相同,不再重复。

5 讨论及总结

基于视频的移动目标检测是一个十分重要且有挑战性的课题。其成功的关键是选取有效可行的特征对像素或区域进行描述。一般采用的特征有:灰度值(或颜色值),纹理(LBP,Co-Occurrence矩阵等),直方图;另外还可以将数个特征结合在一起使用(Covariance矩阵)。在选择了合适的特征之后,如何进行背景建模及前景检测也对实际结果有很大的影响。目前普遍采用的往往是最简单的均值-阈限方法或者GMM模型。

本报告并没有覆盖移动目标检测的所有方法,而注重处理一类较常见的应用环境(见第二节)。另外本报告介绍的方法大都属于“背景差分”类型,实际上

9O. Tuzel, F. Porikli, and P. Meer. Region, “Covariance: A Fast Descriptor for Detection and C lassification”, Proc. European Conf. Computer Vision, pages 589–600, 2006.

10W. Forstner and B. Moonen, “A Metric for Covariance M atrices”, Technical report, Dept. of Geodesy and Geoinformatic, Stuttgart University, 1999.

还有很多别的方法可用于视频中移动目标的检测,而这也就在基于像素以及基于区域的分类体系之外。例如利用“特征图”的方法[10]采用了PCA算法构建整个画面的背景模型,也能够在实际运用中达到良好的效果。

基于视频的移动目标有多种多样的应用环境,不同的应用环境有不同的需求与难点,往往需要采用迥然不同的方法。充分了解已有的各种方法及它们各自的优劣,有利于设计者为具体的应用环境设计出切实可行且高效的方法。

参考文献

[1] C. Stauffer and W. E. L. Grimson, "Learning Patterns of Activity Using Real-Time Tracking",

IEEE Trans. Pattern Analysis and Machine Intelligence, vol. 22, no. 8, August 2000.

[2] A. Elgammal, D. Harwood, and L. Davis, “Non-Parametric Model for Background Subtraction”,

Proc. European Conf. Computer Vision, vol. 2, pp. 751-767, June 2000.

[3]T. Hoprasert, D. Harwood, and L. S. Davis, "A Statistical Approach for Real-Time Robust

Background Subtraction and Shadow Detection," Proc. the 7th IEEE International Conf.

Computer Vision, Frame Rate Workshop, pp. 1-19, September 1999.

[4]N. Friedman, and S. Russell, "Image Segmentation in Video Sequences: A Probabilistic

Approach", the Thirteenth Conference on Uncertainty in Artificial Intelligence, 1997.

[5] M. Heikkil? and M. Pietik?inen, "A Texture-Based Method for Modeling the Background and

Detecting Moving Objects", IEEE Trans. Pattern Analysis and Machine Intelligence, vol. 28, no.

4, April 2006.

[6] D. Luo, "Texture Analysis for Shadow Removing and Tracking of Vehicle in Traffic Monitoring

System", Proc. International Symposium on Intelligent Information Technology Application Workshops, pp. 863-866, 2008.

[7]K. Onoguchi, “Moving Objec t Detection Using a Cross Correlation between a Short

Accumulated Histogram and a Long Accumulated Histogram”, Proc. IEEE 18th International Conf. Pattern Recognition, vol. 4, pp. 896-899, August 2006.

[8]S. Zhang, H. Yao, S. Liu, X. Chen, and W. Gao, "A Covariance-based Method for Dynamic

Background Subtraction", IEEE International Conf. Pattern Recognition, 2008.

[9]O. Tuzel, F. Porikli, and P. Meer, "Region Covariance: A Fast Descriptor for Detection and

Classification", Proc. 9th European Conf. Computer Vision, vol. 2, pp. 589–600, 2006.

[10]N. M. Oliver, B. Rosario, and A. P. Pentland, "A Bayesian Computer Vision System for

Modeling Human Interactions", IEEE Trans. Pattern Analysis and Machine Intelligence, vol.

22, no. 8, August 2000.

视频中的行人检测(新)

山东建筑大学 课程设计说明书 题目:视频监控中行人的检测课程:数字图像处理课程设计院(部):信息与电气工程学院 专业:电子信息工程 班级:电信111 学生姓名: 学号: 指导教师: 完成日期:

目录 摘要 ............................................................................................................................................. II 一、绪论 (1) 1.1 研究背景与意义 (1) 1.2 智能视频监控概述 (2) 1.2.1 智能视频监控的发展 (2) 1.2.2 智能视频监控的研究内容 (3) 1.3 行人检测与跟踪 (3) 1.3.1 行人检测 (3) 1.3.2 行人跟踪 (4) 二、设计原理 (5) 2.1 图像处理基础 (5) 2.1.1 颜色空间 (5) 2.1.2 图像预处理 (7) 2.1.3 形态学方法 (7) 2.2 运动目标检测方法 (8) 2.2.1 背景差分法 (8) 2.2.2光流法 (9) 2.2.3边缘检测方法 (10) 2.4 本章小结 (10) 三、设计内容 (11) 3.1背景减法运动目标检测 (11) 3.2阈值的选取 (11) 3.3形态学滤波 (12) 3.4设计方案流程图 (14) 四、实验结果分析及总结 (16) 4.1试验结果 (16) 4.2实验结果分析 (16) 五、参考文献 (17) 致谢 (18) 附录 (19)

摘要 智能视频监控是计算机视觉领域新兴的研究方向,它通过对摄像机拍摄的视频图像序列进行自动分析来对被监控场景中的事物变化进行定位、跟踪和识别,并以此对相关目标的行为进行分析和判别,在实现了日常管理工作的同时又能对目标的异常行为做出及时反应。行人目标检测与跟踪算法是智能视频监控系统中的核心问题,研究相关算法对于提高智能视频监控系统的性能具有重要的意义。本文在熟悉和掌握了有关数字图像处理原理和技术的基础上,分析对比了常用的目标检测和跟踪方法,针对不同条件下的行人目标检测和跟踪进行了研究。本文完成的主要研究工作是对监控视频中行人目标的检测,为以后的行人跟踪和行人行为的分析打下基础。 本设计以Matlab为平台,利用背景减法,和形态学滤波的方法检测视频中的行人。实验结果表明,本模块能够检测一般静态背景条件下的行人目标,满足了实际应用的初步要求。 关键词:视频监控、行人检测、背景减法、形态学滤波

目标检测综述教学内容

一、传统目标检测方法 如上图所示,传统目标检测的方法一般分为三个阶段:首先在给定的图像上选择一些候选的区域,然后对这些区域提取特征,最后使用训练的分类器进行分类。下面我们对这三个阶段分别进行介绍。 (1) 区域选择这一步是为了对目标的位置进行定位。由于目标可能出现在图像的任何位置,而且目标的大小、长宽比例也不确定,所以最初采用滑动窗口的策略对整幅图像进行遍历,而且需要设置不同的尺度,不同的长宽比。这种穷举的策略虽然包含了目标所有可能出现的位置,但是缺点也是显而易见的:时间复杂度太高,产生冗余窗口太多,这也严重影响后续特征提取和分类的速度和性能。(实际上由于受到时间复杂度的问题,滑动窗口的长宽比一般都是固定的设置几个,所以对于长宽比浮动较大的多类别目标检测,即便是滑动窗口遍历也不能得到很好的区域) (2) 特征提取由于目标的形态多样性,光照变化多样性,背景多样性等因素使得设计一个鲁棒的特征并不是那么容易。然而提取特征的好坏直接影响到分类的准确性。(这个阶段常用的特征有SIFT、HOG等) (3) 分类器主要有SVM, Adaboost等。 总结:传统目标检测存在的两个主要问题: 一是基于滑动窗口的区域选择策略没有针对性,时间复杂度高,窗口冗余; 二是手工设计的特征对于多样性的变化并没有很好的鲁棒性。 二、基于Region Proposal的深度学习目标检测算法 对于传统目标检测任务存在的两个主要问题,我们该如何解决呢? 对于滑动窗口存在的问题,region proposal提供了很好的解决方案。region

proposal(候选区域)是预先找出图中目标可能出现的位置。但由于region proposal 利用了图像中的纹理、边缘、颜色等信息,可以保证在选取较少窗口(几千个甚至几百个)的情况下保持较高的召回率。这大大降低了后续操作的时间复杂度,并且获取的候选窗口要比滑动窗口的质量更高(滑动窗口固定长宽比)。比较常用的region proposal算法有selective Search和edge Boxes,如果想具体了解region proposal可以看一下PAMI2015的“What makes for effective detection proposals?” 有了候选区域,剩下的工作实际就是对候选区域进行图像分类的工作(特征提取+分类)。对于图像分类,不得不提的是2012年ImageNet大规模视觉识别挑战赛(ILSVRC)上,机器学习泰斗Geoffrey Hinton教授带领学生Krizhevsky使用卷积神经网络将ILSVRC分类任务的Top-5 error降低到了15.3%,而使用传统方法的第二名top-5 error高达26.2%。此后,卷积神经网络占据了图像分类任务的绝对统治地位,微软最新的ResNet和谷歌的Inception V4模型的top-5 error降到了4%以内多,这已经超越人在这个特定任务上的能力。所以目标检测得到候选区域后使用CNN对其进行图像分类是一个不错的选择。 2014年,RBG(Ross B. Girshick)大神使用region proposal+CNN代替传统目标检测使用的滑动窗口+手工设计特征,设计了R-CNN框架,使得目标检测取得巨大突破,并开启了基于深度学习目标检测的热潮。 1. R-CNN (CVPR2014, TPAMI2015) (Region-based Convolution Networks for Accurate Object d etection and Segmentation)

【CN109919979A】一种视频实时目标跟踪的方法【专利】

(19)中华人民共和国国家知识产权局 (12)发明专利申请 (10)申请公布号 (43)申请公布日 (21)申请号 201910174796.5 (22)申请日 2019.03.08 (71)申请人 广州二元科技有限公司 地址 510000 广东省广州市南沙区银锋一 街1号银锋广场1栋1608房 (72)发明人 容李庆 关毅 袁亚荣 (74)专利代理机构 广州凯东知识产权代理有限 公司 44259 代理人 罗丹 (51)Int.Cl. G06T 7/246(2017.01) G06K 9/00(2006.01) G06K 9/32(2006.01) (54)发明名称 一种视频实时目标跟踪的方法 (57)摘要 本发明涉及一种视频实时目标跟踪的方法, 采用目标检测与目标跟踪相结合的技术,极大地 降低视频实时目标检测的计算量,由于无需对每 一帧视频图像进行遍历检测,因此极大地提高了 视频实时目标检测的计算效率,可以达到实时视 频的帧率。本发明提供的视频实时目标跟踪的方 法使用神经网络对目标检测器检测出来的目标 框在下一帧图像中的位置进行跟踪回归,极大地 降低了视频实时目标检测的计算量,无需对每一 帧图像都采用检测器检测目标,采用检测与跟踪 相结合的技术应用于视频实时目标检测中,无需 对输入图像进行复杂的降噪等处理,对目标检测 器也无特殊需求,可以大大提升检测的速率,本 发明适用性广,可以在低端的嵌入式设备中保证 足够的计算效率。权利要求书1页 说明书2页 附图1页CN 109919979 A 2019.06.21 C N 109919979 A

权 利 要 求 书1/1页CN 109919979 A 1.一种视频实时目标跟踪的方法,其特征在于包括以下步骤: 1)、通过硬件设备摄像头采集实时的视频作为输入,或者直接输入包含多帧的视频文件; 2)、分解视频,以单帧为单位对视频进行分解; 3)、将不同的数字图像矩阵格式转化为目标检测器支持的数字图像矩阵格式; 4)、输入1帧数字图像矩阵到目标检测器中,检测器通过计算后返回的检测结果以数组的方式进行保存,数组的长度是检测到的目标数量大小; 5)、根据当前输入帧获得的目标检测框作为下一帧图像的目标基础框,采用神经网络对当前帧目标框在下一帧图像的位置进行回归计算,得到下一帧图像的目标检测框信息,如果下一帧检测框信息不为空,则在接下来的帧图像中循环执行当前步骤;若下一帧目标框信息为空,则跳转到步骤4对接下来的帧图像重新调用目标检测器进行目标检测直到视频帧处理结束。 2.根据权利要求1所述的一种视频实时目标跟踪的方法,其特征在于: 所述步骤3)在步骤1)输入视频的时候进行统一的转换。 2

动态视频目标检测和跟踪技术(入门)

动态视频目标检测和跟踪技术 传统电视监控技术只能达到“千里眼”的作用,把远程的目标图像(原始数据)传送到监控中心,由监控人员根据目视到的视频图像对现场情况做出判断。智能化视频监控的目的是将视频原始数据转化为足够量的可供监控人员决策的“有用信息”,让监控人员及时全面地了解所发生的事件:“什么地方”,“什么时间”,“什么人”,“在做什么”。将“原始数据”转化为“有用信息”的技术中,目标检测与跟踪技术的目的是要解决“什么地方”和“什么时间”的问题。目标识别主要解决“什么人”或“什么东西”的问题。行为模式分析主要解决“在做什么”的问题。动态视频目标检测技术是智能化视频分析的基础。 本文将目前几种常用的动态视频目标检测方法简介如下: 背景减除背景减除(Background Subtraction)方法是目前运动检测中最常用的一种方法,它是利用当前图像与背景图像的差分来检测出运动目标的一种技术。它一般能够提供相对来说比较全面的运动目标的特征数据,但对于动态场景的变化,如光线照射情况和外来无关事件的干扰等也特别敏感。实际上,背景的建模是背景减除方法的技术关键。最简单的背景模型是时间平均图像,即利用同一场景在一个时段的平均图像作为该场景的背景模型。由于该模型是固定的,一旦建立之后,对于该场景图像所发生的任何变化都比较敏感,比如阳光照射方向,影子,树叶随风摇动等。大部分的研究人员目前都致力于开发更加实用的背景模型,以期减少动态场景变化对于运动目标检测效果的影响。 时间差分时间差分(Temporal Difference 又称相邻帧差)方法充分利用了视频图像的特征,从连续得到的视频流中提取所需要的动态目标信息。在一般情况下采集的视频图像,若仔细对比相邻两帧,可以发现其中大部分的背景像素均保持不变。只有在有前景移动目标的部分相邻帧的像素差异比较大。时间差分方法就是利用相邻帧图像的相减来提取出前景移动目标的信息的。让我们来考虑安装固定摄像头所获取的视频。我们介绍利用连续的图像序列中两个或三个相邻帧之间的时间差分,并且用阈值来提取出视频图像中的运动目标的方法。我们采用三帧差分的方法,即当某一个像素在连续三帧视频图像上均有相

目标检测方法简要综述

龙源期刊网 https://www.360docs.net/doc/8319066183.html, 目标检测方法简要综述 作者:栗佩康袁芳芳李航涛 来源:《科技风》2020年第18期 摘要:目标检测是计算机视觉领域中的重要问题,是人脸识别、车辆检测、路网提取等领域的理论基础。随着深度学习的快速发展,与基于滑窗以手工提取特征做分类的传统目标检测算法相比,基于深度学习的目标检测算法无论在检测精度上还是在时间复杂度上都大大超过了传统算法,本文将简单介绍目标检测算法的发展历程。 关键词:目标检测;机器学习;深度神经网络 目标检测的目的可分为检测图像中感兴趣目标的位置和对感兴趣目标进行分类。目标检测比低阶的分类任务复杂,同时也是高阶图像分割任的重要基础;目标检测也是人脸识别、车辆检测、路网检测等应用领域的理论基础。 传统的目标检测算法是基于滑窗遍历进行区域选择,然后使用HOG、SIFT等特征对滑窗内的图像块进行特征提取,最后使用SVM、AdaBoost等分类器对已提取特征进行分类。手工构建特征较为复杂,检测精度提升有限,基于滑窗的算法计算复杂度较高,此类方法的发展停滞,本文不再展开。近年来,基于深度学习的目标检测算法成为主流,分为两阶段和单阶段两类:两阶段算法先在图像中选取候选区域,然后对候选区域进行目标分类与位置精修;单阶段算法是基于全局做回归分类,直接产生目标物体的位置及类别。单阶段算法更具实时性,但检测精度有损失,下面介绍这两类目标检测算法。 1 基于候选区域的两阶段目标检测方法 率先将深度学习引入目标检测的是Girshick[1]于2014年提出的区域卷积神经网络目标检测模型(R-CNN)。首先使用区域选择性搜索算法在图像上提取约2000个候选区域,然后使用卷积神经网络对各候选区域进行特征提取,接着使用SVM对候选区域进行分类并利用NMS 回归目标位置。与传统算法相比,R-CNN的检测精度有很大提升,但缺点是:由于全连接层的限制,输入CNN的图像为固定尺寸,且每个图像块输入CNN单独处理,无特征提取共享,重复计算;选择性搜索算法仍有冗余,耗费时间等。 基于R-CNN只能接受固定尺寸图像输入和无卷积特征共享,He[2]于2014年参考金字塔匹配理论在CNN中加入SPP-Net结构。该结构复用第五卷积层的特征响应图,将任意尺寸的候选区域转为固定长度的特征向量,最后一个卷积层后接入的为SPP层。该方法只对原图做一

目标跟踪相关研究综述

Artificial Intelligence and Robotics Research 人工智能与机器人研究, 2015, 4(3), 17-22 Published Online August 2015 in Hans. https://www.360docs.net/doc/8319066183.html,/journal/airr https://www.360docs.net/doc/8319066183.html,/10.12677/airr.2015.43003 A Survey on Object Tracking Jialong Xu Aviation Military Affairs Deputy Office of PLA Navy in Nanjing Zone, Nanjing Jiangsu Email: pugongying_0532@https://www.360docs.net/doc/8319066183.html, Received: Aug. 1st, 2015; accepted: Aug. 17th, 2015; published: Aug. 20th, 2015 Copyright ? 2015 by author and Hans Publishers Inc. This work is licensed under the Creative Commons Attribution International License (CC BY). https://www.360docs.net/doc/8319066183.html,/licenses/by/4.0/ Abstract Object tracking is a process to locate an interested object in a series of image, so as to reconstruct the moving object’s track. This paper presents a summary of related works and analyzes the cha-racteristics of the algorithm. At last, some future directions are suggested. Keywords Object Tracking, Track Alignment, Object Detection 目标跟踪相关研究综述 徐佳龙 海军驻南京地区航空军事代表室,江苏南京 Email: pugongying_0532@https://www.360docs.net/doc/8319066183.html, 收稿日期:2015年8月1日;录用日期:2015年8月17日;发布日期:2015年8月20日 摘要 目标跟踪就是在视频序列的每幅图像中找到所感兴趣的运动目标的位置,建立起运动目标在各幅图像中的联系。本文分类总结了目标跟踪的相关工作,并进行了分析和展望。

多个目标的实时视频跟踪的先进的算法

2008 10th Intl. Conf. on Control, Automation, Robotics and Vision Hanoi, Vietnam, 17–20 December 2008 多个目标的实时视频跟踪的先进的算法 1110200210俞赛艳 Artur Loza Department of Electrical and ElectronicEngineering University of Bristol Bristol BS8 1UB, United Kingdom artur.loza@https://www.360docs.net/doc/8319066183.html, Miguel A. Patricio, Jes′us Garc′?a, and Jos′e M. Molina Applied Artificial Intelligence Group (GIAA) Universidad Carlos III de Madrid 28270-Colmenarejo, Spain mpatrici,jgherrer@inf.uc3m.es, molina@ia.uc3m.es 摘要——本文调查了用组合和概率的方法来实现实时的视频目标跟 踪。特殊兴趣是真实世界的场景,在这场景里.多目标和复杂背景构成对非平凡的自动追踪者的挑战。在一个规范的监控视频序列里,对象跟踪是以组合数据协会和粒子过滤器为基础,通过选择完成视觉跟踪技术实现的。以详细的分析性能的追踪器测试的优点为基础,已经确定了互补的失效模式和每种方法的计算要求。考虑到获得的结果,改善跟踪性能的混合策略被建议了,为不同追踪方法带来了最好的互补特性。 关键字--概率、组合、粒子过滤器、跟踪、监视、实时、多个目标. 1、介绍 最近人们对通过单个摄像机或一个网络摄像头提供来跟踪视频序列增加了兴趣。在许多监测系统中,可靠的跟踪方法至关重要的。因为它们使运营商在远程监控感兴趣的领域,增加对形势感知能力和帮助监测分析与决策过程。跟踪系统可以应用在一个广泛的环境如:交通系统、公共空间(银行、购物)购物中心、停车场等)、工业环境、政府或军事机构。跟踪的对象通常是移动的环境中的一个高可变性。这需要复杂的算法对视频采集,相机校正、噪声过滤、运动检测,能力学习和适应环境。因为它的情况往往现实场景,系统也应该能够处理多个目标出现在现场。 为了实现强大的和可靠的多个跟踪目标,,各种各样的问题,具体到这种场景,都必须加以解决。不仅要解决状态估计问题,而且还必须使执行数据联合运行得准确,特别是当多目标交互存在时。早期多个对象跟踪的工作,关注于一个固定的数字的目标,但是人们已经认识到,很有必要解释新出现的目标以及消失的目标造成的变量数量及多个轨道数量,具有相当良好的间隔。这是典型的用扩展状态估计框架联合跟踪所有检测目标[4]。联合跟踪目标[6],避免使用几个独

交通视频中几种目标检测算法的应用研究

交通视频中几种目标检测算 法的应用研究 运动目标检测是视频处理中一个重要的研究方向,它主要目的是在视频中提取出运动目标,为后来的处理打下基础。运动目标检测是后期对目标进行分析、处理必不可少的部分,是视频监控的基础。通常我们获取的视频图像中包含前景目标和背景图像,前景一般是指运动的目标,背景一般是指静止的环境。当今比较流行的运动目标检测方法主要包括背景差分、帧间差分、混合高斯模型等方法。 1 背景差分法 1.1 算法原理和实验 背景差分是指选取特定帧作为背景图像,以当前帧减去背景帧来检测目标,是比较常用的一种方法。如公式(1)和(2)所示。(,)f x y 表示读取的一帧图像, (,)b x y 表示背景图像,d(,)x y 表示每个像 素点差值的绝对值,(,)v x y 表示二值化处理后的值,t 表示阈值。 d(,)(,)(,)(1) x y f x y b x y =|-| 1,(,)t 0,(,)(,)(2)d x y d x y t v x y ≥ <={ 流程图 实验: 1.2对背景差分的改进 背景差分法是一种比较简单实用的方法,但在交通视频中,实际道路的背景不是一成不变的,比如背景树叶随风摆动以及下雨天气等,背景选取非常重要,在每次选取背景时,采取均值法能更好地接近真实背景,减少背景的随机性带来的问题。如公示(3) 所示。 1 (,)=(,)n k k b x y b x y =∑

2帧间差分法 流程图 2 帧间差分法 2.1 算法原理和实验 的轮廓,是一种比较实用和简单的方法,如公式4所表示。 1(,)(,)(,)k k d x y f x y f x y -=|-| (4) 流程图如 1,(,)t 0,(,)(,)(5)d x y d x y t v x y ≥ <={ 2.2 三帧差分法 帧间差分法也存在着一些缺陷,比如运动目 3高斯模型法 3.1算法原理和实验 高斯模型就是用高斯概率密度函数精 确地量化事物,将一个事物分解为若干的基于高斯概率密度函数形成的模型。对图像背景建立高斯模型的原理及过程:图像灰度直方图反映的是图像中某个灰度值出现的频次,也可以以为是图像灰度概率密度的估计。如果图像所包含的目标区域和背景区域相差比较大,那么该图像的灰度直方图呈现双峰-谷形状,其中一个峰对应于目标,另一个峰对应于背景的中心灰度。对于复杂的图像,尤其是医学图像,一般是多峰的。通过将直方图的多峰特性看作是多个高斯分布

视频图像中运动目标检测方法研究

视频图像中运动目标检测方法研究

毕业论文 题目视频图像中运动目标检测 方法研究

摘要 在很多现代化领域,运动目标检测都显示出了其重要的作用。尤其是近二十年的社会经济的飞速发展,运动目标检测都彰显了其重要性,在航空、通信、航海等各个方面都有关键性的作用,从而使运动目标检测方法的研究成为各国的研究热门课题。 通过阅读大量的相关论文、期刊及其网络资源,了解了高斯背景建模及背景更新的基本原理及思想。在本文中,首先介绍了运动目标检测方法的相关基础知识,如图像的二值化、图像的形态学处理、颜色空间模型。然后重点说明了三种常用的运动目标检测方法的研究,简要阐述了三种研究方法的基本思想。在老师的帮助下进行了相应的实验,最终得出了三种运动目标检测方法的优点和缺点,着重探究了高斯背景建模及其背景更新基本原理及思想。 最后,通过相关的程序及软件对混合高斯背景模型进行了相关的实验,进而发现了混合高斯背景建模算法存在的不足之处,如:高斯背景建模的计算量大、运动目标较大时检测效果差等问题,并对对这些问题提出了相关设想及改进。 关键词:运动目标检测;二值化;图像的形态学处理;高斯背景建模;背景更新 I

ABSTRACT In many modern fields, moving target detection are showing its important role. Especially nearly twenty years of rapid development of social economy, the moving target detection has shown its importance, in various aviation, communication, navigation and so on have a key role, so the study of moving target detection method has become a research hot topic in countries. By reading relevant papers, a large number of journals and cyber source, understand the basic principle and thought of Gauss background modeling and updating the background. In this paper, firstly introduces the basic knowledge of moving target detection method, such as the two values image, morphological image processing, color space model. Then focus on the study of three methods used for moving object detection, a brief description of the basic ideas of the three kinds of research methods. By the experiment, the results of three kinds of method of moving target detection has advantages and disadvantages, this paper emphatically explores Gauss background modeling and background updating basic principle and thought. Finally, through the program and software related to mixed Gauss background model for the relevant experiments, and found the shortcomings, the presence of mixed Gauss background modeling algorithm such as: the problem of computing Gauss background modeling, moving target volume larger detection effect is poor, and on these problems put forward relevant ideas and improvement. Keywords: moving object detection; two values; I I

视频图像中运动目标检测

视频图像中运动目标检测

毕业论文 题目视频图像中运动目标检测 方法研究 专业电气工程及其自动化 班级电气1003 学生曹文 学号20113024543 指导教师赵哥君 二〇一二年六月八日

摘要 在很多现代化领域,运动目标检测都显示出了其重要的作用。尤其是近二十年的社会经济的飞速发展,运动目标检测都彰显了其重要性,在航空、通信、航海等各个方面都有关键性的作用,从而使运动目标检测方法的研究成为各国的研究热门课题。 通过阅读大量的相关论文、期刊及其网络资源,了解了高斯背景建模及背景更新的基本原理及思想。在本文中,首先介绍了运动目标检测方法的相关基础知识,如图像的二值化、图像的形态学处理、颜色空间模型。然后重点说明了三种常用的运动目标检测方法的研究,简要阐述了三种研究方法的基本思想。在老师的帮助下进行了相应的实验,最终得出了三种运动目标检测方法的优点和缺点,着重探究了高斯背景建模及其背景更新基本原理及思想。 最后,通过相关的程序及软件对混合高斯背景模型进行了相关的实验,进而发现了混合高斯背景建模算法存在的不足之处,如:高斯背景建模的计算量大、运动目标较大时检测效果差等问题,并对对这些问题提出了相关设想及改进。 关键词:运动目标检测;二值化;图像的形态学处理;高斯背景建模;背景更新 I

ABSTRACT In many modern fields, moving target detection are showing its important role. Especially nearly twenty years of rapid development of social economy, the moving target detection has shown its importance, in various aviation, communication, navigation and so on have a key role, so the study of moving target detection method has become a research hot topic in countries. By reading relevant papers, a large number of journals and cyber source, understand the basic principle and thought of Gauss background modeling and updating the background. In this paper, firstly introduces the basic knowledge of moving target detection method, such as the two values image, morphological image processing, color space model. Then focus on the study of three methods used for moving object detection, a brief description of the basic ideas of the three kinds of research methods. By the experiment, the results of three kinds of method of moving target detection has advantages and disadvantages, this paper emphatically explores Gauss background modeling and background updating basic principle and thought. Finally, through the program and software related to mixed Gauss background model for the relevant experiments, and found the shortcomings, the presence of mixed Gauss background modeling algorithm such as: the problem of computing Gauss background modeling, moving target volume larger detection effect is poor, and on these problems put forward relevant ideas and improvement. Keywords: moving object detection; two values; I I

AVI视频中运动目标检测的matlab实现

%-------------------------------------------------------------------------- % 基于中位数算法的运动目标检测 % 第1种实现方法 %-------------------------------------------------------------------------- %*******************************读取视频数据******************************** % 调用aviread函数读取视频文件 vid = aviread('WalkingMan.avi') size(vid(1).cdata) % 查看第1帧的大小,也是每一帧的大小 vid(1).colormap % 查看第1帧的colormap值 %*****************************数据类型的转换******************************** % 把vid的cdata字段的取值转换成一个240×360×3×80的四维数组IM IM = cat(4,vid.cdata); size(IM) % 查看IM的大小 [m,n,k,h] = size(IM); % 把IM的大小赋给四个变量 % 把IM转换成一个80行,240×360×3列的矩阵 I = reshape(IM,[m*n*k,h])'; %********************调用median函数求中位数,进行视频图像分割**************** I = median(I); % 求I矩阵中各列元素的中位数 I = reshape(I,[m,n,k]); % 将向量I转成240×360×3的三维数组,得到背景图像 figure; % 新建一个图形窗口 imshow(I); % 显示背景图像 figure; % 新建一个图形窗口 imshow(IM(:,:,:,1) - I); % 显示第1帧中的目标图像 %-------------------------------------------------------------------------- % 基于中位数算法的运动目标检测 % 第1种实现方法 %-------------------------------------------------------------------------- % 调用mmreader函数创建读取视频文件的多媒体阅读对象WalkManObj WalkManObj = mmreader('WalkingMan.avi'); % 根据多媒体阅读对象WalkManObj,读取视频的各帧图像数据 IM = read(WalkManObj, [1, inf]); [m,n,k,h] = size(IM); % 把IM的大小赋给四个变量

人体目标检测与跟踪算法研究

人体目标检测与跟踪算法研究 摘要:近些年以来,基于视频中人体目标的检测与跟踪技术研究越来越被重视。然而,由于受到目标自身特征多样性和目标所处环境的复杂性和不确定性的影响,现存算法的性能受到很大的限制。本文对目前所存在的问题进行了分析,并提出了三帧差分法和改进阈值分割法相结合的运动目标检测算法和多特征融合的改进运动目标跟踪算法。这两种算法不仅可以准确有效的检测出运动目标而且能够满足实时性的要求,有效的解决了因光照变化和目标遮挡等情况造成的运动目标跟踪准确度下降或跟踪目标丢失等问题。 关键词:三帧差分,Camshift,阈值分割 Research Based on Human Target Detectionand Tracking Algorithm Abstract: In recent years, human object detection and tracking become more and more important. However the complexity, uncertainty environment and the target’s own diversity limit the performance of existing algorithms. The main works of this paper is to study and analysis the main algorithm of the human object detection and tracking, and proposes a new moving target detection method based on three-frame difference method and threshold segmentation and improved Camshift tracking algorithm based on multi-feature fusion. These algorithm can satisfy the real-time, while accurately and efficiently detect moving targets, and also effectively solves the problem of tracking object lost or misplaced under illumination change or target occlusion. Keywords: three-frame difference, Camshift, threshold segmentation 一、绪论 (一)选题的背景和意义 人类和动物主要通过眼睛来感受和认知外部世界。人类通过视觉所获取的信息占了60%[1],因此,在开发和完善人工智能的过程中,赋予机器视觉的功能这一操作极不可缺少。完善上述功能需要以许多技术为基础,特别是运动目标的检测与跟踪技术。近些年以来,此技术受到了越来越多的关注[2]。目前,此技术也在各领域得到了充分的应用,涵盖的领域有智能交通、导航、智能视频监控、精确制导、人机交互和多媒体视频编码压缩技术等。

(完整版)视频目标检测与跟踪算法综述

视频目标检测与跟踪算法综述 1、引言 运动目标的检测与跟踪是机器视觉领域的核心课题之一,目前被广泛应用在视频编码、智能交通、监控、图像检测等众多领域中。本文针对视频监控图像的运动目标检测与跟踪方法,分析了近些年来国内外的研究工作及最新进展。 2、视频监控图像的运动目标检测方法 运动目标检测的目的是把运动目标从背景图像中分割出来。运动目标的有效分割对于目标分类、跟踪和行为理解等后期处理非常重要。目前运动目标检测算法的难点主要体现在背景的复杂性和目标的复杂性两方面。背景的复杂性主要体现在背景中一些噪声对目标的干扰,目标的复杂性主要体现在目标的运动性、突变性以及所提取目标的非单一性等等。所有这些特点使得运动目标的检测成为一项相当困难的事情。目前常用的运动目标检测算法主要有光流法、帧差法、背景相减法,其中背景减除法是目前最常用的方法。 2.1帧差法 帧差法主要是利用视频序列中连续两帧间的变化来检测静态场景下的运动目标,假设f k(x, y)和f(k i)(x, y)分别为图像序列中的第k帧和第k+1帧中象素点(x,y)的象素值,则这两帧图像的差值图像就如公式2-1所示: Diff ki f k(x, y) f(k 1)(x, y)(2-1)2-1式中差值不为0的图像区域代表了由运动目标的运动所经过的区域(背景象素值不变),又因为相邻视频帧间时间间隔很小,目标位置变化也很小,所以运动目标的运动所经过的区域也就代表了当前帧中运动目标所在的区域。利用此原理便可以提取出目标。下图给出了帧差法的基本流程:1、首先利用2-1式得到第k帧和第k+1帧的差值图像Diff k 1;2、对所得到的差值图像Diff k 1二值化(如 式子2-2示)得到Qk+1 ;3、为消除微小噪声的干扰,使得到的运动目标更准 确,对Q k 1进行必要的滤波和去噪处理,后处理结果为M k 1。 1

目标检测与跟踪实验报告3 王进

《图像探测、跟踪与识别技术》 实验报告 专业:探测制导与控制技术 学号:11151201 姓名:王进 2014 年11月

实验三复杂场景下目标的检测与跟踪 一、实验目的 1. 学习不同目标跟踪算法,对比不同算法对于复杂场景的效果; 2. 学习OpenCV与VS2010的联合编程,提高编程能力。 二、实验要求 1. 要求学生至少使用一种目标跟踪算法对视频中出现的目标进行跟踪; 2. 检验所选算法在复杂场景下的效果; 3. 使用VS2010/2012和OpenCV进行编程; 4. 本实验不要求目标检测,所以目标可以手动标出。 三、实验步骤 1. 想办法找到目标(可手动框出)。 2. 编写目标跟踪函数代码; 四、实验报告 1、CAMSHIFT算法原理 CAMSHIFT算法是利用目标的颜色直方图模型将图像转换为颜色概率分布图,初始化一个搜索窗的大小和位置,并根据上一帧得到的结果自适应调整搜索窗口的位置和大小,从而定位出当前图像中目标的中心位置。 这个算法可以分为三个部分: 1、色彩投影图(反向投影): (1).RGB颜色空间对光照亮度变化较为敏感,为了减少此变化对跟踪效果的影响,首先将图像从RGB空间转换到HSV空间。(2).然后对其中的H分量作直方图,在直方图中代表了不同H分量值出现的概率或者像素个数,就是说可以查找出H分量大小为h的概率或者像素个数,即得到了颜色概率查找表。(3).将图像中每个像素的值用其颜色出现的概率对替换,就得到了颜色概率分布图。这个过程就叫反向投影,颜色概率分布图是一个灰度图像。 2、MEANSHIFT MEANSHIFT算法是一种密度函数梯度估计的非参数方法,通过迭代寻优找到概率分布的极值来定位目标。 算法过程为: (1).在颜色概率分布图中选取搜索窗W (2).计算零阶距: 计算一阶距:

视频中移动目标检测综述

基于视频的移动目标检测 论文研读报告 苏航00748178 智能科学系信息科学技术学院 北京大学 摘要 基于视频的移动目标检测是一个重要且有挑战性的任务,在许多应用中都起到相当关键的作用。本次论文研读围绕该主题展开,深入阅读了十余篇论文,在本文总结了视频中移动目标检测的一些主要方法及各自的优劣,并将几个重要的方法大致分为了两个不同的类别:基于像素的移动目标检测和基于区域的移动目标检测。在基于像素的方法中,图像特征完全由各个像素的坐标及灰度值(或颜色值)确定,而在基于区域的方法中,各个像素属性之间的关联成为主要特征来用以提取移动目标。另外本文还讨论了以上两类之外的一些方法。 关键词 视频移动目标检测背景差分高斯混合模型直方图 正文 1 引言 基于视频的移动目标检测在许多实际应用中都担当着核心的任务。譬如视频监视、人机交互、视频编码等广泛的领域都需要有效地进行该工作。帧差法(Frame Differencing)12是视频中检测移动目标最简单直观的方法,其在视频片段中固定间隔的两帧之间计算绝对差,该差值大于一定阈限的像素就认为是运动物体可能存在的区域: D t(x,y)=Abs.F t(x,y)?F t?k(x,y)/(1) 这种简单的方法有时十分有效,但在更多应用环境下并不能获得期望的效果。这主要是由于视频中各帧之间的差异并不仅仅来源于运动的物体,而同时可能来 1R. Jain and H. Nagel, “On the Analysis of Accumulative Difference Pictures from Image Sequences of Real World S cenes”, IEEE Trans. Pattern Analysis and Machine Intelligence, vol. 1, no. 2, pp. 206–214, 1979. 2为了避免混淆,本文中将作为主要研读对象的文章列在报告最后的“参考文献”一栏中,而其他引用的 文献则作为脚注注明。